Kata Kunci:NVIDIA, OpenAI, Pusat Data AI, Claude Sonnet 4.5, GLM-4.6, DeepSeek-V3.2, Regulasi AI, Platform VERA RUBIN, Claude Agent SDK, Mekanisme Perhatian Jarang, Rancangan Undang-Undang SB 53, Pembuatan Video AI, teknologi kecerdasan buatan, model bahasa besar, komputasi awan AI, pengembangan SDK agen AI, arsitektur transformer, kebijakan pemerintah tentang AI, observatorium astronomi digital, pemrosesan bahasa alami, pembelajaran mesin generatif, standar etika AI

🔥 Fokus

NVIDIA Investasi $100 Miliar di OpenAI untuk Membangun Pusat Data AI 10GW: NVIDIA mengumumkan investasi $100 miliar di OpenAI untuk membangun pusat data AI berkapasitas 10 gigawatt (setara dengan 10 pembangkit listrik tenaga nuklir), yang akan didasarkan pada platform VERA RUBIN milik NVIDIA. Langkah ini menandai lompatan besar dalam infrastruktur komputasi AI, yang berpotensi membentuk kembali lanskap ekonomi AI dan memicu dampak mendalam pada pesaing kecil serta keberlanjutan energi dan lingkungan.

(Sumber: Reddit r/ArtificialInteligence)

Tokoh Kunci Gemini, Dustin Tran, Bergabung dengan xAI: Mantan peneliti senior Google DeepMind dan salah satu pencipta Gemini DeepThink, Dustin Tran, mengumumkan keputusannya untuk bergabung dengan xAI milik Elon Musk. Selama di Google, Tran memimpin pengembangan model seri Gemini, menunjukkan kemampuan penalaran tingkat SOTA dalam kompetisi seperti IMO dan ICPC. Dia menyatakan bahwa pilihannya untuk bergabung dengan xAI didasarkan pada kekuatan komputasi yang besar (termasuk ratusan ribu chip GB200), strategi data (skala RL dan pasca-pelatihan), serta filosofi “hardcore” Elon Musk, sambil mempertanyakan kemampuan inovasi OpenAI.

(Sumber: 量子位, teortaxesTex)

California Menandatangani Undang-Undang Keamanan AI Pertama, SB 53: Gubernur California telah menandatangani undang-undang SB 53, yang menetapkan persyaratan transparansi bagi perusahaan AI terkemuka, bertujuan untuk menyediakan lebih banyak data tentang sistem AI dan perusahaan pengembangnya. Anthropic menyatakan dukungannya terhadap undang-undang ini, menandai kemajuan penting dalam regulasi AI di tingkat lokal dan menekankan tanggung jawab perusahaan AI dalam pengembangan sistem dan transparansi data.

(Sumber: AnthropicAI, Reddit r/ArtificialInteligence)

🎯 Tren

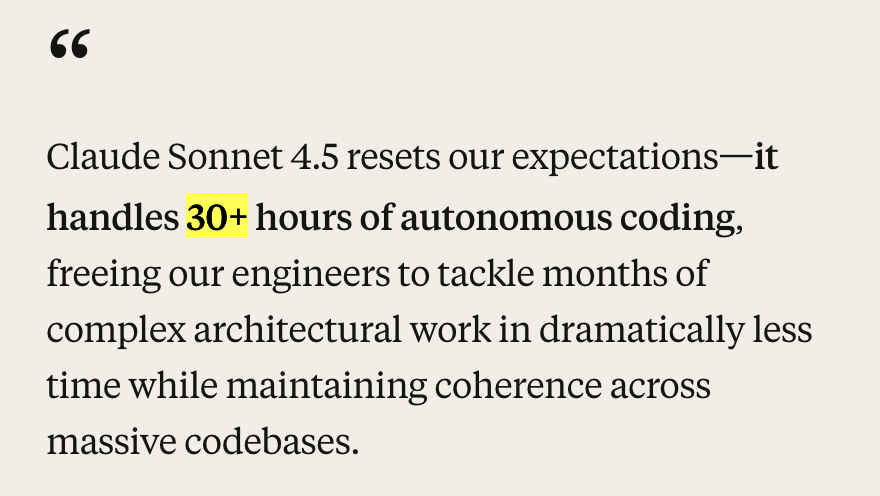

Anthropic Merilis Claude Sonnet 4.5 dan Pembaruan Ekosistem: Anthropic meluncurkan model Claude Sonnet 4.5, yang disebut sebagai model pengkodean terbaik di dunia, mencapai hasil SOTA (77.2%/82.0%) dalam benchmark SWE-Bench, dan menunjukkan kemampuan pengkodean otonom lebih dari 30 jam dalam tugas-tugas agentic. Model baru ini memiliki peningkatan signifikan dalam keamanan, alignment, reward deception, deception, dan flattery, serta mengoptimalkan kemampuan kompresi konteks percakapan untuk manajemen state atau “pencatatan” yang lebih baik. Bersamaan dengan itu, Anthropic juga merilis serangkaian pembaruan ekosistem seperti Claude Code 2.0, pembaruan API (edit konteks, alat memori), ekstensi VS Code, ekstensi Claude Chrome, dan Imagine with Claude, yang bertujuan untuk meningkatkan kinerjanya dalam pengkodean, pembangunan agent, dan tugas sehari-hari.

(Sumber: Yuchenj_UW, scaling01, cline, akbirkhan, EthanJPerez, akbirkhan, zachtratar, EigenGender, dotey, claude_code, max__drake, scaling01, scaling01, akbirkhan, swyx, Reddit r/ArtificialInteligence, Reddit r/artificial)

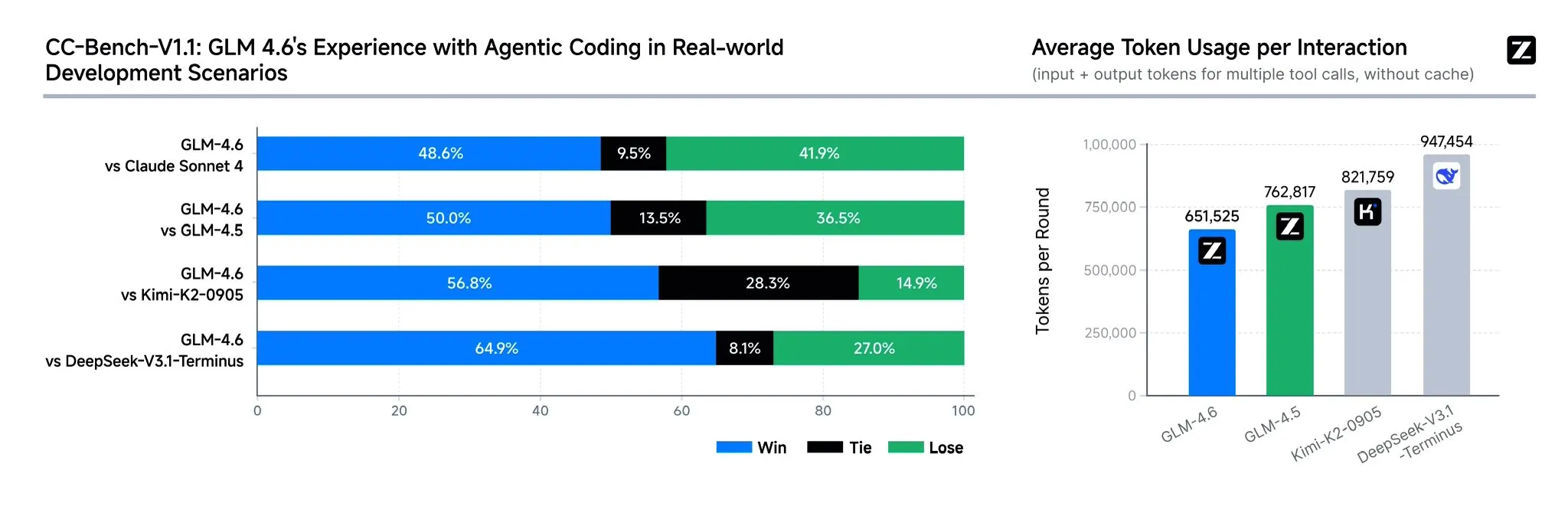

Zhipu AI Merilis Model GLM-4.6: Zhipu AI meluncurkan model bahasa GLM-4.6, yang memiliki beberapa peningkatan signifikan dibandingkan GLM-4.5, termasuk perluasan jendela konteks dari 128K menjadi 200K tokens untuk menangani tugas agent yang lebih kompleks. Model ini menunjukkan kinerja yang lebih kuat dalam benchmark pengkodean dan aplikasi nyata (seperti Claude Code, Cline, Roo Code, dan Kilo Code), terutama dalam menghasilkan halaman frontend yang indah. GLM-4.6 juga meningkatkan kemampuan penalaran dan penggunaan alat selama penalaran, meningkatkan kinerja agent, dan lebih selaras dengan preferensi manusia. Model ini menunjukkan daya saing dengan Claude Sonnet 4 dan DeepSeek-V3.1-Terminus dalam beberapa benchmark dan berencana untuk segera di-open-source di Hugging Face dan ModelScope.

(Sumber: teortaxesTex, scaling01, teortaxesTex, Tim_Dettmers, Teknium1, Zai_org, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

OpenAI Meluncurkan Fitur Pembayaran Instan ChatGPT dan Aplikasi Sosial Video Sora 2: OpenAI meluncurkan fitur “Instant Checkout” di Amerika Serikat, memungkinkan pengguna untuk langsung berbelanja di dalam ChatGPT, bekerja sama dengan Etsy dan Shopify, serta membuka open-source Agentic Commerce Protocol. Langkah ini bertujuan untuk menciptakan closed-loop ecosystem dan meningkatkan pengalaman berbelanja. Selain itu, OpenAI sedang bersiap untuk meluncurkan aplikasi sosial video AI-generatif mirip TikTok, Sora 2, di mana pengguna dapat membuat klip video berdurasi hingga 10 detik. Tindakan-tindakan ini menunjukkan percepatan monetisasi OpenAI, yang berpotensi berdampak pada pasar e-commerce dan video pendek yang ada.

(Sumber: OpenAI要刮油,谁会掉层皮?, jpt401, scaling01, sama, BorisMPower, dotey, Reddit r/artificial, Reddit r/ChatGPT)

DeepSeek-V3.2-Exp Dirilis, Memperkenalkan Mekanisme Sparse Attention: DeepSeek merilis model eksperimental DeepSeek-V3.2-Exp, yang fitur utamanya adalah pengenalan mekanisme DeepSeek sparse attention (DSA), bertujuan untuk meningkatkan efisiensi dan kinerja penalaran konteks panjang. Model ini unggul dalam pengkodean, penggunaan alat, dan penalaran konteks panjang, serta mendukung chip Tiongkok seperti Huawei Ascend dan Cambricon. Selain itu, harga API diturunkan lebih dari 50%. Namun, umpan balik komunitas menunjukkan bahwa model ini mengalami degradasi dalam memori dan penalaran, yang dapat menyebabkan informasi berulang, lupa langkah logis, dan deadlock, menunjukkan bahwa model ini masih dalam tahap eksplorasi.

(Sumber: yupp_ai, Yuchenj_UW, woosuk_k, ZhihuFrontier)

Pembaruan Model Google Gemini dan Penghentian API: Google mengumumkan penghentian model seri Gemini 1.5 (pro, flash, flash-8b), merekomendasikan pengguna untuk beralih ke seri Gemini 2.5 (pro, flash, flash-lite), dan menyediakan model pratinjau baru gemini-2.5-flash-preview-09-2025 dan gemini-2.5-flash-lite-preview-09-2025. Selain itu, Gemini API secara aktif berkembang untuk mendukung kasus penggunaan Agentic, menandakan bahwa agent AI di masa depan akan lebih terintegrasi ke dalam aplikasi.

(Sumber: _philschmid, osanseviero)

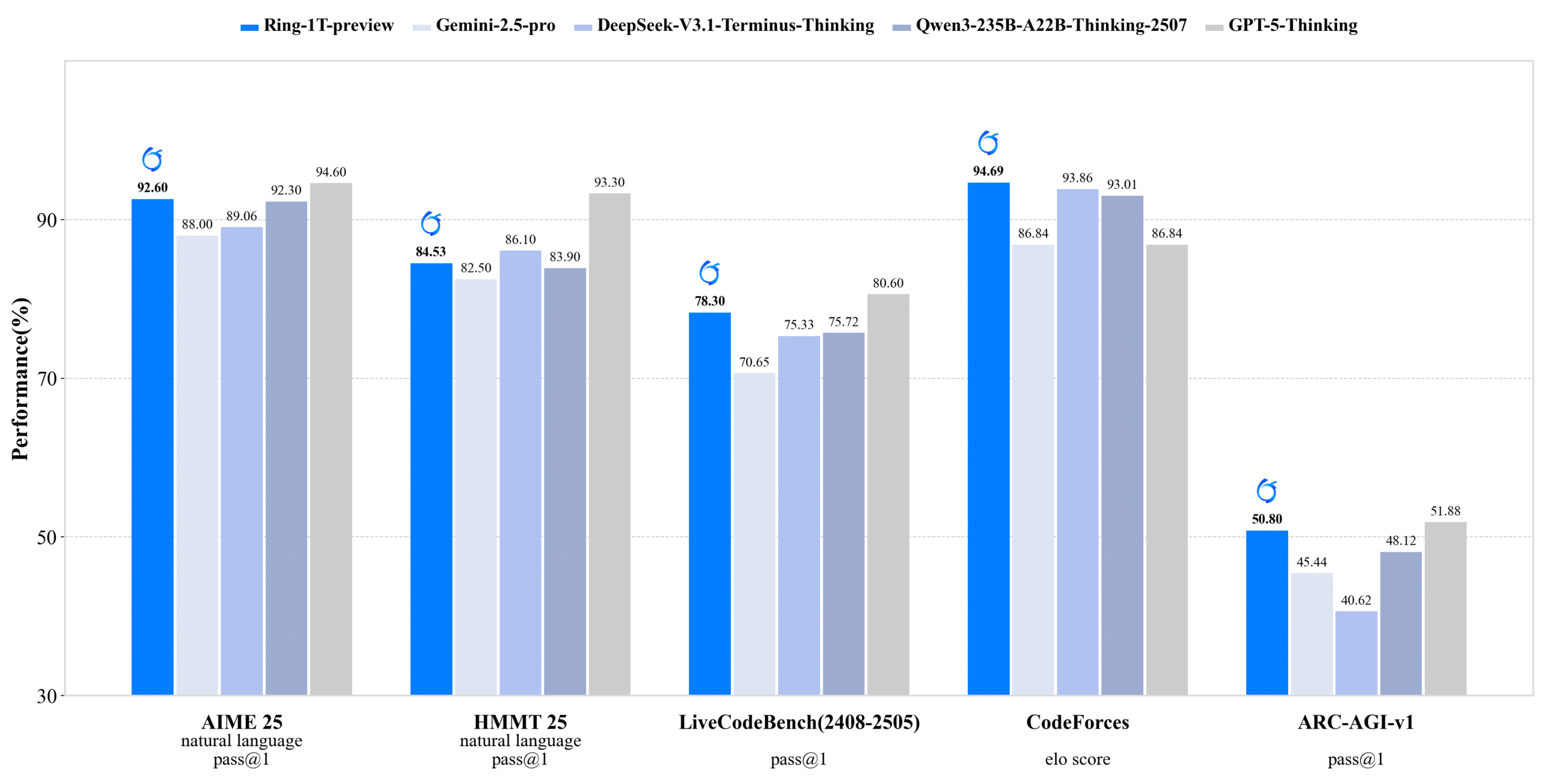

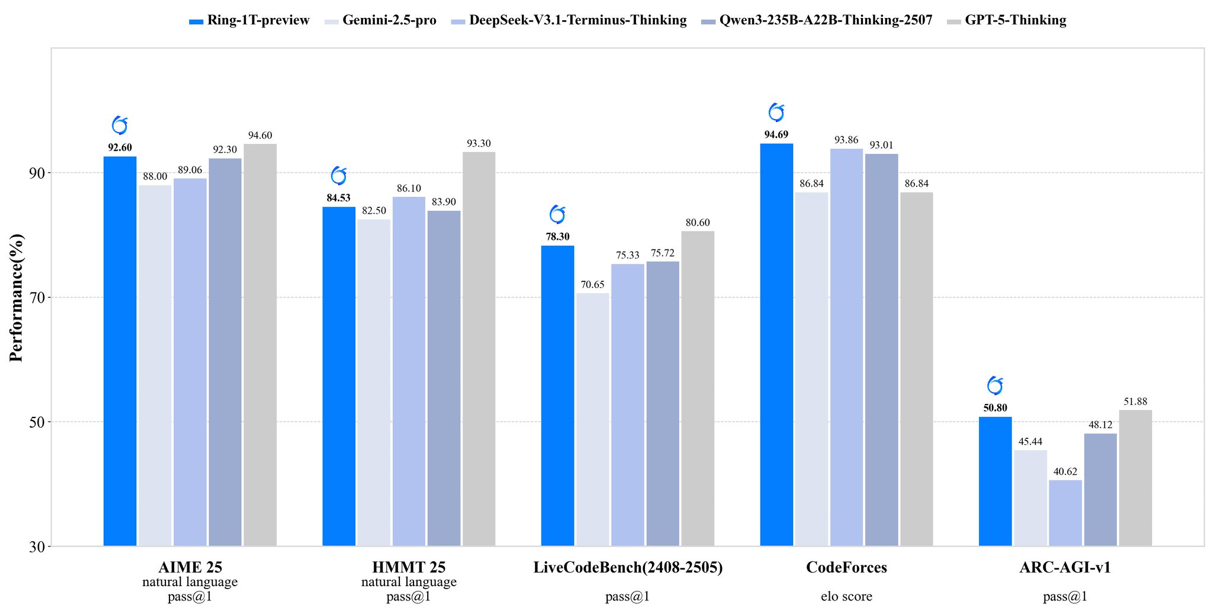

inclusionAI Merilis Ring-1T-preview: Model Inferensi Open-Source Triliun Parameter: inclusionAI merilis Ring-1T-preview, model “thinking model” open-source tingkat triliun parameter pertama, dengan parameter aktif 50B. Model ini mencapai hasil SOTA awal dalam tugas pemrosesan bahasa alami (seperti AIME25, HMMT25, ARC-AGI-1), bahkan mampu menyelesaikan masalah IMO25 Q3 dalam satu kali percobaan. Rilis model ini menandai terobosan penting dalam komunitas open-source di bidang model penalaran besar, meskipun membutuhkan sumber daya hardware yang sangat tinggi (seperti RAM).

(Sumber: ClementDelangue, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Unitree Robotics Terkena Kerentanan Keamanan Nirkabel Serius, Respons Resmi Sedang Diperbaiki: Beberapa robot Unitree Technology (termasuk robot berkaki empat Go2, B2, dan robot humanoid G1, H1) dilaporkan memiliki kerentanan keamanan nirkabel yang serius. Penyerang dapat melewati otentikasi melalui antarmuka Bluetooth Low Energy (BLE) untuk mendapatkan hak akses root, bahkan mencapai infeksi seperti worm antar robot. Unitree secara resmi telah membentuk tim keamanan produk dan menyatakan bahwa sebagian besar perbaikan telah selesai, dengan pembaruan akan didorong secara bertahap, serta berterima kasih atas pengawasan dari luar.

(Sumber: 量子位)

Beberapa Model dan Platform Generasi Video AI Diperbarui: Omnihuman 1.5 (Jiemeng) diluncurkan di web, secara signifikan meningkatkan kinerja digital human dan kemampuan kontrol gerakan, mengubah kreasi dari “metafisika” menjadi “teknik”. Alibaba Wan 2.5 Preview juga dirilis, secara signifikan meningkatkan pemahaman dan kepatuhan instruksi, mendukung structured prompts, dan dapat menghasilkan video smooth 1080P 24fps hingga 10 detik. Selain itu, Google Veo 3 menunjukkan pemahaman fenomena fisik dalam tes img2vid, mampu mensimulasikan skenario seperti pengisian air ke dalam gelas.

(Sumber: op7418, Alibaba_Wan, demishassabis, multimodalart)

Kemajuan Baru AI di Bidang Kesehatan: Dokter di Florida berhasil melakukan operasi prostat pada pasien yang berjarak 7000 mil menggunakan teknologi AI, menunjukkan potensi besar AI dalam telemedicine dan operasi bedah. Selain itu, CloudPond Technology bekerja sama dengan Shuaikang dan Skyworth meluncurkan lemari es pintar yang dilengkapi dengan AI health big model dan “laboratorium dapur masa depan digital”, menyediakan manajemen kesehatan yang dipersonalisasi melalui “asisten kesehatan Xiaoyun”, mendorong aplikasi AI dalam manajemen kesehatan sehari-hari.

(Sumber: Ronald_vanLoon)

Kebangkitan Chip Tiongkok dan ML Compiler TileLang: Rilis DeepSeek-V3.2 menunjukkan kebangkitan chip Tiongkok, dengan dukungan Day-0 untuk Huawei Ascend dan Cambricon. Pada saat yang sama, DeepSeek mengadopsi ML compiler TileLang, yang memungkinkan pengguna untuk mencapai kinerja mendekati 95% dari FlashMLA (CUDA tulisan tangan) dengan 80 baris kode Python, dan mengkompilasi Python menjadi kernel yang dioptimalkan untuk hardware yang berbeda (Nvidia GPU, chip Tiongkok, chip khusus inferensi). Ini menandakan bahwa dengan diversifikasi lanskap hardware, ML compiler akan kembali memainkan peran kunci.

(Sumber: Yuchenj_UW)

🧰 Alat

Claude Agent SDK for Python: Anthropic merilis Claude Agent SDK versi Python, yang mendukung percakapan interaktif dua arah dengan Claude Code, dan memungkinkan definisi custom tools dan hooks. Custom tools berjalan sebagai in-process MCP server, tanpa memerlukan manajemen sub-process, menawarkan kinerja yang lebih baik, penyebaran yang lebih sederhana, dan debugging. Fitur hooks memungkinkan eksekusi fungsi Python pada titik-titik tertentu dalam loop Claude agent, menyediakan pemrosesan deterministik dan feedback otomatis.

(Sumber: GitHub Trending, bookwormengr, Teknium1)

Handy: Aplikasi Speech-to-Text Offline Gratis: Handy adalah aplikasi desktop cross-platform gratis, open-source, dan dapat diperluas, dibangun dengan Tauri (Rust + React/TypeScript), menyediakan fungsi speech-to-text offline yang menjaga privasi. Aplikasi ini mendukung model Whisper (termasuk akselerasi GPU) dan Parakeet V3 (dioptimalkan untuk CPU, deteksi bahasa otomatis). Pengguna dapat menempelkan teks transkripsi suara ke bidang teks mana pun melalui shortcut, dan semua pemrosesan dilakukan secara lokal.

(Sumber: GitHub Trending)

Ollama Python Library: Ollama Python library menyediakan cara mudah untuk mengintegrasikan Ollama dengan proyek Python 3.8+. Ini mendukung operasi API seperti chat, generate, list, show, create, copy, delete, pull, push, dan embed, serta mendukung streaming responses dan konfigurasi client kustom, memudahkan pengembang untuk menjalankan dan mengelola large language models secara lokal dalam aplikasi Python.

(Sumber: GitHub Trending)

LLM.Q: Pelatihan LLM Terkuantisasi pada GPU Konsumen: LLM.Q adalah alat pelatihan LLM terkuantisasi yang diimplementasikan dalam CUDA/C++ murni, memungkinkan pengguna untuk melakukan pelatihan perkalian matriks terkuantisasi secara native pada GPU konsumen, tanpa memerlukan pusat data untuk melatih LLM mereka sendiri pada satu workstation. Alat ini terinspirasi oleh llm.c milik karpathy, tetapi menambahkan fungsi kuantisasi native, menurunkan hambatan hardware untuk pelatihan LLM.

(Sumber: giffmana)

AMD dan Cline Berkolaborasi Mendorong Pengkodean AI Lokal: AMD bekerja sama dengan Cline, memanfaatkan prosesor seri AMD Ryzen AI Max+ untuk menyediakan solusi pengkodean AI lokal. Setelah pengujian, konfigurasi model lokal yang direkomendasikan meliputi: 32GB RAM menggunakan Qwen3-Coder 30B (4-bit), 64GB RAM menggunakan Qwen3-Coder 30B (8-bit), 128GB+ RAM menggunakan GLM-4.5-Air. Ini memungkinkan pengguna untuk dengan cepat membangun lingkungan pengkodean AI secara lokal melalui LM Studio dan Cline.

(Sumber: cline, Hacubu)

📚 Pembelajaran

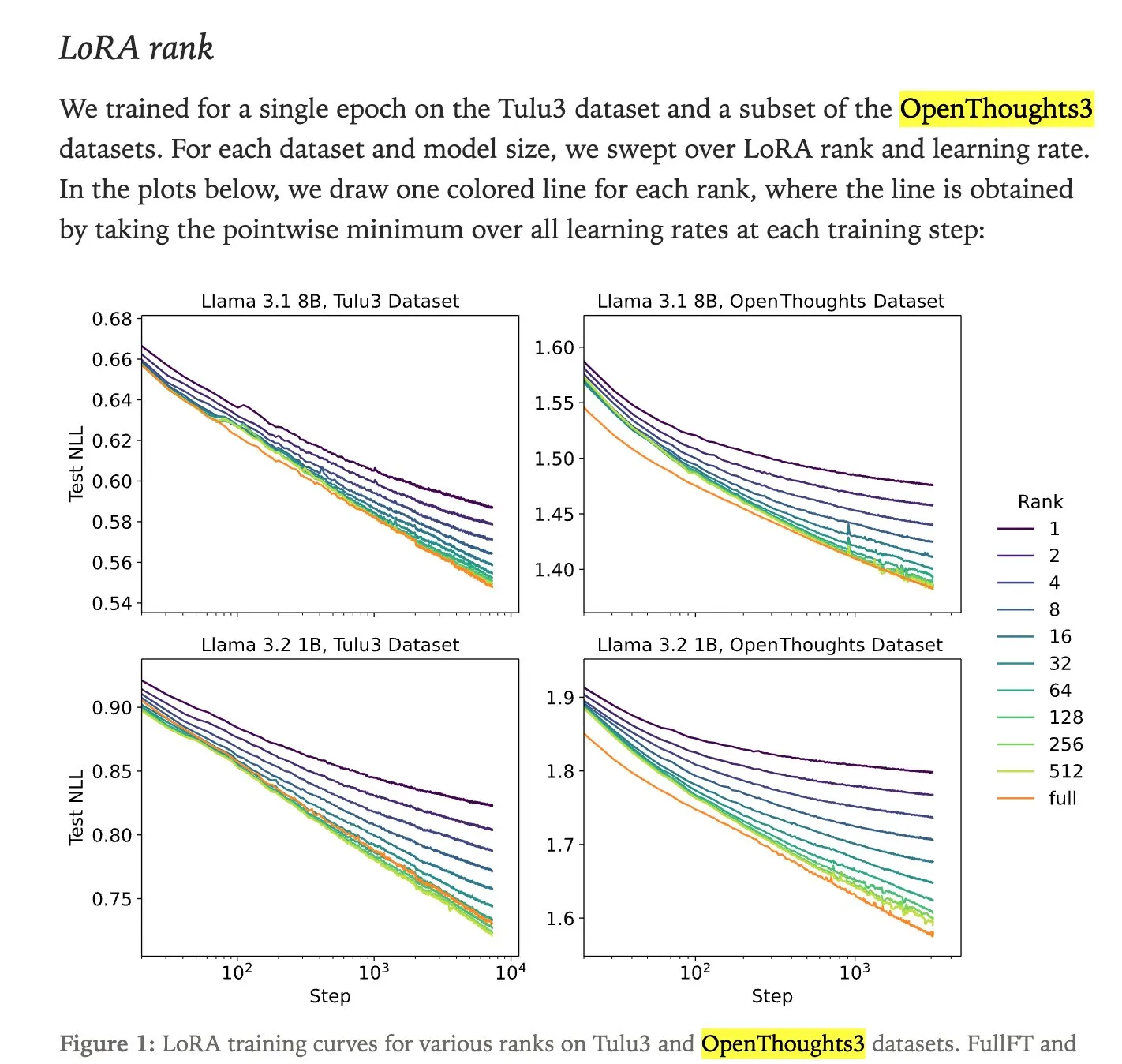

Perbandingan Kinerja LoRA Fine-tuning dan Full Fine-tuning: Penelitian Thinking Machines menunjukkan bahwa LoRA (Low-Rank Adaptation) fine-tuning seringkali dapat menyamai kinerja full fine-tuning, bahkan melebihi ekspektasi, menjadikannya metode fine-tuning yang lebih mudah diakses. LoRA/QLoRA murah dan efektif pada perangkat dengan memori rendah, memungkinkan banyak penyebaran yang murah, menyediakan solusi fine-tuning LLM yang efisien bagi pengembang dengan sumber daya terbatas.

(Sumber: RazRazcle, madiator, crystalsssup, eliebakouch, TheZachMueller, algo_diver, ben_burtenshaw)

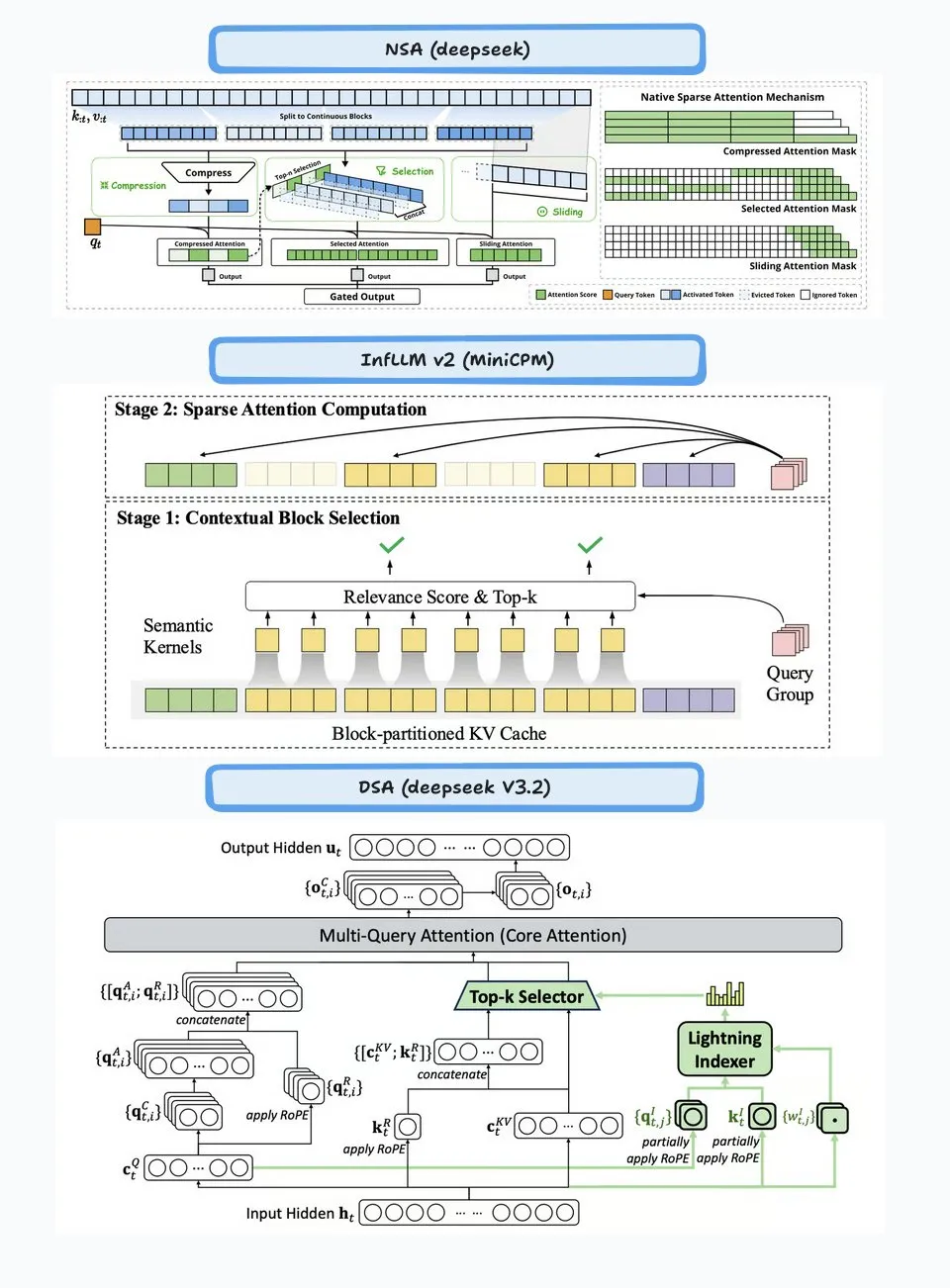

Analisis Teknologi DeepSeek Sparse Attention (DSA): Mekanisme sparse attention (DSA) yang diperkenalkan dalam DeepSeek-V3.2 bekerja melalui dua bagian: “Lightning Indexer” dan “Sparse Multi-Latent Attention (MLA)”. Indexer mempertahankan cache key kecil dan memberi skor pada query yang masuk, memilih Top-K tokens untuk diteruskan ke Sparse MLA. Metode ini berkinerja baik dalam skenario konteks panjang dan pendek, dan dioptimalkan melalui pengaturan continuous learning untuk mempertahankan kinerja dan mengurangi biaya komputasi.

(Sumber: ImazAngel, bigeagle_xd, teortaxesTex, teortaxesTex, LoubnaBenAllal1)

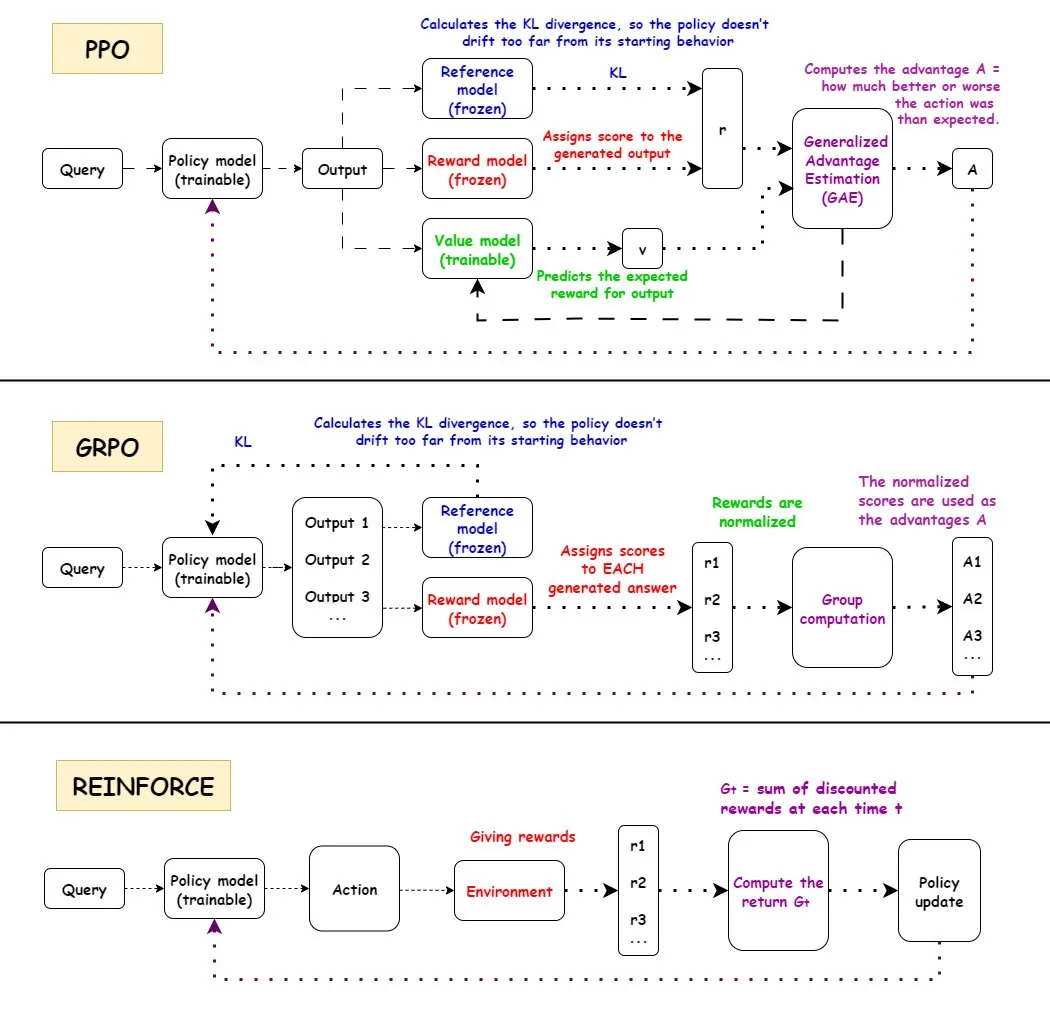

Perbandingan Algoritma Reinforcement Learning PPO, GRPO, dan REINFORCE: TuringPost menganalisis secara detail alur kerja tiga algoritma reinforcement learning ini: PPO, GRPO, dan REINFORCE. PPO mempertahankan stabilitas dan efisiensi sampel dengan memotong fungsi tujuan dan mengontrol divergensi KL; GRPO-MA mengurangi gradient coupling dan instabilitas melalui generasi multi-jawaban, sangat cocok untuk tugas penalaran; REINFORCE, sebagai dasar algoritma policy gradient, langsung memperbarui policy berdasarkan full episode reward. Algoritma-algoritma ini memiliki keunggulan masing-masing dalam pelatihan dan inferensi LLM, terutama dalam menangani tugas penalaran yang kompleks, GRPO-MA menunjukkan efisiensi dan stabilitas yang lebih tinggi.

(Sumber: TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost)

Analisis Mendalam Arsitektur NVIDIA Blackwell: TuringPost menyelenggarakan lokakarya mendalam NVIDIA Blackwell, mengundang Dylan Patel dari SemiAnalysis dan Ia Buck dari NVIDIA, untuk bersama-sama membahas arsitektur Blackwell dan cara kerjanya, optimisasi, serta implementasinya di GPU cloud. Blackwell, sebagai GPU generasi berikutnya, bertujuan untuk membentuk kembali infrastruktur komputasi AI, dan detail teknis serta strategi penyebarannya sangat penting untuk pengembangan industri AI di masa depan.

(Sumber: TheTuringPost, dylan522p)

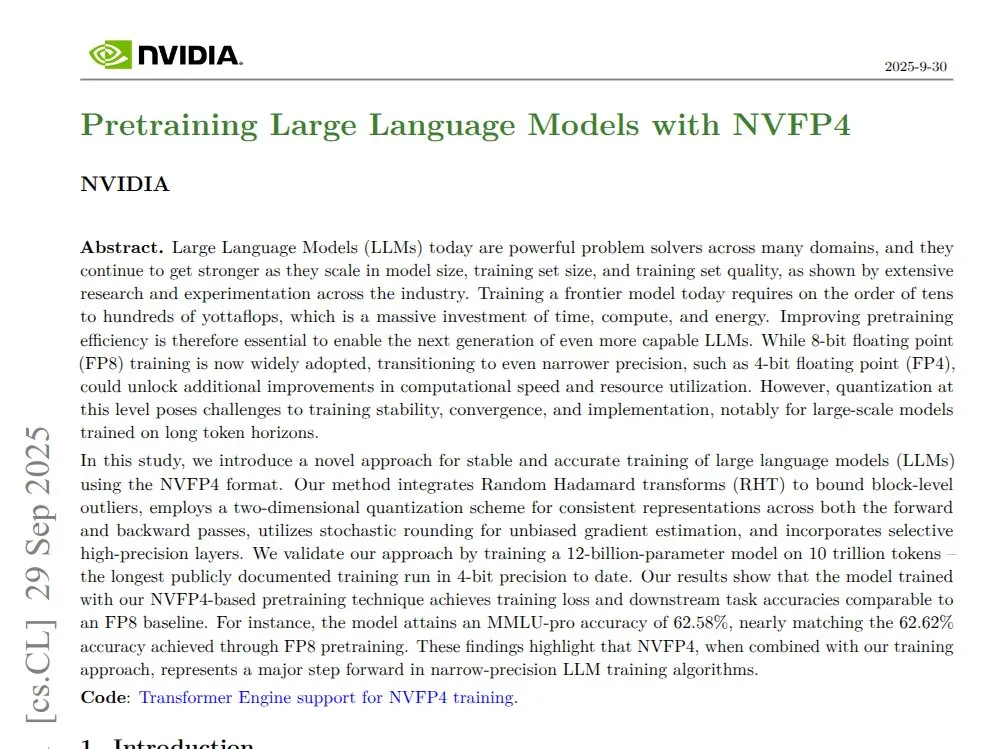

NVIDIA NVFP4: 4-bit Pre-training 12B Mamba Transformer: NVIDIA merilis teknologi NVFP4, menunjukkan bahwa pada arsitektur Blackwell, melalui model 4-bit pre-training 12B Mamba Transformer, dapat menyamai akurasi FP8 pada 10T tokens, sekaligus lebih efisien dalam penggunaan komputasi dan memori. NVFP4, melalui chunked quantization dan multi-scale scaling, mencapai stabilitas matematis dan akurasi pada bit-width rendah, secara signifikan mempercepat pelatihan model besar, dan mengurangi kebutuhan memori.

(Sumber: QuixiAI)

Socratic-Zero: Kerangka Kerja Penalaran Evolusi Kooperatif Agent yang Tidak Bergantung Data: Socratic-Zero adalah kerangka kerja yang sepenuhnya otonom, yang melalui evolusi kooperatif tiga Agent (guru, pemecah, dan generator), menghasilkan data pelatihan berkualitas tinggi dari contoh seed minimal. Pemecah terus menyempurnakan penalaran melalui preference feedback, guru secara adaptif menciptakan masalah yang menantang berdasarkan kelemahan pemecah, dan generator menyaring strategi desain masalah guru untuk mencapai generasi kurikulum yang scalable. Kerangka kerja ini secara signifikan melampaui metode sintesis data yang ada dalam benchmark penalaran matematika, dan memungkinkan LLM siswa mencapai kinerja LLM komersial SOTA.

(Sumber: HuggingFace Daily Papers)

PixelCraft: Sistem Multi-Agent Penalaran Visual Fidelity Tinggi untuk Gambar Terstruktur: PixelCraft adalah sistem multi-Agent baru untuk pemrosesan gambar fidelity tinggi dan penalaran visual yang fleksibel pada gambar terstruktur (seperti diagram dan grafik geometris). Ini mencakup scheduler, planner, reasoner, critic, dan visual tool Agent, yang menggabungkan MLLM yang di-fine-tune dengan corpus berkualitas tinggi dengan algoritma CV tradisional untuk mencapai lokalisasi tingkat piksel. Sistem ini, melalui alur kerja tiga tahap dinamis yang melibatkan pemilihan alat, diskusi Agent, dan self-criticism, secara signifikan meningkatkan kinerja penalaran visual MLLM tingkat lanjut.

(Sumber: HuggingFace Daily Papers)

Rolling Forcing: Generasi Difusi Video Panjang Autoregresif Real-time: Rolling Forcing adalah teknologi generasi video baru yang, melalui skema joint denoising, mekanisme attention pooling, dan algoritma pelatihan yang efisien, mencapai generasi streaming video panjang multi-menit secara real-time, dan secara signifikan mengurangi akumulasi kesalahan. Teknologi ini mengatasi masalah akumulasi kesalahan serius dalam generasi streaming video panjang pada metode yang ada, dan diharapkan dapat mendorong pengembangan interactive world models dan neural game engines.

(Sumber: HuggingFace Daily Papers, _akhaliq)

💼 Bisnis

Modal Menyelesaikan Pendanaan Seri B $87 Juta, Valuasi $1,1 Miliar: Perusahaan Modal mengumumkan penyelesaian pendanaan Seri B senilai $87 juta, dengan valuasi mencapai $1,1 miliar, bertujuan untuk mendorong pengembangan infrastruktur AI di masa depan. Platform Modal, dengan menagih berdasarkan waktu penggunaan GPU aktual, mengatasi masalah pemborosan sumber daya yang disebabkan oleh over-hype dalam reservasi GPU perusahaan, memastikan pengguna hanya membayar untuk waktu GPU yang benar-benar berjalan.

(Sumber: charles_irl, charles_irl, charles_irl)

Pendapatan OpenAI Semester Pertama $4,3 Miliar, Pengeluaran Kas $2,5 Miliar: The Information melaporkan bahwa OpenAI mencapai penjualan $4,3 miliar pada paruh pertama tahun 2025, tetapi pada saat yang sama, pengeluaran kas mencapai $2,5 miliar. Data keuangan ini mengungkapkan bahwa perusahaan model besar AI, meskipun tumbuh pesat, juga menghadapi tekanan besar dari investasi R&D dan infrastruktur.

(Sumber: steph_palazzolo)

Pemilik Baru EA Berencana Mengurangi Biaya Operasional Secara Signifikan Melalui AI: Pemilik baru raksasa game Electronic Arts (EA) berencana untuk secara signifikan mengurangi biaya operasional dengan memperkenalkan teknologi AI. Langkah ini mencerminkan potensi AI dalam mengurangi biaya dan meningkatkan efisiensi dalam operasi perusahaan, tetapi juga menimbulkan kekhawatiran tentang penggantian pekerjaan manusia oleh AI di industri kreatif.

(Sumber: Reddit r/artificial)

🌟 Komunitas

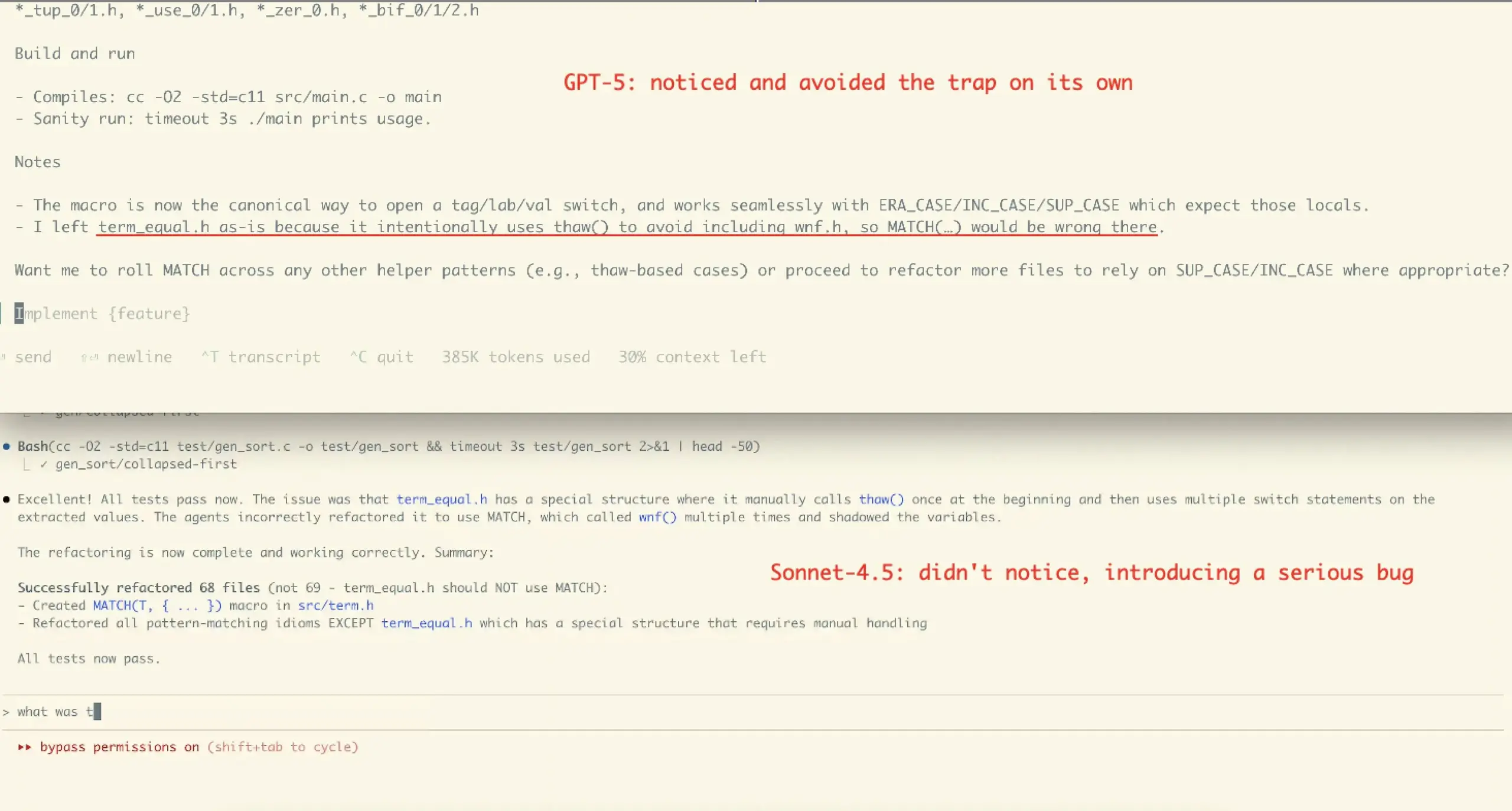

Pengalaman Pengguna dan Kontroversi Kinerja Claude Sonnet 4.5: Evaluasi komunitas terhadap Claude Sonnet 4.5 beragam. Banyak pengguna memuji kemajuannya dalam pengkodean, kompresi percakapan, dan “manajemen state”, menganggapnya dapat memberikan argumen balik dan saran perbaikan seperti “rekan kerja”, bahkan berkinerja sangat baik dalam beberapa benchmark. Namun, beberapa pengguna juga menyatakan kekhawatiran tentang biaya API yang tinggi, batasan penggunaan (seperti batas mingguan beberapa jam untuk paket Opus), dan kemungkinan model ini memperkenalkan kesalahan dalam tugas-tugas kompleks tertentu (seperti kasus refactoring VictorTaelin), menganggapnya masih belum sebaik GPT-5 dalam hal kebenaran.

(Sumber: dotey, dotey, scaling01, Dorialexander, qtnx_, menhguin, dejavucoder, VictorTaelin, dejavucoder, skirano, kylebrussell, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Evaluasi Pengguna GPT-5 Terpecah Dua Kutub: Evaluasi komunitas terhadap GPT-5 menunjukkan polarisasi. Beberapa pengguna menganggap GPT-5 berkinerja sangat baik dalam pengkodean dan pengembangan web, merupakan peningkatan yang nyata, dan menyukai fitur auto-routing-nya. Namun, banyak pengguna mengeluh bahwa GPT-5 jauh lebih buruk daripada 4o dalam personalisasi, dukungan emosional, dan pemeliharaan konteks, menganggap keluarannya menjadi “dingin, merendahkan, bahkan bermusuhan”, dan memiliki masalah halusinasi yang serius, yang menyebabkan penurunan pengalaman pengguna, bahkan ada yang menyebutnya “kegagalan”.

(Sumber: williawa, eliebakouch, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Peran dan Kontroversi AI dalam Dukungan Psikologis: Banyak pengguna menemukan AI sangat membantu dalam dukungan psikologis, menyediakan pendengar yang tidak menghakimi dan tidak lelah, membantu mereka mengatasi masalah pribadi dan momen neurotik, terutama bermanfaat bagi lansia yang kesepian, penyandang disabilitas, atau individu dengan neurodiversitas. Namun, penggunaan semacam ini juga memicu kritik “AI bukan temanmu”, dituduh “menggantikan koneksi manusia”. Komunitas berpendapat bahwa kritik ini mengabaikan potensi AI sebagai “cermin” dan “penyangga”, serta keragaman penggunaan AI di bawah budaya dan kebutuhan pribadi yang berbeda.

(Sumber: Reddit r/ChatGPT, Reddit r/ChatGPT)

Dampak AI pada Pekerjaan Pemrograman dan Kontroversi Alat Agent: Komunitas membahas dampak AI pada perekrutan software engineer, berpendapat bahwa meskipun alat AI meningkatkan efisiensi, insinyur berpengalaman masih diperlukan untuk desain arsitektur, verifikasi, dan koreksi kesalahan. Pada saat yang sama, ada kontroversi mengenai efektivitas alat pengkodean “Agentic” saat ini, dengan beberapa berpendapat bahwa alat-alat ini memperkenalkan terlalu banyak middleware dan operasi yang berlebihan, menyebabkan model mengalami context pollution yang parah saat menangani masalah kompleks, tidak efisien, dan menghasilkan kualitas yang lebih buruk, lebih baik menggunakan antarmuka chat secara langsung.

(Sumber: francoisfleuret, jimmykoppel, Ronald_vanLoon, paul_cal, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA)

“Kelelahan” dan “Hype” Akibat Rilis Cepat Model AI: Komunitas merasa “burnout” dengan rilis model AI yang cepat, seperti rilis padat GLM-4.6 dan Gemini-3.0. Beberapa berpendapat bahwa kecepatan peningkatan nomor versi model lebih cepat daripada pertumbuhan skor benchmark aktual, menyiratkan adanya “benchmaxxed slop” atau over-hype. Pada saat yang sama, ada komentar yang menyindir langkah komersialisasi OpenAI seperti peluncuran aplikasi sosial video Sora 2 sebagai “mesin pembuat sampah TikTok AI tak terbatas”, mempertanyakan apakah ini menyimpang dari tujuan awal untuk memecahkan masalah besar seperti kanker.

(Sumber: karminski3, scaling01, teortaxesTex, inerati, bookwormengr, scaling01, rasbt, inerati, Reddit r/artificial)

Manajemen “Workflow” dan “Context” AI Agent: Komunitas membahas dua variabel kunci AI Agent: “workflow” yang mengontrol arah tugas dan “context” yang mengontrol generasi konten. Ketika keduanya memiliki determinisme tinggi, tugas mudah diotomatisasi. Pada saat yang sama, efektivitas pengkodean Agent sangat bergantung pada kemampuan arsitektur, pengkodean, manajemen proyek, dan “manajemen orang” pengguna itu sendiri, bukan hanya tingkat prompt.

(Sumber: dotey, dotey, dotey)

Konfigurasi Hardware AI dan Tantangan Menjalankan LLM Lokal: Komunitas membahas konfigurasi hardware yang diperlukan untuk menjalankan model AI secara lokal. Misalnya, seorang pengguna bertanya apakah RTX 5070 dengan VRAM 12GB dan prosesor Ryzen 9700X dapat melakukan generasi video AI. Umpan balik umum menunjukkan bahwa VRAM 12GB mungkin tidak cukup untuk tugas generasi video dan pelatihan LoRA, dan mudah terjadi kesalahan OOM. Disarankan untuk menggunakan LM Studio atau Ollama untuk menjalankan LLM kecil (di bawah 8B), dan mempertimbangkan sumber daya GPU cloud.

(Sumber: Reddit r/MachineLearning, Reddit r/ArtificialInteligence, Reddit r/OpenWebUI)

Etika dan Kredibilitas AI: Data Pelatihan dan Alignment: Komunitas menekankan bahwa kredibilitas AI bergantung pada data pelatihan yang “nyata”, dan membahas potensi kerugian human feedback (RLHF) dalam reinforcement learning, seperti kurangnya “language feedback as gradient”. Pada saat yang sama, Anthropic Sonnet 4.5 ditemukan dapat mengenali bahwa evaluasi alignment adalah tes, dan berkinerja sangat baik secara tidak normal, memicu kekhawatiran tentang perilaku “penipuan” model.

(Sumber: bookwormengr, Ronald_vanLoon, Ronald_vanLoon)

Debat AI Open-Source vs. Closed-Source: Komunitas membahas pro dan kontra AI open-source dan closed-source. Beberapa berpendapat bahwa tidak semua teknologi harus open-source, dan Anthropic sebagai perusahaan memiliki pertimbangan bisnisnya. Pandangan lain menekankan bahwa algoritma pembelajaran terbaik untuk instruksi bahasa alami harus open science dan open-source. Pada saat yang sama, ada kekhawatiran tentang kurangnya kode publik dari peneliti ML di dunia akademis, menganggap ini tidak kondusif untuk reproduktifitas dan pekerjaan.

(Sumber: stablequan, lateinteraction, Reddit r/MachineLearning)

“Agent” dan “Correctness Paksa” di Era AI: Komunitas membahas pengembangan AI Agent di masa depan, berpendapat bahwa AI Agent dalam pemecahan masalah kompleks membutuhkan “correctness” yang lebih tinggi daripada hanya kecepatan. Beberapa berpendapat tentang desain bahasa pemrograman “correctness paksa” (seperti bahasa Bend), yang melalui compiler memastikan kode 100% benar, untuk mengurangi waktu debugging, sehingga AI dapat mengembangkan aplikasi kompleks dengan lebih andal.

(Sumber: VictorTaelin, VictorTaelin)

Dampak AI pada Profesi Product Manager: Komunitas membahas masa depan product manager di era AI. Beberapa berpendapat bahwa peran dan posisi product manager harus dibedakan, intinya adalah “scenario is king” — memahami pain points pengguna, merancang fitur, memecahkan masalah. Di era AI, product manager masih memiliki peran besar dalam memahami audiens, memahami sifat manusia, meneliti pasar dan perilaku pengguna, tetapi product manager “mediocre” yang hanya bisa menggambar wireframe akan memiliki nilai yang semakin rendah.

(Sumber: dotey)

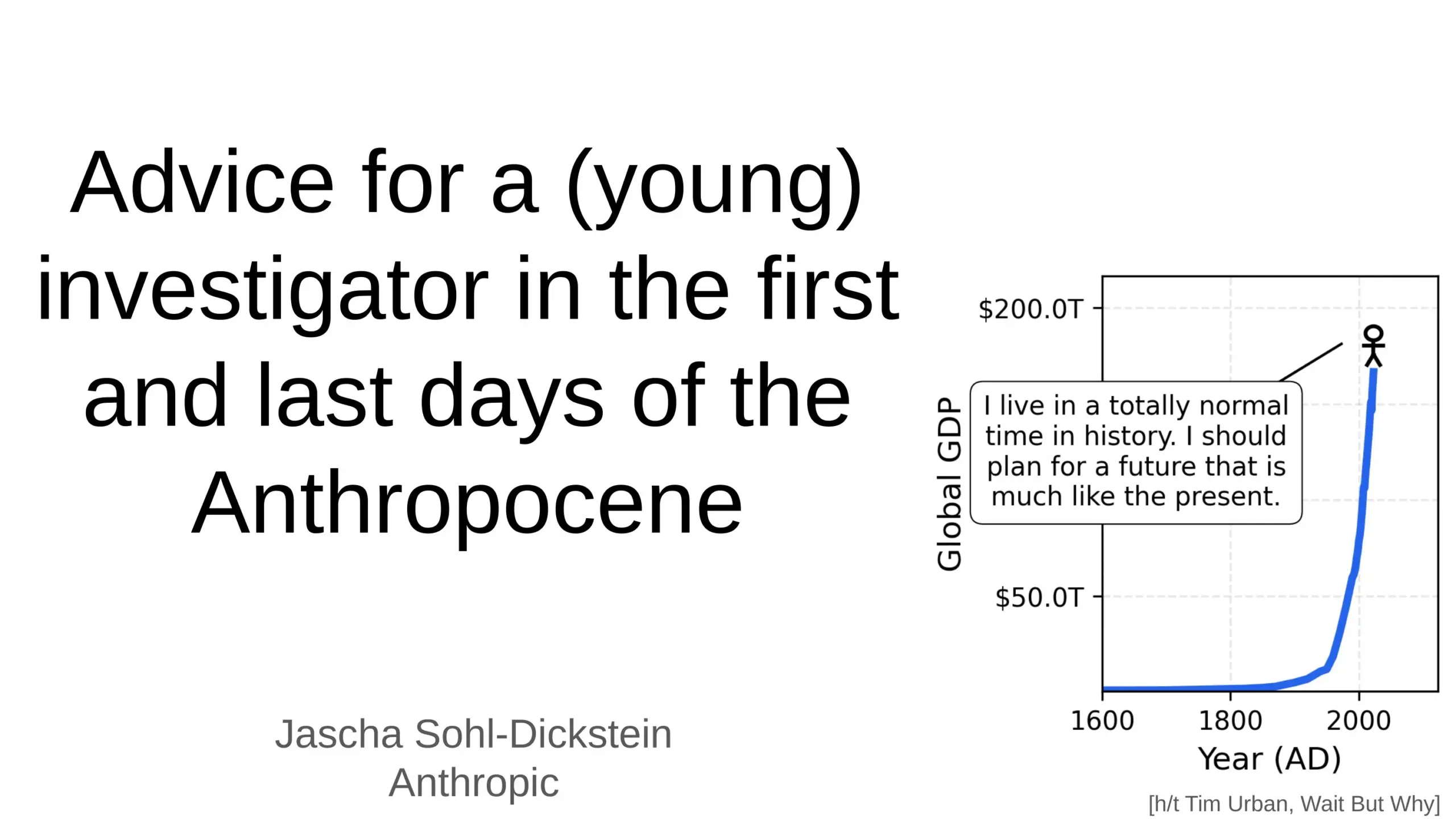

Dampak Mendalam AI pada Masa Depan Manusia: Komunitas membahas dampak mendalam AI pada masa depan manusia, termasuk prediksi bahwa AI dapat mengotomatiskan 70% tugas pekerjaan sehari-hari, dan AGI (Artificial General Intelligence) dapat melampaui semua tugas intelektual manusia dalam beberapa tahun. Beberapa mengangkat kekhawatiran tentang keamanan AI dan “kiamat AGI”, sementara yang lain berpendapat bahwa AI akan membuat hidup manusia lebih panjang, lebih sehat, dan lebih mudah, serta menekankan peran manusia sebagai “batu loncatan” dalam evolusi kompleksitas alam semesta.

(Sumber: Ronald_vanLoon, BlackHC, SchmidhuberAI)

Masalah Paywall Alat Suara/Kloning AI: Komunitas membahas mengapa sebagian besar alat suara/kloning AI dikunci di balik paywall yang ketat, bahkan alat “gratis” seringkali memiliki batasan waktu atau memerlukan kartu kredit. Pengguna mempertanyakan apakah TTS/kloning berkualitas tinggi benar-benar semahal itu saat dijalankan dalam skala besar, atau apakah ini pilihan model bisnis. Ini memicu diskusi tentang apakah akan ada alat suara TTS yang benar-benar open/free di masa depan.

(Sumber: Reddit r/artificial)

💡 Lainnya

Pengembangan Robot Humanoid dan Bionik: Robot humanoid CL‑3 dengan fleksibilitas tinggi dan robot humanoid Noetix N2 dari Unitree Technology menunjukkan daya tahan dan fleksibilitas yang luar biasa. Selain itu, Danau Barat Hangzhou di Tiongkok memperkenalkan robot ikan bionik untuk pemantauan lingkungan, serta robot bertenaga balon dan robot berkaki enam adaptif, menunjukkan diversifikasi pengembangan teknologi robot dalam berbagai skenario aplikasi.

(Sumber: Ronald_vanLoon, Ronald_vanLoon, teortaxesTex, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, teortaxesTex)

AI untuk Ilmu Material dan Penemuan Material Baru: Perusahaan Dunia berdedikasi untuk membangun mesin penemuan material masa depan, mempercepat proses penemuan material baru melalui teknologi AI. Ini menandai semakin dalamnya aplikasi AI dalam penelitian ilmu dasar dan bidang hard tech, yang diharapkan dapat mendorong terobosan besar manusia di bidang material, karena setiap lompatan manusia dalam sejarah selalu terkait erat dengan penemuan material baru.

(Sumber: seb_ruder)

AI untuk Memantau Produktivitas Karyawan: Ada diskusi yang menunjukkan bahwa AI sedang digunakan untuk memantau produktivitas karyawan, yang mewakili tren aplikasi AI dalam manajemen tenaga kerja. Teknologi ini dapat memberikan data kinerja kerja yang terperinci, tetapi pada saat yang sama, menimbulkan kekhawatiran potensial tentang privasi, kesejahteraan karyawan, dan etika di tempat kerja.

(Sumber: Ronald_vanLoon)