Kata Kunci:GPT-5, Komputasi Kuantum, Desain Material AI, Pembelajaran Penguatan, Model Bahasa Besar, Infrastruktur AI, Model Multimodal, Agen AI, Masalah NP Kuantum, Jaringan Saraf Grafik Kristal CGformer, Kerangka Pembelajaran Penguatan RLMT, Perhatian Jarang DeepSeek DSA, Kerangka Tugas Visual Terpadu UniVid

🔥 Fokus

GPT-5 menaklukkan “masalah NP kuantum”: Pakar komputasi kuantum Scott Aaronson untuk pertama kalinya menerbitkan makalah yang mengungkapkan peran pendukung terobosan GPT-5 dalam penelitian teori kompleksitas kuantum. GPT-5 membantu memecahkan tahapan deduksi kunci dalam “versi kuantum dari masalah NP” dalam 30 menit, yang biasanya membutuhkan waktu 1-2 minggu bagi manusia. Pencapaian ini menandai bahwa AI telah mulai menyentuh pekerjaan penemuan ilmiah inti kecerdasan manusia, menandakan lompatan besar dalam potensi AI di bidang penelitian ilmiah. (Sumber: arXiv, scottaaronson.blog)

Model desain material AI baru CGformer: Tim Profesor Li Jinjin dan Profesor Huang Fuqiang dari Shanghai Jiao Tong University mengembangkan model desain material AI baru, CGformer. Dengan inovatif menggabungkan mekanisme perhatian global Graphormer dengan CGCNN, serta mengintegrasikan pengkodean sentralitas dan pengkodean spasial, model ini berhasil mengatasi keterbatasan jaringan saraf grafik kristal tradisional. Model ini mampu menangkap informasi global struktur kristal kompleks secara lengkap, secara signifikan meningkatkan akurasi prediksi dan efisiensi penyaringan material baru seperti elektrolit padat ion natrium entropi tinggi. (Sumber: Matter)

Kerangka tugas visual terpadu UniVid: UniVid adalah kerangka inovatif yang memungkinkan Transformer difusi video pra-terlatih untuk beradaptasi dengan berbagai tugas gambar dan video tanpa modifikasi spesifik tugas. Metode ini merepresentasikan tugas sebagai “visual statements”, mendefinisikan tugas dan modalitas keluaran yang diharapkan melalui urutan konteks, menunjukkan potensi besar model generasi video pra-terlatih sebagai dasar terpadu untuk pemodelan visual. (Sumber: HuggingFace Daily Papers)

RLMT merevolusi pasca-pelatihan model besar: Tim Associate Professor Chen Danqi dari Princeton University mengusulkan kerangka “Reinforcement Learning with Model Reward Thinking” (RLMT). Kerangka ini memungkinkan LLM menghasilkan rantai pemikiran yang panjang sebelum merespons, dan menggabungkan model penghargaan berbasis preferensi untuk optimasi RL online. Metode ini secara signifikan meningkatkan kemampuan penalaran dan generalisasi LLM dalam tugas-tugas terbuka, bahkan membuat model 8B melampaui GPT-4o dalam obrolan dan penulisan kreatif. (Sumber: arXiv)

Model pengenalan teks historis CHURRO: CHURRO adalah model bahasa visual (VLM) open-source dengan 3 miliar parameter, dirancang khusus untuk pengenalan teks historis dengan akurasi tinggi dan biaya rendah. Model ini dilatih pada dataset CHURRO-DS yang berisi 99.491 halaman dokumen historis dari 22 abad dan 46 bahasa. Kinerjanya melampaui VLM yang ada seperti Gemini 2.5 Pro, secara signifikan meningkatkan efisiensi penelitian dan pelestarian warisan budaya. (Sumber: HuggingFace Daily Papers)

🎯 Tren

Altman memprediksi super-intelijen AI dan fitur Pulse: Sam Altman memprediksi AI akan sepenuhnya melampaui kecerdasan manusia pada tahun 2030, dan menunjukkan kecepatan perkembangan AI yang luar biasa. OpenAI meluncurkan fitur “mode aktif” ChatGPT, Pulse, menandai transisi AI dari respons pasif menjadi berpikir proaktif untuk pengguna. Fitur ini mampu secara aktif memberikan informasi relevan berdasarkan obrolan pengguna, mencapai layanan yang sangat personal, mengisyaratkan bahwa AI akan menjadi outsourcing alam bawah sadar manusia. (Sumber: 36氪, )

Jensen Huang membantah teori gelembung AI dan strategi NVIDIA: Jensen Huang dalam sebuah wawancara membantah teori “kerajaan gelembung AI”, menekankan peran kunci AI dalam ekonomi, dan memprediksi NVIDIA berpotensi menjadi perusahaan pertama dengan kapitalisasi pasar 10 triliun dolar AS. Dia menunjukkan bahwa inferensi AI menyembunyikan permintaan daya komputasi yang sangat besar, dan NVIDIA, melalui desain kolaboratif yang ekstrem, meluncurkan arsitektur baru setiap tahun, serta membuka ekosistem sistem, tidak takut dengan gelombang pengembangan mandiri, bertujuan untuk membentuk sistem ekonomi AI dan mendorong “AI berdaulat” menjadi konsensus baru. (Sumber: 36氪, )

DeepSeek merilis open-source V3.2-Exp dan mekanisme DSA: DeepSeek merilis versi eksperimental V3.2-Exp dengan 685B parameter sebagai open-source, dan secara bersamaan menerbitkan makalah yang merinci mekanisme perhatian jarang barunya (DeepSeek Sparse Attention, DSA). DSA bertujuan untuk mengeksplorasi dan memverifikasi optimasi efisiensi pelatihan dan inferensi dalam skenario konteks panjang, secara signifikan meningkatkan efisiensi pemrosesan konteks panjang sambil mempertahankan kualitas keluaran model. (Sumber: 36氪, HuggingFace)

GLM-4.6 akan segera dirilis: Model GLM-4.6 dari Zhipu AI diperkirakan akan segera dirilis. Situs web Z.ai mereka telah menandai GLM-4.5 sebagai “model flagship generasi sebelumnya”, mengisyaratkan bahwa versi baru mungkin membawa peningkatan dalam hal panjang konteks dan aspek lainnya, menarik perhatian dan ekspektasi komunitas. (Sumber: Reddit r/LocalLLaMA, karminski3)

Strategi AI Apple dan chatbot internal Veritas: Chatbot AI internal Apple dengan nama kode “Veritas” terungkap, berfungsi sebagai sparring partner untuk Siri dan mampu melakukan operasi dalam aplikasi. Meskipun demikian, Apple tetap tidak meluncurkan chatbot tingkat konsumen, berfokus pada integrasi AI tingkat sistem, dan berencana untuk memperdalam integrasi model pihak ketiga melalui mesin jawaban AI dan antarmuka umum MCP, daripada mengembangkan chatbot sendiri. (Sumber: 36氪)

Pertumbuhan pasar AI PC dan hambatan teknologi: Volume pengiriman pasar AI PC diperkirakan akan tumbuh kuat pada tahun 2025-2026, tetapi terutama didorong oleh penghentian dukungan Windows 10 dan siklus penggantian PC, bukan oleh disrupsi teknologi AI. Fungsi AI saat ini sebagian besar merupakan pelengkap PC tradisional, menghadapi tantangan seperti daya komputasi lokal yang tidak memadai, interaksi pasif, dan ekosistem tertutup. Perangkat AI sejati perlu mencapai “daya komputasi lokal sebagai yang utama, komplementer cloud sebagai pendukung” dan persepsi aktif. (Sumber: 36氪)

AI membanjiri pasar perdagangan listrik: AI banyak digunakan di pasar perdagangan listrik. Perusahaan seperti Qingpeng Smart menggunakan model besar deret waktu untuk memprediksi volume pembangkitan listrik tenaga angin dan surya serta permintaan listrik, membantu keputusan perdagangan. Keunggulan AI dalam memproses data besar diharapkan dapat memperbesar keuntungan, tetapi juga dapat menyebabkan kerugian karena model yang belum matang dan kompleksitas pasar. Industri ini masih dalam tahap eksplorasi. (Sumber: 36氪)

Pembaruan model besar Alibaba Tongyi dan layanan AI full-stack: Alibaba Cloud secara besar-besaran meningkatkan sistem AI full-stack di Apsara Conference, merilis 6 model baru termasuk Qwen3-MAX dan Qwen3-Omni, memposisikan diri sebagai “penyedia layanan AI full-stack”. Alibaba Cloud berkomitmen untuk membangun “Android era AI” dan “komputer generasi berikutnya”, menyediakan layanan cloud AI full-stack mulai dari model dasar hingga infrastruktur, untuk menghadapi evolusi AI Agent dari “kemunculan intelijen” menjadi “tindakan otonom”. (Sumber: 36氪)

Analisis mendalam arsitektur NVIDIA Blackwell: Acara analisis mendalam arsitektur NVIDIA Blackwell akan membahas arsitektur, optimasi, dan implementasinya di cloud GPU. Acara ini akan dipandu oleh para ahli dari SemiAnalysis dan NVIDIA, bertujuan untuk mengungkapkan bagaimana Blackwell GPU, sebagai “GPU dekade berikutnya”, akan mendorong pengembangan daya komputasi AI dan masa depan cloud GPU. (Sumber: TheTuringPost)

🧰 Alat

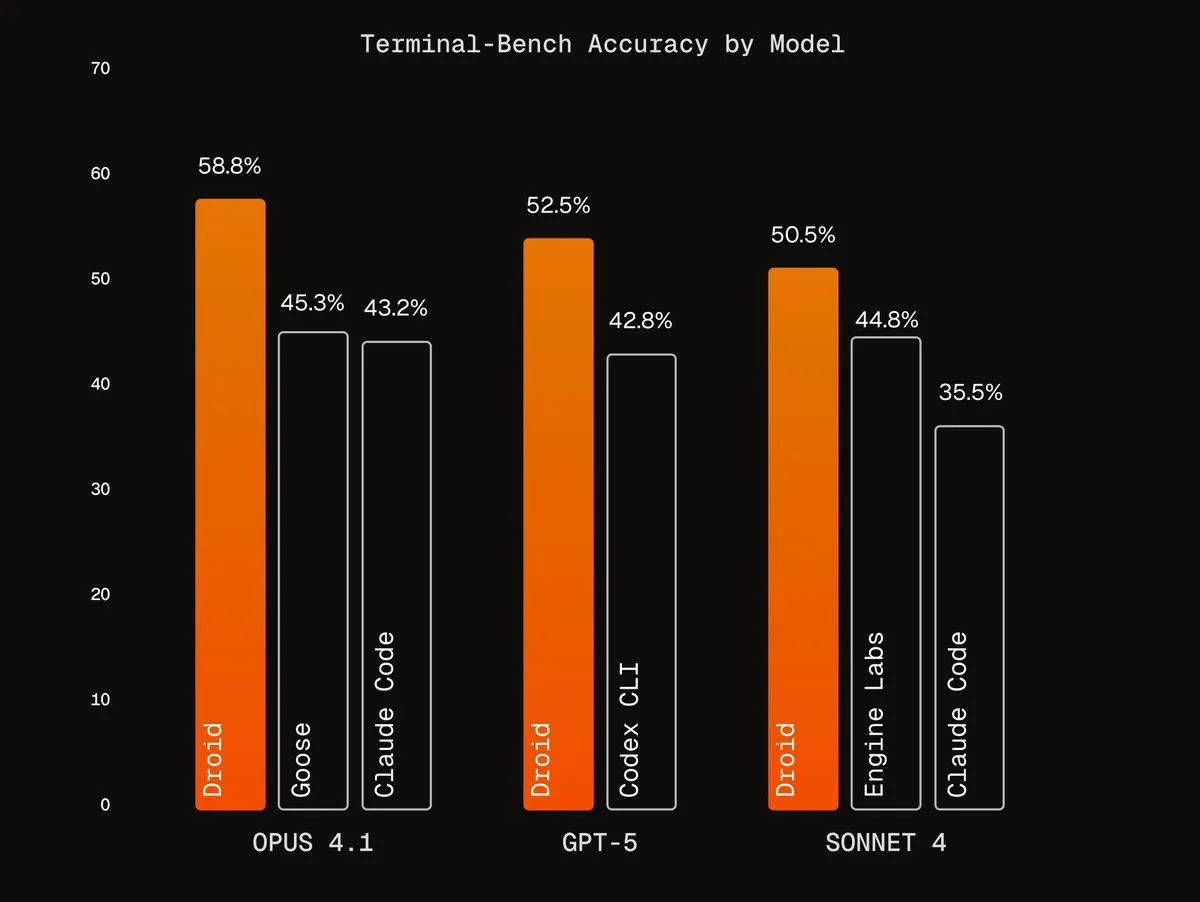

Agentic Harnesses dari Factory AI: Factory AI telah mengembangkan Agentic Harnesses kelas dunia yang secara signifikan meningkatkan kinerja model yang ada, terutama dalam tugas pengkodean, disebut oleh pengguna sebagai “kode curang”. Agen Droids mereka menempati peringkat pertama di Terminal-Bench, dan mencapai refactoring kode yang andal melalui alur kerja verifikasi multi-agen. (Sumber: Vtrivedy10, matanSF, matanSF)

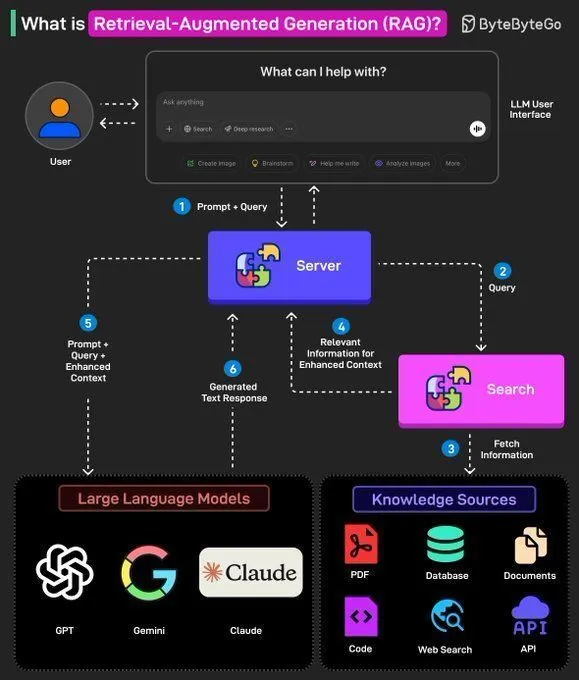

RAGLight, pustaka RAG open-source: LangChainAI merilis RAGLight, pustaka Python ringan untuk membangun sistem RAG tingkat produksi. Pustaka ini dilengkapi dengan pipeline agen berbasis LangGraph, dukungan LLM multi-penyedia, integrasi GitHub bawaan, dan alat CLI, bertujuan untuk menyederhanakan pengembangan dan penerapan sistem RAG. (Sumber: LangChainAI, hwchase17)

Sistem operasi semantik ArgosOS: ArgosOS adalah aplikasi desktop yang memungkinkan pencarian cerdas dan integrasi konten dokumen melalui arsitektur berbasis tag daripada database vektor. Ini menggunakan LLM untuk membuat tag yang relevan dan menyimpannya dalam database SQLite, sehingga secara cerdas memproses kueri, seperti menganalisis tagihan belanja, menyediakan solusi manajemen dokumen yang akurat dan efisien untuk aplikasi skala kecil. (Sumber: Reddit r/MachineLearning)

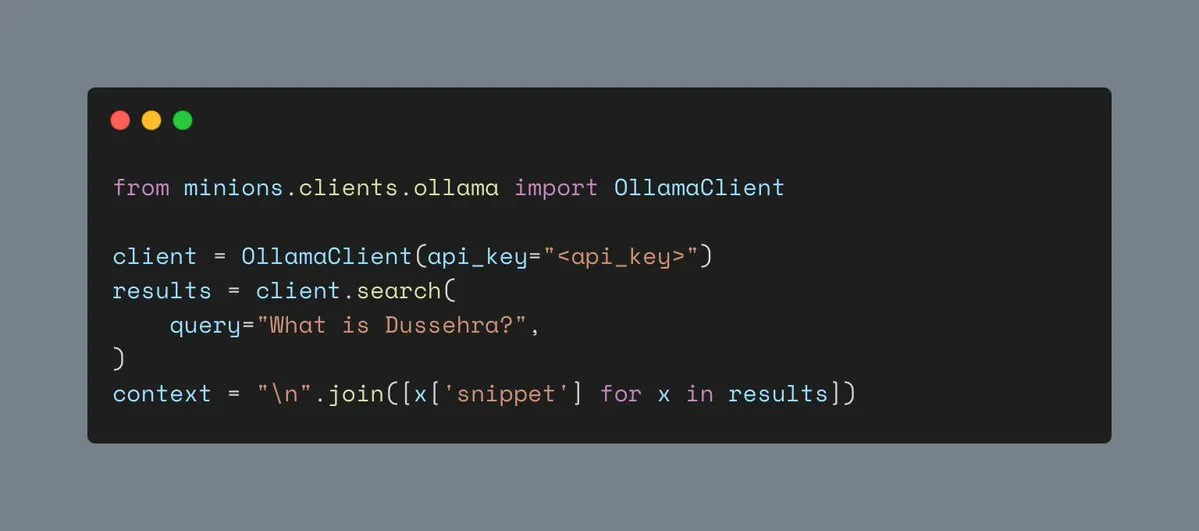

Alat pencarian Web Ollama: Ollama kini mendukung alat pencarian Web, memungkinkan pengguna untuk mengintegrasikan fungsi pencarian Web dalam beban kerja Minions, sehingga memperkaya informasi konteks aplikasi AI dan meningkatkan kemampuannya dalam menangani tugas-tugas kompleks. (Sumber: ollama)

RAG multimodal lokal Hyperlink: Hyperlink menyediakan fungsi RAG multimodal lokal, memungkinkan pengguna untuk mencari dan meringkas tangkapan layar/galeri foto secara offline. Melalui teknologi OCR dan embedding, alat ini dapat mengubah data gambar yang tidak terstruktur menjadi konten yang dapat dicari, mencapai manajemen dokumen dan ekstraksi informasi yang sepenuhnya pribadi dan di perangkat. (Sumber: Reddit r/LocalLLaMA)

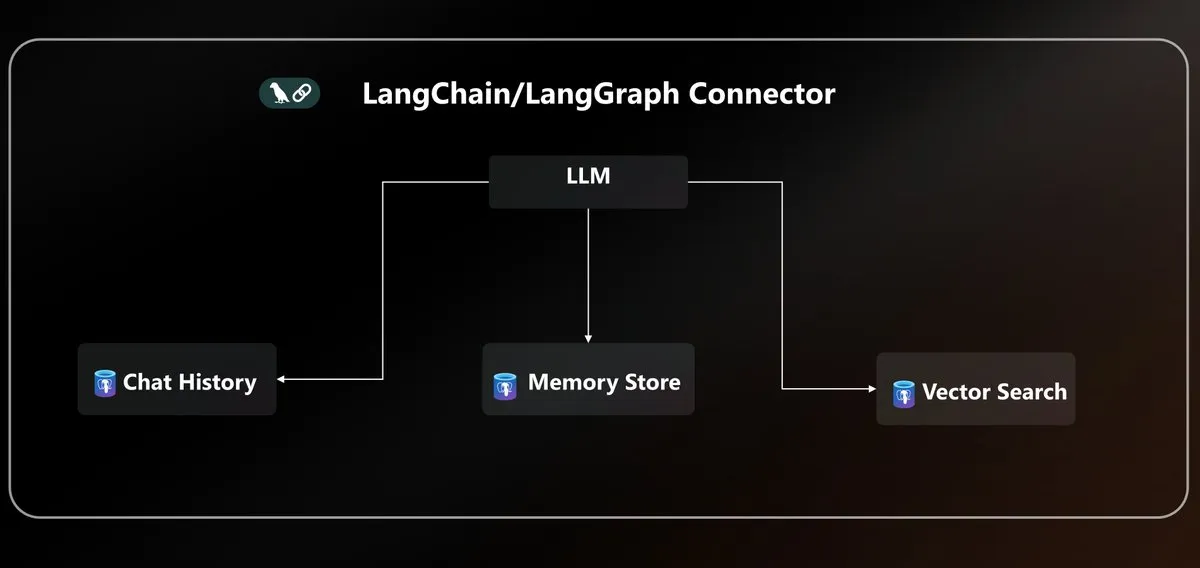

Konektor Azure PostgreSQL LangChain: Microsoft meluncurkan konektor Azure PostgreSQL asli, menyatukan persistensi agen untuk ekosistem LangChain. Konektor ini menyediakan penyimpanan vektor tingkat perusahaan dan manajemen status, menyederhanakan kompleksitas pembangunan dan penerapan agen AI di lingkungan Azure. (Sumber: LangChainAI)

Standardisasi LLM API dan protokol MCP: Komunitas membahas masalah fragmentasi LLM API, menunjukkan bahwa struktur pesan, pola panggilan alat, dan nama bidang inferensi dari penyedia yang berbeda tidak kompatibel, menyerukan standardisasi protokol JSON API di industri. Pada saat yang sama, pengenalan protokol MCP (Model-Client Protocol) juga memicu diskusi tentang dampaknya terhadap pengembangan agen. (Sumber: AAAzzam, charles_irl)

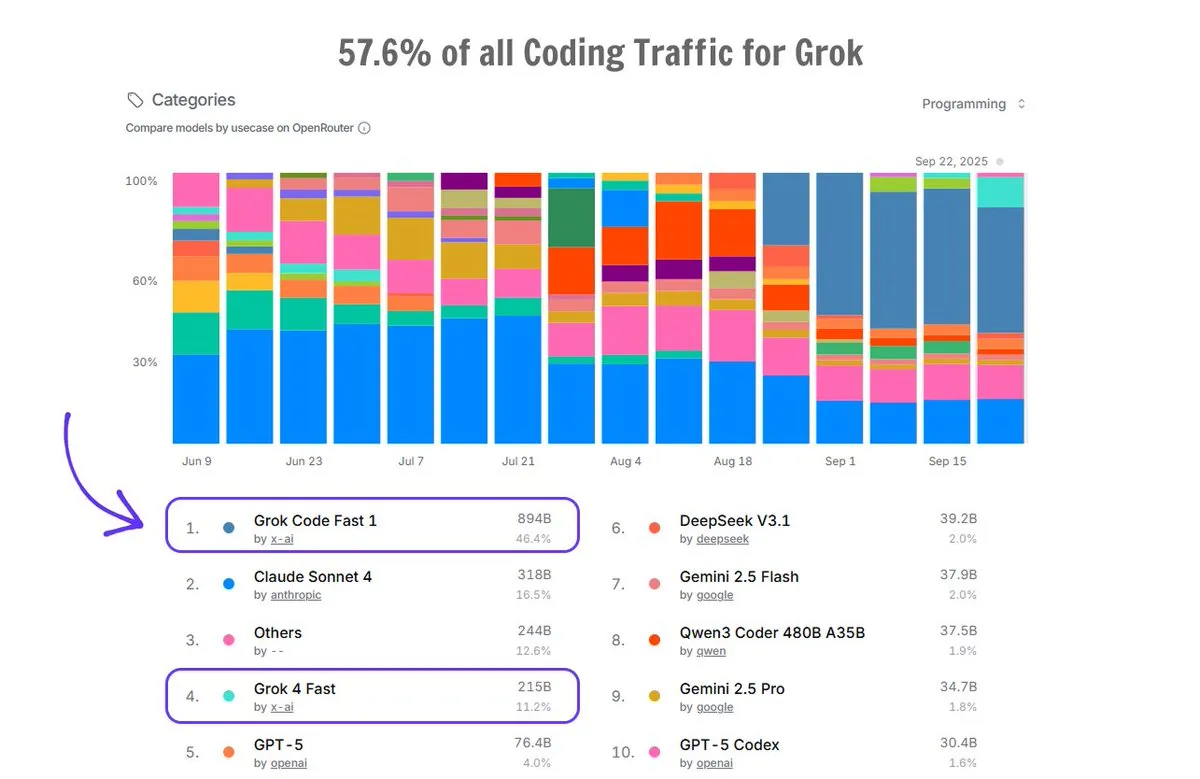

Aplikasi Grok Code di OpenRouter: Grok Code mendominasi 57,6% lalu lintas pengkodean di platform OpenRouter, melebihi total semua generator kode AI lainnya, dengan Grok Code Fast 1 menempati peringkat pertama, menunjukkan kinerja pasar yang kuat dan preferensi pengguna di bidang pembuatan kode. (Sumber: imjaredz)

📚 Belajar

Kursus dasar AI Cursor Learn: Lee Robinson meluncurkan Cursor Learn, seri video gratis enam bagian yang bertujuan untuk membantu pemula menguasai konsep dasar AI seperti tokens, context, dan agents. Kursus ini berdurasi sekitar 1 jam, menyediakan kuis dan uji coba model AI, menjadikannya sumber daya yang nyaman untuk mempelajari dasar-dasar AI. (Sumber: crystalsssup)

Buku gratis struktur data Python: Donald R. Sheehy menerbitkan buku gratis berjudul “A First Course on Data Structures in Python”, yang mencakup struktur data, pemikiran algoritma, analisis kompleksitas, rekursi/pemrograman dinamis, dan metode pencarian, memberikan dasar yang kuat bagi pelajar di bidang AI dan Machine Learning. (Sumber: TheTuringPost)

Model OCR multibahasa dots.ocr: Xiaohongshu Hi Lab merilis dots.ocr, model OCR multibahasa yang kuat, mendukung 100 bahasa, mampu mengurai teks, tabel, rumus, dan tata letak secara end-to-end (output dalam Markdown), dan gratis untuk penggunaan komersial. Model ini berukuran kecil (1.7B VLM) tetapi mencapai kinerja SOTA di OmniDocBench dan dots.ocr-bench. (Sumber: mervenoyann)

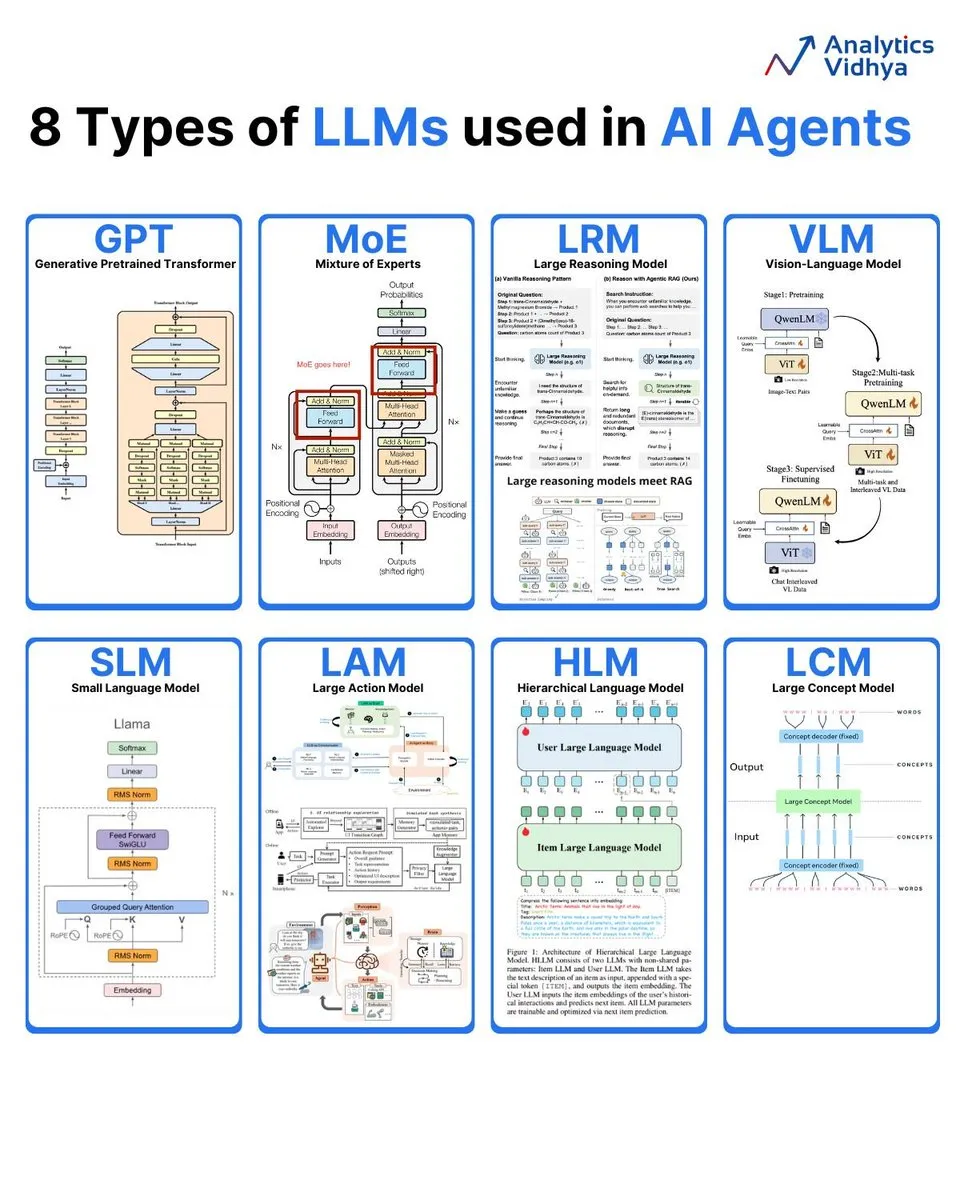

Analisis 8 jenis model bahasa besar: Analytics Vidhya merangkum 8 jenis model bahasa besar utama, termasuk GPT (Generative Pre-trained Transformer), MoE (Mixture of Experts), LRM (Large Reasoning Model), VLM (Visual Language Model), SLM (Small Language Model), LAM (Large Action Model), HLM (Hierarchical Language Model), dan LCM (Large Concept Model), dengan interpretasi rinci tentang arsitektur dan aplikasinya. (Sumber: karminski3)

Laporan mingguan AI: Ringkasan makalah terbaru: DAIR.AI menerbitkan pilihan makalah AI minggu ini (22-28 September), mencakup berbagai penelitian mutakhir seperti ATOKEN, LLM-JEPA, Code World Model, Teaching LLMs to Plan, Agents Research Environments, Language Models that Think, Chat Better, Embodied AI: From LLMs to World Models, memberikan dinamika terbaru bagi peneliti AI. (Sumber: dair_ai)

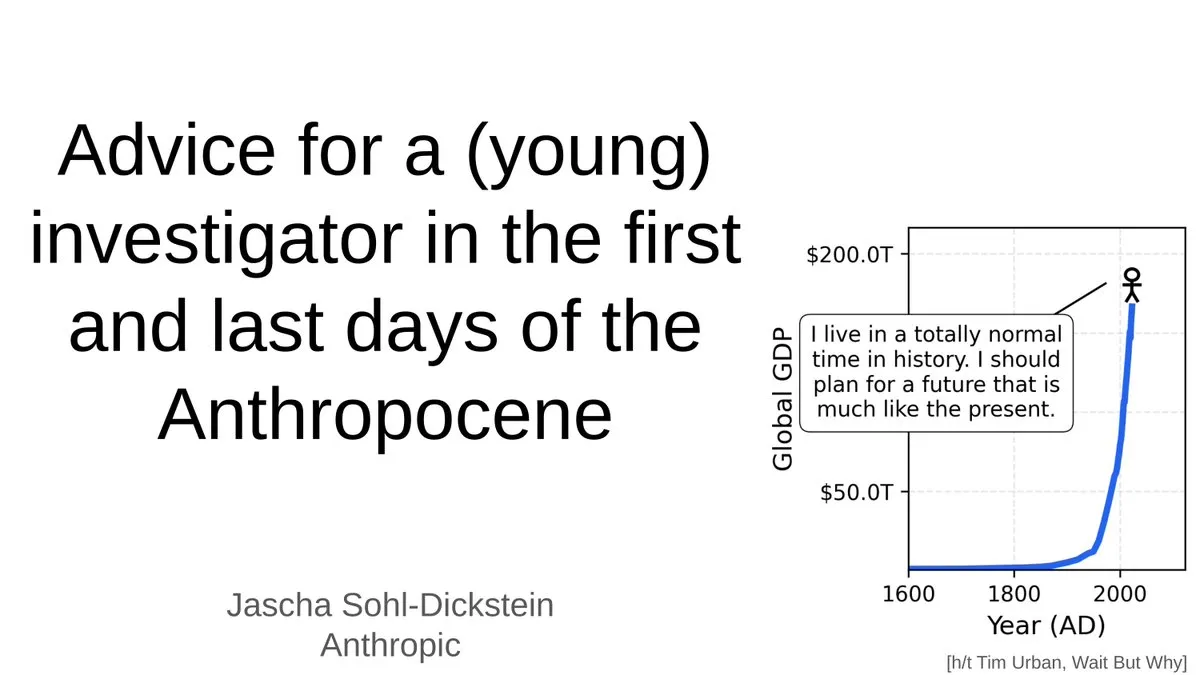

Saran untuk peneliti muda di era AI: Jascha Sohl-Dickstein membagikan saran praktis tentang bagaimana peneliti muda dapat memilih proyek penelitian dan membuat keputusan karir di tahap akhir “Antroposen”. Dia membahas dampak mendalam AGI pada karir akademik dan menekankan perlunya memikirkan kembali arah penelitian dan pengembangan profesional di tengah sistem AI yang akan melampaui kecerdasan manusia. (Sumber: mlpowered)

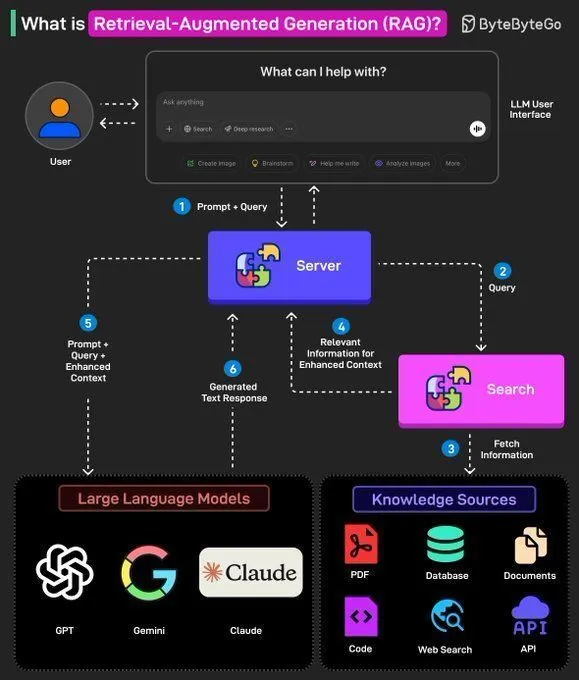

Konsep RAG dan pembangunan AI Agent: Ronald van Loon membagikan konsep dasar RAG (Retrieval-Augmented Generation) dan pentingnya dalam LLM, serta memberikan 8 langkah kunci untuk membangun AI Agent. Konten ini mencakup konsep AI Agent, stack, keunggulan, dan cara mengevaluasinya melalui kerangka kerja, memberikan panduan dari teori hingga praktik bagi pengembang AI. (Sumber: Ronald_vanLoon, Ronald_vanLoon)

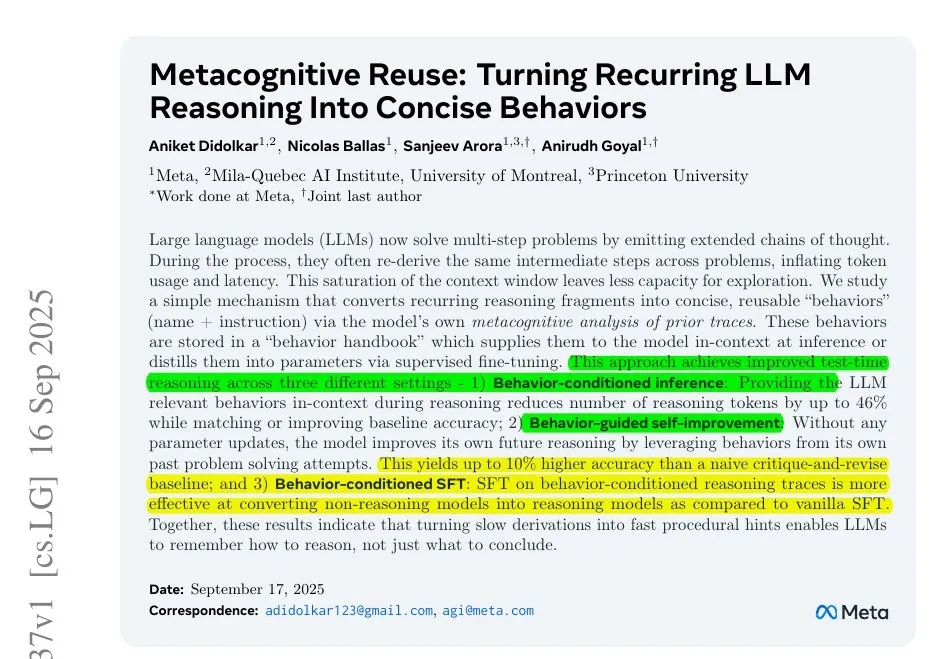

Meta mengatasi masalah inefisiensi inferensi LLM: Penelitian Meta mengungkapkan masalah inefisiensi inferensi LLM yang disebabkan oleh pekerjaan berulang dalam rantai pemikiran yang panjang. Mereka mengusulkan untuk mengompres langkah-langkah berulang menjadi tindakan kecil yang diberi nama, memungkinkan model memanggil tindakan ini daripada menyimpulkan ulang, sehingga mengurangi konsumsi token dan meningkatkan efisiensi serta akurasi inferensi, memberikan ide baru untuk mengoptimalkan proses inferensi LLM. (Sumber: ylecun)

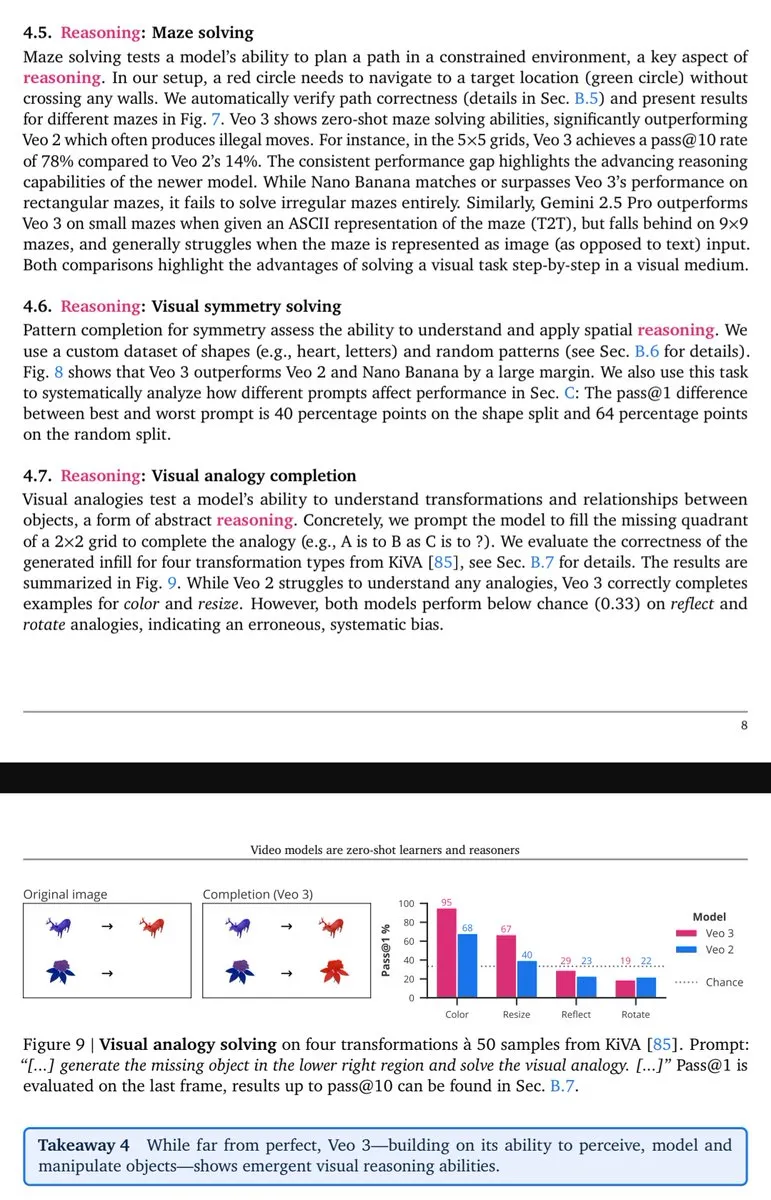

Kemampuan inferensi visual Veo-3 terungkap: Lisan al Gaib menunjukkan bahwa model video Veo-3 menunjukkan kemampuan penalaran (visual) yang muncul mirip dengan GPT-3, mengisyaratkan bahwa model multimodal asli, setelah sepenuhnya memanfaatkan potensinya, akan membawa pemahaman visual dan manfaat penalaran yang lebih komprehensif. (Sumber: scaling01)

💼 Bisnis

Taruhan ratusan miliar OpenAI dan gelembung infrastruktur AI: OpenAI sedang membangun jaringan raksasa yang mencakup chip, komputasi awan, dan pusat data dengan kecepatan pembakaran uang, termasuk investasi 100 miliar dolar AS dari Nvidia dan kemitraan “Stargate” 300 miliar dolar AS dengan Oracle. Meskipun pendapatan tahun 2025 diperkirakan hanya 13 miliar dolar AS, manajemen OpenAI percaya bahwa investasi infrastruktur AI adalah “peluang sekali dalam seabad”, memicu kontroversi apakah infrastruktur AI menghadapi gelembung internet. (Sumber: 36氪)

Elon Musk menggugat OpenAI untuk keenam kalinya: Perusahaan xAI milik Elon Musk menggugat OpenAI untuk keenam kalinya, menuduh mereka secara sistematis merekrut karyawan, mencuri kode sumber model besar Grok secara ilegal, dan rencana strategis pusat data serta rahasia dagang lainnya. Gugatan ini menandai persaingan antara dua raksasa AI yang memanas. Musk percaya OpenAI telah menyimpang dari tujuan nirlabanya, sementara OpenAI membantah tuduhan tersebut, menyebutnya sebagai “pelecehan berkelanjutan”. (Sumber: 36氪)

Ilmuwan AI top Steven Hoi bergabung dengan Alibaba Tongyi: Ilmuwan AI terkemuka dunia, IEEE Fellow Steven Hoi, telah bergabung dengan Alibaba Tongyi Lab, dan akan beralih ke penelitian dasar dan mutakhir model besar multimodal. Steven Hoi memiliki lebih dari 20 tahun pengalaman dalam penelitian, pengembangan, dan industri AI, pernah menjabat sebagai Wakil Presiden Salesforce dan mendirikan HyperAGI. Bergabungnya dia menandai investasi besar Alibaba di bidang model besar multimodal untuk mempercepat efisiensi iterasi model dan terobosan inovasi multimodal. (Sumber: 36氪)

🌟 Komunitas

Penurunan kinerja ChatGPT 4o dan sentimen pengguna: Banyak pengguna ChatGPT melaporkan penurunan kinerja model 4o, dengan masalah “penyusutan” dan “perutean keamanan”, menyebabkan pengguna merasa frustrasi dan tertipu. Banyak pengguna neurodivergen sangat sedih, menganggap 4o pernah menjadi “garis hidup” mereka untuk komunikasi dan pemahaman diri. Pengguna umumnya mempertanyakan kurangnya transparansi OpenAI dan menyerukan agar mereka memenuhi janji “memperlakukan pengguna dewasa” dan menentang mekanisme sensor yang tidak jelas. (Sumber: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Kontroversi pekerjaan dan PHK di era AI: Komunitas ramai membahas dampak AI terhadap pasar kerja, termasuk penurunan signifikan jumlah posisi entry-level, PHK perusahaan yang bersamaan dengan investasi AI, serta keaslian alasan PHK AI. Diskusi menunjukkan tren “orang yang memahami AI menggantikan orang yang tidak memahami AI”, dan menyerukan perusahaan untuk mendesain ulang pekerjaan entry-level daripada sekadar memangkasnya, untuk mengembangkan talenta langka yang sesuai dengan kebutuhan era AI. (Sumber: 36氪, 36氪, Reddit r/artificial)

Tantangan dan ambang batas penelitian LLM: Komunitas ramai membahas ambang batas penelitian Machine Learning yang semakin tinggi, di mana peneliti individu sulit bersaing dengan raksasa teknologi besar. Menghadapi tantangan seperti makalah yang sangat banyak, daya komputasi yang mahal, dan teori matematika yang kompleks, banyak yang merasa sulit untuk memulai dan mencapai terobosan, memicu kekhawatiran tentang keberlanjutan bidang ini. (Sumber: Reddit r/MachineLearning)

Dampak model MoE pada hosting lokal: Komunitas membahas secara mendalam pro dan kontra model MoE untuk hosting LLM lokal. Pandangan menunjukkan bahwa meskipun model MoE membutuhkan lebih banyak VRAM, efisiensi komputasinya tinggi, dan dapat menjalankan model yang lebih besar melalui offloading CPU, terutama cocok untuk perangkat keras konsumen dengan memori yang cukup tetapi GPU terbatas, menjadikannya cara yang efektif untuk meningkatkan kinerja LLM. (Sumber: Reddit r/LocalLLaMA)

Perkembangan pesat dan aplikasi AI Agents: Komunitas membahas perkembangan pesat AI Agents, yang kemampuannya dalam waktu kurang dari setahun telah meningkat pesat dari “hampir tidak dapat digunakan” menjadi “berkinerja baik” dalam skenario sempit, bahkan “General Agent mulai berguna”, kemajuan yang melebihi ekspektasi. Namun, ada juga pandangan yang menganggap Agent pengkodean saat ini sangat homogen dan kurang memiliki perbedaan yang signifikan. (Sumber: nptacek, HamelHusain)

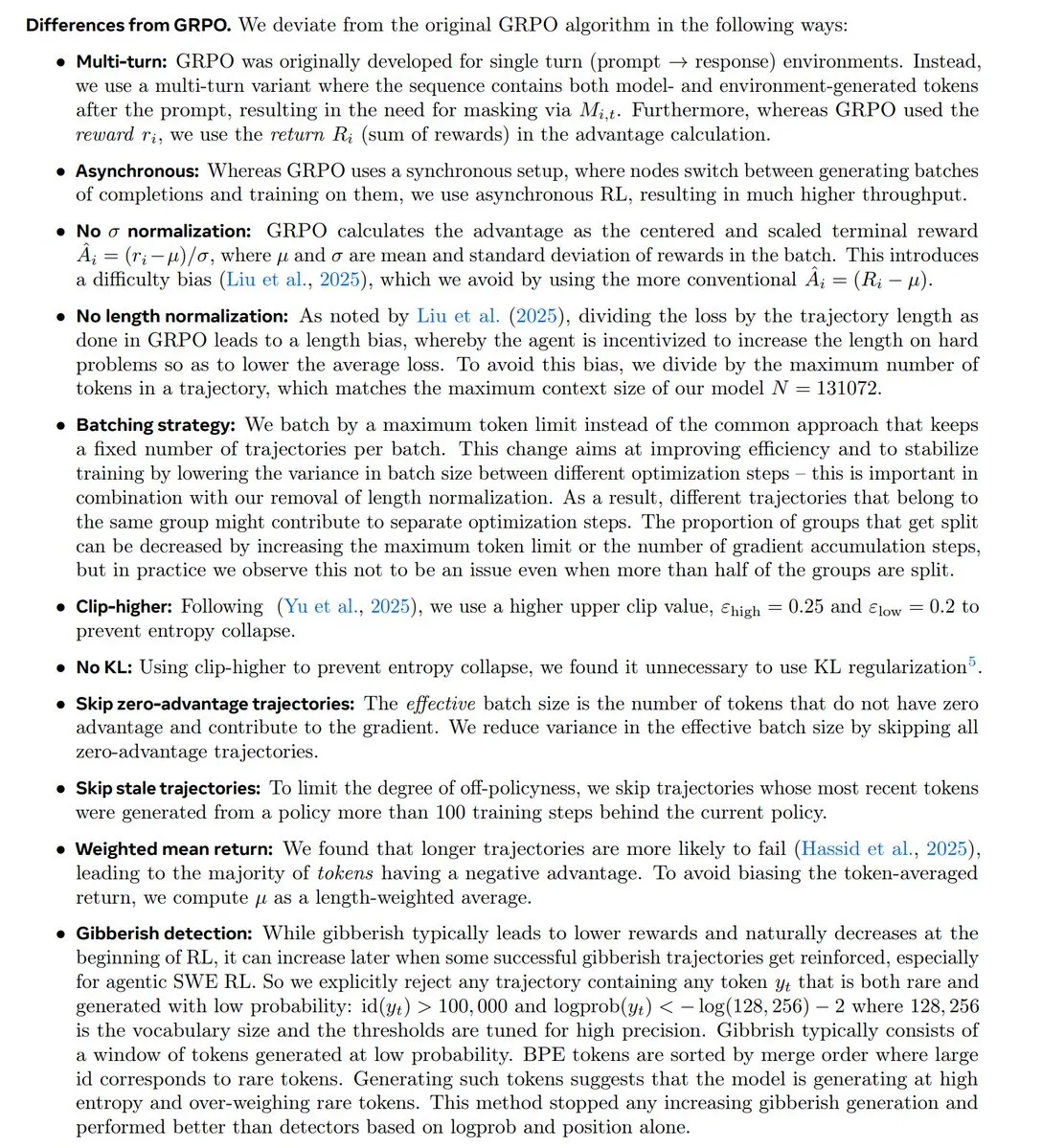

Tren penelitian RL dan kontroversi GRPO: Komunitas membahas secara mendalam tren terbaru dalam penelitian Reinforcement Learning (RL), khususnya status dan kontroversi algoritma GRPO. Beberapa berpendapat bahwa penelitian RL bergeser ke arah pra-pelatihan/pemodelan, dan GRPO adalah kemajuan open-source yang penting, tetapi karyawan OpenAI lainnya berpendapat bahwa itu jauh tertinggal dari teknologi mutakhir, memicu diskusi sengit tentang inovasi algoritma dan kinerja aktual. (Sumber: natolambert, MillionInt, cloneofsimo, jsuarez5341, TheTuringPost)

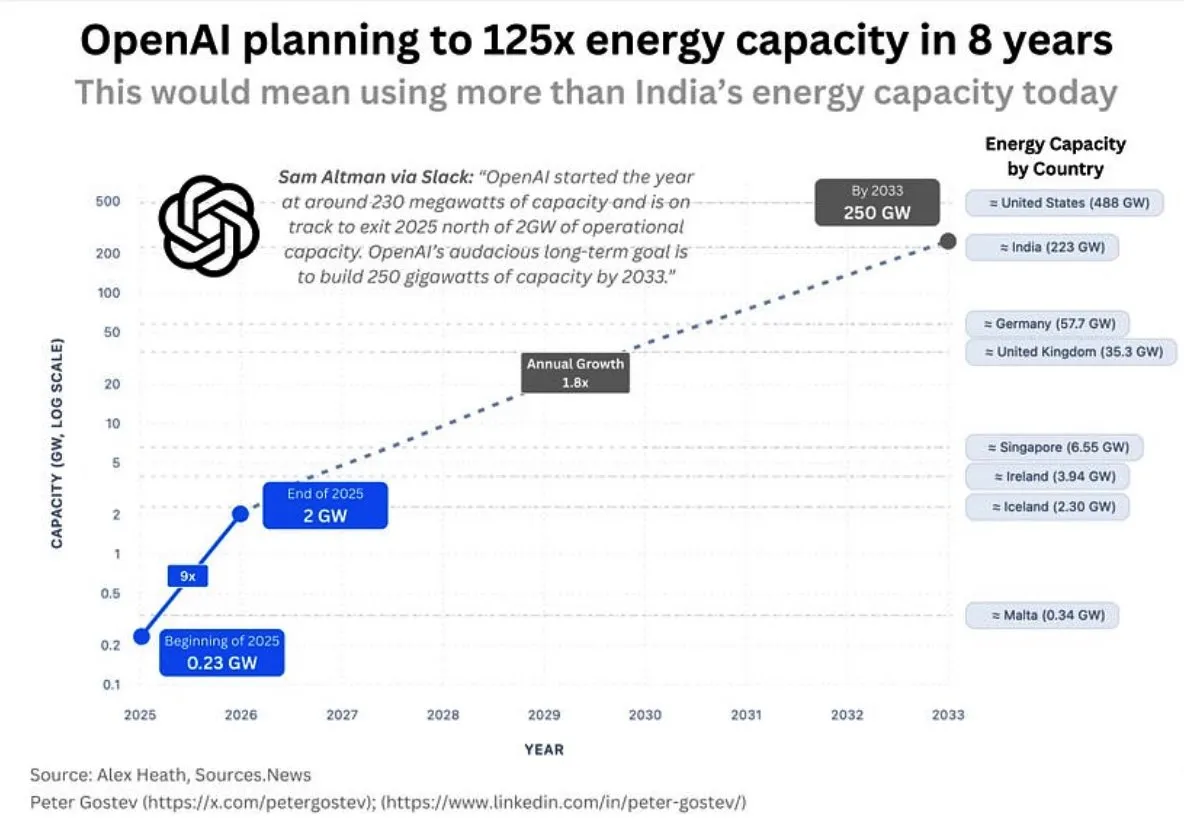

Konsumsi energi OpenAI dan infrastruktur AI: Komunitas membahas kebutuhan energi OpenAI yang sangat besar di masa depan, diperkirakan akan mengonsumsi lebih banyak energi daripada Inggris atau Jerman dalam lima tahun, dan lebih dari India dalam delapan tahun, memicu kekhawatiran tentang skala pembangunan infrastruktur AI, pasokan energi, dan dampak lingkungan. Pada saat yang sama, pemilihan lokasi pusat data Google juga ditentang oleh penduduk setempat karena masalah konsumsi air. (Sumber: teortaxesTex, brickroad7)

Bitter Lesson Sutton dan pengembangan AI: Komunitas membahas “Bitter Lesson” Richard Sutton dan implikasinya terhadap penelitian AI, menekankan bahwa metode komputasi umum lebih unggul daripada pengetahuan a priori manusia. Diskusi berpusat pada hubungan antara “imitasi dan model dunia”, berpendapat bahwa imitasi murni dapat menyebabkan “kultus kargo”, dan imitasi tanpa pengalaman nyata memiliki keterbatasan fundamental. (Sumber: rao2z, jonst0kes)

💡 Lain-lain

Robot bionik BionicWheelBot: Robot BionicWheelBot, dengan meniru gerakan berguling laba-laba roda, mencapai navigasi multifungsi di medan yang kompleks. Inovasi ini menunjukkan potensi penerapan bionik dalam desain robot, memberikan solusi baru bagi robot masa depan untuk menghadapi lingkungan yang berubah-ubah. (Sumber: Ronald_vanLoon)

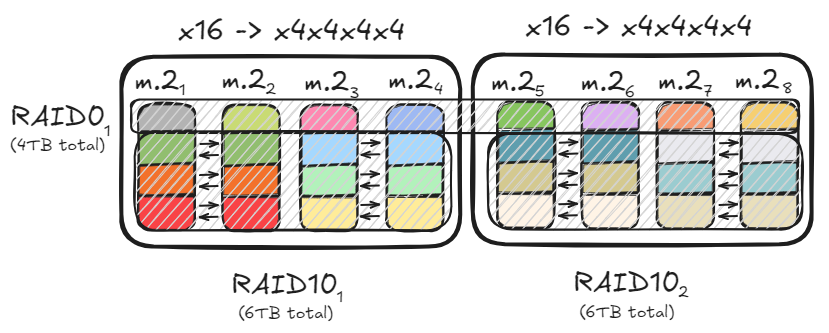

Optimasi penyimpanan PC dan konfigurasi RAID: Pengguna membagikan cara mencapai throughput data hingga 47GB/s melalui konfigurasi RAID0 dan RAID10, menggunakan beberapa saluran PCIe dan hard drive M.2, untuk mempercepat pemuatan model besar. Solusi optimasi ini, sambil memenuhi kebutuhan baca/tulis berkecepatan tinggi, juga mempertimbangkan kapasitas penyimpanan dan redundansi data, menyediakan dasar perangkat keras yang efisien untuk penerapan model AI lokal. (Sumber: TheZachMueller)

Pembukaan “Komunitas Industri AI+ Shuxiwan” Liangzhu: “Komunitas Industri AI+ Shuxiwan” Liangzhu, Hangzhou, resmi dibuka, berfokus pada bidang-bidang mutakhir seperti kecerdasan buatan, ekonomi nomaden digital, dan kreativitas budaya. Komunitas ini, melalui kebijakan khusus “Delapan Butir Shuxi” dan tata letak ruang “Empat Lapangan”, memberikan dukungan siklus penuh bagi penjelajah AI, mulai dari ide awal hingga kepemimpinan ekosistem, bertujuan untuk menciptakan ekosistem inovasi di mana teknologi dan humaniora terintegrasi secara mendalam. (Sumber: 36氪)