Kata Kunci:Deteksi AI, Gambar pelecehan anak, Gemini Robotics, Model embodied, Diagnosis demensia, Simulasi fisika NVIDIA, Agen AI, Penalaran LLM, Teknologi deteksi konten buatan AI, Model eksekusi aksi Gemini Robotics 1.5, Deteksi 9 jenis demensia dalam sekali scan, Kerangka kerja penalaran terdistribusi NVIDIA Dynamo, Token-Aware Editing meningkatkan realisme model

🔥 Fokus Utama

AI Membantu Deteksi Gambar Pelecehan Anak: Dengan generative AI yang menyebabkan lonjakan 1325% dalam jumlah gambar pelecehan seksual anak, Pusat Kejahatan Siber Departemen Keamanan Dalam Negeri AS sedang menguji coba perangkat lunak AI (dari Hive AI) untuk membedakan konten yang dihasilkan AI dari gambar korban nyata. Langkah ini bertujuan untuk memfokuskan sumber daya investigasi pada kasus korban nyata, memaksimalkan dampak proyek, dan melindungi kelompok rentan, menandai aplikasi kunci AI dalam memerangi kejahatan siber. Alat ini menentukan apakah gambar dihasilkan AI dengan mengidentifikasi kombinasi piksel tertentu dalam gambar, tanpa perlu dilatih untuk konten spesifik. (Sumber: MIT Technology Review)

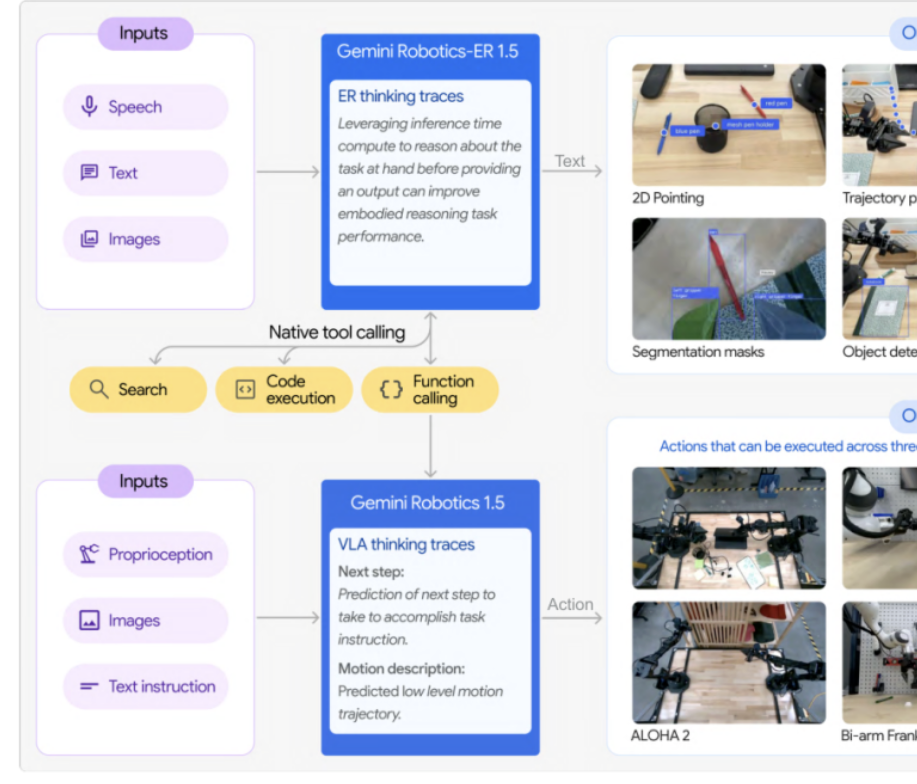

Google DeepMind Meluncurkan Seri Model Embodied Gemini Robotics 1.5: Google DeepMind meluncurkan seri model embodied Gemini Robotics 1.5, model embodied pertama yang memiliki kemampuan penalaran simulasi. Seri ini mencakup model eksekusi tindakan GR 1.5 dan model penalaran yang diperkuat GR-ER 1.5, mewujudkan robot untuk “berpikir dulu, baru bertindak”. Melalui mekanisme “Motion Transfer”, model dapat mentransfer keterampilan zero-shot ke berbagai platform perangkat keras, mematahkan model tradisional “satu mesin, satu pelatihan”, dan mendorong pengembangan robot umum. GR-ER 1.5 melampaui GPT-5 dan Gemini 2.5 Flash dalam benchmark seperti penalaran spasial dan perencanaan tugas, menunjukkan pemahaman dunia fisik yang kuat dan kemampuan memecahkan tugas kompleks. (Sumber: 量子位)

Alat AI Dapat Mendeteksi 9 Jenis Demensia dari Satu Pemindaian: Sebuah alat AI mampu mendeteksi 9 jenis demensia yang berbeda dari satu pemindaian dengan akurasi diagnostik 88%. Teknologi ini diharapkan dapat merevolusi cara diagnosis demensia dini, dengan menyediakan skrining yang cepat dan akurat, membantu pasien mendapatkan perawatan dan dukungan lebih awal, serta memiliki arti penting bagi bidang kesehatan. (Sumber: Ronald_vanLoon)

NVIDIA Berhasil Mengatasi Masalah Fisika untuk Mencapai Simulasi Realistis: NVIDIA berhasil memecahkan masalah yang telah lama membingungkan komunitas fisika, terobosan ini sangat penting untuk menciptakan simulasi yang sangat realistis. Teknologi ini kemungkinan besar memanfaatkan algoritma AI dan machine learning canggih, akan sangat meningkatkan realisme lingkungan virtual dan akurasi pemodelan ilmiah, serta membawa dampak besar bagi bidang game, produksi film, dan penelitian ilmiah. (Sumber: )

🎯 Tren

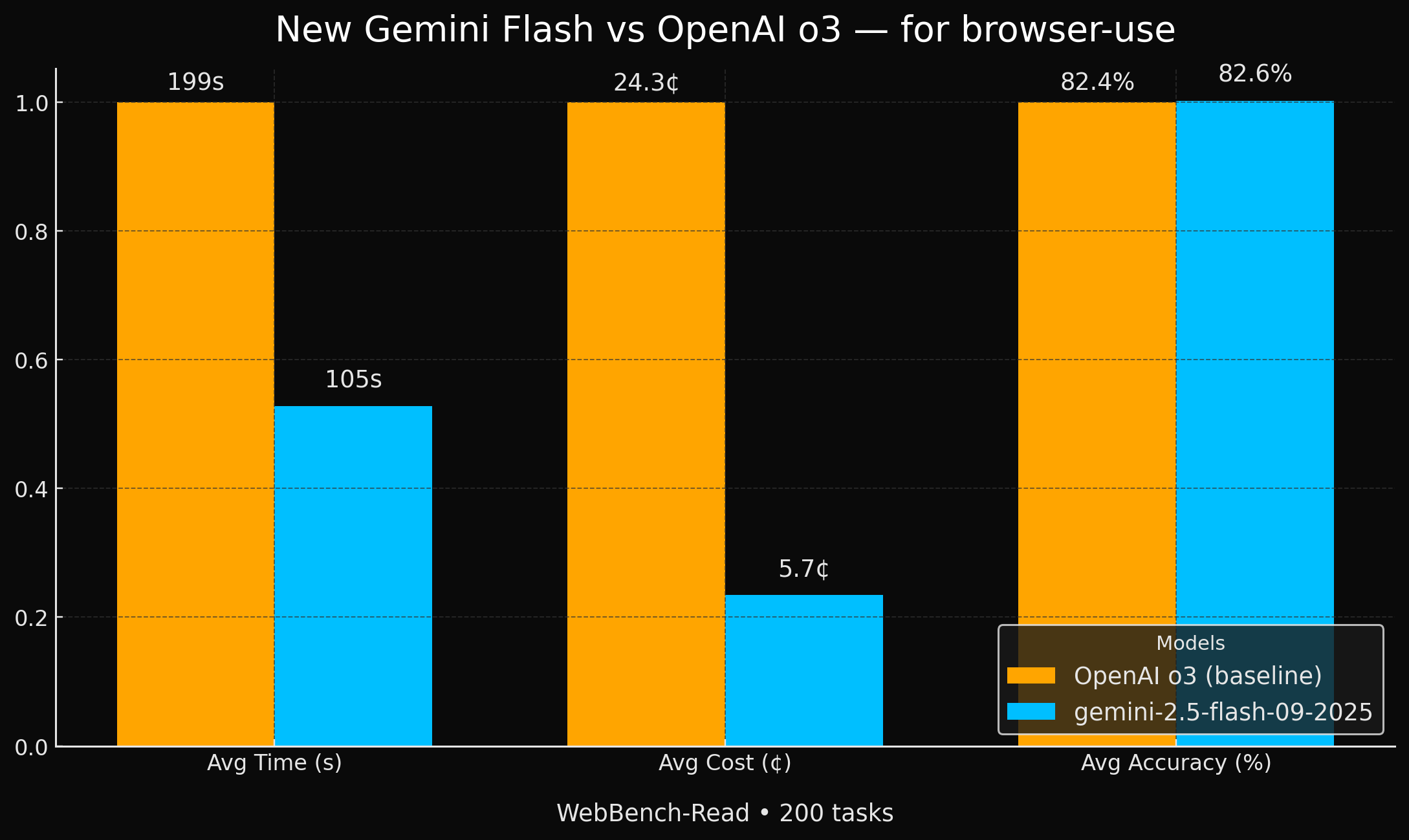

Google Meluncurkan Model Gemini Flash yang Lebih Efisien: Google meluncurkan dua model Gemini 2.5 baru (Flash dan Flash-Lite). Dalam tugas agen browser, keduanya mencapai akurasi yang setara dengan GPT-4o, tetapi 2 kali lebih cepat dan 4 kali lebih murah. Peningkatan kinerja dan efisiensi biaya yang signifikan ini menjadikannya pilihan yang sangat menarik untuk aplikasi AI tertentu, terutama dalam skenario yang membutuhkan efisiensi tinggi dan ekonomis. (Sumber: jeremyphoward, demishassabis, scaling01)

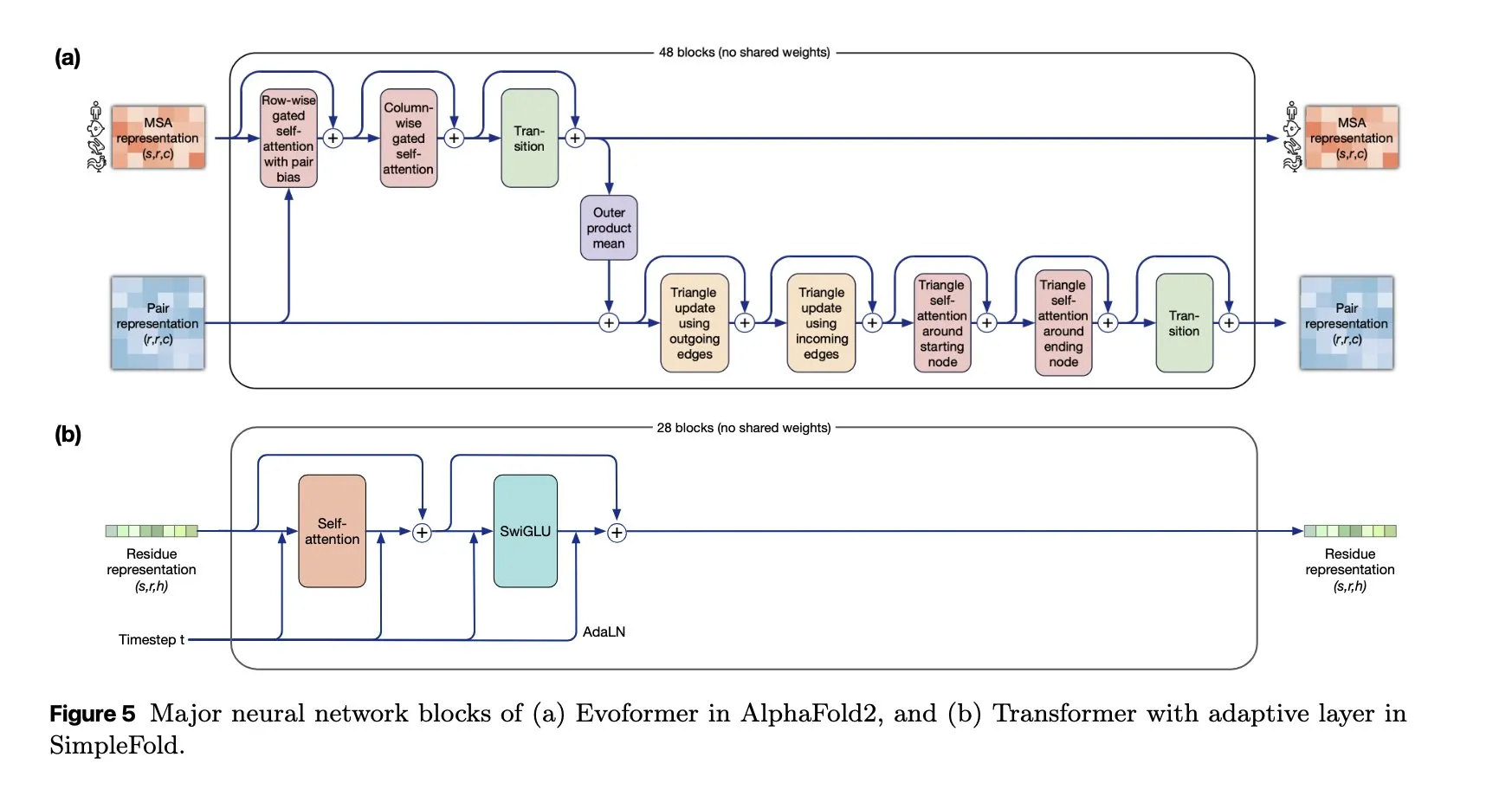

SimpleFold: Model Pelipatan Protein Berbasis Flow Matching: Model SimpleFold pertama kali memperkenalkan metode pelipatan protein berbasis flow matching dan sepenuhnya dibangun menggunakan blok Transformer umum. Inovasi ini menyederhanakan proses pelipatan protein, dibandingkan dengan modul komputasi intensif tradisional, diharapkan dapat meningkatkan efisiensi dan skalabilitas, serta mendorong aplikasi AI di bidang ilmu biologi. (Sumber: jeremyphoward, teortaxesTex)

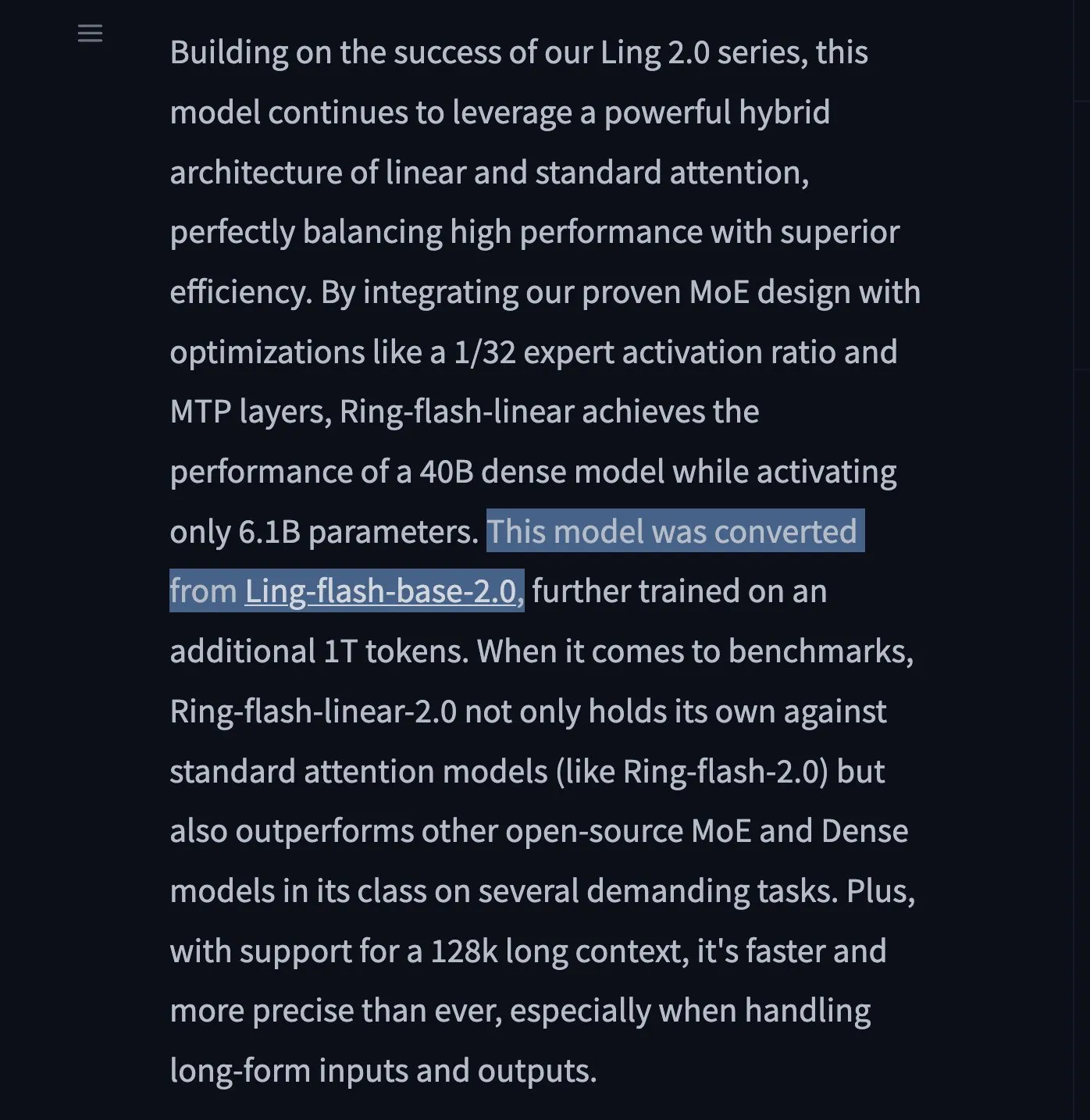

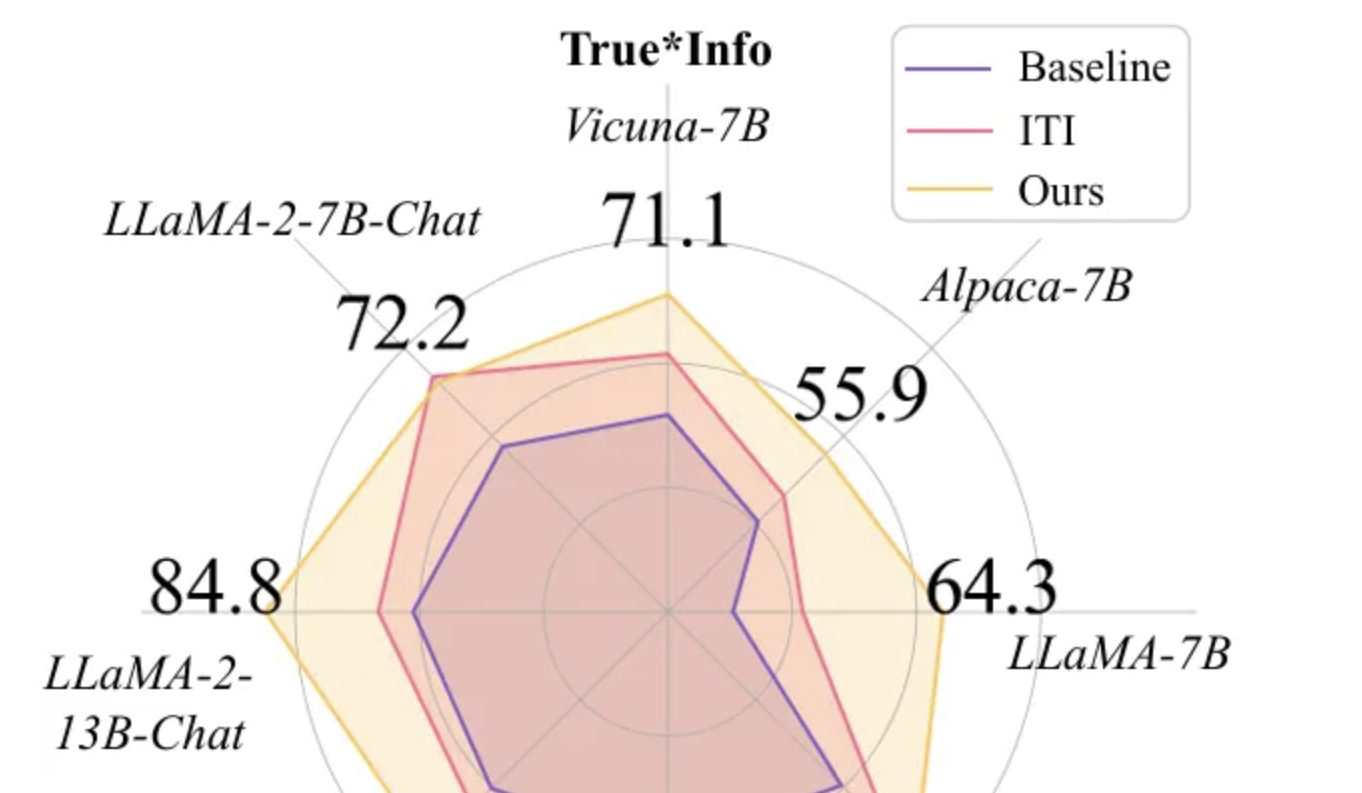

Ring-flash-linear-2.0 dan Ring-mini-linear-2.0 LLM Dirilis: Dua model LLM baru, Ring-flash-linear-2.0 dan Ring-mini-linear-2.0, telah dirilis. Keduanya menggunakan mekanisme perhatian linear hibrida, mencapai kemampuan inferensi super cepat dan canggih. Diklaim, kecepatannya 2 kali lebih cepat dari model MoE dengan skala yang sama, dan 10 kali lebih cepat dari model 32B, menetapkan standar baru untuk inferensi yang efisien. (Sumber: teortaxesTex)

ChatGPT Pulse: Asisten Penelitian Cerdas Seluler: OpenAI meluncurkan ChatGPT Pulse, fitur baru di perangkat seluler yang dapat melakukan penelitian secara asinkron setiap hari berdasarkan percakapan dan memori pengguna sebelumnya, membantu pengguna memahami topik yang diminati secara mendalam. Ini setara dengan mitra pengetahuan pribadi dan layanan berita yang disesuaikan, diharapkan dapat mengubah paradigma perolehan informasi dan pembelajaran. (Sumber: nickaturley, Reddit r/ChatGPT)

Kerangka Kerja UserRL: Melatih Agen AI Interaktif Proaktif: UserRL adalah kerangka kerja baru yang dirancang untuk melatih agen AI yang benar-benar dapat membantu pengguna melalui interaksi proaktif, bukan hanya mengejar skor benchmark statis. Ini menekankan kepraktisan dan adaptabilitas agen dalam skenario nyata, diharapkan dapat mendorong transisi agen AI dari respons pasif menjadi pemecahan masalah proaktif. (Sumber: menhguin)

NVIDIA Terus Berinvestasi di Bidang AI Open-Source: Dalam setahun terakhir, NVIDIA telah menyumbangkan lebih dari 300 model, dataset, dan aplikasi ke Hugging Face, semakin memperkuat posisinya sebagai pemimpin AI open-source di AS. Serangkaian langkah ini tidak hanya mendorong perkembangan komunitas AI, tetapi juga menunjukkan tekad NVIDIA dalam membangun ekosistem perangkat lunak di luar perangkat keras. (Sumber: ClementDelangue)

Sesi Khusus Qwen3 Mengungkap Arah Pengembangan Masa Depan: Alibaba Cloud membagikan rencana masa depan model bahasa besar mereka pada sesi khusus Qwen3: Reinforcement Learning pasca-pelatihan akan memakan lebih dari 50% waktu pelatihan; Qwen3 MoE mencapai leverage parameter aktivasi 5x melalui kerugian load balancing batch global; Qwen3-Next akan mengadopsi arsitektur hibrida yang mencakup perhatian linear dan perhatian bergerbang (gated attention); di masa depan, akan ada unifikasi multimodal penuh, dan akan terus berpegang pada Scaling Law. (Sumber: ZhihuFrontier)

Tim SGLang Merilis Kerangka Kerja Pelatihan RL yang 100% Dapat Direproduksi: Tim SGLang bekerja sama dengan tim slime meluncurkan kerangka kerja pelatihan Reinforcement Learning (RL) stabil open-source pertama yang 100% dapat direproduksi. Kerangka kerja ini, melalui operator perhatian kustom dan logika sampling, menyelesaikan masalah invariansi batch dalam inferensi LLM, memastikan kesesuaian hasil yang sempurna, dan memberikan jaminan yang andal untuk skenario eksperimen yang membutuhkan reproduksi presisi tinggi. (Sumber: 量子位)

Token-Aware Editing (TAE) Meningkatkan Kebenaran Model Bahasa Besar: Tim peneliti Beihang University di EMNLP 2025 mengusulkan metode Token-Aware Editing (TAE), yang meningkatkan metrik kebenaran model bahasa besar pada tugas TruthfulQA sebesar 25.8% melalui pengeditan representasi waktu inferensi yang sadar token, memecahkan SOTA. Metode ini tidak memerlukan pelatihan, bersifat plug-and-play, secara efektif menyelesaikan masalah bias arah dan intensitas pengeditan yang tidak fleksibel pada metode tradisional, dan dapat diterapkan secara luas dalam sistem dialog dan moderasi konten. (Sumber: 量子位)

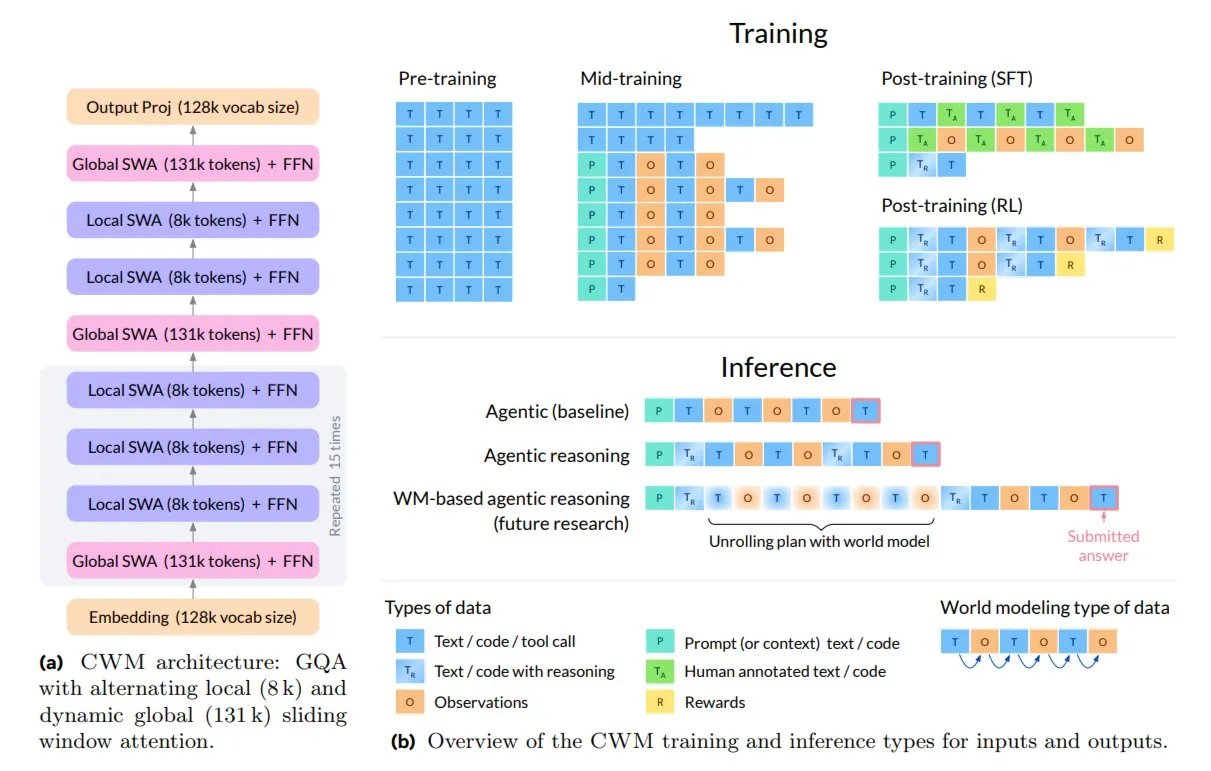

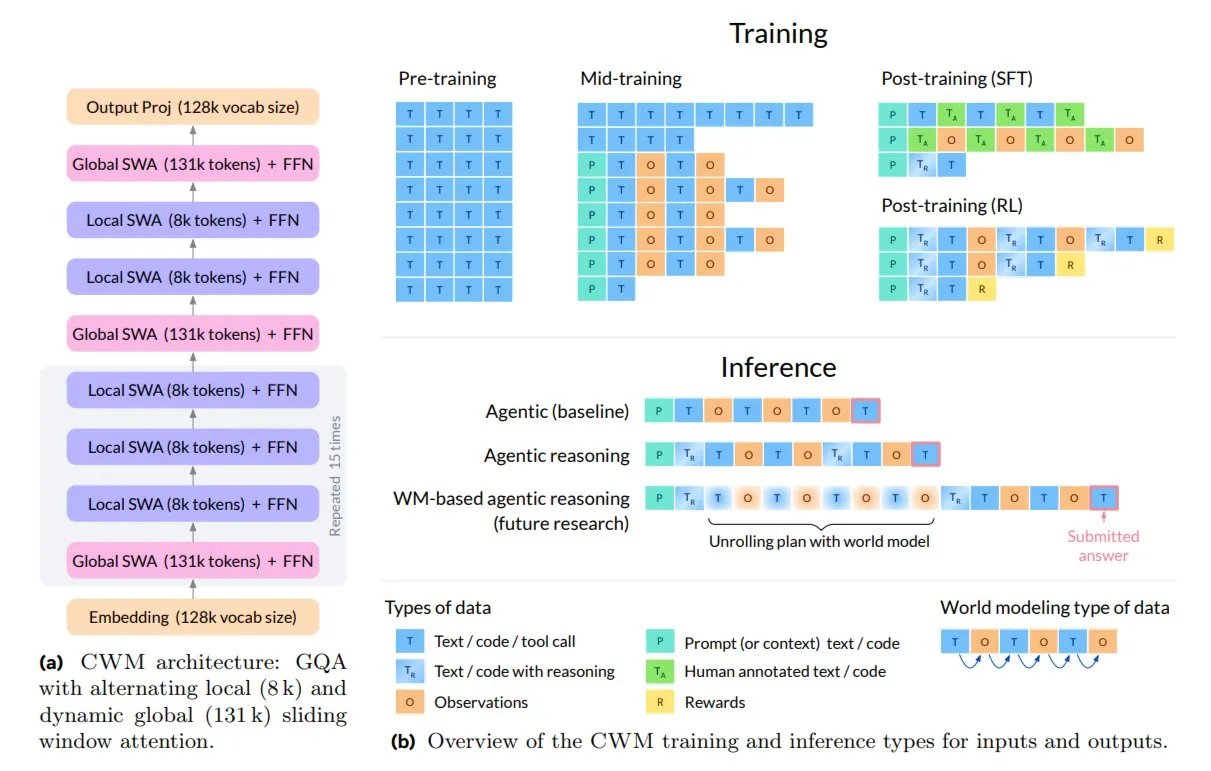

Meta Merilis Code World Model (CWM) untuk Coding dan Inferensi: Meta AI meluncurkan model open-source 32B baru, Code World Model (CWM), yang dirancang khusus untuk coding dan inferensi. CWM tidak hanya mempelajari sintaksis kode, tetapi juga memahami semantik dan proses eksekusinya, mendukung tugas rekayasa perangkat lunak multi-putaran dan konteks panjang. Model ini dilatih melalui jejak eksekusi dan interaksi agen, mewakili pergeseran dari penyelesaian teks otomatis menjadi model yang mampu merencanakan, men-debug, dan memverifikasi kode. (Sumber: TheTuringPost)

🧰 Alat

Peluncuran Produk Replit P1: Replit meluncurkan produk P1-nya, yang mengindikasikan kemajuan baru dalam lingkungan pengembangan AI atau layanan terkait. Replit selalu berkomitmen untuk memberdayakan pengembang melalui AI, dan peluncuran P1 mungkin membawa bantuan coding yang lebih cerdas, fitur kolaborasi, atau kemampuan integrasi baru, yang patut diperhatikan oleh komunitas pengembang. (Sumber: amasad)

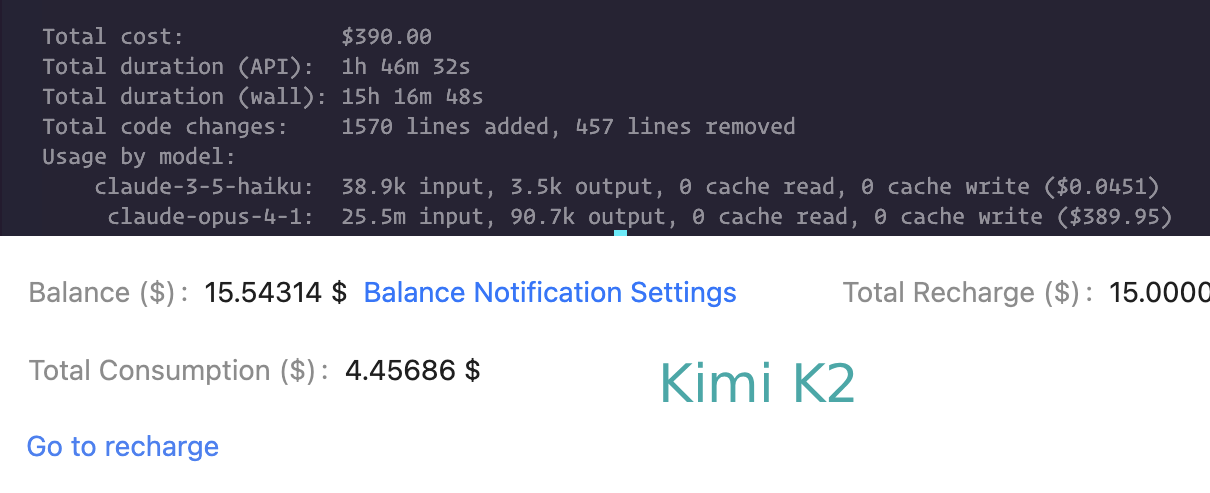

Perbandingan Kemampuan Coding Claude Code dan Kimi K2: Pengguna membandingkan kinerja Claude Code dan Kimi K2 dalam tugas coding. Meskipun Kimi K2 lebih lambat, biayanya lebih rendah, sementara Claude Code (dan Codex) lebih disukai karena kecepatan dan kemampuannya memecahkan masalah kompleks. Ini mencerminkan pertimbangan pengembang antara kinerja dan biaya saat memilih asisten coding LLM. (Sumber: matanSF, Reddit r/ClaudeAI)

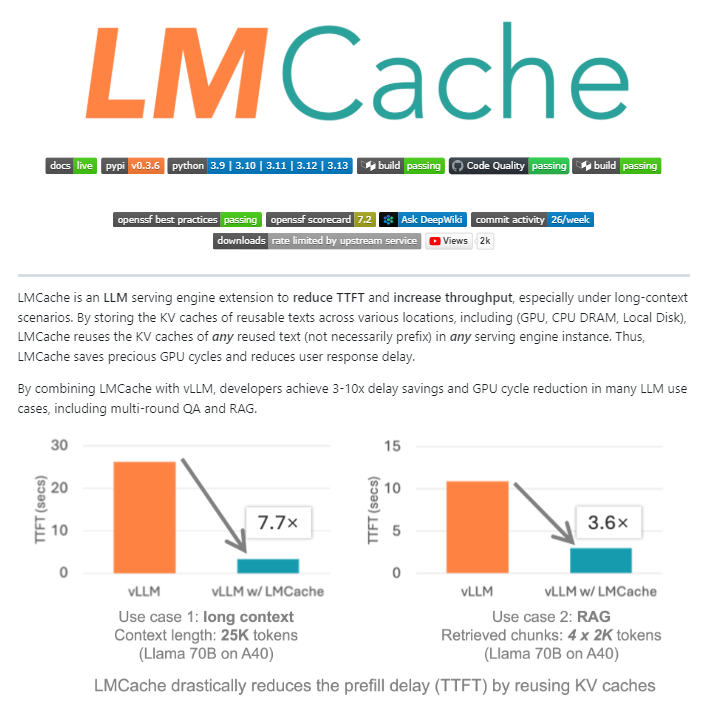

LMCache: Lapisan Cache Open-Source untuk Mesin Layanan LLM: LMCache adalah ekstensi open-source yang berfungsi sebagai lapisan cache untuk mesin layanan LLM. Ini secara signifikan mengoptimalkan inferensi LLM skala besar dengan menggunakan kembali status key-value dari teks sebelumnya antara GPU, CPU, dan disk lokal. Alat ini dapat mengurangi biaya RAG 4-10 kali lipat, mengurangi waktu generasi Token pertama, dan meningkatkan throughput di bawah beban, terutama cocok untuk skenario konteks panjang. (Sumber: TheTuringPost)

Agen Pengembangan Berbasis AI (Paket npm): Sebuah proses agen pengembangan berbasis AI yang matang kini telah dirilis melalui npm, bertujuan untuk menyederhanakan siklus hidup pengembangan perangkat lunak. Agen ini mencakup seluruh proses mulai dari penemuan persyaratan, perencanaan tugas, hingga eksekusi dan peninjauan, diharapkan dapat meningkatkan efisiensi pengembangan dan kualitas kode. (Sumber: mbusigin)

Benchmark Kinerja Inferensi LLM (Qwen3 235B, Kimi K2): Benchmark inferensi offload CPU 4-bit untuk Qwen3 235B dan Kimi K2 pada perangkat keras tertentu menunjukkan bahwa throughput Qwen3 235B sekitar 60 tokens/s, sementara Kimi K2 sekitar 8-9 tokens/s. Data ini memberikan referensi penting bagi pengguna dalam memilih model dan perangkat keras untuk deployment LLM lokal. (Sumber: TheZachMueller)

AI Memori Pribadi: Mengatasi Amnesia Percakapan: Seorang pengguna mengembangkan AI memori pribadi, yang berhasil mengatasi “amnesia percakapan” AI tradisional dengan merujuk pada profil pribadi, basis pengetahuan, dan peristiwa. AI yang disesuaikan ini mampu memberikan pengalaman interaksi yang lebih koheren dan personal, membuka jalan baru bagi aplikasi AI dalam asisten pribadi dan dukungan emosional. (Sumber: Reddit r/artificial)

NVIDIA Dynamo: Kerangka Kerja Layanan Inferensi Terdistribusi Skala Pusat Data: NVIDIA Dynamo adalah kerangka kerja inferensi berkinerja tinggi dan latensi rendah, dirancang khusus untuk melayani generative AI dan model inferensi di lingkungan terdistribusi multi-node. Kerangka kerja ini dibangun menggunakan Rust dan Python, mengoptimalkan efisiensi inferensi dan throughput melalui fitur seperti decoupling layanan dan offload cache KV, serta mendukung berbagai mesin LLM. (Sumber: GitHub Trending)

Model Context Protocol (MCP) TypeScript SDK: MCP TypeScript SDK adalah kit pengembangan resmi yang mengimplementasikan spesifikasi MCP, memungkinkan pengembang membangun server dan klien yang aman dan terstandardisasi untuk mengekspos data (sumber daya) dan fungsionalitas (alat) ke aplikasi LLM. Ini menyediakan cara terpadu untuk manajemen konteks dan integrasi fungsionalitas untuk aplikasi LLM. (Sumber: GitHub Trending)

AI Membantu Generasi Konten 3D Game: Alat AI seperti Hunyuan 3D dari Tencent Cloud dan Tripo dari VAST sedang banyak diadopsi oleh pengembang game untuk pemodelan objek dan karakter 3D dalam game. Teknologi ini secara signifikan meningkatkan efisiensi dan kualitas pembuatan konten 3D, menandakan semakin pentingnya AI dalam alur kerja pengembangan game. (Sumber: 量子位)

HakkoAI: Pendamping Game VLM Real-time: HakkoAI, versi internasional dari Doudou AI Game Companion, adalah pendamping game berbasis Visual Language Model (VLM) real-time yang mampu memahami layar game dan memberikan pendampingan mendalam. Kinerja model ini dalam skenario game melampaui model umum teratas seperti GPT-4o, menunjukkan potensi besar AI dalam pengalaman bermain game yang dipersonalisasi. (Sumber: 量子位)

Terobosan Konsistensi dalam Generasi Video AI: Model Hailuo S2V-01 dari MiniMax AI menyelesaikan masalah inkonsistensi wajah yang telah lama ada dalam generasi video AI, mencapai pemeliharaan identitas. Ini berarti karakter yang dihasilkan AI dapat mempertahankan ekspresi, emosi, dan pencahayaan yang stabil dalam video, membawa pengalaman visual yang lebih nyata dan kredibel untuk influencer virtual, citra merek, dan penceritaan. (Sumber: Ronald_vanLoon)

📚 Pembelajaran

Manifold Modular dalam Optimasi Jaringan Saraf: Penelitian memperkenalkan manifold modular sebagai kemajuan teoretis dalam prinsip desain jaringan saraf dan optimizer. Melalui desain bersama optimizer dengan batasan manifold pada matriks bobot, diharapkan dapat mencapai pelatihan jaringan saraf yang lebih stabil dan berkinerja tinggi. (Sumber: rown, NandoDF)

Interpretasi Metode Model Bahasa “Tanpa Tokenizer”: Sebuah postingan blog membahas secara mendalam metode model bahasa yang disebut “tanpa tokenizer”, dan menjelaskan mengapa sebenarnya tidak tanpa tokenizer, serta mengapa tokenizer sering dikritik dalam komunitas AI. Artikel tersebut menekankan bahwa, bahkan metode “tanpa tokenizer”, juga melibatkan pilihan encoding, dan pilihan-pilihan ini sangat penting untuk kinerja model. (Sumber: YejinChoinka, jxmnop)

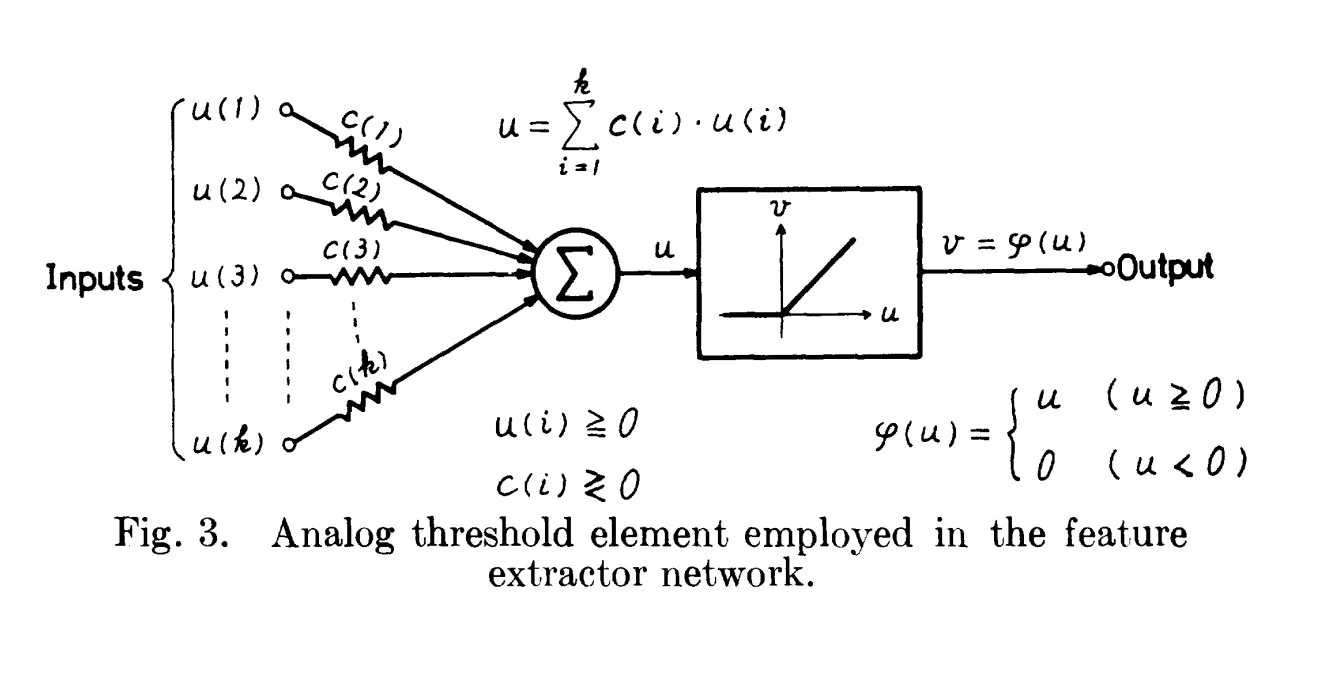

Asal Usul Sejarah ReLU: Kembali ke Tahun 1969: Sebuah diskusi menunjukkan bahwa makalah Fukushima pada tahun 1969 sudah memuat bentuk awal yang jelas dari fungsi aktivasi ReLU, memberikan latar belakang sejarah penting untuk konsep dasar ini dalam deep learning. Ini menunjukkan bahwa dasar dari banyak teknologi AI modern mungkin muncul lebih awal dari yang kita duga. (Sumber: SchmidhuberAI)

Code World Model (CWM) dari Meta: Meta meluncurkan model open-source 32B baru, Code World Model (CWM), untuk coding dan inferensi. CWM dilatih melalui jejak eksekusi dan interaksi agen, bertujuan untuk memahami semantik dan proses eksekusi kode, mewakili pergeseran dari penyelesaian kode sederhana menjadi model cerdas yang mampu merencanakan, men-debug, dan memverifikasi kode. (Sumber: TheTuringPost)

Peran Kunci Data dalam AI: Diskusi komunitas menekankan bahwa di bidang AI, “kita belum cukup membahas data”, menyoroti pentingnya data sebagai fondasi pengembangan AI. Data berkualitas tinggi dan beragam adalah pendorong inti kemampuan dan generalisasi model, pentingnya tidak boleh diremehkan. (Sumber: Dorialexander)

“Super-Weights” dalam Kompresi LLM: Penelitian menemukan bahwa dalam proses kompresi model LLM, mempertahankan sebagian kecil “super-weights” sangat penting untuk menjaga fungsionalitas model dan mencapai kinerja yang kompetitif. Penemuan ini memberikan arah baru untuk mengembangkan model LLM yang lebih efisien, lebih kecil, namun tetap berkinerja tinggi. (Sumber: dl_weekly)

Panduan Arsitektur Agen AI (Melampaui ReAct): Sebuah panduan merinci 6 arsitektur agen AI canggih (termasuk Self-Reflection, Plan-and-Execute, RAISE, Reflexion, LATS). Arsitektur ini dirancang untuk mengatasi keterbatasan pola ReAct dasar, untuk menangani tugas penalaran yang kompleks, dan memberikan cetak biru bagi pengembang untuk membangun agen AI yang lebih kuat. (Sumber: Reddit r/deeplearning)

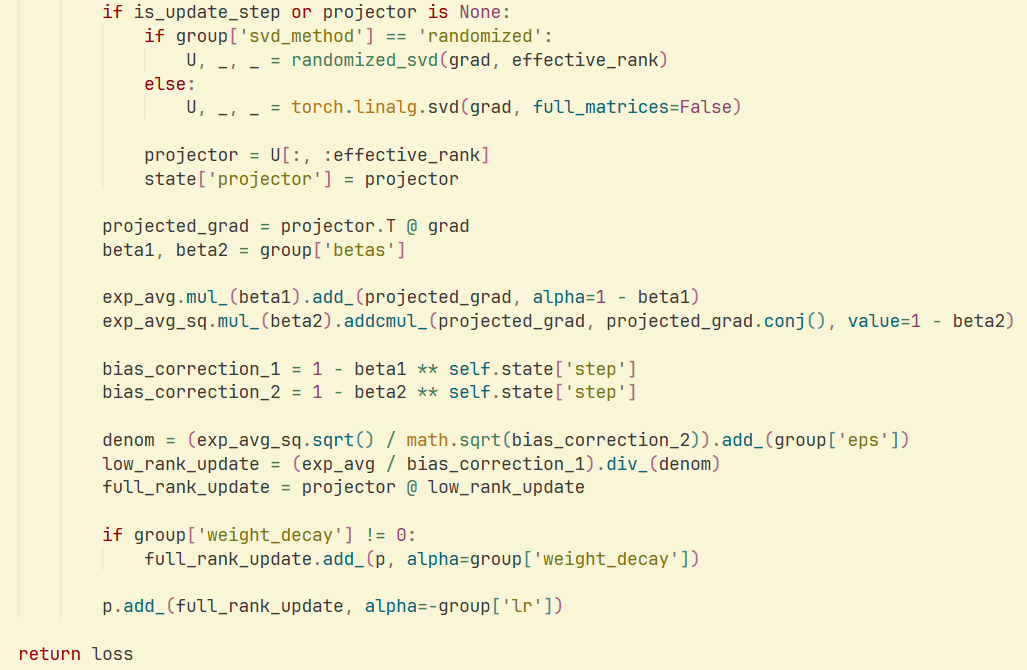

Optimizer GaLore dan Randomized SVD: Sebuah penelitian dan implementasi menunjukkan bahwa menggabungkan Randomized SVD dengan optimizer GaLore dapat mencapai kecepatan lebih tinggi dan efisiensi memori lebih baik dalam pelatihan LLM, secara signifikan mengurangi konsumsi memori optimizer. Ini memberikan strategi optimasi baru untuk pelatihan model skala besar. (Sumber: Reddit r/deeplearning)

💼 Bisnis

Nvidia Mempertimbangkan Model Bisnis Baru untuk Menyewakan Chip AI: Nvidia sedang menjajaki model bisnis baru dengan menawarkan layanan penyewaan chip AI kepada perusahaan yang tidak dapat membelinya secara langsung. Langkah ini bertujuan untuk memperluas akses ke sumber daya komputasi AI dan menjaga pasar tetap aktif, berpotensi memiliki dampak besar pada adopsi infrastruktur AI. (Sumber: teortaxesTex)

Untapped Capital Meluncurkan Dana Kedua, Berfokus pada Investasi AI Tahap Awal: Untapped Capital mengumumkan peluncuran dana kedua mereka, yang berfokus pada investasi pra-seed di bidang AI. Ini menunjukkan minat yang kuat dan berkelanjutan dari komunitas modal ventura terhadap startup AI tahap awal, memberikan dukungan finansial penting bagi teknologi dan perusahaan AI yang sedang berkembang. (Sumber: yoheinakajima)

xAI Menawarkan Model Grok kepada Pemerintah AS: Perusahaan xAI milik Elon Musk mengusulkan untuk menyediakan model Grok mereka kepada pemerintah federal AS dengan harga 42 sen. Langkah yang sangat simbolis ini menandai langkah strategis xAI di bidang kontrak pemerintah, dan berpotensi memengaruhi lanskap aplikasi AI di sektor publik. (Sumber: Reddit r/artificial)

🌟 Komunitas

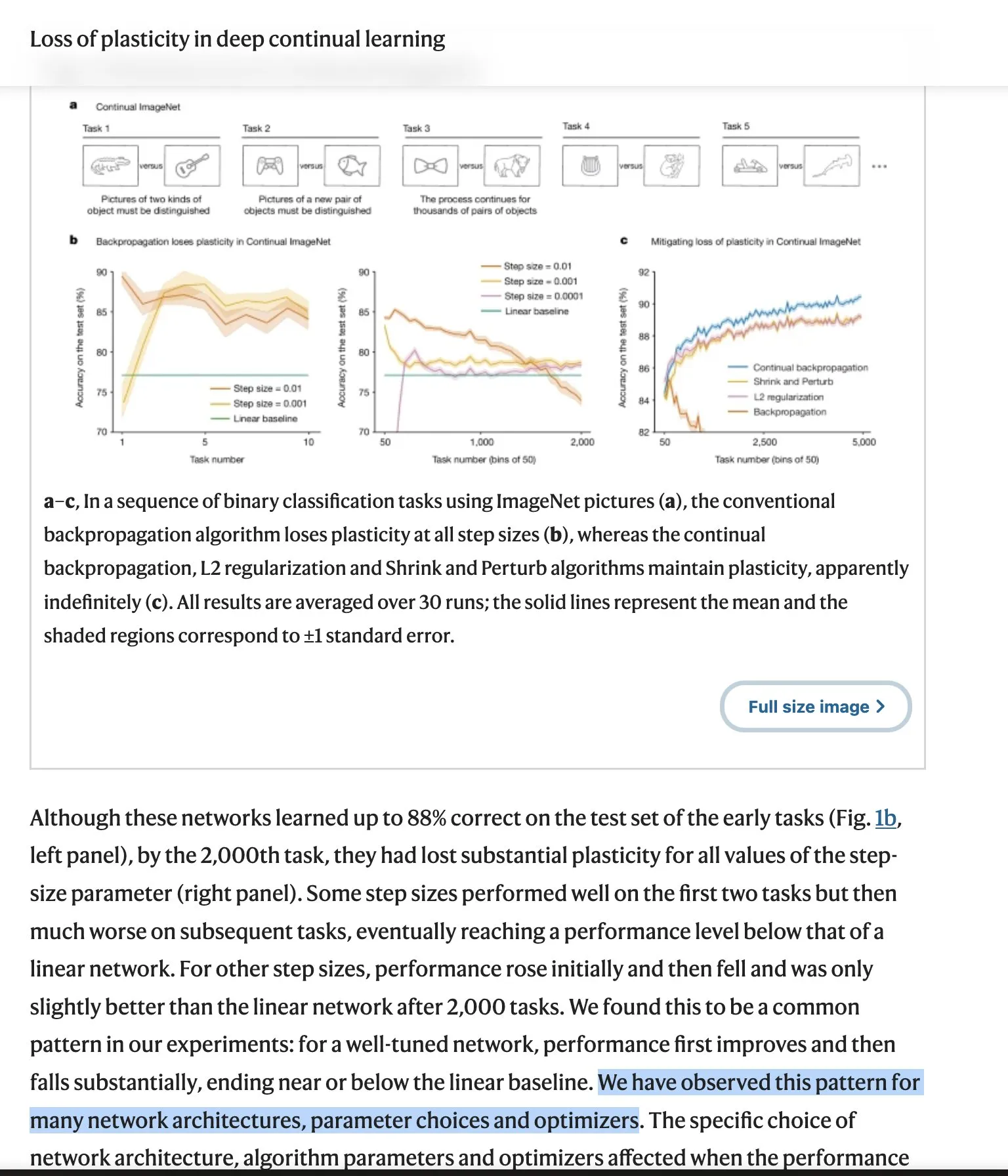

Debat “Bitter Lesson” LLM Terus Memanas: Pandangan “Bitter Lesson” dari Richard Sutton, bapak Reinforcement Learning, memicu perdebatan luas di komunitas. Ia mempertanyakan apakah LLM kekurangan kemampuan belajar berkelanjutan yang sejati dan membutuhkan arsitektur baru. Para penentang menekankan keberhasilan skalabilitas, efektivitas data, dan upaya rekayasa, sementara kritik Sutton menggali lebih dalam aspek filosofis model bahasa-dunia dan intensionalitas. Debat ini mencakup tantangan inti dan arah masa depan pengembangan AI. (Sumber: Teknium1, scaling01, teortaxesTex, Dorialexander, NandoDF, tokenbender, rasbt, dejavucoder, francoisfleuret, natolambert, vikhyatk)

Kekhawatiran Keamanan dan Kontrol AI: Kekhawatiran komunitas terhadap keamanan dan kontrol AI semakin meningkat, mulai dari kekhawatiran pesimis AI tentang AI yang bebas menjelajahi internet, hingga ketakutan akan model AI lokal yang dapat diunduh dan tidak memiliki batasan etika yang mungkin digunakan untuk peretasan dan pembuatan konten berbahaya. Diskusi ini mencerminkan tantangan etika dan sosial yang kompleks yang dibawa oleh perkembangan teknologi AI. (Sumber: jeremyphoward, Reddit r/ArtificialInteligence)

Masalah Routing OpenAI GPT-4o/GPT-5 dan Ketidakpuasan Pengguna: Pengguna ChatGPT Plus secara umum mengeluh bahwa model mereka (4o, 4.5, 5) diam-diam dialihkan ke model “aman” yang “lebih canggung” dan “lebih dingin”, memicu krisis kepercayaan dan laporan tentang kesulitan pembatalan langganan. Meskipun OpenAI secara resmi menyatakan ini bukan “perilaku yang diharapkan”, umpan balik pengguna tetap penuh frustrasi, dan meluas ke kekhawatiran tentang pendamping AI dan sensor konten. (Sumber: Reddit r/ChatGPT, scaling01, MIT Technology Review, Reddit r/ClaudeAI)

Pandangan Richard Sutton tentang Suksesi AI: Pemenang Turing Award, Richard Sutton, berpendapat bahwa suksesi menuju super-intelijen digital adalah “tak terhindarkan”. Ia menunjukkan bahwa manusia kekurangan pandangan yang terpadu, kecerdasan pada akhirnya akan dipahami, dan agen cerdas pasti akan memperoleh sumber daya dan kekuasaan. Pandangan ini memicu diskusi mendalam tentang masa depan pengembangan AI dan nasib umat manusia. (Sumber: Reddit r/ArtificialInteligence, Reddit r/artificial)

Filosofi Produktivitas AI: Peningkatan 10x, Bukan Pulang Lebih Cepat: Diskusi komunitas menekankan bahwa cara yang benar untuk menggunakan AI bukanlah hanya untuk menyelesaikan pekerjaan lebih cepat, tetapi untuk mencapai peningkatan output 10 kali lipat dalam waktu yang sama. Filosofi ini mendorong peningkatan kemampuan pribadi dan pengembangan karier melalui AI, bukan hanya mengejar efisiensi, sehingga menonjol di tempat kerja. (Sumber: cto_junior)

Persepsi Kualitas Model AI dan Humor: Pengguna memuji kreativitas dan selera humor beberapa LLM (seperti GPT-4.5), menganggapnya “menakjubkan” dan “tak tertandingi”. Pada saat yang sama, komunitas juga membahas AI dengan cara yang humoris, seperti lelucon Merriam-Webster tentang peluncuran LLM baru, mencerminkan penetrasi luas LLM dalam budaya. (Sumber: giffmana, suchenzang)

Etika AI: Debat Menyembuhkan Kanker vs. Tujuan AGI: Komunitas membahas masalah etika “apakah menyembuhkan kanker adalah tujuan yang lebih baik daripada mencapai AGI (Artificial General Intelligence)”. Ini mencerminkan debat moral yang luas tentang prioritas pengembangan AI, yaitu, apakah memprioritaskan aplikasi kemanusiaan atau mengejar terobosan kecerdasan yang lebih dalam. (Sumber: iScienceLuvr)

Perbandingan Kemampuan LLM: Kinerja Matematika Claude Opus vs. GPT-5: Pengguna mencatat bahwa Claude 4.1 Opus berkinerja sangat baik dalam tugas nilai ekonomi, tetapi kurang baik dalam matematika tingkat universitas, sementara GPT-5 membuat lompatan signifikan dalam kemampuan matematika. Ini menyoroti keunggulan diferensial LLM yang berbeda dalam kemampuan spesifik. (Sumber: scaling01)

Keamanan Agen AI: Solusi untuk Perintah rm -rf: Seorang pengembang membagikan solusi praktis untuk mengatasi agen AI yang berulang kali menggunakan perintah rm -rf untuk menghapus file penting, yaitu dengan meng-alias perintah rm menjadi trash, sehingga memindahkan file ke tempat sampah daripada menghapusnya secara permanen, secara efektif mencegah kehilangan data yang tidak disengaja. (Sumber: Reddit r/ClaudeAI)

Kekhawatiran Privasi AI dan Penggunaan Data: Perusahaan seperti LinkedIn secara default menggunakan data pengguna untuk pelatihan AI dan mengharuskan pengguna untuk secara aktif memilih keluar. Ini memicu kekhawatiran berkelanjutan tentang privasi data di era AI. Diskusi komunitas menekankan kebutuhan pengguna akan kontrol atas data pribadi mereka dan pentingnya kebijakan data yang transparan. (Sumber: Reddit r/artificial)

💡 Lain-lain

Aplikasi AI dalam Pertanian: Penyemprot Herbisida GUSS: Penyemprot herbisida GUSS, sebagai perangkat otonom, mencapai operasi penyemprotan yang presisi dan efisien dalam pertanian. Ini menunjukkan potensi aplikasi praktis teknologi AI dalam mengoptimalkan proses produksi pertanian, mengurangi pemborosan sumber daya, dan meningkatkan hasil panen. (Sumber: Ronald_vanLoon)

Dampak AI terhadap Pekerjaan Pengembang: Diskusi komunitas menunjukkan bahwa AI tidak menghilangkan pekerjaan pengembang, melainkan menciptakan posisi pengembangan baru dengan meningkatkan efisiensi dan memperluas cakupan pekerjaan. Ini menunjukkan bahwa AI lebih berfungsi sebagai alat pemberdaya daripada pengganti tenaga kerja, mendorong transformasi dan peningkatan pasar kerja. (Sumber: Ronald_vanLoon)

Militer AS Menghadapi Tantangan dalam Menyebarkan Senjata AI: Militer AS menghadapi kesulitan dalam menyebarkan senjata AI, saat ini mengalihkan pekerjaan terkait ke organisasi baru (DAWG) untuk mempercepat program pengadaan drone. Ini mencerminkan kompleksitas yang dihadapi teknologi AI dalam aplikasi militer, termasuk integrasi teknologi, pertimbangan etika, dan tantangan operasional praktis. (Sumber: Reddit r/ArtificialInteligence)