Kata Kunci:LLM-JEPA, Apple Manzano, MediaTek Dimensity 9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, Baidu Qianfan-VL, Kerangka Pelatihan Ruang Embedding, Tokenizer Visual Hibrid, Arsitektur NPU Ganda, Pengujian Tolok Ukur SWE-BENCH PRO, Input Audio Multimodal

🔥 FOKUS

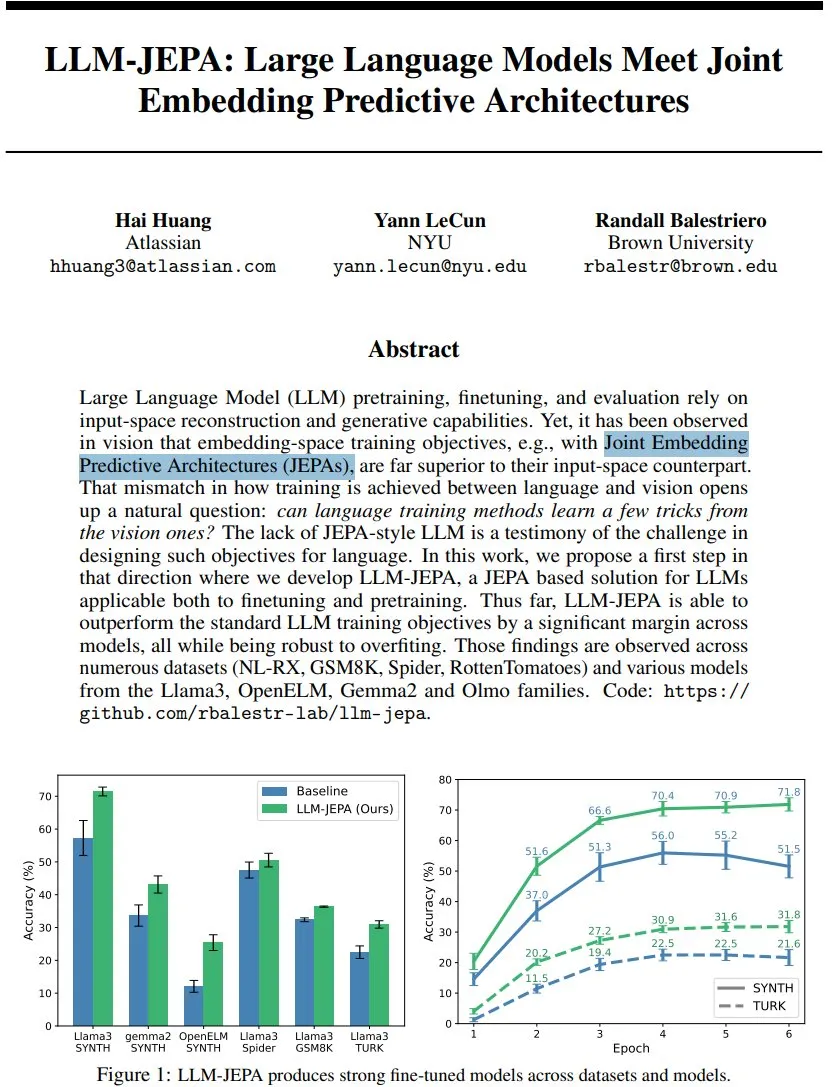

LLM-JEPA: Terobosan Baru dalam Kerangka Pelatihan Model Bahasa : Yann LeCun dan rekan-rekannya memperkenalkan LLM-JEPA, kerangka pelatihan model bahasa bergaya JEPA pertama yang menggabungkan tujuan ruang embedding domain visual dengan tujuan generatif pemrosesan bahasa alami. Kerangka ini melampaui target LLM standar dalam beberapa benchmark seperti NL-RX, GSM8K, dan Spider, serta menunjukkan kinerja yang baik pada model seperti Llama3 dan OpenELM, lebih tangguh terhadap overfitting, serta efektif dalam pre-training dan fine-tuning, menandakan bahwa pelatihan ruang embedding mungkin menjadi lompatan besar berikutnya bagi LLM. (Sumber: ylecun, ylecun)

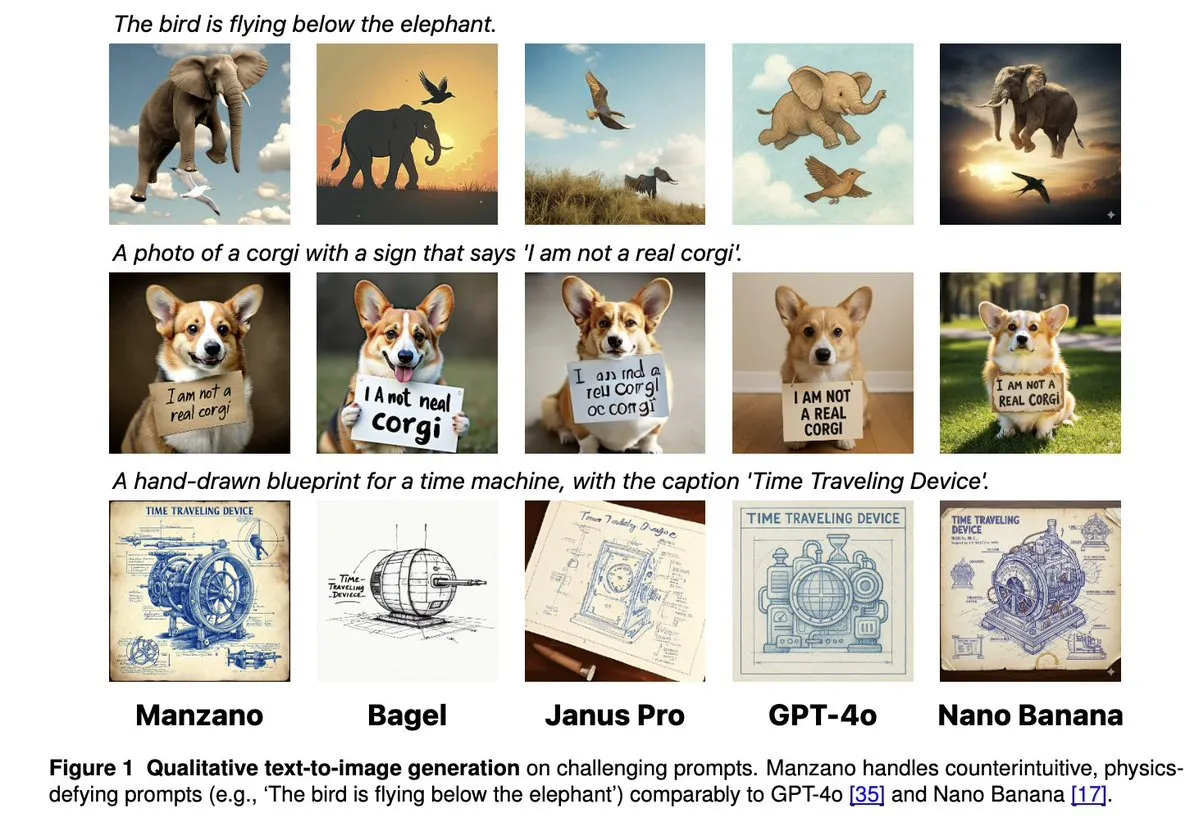

Apple Manzano: Solusi Sederhana dan Skalabel untuk LLM Multimodal Terpadu : Apple merilis Manzano, sebuah model bahasa besar multimodal terpadu yang sederhana dan skalabel. Model ini menggunakan tokenizer visual hibrida, secara efektif mengurangi konflik antara tugas pemahaman dan generasi gambar. Manzano mencapai tingkat SOTA dalam benchmark padat teks (seperti ChartQA, DocVQA) dan bersaing dalam kemampuan generatif dengan GPT-4o/Nano Banana, mendukung pengeditan melalui gambar kondisional, menunjukkan potensi kuat AI multimodal. (Sumber: arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

MediaTek Dimensity 9500 Meluncurkan Arsitektur Dual NPU, Memperkuat Pengalaman AI Aktif : MediaTek meluncurkan chip Dimensity 9500, yang pertama kali menghadirkan arsitektur Dual NPU dengan performa super + efisiensi super, bertujuan untuk mewujudkan pengalaman cerdas “Always on” AI yang selalu aktif. Chip ini mempertahankan posisi teratas dalam daftar AI SoC seluler ETHZ, dengan efisiensi inferensi meningkat 56% dibandingkan generasi sebelumnya, serta mendukung generasi gambar 4K ultra-high-definition di perangkat dan jendela konteks 128K, meletakkan dasar perangkat keras untuk respons real-time dan layanan personalisasi AI seluler, mendorong AI dari “dapat dipanggil” menjadi “online secara default”. (Sumber: 量子位)

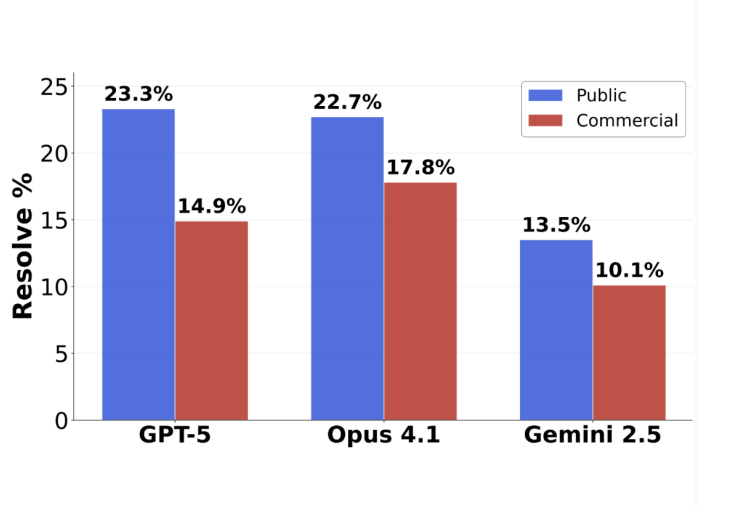

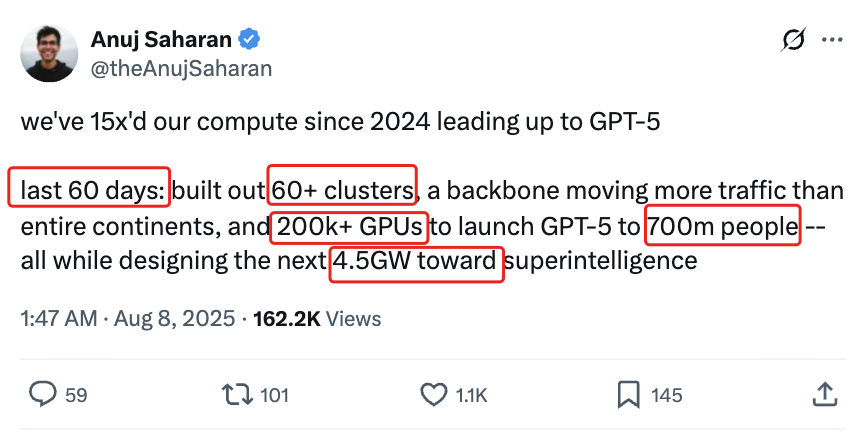

Pembalikan Evaluasi Pemrograman GPT-5: Tingkat Akurasi Tugas yang Diserahkan Mencapai 63.1% : Benchmark rekayasa perangkat lunak baru SWE-BENCH PRO yang dirilis oleh Scale AI menunjukkan bahwa GPT-5 mencapai tingkat akurasi 63.1% pada tugas-tugas yang diserahkan, jauh melampaui 31% dari Claude Opus 4.1, menunjukkan kinerjanya yang masih kuat di bidang yang dikuasainya. Benchmark baru ini menggunakan soal-soal baru dan skenario modifikasi multi-file yang kompleks, menguji kemampuan pemrograman model yang sebenarnya secara lebih realistis, mengungkapkan bahwa model-model teratas saat ini masih menghadapi tantangan dalam tugas rekayasa perangkat lunak tingkat industri, namun kemampuan sebenarnya GPT-5 diremehkan di bawah strategi “jika bisa, serahkan; jika tidak, jangan serahkan”. (Sumber: 36氪)

🎯 ARAH

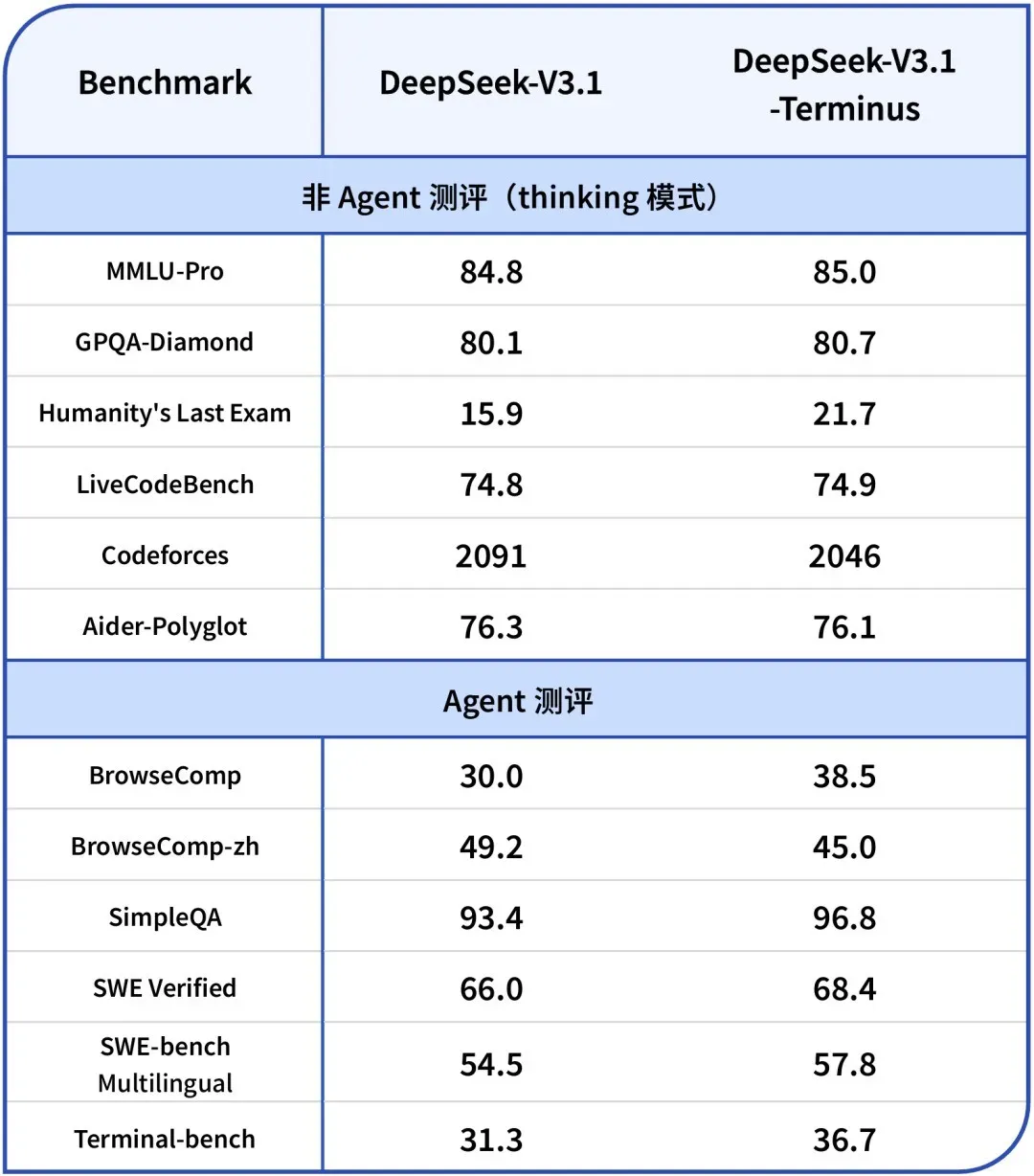

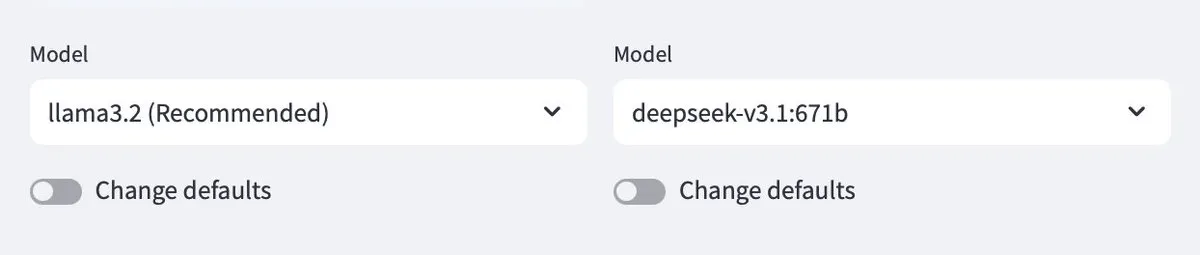

DeepSeek-V3.1-Terminus Dirilis: Mengoptimalkan Konsistensi Bahasa dan Kemampuan Agent : DeepSeek merilis versi V3.1-Terminus, dengan peningkatan utama pada konsistensi bahasa (mengurangi campuran bahasa Mandarin-Inggris dan karakter aneh) serta mengoptimalkan kinerja Code Agent dan Search Agent. Model baru ini menghasilkan output yang lebih stabil dan andal dalam evaluasi multi-domain, dan bobot open-source-nya telah tersedia di Hugging Face dan ModelScope, menandakan penyempurnaan akhir DeepSeek pada arsitektur seri V3. (Sumber: DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

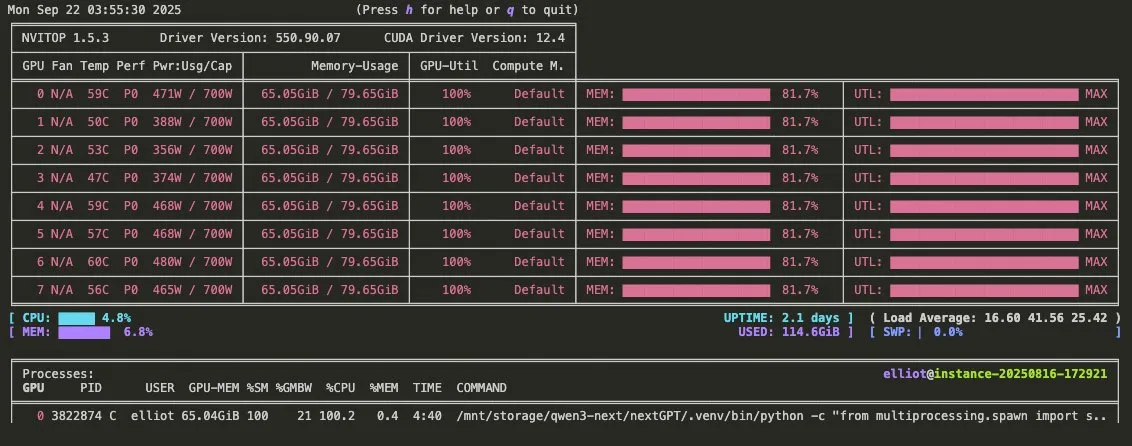

Video Promosi Qwen3-Omni Dirilis: Mendukung Audio Multimodal dan Pemanggilan Alat : Qwen merilis video promosi Qwen3-Omni, mengumumkan dukungannya untuk input dan output audio multimodal, serta kemampuan pemanggilan alat bawaan. Model ini diharapkan menjadi pesaing langsung Gemini 2.5 Flash Native Audio, menawarkan mode berpikir dan non-berpikir, secara signifikan meningkatkan potensi pembangunan Voice Agent, dan bobotnya akan segera dirilis. (Sumber: Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

Baidu Merilis Open-Source Model Bahasa Besar Multimodal Seri Qianfan-VL : Baidu AI Cloud merilis open-source model bahasa besar multimodal seri Qianfan-VL (3B, 8B, 70B), dioptimalkan khusus untuk aplikasi tingkat perusahaan. Model ini menggabungkan encoder visual InternViT dan korpus multibahasa yang ditingkatkan, menawarkan panjang konteks 32K, menunjukkan kinerja luar biasa dalam OCR, pemahaman dokumen, analisis grafik, dan pemecahan masalah matematika, serta mendukung inferensi pemikiran berantai, bertujuan untuk menyediakan kemampuan umum yang kuat dan optimasi mendalam untuk skenario frekuensi tinggi di industri. (Sumber: huggingface, Reddit r/LocalLLaMA)

xAI Merilis Model Grok 4 Fast: Jendela Konteks 2M, Efisiensi Biaya Tinggi : xAI meluncurkan model Grok 4 Fast, sebuah model inferensi multimodal dengan jendela konteks 2M, bertujuan untuk menetapkan standar baru dengan efisiensi biaya tinggi. Versi ini kemungkinan mencapai inferensi cepat melalui teknologi seperti kuantisasi FP8, dan mengoptimalkan kemampuan pemrograman Agentic, sehingga menyeimbangkan kinerja dan efisiensi saat menangani tugas-tugas kompleks. (Sumber: TheRundownAI, Yuhu_ai_)

GPT-5-Codex: OpenAI Meluncurkan Versi GPT-5 yang Dioptimalkan untuk Pemrograman Agentic : OpenAI merilis GPT-5-Codex, sebuah versi GPT-5 yang dioptimalkan khusus untuk pemrograman Agentic. Model ini bertujuan untuk meningkatkan kinerja AI dalam generasi kode dan tugas rekayasa perangkat lunak, sejalan dengan tren pengembangan alur kerja Agentic dan LLM multimodal, serta mendorong lebih lanjut aplikasi AI di bidang pengembangan dengan meningkatkan kemampuan pemrogramannya. (Sumber: TheRundownAI, Reddit r/artificial)

Platform Pengembangan Agen Cerdas Tencent 3.0 Diluncurkan Global, Teknologi Kunci Youtu Lab Terus Open-Source : Platform Pengembangan Agen Cerdas Tencent Cloud 3.0 (ADP3.0) diluncurkan secara global, dengan peningkatan menyeluruh dalam RAG, kolaborasi Multi-Agent, Workflow, evaluasi aplikasi, dan ekosistem plugin. Tencent Youtu Lab akan terus merilis open-source teknologi agen cerdas kunci, termasuk kerangka Youtu-Agent dan kerangka knowledge graph Youtu-GraphRAG, bertujuan untuk mendorong inklusi teknologi dan pembangunan ekosistem agen cerdas yang terbuka, memungkinkan perusahaan membangun, mengintegrasikan, dan mengoperasikan agen AI mereka sendiri dengan hambatan rendah. (Sumber: 量子位)

Baidu Wenku Kembali Raih Sertifikasi dari Pusat Keamanan Industri dan Teknologi Informasi Nasional, Memimpin Industri PPT Cerdas : Baidu Wenku menduduki peringkat pertama dalam evaluasi model besar yang mendukung kantor cerdas oleh Pusat Keamanan Industri dan Teknologi Informasi Nasional, menempati posisi pertama dalam enam indikator termasuk kualitas generasi, pemahaman maksud, dan estetika tata letak. Fungsi PPT cerdasnya menyediakan solusi alur kerja lengkap, dengan lebih dari 97 juta pengguna aktif bulanan AI dan lebih dari 34 juta kunjungan bulanan, terus memperkuat posisi terdepannya di bidang PPT cerdas, memberikan pengalaman pembuatan PPT yang profesional, akurat, dan estetis kepada pengguna. (Sumber: 量子位)

Google DeepMind Meluncurkan Frontier Safety Framework untuk Menghadapi Risiko AI yang Muncul : Google DeepMind merilis “kerangka keamanan frontier” terbarunya, yang merupakan pendekatan paling komprehensif hingga saat ini, bertujuan untuk mengidentifikasi dan mengantisipasi risiko AI yang muncul. Kerangka ini menekankan pengembangan model AI yang bertanggung jawab, berkomitmen untuk memastikan bahwa seiring dengan peningkatan kemampuan AI, langkah-langkah keamanan juga ditingkatkan secara bersamaan untuk menghadapi tantangan kompleks yang mungkin muncul di masa depan. (Sumber: GoogleDeepMind)

Pengembangan Robot Humanoid dan Sistem Otomatisasi: Meningkatkan Interaksi dan Stabilitas : Teknologi robot terus berkembang, termasuk RoboForce yang meluncurkan robot humanoid industri Titan, platform ALLEX dari WIROBOTICS yang mewujudkan interaksi mirip manusia dengan sentuhan, gerakan alami, dan keseimbangan bawaan, serta robot Unitree G1 yang menunjukkan mode “anti-gravitasi” untuk meningkatkan stabilitas. Selain itu, peternakan robot Hitbot menunjukkan sistem pemanenan otomatis, dan robot transportasi bergerak otonom juga menekankan desain kolaborasi manusia-mesin, bersama-sama mendorong transformasi robot dari komputasi menjadi merasakan dunia. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

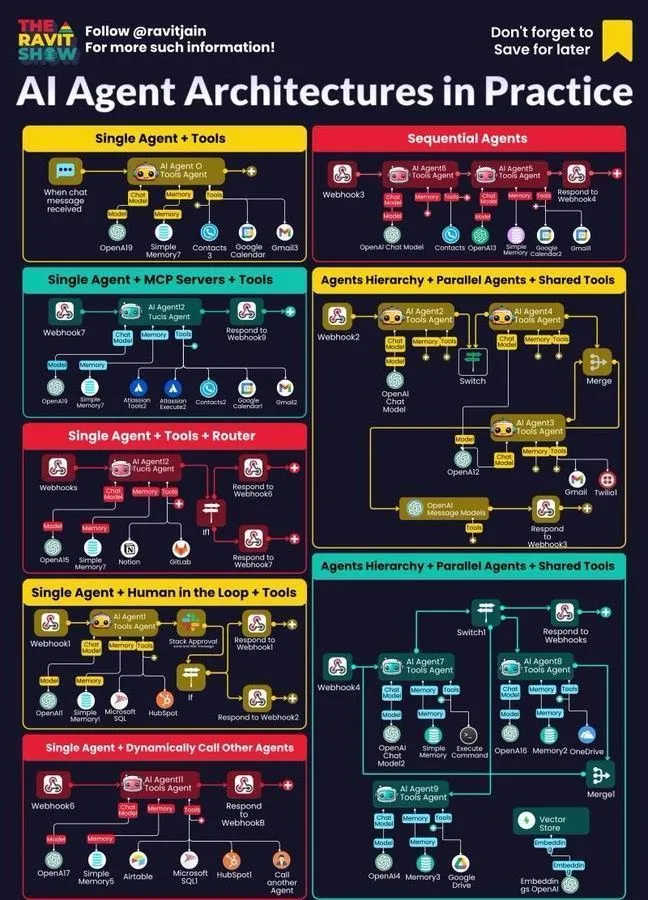

AI Agent Menjadi Inti Alur Kerja Perusahaan: Arsitektur, Peta, Aplikasi Praktis : AI Agent dengan cepat menjadi inti alur kerja perusahaan, dengan desain arsitektur, peta ekosistem, dan aplikasi praktisnya menarik perhatian luas. AI neuro-simbolik dipandang sebagai solusi potensial untuk halusinasi LLM, sementara studi simulasi Anthropic menunjukkan bahwa model AI dapat menimbulkan ancaman internal, menyoroti peluang dan tantangan AI Agentic dalam penerapan perusahaan, dan mendorong perusahaan untuk menjelajahi metode praktik yang lebih aman. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 ALAT

Ollama Mendukung Model Cloud, Memungkinkan Interaksi Model Lokal dan Cloud : Ollama kini mendukung deployment model di cloud, memungkinkan pengguna untuk berinteraksi antara model Ollama lokal dan model yang di-host di cloud. Fungsi ini diwujudkan melalui aplikasi Minions, memungkinkan pengguna untuk mengelola dan memanfaatkan sumber daya LLM mereka dengan lebih fleksibel, baik berjalan secara lokal maupun diakses melalui layanan cloud, memberikan pengalaman yang mulus. (Sumber: ollama)

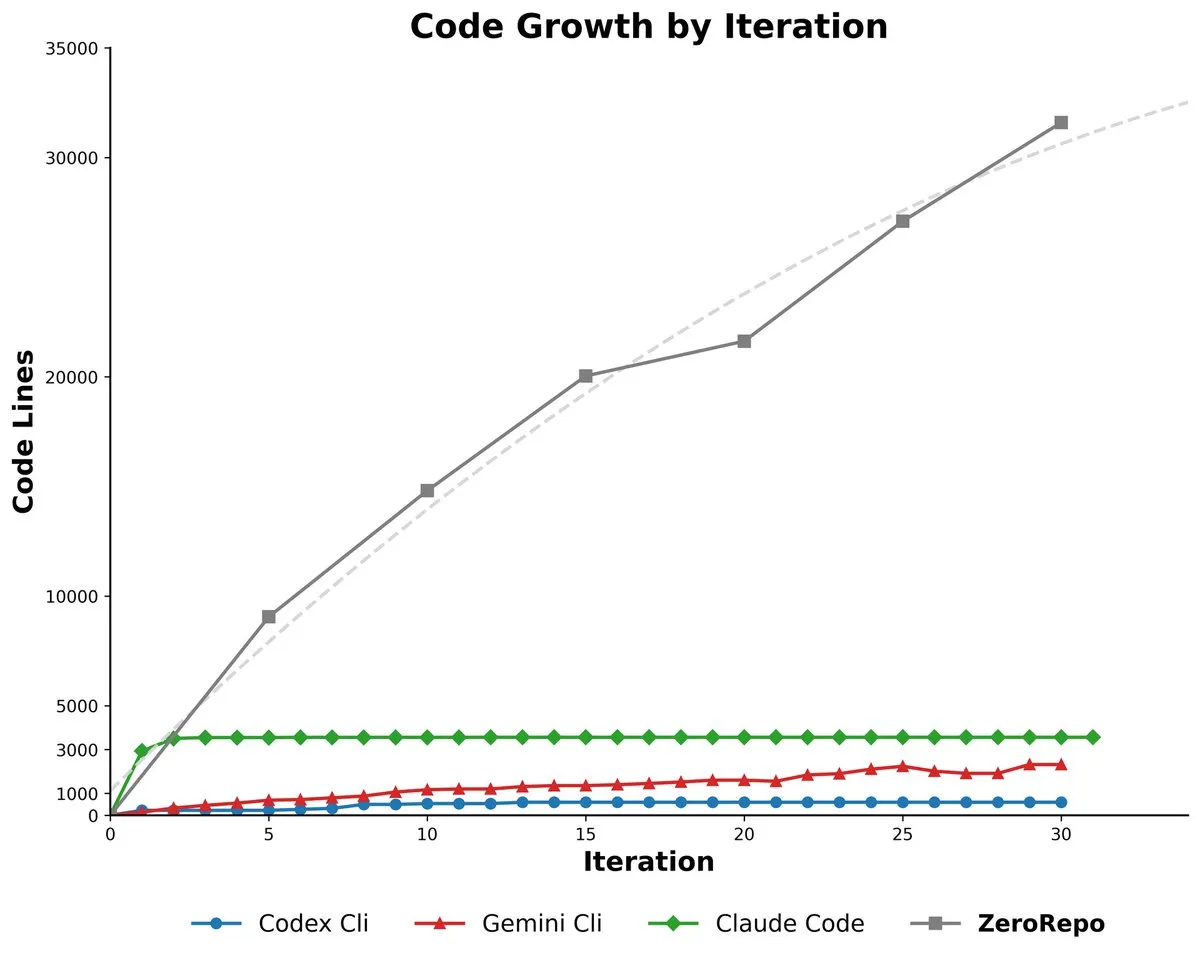

Microsoft ZeroRepo: Menghasilkan Basis Kode Lengkap Berdasarkan Kerangka Kerja Berbasis Graf : Microsoft meluncurkan ZeroRepo, sebuah alat berbasis kerangka kerja berbasis graf (Repository Planning Graph, RPG) yang mampu membangun proyek perangkat lunak lengkap dari nol. Alat ini menghasilkan volume kode 3.9 kali lebih tinggi dari baseline yang ada, dengan tingkat kelulusan 69.7%, mengatasi masalah ketidakcocokan bahasa alami dengan struktur perangkat lunak, dan mencapai perencanaan jangka panjang yang andal serta generasi basis kode yang skalabel. (Sumber: _akhaliq, TheTuringPost, paul_cal)

DSPy UI: Antarmuka Visual untuk Membangun Agent : DSPy sedang mengembangkan antarmuka pengguna (UI) visual, bertujuan untuk menyederhanakan proses pembangunan Agent, membuatnya seperti Figma atau Framer, dengan menggabungkan Agent melalui drag-and-drop komponen. UI ini akan membantu pengguna mengkonseptualisasikan pipeline Agent yang kompleks dengan lebih baik, dan menyederhanakan sintaks kode yang dihasilkan, dengan tujuan akhir untuk mewujudkan generasi versi bahasa DSPy yang berbeda dan pengoperasian GEPA. (Sumber: lateinteraction)

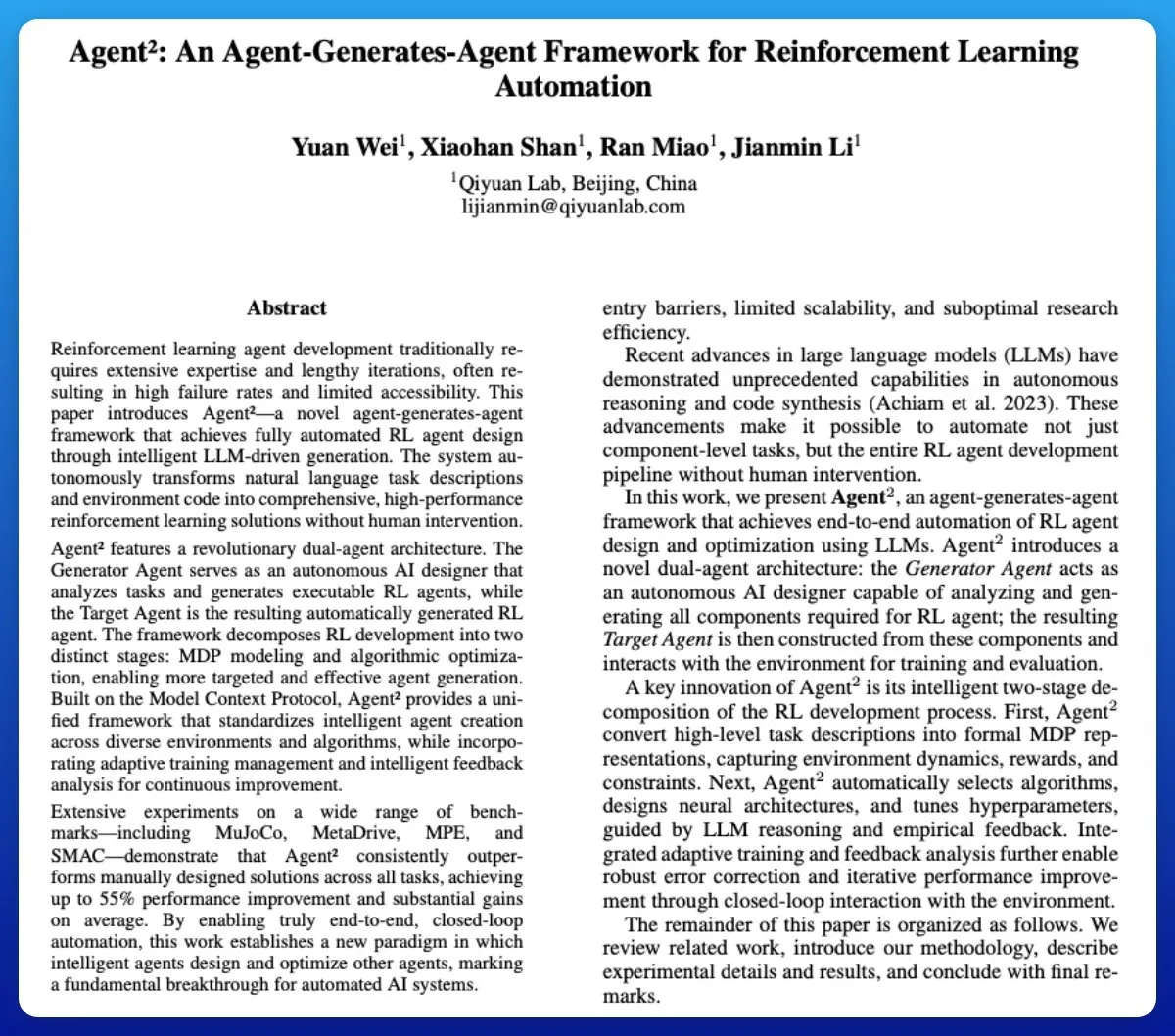

Agent²: LLM Menghasilkan Agent Pembelajaran Penguatan End-to-End : Agent² adalah alat yang memanfaatkan Large Language Models (LLM) untuk secara otomatis menghasilkan Agent Pembelajaran Penguatan (RL) end-to-end. Alat ini secara otomatis menghasilkan solusi RL yang efektif melalui bahasa alami dan kode lingkungan, tanpa intervensi manusia, dapat dianggap sebagai alat AutoML di bidang RL, sangat menyederhanakan proses pengembangan RL Agent. (Sumber: omarsar0)

Weaviate Merilis Query Agent, Mendukung Referensi, Introspeksi Skema, dan Routing Multi-Koleksi dalam Sistem AI : Weaviate secara resmi merilis Query Agent-nya, yang mencapai ketersediaan umum setelah enam bulan pengembangan. Ini mendukung generasi referensi, introspeksi skema, dan routing multi-koleksi dalam sistem AI, serta meningkatkan pola pencarian melalui Compound Retrieval System. Query Agent bertujuan untuk menyederhanakan interaksi dengan Weaviate, dan menyediakan klien Python serta TypeScript, meningkatkan pengalaman pengembang. (Sumber: bobvanluijt, Reddit r/deeplearning)

Claude Code CLI: Manajemen Karyawan Mikro dengan Pola Pikir SDK, Menekankan Status Eksternal dan Rekayasa Proses : Memperlakukan Claude Code CLI sebagai SDK daripada alat sederhana, pengembang perlu menekankan manajemen status eksternal (seperti file JSON, entri database) untuk kontinuitas sesi, seperti mengelola karyawan mikro, dan menganggap rekayasa prompt sebagai rekayasa proses. Pendekatan ini mengungkapkan keterbatasan LLM saat ini dalam hal kelebihan konteks dan UI yang membengkak, tetapi juga menyoroti nilai besar alat otomatisasi internal yang sangat spesifik. (Sumber: Reddit r/ClaudeAI)

Synapse-system: Sistem Bantuan AI untuk Basis Kode Besar Berbasis Knowledge Graph, Pencarian Vektor, dan Agent Profesional : Synapse-system adalah sistem yang dirancang untuk meningkatkan kemampuan bantuan AI pada basis kode besar, menggabungkan knowledge graph (Neo4j) untuk menyimpan hubungan kode, pencarian vektor (BGE-M3) untuk menemukan kode yang secara semantik serupa, Agent profesional (ahli Rust, TypeScript, Go, Python) untuk menyediakan konteks, dan cache cerdas (Redis) untuk akses cepat ke pola umum. Sistem ini, melalui desain modular, menghindari model raksasa tunggal, dan dioptimalkan untuk karakteristik bahasa yang berbeda. (Sumber: Reddit r/ClaudeAI)

Claude Opus 4.0+: Aplikasi Pemandu Wisata AI, Menghasilkan Tur Kota Personal Secara Real-time : Seorang pengembang mewujudkan impian 15 tahunnya dengan memanfaatkan Claude Opus 4.0 dan Claude Code, mengembangkan sebuah aplikasi pemandu wisata AI. Aplikasi ini dapat menghasilkan tur personal secara real-time untuk kota mana pun, tema apa pun (seperti “Wisata Venesia” atau “Tur Assassin’s Creed Florence”), dan pemandu wisata AI menyediakan penjelasan multibahasa, cerita, dan tanya jawab interaktif. Aplikasi ini menawarkan pengalaman imersif yang fleksibel, dapat dijeda dan dilanjutkan, dengan harga jauh lebih rendah daripada pemandu wisata manusia. (Sumber: Reddit r/ClaudeAI)

Mindcraft: Kombinasi AI Minecraft dan LLM, Mengontrol Agen dalam Game melalui Mineflayer : Proyek Mindcraft menggabungkan Large Language Models (LLM) dan pustaka Mineflayer untuk menciptakan agen AI dalam game Minecraft. Proyek ini memungkinkan LLM untuk menulis dan mengeksekusi kode dalam game, guna menyelesaikan tugas-tugas seperti mendapatkan item atau membangun struktur. Ini mendukung berbagai API LLM (seperti OpenAI, Gemini, Anthropic, dll.) dan menyediakan lingkungan sandbox, tetapi memperingatkan pengguna tentang potensi risiko serangan injeksi. (Sumber: GitHub Trending)

AI Agents for Continuous Inventory Management with Drones : Menggabungkan AI Agent dan teknologi drone untuk mencapai manajemen inventaris berkelanjutan tanpa beacon atau penerangan. Inovasi ini memanfaatkan drone terbang otonom, melakukan inventarisasi dan manajemen stok secara real-time melalui algoritma AI, diharapkan dapat secara signifikan meningkatkan efisiensi logistik dan pergudangan, mengurangi biaya tenaga kerja, dan menyediakan data yang lebih akurat di lingkungan yang kompleks. (Sumber: Ronald_vanLoon)

Panduan Evaluasi LLM: Praktik Terbaik untuk Keandalan, Keamanan, Kinerja : Sebuah panduan evaluasi LLM yang komprehensif telah dirilis, merinci indikator kunci, metode, dan praktik terbaik untuk mengevaluasi Large Language Models (LLM). Panduan ini bertujuan untuk membantu memastikan keandalan, keamanan, dan kinerja aplikasi berbasis AI, menyediakan kerangka evaluasi yang sistematis bagi pengembang dan peneliti untuk mengatasi tantangan dalam deployment LLM. (Sumber: dl_weekly)

📚 BELAJAR

Ilmuwan OpenAI Lukasz Kaiser Berbicara tentang Pemikiran Prinsip Pertama Model Besar : Ilmuwan OpenAI Lukasz Kaiser (salah satu dari delapan ‘anak’ Transformer) berbagi pemikirannya tentang “prinsip pertama” pengembangan model besar. Ia percaya bahwa fase berikutnya AI terletak pada pengajaran model untuk “berpikir”, melakukan inferensi mendalam dengan menghasilkan lebih banyak langkah perantara, daripada langsung mengeluarkan jawaban. Ia memprediksi bahwa di masa depan, daya komputasi akan beralih dari pre-training skala besar ke komputasi inferensi masif pada sejumlah kecil data berkualitas tinggi, sebuah mode yang lebih mendekati kecerdasan manusia. (Sumber: 36氪)

Prinsip Bertahan Hidup di Era Pemrograman AI: Andrew Ng Menekankan Bertindak Cepat, Bertanggung Jawab : Andrew Ng dalam pidatonya di Buildathon menunjukkan bahwa pemrograman berbantuan AI mempercepat pengembangan prototipe independen hingga 10 kali lipat, mendorong pengembang untuk berani mencoba-coba di lingkungan sandbox dengan prinsip “bertindak cepat, bertanggung jawab”. Ia menekankan bahwa nilai kode sedang terdepresiasi, dan pengembang perlu bertransformasi menjadi desainer sistem dan konduktor AI, menguasai alat pemrograman AI terbaru, blok bangunan AI (rekayasa prompt/teknik evaluasi/MCP), dan kemampuan prototipe cepat, membantah pandangan “tidak perlu belajar pemrograman di era AI”. (Sumber: 36氪)

Edisi Ketiga ‘Deep Learning with Python’ Dirilis Online Gratis : François Chollet mengumumkan bahwa edisi ketiga bukunya ‘Deep Learning with Python’ telah diterbitkan, dan versi online lengkap gratis juga tersedia secara bersamaan. Langkah ini bertujuan untuk menurunkan hambatan belajar deep learning, memungkinkan lebih banyak orang yang tertarik pada kecerdasan buatan untuk mengakses sumber daya belajar berkualitas tinggi, dan mendorong penyebaran pengetahuan. (Sumber: fchollet, fchollet)

‘Kaggle Grandmasters Playbook’: 7 Teknik Praktis Pemodelan Data Tabular : Tim Kaggle Grandmasters, Gilberto Titericz Jr dan rekan-rekannya, merilis ‘Kaggle Grandmasters Playbook’ berdasarkan pengalaman bertahun-tahun dalam kompetisi dan praktik. Manual ini mengumpulkan 7 teknik pemodelan data tabular yang telah teruji dalam praktik, bertujuan untuk membantu ilmuwan data dan insinyur pembelajaran mesin meningkatkan kemampuan mereka dalam pemrosesan data tabular dan pembangunan model, terutama cocok untuk kompetisi Kaggle dan tantangan data dunia nyata. (Sumber: HamelHusain)

Kekurangan Insinyur AI yang Parah, Kurikulum Universitas Sangat Terputus : Andrew Ng menunjukkan bahwa meskipun tingkat pengangguran lulusan ilmu komputer meningkat, perusahaan masih menghadapi kekurangan insinyur AI yang parah. Kontradiksi utamanya adalah kurikulum universitas gagal mencakup keterampilan kunci seperti pemrograman berbantuan AI, pemanggilan model bahasa besar, pembangunan alur kerja RAG/Agentic, dan proses analisis kesalahan yang terstandarisasi secara tepat waktu. Ia menyerukan agar sistem pendidikan mempercepat pembaruan kurikulum, melatih insinyur yang memiliki blok bangunan AI terbaru dan kemampuan prototipe cepat. (Sumber: 36氪)

Panduan Evaluasi LLM: Praktik Terbaik untuk Keandalan, Keamanan, Kinerja : Sebuah panduan evaluasi LLM yang komprehensif telah dirilis, merinci indikator kunci, metode, dan praktik terbaik untuk mengevaluasi Large Language Models (LLM). Panduan ini bertujuan untuk membantu memastikan keandalan, keamanan, dan kinerja aplikasi berbasis AI, menyediakan kerangka evaluasi yang sistematis bagi pengembang dan peneliti untuk mengatasi tantangan dalam deployment LLM, memastikan kualitas produk AI dan kepercayaan pengguna. (Sumber: dl_weekly)

💼 BISNIS

Demam Investasi Infrastruktur AI: Pengeluaran Pusat Data AI AS Diperkirakan Mencapai $520 Miliar pada 2025 : Menurut laporan Wall Street Journal dan The Economist, Amerika Serikat sedang mengalami demam pengeluaran pusat data AI, diperkirakan mencapai $520 miliar pada tahun 2025, melebihi puncak pengeluaran telekomunikasi di era internet. Ini secara singkat meningkatkan PDB AS, tetapi dalam jangka panjang dapat menyebabkan kelangkaan dana di sektor lain, PHK massal, dan risiko depresiasi tinggi karena iterasi perangkat keras AI yang cepat, memicu kekhawatiran ekonomi struktural, dan menimbulkan tantangan bagi kesehatan ekonomi AS jangka panjang. (Sumber: 36氪)

OpenAI Mengumumkan Fitur Baru Akan Berbayar: Pengguna Pro Membutuhkan Biaya Tambahan, Intensif Biaya : CEO OpenAI Sam Altman mengumumkan bahwa beberapa fitur baru yang intensif komputasi akan diluncurkan dalam beberapa minggu mendatang. Karena biaya yang tinggi, fitur-fitur ini awalnya hanya akan tersedia untuk pelanggan Pro dengan biaya $200 per bulan, dan bahkan mungkin memerlukan biaya tambahan. Altman menyatakan bahwa tim sedang berupaya mengurangi biaya, tetapi langkah ini mengindikasikan bahwa model bisnis layanan AI mungkin beralih ke model “mempekerjakan karyawan per jam”, membawa tantangan baru bagi pengguna dan industri. (Sumber: The Verge, op7418, amasad)

Startup Memperoleh Kredit OpenAI Besar, Mencari Cara Monetisasi : Sebuah startup teknologi memperoleh kredit Azure OpenAI senilai $120.000, jauh melebihi kebutuhannya, dan sedang mencari cara untuk memonetisasinya. Ini mencerminkan potensi ketidakseimbangan penawaran dan permintaan sumber daya AI di pasar, serta eksplorasi perusahaan tentang cara efektif memanfaatkan dan memonetisasi sumber daya komputasi AI yang berlebihan, dan juga dapat memunculkan model transaksi sumber daya AI baru. (Sumber: Reddit r/deeplearning)

🌟 KOMUNITAS

Dampak Negatif AI terhadap Pemikiran Kritis: Ketergantungan Berlebihan Menyebabkan Degenerasi Kemampuan : Ramai dibahas di media sosial, penggunaan AI yang meluas menyebabkan degenerasi kemampuan berpikir kritis manusia. Ada pandangan bahwa ketika orang tidak lagi menggunakan “otot berpikir”, kemampuan ini akan menyusut. Meskipun AI dapat meningkatkan efisiensi, ia juga dapat menyebabkan orang kehilangan kemampuan berpikir mendalam di bidang-bidang penting, menimbulkan kekhawatiran tentang dampak jangka panjang pada kemampuan kognitif manusia. (Sumber: mmitchell_ai)

Dilema Etika AI di Bidang Kesehatan: Pro dan Kontra Prediksi Penyakit Delphi-2M : Model AI baru Delphi-2M dapat menganalisis data kesehatan, memprediksi risiko pengguna terkena lebih dari seribu jenis penyakit dalam 20 tahun ke depan. Diskusi komunitas menunjukkan bahwa mengetahui risiko penyakit lebih awal dapat membawa intervensi pencegahan yang positif, tetapi juga dapat menyebabkan kecemasan jangka panjang, dan memicu risiko privasi serta diskriminasi bagi perusahaan asuransi atau pemberi kerja yang memperoleh data semacam itu. Saat alat AI belum matang, dampak etika sosial potensialnya telah menjadi fokus. (Sumber: Reddit r/ArtificialInteligence)

Fenomena ‘Kecacatan Otak’ Akibat Penggunaan AI Sehari-hari: Ketergantungan Berlebihan pada AI Menyebabkan Penurunan Kemampuan Berpikir : Dalam diskusi sosial, banyak pengguna mengeluh bahwa AI terlalu sering digunakan dalam kehidupan sehari-hari, menyebabkan penurunan kemampuan berpikir orang. Dari keputusan sederhana (film apa yang akan ditonton, makanan apa yang akan dimakan) hingga masalah kompleks (masalah organisasi universitas), AI sering dikonsultasikan, bahkan jika jawabannya salah atau mudah didapat. Fenomena “kecacatan otak AI” ini tidak hanya mengurangi partisipasi individu, tetapi juga mendorong penyebaran informasi palsu, memicu refleksi mendalam tentang batas penggunaan AI. (Sumber: Reddit r/ArtificialInteligence)

Kelelahan Penggunaan Alat Pemrograman AI: Pengembang Merasa Penurunan Keterlibatan Mental : Banyak pengembang melaporkan bahwa penggunaan alat pemrograman AI sehari-hari (seperti Claude Code), meskipun meningkatkan produktivitas, menyebabkan kelelahan mental dan penurunan keterlibatan. Mereka menemukan diri mereka lebih sering dalam “mode peninjauan” daripada secara aktif memecahkan masalah, dan proses menunggu AI menghasilkan output terasa pasif. Komunitas sedang membahas bagaimana menyeimbangkan bantuan AI dengan menjaga aktivitas berpikir, untuk menghindari beban kognitif dan penurunan kreativitas. (Sumber: Reddit r/artificial, Reddit r/ClaudeAI)

1/4 Anak Muda Berinteraksi dengan AI untuk Tujuan Romantis dan Seksual : Sebuah penelitian menunjukkan bahwa 1/4 orang dewasa muda berinteraksi dengan AI untuk tujuan romantis dan seksual. Fenomena ini memicu diskusi komunitas tentang kesepian, kurangnya interaksi interpersonal, dan peran AI dalam pendampingan emosional. Meskipun AI memberikan kenyamanan dalam beberapa aspek, banyak yang masih mempertanyakan apakah ia dapat menggantikan hubungan interpersonal yang benar-benar bermakna, dan khawatir tentang dampak jangka panjangnya pada pola interaksi sosial. (Sumber: Reddit r/ArtificialInteligence)

Ancaman Keamanan AI: Pengujian Kerentanan Model Besar Mengungkap Risiko Baru, Injeksi Prompt Merajalela : Pengujian kerentanan model besar AI pertama di Tiongkok menemukan 281 kerentanan keamanan, di mana 177 di antaranya spesifik untuk model besar, mencakup lebih dari 60%. Risiko tipikal termasuk output yang tidak pantas, kebocoran informasi, injeksi prompt (paling umum), dan serangan konsumsi tak terbatas. Model mainstream domestik seperti Tencent Hunyuan dan Baidu Wenxin Yiyan menunjukkan kinerja yang relatif baik. Komunitas memperingatkan bahwa kepercayaan tanpa pertahanan pengguna terhadap AI dapat menyebabkan kebocoran privasi, terutama saat berkonsultasi tentang masalah pribadi. (Sumber: 36氪)

Dilema Etika AI Agent: Keputusan dan Tanggung Jawab Sistem Pengawasan AI Kota dengan Tingkat Kesalahan 10% : Komunitas membahas skenario hipotetis tentang dilema etika AI Agent: sistem pengawasan AI kota memiliki tingkat kesalahan 10%, menandai orang yang tidak bersalah sebagai ancaman potensial. Diskusi berfokus pada bagaimana menyeimbangkan antara tekanan deployment dan prinsip etika (seperti Prinsip Blackstone). Solusi yang diusulkan meliputi: membentuk tim kolaborasi manusia-mesin untuk memperbaiki masalah, mengalihkan biaya kesalahan kepada manajemen, menghapus sepenuhnya catatan orang yang salah ditandai dan meminta maaf, serta mempertimbangkan untuk mengundurkan diri dalam situasi “kehilangan kepercayaan publik sepenuhnya dan pengabaian serakah dari manajemen”. (Sumber: Reddit r/artificial)

Kesadaran AI dan Definisi AGI: Andrew Ng Menganggap AGI Telah Menjadi Istilah Hype, Kesadaran adalah Masalah Filosofis : Andrew Ng dalam pidatonya menunjukkan bahwa Artificial General Intelligence (AGI) telah berubah dari istilah teknis menjadi istilah hype, dengan definisi yang kabur, menyebabkan kurangnya standar yang seragam dalam industri mengenai klaim “pencapaian AGI”. Ia berpendapat bahwa kesadaran adalah masalah filosofis yang penting, bukan masalah ilmiah, dan saat ini tidak ada standar pengukuran. Insinyur dan ilmuwan harus fokus pada pembangunan sistem AI yang benar-benar berguna, daripada terjebak dalam debat filosofis tentang kesadaran. (Sumber: 36氪)

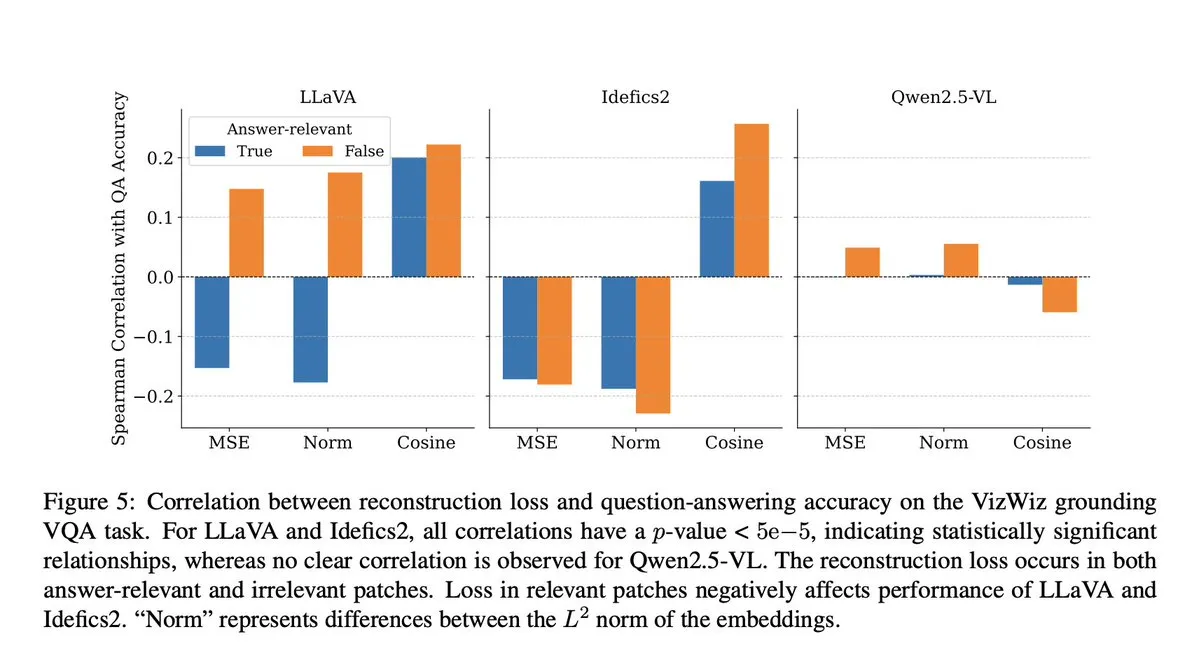

Kecurangan Model AI: Penelitian VLM Mengungkap Langkah Proyeksi Menyebabkan Kehilangan Konteks Semantik : Komunitas membahas sebuah penelitian Microsoft yang mengungkapkan bahwa model visual-bahasa (VLM) kehilangan 40-60% konteks semantik selama langkah proyeksi, sehingga mendistorsi representasi visual dan memengaruhi tugas-tugas hilir. Penemuan ini memicu kekhawatiran tentang akurasi evaluasi VLM dan kontaminasi data, terutama dalam benchmark seperti DocVQA, di mana skor tinggi mungkin tidak sepenuhnya mencerminkan kemampuan sebenarnya model. (Sumber: vikhyatk)

Etika AI dan Robot: Seruan untuk Menghentikan Uji Coba Kekerasan pada Robot : Di media sosial, beberapa peneliti AI dan anggota komunitas menyerukan penghentian uji coba kekerasan pada robot, seperti berulang kali memukul robot Unitree G1 untuk menunjukkan stabilitasnya. Mereka berpendapat bahwa metode pengujian ini tidak hanya menimbulkan kekhawatiran etika, tetapi juga dapat memperkuat persepsi negatif terhadap robot, dan mempertanyakan kebutuhan ilmiahnya, menganjurkan evaluasi kinerja robot dengan cara yang lebih manusiawi dan ilmiah. (Sumber: vikhyatk, dejavucoder, Ar_Douillard)

‘Pseudo-Intelligence’ AI: Seruan untuk Mengubah ‘Kecerdasan Buatan’ Menjadi ‘Pseudo-Intelligence’ untuk Mengurangi Kesalahpahaman Publik : Ada pandangan yang mengusulkan agar sebutan “Kecerdasan Buatan” (Artificial Intelligence) diubah menjadi “Pseudo Intelligence” untuk mengurangi pembesar-besaran dan kesalahpahaman publik terhadap kemampuan AI. Usulan ini berasal dari kesadaran yang jelas akan keterbatasan AI saat ini, bertujuan untuk menghindari menyesatkan publik dengan narasi “ala Terminator” yang megah, dan mendorong pemahaman rasional tentang kemampuan AI yang sebenarnya di dalam dan di luar industri. (Sumber: clefourrier)

Chatbot AI Albania Diella Ditunjuk sebagai Anggota Kabinet, Memicu Kontroversi : Pemerintah Albania menunjuk chatbot AI Diella sebagai anggota kabinet, bertujuan untuk memerangi korupsi. Langkah ini memicu kontroversi luas, dikritik sebagai gimmick murahan, mirip dengan insiden Arab Saudi yang memberikan “kewarganegaraan” kepada robot Sophia pada tahun 2017. Komentar berpendapat bahwa langkah ini mungkin terlalu mempromosikan kemampuan AI, dan mengaburkan batas antara teknologi dan tata kelola. (Sumber: The Verge)

Fenomena ‘Halusinasi’ ChatGPT: Model Terjebak dalam Lingkaran, Mengoreksi Diri tetapi Tidak Dapat Keluar : Pengguna komunitas membagikan kasus ChatGPT yang terjebak dalam lingkaran “halusinasi”, di mana model berulang kali menghasilkan informasi yang salah saat menjawab pertanyaan, dan bahkan jika “menyadari” kesalahannya, ia tidak dapat keluar dari lingkaran ini. Fenomena ini memicu diskusi tentang cacat teknis mendalam LLM, menunjukkan adanya ketidaksesuaian antara kemampuan model untuk memahami kesalahan logisnya sendiri dan kemampuan untuk mengoreksinya dalam beberapa kasus. (Sumber: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 LAIN-LAIN

Dari Transformer ke GPT-5: Pemikiran Prinsip Pertama Model Besar oleh Ilmuwan OpenAI Lukasz Kaiser : Ilmuwan OpenAI Lukasz Kaiser (salah satu dari delapan ‘anak’ Transformer) berbagi perjalanannya dari latar belakang logika, berpartisipasi dalam penemuan arsitektur Transformer, hingga terlibat secara mendalam dalam pengembangan GPT-4/5. Ia menekankan pentingnya membangun sistem dari prinsip pertama, dan memprediksi bahwa fase berikutnya AI adalah mengajar model untuk “berpikir”, melakukan inferensi mendalam dengan menghasilkan lebih banyak langkah perantara, daripada langsung mengeluarkan jawaban, dan daya komputasi akan beralih ke inferensi masif pada sejumlah kecil data berkualitas tinggi. (Sumber: 36氪)

Sintesis Gambar Semantik: Teknologi Generasi Kerangka Foto Sungai Satelit : Komunitas pembelajaran mesin sedang membahas kemajuan terbaru di bidang sintesis gambar semantik, dengan fokus khusus pada cara menghasilkan foto sungai satelit hitam-putih dari kerangka gambar sungai. Tugas ini melibatkan penggunaan generator untuk menghasilkan gambar satelit dari data kerangka baru yang belum pernah dilihat, dan mungkin memperkenalkan variabel kondisional tambahan. Diskusi bertujuan untuk menemukan metode paling canggih dan makalah penelitian terkait untuk memandu proyek visi komputer semacam itu. (Sumber: Reddit r/MachineLearning)

Kesenjangan Kecerdasan di Era AI: Profesor Qiu Zeqi Membahas Dampak Mendalam AI terhadap Pemikiran dan Kognisi Manusia : Profesor Qiu Zeqi dari Universitas Peking menunjukkan bahwa penggunaan AI bukan sekadar menyebabkan “penurunan kecerdasan”, melainkan lebih seperti latihan berpikir, tergantung pada inisiatif dan sikap kritis seseorang. Ia menekankan bahwa pemahaman manusia tentang pemikiran masih dalam tahap awal, dan meskipun AI kuat, ia masih berbasis pada pengetahuan manusia, tidak dapat sepenuhnya mensimulasikan persepsi panca indera dan pemikiran lompat manusia. Kecenderungan AI untuk “menyenangkan” menuntut pengguna untuk menantangnya, dan waspada terhadap nilai-nilainya. Ia berpendapat bahwa di era AI, pengembangan kemampuan dasar dan pembangunan masyarakat yang beragam lebih penting, menghindari pengamatan “kesenjangan kecerdasan” dari perspektif yang tinggi. (Sumber: 36氪)