Kata Kunci:superkomputer, halusinasi AI, pelanggaran hak cipta, model bahasa besar, chip AI, superkomputer JUPITER, makalah halusinasi AI OpenAI, kasus penyelesaian hak cipta Anthropic, model Qwen3-Max-Preview, chip AI buatan OpenAI

🔥 Fokus Utama

Superkomputer exascale pertama di Eropa, JUPITER, telah diluncurkan: Superkomputer exascale pertama di Eropa, JUPITER, telah diluncurkan, ditenagai oleh NVIDIA Grace Hopper. Sistem ini adalah superkomputer paling hemat energi di dunia, menggabungkan AI dengan HPC, bertujuan untuk mencapai terobosan di bidang seperti ilmu iklim, ilmu saraf, dan simulasi kuantum. Ini menandai langkah penting bagi Eropa dalam komputasi kinerja tinggi dan penelitian AI, diharapkan dapat mempercepat penemuan ilmiah terdepan. (Sumber: nvidia)

OpenAI merilis makalah yang mengungkap akar halusinasi AI: OpenAI merilis makalah ‘Mengapa Model Bahasa Berhalusinasi’, menunjukkan bahwa akar penyebab halusinasi AI terletak pada mekanisme pelatihan dan evaluasi saat ini yang menghargai model untuk menebak daripada mengakui ketidakpastian. Selama fase pra-pelatihan, model kesulitan membedakan informasi yang valid dan tidak valid karena kurangnya label ‘benar/salah’, dan cenderung mengarang fakta, terutama saat menangani fakta berfrekuensi rendah. OpenAI menyerukan pembaruan metrik evaluasi, menghukum kesalahan yang percaya diri, dan menghargai ekspresi ketidakpastian, untuk mendorong model agar lebih ‘jujur’. (Sumber: source, source, source, source, source)

Anthropic mencapai penyelesaian $1,5 miliar dalam kasus pelanggaran hak cipta AI: Anthropic telah mencapai penyelesaian senilai setidaknya $1,5 miliar dengan penulis buku terkait kasus pelanggaran hak cipta AI. Kesepakatan penyelesaian ini mencakup sekitar 500.000 karya berhak cipta, dengan rata-rata sekitar $3.000 per karya (sebelum biaya pengacara), dan berjanji untuk menghancurkan dataset bajakan. Kasus ini adalah penyelesaian gugatan class action terkait AI dan hak cipta pertama di AS, yang dapat menjadi preseden untuk definisi hukum AI generatif dan kekayaan intelektual. (Sumber: source, source, source, source, source, source, source)

🎯 Tren

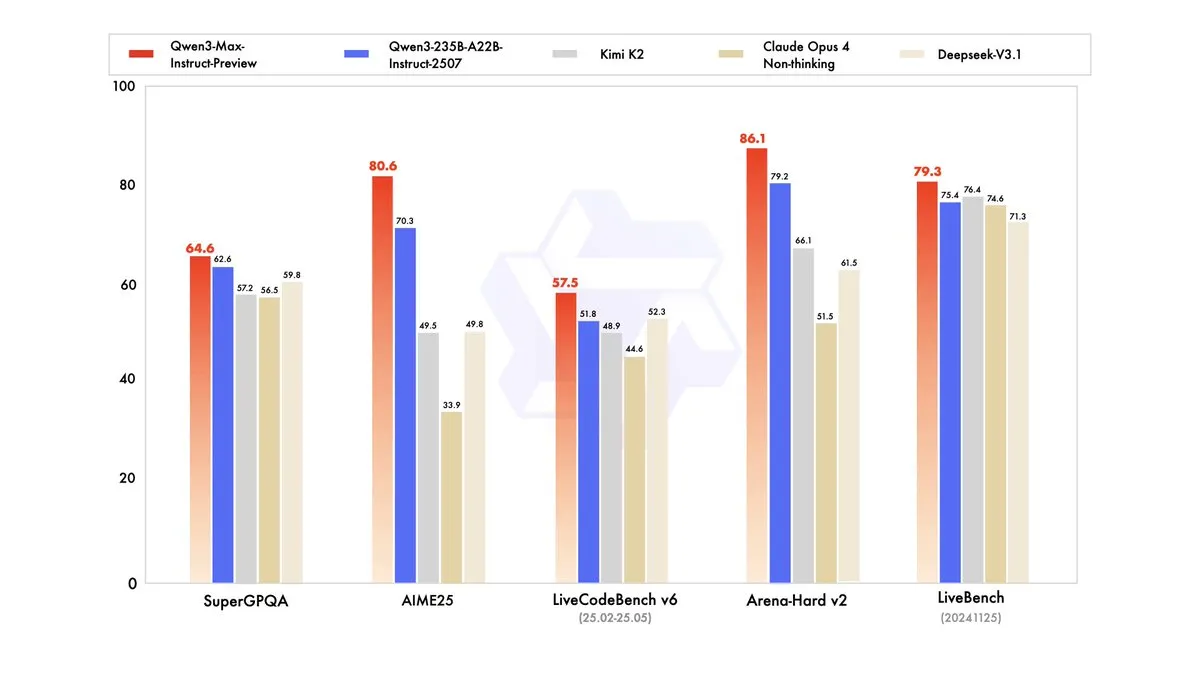

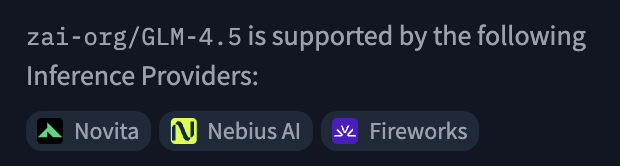

Qwen3-Max-Preview dirilis, dengan lebih dari satu triliun parameter: Alibaba Cloud Tongyi Qianwen (Qwen) telah merilis model terbesarnya hingga saat ini, Qwen3-Max-Preview (Instruct), dengan lebih dari satu triliun parameter. Model ini telah tersedia melalui Qwen Chat dan Alibaba Cloud API, dan telah melampaui Qwen3-235B-A22B-2507 sebelumnya dalam benchmark. Tes internal dan umpan balik pengguna awal menunjukkan peningkatan signifikan dalam kinerja, cakupan pengetahuan, kemampuan percakapan, tugas Agent, dan kepatuhan instruksi. Model ini juga telah diluncurkan di OpenRouter, memicu diskusi di komunitas tentang apakah model ini akan menjadi open source. (Sumber: source, source, source, source, source, source, source, source)

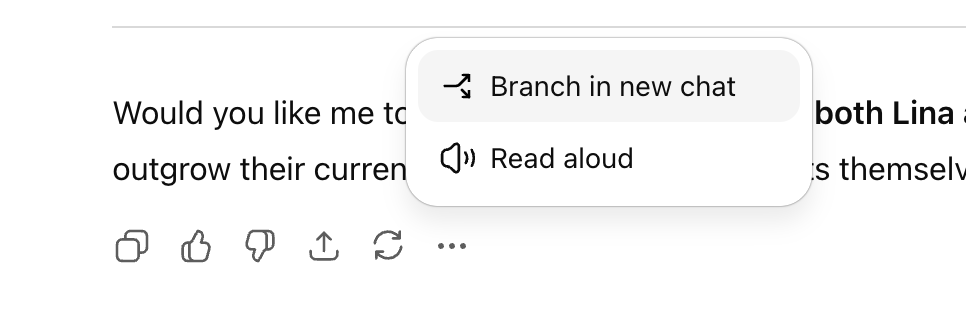

ChatGPT menambahkan fitur percakapan bercabang, meningkatkan kemampuan eksplorasi multi-jalur: OpenAI telah meluncurkan fitur baru ‘cabang percakapan’ untuk versi web ChatGPT, memungkinkan pengguna membuat cabang baru dari balasan mana pun untuk eksplorasi multi-jalur, tanpa perlu memulai percakapan baru atau khawatir tentang konteks yang terlalu panjang. Fitur ini, dikombinasikan dengan fungsi memori, membuat percakapan lebih berkelanjutan dan fleksibel, mengubah percakapan dari struktur linier menjadi pohon, membantu pengguna mempertahankan ide-ide berbeda dan meningkatkan efisiensi kolaborasi asisten AI. (Sumber: source, source, source)

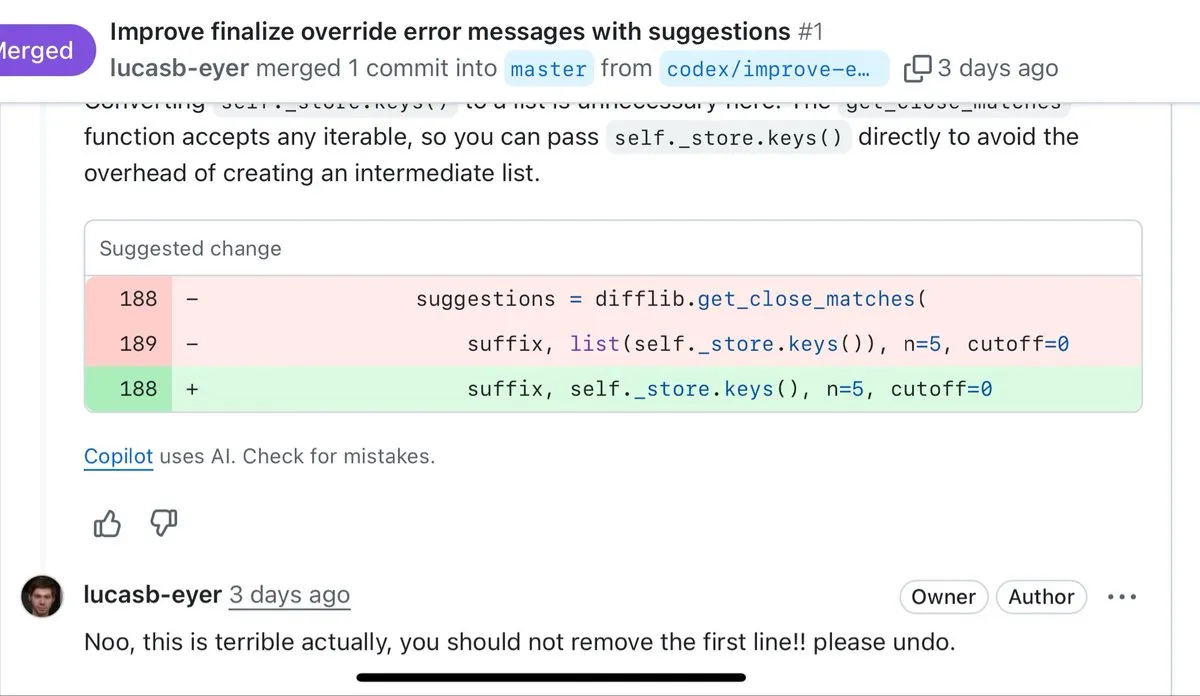

OpenAI berencana meluncurkan platform rekrutmen AI dan mengembangkan chip AI sendiri: OpenAI berencana meluncurkan platform rekrutmen berbasis AI pada pertengahan 2026, bersaing dengan LinkedIn, dan menawarkan sertifikasi ‘AI fluency’. Selain itu, untuk mengurangi ketergantungan pada Nvidia, OpenAI akan mulai memproduksi chip AI yang dirancang sendiri tahun depan. Langkah-langkah ini menunjukkan ambisi OpenAI dalam memperluas ekosistem aplikasi AI dan mengoptimalkan infrastruktur perangkat keras. (Sumber: source, source, source, source, source)

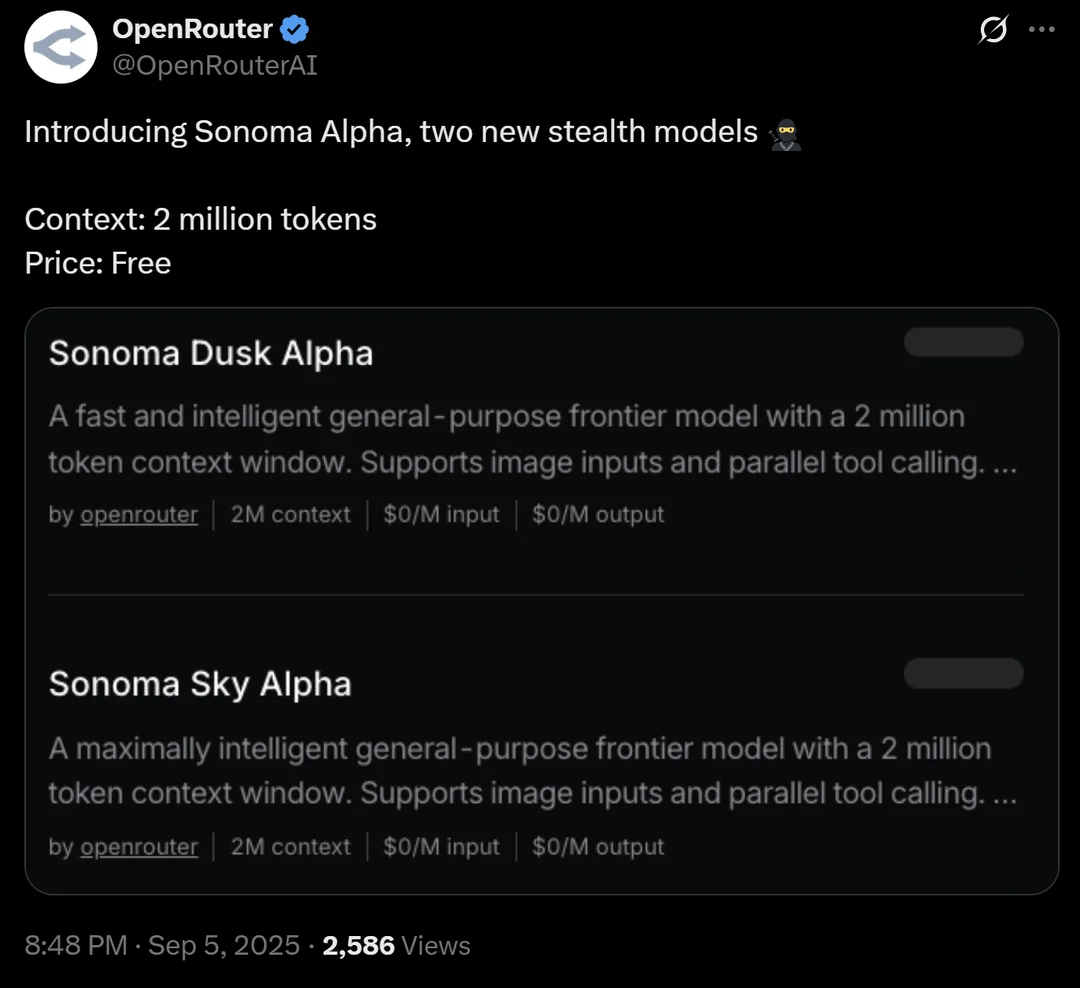

OpenRouter memperkenalkan model ‘siluman’ Sonoma Alpha dengan jendela konteks 2 juta: Platform OpenRouter telah meluncurkan model ‘siluman’ bernama Sonoma Alpha, dengan fitur utama dukungan jendela konteks 2 juta dan ketersediaan gratis. Komunitas secara luas berspekulasi bahwa model ini adalah bagian dari seri Grok xAI, karena karakteristiknya yang ‘mencari kebenaran secara maksimal’ sejalan dengan filosofi Elon Musk. Model ini menunjukkan kinerja luar biasa dalam pembuatan kode, logika, dan tugas-tugas ilmiah, mengindikasikan potensi model konteks super panjang dalam aplikasi praktis. (Sumber: source, source, source)

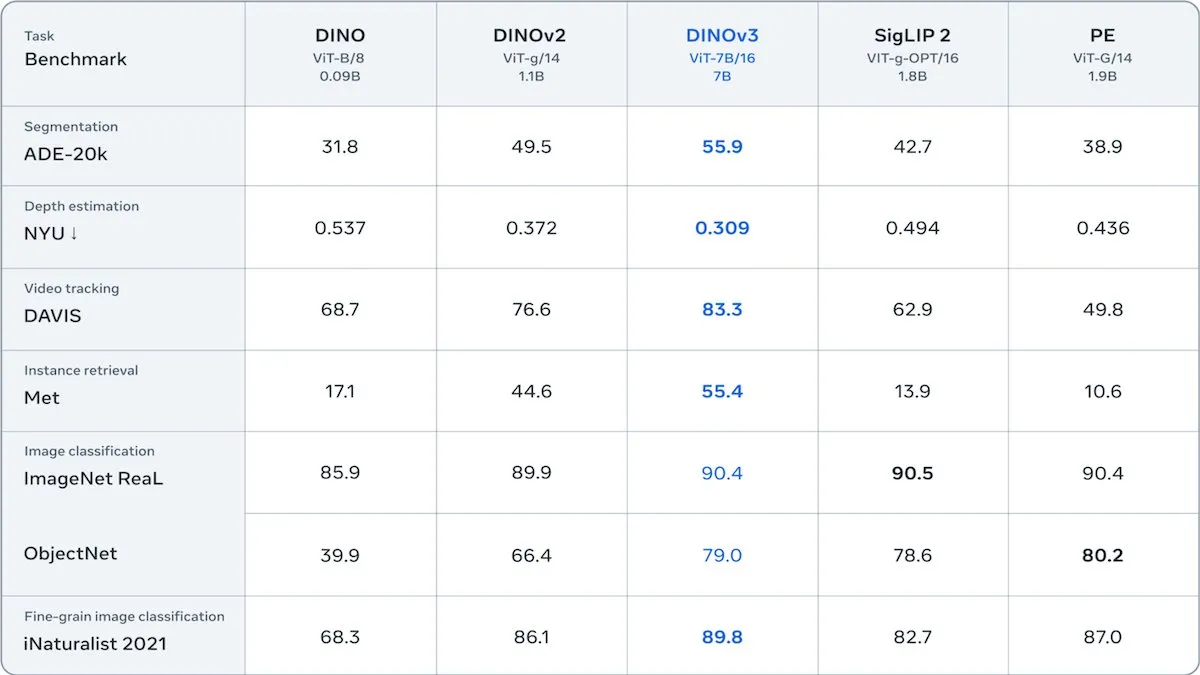

Meta merilis DINOv3, Transformer visual self-supervised: Meta merilis DINOv3, model Transformer visual self-supervised dengan 6,7 miliar parameter, yang secara signifikan meningkatkan kualitas embedding gambar dalam tugas-tugas seperti segmentasi gambar dan estimasi kedalaman. Model ini dilatih pada 1,7 miliar gambar Instagram, memperkenalkan istilah kerugian baru untuk mempertahankan keragaman tingkat patch, mengatasi keterbatasan data tanpa label. DINOv3 dirilis di bawah lisensi yang mengizinkan penggunaan komersial tetapi melarang aplikasi militer, menyediakan backbone self-supervised yang kuat untuk aplikasi visual hilir. (Sumber: DeepLearningAI)

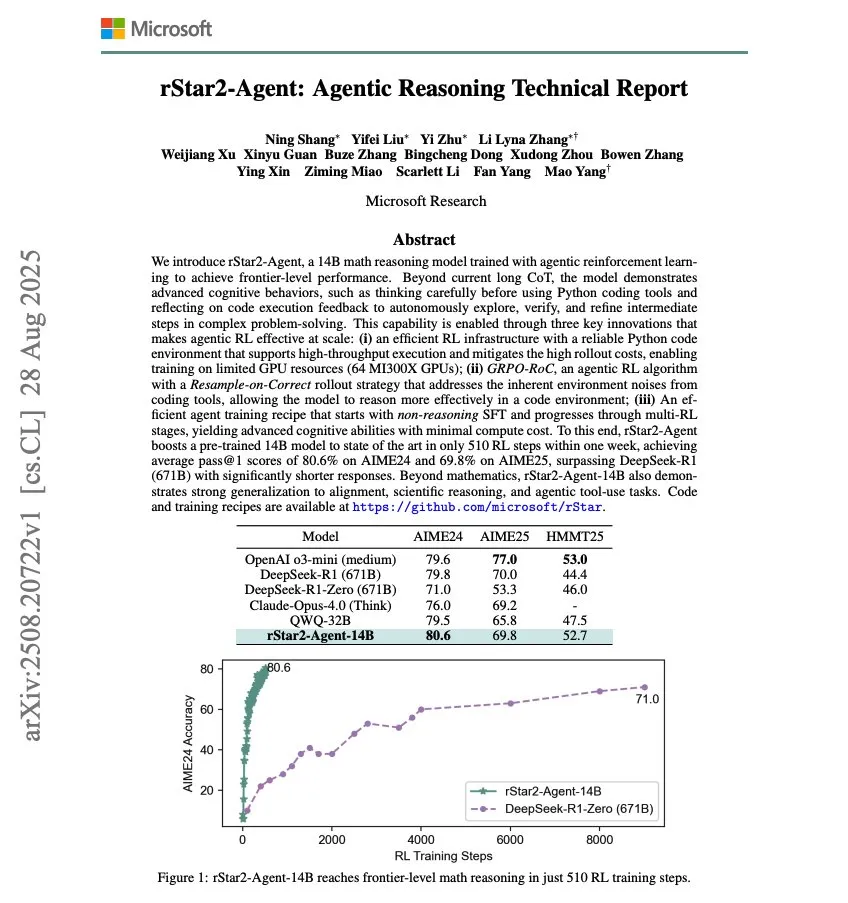

Microsoft merilis rStar2-Agent, model penalaran matematika 14B: Microsoft merilis rStar2-Agent, model penalaran matematika 14B, yang dilatih melalui Agentic RL, mencapai kemampuan penalaran matematika tingkat canggih hanya dengan 510 langkah pelatihan RL. Penelitian ini menunjukkan potensi untuk meningkatkan kinerja model AI dengan cepat di domain tertentu melalui reinforcement learning. (Sumber: dair_ai)

OpenAI membentuk oai Labs untuk mengeksplorasi antarmuka kolaborasi manusia-AI baru: OpenAI mengumumkan pembentukan oai Labs, dipimpin oleh Joanne Jang, yang berfokus pada penelitian dan prototipe antarmuka baru untuk kolaborasi manusia-AI. Tim ini bertujuan untuk melampaui mode obrolan dan agen yang ada, mengeksplorasi paradigma dan alat baru untuk meningkatkan cara orang berinteraksi, berpikir, berkreasi, belajar, dan terhubung dengan AI. (Sumber: source, source)

Pameran IFA 2025: Tren perangkat keras AI dan robotika: Pada IFA 2025 di Berlin, Jerman, produsen Tiongkok sepenuhnya mendominasi pasar kacamata AI, dengan merek seperti Rokid dan Rayneo Innovation memamerkan berbagai produk dan secara aktif menjelajahi ekosistem luar negeri. Di bidang robotika, Unitree Robotics memamerkan robot humanoid G1 dan robot anjing Go 2, menarik banyak perhatian; Midea, UBTECH, dan lainnya juga memamerkan robot layanan rumah tangga. Robot fungsional seperti robot pembersih cerdas, robot pemotong rumput, dan robot kolam renang bermunculan, dengan peningkatan teknologi yang lebih dekat dengan skenario kehidupan sehari-hari. AI telah terintegrasi secara mendalam ke dalam produk elektronik konsumen seperti peralatan rumah tangga, ponsel, dan PC, menekankan implementasi praktis dan pengalaman ‘tanpa terasa’. (Sumber: 36氪)

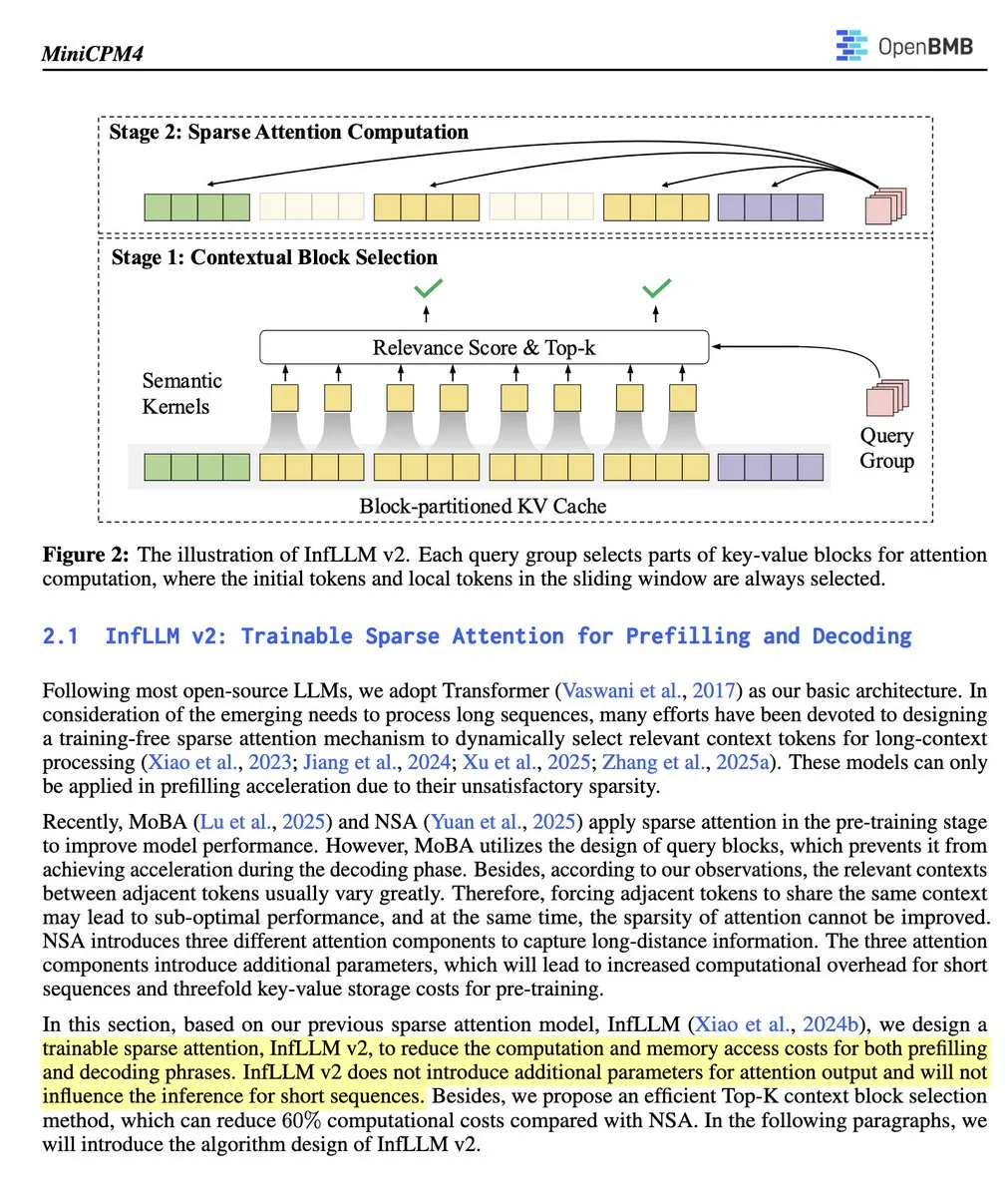

OpenBMB merilis MiniCPM 4.1-8B, LLM inferensi sparse attention yang dapat dilatih dan open-source pertama: OpenBMB telah merilis model MiniCPM 4.1-8B, LLM inferensi open-source pertama yang menggunakan sparse attention yang dapat dilatih. Model ini mengungguli model seukuran dalam 15 tugas, meningkatkan kecepatan inferensi 3 kali lipat, dan mengadopsi arsitektur yang efisien. Ini menandai kemajuan penting dalam kemampuan inferensi dan efisiensi model open-source, menyediakan alat baru yang kuat bagi para peneliti. (Sumber: teortaxesTex)

🧰 Alat

Open Instruct: Codebase penelitian RL berkinerja tinggi: Open Instruct, yang dikelola oleh AllenAI, adalah codebase penelitian Reinforcement Learning (RL) berkinerja tinggi, yang bertujuan untuk menyediakan implementasi RL yang mudah dimodifikasi dan berkinerja unggul. Proyek ini, dipimpin oleh Finbarr dan lainnya, terus ditingkatkan, menyediakan platform dasar bagi para peneliti untuk melakukan eksperimen dan pengembangan RL. (Sumber: source, source)

Grok: Pemahaman dan ringkasan pembaca PDF: Grok dari xAI meluncurkan fitur pembaca PDF, memungkinkan pengguna menyorot bagian mana pun dan mengklik ‘jelaskan’ untuk memahami konten, atau mengklik ‘kutip’ untuk mengajukan pertanyaan spesifik. Ini secara signifikan meningkatkan efisiensi dan kedalaman pemahaman pengguna dalam memproses dokumen PDF yang panjang. (Sumber: source, source)

Devin AI: Analis data untuk EightSleep: Devin AI dari Cognition digunakan oleh tim EightSleep sebagai analis data, menangani berbagai tugas mulai dari ‘anomali digital’ hingga kueri data ad-hoc, mempersingkat waktu penyelesaian analisis/dashboard dari beberapa hari menjadi beberapa jam, secara signifikan meningkatkan efisiensi wawasan data. Ini menunjukkan potensi aplikasi yang kuat dari agen AI di bidang analisis data perusahaan. (Sumber: cognition)

Fungsi sub-agen Claude Code dijelaskan secara detail: Claude Code, melalui alat Task-nya, memungkinkan pengguna membuat tiga jenis sub-agen khusus: agen umum, pengaturan baris status, dan pengaturan gaya output. Sub-agen ini memiliki set alat masing-masing untuk menangani tugas-tugas kompleks, mengkonfigurasi pengaturan, atau membuat gaya output. Sub-agen bersifat stateless, mengeksekusi sekali dan mengembalikan hasil, cocok untuk mendelegasikan pencarian kompleks, analisis, atau konfigurasi khusus untuk menjaga fokus percakapan utama. (Sumber: Vtrivedy10)

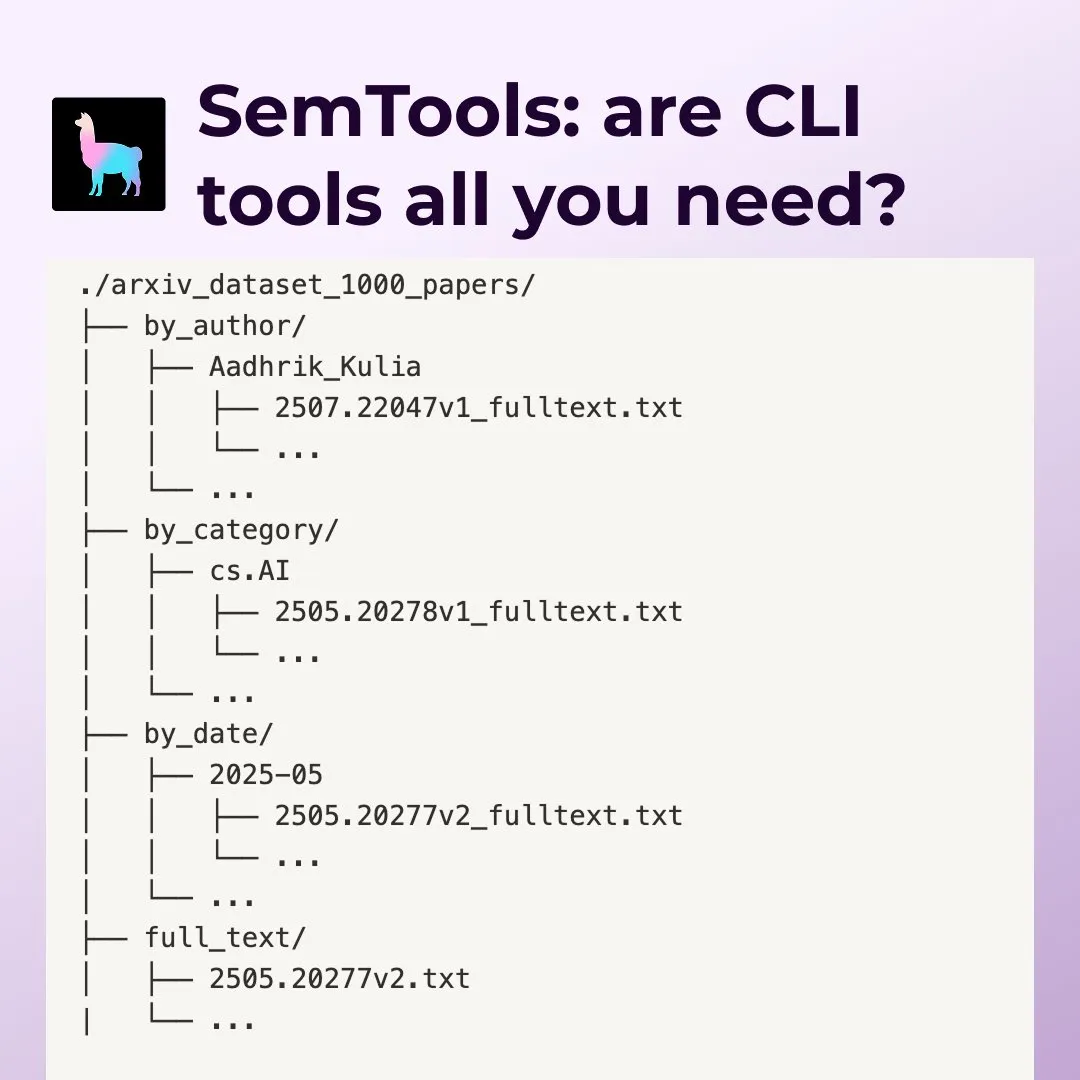

LlamaIndex SemTools: Alat pencarian dan analisis dokumen untuk Agent baris perintah: LlamaIndex merilis SemTools, sebuah toolkit CLI untuk parsing dan pencarian semantik. Menggabungkan alat Unix dan kemampuan pencarian semantik, Agent dapat memproses dokumen kompleks secara efisien, memberikan jawaban yang lebih detail dan akurat, mencakup tugas-tugas seperti pencarian, referensi silang, dan analisis waktu. Ini menunjukkan bahwa menggabungkan alat Unix yang ada dengan pencarian semantik dapat menciptakan pekerja pengetahuan yang kuat. (Sumber: source, source)

Replit Agent: Asisten pengkodean AI dari Prompt hingga aplikasi produksi: Replit Agent merayakan ulang tahun pertamanya, alat ini telah berkembang dari penyelesaian kode AI awal dan pengeditan obrolan, hingga mampu mengubah prompt langsung menjadi aplikasi tingkat produksi. Replit menekankan kemampuannya untuk mengotomatiskan pengaturan lingkungan pengembangan, instalasi paket, konfigurasi database, dan deployment, bertujuan untuk merevolusi proses pengembangan perangkat lunak. (Sumber: source, source)

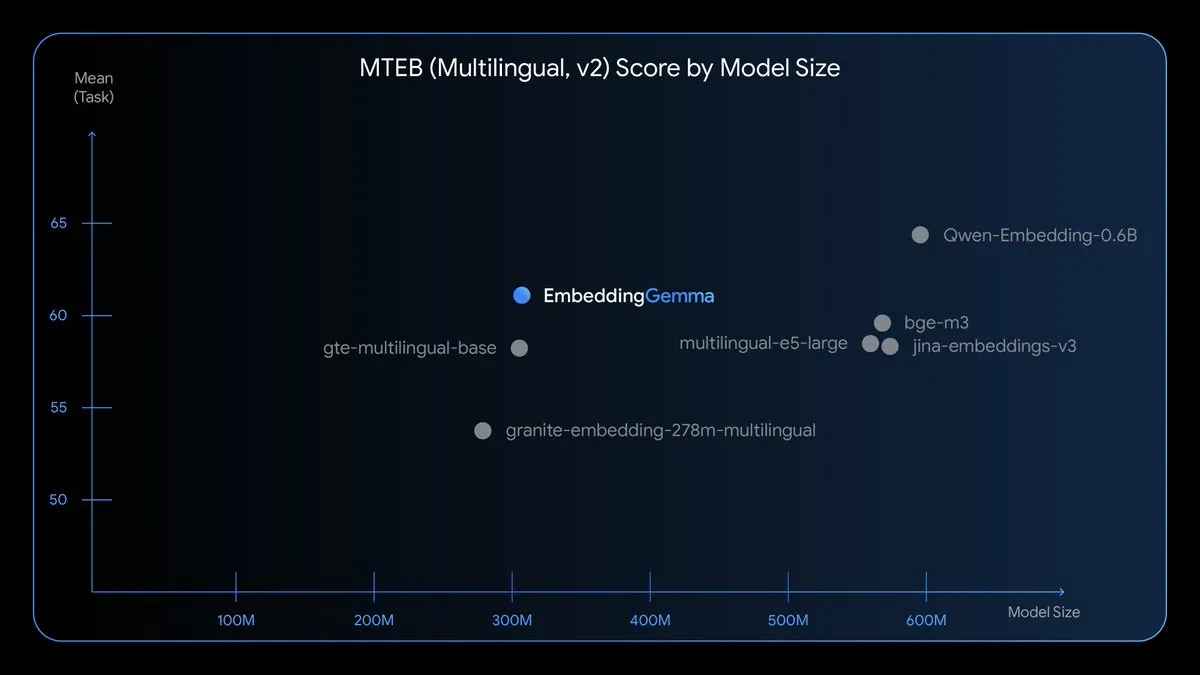

EmbeddingGemma: Model embedding multilingual di perangkat: EmbeddingGemma adalah model embedding multilingual open-source baru dengan 308M parameter, dilatih berdasarkan Gemma 3, mendukung lebih dari 100 bahasa. Model ini dioptimalkan untuk kecepatan, privasi, dan efisiensi, dapat berjalan secara offline, dengan penggunaan memori kurang dari 200MB dan waktu inferensi kurang dari 15ms, memungkinkan RAG, pencarian semantik, dan klasifikasi di perangkat. (Sumber: TheTuringPost)

Nano Banana Hackathon: Tantangan AI generatif: Kaggle akan menyelenggarakan Nano Banana Hackathon, menawarkan hadiah $400.000, dan membuka Gemini API untuk penggunaan gratis Gemini 2.5 Flash Image. Peserta akan berkreasi menggunakan teknologi AI generatif dalam 48 jam, dan kompetisi akan mengevaluasi inovasi, eksekusi teknis, dampak, dan efek presentasi. (Sumber: source, source, source)

📚 Pembelajaran

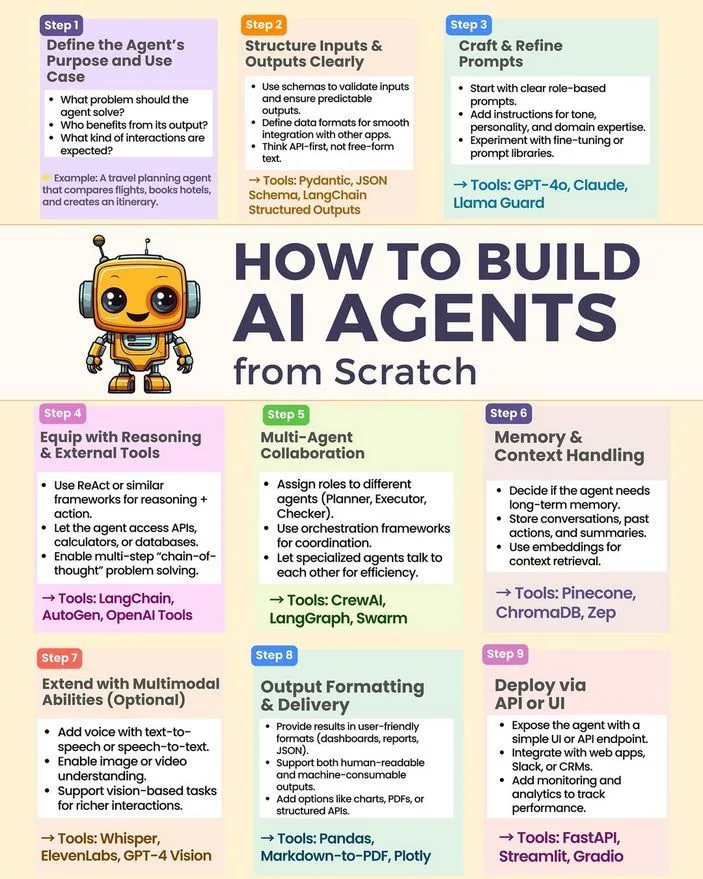

Cara membangun AI Agent dari nol: Python_Dv membagikan tutorial dan panduan untuk membangun AI Agent dari awal, mencakup teknologi kunci seperti LLM, AI generatif, dan machine learning. Sumber daya ini menyediakan jalur awal bagi pengembang untuk mempraktikkan pengembangan AI Agent. (Sumber: Ronald_vanLoon)

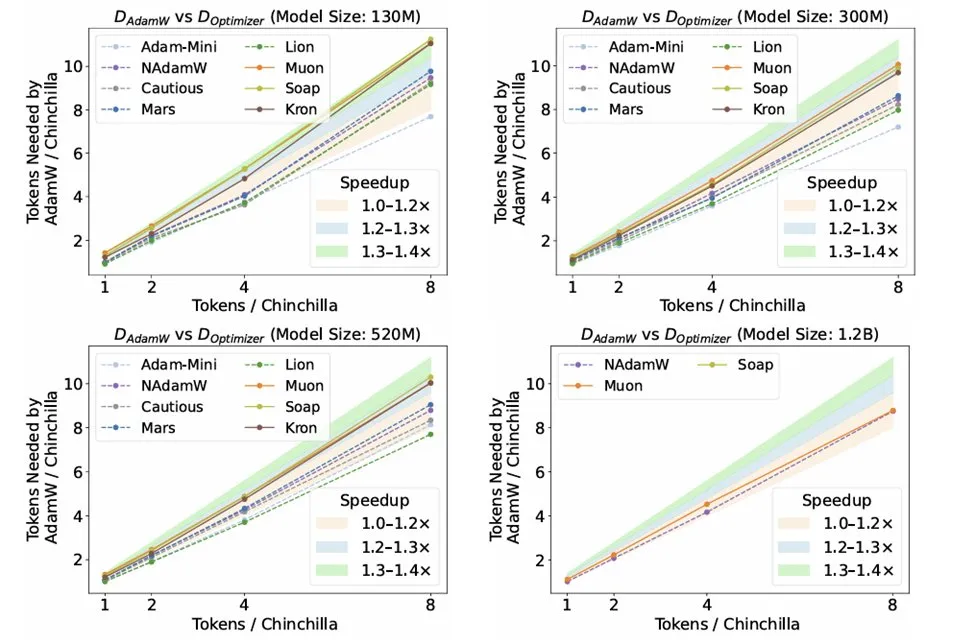

Penelitian optimizer dalam inferensi LLM: Makalah penelitian ‘Fantastic Pretraining Optimizers and Where to Find Them’ oleh Kaiyue Wen et al. melakukan benchmark yang ketat terhadap 10 optimizer. Studi tersebut menemukan bahwa meskipun optimizer seperti Muon dan Mars menarik perhatian, setelah penyesuaian hyperparameter yang ketat dan peningkatan skala, efek akselerasinya dibandingkan AdamW hanya sekitar 10%. Ini menekankan perlunya berhati-hati terhadap masalah penyetelan baseline yang tidak memadai atau skala yang terbatas saat mengevaluasi optimizer baru. (Sumber: source, source, source)

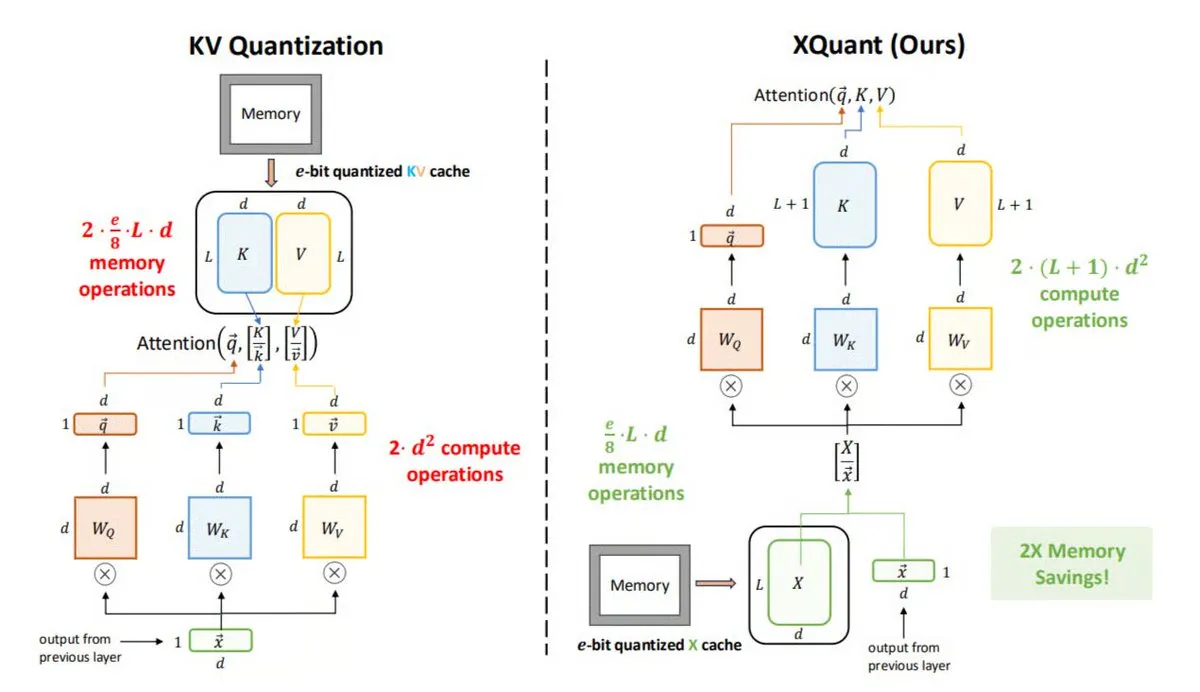

Teknologi optimasi memori XQuant dalam inferensi LLM: UC Berkeley mengusulkan XQuant, metode optimasi memori LLM baru yang dapat mengurangi penggunaan memori hingga 12 kali lipat. XQuant tidak menyimpan cache KV tradisional, melainkan mengkuantisasi dan menyimpan aktivasi input lapisan (X), kemudian meregenerasi Key dan Value sesuai permintaan dari X selama inferensi. Teknologi ini, dengan sedikit peningkatan komputasi, mencapai inferensi yang lebih cepat dan efisien tanpa mengorbankan akurasi. (Sumber: TheTuringPost)

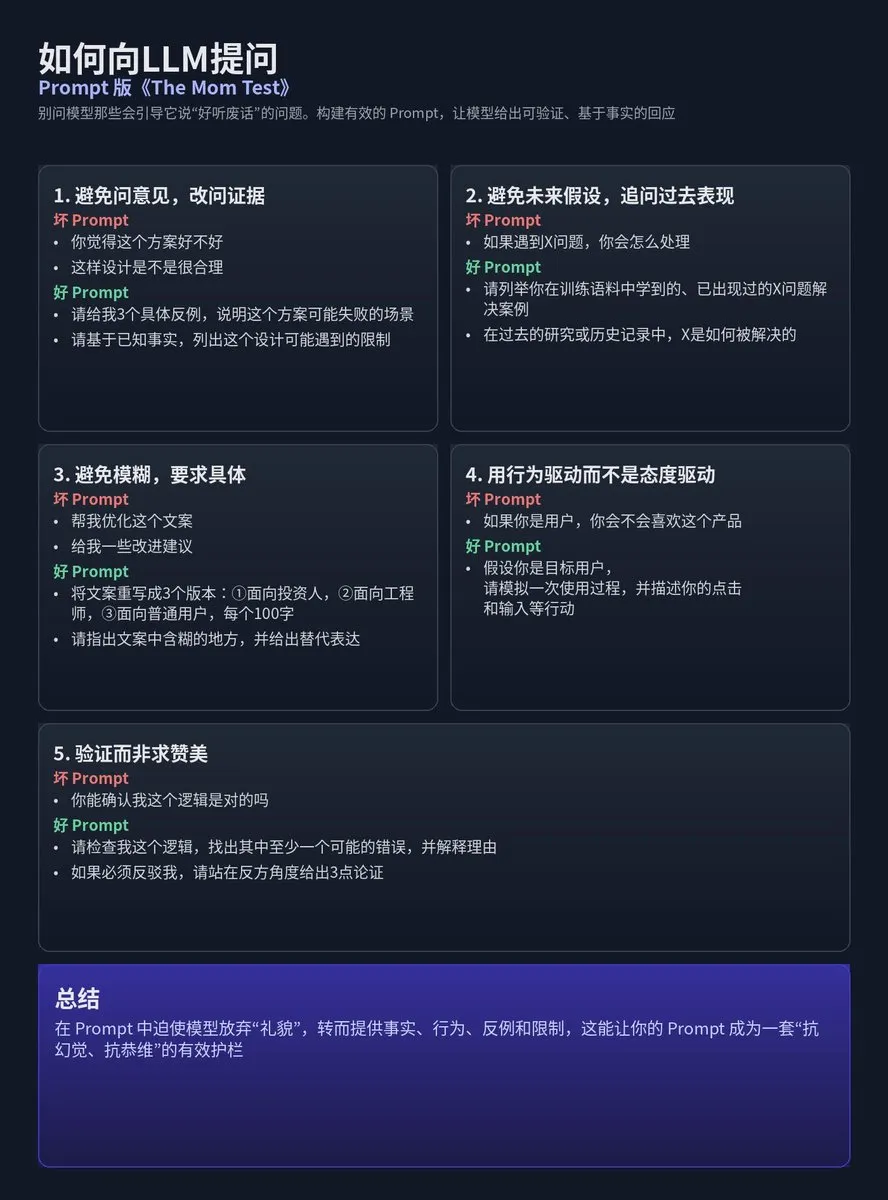

Desain prompt LLM: Metodologi Mom Test: Tz membagikan metodologi penerapan ide riset pengguna ‘Mom Test’ pada desain prompt LLM, menekankan untuk menghindari pertanyaan yang akan menghasilkan ‘omong kosong yang enak didengar’ dari model, melainkan menyusun Prompt agar model memberikan respons yang dapat diverifikasi, berbasis fakta, atau dengan batasan yang jelas. Intinya adalah menghindari opini, asumsi masa depan, dan ambiguitas, serta menuntut spesifik, berbasis perilaku, dan verifikasi daripada pujian. (Sumber: dotey)

Teknologi kompresi AI 300 kali lebih baik dari metode tradisional: Saluran YouTube Two Minute Papers menunjukkan bahwa teknologi kompresi AI 300 kali lebih efisien daripada metode kompresi tradisional, tetapi saat ini belum banyak digunakan. Video tersebut mungkin membahas teknologi mesin fisika seperti WaveBlender dari NVIDIA, menunjukkan potensi besar AI dalam kompresi data, serta aplikasinya dalam simulasi audio. (Sumber: , source)

Tantangan Superintelligence Multimodal NeurIPS 2025: Lambda Research mengundang peneliti, insinyur, dan penggemar AI untuk berpartisipasi dalam NeurIPS 2025 Grand Challenge on Multimodal Superintelligence, yang bertujuan untuk mendorong pengembangan machine learning multimodal open-source. Tim peserta akan memiliki kesempatan untuk memenangkan hingga $20.000 dalam kredit komputasi, bersama-sama membangun AI multimodal open-source masa depan. (Sumber: Reddit r/deeplearning)

Panduan beranotasi lengkap untuk Diffusion Models: Komunitas Reddit membagikan panduan beranotasi komprehensif tentang ‘Apa itu Diffusion Models?’. Panduan ini menyediakan sumber daya bagi pelajar untuk memahami secara mendalam prinsip dan aplikasi diffusion models, membantu menguasai teknologi AI generatif terdepan ini. (Sumber: Reddit r/deeplearning)

Penerapan LoRA/QLoRA dalam pelatihan multi-GPU LLM visual: Komunitas membahas tantangan dan praktik LoRA/QLoRA dalam melatih LLM visual besar (seperti Llama 3.2 90B Visual Instruct) di lingkungan multi-GPU. Karena skala model yang besar, tidak dapat berjalan pada satu GPU, pengembang sedang mencari framework/paket yang mendukung pelatihan multi-GPU. LoRA/QLoRA, karena karakteristik fine-tuning yang efisien, sangat diharapkan, tetapi penerapannya dalam skenario tertentu masih perlu dieksplorasi lebih lanjut. (Sumber: source, source)

💼 Bisnis

OpenAI mengakuisisi tim Alex yang didukung Y Combinator: OpenAI mengakuisisi tim Alex, startup yang didukung Y Combinator, yang akan bergabung dengan tim Codex OpenAI untuk fokus pada asisten pengkodean AI. Pendiri Alex, Daniel Edrisian, menyatakan bahwa mereka berhasil membangun agen pengkodean terkemuka untuk aplikasi iOS dan macOS, dan akuisisi ini akan memungkinkan pekerjaan mereka berlanjut dalam skala yang lebih besar. (Sumber: The Verge)

Baseten menyelesaikan pendanaan Seri D $150 juta, fokus pada masa depan inferensi AI: Baseten menyelesaikan putaran pendanaan Seri D senilai $150 juta. CEO Tuhin One menunjukkan bahwa dengan penurunan harga token, biaya inferensi akan terus berkurang, mengindikasikan bahwa pasar inferensi AI akan mengalami pertumbuhan skala yang lebih besar. Baseten berkomitmen untuk membangun infrastruktur inferensi AI yang ada di mana-mana untuk mendukung aplikasi AI yang luas di berbagai industri. (Sumber: basetenco)

RecallAI menyelesaikan pendanaan Seri B $38 juta, mempercepat layanan pencatatan rapat AI: RecallAI mengumumkan penyelesaian putaran pendanaan Seri B senilai $38 juta, dipimpin oleh BessemerVP, dengan partisipasi dari HubSpot Ventures dan SalesforceVC. RecallAI menyediakan layanan API perekaman rapat, telah melayani lebih dari 2000 perusahaan, dan pendanaan ini akan mempercepat ekspansinya di bidang pencatatan rapat AI, lebih lanjut mengkonsolidasikan posisi pasarnya. (Sumber: blader)

🌟 Komunitas

Nilai dan kontroversi evaluasi AI (Evals): Komunitas terlibat dalam diskusi sengit seputar kebutuhan dan metode evaluasi AI (Evals), membahas perannya dalam aplikasi tingkat perusahaan, komplementaritasnya dengan A/B testing, dan pentingnya ilmu data dalam rekayasa AI. Beberapa berpendapat bahwa Evals adalah kunci untuk memahami kinerja sistem AI dan optimasi iteratif, sementara yang lain percaya bahwa ketergantungan berlebihan pada Evals dapat mengarah pada ‘pseudosains’. (Sumber: source, source)

Kualitas pengkodean AI dan keterbatasan ‘Vibe Coding’: Pengembang membahas pro dan kontra pembuatan kode AI, menunjukkan bahwa AI unggul dalam prototyping cepat, menangani boilerplate code, dan menulis tes, tetapi kode yang dihasilkan sering dikritik karena bertele-tele, terlalu defensif, dan kurang kemampuan refactoring. Banyak pengembang percaya bahwa untuk kode yang membutuhkan pemeliharaan jangka panjang, penulisan manual masih lebih unggul daripada ‘Vibe Coding’ yang dihasilkan AI. (Sumber: source, source)

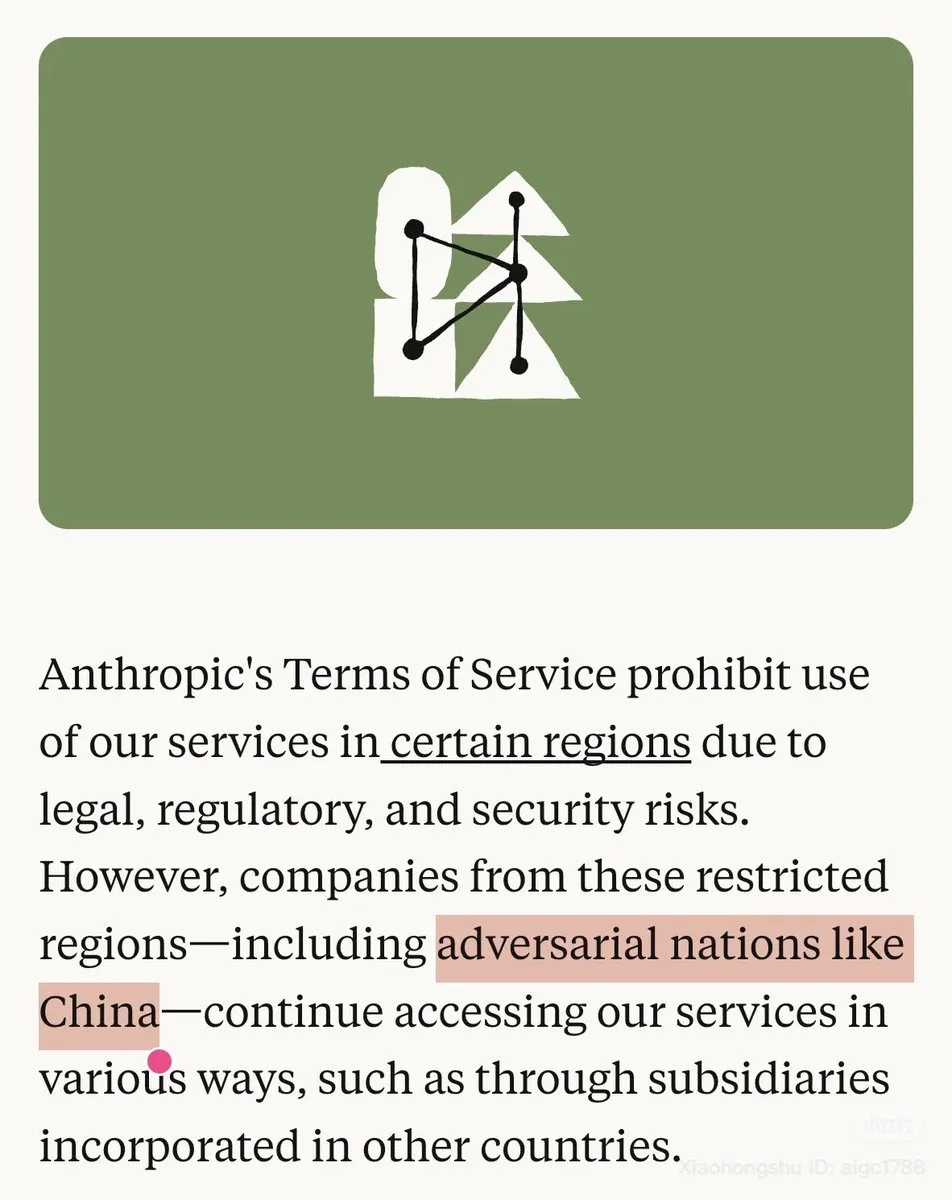

Kebijakan Anthropic terhadap Tiongkok dan kontroversi ketersediaan model: Anthropic secara eksplisit menandai Tiongkok sebagai ‘negara musuh’ di blognya dan membatasi penggunaan Claude di wilayah tertentu, memicu ketidakpuasan yang kuat di komunitas. Pada saat yang sama, model Opus 4.1 dari Claude.ai juga sementara tidak tersedia, memperburuk kekhawatiran pengguna tentang stabilitas model dan kebijakan perusahaan, dengan banyak pengguna Tiongkok menyatakan akan beralih ke OpenAI Codex. (Sumber: source, source)

Interaksi AI dengan politik dan kekhawatiran regulasi: Para pemimpin teknologi seperti Sam Altman dan Lisa Su memuji kebijakan pro-bisnis dan pro-inovasi pemerintahan Trump pada jamuan makan malam Gedung Putih, memicu diskusi tentang interaksi perusahaan AI dengan kekuatan politik dan prospek aplikasi AI di bidang pendidikan. Pada saat yang sama, FTC akan menyelidiki dampak perusahaan AI terhadap anak-anak, mencerminkan kekhawatiran regulator terhadap potensi risiko sosial teknologi AI. (Sumber: source, source)

Kemampuan AI Agent dan tantangan pengembangan: Komunitas membahas kemampuan inti yang dibutuhkan oleh AI Agent, termasuk kebutuhan akan konteks super panjang dan interpretasi Agent. Insinyur AI melaporkan bahwa dalam proses agen AI menghasilkan kode, mengevaluasi eksekusi, dan model berpikir, alur kerja menjadi sangat terfragmentasi, menyebabkan banyak waktu terbuang untuk menunggu, menjadi salah satu pengalaman paling membuat frustrasi di era AI. (Sumber: source, source)

Dampak AI terhadap pekerjaan, UBI, dan distribusi kekayaan sosial: Komunitas ramai membahas dampak AI terhadap pasar kerja, perlunya Universal Basic Income (UBI), dan kekhawatiran bahwa AI dapat memperburuk kesenjangan kekayaan. Para ahli seperti ilmuwan komputer Geoffrey Hinton percaya bahwa AI akan membuat segelintir orang lebih kaya dan mayoritas lebih miskin, memicu diskusi mendalam tentang keadilan sosial teknologi AI, dampak pekerjaan, dan redistribusi kekayaan. (Sumber: source, source)

Penurunan kinerja model AI dan pengalaman pengguna: Banyak pengguna mengeluhkan penurunan kinerja ChatGPT yang signifikan baru-baru ini, ditandai dengan peningkatan halusinasi, penolakan untuk menjawab pertanyaan tertentu, kurangnya empati yang tulus, dan batasan sensor konten. Pada saat yang sama, masalah ‘berpura-pura bodoh’ pada chatbot AI juga memicu ketidakpuasan, dengan anggapan bahwa hal itu mungkin disebabkan oleh batasan kebijakan perusahaan, bukan kurangnya kemampuan sebenarnya, yang mengakibatkan pengalaman pengguna yang buruk. (Sumber: source, source)

Kualitas konten yang dihasilkan AI dan persepsi publik: Komunitas membahas pandangan negatif masyarakat terhadap konten yang dihasilkan AI, sering disebut ‘AI Slop’ (sampah AI), mencerminkan kekhawatiran akan penyalahgunaan AI, kualitas yang bervariasi, dan devaluasi kreativitas manusia. Pada saat yang sama, teknologi AI generatif juga menantang era fotografi sebagai bukti yang dapat diandalkan, memicu diskusi tentang deepfake dan keaslian informasi. (Sumber: source, source)

Etika AI dan perilaku pengguna: Bersikap baik kepada AI: Komunitas membahas apakah pengguna menjadi lebih kasar saat berinteraksi dengan asisten AI karena ‘penyesuaian’ tanpa syarat, dan apakah pola interaksi ini akan berdampak negatif pada komunikasi dengan manusia. Banyak yang berpendapat bahwa, meskipun AI tidak memiliki emosi, menjaga kesopanan adalah demi kesehatan mental diri sendiri dan untuk menghindari kebiasaan buruk menyebar ke hubungan antarmanusia di kehidupan nyata. (Sumber: Reddit r/ClaudeAI)

Kesadaran AI dan batas filosofis kecerdasan: Komunitas membahas pertanyaan filosofis apakah AI memiliki kesadaran atau ‘kehidupan’, mengutip contoh robot Johnny 5 dari film ‘Short Circuit’ yang dinilai ‘hidup’ karena memahami humor. Mayoritas berpendapat bahwa pemahaman humor oleh AI adalah manifestasi kecerdasan, tetapi bukan bukti kehidupan atau kesadaran, dan keterbatasan Turing Test terletak pada ketidakmampuannya untuk memverifikasi ‘pengalaman internal’ AI. (Sumber: Reddit r/ArtificialInteligence)

Manajemen komunitas LocalLLaMA dan kontroversi generalisasi AI: Komunitas LocalLLaMA di Reddit meluncurkan tag baru ‘local only’, yang mengharuskan postingan terkait teknologi LLM lokal menggunakan tag ini untuk menyaring ‘kebisingan’ seperti model non-lokal dan biaya API. Langkah ini memicu reaksi keras dari komunitas, dengan banyak pengguna berpendapat bahwa ini bertentangan dengan niat awal komunitas ‘local first’, sementara diskusi tentang ‘sistem AI umum adalah kebohongan’ juga mencerminkan keraguan terhadap kemampuan generalisasi dan keandalan AI. (Sumber: source, source)

Persaingan pasar komputasi GPU dan jalur pengembangan AI: Komunitas membahas persaingan ketat di pasar komputasi GPU, dengan penyedia layanan cloud yang baru muncul perlu meningkatkan daya saing. Pada saat yang sama, kemajuan AI tidak sepenuhnya didorong oleh daya komputasi; efisiensi pembelajaran dan arsitektur non-Transformer dapat membawa lompatan eksponensial berikutnya, memicu pemikiran tentang jalur pengembangan AI di masa depan. Ada juga pandangan yang menunjukkan bahwa kemajuan AI tidak sepenuhnya didorong oleh daya komputasi; efisiensi pembelajaran dan arsitektur non-Transformer dapat membawa lompatan eksponensial berikutnya. (Sumber: source, source)

💡 Lain-lain

India menggunakan robot untuk membersihkan saluran pembuangan, mengatasi dilema pembersihan manual: Pemerintah Delhi, India, sedang mendorong penggunaan robot untuk menggantikan pembersihan saluran pembuangan secara manual, untuk mengatasi masalah ‘pembersihan manual’ yang telah lama ada. Meskipun praktik ini telah dilarang sejak tahun 1993, namun masih banyak dilakukan dan berbahaya. Beberapa perusahaan telah menyediakan solusi teknologi alternatif, termasuk robot dengan berbagai tingkat kompleksitas, yang bertujuan untuk meningkatkan keselamatan dan martabat kerja. (Sumber: MIT Technology Review)

Penelitian menggunakan ‘robot tikus’ untuk mensimulasikan perilaku tikus sungguhan: Para peneliti sedang mengembangkan ‘robot tikus’ yang bertujuan untuk mempelajari biologi dan ilmu saraf secara mendalam dengan mensimulasikan perilaku tikus sungguhan. Proyek ini menggabungkan robotika, machine learning, dan kecerdasan buatan, menyediakan platform eksperimental baru untuk memahami perilaku hewan. (Sumber: Ronald_vanLoon)

AI merekonstruksi film Orson Welles yang hilang, ‘The Magnificent Ambersons’: Tim Fable Simulation sedang menggunakan teknologi AI untuk merekonstruksi, secara non-komersial dan akademis, 43 menit yang hilang dari mahakarya Orson Welles yang hilang, ‘The Magnificent Ambersons’. Proyek ini menunjukkan potensi AI dalam restorasi film dan pelestarian warisan seni, diharapkan dapat memungkinkan penonton untuk kembali merasakan karya klasik yang belum selesai ini. (Sumber: source, source)