Kata Kunci:Insinyur xAI, OpenAI, pencurian kode, kekayaan intelektual, persaingan industri, model AI, pasar GPU, etika AI, Insinyur xAI pindah ke OpenAI, GPU Huawei 96GB VRAM, model LongCat-Flash-Chat Meituan, aplikasi AI di bidang keuangan, tantangan teknologi AI Agent

🔥 FOKUS

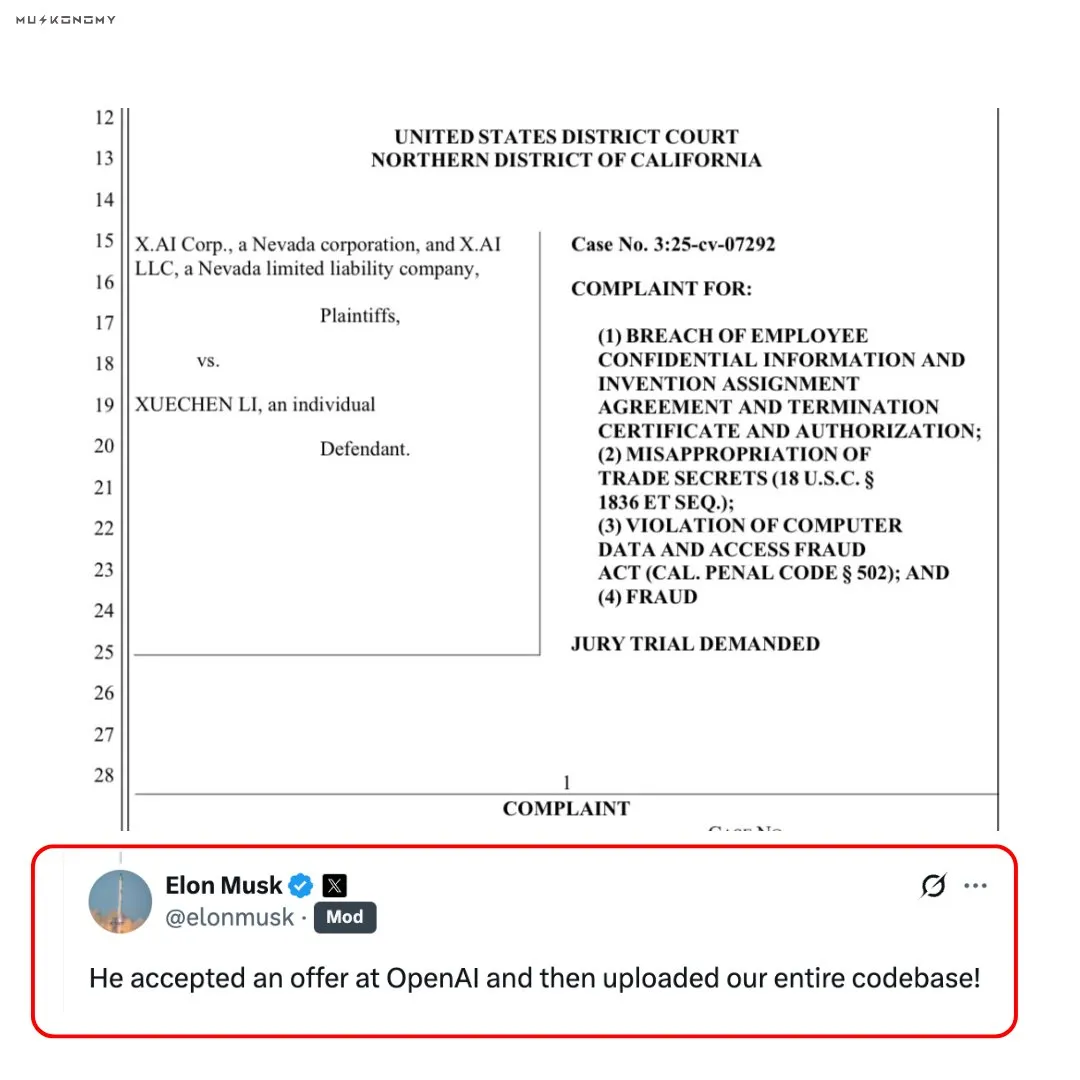

Kontroversi Insinyur xAI Pindah ke OpenAI dan Mencuri Kode : Elon Musk mengonfirmasi bahwa seorang mantan insinyur xAI mengunggah seluruh basis kode xAI setelah bergabung dengan OpenAI. Insinyur tersebut sebelumnya telah menjual saham xAI senilai 7 juta USD. Insiden ini memicu diskusi sengit mengenai pencurian kekayaan intelektual dan etika persaingan industri, memberikan dampak mendalam pada hubungan kompetitif antara OpenAI dan xAI. Di media sosial, kebenaran dan aspek moral dari insiden ini dipertanyakan dan dikomentari secara luas. (Sumber: scaling01, teortaxesTex, Reddit r/ChatGPT)

🎯 PERKEMBANGAN

Peluncuran Model Nous Hermes 4 : Nous Research meluncurkan Hermes 4, sebuah “model penalaran” hibrida yang mampu beralih antara respons cepat dan pemikiran mendalam melalui label sederhana. Model ini dilatih dengan data 50 kali lebih banyak dari versi sebelumnya, memiliki bias anti-penjilat bawaan, dan menunjukkan kinerja luar biasa dalam benchmark SpeechMap. (Sumber: Teknium1, Teknium1, Teknium1)

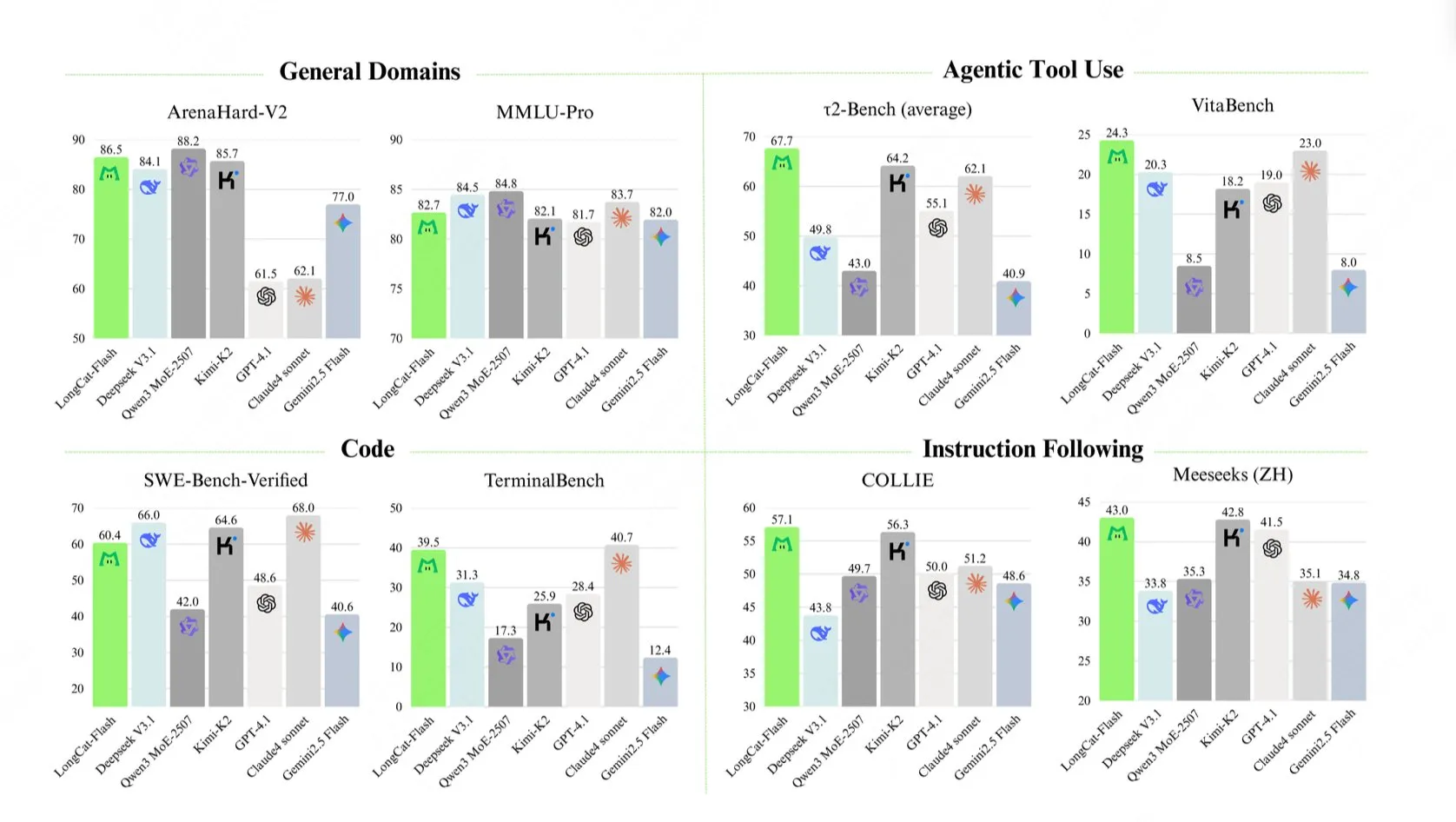

Peluncuran Model Besar Meituan LongCat-Flash-Chat : Meituan meluncurkan LongCat-Flash-Chat, sebuah model bahasa dengan total 560 miliar parameter. Mekanisme komputasi dinamisnya dapat mengaktifkan 18,6 miliar hingga 31,3 miliar parameter (rata-rata sekitar 27 miliar) sesuai kebutuhan konteks, dengan kecepatan inferensi lebih dari 100 tokens/detik, dan menunjukkan kinerja luar biasa dalam benchmark seperti TerminalBench dan τ²-Bench. (Sumber: reach_vb, teortaxesTex, bigeagle_xd, Reddit r/LocalLLaMA)

Huawei Meluncurkan GPU VRAM 96GB Berkinerja Tinggi : Huawei dilaporkan telah menguasai 70% pangsa pasar GPU VRAM 96GB kelas 4090, dengan harga jual hanya 1887 USD. Ini menandai terobosan penting bagi Tiongkok di pasar GPU, berpotensi memecahkan monopoli NVIDIA dan menyediakan pilihan perangkat keras yang lebih hemat biaya untuk pelatihan LLM lokal, meskipun kompatibilitas perangkat lunak tetap menjadi fokus perhatian. (Sumber: scaling01, Reddit r/LocalLLaMA)

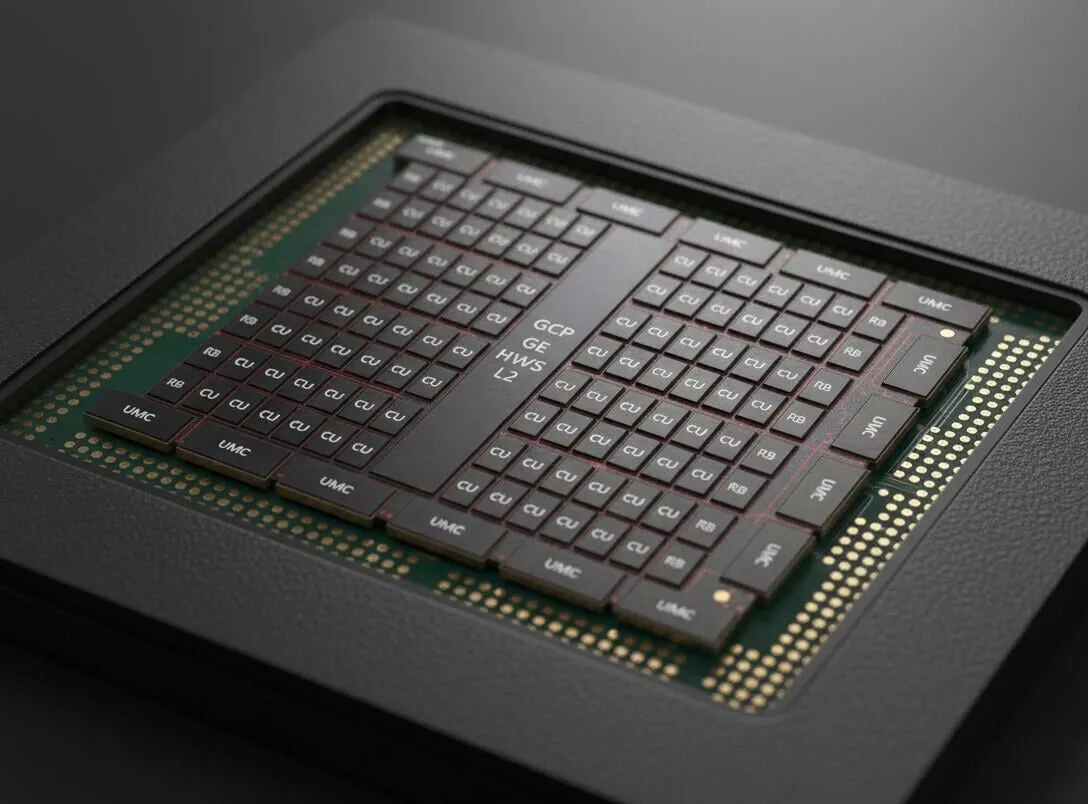

Produk Memori Terpadu Generasi Baru AMD Terungkap : Produk memori terpadu generasi baru AMD yang bocor mengindikasikan penggunaan bus memori 512-bit, dengan bandwidth memori yang diperkirakan mencapai sekitar 512GB/s. Ini dianggap sebagai arah pengembangan perangkat keras LLM di masa depan, yang dikombinasikan dengan VRAM berkecepatan sangat tinggi dan model MoE besar, menandakan peningkatan signifikan dalam kinerja perangkat keras AI. (Sumber: Reddit r/LocalLLaMA)

Peluncuran Model Art-0-8B, Mewujudkan Penalaran yang Dapat Dikontrol : Model eksperimental open-source Art-0-8B, yang disetel ulang berdasarkan Qwen3, telah diluncurkan, untuk pertama kalinya memungkinkan pengguna secara eksplisit mengontrol proses berpikir model melalui prompt, seperti “berpikir dengan lirik rap” atau “mengorganisir ide dengan poin-poin”. Ini memberikan dimensi kontrol baru untuk penalaran AI, meningkatkan kemampuan pengguna untuk menyesuaikan alur kerja internal model. (Sumber: Reddit r/MachineLearning)

Google Gemini Meluncurkan Fitur Baru seperti Penalaran Deep Think : Google Gemini meluncurkan beberapa fitur baru, termasuk paket Pro gratis dan kemampuan penalaran Deep Think, yang bertujuan untuk memberikan pengalaman yang tak tertandingi oleh ChatGPT. Ini menunjukkan bahwa Google secara aktif mengejar dan berinovasi dalam kemampuan model AI dan layanan pengguna. (Sumber: demishassabis)

GPT-5 Berkinerja Unggul dalam Game Werewolf : GPT-5 mencapai tingkat kemenangan 96,7% dalam benchmark game Werewolf, menunjukkan kemampuannya yang kuat dalam penalaran sosial, kepemimpinan, gertakan, dan resistensi terhadap manipulasi. Ini menunjukkan bahwa kinerja LLM dalam skenario sosial yang kompleks dan konfrontatif meningkat pesat. (Sumber: SebastienBubeck)

Kemajuan Terbaru di Bidang Robotics : Teknologi robotika terus berinovasi, termasuk robot humanoid yang mampu merakit sendi secara mandiri, robot Atlas Boston Dynamics yang berperan sebagai fotografer, RoBuild yang menyediakan solusi robotika untuk industri konstruksi, peneliti Beihang yang menciptakan robot mikro berkecepatan super 2cm, Unitree Robotics yang menampilkan tarian robot humanoid, serta robot pemanjat tali dan robot tali semi-otomatis untuk perbaikan bilah turbin angin. Kemajuan ini menunjukkan potensi besar robot dalam otomatisasi, pelaksanaan tugas kompleks, dan aplikasi multi-bidang. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Waktu Mulai Tugas Jarak Jauh Codex Meningkat Secara Signifikan : Waktu mulai tugas jarak jauh Codex dari OpenAI telah meningkat secara signifikan, dengan waktu mulai median berkurang dari 48 detik menjadi 5 detik, sebuah peningkatan 90%. Peningkatan ini terutama berkat pengenalan caching kontainer, yang secara signifikan meningkatkan efisiensi pengembangan dan pengalaman pengguna. (Sumber: gdb)

🧰 ALAT

Model Generasi Gambar Nano Banana Diterapkan Secara Luas : Model Nano Banana menunjukkan potensi besar dalam bidang generasi gambar. Pengguna dapat memanfaatkannya untuk kontrol bentuk wajah yang presisi, menggabungkan pose karakter Tionghoa untuk menghasilkan video tari, membuat diagram pengajaran, bahkan untuk menghasilkan gambar Wiki atau landing page edukasi. Outputnya yang “tanpa nuansa AI” serta kemampuan referensi pose, pencahayaan, dan desain yang stabil mendapat pujian. (Sumber: dotey, dotey, crystalsssup, fabianstelzer, Vtrivedy10, demishassabis, karminski3)

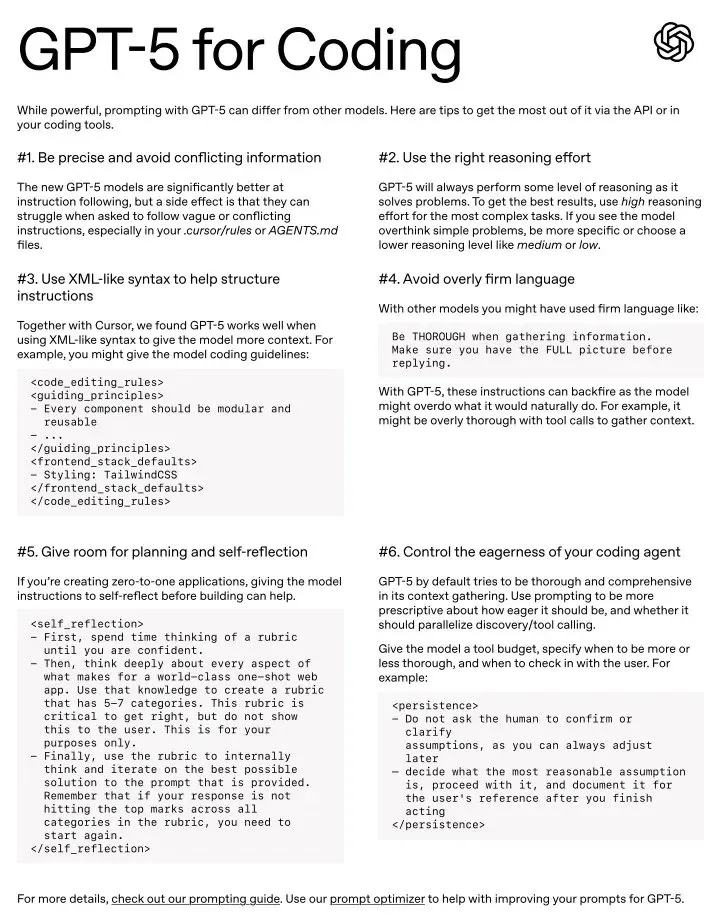

Potensi GPT-5 sebagai Alat Coding Sehari-hari : GPT-5 dianggap sebagai alat coding yang luar biasa, terutama berkinerja sangat baik dengan gaya prompt yang tepat. Meskipun beberapa pengguna menganggapnya mungkin sedikit “akademis” dan membutuhkan prompt yang lebih presisi, model ini dianggap yang terbaik di berbagai bidang, dan memiliki panduan prompt resmi untuk membantu pengguna menguasai enam teknik prompt kuncinya. (Sumber: gdb, kevinweil, gdb, nptacek)

Docuflows Mewujudkan Alur Kerja Agent Tingkat Lanjut untuk Data Keuangan : Jerry Liu menunjukkan bagaimana menggunakan Docuflows untuk membangun alur kerja Agent tingkat lanjut untuk ekstraksi keuangan dalam waktu kurang dari 5 menit, tanpa perlu menulis kode untuk mengurai file 10Q, mengekstrak informasi pendapatan terperinci, dan mengeluarkannya dalam format CSV. Docuflows, sebagai mini-coding agent, memungkinkan definisi alur kerja dokumen menggunakan bahasa alami, dan mengompilasinya menjadi aliran kode multi-langkah yang dapat diperluas. (Sumber: jerryjliu0)

Replit Vibe Coding Mempercepat Transformasi Digital Perusahaan : Hexaware bermitra dengan Replit untuk mempercepat transformasi digital perusahaan melalui Vibe Coding. Replit Agent dan pengalaman pengembangnya dipuji sebagai “pengubah permainan”, memungkinkan non-programmer untuk membangun aplikasi SaaS yang kompleks dalam waktu singkat, sangat meningkatkan efisiensi pengembangan dan kemampuan inovasi. (Sumber: amasad, amasad)

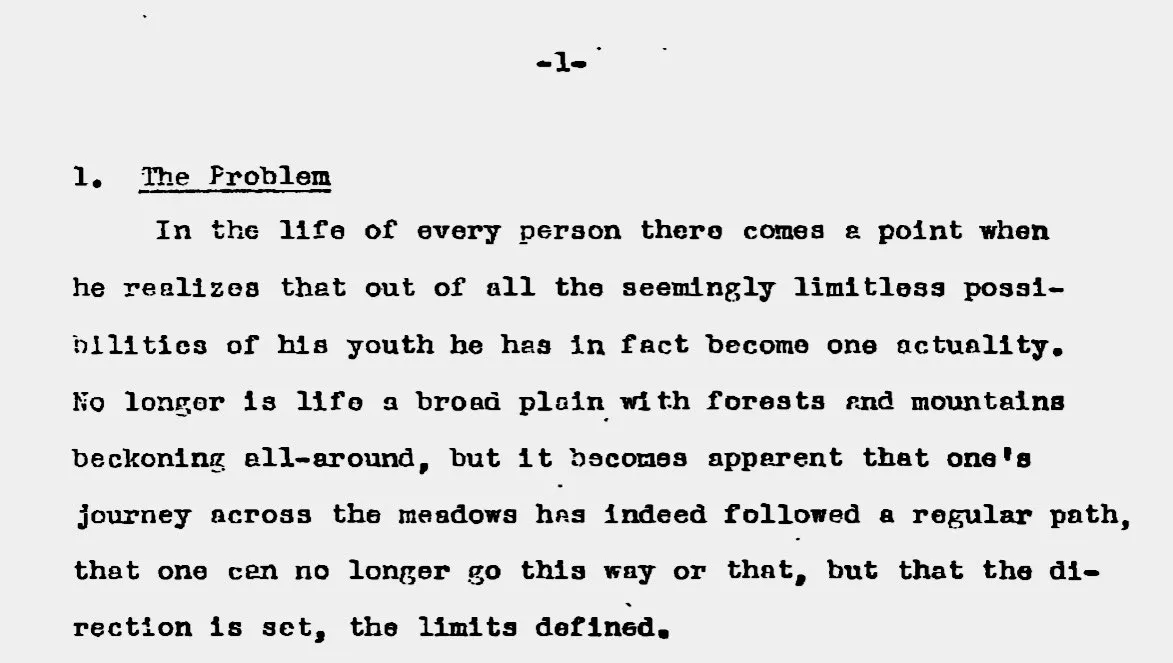

Pemrosesan dan Penelitian Dokumen Berbantuan AI : AI digunakan untuk mengonversi tesis sarjana Henry Kissinger setebal 400 halaman dari PDF yang dipindai ke format Markdown, serta menggunakan sistem multi-Agent untuk memperbaiki catatan kaki, menyisipkan tautan sumber, bahkan menghasilkan peta pikiran dan ringkasan. Ini menunjukkan potensi besar AI dalam memproses dokumen kompleks dan mempercepat penelitian akademis. (Sumber: andrew_n_carr, riemannzeta)

Claude Code Menunjukkan Produktivitas Besar di Bidang Non-Pemrograman : Claude Code digunakan oleh non-programmer untuk memproses file Excel dalam jumlah besar, mengatur dokumen kerja, menganalisis dataset besar, bahkan secara otomatis mencatat catatan harian, mempersingkat pekerjaan yang semula memakan waktu berhari-hari menjadi 30 menit. Pengguna menemukan bahwa ini lebih akurat daripada operasi manual dan dapat membuat alur kerja otomatis yang dapat digunakan kembali, sangat meningkatkan produktivitas pribadi. (Sumber: Reddit r/ClaudeAI)

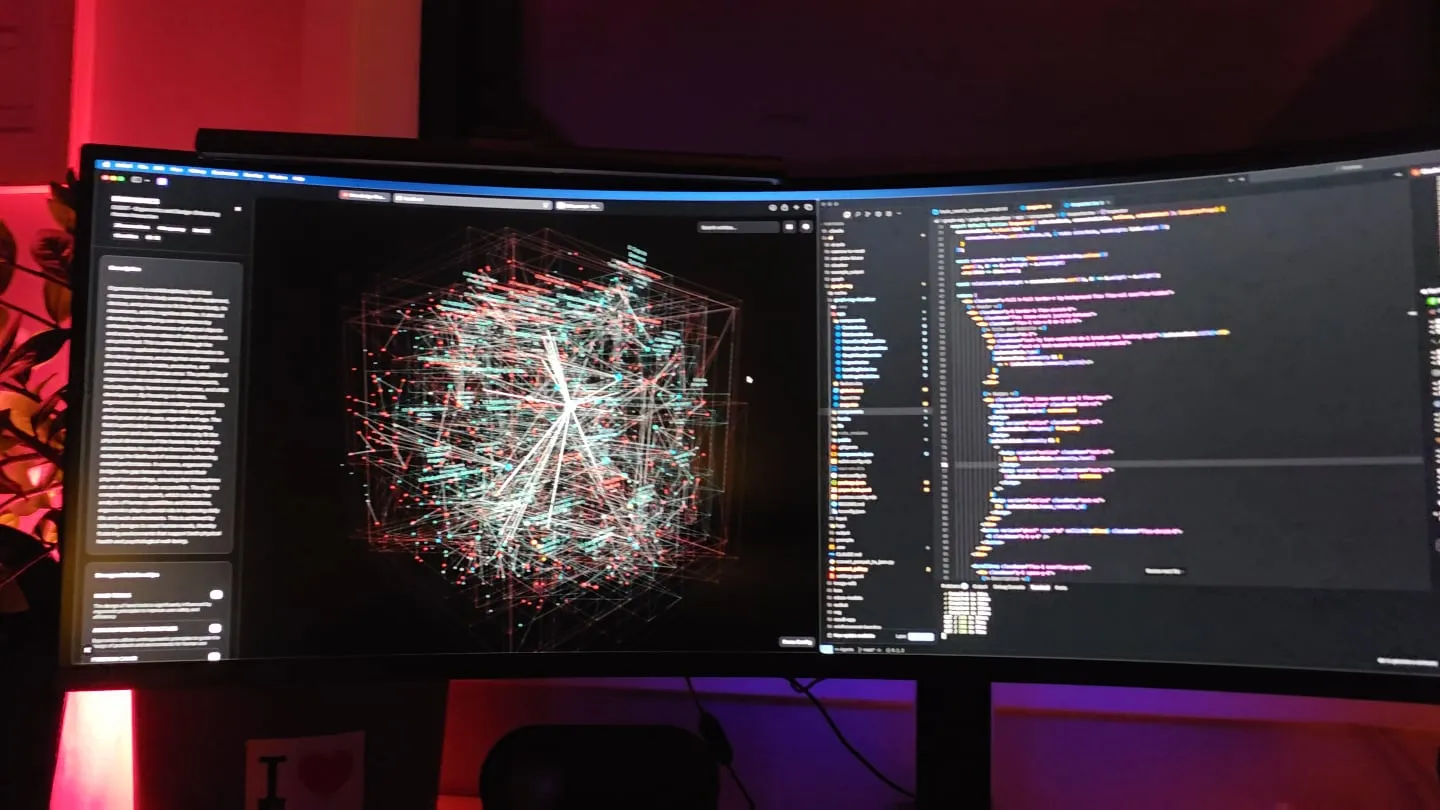

GraphRAG: Peningkatan Retrieval dengan Knowledge Graph : Seorang pengembang secara signifikan meningkatkan kinerja model kecil di bidang tertentu melalui pipeline knowledge graph “nested community” yang menggabungkan pencarian semantik bottom-up dan mekanisme traversal tautan referensi. Metode ini memanfaatkan knowledge graph untuk menyediakan konteks yang lebih komprehensif bagi LLM, secara efektif mengatasi keterbatasan RAG berbasis embedding tradisional, dan menyediakan alat visualisasi untuk membantu pemahaman. (Sumber: Reddit r/LocalLLaMA)

Claude Membantu Pengembangan Game, 400 Ribu Baris Kode dalam 8 Bulan : Seorang pengembang independen menggunakan Claude untuk menyelesaikan versi Alpha dari game kartu roguelike cyberpunk “Hard Reset” dengan 400 ribu baris kode dalam 8 bulan. Claude tidak hanya bertindak sebagai “tim pengembangan tingkat lanjut” untuk menghasilkan kode Dart/Flutter, tetapi juga membantu dalam animasi game, konversi peta, dan generasi audio, menunjukkan kemampuan kuat AI dalam mempercepat pengembangan game dan pembuatan konten. (Sumber: Reddit r/ClaudeAI)

📚 PEMBELAJARAN

Prinsip Inti dan Aplikasi DSPy Framework : Framework DSPy menekankan bahwa manusia hanya perlu menentukan niat dalam bentuk yang paling alami, daripada terlalu bergantung pada pembelajaran penguatan atau optimasi prompt. Prinsip intinya adalah memaksimalkan deklarativitas, menangani berbagai tingkat abstraksi melalui struktur kode, deklarasi bahasa alami terstruktur, dan pembelajaran data/metrik, yang bertujuan untuk menghindari keterbatasan metode tunggal dalam skenario umum. (Sumber: lateinteraction, lateinteraction)

Algoritma KSVD untuk Memahami Embedding Transformer : Sebuah postingan blog dari Stanford AI Lab menjelaskan bagaimana memodifikasi algoritma KSVD yang berusia 20 tahun (khususnya DB-KSVD) agar dapat diperluas secara efektif untuk memahami embedding Transformer. Ini menyediakan metode baru untuk analisis mendalam dan interpretasi model deep learning yang kompleks. (Sumber: dl_weekly)

Kurangnya Investasi di Bidang Information Retrieval dan ColBERTv2 : Secara umum di industri, bidang information retrieval dianggap kurang investasi, terutama dalam hal mesin pencari Web terbuka. Model ColBERTv2, setelah dilatih pada tahun 2021, masih menjadi model utama hingga saat ini, yang sangat kontras dengan iterasi cepat di bidang LLM, menyoroti keterlambatan pengembangan teknologi information retrieval. (Sumber: lateinteraction, lateinteraction)

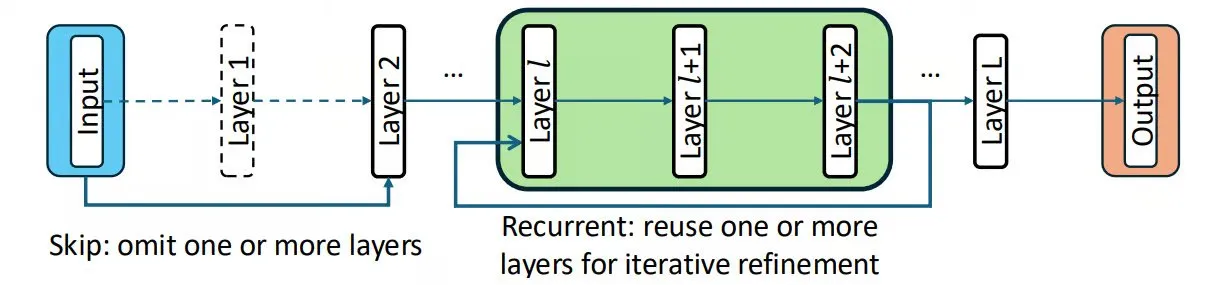

Chain-of-Layers (CoLa) Mewujudkan Kontrol Komputasi Saat Pengujian : CoLa adalah metode untuk mengontrol komputasi saat pengujian dengan memperlakukan lapisan model sebagai blok bangunan yang dapat diatur ulang. Ini memungkinkan penyesuaian versi model berdasarkan input, melewatkan lapisan yang tidak perlu untuk meningkatkan kecepatan, menggunakan kembali lapisan secara rekursif untuk mensimulasikan pemikiran mendalam, dan menyusun ulang lapisan untuk menemukan kombinasi yang lebih optimal, sehingga memanfaatkan lapisan yang telah dilatih sebelumnya secara cerdas tanpa mengubah parameter model. (Sumber: TheTuringPost, TheTuringPost)

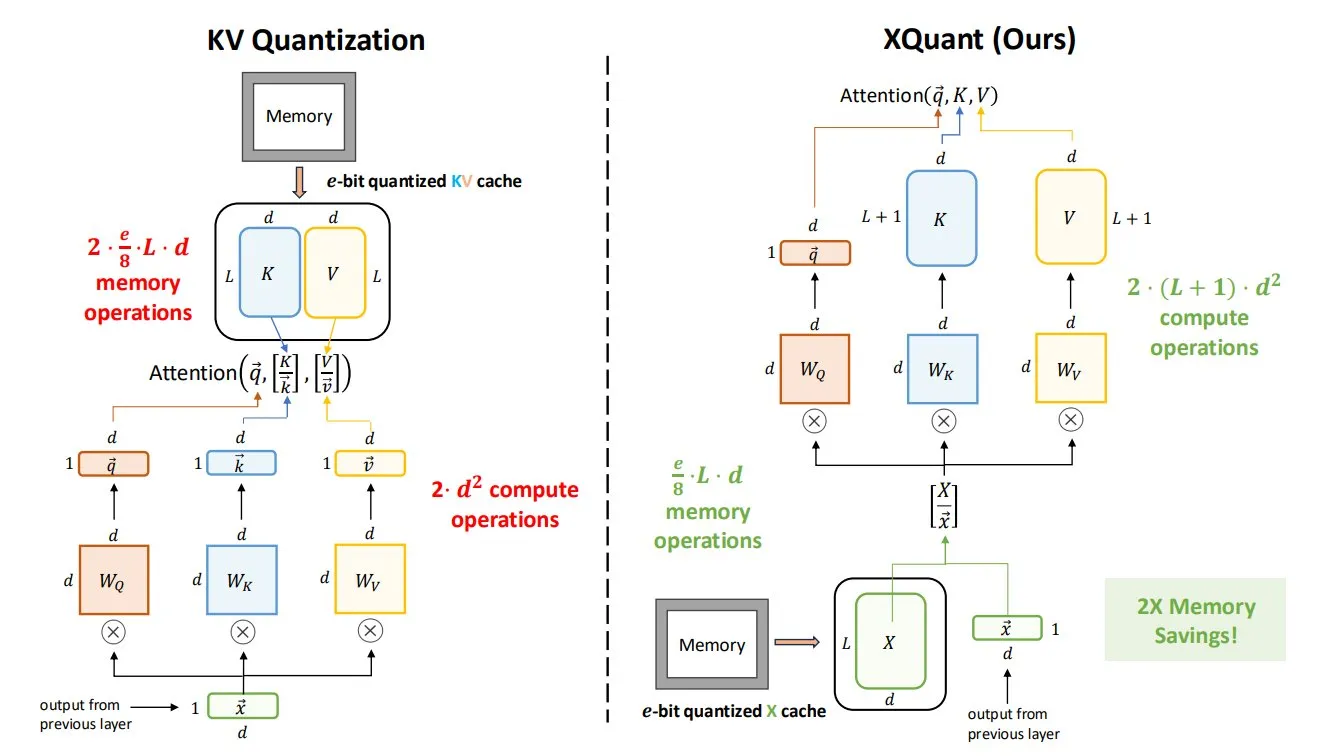

Teknologi XQuant Secara Signifikan Mengurangi Kebutuhan Memori LLM : Teknologi XQuant, yang diusulkan oleh University of California, Berkeley, dapat mengurangi kebutuhan memori LLM hingga 12 kali lipat dengan mengkuantisasi aktivasi input lapisan dan merekonstruksi pasangan kunci-nilai secara instan. Versi lanjutannya, XQuant-CL, menunjukkan kinerja yang sangat baik dalam efisiensi memori, yang sangat penting untuk deployment dan pengoperasian LLM besar. (Sumber: TheTuringPost, TheTuringPost)

Teknik Kompresi dalam Optimasi LLM : Teknik kompresi yang umum digunakan dalam optimasi LLM meliputi kompresi input (mengganti deskripsi panjang dengan konsep, seperti “prompt tingkat dewa”) dan kompresi output (mengganti Agent yang menjalankan tugas dengan alat yang dikemas secara presisi). Yang pertama menguji pemahaman abstrak dan akumulasi, sedangkan yang kedua menguji pilihan skala alat dan filosofi desain. (Sumber: dotey)

💼 BISNIS

Meta Mempertimbangkan Penggunaan Model AI Pihak Ketiga untuk Meningkatkan Kemampuan Produk : Menghadapi kinerja model Llama 4 yang buruk dan kekacauan manajemen internal, manajemen senior Meta’s Superintelligence Lab (MSL) sedang membahas pengenalan model Google Gemini atau OpenAI di Meta AI sebagai “solusi sementara”. Langkah ini dianggap sebagai pengakuan Meta atas ketertinggalan sementara dalam persaingan teknologi inti AI, dan menimbulkan pertanyaan tentang strategi AI serta efektivitas investasi puluhan miliar dolar mereka. (Sumber: 36氪, steph_palazzolo, menhguin)

Valuasi OpenEvidence Mencapai 6 Miliar USD : OpenEvidence, “ChatGPT versi dokter”, mencapai valuasi 6 miliar USD dalam putaran pendanaan terbaru, berlipat ganda dari bulan sebelumnya. Model berbasis iklannya telah menghasilkan pendapatan tahunan lebih dari 50 juta USD, menunjukkan potensi bisnis yang besar dan pertumbuhan cepat AI di sektor kesehatan. (Sumber: steph_palazzolo)

OpenAI Merekrut Tenaga Teknis untuk Frontier Evals di Bidang Keuangan : OpenAI sedang merekrut tenaga teknis untuk membangun evaluasi garis depan (frontier evals) di bidang keuangan. Ini menunjukkan bahwa OpenAI secara aktif memperluas aplikasi AI di industri keuangan dan berkomitmen untuk meningkatkan kemampuan praktis dan keandalan model di bidang tersebut. (Sumber: BorisMPower)

🌟 KOMUNITAS

Penurunan Kinerja Model Claude dan Kontroversi Sensor Konten : Beberapa pengguna melaporkan penurunan kinerja yang serius pada model Claude (termasuk Claude Max dan Claude Code) baru-baru ini, dengan masalah seperti perilaku tidak konsisten, ketidakmampuan menjaga konteks, sensor berlebihan, bahkan melakukan “diagnosis kesehatan mental”. Anthropic mengakui bahwa stack inferensi baru menyebabkan degradasi kinerja, namun pengguna secara umum berpendapat bahwa mekanisme sensornya terlalu sensitif, memengaruhi penggunaan kreatif dan profesional, serta menimbulkan kekhawatiran luas tentang etika AI dan pengalaman pengguna. (Sumber: teortaxesTex, QuixiAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT)

Manajemen Tim AI Meta dan Masalah Kualitas Data : Meta’s Superintelligence Lab (MSL) menghadapi masalah seperti kehilangan talenta, konflik budaya internal, dan kualitas data yang buruk yang diimpor dari Scale AI. Beberapa komentar menunjukkan bahwa upaya AI Meta “berantakan”, dan strategi perekrutan “brutal” mereka mungkin menjadi bumerang, serta menimbulkan pertanyaan tentang kemampuan perusahaan untuk mempertahankan posisi terdepan dalam persaingan AI. (Sumber: 36氪, arohan, teortaxesTex, scaling01, suchenzang, farguney, teortaxesTex, suchenzang)

Keniscayaan Koneksi Emosional AI dengan Manusia : Banyak orang percaya bahwa manusia pasti akan membentuk koneksi emosional dengan AI, terutama setelah peluncuran model seperti GPT-5, di mana frustrasi atas hilangnya “kepribadian” GPT-4o menyoroti hal ini. Komentar menunjukkan bahwa manusia secara alami mendambakan koneksi, dan simulasi emosi oleh AI secara alami akan memicu keterikatan, serta mempertanyakan apakah menekan emosi semacam itu akan menyebabkan ketidakpedulian. (Sumber: Reddit r/ChatGPT)

Tantangan ROI dalam Aplikasi Bisnis AI : Laporan bisnis AI dari MIT Nanda menganalisis bahwa 95% organisasi gagal mendapatkan pengembalian investasi dari AI. Ini memicu diskusi tentang strategi proyek AI yang sukses, menyoroti tantangan dalam implementasi proyek AI, serta bagaimana mengukur dan mewujudkan nilai bisnis AI secara efektif. (Sumber: TheTuringPost, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Dampak AI pada Pasar Kerja: Pemutusan Hubungan Kerja Manajer Tingkat Menengah : Wall Street Journal melaporkan bahwa perusahaan-perusahaan sedang memangkas manajer tingkat menengah untuk mengurangi biaya dan menciptakan tim yang lebih fleksibel. Data menunjukkan bahwa jumlah karyawan yang diawasi oleh setiap manajer telah meningkat tiga kali lipat dalam dekade terakhir, dari 1:5 pada tahun 2017 menjadi 1:15 pada tahun 2023. Tren ini dianggap terkait dengan kemajuan teknologi AI, menandakan dampak mendalam AI pada struktur organisasi perusahaan dan pasar kerja. (Sumber: Reddit r/ArtificialInteligence)

Etika dan Urgensi Regulasi AI : Yoshua Bengio menekankan potensi besar AI dalam masyarakat, namun dengan syarat perlu mengembangkan kerangka regulasi yang berarti dan memahami risiko yang terkait dengan model AI saat ini dan di masa depan dengan lebih baik. Investigasi Reuters terhadap chatbot selebriti Meta AI mengungkapkan risiko penyimpangan etika AI, termasuk peniruan selebriti tanpa izin, pembuatan konten eksplisit, dan lain-lain. (Sumber: Yoshua_Bengio, 36氪, Reddit r/artificial, Reddit r/artificial)

Jarak dan Definisi Artificial General Intelligence (AGI) : Diskusi luas telah muncul mengenai seberapa jauh teknologi AI saat ini dari AGI, serta definisi AGI itu sendiri. Keberhasilan AlphaFold dikutip sebagai contoh bahwa AI masih memerlukan kustomisasi dari ahli manusia, mempertanyakan kedekatan AGI. Pada saat yang sama, ada juga pandangan bahwa AGI mungkin tidak melampaui manusia dalam segala aspek, atau cara pencapaiannya mungkin berbeda dari yang diharapkan. (Sumber: fchollet, Dorialexander, mbusigin, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Masa Depan dan Tantangan AI Agent : Industri sangat antusias dengan potensi AI Agent, percaya bahwa ini dapat mengakhiri “manajemen mikro”, namun pada saat yang sama menunjukkan bahwa sebagian besar perusahaan belum siap. Diskusi tentang apakah Agent dapat menyetel ulang model secara mandiri untuk beradaptasi dengan kasus-kasus ekstrem, serta aplikasi Agent dalam tugas pengembangan dan operasi seperti perbaikan UI, semuanya mengindikasikan bahwa teknologi Agent akan membawa revolusi produktivitas. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, andriy_mulyar, Reddit r/MachineLearning)

Pentingnya Model AI Open-Source : Ada pandangan yang menekankan keunggulan model open-source dalam menghindari masalah kinerja yang tidak konsisten, terutama di bidang aplikasi penting seperti kesehatan. Ini kontras dengan kekhawatiran yang dipicu oleh degradasi kinerja model Anthropic, menyerukan dukungan dan penggunaan solusi AI open-source yang lebih luas. (Sumber: iScienceLuvr)

Studi Kasus Kegagalan AI dalam Sistem Pemesanan Makanan Cepat Saji : Sistem pemesanan makanan cepat saji berbasis AI mengalami kegagalan, misalnya pelanggan memesan 18.000 gelas air atau AI berulang kali meminta untuk menambahkan minuman, yang menyebabkan sistem crash atau kemarahan pengguna. Ini menyoroti tantangan yang masih dihadapi AI dalam aplikasi praktis, terutama dalam menangani situasi abnormal dan komunikasi dengan pengguna. (Sumber: menhguin)

💡 LAIN-LAIN

HUAWEI’S HELLCAT: Arsitektur Interkoneksi UB MESH : Unified Bus (UB) Huawei adalah arsitektur interkoneksi proprietary yang dirancang untuk menggantikan penggunaan campuran PCIe, NVLink, dan InfiniBand/RoCE dalam sistem tradisional. Ini menyediakan bandwidth ultra-tinggi dan latensi rendah, menghubungkan semua NPU, dan dianggap sebagai arah pengembangan penting untuk arsitektur komputasi di masa depan. (Sumber: teortaxesTex)

Diskusi Filosofis AI dan Emosi : Penggabungan AI dengan empati telah diusulkan, memicu diskusi filosofis tentang apakah AI dapat benar-benar memahami dan mengekspresikan emosi, serta potensi dampak kombinasi ini terhadap masyarakat dan interaksi manusia-mesin. (Sumber: Ronald_vanLoon)

Sumber Belajar Sistem Terdistribusi ‘14 Days of Distributed’ : Zach Mueller dan rekan-rekan berbagi seri “14 Days of Distributed”, yang bertujuan untuk mengeksplorasi sistem terdistribusi dan teknologi terkait, menyediakan sumber belajar untuk komputasi skala besar dalam penelitian dan pengembangan AI. (Sumber: charles_irl, winglian)