Kata Kunci:DeepSeek V3.1, GPT-5, Tencent Hunyuan 3D, Alibaba Qwen-Image, Robot Humanoid, AI Agent, Restrukturisasi Meta AI, DeepSeek V3.1 Base 128K konteks, Pelatihan dua sumbu GPT-5, Tencent Hunyuan 3D Lite versi FP8 kuantisasi, Render teks Qwen-Image, Kolaborasi Robot Zhiyuan dengan Fuling Precision

Berikut adalah terjemahan informasi AI ke dalam Bahasa Indonesia, dengan mempertahankan istilah teknis dan format asli:

🎯 Tren

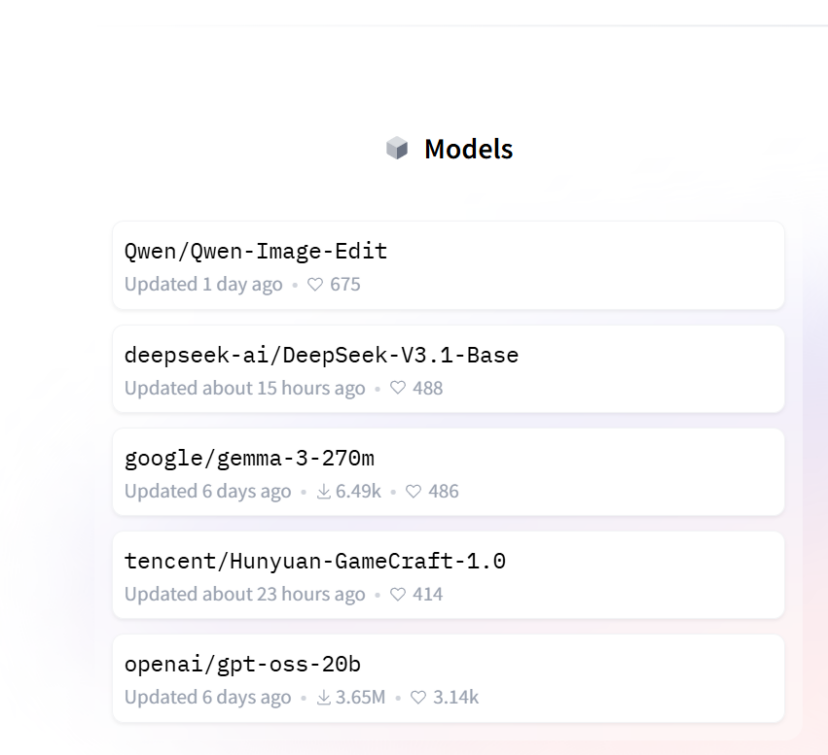

DeepSeek V3.1 Base Meluncur Mengejutkan: DeepSeek merilis model V3.1, dengan jumlah parameter 685B dan panjang konteks diperluas hingga 128K. Kemampuan pemrogramannya mengungguli Claude 4 Opus dalam tes Aider Polyglot dengan skor tinggi 71,6%, dengan kecepatan inferensi dan respons yang lebih cepat, serta biaya hanya 1/68 dari yang terakhir. Model ini menambahkan “search token” dan “think token”, mengisyaratkan kemungkinan penggunaan arsitektur hibrida. Meskipun dirilis secara diam-diam oleh pihak resmi, V3.1 telah berada di peringkat atas dalam daftar tren Hugging Face, menunjukkan posisi terdepan dalam model sumber terbuka dan ekspektasi pasar. (Sumber: 36氪, 36氪, 36氪, ClementDelangue)

Kemampuan dan Strategi OpenAI GPT-5: Chief Operating Officer OpenAI, Brad Lightcap, mengungkapkan bahwa terobosan inti GPT-5 terletak pada kemampuannya untuk secara mandiri memutuskan apakah akan melakukan inferensi mendalam, yang secara signifikan meningkatkan akurasi dan kecepatan respons, terutama di bidang penulisan, pemrograman, dan kesehatan. Ia menekankan bahwa Scaling Law belum mati, dan OpenAI mempercepat inovasi model melalui “dua sumbu” pra-pelatihan dan pasca-pelatihan. Meskipun kuat tetapi bukan AGI, “cadangan kemampuan berlebih” GPT-5 berarti masih ada ruang sepuluh tahun untuk pengembangan produk. Filosofi produknya adalah memecahkan masalah secara efisien, bukan memperpanjang durasi penggunaan pengguna, dan berfokus pada implementasi AI di skenario kesehatan dan perusahaan. (Sumber: 36氪, 36氪)

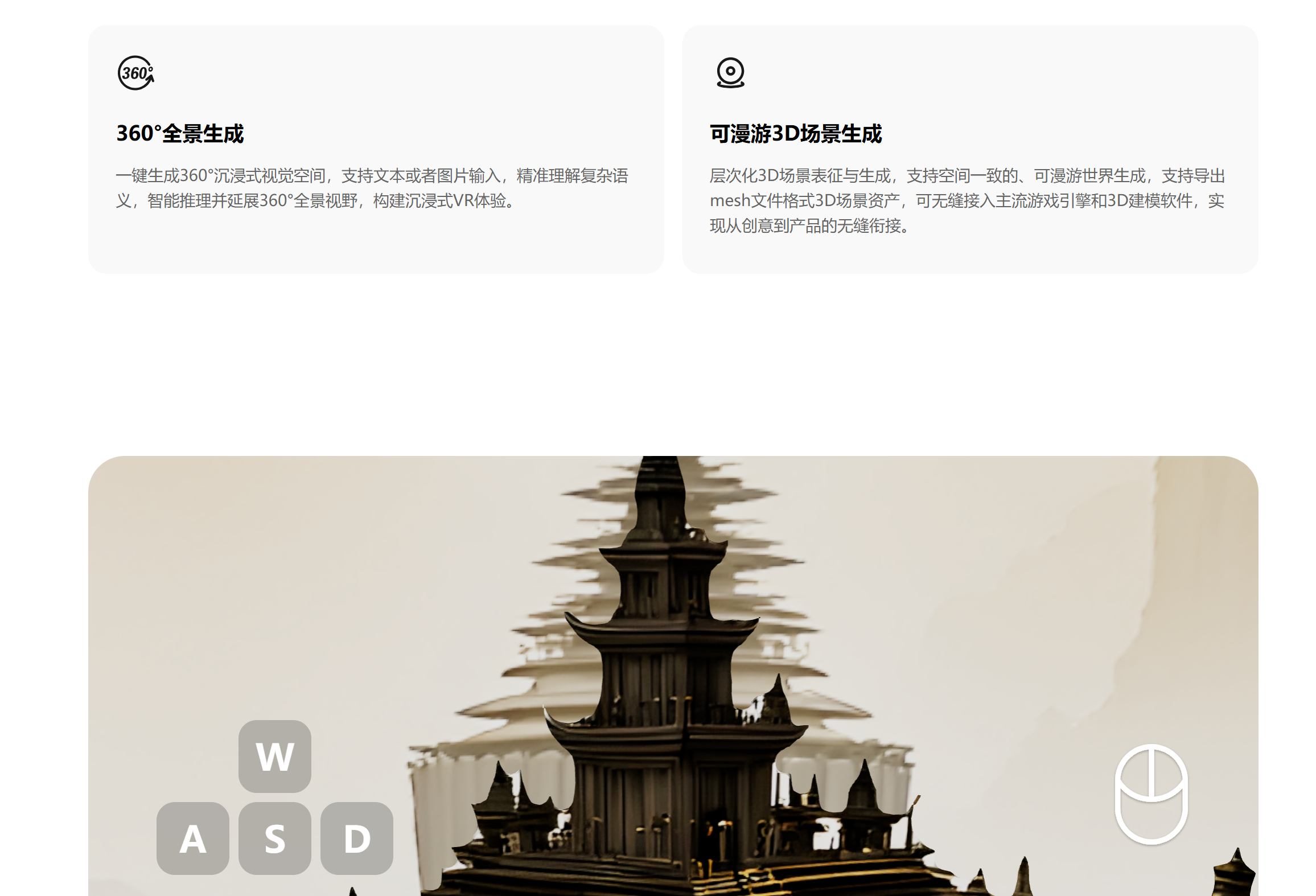

Tencent Hunyuan 3D Lite Dirilis: Tim Tencent Hunyuan merilis model dunia 3D versi Lite, yang mengurangi kebutuhan VRAM hingga di bawah 17GB melalui teknologi kuantisasi FP8 dinamis, memungkinkan kartu grafis kelas konsumen untuk berjalan lancar. Model ini mampu menghasilkan model dunia 3D yang lengkap, dapat diedit, dan interaktif berdasarkan gambar atau teks, meningkatkan efisiensi pengembangan skenario secara signifikan. Langkah ini bertujuan untuk menarik lebih banyak pengembang dan kreator, mendorong model 3D menuju popularitas massal, dan diharapkan dapat membentuk ekosistem yang terhubung dengan perangkat VR, pencetakan 3D, dll. (Sumber: 36氪)

Model Generasi Gambar Alibaba Qwen-Image Menduduki Puncak HuggingFace: Alibaba merilis model dasar generasi gambar Qwen-Image, yang menyelesaikan masalah rendering teks kompleks dan pengeditan gambar yang presisi melalui rekayasa data sistematis, pembelajaran progresif, dan pelatihan multi-tugas. Model ini mampu memproses teks multibaris dalam bahasa Mandarin dan Inggris secara akurat, dan mempertahankan konsistensi semantik dan visual dalam pengeditan gambar. Menggunakan arsitektur Qwen2.5-VL dan MMDiT, model ini mempertahankan detail melalui pengkodean ganda, dan mencapai tingkat terdepan di industri dalam tugas generasi gambar umum, rendering teks, dan pengeditan gambar berbasis instruksi. (Sumber: 36氪, huggingface, Alibaba_Qwen, fabianstelzer)

Wawasan Pesanan dan Kemampuan Pengiriman Robot Humanoid: Pesanan industri robot humanoid pada tahun 2025 meningkat secara signifikan, dengan fokus pasar bergeser ke aplikasi praktis dan pengiriman. Produsen seperti Ubtech, Unitree Robotics, dan LimX Dynamics memenangkan pesanan besar, dengan skenario aplikasi meliputi industri, panduan, penelitian ilmiah, pendidikan, dan perawatan kesehatan. LimX Dynamics mencapai kerja sama dengan Fulin Precision untuk hampir seratus robot beroda, dan Ubtech memenangkan tender pengadaan peralatan otomotif, menunjukkan bahwa skenario industri sedang memimpin dalam implementasi skala besar. Industri menghadapi tantangan kapasitas rantai pasokan, kematangan teknologi, dan standardisasi, tetapi diperkirakan volume pengiriman akan tumbuh pesat dalam beberapa tahun ke depan. (Sumber: 36氪)

Proposal Akuisisi Chrome Perplexity AI dan Visi Browser AI: Perplexity AI pernah mengusulkan untuk mengakuisisi Google Chrome seharga 34,5 miliar USD, bertujuan untuk mempromosikan web terbuka dan keamanan pengguna, meskipun dikritik sebagai sensasi. CEO Perplexity, AravSrinivas, menyatakan bahwa AI Agent, personalisasi, dan mode penjelajahan baru akan membentuk kembali pengalaman internet, dengan visi jangka panjangnya adalah mewujudkan sistem operasi asli AI, menggantikan alur kerja tradisional dengan AI proaktif. (Sumber: AravSrinivas, Reddit r/ArtificialInteligence)

Google DeepMind Genie 3 sebagai Simulator Universal: Google DeepMind Genie 3 digambarkan sebagai simulator umum daripada AI Agent. Lingkungan ini memungkinkan AI untuk menemukan perilaku melalui percobaan dan kegagalan berulang, mirip dengan cara belajar AlphaGo. Di bidang robotika, ini diharapkan memungkinkan AI mempelajari keterampilan yang dapat ditransfer, mendorong aplikasi yang lebih luas. (Sumber: jparkerholder)

Layanan Multi-Node Model Besar dan vLLM: SkyPilot menunjukkan bagaimana memanfaatkan vLLM untuk layanan model parameter triliunan dalam multi-node, mendukung model besar seperti Kimi K2 untuk berjalan dengan panjang konteks penuh. Dengan menggabungkan teknologi tensor parallelism dan pipeline parallelism, SkyPilot menyederhanakan pengaturan multi-node dan dapat memperluas replika, secara efektif memecahkan tantangan kompleksitas dan skalabilitas dalam penyebaran model besar. (Sumber: skypilot_org, vllm_project)

ChatGPT Go Diluncurkan di India: OpenAI meluncurkan layanan berlangganan ChatGPT Go di India, menawarkan batas pesan yang lebih tinggi, lebih banyak generasi gambar, lebih banyak unggahan file, dan memori yang lebih panjang, dengan harga 399 Rupee. Langkah ini bertujuan untuk mempopulerkan ChatGPT di pasar India, dan berencana untuk memperluasnya ke negara lain berdasarkan umpan balik, menjadikannya lebih terjangkau. (Sumber: sama)

Pembaruan Model Claude dan Peningkatan Fitur: Claude Opus 4.1 dari Anthropic menunjukkan kemampuan sintesis dan ringkasan yang lebih baik dalam mode penelitian, mengurangi kerumitan. Claude Sonnet 4 mendukung konteks 1M, memungkinkan analisis seluruh basis kode dan sintesis dokumen besar, serta mengoptimalkan biaya. Claude juga menambahkan mode “Opus 4.1 Plan, Sonnet 4 Execute” dan “mode pembelajaran” yang dapat disesuaikan, meningkatkan pengalaman pengguna dan efisiensi model. (Sumber: gallabytes, Reddit r/ArtificialInteligence)

🧰 Alat

Zhipu AI Merilis AutoGLM, Agent Universal Pertama di Dunia untuk Ponsel: Zhipu AI meluncurkan AutoGLM, Agent universal pertama di dunia untuk ponsel, tersedia gratis untuk umum, mendukung Android dan iOS. Agent ini mampu menjalankan tugas di cloud, tidak memakan sumber daya lokal, mewujudkan operasi lintas aplikasi, seperti perbandingan harga belanja, pemesanan makanan, pembuatan laporan, dll. Didukung oleh model GLM-4.5 dan GLM-4.5V, ia mengintegrasikan berbagai kemampuan seperti inferensi, pengkodean, dan Agentic, serta mengusulkan “3A principles” (sepanjang waktu, operasi mandiri tanpa gangguan, konektivitas seluruh domain), bertujuan untuk menyebarkan kemampuan Agent ke pasar konsumen massal. (Sumber: 36氪)

Anycoder Mengintegrasikan GLM 4.5 dan Fitur Pengeditan Gambar Qwen: Platform Anycoder kini mendukung GLM 4.5 dan fitur pengeditan gambar Alibaba Qwen, menyediakan kemampuan pengeditan gambar, terutama cocok untuk kasus penggunaan “vibe coding”. Qwen-Image-Edit didasarkan pada model 20B Qwen-Image, mendukung pengeditan teks bilingual yang presisi (Mandarin dan Inggris) sambil mempertahankan gaya gambar, dan mendukung pengeditan pada tingkat semantik dan visual. (Sumber: Zai_org, _akhaliq, _akhaliq, Alibaba_Qwen)

Versi Baru OpenAI Codex CLI Dirilis: OpenAI merilis versi Rust baru dari alat Codex CLI-nya, yang menggunakan model GPT-5 dan dapat memanfaatkan langganan GPT Pro yang sudah ada. Versi baru ini mengatasi banyak masalah dari versi Node.js/Typescript lama, seperti kinerja rendah, UI/UX buruk, kemampuan model lemah, dan operasi yang ceroboh. Pengenalan bahasa Rust secara signifikan meningkatkan kecepatan interaksi dan responsivitas, dikombinasikan dengan kemampuan pengkodean dan pemanggilan alat GPT-5 yang kuat, menjadikannya pesaing kuat bagi Claude Code. (Sumber: doodlestein)

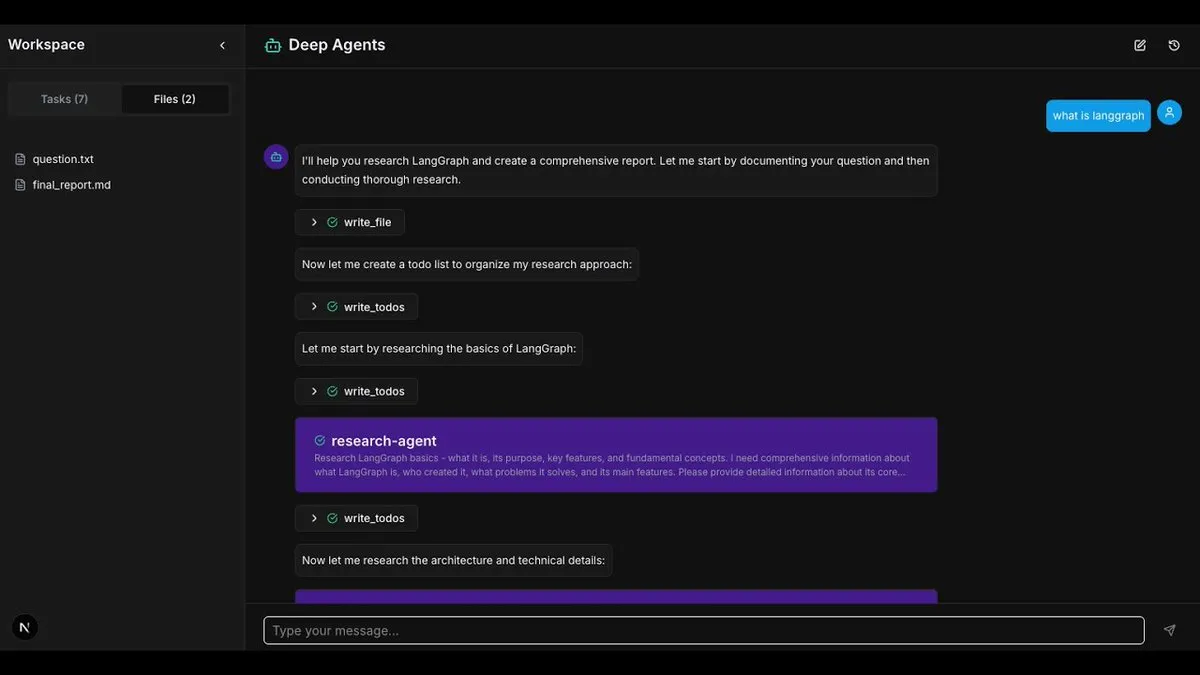

Kerangka Kerja dan Aplikasi LangChain DeepAgents: Arsitektur DeepAgents LangChain kini tersedia dalam paket Python dan TypeScript, meletakkan dasar untuk membangun AI Agent yang dapat dikombinasikan dan berguna. Kerangka kerja ini memiliki fitur perencanaan bawaan, sub-Agent, dan penggunaan sistem file, dapat digunakan untuk membangun aplikasi kompleks seperti “Deep Research”, mewujudkan penelitian mendalam dan agregasi informasi. (Sumber: LangChainAI, hwchase17, LangChainAI)

Jupyter Agent 2 Dirilis: Jupyter Agent 2 telah dirilis, didukung oleh Qwen3-Coder, berjalan di Cerebras, dan dieksekusi oleh E2B. Agent ini mampu memuat data, mengeksekusi kode, dan menggambar hasil di dalam Jupyter dengan kecepatan sangat tinggi, dan mendukung unggahan file. Semua demonstrasi video bersifat real-time, menunjukkan efisiensi yang kuat dalam analisis data dan eksekusi kode. (Sumber: ben_burtenshaw)

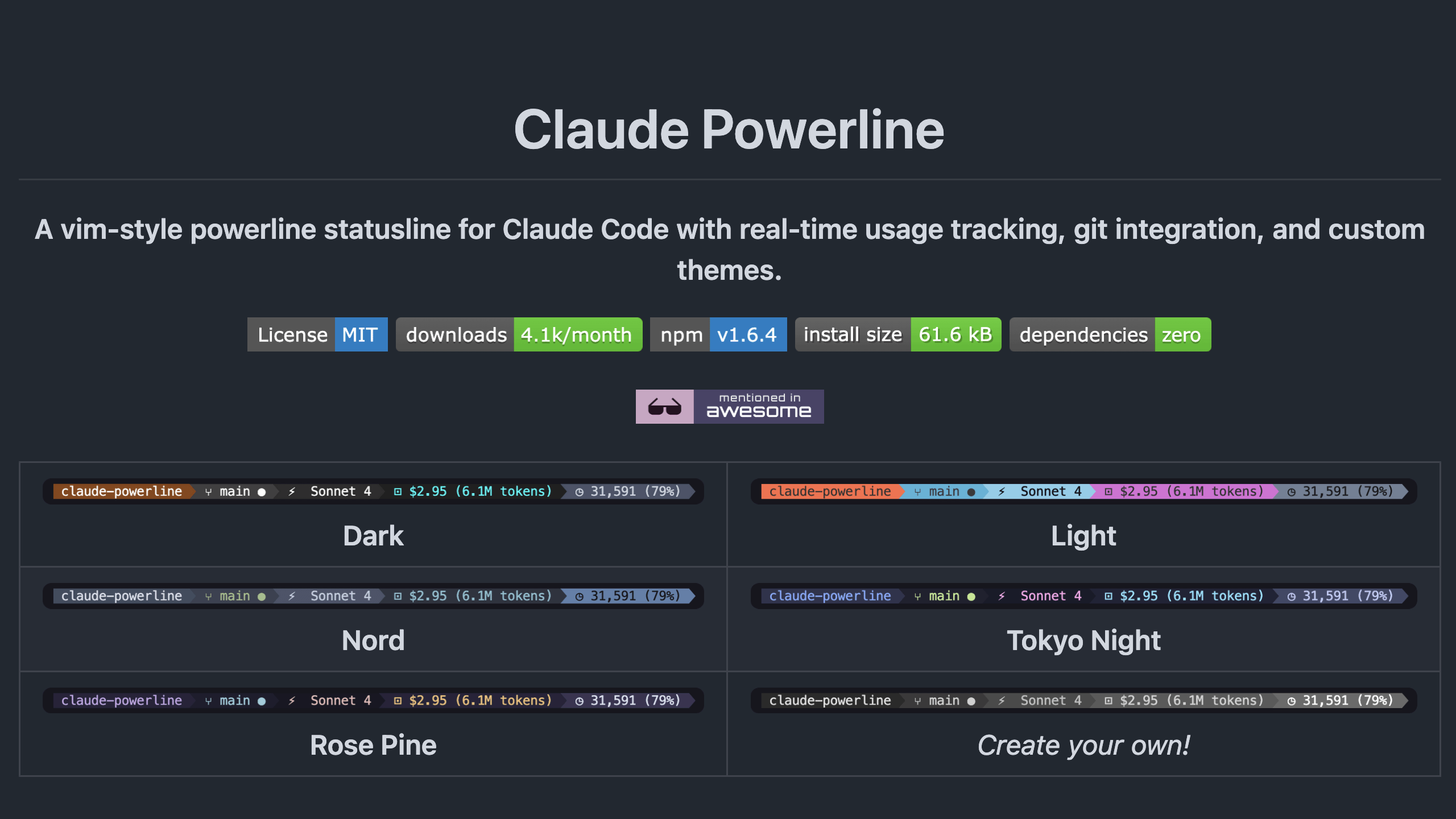

Alat Bilah Status Claude-Powerline: Claude-Powerline adalah alat bilah status Claude Code yang ringan dan aman, tanpa dependensi. Menyediakan integrasi Tmux, metrik kinerja (waktu respons, durasi sesi, jumlah pesan), informasi versi, penggunaan konteks, dan tampilan status Git yang ditingkatkan. Alat ini diinstal melalui npx, memastikan pembaruan otomatis, dan meningkatkan kompatibilitas lintas platform serta keamanan. (Sumber: Reddit r/ClaudeAI)

Eksplorasi Kombinasi LLM Lokal dengan Pengenalan Wajah: Seorang pengembang mencoba menggabungkan LLM lokal dengan alat pengenalan wajah eksternal, untuk mendeskripsikan orang dari gambar dan mencari wajah secara online. Meskipun alat pencarian wajah saat ini tidak bersifat lokal, kombinasi ini menunjukkan potensi pengenalan dan inferensi AI. Diskusi berpendapat bahwa menggabungkan pengenalan dan inferensi adalah arah pengembangan AI, dan menantikan sistem pencarian dan inferensi wajah yang sepenuhnya lokal di masa depan. (Sumber: Reddit r/LocalLLaMA)

Pengembangan Robot Trading Berbantuan AI: Pengembang Jordan A. Metzner menggunakan Public API dan ChatGPT di Replit, hanya dalam waktu kurang dari 6 jam untuk mengembangkan robot trading. Studi kasus ini menunjukkan potensi aplikasi AI dalam pengembangan prototipe cepat dan bidang fintech, mewujudkan pemrograman yang efisien melalui “vibe coding”. (Sumber: amasad)

Pembaruan Cursor CLI: Alat Cursor CLI diperbarui, menambahkan MCPs (Model Context Protocols), Review Mode, fitur /compress, dukungan @ -files, dan peningkatan pengalaman pengguna lainnya. Fitur-fitur ini bertujuan untuk meningkatkan efisiensi dan kenyamanan pengembang saat menggunakan Cursor untuk pengeditan kode dan pemrograman yang dibantu AI. (Sumber: Reddit r/ArtificialInteligence)

📚 Pembelajaran

Kursus dan Metode Evaluasi AI (Evals): Hamel Husain mempopulerkan evaluasi AI (Evals) melalui artikel yang ditulisnya, dan menyelenggarakan kursus evaluasi yang sukses. Ia berbagi cara membangun dataset untuk menguji kemampuan AI dalam mengekspresikan ketidakpastian atau menolak menjawab, menekankan peningkatan keandalan AI melalui suite pengujian dan analisis data. (Sumber: HamelHusain, HamelHusain, TheZachMueller)

Paradigma Pembelajaran Kombinasi LLM dan RL: Perkembangan AI dalam beberapa tahun ke depan akan banyak mengadopsi paradigma pembelajaran penguatan (RL) yang dikombinasikan dengan LLM sebagai fungsi hadiah (LLM-as-a-judge reward functions). Metode ini memungkinkan model untuk meningkatkan diri melalui evaluasi diri dan iterasi, merupakan arah penting untuk pembelajaran mandiri dan peningkatan diri AI. (Sumber: jxmnop, tokenbender)

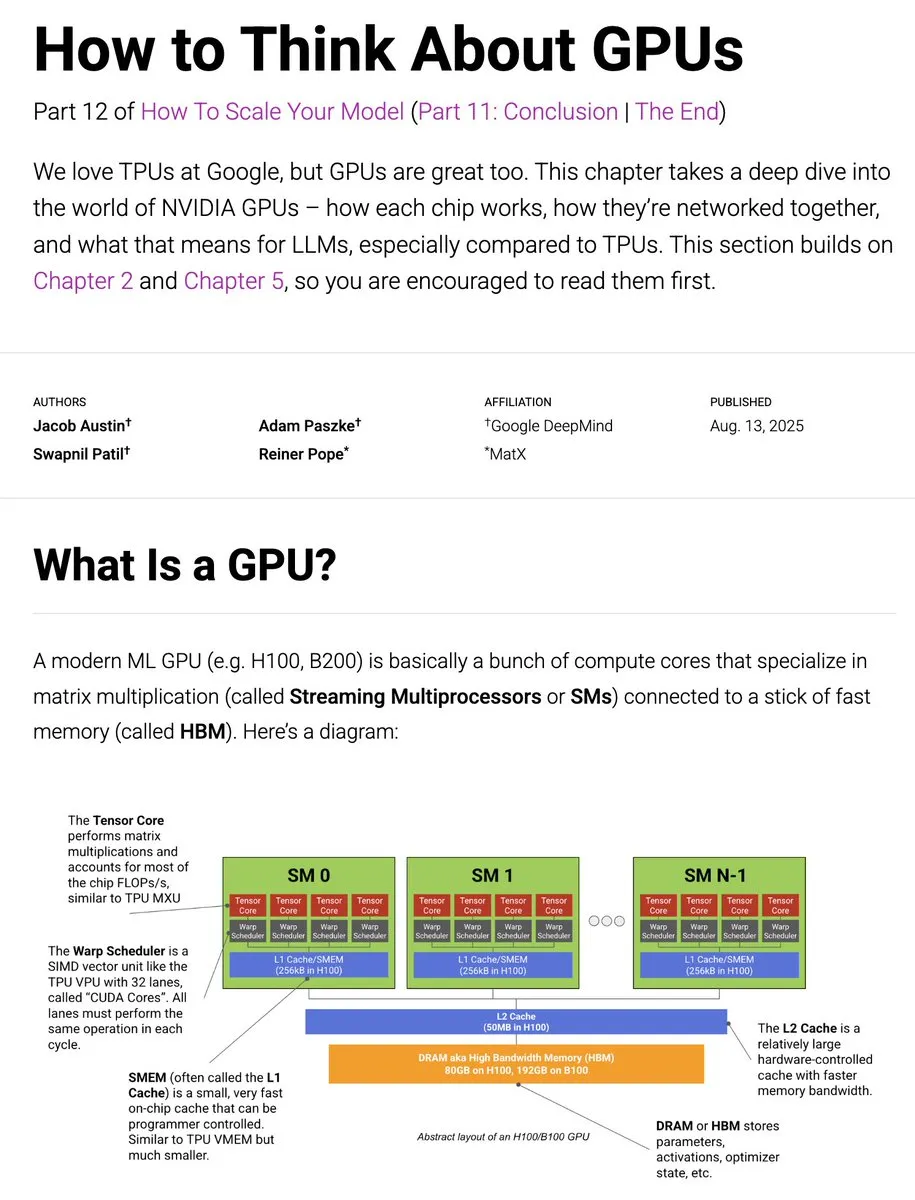

Pembaruan Panduan Pelatihan JAX TPU ke GPU: Buku JAX TPU memperbarui konten terkait GPU, menjelajahi secara mendalam cara kerja GPU, perbandingannya dengan TPU, metode koneksi jaringan, dan dampaknya pada pelatihan LLM. Ini memberikan sumber daya dan wawasan berharga bagi pengembang tentang pengoptimalan pelatihan LLM pada perangkat keras yang berbeda. (Sumber: sedielem, algo_diver)

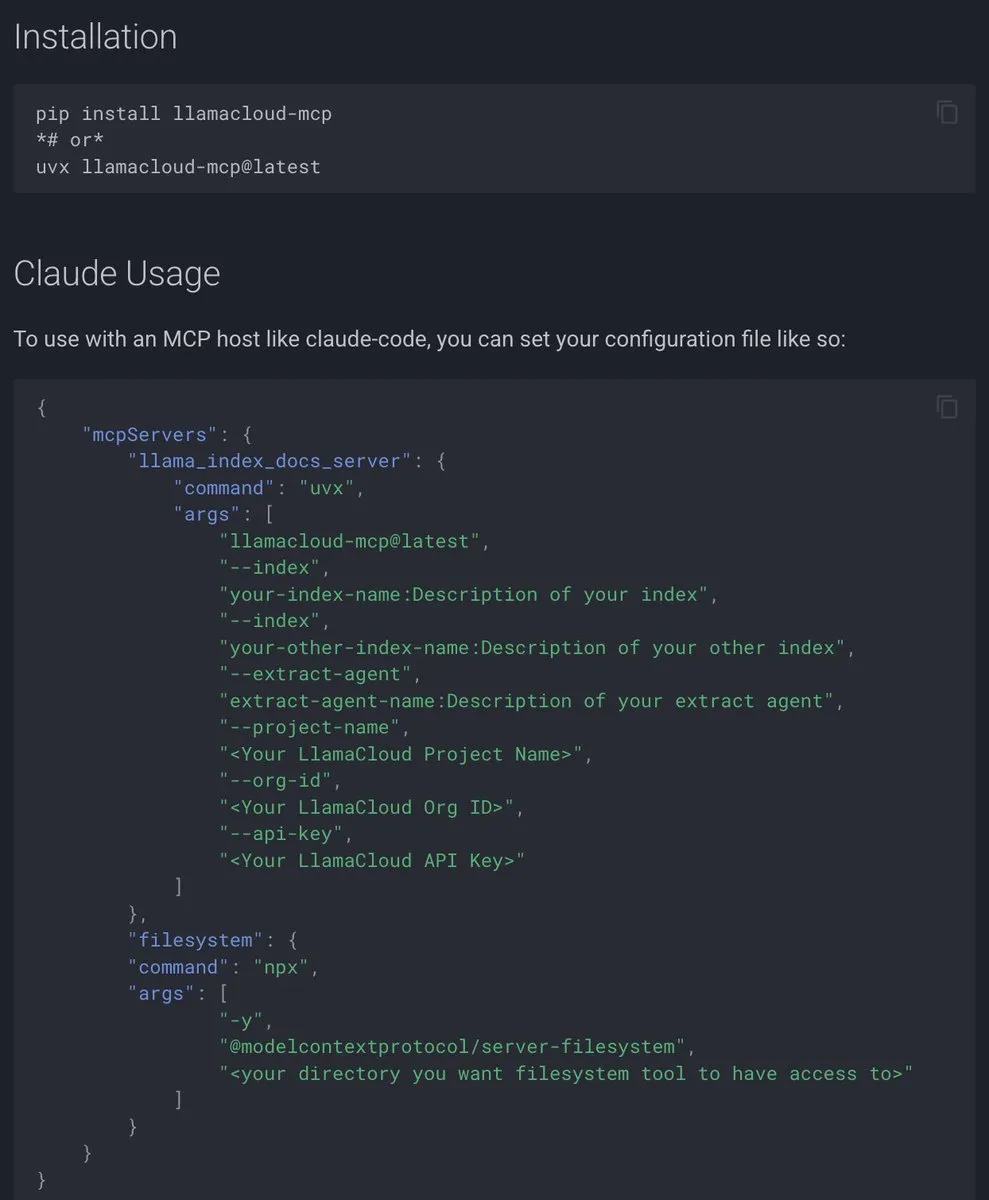

Dokumentasi Model Context Protocols (MCP) LlamaIndex: LlamaIndex merilis dokumentasi Model Context Protocols (MCP) yang komprehensif, bertujuan untuk membantu aplikasi AI terhubung dengan alat eksternal dan sumber data melalui antarmuka standar. MCP mendukung koneksi arsitektur client-server LLM dengan database, alat, dan layanan, memungkinkan pengguna untuk mengubah alur kerja yang ada menjadi server MCP, dan berintegrasi dengan host seperti Agent, Claude Desktop, dll. (Sumber: jerryjliu0)

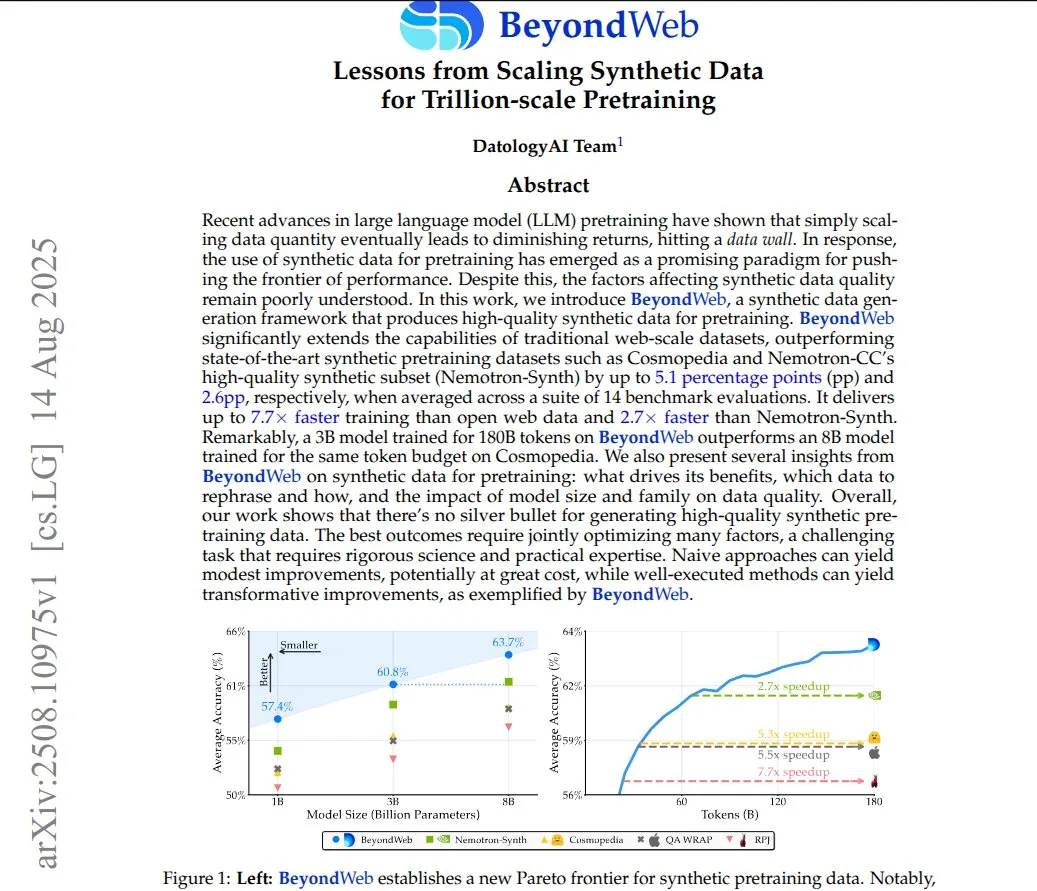

BeyondWeb: Data Sintetis untuk Pra-pelatihan Triliunan Parameter: Kerangka kerja BeyondWeb menghasilkan data pelatihan sintetis yang padat dan beragam dengan menulis ulang konten web nyata ke dalam berbagai format seperti tutorial, tanya jawab, dan ringkasan. Ini memungkinkan model kecil untuk belajar lebih cepat dan melampaui model dasar besar, mencapai kepadatan informasi yang lebih tinggi dan lebih sesuai dengan pola kueri pengguna. Penelitian menunjukkan bahwa data sintetis yang ditulis ulang dengan cermat dapat secara signifikan meningkatkan efisiensi dan akurasi pelatihan model. (Sumber: code_star)

Penggunaan GPU untuk AutoLSTM di Google Colab: Pengguna Reddit berbagi metode untuk melatih model AutoLSTM NeuralForecast menggunakan GPU di Google Colab. Dengan mengatur parameter accelerator dan devices dalam trainer_kwargs, pengguna dapat menentukan penggunaan GPU untuk pelatihan model, sehingga meningkatkan efisiensi komputasi. (Sumber: Reddit r/deeplearning)

PosetLM: Studi Awal Alternatif Transformer: Sebuah studi baru mengusulkan PosetLM, alternatif untuk Transformer, yang memproses urutan melalui DAG kausal, di mana setiap token terhubung ke sejumlah kecil token sebelumnya, dan informasi mengalir melalui langkah-langkah penyempurnaan. Hasil awal menunjukkan bahwa PosetLM mengurangi jumlah parameter sebesar 35% pada dataset enwik8, dengan kualitas yang mirip dengan Transformer, tetapi implementasi saat ini lebih lambat dan membutuhkan memori tinggi. Peneliti mencari umpan balik komunitas untuk memutuskan arah pengembangan selanjutnya. (Sumber: Reddit r/deeplearning)

Tutorial AI for Video Understanding: LearnOpenCV merilis tutorial tentang pemahaman video AI, mencakup alur kerja praktis mulai dari moderasi konten hingga ringkasan video. Artikel ini memperkenalkan model seperti CLIP, Gemini, dan Qwen2.5-VL, dan memandu cara membangun sistem moderasi konten video (menggunakan CLIP dan Gemini) dan sistem ringkasan video (menggunakan Qwen2.5-VL), bertujuan untuk membantu pengembang membangun pipeline AI video yang komprehensif. (Sumber: LearnOpenCV)

Konferensi Pengembang AI 2025 Diadakan di New York: DeepLearning.AI mengumumkan bahwa konferensi AI Dev 25 akan diadakan pada 14 November 2025 di New York City. Konferensi ini diselenggarakan oleh Andrew Ng dan DeepLearning.AI, menawarkan kesempatan untuk pengkodean, pembelajaran, dan jaringan, termasuk presentasi ahli AI, lokakarya langsung, sesi fintech, dan demonstrasi mutakhir, bertujuan untuk mengumpulkan lebih dari 1200 pengembang. (Sumber: DeepLearningAI, DeepLearningAI)

💼 Bisnis

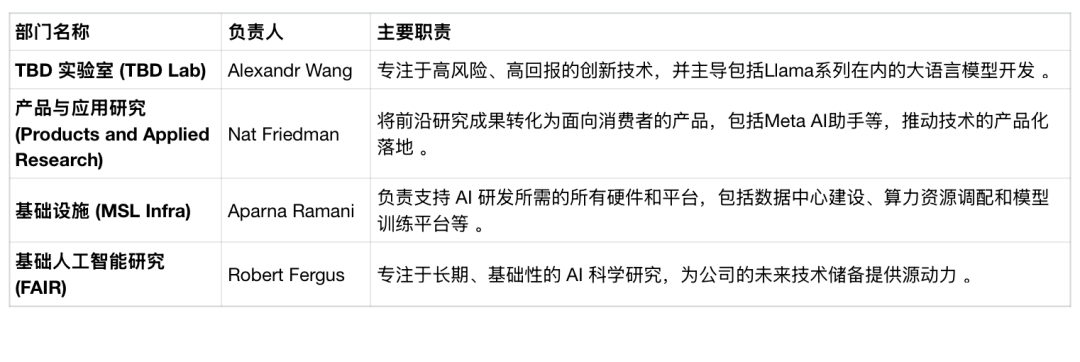

Restrukturisasi Departemen AI Meta dan Gejolak Talenta: Meta mengumumkan restrukturisasi departemen AI-nya, membagi laboratorium super-intelijen menjadi empat tim: TBD Lab, FAIR, Penelitian Produk & Aplikasi, dan MSL Infra. Restrukturisasi ini disertai dengan kepergian eksekutif AI dan potensi PHK, dengan tingkat retensi karyawan hanya 64%, jauh di bawah rekan-rekan. Meta secara aktif menjajaki penggunaan model AI pihak ketiga, dan mempertimbangkan untuk “menutup” model AI berikutnya, yang bertentangan dengan filosofi sumber terbuka sebelumnya, mencerminkan tekadnya untuk membentuk kembali struktur perusahaan dalam perlombaan AI demi terobosan. (Sumber: 36氪, 36氪)

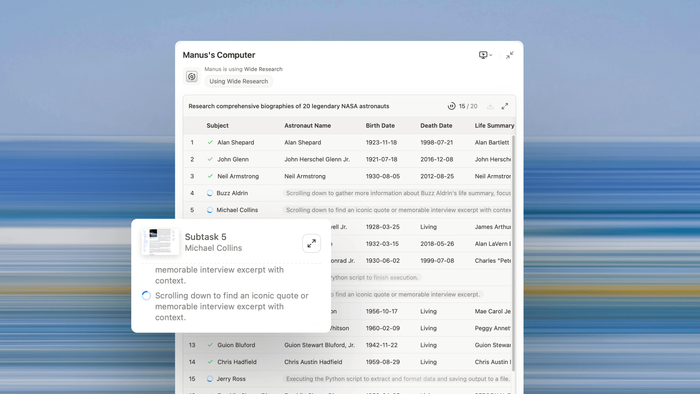

Pendapatan Manus AI dan Pengembangan Agent Universal: Manus AI mengungkapkan bahwa Pendapatan Berulang Tahunan (RRR) mereka telah mencapai 90 juta USD, akan segera menembus 100 juta USD, menunjukkan bahwa AI Agent sedang bergerak dari penelitian ke aplikasi praktis. Co-founder Ji Yichao menjelaskan arah pengembangan Agent universal: memperluas skala eksekusi melalui kolaborasi multi-Agent (seperti fitur Wide Research), dan memperluas “permukaan alat” Agent, memungkinkannya memanggil ekosistem sumber terbuka seperti seorang programmer. Manus sedang bekerja sama dengan Stripe untuk memajukan pembayaran dalam Agent, bertujuan untuk menghilangkan gesekan di dunia digital. (Sumber: 36氪, 36氪)

Perang Talenta AI dan Fenomena Gaji Tinggi: Perebutan talenta di bidang AI sangat sengit, dengan gaji tahunan lulusan doktor baru umumnya mencapai 3 juta RMB, dan beberapa mahasiswa berprestasi bahkan melebihi 5 juta RMB, jauh melampaui gaji eksekutif internet tradisional. Perusahaan besar seperti ByteDance, Alibaba, dan Tencent adalah pesaing utama, menarik talenta melalui gaji tinggi, sistem mentor, evaluasi longgar, dan kebebasan proyek. Fenomena ini mencerminkan kelangkaan talenta AI papan atas, serta strategi perusahaan domestik untuk melakukan perencanaan awal guna menghindari kehilangan talenta ke luar negeri atau pesaing. (Sumber: 36氪)

🌟 Komunitas

Ketergantungan Emosional Pengguna pada Model AI dan “Cyber Heartbreak”: Setelah OpenAI merilis GPT-5 yang menggantikan GPT-4o, memicu protes keras dari pengguna yang menyebut GPT-5 “tidak manusiawi”, menyebabkan “cyber heartbreak”. Pengguna memiliki ikatan emosional yang mendalam dengan GPT-4o, bahkan menyebutnya “teman” atau “hidup”. OpenAI mengakui meremehkan emosi pengguna, dan meluncurkan kembali GPT-4o. Fenomena ini mengungkapkan munculnya aplikasi pendamping AI (seperti Character.AI), memenuhi kebutuhan manusia akan dukungan emosional, tetapi juga membawa masalah seperti amnesia AI, penurunan kepribadian, dan potensi risiko kesehatan mental. (Sumber: 36氪, Reddit r/ChatGPT, Reddit r/ArtificialInteligence)

Dampak AI pada Pembuatan Konten dan Lalu Lintas Berita: Fitur Google AI Overview menyebabkan situs berita global kehilangan 600 juta kunjungan dalam setahun, dan mata pencarian blogger independen terancam. AI langsung meringkas konten, sehingga pengguna tidak perlu mengklik artikel asli, menyebabkan lalu lintas platform berita dan kreator anjlok. Dampak lalu lintas domestik mulai terlihat, tetapi lalu lintas platform AI tumbuh secara eksplosif. Lembaga konten mengajukan gugatan untuk melindungi hak cipta, tetapi juga menjajaki keseimbangan kerja sama dengan AI, menyoroti tantangan dan peluang monetisasi konten di era AI. (Sumber: 36氪)

Aplikasi dan Evaluasi AI di Bidang Produksi Iklan: AI digunakan untuk membuat video iklan bergaya Duolingo, termasuk karakter burung hantu, gerakan, dan pengisi suara skrip, mewujudkan produksi tanpa animator dan editor. Komentar tentang efek iklan yang dihasilkan AI bervariasi, beberapa kagum dengan pengisi suara alami dan sinkronisasi bibir, sementara yang lain berpendapat efek visualnya buruk atau kurang strategis. Ini memicu diskusi tentang kemungkinan AI menggantikan tenaga manusia di industri kreatif dan nilai inti periklanan. (Sumber: Reddit r/artificial)

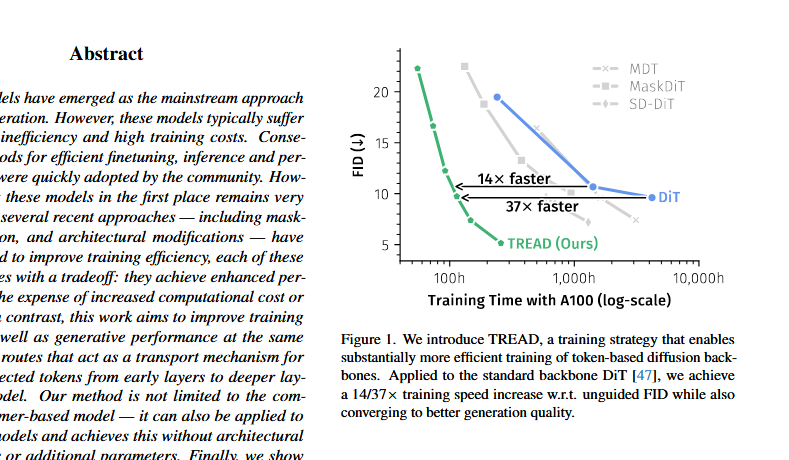

Kontroversi Arsitektur DiT dan Tanggapan Saining Xie: Diskusi muncul di X tentang arsitektur DiT (Diffusion Transformer) yang “salah secara matematis dan formal”, menunjukkan masalah seperti FID yang stabil terlalu dini, penggunaan normalisasi lapisan setelahnya, dan adaLN-zero. Penulis DiT, Saining Xie, menanggapi bahwa menemukan cacat arsitektur adalah impian peneliti, dan membantah beberapa pandangan dari sudut pandang teknis, sekaligus mengakui bahwa sd-vae adalah “kelemahan” DiT. Diskusi ini menyoroti pertanyaan dan perbaikan berkelanjutan terhadap metode yang ada dalam iterasi arsitektur model AI. (Sumber: sainingxie, teortaxesTex, 36氪)

Tantangan Keamanan dan Skalabilitas Eksekusi Kode AI Agent: AI Agent menghadapi dua tantangan inti dalam penulisan dan eksekusi kode: keamanan dan skalabilitas. Kekuatan komputasi tidak cukup untuk menjalankan kode secara lokal, sementara komputasi bersama membawa risiko keamanan dan tantangan skalabilitas horizontal. Industri sedang berupaya membangun lingkungan runtime eksekusi kode Agent yang aman dan skalabel, menyediakan sumber daya komputasi yang diperlukan, kontrol izin yang tepat, dan isolasi lingkungan, untuk membuka potensi eksplorasi AI Agent. (Sumber: jefrankle)

Diskusi Kasus Penggunaan Nyata Claude Code: Komunitas membahas aplikasi praktis Claude Code, pengguna berbagi berbagai studi kasus sukses, termasuk membangun perangkat lunak QC, alat transkripsi offline, pengatur Google Drive, sistem RAG lokal, dan aplikasi yang dapat menggambar garis PDF. Pengguna umumnya percaya bahwa Claude Code unggul dalam menangani pekerjaan dasar yang “membosankan”, menganggapnya sebagai alat bantu tingkat SWE-I/II, sehingga memungkinkan pengembang untuk fokus pada tugas yang lebih kreatif. (Sumber: Reddit r/ClaudeAI)

Masalah Output Gambar Markdown Google Gemini: Pengguna dotey bertanya apakah Gemini mendukung output gambar Markdown, menunjukkan bahwa hasilnya hanya berupa konten teks, tidak termasuk format gambar Markdown. Ini memicu diskusi tentang kemampuan output model Gemini dan pengaturan pengguna, mencerminkan ekspektasi pengguna terhadap format output multimodal model AI. (Sumber: dotey)

Rendahnya ROI Investasi AI dan Masalah Integrasi Perusahaan: Laporan MIT menunjukkan bahwa hingga 95% perusahaan memiliki pengembalian nol dalam investasi AI generatif. Masalah intinya bukan pada kualitas model AI, tetapi pada cacat dalam proses integrasi perusahaan. Model besar umum seringkali stagnan dalam aplikasi perusahaan karena mereka tidak dapat belajar atau beradaptasi dari alur kerja. Kasus sukses sebagian besar terkonsentrasi pada perusahaan yang berfokus pada masalah, eksekusi yang tepat, dan bekerja sama dengan pemasok. (Sumber: lateinteraction)

Kontroversi Etika yang Dipicu oleh AI Menghidupkan Kembali Orang Meninggal: Penggunaan AI generatif untuk “menghidupkan kembali” orang yang meninggal (seperti Joaquin Oliver, korban penembakan Parkland) memicu kontroversi etika yang besar. AI mensimulasikan suara dan percakapan orang yang meninggal, bertujuan untuk mengadvokasi kontrol senjata, tetapi dikritik sebagai “pemanggilan arwah digital” dan “komodifikasi orang yang meninggal”. Perilaku ini memicu refleksi mendalam masyarakat tentang batas teknologi AI, privasi, martabat orang yang meninggal, dan emosi kerabat, menyoroti ketegangan antara etika sosial dan perkembangan teknologi dalam aplikasi AI. (Sumber: Reddit r/ArtificialInteligence)

Pemilih Model OpenAI dan Pengalaman Pengguna: OpenAI memicu protes pengguna setelah peluncuran GPT-5 karena membatalkan pilihan default GPT-4o, dengan beberapa pengguna merasa ini menghilangkan hak pilihan mereka. Kepala ChatGPT Nick Turley mengakui ini adalah kesalahan, dan menyatakan akan mempertahankan opsi peralihan model penuh untuk pengguna Plus, sementara tetap mempertahankan pemilih otomatis yang sederhana untuk sebagian besar pengguna biasa. Ini mencerminkan tantangan OpenAI dalam menyeimbangkan pengalaman pengguna, iterasi teknologi, dan strategi produk. (Sumber: Reddit r/ArtificialInteligence)

Mode Iklan Potensial Grok: Diskusi sosial menyebutkan bahwa “Grok Shill Mode” Grok mungkin lebih berpengaruh daripada iklan tradisional, memanfaatkan reputasi Grok di mata pengguna sebagai aset berharga. Ini mengisyaratkan model aplikasi baru AI di masa depan dalam bidang periklanan dan pemasaran, tetapi menekankan perlunya memastikan tidak membocorkan prompt untuk menjaga kredibilitasnya. (Sumber: teortaxesTex)

Manajemen Alur Kerja AI Agent: Diskusi menunjukkan bahwa kunci penggunaan Agent pengkodean yang efektif adalah membagi unit kerja dengan benar dan mengelola pekerjaan sehari-hari, memastikan semua tugas selesai dan tercatat pada hari berikutnya. Ini menekankan bahwa saat menggunakan AI Agent, operator manusia perlu memiliki kemampuan dekomposisi tugas dan manajemen proyek yang jelas, untuk memaksimalkan efisiensi dan output Agent. (Sumber: nptacek)

Tren Masa Depan Model Terbuka dan Diskusi: Komunitas AI memperhatikan tren pengembangan model terbuka, diperkirakan model terbuka akan menjadi topik penting di bidang AI di masa depan. Ini menunjukkan antusiasme industri terhadap teknologi AI sumber terbuka dan pengakuan akan potensinya, di masa depan akan ada lebih banyak diskusi mendalam tentang model terbuka pada tingkat teknis, aplikasi, dan etika. (Sumber: natolambert)

💡 Lain-lain

Pergeseran Paradigma dari Kehidupan Digital ke Kehidupan AI: Personalisasi informasi, jaringan, dan ekonomi bit yang diramalkan dalam “Being Digital” oleh Nicholas Negroponte telah terwujud, tetapi visi seperti invisibilitas teknologi, agen cerdas, dan konsensus global belum tercapai sesuai harapan. Munculnya AI menandai pergeseran paradigma dari “kehidupan digital” ke “kehidupan AI”, di mana AI berubah dari alat menjadi agen, membentuk kembali kreasi, identitas, pendidikan, dan hubungan manusia-mesin. Di masa depan, manusia perlu membangun logika keberadaan bersama AI, mendefinisikan ulang kecerdasan dan nilai, menghadapi kekuatan algoritma dan tantangan etika dengan sikap realisme kritis. (Sumber: 36氪)