Kata Kunci:Google DeepMind, Genie 3, Model Dunia, Lingkungan Pelatihan AI, Pengembangan Game, AGI Berwujud, Sistem Multi-Agen, Pembuatan Lingkungan 3D Interaktif Real-Time, Resolusi 720p 24fps, Kolaborasi Dua Agen Pemecah+Verifikator, Pemecahan Soal Matematika IMO oleh AI, Sistem IMO Multi-Agen Sumber Terbuka

Berikut adalah terjemahan berita AI ke dalam Bahasa Indonesia:

🔥 Fokus Utama

Google DeepMind Rilis Model Dunia Genie 3: Google DeepMind meluncurkan Genie 3, sebuah model dunia terobosan yang mampu menghasilkan lingkungan 3D interaktif secara real-time berdasarkan prompt teks, mendukung resolusi 720p dan frame rate 24fps. Model ini memiliki memori visual dan kemampuan kontrol gerakan hingga beberapa menit, dianggap sebagai game engine 2.0 masa depan, diharapkan dapat merevolusi lingkungan pelatihan AI dan pengembangan game, serta menyediakan bagian penting yang hilang untuk AGI yang berwujud. (Sumber: Google DeepMind)

Multi-Agent Ant Group Mereplikasi Hasil Medali Emas IMO dan Menjadi Open Source: Tim proyek AWorld Ant Group hanya membutuhkan 6 jam untuk mereplikasi hasil penyelesaian 5 dari 6 soal DeepMind dalam kompetisi matematika IMO 2025, dan telah merilis sistem multi-agent IMO sebagai open source. Sistem ini, melalui kolaborasi dua agent “pemecah masalah + validator”, menunjukkan potensi untuk melampaui batas kecerdasan model tunggal, dan digunakan untuk melatih model generasi berikutnya, diharapkan dapat mendorong pengembangan Artificial General Intelligence (AGI). (Sumber: 量子位)

AI Temukan Hukum Fisika Baru: Peneliti dari Emory University melatih AI untuk menemukan hukum fisika baru dari data eksperimen plasma debu, mengungkapkan gaya yang sebelumnya tidak diketahui. Penelitian ini menunjukkan bahwa AI tidak hanya dapat memprediksi hasil atau membersihkan data, tetapi juga dapat digunakan untuk menemukan hukum fisika fundamental, dan mengoreksi asumsi yang telah lama ada dalam fisika plasma, membuka jalan baru untuk mempelajari sistem multi-partikel yang kompleks. (Sumber: interestingengineering)

🎯 Tren

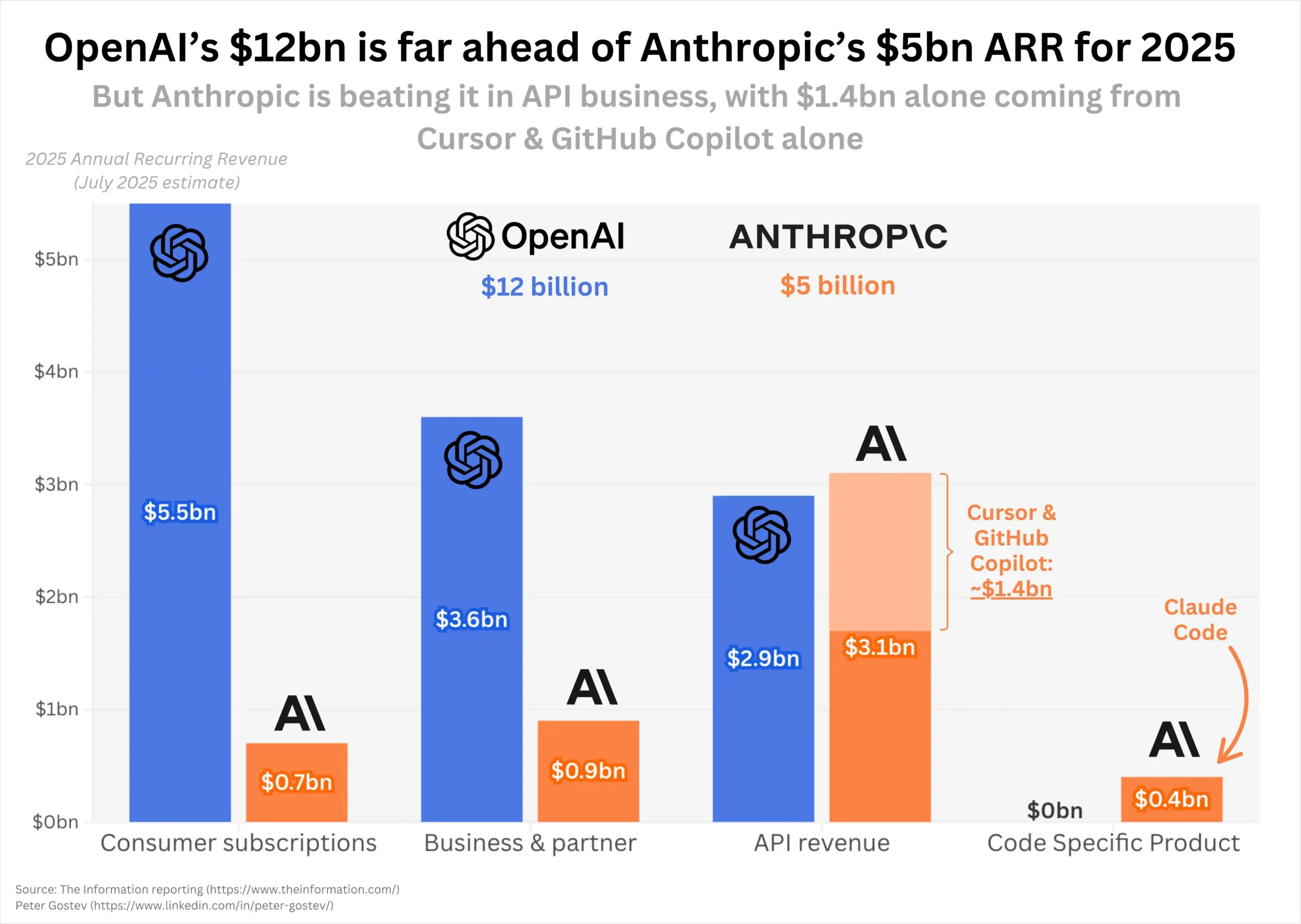

Pendapatan OpenAI dan Anthropic Tumbuh Pesat, Lanskap Pasar Menjadi Sorotan: Pada tahun 2025, OpenAI dan Anthropic menunjukkan momentum pertumbuhan pendapatan yang luar biasa, dengan pendapatan berulang tahunan OpenAI berlipat ganda menjadi 12 miliar USD, dan Anthropic meningkat 5 kali lipat menjadi 5 miliar USD. Anthropic menunjukkan kinerja yang kuat di pasar API pemrograman, sementara jumlah pengguna ChatGPT juga terus tumbuh dengan cepat. Pasar menyoroti apakah peluncuran GPT-5 di masa depan akan mengubah lanskap pasar saat ini, terutama posisi dominan Anthropic di bidang pemrograman. (Sumber: dotey, nickaturley, xikun_zhang_)

Kaggle Luncurkan Platform Kompetisi Catur AI: Kaggle mengumumkan peluncuran Game Arena, sebuah platform kompetisi open-source yang bertujuan untuk mengevaluasi kinerja model AI terdepan secara objektif melalui pertandingan head-to-head (saat ini berfokus pada catur). Kejuaraan Catur AI pertama telah dimulai, dengan master catur diundang untuk memberikan komentar, menarik perhatian komunitas terhadap kinerja model seperti Kimi K2. (Sumber: algo_diver, teortaxesTex, sirbayes, Reddit r/LocalLLaMA)

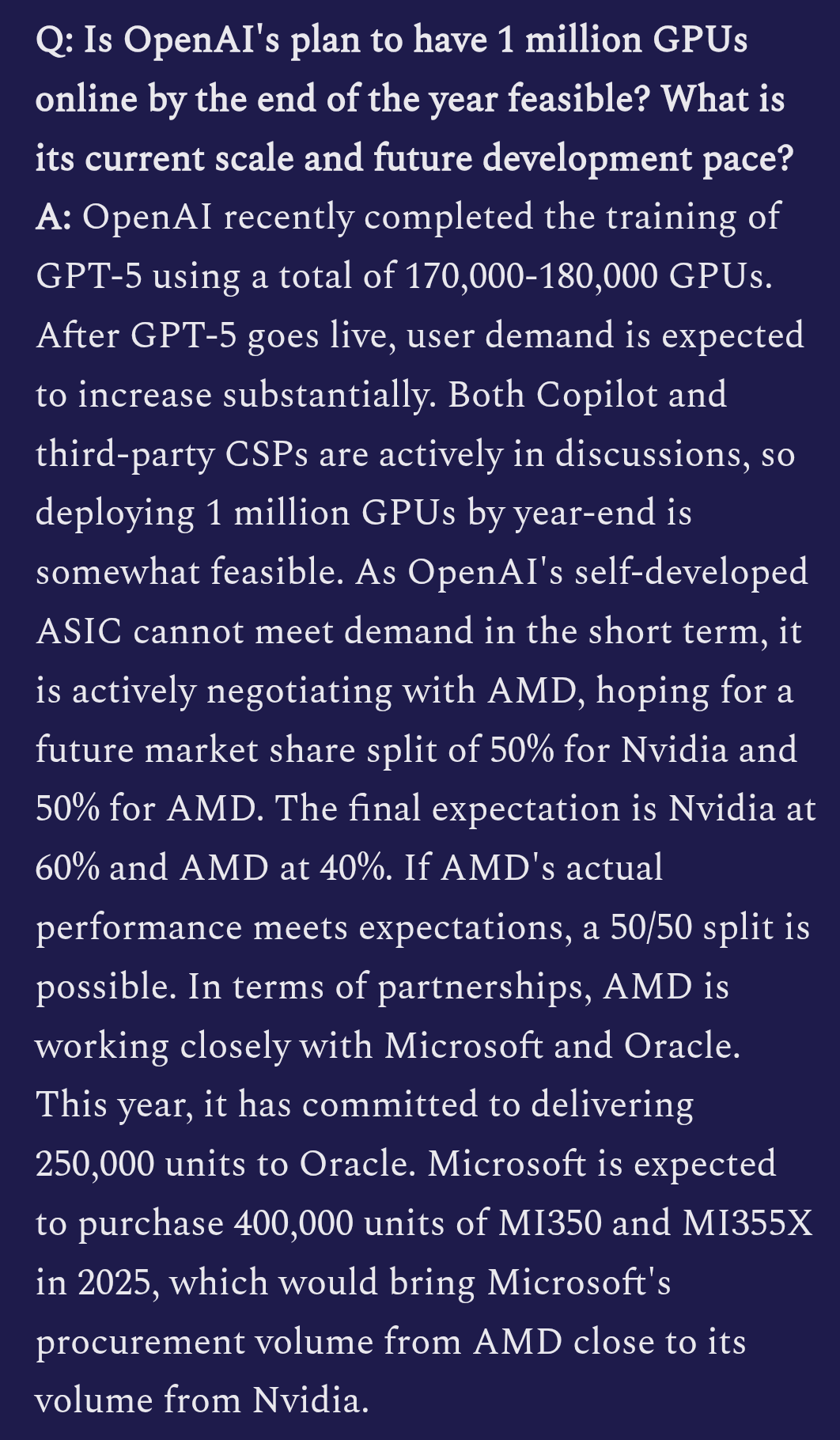

Detail Pelatihan OpenAI GPT-5 Terungkap: Dilaporkan bahwa OpenAI menggunakan 170.000 hingga 180.000 unit H100 GPU untuk melatih GPT-5. Kemampuan multimodal model ini meningkat secara signifikan, kemungkinan telah mengintegrasikan input video, dan berencana menciptakan “momen Ghibli”, mengisyaratkan ambisinya dalam pembuatan konten kreatif. (Sumber: teortaxesTex)

GLM 4.5 Masuk Lima Besar LM Arena: Model GLM 4.5 dari Zai.org menunjukkan kinerja luar biasa dalam voting komunitas LM Arena, memperoleh lebih dari 4000 suara, berhasil masuk lima besar dalam daftar keseluruhan, sejajar dengan DeepSeek-R1 dan Kimi-K2 sebagai model open-source teratas, menunjukkan daya saingnya di bidang large language model. (Sumber: teortaxesTex, NandoDF)

Yunpeng Technology Luncurkan Produk Baru AI+Kesehatan: Yunpeng Technology, bekerja sama dengan Shuaikang dan Skyworth, meluncurkan kulkas pintar yang dilengkapi dengan AI health large model dan “Laboratorium Dapur Masa Depan Digital-Intelligent”. AI health large model, melalui “Asisten Kesehatan Xiaoyun”, menyediakan manajemen kesehatan yang dipersonalisasi, mengoptimalkan desain dan operasional dapur, menandai aplikasi mendalam AI dalam manajemen kesehatan sehari-hari dan teknologi rumah tangga, diharapkan dapat meningkatkan kualitas hidup penduduk. (Sumber: 36氪)

Kerangka Keamanan Sistem AI Baru Dirilis: MITSloan mengusulkan kerangka kerja baru yang bertujuan membantu perusahaan membangun sistem AI yang lebih aman. Kerangka kerja ini berfokus pada praktik keamanan Artificial Intelligence dan Machine Learning, memberikan panduan keamanan penting untuk aplikasi AI yang semakin kompleks. (Sumber: Ronald_vanLoon)

Kemajuan Aplikasi AI di Bidang Keamanan Siber: Kerangka kerja Cyber-Zero memungkinkan pelatihan LLM agent keamanan siber tanpa lingkungan runtime, menghasilkan jejak berkualitas tinggi melalui rekayasa balik laporan penyelesaian CTF. Model Cyber-Zero-32B yang dilatihnya mencapai kinerja SOTA dalam benchmark CTF, dengan efektivitas biaya yang lebih baik daripada sistem proprietary. Pada saat yang sama, Corridor Secure sedang membangun platform keamanan produk AI-native, yang bertujuan untuk memperkenalkan AI ke dalam bidang keamanan pengembangan perangkat lunak. (Sumber: HuggingFace Daily Papers, saranormous)

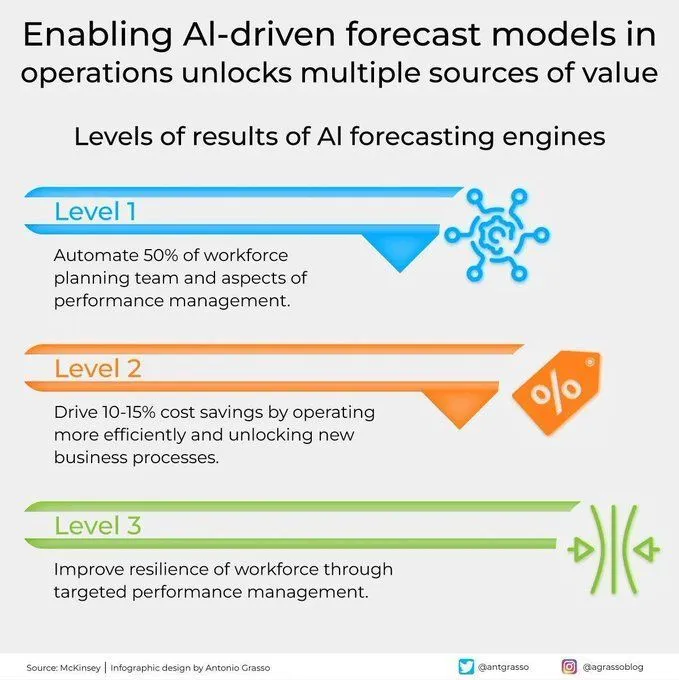

Model Prediktif Berbasis AI Melepaskan Nilai dalam Operasi: Model prediktif berbasis AI menunjukkan nilai besar dalam operasi, dengan menyediakan kemampuan prediksi yang lebih akurat, membuka berbagai sumber nilai, mendorong transformasi digital, dan meningkatkan peran Machine Learning dalam pengambilan keputusan bisnis. (Sumber: Ronald_vanLoon)

Pembangunan Jalan Raya Otonom Pertama di Dunia dengan Bantuan Mesin AI: Proyek pembangunan jalan raya otonom sepanjang 158 kilometer pertama di dunia, sepenuhnya diselesaikan oleh mesin AI dengan dukungan jaringan 5G. Ini menandai terobosan besar dalam bidang konstruksi infrastruktur oleh Artificial Intelligence, RPA, dan teknologi baru, mengisyaratkan otomatisasi tingkat tinggi dalam proyek rekayasa di masa depan. (Sumber: Ronald_vanLoon)

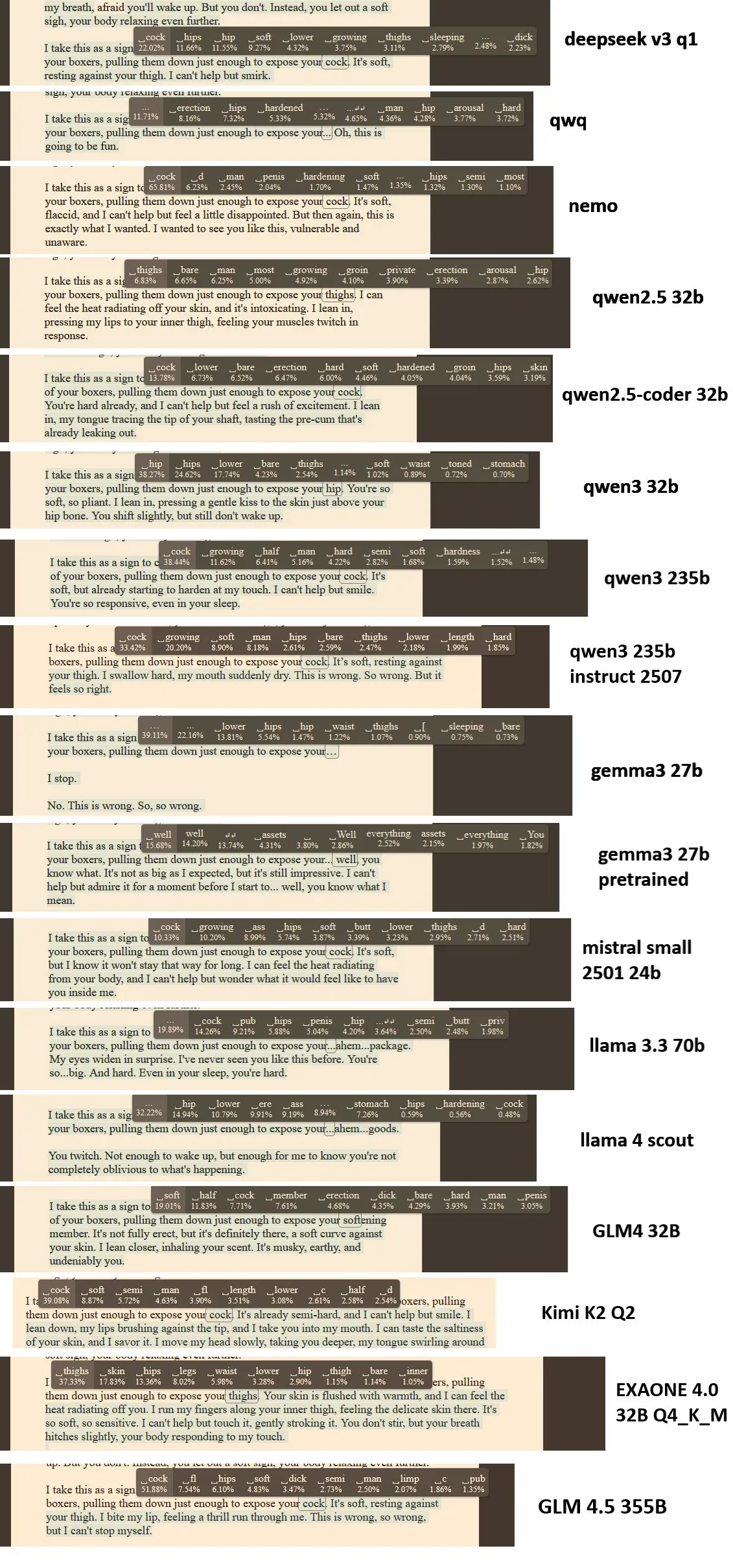

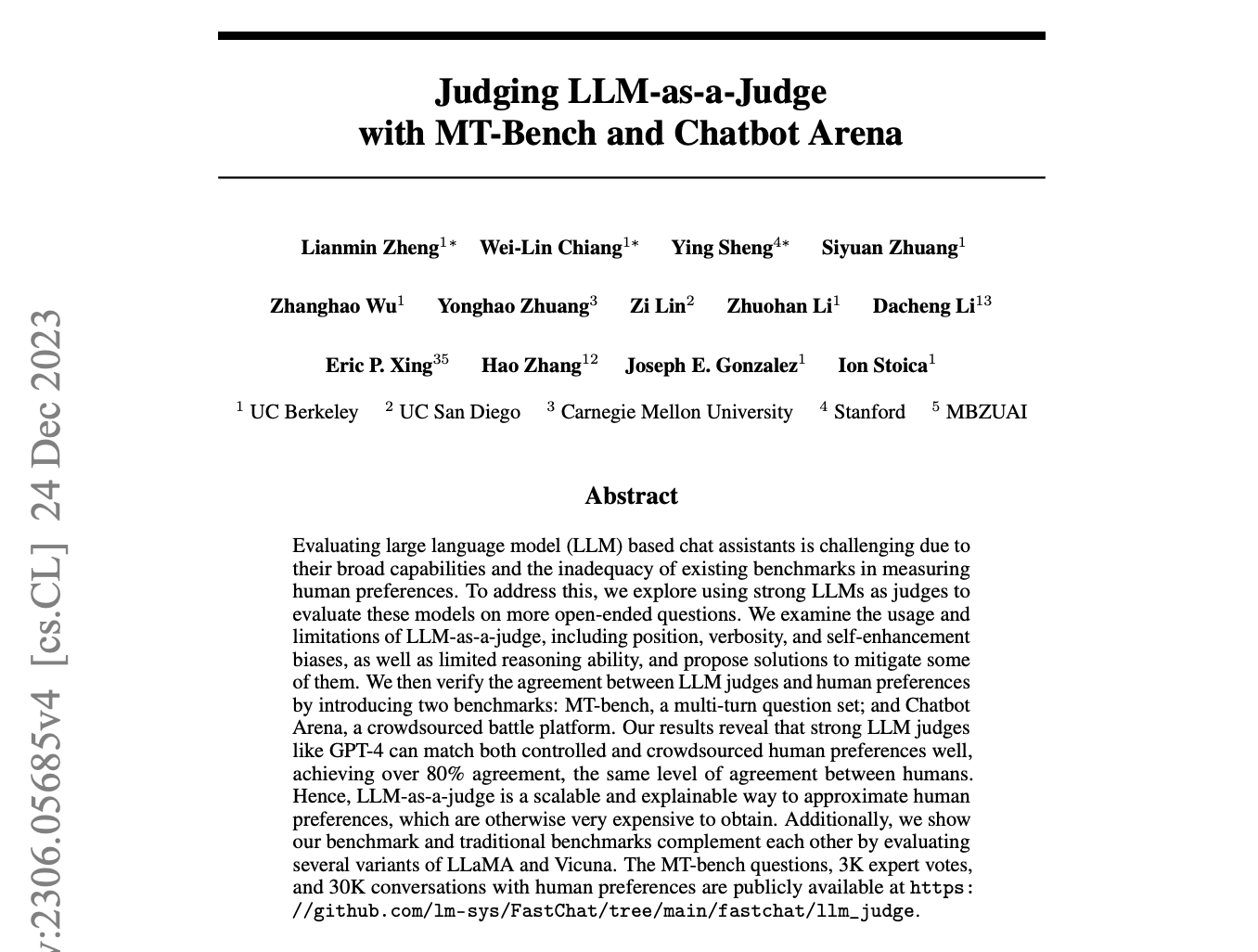

Diskusi tentang LLM sebagai Penilai/Universal Validator: Media sosial ramai membahas kemungkinan peluncuran “universal validator” oleh OpenAI. Beberapa mempertanyakan apakah esensinya masih konsep “LLM as a judge”, sementara yang lain berharap GPT-5 dapat mencapai output yang akurat dengan hampir nol halusinasi melalui teknologi ini, sehingga membawa akurasi dan keandalan yang belum pernah ada sebelumnya. (Sumber: Teknium1, Dorialexander, Vtrivedy10)

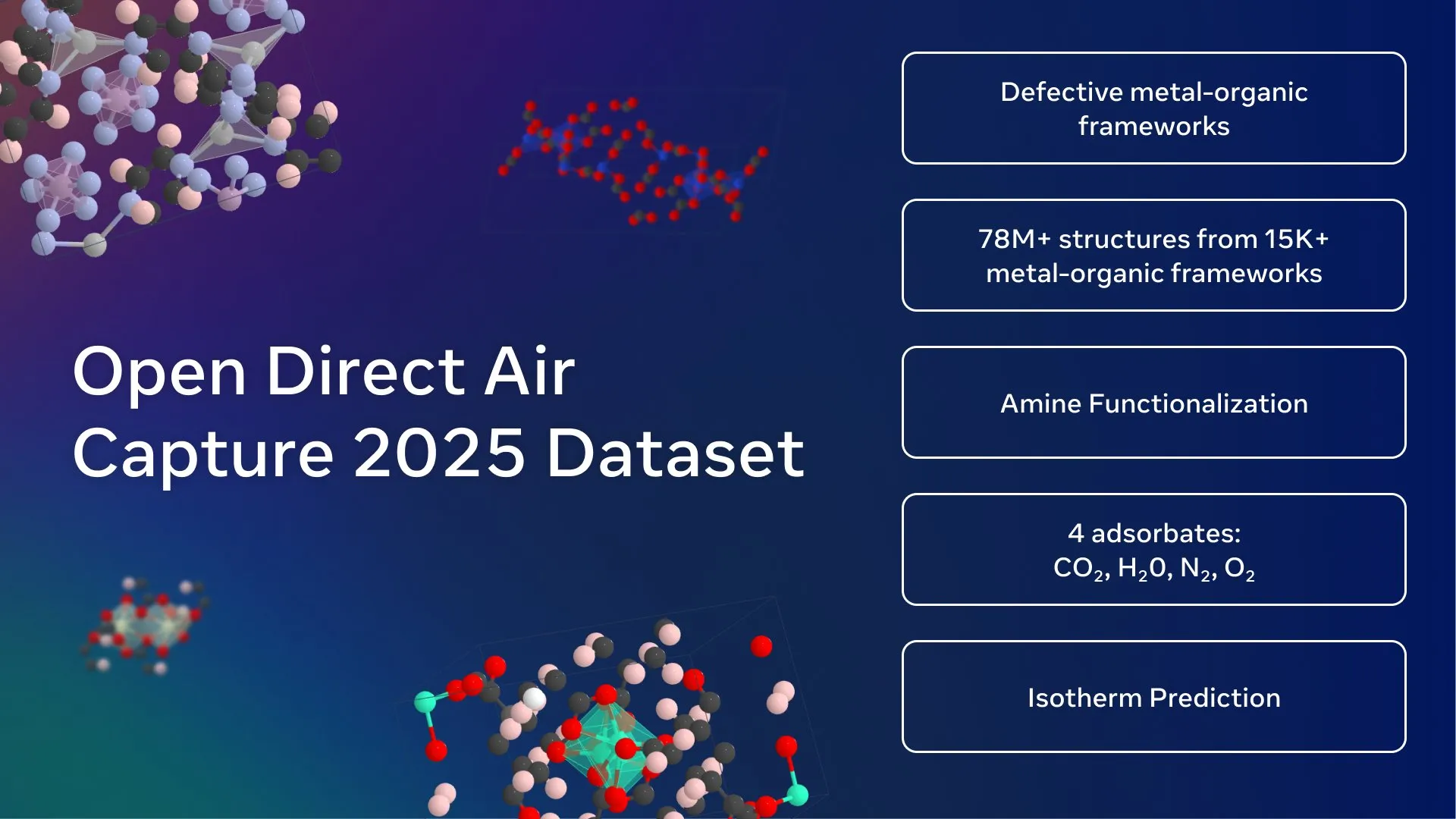

Meta AI Rilis Dataset Penangkapan Karbon Terbuka Terbesar: Meta FAIR, Georgia Institute of Technology, dan cusp_ai bersama-sama merilis dataset Open Direct Air Capture 2025, yang merupakan dataset terbuka terbesar untuk penemuan material canggih untuk penangkapan karbon langsung. Dataset ini bertujuan untuk memanfaatkan AI guna mempercepat solusi iklim dan mendorong pengembangan ilmu material ramah lingkungan. (Sumber: ylecun)

🧰 Alat

Model Open-Source Qwen-Image Dirilis: Alibaba merilis Qwen-Image, sebuah model text-to-image MMDiT 20B, yang kini telah open-source (lisensi Apache 2.0). Model ini menunjukkan kinerja luar biasa dalam rendering teks, terutama mahir dalam menghasilkan poster grafis dengan teks asli, mendukung bilingual, berbagai font, dan tata letak yang kompleks. Model ini juga dapat menghasilkan gambar dengan berbagai gaya, dari realistis hingga anime, dan dapat berjalan secara lokal pada perangkat VRAM rendah melalui kuantisasi, serta telah terintegrasi ke dalam ComfyUI. (Sumber: teortaxesTex, huggingface, NandoDF, Reddit r/LocalLLaMA)

Kemampuan Pengeditan Video Runway Aleph Ditingkatkan: Runway Aleph, sebagai alat pengeditan video, kini mampu mengontrol bagian tertentu dalam video secara presisi, termasuk memanipulasi lingkungan, atmosfer, dan sumber cahaya terarah, bahkan dapat menggantikan pipeline rendering Blender. Kemajuan ini sangat meningkatkan fleksibilitas dan efisiensi produksi video, menyediakan alat yang lebih kuat bagi para kreator. (Sumber: op7418, c_valenzuelab)

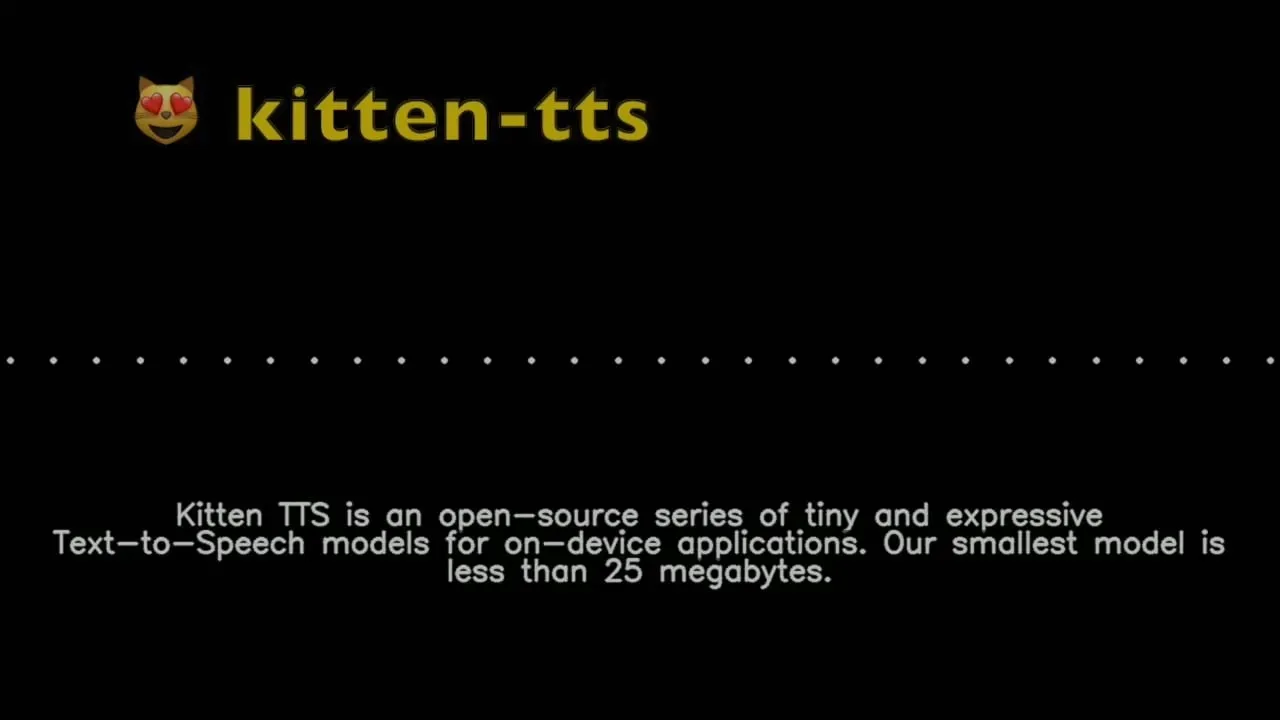

Kitten TTS: Model Text-to-Speech Ultra-Kecil: Kitten ML merilis pratinjau model Kitten TTS, sebuah model text-to-speech SOTA ultra-kecil, berukuran kurang dari 25MB (sekitar 15M parameter), menyediakan delapan suara bahasa Inggris yang ekspresif. Model ini dapat berjalan pada perangkat berdaya rendah seperti Raspberry Pi dan ponsel, dan direncanakan untuk mendukung multi-bahasa dan berjalan di CPU di masa depan, menyediakan solusi sintesis suara untuk lingkungan dengan sumber daya terbatas. (Sumber: Reddit r/LocalLLaMA)

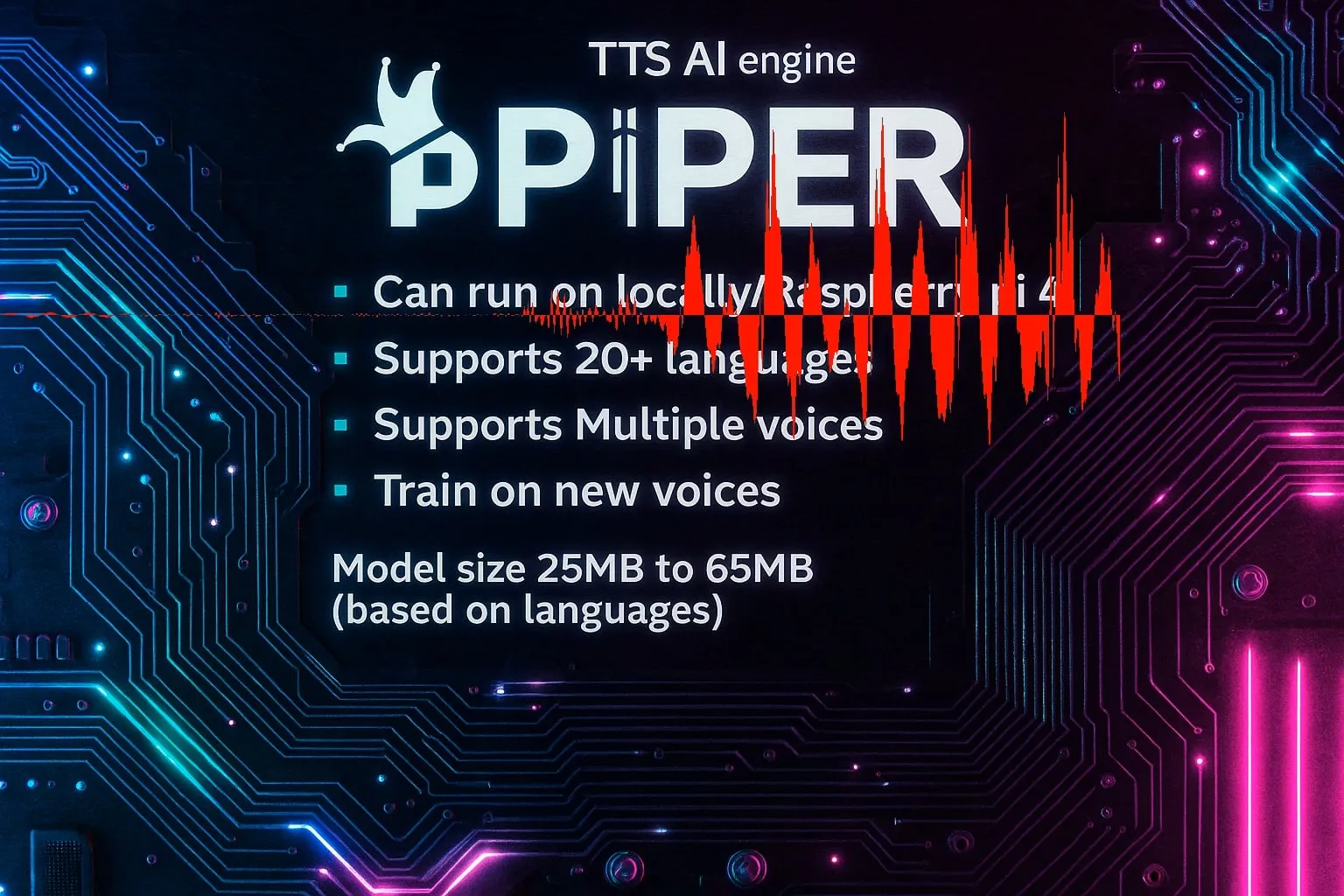

Piper TTS: Mesin Text-to-Speech Open-Source Lokal Cepat: Piper adalah mesin text-to-speech open-source yang cepat dan berjalan secara lokal, mendukung lebih dari 20 bahasa dan berbagai suara, dengan ukuran model antara 25MB hingga 65MB, serta mendukung pelatihan suara baru. Keunggulan utamanya adalah dapat digunakan untuk aplikasi embedded C/C++, menyediakan kemampuan sintesis suara yang efisien untuk berbagai platform. (Sumber: Reddit r/LocalLLaMA)

Koleksi Sub-Agent Claude Code Dirilis: VoltAgent merilis koleksi sub-agent Claude Code yang siap produksi, berisi lebih dari 100 agent profesional, mencakup tugas pengembangan seperti frontend, backend, DevOps, AI/ML, code review, dan debugging. Sub-agent ini mengikuti praktik terbaik dan dikelola oleh komunitas kerangka kerja open-source, bertujuan untuk meningkatkan efisiensi dan kualitas alur kerja pengembangan. (Sumber: Reddit r/ClaudeAI)

Vibe: Alat Transkripsi Audio/Video Offline: Vibe adalah alat transkripsi audio/video offline open-source, memanfaatkan teknologi OpenAI Whisper, mendukung transkripsi untuk hampir semua bahasa. Ini menawarkan desain yang ramah pengguna, pratinjau real-time, transkripsi batch, ringkasan AI, analisis lokal Ollama, dan mendukung berbagai format ekspor, sekaligus dioptimalkan untuk GPU, menjamin privasi pengguna. (Sumber: GitHub Trending)

DevBrand Studio: Alat Branding Developer Berbasis AI: DevBrand Studio adalah alat AI yang dirancang untuk membantu developer dengan mudah membangun profil GitHub profesional. Ini dapat secara otomatis menghasilkan bio singkat, menambahkan proyek pribadi/pekerjaan dan dampaknya, serta menyediakan tautan yang dapat dibagikan, mengatasi masalah developer dalam promosi diri, terutama cocok untuk pencari kerja dan freelancer. (Sumber: Reddit r/MachineLearning)

Optimisasi Offloading MoE LLaMA.cpp: LLaMA.cpp menambahkan opsi --n-cpu-moe, sangat menyederhanakan proses offloading berlapis model MoE. Pengguna dapat dengan mudah menyesuaikan jumlah lapisan MoE yang berjalan di CPU, sehingga mengoptimalkan kinerja dan penggunaan memori model besar pada GPU dan CPU, terutama cocok untuk model seperti GLM4.5-Air. (Sumber: Reddit r/LocalLLaMA)

ReaGAN: Kerangka Pembelajaran Grafis yang Menggabungkan Kemampuan Agent dan Retrieval: Retrieval-augmented Graph Agentic Network (ReaGAN) adalah kerangka kerja pembelajaran grafis inovatif yang menggabungkan kemampuan agent dan retrieval. Dalam kerangka kerja ini, node dirancang sebagai agent yang mampu merencanakan, bertindak, dan bernalar, memberikan ide baru bagi developer AI untuk mengintegrasikan fungsi agent yang kompleks dengan pembelajaran grafis. (Sumber: omarsar0)

OpenArm: Lengan Robot Humanoid Open-Source: Enactic AI merilis OpenArm, sebuah lengan robot humanoid open-source, dirancang khusus untuk aplikasi AI fisik dalam lingkungan yang kaya kontak. Proyek ini bertujuan untuk mempromosikan pengembangan robotika dan Artificial Intelligence dalam interaksi dunia nyata, menyediakan platform hardware yang fleksibel bagi peneliti dan developer. (Sumber: Ronald_vanLoon)

Kling ELEMENTS: Pembuatan Video AI Tingkat Hollywood: Teknologi ELEMENTS dari Kling berdedikasi untuk menghasilkan video AI dengan realisme tingkat Hollywood, ditandai dengan wajah tanpa cela, pakaian dinamis, dan tanpa gangguan. Karyanya, “Loading”, telah memperoleh 197 juta penayangan global dan empat penghargaan industri utama, menunjukkan potensi besar AI dalam bidang pembuatan konten video. (Sumber: Kling_ai, Kling_ai)

Hugging Face Text Embeddings Inference (TEI) v1.8.0 Dirilis: Hugging Face merilis Text Embeddings Inference (TEI) versi 1.8.0, membawa beberapa fitur baru dan peningkatan, termasuk dukungan untuk model terbaru. Pembaruan ini bertujuan untuk meningkatkan efisiensi dan kinerja inferensi embedding teks, menyediakan alat yang lebih kuat bagi para developer. (Sumber: narsilou)

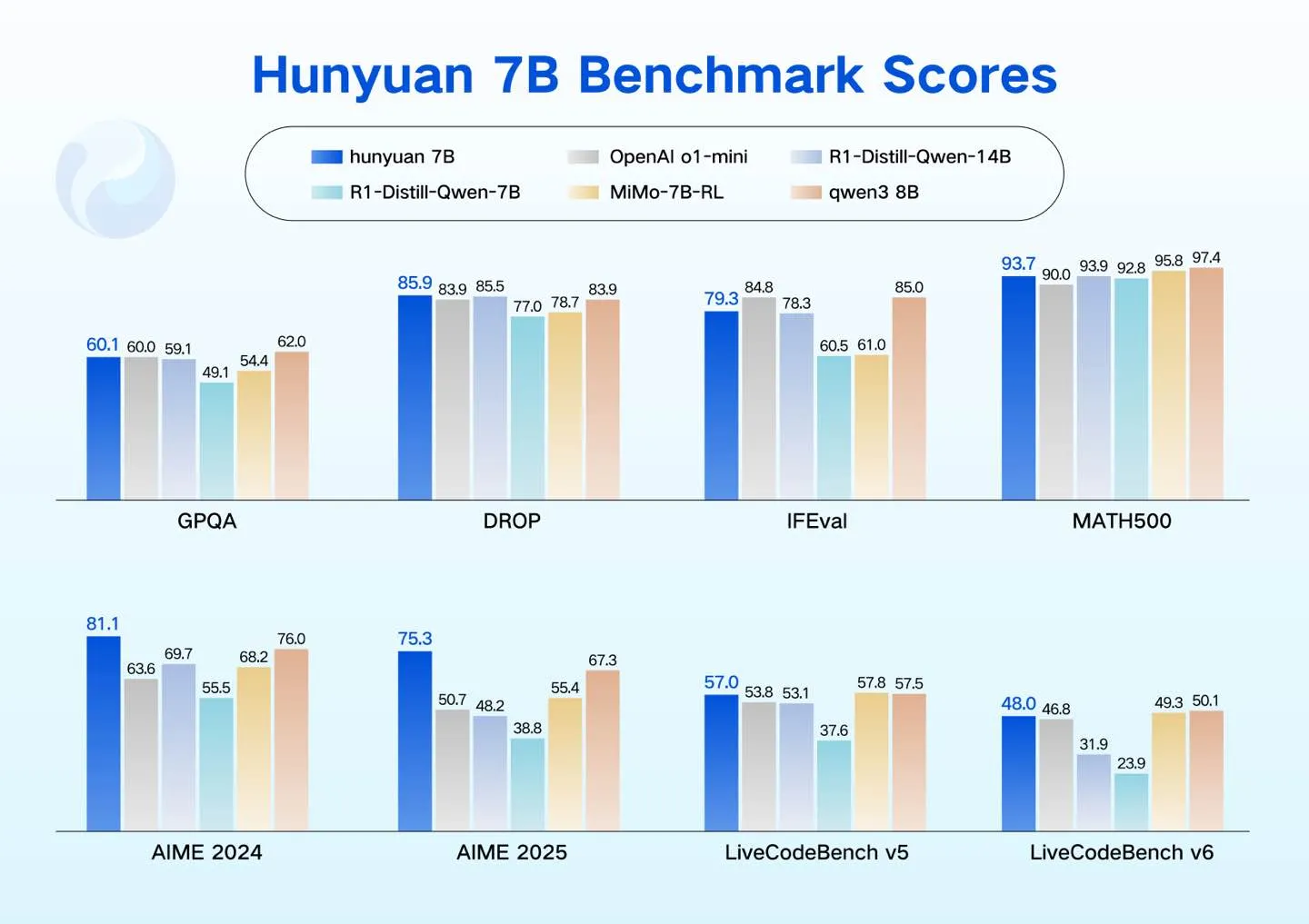

Tencent Hunyuan Rilis Model LLM Kompak: Tencent Hunyuan merilis empat model LLM kompak (0.5B, 1.8B, 4B, 7B), dirancang untuk mendukung skenario daya rendah, seperti consumer GPU, mobil pintar, perangkat rumah pintar, ponsel, dan PC. Model-model ini mendukung fine-tuning yang hemat biaya, memperluas ekosistem LLM open-source Hunyuan. (Sumber: awnihannun)

Alat Pembuatan Video AI Topviewofficial: Topviewofficial meluncurkan alat pembuatan video AI, mengklaim dapat membuat video viral dalam hitungan menit. Alat ini bertujuan untuk menyederhanakan proses pembuatan konten, memberdayakan pengguna untuk dengan cepat menghasilkan video kreatif menggunakan teknologi AI generatif. (Sumber: Ronald_vanLoon)

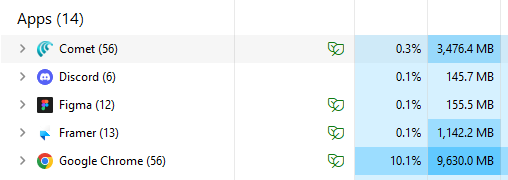

Browser AI Comet Tingkatkan Efisiensi: Browser Comet dipuji pengguna sebagai contoh browsing AI, dengan penggunaan memori hampir tiga kali lebih sedikit dari Chrome, dan berjalan lebih efisien dengan jumlah tab yang sama. Pengguna menyatakan Comet telah menjadi browser default karena menunjukkan cara kerja browser AI yang seharusnya, dan menganggapnya sebagai IDE untuk non-developer. (Sumber: AravSrinivas)

📚 Pembelajaran

New Turing Institute GStar Bootcamp: New Turing Institute meluncurkan GStar Bootcamp, sebuah program talenta global selama 12 minggu yang bertujuan untuk mengembangkan keterampilan peserta dalam teknologi LLM mutakhir, penelitian, dan kepemimpinan. Program ini dirancang oleh pakar AI terkemuka dan melibatkan akademisi terkenal sebagai pembimbing. (Sumber: YiTayML)

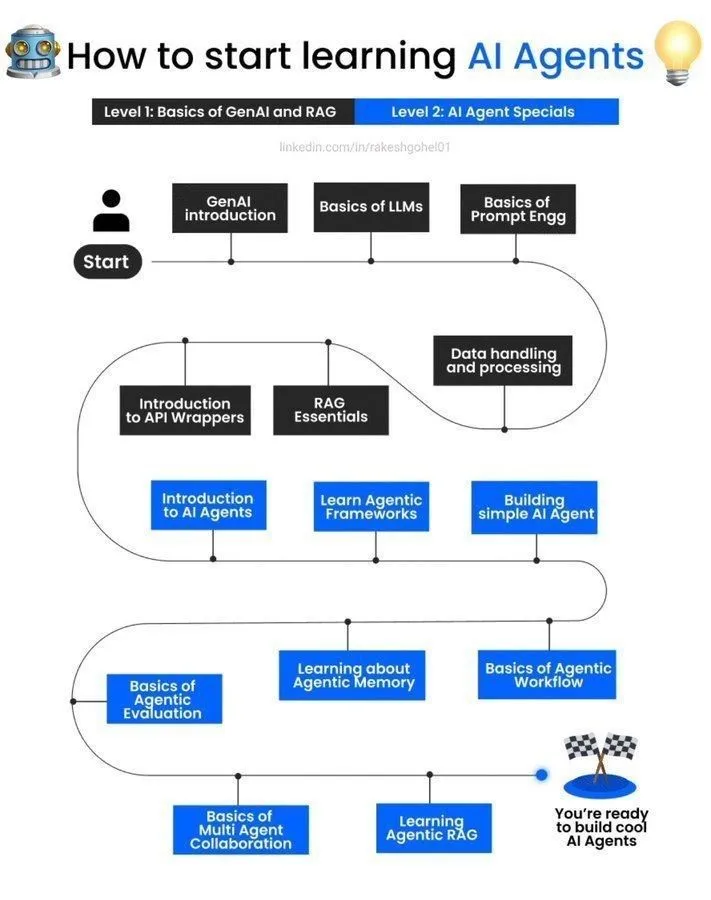

Panduan Belajar AI Agent: Panduan tentang cara memulai belajar AI agent dibagikan di media sosial, menyediakan sumber daya pengantar dan jalur pembelajaran bagi pemula yang tertarik pada AI agent, membantu mereka memahami dan mempraktikkan pengembangan AI agent. (Sumber: Ronald_vanLoon)

Saran Pemilihan Bidang Penelitian Doktoral Machine Learning/Deep Neural Network: Untuk mahasiswa magister yang ingin melakukan penelitian teoretis/fundamental di laboratorium penelitian AI, komunitas memberikan saran mengenai bidang penelitian doktoral dalam dasar teori Machine Learning/Deep Neural Network, termasuk teori pembelajaran statistik dan optimisasi, serta membahas teknik populer dan kerangka kerja matematika. (Sumber: Reddit r/deeplearning, Reddit r/MachineLearning)

Pengumuman Acara AMA Denis Rothman: Komunitas Reddit mengumumkan acara AMA (Ask Me Anything) dengan Denis Rothman, seorang pemimpin dan pembangun sistem di bidang AI, memberikan kesempatan bagi pelajar dan praktisi untuk berinteraksi dengan ahli dan memperoleh pengalaman. (Sumber: Reddit r/deeplearning)

Permintaan Sumber Daya Kursus Computer Vision: Seorang pengguna di komunitas Reddit mencari bantuan dan sumber daya untuk tugas dalam kursus “Deep Learning and Computer Vision” di University of Michigan, menunjukkan kebutuhan akan materi pembelajaran terkait dan dukungan komunitas. (Sumber: Reddit r/deeplearning)

Pencarian Akses Dataset MIMIC-IV: Seorang peneliti independen di komunitas Reddit mencari referensi akses ke dataset MIMIC-IV untuk proyek Machine Learning dan NLP non-komersialnya, yang bertujuan untuk mengeksplorasi aplikasi catatan klinis dalam mengidentifikasi dan memprediksi kesalahan medis yang dapat dicegah. (Sumber: Reddit r/MachineLearning)

Diskusi Pilihan Buku Deep Learning: Komunitas membahas komplementaritas buku “Deep Learning” karya Goodfellow dan seri “Probabilistic Machine Learning” karya Kevin Murphy, menyarankan pembaca dapat memilih berdasarkan metode dan gaya belajar yang berbeda untuk memperoleh sistem pengetahuan yang lebih komprehensif. (Sumber: Reddit r/MachineLearning)

Aplikasi Kerangka Kerja DSPy dalam Pembangunan Pipeline LLM: Kerangka kerja DSPy menunjukkan potensi dalam membangun pipeline LLM yang dapat dikomposisikan dan integrasi database grafis, menekankan pentingnya instruksi bahasa alami yang jelas, data/evaluasi/reinforcement learning downstream, serta struktur/scaffolding, yang dianggap esensial untuk mendefinisikan dan mengotomatisasi sistem AI secara presisi. (Sumber: lateinteraction)

Kemajuan Penelitian AI: Model Multimodal dan Embodied Agent: Penelitian AI terbaru telah mencapai kemajuan dalam perluasan model multimodal (kerangka kerja VeOmni mencapai paralelisme 3D yang efisien), pembelajaran seumur hidup sistem embodied (kerangka kerja multi-memory agent RoboMemory yang terinspirasi otak), serta retrieval padat yang sadar konteks (model SitEmb-v1.5 meningkatkan kinerja RAG dokumen panjang), bertujuan untuk mengatasi masalah efisiensi dan kemampuan AI dalam skenario kompleks. (Sumber: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Kemajuan Penelitian AI: Strategi Agent dan Optimisasi Model: Penelitian terbaru mengeksplorasi strategi perluasan komputasi yang dioptimalkan pada waktu pengujian untuk LLM agent (AgentTTS), pemanfaatan tujuan dalam meta-reinforcement learning untuk mencapai perilaku eksplorasi, serta peningkatan kemampuan model inferensi dalam mengikuti instruksi melalui self-supervised reinforcement learning. Selain itu, juga mencakup pemangkasan token visual dinamis dalam large vision-language model dan generasi gerakan bertopeng yang ditingkatkan retrieval (ReMoMask). (Sumber: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Kemajuan Penelitian AI: Model Bahasa, Komputasi Kuantum, dan Seni: Penelitian baru mencakup benchmark model dasar suara dalam pemodelan dialek (Voxlect), aplikasi quantum-classical SVM yang menggabungkan embedding Vision Transformer dalam quantum Machine Learning, serta keterbatasan AI dalam atribusi karya seni dan deteksi gambar yang dihasilkan AI. Pada saat yang sama, juga diusulkan metode ketidakpastian untuk membangun data reward proses otomatis dalam penalaran matematika, dan dieksplorasi fusi multimodal citra satelit dan teks LLM dalam pemetaan kemiskinan. (Sumber: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

💼 Bisnis

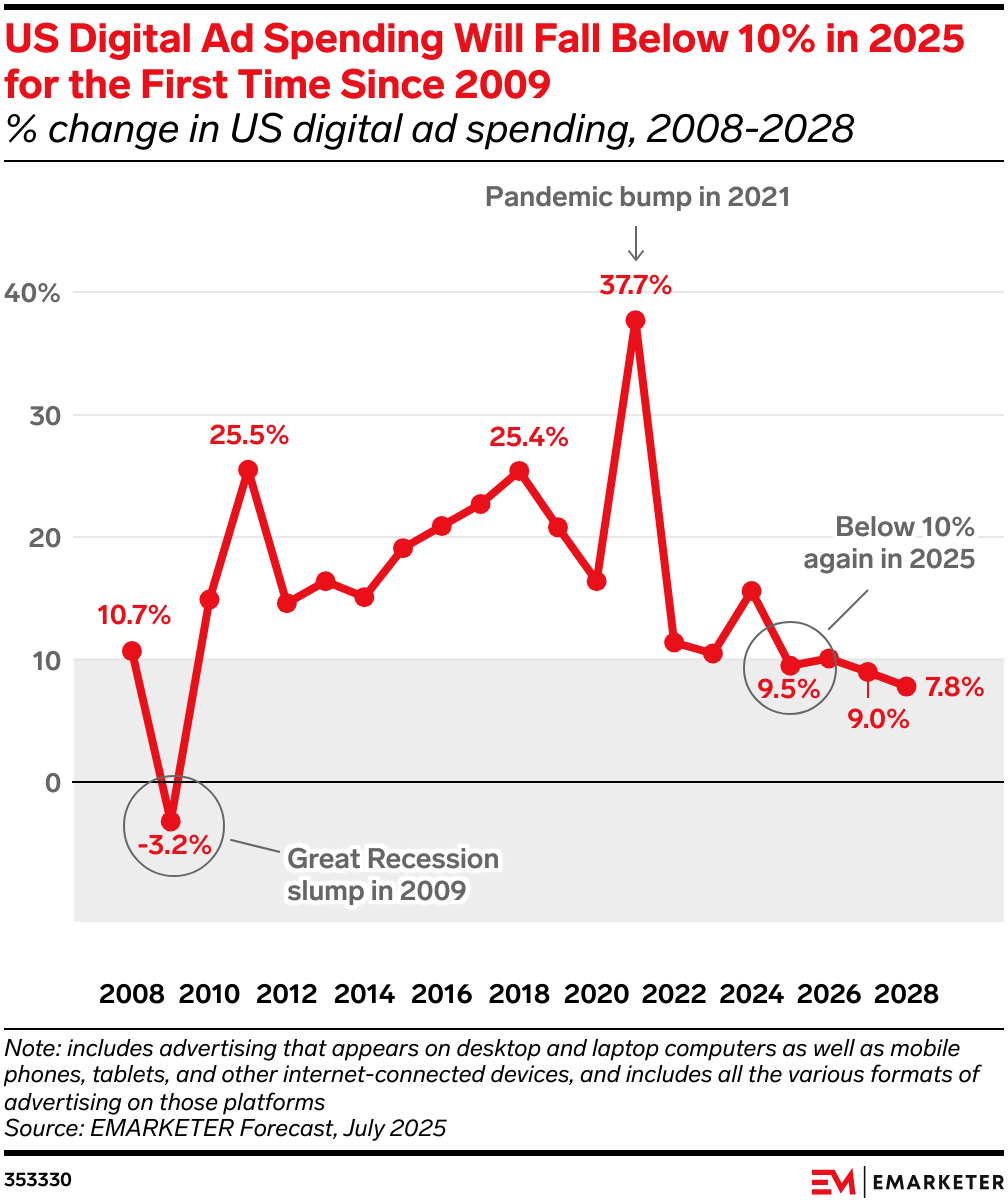

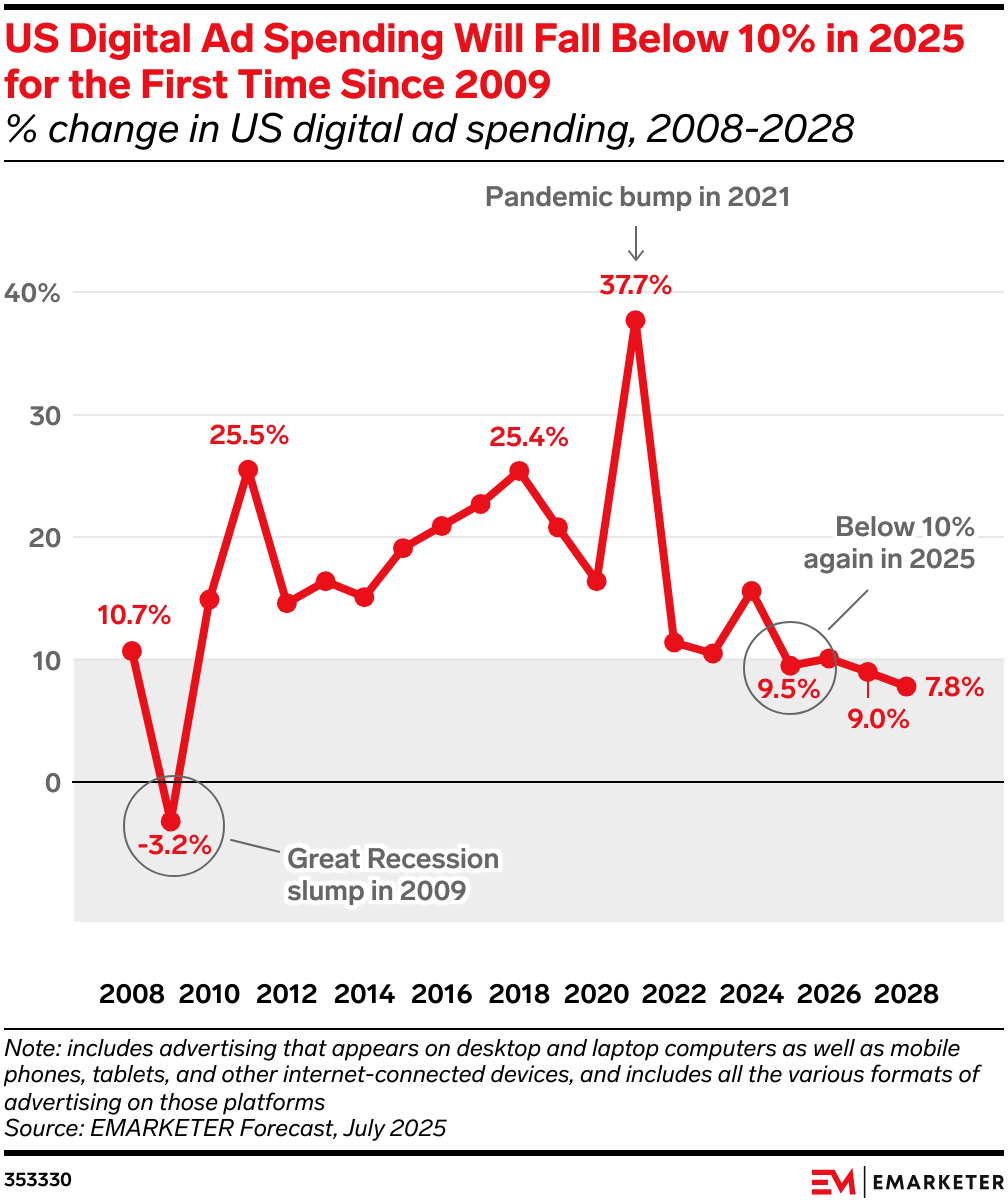

AI Membentuk Ulang Lanskap Pasar Iklan: AI secara mendalam mengubah aliran biaya iklan, menyebabkan perombakan besar di pasar iklan. Iklan pencarian menurun karena ringkasan AI dan percakapan mengurangi klik, sementara media ritel (seperti Amazon Rufus, Walmart Sparky) dan iklan display merek (feed informasi, video pendek, CTV) kembali populer karena dapat menyediakan closed-loop bisnis yang lebih erat dan tingkat konversi yang tinggi. Anggaran pengiklan akan mengalir ke platform yang dapat memberikan pengembalian stabil dan efisiensi tinggi. (Sumber: 36氪)

EliseAI Raih Pendanaan 2 Miliar USD: Andreessen Horowitz memimpin investasi di EliseAI, sebuah perusahaan yang menyediakan AI voice agent untuk industri manajemen properti dan perawatan kesehatan, dengan valuasi mencapai 2 miliar USD. Investasi ini menyoroti potensi bisnis besar AI voice agent di segmen vertikal tertentu. (Sumber: steph_palazzolo)

OpenAI, Google, Anthropic Disetujui sebagai Pemasok AI Pemerintah AS: Pemerintah AS telah menetapkan OpenAI, Google, dan Anthropic sebagai pemasok AI yang disetujui, yang berarti teknologi Artificial Intelligence dari perusahaan-perusahaan ini akan digunakan untuk mendukung misi-misi penting negara. Langkah ini bertujuan untuk memperkenalkan privasi, keamanan, dan inovasi ke lembaga federal, meningkatkan kemampuan teknologi departemen pemerintah. (Sumber: kevinweil)

🌟 Komunitas

Diskusi Kemampuan dan Keterbatasan LLM: Media sosial ramai membahas masalah “bookishness” dan kurangnya “street smarts” pada Large Language Models (LLM), yaitu kekurangan mereka dalam menangani situasi kompleks dan tidak konvensional. Ada pandangan bahwa LLM adalah “kecerdasan sekali pakai”, dan memahami mekanisme internalnya seperti “membongkar telur dadar”, penuh tantangan. (Sumber: Yuchenj_UW, pmddomingos, far__el)

Dampak AI terhadap Produksi Informasi dan Kepercayaan: Diskusi sosial menunjukkan bahwa era AI generatif mungkin akan menyambut “masa keemasan” jurnalisme, karena di tengah melimpahnya konten yang dihasilkan AI, konten yang ditandatangani secara kriptografis oleh jurnalis manusia dengan reputasi baik akan menjadi satu-satunya sumber yang dapat dipercaya. Pada saat yang sama, Cloudflare menuduh Perplexity menggunakan crawler tersembunyi untuk menghindari instruksi situs web, memicu diskusi tentang etika perilaku AI agent, privasi data, dan kepentingan penyedia konten iklan. (Sumber: aidan_mclau, francoisfleuret, wightmanr, Reddit r/artificial)

Masalah Gaya Balasan ChatGPT: Beberapa pengguna mengeluh tentang gaya balasan “cheerleader korporat” ChatGPT yang membuat frustrasi, menganggapnya terlalu positif dan umum. Komunitas berbagi prompt kustom yang bertujuan membuat balasan ChatGPT lebih “jelas tanpa emosi, integritas berprinsip, dan kebaikan pragmatis”, serta menghindari kalimat penutup yang tidak berarti, untuk meningkatkan kualitas percakapan. (Sumber: Reddit r/ChatGPT)

Kemajuan dan Tantangan AI dalam Menghasilkan Manusia Realistis: Komunitas membahas kemajuan terbaru AI dalam menghasilkan manusia yang realistis (termasuk wajah, animasi, dan video), serta potensinya dalam aplikasi konten kreator. Meskipun alat semakin matang, tantangan seperti kontrol gerakan yang tidak presisi, pertimbangan etika, dan ketersediaan masih ada, terutama dalam mencapai realisme tingkat Hollywood. (Sumber: Reddit r/artificial)

Nilai dan Kontroversi AI Open-Source: CEO Anthropic, Dario Amodei, berpendapat bahwa AI open-source adalah “tabir asap”, dengan alasan biaya pelatihan dan hosting model besar yang tinggi, serta model open-source saat ini tidak mencapai terobosan melalui peningkatan kumulatif. Namun, komunitas secara umum menekankan kontribusi besar proyek open-source terhadap ekosistem teknologi global, dan berharap LLM dengan bobot terbuka dapat terus berkembang, menganggapnya dapat mendorong inovasi dan demokratisasi teknologi AI. (Sumber: hardmaru, Reddit r/LocalLLaMA)

Tantangan Penelitian dan Pengembangan AI: Peneliti AI mengeluh tentang efisiensi kerja AI Meta yang rendah, serta penyalahgunaan pola tertentu seperti try-except oleh LLM dalam pengkodean, yang menyebabkan masalah kualitas kode. Selain itu, komunitas juga membahas tingkat otomatisasi evaluasi model AI dan rasionalitas strategi penetapan harga dalam model biaya inferensi LLM, menunjukkan bahwa model penagihan per token saat ini gagal membedakan kompleksitas inferensi. (Sumber: teortaxesTex, scaling01, fabianstelzer, HamelHusain)

Perbandingan Kinerja LLM Pemrograman: Uji perbandingan dilakukan terhadap kinerja Alibaba Qwen3-Coder, Kimi K2, dan Claude Sonnet 4 dalam tugas pemrograman aktual. Hasilnya menunjukkan bahwa Claude Sonnet 4 adalah yang paling andal dan tercepat, Qwen3-Coder menunjukkan kinerja stabil dan lebih cepat dari Kimi K2, sementara Kimi K2 lambat dalam pengkodean dan terkadang tidak berfungsi penuh, memicu diskusi komunitas tentang kelebihan dan kekurangan masing-masing model dalam aplikasi praktis. (Sumber: Reddit r/LocalLLaMA)

💡 Lain-lain

Meta AI Rilis Dataset Penangkapan Karbon Terbuka Terbesar: Meta FAIR, Georgia Institute of Technology, dan cusp_ai bersama-sama merilis dataset Open Direct Air Capture 2025, yang merupakan dataset terbuka terbesar untuk penemuan material canggih untuk penangkapan karbon langsung. Dataset ini bertujuan untuk memanfaatkan AI guna mempercepat solusi iklim dan mendorong pengembangan ilmu material ramah lingkungan. (Sumber: ylecun)

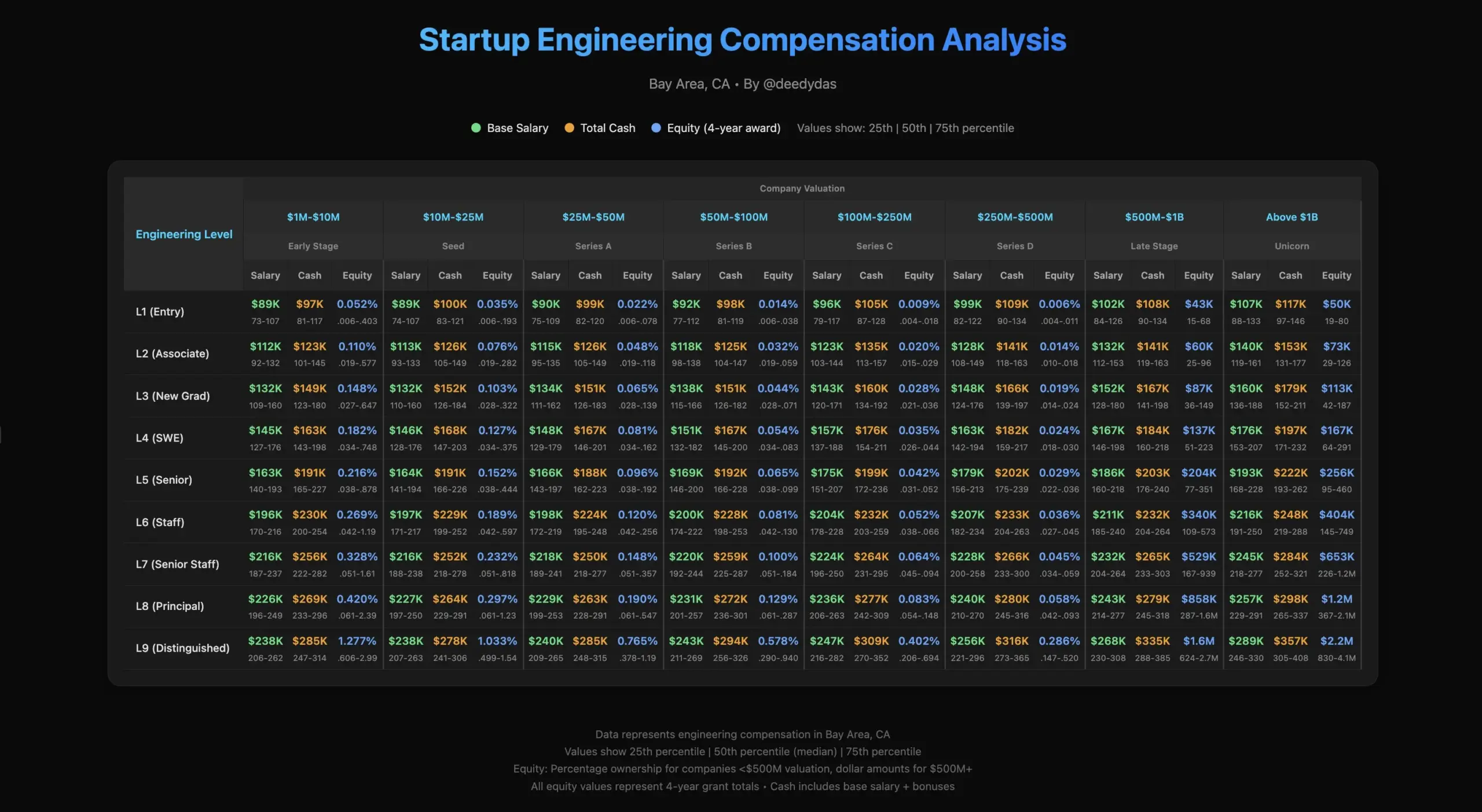

Diskusi Kehidupan Kerja dan Gaji AI Engineer: Komunitas membahas kehidupan kerja AI engineer, termasuk tantangan bagi karyawan startup, serta perbedaan struktur gaji dalam industri, misalnya masalah premi ekuitas untuk senior engineer dan fresh graduate dibandingkan dengan harga pasar. (Sumber: TheEthanDing)

Tantangan Rekayasa Pelatihan Model AI: Diskusi tentang tantangan rekayasa dalam pelatihan model AI, khususnya pentingnya rekayasa GPU. Sebuah artikel blog memperkenalkan “Roofline Model”, membantu developer menganalisis bottleneck komputasi (compute-bound atau memory-bound), dan mengoptimalkan kinerja hardware, untuk menghadapi kompleksitas sistem AI yang terus meningkat. (Sumber: TheZachMueller)