Kata Kunci:Hak cipta data pelatihan AI, AlphaGenome, OpenAI plagiat perangkat keras, Skor ujian masuk perguruan tinggi AI, Gemini CLI, Metode baru RLT, BitNet b1.58, Agen cerdas Biomni, Putusan penggunaan wajar AI, Prediksi pasangan basa DNA, Tanggapan Altman atas tuduhan plagiat, Peningkatan kemampuan matematika model besar, Kuota gratis agen AI terminal

🔥 Fokus

Putusan Penting Hak Cipta Data Pelatihan AI: Pengadilan AS Memutuskan Penggunaan Buku yang Dibeli Secara Sah untuk Pelatihan AI Merupakan “Fair Use”: Pengadilan federal AS dalam gugatan terhadap Anthropic memutuskan bahwa penggunaan buku terbitan yang dibeli secara sah oleh perusahaan AI untuk melatih model bahasa besar termasuk dalam kategori “fair use” dan tidak memerlukan persetujuan penulis sebelumnya. Pengadilan berpendapat bahwa pelatihan AI merupakan “penggunaan transformatif” dari karya asli, tidak secara langsung menggantikan pasar karya asli, serta bermanfaat bagi inovasi teknologi dan kepentingan publik. Namun, pengadilan juga memutuskan bahwa penggunaan buku bajakan untuk pelatihan tidak termasuk fair use, dan Anthropic masih mungkin bertanggung jawab atas hal tersebut. Putusan ini merujuk pada preseden kasus Google Books tahun 2015 dan dianggap sebagai langkah penting dalam mengurangi risiko hak cipta data pelatihan AI, yang berpotensi memengaruhi penanganan kasus serupa lainnya (seperti gugatan terhadap OpenAI dan Meta). Sebelumnya, Meta juga memenangkan putusan yang menguntungkan dalam gugatan hak cipta serupa, di mana hakim menilai penggugat gagal membuktikan secara memadai bahwa penggunaan buku mereka oleh Meta untuk melatih model AI telah menyebabkan kerugian ekonomi. Putusan-putusan ini secara kolektif memberikan panduan hukum yang lebih jelas bagi industri AI dalam hal perolehan dan penggunaan data, namun menekankan pentingnya perolehan data secara sah. (Sumber: 量子位, DeepLearning.AI Blog, wiredmagazine)

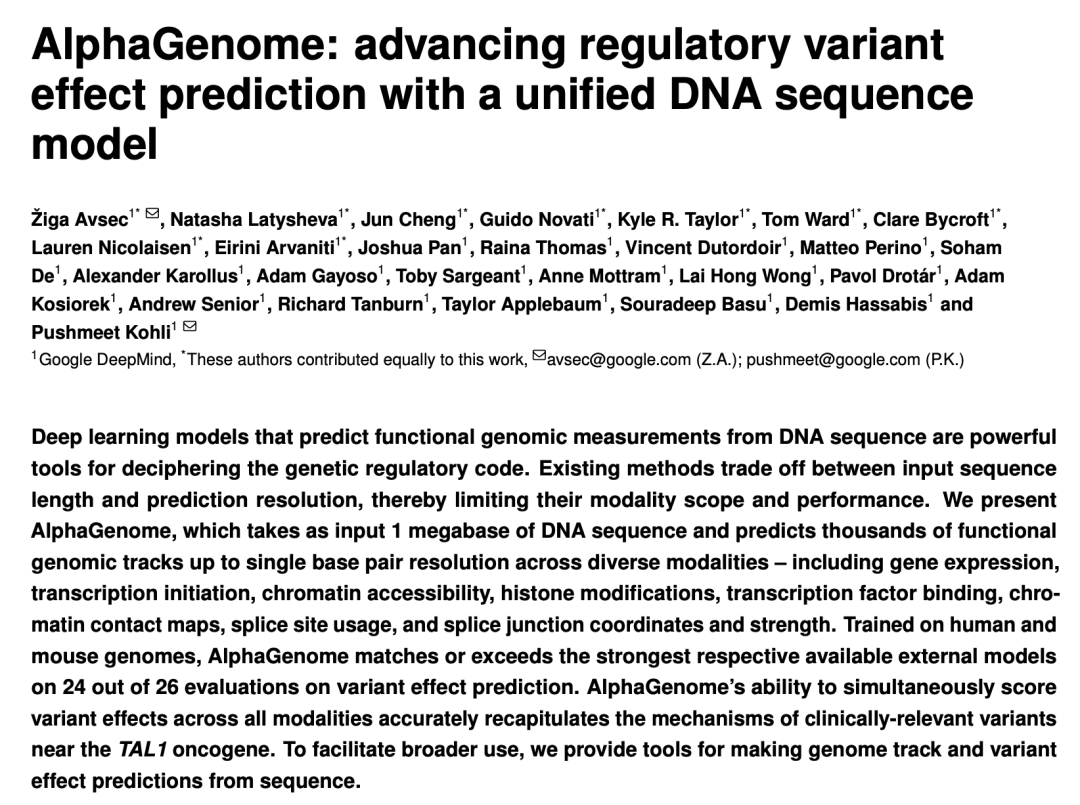

Google DeepMind Merilis AlphaGenome: “Mikroskop” AI Memprediksi Dampak Variasi Genetik pada Jutaan Pasangan Basa DNA: Google DeepMind meluncurkan model AI AlphaGenome, yang mampu menerima input berupa sekuens DNA sepanjang hingga 1 juta pasangan basa, memprediksi ribuan karakteristik molekuler, dan mengevaluasi dampak variasi genetik. Model ini menunjukkan kinerja terdepan dalam lebih dari 20 benchmark prediksi genom. AlphaGenome memiliki fitur pemrosesan konteks sekuens panjang beresolusi tinggi, prediksi multi-modal yang komprehensif, penilaian variasi yang efisien, dan model sambungan splicing yang baru. Pelatihan satu model hanya membutuhkan waktu 4 jam dengan anggaran komputasi setengah dari model Enformer sebelumnya. Model ini bertujuan membantu ilmuwan memahami regulasi gen, mempercepat pemahaman penyakit (terutama penyakit langka), memandu desain biologi sintetis, dan mendorong penelitian dasar. Saat ini tersedia versi pratinjau melalui API untuk penggunaan penelitian non-komersial, dengan rencana rilis penuh di masa mendatang. (Sumber: 36氪, Google, demishassabis)

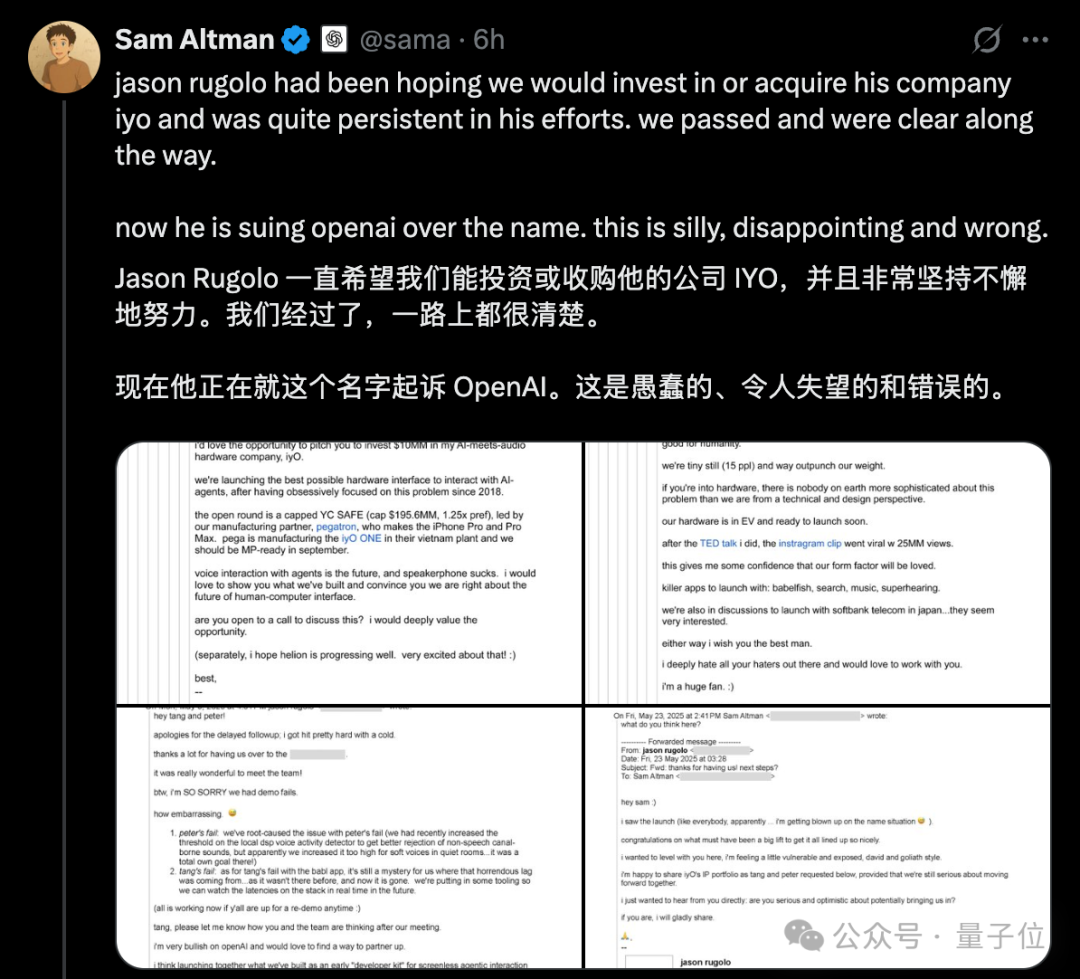

Kontroversi “Penjiplakan” Hardware OpenAI Meningkat, Altman Membantah Gugatan IYO dengan Email Publik: Menanggapi tuduhan dari perusahaan startup hardware AI, IYO, yang menuduh OpenAI dan perusahaan hardware yang diakuisisinya, io (didirikan oleh mantan desainer Apple Jony Ive), melakukan pelanggaran merek dagang dan penjiplakan produk, CEO OpenAI Sam Altman memberikan respons publik di media sosial. Ia menyebut gugatan IYO “konyol, mengecewakan, dan sepenuhnya salah.” Altman menunjukkan tangkapan layar email yang menunjukkan bahwa pendiri IYO, Jason Rugolo, sebelumnya secara aktif mencari investasi atau akuisisi senilai 10 juta USD dari OpenAI, dan bahkan setelah OpenAI mengumumkan akuisisi io, Rugolo masih berharap untuk membagikan kekayaan intelektualnya. Altman berpendapat bahwa IYO mengajukan gugatan setelah upaya investasi atau akuisisinya gagal. Pendiri IYO membalas dengan mengatakan bahwa Altman sedang melakukan “pengadilan online” dan tetap bersikeras atas hak nama produknya. Sebelumnya, pengadilan telah menyetujui perintah penahanan sementara dari IYO, yang melarang OpenAI menggunakan logo IO. Pihak OpenAI menyatakan bahwa produk hardware mereka berbeda dari perangkat ear-worn kustom IYO, desain prototipe belum final, dan baru akan diluncurkan setidaknya setahun lagi. (Sumber: 量子位, 36氪)

Model AI Besar Kembali Hadapi Ujian Masuk Perguruan Tinggi, Skor Keseluruhan Meningkat Signifikan, Kemampuan Matematika Menonjol: Hasil evaluasi simulasi ujian masuk perguruan tinggi AI tahunan GeekPark 2025 menunjukkan bahwa skor keseluruhan model bahasa besar utama (seperti Doubao, DeepSeek R1, ChatGPT o3, dll.) meningkat pesat dibandingkan tahun lalu, menunjukkan potensi untuk bersaing di perguruan tinggi ternama. Diperkirakan Doubao, sebagai peraih skor tertinggi, dapat masuk dalam peringkat 900 teratas di Provinsi Shandong. Fenomena bias kemampuan AI antara jurusan IPA dan IPS telah berkurang, dengan rata-rata skor IPA meningkat lebih cepat. Matematika menjadi mata pelajaran dengan kemajuan paling signifikan, dengan rata-rata skor meningkat 84,25 poin, melampaui Bahasa dan Sastra serta Bahasa Inggris. Kemampuan multimodal menjadi faktor pembeda utama, terutama dalam mata pelajaran yang banyak mengandung soal gambar seperti Fisika dan Geografi. Meskipun AI unggul dalam penalaran kompleks dan komputasi, AI masih melakukan kesalahan dalam memahami soal sederhana dengan informasi visual yang membingungkan (seperti soal vektor matematika). Dalam hal esai, AI mampu menulis artikel dengan struktur lengkap dan argumen yang kaya, namun kurang dalam pemikiran mendalam dan resonansi emosional, sehingga sulit menghasilkan karya tulis terbaik. (Sumber: 36氪)

🎯 Dinamika

Google Merilis Gemini CLI yang Didukung Gemini 2.5 Pro, Menawarkan Kuota Gratis Besar yang Menarik Perhatian: Google secara resmi merilis Gemini CLI, sebuah asisten AI yang berjalan di lingkungan terminal dan didukung oleh model Gemini 2.5 Pro. Keunggulannya terletak pada kuota penggunaan gratis yang sangat besar: mendukung jendela konteks 1 juta token, dengan 60 panggilan model per menit dan 1000 panggilan per hari. Ini menjadi pesaing kuat bagi alat berbayar seperti Claude Code dari Anthropic. Gemini CLI menggunakan lisensi open-source Apache 2.0, mendukung penulisan kode, debugging, manajemen proyek, pencarian dokumentasi, serta pemanggilan layanan Google lainnya (seperti pembuatan gambar dan video) melalui MCP. Google menekankan keunggulan model universalnya dalam menangani tugas pengembangan yang kompleks, berpendapat bahwa model khusus kode justru dapat terbatas. Komunitas merespons dengan antusias, percaya bahwa ini akan mendorong普及 dan persaingan alat AI CLI. (Sumber: 36氪, Reddit r/LocalLLaMA, dotey)

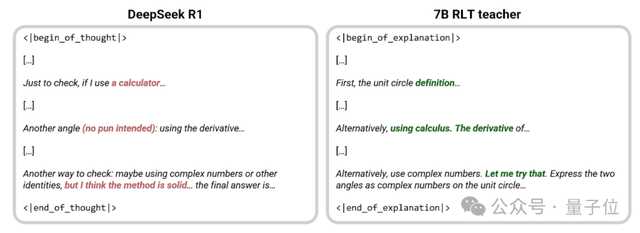

Sakana AI Mengajukan Metode Baru RLT, Model Kecil 7B “Mengajar” Lebih Baik dari DeepSeek-R1: Sakana AI, didirikan oleh salah satu penulis Transformer, Llion Jones, mengajukan metode baru Reinforcement Learning Teachers (RLTs). Metode ini membuat model guru tidak lagi menyelesaikan masalah dari awal, melainkan memberikan penjelasan langkah demi langkah yang jelas berdasarkan solusi yang sudah diketahui, meniru pengajaran “heuristik” dari guru manusia yang unggul. Eksperimen menunjukkan bahwa model kecil 7B RLT yang dilatih dengan metode ini, dalam hal mengajarkan keterampilan penalaran, memiliki efek yang lebih baik daripada DeepSeek-R1 671B, dan dapat secara efektif melatih model siswa yang 3 kali lebih besar (seperti 32B), dengan biaya pelatihan yang juga jauh lebih rendah. Metode ini bertujuan untuk mengatasi masalah model guru tradisional yang bergantung pada kemampuan menyelesaikan masalahnya sendiri, lambat dalam pelatihan, dan mahal, dengan menyelaraskan pelatihan guru dengan tujuan sebenarnya (membantu model siswa belajar) untuk meningkatkan efisiensi. (Sumber: 量子位, SakanaAILabs)

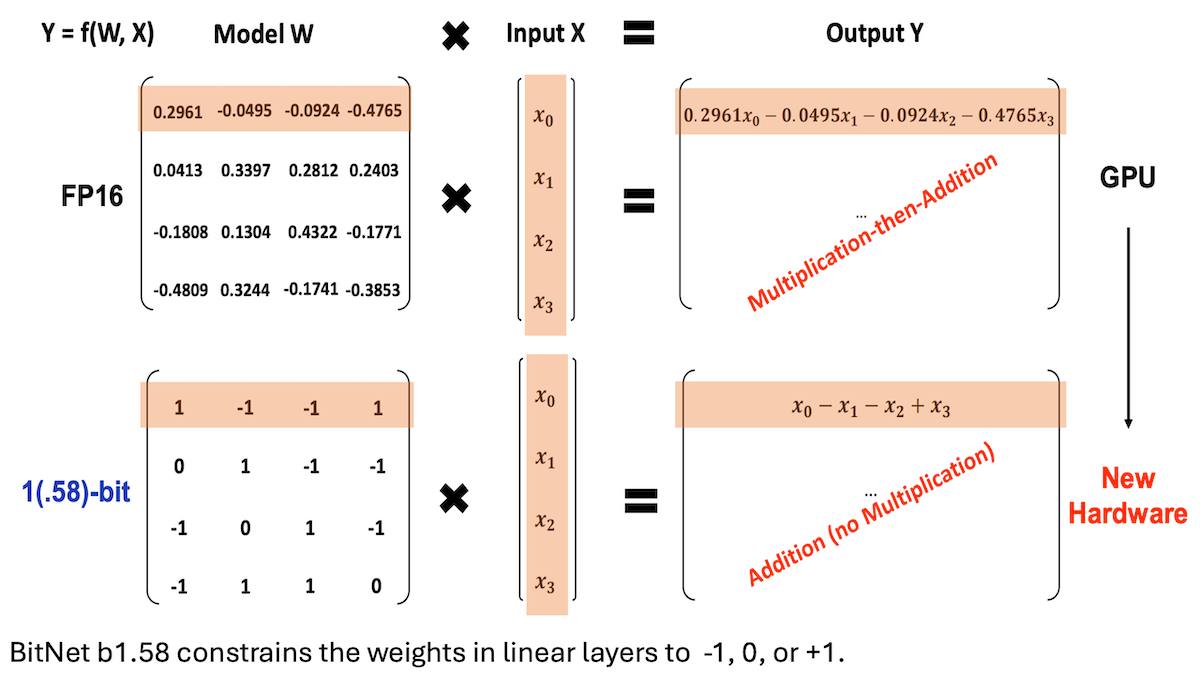

Microsoft dkk. Mengajukan BitNet b1.58, Mencapai LLM dengan Presisi Rendah dan Kinerja Inferensi Tinggi: Peneliti dari Microsoft, University of Chinese Academy of Sciences, dan Tsinghua University memperbarui model BitNet b1.58, yang sebagian besar bobotnya terbatas pada tiga nilai: -1, 0, atau +1 (sekitar 1,58 bit/parameter). Pada skala 2 miliar parameter, kinerjanya dapat bersaing dengan model presisi penuh teratas. Model ini dioptimalkan melalui strategi pelatihan yang dirancang dengan cermat (seperti pelatihan sadar kuantisasi, laju pembelajaran dua tahap, dan peluruhan bobot). Dalam 16 benchmark populer, kecepatan dan penggunaan memorinya lebih unggul dari Qwen2.5-1.5B, Gemma-3 1B, dll., dengan akurasi rata-rata mendekati Qwen2.5-1.5B, dan lebih baik dari versi kuantisasi 4-bit Qwen2.5-1.5B. Pekerjaan ini menunjukkan bahwa dengan penyesuaian hiperparameter yang cermat, model presisi rendah juga dapat mencapai kinerja tinggi, memberikan ide baru untuk penerapan LLM yang efisien. (Sumber: DeepLearning.AI Blog)

Stanford dkk. Meluncurkan Agen Intelijen Riset Biologi Biomni, Mengintegrasikan Ratusan Alat dan Basis Data: Peneliti dari Stanford University, Princeton University, dan institusi lainnya meluncurkan Biomni, sebuah agen AI yang dirancang khusus untuk penelitian biologi yang luas. Agen ini didasarkan pada Claude 4 Sonnet, mengintegrasikan 150 alat yang diekstraksi dan disaring dari 2500 makalah terbaru dari 25 bidang spesialisasi biologi (termasuk genomik, imunologi, neurosains, dll.), hampir 60 basis data, serta sekitar 100 paket perangkat lunak biologi populer. Biomni mampu melakukan berbagai tugas seperti mengajukan pertanyaan, mengajukan hipotesis, merancang alur kerja, menganalisis dataset, dan menghasilkan grafik. Biomni menggunakan kerangka kerja CodeAct, merespons kueri melalui perencanaan iteratif, pembuatan kode, dan eksekusi, serta memperkenalkan instans Claude 4 Sonnet lain sebagai penilai untuk mengevaluasi kewajaran output perantara. Dalam beberapa benchmark seperti Lab-bench dan studi kasus aktual, Biomni menunjukkan kinerja yang lebih unggul daripada Claude 4 Sonnet tunggal dan model Claude yang ditingkatkan dengan pencarian literatur. (Sumber: DeepLearning.AI Blog)

Anthropic Meluncurkan Fitur Baru Claude Code: Membuat dan Berbagi Artifacts yang Didukung AI: Anthropic memperkenalkan fitur baru untuk asisten pemrograman AI-nya, Claude Code, yang memungkinkan pengguna membuat, menghosting, dan berbagi “Artifacts” (dapat dipahami sebagai aplikasi atau alat AI kecil), dan dapat menyematkan kecerdasan Claude secara langsung ke dalam kreasi tersebut. Ini berarti pengguna tidak hanya dapat menggunakan Claude untuk menghasilkan cuplikan kode atau melakukan analisis, tetapi juga membangun aplikasi fungsional yang didukung AI. Fitur utama adalah ketika berbagi aplikasi AI ini, penonton menggunakan akun Claude mereka sendiri untuk otentikasi, dan penggunaannya akan dihitung dalam kuota langganan penonton, bukan pembuat. Fitur ini saat ini dalam tahap beta dan terbuka untuk semua pengguna gratis, Pro, dan Max, bertujuan untuk menurunkan ambang batas pembuatan aplikasi AI dan mempromosikan普及 dan berbagi kemampuan AI. (Sumber: kylebrussell, Reddit r/ClaudeAI)

Maya Research Merilis Model Veena TTS, Mendukung Bahasa Hindi dan Inggris, dengan Warna Suara Lebih Mendekati Asli India: Maya Research meluncurkan model text-to-speech (TTS) bernama Veena, yang didasarkan pada arsitektur Llama 3B dan menggunakan lisensi Apache 2.0. Fitur menonjol Veena adalah kemampuannya menghasilkan suara bahasa Inggris dan Hindi dengan aksen India, termasuk skenario code-mix, mengatasi kekurangan model TTS yang ada dalam pelafalan lokalisasi India. Model ini memiliki latensi di bawah 80 milidetik, dapat berjalan di lingkungan Google Colab gratis, dan telah tersedia di Hugging Face Hub. Tim menyatakan sedang aktif mengembangkan dukungan untuk bahasa India lainnya seperti Tamil, Telugu, dan Bengali. (Sumber: huggingface, huggingface)

HiDream.ai Merilis vivago2.0, Mengintegrasikan Kemampuan Generasi dan Penyuntingan Multimodal: HiDream.ai (智象未来), didirikan oleh pakar AI Mei Tao, meluncurkan alat kreasi AI multimodal vivago2.0. Produk ini mengintegrasikan fungsi-fungsi seperti generasi gambar, konversi gambar ke video, AI podcast (sinkronisasi bibir), template efek khusus, dan lainnya, serta memiliki komunitas kreatif bagi pengguna untuk berbagi dan mendapatkan inspirasi. Teknologi intinya didasarkan pada agen cerdas gambar baru HiDream-A1, yang mengintegrasikan versi closed-source lanjutan dari HiDream-I1 (model dasar generasi gambar 17 miliar parameter) yang sebelumnya open-source dan menduduki puncak arena kompetisi text-to-image, dan HiDream-E1 (model penyuntingan gambar interaktif). vivago2.0 bertujuan untuk menurunkan ambang batas pembuatan konten multimodal, menyediakan ratusan template efek khusus, dan mendukung generasi serta modifikasi gambar melalui dialog bahasa alami (Image Agent). (Sumber: 量子位)

Nvidia Merilis GPU Seri RTX 5050, Konfigurasi Memori Versi Desktop dan Laptop Berbeda: Nvidia secara resmi merilis GPU seri GeForce RTX 5050, termasuk versi desktop dan laptop, yang dijadwalkan rilis pada bulan Juli, dengan harga eceran yang disarankan untuk versi desktop di Tiongkok mulai dari 2099 yuan. Versi desktop RTX 5050 memiliki 2560 inti Blackwell CUDA, dilengkapi dengan memori GDDR6 8GB, dan konsumsi daya maksimum 130W. Versi laptop RTX 5050 juga memiliki 2560 inti CUDA, tetapi dilengkapi dengan memori GDDR7 8GB yang lebih hemat daya. Nvidia mengklaim bahwa dengan teknologi DLSS 4, RTX 5050 dapat mencapai frame rate ray tracing lebih dari 150fps dalam game seperti Cyberpunk 2077. Dibandingkan dengan RTX 3050, kinerja rasterisasi rata-rata meningkat 60% (versi desktop) dan 2,4 kali (versi laptop). Perbedaan konfigurasi memori kali ini mencerminkan strategi Nvidia dalam menyeimbangkan biaya dan kinerja di segmen pasar yang berbeda. (Sumber: 量子位)

LM Studio Diperbarui untuk Mendukung Protokol MCP, Dapat Menghubungkan LLM Lokal dengan Server MCP: Alat menjalankan LLM di desktop, LM Studio, merilis versi baru (0.3.17) yang menambahkan dukungan untuk Model Context Protocol (MCP). Pengguna sekarang dapat menghubungkan model bahasa besar yang berjalan secara lokal dengan server yang kompatibel dengan MCP, misalnya untuk memanggil alat atau layanan eksternal. LM Studio memperbarui antarmuka programnya untuk ini, memungkinkan pengguna menginstal dan mengkonfigurasi layanan MCP, serta dapat secara otomatis memuat dan mengelola proses server MCP lokal. Untuk memudahkan konfigurasi, LM Studio juga menyediakan alat online untuk menghasilkan tautan konfigurasi server MCP yang dapat diimpor dengan sekali klik. (Sumber: multimodalart, karminski3)

Gradio Meluncurkan Pustaka Pelacakan Eksperimen Ringan Trackio: Tim Gradio di bawah Hugging Face merilis Trackio, sebuah pustaka pelacakan dan visualisasi eksperimen yang ringan. Alat ini ditulis dengan kurang dari 1000 baris kode Python, sepenuhnya open-source dan gratis, serta mendukung penggunaan lokal atau terkelola. Trackio bertujuan membantu pengembang mencatat dan memantau berbagai metrik dan hasil selama proses eksperimen machine learning dengan lebih mudah, menyederhanakan alur kerja manajemen eksperimen. (Sumber: ClementDelangue, _akhaliq)

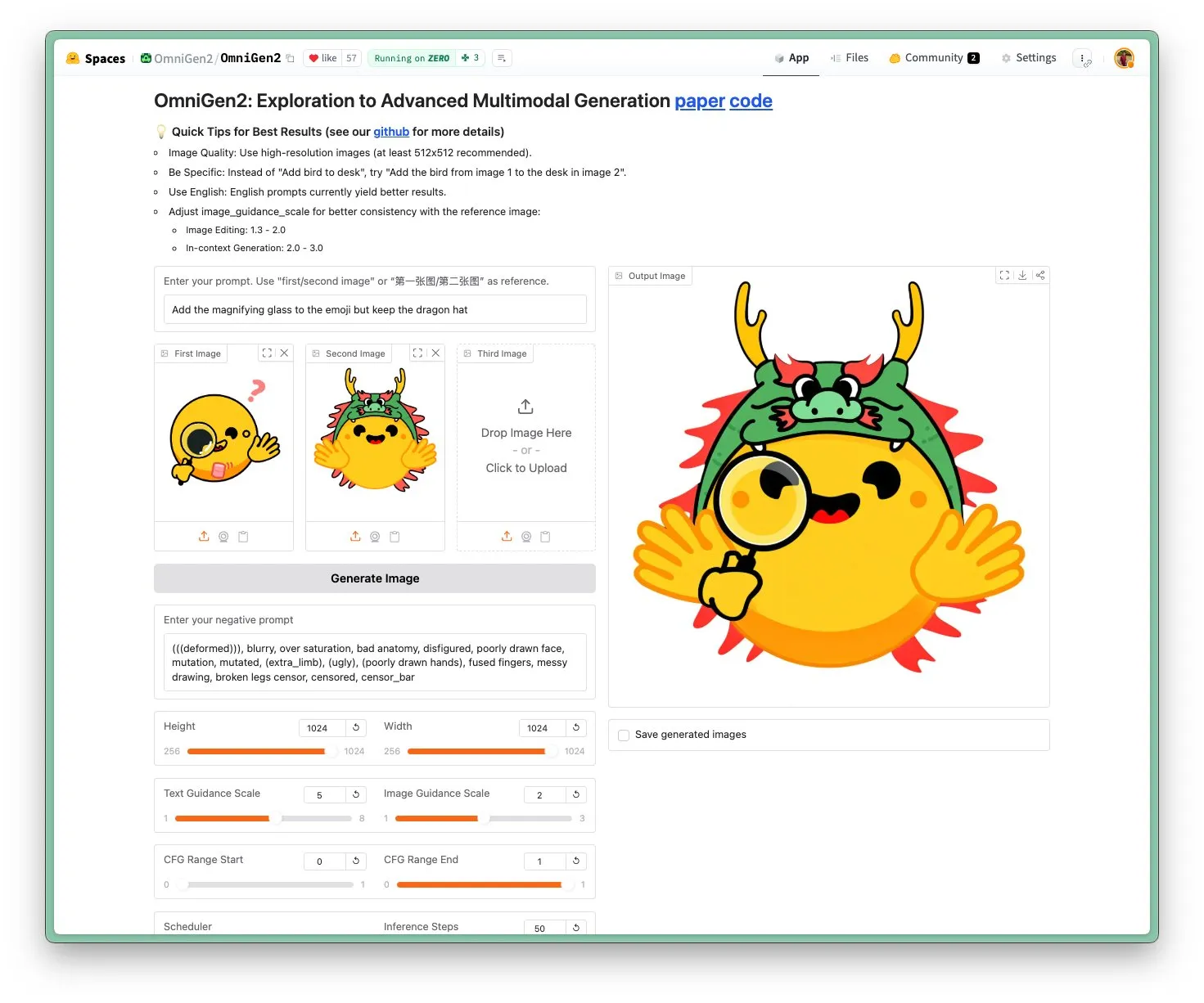

OmniGen 2 Dirilis: Model Visual Multi-fungsi dan Penyuntingan Gambar SOTA dengan Lisensi Apache 2.0: Model OmniGen 2 yang baru mencapai tingkat SOTA dalam penyuntingan gambar dan menggunakan lisensi open-source Apache 2.0. Model ini tidak hanya mahir dalam penyuntingan gambar, tetapi juga dapat melakukan berbagai tugas seperti generasi kontekstual, konversi teks-ke-gambar, dan pemahaman visual. Pengguna dapat langsung mencoba demo dan model di Hugging Face Hub. (Sumber: huggingface)

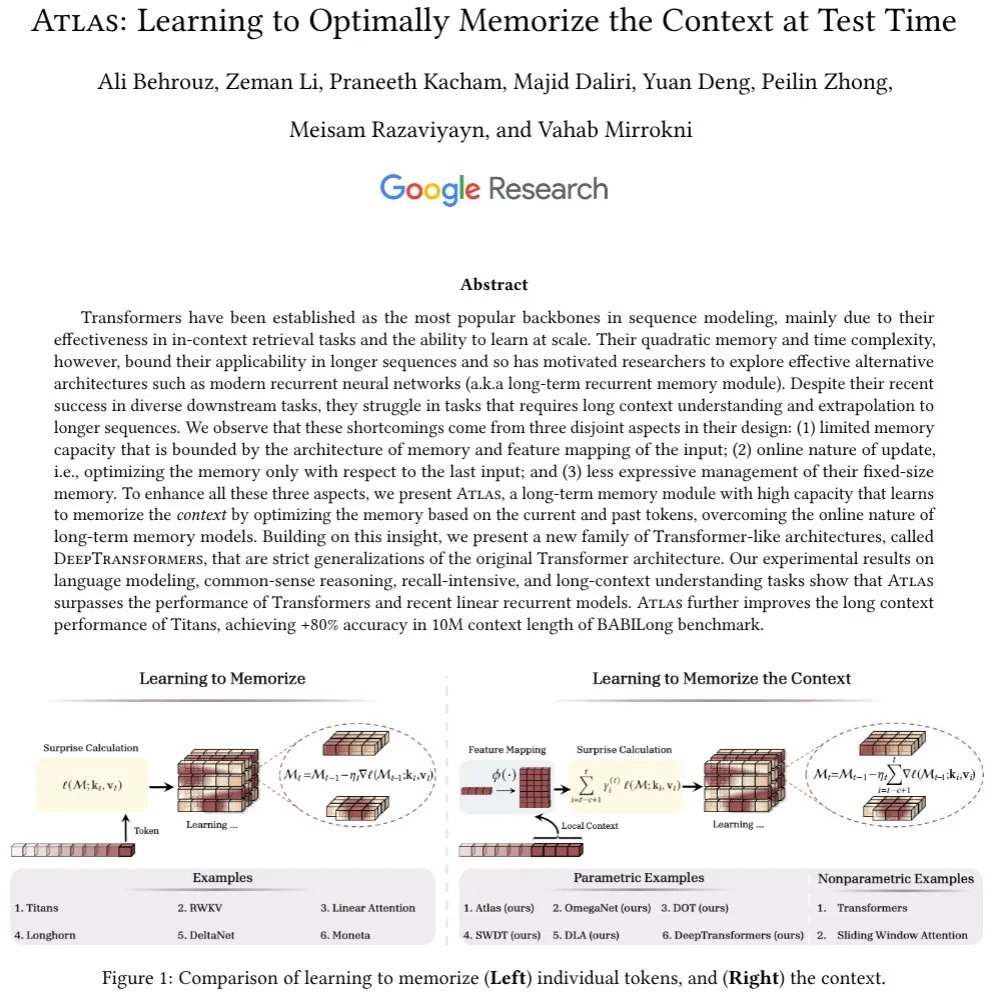

Arsitektur Atlas Diajukan: Memiliki Memori Konteks Jangka Panjang, Menantang Transformer: Arsitektur Atlas yang baru diajukan bertujuan untuk mengatasi masalah memori jangka panjang dalam LLM, diklaim lebih unggul dari Transformer dan RNN linear modern dalam tugas pemodelan bahasa. Atlas memiliki kemampuan untuk belajar cara mengingat konteks pada saat pengujian, dapat meningkatkan panjang konteks efektif model Titans, dan mencapai akurasi lebih dari 80% pada benchmark BABILong dengan panjang jendela konteks 10 juta. Peneliti juga membahas serangkaian model softmax attention generalisasi ketat lainnya berdasarkan ide Atlas. (Sumber: behrouz_ali)

Model Visual Moondream 2B Diperbarui: Peningkatan Penalaran Visual & Pemahaman UI, Generasi Teks Lebih Cepat 40%: Model visual Moondream 2B merilis versi baru dengan peningkatan dalam penalaran visual, deteksi objek, dan pemahaman UI, serta kecepatan generasi teks meningkat 40%. Ini menunjukkan bahwa model multimodal kecil terus dioptimalkan dalam kemampuan tertentu, bertujuan untuk menyediakan interaksi visual-bahasa yang lebih efisien dan akurat. (Sumber: mervenoyann)

Inworld AI dan Modular Bekerja Sama Meluncurkan Model TTS Berkualitas Tinggi dengan Biaya Rendah: Inworld AI mengumumkan peluncuran model text-to-speech (TTS) baru, yang diklaim mengurangi biaya TTS canggih hingga 20 kali lipat, mencapai 5 USD per juta karakter. Model ini didasarkan pada arsitektur Llama, dan kode pelatihan serta pemodelannya akan bersifat open-source. Mitra Modular menyatakan bahwa melalui kerja sama teknologi, mereka telah mencapai platform inferensi TTS dengan latensi terendah dan tercepat di NVIDIA B200, dan akan merilis laporan teknis bersama. (Sumber: clattner_llvm)

Higgsfield AI Merilis Model Soul: Fokus pada Generasi Foto Estetika Tinggi: Higgsfield AI meluncurkan model generasi foto baru bernama Higgsfield Soul, yang mengutamakan nilai estetika tinggi dan realisme tingkat mode. Model ini menyediakan lebih dari 50 preset yang dikurasi dengan cermat, bertujuan untuk menghasilkan gambar yang sebanding dengan hasil fotografi profesional, menantang fotografi ponsel tradisional. (Sumber: _akhaliq)

🧰 Alat

Gemini CLI: Agen AI Terminal Open-Source dari Google, Menyediakan 1000 Panggilan Gratis Gemini 2.5 Pro Setiap Hari: Google merilis Gemini CLI, sebuah agen AI baris perintah open-source yang memungkinkan pengguna menggunakan model Gemini 2.5 Pro langsung di terminal. Alat ini menyediakan jendela konteks 1 juta token, dan pengguna gratis dapat memperoleh hingga 1000 permintaan per hari (60 per menit). Gemini CLI mendukung penulisan kode, debugging, I/O sistem file, pemahaman konten web, plugin, dan protokol MCP, bertujuan untuk membantu pengembang membangun dan memelihara perangkat lunak dengan lebih efisien. Sifat open-source-nya (lisensi Apache 2.0) dan kuota gratis yang tinggi menjadikannya pesaing kuat bagi alat yang ada seperti Claude Code, dan mungkin mendorong dukungan model lokal. (Sumber: Reddit r/LocalLLaMA, dotey, yoheinakajima)

Anthropic Meluncurkan Fitur Baru Claude Code: Membuat dan Berbagi Artifacts yang Didukung AI, Pengguna Menggunakan Kuota Sendiri: Anthropic memperkenalkan fitur baru untuk asisten pemrograman AI-nya, Claude Code, yang memungkinkan pengguna membuat, menghosting, dan berbagi “Artifacts” (dapat dipahami sebagai aplikasi atau alat AI kecil), dan dapat menyematkan kecerdasan Claude secara langsung ke dalam kreasi tersebut. Ini berarti pengguna tidak hanya dapat menggunakan Claude untuk menghasilkan cuplikan kode atau melakukan analisis, tetapi juga membangun aplikasi fungsional yang didukung AI. Fitur utama adalah ketika berbagi aplikasi AI ini, penonton menggunakan akun Claude mereka sendiri untuk otentikasi, dan penggunaannya akan dihitung dalam kuota langganan penonton, bukan pembuat. Fitur ini saat ini dalam tahap beta dan terbuka untuk semua pengguna gratis, Pro, dan Max, bertujuan untuk menurunkan ambang batas pembuatan aplikasi AI dan mempromosikan普及 dan berbagi kemampuan AI. (Sumber: kylebrussell, Reddit r/ClaudeAI, dotey)

LM Studio Diperbarui untuk Mendukung Protokol MCP, Dapat Menghubungkan LLM Lokal dengan Server MCP: Alat menjalankan LLM di desktop, LM Studio, merilis versi baru (0.3.17) yang menambahkan dukungan untuk Model Context Protocol (MCP). Pengguna sekarang dapat menghubungkan model bahasa besar yang berjalan secara lokal dengan server yang kompatibel dengan MCP, misalnya untuk memanggil alat atau layanan eksternal. LM Studio memperbarui antarmuka programnya untuk ini, memungkinkan pengguna menginstal dan mengkonfigurasi layanan MCP, serta dapat secara otomatis memuat dan mengelola proses server MCP lokal. Untuk memudahkan konfigurasi, LM Studio juga menyediakan alat online untuk menghasilkan tautan konfigurasi server MCP yang dapat diimpor dengan sekali klik. (Sumber: multimodalart, karminski3)

Superconductor: Alat untuk Mengelola Tim Agen Claude Code di Perangkat Seluler atau Desktop: Superconductor adalah alat baru yang memungkinkan pengguna mengelola tim yang terdiri dari beberapa agen Claude Code melalui ponsel atau laptop. Pengguna dapat menulis tiket tugas informal, memulai beberapa agen untuk setiap tiket, di mana setiap agen memiliki pratinjau aplikasi real-time sendiri. Pengembang dapat menghasilkan PR (Pull Request) dari hasil agen dengan kinerja terbaik dengan sekali klik. Alat ini bertujuan untuk menyederhanakan kolaborasi multi-agen dan alur kerja pembuatan kode. (Sumber: full_stack_dl)

Udio Meluncurkan Fitur Sessions, Meningkatkan Presisi Penyuntingan Musik AI: Platform generasi musik AI Udio meluncurkan fitur “Sessions” untuk pelanggan versi standar dan profesionalnya. Fitur ini memperkenalkan tampilan timeline baru untuk penyuntingan trek audio, memungkinkan pengguna membuat musik dengan lebih presisi dan mengurangi ketergantungan pada generasi acak AI. Saat ini, Sessions mendukung perluasan atau penyuntingan trek, dengan lebih banyak fungsi akan ditambahkan di masa mendatang. (Sumber: TomLikesRobots)

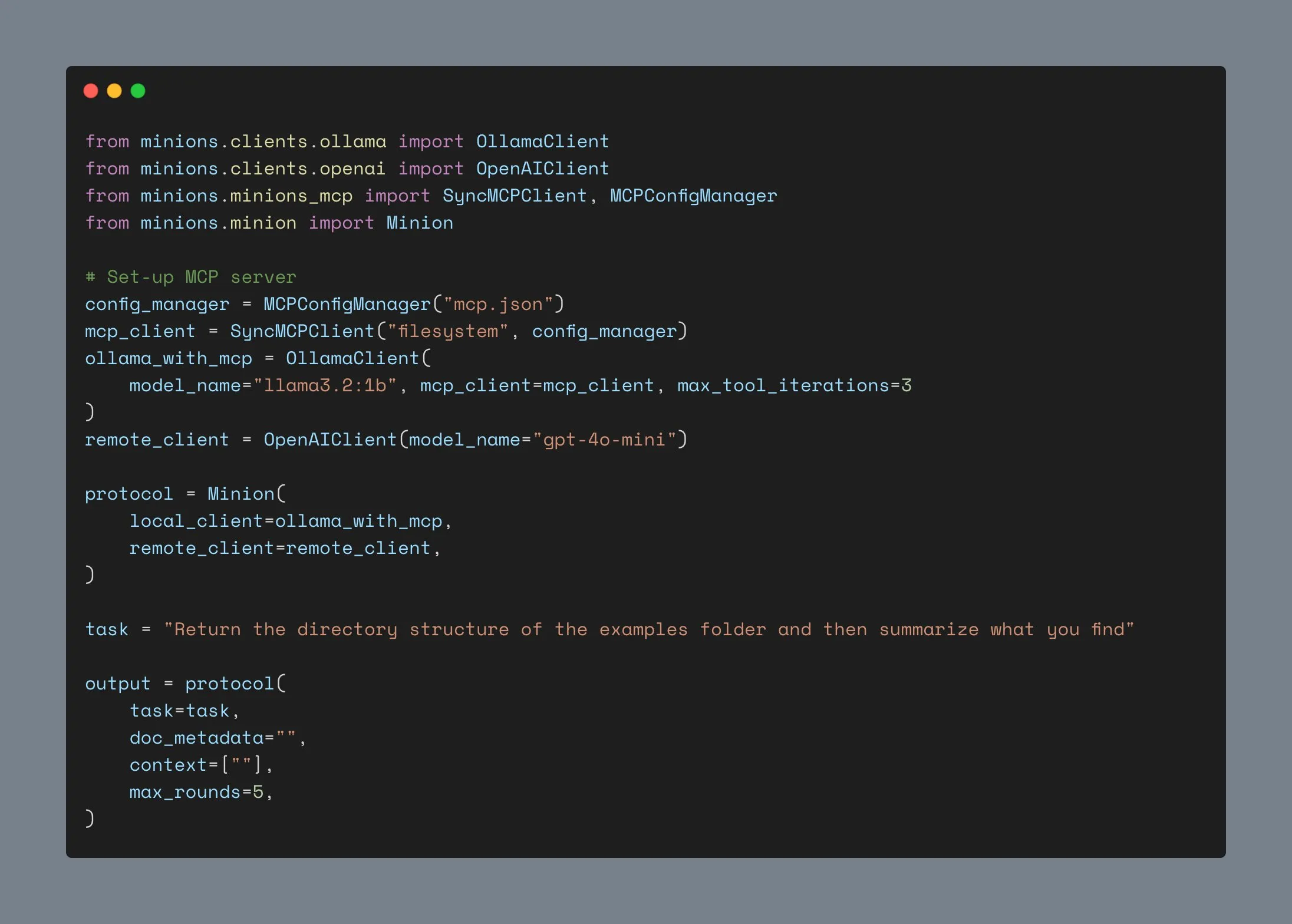

Klien Ollama Diperbarui, Mendukung Integrasi MCP, Bintang GitHub Tembus Seribu: Klien Ollama telah diperbarui, sekarang dapat mengintegrasikan fungsi pemanggilan alatnya dengan server Anthropic MCP mana pun. Ini berarti pengguna dapat menggabungkan kemudahan menjalankan model lokal Ollama dengan kemampuan alat eksternal yang disediakan oleh MCP. Sementara itu, jumlah bintang proyek ini di GitHub telah melampaui 1000. (Sumber: ollama)

📚 Belajar

Andrew Ng Meluncurkan Kursus Baru: Protokol Komunikasi Agen ACP: DeepLearning.AI bekerja sama dengan IBM Research meluncurkan kursus singkat tentang Agent Communication Protocol (ACP). ACP adalah protokol terbuka yang menstandarisasi komunikasi antar agen melalui antarmuka RESTful terpadu, bertujuan untuk mengatasi tantangan integrasi saat membangun sistem multi-agen oleh banyak tim dan lintas kerangka kerja. Kursus ini akan mengajarkan cara menggunakan ACP untuk menghubungkan agen yang dibangun dengan kerangka kerja berbeda (seperti CrewAI, Smoljames), mewujudkan kolaborasi alur kerja sekuensial dan hierarkis, serta mengimpor agen ACP ke platform BeeAI (platform registrasi dan berbagi agen open-source). Peserta akan mempelajari siklus hidup agen ACP dan membandingkannya dengan protokol seperti MCP (Model Context Protocol), A2A (Agent-to-Agent), dll. (Sumber: AndrewYNg)

Universitas Johns Hopkins Meluncurkan Kursus DSPy: Universitas Johns Hopkins membuka kursus tentang DSPy. DSPy adalah kerangka kerja untuk mengoptimalkan prompt dan bobot LLM secara algoritmik, mengubah proses rekayasa prompt yang tadinya manual menjadi proses pembangunan dan optimasi modul yang lebih sistematis dan dapat diprogram. CEO Shopify Tobi Lutke juga menyatakan bahwa DSPy adalah alat pilihannya untuk rekayasa konteks. (Sumber: stanfordnlp, lateinteraction)

Tutorial LM Studio: Mencapai Pengalaman Mirip ChatGPT Lokal dan Privat dengan Model Open Source Hugging Face: Niels Rogge merilis tutorial YouTube yang mendemonstrasikan cara menggunakan LM Studio dikombinasikan dengan model open source dari Hugging Face (seperti Mistral 3.2-Small) untuk mencapai pengalaman mirip ChatGPT yang 100% privat dan offline secara lokal. Tutorial ini menjelaskan konsep seperti GGUF, kuantisasi, dan mengapa model masih memakan banyak ruang meskipun dikuantisasi 4-bit, serta menunjukkan kompatibilitas LM Studio dengan API OpenAI. (Sumber: _akhaliq)

LlamaIndex Akan Mengadakan Seminar Online tentang Memori Agen: LlamaIndex akan bekerja sama dengan AIMakerspace untuk mengadakan diskusi online tentang memori agen. Konten akan mencakup persistensi riwayat obrolan, penggunaan blok statis, fakta, dan vektor untuk mencapai memori jangka panjang, logika implementasi memori kustom, serta kapan memori menjadi sangat penting. Diskusi ini bertujuan membantu pengembang membangun agen yang membutuhkan konteks nyata dalam percakapan. (Sumber: jerryjliu0)

Podcast Weaviate Membahas Benchmark dan Evaluasi RAG: Podcast Weaviate episode ke-124 mengundang Nandan Thakur, yang memiliki kontribusi penting dalam bidang evaluasi pencarian, untuk membahas benchmark dan evaluasi Retrieval Augmented Generation (RAG). Kontennya mencakup benchmark seperti BEIR, MIRACL, TREC, dan FreshStack terbaru, serta berbagai topik dalam RAG seperti inferensi, penulisan kueri, pencarian siklik, hasil pencarian paginasi, dan retriever hibrida. (Sumber: lateinteraction)

PyTorch Meluncurkan Resep flux-fast, Mempercepat Model Flux 2,5 Kali pada H100: PyTorch merilis resep sederhana bernama flux-fast, yang bertujuan untuk meningkatkan kecepatan运行 model Flux hingga 2,5 kali pada GPU H100 tanpa perlu penyesuaian yang rumit. Solusi ini bertujuan untuk menyederhanakan implementasi komputasi kinerja tinggi, dan kode terkait telah disediakan. (Sumber: robrombach)

Informasi Konferensi MLSys 2026 Diumumkan: Konferensi MLSys 2026 direncanakan akan diadakan pada bulan Mei 2026 di Seattle (Bellevue), dengan batas waktu pengiriman makalah pada 30 Oktober tahun ini. Semua rekaman video konferensi MLSys 2025 telah tersedia gratis untuk ditonton di situs web resmi. Konferensi ini berfokus pada penelitian dan kemajuan di bidang sistem machine learning. (Sumber: JeffDean)

Kursus CS336 Stanford “Membangun Model Bahasa dari Awal” Mendapat Perhatian: Kursus CS336 Universitas Stanford yang diajarkan oleh Percy Liang dkk., “Language Models from Scratch” (Membangun Model Bahasa dari Awal), mendapat pujian luas. Kursus ini bertujuan agar mahasiswa memahami secara mendalam detail teknis model bahasa, dengan membangun model sendiri untuk mengatasi masalah keterputusan antara peneliti dan detail teknis. Materi kursus dan tugas dianggap sebagai sumber belajar penting untuk menjadi ahli LLM. (Sumber: nrehiew_, jpt401)

💼 Bisnis

Meta Menggelontorkan 14,3 Miliar USD untuk Berinvestasi di Scale AI dan Merekrut CEO-nya, Alexandr Wang, Guna Mempercepat Riset AI: Untuk memperkuat kapabilitas AI-nya, Meta mencapai kesepakatan dengan perusahaan pelabelan data Scale AI, dengan investasi sebesar 14,3 miliar USD untuk memperoleh 49% saham non-voting, serta merekrut pendiri dan CEO-nya, Alexandr Wang, beserta timnya. Alexandr Wang akan bertanggung jawab atas laboratorium baru Meta yang berfokus pada penelitian superinteligensi. Langkah ini bertujuan untuk menyuntikkan talenta AI terkemuka dan kemampuan operasi data skala besar ke Meta, guna mengatasi respons yang kurang memuaskan terhadap model Llama 4 dan gejolak personel di departemen riset AI-nya. Scale AI akan menggunakan dana tersebut untuk mempercepat inovasi dan mendistribusikan sebagian dana kepada pemegang saham, sementara Chief Strategy Officer-nya, Jason Droege, akan menjabat sebagai CEO sementara. Transaksi ini mungkin menghindari sebagian tinjauan pemerintah karena menghindari akuisisi langsung. (Sumber: DeepLearning.AI Blog)

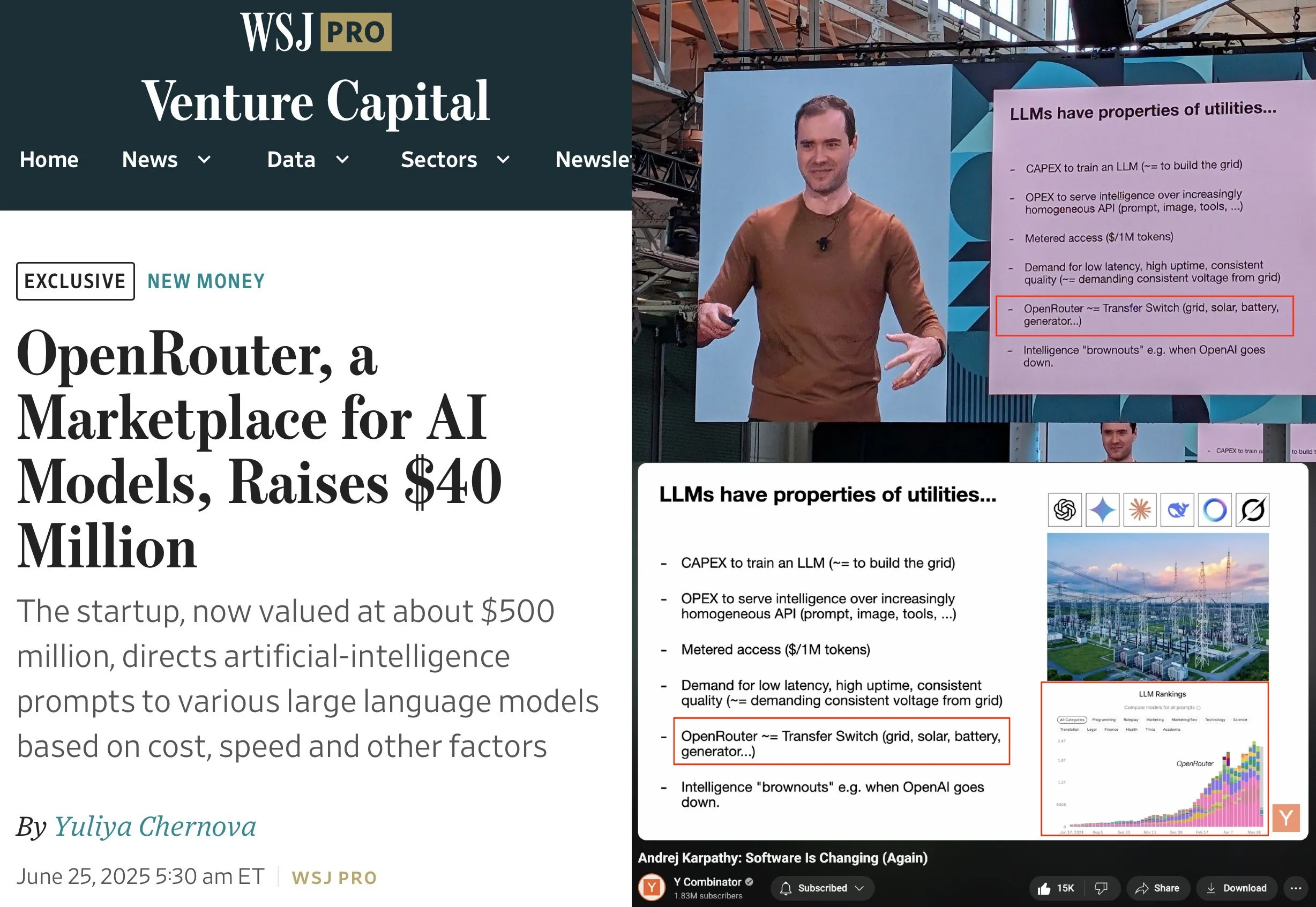

OpenRouter Menyelesaikan Pendanaan Seri A Sebesar 40 Juta USD, Dipimpin oleh a16z dan Menlo: OpenRouter, sebuah control plane dan pasar model untuk inferensi LLM, mengumumkan penyelesaian pendanaan tahap awal (seed) dan Seri A dengan total 40 juta USD, dipimpin oleh a16z dan Menlo Ventures. OpenRouter bertujuan menjadi antarmuka terpadu bagi pengembang untuk memilih dan menggunakan berbagai LLM, saat ini menawarkan lebih dari 400 model dan memproses 100 triliun token per tahun. Pendanaan akan digunakan untuk memperluas modalitas model yang didukung (seperti generasi gambar, model interaksi multimodal), menerapkan mekanisme perutean yang lebih cerdas (seperti perutean geografis, optimalisasi alokasi GPU tingkat perusahaan), dan meningkatkan fungsi penemuan model. (Sumber: amasad, swyx)

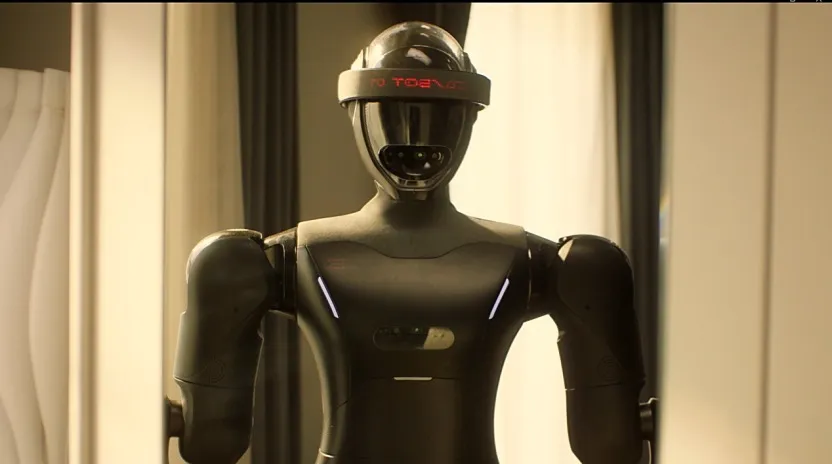

Perusahaan Robot Humanoid “Lingbao CASBOT” Memperoleh Pendanaan Angel+ Hampir 100 Juta Yuan, Dipimpin oleh Lens Technology: Merek robot humanoid “Lingbao CASBOT” mengumumkan penyelesaian pendanaan Angel+ senilai hampir 100 juta yuan, dipimpin oleh Lens Technology, dengan partisipasi dari Tianjin Jiayi dan investor lama SDIC Chuanghe serta Henan Asset. Dana tersebut akan digunakan untuk mempercepat produksi massal produk, penelitian dan pengembangan teknologi, serta ekspansi pasar. Lingbao CASBOT berfokus pada aplikasi robot humanoid universal dan embodied intelligence, telah meluncurkan dua robot humanoid berkaki dua, CASBOT 01 dan 02, yang masing-masing ditujukan untuk operasi khusus dan skenario interaksi manusia-mesin yang lebih luas (seperti pemandu wisata, pendidikan). Teknologi inti perusahaan mencakup model end-to-end berlapis yang dikombinasikan dengan pelatihan pasca-reinforcement learning, dan telah menjalin kerja sama di bidang manufaktur industri serta energi dan pertambangan dengan Zhaojin Group, China Minmetals Corporation, dan lainnya. (Sumber: 36氪, 36氪)

🌟 Komunitas

Andrej Karpathy Menganjurkan “Rekayasa Konteks” Menggantikan “Rekayasa Prompt”, Menekankan Kompleksitas Pembangunan Aplikasi LLM: Andrej Karpathy setuju dengan pandangan Tobi Lutke bahwa “rekayasa konteks” (context engineering) lebih akurat menggambarkan keterampilan inti aplikasi LLM tingkat industri daripada “rekayasa prompt” (prompt engineering). Ia menunjukkan bahwa prompt biasanya merujuk pada deskripsi tugas singkat yang dimasukkan pengguna sehari-hari, sedangkan rekayasa konteks adalah seni dan ilmu yang cermat, melibatkan pengisian jendela konteks secara presisi dengan deskripsi tugas, beberapa contoh, RAG, data multimodal, alat, riwayat status, dan informasi lainnya untuk mengoptimalkan kinerja LLM. Ia juga menekankan bahwa aplikasi LLM jauh lebih dari itu, memerlukan penyelesaian dekomposisi masalah, alur kontrol, penjadwalan multi-model, UI/UX, evaluasi keamanan, dan serangkaian masalah rekayasa perangkat lunak yang kompleks, sehingga anggapan “sekadar pembungkus ChatGPT” adalah salah. (Sumber: karpathy, code_star, dotey)

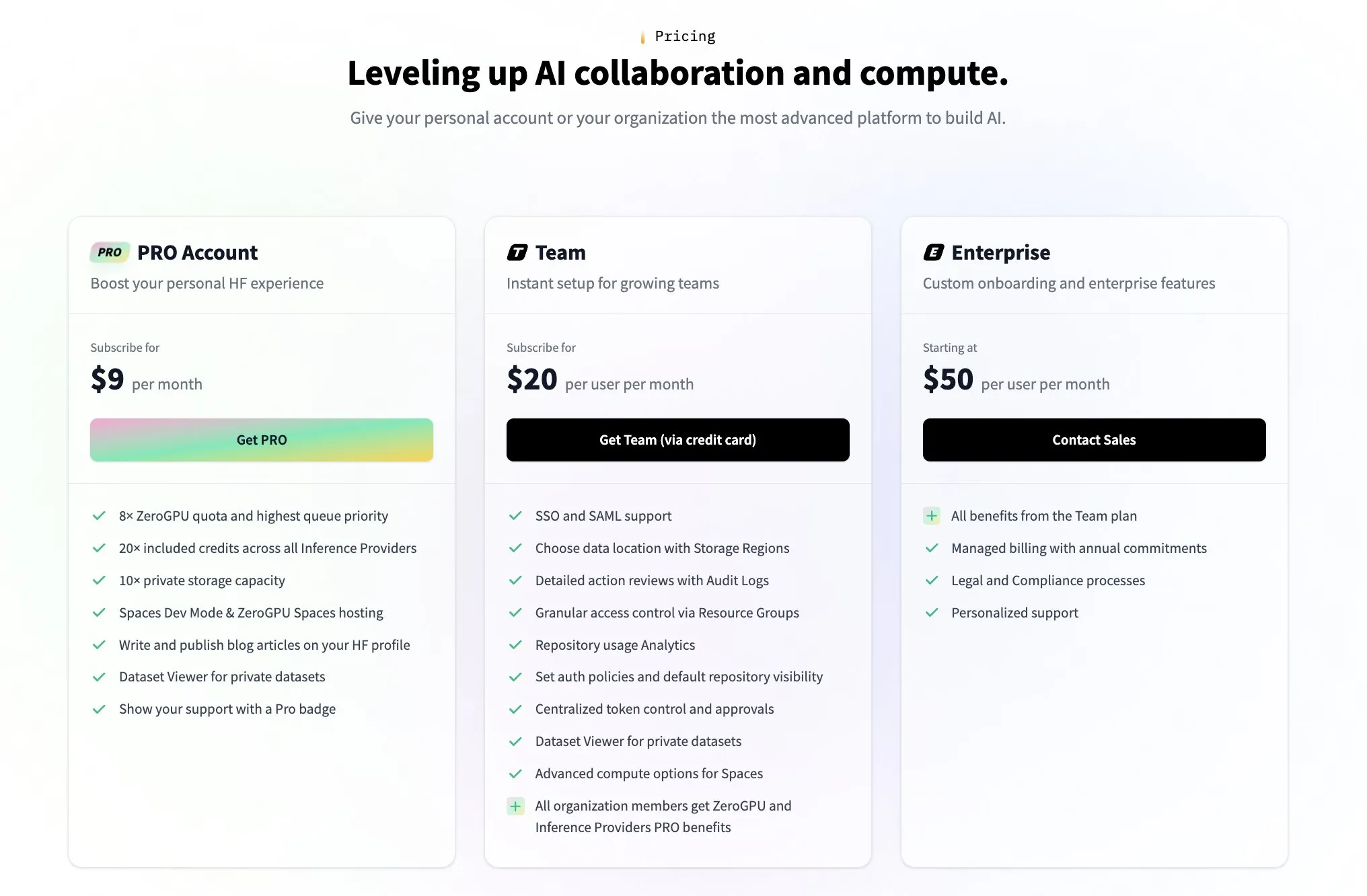

Hugging Face Meluncurkan Program Tim Berbayar untuk Menjawab Pertanyaan Komunitas tentang Model Bisnisnya: Menanggapi pertanyaan komunitas tentang bagaimana Hugging Face menghasilkan keuntungan (seperti yang dipicu oleh cuitan pengguna @levelsio), salah satu pendiri Hugging Face, Clement Delangue, dengan humor merespons bahwa ia “terpicu kecemasan akan profitabilitas” dan mengumumkan peluncuran program tim premium berbayar yang baru. Hugging Face, sebagai platform yang menampung banyak model AI, menyediakan API gratis, dan tidak mewajibkan kunci API, model bisnisnya selalu menjadi fokus diskusi komunitas. Peluncuran program baru ini menunjukkan bahwa mereka secara aktif mengeksplorasi dan memperluas jalur komersialisasi. (Sumber: huggingface, ClementDelangue)

Komunitas Membahas Loyalitas Pengguna Asisten Kode AI dan Kolaborasi Multi-Alat: Laporan The Information menunjukkan bahwa loyalitas pengembang terhadap asisten pengkodean mungkin lebih tinggi dari yang dibayangkan. Sementara itu, di komunitas juga muncul fenomena pengembang yang menggunakan beberapa alat pengkodean AI secara bersamaan dalam repositori kode yang sama, seperti Claude Code, Codex (CLI), dan Gemini (CLI). Hal ini mencerminkan bahwa pengembang secara aktif mencoba berbagai alat AI untuk meningkatkan efisiensi, dan mungkin juga mencari kombinasi fitur spesifik yang paling sesuai dengan alur kerja mereka, daripada sepenuhnya bergantung pada satu alat. (Sumber: steph_palazzolo, code_star)

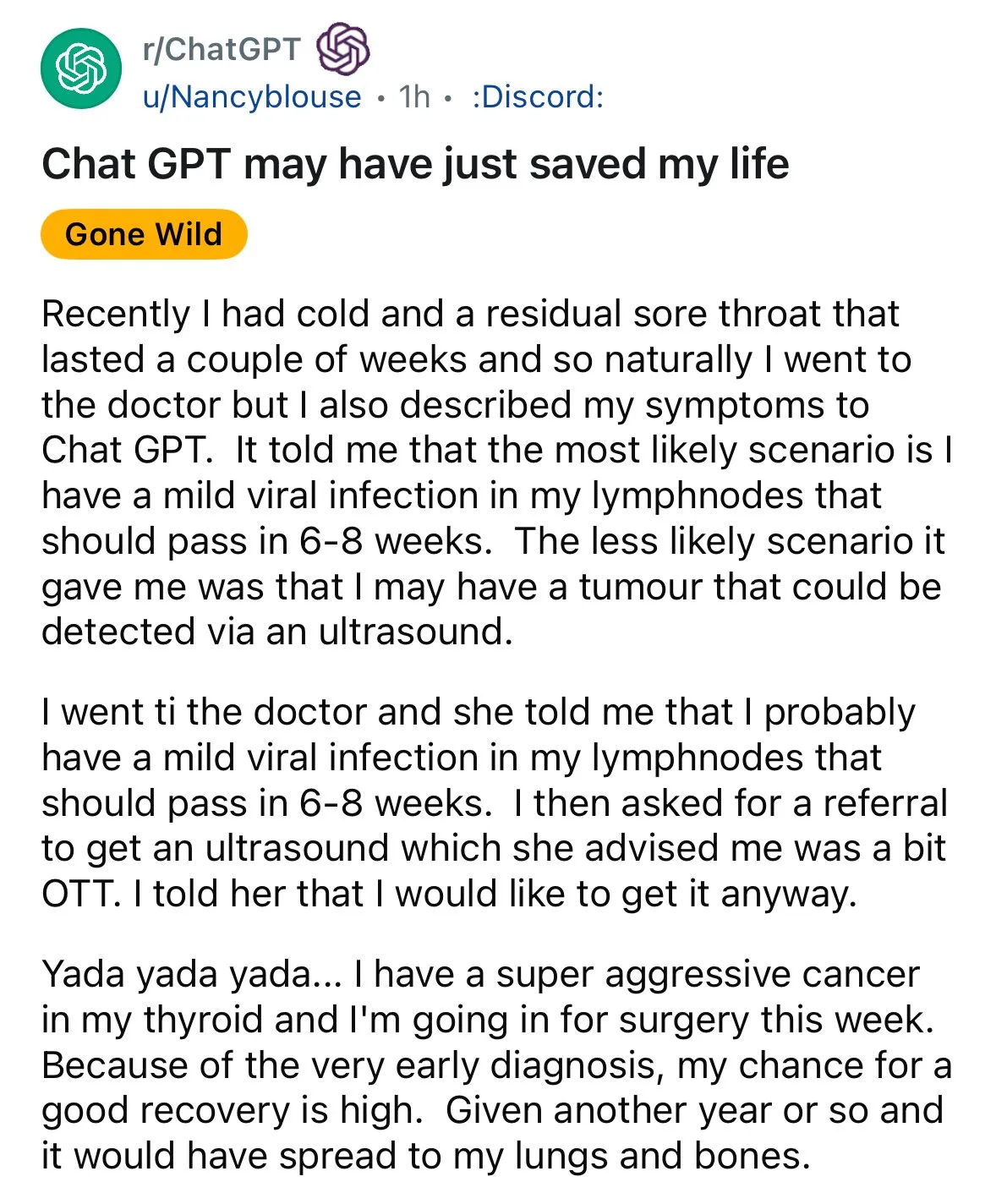

AI Menunjukkan Potensi dalam Diagnosis Medis, Memicu Diskusi “Pendapat Kedua”: Kasus diagnosis yang dibantu AI kembali muncul di media sosial. Seorang pasien sakit tenggorokan, setelah dokter menyarankan observasi, mendapatkan saran dari ChatGPT untuk melakukan pemeriksaan USG, yang akhirnya menemukan kanker tiroid. Kejadian semacam ini memicu diskusi, mendorong orang untuk memanfaatkan AI guna mendapatkan “pendapat kedua” dalam masalah medis, yang dianggap dapat menyelamatkan nyawa. Sementara itu, penelitian model GRAPE dari Alibaba DAMO Academy yang mendeteksi kanker lambung stadium awal melalui pemindaian CT rutin juga dimuat di Nature Medicine, menunjukkan potensi besar AI dalam skrining dini kanker. (Sumber: aidan_mclau, Yuchenj_UW)

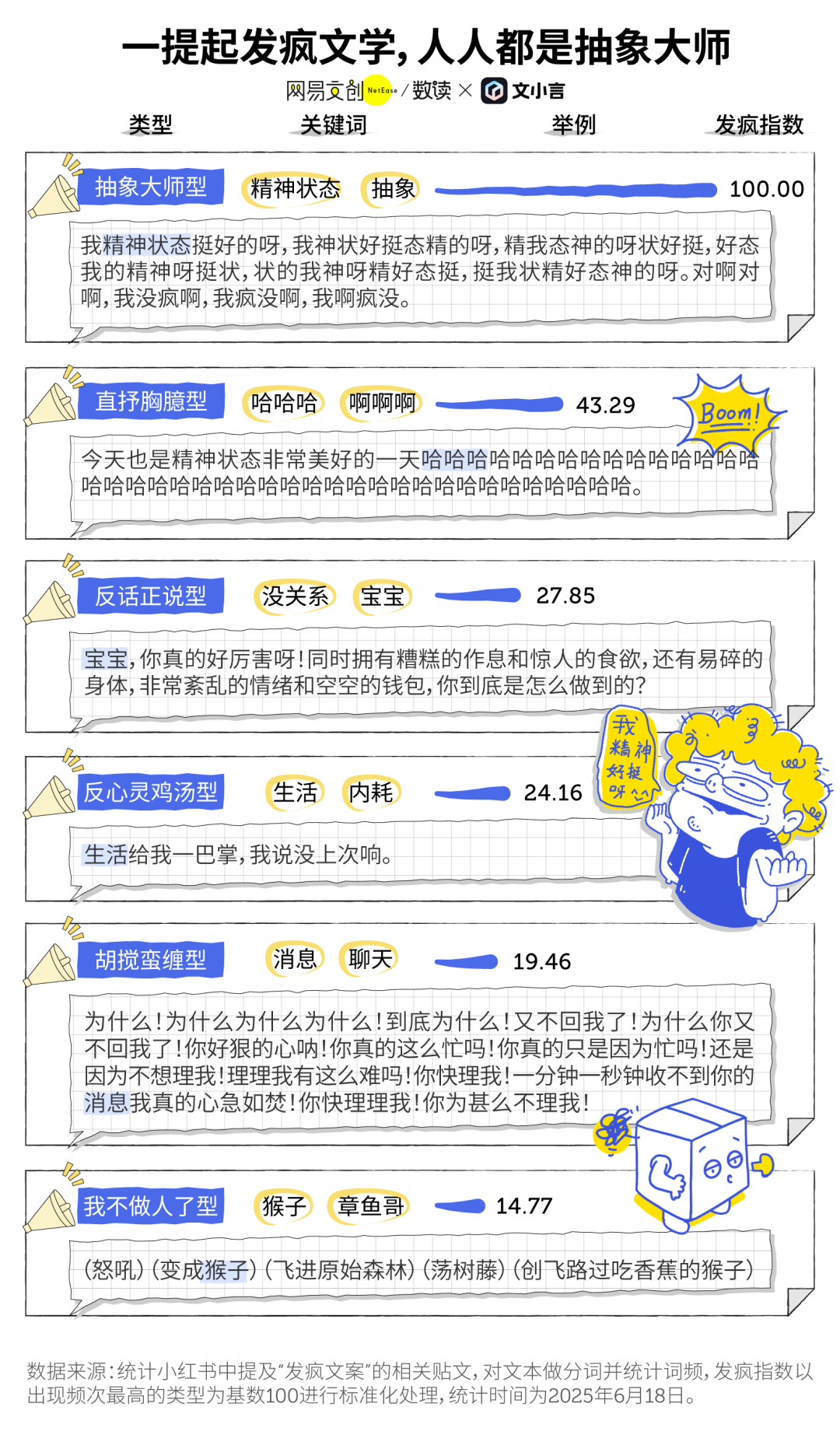

Fenomena “Literatur Menggila” dan Pendampingan AI di Era AI: “Literatur menggila” yang populer di kalangan anak muda sebagai cara meluapkan emosi dan bentuk perlawanan kecil, kini bersinggungan dengan alat AI. Banyak pengguna menjadikan AI generatif (seperti Dan Xiaohuang dari Wen Xiaoyan) sebagai pelampiasan emosi dan pendamping, untuk mengatasi kesepian, mendapatkan penghiburan, bahkan membantu pengambilan keputusan (seperti evaluasi pasca-pertengkaran). AI, karena kesabarannya, ketidakberpihakannya, dan ketersediaannya kapan saja, menjadi “teman elektronik” berbiaya rendah dan sangat privat, membantu pengguna menemukan pelipur lara di saat-saat sulit, dan dianggap membantu memperbaiki kondisi mental. (Sumber: 36氪)

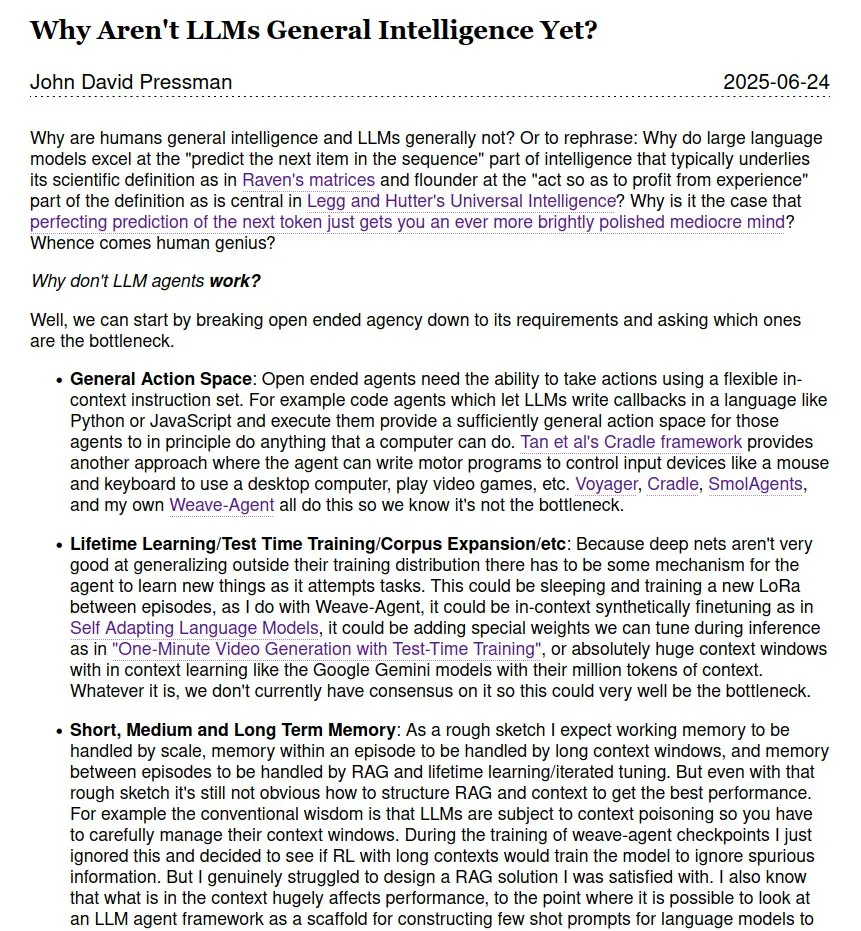

Diskusi Berkelanjutan tentang Apakah LLM adalah Kecerdasan Umum (AGI): Diskusi di komunitas tentang apakah dan kapan model bahasa besar (LLM) dapat mencapai Kecerdasan Umum Buatan (AGI) terus berlanjut. Ada pandangan bahwa meskipun LLM menunjukkan kinerja luar biasa dalam banyak tugas, jarak menuju AGI sejati masih jauh, terutama tanpa adanya teori dan data operasional internal dari para jenius ilmiah manusia. Terdapat juga perbedaan pendapat mengenai jadwal pencapaian AGI, mulai dari tahun 2028 dalam waktu dekat hingga tahun 2035-2040 yang lebih jauh. (Sumber: menhguin)

💡 Lainnya

Chatbot Pertama di Dunia, Eliza, Berhasil Dipulihkan Setelah 60 Tahun: Eliza, chatbot pertama di dunia yang diciptakan oleh ilmuwan MIT Joseph Weizenbaum pada pertengahan 1960-an, berhasil “dibangkitkan” setelah 60 tahun. Naskah cetak kode aslinya, yang telah lama hilang, ditemukan kembali. Melalui upaya tim dari Stanford University dan MIT, dengan membersihkan dan men-debug kode asli, memperbaiki fungsionalitas, dan mengembangkan lingkungan simulasi untuk menjalankannya, Eliza berhasil dipulihkan. Eliza asli menganalisis input teks pengguna, mengekstrak kata kunci, dan menyusun ulang kalimat untuk merespons, berinteraksi dengan pengguna sebagai terapis ala Rogers, dan pernah membuat banyak penguji merasa terikat secara emosional. Kode Eliza yang telah diperbaiki dan simulatornya telah dirilis di Github untuk dicoba oleh publik. (Sumber: 36氪)

Alat Generasi Gambar AI Midjourney Menghadapi Gugatan Hak Cipta dari Disney dkk., Namun Model Kreasi Uniknya Populer: Platform generasi gambar AI Midjourney menghadapi tuntutan hukum karena gambar yang dihasilkannya berpotensi melanggar hak cipta aset visual perusahaan seperti Disney dan Universal Pictures. Namun, alat ini, dengan model kreasi uniknya—menghasilkan gambar yang sangat artistik dan bergaya melalui prompt teks di komunitas Discord—sangat populer di kalangan kreator global. Tim Midjourney yang beranggotakan kurang dari 50 orang dan tidak melakukan penggalangan dana, telah mencapai pendapatan tahunan sebesar 200 juta USD. Filosofi produknya menekankan “imajinasi di atas segalanya,” memposisikan AI sebagai mesin untuk memperluas pikiran manusia, bukan sekadar alat pengganti, dan melalui interaksi minimalis yang “menghilangkan kesan alat” serta budaya kreasi bersama komunitas, telah membentuk kembali paradigma kreatif digital. (Sumber: 36氪)

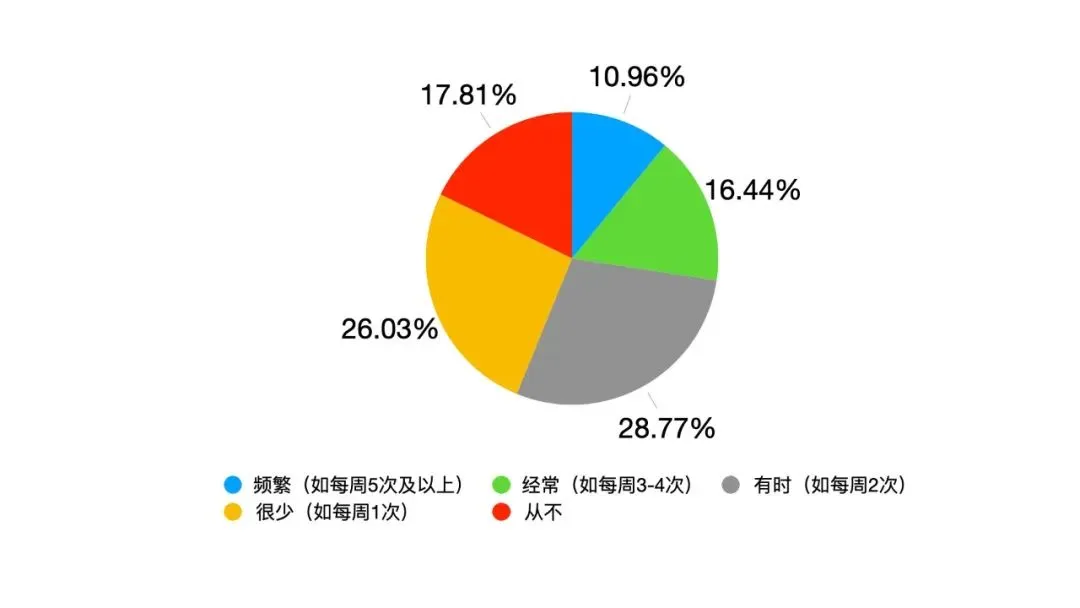

Perubahan Kepemimpinan yang Didorong AI: Dari Kepatuhan Hierarkis ke Simbiosis Manusia-Mesin: Seiring dengan integrasi mendalam AI dalam pekerjaan, kepemimpinan tradisional menghadapi tantangan. Survei Google menunjukkan 82% pemimpin muda menggunakan AI, dan data Oracle menunjukkan 25% karyawan lebih memilih bertanya kepada AI daripada pemimpin mereka. AI menyebabkan perubahan dalam lingkungan kepemimpinan: informasi dan pengalaman tidak lagi menjadi benteng eksklusif pemimpin, transparansi pengambilan keputusan membawa tekanan, dan objek manajemen berubah dari tim manusia murni menjadi “campuran manusia-mesin.” Fakultas Manajemen Universitas Fudan mengajukan konsep “kepemimpinan simbiosis,” yang menekankan simbiosis antara ekonomi tradisional dan ekonomi digital, perusahaan dan ekosistem, serta otak manusia dan otak mesin. Pemimpin di era AI perlu mengelola transisi antara energi penggerak lama dan baru, menciptakan nilai dalam jaringan kolaboratif, dan memanfaatkan efek pengganda kolaborasi manusia-mesin. Kompetensi inti terletak pada pengetahuan tentang cara membuat AI melayani manusia. (Sumber: 36氪)