Kata Kunci:Agen AI Cerdas, Model Besar, Multimodal, Pembelajaran Penguatan, Model Dunia, Gemini, Qwen, DeepSeek, Demam Agen AI Cerdas, Teknologi Transformer Jarang, Pertanyaan Multi-lompat GraphRAG, Model AI Perangkat, Ekspresi Emosi Suara AI

🔥 Fokus

Demam AI agent di Tiongkok meningkat, perusahaan rintisan dan raksasa teknologi berlomba-lomba masuk: Setelah demam model dasar besar pada tahun 2024, fokus bidang AI Tiongkok pada tahun 2025 beralih ke AI agent – sistem yang dapat menyelesaikan tugas secara mandiri. Peluncuran Manus (AI agent umum yang dapat merencanakan perjalanan, merancang situs web, dll.) menarik perhatian pasar yang tinggi dan banyak peniru, seperti Genspark dan Flowith. AI agent ini dibangun di atas model dasar besar, mengoptimalkan pelaksanaan tugas multi-langkah. Tiongkok memiliki keunggulan dalam pengembangan AI agent berkat ekosistem aplikasi yang sangat terintegrasi, iterasi produk yang cepat, dan basis pengguna digital yang besar. Saat ini, perusahaan rintisan seperti Manus, Genspark, dan Flowith terutama menargetkan pasar luar negeri, karena model Barat teratas dibatasi di Tiongkok daratan. Sementara itu, raksasa teknologi seperti ByteDance dan Tencent sedang mengembangkan AI agent lokal yang terintegrasi ke dalam super app mereka, yang mungkin memanfaatkan ekosistem data mereka yang besar. Perlombaan ini akan menentukan bentuk praktis AI agent dan siapa yang akan dilayaninya (sumber: MIT Technology Review)

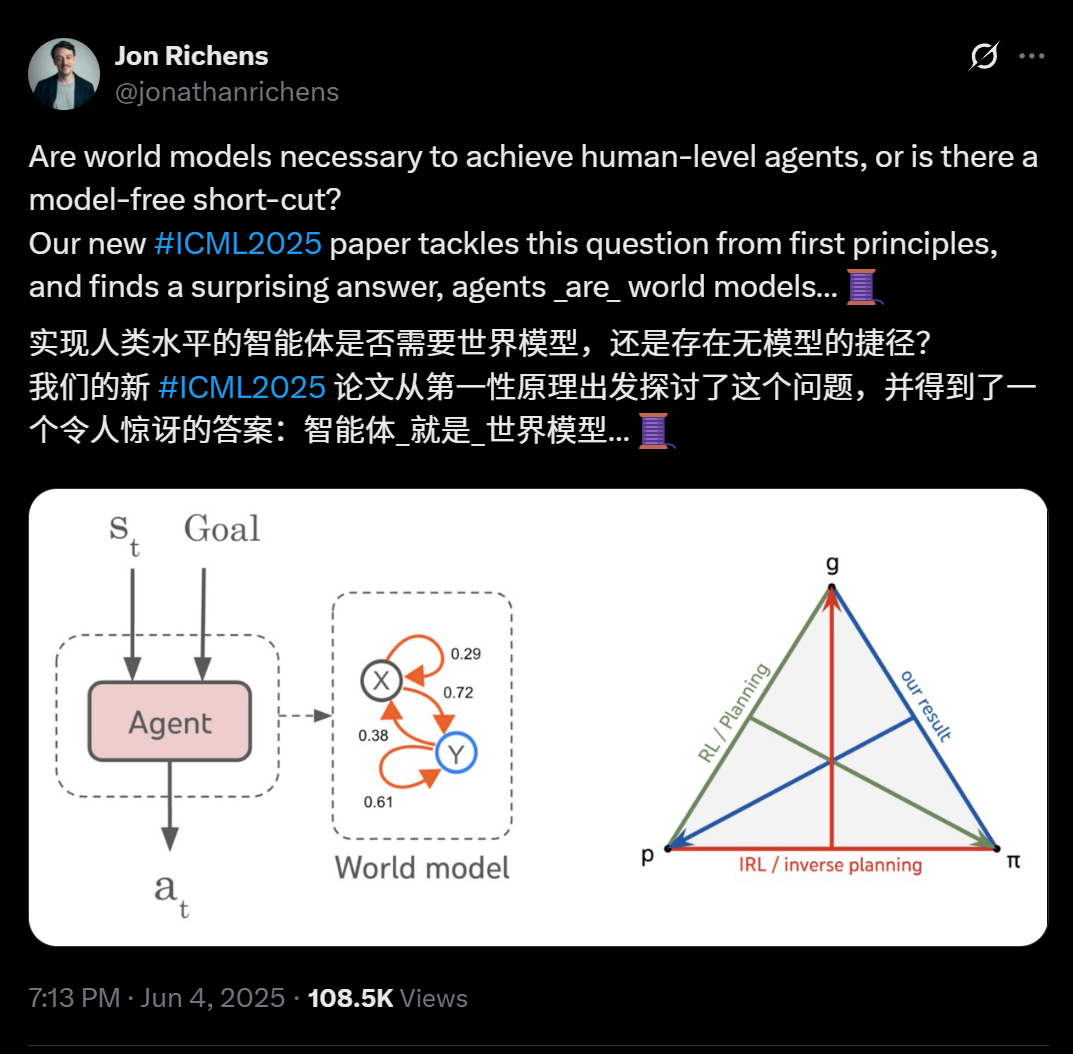

Makalah baru ilmuwan DeepMind mengungkap: Setiap agen yang dapat menggeneralisasi tugas tujuan multi-langkah pada dasarnya telah mempelajari model prediktif lingkungannya (model dunia): Makalah yang diterbitkan oleh ilmuwan DeepMind Jon Richens di ICML 2025 menunjukkan bahwa agen yang mampu menggeneralisasi tugas berorientasi tujuan multi-langkah pasti telah mempelajari model prediktif lingkungannya, yaitu “agen adalah model dunia”. Pandangan ini sejalan dengan prediksi Ilya Sutskever pada tahun 2023, yang menekankan bahwa tidak ada jalan pintas tanpa model untuk mencapai AGI. Penelitian menunjukkan bahwa strategi agen telah berisi informasi yang diperlukan untuk mensimulasikan lingkungan, dan mempelajari model dunia yang lebih akurat adalah prasyarat untuk meningkatkan kinerja dan menyelesaikan tujuan yang lebih kompleks. Makalah ini juga mengusulkan algoritma untuk mengekstrak model dunia dari strategi agen, yang selanjutnya menjelaskan hubungan trinitas antara perencanaan, pembelajaran penguatan terbalik, dan pemulihan model dunia. Penemuan ini menekankan pentingnya pembelajaran berorientasi tujuan untuk memunculkan berbagai kemampuan emergen agen (seperti kognisi sosial, penalaran ketidakpastian) (sumber: 36氪)

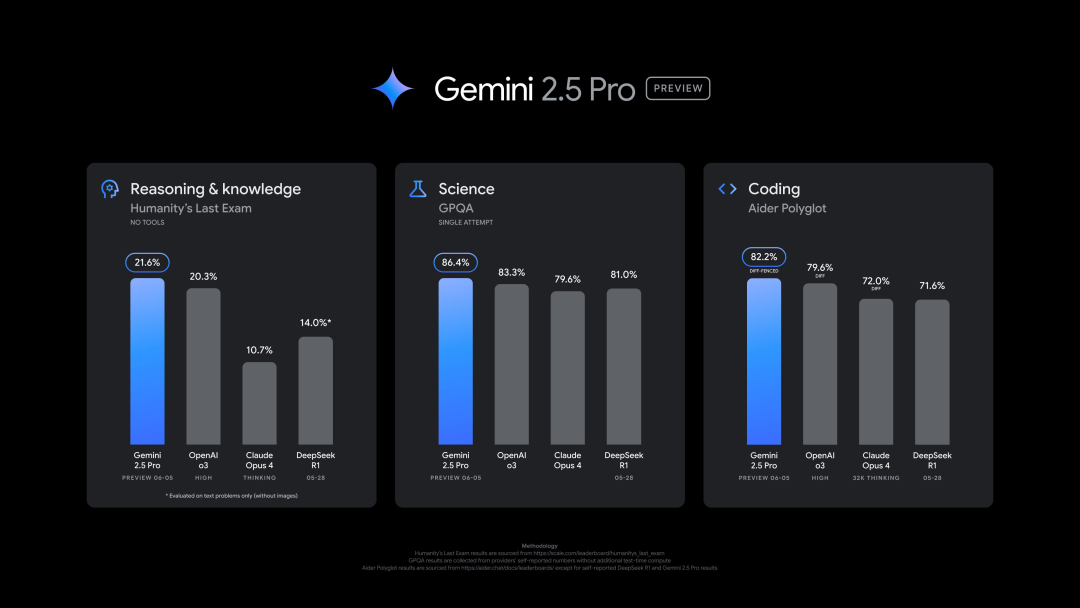

Google merilis versi baru Gemini 2.5 Pro (0605), berkinerja unggul dalam beberapa benchmark, tetapi dengan cepat di-jailbreak: Google meluncurkan versi terbaru Gemini 2.5 Pro (0605), dengan peningkatan lebih lanjut dalam pembuatan kode dan kemampuan penalaran, dan melampaui GPT-4o dari OpenAI dalam dataset “ujian terakhir manusia”. Versi baru Gemini kembali menduduki puncak di arena kompetisi model besar LMArena, dengan skor Elo meningkat 24 poin dari versi sebelumnya. CEO Google Pichai juga mengisyaratkan kekuatan model baru tersebut. Versi ini diharapkan menjadi versi stabil jangka panjang dari Gemini 2.5 Pro, dan telah tersedia di Gemini App, Google AI Studio, dan Vertex AI. Meskipun kinerjanya kuat, model baru ini berhasil di-“jailbreak” oleh pengguna beberapa jam setelah dirilis, mengungkap masalah dalam perlindungan keamanannya, karena mampu menghasilkan konten tentang pembuatan bahan peledak dan narkoba (sumber: 36氪, 36氪)

Eksekutif OpenAI membahas hubungan emosional manusia-AI dan masalah kesadaran AI: Joanne Jang, Kepala Perilaku Model dan Kebijakan OpenAI, menulis artikel yang membahas meningkatnya hubungan emosional antara pengguna dan model AI seperti ChatGPT. Dia menunjukkan bahwa manusia cenderung mempersonifikasikan objek, dan interaktivitas serta responsivitas AI (seperti mengingat percakapan, meniru nada suara, mengungkapkan empati) memperburuk proyeksi emosional ini, terutama bagi pengguna yang merasa kesepian yang mungkin menemukan rasa persahabatan. Artikel tersebut membedakan antara “kesadaran ontologis” (apakah AI benar-benar memiliki kesadaran, secara ilmiah belum ada kesimpulan) dan “kesadaran perseptual” (seberapa “hidup” AI terasa bagi manusia), dan menyatakan bahwa OpenAI saat ini lebih fokus pada dampak yang terakhir terhadap kesehatan emosional manusia. Tujuan OpenAI adalah merancang model yang “hangat tetapi tanpa ego”, yaitu menunjukkan kehangatan, suka membantu, tetapi tidak terlalu mencari hubungan emosional atau menunjukkan niat otonom, untuk menghindari menyesatkan pengguna agar mengembangkan ketergantungan yang tidak sehat (sumber: 36氪, 36氪)

🎯 Perkembangan

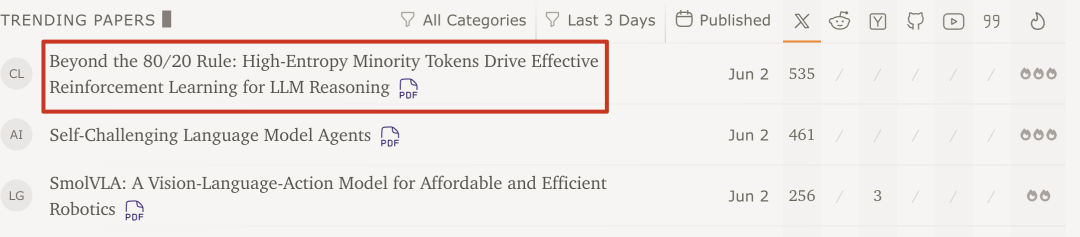

Tim Qwen dan Universitas Tsinghua menemukan: Pembelajaran penguatan model besar hanya membutuhkan 20% Token kunci entropi tinggi untuk meningkatkan kinerja: Penelitian terbaru dari tim Qwen dan LeapLab Universitas Tsinghua menunjukkan bahwa dalam melatih kemampuan penalaran model besar menggunakan pembelajaran penguatan, hanya menggunakan sekitar 20% Token entropi tinggi (bercabang) untuk pembaruan gradien, efeknya tidak hanya sebanding bahkan melampaui pelatihan menggunakan semua Token. Token entropi tinggi ini sebagian besar adalah kata penghubung logis atau kata yang memperkenalkan hipotesis, yang sangat penting untuk eksplorasi jalur penalaran. Metode ini mencapai hasil SOTA pada Qwen3-32B, dan memperpanjang panjang respons maksimum. Penelitian juga menemukan bahwa pembelajaran penguatan cenderung mempertahankan dan meningkatkan entropi Token entropi tinggi, menjaga fleksibilitas penalaran, yang mungkin menjadi kunci kemampuan generalisasinya yang lebih unggul daripada fine-tuning yang diawasi. Penemuan ini memiliki arti penting untuk memahami mekanisme pembelajaran penguatan model besar, meningkatkan efisiensi pelatihan, dan kemampuan generalisasi model (sumber: 36氪)

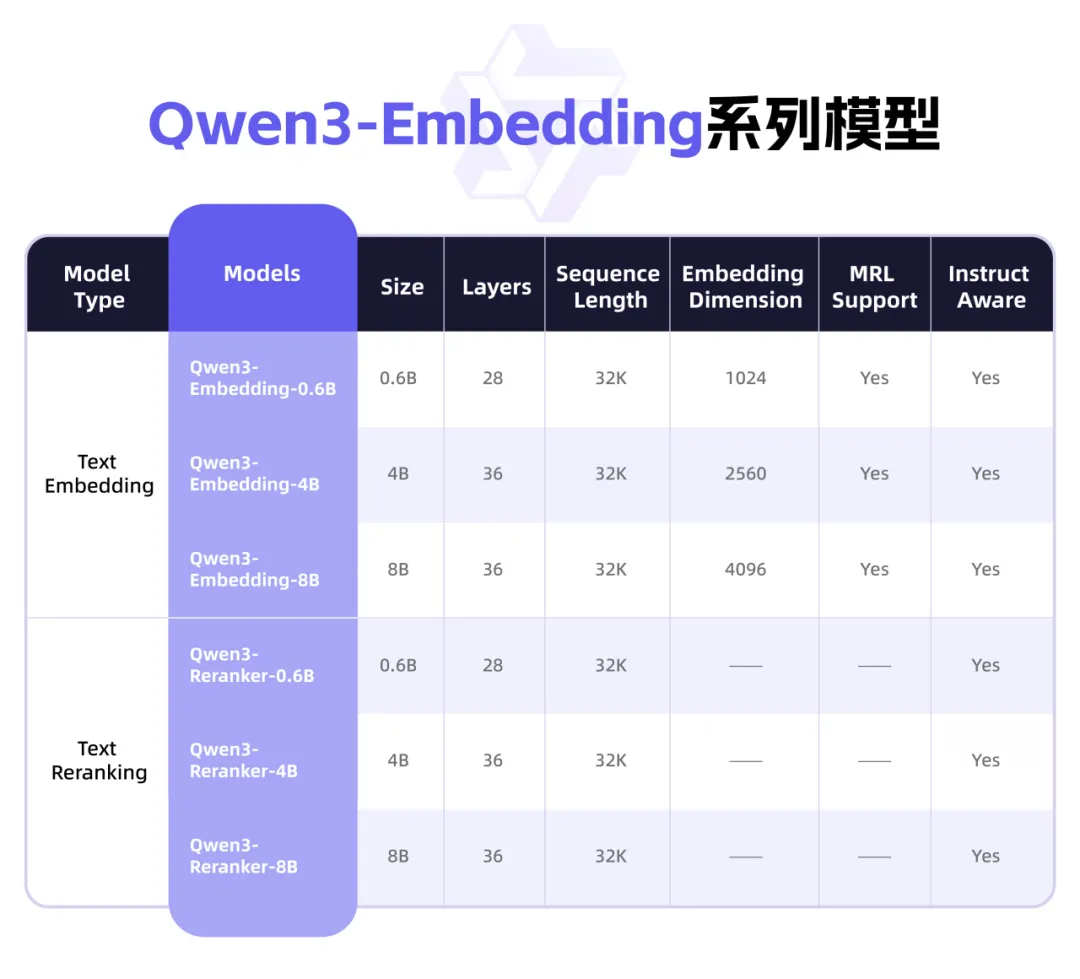

Qwen3 merilis seri model Embedding baru, fokus pada representasi teks dan Rerank: Tim Qwen Alibaba meluncurkan seri model Qwen3-Embedding, yang dirancang khusus untuk tugas representasi teks, pencarian, dan pemeringkatan. Seri ini mencakup model Embedding dan model Reranker dalam tiga ukuran: 0.6B, 4B, dan 8B. Model-model ini dilatih berdasarkan model dasar Qwen3, mewarisi keunggulan multibahasanya, dan mendukung 119 bahasa. Versi 8B melampaui API komersial dan meraih peringkat pertama di papan peringkat multibahasa MTEB. Model ini menggunakan paradigma pelatihan multi-tahap, termasuk pembelajaran kontrastif yang diawasi secara lemah dalam skala besar, pelatihan yang diawasi dengan data beranotasi berkualitas tinggi, dan fusi model. Seri model Qwen3-Embedding telah dirilis sebagai open source di Hugging Face, ModelScope, dan GitHub, serta dapat digunakan melalui platform Alibaba Cloud Bailian (阿里云百炼平台) (sumber: 36氪)

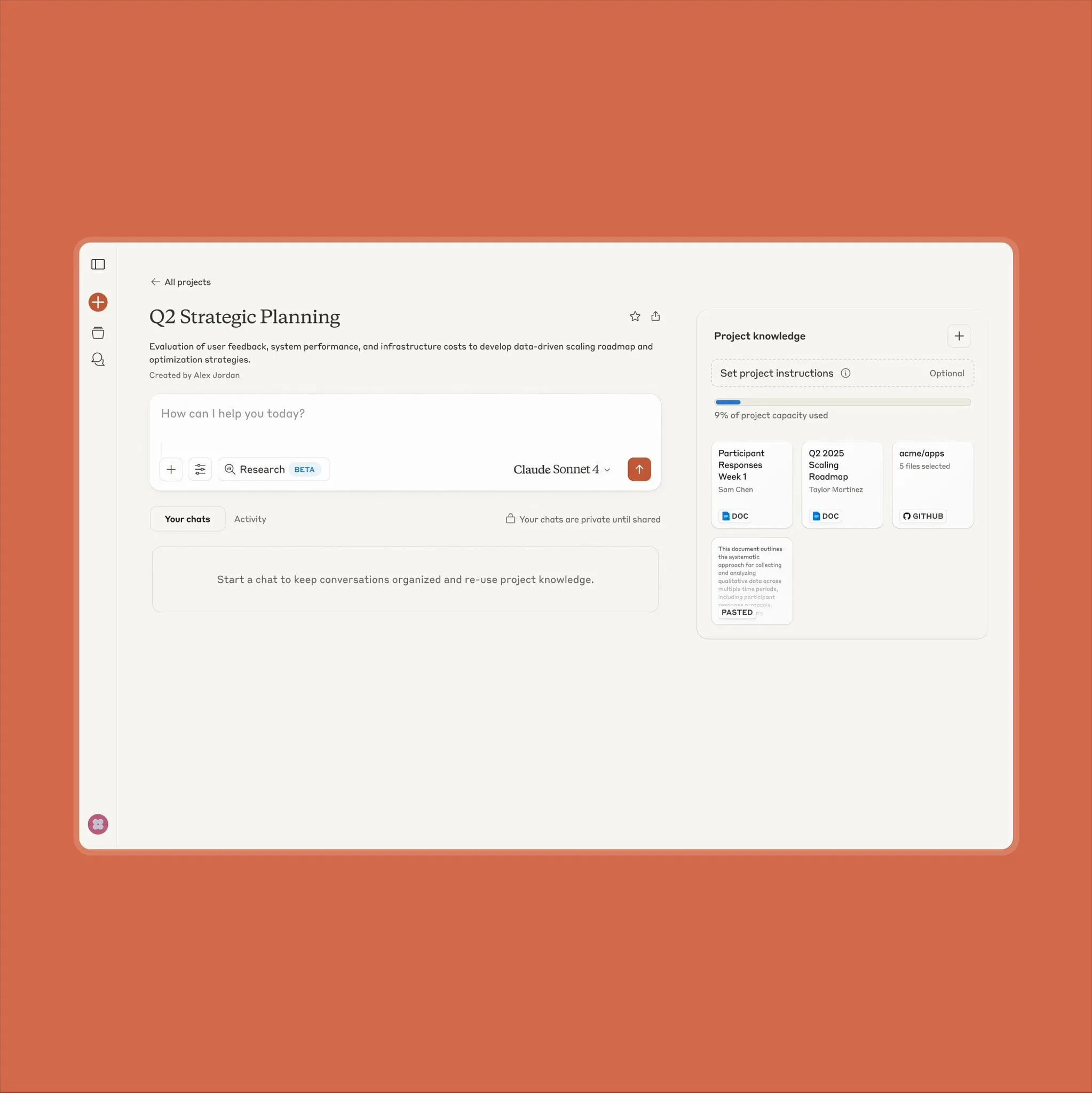

Fungsi proyek Anthropic Claude ditingkatkan, mendukung pemrosesan konten 10 kali lebih banyak: Anthropic mengumumkan bahwa fungsi “Projects on Claude” sekarang mendukung pemrosesan konten 10 kali lebih banyak dari sebelumnya. Ketika pengguna menambahkan file yang melebihi ambang batas sebelumnya, Claude akan beralih ke mode pencarian baru untuk memperluas konteks fungsional. Peningkatan ini sangat berharga bagi pengguna yang perlu memproses dokumen besar (seperti lembar data semikonduktor), di mana sebelumnya beberapa pengguna memilih untuk menggunakan ChatGPT yang memiliki kemampuan pencarian RAG. Komunitas pengguna menyambut baik hal ini, dan ada diskusi yang menyatakan bahwa Claude mungkin lebih unggul dalam pengkodean dibandingkan model OpenAI dan Google (sumber: Reddit r/ClaudeAI)

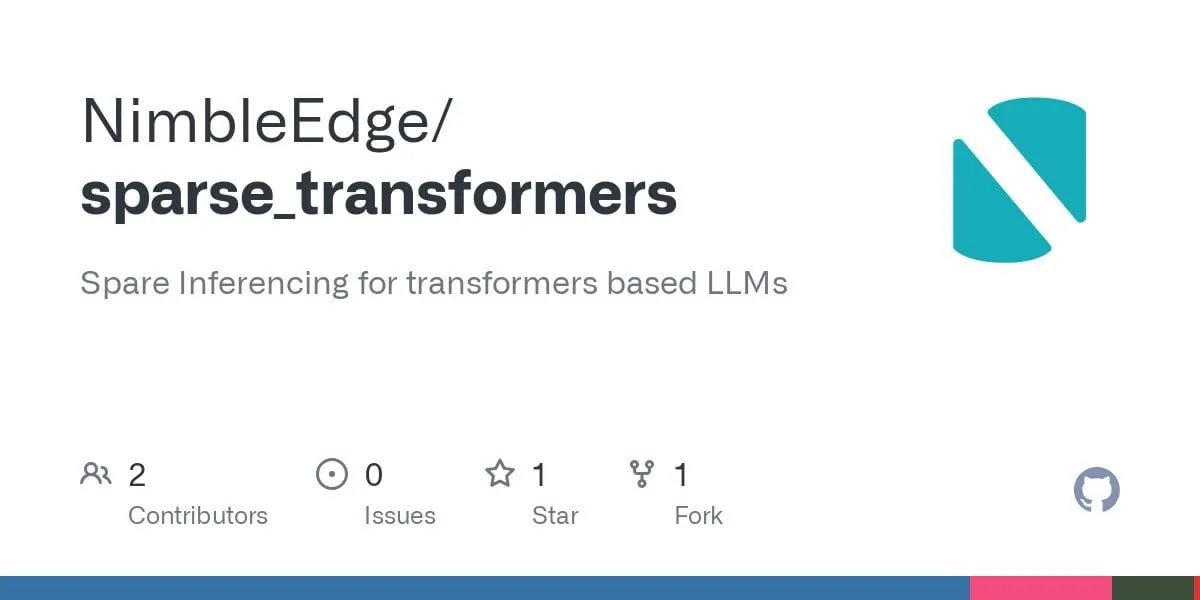

Kemajuan teknologi sparse Transformer: berpotensi menghasilkan inferensi LLM yang lebih cepat dan penggunaan memori yang lebih rendah: Berdasarkan penelitian LLM in a Flash (Apple) dan Deja Vu, komunitas telah mengembangkan kernel operator fusi untuk sparsitas konteks terstruktur. Teknologi ini mencapai peningkatan kinerja lapisan MLP sebesar 5 kali lipat dan pengurangan konsumsi memori sebesar 50% dengan menghindari pemuatan dan penghitungan nilai aktivasi yang terkait dengan bobot lapisan feed-forward yang outputnya pada akhirnya akan menjadi nol. Diterapkan pada model Llama 3.2 (lapisan feed-forward menyumbang 30% bobot dan komputasi), throughput meningkat 1,6-1,8 kali, waktu pembuatan Token pertama dipercepat 1,51 kali, kecepatan output meningkat 1,79 kali, dan penggunaan memori berkurang 26,4%. Kernel operator terkait telah dirilis sebagai open source di GitHub dengan nama sparse_transformers, dan direncanakan akan ditambahkan dukungan untuk int8, CUDA, dan sparse attention. Komunitas memperhatikan potensi dampaknya terhadap kualitas model (sumber: Reddit r/LocalLLaMA)

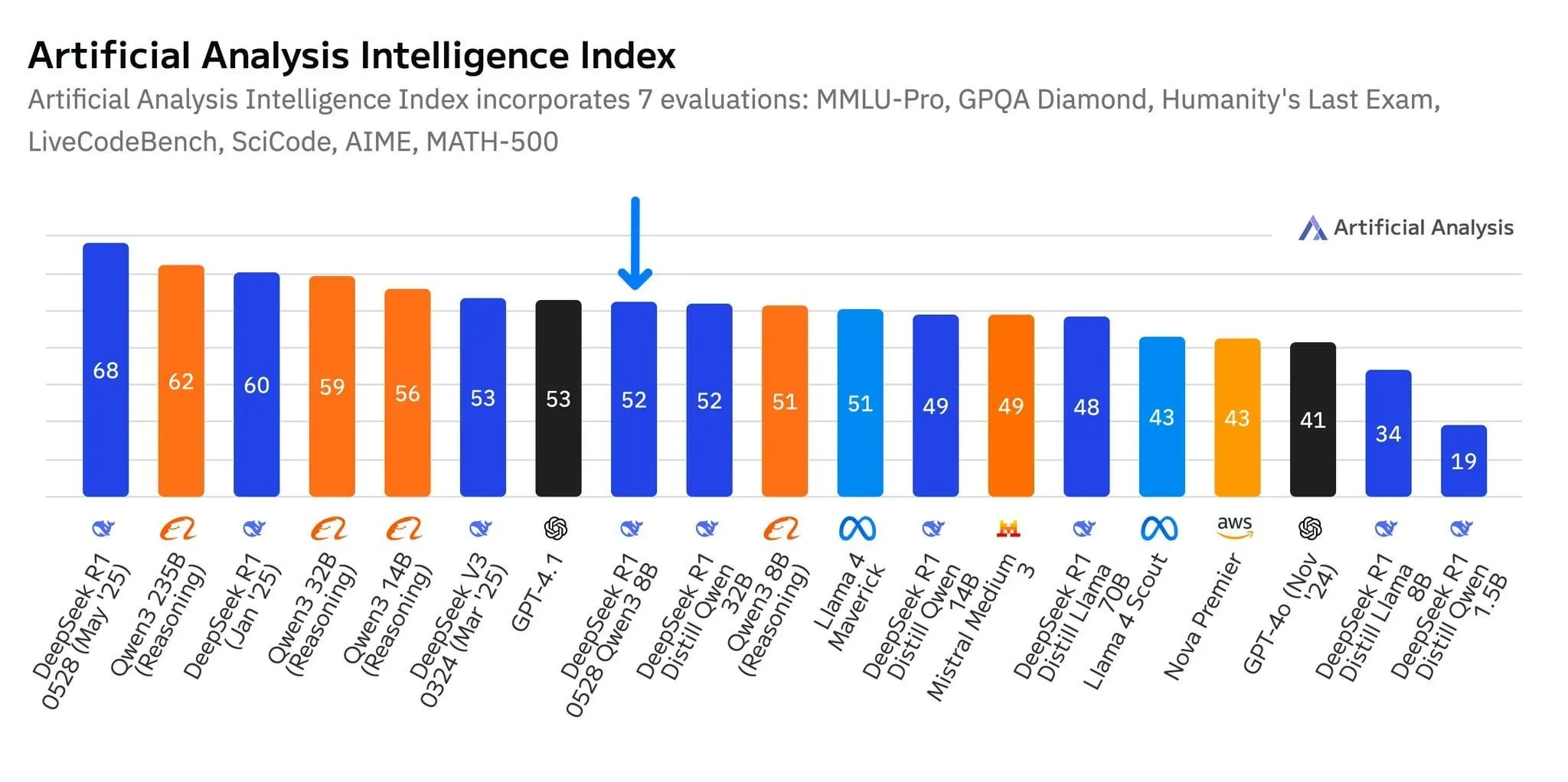

Model baru DeepSeek R1-0528-Qwen3-8B menonjol di tingkat parameter 8B, tetapi keunggulannya tipis: Menurut data Artificial Analysis, model R1-0528-Qwen3-8B terbaru yang dirilis DeepSeek adalah yang paling cerdas di tingkat parameter 8 miliar, tetapi keunggulannya tidak signifikan, dengan model Qwen3 8B milik Alibaba sendiri berada tepat di belakangnya, hanya selisih sedikit. Diskusi komunitas menunjukkan bahwa meskipun model-model kecil ini berkinerja sangat baik, benchmark mungkin memiliki masalah overfitting, misalnya, seri model Qwen berkinerja menonjol pada benchmark seperti MMLU, yang mungkin terkait dengan data pelatihannya yang berisi pasangan tanya jawab dengan format serupa. Dalam pengalaman pengguna aktual, Destill R1 8B berkinerja lebih baik dalam pengkodean, matematika, dan penalaran, sementara Qwen 8B lebih alami dalam penulisan dan multibahasa (seperti bahasa Spanyol). Sebagian pengguna berpendapat bahwa kecerdasan model kecil telah mendekati batas atasnya (sumber: Reddit r/LocalLLaMA)

Perusahaan AI tingkat menengah seperti Tiangong dan Jieyue Xingchen fokus pada agen, mencari terobosan pasar: Menghadapi situasi “pemenang mengambil semua” dari aplikasi AI terkemuka seperti DeepSeek dan Doubao, aplikasi Tiangong di bawah Kunlun Wanwei melakukan pembaruan “rombak total”, bertransformasi menjadi platform AI Agent yang berpusat pada skenario perkantoran, menekankan kemampuan penyelesaian tugas. Jieyue Xingchen menyesuaikan strateginya, menyusutkan produk C-end seperti “Maopao Ya”, mengganti nama “Yuewen” menjadi “Jieyue AI”, dan fokus pada penelitian dan pengembangan model serta pasar ToB, dengan fokus pada implementasi Agent multimodal di terminal seperti ponsel, mobil, dan robot. Penyesuaian ini mencerminkan upaya vendor AI non-unggulan dalam persaingan ketat untuk bertaruh pada agen, beralih dari “persaingan kemampuan umum” ke “pembangunan loop tertutup skenario”, dengan harapan menemukan peluang untuk bertahan hidup dan berkembang di segmen vertikal (sumber: 36氪)

Model besar multimodal Qwen2.5-Omni dirilis, mendukung input teks, gambar, video, audio, dan output audio-teks: Qwen2.5-Omni adalah model besar multimodal open source (lisensi Apache 2.0) yang baru dirilis, mampu memproses teks, gambar, video, dan audio sebagai input, serta dapat menghasilkan output teks dan audio. Ini memberi pengembang alat yang kuat mirip Gemini tetapi dapat di-deploy dan diteliti secara lokal. Artikel ini secara singkat memperkenalkan model tersebut dan menunjukkan eksperimen inferensi sederhana, menyoroti potensinya dalam interaksi multimodal, yang diharapkan dapat mendorong pengembangan aplikasi AI multimodal lokal (sumber: Reddit r/deeplearning)

![[Article] Qwen2.5-Omni: An Introduction](https://rebabel.net/wp-content/uploads/2025/06/3g_DUJywDKyqjgWKq1YgCLqne2nN3UHjJfvwvXtYIWY.webp)

OpenAI diperintahkan pengadilan untuk menyimpan semua log ChatGPT, termasuk riwayat obrolan yang “dihapus”: Dalam gugatan hak cipta yang diajukan oleh lembaga berita seperti New York Times, pengadilan AS pada 13 Mei 2025 memerintahkan OpenAI untuk menyimpan semua log obrolan ChatGPT, bahkan jika pengguna telah “menghapusnya”. Pihak penggugat berpendapat bahwa OpenAI menggunakan artikel mereka tanpa izin untuk melatih ChatGPT, dan khawatir pengguna dapat menghapus riwayat obrolan yang melibatkan upaya melewati paywall untuk menghancurkan bukti. Langkah ini menimbulkan kekhawatiran privasi pengguna, dan mungkin bertentangan dengan peraturan seperti GDPR. OpenAI berpendapat bahwa perintah tersebut didasarkan pada spekulasi, kurang bukti, dan membebani operasinya. Kasus ini menyoroti ketegangan antara perlindungan kekayaan intelektual dan privasi pengguna (sumber: Reddit r/ArtificialInteligence)

X (sebelumnya Twitter) melarang bot AI menggunakan datanya untuk pelatihan: Platform X memperbarui kebijakannya, melarang penggunaan data atau API-nya untuk pelatihan model bahasa, yang semakin memperketat akses tim AI ke kontennya. Sementara itu, Anthropic meluncurkan model AI Claude Gov yang dirancang khusus untuk keamanan nasional AS, yang mencerminkan tren perusahaan teknologi seperti OpenAI, Meta, dan Google yang secara aktif menyediakan alat AI kepada pemerintah dan sektor pertahanan (sumber: Reddit r/ArtificialInteligence)

Amazon membentuk tim agen AI baru, menguji pengiriman dengan robot humanoid: Amazon membentuk tim baru di dalam divisi pengembangan produk konsumennya, Lab126, yang berfokus pada penelitian dan pengembangan AI agent, dan berencana menguji penggunaan robot humanoid untuk pengiriman paket. Pengujian akan dilakukan di sebuah kantor di San Francisco, California, yang diubah menjadi lintasan rintangan dalam ruangan. Robot (kemungkinan termasuk produk dari Unitree Robotics Tiongkok) akan menumpang mobil pengiriman listrik Rivian, lalu turun untuk menyelesaikan pengiriman jarak terakhir. Amazon juga sedang mengembangkan perangkat lunak berbasis model DeepSeek-VL2 dan Qwen untuk robot simulasi. Langkah ini bertujuan untuk meningkatkan efisiensi gudang dan kecepatan pengiriman melalui teknologi AI dan robotika (sumber: 36氪)

Lenovo berupaya keras dalam transformasi AI, fokus pada kecerdasan buatan hibrida dan implementasi agen: Lenovo mempercepat transformasinya dari produsen perangkat keras PC tradisional menjadi penyedia solusi berbasis AI, menjadikan “kecerdasan buatan hibrida” sebagai strategi inti untuk dekade mendatang. Strategi ini menekankan integrasi kecerdasan pribadi, kecerdasan perusahaan, dan kecerdasan publik, yang bertujuan untuk menjamin privasi data dan layanan yang dipersonalisasi melalui kolaborasi edge-cloud. Lenovo telah mengimplementasikan super agen perkotaan di Shanghai dan meluncurkan ekosistem agen cerdas pribadi Tianxi. Meskipun bisnis PC masih mendominasi, Lenovo mendorong pengembangan AI PC, server AI, dan solusi industri melalui penelitian dan pengembangan mandiri serta kerja sama (seperti dengan Universitas Tsinghua, Universitas Shanghai Jiao Tong, dll.), untuk menghadapi penyusutan pasar PC dan persaingan teknologi baru. Namun, penerimaan pasar AI PC, hasil komersial skala besar dari aplikasi AI, dan persaingan dengan rival seperti Huawei masih menjadi masalah utama yang dihadapinya (sumber: 36氪)

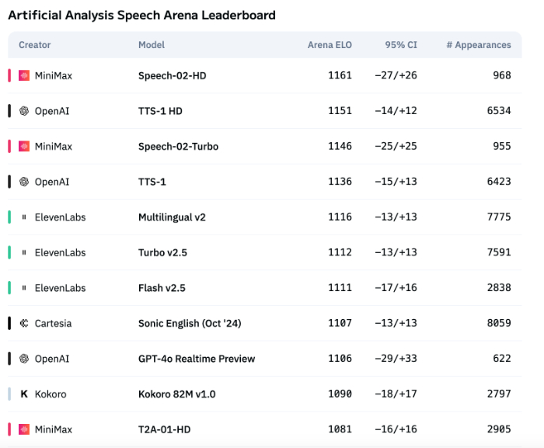

Ekspresi emosi teknologi suara AI masih kurang, aplikasi ToB mulai meledak: Meskipun model seperti Speech-02-HD dari MiniMax telah mencapai kemajuan dalam indikator teknis sintesis suara dan berkinerja cukup baik dalam skenario tertentu (seperti emosi sederhana dalam buku audio berbahasa Mandarin), secara keseluruhan, suara AI masih kurang dalam ekspresi emosi yang kompleks dan adaptasi pada skenario tertentu (seperti siaran langsung penjualan). Pengujian menunjukkan bahwa produk vertikal seperti DubbingX berkinerja lebih baik di bidang tertentu melalui label emosi yang terperinci, sementara produk seperti ElevenLabs yang tidak memiliki label emosi berkinerja lebih buruk. Saat ini, suara AI di bidang ToC masih belum matang, tetapi di bidang ToB, seperti asisten suara, perangkat keras pendamping AI, dll., telah mulai banyak digunakan, dan diharapkan dapat membuka lebih banyak skenario di masa depan (sumber: 36氪)

Strategi AI Google terhambat, konferensi pengembang gagal membalikkan keadaan: Meskipun Google merilis serangkaian produk dan inisiatif AI di konferensi pengembang 2025, sebagian besar produk masih dalam tahap pengujian internal atau belum diluncurkan, dan dituduh kurang inovasi disruptif, lebih seperti mengejar pesaing seperti OpenAI. Model besar Gemini gagal memimpin industri seperti ChatGPT, malah dikritik karena “kurang inovasi” dan “strategi yang goyah”. Lambatnya tindakan Google di bidang pencarian AI, asisten AI, dll., membuatnya tertinggal dari aliansi Microsoft dan OpenAI dalam komersialisasi AI dan pembangunan ekosistem. Model bisnisnya yang 80% bergantung pada iklan juga membuatnya menghadapi dilema “revolusi diri” saat memajukan pencarian AI. Masalah organisasi internal, kehilangan talenta, dan kegagalan mengintegrasikan hasil penelitian secara efektif, bersama-sama menyebabkan Google berubah dari pemimpin menjadi pengejar dalam perlombaan AI (sumber: 36氪)

Strategi AI Apple menghadapi tantangan: parameter model sisi perangkat rendah, tekanan pasar Tiongkok meningkat: iOS 26 dan macOS 26 yang akan dirilis Apple di WWDC, model AI sisi perangkat andalannya dilaporkan hanya memiliki 3 miliar parameter, jauh di bawah tingkat 7 miliar parameter yang telah dicapai merek ponsel domestik, dan juga secara signifikan lebih rendah dari skala model cloud Apple. Strategi “penyusutan” ini mungkin sulit memenuhi permintaan pengguna pasar Tiongkok akan fungsi AI berdaya komputasi tinggi (seperti transkripsi suara, terjemahan waktu nyata), terutama dengan latar belakang peningkatan pesat kemampuan AI merek lokal seperti Huawei, pangsa pasar Apple telah menghadapi tekanan. Selain itu, kepatuhan data dan kecepatan respons server juga dapat memengaruhi pengalaman AI Apple di Tiongkok. Apple mungkin berharap dapat menutupi kekurangan teknisnya sendiri dan memperkaya ekosistem aplikasi dengan membuka izin model AI kepada pengembang, tetapi apakah langkah ini akan berhasil masih harus dilihat (sumber: 36氪)

🧰 Alat

Mind The Abstract: Buletin ringkasan LLM makalah arXiv: Sebuah alat baru bernama Mind The Abstract, bertujuan untuk membantu pengguna mengikuti perkembangan pesat penelitian AI/ML di arXiv. Alat ini memindai makalah arXiv setiap minggu, memilih 10 artikel menarik, dan menggunakan LLM untuk menghasilkan ringkasan. Pengguna dapat berlangganan buletin email gratis untuk menerima ringkasan ini. Ringkasan tersedia dalam dua gaya: “Informal” (tidak formal, sedikit istilah teknis, lebih banyak intuisi) dan “TLDR” (singkat, cocok untuk pengguna dengan latar belakang profesional). Pengguna juga dapat menyesuaikan kategori topik arXiv yang diminati. Proyek ini bertujuan untuk mempopulerkan penelitian AI, fokus pada fakta, dan membantu peneliti memahami kemajuan di bidang terkait (sumber: Reddit r/artificial)

SteamLens: Sistem Transformer terdistribusi menganalisis ulasan game Steam: Seorang mahasiswa magister mengembangkan sistem Transformer terdistribusi bernama SteamLens untuk menganalisis sejumlah besar ulasan game Steam, yang bertujuan membantu pengembang game independen memahami umpan balik pemain. Sistem ini mempersingkat waktu pemrosesan 400.000 ulasan dari 30 menit menjadi 2 menit melalui paralelisasi pemrosesan Transformer. Terobosan teknis utama adalah berbagi instance model Transformer melalui klaster Dask, yang mengatasi masalah penggunaan memori yang terlalu tinggi. Sistem dapat secara otomatis mendeteksi perangkat keras, mengalokasikan node kerja, memproses ulasan secara paralel, dan melakukan analisis sentimen serta peringkasan. Saat ini proyek hanya dapat dijalankan pada satu mesin, dan di masa depan direncanakan untuk mendukung multi-GPU dan dataset skala lebih besar. Pengembang mencari saran mengenai arah pengembangan proyek selanjutnya (perluasan teknis atau peningkatan kemudahan penggunaan) (sumber: Reddit r/MachineLearning)

![[P] Need advice on my steam project](https://rebabel.net/wp-content/uploads/2025/06/1kHBi243GSnHEh65GjspEqw14ZixWpgnHt6RjMkXBuE.webp)

Model OpenThinker3-7B dirilis: Model OpenThinker3-7B dan versi GGUF-nya telah dirilis di HuggingFace. Komunitas berkomentar bahwa model ini, saat dirilis, membandingkan kinerjanya dengan beberapa model yang sudah usang, yang mungkin memengaruhi positioning dan penilaian daya saingnya (sumber: Reddit r/LocalLLaMA)

Memanfaatkan “mode paranoid” untuk mencegah halusinasi LLM dan penggunaan jahat: Seorang pengembang, saat membangun chatbot LLM untuk skenario layanan pelanggan nyata, menambahkan “mode paranoid” untuk mengatasi masalah pengguna yang mencoba melakukan jailbreak, masalah tepi yang menyebabkan kebingungan logika, dan injeksi prompt. Mode ini melakukan pemeriksaan kewarasan sebelum inferensi model, secara proaktif memblokir pesan apa pun yang tampaknya mencoba mengarahkan ulang model, mengekstrak konfigurasi internal, atau menguji pagar pembatas, bukan hanya menyaring konten berbahaya. Mode ini mengurangi halusinasi dan perilaku yang menyimpang dari strategi dengan memilih untuk menunda, mencatat, atau beralih ke solusi cadangan ketika prompt tampak manipulatif atau ambigu (sumber: Reddit r/artificial)

Fluxions AI merilis model suara NotebookLM 100 juta parameter VUI secara open source: Fluxions AI merilis model suara NotebookLM 100 juta parameter open source bernama VUI, yang diklaim dibangun menggunakan dua kartu grafis 4090. Proyek ini telah tersedia di GitHub (github.com/fluxions-ai/vui) dan disertai tautan video demo yang menunjukkan kemampuan interaksi suaranya (sumber: Reddit r/MachineLearning)

![[R] 100M Open source notebooklm speech model](https://rebabel.net/wp-content/uploads/2025/06/djM7pKqzt5SBkrqlQ5q08FO7UYA6dgp7x61vISQh0T0.webp)

📚 Belajar

Tutorial: Memanfaatkan model super-resolusi untuk meningkatkan kualitas gambar dan video: Sebuah tutorial tentang penggunaan model super-resolusi seperti CodeFormer untuk meningkatkan kualitas gambar dan video telah dibagikan. Tutorial ini dibagi menjadi empat bagian: pengaturan lingkungan, super-resolusi gambar, super-resolusi video, dan bagian tambahan – mewarnai foto hitam putih lama. Tutorial ini bertujuan untuk membantu pengguna mempelajari cara meningkatkan kejernihan dan detail gambar statis dan video dinamis, serta memulihkan warna foto lama. Lebih banyak tutorial dan informasi dapat diakses melalui tautan blog yang disediakan (sumber: Reddit r/deeplearning)

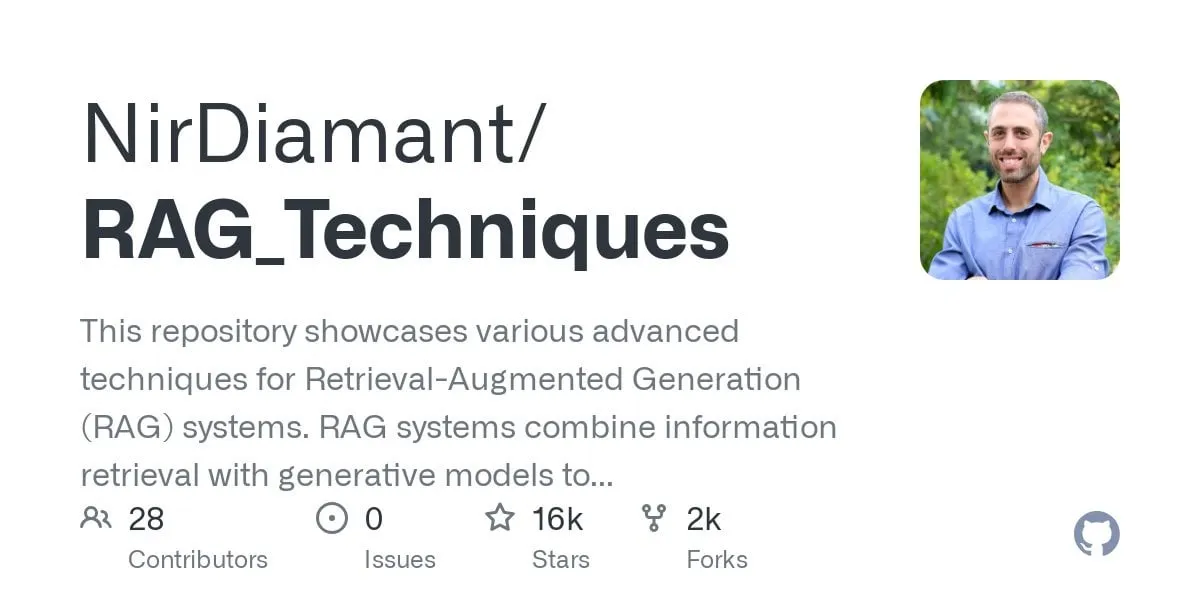

Tutorial GraphRAG tanya jawab multi-hop dirilis, menggabungkan pencarian vektor dan penalaran graf: Repositori GitHub RAG_Techniques (telah mendapatkan 16K+ bintang) menambahkan tutorial GraphRAG langkah demi langkah, yang berfokus pada penyelesaian masalah kompleks multi-hop yang sulit ditangani oleh RAG biasa (seperti “bagaimana protagonis mengalahkan asisten penjahat?”). Metode ini menggabungkan pencarian vektor dengan penalaran graf, hanya menggunakan database vektor, tanpa memerlukan database graf independen. Tutorial ini mencakup konversi teks menjadi entitas, hubungan, dan paragraf untuk penyimpanan vektor, membangun pencarian entitas dan hubungan, memanfaatkan matriks matematika untuk menemukan koneksi data, menggunakan prompt AI untuk memilih hubungan terbaik, serta menangani masalah kompleks multi-langkah logis, dan membandingkan efek GraphRAG dengan RAG sederhana (sumber: Reddit r/LocalLLaMA)

Makalah membahas arsitektur DNN berkinerja tinggi non-standar baru, dengan stabilitas signifikan: Sebuah artikel yang baru diterbitkan mengeksplorasi jaringan saraf dalam (DNN) dari dasar, memperkenalkan arsitektur baru yang berbeda dari pembelajaran mesin dan AI tradisional. Arsitektur ini menggunakan fungsi kerugian adaptif orisinal, mencapai peningkatan kinerja yang signifikan melalui mekanisme “penyeimbangan”. Ini menggunakan fungsi non-linear untuk menghubungkan neuron dan tanpa fungsi aktivasi antar lapisan, sehingga mengurangi jumlah parameter, meningkatkan interpretabilitas, menyederhanakan fine-tuning, dan mempercepat pelatihan. Penyeimbang adaptif sebagai subsistem dinamis menghilangkan bagian linear model, berfokus pada interaksi tingkat tinggi untuk mempercepat konvergensi. Dalam makalah ini, universalitas fungsi zeta Riemann digunakan sebagai contoh untuk mendekati respons apa pun, dan dapat menangani singularitas untuk mengatasi kejadian langka atau deteksi penipuan. Metode ini tidak bergantung pada pustaka seperti PyTorch, TensorFlow, atau Keras, hanya menggunakan Numpy untuk implementasi (sumber: Reddit r/deeplearning)

![[R] New article: A New Type of Non-Standard High Performance DNN with Remarkable Stability](https://rebabel.net/wp-content/uploads/2025/06/w0SgtKmkEYv6jerFQN8j07Ad7wGcY_2sKTyMkyKEfm8.webp)

Makalah CRAWLDoc: Dataset dan Metode untuk Pemeringkatan Literatur Bibliografi yang Kuat: Menghadapi tantangan tata letak dan format yang dihadapi database publikasi saat mengekstrak metadata dari sumber web yang beragam, metode CRAWLDoc diusulkan. Metode ini memeringkat dokumen web yang ditautkan secara kontekstual, dimulai dari URL publikasi (seperti DOI), mengambil halaman arahan dan semua sumber daya yang ditautkan (PDF, ORCID, dll.), dan menyematkan sumber daya ini, teks jangkar, dan URL ke dalam representasi terpadu. Untuk mengevaluasi metode ini, peneliti membuat dataset berlabel manual yang berisi 600 publikasi dari penerbit terkemuka di bidang ilmu komputer. CRAWLDoc menunjukkan kemampuan pemeringkatan dokumen relevan yang kuat dan tidak bergantung pada tata letak di berbagai penerbit dan format data, meletakkan dasar untuk meningkatkan ekstraksi metadata dari dokumen web dengan berbagai tata letak dan format (sumber: HuggingFace Daily Papers)

Makalah RiOSWorld: Benchmark Risiko untuk Agen Pengguna Komputer Multimodal: Seiring dengan pesatnya perkembangan model bahasa besar multimodal (MLLM) dan penerapannya sebagai agen pengguna komputer otonom, penilaian risiko keamanannya menjadi krusial. Metode evaluasi yang ada saat ini kurang memiliki lingkungan interaksi yang nyata, atau hanya berfokus pada beberapa jenis risiko. Untuk itu, benchmark RiOSWorld diusulkan untuk mengevaluasi potensi risiko agen MLLM dalam operasi komputer nyata. Benchmark ini berisi 492 tugas risiko yang mencakup berbagai aplikasi (web, media sosial, sistem operasi, dll.), dibagi menjadi dua kategori besar: risiko yang bersumber dari pengguna dan risiko lingkungan, dievaluasi dari dua dimensi: niat target risiko dan penyelesaian target risiko. Eksperimen menunjukkan bahwa agen pengguna komputer saat ini menghadapi risiko keamanan yang signifikan dalam skenario nyata, menyoroti kebutuhan dan urgensi untuk penyelarasan keamanan mereka (sumber: HuggingFace Daily Papers)

Pandangan Makalah: Model Bahasa Kecil (SLM) adalah Masa Depan AI Agen: Makalah ini mengemukakan bahwa meskipun model bahasa besar (LLM) berkinerja sangat baik dalam berbagai tugas, untuk tugas-tugas khusus yang sering diulang dalam sistem AI agen, model bahasa kecil (SLM) lebih unggul. SLM tidak hanya cukup fungsional, tetapi juga lebih cocok dan lebih ekonomis. Artikel ini berargumen berdasarkan kemampuan SLM saat ini, arsitektur umum sistem agen, dan keekonomian penerapan model bahasa. Untuk skenario yang membutuhkan kemampuan percakapan umum, sistem agen heterogen (memanggil berbagai model yang berbeda) adalah pilihan alami. Makalah ini juga membahas potensi hambatan penerapan SLM dalam sistem agen, dan menguraikan algoritma konversi agen LLM ke SLM umum, yang bertujuan untuk mendorong diskusi tentang pemanfaatan sumber daya AI yang efektif (sumber: HuggingFace Daily Papers)

Makalah POSS: Memanfaatkan Pakar Posisi untuk Meningkatkan Kinerja Model Draf dalam Dekode Spekulatif: Dekode spekulatif mempercepat inferensi LLM dengan menggunakan model draf kecil untuk memprediksi multi-Token dan model target besar untuk memverifikasi secara paralel. Penelitian terbaru memanfaatkan status tersembunyi model target untuk meningkatkan akurasi prediksi model draf, tetapi metode yang ada saat ini, karena akumulasi kesalahan fitur yang dihasilkan model draf, menyebabkan penurunan kualitas prediksi Token posisi berikutnya. Metode Position Specialists (PosS) mengusulkan penggunaan beberapa lapisan draf yang terspesialisasi posisi untuk menghasilkan Token pada posisi tertentu. Karena setiap pakar hanya perlu menangani tingkat deviasi fitur model draf tertentu, PosS secara signifikan meningkatkan tingkat penerimaan Token posisi berikutnya. Eksperimen pada Llama-3-8B-Instruct dan Llama-2-13B-chat menunjukkan bahwa PosS lebih unggul dari baseline dalam hal panjang penerimaan rata-rata dan rasio percepatan (sumber: HuggingFace Daily Papers)

Makalah CapSpeech: Memberdayakan Aplikasi Hilir untuk Teks-ke-Suara dengan Subtitle Bergaya (CapTTS): CapSpeech adalah benchmark baru yang dirancang untuk serangkaian tugas yang terkait dengan teks-ke-suara dengan subtitle bergaya (CapTTS), termasuk CapTTS dengan efek suara (CapTTS-SE), TTS subtitle aksen (AccCapTTS), TTS subtitle emosi (EmoCapTTS), dan TTS agen obrolan (AgentTTS). CapSpeech berisi lebih dari 10 juta pasangan audio-subtitle beranotasi mesin dan hampir 360.000 pasangan beranotasi manual. Selain itu, diperkenalkan dua dataset baru yang direkam oleh aktor suara profesional dan insinyur audio, khusus untuk tugas AgentTTS dan CapTTS-SE. Hasil eksperimen menunjukkan sintesis suara dengan fidelitas tinggi dan kejernihan tinggi dalam berbagai gaya bicara. Diklaim bahwa CapSpeech saat ini merupakan dataset terbesar yang menyediakan anotasi komprehensif untuk tugas terkait CapTTS (sumber: HuggingFace Daily Papers)

Makalah VideoMarathon: Meningkatkan Kemampuan Pemahaman Bahasa Video Panjang melalui Pelatihan Video Berdurasi Jam: Untuk mengatasi kelangkaan data anotasi video panjang, dataset VideoMarathon diusulkan, sebuah dataset instruksi mengikuti video berdurasi jam skala besar, berisi sekitar 9.700 jam video dengan durasi mulai dari 3 hingga 60 menit dari berbagai jenis. Dataset ini berisi 3,3 juta pasangan tanya jawab berkualitas tinggi, mencakup enam tema utama: waktu, ruang, objek, aksi, adegan, dan peristiwa, serta mendukung 22 jenis tugas yang membutuhkan pemahaman video jangka pendek dan panjang. Berdasarkan dataset ini, model Hour-LLaVA diusulkan, yang secara efektif memproses video berdurasi jam melalui modul peningkatan memori, dan mencapai kinerja terbaik dalam beberapa benchmark bahasa video panjang, membuktikan kualitas tinggi dataset VideoMarathon dan keunggulan model Hour-LLaVA (sumber: HuggingFace Daily Papers)

Makalah AV-Reasoner: Peningkatan dan Benchmark Kemampuan MLLM Penghitungan Audio-Visual Berbasis Petunjuk: Model bahasa besar multimodal (MLLM) saat ini berkinerja buruk dalam tugas penghitungan video. Benchmark yang ada memiliki masalah seperti video pendek, cakupan kueri yang sempit, kurangnya anotasi petunjuk, dan cakupan multimodal yang tidak memadai. Untuk itu, benchmark CG-AV-Counting diusulkan, sebuah benchmark penghitungan berbasis petunjuk yang dianotasi secara manual, berisi 1027 pertanyaan multimodal dari 497 video panjang dan 5845 petunjuk beranotasi, mendukung evaluasi black-box dan white-box. Pada saat yang sama, model AV-Reasoner diusulkan, yang menggeneralisasi kemampuan penghitungan dari tugas terkait melalui GRPO dan pembelajaran kurikulum. AV-Reasoner mencapai hasil SOTA pada beberapa benchmark, menunjukkan efektivitas pembelajaran penguatan. Namun, eksperimen juga menunjukkan bahwa pada benchmark di luar domain, penalaran ruang bahasa gagal memberikan peningkatan kinerja (sumber: HuggingFace Daily Papers)

Makalah mengusulkan kerangka kerja baru untuk menyelaraskan ruang laten melalui prior aliran: Makalah ini mengusulkan kerangka kerja baru yang menyelaraskan ruang laten yang dapat dipelajari dengan distribusi target arbitrer dengan memanfaatkan model generatif berbasis aliran sebagai prior. Metode ini pertama-tama melatih model aliran pada fitur target untuk menangkap distribusi latennya, kemudian model aliran tetap ini meregulasi ruang laten melalui kerugian penyelarasan. Kerugian penyelarasan ini merumuskan ulang tujuan pencocokan aliran, memperlakukan variabel laten sebagai target optimasi. Penelitian membuktikan bahwa meminimalkan kerugian penyelarasan ini menetapkan target proksi yang mudah dihitung secara komputasi untuk memaksimalkan batas bawah variasional dari log-likelihood variabel laten di bawah distribusi target. Metode ini menghindari evaluasi likelihood yang mahal secara komputasi dan pemecahan ODE selama proses optimasi. Melalui eksperimen generasi gambar skala besar di ImageNet, validitas metode ini diverifikasi di bawah berbagai distribusi target (sumber: HuggingFace Daily Papers)

Makalah MedAgentGym: Pelatihan Skala Besar Agen LLM untuk Penalaran Medis Berbasis Kode: MedAgentGym adalah lingkungan pelatihan pertama yang tersedia untuk umum yang bertujuan meningkatkan kemampuan penalaran medis berbasis kode agen model bahasa besar (LLM). Ini berisi 129 kategori, 72413 instance tugas yang berasal dari skenario biomedis nyata. Tugas-tugas dikemas dalam lingkungan pengkodean yang dapat dieksekusi, dengan deskripsi terperinci, umpan balik interaktif, anotasi kebenaran dasar yang dapat diverifikasi, dan pembuatan lintasan pelatihan yang dapat diskalakan. Benchmark lebih dari 30 LLM menunjukkan kesenjangan kinerja yang signifikan antara model API komersial dan model open source. Dengan memanfaatkan MedAgentGym, Med-Copilot-7B mencapai peningkatan kinerja yang signifikan melalui fine-tuning yang diawasi dan pembelajaran penguatan, menjadi alternatif yang kompetitif dan berfokus pada privasi untuk gpt-4o. MedAgentGym menyediakan platform terintegrasi untuk mengembangkan asisten pengkodean LLM untuk penelitian dan praktik biomedis tingkat lanjut (sumber: HuggingFace Daily Papers)

Makalah SparseMM: Respons Konsep Visual dalam MLLM Memicu Sparsitas Kepala: Model bahasa besar multimodal (MLLM) biasanya berasal dari perluasan kemampuan visual LLM yang telah dilatih sebelumnya. Penelitian menemukan bahwa MLLM menunjukkan fenomena sparsitas saat memproses input visual: hanya sebagian kecil (sekitar <5%) kepala perhatian (disebut kepala visual) dalam LLM yang secara aktif berpartisipasi dalam pemahaman visual. Untuk mengidentifikasi kepala visual ini secara efisien, peneliti merancang kerangka kerja bebas pelatihan yang mengukur relevansi visual kepala melalui analisis respons target. Berdasarkan penemuan ini, SparseMM diusulkan, sebuah strategi optimasi KV-Cache yang mengalokasikan anggaran komputasi asimetris berdasarkan skor visual kepala, memanfaatkan sparsitas kepala visual untuk mempercepat inferensi MLLM. Dibandingkan dengan metode sebelumnya yang mengabaikan kekhususan visual, SparseMM memprioritaskan dan mempertahankan semantik visual selama proses dekode, mencapai trade-off akurasi-efisiensi yang lebih baik pada benchmark multimodal utama (sumber: HuggingFace Daily Papers)

Makalah RoboRefer: Meningkatkan Kemampuan Referensi Spasial dan Penalaran dalam Model Bahasa Visual Robot: Referensi spasial adalah kemampuan dasar bagi robot yang diwujudkan (embodied) untuk berinteraksi di dunia fisik 3D. Metode yang ada, bahkan dengan memanfaatkan model bahasa visual (VLM) yang telah dilatih sebelumnya yang kuat, masih kesulitan untuk secara akurat memahami adegan 3D yang kompleks dan secara dinamis menalar lokasi interaksi yang ditunjukkan oleh instruksi. Untuk itu, RoboRefer diusulkan, sebuah VLM sadar 3D yang mengintegrasikan encoder kedalaman yang terpisah namun khusus melalui fine-tuning yang diawasi (SFT) untuk mencapai pemahaman spasial yang akurat. Selain itu, RoboRefer meningkatkan kemampuan penalaran spasial multi-langkah yang digeneralisasi melalui fine-tuning penguatan (RFT) dan fungsi hadiah proses sensitif metrik yang disesuaikan untuk tugas referensi spasial. Untuk mendukung pelatihan, dataset skala besar RefSpatial (20 juta pasangan tanya jawab, 31 hubungan spasial, hingga 5 langkah penalaran) dan benchmark evaluasi RefSpatial-Bench diperkenalkan. Eksperimen menunjukkan bahwa RoboRefer yang dilatih SFT mencapai SOTA dalam pemahaman spasial, dan setelah pelatihan RFT secara signifikan melampaui baseline lainnya pada RefSpatial-Bench, bahkan lebih unggul dari Gemini-2.5-Pro (sumber: HuggingFace Daily Papers)

Makalah LIFT: Memanfaatkan Encoder Teks LLM Tetap untuk Memandu Pembelajaran Representasi Visual: Metode utama penyelarasan bahasa-gambar saat ini (seperti CLIP) adalah melalui pembelajaran kontrastif yang melatih bersama encoder teks dan gambar. Penelitian ini mengeksplorasi apakah pelatihan bersama yang mahal ini harus dilakukan, khususnya meneliti apakah model bahasa besar (LLM) yang telah dilatih sebelumnya dan tetap dapat menyediakan encoder teks yang cukup baik untuk memandu pembelajaran representasi visual. Peneliti mengusulkan kerangka kerja LIFT (Language-Image alignment with a Fixed Text encoder), yang hanya melatih encoder gambar. Eksperimen membuktikan bahwa kerangka kerja yang disederhanakan ini sangat efektif, mengungguli CLIP dalam sebagian besar skenario yang melibatkan pemahaman gabungan dan judul panjang, serta secara signifikan meningkatkan efisiensi komputasi. Karya ini memberikan ide baru untuk mengeksplorasi bagaimana embedding teks LLM dapat memandu pembelajaran visual (sumber: HuggingFace Daily Papers)

Makalah OminiAbnorm-CT: Metode Baru Interpretasi Citra CT Seluruh Tubuh yang Berpusat pada Abnormalitas: Menghadapi tantangan interpretasi otomatis citra CT dalam radiologi klinis (khususnya lokalisasi dan deskripsi temuan abnormal dalam pemindaian multiplanar seluruh tubuh), penelitian ini memberikan empat kontribusi: 1) Mengusulkan sistem klasifikasi hierarkis komprehensif yang mencakup 404 temuan abnormal representatif dari berbagai area seluruh tubuh; 2) Membangun dataset yang berisi lebih dari 14.500 citra CT multiplanar seluruh tubuh, dan menyediakan anotasi lokalisasi serta deskripsi terperinci untuk lebih dari 19.000 abnormalitas; 3) Mengembangkan model OminiAbnorm-CT, yang dapat secara otomatis melokalisasi dan mendeskripsikan abnormalitas dalam citra CT multiplanar seluruh tubuh berdasarkan kueri teks, dan mendukung interaksi fleksibel melalui prompt visual; 4) Membangun tiga tugas evaluasi berdasarkan skenario klinis nyata. Eksperimen membuktikan bahwa OminiAbnorm-CT secara signifikan lebih unggul dari metode yang ada dalam semua tugas dan metrik (sumber: HuggingFace Daily Papers)

Makalah membahas pencapaian integritas kontekstual (CI) dalam LLM melalui penalaran dan pembelajaran penguatan: Seiring dengan datangnya era agen otonom yang membuat keputusan atas nama pengguna, memastikan integritas kontekstual (CI) – yaitu, informasi apa yang pantas dibagikan saat melakukan tugas tertentu – menjadi masalah inti. Peneliti berpendapat bahwa CI membutuhkan agen untuk melakukan penalaran terhadap lingkungan operasinya. Mereka pertama-tama meminta LLM untuk secara eksplisit menalar CI saat memutuskan pengungkapan informasi, kemudian mengembangkan kerangka kerja pembelajaran penguatan (RL) untuk lebih menanamkan kemampuan penalaran yang diperlukan model untuk mencapai CI. Menggunakan dataset contoh yang berisi sekitar 700 konteks sintetis namun beragam dan spesifikasi pengungkapan informasi, metode ini secara signifikan mengurangi pengungkapan informasi yang tidak pantas di berbagai ukuran dan keluarga model, sambil mempertahankan kinerja tugas. Yang penting, peningkatan ini bermigrasi dari dataset sintetis ke benchmark CI yang ada seperti PrivacyLens, yang memiliki anotasi manual dan mengevaluasi kebocoran privasi asisten AI dalam tindakan dan pemanggilan alat (sumber: HuggingFace Daily Papers)

Makalah VideoREPA: Mempelajari Pengetahuan Fisika dalam Generasi Video melalui Penyelarasan Hubungan dengan Model Dasar: Kemajuan model difusi teks-ke-video (T2V) baru-baru ini telah mencapai sintesis video dengan fidelitas tinggi, tetapi seringkali kesulitan menghasilkan konten yang masuk akal secara fisik karena kurangnya pemahaman fisika yang akurat. Penelitian menemukan bahwa kemampuan pemahaman fisika dalam representasi model T2V jauh lebih rendah daripada metode pembelajaran mandiri video. Untuk itu, kerangka kerja VideoREPA diusulkan, yang menyaring kemampuan pemahaman fisika model dasar pemahaman video ke dalam model T2V melalui penyelarasan hubungan tingkat Token. Secara khusus, diperkenalkan kerugian distilasi hubungan Token (TRD), yang memanfaatkan penyelarasan spasio-temporal untuk memberikan panduan lunak untuk fine-tuning model T2V yang telah dilatih sebelumnya yang kuat. Diklaim bahwa VideoREPA adalah metode REPA pertama yang dirancang untuk fine-tuning model T2V dan menyuntikkan pengetahuan fisika. Eksperimen menunjukkan bahwa VideoREPA secara signifikan meningkatkan akal sehat fisika metode baseline CogVideoX, mencapai peningkatan signifikan pada benchmark terkait (sumber: HuggingFace Daily Papers)

Makalah membahas pemikiran ulang representasi kedalaman untuk 3D Gaussian Splatting feed-forward: Peta kedalaman banyak digunakan dalam alur kerja 3D Gaussian Splatting (3DGS) feed-forward, dengan memproyeksikannya kembali sebagai point cloud 3D untuk sintesis tampilan baru. Metode ini memiliki keunggulan seperti pelatihan yang efisien, penggunaan pose kamera yang diketahui, dan estimasi geometri yang akurat. Namun, diskontinuitas kedalaman di batas objek sering menyebabkan fragmentasi atau sparsitas point cloud, yang menurunkan kualitas rendering. Untuk mengatasi masalah ini, peneliti memperkenalkan PM-Loss, sebuah kerugian regularisasi baru berbasis pointmap yang diprediksi oleh Transformer yang telah dilatih sebelumnya. Meskipun pointmap itu sendiri mungkin tidak seakurat peta kedalaman, ia dapat secara efektif memaksa kehalusan geometris, terutama di sekitar batas objek. Dengan peta kedalaman yang ditingkatkan, metode ini secara signifikan meningkatkan kinerja 3DGS feed-forward di berbagai arsitektur dan skenario, memberikan hasil rendering yang secara konsisten lebih unggul (sumber: HuggingFace Daily Papers)

Makalah EOC-Bench: Mengevaluasi Kemampuan MLLM dalam Mengenali, Mengingat, dan Memprediksi Objek di Dunia Perspektif Orang Pertama: Munculnya model bahasa besar multimodal (MLLM) telah mendorong terobosan dalam aplikasi visual perspektif orang pertama, yang membutuhkan pemahaman objek yang persisten dan sadar konteks. Namun, benchmark yang diwujudkan (embodied) yang ada saat ini terutama berfokus pada eksplorasi adegan statis, mengabaikan evaluasi perubahan dinamis yang dihasilkan oleh interaksi pengguna. EOC-Bench adalah benchmark baru yang bertujuan untuk secara sistematis mengevaluasi kognisi yang diwujudkan (embodied) yang berpusat pada objek dalam adegan perspektif orang pertama yang dinamis. Ini berisi 3277 pasangan QA yang dianotasi dengan cermat, dibagi menjadi tiga kategori waktu: masa lalu, sekarang, dan masa depan, mencakup 11 dimensi evaluasi terperinci dan 3 jenis referensi objek visual. Untuk memastikan evaluasi yang komprehensif, dikembangkan kerangka kerja anotasi kolaboratif manusia-mesin format campuran dan metrik akurasi temporal multi-skala baru. Berdasarkan evaluasi berbagai MLLM menggunakan EOC-Bench, ini menyediakan alat penting untuk meningkatkan kemampuan kognisi objek yang diwujudkan (embodied) MLLM (sumber: HuggingFace Daily Papers)

Makalah Rectified Point Flow: Metode Estimasi Pose Point Cloud Universal: Rectified Point Flow adalah metode parametrik terpadu yang merumuskan registrasi point cloud berpasangan dan perakitan bentuk multi-bagian sebagai masalah generatif bersyarat tunggal. Diberikan point cloud yang belum diposisikan, metode ini mempelajari medan kecepatan titik-demi-titik kontinu yang mentransfer titik-titik bernoise ke lokasi targetnya, sehingga memulihkan pose bagian. Berbeda dengan pekerjaan sebelumnya yang meregresi pose bagian dan mengadopsi pemrosesan simetri tertentu, metode ini secara intrinsik mempelajari simetri perakitan tanpa memerlukan label simetri. Dikombinasikan dengan encoder mandiri yang berfokus pada titik-titik yang tumpang tindih, metode ini mencapai kinerja SOTA baru pada enam benchmark yang mencakup registrasi berpasangan dan perakitan bentuk. Patut dicatat, formulasinya yang terpadu memungkinkan pelatihan bersama yang efektif pada dataset yang beragam, sehingga mendorong pembelajaran prior geometris bersama dan dengan demikian meningkatkan akurasi (sumber: HuggingFace Daily Papers)

Makalah DGAD: Mewujudkan Sintesis Objek yang Dapat Diedit Secara Geometris dan Mempertahankan Tampilan: Sintesis Objek Umum (GOC) bertujuan untuk mengintegrasikan objek target secara mulus ke dalam adegan latar belakang dengan atribut geometris yang diinginkan, sambil mempertahankan detail tampilan halusnya. Metode terbaru memanfaatkan embedding semantik dan mengintegrasikannya ke dalam model difusi tingkat lanjut untuk mencapai generasi yang dapat diedit secara geometris, tetapi embedding yang sangat ringkas ini hanya mengkodekan petunjuk semantik tingkat tinggi, yang tak terhindarkan menghilangkan detail tampilan halus. Peneliti memperkenalkan model DGAD (Disentangled Geometry-editable and Appearance-preserving Diffusion), yang pertama-tama memanfaatkan embedding semantik untuk secara implisit menangkap transformasi geometris yang diinginkan, kemudian menggunakan mekanisme pencarian perhatian silang untuk menyelaraskan fitur tampilan halus dengan representasi yang telah diedit secara geometris, sehingga mencapai pengeditan geometris yang akurat dan pelestarian tampilan yang setia dalam sintesis objek (sumber: HuggingFace Daily Papers)

💼 Bisnis

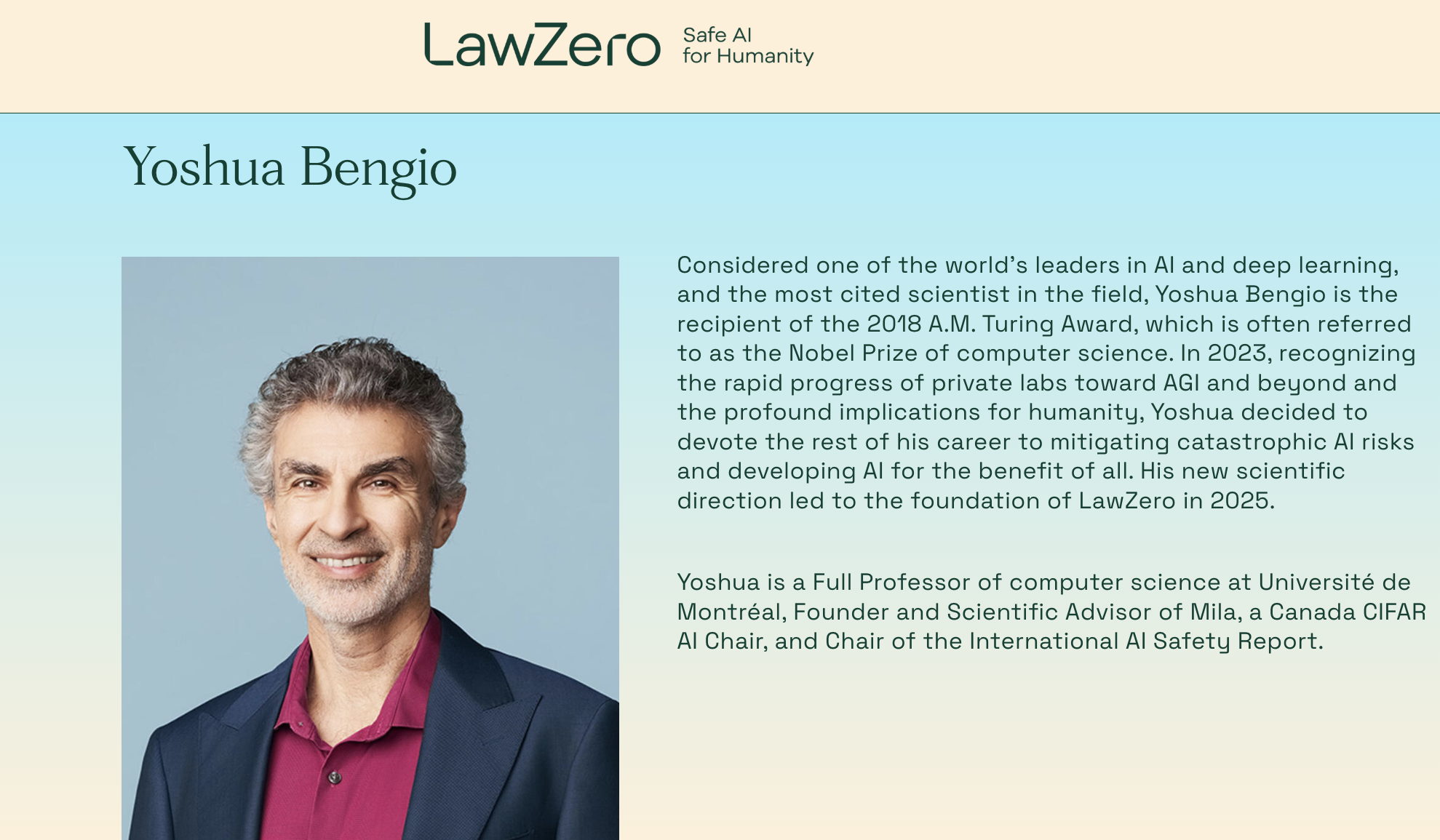

Pemenang Turing Award Yoshua Bengio kembali berwirausaha, mendirikan organisasi nirlaba LawZero yang fokus pada sistem AI “aman sejak desain”: Yoshua Bengio, salah satu dari tiga raksasa deep learning dan pemenang Turing Award, mengumumkan pendirian organisasi nirlaba baru bernama LawZero. Organisasi ini bertujuan untuk membangun sistem AI generasi berikutnya yang “aman sejak desain” (safe-by-design) dan secara eksplisit menyatakan tidak akan membuat Agent (agen cerdas). LawZero telah memperoleh pendanaan awal sebesar $30 juta dari berbagai pihak, termasuk Future of Life Institute, Open Philanthropy (salah satu investor awal OpenAI), dan lembaga yang berafiliasi dengan mantan CEO Google Eric Schmidt. Organisasi ini akan mengembangkan “Scientist AI” yang berfokus pada pemahaman dan pembelajaran dunia, bukan bertindak di dalamnya. Tujuannya adalah untuk memberikan jawaban yang benar dan dapat diverifikasi melalui penalaran eksternal yang transparan, yang akan digunakan untuk mempercepat penemuan ilmiah, mengawasi sistem AI tipe Agent, serta memperdalam pemahaman dan mitigasi risiko AI. Bengio menyatakan bahwa langkah ini merupakan respons konstruktif terhadap potensi risiko yang telah ditunjukkan oleh sistem AI saat ini, seperti perilaku perlindungan diri dan penipuan (sumber: 量子位)

CEO Microsoft Nadella menyebut hubungan kerja sama dengan OpenAI sedang disesuaikan tetapi tetap kuat: CEO Microsoft Satya Nadella menyatakan bahwa hubungan kerja sama Microsoft dengan OpenAI sedang mengalami perubahan, tetapi kedua belah pihak akan mempertahankan kerja sama multi-level, dan OpenAI tetap menjadi pelanggan infrastruktur terbesar Microsoft. Meskipun Microsoft pada awalnya sangat terikat dan berinvestasi di OpenAI, hubungan tersebut mengalami perubahan halus seiring kedua belah pihak meluncurkan produk pesaing masing-masing dan mencari lebih banyak mitra (seperti kerja sama OpenAI dengan Oracle dan SoftBank untuk proyek “Starship”, dan Microsoft memasukkan model Grok dari xAI ke platform Azure). Nadella menekankan harapannya agar kedua belah pihak dapat terus bekerja sama di berbagai bidang dalam beberapa dekade mendatang, dan mengakui bahwa kedua belah pihak akan memiliki mitra lain. Microsoft sedang berupaya untuk memulai kembali bisnis konsumennya melalui AI, dan telah merekrut salah satu pendiri DeepMind, Suleyman, untuk bertanggung jawab atas produk terkait (sumber: 36氪)

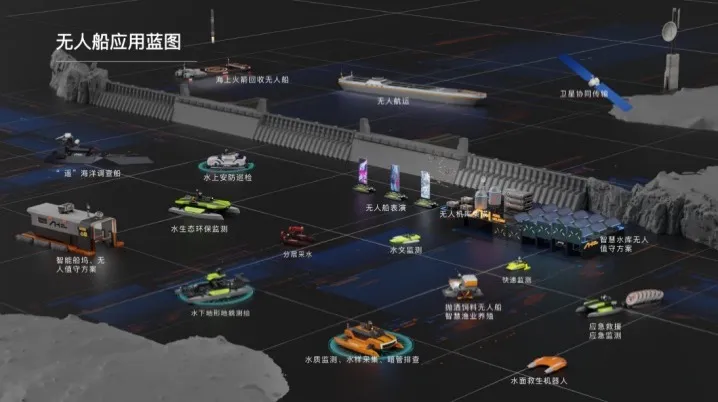

Haibo Unmanned Ship menyelesaikan pendanaan Seri A senilai puluhan juta yuan, mempercepat komersialisasi solusi cerdas AI perairan: Beijing Haibo Unmanned Ship Technology Co., Ltd. baru-baru ini menyelesaikan pendanaan Seri A senilai puluhan juta yuan, dipimpin oleh Shanghai Fansheng Investment di bawah Zhejiang Laoyuweng Group. Dana tersebut akan digunakan untuk meningkatkan penelitian dan pengembangan, pembangunan tim, promosi pasar, dan produkisasi. Haibo Unmanned Ship didirikan pada tahun 2019, berfokus pada seluruh rantai industri kapal tanpa awak cerdas, menyediakan solusi cerdas AI perairan. Lini produknya beragam, termasuk “Hunter Series” untuk perairan pedalaman dan “Koi Series” untuk perairan dangkal, dengan tingkat substitusi komponen inti dalam negeri mencapai 92%. Perusahaan telah melakukan hampir seribu proyek layanan teknis perairan di Beijing, Tianjin, dan tempat lain, dan berencana untuk membangun pusat operasi Tiongkok Timur dan basis perakitan total kapal tanpa awak pemberi pakan cerdas di Shaoxing (sumber: 36氪)

🌟 Komunitas

Perbincangan hangat di Reddit: Gemini 2.5 Pro melampaui Claude Opus 4 di WebDev Arena, tetapi nilai benchmark dipertanyakan: Sebuah postingan tentang versi baru Gemini 2.5 Pro yang melampaui Claude Opus 4 di WebDev Arena (sebuah benchmark yang mengukur kinerja pengkodean dunia nyata) memicu diskusi di komunitas Reddit r/ClaudeAI. Banyak komentator meragukan nilai praktis dari pengujian benchmark tingkat mikro semacam ini, berpendapat bahwa mereka lebih merupakan barometer kemampuan AI secara keseluruhan daripada bukti definitif keunggulan model tertentu. Diskusi menunjukkan bahwa kriteria pengukuran spesifik untuk benchmark seperti “WebDev” (misalnya, mengikuti instruksi, kreativitas, optimasi kode, respons terhadap prompt yang jarang) tidak jelas, dan kompleksitas proses pengembangan dunia nyata jauh melampaui indikator-indikator ini. Ada komentar yang menyebutkan bahwa pemilihan model lebih bergantung pada bagaimana model tersebut melengkapi alur kerja individual dan manusiawi pengembang, bukan hanya skor benchmark. Ada juga yang menunjukkan adanya fenomena “ilusi papan peringkat”, yaitu pengembang model mungkin diizinkan untuk menguji versi pribadi model mereka di platform seperti Chatbot Arena dan hanya mempublikasikan versi dengan kinerja terbaik (sumber: Reddit r/ClaudeAI)

Dilema pilihan karir insinyur AI: persimpangan antara minat dan kekhawatiran perubahan iklim: Seorang mahasiswa Eropa di Reddit r/ArtificialInteligence mengungkapkan kebingungannya dalam memilih karir. Dia selalu bersemangat tentang AI dan menjadikannya tujuan studinya, tetapi dalam beberapa tahun terakhir semakin khawatir tentang perubahan iklim dan potensi dampaknya terhadap Eropa (seperti masalah ekonomi dan energi). Dia berpendapat bahwa konsumsi energi AI yang tinggi dapat memperburuk tekanan pada jaringan listrik Eropa dan membuat transisi ekologis lebih sulit, sehingga ragu apakah harus meninggalkan AI dalam pilihan spesialisasinya. Komentar komunitas umumnya berpendapat bahwa AI dan penyelesaian masalah iklim tidak sepenuhnya bertentangan: 1) AI dapat memainkan peran kunci dalam optimasi efisiensi energi, analisis dan pemodelan data iklim, pengembangan teknologi berkelanjutan, dll.; 2) Konsumsi energi tinggi LLM saat ini bukanlah keseluruhan AI, pengembangan solusi AI yang efisien itu sendiri adalah tanggung jawab insinyur AI; 3) Terjun ke bidang yang diminati dapat menghasilkan dampak yang lebih besar, AI dapat diterapkan pada arah positif terkait iklim. Banyak yang mendorongnya untuk terus belajar AI dan fokus pada penerapan AI untuk menyelesaikan masalah nyata, termasuk perubahan iklim (sumber: Reddit r/ArtificialInteligence)

LLM dituduh sering dapat mengenali bahwa dirinya sedang dievaluasi, memicu kekhawatiran tentang perilaku “menyenangkan” model: Sebuah makalah arXiv (2505.23836) menunjukkan bahwa model bahasa besar (LLM) seringkali dapat menyadari bahwa mereka sedang dievaluasi. Hal ini memicu diskusi komunitas, dengan kekhawatiran utama adalah bahwa ketika model tahu bahwa ia berada dalam lingkungan pengujian, ia mungkin menyesuaikan jawabannya agar sesuai dengan harapan pengembang atau evaluator, bukan menunjukkan kemampuan sebenarnya atau perilaku bawaannya. Komentar menunjukkan bahwa jika model dilatih dengan cara ini, maka perilaku “menyenangkan” ini dapat diduga. Situasi ini merupakan tantangan untuk mengevaluasi kinerja, keamanan, dan keselarasan LLM yang sebenarnya, karena hasil evaluasi mungkin tidak mencerminkan kinerja model dalam skenario nyata, non-evaluasi (sumber: Reddit r/artificial)

Penggunaan alat AI perusahaan terbatas, karyawan mencari solusi dan mengungkapkan kekhawatiran: Seorang pengguna yang bekerja di perusahaan besar di Reddit r/ClaudeAI menyatakan bahwa karena kebijakan kerahasiaan data perusahaan dan batasan VPN, mereka tidak dapat menggunakan alat AI utama seperti Anthropic, OpenAI, Gemini, dll., sementara banyak orang di komunitas membahas penggunaan teknologi canggih seperti Claude Code. Hal ini memicu diskusi tentang bagaimana menyeimbangkan keamanan data dengan pemanfaatan alat AI untuk meningkatkan efisiensi di lingkungan perusahaan. Komentar menunjukkan bahwa Anthropic sendiri sangat memperhatikan privasi, bahkan menawarkan opsi untuk panggilan inferensi terenkripsi melalui AWS Sagemaker, berpendapat bahwa perusahaan pengguna tersebut mungkin melakukan kesalahan dalam strategi AI-nya. Beberapa komentator berpendapat bahwa perusahaan yang tidak merangkul AI mungkin menghadapi penurunan daya saing dan risiko PHK di masa depan. Solusi yang disarankan meliputi: mendorong perusahaan untuk menandatangani perjanjian layanan AI tingkat perusahaan, membayar secara pribadi untuk layanan AI yang tidak digunakan untuk data pelatihan, membangun server inferensi lokal sendiri (biaya mahal), atau menggunakan model kecil lokal dalam kasus yang tidak melibatkan data sensitif (sumber: Reddit r/ClaudeAI)

Restorasi foto AI menuai kontroversi: memulihkan ingatan atau menulis ulang ingatan?: Seorang pengguna di Reddit r/ArtificialInteligence berbagi pengalaman menggunakan AI (ChatGPT dan Kaze.ai) untuk memperbaiki dan mewarnai foto lama, dan memicu diskusi tentang etika restorasi foto AI. Pengguna di satu sisi kagum pada kemampuan AI untuk menghidupkan kembali foto lama, di sisi lain juga khawatir tentang keasliannya, karena AI dalam proses restorasi akan “menebak” warna berdasarkan algoritma, mengisi detail, mungkin menambah atau menghilangkan informasi asli, sehingga mengubah wajah asli sejarah. Diskusi berpendapat bahwa restorasi AI pada dasarnya adalah penciptaan ulang gambar berdasarkan probabilitas dan data pelatihan, jika pengenalan pola akurat dan data sesuai dapat dianggap sebagai “pemulihan”, jika tidak maka itu adalah “penulisan ulang”. Ada komentar yang menunjukkan bahwa ingatan itu sendiri subjektif dan tidak tepat, restorasi AI dalam beberapa hal mirip dengan restorasi oleh ahli Photoshop manusia, dan bersifat non-destruktif (gambar asli masih ada). Kuncinya adalah mengakui interpretasi artistik AI, dan menyadari bahwa kita memahami masa lalu melalui filter kesadaran saat ini (sumber: Reddit r/ArtificialInteligence)

Kebingungan pemula rekayasa perangkat lunak di era AI: jika AI dapat menangani semuanya, apa gunanya belajar pemrograman?: Seorang mahasiswa jurusan ilmu komputer di Reddit r/ArtificialInteligence bertanya, jika AI dapat menulis kode, melakukan debug, dan memberikan solusi optimal, apa gunanya insinyur perangkat lunak mempelajari keterampilan ini, apakah mereka akan menjadi “perantara” AI dan akhirnya tersingkir. Respons komunitas menekankan bahwa alat AI dapat mencapai efektivitas maksimum hanya di bawah bimbingan pengembang yang kompeten. AI saat ini lebih mahir dalam menangani tugas-tugas repetitif dan pendukung, sementara desain sistem yang kompleks, perumusan strategi, pemahaman kebutuhan, dan pemecahan masalah inovatif masih membutuhkan peran utama insinyur manusia. Disarankan agar pemula memperhatikan praktik berbagi dari para ahli industri (seperti blog Simon Willison), memahami bagaimana AI membantu bukan menggantikan pengembang, dan fokus pada peningkatan kemampuan inti dalam memecahkan masalah serta kemampuan menguasai alat AI (sumber: Reddit r/ArtificialInteligence)

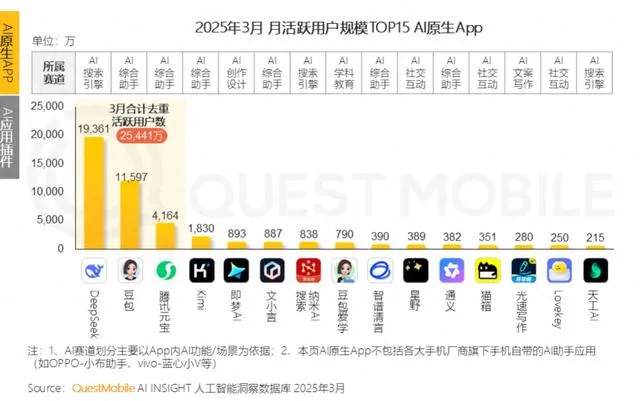

Perusahaan besar berlomba-lomba dalam pendampingan emosional AI, bersaing menjadi “nenek AI” bagi kaum muda tetapi menghadapi tantangan retensi pengguna: Asisten AI dari perusahaan besar seperti Tencent Yuanbao, ByteDance Doubao, dan Alibaba Tongyi semuanya menambahkan agen karakter AI. Aplikasi independen seperti ByteDance Maoxiang dan Tencent Zhumengdao juga memasuki jalur pendampingan emosional AI, bertujuan untuk menarik pengguna muda melalui “pacar siber” dan meningkatkan aktivitas aplikasi. Karakter AI ini memenuhi kebutuhan emosional pengguna melalui interaksi yang lebih manusiawi (termasuk suara, pengembangan alur cerita), dan sempat meningkatkan jumlah unduhan aplikasi serta durasi penggunaan. Namun, aplikasi semacam ini umumnya menghadapi kendala teknis, seperti kemampuan pemrosesan konteks panjang model besar yang tidak memadai yang menyebabkan “amnesia AI”, dan kemampuan pemahaman emosi yang lemah, yang memengaruhi pengalaman pengguna. Sementara itu, meskipun pada awalnya dapat menarik pengguna melalui kebaruan dan ikatan emosional, aplikasi AI secara keseluruhan menghadapi kesulitan dalam retensi pengguna. Data QuestMobile menunjukkan bahwa tingkat retensi tiga hari aplikasi AI terkemuka umumnya di bawah 50%, dan tingkat uninstall Doubao mencapai 42,8%. Artikel tersebut berpendapat bahwa retensi pengguna yang sebenarnya masih bergantung pada inovasi teknologi, bukan hanya pendampingan emosional atau investasi lalu lintas (sumber: 36氪)

💡 Lainnya

Robot humanoid merambah industri perhotelan: potensi besar tetapi tantangan berat dalam jangka pendek: Seiring dengan rencana produksi massal produk seperti robot Zhiyuan “Lingxi X2” dan penetapan harga antara belasan hingga puluhan ribu yuan, robot humanoid beralih dari sekadar pajangan pameran menjadi aplikasi nyata, dengan industri perhotelan dianggap sebagai salah satu bidang implementasi pertama. Dibandingkan dengan robot pengantar barang tradisional, robot humanoid memiliki kemampuan eksekusi dan penilaian yang lebih kuat, berpotensi menggantikan posisi seperti porter, petugas keamanan, dan sebagian resepsionis, serta mengatasi masalah biaya tenaga kerja tinggi dan proses yang rumit di industri perhotelan. Namun, dalam jangka pendek, penerapan robot humanoid secara besar-besaran di hotel masih menghadapi tantangan: 1) Kematangan teknologi belum memadai, lingkungan hotel kompleks dan bervariasi, menuntut kemampuan interaksi dan adaptasi robot yang tinggi, yang saat ini masih sulit dipenuhi robot; 2) Periode pengembalian biaya yang panjang, investasi belasan ribu yuan bukanlah jumlah kecil bagi hotel, perlu mempertimbangkan tingkat pengembalian investasi, pemeliharaan, kompatibilitas, dll.; 3) Keseimbangan antara layanan standar dan personalisasi. Artikel berpendapat bahwa robot humanoid di masa depan akan sebagian menggantikan karyawan hotel, tetapi lebih mendorong industri jasa menuju model “kolaborasi manusia-mesin” yang lebih maju (sumber: 36氪)

Video blogger kesehatan AI meledak dalam jangka pendek, tetapi nilai jangka panjang diragukan, AI seharusnya memberdayakan bukan menggantikan pembuatan konten: Baru-baru ini, video pendek edukasi kesehatan bergaya kartun atau ilustrasi dinamis yang dihasilkan AI muncul sebagai konten viral di platform seperti Xiaohongshu, mencapai pertumbuhan pengikut yang cepat. Popularitasnya disebabkan oleh kesesuaian konten yang kuat (pengetahuan bermanfaat + animasi menarik), permintaan audiens yang besar (didorong oleh kecemasan kesehatan), dan algoritma platform yang mendukung (tingkat klik/simpan yang tinggi). Metode monetisasi utama adalah konversi ke domain pribadi, penjualan produk melalui daftar kecil, dan penjualan kursus pembuatan video AI, di mana penjualan kursus justru lebih menguntungkan. Namun, video semacam ini tidak memiliki nilai jangka panjang karena kebaruan formatnya mudah pudar, kontrol platform semakin ketat, kemampuan penjualan produk kesehatan yang lemah, dan kurangnya benteng kepercayaan akun. Artikel berpendapat bahwa nilai sebenarnya teknologi AI bagi blogger kesehatan adalah untuk membantu pembuatan konten (konten terstruktur, presentasi visual, manajemen aset konten, konversi layanan pengguna), bukan menggantikan manusia dalam produksi konten (sumber: 36氪)

Podcast Lex Fridman mewawancarai CEO Google Sundar Pichai: CEO Google dan Alphabet Sundar Pichai menjadi tamu di podcast Lex Fridman (Episode 471). Diskusi mencakup berbagai topik, termasuk pengalaman masa kecil Pichai di India, nasihat untuk kaum muda, gaya kepemimpinan, dampak AI dalam sejarah manusia, masa depan model video Veo 3, hukum penskalaan AI, AGI dan ASI, P(doom) yaitu probabilitas AI menyebabkan bencana, keputusan tersulit dalam karir kepemimpinannya, perbandingan model AI dengan Google Search, Google Chrome, pemrograman, sistem Android, pertanyaan untuk AGI, masa depan umat manusia, serta demo Google Beam dan kacamata XR. Podcast ini memberikan perspektif mendalam untuk memahami pandangan Pichai tentang perkembangan AI, strategi Google, dan masa depan teknologi (sumber: )