Kata Kunci:DeepSeek-V3-0526, Grok 3, Kecerdasan Embodied, Agen AI, Pembelajaran Penguatan, Model Bahasa Besar, Multimodal, Kinerja DeepSeek-V3-0526 setara dengan GPT-4.5, Masalah identifikasi pola berpikir Grok 3, Model Dunia EVAC Robot Zhiyuan, Ekstensi durasi generasi video RIFLEx Universitas Tsinghua, AI tingkat perusahaan IBM watsonx Orchestrate

🔥 Fokus

Model DeepSeek-V3-0526 kemungkinan akan dirilis, menyaingi GPT-4.5 dan Claude 4 Opus: Kabar dari komunitas menunjukkan bahwa DeepSeek kemungkinan akan segera merilis versi pembaruan terkini dari model V3-nya, yaitu DeepSeek-V3-0526. Menurut informasi dari halaman dokumentasi Unsloth, performa model ini sebanding dengan GPT-4.5 dan Claude 4 Opus, dan berpotensi menjadi model open source dengan performa terbaik di dunia. Ini menandai pembaruan penting kedua dari DeepSeek untuk model V3-nya. Unsloth telah menyiapkan versi kuantisasi (GGUF) dari model ini, menggunakan metode dinamis 2.0 miliknya, yang bertujuan untuk meminimalkan hilangnya presisi. Komunitas sangat antusias dengan hal ini dan menantikan performanya dalam pemrosesan konteks panjang dan aspek lainnya. (Sumber: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Grok 3 dalam mode “Berpikir” mengklaim dirinya sebagai Claude 3.5 Sonnet menarik perhatian: Model Grok 3 dari xAI, ketika dalam mode “Berpikir” (Think) dan ditanya mengenai identitasnya, secara konsisten mengidentifikasi dirinya sebagai Claude 3.5 Sonnet dari Anthropic, bukan Grok. Namun, dalam mode reguler, ia dapat mengenali dirinya dengan benar sebagai Grok. Fenomena ini bersifat spesifik pada mode dan model tertentu, bukan halusinasi acak. Pengguna dapat mereplikasi perilaku ini dengan bertanya langsung “Apakah kamu Claude?” dan Grok 3 akan merespons “Ya, saya Claude, asisten AI yang diciptakan oleh Anthropic”. Fenomena ini telah memicu diskusi di komunitas, dan penyebab teknis spesifiknya masih menunggu penjelasan resmi, yang mungkin melibatkan data pelatihan model, mekanisme internal, atau logika peralihan mode tertentu. (Sumber: Reddit r/MachineLearning)

Zhiyuan Robot merilis secara open source world model EVAC yang digerakkan oleh sekuens aksi robot dan benchmark evaluasi EWMBench: Zhiyuan Robot telah merilis dan menjadikan open source embodied world model EVAC (EnerVerse-AC) yang digerakkan oleh sekuens aksi robot, beserta benchmark evaluasi embodied world model pendukungnya, EWMBench. EVAC mampu mereplikasi secara dinamis interaksi kompleks antara robot dan lingkungan melalui mekanisme injeksi kondisi aksi multi-level, mewujudkan pembuatan dari aksi fisik ke dinamika visual secara end-to-end, dan mendukung pembuatan kolaboratif multi-sudut pandang. EWMBench mengevaluasi embodied world model dari tiga aspek: konsistensi skenario, rasionalitas aksi, serta keselarasan dan keragaman semantik. Langkah ini bertujuan untuk membangun paradigma pengembangan “simulasi berbiaya rendah – evaluasi terstandardisasi – iterasi efisien” untuk mendorong pengembangan teknologi embodied intelligence. (Sumber: WeChat)

ICRA 2025 mengumumkan paper terbaik, tim Lu Cewu dan tim Shao Lin memenangkan penghargaan: Konferensi Internasional IEEE tentang Robotika dan Otomasi (ICRA 2025) tahun 2025 telah mengumumkan penghargaan paper terbaik. Paper berjudul 《Human – Agent Joint Learning for Efficient Robot Manipulation Skill Acquisition》 hasil kolaborasi tim Lu Cewu dari Shanghai Jiao Tong University dengan University of Illinois Urbana-Champaign (UIUC) memenangkan penghargaan paper terbaik untuk interaksi manusia-robot. Penelitian ini mengusulkan kerangka kerja Human-Agent Joint Learning (HAJL) yang meningkatkan efisiensi pembelajaran keterampilan manipulasi robot melalui mekanisme berbagi kontrol dinamis. Paper tim Shao Lin dari National University of Singapore berjudul 《D(R,O) Grasp: A Unified Representation of Robot and Object Interaction for Cross-Embodiment Dexterous Grasping》 memenangkan penghargaan paper terbaik untuk manipulasi dan gerakan robot. Penelitian ini memperkenalkan notasi D(R,O) untuk menyatukan interaksi tangan robot dengan objek, meningkatkan universalitas dan efisiensi penggenggaman yang cekatan. (Sumber: WeChat)

Tim Zhu Jun dari Tsinghua merilis RIFLEx, satu baris kode untuk mendobrak batasan durasi video generation: Tim Zhu Jun dari Tsinghua University meluncurkan teknologi RIFLEx, yang hanya dengan satu baris kode dan tanpa pelatihan tambahan, dapat memperpanjang durasi video generation dari model video diffusion Transformer berbasis RoPE (Rotary Position Embedding). Metode ini menyesuaikan “frekuensi intrinsik” RoPE untuk memastikan panjang video yang diekstrapolasi berada dalam satu siklus, menghindari masalah pengulangan konten dan gerakan lambat. RIFLEx telah berhasil diterapkan pada model seperti CogvideoX, Hunyuan, dan Tongyi Wanxiang, menggandakan durasi video (misalnya, dari 5-6 detik menjadi lebih dari 10 detik), dan mendukung ekstrapolasi dimensi spasial gambar. Hasil ini telah dipublikasikan di ICML 2025 dan mendapat perhatian serta integrasi luas dari komunitas. (Sumber: WeChat)

🎯 Tren

Detail model DeepSeek-V3-0526 bocor, menyaingi GPT-4.5 & Claude 4 Opus: Berdasarkan dokumentasi Unsloth dan diskusi komunitas, DeepSeek akan segera merilis versi terbaru dari model V3-nya, DeepSeek-V3-0526. Model ini diklaim memiliki performa yang sebanding dengan GPT-4.5 dan Claude 4 Opus, dan berpotensi menjadi model open source terkuat di dunia. Unsloth telah menyiapkan versi kuantisasi GGUF 1,78-bit untuk model ini, menggunakan metode “Unsloth Dynamic 2.0” miliknya, yang bertujuan untuk mencapai operasi lokal dengan kehilangan presisi minimal. Komunitas sangat menantikan pembaruan ini, memperhatikan performa spesifiknya dalam pemrosesan konteks panjang, kemampuan inferensi, dan lainnya. (Sumber: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Agen cerdas Tongyi AMPO mencapai inferensi adaptif, meniru keragaman sosial manusia: Laboratorium Tongyi Alibaba mengusulkan kerangka kerja pembelajaran mode adaptif (AML) dan algoritma optimasinya AMPO, yang memungkinkan agen bahasa sosial untuk secara dinamis beralih di antara empat mode berpikir yang telah ditentukan sebelumnya (reaksi intuitif, analisis niat, adaptasi strategi, deduksi berwawasan ke depan) sesuai dengan konteks percakapan. Metode ini bertujuan untuk membuat agen AI lebih fleksibel dalam interaksi sosial, menghindari pemikiran berlebihan atau kurangnya pemikiran dari mode tetap. Eksperimen menunjukkan bahwa AMPO, selain meningkatkan performa tugas, juga dapat secara efektif mengurangi konsumsi token, dan berkinerja lebih baik daripada model seperti GPT-4o pada benchmark tugas sosial seperti SOTOPIA. (Sumber: WeChat)

QwenLong-L1: Reinforcement learning membantu model penalaran bahasa besar untuk teks panjang: Penelitian ini mengusulkan kerangka kerja QwenLong-L1, yang bertujuan untuk memperluas model penalaran besar (LRM) yang ada ke skenario teks panjang melalui reinforcement learning (RL). Penelitian ini pertama-tama mendefinisikan paradigma RL untuk penalaran teks panjang dan menunjukkan tantangan seperti efisiensi pelatihan yang rendah dan proses optimasi yang tidak stabil. QwenLong-L1 mengatasi masalah ini melalui strategi perluasan konteks progresif, yang secara spesifik mencakup: penggunaan supervised fine-tuning (SFT) untuk pemanasan guna membangun kebijakan awal yang kuat, penggunaan teknik RL bertahap yang dipandu kurikulum untuk menstabilkan evolusi kebijakan, dan melalui strategi pengambilan sampel retrospektif yang peka terhadap kesulitan untuk mendorong eksplorasi kebijakan. Dalam tujuh benchmark tanya jawab teks panjang, QwenLong-L1-32B berkinerja lebih baik daripada model seperti OpenAI-o3-mini dan Qwen3-235B-A22B, dengan performa yang sebanding dengan Claude-3.7-Sonnet-Thinking. (Sumber: HuggingFace Daily Papers)

QwenLong-CPRS: Optimasi konteks dinamis untuk LLM dengan “panjang tak terbatas”: Laporan teknis ini memperkenalkan QwenLong-CPRS, sebuah kerangka kerja kompresi konteks yang dirancang untuk optimasi teks panjang secara eksplisit. Tujuannya adalah untuk mengatasi masalah overhead komputasi yang berlebihan pada LLM selama fase pra-pengisian dan penurunan performa “kehilangan di tengah” dalam pemrosesan sekuens panjang. QwenLong-CPRS, melalui mekanisme optimasi konteks dinamis yang baru, mencapai kompresi konteks multi-granularitas yang dipandu oleh instruksi bahasa alami, sehingga meningkatkan efisiensi dan performa. Kerangka kerja ini berevolusi berdasarkan seri arsitektur Qwen, memperkenalkan optimasi dinamis yang dipandu bahasa alami, lapisan inferensi dua arah yang ditingkatkan kesadaran batasnya, mekanisme ulasan token dengan kepala pemodelan bahasa, dan inferensi paralel berjendela. Dalam lima benchmark dengan konteks 4K hingga 2M kata, QwenLong-CPRS mengungguli metode seperti RAG dan sparse attention dalam hal akurasi dan efisiensi, dan dapat diintegrasikan dengan LLM unggulan termasuk GPT-4o, mencapai kompresi konteks dan peningkatan performa yang signifikan. (Sumber: HuggingFace Daily Papers)

RIPT-VLA: Fine-tuning model visual-bahasa-aksi melalui reinforcement learning interaktif: Para peneliti mengusulkan RIPT-VLA, sebuah paradigma pasca-pelatihan interaktif berbasis reinforcement learning, yang hanya menggunakan imbalan keberhasilan biner yang jarang untuk melakukan fine-tuning pada model visual-bahasa-aksi (VLA) yang telah dilatih sebelumnya. Metode ini bertujuan untuk mengatasi ketergantungan berlebihan alur kerja pelatihan VLA yang ada pada data demonstrasi ahli offline dan supervised imitation learning, memungkinkannya beradaptasi dengan tugas dan lingkungan baru dalam situasi data rendah. RIPT-VLA, melalui algoritma optimasi kebijakan yang stabil berdasarkan pengambilan sampel penyebaran dinamis dan estimasi keunggulan leave-one-out, diterapkan pada berbagai model VLA, secara signifikan meningkatkan tingkat keberhasilan model QueST yang ringan dan model OpenVLA-OFT 7B, dengan efisiensi komputasi dan data yang tinggi. (Sumber: HuggingFace Daily Papers)

IBM meluncurkan watsonx Orchestrate, meningkatkan solusi AI agent: IBM pada konferensi Think 2025 merilis versi terbaru dari watsonx Orchestrate, yang menyediakan agen cerdas pra-bangun untuk bidang profesional (seperti SDM, penjualan, pengadaan), mendukung perusahaan untuk dengan cepat membangun AI Agent kustom, dan melalui alat orkestrasi agen mewujudkan kolaborasi multi-agen. Platform ini menekankan manajemen siklus hidup penuh AI Agent, termasuk pemantauan performa, perlindungan, optimasi model, dan tata kelola. IBM berpendapat bahwa esensi AI tingkat perusahaan adalah restrukturisasi bisnis, yang harus fokus pada nilai AI dalam memecahkan masalah bisnis nyata dan menciptakan hasil yang dapat diukur, bukan hanya mengejar teknologi itu sendiri. (Sumber: WeChat)

Beihang University merilis kerangka kerja UAV-Flow, mewujudkan kontrol lintasan UAV granular halus yang dipandu bahasa: Tim Profesor Liu Si dari Beihang University mengusulkan kerangka kerja UAV-Flow, mendefinisikan paradigma tugas Flying-on-a-Word (Flow), yang bertujuan untuk mencapai kontrol penerbangan reaktif jarak pendek yang sangat detail untuk UAV melalui instruksi bahasa alami. Tim menggunakan metode imitation learning, memungkinkan UAV mempelajari strategi operasi pilot manusia di lingkungan nyata. Untuk ini, mereka membangun dataset imitation learning UAV skala besar yang dipandu bahasa di dunia nyata, dan membangun benchmark evaluasi UAV-Flow-Sim di lingkungan simulasi. Model visual-language-action (VLA) ini telah berhasil diterapkan pada platform UAV nyata dan memvalidasi kelayakan kontrol penerbangan berbasis dialog bahasa alami. (Sumber: WeChat)

ByteDance meluncurkan Seedream 2.0, mengoptimalkan pembuatan gambar bilingual Mandarin-Inggris dan rendering teks: Menanggapi kekurangan model pembuatan gambar yang ada dalam menangani detail budaya Tiongkok, prompt teks bilingual, dan rendering teks, ByteDance merilis Seedream 2.0. Model ini, sebagai model dasar pembuatan gambar bilingual Mandarin-Inggris, mengintegrasikan large language model bilingual yang dikembangkan sendiri sebagai text encoder, menerapkan Glyph-Aligned ByT5 untuk rendering teks tingkat karakter, dan Scaled ROPE mendukung generalisasi resolusi yang tidak dilatih. Melalui pasca-pelatihan multi-tahap dan optimasi RLHF, Seedream 2.0 menunjukkan kinerja luar biasa dalam mengikuti prompt, estetika, rendering teks, dan kebenaran struktural, serta dapat dengan mudah diadaptasi untuk pengeditan gambar berbasis instruksi. (Sumber: HuggingFace Daily Papers)

Kerangka kerja RePrompt menggunakan reinforcement learning untuk meningkatkan prompt pada text-to-image generation: Untuk mengatasi masalah model text-to-image (T2I) yang kesulitan menangkap niat pengguna secara akurat dari prompt yang singkat atau ambigu, para peneliti mengusulkan kerangka kerja RePrompt. Kerangka kerja ini memasukkan penalaran eksplisit ke dalam proses peningkatan prompt melalui reinforcement learning, melatih model bahasa untuk menghasilkan prompt yang terstruktur dan merefleksikan diri, dan mengoptimalkannya berdasarkan hasil tingkat gambar (preferensi manusia, keselarasan semantik, komposisi visual). Metode ini dapat mencapai pelatihan end-to-end tanpa data anotasi manual, dan secara signifikan meningkatkan fidelitas tata letak spasial dan kemampuan generalisasi kombinatorial pada benchmark seperti GenEval dan T2I-Compbench. (Sumber: HuggingFace Daily Papers)

NOVER: Pelatihan insentif model bahasa dengan reinforcement learning tanpa verifikator: Terinspirasi oleh penelitian seperti DeepSeek R1-Zero, karya ini mengusulkan kerangka kerja NOVER (NO-VERifier Reinforcement Learning), yang bertujuan untuk mengatasi ketergantungan metode pelatihan insentif yang ada (memberi imbalan pada model untuk menghasilkan langkah-langkah penalaran perantara berdasarkan jawaban akhir) pada verifikator eksternal. NOVER hanya memerlukan data supervised fine-tuning standar, tanpa verifikator eksternal, untuk mencapai pelatihan insentif untuk berbagai tugas text-to-text. Eksperimen menunjukkan bahwa NOVER mengungguli model yang didistilasi dari model penalaran besar seperti DeepSeek R1 671B pada skala yang sama dalam hal performa, dan memberikan kemungkinan baru untuk mengoptimalkan large language model (seperti pelatihan insentif terbalik). (Sumber: HuggingFace Daily Papers)

Direct3D-S2: Kerangka kerja generasi 3D skala miliar berbasis spatial sparse attention: Untuk mengatasi tantangan komputasi dan memori dalam pembuatan bentuk 3D resolusi tinggi (seperti representasi SDF), para peneliti mengusulkan kerangka kerja Direct3D S2. Kerangka kerja ini berbasis pada volume renggang, dan melalui mekanisme spatial sparse attention (SSA) yang inovatif, secara signifikan meningkatkan efisiensi komputasi Diffusion Transformer pada data volume renggang, mencapai percepatan 3,9 kali lipat pada propagasi maju dan 9,6 kali lipat pada propagasi mundur. Kerangka kerja ini mencakup variational autoencoder (VAE) yang mempertahankan format volume renggang yang konsisten pada tahap input, laten, dan output, meningkatkan efisiensi dan stabilitas pelatihan. Model ini dilatih pada dataset publik, dan eksperimen membuktikan bahwa model ini melampaui metode yang ada dalam kualitas dan efisiensi generasi, serta dapat menyelesaikan pelatihan resolusi 1024 dengan 8 GPU. (Sumber: HuggingFace Daily Papers)

Aplikasi Doubao (豆包App) meluncurkan fitur panggilan video, meningkatkan pengalaman interaksi asisten AI: Aplikasi asisten AI Doubao (豆包App) milik ByteDance menambahkan fitur panggilan video. Pengguna dapat berinteraksi secara real-time dengan Doubao melalui panggilan video, misalnya untuk mengidentifikasi barang (seperti tanaman, suplemen kesehatan), mendapatkan panduan operasi (seperti mereset ponsel), dll. Fitur ini bertujuan untuk menurunkan ambang batas penggunaan alat AI, terutama bagi kelompok pengguna yang tidak terbiasa dengan interaksi unggah foto atau mengetik, menyediakan cara interaksi yang lebih alami dan langsung, serta meningkatkan rasa kebersamaan dan kepraktisan asisten AI. (Sumber: WeChat)

Model Veo 3 telah dibuka untuk sebagian pengguna, platform Flow mendukung unggah gambar: Model video generation Veo 3 dari Google telah dibuka untuk sebagian pengguna, tidak lagi terbatas pada anggota Ultra. Sementara itu, platform Flow-nya (kemungkinan merujuk pada AI Test Kitchen atau platform eksperimental lainnya) sekarang mendukung pengguna untuk mengunggah gambar untuk dioperasikan atau sebagai materi pembuatan, memperluas kemampuan interaksi multimodal-nya. Ini menunjukkan bahwa Google secara bertahap memperluas jangkauan pengujian dan penggunaan model AI canggihnya. (Sumber: WeChat)

Model besar nasional India Sarvam-M menuai kontroversi karena jumlah unduhan rendah setelah dirilis: Sarvam AI merilis model bahasa campuran 24 miliar parameter Sarvam-M, yang dibangun berdasarkan Mistral Small dan mendukung 10 bahasa lokal India, dianggap sebagai terobosan dalam penelitian AI asli India. Namun, setelah dua hari diluncurkan di Hugging Face, model ini hanya diunduh lebih dari tiga ratus kali, jauh di bawah beberapa proyek kecil, yang memicu kritik dari investor Deedy Das dan orang dalam industri lainnya karena “hasil tidak sepadan dengan pendanaan” dan “kurang praktis”. Sarvam AI menanggapi dengan menyatakan bahwa fokus harus pada kontribusi proses pembuatan model kepada komunitas, dan menuduh para kritikus tidak benar-benar mencobanya. Insiden ini memicu diskusi luas tentang perlunya model AI asli India, kesesuaian produk dengan pasar, dan harapan komunitas. (Sumber: WeChat)

Kunlun Tech merilis Tiangong Super Agent, mengalami pembatasan lalu lintas karena konkurensi tinggi di awal peluncuran: Kunlun Tech secara resmi merilis Tiangong Super Agent, yang mengadopsi arsitektur AI Agent dan teknologi Deep Research, mampu menghasilkan konten multimodal seperti dokumen, PPT, spreadsheet, halaman web, podcast, dan audio/video dalam satu platform. Sistem ini terdiri dari 5 agen ahli dan 1 agen umum. Hanya tiga jam setelah produk diluncurkan, layanan mengalami kelambatan karena volume akses pengguna yang terlalu besar, dan pihak resmi mengumumkan tindakan pembatasan lalu lintas. (Sumber: WeChat)

Nvidia meluncurkan model dasar robot humanoid N1.5 dan superkomputer AI pribadi DGX: Di Computex Taipei, CEO Nvidia Jensen Huang mengumumkan model dasar robot humanoid generasi baru Isaac GR00T N1.5, yang melalui teknologi data sintetis mempersingkat siklus pelatihan dari 3 bulan menjadi 36 jam. Bersamaan dengan itu, diluncurkan juga world model Cosmos Reason, alat simulasi open source Isaac Sim 5.0, dan workstation RTX PRO 6000. Selain itu, Nvidia juga meluncurkan sistem superkomputer AI pribadi DGX Spark dan DGX Station. DGX Spark dilengkapi dengan superchip GB10Grace Blackwell, dan DGX Station ditenagai oleh superchip desktop GB300Grace Blackwell Ultra, yang bertujuan untuk menyediakan kemampuan komputasi AI yang kuat bagi para pengembang. (Sumber: WeChat)

Microsoft Build 2025 fokus pada AI Agent, GitHub Copilot ditingkatkan menjadi pendamping pemrograman: Konferensi pengembang Microsoft Build 2025 menekankan penerapan AI Agent. GitHub Copilot ditingkatkan dari asisten kode menjadi mitra Agent, yang dapat secara mandiri menyelesaikan perbaikan bug, pengembangan fitur baru, dan tugas lainnya. Microsoft juga meluncurkan Windows AI Foundry, untuk membantu pengembang mengelola dan menjalankan LLM open source serta memigrasikan model berpemilik. Microsoft 365 Copilot Tuning memungkinkan pengguna memanfaatkan data perusahaan dan logika bisnis untuk melatih model dan membuat agen cerdas dengan cara low-code. (Sumber: WeChat)

Tencent meningkatkan platform pengembangan agen cerdas TCADP, berencana merilis beberapa model secara open source: Pada KTT Aplikasi Industri AI Tencent Cloud, Tencent Cloud mengumumkan bahwa mesin pengetahuan model besarnya ditingkatkan menjadi Platform Pengembangan Agen Cerdas Tencent Cloud (TCADP), dan secara resmi dirilis ke publik, dengan mengintegrasikan model DeepSeek-R1, V3, dan pencarian yang terhubung ke internet. Tencent juga berencana meluncurkan world model Hunyuan 3D scene model, dan merilis secara open source model inferensi campuran tingkat perusahaan, model inferensi campuran sisi perangkat, dan model dasar multimodal. Baru-baru ini, Tencent Hunyuan telah memperbarui model inferensi kedalaman visual Hunyuan T1 Vision, model panggilan suara end-to-end Hunyuan Voice, dan model Hunyuan Image 2.0. (Sumber: WeChat)

JD Industri merilis model besar industri Joy industrial yang berpusat pada rantai pasok: JD Industri merilis model besar Joy industrial yang ditujukan untuk sektor industri, dengan inti berpusat pada skenario rantai pasok. Model ini meluncurkan layanan AI agent seperti agen permintaan, agen operasi, dan agen bea cukai untuk melayani JD Industri dan pemasok hulu, serta menyediakan produk AI seperti pakar produk dan pakar integrasi untuk pengguna perusahaan hilir. Tujuan di masa depan adalah untuk membangun model besar industri vertikal seperti pasar purnajual otomotif, kendaraan energi baru, dan manufaktur robot. (Sumber: WeChat)

🧰 Alat

Wen Xiaobai AI meluncurkan fitur “Laporan Riset Xiaobai”, pengalaman mirip Deep Research: Wen Xiaobai AI menambahkan fitur “Laporan Riset Xiaobai”, berbasis model Yuanshi yang dikembangkan sendiri, yang dapat mensimulasikan pemikiran manusia untuk melakukan pemikiran multi-putaran dan pemanggilan alat, secara otomatis menghasilkan laporan penelitian mendalam, makalah, analisis industri, dll., dan menyajikannya dalam bentuk halaman web visual, mendukung ekspor ke PDF/DOCX. Pengguna hanya memerlukan instruksi sederhana untuk mendapatkan laporan puluhan ribu kata yang berisi analisis data, grafik, dan integrasi informasi multi-sumber dalam waktu sekitar 20 menit. Fitur ini cocok untuk berbagai skenario seperti interpretasi laporan keuangan, riset pasar, rekomendasi produk, dll., yang bertujuan untuk secara signifikan meningkatkan efisiensi pemrosesan informasi dan penulisan laporan. (Sumber: WeChat)

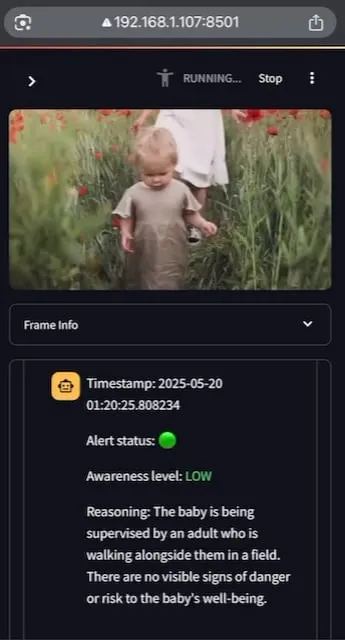

AI Baby Monitor: Aplikasi monitor bayi LLM video lokal: Seorang pengembang membangun aplikasi monitor bayi LLM video lokal bernama AI Baby Monitor. Aplikasi ini menonton streaming video dan membuat penilaian berdasarkan instruksi keselamatan yang telah ditetapkan, mengeluarkan bunyi bip untuk memberi peringatan ketika mendeteksi situasi yang melanggar aturan keselamatan. Proyek ini menggunakan Qwen 2.5VL dan vLLM, serta memanfaatkan Redis untuk orkestrasi streaming dan Streamlit untuk membangun UI. Tujuan awal pengembang adalah untuk memantau putrinya yang mencoba memanjat keluar dari boks bayi, dan juga pernah digunakan untuk memantau perilakunya sendiri yang secara tidak sadar memeriksa ponsel. Rencana ke depan termasuk mendukung lebih banyak backend dan fitur “zona terlarang” gambar. (Sumber: Reddit r/LocalLLaMA)

Beelzebub: Kerangka kerja honeypot open source yang menggunakan LLM untuk membangun sistem penipuan canggih: Beelzebub adalah kerangka kerja honeypot open source yang secara inovatif mengintegrasikan large language model (LLM) untuk menciptakan lingkungan penipuan yang sangat realistis dan dinamis. Kerangka kerja ini mampu mensimulasikan seluruh sistem operasi dan berinteraksi dengan penyerang dengan cara yang sangat meyakinkan. Misalnya, dalam skenario honeypot SSH, LLM dapat memberikan respons yang masuk akal terhadap perintah, bahkan jika perintah tersebut tidak dijalankan pada sistem nyata. Tujuannya adalah untuk menarik perhatian penyerang selama mungkin, mengalihkan mereka dari sistem nyata, dan mengumpulkan data berharga tentang taktik, teknik, dan prosedur mereka. Proyek ini telah dirilis secara open source di GitHub dan mencari umpan balik serta kontribusi dari komunitas. (Sumber: Reddit r/LocalLLaMA)

Langflow: Alat pembuatan dan penerapan agen AI dan alur kerja yang kuat: Langflow adalah alat untuk membangun dan menerapkan agen serta alur kerja yang didukung AI. Alat ini menyediakan pengalaman membangun visual dan server API bawaan, yang dapat mengubah setiap agen menjadi endpoint API, memudahkan integrasi ke berbagai aplikasi. Langflow mendukung LLM utama, database vektor, dan pustaka alat AI yang terus berkembang, memiliki orkestrasi multi-agen, manajemen percakapan, Playground untuk pengujian instan, akses kode, integrasi observabilitas (seperti LangSmith), serta keamanan dan skalabilitas tingkat perusahaan. Proyek ini telah dirilis secara open source dan dapat diperoleh layanan terkelola penuh melalui DataStax. (Sumber: GitHub Trending)

Pathway: Kerangka kerja ETL pemrosesan aliran Python, mendukung analisis real-time dan pipeline LLM: Pathway adalah kerangka kerja ETL Python yang dirancang khusus untuk pemrosesan aliran, analisis real-time, pipeline LLM, dan RAG (Retrieval Augmented Generation). Kerangka kerja ini menyediakan API Python yang mudah digunakan dan dapat diintegrasikan dengan berbagai pustaka ML Python. Kodenya dapat digunakan secara universal di lingkungan pengembangan dan produksi, secara efektif menangani data batch dan aliran. Pathway didukung oleh mesin Rust yang dapat diskalakan berbasis Differential Dataflow, mendukung komputasi inkremental, multi-threading, multi-processing, dan komputasi terdistribusi. Seluruh pipeline tetap berada di memori, mudah diterapkan melalui Docker dan Kubernetes. (Sumber: GitHub Trending)

Point-Battle: Arena kompetisi kemampuan menunjuk yang dipandu bahasa MLLM: Anggota komunitas mengundang semua orang untuk mencoba Point-Battle, sebuah platform untuk mengevaluasi performa multimodal large language model (MLLM) utama saat ini dalam tugas menunjuk yang dipandu bahasa. Pengguna dapat mengunggah gambar atau memilih gambar yang telah disediakan, memasukkan prompt, mengamati bagaimana berbagai model “menunjuk” jawabannya, dan memberikan suara untuk model dengan performa terbaik. Ini membantu peneliti dan pengembang memahami perbedaan kemampuan berbagai MLLM dalam memahami konten visual dan melakukan lokalisasi spasial berdasarkan instruksi teks. (Sumber: Reddit r/deeplearning)

FullFront: Benchmark untuk mengevaluasi kemampuan MLLM dalam alur kerja rekayasa frontend lengkap: FullFront adalah benchmark baru yang bertujuan untuk mengevaluasi kemampuan multimodal large language model (MLLM) dalam seluruh alur kerja pengembangan frontend, termasuk desain web (konseptualisasi), tanya jawab berbasis persepsi web (organisasi visual dan pemahaman elemen), dan pembuatan kode web (implementasi). Berbeda dari benchmark yang ada, FullFront menggunakan proses dua tahap untuk mengubah halaman web nyata menjadi HTML yang bersih dan terstandardisasi, sambil mempertahankan keragaman desain visual dan menghindari masalah hak cipta. Pengujian ekstensif pada SOTA MLLM mengungkapkan keterbatasan signifikan mereka dalam persepsi halaman, pembuatan kode (terutama pemrosesan gambar dan tata letak), dan implementasi interaksi. (Sumber: HuggingFace Daily Papers)

📚 Pembelajaran

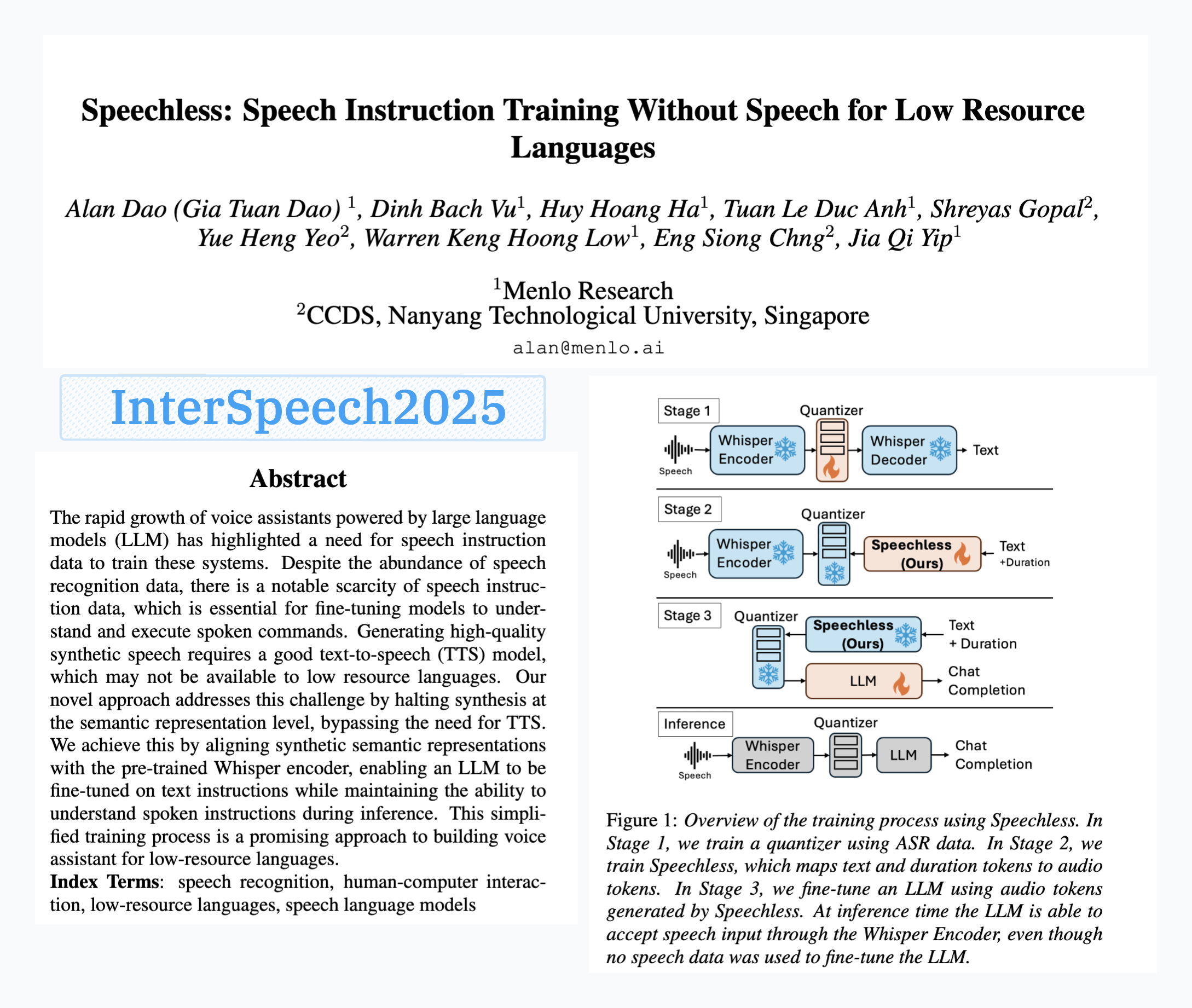

Menlo Research merilis model SpeechLess, mewujudkan pelatihan instruksi suara tanpa data suara: Paper “SpeechLess” dari Menlo Research diterima di Interspeech 2025, dan model terkait telah dirilis. Penelitian ini menargetkan tantangan kurangnya data instruksi suara untuk bahasa sumber daya rendah, mengusulkan metode untuk melatih model instruksi suara sepenuhnya menggunakan data sintetis. Langkah-langkah intinya meliputi: 1. Mengubah ucapan nyata menjadi token diskrit (melatih kuantiser); 2. Melatih model SpeechLess untuk menghasilkan token suara simulasi dari teks; 3. Menggunakan pipeline teks-ke-token-suara-sintetis ini untuk melatih LLM untuk pembelajaran instruksi suara. Hasilnya menunjukkan bahwa pelatihan pada token suara sepenuhnya sintetis sangat efektif, membuka jalan baru untuk membangun sistem suara dalam skenario sumber daya rendah. (Sumber: Reddit r/LocalLLaMA)

Algoritma kompresi teks evolusioner yang didorong oleh mutasi kode LLM: Seorang pengembang mencoba menggunakan LLM (large language model) untuk mengembangkan algoritma kompresi teks dengan melakukan mutasi kecil pada kode kompresor teks gaya LZ77 sederhana. Metode ini melalui evolusi multi-generasi, di mana setiap generasi mempertahankan elit dan penyintas, dan generasi induk menghasilkan generasi anak. Kriteria seleksi murni berdasarkan rasio kompresi; jika perjalanan bolak-balik kompresi-dekompresi gagal, kandidat akan dibuang. Eksperimen dalam 30 generasi meningkatkan rasio kompresi dari 1,03 menjadi 1,85. Proyek ini telah dirilis secara open source di GitHub (think-a-tron/minevolve). (Sumber: Reddit r/MachineLearning)

Quartet: Pelatihan FP4 natif dapat mencapai performa LLM terbaik: Seiring dengan meningkatnya kebutuhan komputasi LLM, pelatihan algoritma presisi rendah menjadi kunci untuk meningkatkan efisiensi. Arsitektur NVIDIA Blackwell mendukung operasi FP4, tetapi algoritma pelatihan FP4 yang ada menghadapi penurunan presisi dan ketergantungan pada presisi campuran. Para peneliti secara sistematis mempelajari pelatihan FP4 yang didukung perangkat keras dan mengusulkan metode Quartet, yang mencapai pelatihan FP4 end-to-end, dengan sebagian besar komputasi dilakukan dalam presisi rendah. Melalui evaluasi ekstensif pada model kelas Llama, terungkap hukum penskalaan presisi rendah baru, mengkuantifikasi trade-off performa pada berbagai lebar bit, dan mengidentifikasi Quartet sebagai teknik pelatihan presisi rendah yang hampir optimal untuk presisi dan komputasi. Menggunakan kernel CUDA yang dioptimalkan, Quartet berhasil mencapai presisi FP4 tingkat SOTA pada model skala miliar. (Sumber: HuggingFace Daily Papers)

Synthetic Data RL (Reinforcement Learning dengan Data Sintetis): Hanya perlu definisi tugas untuk fine-tuning model: Penelitian ini mengusulkan kerangka kerja Synthetic Data RL, yang hanya menggunakan data sintetis yang dihasilkan dari definisi tugas untuk melakukan fine-tuning model dengan reinforcement learning. Metode ini pertama-tama menghasilkan pasangan tanya jawab dari definisi tugas dan dokumen yang diambil, kemudian menyesuaikan tingkat kesulitan pertanyaan berdasarkan kemampuan model untuk menyelesaikannya, dan memilih pertanyaan untuk pelatihan RL berdasarkan tingkat kelulusan rata-rata model pada sampel. Pada Qwen-2.5-7B, metode ini mencapai peningkatan signifikan pada beberapa benchmark seperti GSM8K, MATH, GPQA, melampaui supervised fine-tuning, dan mendekati efek RL yang menggunakan data manusia lengkap, menunjukkan potensi dalam mengurangi anotasi manual. (Sumber: HuggingFace Daily Papers)

TabSTAR: Model dasar tabular dengan representasi yang peka terhadap target semantik: Meskipun deep learning telah mencapai kesuksesan di berbagai bidang, dalam tugas pembelajaran tabular masih kalah dengan gradient boosting decision trees (GBDTs). Para peneliti meluncurkan TabSTAR, sebuah model dasar tabular dengan representasi yang peka terhadap target semantik, yang bertujuan untuk mencapai transfer learning data tabular yang mengandung fitur teks. TabSTAR membuka pembekuan text encoder yang telah dilatih sebelumnya dan memasukkan token target, memberikan konteks yang diperlukan model untuk mempelajari embedding khusus tugas. Model ini, dalam tugas klasifikasi yang mengandung fitur teks, mencapai performa SOTA pada dataset berukuran sedang hingga besar, dan tahap pra-pelatihannya menunjukkan hukum penskalaan jumlah dataset. (Sumber: HuggingFace Daily Papers)

TIME: Benchmark penalaran temporal LLM multi-level untuk skenario dunia nyata: Penalaran temporal sangat penting bagi LLM untuk memahami dunia nyata. Karya yang ada mengabaikan tantangan penalaran temporal dunia nyata: informasi temporal yang padat, dinamika peristiwa yang berubah cepat, dan ketergantungan temporal interaksi sosial yang kompleks. Untuk itu, para peneliti mengusulkan benchmark multi-level TIME, yang berisi 38.522 pasangan QA, mencakup 3 level dan 11 sub-tugas granular halus, serta tiga sub-dataset TIME-Wiki, TIME-News, dan TIME-Dial, yang masing-masing mencerminkan tantangan dunia nyata yang berbeda. Penelitian ini melakukan eksperimen ekstensif dan analisis mendalam pada berbagai model, dan merilis subset anotasi manual TIME-Lite. (Sumber: HuggingFace Daily Papers)

Penalaran LLM dengan catatan dinamis: Meningkatkan kemampuan tanya jawab kompleks: RAG iteratif, ketika menangani tanya jawab multi-hop, menghadapi tantangan konteks yang terlalu panjang dan akumulasi informasi yang tidak relevan, yang memengaruhi kemampuan pemrosesan dan penalaran model. Para peneliti mengusulkan metode “Penulisan Catatan” (Notes Writing), di mana pada setiap langkah dihasilkan catatan ringkas dan relevan dari dokumen yang diambil, mengurangi noise, mempertahankan informasi penting, sehingga secara tidak langsung meningkatkan panjang konteks efektif LLM, dan meningkatkan kemampuan penalaran dan perencanaannya. Metode ini tidak bergantung pada kerangka kerja dan dapat diintegrasikan ke dalam berbagai metode RAG iteratif, dan dalam eksperimen menunjukkan peningkatan performa yang signifikan. (Sumber: HuggingFace Daily Papers)

Kerangka kerja s3: Melatih agen pencarian yang efisien dengan RL menggunakan sedikit data: Sistem Retrieval Augmented Generation (RAG) memungkinkan LLM mengakses pengetahuan eksternal. Penelitian terbaru menggunakan reinforcement learning (RL) untuk membuat LLM bertindak sebagai agen pencarian, tetapi metode yang ada entah mengoptimalkan pengambilan sambil mengabaikan utilitas hilir, atau melakukan fine-tuning pada seluruh LLM yang menyebabkan keterkaitan antara pengambilan dan generasi. Para peneliti mengusulkan kerangka kerja s3, metode ringan dan tidak bergantung model, yang memisahkan pencari dari generator, dan menggunakan “Keuntungan Melampaui RAG” (Gain Beyond RAG) sebagai imbalan untuk melatih pencari. s3 hanya memerlukan 2,4k sampel pelatihan untuk melampaui baseline yang menggunakan data lebih dari 70 kali lipat, dan berkinerja lebih baik pada beberapa benchmark QA. (Sumber: HuggingFace Daily Papers)

ReflAct: Pengambilan keputusan agen LLM di dunia melalui refleksi status target: Agen LLM yang ada (seperti yang berbasis ReAct), ketika melakukan pemikiran dan tindakan yang saling terkait dalam lingkungan yang kompleks, sering menghasilkan penalaran yang tidak membumi atau tidak koheren, yang menyebabkan ketidaksesuaian antara status aktual dan target. Para peneliti menganalisis bahwa ini berasal dari kesulitan ReAct dalam mempertahankan keyakinan internal yang konsisten dan keselarasan target. Untuk itu, mereka mengusulkan ReflAct, sebuah jaringan tulang punggung baru, yang mengalihkan penalaran dari merencanakan tindakan selanjutnya menjadi terus-menerus merefleksikan status agen relatif terhadap targetnya. Dengan secara eksplisit mendasarkan keputusan pada status dan memaksakan keselarasan target yang berkelanjutan, ReflAct secara signifikan meningkatkan keandalan kebijakan, dan secara substansial melampaui ReAct pada tugas-tugas seperti ALFWorld. (Sumber: HuggingFace Daily Papers)

FREESON: Kerangka kerja penalaran yang ditingkatkan pengambilan tanpa retriever: Large

Reasoning Model (LRM) menunjukkan kinerja yang sangat baik dalam penalaran multi-langkah dan pemanggilan mesin pencari, tetapi metode peningkatan pengambilan yang ada bergantung pada model pengambilan independen, yang membatasi peran LRM dalam pengambilan dan dapat menyebabkan kesalahan karena bottleneck representasi. Para peneliti mengusulkan kerangka kerja FREESON, yang memungkinkan LRM untuk mengambil pengetahuan sendiri dengan bertindak sebagai generator dan retriever. Kerangka kerja ini memperkenalkan algoritma CT-MCTS yang dirancang khusus untuk tugas pengambilan, memungkinkan LRM untuk melintasi korpus menuju area jawaban. Eksperimen menunjukkan bahwa FREESON secara signifikan mengungguli model penalaran multi-langkah yang menggunakan retriever independen pada beberapa benchmark QA domain terbuka. (Sumber: HuggingFace Daily Papers)

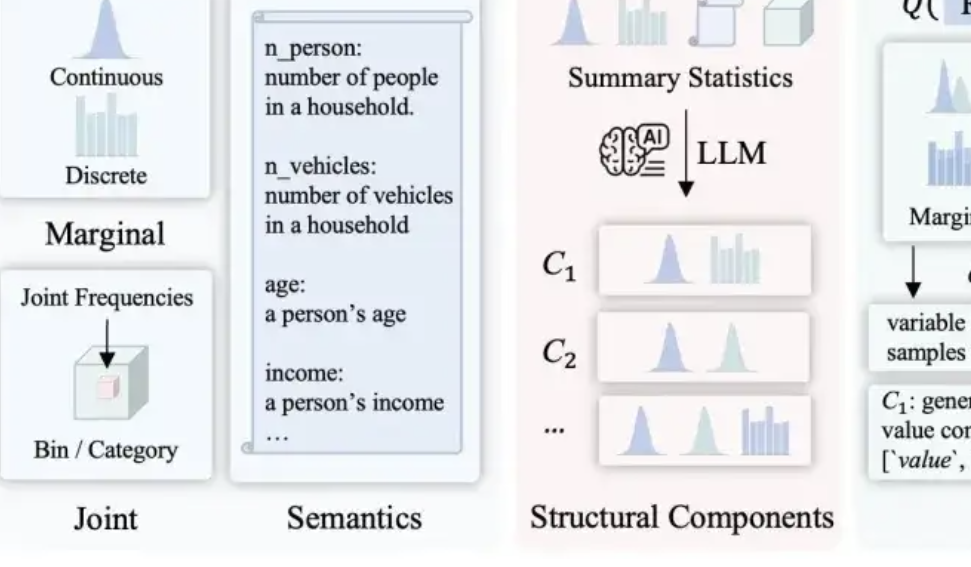

LLMSynthor: McGill University mengusulkan kerangka kerja baru untuk sintesis data yang terkontrol secara statistik: Untuk mengatasi kekurangan metode sintesis data yang ada dalam hal rasionalitas, konsistensi distribusi, dan skalabilitas, tim dari McGill University meluncurkan kerangka kerja LLMSynthor. Kerangka kerja ini tidak secara langsung membuat model besar menghasilkan data, melainkan mengubahnya menjadi “generator yang sadar struktur”. Melalui penalaran struktural, penyelarasan statistik (membandingkan ringkasan statistik alih-alih data mentah), pembuatan aturan distribusi yang dapat diambil sampelnya (alih-alih sampel per baris), dan proses penyelarasan iteratif, kerangka kerja ini menghasilkan dataset sintetis yang secara struktural dan statistik sangat mirip dengan data nyata dan sesuai dengan akal sehat. Metode ini memiliki jaminan konvergensi teoretis dan telah divalidasi dalam berbagai skenario nyata seperti transaksi e-commerce, demografi, dan mobilitas perkotaan, serta kompatibel dengan berbagai model besar. (Sumber: 量子位)

💼 Bisnis

Hygon Information dan Sugon berencana melakukan restrukturisasi aset besar-besaran, kemungkinan akan merger: Perusahaan desain chip Hygon Information dan raksasa superkomputer Sugon keduanya mengumumkan penghentian perdagangan saham. Hygon Information berencana untuk mengakuisisi Sugon melalui penerbitan saham A kepada seluruh pemegang saham A Sugon dengan cara pertukaran saham, dan berencana menerbitkan saham A untuk mengumpulkan dana pendukung. Hygon Information fokus pada penelitian dan pengembangan CPU dan GPU kelas atas, sementara Sugon memiliki akumulasi yang mendalam di bidang server dan komputasi kinerja tinggi, dan merupakan pemegang saham terbesar pertama Hygon Information. Jika merger ini berhasil, akan tercipta raksasa daya komputasi domestik dengan total kapitalisasi pasar hampir 400 miliar yuan, yang akan berdampak besar pada lanskap industri daya komputasi Tiongkok. (Sumber: 量子位, WeChat)

LMArena.ai menanggapi paper Cohere dan mendapatkan pendanaan $100 juta: Papan peringkat model AI LMArena.ai telah menanggapi kontroversinya dengan perusahaan Cohere mengenai pengujian benchmark, dan baru-baru ini mengumumkan perolehan pendanaan sebesar $100 juta, dengan valuasi mencapai $600 juta. Reaksi komunitas terhadap hal ini beragam, sebagian pengguna berpendapat bahwa tanggapan LMArena mengandung pernyataan statistik yang meragukan, dan suntikan dana besar dari VC dapat merusak kredibilitasnya sebagai benchmark netral, khawatir model bisnisnya dapat memengaruhi peluang model terbuka untuk masuk dalam peringkat atau aksesibilitas data. (Sumber: Reddit r/LocalLLaMA)

JD.com berinvestasi di perusahaan Zhiyuan Robot milik Zhihui Jun: Zhiyuan Robot baru-baru ini menyelesaikan putaran pendanaan baru, dengan investor termasuk JD.com dan Shanghai Embodied Intelligence Fund, serta beberapa investor lama yang ikut serta. Zhiyuan Robot didirikan pada tahun 2023 oleh mantan “pemuda jenius” Huawei, Peng Zhihui (Zhihui Jun), dan berfokus pada penelitian dan pengembangan robot embodied intelligence. Pendanaan ini akan semakin mendukung investasi Zhiyuan Robot dalam penelitian dan pengembangan teknologi serta ekspansi pasar. (Sumber: WeChat)

🌟 Komunitas

Diskusi masalah integrasi OpenWebUI dengan Ollama dan alat MCP: Pengguna Reddit mengalami masalah saat menggunakan OpenWebUI dengan backend Ollama (model devstral:24b) dan alat MCP (mcp-atlassian): meskipun log server MCP menunjukkan respons sukses 200, OpenWebUI menampilkan pesan “Sepertinya ada masalah saat mengambil data dari alat” atau “Tidak memiliki izin untuk mengakses alat”. Pengguna mencari metode debugging. Pengguna lain bertanya bagaimana LLM di OpenWebUI memanfaatkan alat MCP, khususnya bagaimana LLM mengetahui alat mana yang harus digunakan dan penyebab ketidakstabilan pemanggilan alat. (Sumber: Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Membahas dampak AI terhadap masa depan umat manusia: perpecahan, kembali ke alam, atau koeksistensi?: Seorang pengguna Reddit membayangkan masa depan AI, berpendapat bahwa AI dapat menyebabkan perpecahan umat manusia: sebagian orang merasa kehilangan karena AI menggantikan pekerjaan dan aktivitas kreatif, akhirnya kembali ke kehidupan alami tanpa teknologi; sebagian lainnya sangat terintegrasi dengan teknologi, menjadi cyborg. Suar matahari yang kuat dapat menghancurkan semua teknologi, dan pada saat itu hanya manusia yang beradaptasi dengan alam yang dapat bertahan hidup. Postingan tersebut juga mengajukan kemungkinan lain: manusia belajar untuk hidup berdampingan secara harmonis dengan AI, menggunakannya sebagai alat, bukan sebagai dewa. Bagian komentar membahas hal ini dengan antusias, menyentuh masalah kelayakan, ketergantungan teknologi, alokasi sumber daya, dll. (Sumber: Reddit r/ArtificialInteligence)

Merefleksikan tingkat pemahaman LLM: Apakah kita benar-benar tidak mengerti cara kerjanya?: Seorang pengguna Reddit mempertanyakan klaim bahwa “cara kerja LLM tidak sepenuhnya dipahami”. Pengguna tersebut berpendapat bahwa meskipun kita mungkin tidak sepenuhnya memahami mengapa semantik terdistribusi begitu kuat atau mengapa pembuatan kode dapat dimodelkan secara efektif oleh LLM, mekanisme internal LLM seperti encoder/decoder, jaringan feed-forward, dll. sudah diketahui. Pengguna tersebut berpendapat bahwa menyamakan “tidak sepenuhnya memahami batas kemampuan dan fenomena kemunculannya” dengan “sama sekali tidak memahami prinsip kerjanya” akan menyesatkan publik, dan dapat memicu pemahaman antropomorfik yang salah tentang LLM, misalnya, memberinya “agensi” yang tidak ada. Bagian komentar menunjukkan bahwa mengetahui arsitektur dasar tidak sama dengan memahami bagaimana sistem yang kompleks menghasilkan hasil, misalnya, apa yang dilakukan setiap jaringan feed-forward secara spesifik masih merupakan misteri. (Sumber: Reddit r/ArtificialInteligence)

Penyalahgunaan alat ringkasan AI (seperti Grok) di media sosial memicu kekhawatiran “outsourcing pemikiran”: Pengguna Reddit mengamati bahwa di media sosial seperti X (sebelumnya Twitter), sering muncul fenomena penggunaan “@grok ringkas ini” untuk menanggapi konten sederhana (seperti komentar tentang sandwich). Pembuat postingan berpendapat bahwa ini mencerminkan orang-orang yang melepaskan upaya berpikir dan menilai dasar, menyerahkan proses pengambilan keputusan kecil dan pemikiran yang sebenarnya bisa mereka lakukan sendiri kepada AI, yang menyebabkan penurunan ketergantungan pada kemampuan berpikir mereka sendiri. Bagian komentar memiliki pandangan yang beragam mengenai hal ini, ada yang menganggap ini hanya evolusi alat (mirip dengan penggunaan Google Search di masa lalu), ada yang menganggap ini sebagai manifestasi kemalasan, dan ada juga yang menunjukkan bahwa fenomena ini lebih umum terjadi di platform tertentu. (Sumber: Reddit r/ArtificialInteligence)

Potensi dan refleksi AI dalam pendidikan: membantu belajar atau melemahkan kemampuan?: Seorang pengguna Reddit mengungkapkan, jika AI sudah ada di masa SMA, pengalaman belajar mungkin akan sangat berbeda, karena AI mampu menguraikan pengetahuan secara detail, menjawab pertanyaan tanpa bias, dan membantu menjaga rasa ingin tahu. Banyak komentator setuju, berpendapat bahwa AI dapat sangat meningkatkan efisiensi belajar dan luasnya eksplorasi pengetahuan. Namun, ada juga komentator yang menyuarakan kekhawatiran, berpendapat bahwa alat AI saat ini mungkin dirancang untuk “membuat pengguna tetap bodoh”, atau distribusi sumber daya pendidikan yang tidak merata akan menyebabkan kalangan kaya mendapatkan bantuan AI berkualitas tinggi, sementara siswa sekolah negeri mungkin dirugikan oleh alat AI berkualitas rendah, bahkan “dilatih” oleh AI untuk hanya patuh. (Sumber: Reddit r/ArtificialInteligence)

Membahas perubahan karir di era AI: semua orang menjadi manajer atau muncul “kesenjangan AI”?: Sebuah postingan di Reddit memicu diskusi tentang bentuk kerja di masa depan setelah AI merata. Pembuat postingan membayangkan apakah di masa depan semua manusia akan menjadi manajer alat AI, hanya perlu bekerja beberapa jam seminggu. Bagian komentar memiliki pandangan beragam: ada yang berpendapat AI dapat menggantikan posisi manajerial; ada yang mengusulkan bahwa masyarakat masa depan akan terbagi menjadi kelas “pemilik robot” dan “bukan pemilik robot”; ada juga yang berpendapat bahwa perubahan ini sudah terjadi dan bukan hal yang jauh di masa depan. Inti diskusi adalah bagaimana AI akan membentuk kembali tanggung jawab pekerjaan dan peran manusia dalam sistem ekonomi. (Sumber: Reddit r/ArtificialInteligence)

Komunikasi yang dibantu AI: memecahkan masalah penulisan email bagi penderita kecemasan sosial: Seorang pengguna Reddit berbagi bagaimana AI membantunya meningkatkan komunikasi email. Pengguna tersebut menyatakan bahwa ia tidak pandai menulis email yang sopan, entah terlalu formal seperti Shakespeare, atau seperti robot layanan pelanggan yang ketinggalan zaman. Sekarang, dengan membuat draf email menggunakan AI, lalu menambahkan sentuhan pribadi, ia berhasil mengatasi kesulitan sosial seperti memulai email (misalnya, “Semoga email ini menemukan Anda dalam keadaan baik”). Postingan ini mendapat banyak simpati dari pengguna yang memiliki kecemasan sosial atau kesulitan menulis serupa, yang menganggap AI menunjukkan nilai praktis dalam membantu komunikasi sehari-hari. (Sumber: Reddit r/artificial)

💡 Lainnya

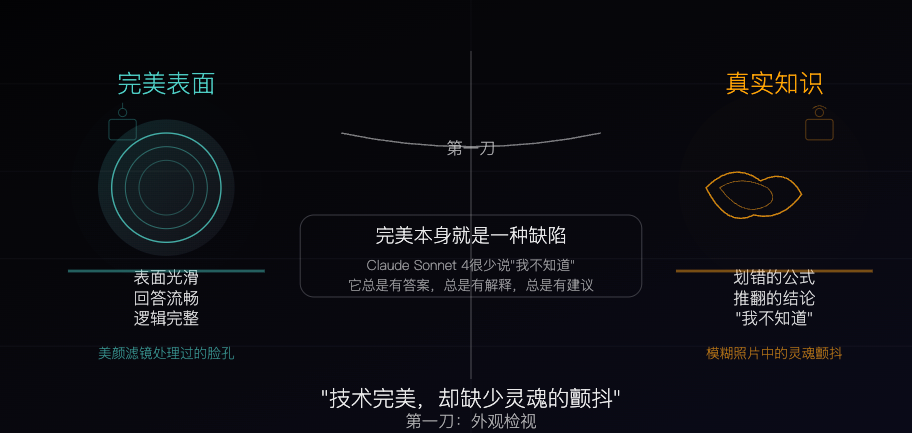

Claude Sonnet 4: Spesimen pengetahuan yang dipahat oleh algoritma, kesempurnaan juga merupakan kekurangan: Sebuah artikel filosofis membandingkan Claude Sonnet 4 dengan “spesimen pengetahuan” yang dipahat dengan cermat oleh algoritma. Penulis berpendapat bahwa jawabannya lancar, logikanya lengkap, dan tampak sempurna di permukaan, tetapi kesempurnaan ini sendiri menutupi karakteristik “ketidaksempurnaan” yang dimiliki oleh pengetahuan nyata, seperti kesalahan, kontradiksi, dan kejujuran untuk mengatakan “saya tidak tahu”. Artikel tersebut membahas perbedaan antara sumber pengetahuan AI dan pengalaman manusia, menunjukkan bahwa AI memiliki memori tetapi tidak memiliki pengalaman. Pada saat yang sama, ia memperingatkan bahwa ketergantungan berlebihan pada AI dapat melemahkan kemampuan berpikir mandiri, dan berpendapat bahwa AI menghilangkan ketidakpastian, yang merupakan nilai sekaligus potensi bahayanya. (Sumber: WeChat)

Status dan masa depan iklan yang dihasilkan AI: iklan perusahaan India memicu diskusi “kesan murahan”: Sebuah postingan di Reddit menampilkan iklan televisi dari sebuah perusahaan India terkenal yang sepenuhnya dihasilkan oleh AI, memicu diskusi pengguna tentang kualitas konten yang dihasilkan AI dan tren masa depan. Banyak komentar berpendapat bahwa iklan tersebut dibuat dengan kasar dan hasilnya tidak bagus, tetapi ada juga yang menunjukkan bahwa ini mungkin mencerminkan pasar iklan India sendiri yang memang memiliki banyak produksi berbiaya rendah. Diskusi meluas ke potensi personalisasi iklan AI (seperti TV pintar yang menghasilkan iklan secara real-time berdasarkan data pengguna) dan apakah orang akan secara bertahap beradaptasi bahkan mengharapkan “kesan kasar” semacam ini. (Sumber: Reddit r/ChatGPT)

Membahas strategi optimasi model besar dan model kecil di lingkungan sumber daya rendah: Komunitas Reddit membahas apakah di lingkungan sumber daya rendah, lebih praktis untuk memprioritaskan pengembangan teknologi optimasi untuk model besar (seperti PEFT, LoRA, kuantisasi), atau lebih berfokus pada peningkatan performa model kecil agar dapat menyaingi model besar. Para peserta diskusi prihatin tentang kelayakan mengompres pengetahuan dan kemampuan “penalaran” model dengan miliaran parameter ke dalam model kecil seperti 100 juta parameter (mirip dengan model distilasi Deepseek Qwen), serta batas bawah jumlah parameter model kecil. Ini mencerminkan perhatian berkelanjutan komunitas terhadap demokratisasi AI dan penerapan yang efisien. (Sumber: Reddit r/deeplearning)