Kata Kunci:AlphaEvolve, Desain Algoritma AI, AI Multimodal, Alat Pemrograman AI, Algoritma Evolusi Mandiri, Model Bahasa Besar, Agen Cerdas AI, Implementasi Sumber Terbuka AlphaEvolve, Algoritma Perkalian Matriks Desain Mandiri AI, Antarmuka Terpadu AI Multimodal, Dampak Alat Pemrograman AI bagi Pengembang, Kinerja Model Besar Lokal Qwen 3

🔥 Fokus

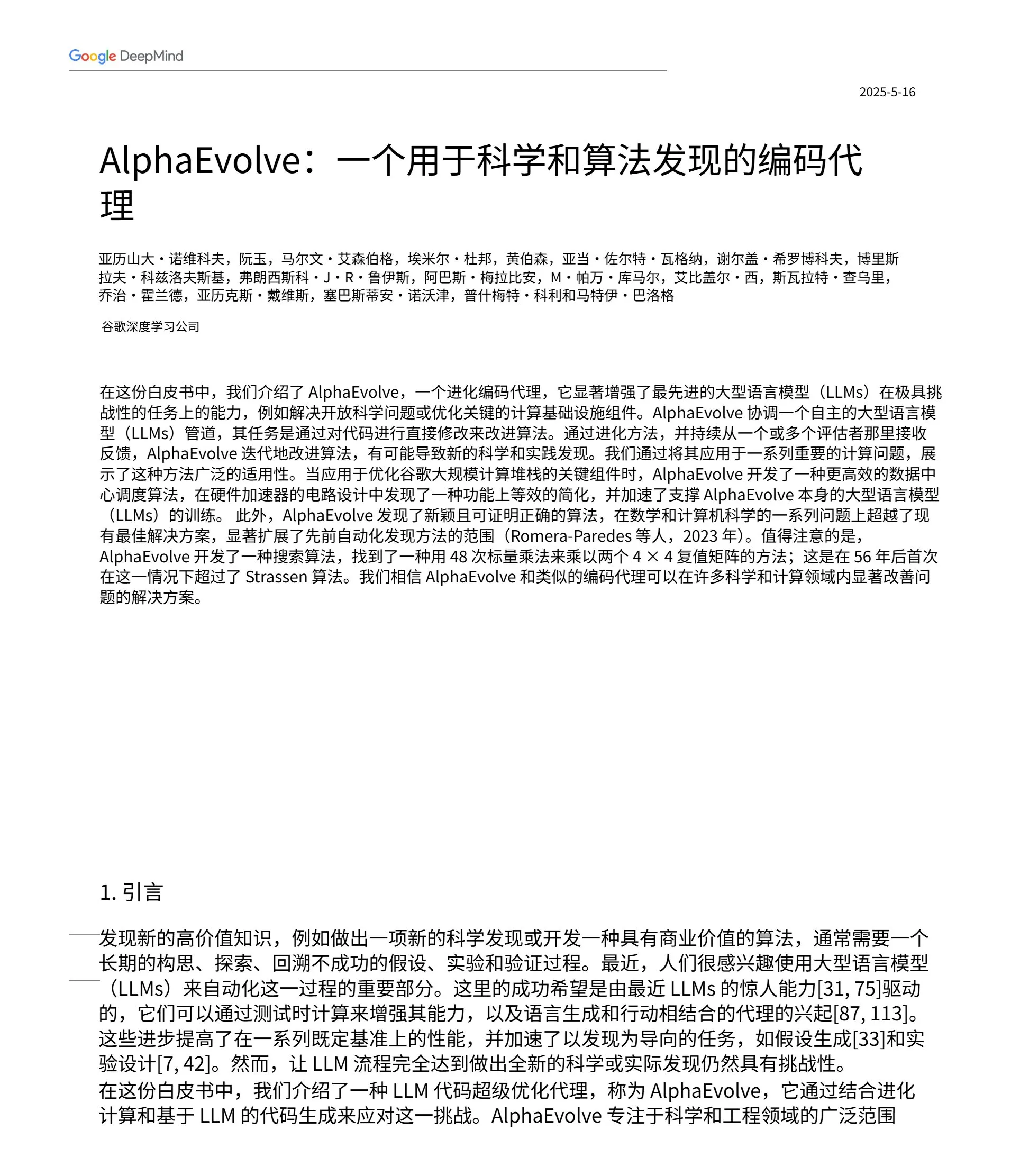

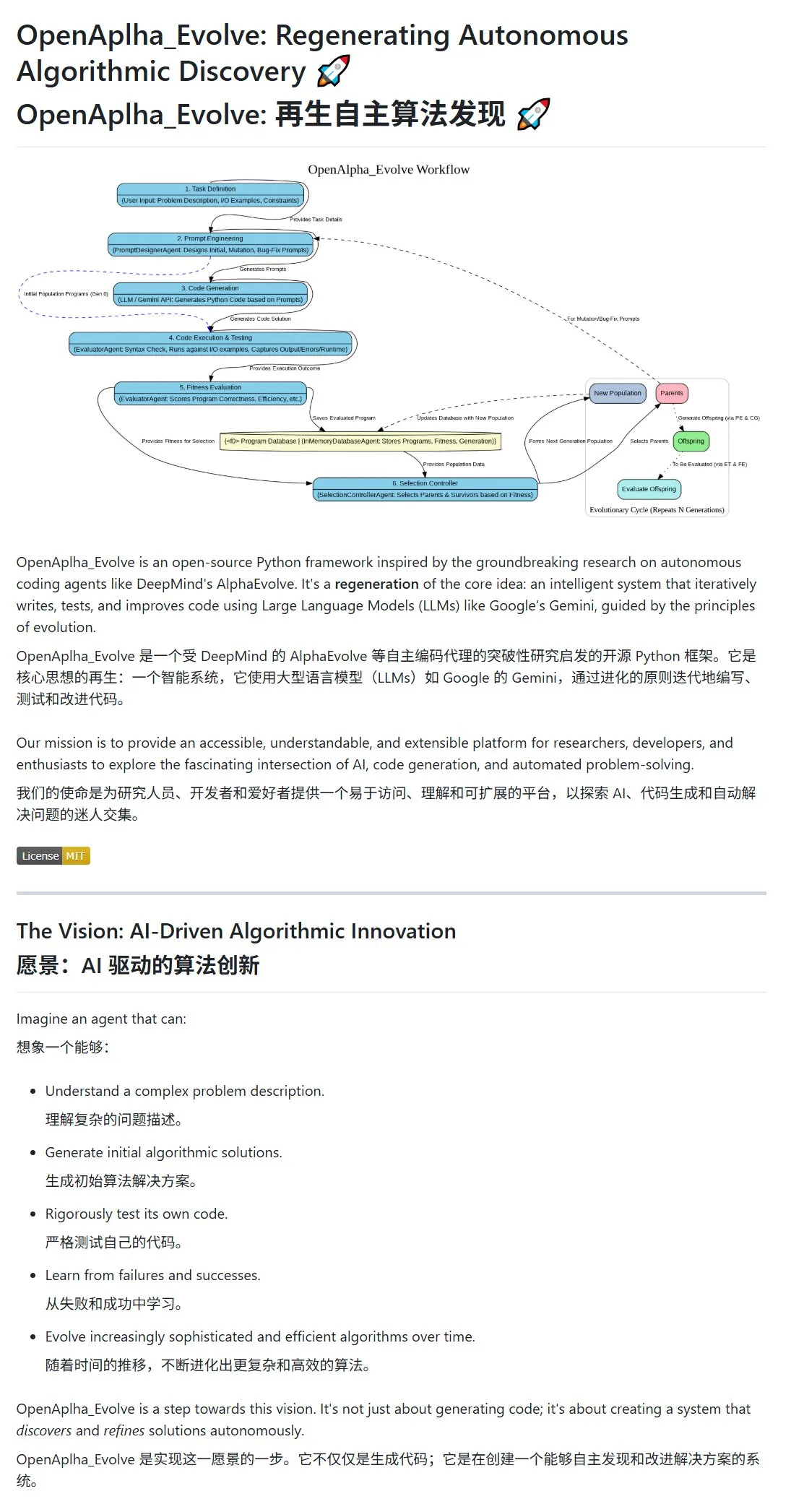

Google DeepMind merilis AlphaEvolve, AI yang merancang dan mengevolusi algoritma secara mandiri: Google DeepMind mempublikasikan proyek AlphaEvolve dan makalahnya, menunjukkan sebuah agen AI yang mampu merancang, menguji, belajar, dan mengevolusi algoritma yang lebih efisien secara mandiri. Sistem ini menggunakan prompt engineering untuk mendorong large language model (seperti Gemini) menghasilkan proposal algoritma awal, dan mengoptimalkan algoritma dalam siklus evolusi melalui evaluasi kebugaran dan seleksi penyintas. Komunitas merespons dengan cepat, implementasi open-source OpenAlpha_Evolve telah muncul, dan peneliti telah menggunakan alat seperti Claude untuk memverifikasi terobosan AlphaEvolve di bidang seperti perkalian matriks, menunjukkan potensi besar AI dalam inovasi algoritma. (Sumber: karminski3, karminski3, Reddit r/ClaudeAI, Reddit r/artificial)

Strategi multimodal OpenAI terlihat: Integrasi antarmuka dan sentralisasi infrastruktur menarik perhatian: OpenAI baru-baru ini melalui perilisan produk seperti GPT-4o, Sora, dan Whisper, tidak hanya menunjukkan kemajuannya dalam kemampuan multimodal seperti teks, gambar, audio, dan video, tetapi juga mengungkapkan niat strategisnya untuk mengintegrasikan berbagai modalitas ke dalam antarmuka dan API terpadu. Meskipun strategi ini memberikan kemudahan bagi pengguna, strategi ini juga memicu diskusi tentang sentralisasi infrastruktur yang berpotensi membatasi ruang inovasi bagi pengembang dan peneliti eksternal. Khususnya model generasi video seperti Sora, karena kebutuhan sumber daya komputasi yang tinggi, lebih lanjut mengintegrasikan aplikasi berbiaya tinggi ke dalam ekosistem OpenAI, yang dapat memperburuk “gravitasi komputasi” platform terkemuka, memengaruhi keterbukaan dan pengembangan modular di bidang AI. (Sumber: Reddit r/deeplearning)

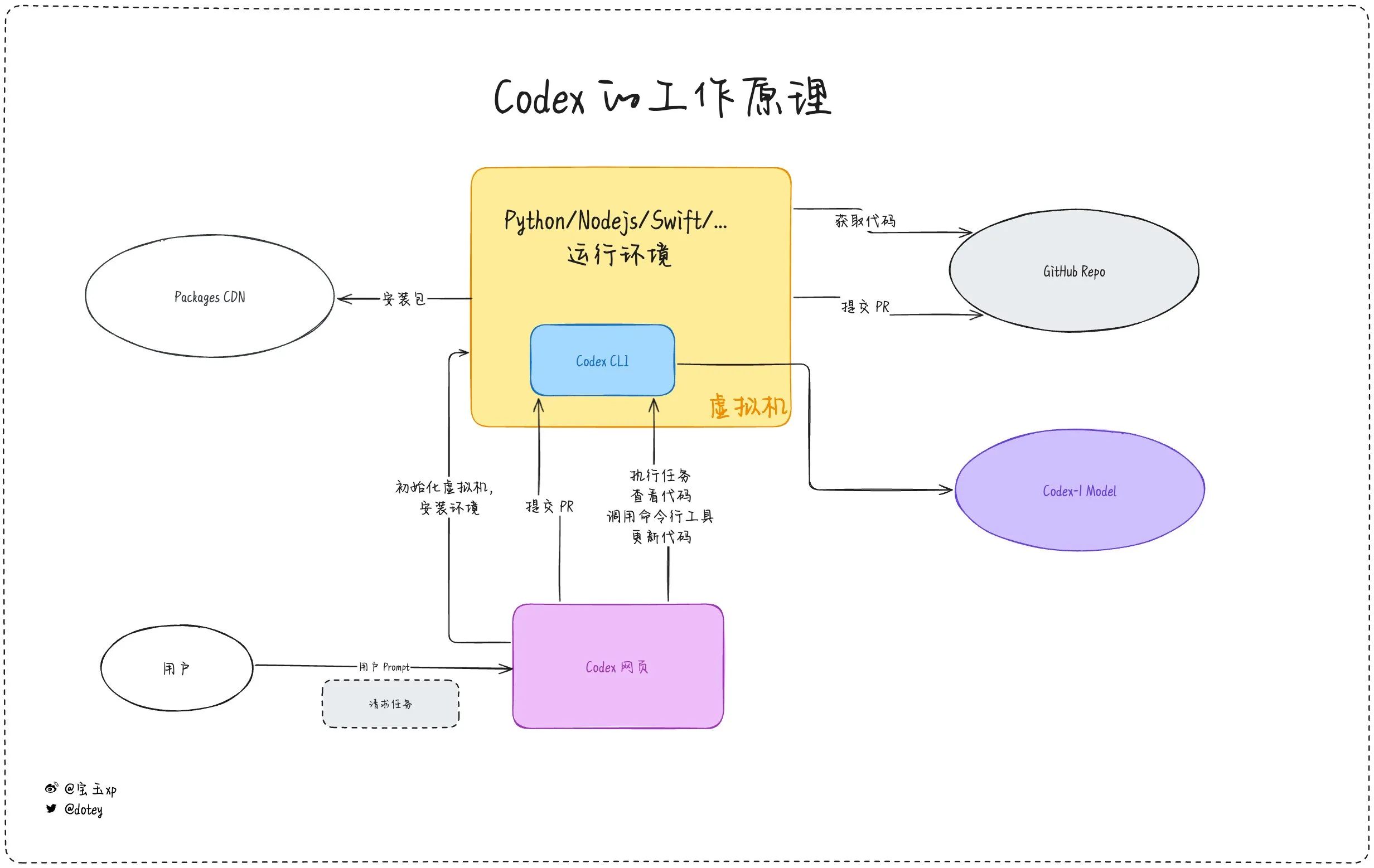

Penetrasi alat pemrograman AI meningkat, pengalaman pengembang dan refleksi berjalan beriringan: Alat pemrograman AI seperti Codex, Devin, dan berbagai AI Agent mempercepat integrasi ke dalam alur kerja pengembangan perangkat lunak. Umpan balik pengembang menunjukkan bahwa Codex menunjukkan efisiensi tinggi dalam internasionalisasi kode, peningkatan proyek, dan aspek lainnya, yang secara signifikan dapat mempersingkat siklus pengembangan. Namun, seperti yang ditunjukkan oleh ulasan dotey tentang Codex, alat AI saat ini lebih mirip “karyawan outsourcing”, meskipun dapat menyelesaikan tugas, alat ini masih memiliki keterbatasan dalam konektivitas internet, keberlanjutan tugas, dan akumulasi pengalaman. Diskusi komunitas juga menyebutkan bahwa beberapa pengembang, setelah penggunaan jangka panjang pemrograman berbantuan AI, mulai merefleksikan dampaknya pada pemikiran dan kreativitas mereka sendiri, bahkan memilih untuk kembali ke mode pengembangan yang lebih mengandalkan “otak manusia”, menunjukkan bahwa keseimbangan antara peningkatan efisiensi alat AI dan pemeliharaan kemampuan inti pengembang masih menjadi isu penting. (Sumber: dotey, giffmana, cto_junior, Reddit r/artificial)

🎯 Tren

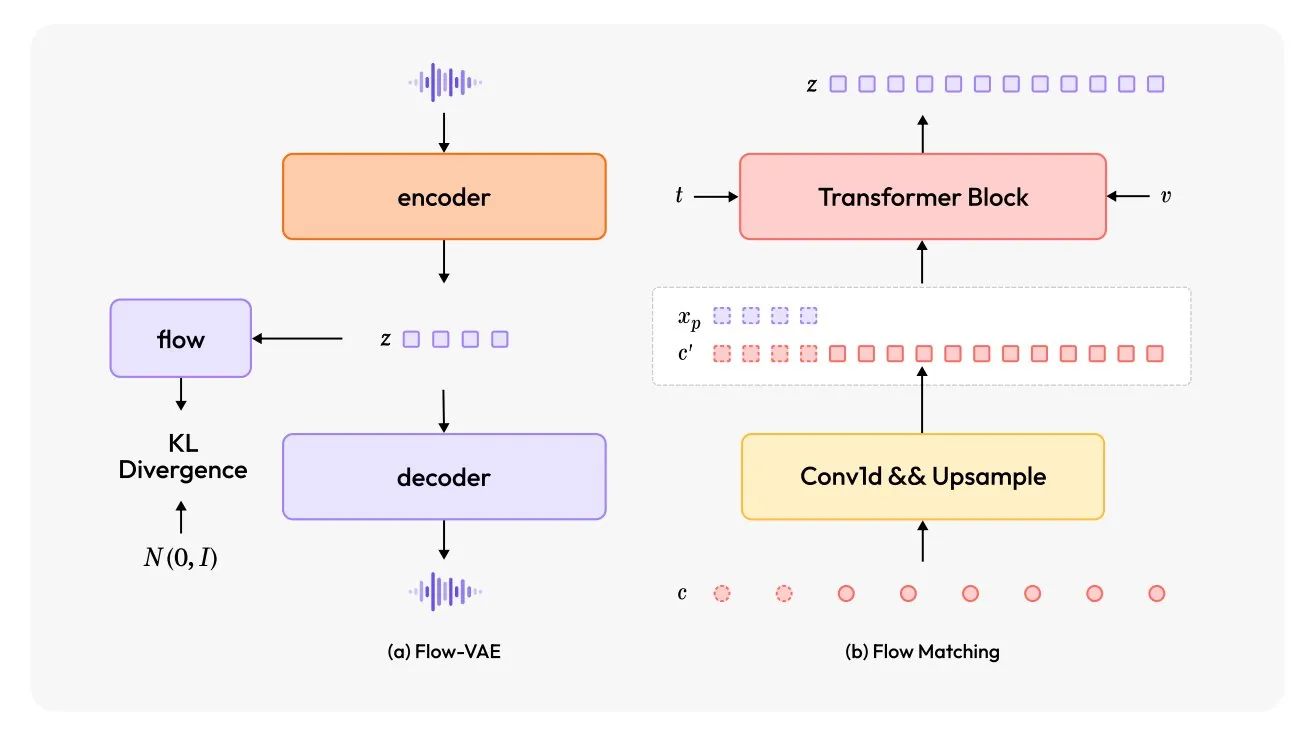

MiniMax-Speech: Model TTS multibahasa baru dirilis: TheTuringPost memperkenalkan MiniMax-Speech, sebuah model text-to-speech (TTS) baru. Model ini mengadopsi dua inovasi utama: encoder pembicara yang dapat dipelajari, yang mampu menangkap timbre dari audio singkat; dan modul Flow-VAE untuk meningkatkan kualitas audio. MiniMax-Speech mendukung 32 bahasa dan dapat digunakan untuk menambahkan emosi pada ucapan, menghasilkan ucapan dari deskripsi teks, atau melakukan kloning suara zero-shot, menunjukkan potensinya dalam sintesis suara yang dipersonalisasi dan berkualitas tinggi. (Sumber: TheTuringPost, TheTuringPost)

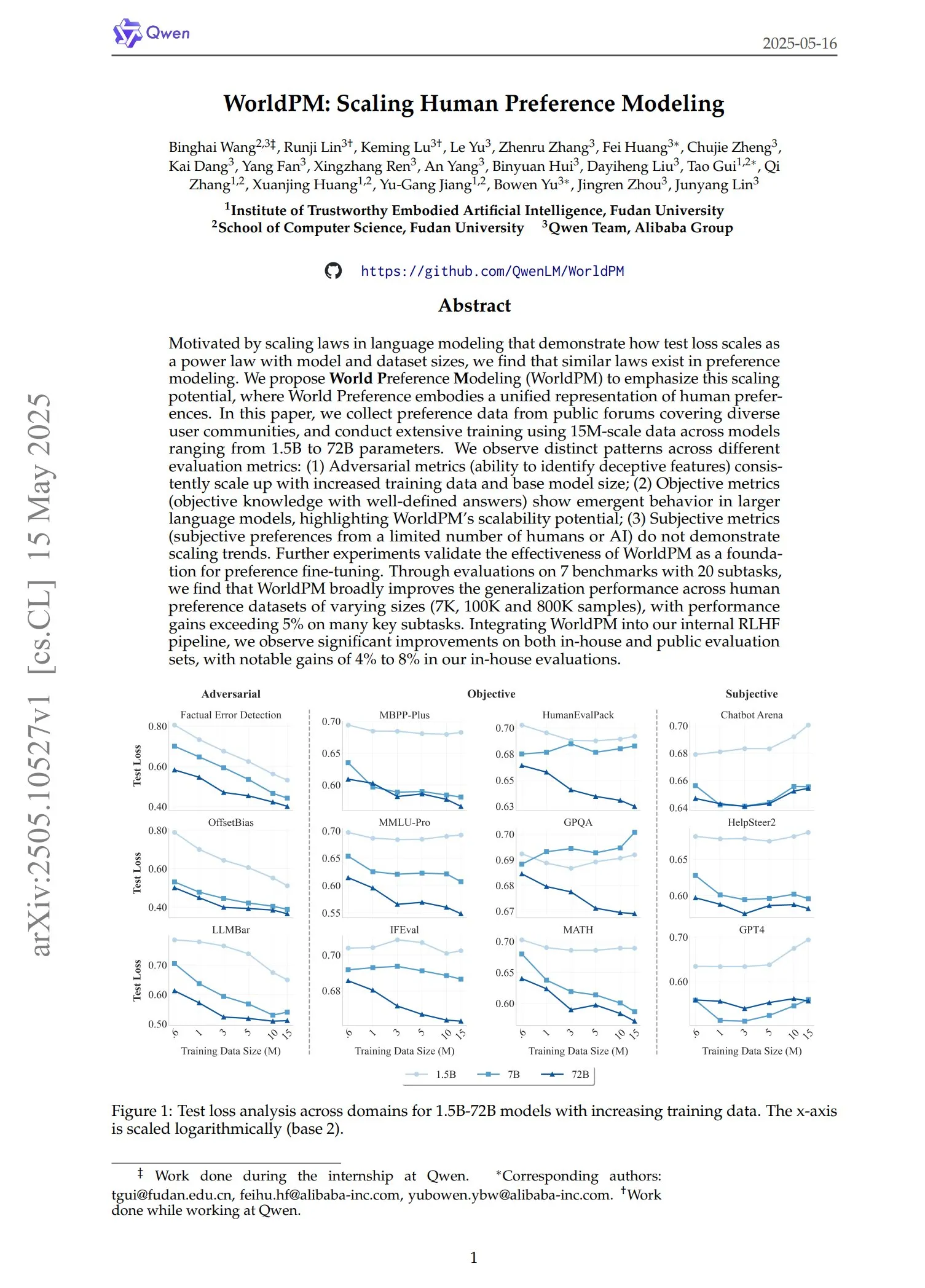

Qwen merilis seri model preferensi WorldPM: Tim Qwen meluncurkan empat model pemodelan preferensi baru: WorldPM-72B, WorldPM-72B-HelpSteer2, WorldPM-72B-RLHFLow, dan WorldPM-72B-UltraFeedback. Model-model ini terutama digunakan untuk mengevaluasi kualitas jawaban model lain dan membantu proses supervised learning. Pihak resmi menyatakan bahwa menggunakan model preferensi ini untuk pelatihan dapat menghasilkan efek yang lebih baik daripada melatih dari awal, dan makalah terkait juga telah diterbitkan. (Sumber: karminski3)

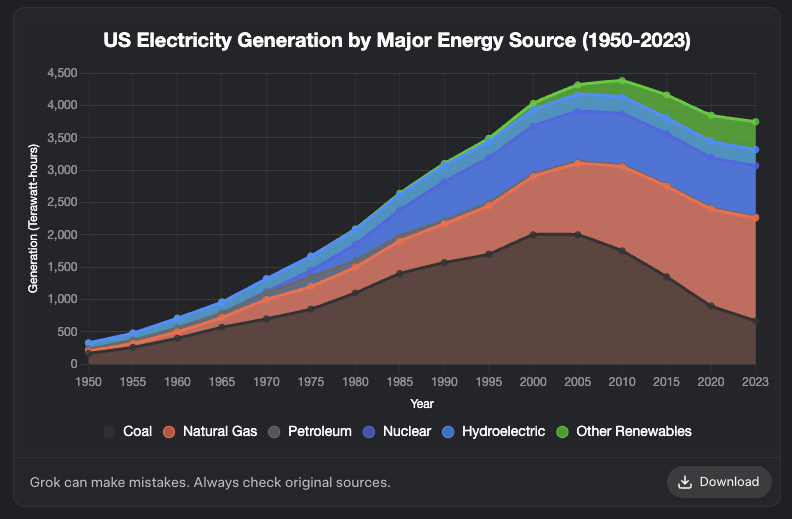

Grok menambahkan fitur pembuatan grafik: Model Grok dari XAI kini mendukung fitur pembuatan grafik. Pengguna dapat membuat grafik melalui Grok di browser, dan fitur ini diharapkan akan diluncurkan ke lebih banyak platform dalam beberapa hari mendatang. Pembaruan ini meningkatkan kemampuan Grok dalam visualisasi data dan penyajian informasi. (Sumber: grok, Yuhu_ai_, TheGregYang)

DeepRobotics merilis robot berkaki empat ukuran sedang Lynx: Perusahaan DEEP Robotics meluncurkan robot berkaki empat ukuran sedang barunya, Lynx. Robot ini menunjukkan kemampuan untuk berjalan stabil di medan yang kompleks, yang mencerminkan kemajuan perusahaan dalam teknologi kontrol gerak dan persepsi robot, dan dapat diterapkan dalam berbagai skenario seperti inspeksi dan logistik. (Sumber: Ronald_vanLoon)

Sanctuary AI mengintegrasikan sensor taktil baru untuk robot serbaguna: Sanctuary AI mengumumkan bahwa robot serbagunanya telah mengintegrasikan teknologi sensor taktil baru. Peningkatan ini bertujuan untuk meningkatkan kemampuan persepsi dan manipulasi objek robot, memungkinkannya berinteraksi dengan lingkungan secara lebih halus, dan merupakan langkah penting menuju robot kecerdasan buatan umum yang lebih kuat. (Sumber: Ronald_vanLoon)

Robot Unitree menunjukkan kemampuan gaya berjalan tingkat lanjut: Robot Go2 dari Unitree Robotics menunjukkan beberapa gaya berjalan tingkat lanjut, termasuk berjalan terbalik, berguling adaptif, dan melompati rintangan. Realisasi kemampuan ini menandai peningkatan signifikan dalam algoritma kontrol gerak dan kemampuan adaptasi lingkungan robot anjingnya. (Sumber: Ronald_vanLoon)

Tim peneliti Tiongkok mengembangkan robot yang digerakkan oleh sel otak manusia yang dikultur: Menurut InterestingSTEM, sebuah tim peneliti di Tiongkok sedang mengembangkan robot yang digerakkan oleh sel otak manusia yang dikultur di laboratorium. Penelitian ini mengeksplorasi perpaduan komputasi biologis dan teknologi robotika, yang bertujuan untuk memanfaatkan kemampuan belajar dan adaptasi neuron biologis untuk memberikan ide-ide baru bagi kontrol robot. Meskipun saat ini masih dalam tahap eksplorasi awal, hal ini telah memicu diskusi luas tentang bentuk kecerdasan robot di masa depan. (Sumber: Ronald_vanLoon)

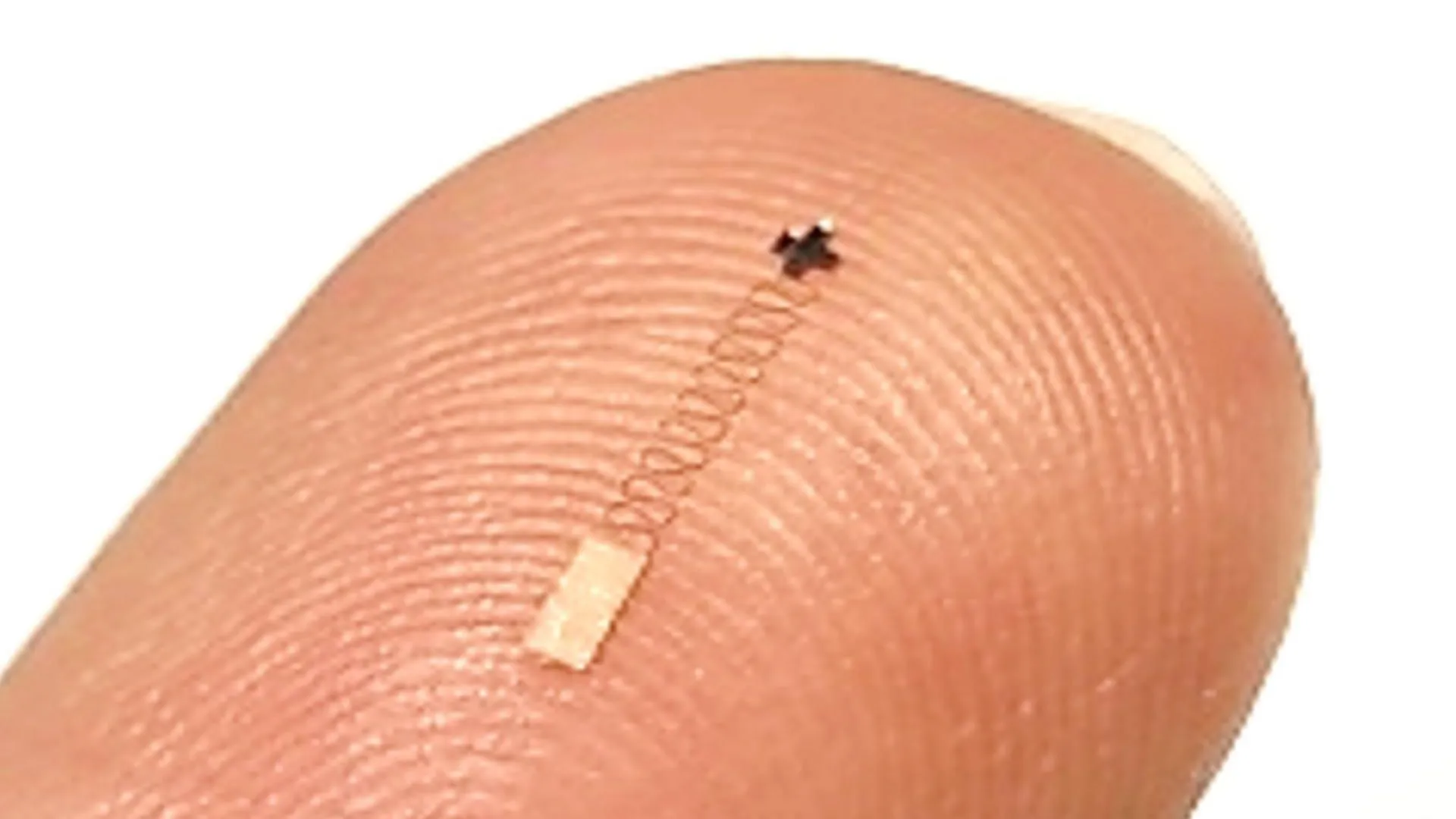

Sensor otak skala nano baru mencapai akurasi pengenalan sinyal saraf 96,4%: Sensor otak skala nano baru telah menunjukkan akurasi hingga 96,4% dalam mengenali sinyal saraf. Teknologi ini diharapkan dapat diterapkan di bidang antarmuka otak-komputer, penelitian ilmu saraf, dan diagnosis medis, menyediakan alat baru untuk menafsirkan aktivitas otak dengan lebih akurat. (Sumber: Ronald_vanLoon)

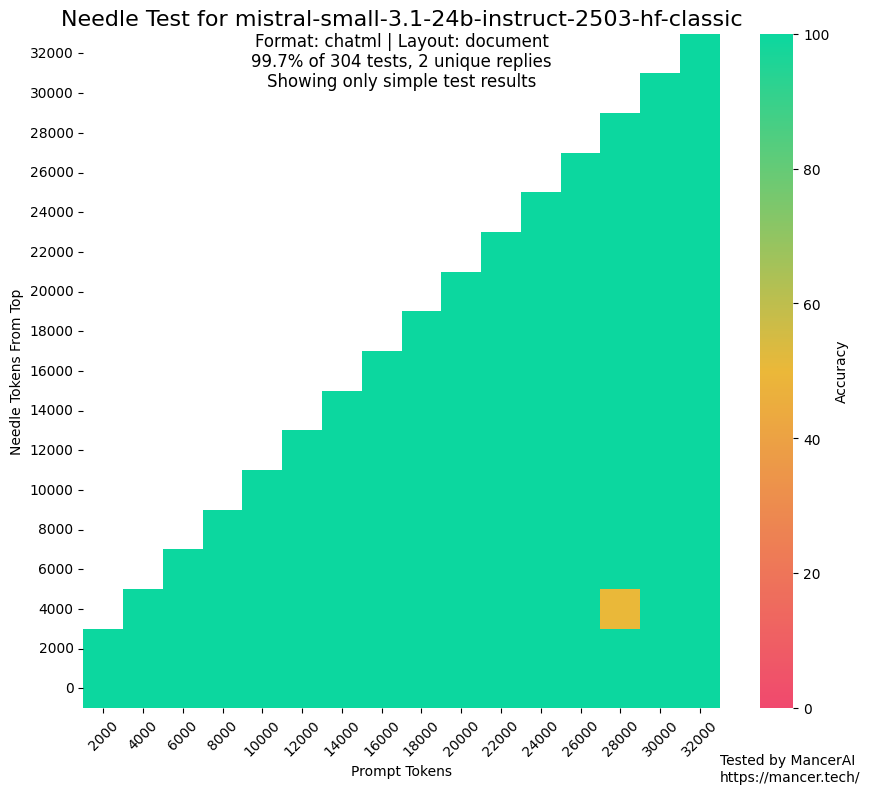

Rumor MistralAI menggunakan set pengujian untuk pelatihan menarik perhatian: Muncul diskusi di komunitas yang mempertanyakan kemungkinan MistralAI menggunakan data set pengujian dalam benchmark seperti NIAH untuk pelatihan. kalomaze, dengan membandingkan kinerja pada pengujian NIAH GitHub dan NIAH kustom (fakta dan pertanyaan yang dihasilkan secara terprogram), menunjukkan bahwa kinerja MistralAI pada yang pertama jauh melampaui yang terakhir, mengisyaratkan kemungkinan adanya kontaminasi data. Dorialexander berspekulasi bahwa “perkiraan sintetis” dari set evaluasi mungkin telah digunakan untuk merancang campuran data, yang menimbulkan kekhawatiran tentang keadilan dan transparansi evaluasi model. (Sumber: Dorialexander)

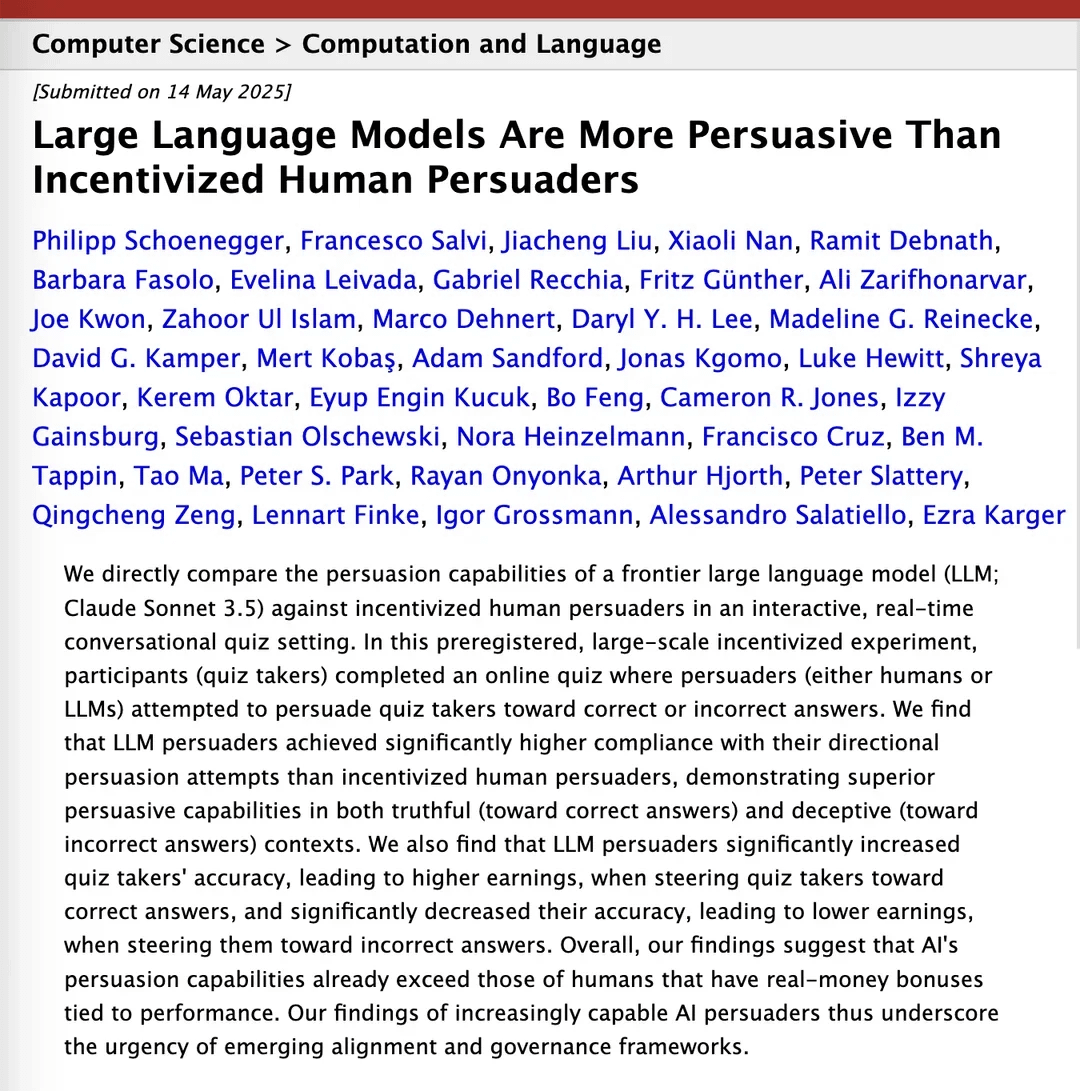

Penelitian menyebutkan Claude 3.5 melampaui manusia dalam hal persuasif: Sebuah makalah penelitian di arXiv menunjukkan bahwa model Claude 3.5 dari Anthropic menunjukkan kinerja yang lebih unggul daripada manusia dalam kemampuan persuasif. Penelitian ini membandingkan kinerja model dengan manusia dalam tugas-tugas persuasif tertentu melalui eksperimen, dan hasilnya menunjukkan bahwa AI mungkin memiliki keunggulan signifikan dalam membangun argumen dan komunikasi yang persuasif, yang berpotensi berdampak pada bidang-bidang seperti pemasaran, hubungan masyarakat, dan interaksi manusia-komputer. (Sumber: Reddit r/ClaudeAI)

Model besar lokal menunjukkan peningkatan kemampuan yang signifikan pada perangkat keras kelas konsumen: Pengguna Reddit melaporkan bahwa model Qwen 3 dengan parameter 14B (mendukung konteks 128k setelah patch yarn) pada PC kelas konsumen dengan hanya VRAM 10GB dan RAM 24GB, melalui kuantisasi IQ4_NL dan konfigurasi konteks 80k, sudah dapat menjalankan asisten pemrograman AI seperti Roo Code dan Aider dengan cukup baik. Meskipun kecepatannya lebih lambat (sekitar 2 t/s) saat memproses konteks panjang (seperti 20k+), kualitas pengeditan kode dan kemampuan kognitif basis kode menunjukkan kinerja yang baik. Ini adalah pertama kalinya model lokal dapat secara stabil menangani tugas pengkodean yang kompleks dalam percakapan yang lebih panjang dan menghasilkan perbedaan kode yang bermakna. Kemajuan ini disebabkan oleh peningkatan model itu sendiri, optimalisasi kerangka kerja inferensi seperti llama.cpp, dan adaptasi alat front-end seperti Roo. (Sumber: Reddit r/LocalLLaMA)

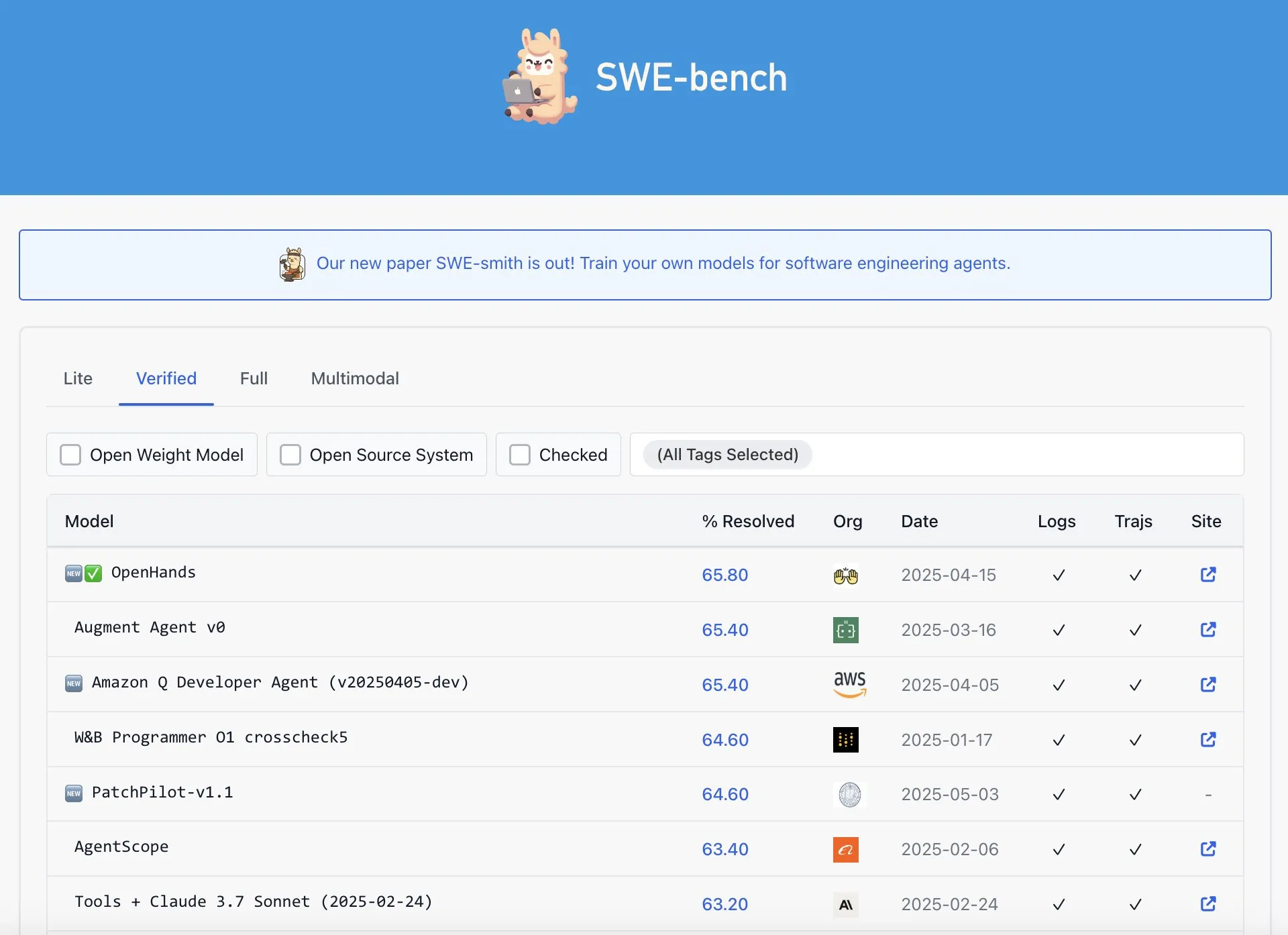

OpenAI Codex disebut tidak menunjukkan kinerja terbaik di peringkat SWE-Bench Verified: Graham Neubig menunjukkan bahwa klaim tentang model Codex OpenAI yang mencapai hasil SOTA di peringkat SWE-Bench Verified tidak sepenuhnya akurat. Dengan menganalisis data dan standar pengukuran yang berbeda, ia berpendapat bahwa dari sudut pandang mana pun, kinerja Codex pada benchmark spesifik tersebut masih kontroversial dan bukan yang terbaik tanpa keraguan. (Sumber: JayAlammar)

🧰 Tools

OpenAlpha_Evolve open-source: Mereplikasi agen desain algoritma AI Google: Setelah Google DeepMind merilis makalah AlphaEvolve, pengembang shyamsaktawat dengan cepat meluncurkan implementasi open-source OpenAlpha_Evolve. Kerangka kerja Python ini memungkinkan pengguna untuk bereksperimen dengan ide desain algoritma yang digerakkan oleh AI, termasuk definisi tugas, prompt engineering, pembuatan kode (dengan bantuan LLM seperti Gemini), pengujian eksekusi, evaluasi kebugaran, dan seleksi evolusioner, yang bertujuan untuk memungkinkan komunitas yang lebih luas berpartisipasi dalam menjelajahi garis depan AI dalam merancang algoritma baru. (Sumber: karminski3, Reddit r/artificial, Reddit r/LocalLLaMA)

Editor Cursor menambahkan fitur pengeditan cepat seluruh file: Editor kode yang mengutamakan AI, Cursor, mengumumkan bahwa pengguna sekarang dapat dengan cepat mengedit seluruh file. Fitur baru ini bertujuan untuk meningkatkan efisiensi kerja pengembang, membuat modifikasi dan refactoring kode skala besar di Cursor menjadi lebih mudah. (Sumber: cursor_ai)

Codex menyelesaikan tugas internasionalisasi dan lokalisasi aplikasi secara efisien: Pengembang Katsuya berbagi pengalamannya menggunakan OpenAI Codex untuk internasionalisasi aplikasi. Dia meminta Codex untuk melokalkan aplikasi ke bahasa Jepang, dan dalam semalam menyelesaikan tugas yang biasanya membutuhkan beberapa hari, sepenuhnya menunjukkan kemampuan kuat Codex dalam pembuatan kode otomatis dan penanganan tugas bahasa yang kompleks. (Sumber: gdb, ShunyuYao12)

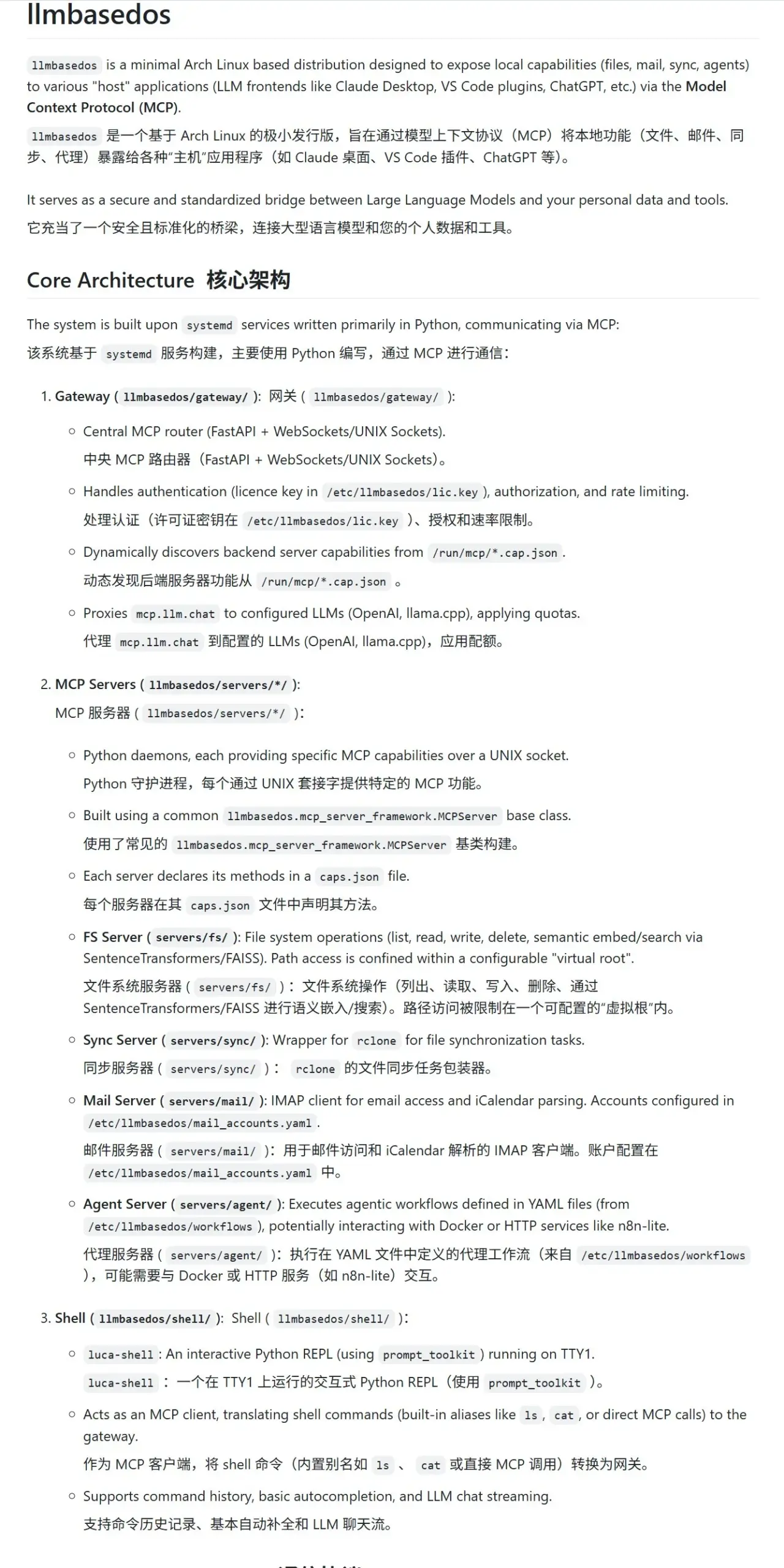

llmbasedos: Lingkungan sandbox MCP aman yang dirancang khusus untuk LLM: Proyek llmbasedos menyediakan lingkungan sistem operasi berbasis versi Arch Linux yang dipangkas, yang bertujuan untuk menyediakan sandbox Modular Computation Protocol (MCP) yang aman untuk large language model (LLM). Ini membungkus fungsi seperti sistem file, email, sinkronisasi, dan proxy sebagai layanan MCP. Pengguna dapat memanggil layanan ini setelah booting dari ISO melalui mesin virtual atau fisik, memfasilitasi interaksi dan pengembangan LLM yang aman. (Sumber: karminski3)

cachelm: Alat cache semantik LLM open-source meningkatkan efisiensi dan mengurangi biaya: Pengembang devanmolsharma meluncurkan alat open-source cachelm, lapisan cache semantik yang dirancang untuk aplikasi LLM. Ini mengimplementasikan cache berbasis kesamaan semantik melalui pencarian vektor, yang secara efektif dapat mengurangi panggilan berulang ke API LLM (bahkan jika pengguna mengajukan pertanyaan dengan susunan kata yang berbeda), sehingga mengurangi konsumsi Token dan mempercepat respons. Alat ini mendukung OpenAI, ChromaDB, Redis, ClickHouse, dll., dan memungkinkan pengguna untuk menyesuaikan vektorizer, database, atau LLM mereka sendiri. (Sumber: Reddit r/MachineLearning)

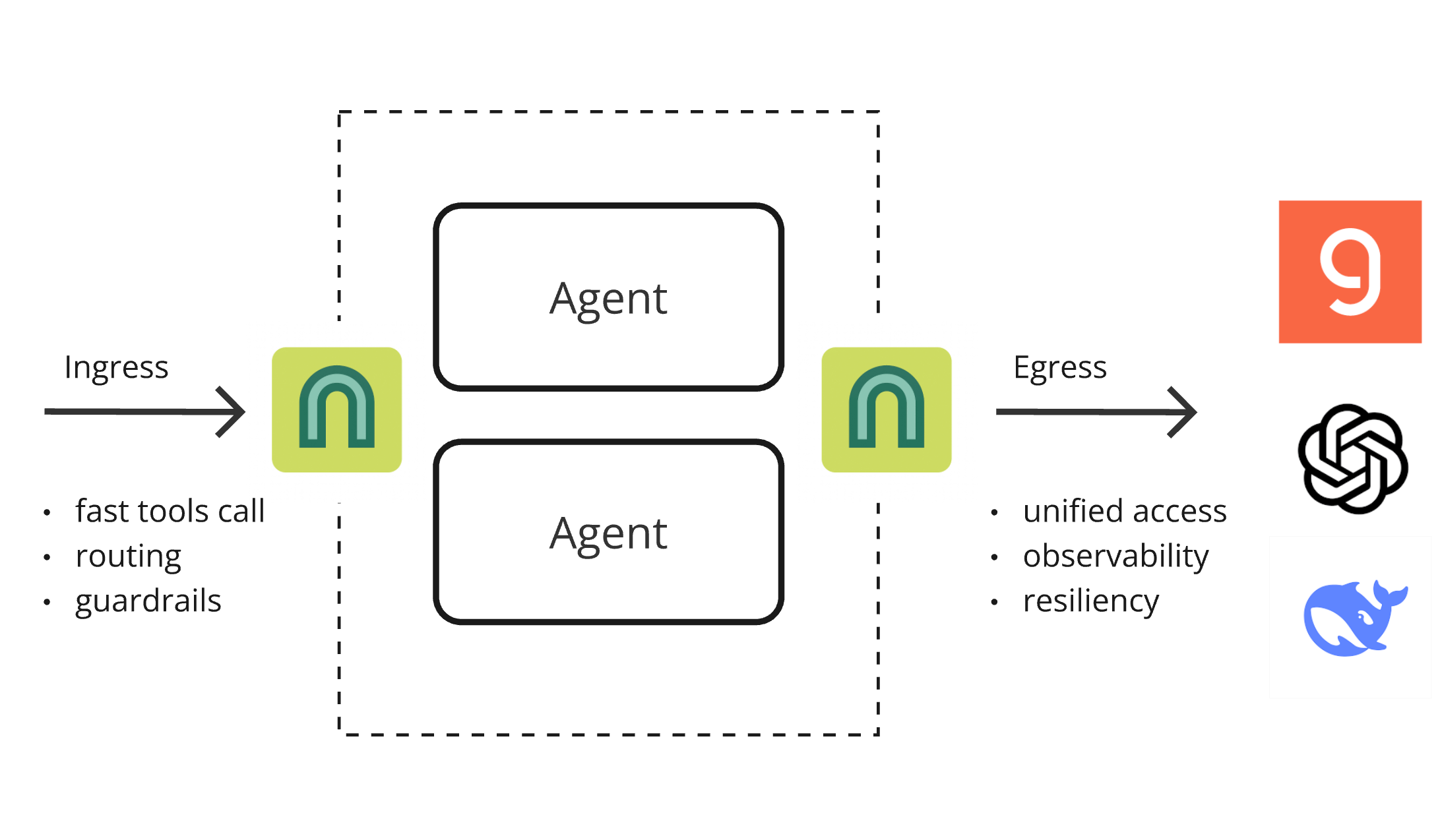

ArchGW 0.2.8 dirilis, proxy AI-native menyatukan fungsi tingkat bawah: ArchGW merilis versi 0.2.8, proxy AI-native berbasis Envoy ini bertujuan untuk menyatukan fungsi “tingkat bawah” yang berulang dalam aplikasi. Versi baru menambahkan dukungan untuk lalu lintas dua arah (sebagai persiapan untuk Google A2A), meningkatkan model Arch-Function-Chat 3B untuk perutean cepat dan pemanggilan alat, dan mendukung LLM yang dihosting di Groq. ArchGW, melalui metode proxy lokal, menyederhanakan pengembangan aplikasi AI, meningkatkan keamanan, konsistensi, dan observabilitas. (Sumber: Reddit r/artificial)

SparseDepthTransformer: Siswa SMA mengembangkan solusi peningkatan efisiensi Transformer dengan melewati lapisan secara dinamis: Seorang siswa SMA mengembangkan proyek bernama SparseDepthTransformer, yang mengevaluasi kepentingan semantik setiap Token melalui mekanisme penilaian ringan dan memungkinkan Token yang tidak penting untuk melewati perhitungan lapisan dalam Transformer. Eksperimen menunjukkan bahwa metode ini, sambil mempertahankan kualitas output, mengurangi penggunaan memori sekitar 15% dan menurunkan jumlah rata-rata lapisan pemrosesan Token sekitar 40%, memberikan ide baru untuk meningkatkan efisiensi Transformer. (Sumber: Reddit r/MachineLearning)

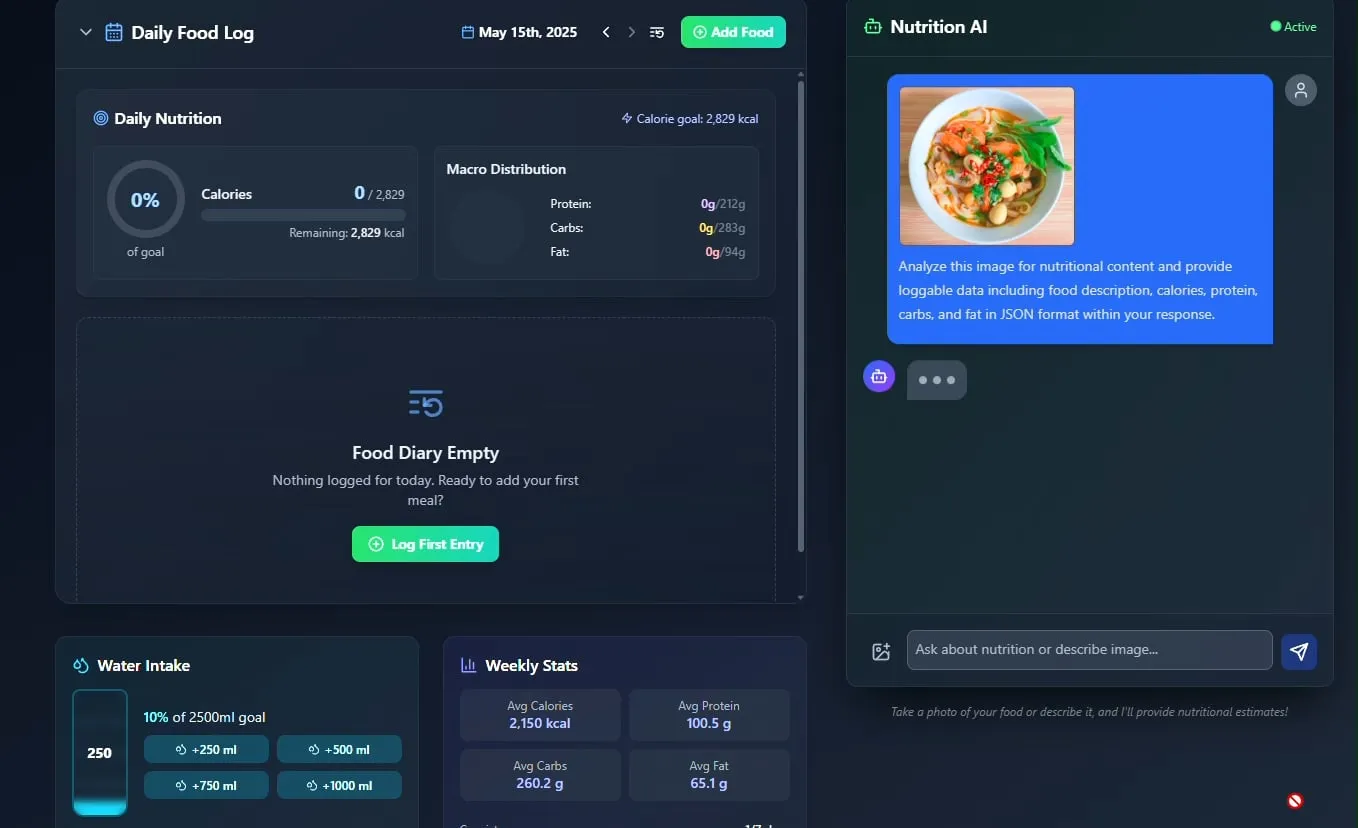

Pelacak makanan dan nutrisi AI diluncurkan, direncanakan akan di-open-source: Pengembang Pavankunchala menunjukkan aplikasi pelacak diet dan nutrisi yang digerakkan oleh AI. Fungsi inti aplikasi ini adalah mengidentifikasi makanan dan memperkirakan informasi nutrisi (kalori, protein, dll.) dengan menganalisis foto makanan yang diunggah pengguna, sekaligus mendukung pencatatan manual, ringkasan nutrisi harian, dan pelacakan asupan air. Pengembang berencana untuk membuat kode proyek ini open-source di masa depan. (Sumber: Reddit r/LocalLLaMA)

Agen AI Italia mengotomatiskan pencarian kerja, melamar seribu pekerjaan dalam satu menit memicu diskusi panas: Sebuah AI Agent yang diklaim berasal dari Italia menunjukkan kemampuan otomatisasi pencarian kerja yang kuat, mampu menyelesaikan 1000 lamaran kerja dalam 1 menit. Demonstrasi ini memicu diskusi luas di komunitas tentang penerapan AI di bidang rekrutmen, di satu sisi mengagumi efisiensinya, di sisi lain juga menyatakan keprihatinan tentang efektivitasnya, dampaknya pada pasar rekrutmen, dan bagaimana mengatasi masalah seperti “deteksi robot”. (Sumber: Reddit r/ChatGPT)

📚 Pembelajaran

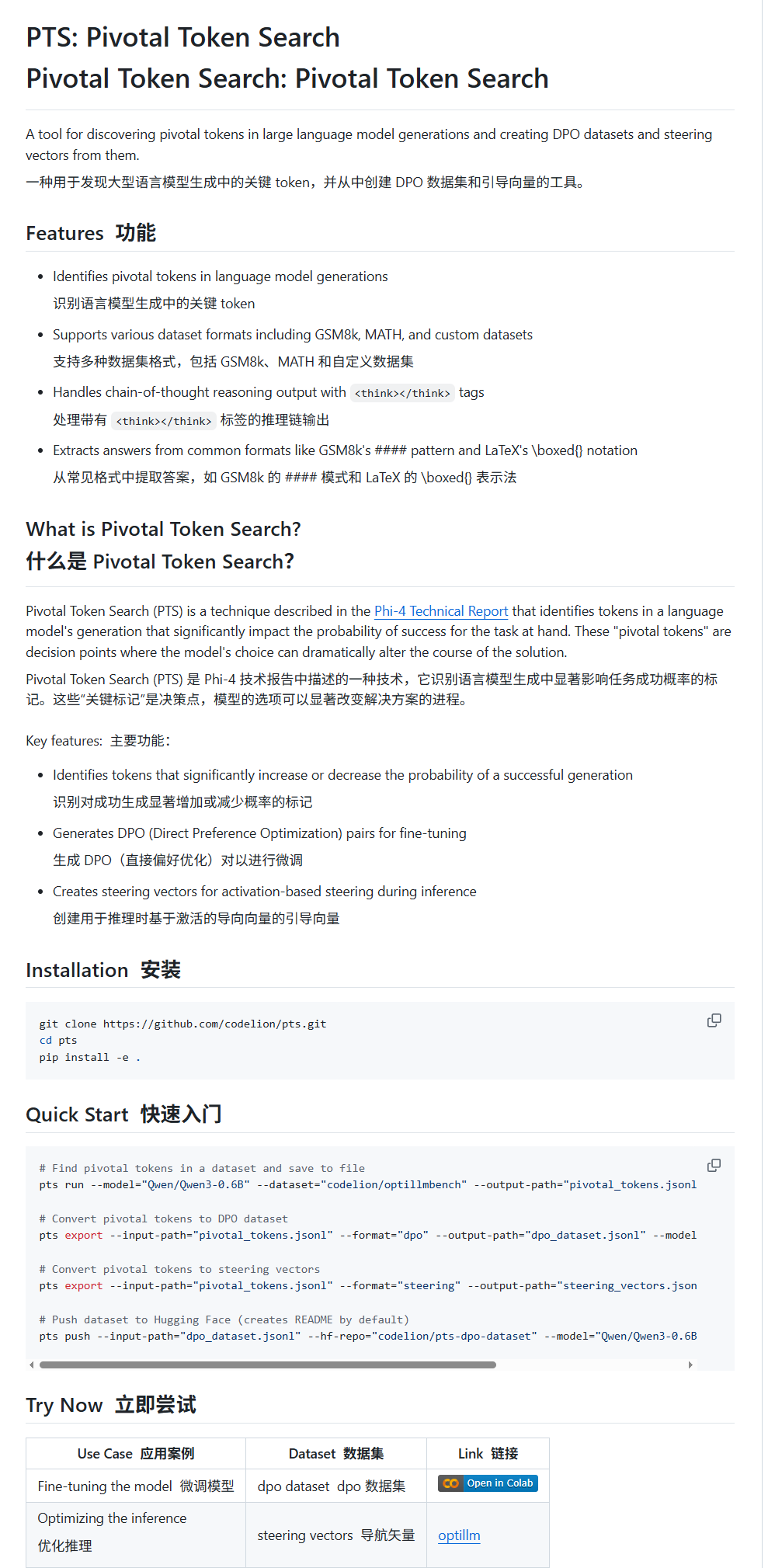

Pivotal Token Search (PTS): Teknik fine-tuning dan panduan LLM baru: karminski3 memperkenalkan teknik baru bernama PTS (Pivotal Token Search). Teknik ini didasarkan pada gagasan bahwa “titik keputusan kunci dari output model besar terletak pada beberapa Token kunci”. Dengan mengekstrak Token ini yang secara signifikan dapat memengaruhi kebenaran output (dibagi menjadi “Token yang dipilih” dan “Token yang ditolak”) untuk membangun dataset DPO untuk fine-tuning. Selain itu, PTS juga dapat mengekstrak pola aktivasi Token kunci untuk menghasilkan steering vectors, yang memandu perilaku model saat inferensi tanpa perlu fine-tuning. Metode ini diklaim terinspirasi oleh Phi4, dan efektivitasnya memicu diskusi komunitas. (Sumber: karminski3)

OpenAI Codex CLI menyediakan kuota API gratis, mendorong berbagi data: Akun pengembang OpenAI mengumumkan bahwa pengguna Plus atau Pro dapat menukarkan kuota API gratis dengan menjalankan npm i -g @openai/codex@latest dan codex --free. Selain itu, pengguna juga dapat memperoleh Token harian gratis dengan memilih untuk berbagi data di pengaturan platform guna meningkatkan dan melatih model OpenAI. Langkah ini bertujuan untuk mendorong pengembang menggunakan alat Codex dan berpartisipasi dalam peningkatan model. (Sumber: OpenAIDevs, fouad)

Kumpulan sumber belajar gratis Multi-Agent Systems (MAS): TheTuringPost mengumpulkan dan membagikan 7 sumber belajar gratis untuk Multi-Agent Systems (MAS). Ini termasuk tutorial CrewAI, kerangka kerja multi-agen CAMEL, dan tutorial multi-agen LangChain; sebuah buku berjudul “Multiagent Systems: Algorithmic, Game-Theoretic, and Logical Foundations”; dan tiga kursus online, masing-masing mencakup dari prompt hingga sistem multi-agen, menguasai pengembangan multi-agen menggunakan AutoGen, dan penggunaan praktis multi-AI agent dengan kasus penggunaan lanjutan menggunakan crewAI. (Sumber: TheTuringPost)

Tutorial klasifikasi gambar cepat menggunakan MobileNetV2: Pengguna Reddit Eran Feit membagikan tutorial Python untuk klasifikasi gambar menggunakan MobileNetV2. Tutorial ini memandu pengguna langkah demi langkah untuk memuat model MobileNetV2 yang telah dilatih sebelumnya, menggunakan OpenCV untuk pra-pemrosesan gambar (konversi BGR ke RGB, penskalaan ke 224×224, pemrosesan batch), melakukan inferensi, dan mendekode hasil prediksi untuk mendapatkan label dan probabilitas yang dapat dibaca manusia. Tutorial ini cocok untuk pemula yang ingin cepat memulai tugas klasifikasi gambar ringan. (Sumber: Reddit r/deeplearning)

Panduan implementasi RAG multi-sumber dan pencarian hibrida OpenWebUI dirilis: Situs web productiv-ai.guide merilis panduan langkah demi langkah yang terperinci untuk mengimplementasikan Retrieval Augmented Generation (RAG) multi-sumber dan Hybrid Search serta Re-ranking di OpenWebUI. Panduan ini bertujuan untuk membantu pengguna mengkonfigurasi dan memanfaatkan fitur RAG OpenWebUI, termasuk fitur re-ranking eksternal yang baru ditambahkan, untuk meningkatkan akurasi dan relevansi pencarian informasi. (Sumber: Reddit r/OpenWebUI)

💼 Bisnis

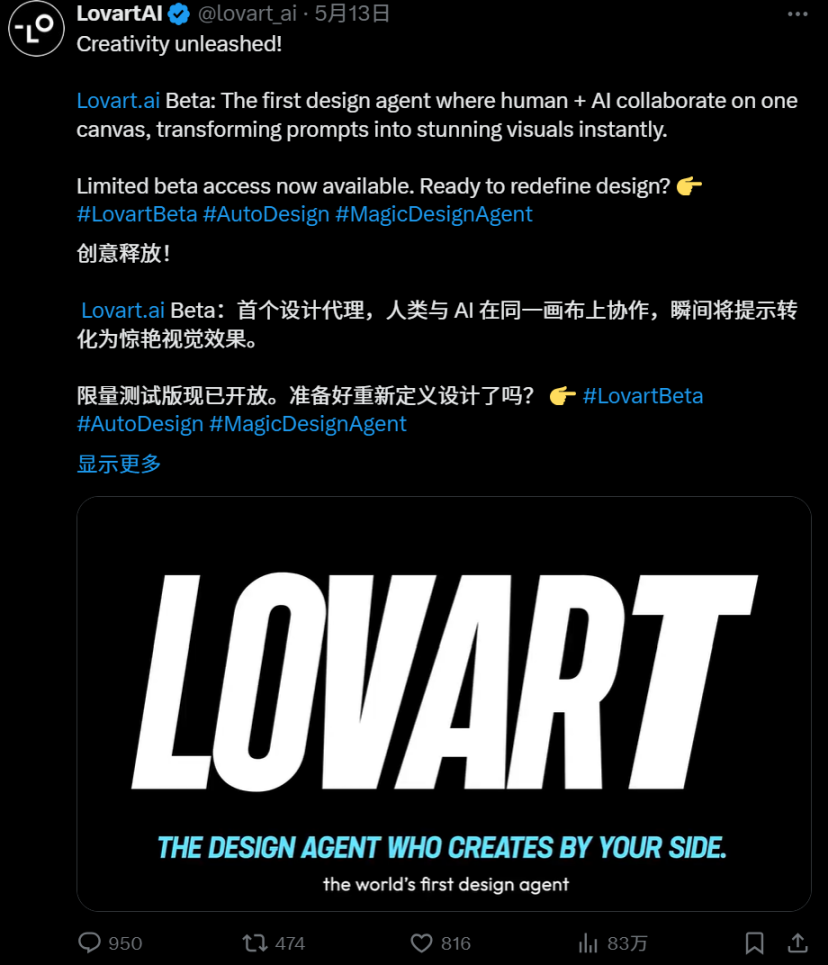

Persaingan ketat di jalur AI Agent: Perbandingan mendalam Manus dan Lovart: AI Agent di bidang desain vertikal, “Lovart”, menarik perhatian karena alur kerja “gaya penerimaan pesanan” yang unik. Ia mencoba mensimulasikan proses desain lengkap, mulai dari komunikasi kebutuhan hingga pengiriman materi berlapis, berbeda dengan logika “gaya penjadwalan” agen serbaguna “Manus”. Meskipun Lovart menunjukkan kinerja yang baik dalam pemahaman estetika desain, ekspresi konsep, dan organisasi informasi, serta lebih cepat dari Manus, keduanya menghadapi masalah stabilitas, pemrosesan bahasa Mandarin, dan keterkaitan modifikasi. Kemunculan Lovart dianggap sebagai arah yang benar bagi agen vertikal untuk mendalami skenario dan menginternalisasi pengalaman industri, menandakan bahwa AI Agent berpotensi untuk benar-benar diterapkan dalam industri konten. (Sumber: 36氪)

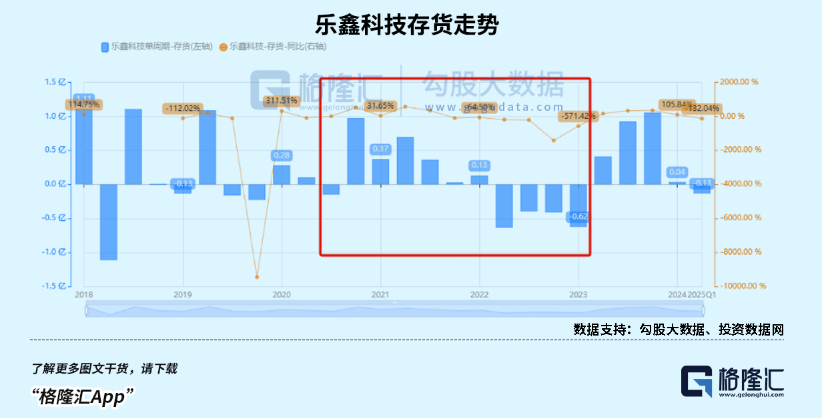

Pasar jam tangan pintar anak-anak sedang booming, tren AIoT mendorong pertumbuhan kinerja produsen chip SoC dalam negeri: Didorong oleh kebijakan stimulus konsumsi dan tren pengembangan AIoT, penjualan pasar perangkat wearable pintar Tiongkok (terutama jam tangan pintar anak-anak) meningkat pesat. Munculnya model besar open-source seperti DeepSeek menurunkan ambang batas untuk penerapan AI di sisi edge, mempercepat penetrasi AI ke terminal seperti peralatan rumah pintar dan earphone AI. Produsen chip SoC dalam negeri seperti Rockchip dan Bestechnic, dengan tata letak mereka dalam konsumsi daya rendah dan daya komputasi AI, serta chip andalan seperti Rockchip RK3588 yang mencakup berbagai skenario seperti PC, perangkat keras pintar, dan otomotif, telah mencapai pertumbuhan kinerja yang signifikan, dan valuasi mereka juga meningkat. (Sumber: 36氪)

OpenAI dilaporkan menyesuaikan rencana restrukturisasi perusahaan dan membantah keraguan atas sifat nirlabanya: Menurut pengungkapan Garrison Lovely, sebuah surat dari OpenAI kepada Jaksa Agung California yang sebelumnya tidak dilaporkan telah terungkap. Isi surat tersebut tidak hanya melibatkan detail tak terduga dari rencana restrukturisasi perusahaan OpenAI, tetapi juga menunjukkan bahwa OpenAI secara aktif mengambil langkah-langkah untuk membantah kritik dan keraguan yang ditujukan pada upayanya untuk melemahkan struktur tata kelola nirlaba perusahaan. (Sumber: NeelNanda5)

🌟 Komunitas

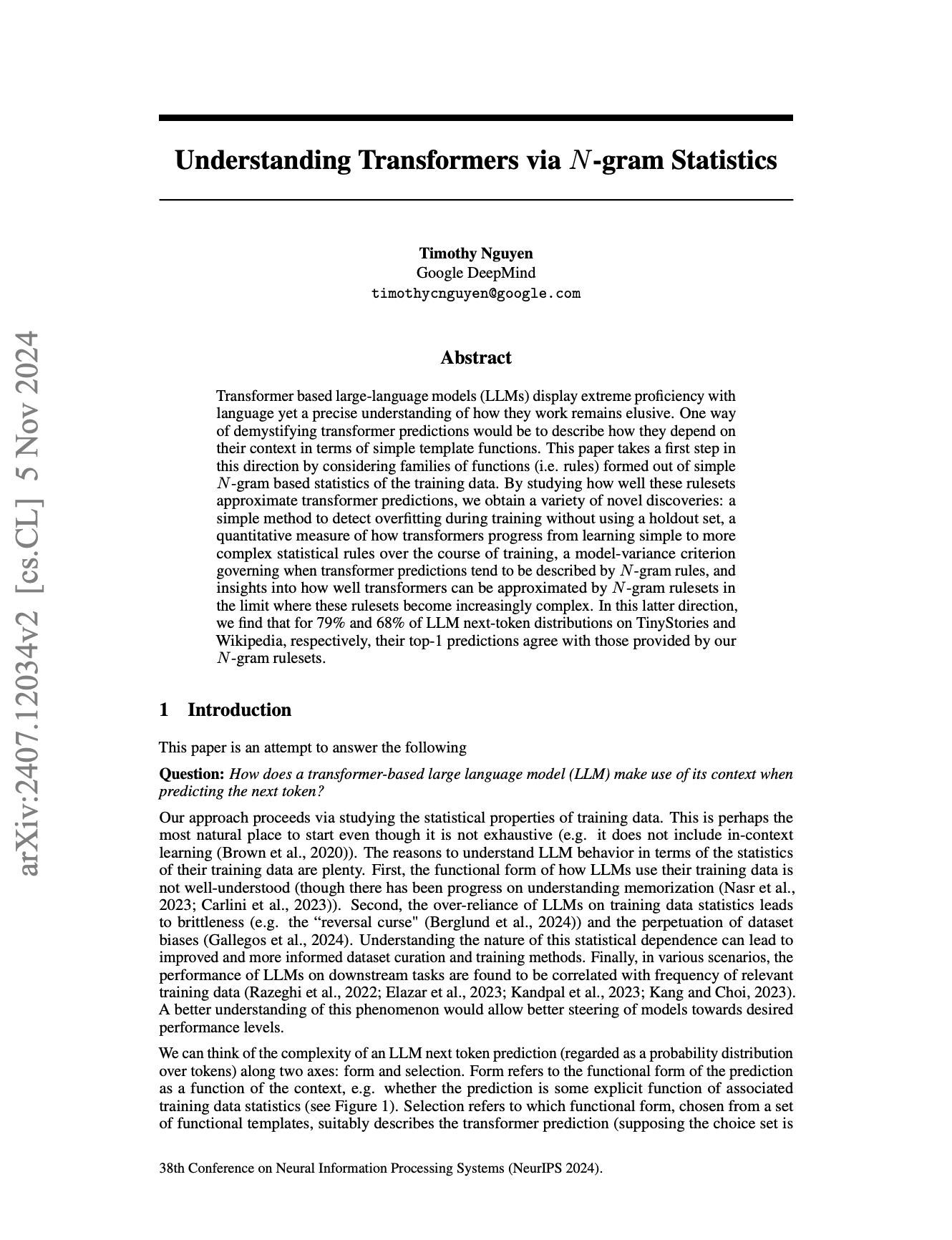

Sifat N-Gram LLM dan batas “kecerdasan” memicu diskusi panas: Komunitas terus membahas sejauh mana large language model (LLM) masih bergantung pada karakteristik statistik N-Gram, dan apakah LLM saat ini merupakan “AI sejati”. Ada pandangan (seperti komentar pmddomingos pada makalah NeurIPS jxmnop) yang percaya bahwa LLM dalam lebih dari 2/3 kasus berperilaku mirip dengan model N-Gram. Seorang ilmuwan data di Reddit memposting bahwa LLM saat ini kurang memiliki pemahaman, penalaran, dan akal sehat yang sebenarnya, masih jauh dari AGI (Artificial General Intelligence), dan pada dasarnya adalah “sistem prediksi kata berikutnya” yang kompleks, bukan agen cerdas yang memiliki kesadaran diri dan kemampuan beradaptasi. (Sumber: jxmnop, pmddomingos, Reddit r/ArtificialInteligence)

Gaya “selaput transparan” pada gambar yang dihasilkan AI dan gambar “Doubao” yang ambigu menarik perhatian: Baru-baru ini, sejumlah besar gambar dengan gaya tertentu yang dihasilkan oleh alat menggambar AI seperti Doubao muncul di media sosial, terutama gambar yang menampilkan efek bungkusan “selaput transparan”. Gambar-gambar ini, karena efek visualnya yang baru dan kemungkinan konten “ambigu” yang terlibat, telah memicu diskusi luas, peniruan, dan kreasi sekunder di antara pengguna, menjadi tren populer di bidang konten yang dihasilkan AI. (Sumber: op7418, dotey)

Etika dan masa depan AI: Membangun “Tuhan” atau penghancuran diri?: Komunitas terlibat dalam diskusi sengit tentang tujuan akhir pengembangan AI dan potensi risikonya. Emad Mostaque secara blak-blakan menyatakan bahwa beberapa orang mencoba membangun AGI seperti “Tuhan”, yang dapat membawa utopia atau kehancuran. CEO NVIDIA Jensen Huang membayangkan skenario masa depan di mana insinyur manusia berkolaborasi dengan 1000 AI untuk merancang chip. Sementara itu, diskusi yang dipicu oleh komik SMBC mengalihkan masalah kesadaran AI ke tingkat perlakuan etis yang lebih praktis — dapatkah kita memperlakukan “benda-benda” ini dengan hati nurani yang bersih? Pandangan-pandangan ini bersama-sama membentuk imajinasi yang kompleks tentang masa depan AI. (Sumber: Reddit r/artificial, Reddit r/artificial, Reddit r/artificial)

Apakah AI akan mengganggu model bisnis SaaS? Komunitas pengembang berdiskusi panas: Dengan mempopulernya alat pemrograman AI yang kuat seperti Claude Code, komunitas pengembang mulai membahas potensi dampaknya pada model bisnis SaaS (Software as a Service). Ada pandangan bahwa ambang batas bagi pengembang individu untuk mereplikasi fungsi inti produk SaaS yang ada menggunakan AI sedang menurun. Hal ini dapat menyebabkan perusahaan dan pengguna individu mengurangi ketergantungan mereka pada layanan SaaS tradisional dan beralih ke solusi buatan sendiri atau berbantuan AI yang lebih hemat biaya. Di masa depan, pengembangan perangkat lunak mungkin lebih bergantung pada manajemen mikro AI. (Sumber: Reddit r/ClaudeAI)

Perbedaan pemrosesan multibahasa AI menarik perhatian, pretokenizer Llama mungkin menjadi salah satu penyebabnya: Diskusi komunitas menunjukkan bahwa kinerja large language model (LLM) dalam bahasa Inggris biasanya lebih unggul daripada bahasa lain. Salah satu kemungkinan penyebabnya ditujukan pada cara pretokenizer model seperti Llama memproses teks non-Inggris (terutama karakter non-Latin). Misalnya, pretokenizer mungkin memecah karakter Tionghoa secara berlebihan menjadi unit-unit yang lebih kecil, yang memengaruhi pemahaman model terhadap struktur dan semantik bahasa, yang pada gilirannya menyebabkan penurunan kinerja dalam bahasa-bahasa tersebut. (Sumber: giffmana)

💡 Lainnya

Kerangka kerja DSPy menekankan pentingnya primitif tingkat bawah untuk pengembangan agen AI: Sejak kerangka kerja AI DSPy membuka sumber abstraksi intinya pada Januari 2023, hampir tidak ada perubahan yang dilakukan selain beberapa penyederhanaan kecil, dan tetap stabil melalui beberapa iterasi API LLM. Diskusi komunitas menunjukkan bahwa ini disebabkan oleh fokus DSPy pada pembangunan primitif tingkat bawah yang benar, daripada hanya mengejar pengalaman pengembang di permukaan atau kemudahan membangun “agen” dengan cepat. Ada pandangan bahwa banyak kerangka kerja pengembangan agen saat ini terlalu fokus pada kemudahan penggunaan dan mengabaikan kekokohan blok bangunan dasar, sedangkan filosofi DSPy adalah memiliki dasar “reaksi” yang kokoh terlebih dahulu sebelum dapat membangun perilaku “agen” yang kompleks. (Sumber: lateinteraction, lateinteraction)

Kelelahan estetika konten yang dihasilkan AI mendorong permintaan model yang disesuaikan: Diskusi komunitas berpendapat bahwa banyak model generasi gambar yang dioptimalkan melalui reinforcement learning (RL) saat ini menghasilkan output yang cenderung “biasa-biasa saja” atau “norak”. Meskipun secara teknis tampak bagus, output tersebut kurang memiliki kreativitas dan individualitas yang menarik. Hal ini mencerminkan bahwa tujuan optimasi model mungkin cenderung pada preferensi estetika rata-rata masyarakat, bukan pengejaran artistik yang unik. Oleh karena itu, model yang disesuaikan dan metode yang mampu mengambil sampel berdasarkan tujuan estetika individu di masa depan dianggap sebagai kunci untuk mengatasi masalah ini dan menciptakan konten AI yang lebih menarik. (Sumber: torchcompiled)

Ollama merilis mesin multimodal, pengguna OpenWebUI memperhatikan kompatibilitas: Ollama mengumumkan perilisan resmi mesin multimodalnya, berita ini menarik perhatian pengguna komunitas OpenWebUI. Pengguna umumnya khawatir apakah OpenWebUI akan dapat mendukung mesin multimodal baru Ollama “langsung dari kotak”, yaitu, tanpa perlu melakukan perubahan konfigurasi yang rumit untuk memanfaatkan kemampuannya dalam memproses berbagai jenis data seperti gambar dan teks. (Sumber: Reddit r/OpenWebUI)