Kata Kunci:OpenAI Codex, Pengembangan Perangkat Lunak AI, Model Multimodal, Generasi Suara AI, Penyaringan Data, Codex Research Preview, MiniMax Speech-02, Model Multimodal BLIP3-o, Penyaringan Data PreSelect, Seri Model SWE-1

🔥 Fokus

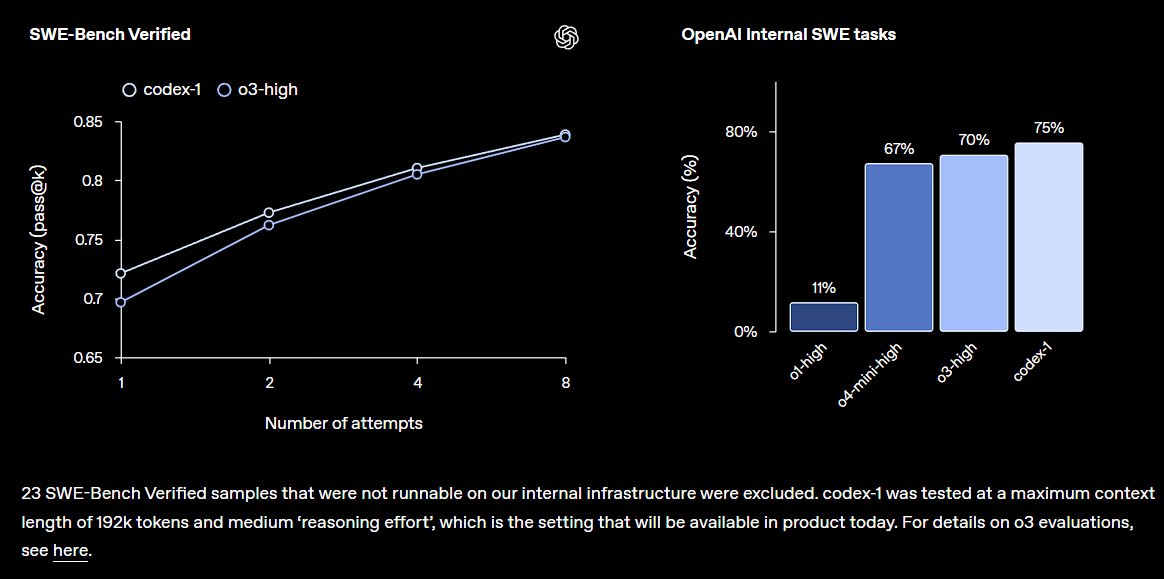

OpenAI merilis versi pratinjau riset Codex, terintegrasi ke dalam ChatGPT: OpenAI meluncurkan Codex, sebuah agen rekayasa perangkat lunak berbasis cloud, yang dapat memahami codebase besar, menulis fitur baru, memperbaiki bug, dan dapat memproses beberapa tugas secara paralel. Codex didasarkan pada model codex-1 yang di-fine-tuning dengan o3, dan menunjukkan kinerja yang sangat baik di SWE-bench. Fitur ini akan secara bertahap dibuka untuk pengguna ChatGPT Pro, Team, dan Enterprise, yang bertujuan untuk meningkatkan produktivitas developer secara signifikan, menandakan bahwa AI akan memainkan peran yang lebih inti dalam bidang pengembangan perangkat lunak. Komunitas memberikan reaksi positif terhadap hal ini, tetapi juga menyoroti efektivitas aktual dan potensi bug (Sumber: OpenAI, OpenAI Developers, scaling01, dotey)

PHK skala besar Microsoft guncang industri, percepat transformasi organisasi berbasis AI: Microsoft mengumumkan PHK global terhadap sekitar 6.000 karyawan, bertujuan untuk menyederhanakan jenjang manajemen dan meningkatkan proporsi programmer. Sebagian karyawan yang di-PHK termasuk veteran dengan masa kerja 25 tahun dan kontribusi luar biasa, serta developer inti TypeScript. PHK kali ini dianggap terkait dengan peningkatan efisiensi teknologi AI dan otomatisasi sebagian tugas kerja, yang mencerminkan tren raksasa teknologi dalam mengendalikan biaya dan mengoptimalkan struktur sumber daya manusia di era AI. Peristiwa ini memicu diskusi luas tentang dampak AI terhadap pasar kerja, loyalitas perusahaan, dan model kerja di masa depan (Sumber: WeChat, NeelNanda5)

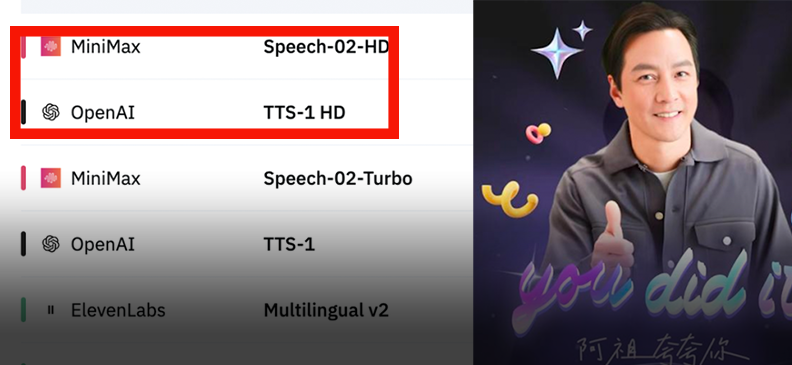

MiniMax merilis model suara Speech-02, puncaki peringkat global: MiniMax meluncurkan model suara generasi baru Speech-02, yang meraih peringkat pertama dalam dua evaluasi suara otoritatif, Artificial Analysis Speech Arena dan Hugging Face TTS Arena, melampaui OpenAI dan ElevenLabs. Model ini menonjol dalam aspek super-realistis, kustomisasi warna suara yang dipersonalisasi (mendukung 32 bahasa dan aksen, dapat mereplikasi dengan referensi beberapa detik), dan keragaman, serta secara inovatif mengadopsi teknologi Flow-VAE untuk meningkatkan detail kloning. Teknologinya telah diterapkan dalam skenario seperti “AI Ah Zu” belajar bahasa Inggris dan pemandu AI Kota Terlarang, menunjukkan posisi terdepan model besar domestik dalam bidang generasi suara AI (Sumber: WeChat, WeChat)

Salesforce dan institusi lain merilis model multimodal terpadu BLIP3-o: Salesforce Research bersama beberapa universitas merilis model multimodal terpadu open source BLIP3-o, yang mengadopsi strategi “pahami dulu baru hasilkan”, menggabungkan arsitektur autoregresif dan difusi. Model ini secara inovatif menggunakan fitur CLIP dan Flow Matching untuk pelatihan, secara signifikan meningkatkan kualitas, keragaman, dan kemampuan penyelarasan prompt dari gambar yang dihasilkan. BLIP3-o menunjukkan kinerja yang sangat baik dalam beberapa benchmark dan sedang diperluas ke tugas multimodal kompleks seperti pengeditan gambar dan dialog visual, mendorong pengembangan teknologi AI multimodal (Sumber: 36氪)

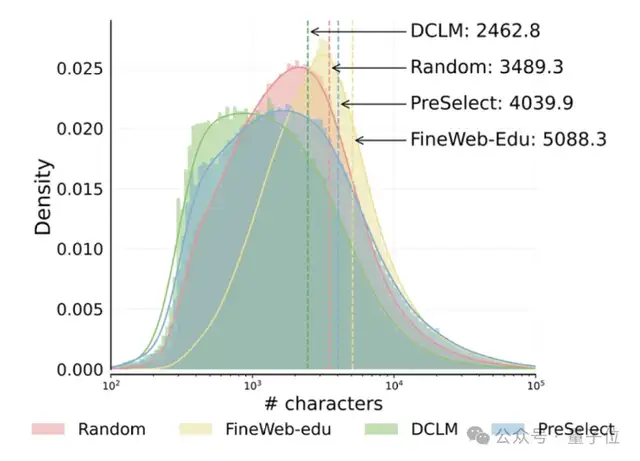

HKUST dan vivo mengusulkan skema penyaringan data PreSelect, tingkatkan efisiensi pra-pelatihan 10 kali lipat: Hong Kong University of Science and Technology (HKUST) bekerja sama dengan vivo AI Lab mengusulkan metode pemilihan data yang ringan dan efisien, PreSelect, yang telah diterima oleh ICML 2025. Metode ini mengukur kontribusi data terhadap kemampuan spesifik model melalui indikator “kekuatan prediksi”, menggunakan fastText scorer untuk menyaring seluruh data pelatihan, dan dapat meningkatkan efek model rata-rata sebesar 3% sambil mengurangi kebutuhan komputasi sebanyak 10 kali lipat. PreSelect bertujuan untuk menyaring data berkualitas tinggi dan beragam secara lebih objektif dan general, mengatasi keterbatasan metode penyaringan tradisional berbasis aturan atau model (Sumber: 量子位)

🎯 Perkembangan

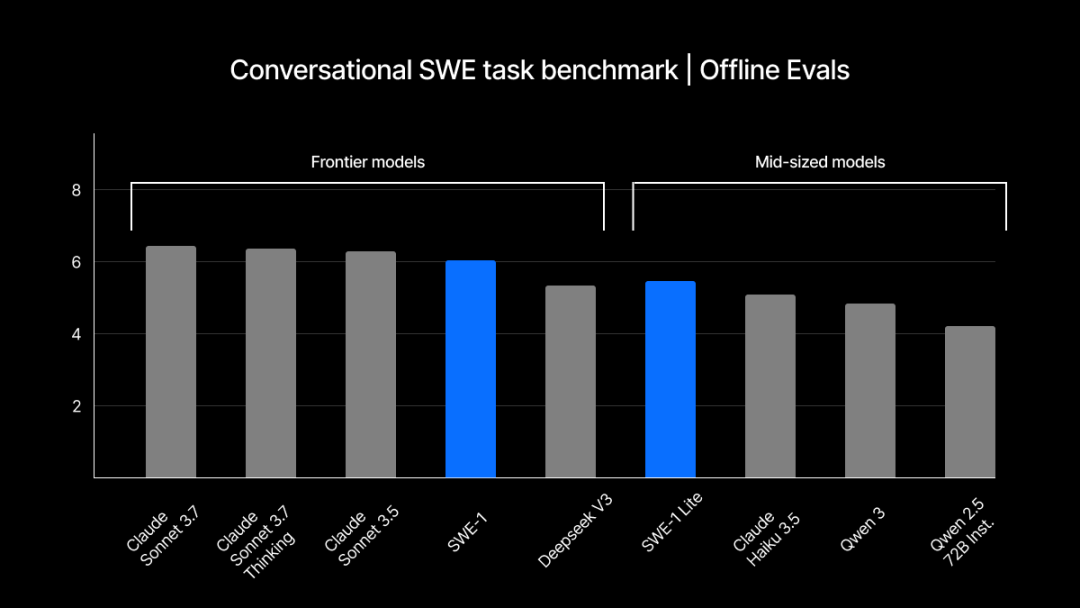

Windsurf merilis seri model SWE-1 yang dikembangkan sendiri, optimalkan alur kerja rekayasa perangkat lunak: Windsurf meluncurkan seri model pertama yang dioptimalkan khusus untuk rekayasa perangkat lunak, SWE-1, yang bertujuan untuk meningkatkan efisiensi pengembangan sebesar 99%. Seri ini mencakup SWE-1 (kemampuan pemanggilan alat mendekati Claude 3.5 Sonnet, dengan biaya lebih rendah), SWE-1-lite (kualitas tinggi, pengganti Cascade Base), dan SWE-1-mini (kecil dan cepat, untuk skenario latensi rendah). Inovasi intinya terletak pada sistem “Flow Awareness”, yaitu AI berbagi timeline operasi dengan pengguna, mewujudkan kolaborasi yang efisien dan pemahaman terhadap status yang belum selesai (Sumber: WeChat, WeChat)

Mekanisme memori ChatGPT direkayasa balik, ungkap tiga subsistem memori: Fitur memori “riwayat obrolan” yang diluncurkan OpenAI untuk ChatGPT dianalisis oleh penggemar teknologi, mengungkapkan kemungkinan adanya tiga subsistem: riwayat percakapan saat ini, catatan riwayat percakapan (berdasarkan ringkasan dan pencarian konten), dan wawasan pengguna (dihasilkan berdasarkan analisis multi-percakapan, dengan tingkat kepercayaan). Mekanisme ini bertujuan untuk memberikan pengalaman interaksi yang lebih personal dan efisien, diimplementasikan melalui teknologi seperti RAG dan ruang vektor. Meskipun pihak resmi mengklaim dapat meningkatkan pengalaman pengguna, umpan balik komunitas beragam, dengan sebagian pengguna melaporkan fungsi yang tidak stabil atau adanya bug (Sumber: WeChat, 量子位)

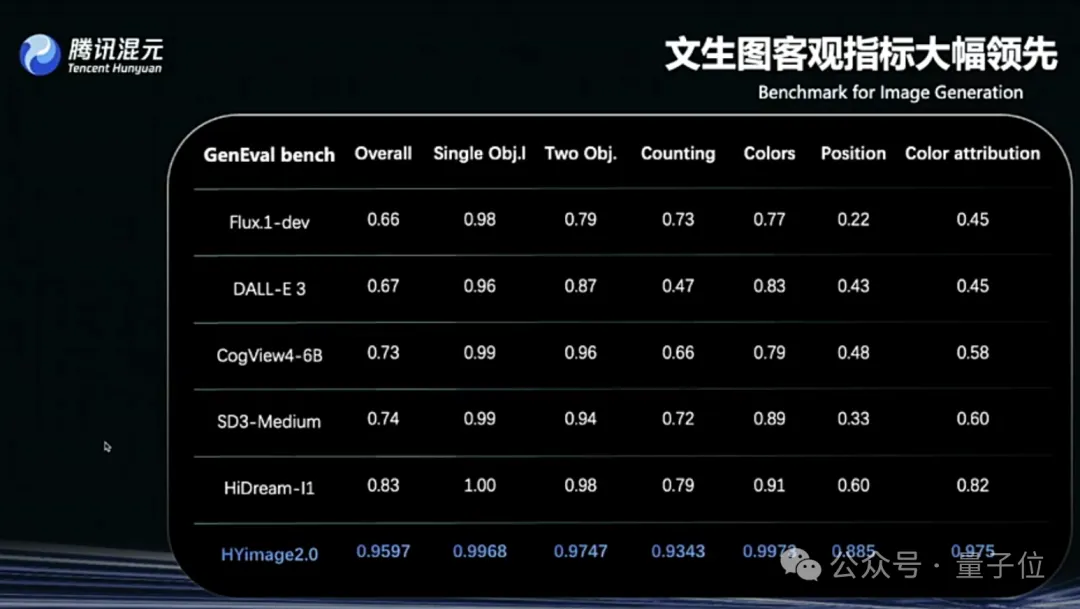

Tencent Hunyuan Image 2.0 dirilis, mendukung “melukis sambil berbicara” secara real-time: Tencent Hunyuan meluncurkan model Hunyuan Image 2.0, yang mewujudkan fungsi text-to-image real-time dengan respons tingkat milidetik. Saat pengguna memasukkan teks atau deskripsi suara, gambar akan dihasilkan dan disesuaikan secara real-time. Model baru ini juga mendukung papan lukis real-time, di mana pengguna dapat membuat sketsa tangan yang dikombinasikan dengan deskripsi teks untuk menghasilkan gambar. Model ini menunjukkan peningkatan signifikan dalam realisme, kepatuhan semantik (beradaptasi dengan model bahasa besar multimodal sebagai encoder teks), dan rasio kompresi codec gambar, serta dioptimalkan melalui pelatihan penguatan pasca-pelatihan (Sumber: 量子位)

TII merilis seri model BitNet Falcon-Edge dan pustaka fine-tuning onebitllms: TII meluncurkan Falcon-Edge, serangkaian model bahasa ringkas dengan parameter 1B dan 3B, dengan ukuran masing-masing hanya 600MB dan 900MB. Model-model ini menggunakan arsitektur BitNet, yang dapat dipulihkan ke bfloat16 hampir tanpa kehilangan kinerja. Hasil awal menunjukkan kinerjanya lebih unggul dari model kecil lainnya dan sebanding dengan Qwen3-1.7B, tetapi dengan penggunaan memori hanya 1/4nya. Pustaka onebitllms yang dirilis bersamaan dikhususkan untuk fine-tuning model BitNet (Sumber: Reddit r/LocalLLaMA, winglian)

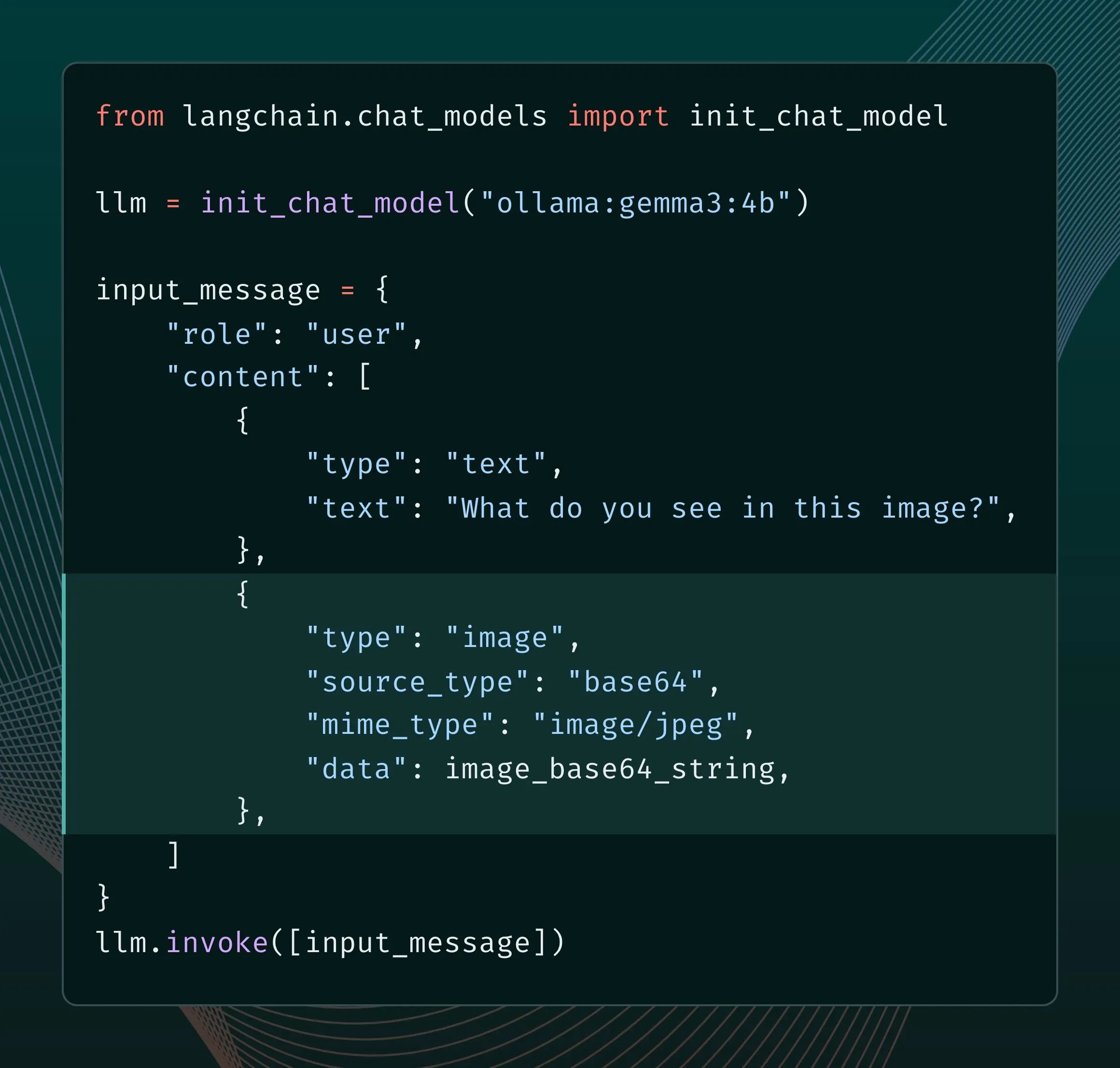

Mesin baru Ollama tingkatkan dukungan multimodal: Ollama memperbarui mesinnya untuk memberikan dukungan native bagi model multimodal, memungkinkan optimasi spesifik model dan meningkatkan manajemen memori. Pengguna dapat mencoba model multimodal seperti Llama 4, Gemma 3 melalui integrasi LangChain. Developer Google AI juga merilis panduan penggunaan Ollama dan Gemma 3 untuk pemanggilan fungsi, guna mewujudkan fitur seperti pencarian real-time (Sumber: LangChainAI, ollama)

Grok menambahkan fitur kontrol rasio aspek pembuatan gambar: Model Grok dari xAI sekarang memungkinkan pengguna untuk menentukan rasio aspek yang diinginkan saat membuat gambar, memberikan fleksibilitas dan kontrol yang lebih besar dalam pembuatan gambar (Sumber: grok)

Google AI Studio diperbarui, tambahkan halaman media generatif dan dasbor penggunaan: Platform ai.studio Google melakukan serangkaian pembaruan, termasuk desain halaman arahan baru, dasbor penggunaan bawaan, dan halaman media generatif (gen media) baru, yang mengisyaratkan kemungkinan akan ada lebih banyak rilis terkait pada konferensi I/O mendatang (Sumber: matvelloso)

LatitudeGames merilis model baru Harbinger-24B (New Wayfarer): LatitudeGames merilis model baru bernama Harbinger-24B di Hugging Face, dengan nama kode New Wayfarer. Komunitas menaruh perhatian pada hal ini dan membahas mengapa tidak memilih untuk melakukan fine-tuning pada model lain seperti Qwen3 32B atau Llama 4 Scout (Sumber: Reddit r/LocalLLaMA)

🧰 Alat

Adopt AI raih pendanaan 6 juta USD, bertujuan merekonstruksi interaksi perangkat lunak melalui AI Agent: Perusahaan startup Adopt AI meraih pendanaan tahap awal sebesar 6 juta USD, berdedikasi untuk memungkinkan perangkat lunak perusahaan tradisional mengintegrasikan kemampuan interaksi bahasa alami secara cepat tanpa kode melalui dua fungsi utama: Agent Builder dan Agent Experience. Teknologinya dapat secara otomatis mempelajari struktur aplikasi dan API, menghasilkan operasi yang dapat dipanggil oleh bahasa alami, dan menjamin keamanan data melalui arsitektur Pass-through, bertujuan untuk meningkatkan tingkat adopsi dan efisiensi perangkat lunak, serta mengurangi biaya perusahaan (Sumber: WeChat)

Volcano Engine ByteDance meluncurkan Demo perangkat keras AI mini, mendukung kustomisasi tinggi: Volcano Engine merilis Demo perangkat keras AI mini dan membuat kode klien/servernya menjadi open source. Perangkat keras ini mendukung kustomisasi tingkat tinggi, dapat dihubungkan dengan model besar Volcano, agen Coze, serta model besar pihak ketiga yang kompatibel dengan API OpenAI (seperti FastGPT) dan berbagai suara TTS (termasuk MiniMax). Pengguna dapat melakukan DIY untuk mewujudkan percakapan dengan karakter tertentu (seperti Jay Chou muda, He Jiong), atau membangun aplikasi seperti layanan pelanggan suara AI, menyediakan pengalaman interaksi AI yang kaya (Sumber: WeChat)

Runway merilis Gen-4 References API, memberdayakan developer membangun aplikasi pembuatan gambar: Runway membuka model pembuatan gambar Gen-4 References yang populer melalui API untuk para developer. Model ini terkenal karena universalitas dan fleksibilitasnya, mampu menghasilkan gambar baru yang konsisten secara gaya berdasarkan gambar referensi. Rilis API ini akan memungkinkan developer untuk mengintegrasikan kemampuan pembuatan gambar yang kuat ini ke dalam aplikasi dan alur kerja mereka sendiri (Sumber: c_valenzuelab)

Zencoder meluncurkan platform agen AI cerdas untuk optimasi pengkodean, Zen Agents: Perusahaan startup AI Zencoder (nama resmi For Good AI Inc.) merilis platform cloud bernama Zen Agents, yang digunakan untuk membuat agen AI yang dioptimalkan untuk tugas pengkodean, bertujuan untuk meningkatkan efisiensi dan kualitas pengembangan perangkat lunak (Sumber: dl_weekly)

llmbasedos: Distribusi Linux minimalis berbasis MCP, dioptimalkan khusus untuk LLM lokal: Seorang developer membangun llmbasedos, sebuah distribusi minimalis berbasis Arch Linux, yang bertujuan untuk mengubah lingkungan lokal menjadi warga kelas satu untuk frontend LLM (seperti Claude Desktop, VS Code). Ini mengekspos kemampuan lokal (file, email, proxy, dll.) melalui protokol MCP (Model Context Protocol), mendukung mode offline (termasuk llama.cpp) atau terhubung ke model cloud seperti GPT-4o, Claude, memudahkan developer untuk menambahkan fitur baru dengan cepat (Sumber: Reddit r/LocalLLaMA)

File PDF dapat menjalankan LLM dan sistem Linux menarik perhatian: Penggemar teknologi Aiden Bai mendemonstrasikan proyek “llm.pdf” yang menjalankan model bahasa kecil (seperti TinyStories, Pythia, TinyLLM) di dalam file PDF, dengan mengkompilasi model menjadi JavaScript dan memanfaatkan dukungan PDF untuk JS. Di kolom komentar, ada yang menunjukkan bahwa sebelumnya sudah ada preseden menjalankan sistem Linux di dalam PDF (melalui emulator RISC-V). Hal ini mengungkapkan potensi PDF sebagai wadah konten dinamis, tetapi juga menimbulkan diskusi tentang keamanan dan kepraktisan (Sumber: WeChat)

Alat OpenAI Codex CLI diperbarui, dukung login ChatGPT dan model mini baru: Tim developer OpenAI mengumumkan peningkatan pada alat Codex CLI, termasuk dukungan login melalui akun ChatGPT untuk koneksi cepat ke organisasi API, dan penambahan model codex-mini, yang dioptimalkan khusus untuk tugas tanya jawab kode dan pengeditan dengan latensi rendah (Sumber: openai, dotey)

Mesin all-in-one model besar SenseTime direkomendasikan IDC, dukung model seperti Rìrìxīn dan DeepSeek: Dalam laporan “Analisis Pasar dan Rekomendasi Merek Mesin All-in-One Model AI Besar Tiongkok, 2025” yang dirilis IDC, mesin all-in-one model besar SenseTime terpilih. Mesin ini didasarkan pada infrastruktur AI SenseTime Big Device, dilengkapi dengan chip komputasi berkinerja tinggi dan mesin akselerasi inferensi, mendukung model besar mainstream seperti “Rìrìxīn SenseNova V6” SenseTime dan DeepSeek, menyediakan solusi mandiri dan terkontrol penuh, mengoptimalkan total biaya kepemilikan (TCO), dan telah diterapkan di berbagai industri seperti medis dan keuangan (Sumber: 量子位)

Alat otomatisasi alur kerja open source n8n tambahkan dukungan bahasa Mandarin: Alat otomatisasi alur kerja open source populer n8n kini mendukung antarmuka bahasa Mandarin melalui paket lokalisasi yang dikontribusikan oleh komunitas. Pengguna dapat mengunduh file lokalisasi versi yang sesuai dan, melalui modifikasi konfigurasi Docker sederhana, dapat menggunakan n8n dalam bahasa Mandarin, menurunkan hambatan penggunaan bagi pengguna domestik (Sumber: WeChat)

git-bug: Pelacak bug terdistribusi offline-first yang disematkan di Git: git-bug adalah alat open source yang menyematkan masalah, komentar, dll. sebagai objek di dalam repositori Git (bukan file biasa), mewujudkan pelacakan bug terdistribusi dan offline-first. Ini mendukung sinkronisasi masalah dengan platform seperti GitHub, GitLab melalui jembatan, dan menyediakan antarmuka CLI, TUI, dan Web (Sumber: GitHub Trending)

PyLate integrasikan indeks PLAID, tingkatkan efisiensi benchmark model pada dataset skala besar: Antoine Chaffin mengumumkan bahwa PyLate (ekosistem pelatihan dan inferensi untuk model ColBERT) telah menggabungkan indeks PLAID. Integrasi ini memungkinkan pengguna untuk secara efektif melakukan benchmark pada model terbaik mereka pada dataset skala sangat besar, memberikan kemudahan untuk mencapai SOTA di berbagai peringkat pencarian (Sumber: lateinteraction, tonywu_71)

Neon: Database PostgreSQL serverless open source: Neon adalah alternatif PostgreSQL serverless open source, yang memisahkan penyimpanan dan komputasi untuk mencapai penskalaan otomatis, percabangan database sebagai kode, dan fitur penskalaan hingga nol. Proyek ini mendapat perhatian di GitHub, menyediakan pilihan baru bagi developer AI dan aplikasi lain yang membutuhkan solusi database elastis dan dapat diskalakan (Sumber: GitHub Trending)

Unmute.sh: Alat obrolan suara AI baru dengan prompt dan suara yang dapat disesuaikan: Unmute.sh adalah alat obrolan suara AI baru yang diluncurkan, yang fiturnya memungkinkan pengguna untuk menyesuaikan prompt dan memilih suara yang berbeda, memberikan pengalaman interaksi suara yang lebih personal dan fleksibel kepada pengguna (Sumber: Reddit r/artificial)

📚 Belajar

Framework evaluasi model generalis multimodal pertama di dunia General-Level dan benchmark General-Bench dirilis: Sebuah penelitian yang diterima di ICML‘25 (Spotlight) mengusulkan framework evaluasi model besar multimodal (MLLM) baru, General-Level, beserta dataset pendampingnya, General-Bench. Framework ini memperkenalkan sistem peringkat lima tingkat, yang inti penilaiannya adalah “efek generalisasi sinergis” (Synergy) model, yaitu kemampuan transfer pengetahuan untuk meningkatkan kinerja antar modalitas atau tugas yang berbeda. General-Bench saat ini merupakan benchmark evaluasi MLLM terbesar dan paling komprehensif, berisi lebih dari 700 tugas, lebih dari 320.000 data uji, mencakup lima modalitas utama (gambar, video, audio, 3D, dan bahasa) dan 29 domain. Papan peringkat menunjukkan bahwa model seperti GPT-4V saat ini hanya mencapai Level-2 (tanpa sinergi), dan belum ada model yang mencapai Level-5 (sinergi penuh semua modalitas) (Sumber: WeChat)

Makalah J1 mengusulkan untuk mendorong LLM-as-a-Judge berpikir melalui reinforcement learning: Sebuah makalah baru berjudul “J1: Incentivizing Thinking in LLM-as-a-Judge via RL” (arxiv:2505.10320) membahas bagaimana memanfaatkan reinforcement learning (RL) untuk mendorong model bahasa besar yang berfungsi sebagai penilai (LLM-as-a-Judge) untuk melakukan “pemikiran” yang lebih mendalam, daripada hanya memberikan penilaian dangkal. Metode ini berpotensi meningkatkan akurasi dan keandalan LLM dalam mengevaluasi tugas-tugas kompleks (Sumber: jaseweston)

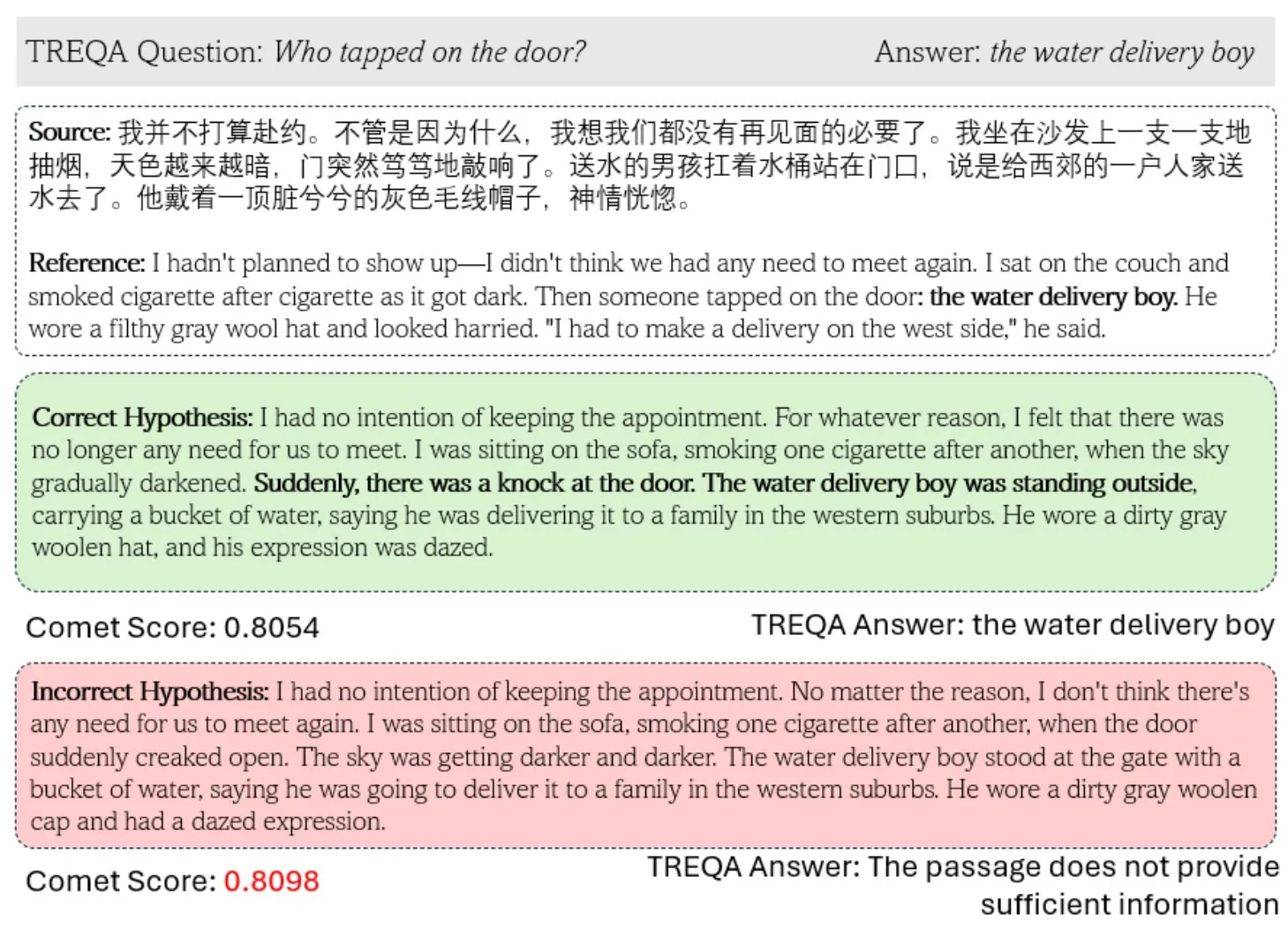

Framework baru TREQA memanfaatkan LLM untuk mengevaluasi kualitas terjemahan teks kompleks: Menanggapi kekurangan metrik terjemahan mesin (MT) yang ada dalam mengevaluasi teks kompleks, para peneliti mengusulkan framework TREQA. Framework ini menggunakan model bahasa besar (LLM) untuk menghasilkan pertanyaan tentang teks sumber dan teks terjemahan, dan membandingkan jawaban atas pertanyaan-pertanyaan tersebut untuk mengevaluasi apakah terjemahan mempertahankan informasi penting. Metode ini bertujuan untuk mengukur kualitas terjemahan teks panjang secara lebih komprehensif (Sumber: gneubig)

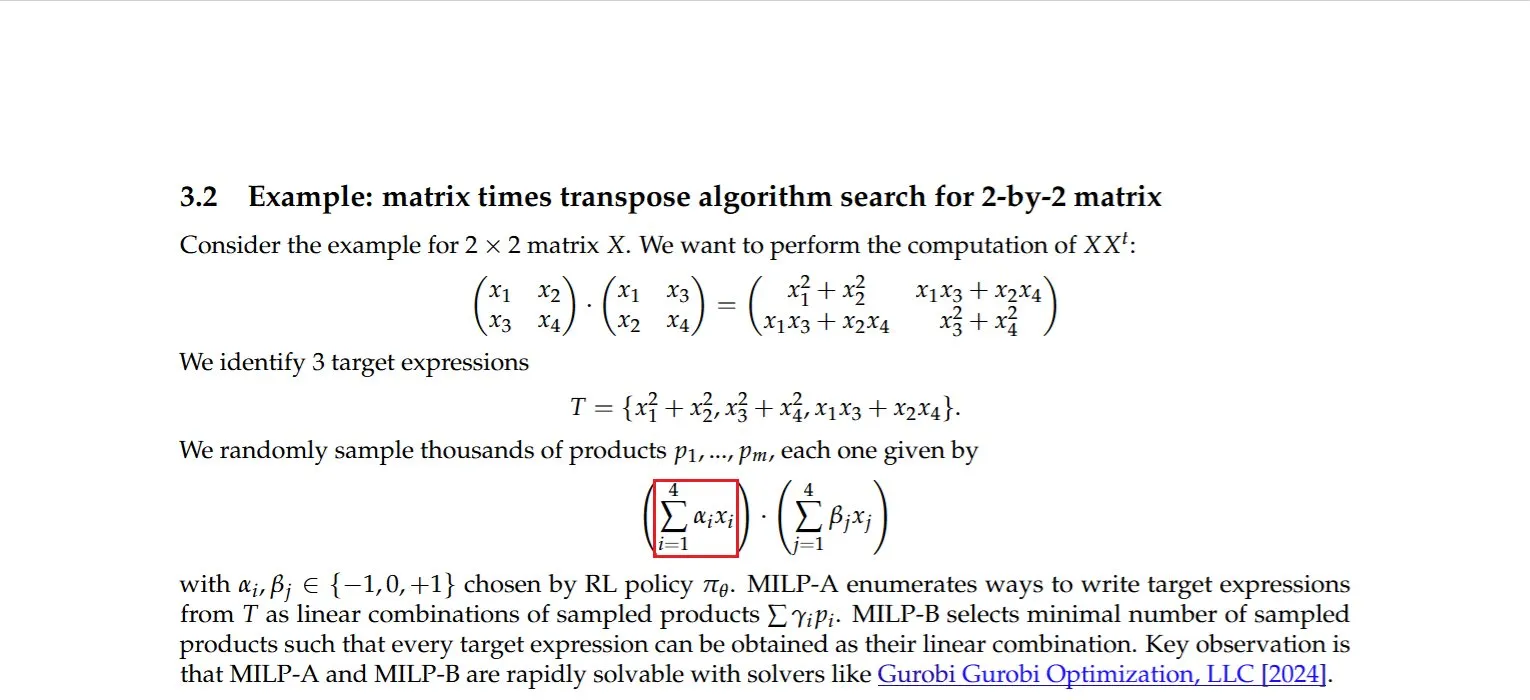

Penelitian menemukan metode komputasi efisien untuk perkalian matriks dengan transposnya: Dmitry Rybin dkk. menemukan algoritma yang lebih cepat untuk menghitung perkalian matriks dengan transposnya (arxiv:2505.09814). Terobosan mendasar ini memiliki dampak yang luas bagi berbagai bidang seperti analisis data, desain chip, komunikasi nirkabel, dan pelatihan LLM, karena komputasi semacam ini merupakan operasi umum dalam bidang-bidang tersebut. Ini sekali lagi membuktikan bahwa bahkan dalam bidang aljabar linier komputasi yang sudah matang, masih ada ruang untuk perbaikan (Sumber: teortaxesTex, Ar_Douillard)

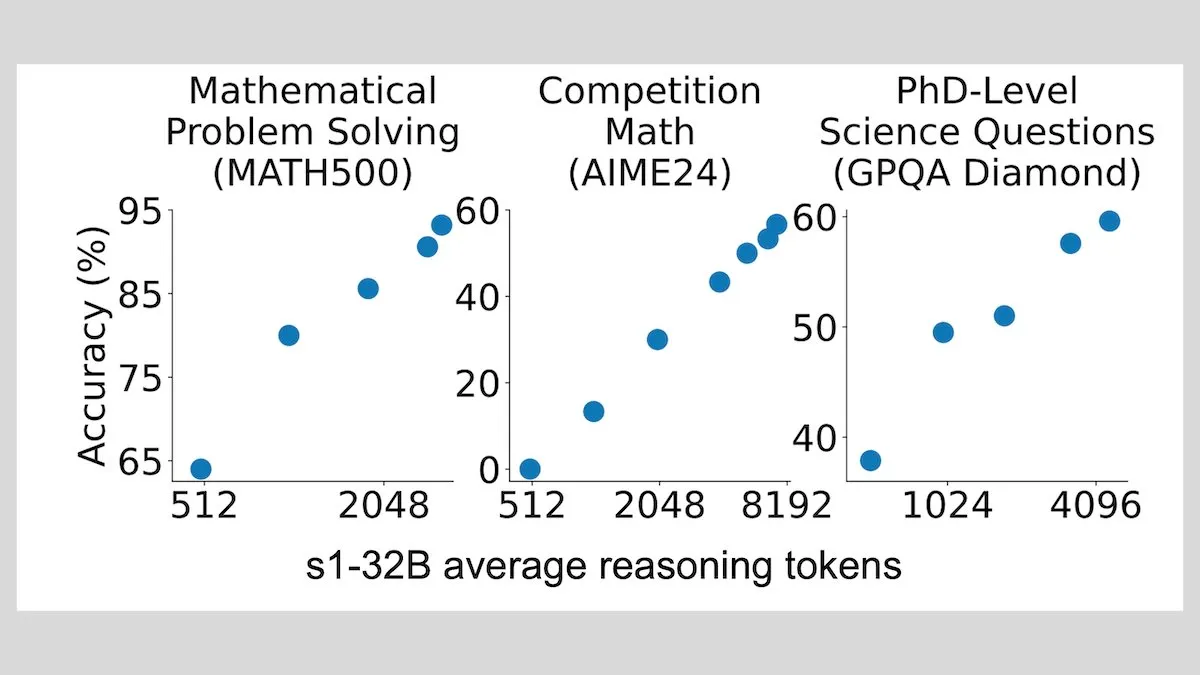

DeepLearningAI: Fine-tuning dengan sedikit sampel dapat meningkatkan kemampuan penalaran LLM secara signifikan: Penelitian menunjukkan bahwa fine-tuning model bahasa besar hanya dengan 1000 sampel dapat meningkatkan kemampuan penalarannya secara signifikan. Model eksperimentalnya, s1, memperluas proses penalaran dengan menambahkan kata “Wait” saat bernalar, dan mencapai kinerja yang baik pada benchmark seperti AIME dan MATH 500. Metode sumber daya rendah ini menunjukkan bahwa penalaran tingkat lanjut dapat diajarkan dengan sedikit data, tanpa memerlukan reinforcement learning (Sumber: DeepLearningAI)

Hugging Face meluncurkan kursus MCP gratis, bantu membangun aplikasi AI dengan konteks kaya: Hugging Face bekerja sama dengan Anthropic meluncurkan kursus gratis berjudul “MCP: Build Rich-Context AI Apps with Anthropic”. Kursus ini bertujuan untuk membantu developer memahami arsitektur MCP (Model Context Protocol), mempelajari cara membangun dan menerapkan server MCP serta aplikasi yang kompatibel, sehingga menyederhanakan integrasi aplikasi AI dengan alat dan sumber data. Saat ini, lebih dari 3000 siswa telah mendaftar (Sumber: DeepLearningAI, huggingface, ClementDelangue)

Proyek awesome-gpt4o-images kumpulkan contoh-contoh menarik pembuatan gambar GPT-4o: Proyek GitHub awesome-gpt4o-images yang dibuat oleh Jamez Bondos mendapatkan lebih dari 5700 bintang dalam 33 hari. Proyek ini mengumpulkan dan menampilkan contoh-contoh gambar luar biasa yang dihasilkan menggunakan GPT-4o beserta prompt-nya, saat ini sudah ada hampir seratus contoh, dan direncanakan akan terus diperbarui setelah dirapikan dan divalidasi, menyediakan sumber daya kreatif yang berharga bagi komunitas AIGC (Sumber: dotey)

Yann LeCun bagikan presentasi Self-Supervised Learning (SSL): Yann LeCun membagikan konten presentasinya mengenai Self-Supervised Learning (SSL). SSL sebagai paradigma machine learning yang penting, bertujuan agar model dapat mempelajari representasi yang efektif dari data yang tidak berlabel, yang memiliki arti penting untuk mengurangi ketergantungan pada data berlabel skala besar dan meningkatkan kemampuan generalisasi model (Sumber: ylecun)

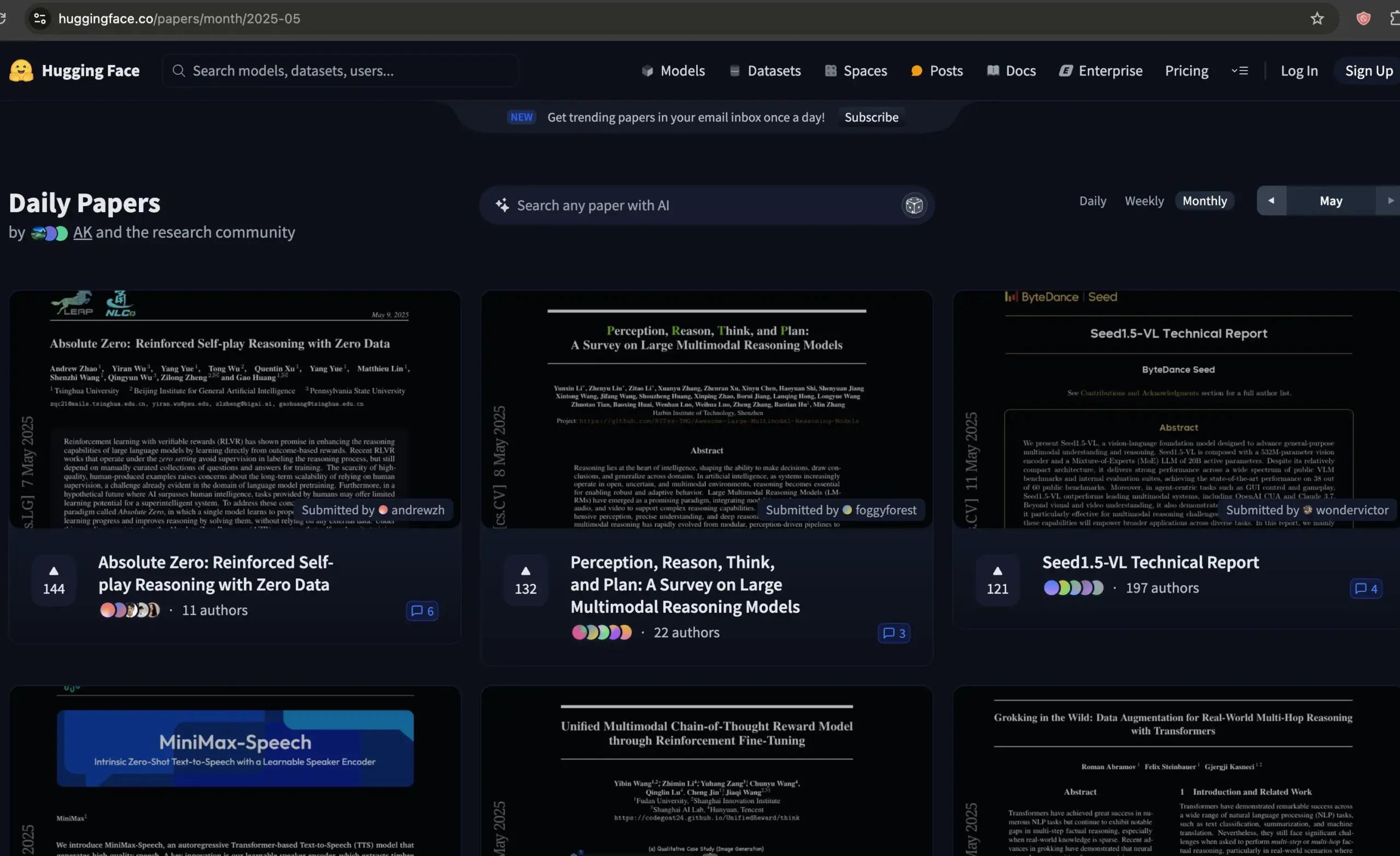

Forum makalah Hugging Face menjadi sumber daya berkualitas untuk penyaringan makalah AI: Dwarkesh Patel merekomendasikan forum makalah Hugging Face, menganggapnya sebagai sumber daya yang sangat baik untuk menyaring makalah AI terbaik dari bulan lalu. Platform ini menyediakan saluran yang nyaman bagi para peneliti untuk menemukan dan mendiskusikan kemajuan penelitian AI terbaru (Sumber: dwarkesh_sp, huggingface)

Hasil penerimaan ACL 2025 diumumkan, beberapa makalah tim AIB Internasional Alibaba terpilih: Konferensi terkemuka dalam pemrosesan bahasa alami, ACL 2025, mengumumkan hasil penerimaan. Jumlah kiriman tahun ini mencapai rekor tertinggi, dengan persaingan yang ketat. Tim AI Business Internasional Alibaba memiliki beberapa makalah yang diterima, dengan beberapa hasil seperti Marco-o1 V2, Marco-Bench-IF, dan HD-NDEs (persamaan diferensial saraf untuk deteksi halusinasi) mendapatkan evaluasi tinggi dan diterima sebagai makalah panjang di konferensi utama. Hal ini mencerminkan investasi berkelanjutan Alibaba Internasional di bidang AI dan pengembangan bakat yang mulai membuahkan hasil (Sumber: 量子位)

dstack merilis panduan pengaturan interkoneksi cepat untuk pelatihan terdistribusi: dstack menyediakan panduan ringkas bagi pengguna yang melakukan pelatihan terdistribusi pada klaster NVIDIA atau AMD, menjelaskan cara mengatur interkoneksi cepat melalui dstack. Panduan ini bertujuan untuk membantu pengguna mengoptimalkan kinerja jaringan saat memperluas beban kerja AI di cloud atau secara lokal (Sumber: algo_diver)

AssemblyAI bagikan 10 video tips untuk meningkatkan prompting LLM: AssemblyAI melalui video YouTube membagikan 10 tips untuk meningkatkan efektivitas prompting pada Large Language Model (LLM), bertujuan untuk membantu pengguna berinteraksi lebih efektif dengan LLM guna mendapatkan output yang diinginkan (Sumber: AssemblyAI)

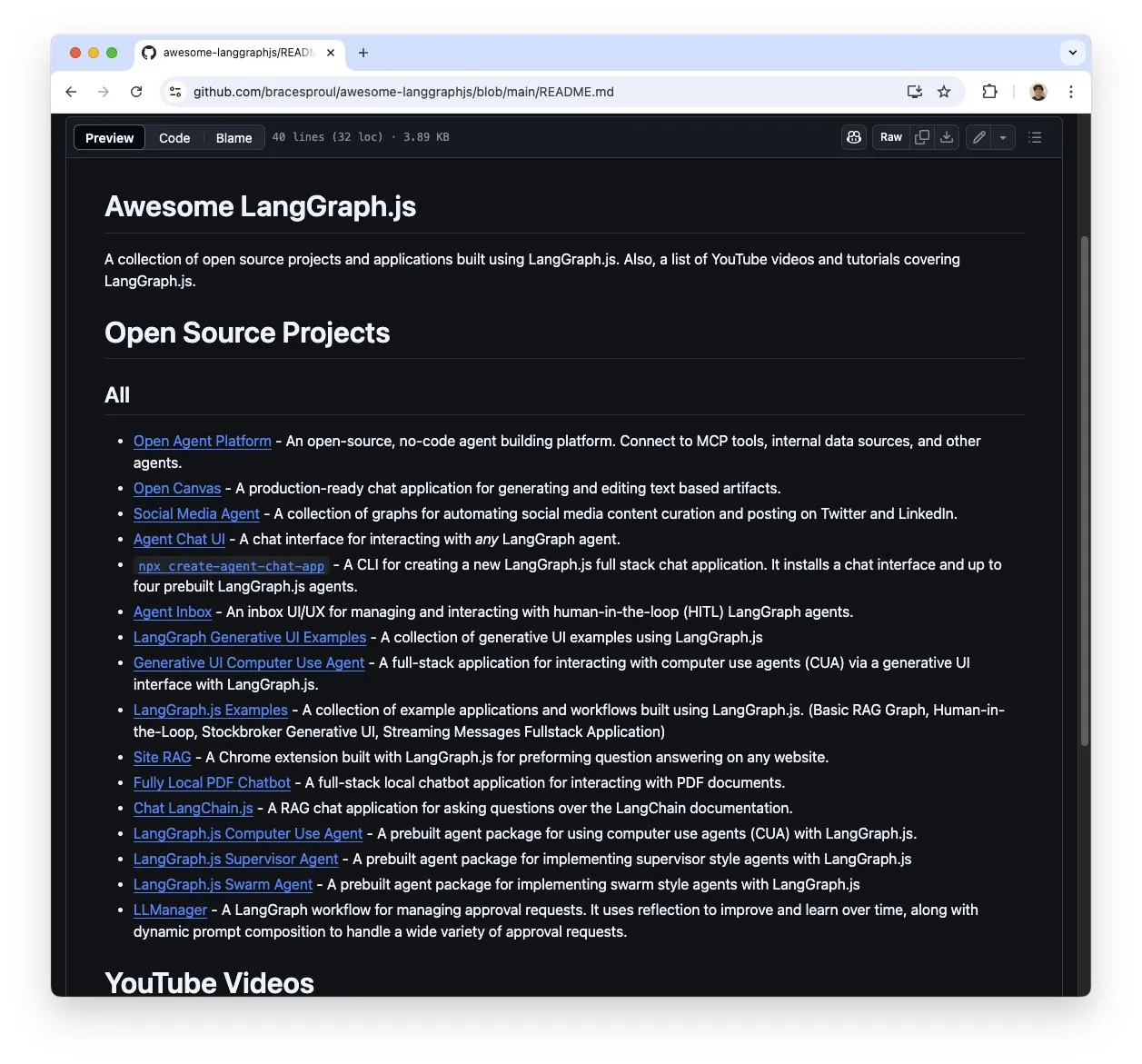

Kumpulan sumber belajar LangGraph.js “awesome-langgraphjs” menarik perhatian: Brace membuat dan memelihara repositori GitHub bernama “awesome-langgraphjs”, yang mengumpulkan proyek open source dan tutorial video YouTube yang dibangun menggunakan LangGraph.js. Sumber daya ini memberikan kemudahan bagi developer yang ingin belajar dan menggunakan LangGraph.js untuk membangun berbagai jenis aplikasi, mulai dari sistem multi-agen hingga aplikasi obrolan full-stack (Sumber: LangChainAI)

💼 Bisnis

Transformasi strategis AI Alibaba menunjukkan hasil, pendapatan bisnis cloud dan produk AI tumbuh signifikan: Laporan keuangan Alibaba Q4 2025 menunjukkan bahwa setelah mengeluarkan bisnis tertentu, pendapatan keseluruhan tumbuh 10% YoY, pendapatan bisnis cloud intelligence tumbuh 18%, di mana pendapatan produk terkait AI mempertahankan pertumbuhan tiga digit YoY selama 7 kuartal berturut-turut. Alibaba memandang AI sebagai strategi inti, berencana untuk menginvestasikan lebih dari 380 miliar yuan dalam tiga tahun ke depan untuk meningkatkan infrastruktur komputasi cloud dan AI. Model open source-nya, Tongyi Qianwen Qwen-3, menduduki puncak beberapa peringkat global, dengan lebih dari 100.000 model turunan, menunjukkan kekuatan teknis dan vitalitas ekosistem open source-nya. Alibaba mempercepat penerapan AI di industri seperti otomotif, komunikasi, dan keuangan (Sumber: 36氪)

Aplikasi edit video Mojo diakuisisi oleh Dailymotion: Aplikasi edit video Mojo (@mojo_video_app) telah diakuisisi oleh Dailymotion. Teknologi edit video Mojo akan diintegrasikan ke dalam aplikasi sosial dan produk B2B Dailymotion, dengan tujuan bersama untuk membangun platform video sosial generasi berikutnya di Eropa (Sumber: ClementDelangue)

Cohere mengakuisisi Ottogrid, perkuat kemampuan AI perusahaan: Perusahaan AI Cohere mengumumkan akuisisi perusahaan startup Ottogrid. Akuisisi ini diharapkan dapat memperkuat kemampuan Cohere dalam solusi AI tingkat perusahaan, namun detail transaksi spesifik dan arah teknologi Ottogrid tidak diungkapkan secara rinci (Sumber: aidangomez, nickfrosst)

🌟 Komunitas

AI Agent memicu diskusi perubahan cara kerja, masa depan mungkin seperti game strategi real-time: Will Depue mengemukakan bahwa pekerjaan di masa depan mungkin berkembang menjadi model yang mirip dengan 《StarCraft》 atau 《Age of Empires》, di mana manusia memimpin sekitar 200 agen mikro cerdas untuk menangani tugas, mengumpulkan informasi, merancang sistem, dll. Sam Altman me-retweet dan setuju. Fabian Stelzer bercanda menyebutnya sebagai “Zerg rush coded”. Pandangan ini mencerminkan imajinasi dan diskusi komunitas tentang bagaimana AI Agent akan membentuk kembali alur kerja dan mode kolaborasi manusia-mesin (Sumber: willdepue, sama, fabianstelzer)

Respons robot Grok xAI picu kontroversi, prompt dituduh diubah tanpa izin: xAI mengakui bahwa prompt robot respons Grok-nya di platform X diubah tanpa izin pada dini hari tanggal 14 Mei, menyebabkan analisisnya terhadap beberapa peristiwa (seperti peristiwa yang melibatkan Trump) tampak aneh atau tidak sesuai dengan informasi arus utama. Komunitas sangat memperhatikan masalah ini, Clement Delangue dkk. menyerukan agar Grok menjadi open source untuk meningkatkan transparansi. Pengguna seperti Colin Fraser, dengan membandingkan respons Grok pada waktu yang berbeda, mencoba merekayasa balik riwayat modifikasi prompt sistemnya (Sumber: ClementDelangue, menhguin, colin_fraser)

Tim Meta Llama4 dikabarkan banyak yang resign, picu kekhawatiran komunitas tentang prospek AI open source: Kabar dari komunitas menyebutkan bahwa sekitar 80% anggota tim Llama4 Meta (11 dari 14 anggota tim asli) telah mengundurkan diri, dan rilis model andalannya, Behemoth, ditunda. Hal ini menarik perhatian luas, dengan tokoh industri seperti Nat Lambert menyatakan penyesalannya. Scaling01 berkomentar bahwa Meta mungkin membutuhkan direktur pemasaran Llama yang baru. Pengguna seperti TeortaxesTex khawatir hal ini dapat berdampak negatif pada perkembangan AI open source, bahkan membahas apakah Tiongkok akan menjadi harapan terakhir untuk open source (Sumber: teortaxesTex, Dorialexander, scaling01)

Penggunaan AI dalam perang dan masalah etika menarik perhatian: Komunitas Reddit membahas penggunaan AI dalam perang, menunjukkan bahwa AI telah digunakan untuk pengawasan dan penentuan lokasi kombatan, dengan menganalisis informasi untuk menyediakan intelijen militer. Diskusi menyebutkan bahwa militer AS telah menggunakan alat AI seperti DART sejak tahun 1991. Pengguna khawatir tentang risiko mematikan yang mungkin ditimbulkan oleh persenjataan AI dan potensi ancamannya terhadap manusia, serta memperhatikan penyusunan perjanjian dan tindakan internasional terkait. Panduan penggunaan OpenAI juga telah menghapus klausul yang melarang penggunaan untuk tujuan militer, yang memicu pemikiran lebih lanjut (Sumber: Reddit r/ArtificialInteligence)

Model bahasa besar berkinerja buruk dalam kompetisi pemrograman CCPC, ungkap keterbatasan saat ini: Dalam final Kompetisi Desain Program Mahasiswa Tiongkok (CCPC) ke-10, beberapa model bahasa besar terkenal seperti Seed-Thinking dari ByteDance (termasuk o3/o4, Gemini 2.5 pro, DeepSeek R1) berkinerja buruk, sebagian besar hanya menyelesaikan soal pemanasan atau mendapatkan skor nol. Staf resmi menjelaskan bahwa model tersebut mencoba secara mandiri murni, tanpa intervensi manual. Analisis komunitas berpendapat bahwa ini mengungkapkan kelemahan model besar saat ini dalam memecahkan masalah algoritma yang sangat inovatif dan kompleks, terutama dalam mode non-Agentic (yaitu, tanpa bantuan alat untuk eksekusi dan debugging). Ini kontras dengan OpenAI o3 yang meraih medali emas dalam kompetisi IOI melalui pelatihan Agentic (Sumber: WeChat)

Framework DSPy dan “pelajaran pahit” memicu diskusi, tekankan desain规范 dan otomatisasi prompt: Diskusi terkait DSPy menekankan bahwa meskipun penskalaan AI (Scaling) dapat mengatasi banyak kesulitan rekayasa (“pelajaran pahit”), hal itu tidak dapat menggantikan desain yang cermat terhadap spesifikasi inti masalah (kebutuhan dan aliran informasi). Namun, penskalaan dapat meningkatkan tingkat abstraksi dalam mendefinisikan masalah. Otomatisasi prompt (seperti prompt optimizers) dianggap sebagai metode pemanfaatan kemampuan komputasi yang sesuai dengan “pelajaran pahit”, sedangkan prompt manual mungkin melanggarnya karena menyuntikkan intuisi manusia alih-alih membiarkan model belajar (Sumber: lateinteraction, lateinteraction)

Biaya komputasi AI Agent untuk pemeriksaan diri/eksplorasi alat saat inferensi menjadi perhatian: Paul Calcraft bertanya tentang praktik penggunaan sumber daya komputasi yang besar (misalnya, lebih dari 200 USD untuk menyelesaikan satu masalah) pada tahap inferensi agar AI Agent dapat melakukan pemeriksaan diri aktif, penggunaan alat, dan alur kerja eksploratif. Dia menunjukkan bahwa Devin dan pesaingnya mungkin melakukannya untuk demonstrasi PR, tetapi tidak jelas untuk skenario yang mencari solusi baru (mirip dengan FunSearch tetapi dengan batasan yang lebih sedikit) (Sumber: paul_cal)

“Vibe Coding” dengan bantuan AI memicu diskusi: Alat seperti GitHub Copilot memungkinkan “Vibe Coding” (pemrograman yang lebih mengandalkan intuisi dan bantuan AI daripada perencanaan yang ketat), bahkan ada siswa berusia 16 tahun yang menggunakan Copilot untuk menyelesaikan proyek sekolah. Komunitas memiliki pandangan yang beragam terhadap fenomena ini, ada yang menganggapnya sebagai paradigma pemrograman baru, ada pula yang menekankan pentingnya dasar dan spesifikasi (Sumber: Reddit r/ArtificialInteligence, nrehiew_)

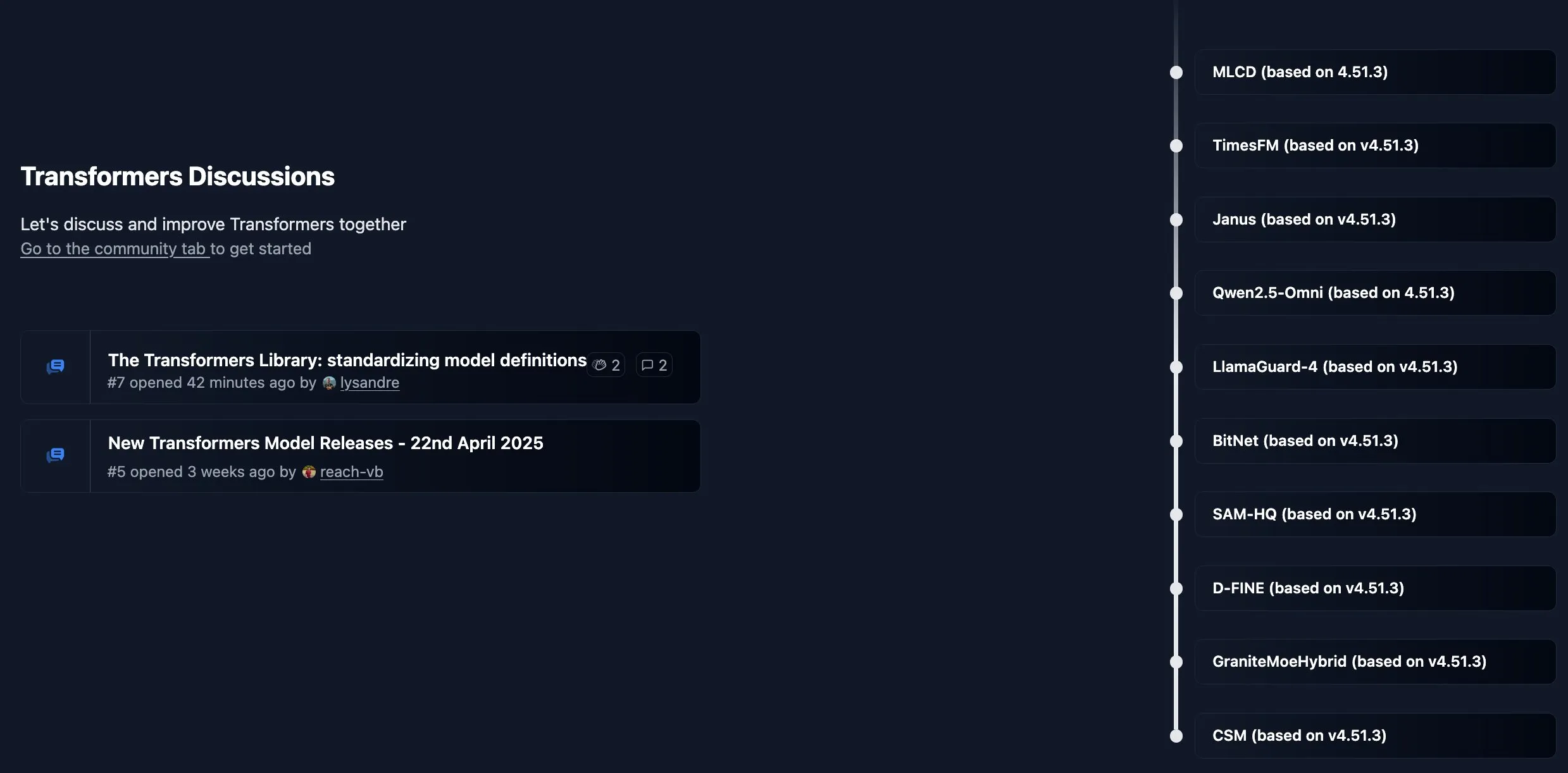

Pustaka Hugging Face Transformers aktifkan papan komunitas baru: Hugging Face membuka papan komunitas baru untuk pustaka intinya, Transformers, guna mempublikasikan pengumuman, pengenalan fitur baru, pembaruan peta jalan, dan menyambut pengguna untuk bertanya dan berdiskusi mengenai penggunaan pustaka atau masalah model, bertujuan untuk memperkuat interaksi dan dukungan dengan para developer (Sumber: TheZachMueller, ClementDelangue)

Developer AI serukan konferensi terkemuka untuk menambah jalur makalah “Findings”: Mengingat lonjakan jumlah kiriman ke konferensi AI terkemuka seperti NeurIPS (misalnya, NeurIPS mencapai 25.000 kiriman), Dan Roy dkk. menyerukan untuk meniru konferensi seperti ACL dengan membuat jalur makalah bersifat “Findings”. Ini bertujuan untuk memberikan kesempatan publikasi bagi penelitian yang, meskipun belum mencapai standar konferensi utama, masih memiliki nilai, mengurangi tekanan pada peninjau, dan mendorong pertukaran akademis yang lebih luas. Usulan tersebut mencakup tinjauan ringan, dengan fokus pada peningkatan kejelasan makalah, dll. (Sumber: AndrewLampinen)

💡 Lainnya

Eksoskeleton bertenaga AI bantu pengguna kursi roda berdiri dan berjalan: Sebuah perangkat eksoskeleton bertenaga AI menunjukkan kemampuannya membantu pengguna kursi roda untuk berdiri dan berjalan kembali. Teknologi semacam ini menggabungkan teknologi robotika, sensor, dan algoritma AI, dengan merasakan niat pengguna dan memberikan bantuan tenaga, membawa harapan rehabilitasi dan peningkatan kualitas hidup bagi penyandang disabilitas gerak (Sumber: Ronald_vanLoon)

Memanfaatkan AI untuk memvisualisasikan ide nama pengguna: Di komunitas Reddit dan X, muncul tren kecil di mana pengguna menggunakan alat penghasil gambar AI (seperti DALL-E 3 yang terintegrasi di ChatGPT) untuk membuat gambar konsep berdasarkan nama pengguna media sosial mereka, dan membagikan karya-karya imajinatif ini, menunjukkan aplikasi AI yang menyenangkan dalam ekspresi kreatif yang dipersonalisasi (Sumber: Reddit r/ChatGPT, Reddit r/ChatGPT)

Amazon Ads manfaatkan AI untuk tingkatkan efisiensi pemasaran merek go-international: Amazon Ads meluncurkan konsep “World Public Screen Lab”, menunjukkan bagaimana mereka memanfaatkan teknologi AI untuk memberdayakan merek Tiongkok yang berekspansi ke pasar global. Melalui matriks media seperti Prime Video, jangkauan merek diperluas, studio kreatif AI (seperti alat penghasil video) menurunkan hambatan produksi konten, dan alat seperti Amazon DSP dan Performance+ mengoptimalkan penempatan iklan dan konversi. AI memainkan peran di seluruh rantai, mulai dari pembuatan ide kreatif hingga pengukuran efektivitas, bertujuan untuk membantu pemilik merek, terutama UKM, membangun merek global dengan lebih efisien (Sumber: 36氪)