Kata Kunci:AI Programming Agent, Codex, Voice Large Model, AI Agent, OpenAI, MiniMax, Alibaba, Qwen, Codex Preview, Speech-02 Voice Model, WorldPM Research, FastVLM Visual Language Model, FG-CLIP Cross-Modal Model

🔥 Fokus

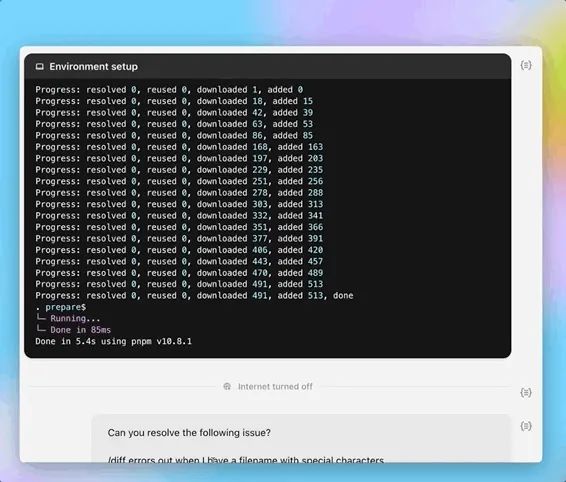

OpenAI merilis versi pratinjau agen pemrograman AI Codex: OpenAI meluncurkan versi pratinjau agen rekayasa perangkat lunak berbasis cloud, Codex, pada larut malam tanggal 16 Mei. Codex didukung oleh model varian o3 codex-1 yang dioptimalkan untuk rekayasa perangkat lunak, dan dapat menangani tugas-tugas seperti pemrograman, tanya jawab codebase, perbaikan bug, dan pengajuan pull request secara paralel. Codex berjalan di lingkungan sandbox cloud dengan codebase pengguna yang sudah dimuat sebelumnya, dan waktu penyelesaian tugas berkisar antara 1-30 menit. Saat ini, Codex telah tersedia untuk pengguna ChatGPT Pro, Team, dan Enterprise, dan akan segera hadir untuk pengguna Plus dan Edu. Bersamaan dengan itu, dirilis pula model ringan codex-mini (berbasis o4-mini) untuk Codex CLI, dengan harga API $1,5/juta token untuk input dan $6/juta token untuk output. (Sumber: 36氪, 机器之心, op7418)

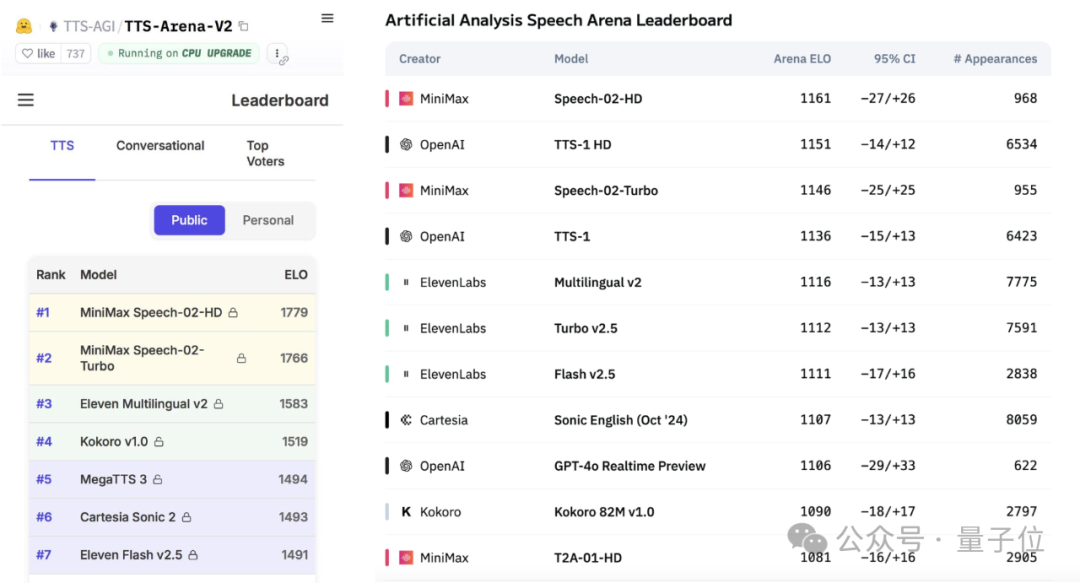

MiniMax merilis model besar suara Speech-02, memuncaki peringkat evaluasi global: Perusahaan AI Tiongkok, MiniMax, baru-baru ini merilis model besar text-to-speech (TTS) Speech-02-HD, yang meraih peringkat pertama dalam dua evaluasi benchmark suara otoritatif global, yaitu Artificial Analysis Speech Arena dan Hugging Face TTS Arena V2, melampaui OpenAI dan ElevenLabs. Model ini memiliki karakteristik super-realistis, personal, dan beragam, mendukung 32 bahasa, dan dapat mereplikasi timbre suara yang sangat mirip dengan referensi suara minimal 10 detik. Aplikasi belajar bahasa Inggris “AI Wu Yanzu” yang populer sebelumnya menggunakan teknologi MiniMax. Inovasi inti Speech-02 mencakup encoder pembicara yang dapat dipelajari dan model pencocokan aliran Flow-VAE, yang meningkatkan kualitas suara dan kemiripan. (Sumber: 36氪, karminski3)

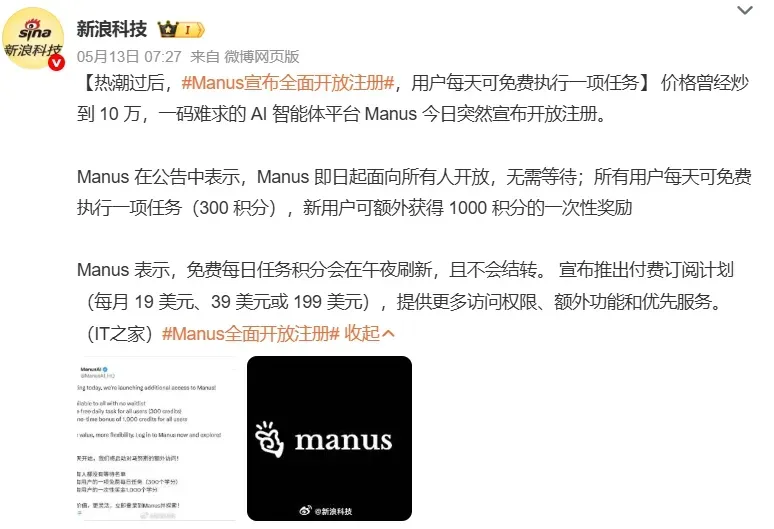

AI Agent menarik perhatian pasar, perusahaan besar mempercepat penempatan: AI Agent (Agen) menjadi fokus baru di bidang AI. Platform Agen serbaguna seperti Manus membuka pendaftaran dan memicu antusiasme, dengan perusahaan induknya, Monica, dilaporkan menyelesaikan putaran pendanaan baru sebesar $75 juta dengan valuasi mendekati $500 juta. Perusahaan besar seperti Baidu (Xinxiang), ByteDance (Kouzi Kongjian), dan Alibaba (Xinliu) berturut-turut meluncurkan produk atau platform Agen mereka sendiri, bersaing untuk menjadi pintu masuk di era AI. Agen dapat melakukan tugas yang lebih kompleks, seperti pembuatan materi, desain web, perencanaan perjalanan, dll. Saat ini, Agen serbaguna masih memiliki kekurangan dalam operasi lintas aplikasi dan tugas yang mendalam, dengan ekosistem yang belum sempurna dan silo data menjadi tantangan utama. Protokol MCP dianggap sebagai kunci untuk menyelesaikan interoperabilitas, tetapi jumlah pihak yang terhubung masih sedikit. Agen di bidang vertikal B2B dianggap lebih mudah mencapai komersialisasi lebih dulu karena fokus pada skenario dan kemudahan kustomisasi. (Sumber: 36氪, 36氪)

Alibaba merilis penelitian WorldPM, mengeksplorasi hukum penskalaan pemodelan preferensi manusia: Tim Qwen Alibaba menerbitkan makalah berjudul “Modeling World Preference”, yang mengungkapkan bahwa pemodelan preferensi manusia mengikuti hukum penskalaan (Scaling Laws), menunjukkan bahwa preferensi manusia yang beragam mungkin berbagi representasi terpadu. Penelitian ini menggunakan dataset StackExchange yang berisi 15 juta pasangan preferensi, dan melakukan eksperimen pada model Qwen2.5 dengan parameter mulai dari 1.5B hingga 72B. Hasilnya menunjukkan bahwa pemodelan preferensi menunjukkan pengurangan kerugian logaritmik pada metrik objektif dan ketahanan seiring dengan meningkatnya skala pelatihan; model 72B menunjukkan fenomena kemunculan (emergent phenomenon) pada beberapa tugas yang menantang. Penelitian ini memberikan dasar yang efektif untuk penyempurnaan preferensi (preference fine-tuning), dan makalah serta model (WorldPM-72B) telah dirilis sebagai open source. (Sumber: Alibaba_Qwen)

🎯 动向

Google DeepMind dan Anthropic berbeda pendapat dalam penelitian interpretabilitas AI: Google DeepMind baru-baru ini mengumumkan tidak lagi menjadikan “interpretabilitas mekanistik” (mechanistic interpretability) sebagai fokus penelitian, dengan alasan bahwa jalur rekayasa balik operasi internal AI melalui metode seperti sparse autoencoders (SAE) sangat sulit, dan SAE memiliki kekurangan inheren. Sebaliknya, CEO Anthropic Dario Amodei menganjurkan penguatan penelitian di bidang ini dan menyatakan optimisme tentang pencapaian “pencitraan resonansi magnetik AI” dalam 5-10 tahun ke depan. Sifat “kotak hitam” (black box) AI adalah akar dari banyak risiko, dan interpretabilitas mekanistik bertujuan untuk memahami fungsi neuron dan sirkuit spesifik dalam model, tetapi hasil penelitian selama lebih dari sepuluh tahun terbatas, memicu refleksi mendalam tentang jalur penelitian. (Sumber: WeChat)

Laporan Poe mengungkapkan perubahan lanskap pasar model AI, OpenAI dan Google memimpin: Laporan penggunaan model AI terbaru dari Poe menunjukkan bahwa di bidang pembuatan teks, GPT-4o (35,8%) memimpin, sementara di bidang penalaran, Gemini 2.5 Pro (31,5%) menduduki puncak. Pembuatan gambar didominasi oleh seri Imagen3, GPT-Image-1, dan Flux. Pangsa pasar Runway dalam pembuatan video menurun, sementara Kling dari Kuaishou menjadi kuda hitam. Dalam hal agen cerdas, o3 dari OpenAI menunjukkan kinerja yang lebih baik daripada Claude dan Gemini dalam pengujian penelitian. Pangsa pasar Claude dari Anthropic mengalami penurunan. Laporan tersebut menunjukkan bahwa kemampuan penalaran menjadi titik persaingan utama, dan perusahaan perlu membangun sistem evaluasi serta secara fleksibel memilih model yang berbeda untuk menghadapi pasar yang berubah dengan cepat. (Sumber: WeChat)

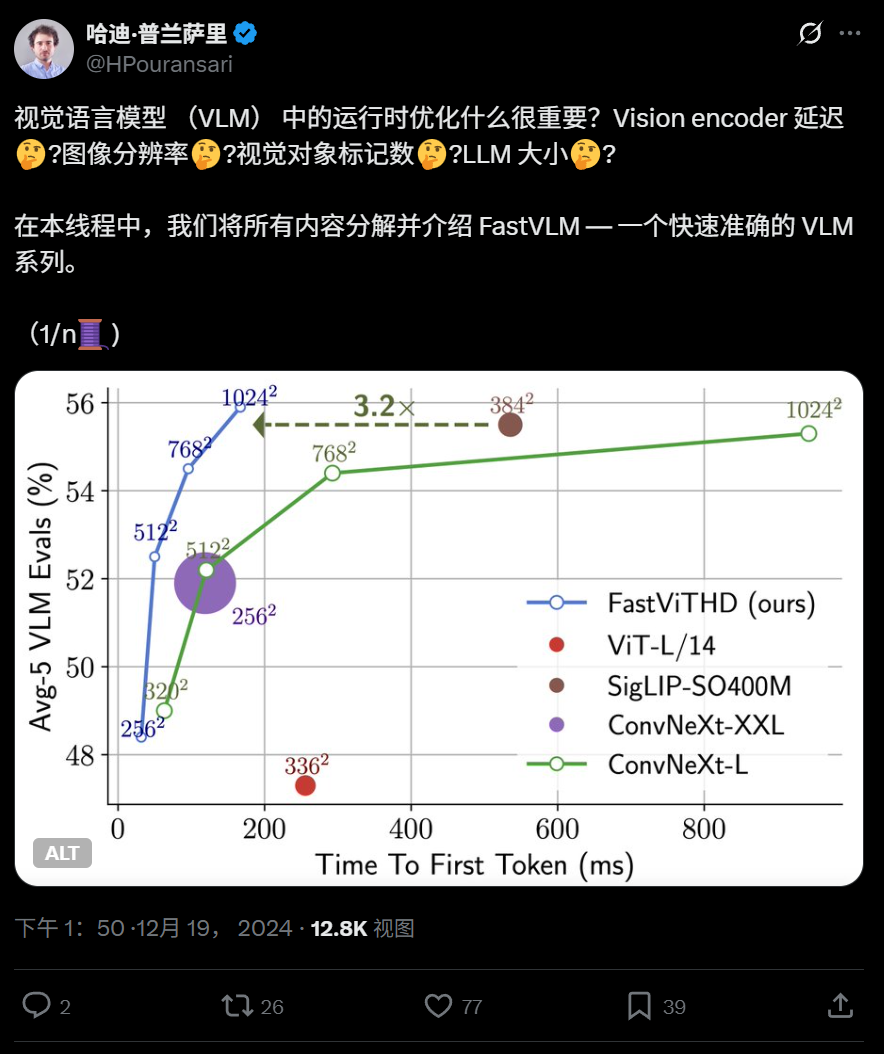

Apple merilis model bahasa visual efisien FastVLM secara open source, dapat berjalan di iPhone: Apple telah merilis FastVLM secara open source, sebuah model bahasa visual yang dirancang khusus untuk berjalan secara efisien di perangkat sisi edge seperti iPhone. Model ini secara signifikan mengurangi jumlah token visual (16 kali lebih sedikit dari ViT) melalui encoder visual hibrida baru FastViTHD (menggabungkan lapisan konvolusional dengan modul Transformer, menggunakan teknik multi-scale pooling dan downsampling), sehingga kecepatan output token pertama 85 kali lebih cepat dibandingkan model sejenis. FastVLM kompatibel dengan LLM mainstream dan telah dirilis dalam versi parameter 0.5B, 1.5B, dan 7B, yang bertujuan untuk meningkatkan kecepatan pemahaman gambar dan pengalaman pengguna aplikasi AI di sisi edge. (Sumber: WeChat)

360 merilis model lintas-modal gambar-teks generasi baru FG-CLIP, meningkatkan kemampuan penyelarasan fine-grained: 360 Artificial Intelligence Research Institute telah mengembangkan model lintas-modal gambar-teks generasi baru, FG-CLIP, yang bertujuan untuk mengatasi kekurangan model CLIP tradisional dalam pemahaman fine-grained gambar-teks. FG-CLIP mengadopsi strategi pelatihan dua tahap: pembelajaran kontrastif global (mengintegrasikan deskripsi panjang yang dihasilkan oleh model besar multimodal) dan pembelajaran kontrastif lokal (memperkenalkan data anotasi wilayah-teks dan pembelajaran sampel negatif fine-grained yang sulit), sehingga mencapai penangkapan yang akurat terhadap detail lokal gambar dan perbedaan atribut halus teks. Model ini telah diterima di ICML 2025 dan telah dirilis sebagai open source di Github dan Huggingface, dengan bobot yang dapat digunakan secara komersial. (Sumber: WeChat)

Google meluncurkan LightLab, menggunakan model difusi untuk mengontrol pencahayaan dan bayangan gambar secara presisi: Tim peneliti Google merilis proyek LightLab, sebuah teknologi yang mampu melakukan kontrol parametrik fine-grained terhadap sumber cahaya berdasarkan satu gambar. Pengguna dapat menyesuaikan intensitas dan warna sumber cahaya yang terlihat, intensitas cahaya sekitar, dan dapat menyisipkan sumber cahaya virtual ke dalam adegan. LightLab dicapai dengan menyempurnakan model difusi pada dataset yang dibuat khusus (berisi pasangan foto dengan pencahayaan terkontrol nyata dan gambar render sintetis skala besar), memanfaatkan sifat linear cahaya untuk memisahkan sumber cahaya dan cahaya sekitar, serta mensintesis sejumlah besar pasangan gambar dengan variasi pencahayaan yang berbeda untuk pelatihan. Model ini dapat secara langsung mensimulasikan efek pencahayaan kompleks di ruang gambar, seperti pencahayaan tidak langsung, bayangan, dan refleksi. (Sumber: WeChat)

Tencent mengusulkan metode reinforcement learning GRPO dan RCS, meningkatkan generalisasi deteksi niat: Tim peneliti PCG Social Line Tencent mengusulkan penggunaan algoritma Group Relative Policy Optimization (GRPO) yang dikombinasikan dengan strategi pengambilan sampel kurikulum berbasis imbalan (Reward-based Curriculum Sampling – RCS) dalam metode reinforcement learning, yang diterapkan pada tugas identifikasi niat. Metode ini secara signifikan meningkatkan kemampuan generalisasi model pada niat yang tidak diketahui (peningkatan hingga 47% pada niat baru dan kemampuan lintas bahasa), terutama setelah memperkenalkan “Pemikiran (Thought)”, kemampuan generalisasi deteksi niat kompleks semakin ditingkatkan. Eksperimen menunjukkan bahwa model yang dilatih dengan RL lebih unggul dalam generalisasi dibandingkan model SFT, dan terlepas dari apakah berbasis model pra-terlatih atau model yang disesuaikan dengan instruksi, kinerja setelah pelatihan GRPO serupa. (Sumber: WeChat)

Nanyang Technological University dkk. mengusulkan kerangka kerja RAP, meningkatkan persepsi gambar resolusi tinggi berbasis RAG: Tim Profesor Tao Dacheng dari Nanyang Technological University dkk. mengusulkan Retrieval-Augmented Perception (RAP), sebuah plugin persepsi gambar resolusi tinggi berbasis teknologi RAG yang tidak memerlukan pelatihan, yang bertujuan untuk mengatasi masalah kehilangan informasi ketika model bahasa besar multimodal (MLLM) memproses gambar resolusi tinggi. RAP mengambil patch gambar yang relevan dengan pertanyaan pengguna, dan menggunakan algoritma Spatial-Awareness Layout untuk mempertahankan hubungan posisi relatifnya, kemudian melalui Retrieved-Exploration Search (RE-Search) secara adaptif memilih jumlah patch gambar K yang akan dipertahankan, secara efektif mengurangi resolusi gambar input sambil mempertahankan informasi visual utama. Eksperimen menunjukkan bahwa RAP meningkatkan akurasi pada dataset HR-Bench 4K dan 8K masing-masing hingga 21% dan 21,7%. Hasil ini telah diterima sebagai makalah Spotlight di ICML 2025. (Sumber: WeChat)

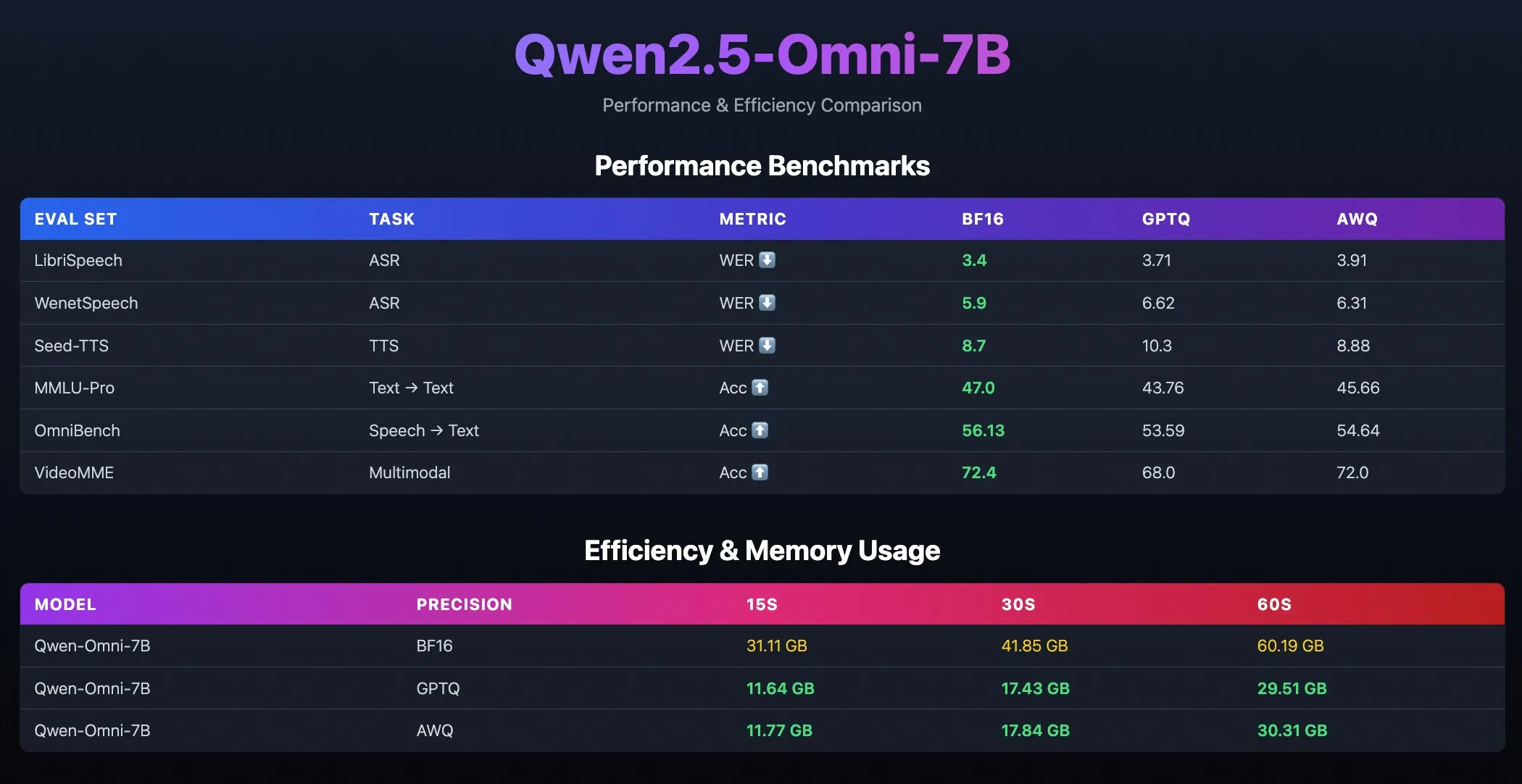

Model terkuantisasi Qwen2.5-Omni-7B dirilis: Tim Qwen Alibaba merilis versi terkuantisasi dari model Qwen2.5-Omni-7B, termasuk checkpoint yang dioptimalkan dengan GPTQ dan AWQ. Model-model ini telah tersedia di Hugging Face dan ModelScope, bertujuan untuk menyediakan opsi deployment yang lebih efisien dan hemat sumber daya, sambil mempertahankan kemampuan multimodal yang kuat. (Sumber: Alibaba_Qwen, karminski3, reach_vb)

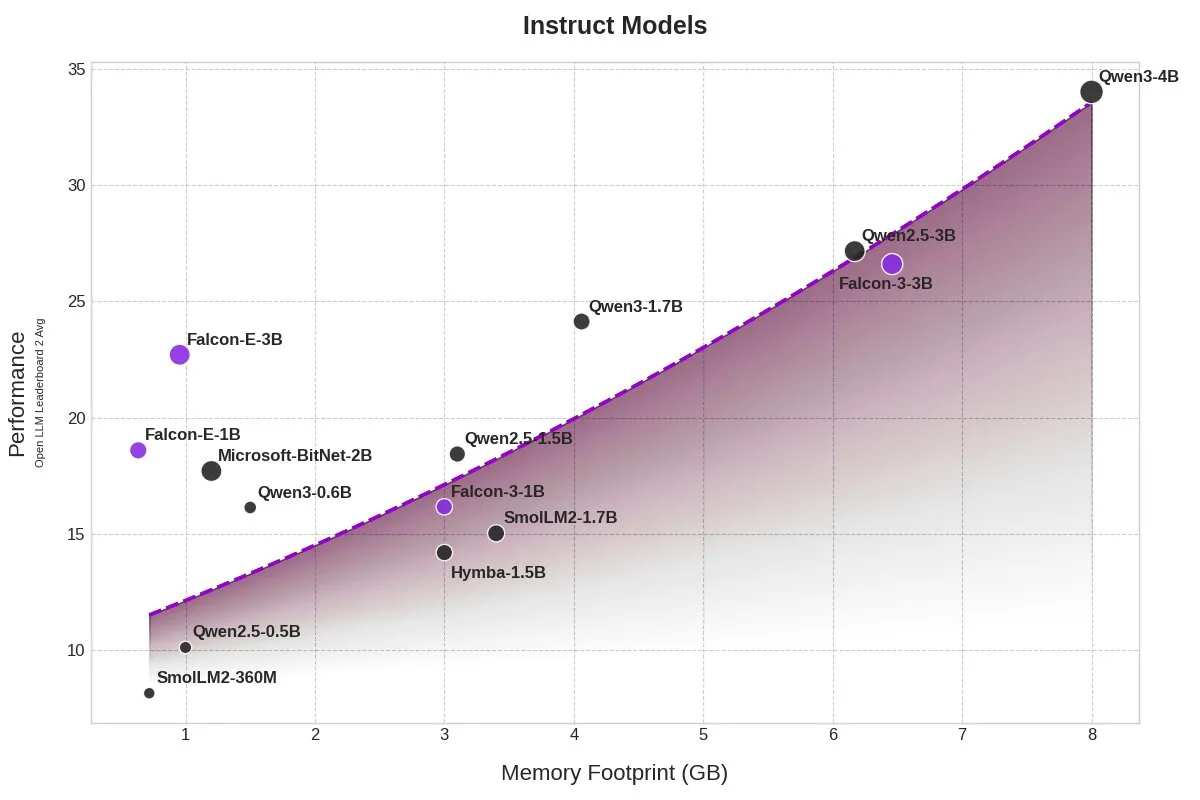

TII merilis model BitNet Falcon-E-1B/3B, secara signifikan mengurangi penggunaan memori: Technology Innovation Institute (TII) meluncurkan seri model baru Falcon-Edge berdasarkan kerangka kerja model presisi 1-bit Microsoft, BitNet, termasuk Falcon-E-1B dan Falcon-E-3B. Dilaporkan, kinerja model-model ini sebanding dengan Qwen3-1.7B, tetapi penggunaan memorinya hanya 1/4 darinya. TII juga merilis pustaka fine-tuning onebitllms, yang mendukung pengguna untuk melakukan fine-tuning model 1-bit ini sendiri pada kartu grafis NVIDIA. (Sumber: karminski3)

Model Qwen3 dan DeepSeek memimpin di peringkat tanya jawab medis MEDIC-Benchmark: Model Qwen3 meraih peringkat pertama dan kedua pada peringkat tanya jawab medis MEDIC-Benchmark yang baru dirilis. Selain itu, lima besar dalam daftar tersebut diduduki oleh model seri Qwen dan DeepSeek, menunjukkan kemampuan tanya jawab yang kuat dari model-model besar buatan Tiongkok ini di bidang medis profesional. (Sumber: karminski3)

Universitas Zhejiang mengusulkan Rankformer: arsitektur model rekomendasi Transformer yang secara langsung mengoptimalkan peringkat: Tim dari Universitas Zhejiang mengusulkan arsitektur model rekomendasi graph Transformer baru bernama Rankformer, yang desainnya secara langsung berasal dari tujuan pengurutan (seperti fungsi kerugian BPR). Rankformer mensimulasikan arah optimasi vektor selama proses penurunan gradien untuk merancang mekanisme graph Transformer yang unik, membimbing model untuk mengkodekan representasi pengurutan yang lebih baik dalam propagasi maju. Model ini menggunakan mekanisme perhatian global untuk menggabungkan informasi dan mengklaim mengurangi kompleksitas ruang-waktu ke tingkat linear melalui transformasi matematika dan optimasi cache. Penelitian ini telah diterima oleh konferensi WWW 2025. (Sumber: WeChat)

🧰 工具

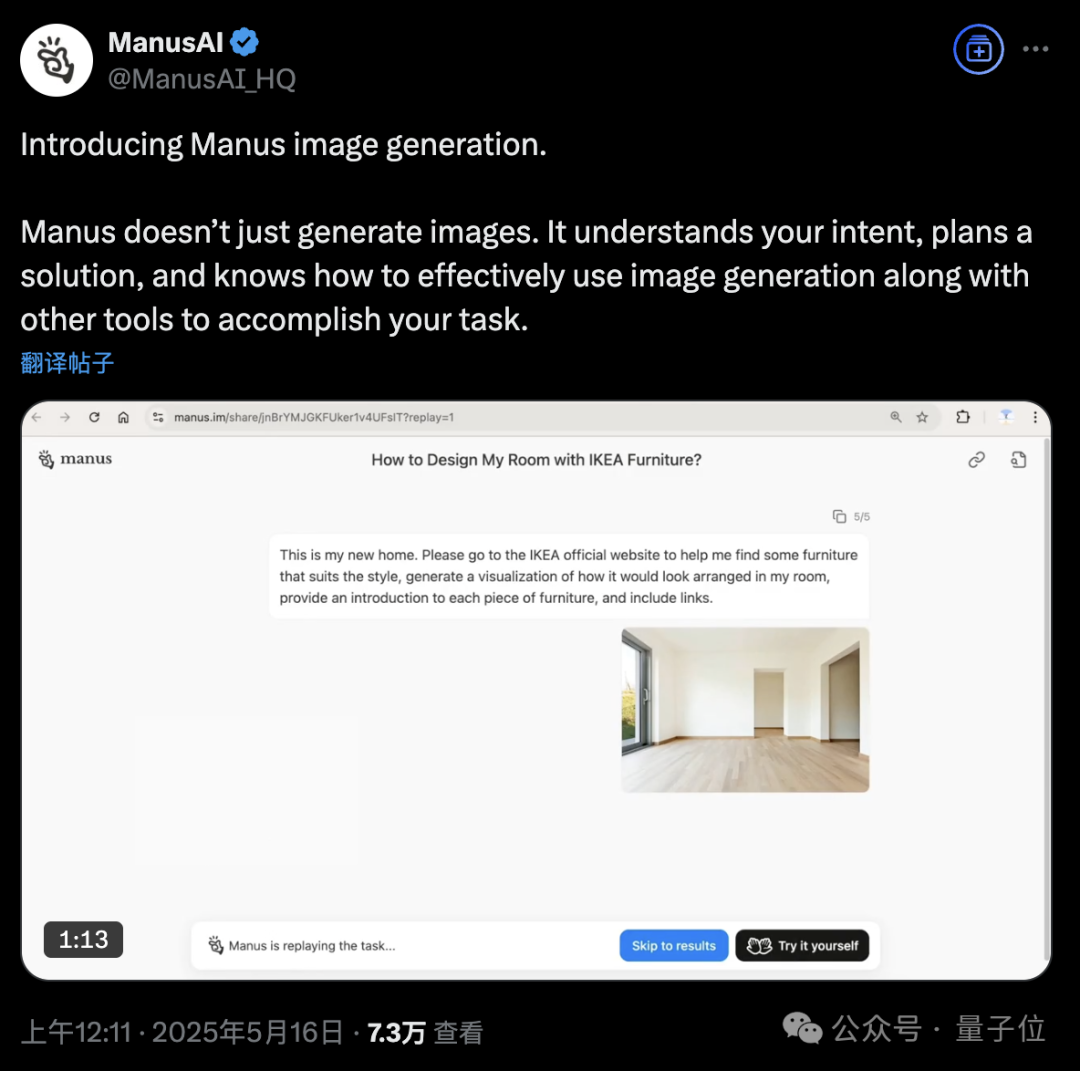

Platform AI Agent Manus menambahkan fungsi pembuatan gambar: Platform AI Agent Manus mengumumkan dukungan untuk pembuatan gambar. Berbeda dari alat menggambar AI tradisional, Manus dapat memahami tujuan menggambar pengguna dan merencanakan skema pembuatan. Misalnya, pengguna dapat mengunggah foto ruangan, meminta Manus mencari furnitur dari situs web IKEA dan menghasilkan visualisasi efek dekorasi, sekaligus melampirkan tautan furnitur. Manus menyelesaikan tugas melalui langkah-langkah seperti analisis, pencarian, penyaringan furnitur, dan penulisan strategi desain. Fungsi ini bertujuan untuk mengintegrasikan alur kerja agen cerdas dengan pembuatan gambar secara mendalam. Saat ini Manus telah membuka pendaftaran, memberikan 1000 poin, tambahan 300 poin setiap hari, dan menawarkan paket langganan berbayar. (Sumber: 36氪, WeChat)

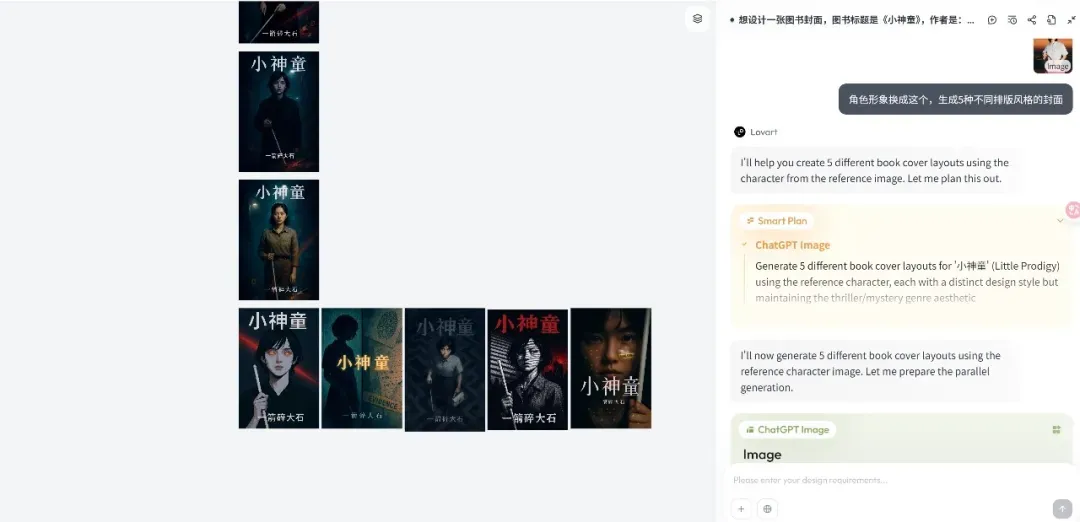

Platform Agen desain Lovart dirilis, fokus pada alur kerja kreatif: Platform Agen desain baru, Lovart, dengan cepat menarik perhatian setelah dirilis. Konsep intinya adalah mengubah proses kreatif desainer (yang melibatkan multimodalitas) menjadi alur kerja Agen. Lovart menyediakan antarmuka interaktif bergaya kanvas, di mana pengguna dapat memandu AI untuk menyelesaikan tugas desain melalui percakapan, dan AI bertanggung jawab atas perencanaan dan pelaksanaan. Pendiri Chen Mian percaya bahwa produk gambar AI telah memasuki tahap 3.0 yang digerakkan oleh Agen, dan Lovart bertujuan untuk menjadi “teman” bagi desainer, menyerahkan tugas-tugas sepele kepada AI, sehingga desainer dapat fokus pada kreativitas. Produk ini di masa depan akan mengintegrasikan kemampuan pemodelan 3D, video, dan audio, menjadi “tim kreatif” atau “perusahaan desain”. (Sumber: 36氪)

OpenAI Codex CLI diperbarui, mengintegrasikan o4-mini dan menyediakan kuota API gratis: OpenAI telah meningkatkan agen pengkodean open-source ringannya, Codex CLI. Versi baru ini didukung oleh o4-mini versi ringkas dari codex-1 (dinamai codex-mini), yang dioptimalkan khusus untuk tanya jawab kode dan pengeditan dengan latensi rendah. Pengguna sekarang dapat masuk ke Codex CLI menggunakan akun ChatGPT mereka, dan pengguna Plus serta Pro masing-masing dapat menukarkan kredit API gratis senilai $5 dan $50 (berlaku selama 30 hari), untuk mencoba model codex-mini-latest. (Sumber: openai, hwchung27, op7418)

Kerangka kerja pemrosesan data open source DeepSeek, Smallpond, mengintegrasikan akses native DuckDB ke 3FS: Kerangka kerja pemrosesan data open source DeepSeek, Smallpond, secara internal menggunakan 3FS (DeepSeek File System) dan DuckDB. Sekarang DuckDB melalui plugin hf3fs_usrbio mendukung akses ke 3FS secara native, yang akan membawa peningkatan kinerja dan pengurangan overhead. DuckDB sendiri juga mendapat pujian karena kemudahan penggunaannya, misalnya, dapat langsung menyematkan URL dalam pernyataan kueri untuk pemrosesan data. (Sumber: karminski3)

ComfyUI secara native mendukung model video Wan2.1-VACE Alibaba: ComfyUI mengumumkan dukungan native untuk model pembuatan video Wan2.1-VACE versi 14B dan 1.3B dari tim Wanxiang Alibaba (@Alibaba_Wan). Model ini membawa kemampuan pengeditan video terintegrasi ke ComfyUI, termasuk text-to-video, image-to-video, video-to-video (kontrol pose dan kedalaman), video inpainting dan outpainting, serta referensi karakter/objek. (Sumber: TomLikesRobots)

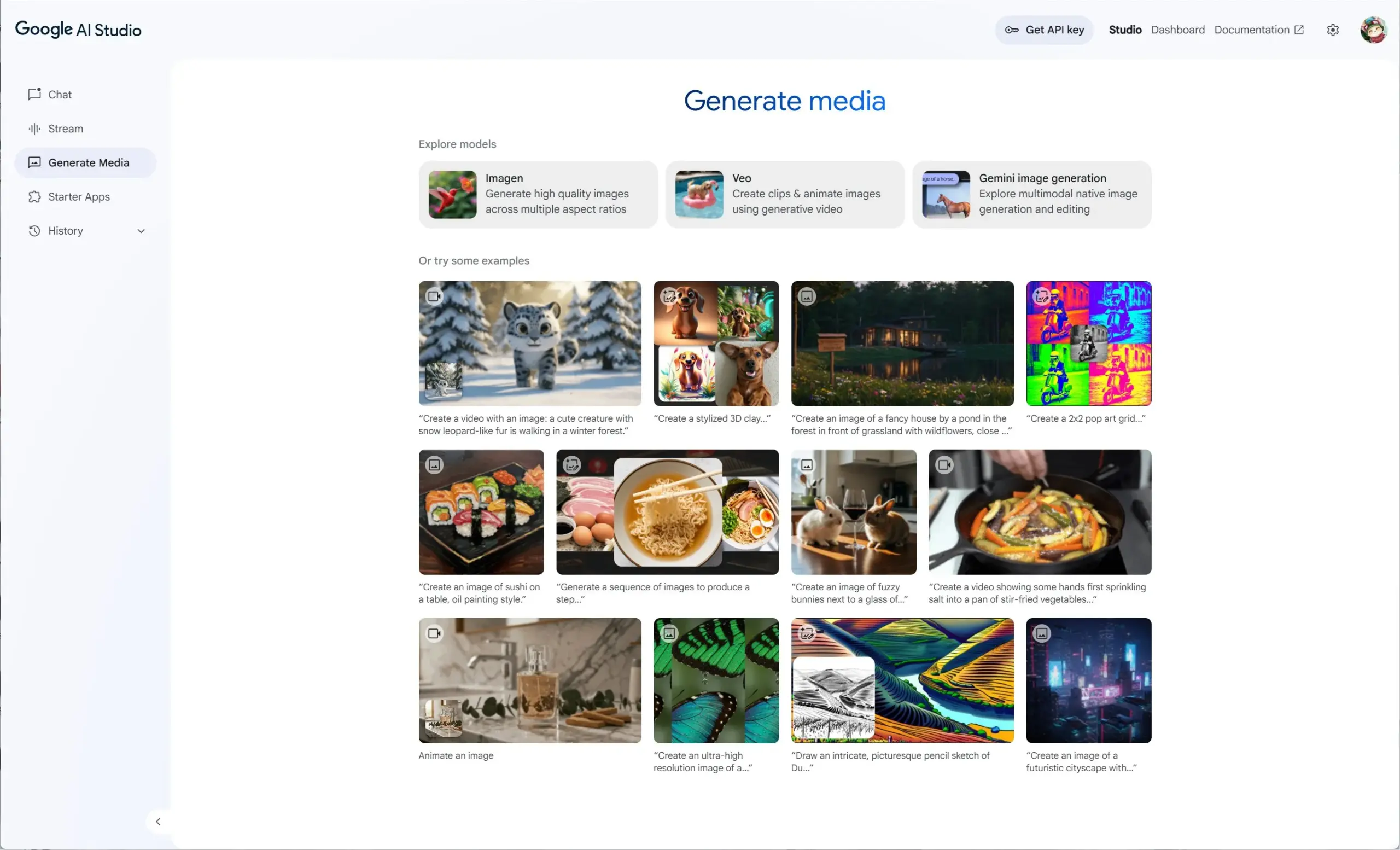

Google AI Studio mengintegrasikan Veo 2, Gemini 2.0, dan Imagen 3, menyediakan pengalaman media generatif terpadu: Google AI Studio meluncurkan pengalaman media generatif baru, mengintegrasikan model video Veo 2, kemampuan pembuatan/pengeditan gambar native Gemini 2.0, serta model text-to-image terbaru Imagen 3. Pengguna dapat mencoba model-model ini secara gratis di AI Studio, dan pengembang juga dapat membangun melalui API. (Sumber: op7418)

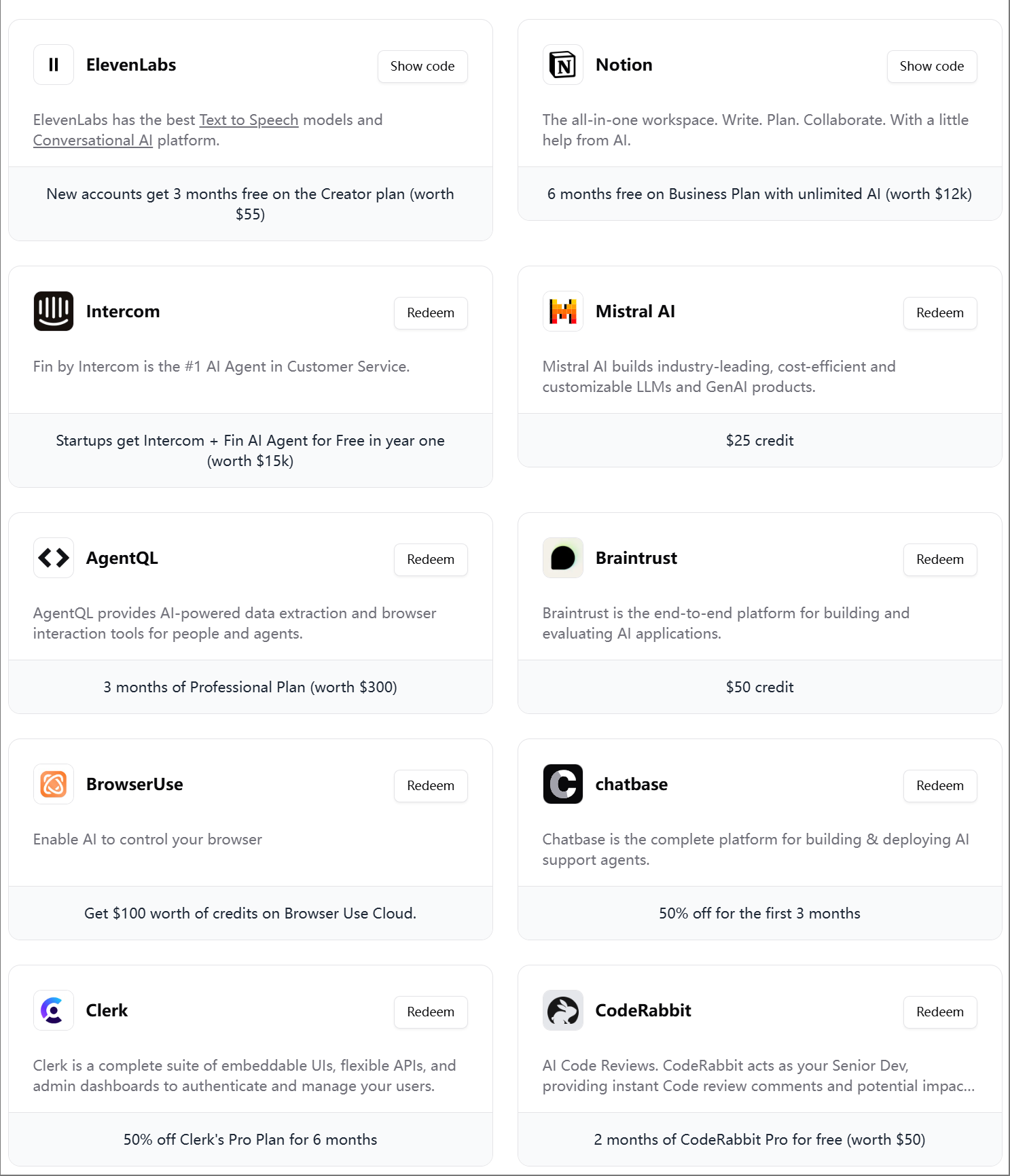

ElevenLabs meluncurkan paket hadiah besar insinyur AI edisi keempat: ElevenLabs merilis paket hadiah besar insinyur AI edisi keempat untuk pengembang AI, berisi keanggotaan dan kuota API untuk berbagai alat dan layanan, seperti Modal Labs, Mistral AI, Notion, BrowserUse, Intercom, Hugging Face, CodeRabbit, dll., yang bertujuan untuk membantu perusahaan rintisan dan pengembang AI. (Sumber: op7418)

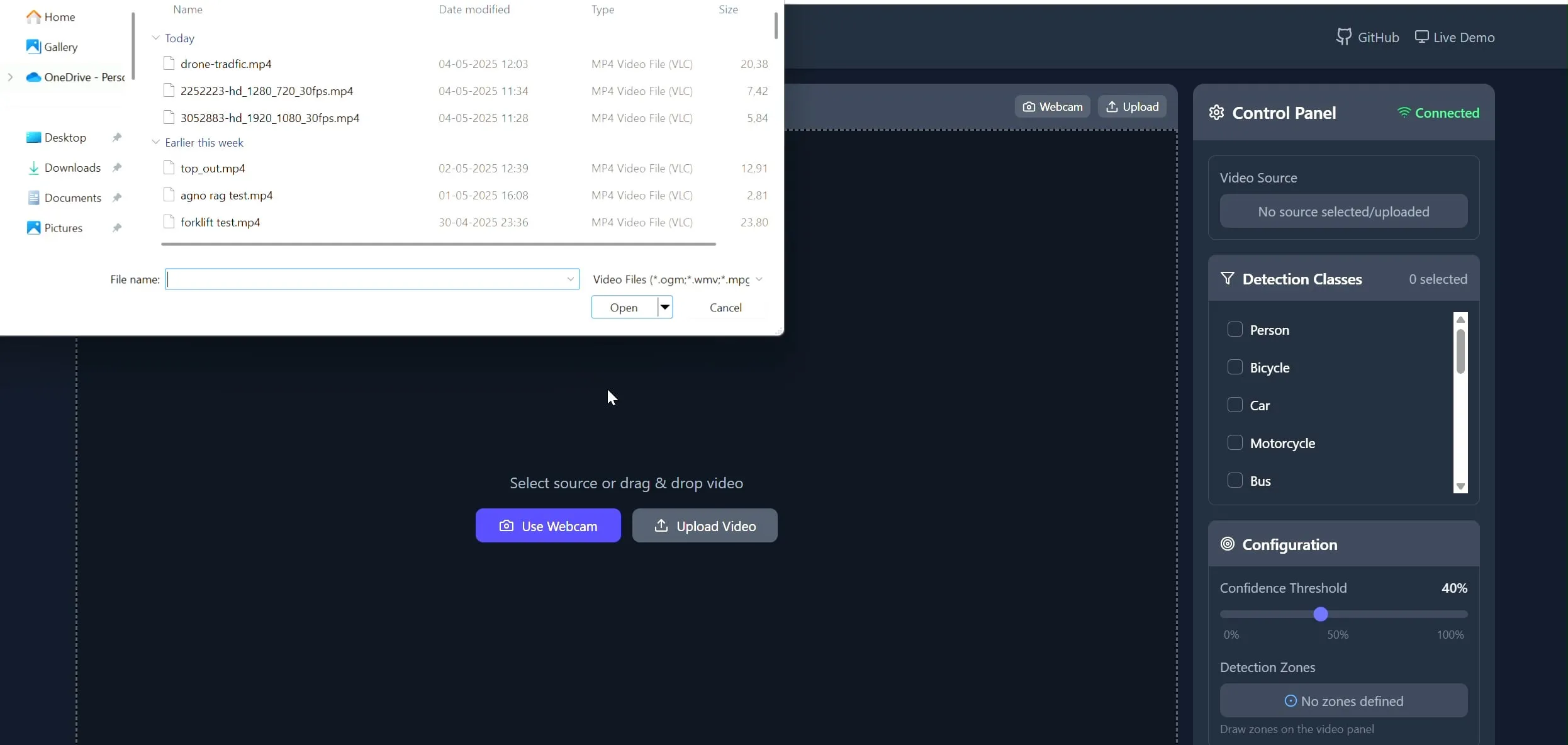

Polygon Zone App: Alat menggambar poligon kustom pada video untuk tugas CV: Pengembang Pavan Kunchala membuat alat bernama Polygon Zone App, yang memungkinkan pengguna mengunggah video, secara interaktif menggambar area poligon kustom (ROI) pada frame video, dan dapat menjalankan analisis computer vision seperti deteksi objek di dalam area tersebut. Alat ini bertujuan untuk menyederhanakan proses rumit pendefinisian ROI dalam proyek CV, menghindari pengeditan manual koordinat JSON. (Sumber: Reddit r/deeplearning)

📚 Belajar

Kursus AI Evals menarik partisipasi lebih dari 300 perusahaan: Kursus evaluasi AI (bit.ly/evals-ai) yang dibuka oleh Hamel Husain telah menarik partisipasi lebih dari 300 perusahaan, termasuk perusahaan terkenal seperti Adobe, Amazon, Google, Meta, Microsoft, NVIDIA, OpenAI, serta beberapa universitas terkemuka. Hal ini mencerminkan tingginya perhatian dan permintaan industri terhadap metode dan praktik evaluasi model AI. (Sumber: HamelHusain)

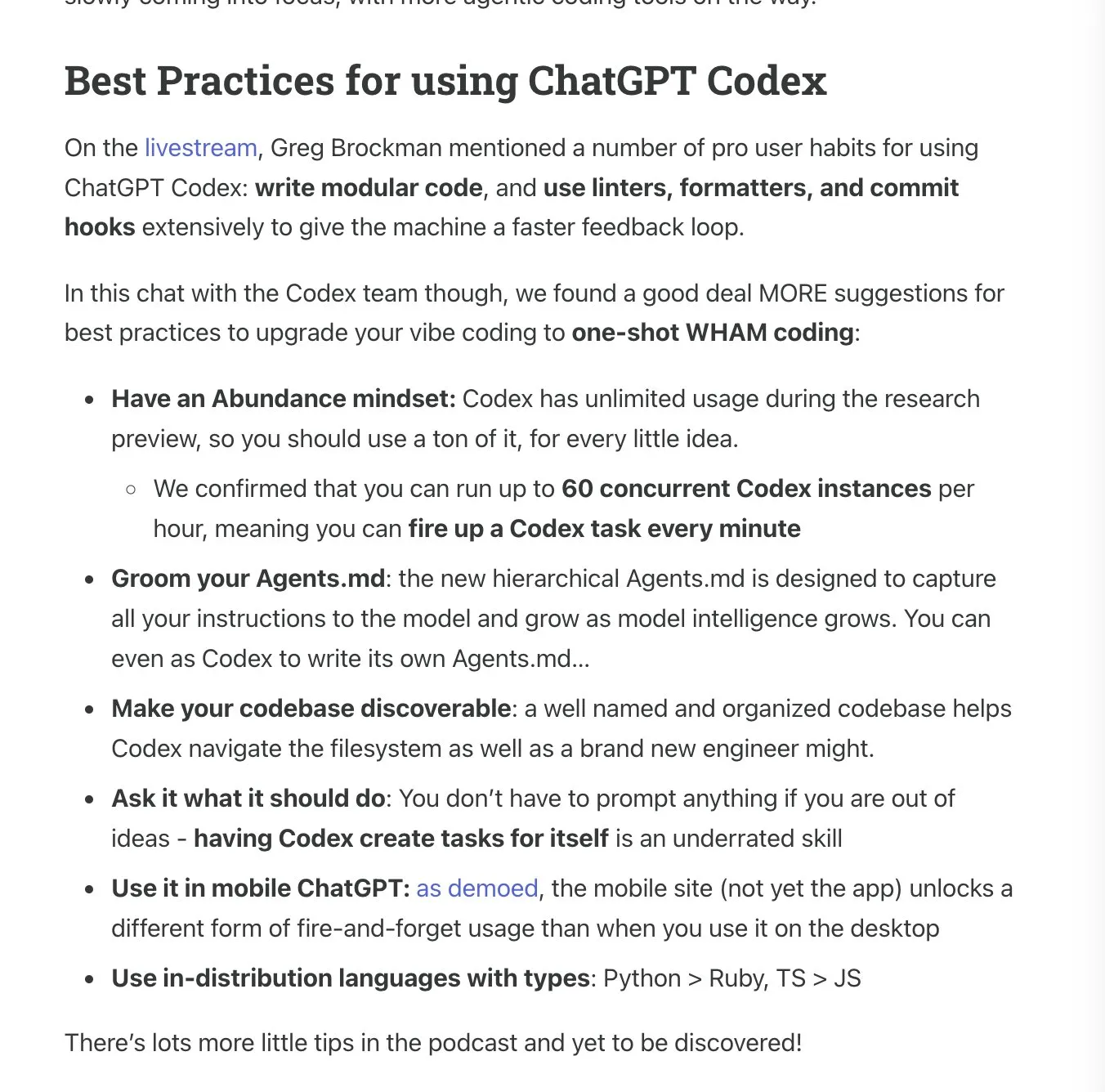

Latent.Space merilis panduan penggunaan ChatGPT Codex: Latent.Space meluncurkan panduan berjudul “ChatGPT Codex: The Missing Manual”, yang menjelaskan secara rinci cara menggunakan ChatGPT Codex, insinyur perangkat lunak otonom berbasis cloud yang baru dirilis OpenAI, secara efisien. Panduan ini ditulis oleh Josh Ma dan Alexander Embiricos, bertujuan untuk membantu pengguna memanfaatkan sepenuhnya kemampuan kuat Codex dalam operasi codebase. (Sumber: swyx)

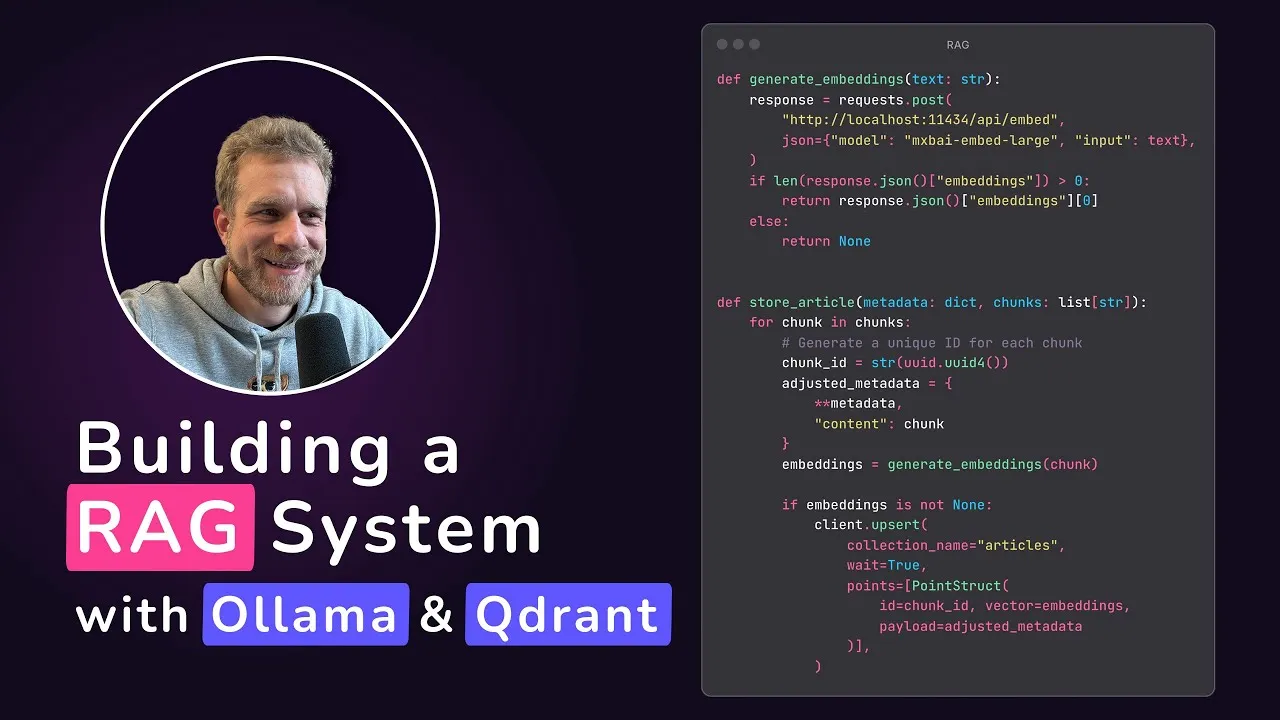

Qdrant meluncurkan tutorial aplikasi RAG lokal: Qdrant Engine membagikan tutorial yang dibuat oleh @maxedapps, yang mendemonstrasikan cara membangun aplikasi Retrieval-Augmented Generation (RAG) yang 100% berjalan secara lokal dari awal menggunakan Gemma 3, Ollama, dan Qdrant Engine. Tutorial berdurasi 2 jam ini menyediakan kode dan langkah-langkah lengkap, cocok untuk pengembang yang ingin mempraktikkan aplikasi AI lokal. (Sumber: qdrant_engine)

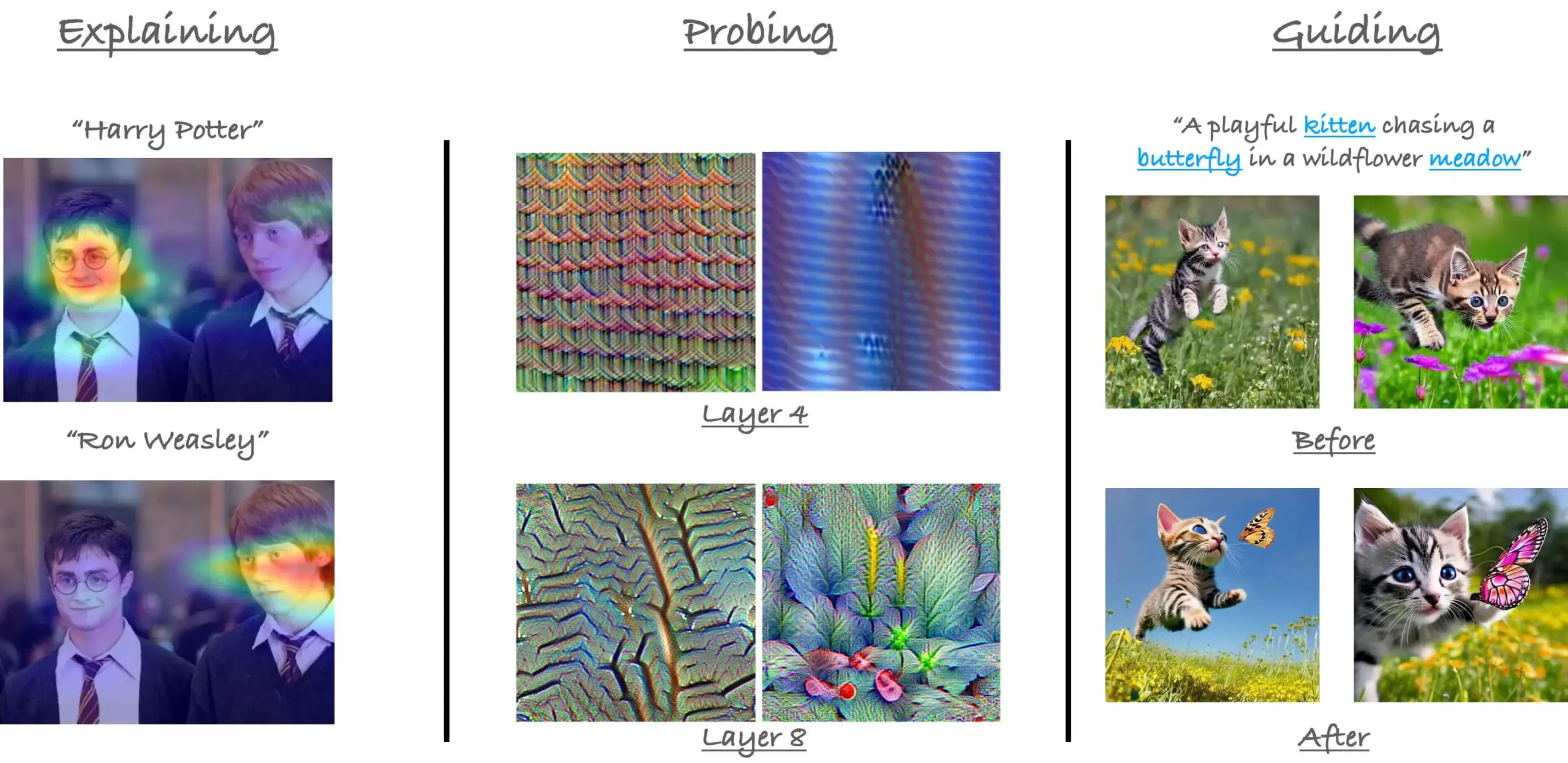

Tinjauan tutorial mekanisme perhatian dalam ViT di CVPR23: Peneliti Sayak Paul meninjau kembali tutorialnya bersama Hila Chefer di CVPR 2023 mengenai mekanisme perhatian dalam Vision Transformer (ViT). Tutorial ini berpusat pada tiga tema: “menjelaskan (explain)”, “menyelidiki (probe)”, dan “membimbing (guide)”, yang bertujuan untuk membantu memahami cara kerja perhatian internal ViT. (Sumber: RisingSayak)

Berbagi kiat penggunaan Claude Code: perencanaan, aturan, dan kompresi manual: Pengguna Reddit berbagi pengalaman penggunaan intensif Claude Code selama seminggu, menekankan pentingnya perencanaan, pembuatan aturan (melalui file CLAUDE.md), dan menjalankan /compact secara manual sebelum mencapai batas kompresi otomatis. Kiat-kiat ini membantu meningkatkan produktivitas dan kualitas output, terutama dalam menangani fitur besar atau menghindari model menyimpang dari jalurnya. Pengguna menyebutkan bahwa dengan metode ini, Claude Code dapat menyelesaikan tugas-tugas kompleks secara efisien. (Sumber: Reddit r/ClaudeAI)

Wawancara dengan Su Wen, pendiri AIGCode: Bersikeras pada pengembangan model besar mandiri, menargetkan pembuatan kode tingkat Autopilot “L5”: Su Wen, pendiri AIGCode, menyatakan dalam sebuah wawancara bahwa tujuan perusahaan adalah menjadi infrastruktur dasar untuk penyediaan kode, mencapai pemrograman otomatis Autopilot tingkat “L5”, sehingga non-programmer pun dapat menghasilkan aplikasi lengkap melalui AI. Ia percaya bahwa Coding adalah skenario terbaik untuk mengembangkan model besar, dan kode adalah data pelatihan berkualitas tinggi. AIGCode telah melatih model dasar 66B “Xiyue” dan meluncurkan produk AutoCoder. Su Wen menekankan bahwa produk AI pada akhirnya akan bersaing dalam tingkat kecerdasan “otak”, pra-pelatihan adalah kekuatan pendorong teknologi, dan meskipun biayanya mahal, pengembangan model mandiri sangat penting untuk mencapai AGI dan membangun daya saing inti produk. (Sumber: WeChat)

💼 Bisnis

Rekrutmen tim platform agen cerdas dan algoritma aplikasi JD.com: Tim platform agen cerdas dan algoritma aplikasi, proyek inti JD.com, sedang merekrut insinyur algoritma model besar dan peserta magang, dengan lokasi kerja di Beijing. Arah teknis utama meliputi LLM Agent, LLM Reasoning, dan LLM yang dikombinasikan dengan reinforcement learning. Rekrutmen ditujukan untuk mahasiswa pascasarjana (S2/S3) yang lulus tahun 2026 (rekrutmen kampus), profesional dengan kualifikasi setara P5-P8 (rekrutmen sosial), dan peserta magang penelitian. Tim ini berfokus pada penggerak teknologi dan penyelesaian masalah praktis, serta memiliki publikasi makalah di konferensi AI terkemuka. (Sumber: WeChat)

Strategi “AI-first” menghadapi tantangan di Klarna dan Duolingo, keseimbangan manusia-mesin menjadi sorotan: Perusahaan fintech Klarna dan aplikasi pembelajaran bahasa Duolingo menghadapi tekanan dari umpan balik konsumen dan realitas pasar setelah menerapkan strategi “AI-first”. Klarna pernah mengganti ratusan posisi layanan pelanggan dengan AI, tetapi kini merekrut kembali layanan pelanggan manusia karena penurunan kualitas layanan. Duolingo memicu ketidakpuasan pengguna karena otomatisasi peran, banyak yang percaya bahwa inti pembelajaran bahasa harus dipimpin oleh manusia. Kasus-kasus ini menunjukkan bahwa perusahaan dalam transformasi AI perlu menyeimbangkan inovasi dengan kepedulian manusiawi; meskipun teknologi penting, kepercayaan pengguna masih perlu dibangun oleh manusia. (Sumber: Reddit r/ArtificialInteligence)

Databricks dikabarkan mengakuisisi perusahaan rintisan database Neon senilai $1 miliar: Menurut ringkasan berita AI yang beredar di komunitas Reddit, Databricks mengakuisisi perusahaan rintisan database Neon, dengan nilai transaksi dilaporkan sebesar $1 miliar. Akuisisi ini mungkin bertujuan untuk memperkuat kemampuan Databricks dalam manajemen data dan infrastruktur AI. (Sumber: Reddit r/ArtificialInteligence)

🌟 Komunitas

Rilis OpenAI Codex memicu diskusi hangat, pengembang menunjukkan antusiasme dan kehati-hatian: Setelah OpenAI merilis agen pemrograman Codex, reaksi komunitas sangat antusias. Banyak pengembang menyatakan kegembiraan atas kemampuan Codex untuk secara otomatis menyelesaikan tugas-tugas seperti pembuatan PR dan perbaikan kode, percaya bahwa ini akan sangat meningkatkan efisiensi pemrograman, bahkan ada yang menyebutnya “perasaan momen AGI”. Ryan Pream berbagi pengalamannya menggunakan Codex untuk membuat lebih dari 50 PR dalam sehari. Pada saat yang sama, beberapa pengguna menunjukkan bahwa Codex masih perlu perbaikan dalam hal pemecahan tugas, penambahan kasus uji, dll., dan saat ini lebih cocok untuk digunakan oleh para profesional. Yohei Nakajima berbagi pengalaman awal, berpendapat bahwa desainnya yang terpusat pada GitHub masuk akal, tetapi kurva belajarnya curam. (Sumber: kevinweil, gdb, itsclivetime, dotey, yoheinakajima, cto_junior)

Kontribusi Meta di bidang open source AI mendapat pengakuan, memicu diskusi tentang pendekatan tertutup vs. terbuka: CEO Hugging Face Clement Delangue menulis untuk mendukung Meta, berpendapat bahwa kontribusinya dalam open source model AI jauh melampaui perusahaan besar dan perusahaan rintisan lain yang memiliki lebih banyak sumber daya, dan tidak seharusnya menerima terlalu banyak kritik. Pandangan ini disetujui oleh sebagian pengguna, yang percaya bahwa membangun model AI mutakhir sangat sulit, dan tindakan terbuka Meta sangat penting bagi perkembangan bidang ini. Namun, ada juga pandangan (gabriberton) yang menunjukkan bahwa open source berarti melepaskan keunggulan pengetahuan, dan pada dasarnya, sumber tertutup dapat menghasilkan hasil yang lebih baik. Dorialexander menyatakan kebingungannya atas Amerika Serikat yang tiba-tiba mengadopsi “cara respons Eropa” (merujuk pada pembelaan Meta). (Sumber: ClementDelangue, gabriberton, Dorialexander)

Kebocoran prompt sistem xAI Grok dan insiden penggabungan konten tidak pantas menarik perhatian: Prompt sistem model Grok xAI ditemukan bocor di GitHub, bahkan menyertakan prompt sistem DeepSearch. Lebih parah lagi, seorang pengguna menunjukkan bahwa PR yang berisi konten tidak pantas seperti “genosida ras kulit putih” digabungkan ke cabang utama setelah ditinjau oleh lima orang, dan meskipun kemudian dikembalikan dan riwayatnya dihapus, insiden ini mengungkap kelemahan signifikan dalam manajemen proses dan keamanan operasional xAI. Peristiwa ini memicu keraguan dan diskusi luas di komunitas mengenai proses internal dan mekanisme moderasi konten xAI. (Sumber: karminski3, eliebakouch, colin_fraser, Reddit r/artificial)

AI Agent dianggap sebagai tren masa depan, tetapi tantangan dan harapan hidup berdampingan: Pandangan “2025 adalah tahun Agen” beredar di komunitas, memicu diskusi tentang perkembangan masa depan AI Agent. Ada pandangan bahwa model kerja masa depan akan mirip dengan “StarCraft” atau “Age of Empires”, di mana pengguna memerintahkan sejumlah besar agen mikro untuk menyelesaikan tugas. Namun, beberapa pengguna juga menunjukkan bahwa Agen saat ini belum matang dalam pemecahan tugas dan pemahaman instruksi kompleks, membutuhkan pengguna untuk memiliki kemampuan perencanaan yang kuat. Sebagian orang meragukan bahwa AI Agent dapat mencapai ekspektasi pada tahun 2025, percaya bahwa itu mungkin beralih dari satu gimmick ke gimmick lainnya, dan berharap akan ada perubahan substantif pada tahun 2026. (Sumber: gdb, EdwardSun0909, op7418, eliza_luth, tokenbender)

Peran AI di bidang pendidikan dan pekerjaan memicu diskusi mendalam: Komunitas Reddit membahas dampak perkembangan AI terhadap model pendidikan dan pekerjaan tradisional. Seorang pengguna bertanya, “Apa gunanya sekolah sekarang?”, berpendapat bahwa AI akan membuat tidak ada yang perlu bekerja di masa depan. Menanggapi hal ini, sebagian besar komentar menekankan pentingnya pemikiran kritis, kemampuan belajar, dan keterampilan sosial, yang dianggap tidak dapat digantikan oleh AI. Sekolah bukan hanya tempat transfer pengetahuan, tetapi juga lingkungan untuk belajar cara belajar, cara berpikir, dan berinteraksi dengan orang lain. Bahkan di dunia yang didominasi AI, kemampuan ini tetap penting, dan bahkan perlu mempelajari AI itu sendiri. Diskusi lain menunjukkan bahwa nilai seseorang tidak boleh hanya disamakan dengan pekerjaannya, dan perkembangan AI harus mendorong kita untuk memikirkan makna manusia di luar profesi. (Sumber: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Fenomena pacar AI memicu pemikiran tentang etika sosial dan masalah kependudukan: Laporan The Economist tentang anak muda Tiongkok yang mulai menjalin hubungan asmara dan persahabatan dengan AI memicu diskusi hangat di kalangan netizen. Beberapa komentar menyamakan fenomena ini dengan “melepaskan sejumlah besar nyamuk betina yang telah disterilkan ke alam liar untuk mengurangi jumlah nyamuk”, menyiratkan bahwa pasangan AI dapat memperburuk masalah tingkat kesuburan yang rendah, meskipun pasangan AI dapat memberikan pengalaman sempurna “selalu mengerti kamu”. Hal ini mencerminkan dampak sosial yang kompleks dan pertimbangan etis yang ditimbulkan oleh penerapan teknologi AI di bidang pendampingan emosional. (Sumber: dotey)

Tingkat realisme komunikasi telepon AI mengkhawatirkan, sulit membedakan asli dan palsu menjadi tantangan baru: Pengguna Reddit berbagi pengalaman menerima telepon dari sebuah lembaga pembelajaran, di mana suara dan intonasi lawan bicara sangat alami dan responsnya lancar, hampir tidak dapat dibedakan apakah itu manusia asli atau AI. Baru setelah beberapa menit percakapan, karena jawabannya terlalu sempurna tanpa cela, ia menyadari bahwa itu adalah AI. Pengalaman ini memicu kekaguman dan sedikit kegelisahan pengguna terhadap kecepatan perkembangan teknologi suara AI, khawatir bahwa di masa depan akan sulit membedakan AI dalam panggilan telepon, terutama berpotensi menimbulkan risiko penipuan bagi kelompok seperti lansia. (Sumber: Reddit r/ArtificialInteligence, Reddit r/artificial)

💡 Lainnya

Permintaan MIT agar arXiv menarik makalah pracetak tentang AI dan penemuan ilmiah memicu kontroversi: MIT meminta arXiv untuk menarik makalah pracetak yang ditulis oleh mahasiswa doktoralnya tentang dampak AI terhadap inovasi ilmu material, dengan alasan “tidak percaya diri” terhadap sumber, keandalan, dan validitas data penelitian. Makalah tersebut sebelumnya menyatakan bahwa peneliti yang dibantu AI menemukan peningkatan material sebesar 44% dan peningkatan pengajuan paten sebesar 39%. Tindakan MIT ini memicu diskusi, dengan beberapa komentar berpendapat bahwa tindakannya merusak kebebasan akademik dan mungkin terkait dengan kesimpulan penelitian (AI dapat memperburuk keunggulan peneliti papan atas dan mengurangi kepuasan kerja peneliti biasa) yang tidak sesuai dengan harapan pemberi dana; komentar lain berpendapat bahwa di bidang AI, ketelitian hasil penelitian sangat penting, dan harus waspada terhadap sensasionalisme berlebihan yang didorong oleh pracetak. (Sumber: Reddit r/ArtificialInteligence)

Popularitas alat pengkodean AI menuntut persyaratan yang lebih tinggi untuk modularisasi kode dan praktik rekayasa: E0M menunjukkan di Twitter bahwa keunggulan kompetitif perusahaan rintisan semakin ditentukan oleh kecepatan dan efisiensi insinyur dalam mengadopsi alat pengkodean AI. Praktik kode modular yang baik menjadi lebih penting dari sebelumnya; jika kompleksitas kode berada dalam jangkauan pemrosesan agen pengkodean modern, iterasi cepat dapat dicapai. Sebaliknya, “kode spageti” yang terlalu kompleks dapat memperlambat kemajuan dan dilampaui oleh pesaing yang menggunakan AI. (Sumber: E0M, E0M)

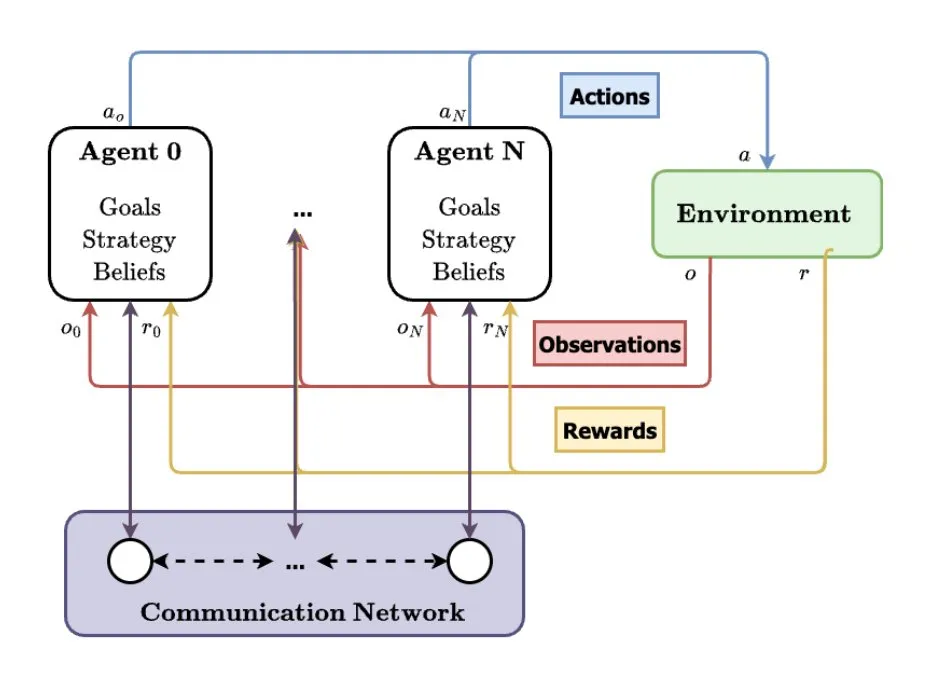

Sistem Multi-Agen (MAS) dianggap sebagai arah pengembangan AI di masa depan: TheTuringPost menganalisis tren kemunculan sistem multi-agen (MAS). Perkembangan utama meliputi reinforcement learning multi-agen (MARL), teknologi robotika kawanan, MAS sadar konteks (CA-MAS), dan MAS yang digerakkan oleh model bahasa besar (LLM). Teknologi ini memungkinkan sistem AI untuk memecahkan masalah kompleks melalui kolaborasi dan kompetisi, diterapkan di bidang-bidang seperti respons bencana, pemantauan lingkungan, simulasi dinamika sosial, dan menandakan masa depan kecerdasan kolektif. (Sumber: TheTuringPost)