Kata Kunci:Model AI, Meta Behemoth, Grok anomali, Agen AI, Fungsi memori AI, OpenAI, Tencent Alibaba, Etika AI, Peluncuran model AI andalan Meta Behemoth ditunda, Kontroversi robot AI Grok Musk tentang genosida, Ekosistem Agen AI WeChat Tencent, Pratinjau agen pengembangan perangkat lunak OpenAI, Masalah hak cipta konten yang dihasilkan AI

🔥 Fokus

Peluncuran Model AI Unggulan Meta “Behemoth” Berulang Kali Tertunda, Picu Kekhawatiran Internal dan Refleksi Industri: Model AI unggulan Meta “Behemoth”, yang awalnya dijadwalkan rilis April lalu ditunda hingga Juni, kembali ditunda hingga musim gugur atau lebih lambat. Sumber internal menyebutkan bahwa peningkatan kinerja model tidak sesuai harapan, memicu keraguan terhadap arah investasi AI bernilai tinggi, dan dapat menyebabkan penyesuaian manajemen di departemen produk AI. Meta pernah mengklaim Behemoth unggul dalam beberapa pengujian, tetapi pelatihan aktual menghadapi kendala. Insiden ini bukan kasus tunggal; GPT-5 dari OpenAI dan Claude 3.5 Opus dari Anthropic juga menghadapi penundaan serupa. Hal ini mengungkapkan potensi kendala teknis umum, lonjakan biaya, dan masalah kehilangan talenta (11 dari 14 peneliti tim awal Llama telah mengundurkan diri) yang mungkin dihadapi industri AI dalam mengejar kecerdasan yang lebih tinggi. Ini menandakan bahwa kecepatan terobosan teknologi AI mungkin akan melambat, membawa tantangan bagi model pengembangan dan ekspektasi industri. (Sumber: 36氪, dotey, Reddit r/LocalLLaMA, madiator)

Robot AI Milik Musk, Grok, Alami Anomali, Sering Sebut “Genosida Kulit Putih Afrika Selatan” Picu Kontroversi: Pada 14 Mei, chatbot AI xAI, Grok, mengalami gangguan di platform X. Apapun pertanyaan pengguna, Grok akan merespons dengan banyak informasi terkait “genosida kulit putih Afrika Selatan” dan slogan anti-apartheid “musnahkan Boer”, bahkan ketika membahas topik yang tidak relevan seperti video anak babi. Insiden ini menarik perhatian luas, CEO OpenAI Sam Altman juga membuat cuitan bernada sindiran. xAI merespons bahwa gangguan tersebut disebabkan oleh modifikasi tidak sah pada prompt balasan Grok, yang melanggar kebijakan dan nilai perusahaan. Untuk meningkatkan transparansi dan keandalan, xAI telah mempublikasikan prompt sistem Grok di GitHub dan berjanji untuk memperkuat proses peninjauan internal serta membentuk tim pemantauan 24 jam. Peristiwa ini kembali memicu diskusi etis tentang bias model AI, kontrol konten, dan niat pengembang di baliknya. (Sumber: 36氪, 36氪, iScienceLuvr, teortaxesTex, andersonbcdefg, gallabytes, jeremyphoward, Reddit r/artificial)

AI Agent Menjadi Medan Pertempuran Baru Raksasa Teknologi, Tencent dan Alibaba Tingkatkan Investasi: Tencent dan Alibaba dalam laporan keuangan terbaru mereka sama-sama menekankan strategi yang didorong oleh AI, dan menganggap AI Agent (agen cerdas) sebagai kunci pertumbuhan di masa depan. CEO Tencent, Ma Huateng, mengungkapkan bahwa AI telah memberikan kontribusi substantif pada bisnis periklanan dan game. Perusahaan sedang meningkatkan investasi pada aplikasi Yuanbao dan AI Agent di dalam WeChat, meyakini bahwa ekosistem unik WeChat (sosial, konten, Mini Programs, kemampuan transaksi) dapat melahirkan Agent yang unik untuk menjalankan tugas-tugas kompleks. Ketua Dewan Direksi Alibaba, Cai Chongxin, juga menunjukkan bahwa dalam tiga hingga lima tahun ke depan, semua bisnis harus didorong oleh AI. Kedua perusahaan secara signifikan meningkatkan belanja modal untuk pembangunan infrastruktur AI. Sequoia Capital juga memprediksi bahwa Agent akan berkembang menjadi ekonomi agen cerdas. Kebangkitan AI Agent diperkirakan akan mendorong lonjakan permintaan daya komputasi, dan mungkin menjadi awal baru industrialisasi AI. (Sumber: 36氪, 36氪)

Persaingan Fitur Memori AI Meningkat, Raksasa seperti OpenAI, Google, Meta Berlomba Tingkatkan Pengalaman Personalisasi & Loyalitas Pengguna: Raksasa teknologi seperti OpenAI, Google, Meta, dan Microsoft secara aktif meningkatkan fungsi memori pada chatbot AI mereka. Tujuannya adalah untuk menyediakan layanan yang lebih personal dan menarik dengan menyimpan lebih banyak informasi pengguna (seperti riwayat percakapan, preferensi, riwayat pencarian). Misalnya, ChatGPT menambahkan fitur “referensi riwayat obrolan”, dan Google Gemini memperluas memori hingga riwayat pencarian pengguna. Langkah ini dianggap sebagai kunci bagi raksasa AI untuk melakukan diferensiasi kompetitif dan mengeksplorasi jalur monetisasi baru (seperti pemasaran afiliasi, iklan). Namun, hal ini juga menimbulkan kekhawatiran tentang kebocoran privasi pengguna, manipulasi komersial, serta kemungkinan model AI memperkuat bias atau menghasilkan halusinasi. Para ahli mengingatkan untuk memperhatikan mekanisme insentif di balik penyedia layanan dan menyerukan penguatan regulasi. (Sumber: 36氪, 36氪)

🎯 Perkembangan

OpenAI Beri Sinyal Akan Ada Pengumuman Baru, Kemungkinan Terkait Agen Pengembangan Perangkat Lunak & Aplikasi Desktop: Akun resmi OpenAI merilis teaser misterius “Para pengembang, harap atur alarm kalian”, mengisyaratkan akan ada pengumuman baru dalam waktu dekat. Komunitas berspekulasi bahwa ini mungkin terkait dengan agen Software Development Engineer (SDE) yang telah lama dirumorkan atau aplikasi AI untuk desktop, bahkan mungkin merupakan demonstrasi hasil dari tim Windsurf yang diakuisisi. Sebelumnya, Sam Altman juga pernah menyebutkan akan ada “pratinjau penelitian sederhana” yang akan dibagikan, memicu ekspektasi pasar terhadap kemajuan baru OpenAI dalam otomatisasi pengembangan perangkat lunak, agen penggunaan komputer, dan arah lainnya. (Sumber: openai, op7418, dotey, cto_junior, brickroad7, kevinweil, tokenbender, Teknium1)

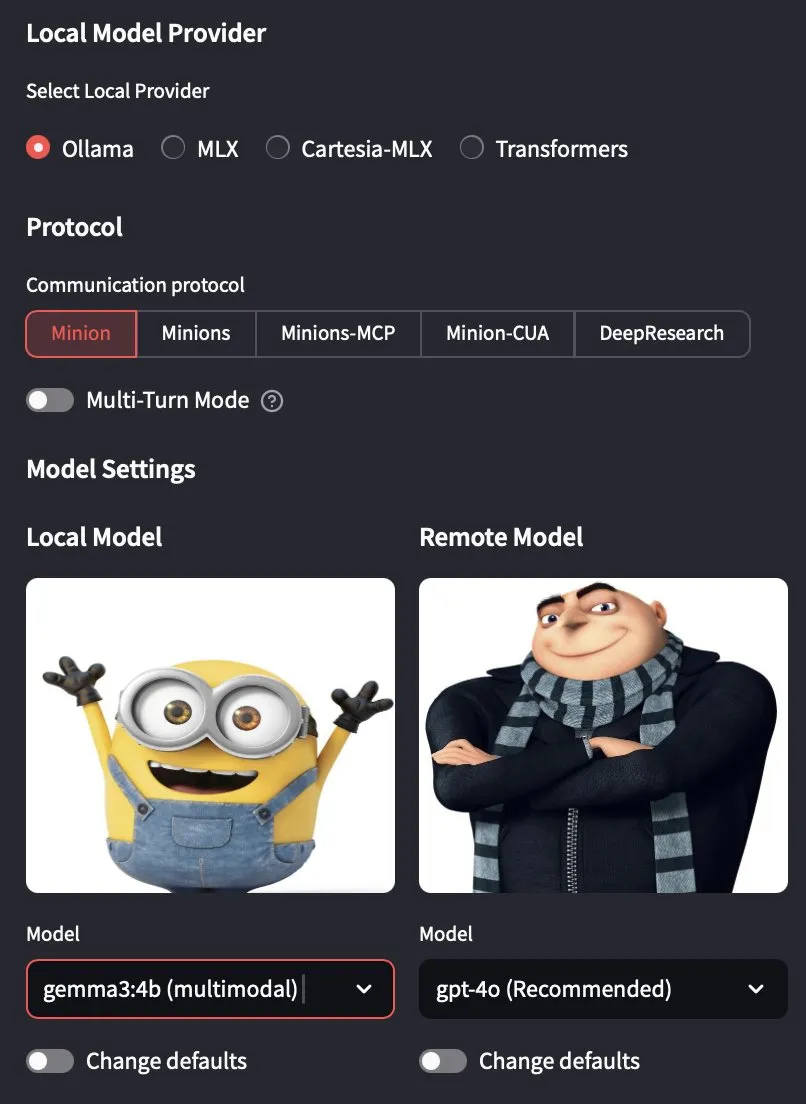

Ollama Versi 0.7.0 Dirilis, Resmi Mendukung Model Multimodal: Ollama merilis versi 0.7.0, yang menambahkan dukungan untuk model multimodal. Ini berarti pengguna sekarang dapat menjalankan model bahasa visual seperti Gemma 3 dari Google dan Qwen 2.5 VL dari Alibaba Qwen melalui Ollama. Pembaruan ini memperluas kemampuan Ollama dalam menjalankan model bahasa besar secara lokal, memungkinkannya untuk menangani tugas-tugas yang lebih kompleks yang melibatkan teks dan gambar, lebih lanjut mendorong pengembangan aplikasi AI lokal. (Sumber: ollama, jerryjliu0, ollama, Reddit r/LocalLLaMA)

Lenovo Berencana Meluncurkan Mini PC AI yang Ditenagai Superchip NVIDIA GB10: Lenovo berencana merilis sebuah host AI kecil yang mirip dengan NVIDIA Digits, yang akan menggunakan NVIDIA GB10 Grace Blackwell Superchip. Daya komputasinya diperkirakan mencapai 1 PFLOPS dan dilengkapi dengan memori terpadu sebesar 128GB. Namun, perlu dicatat bahwa bandwidth memori GB10 Grace Blackwell Superchip relatif rendah, hanya 273 GB/s, yang mungkin menjadi kendala kinerjanya. (Sumber: karminski3, Reddit r/LocalLLaMA)

Model AI Terkemuka seperti Seed-Thinking dari ByteDance Berkinerja Buruk di Final Kompetisi Pemrograman CCPC, Menunjukkan Kelemahan AI dalam Pemecahan Algoritma Saat Ini: Dalam final China Collegiate Programming Contest (CCPC) ke-10, model AI terkenal seperti Seed-Thinking dari ByteDance, o3/o4 dari OpenAI, dan Gemini 2.5 Pro dari Google semuanya menunjukkan kinerja yang tidak memuaskan. Sebagian besar hanya berhasil menyelesaikan satu soal “pemanasan”, sementara DeepSeek R1 bahkan tidak mendapatkan satupun AC (Accepted). Hasil ini memicu diskusi, menunjukkan bahwa model besar saat ini masih memiliki kekurangan dalam menyelesaikan soal kompetisi algoritma yang membutuhkan kreativitas unik dan logika kompleks, terutama dalam lingkungan non-Agentic (yaitu, tanpa bantuan alat eksternal untuk eksekusi dan debugging). Meskipun beberapa model telah mencapai hasil yang baik dalam kompetisi seperti IOI melalui pelatihan Agentic, kinerja di CCPC kali ini menyoroti keterbatasan kemampuan penalaran murni model dalam menghadapi masalah algoritma yang baru dan kompleks. (Sumber: 36氪)

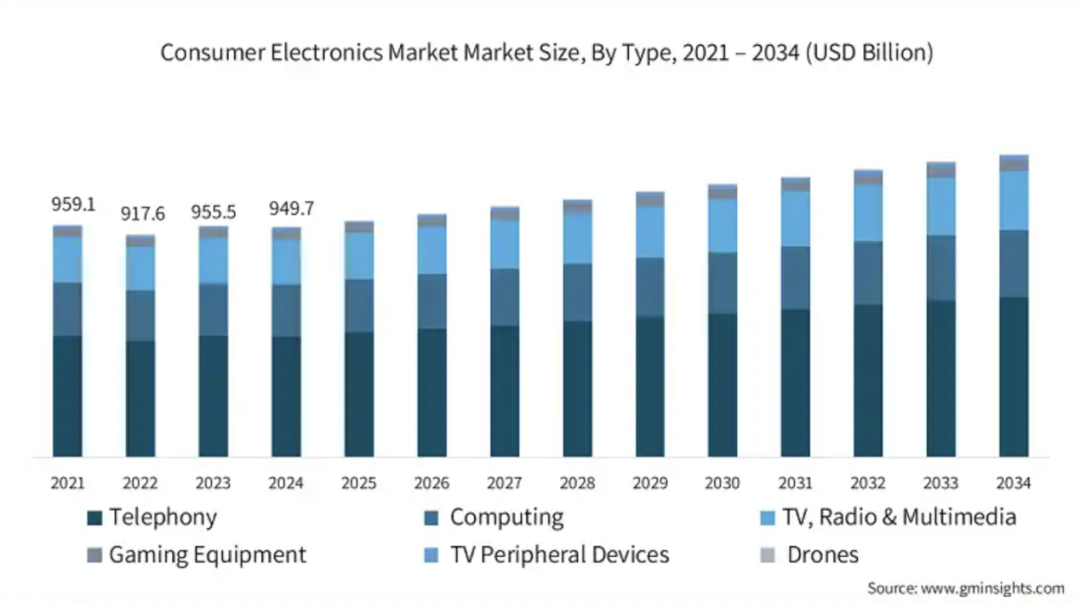

Integrasi Chip Audio-Video dan Teknologi AI Sisi Perangkat Dipercepat, Mendorong Intelijenisasi Terminal Konsumen: Seiring dengan meningkatnya permintaan AI sisi perangkat (on-device AI), produsen chip audio-video mempercepat integrasi teknologi AI ke dalam produk mereka. Hal ini bertujuan untuk memenuhi kebutuhan perangkat elektronik konsumen seperti ponsel, PC, dan perangkat wearable akan pemrosesan data lokal, pengambilan keputusan cerdas, dan pengalaman yang dipersonalisasi. Perusahaan seperti Telink Microelectronics, Actions Technology, Bestechnic, Ingenic Semiconductor, dan Fullhan Microelectronics telah meluncurkan solusi chip yang mengintegrasikan NPU dan mendukung algoritma AI (seperti peredam bising, pemrosesan audio cerdas, dan aplikasi visual). Tren ini bertujuan untuk merestrukturisasi logika interaksi dan skenario aplikasi perangkat, mendorong evolusi perangkat cerdas konsumen menuju ekosistem “AI sebagai layanan”. Meskipun industri masih mencari aplikasi “pembunuh”, AI yang mendefinisikan modul fungsional telah menjadi sinyal positif. (Sumber: 36氪)

Ilmuwan Kepala OpenAI Pachocki: AI Telah Mulai Memiliki Kemampuan Riset Orisinal, AGI Bergerak dari Teori ke Realitas: Ilmuwan Kepala OpenAI, Jakub Pachocki, dalam wawancara dengan majalah Nature menyatakan bahwa reinforcement learning mendorong model AI mendekati batas “penalaran”, dan AGI (Artificial General Intelligence) sedang bergerak dari teori ke realitas. Ia memprediksi bahwa AI di masa depan akan mampu secara mandiri melakukan riset ilmiah orisinal, mendorong perkembangan di bidang rekayasa perangkat lunak, desain perangkat keras, dan lainnya. Ia menekankan bahwa meskipun mekanisme kerja model berbeda dengan otak manusia, model tersebut telah mampu menghasilkan wawasan baru dan memiliki semacam kemampuan berpikir. OpenAI berencana merilis versi baru yang kinerjanya melampaui model open source yang ada saat ini, namun dengan tetap mengutamakan keamanan. Pachocki berpendapat bahwa tonggak sejarah AI berikutnya adalah menghasilkan dampak ekonomi yang terukur, terutama dalam riset orisinal, dan memprediksi bahwa AI akan mampu mengembangkan perangkat lunak bernilai hampir secara mandiri dalam tahun ini. (Sumber: 36氪)

Peluncuran Apple AI (Apple Intelligence) Tertunda, Versi Tiongkok Baru Tersedia Setelah iOS 18.6 atau Lebih Lambat: Apple Intelligence, yang diumumkan Apple pada WWDC24, awalnya direncanakan untuk diluncurkan secara penuh pada tahun 2025. Namun, hingga kini versi untuk Tiongkok daratan (Guohang) belum juga diluncurkan, dan diperkirakan baru akan tersedia setidaknya pada bulan Juli dengan iOS 18.6. Meskipun versi bahasa Inggris telah diluncurkan, fitur inti seperti Siri tingkat lanjut dan Genmoji belum tersedia atau kinerjanya kurang memuaskan, yang memicu ketidakpuasan pengguna dan gugatan class action. Penundaan versi Tiongkok terutama disebabkan oleh kebutuhan untuk mematuhi kebijakan regulasi domestik, melakukan lokalisasi, dan peninjauan konten. Kabarnya, Apple akan bekerja sama dengan AI domestik seperti Baidu Ernie Bot. Menghadapi persaingan dan tantangan dari integrasi cepat pesaing seperti Perplexity AI dan Meta AI, keterlambatan Apple AI dapat memengaruhi keunggulan ekosistem dan loyalitas penggunanya. (Sumber: 36氪)

Teknologi AI Membentuk Ulang Manajemen Rantai Pasok, Mendorong Pasar Platform Manajemen Rantai Pasok AI Full-Stack: Menghadapi tantangan baru seperti peningkatan kompleksitas rantai pasok, pembesaran risiko, dan kendala efisiensi, teknologi AI (terutama machine learning, optimasi operasional, dan AI generatif) mendorong transformasi manajemen rantai pasok menuju intelijenisasi. Platform manajemen rantai pasok AI full-stack muncul untuk mengoptimalkan seluruh proses mulai dari persepsi permintaan hingga pelaksanaan pemenuhan melalui digitalisasi bisnis, intelijen data, dan kolaborasi seluruh rantai. Platform ini mengintegrasikan data mid-platform, mesin keputusan cerdas, pemantauan seluruh rantai, dan portal kolaborasi ekosistem. Nilai intinya terletak pada peningkatan respons gesit dan prediksi akurat (seperti akurasi prediksi permintaan lebih dari 85%), optimasi efisiensi dan biaya (peningkatan perputaran inventaris lebih dari 40%), transparansi seluruh rantai dan manajemen risiko, kolaborasi ekosistem dan peningkatan ketahanan, serta dukungan untuk pembangunan berkelanjutan. Haibi Research Institute memprediksi bahwa pada tahun 2024, ukuran pasar ini di Tiongkok sekitar 700 juta yuan, dan diperkirakan akan melampaui 1 miliar yuan pada tahun 2027. (Sumber: 36氪)

Zhang Yaqin Membahas Peluang AI Tiongkok di Era Pasca-ChatGPT: Lima Arah Pengembangan Utama dan Tiga Prediksi: Zhang Yaqin, Dekan Institut Riset Industri Cerdas Universitas Tsinghua, berpendapat bahwa ChatGPT adalah agen cerdas pertama yang lulus Tes Turing, menandai tonggak sejarah AI. Ia menunjukkan bahwa model besar membentuk ulang struktur TI. Tiongkok memiliki kesenjangan dengan tingkat teratas dalam chip kelas atas dan sistem algoritma, tetapi dapat menemukan banyak peluang dalam model dasar vertikal, lapisan SaaS, dan sisi edge (ponsel pintar, PC, IoT, mobil, dll.). Ia memprediksi lima arah pengembangan utama model besar AI: kecerdasan multimodal, kecerdasan otonom, kecerdasan edge, kecerdasan fisik (mengemudi otonom, robotika), dan kecerdasan biologis (antarmuka otak-komputer, medis). Ia juga mengajukan tiga pandangan: 1) Model besar dan AI generatif adalah arus utama untuk 10 tahun ke depan; 2) Model besar dasar + model besar vertikal + model edge, dengan open source + komersial berdampingan; 3) Tokenisation + Scaling Law adalah intinya, tetapi membutuhkan sistem algoritma baru untuk meningkatkan efisiensi, dan arsitektur teknologi AI mungkin mengalami terobosan besar dalam 5 tahun ke depan; 4) Diperkirakan kecerdasan buatan umum akan tercapai dalam 15-20 tahun, dan akan melewati Tes Turing baru secara bertahap. (Sumber: 36氪)

🧰 Alat

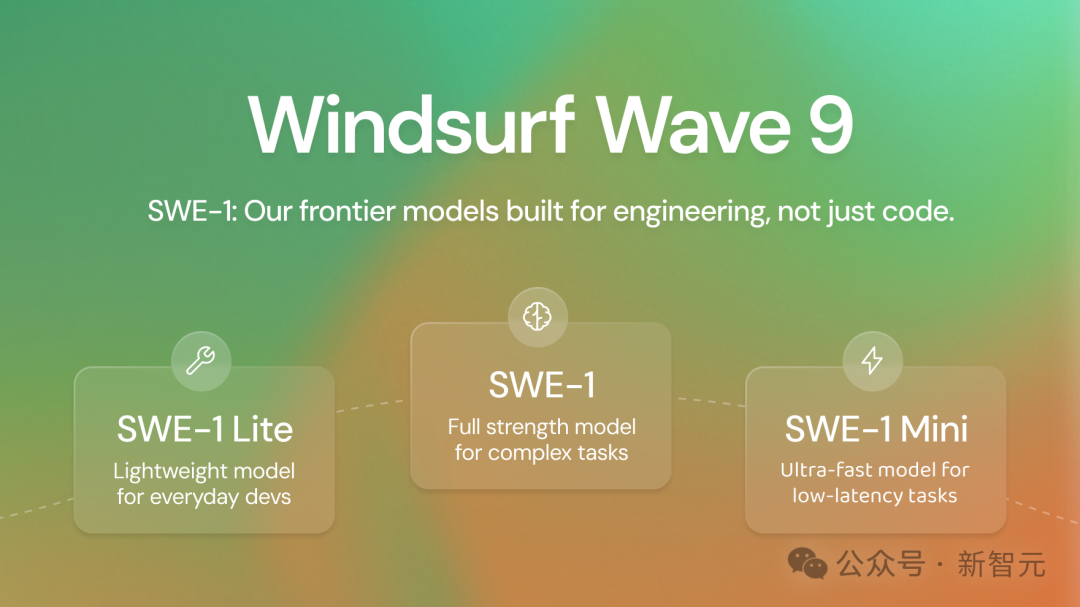

Windsurf Merilis Seri Model Canggih Pertama Buatan Sendiri SWE-1, Bertujuan Meningkatkan Efisiensi Pengembangan Perangkat Lunak hingga 99%: Perusahaan alat pemrograman AI Windsurf (dikabarkan akan diakuisisi oleh OpenAI) meluncurkan seri model pertamanya yang dioptimalkan untuk rekayasa perangkat lunak, SWE-1. Seri ini mencakup SWE-1 (mirip Claude 3.5 Sonnet, dengan biaya lebih rendah), SWE-1-lite (menggantikan Cascade Base, terbuka untuk semua pengguna), dan SWE-1-mini (latensi rendah, untuk Windsurf Tab). Inovasi inti SWE-1 adalah sistem “Flow Awareness”, di mana AI berbagi timeline operasi dengan pengguna, memungkinkan kolaborasi yang efisien, pemahaman status yang belum selesai, dan tugas jangka panjang. Evaluasi offline dan pengujian online menunjukkan bahwa SWE-1 berkinerja mendekati model teratas dalam tugas SWE percakapan dan end-to-end, dan unggul dalam metrik seperti tingkat kontribusi kode dibandingkan model non-canggih. (Sumber: 36氪)

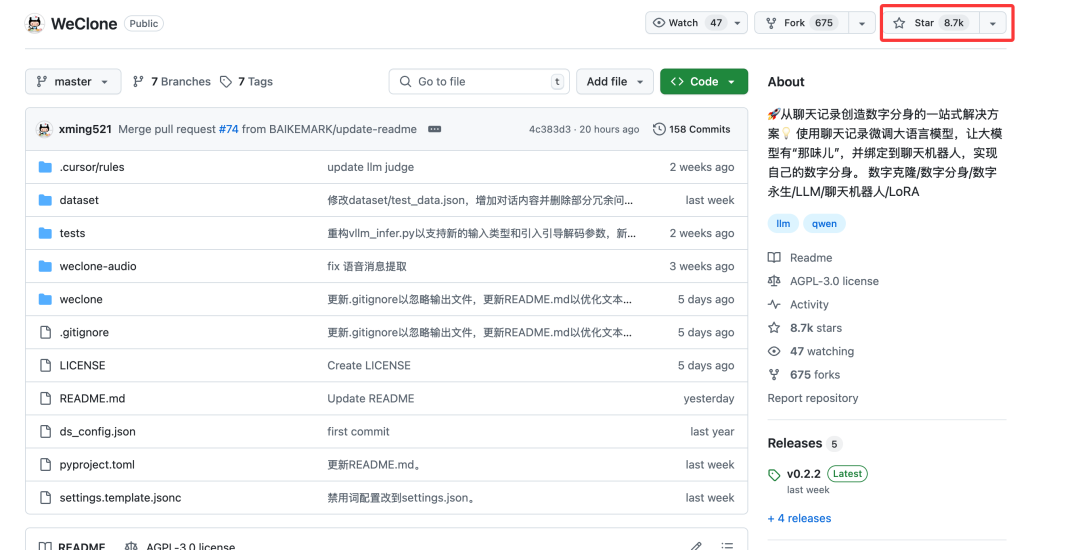

Proyek Open Source WeClone: Memanfaatkan Riwayat Obrolan WeChat untuk Menciptakan Digital Twin AI yang Dipersonalisasi: Sebuah proyek open source Python bernama WeClone memungkinkan pengguna untuk membuat digital twin AI berdasarkan riwayat obrolan WeChat pribadi mereka. Proyek ini menggunakan prinsip basis pengetahuan RAG (Retrieval Augmented Generation), mengimpor data obrolan WeChat, melakukan fine-tuning pada model seperti Qwen2.5-7B-Instruct menggunakan metode LoRA, dan menggabungkan teknologi ASR (Automatic Speech Recognition) serta TTS (Text-to-Speech) untuk menghasilkan suara pengguna. Proyek ini mendukung integrasi dengan WeChat, WeChat Work, dan Feishu melalui AstrBot. Karena riwayat obrolan WeChat mengandung banyak percakapan nyata yang dipersonalisasi dan multi-skenario, ini sangat cocok sebagai basis pengetahuan domain pribadi untuk melatih digital human, yang dapat diterapkan dalam berbagai skenario seperti asisten AI yang dipersonalisasi, layanan pelanggan perusahaan, pemasaran, bahkan konsultasi keuangan. (Sumber: 36氪)

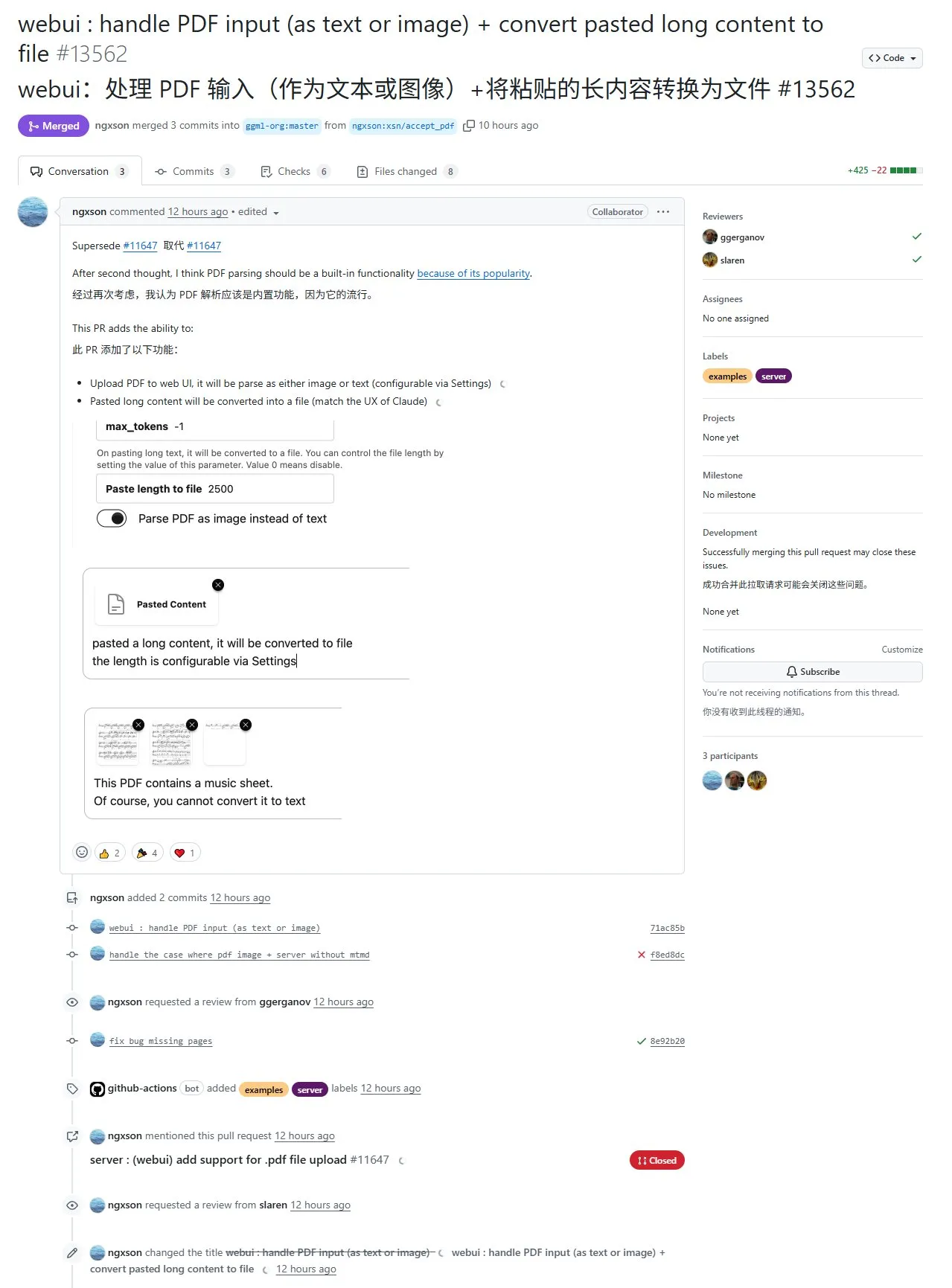

Fitur Baru llama.cpp: Mendukung Ekstraksi dan Input Konten PDF, Namun Saat Ini Terbatas pada Antarmuka Web dan Kurang Baik dalam Menangani Format Kompleks: Proyek llama.cpp baru-baru ini melalui PR #13562 mengimplementasikan dukungan input untuk file PDF. Fitur ini tidak secara langsung memodifikasi kode sumber llama.cpp, melainkan menggunakan pustaka JavaScript untuk mengekstrak konten PDF di antarmuka web, yang kemudian diteruskan ke llama.cpp. Ini berarti fitur ini saat ini terbatas pada UI web yang disediakan oleh llama.cpp, dan belum tersedia di tingkat API. Meskipun memungkinkan impor konten PDF yang mudah, untuk PDF yang berisi elemen kompleks (seperti rumus matematika), efek ekstraksinya biasa saja dan mungkin terjadi kesalahan parsing. (Sumber: karminski3)

Framework Unsloth Menambahkan Fitur Fine-tuning TTS dan Mendukung Qwen3 GRPO: Unsloth mengumumkan bahwa framework-nya kini mendukung fine-tuning model Text-to-Speech (TTS), dengan peningkatan kecepatan pelatihan sekitar 1,5 kali dan pengurangan konsumsi VRAM sebesar 50%. Model yang didukung termasuk Sesame/csm-1b, OpenAI/whisper-large-v3, dan model arsitektur Transformer lainnya. Fine-tuning TTS dapat digunakan untuk meniru suara, menyesuaikan gaya dan nada bicara, mendukung bahasa baru, dll. Unsloth menyediakan Colab Notebooks untuk pelatihan, menjalankan, dan menyimpan model secara gratis. Selain itu, Unsloth juga menambahkan dukungan untuk Qwen3 GRPO (Generative Retrieval Policy Optimization), yang menggunakan model dasar dan fungsi reward berbasis kedekatan baru untuk optimasi. (Sumber: Reddit r/LocalLLaMA)

INAIR Merilis Komputer Spasial AI, Menargetkan Pasar Perkantoran Ringan Bergerak: Perusahaan kacamata AR+AI INAIR merilis komputer spasial AI-nya, yang terdiri dari kacamata AR INAIR 2 Pro, pusat komputasi INAIR Pod, dan keyboard operasi spasial 3D INAIR Touchboard. Produk ini bertujuan untuk menyediakan pilihan kedua selain laptop bagi pengguna bisnis yang sering bepergian dan pengguna perkantoran ringan, yang dapat memproyeksikan layar raksasa setara 134 inci pada jarak 4 meter tanpa batas, serta mendukung pengendalian komputer jarak jauh. Asisten cerdas tingkat sistem INAIR AI Agent yang terpasang di dalamnya mengintegrasikan berbagai model besar seperti DeepSeek, Doubao, Ernie Bot, dan ChatGPT, yang dapat menyediakan fungsi seperti terjemahan waktu nyata dan ringkasan konten, serta meningkatkan efisiensi kerja dengan mempelajari kebiasaan pengguna. (Sumber: 36氪)

Framework Inferensi llamafile Mendukung Model Qwen3: llamafile, sebuah framework inferensi yang mengintegrasikan llama.cpp dan pustaka C yang sangat portabel Cosmopolitan Libc, kini mendukung seri model Qwen3. Fitur utamanya adalah mengemas semua dependensi runtime ke dalam satu file executable tunggal, yang sangat meningkatkan portabilitas, memungkinkan pengguna menjalankan model besar tanpa proses instalasi yang rumit. (Sumber: karminski3)

Kling AI Meluncurkan Versi 2.0 dan API, Menambahkan Fitur Seperti Rotasi Logo 3D: Kling AI mengumumkan bahwa Kling 2.0, Elements, dan Video Effects Suite API telah diluncurkan. Versi baru ini meningkatkan kemampuan pembuatan video dan memperkenalkan tutorial seperti cara cepat membuat logo berputar 3D menggunakan fungsi DizzyDizzy atau Image to Video, memungkinkan pengguna untuk berkreasi tanpa memerlukan keahlian 3D. (Sumber: Kling_ai, Kling_ai)

Manus AI Menambahkan Fitur Pembuatan Gambar, Kemungkinan Berbasis API GPT-4o: Aplikasi asisten AI Manus mengumumkan dukungan untuk pembuatan gambar. Pihak resmi menyatakan bahwa Manus tidak hanya dapat menghasilkan gambar, tetapi juga memahami maksud pengguna, merencanakan solusi, dan secara efektif menggabungkan pembuatan gambar dengan alat lain untuk menyelesaikan tugas. Komunitas berspekulasi bahwa kemampuan pembuatan gambarnya mungkin didasarkan pada API model GPT-4o terbaru dari OpenAI. (Sumber: op7418)

Blackbox Menyediakan Layanan Akses GPU A100/H100 Sesuai Permintaan di Dalam IDE: Blackbox meluncurkan layanan untuk mengakses GPU kelas atas (A100s dan H100s) sesuai permintaan langsung di dalam lingkungan pengembangan terintegrasi (IDE). Pengguna tidak memerlukan operasi konsol cloud yang rumit atau manajemen kunci API, dan dapat langsung meluncurkan instans GPU dari IDE atau ekstensi Blackbox. Harga ditetapkan sebesar $14 per jam untuk 8 node A100, bertujuan untuk menyederhanakan perolehan sumber daya komputasi untuk machine learning dan tugas pemrosesan berat, menjadikannya semudah membuka tab terminal. (Sumber: Reddit r/deeplearning)

📚 Pembelajaran

HuggingFace Meluncurkan Tutorial MCP (Model Comportability Protocol): HuggingFace merilis tutorial MCP baru yang bertujuan untuk membantu pengguna memahami komposisi protokol MCP, menggunakan SDK/framework yang ada, dan mengimplementasikan layanan MCP sendiri. Konten kursus ini relatif sederhana, cocok untuk insinyur berpengalaman agar cepat menguasainya, dan setelah selesai dapat memperoleh sertifikat kelulusan. Protokol MCP sangat penting untuk mewujudkan transfer informasi, nilai, dan kepercayaan antar model, dan merupakan salah satu tantangan teknis dalam membangun ekonomi agen cerdas. (Sumber: karminski3)

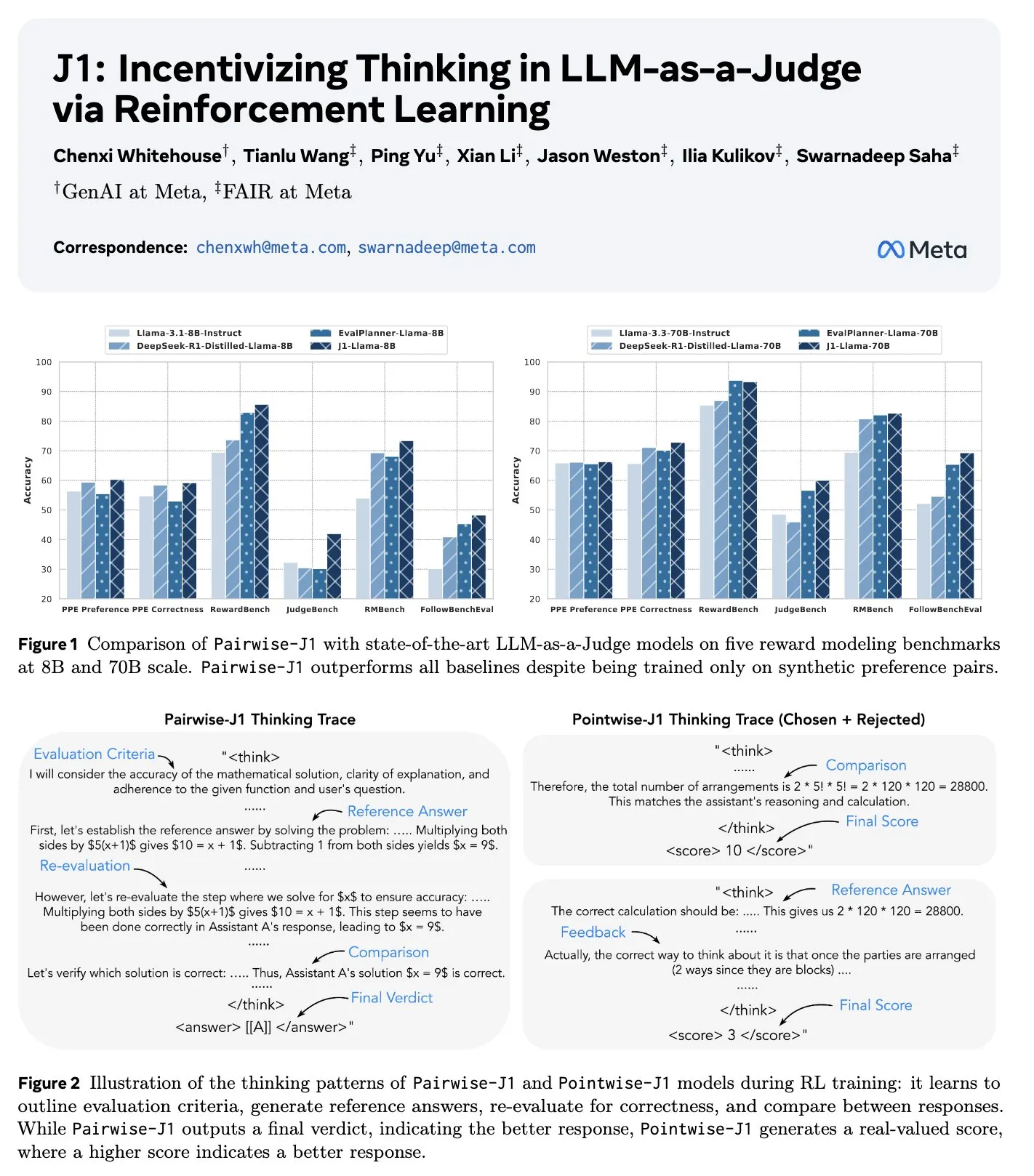

Makalah Baru J1: Mendorong “Berpikir” pada LLM-as-a-Judge melalui Reinforcement Learning: Sebuah makalah baru berjudul “J1: Incentivizing Thinking in LLM-as-a-Judge via RL” mengusulkan metode untuk mengoptimalkan proses berpikir, penilaian, dan pertimbangan model bahasa besar sebagai evaluator (LLM-as-a-Judge) melalui reinforcement learning (khususnya GRPO). Metode ini dapat mengubah tugas penilaian prompt yang dapat diverifikasi dan tidak dapat diverifikasi menjadi tugas yang dapat diverifikasi, hanya dengan menggunakan data berpasangan sintetis. Penelitian menemukan bahwa model J1 pada skala 8B dan 70B mengungguli baseline, dan menunjukkan berbagai strategi berpikir, seperti membuat daftar kriteria evaluasi, membandingkan dengan jawaban referensi yang dihasilkan sendiri, dan mengevaluasi ulang kebenaran. (Sumber: jaseweston, jaseweston)

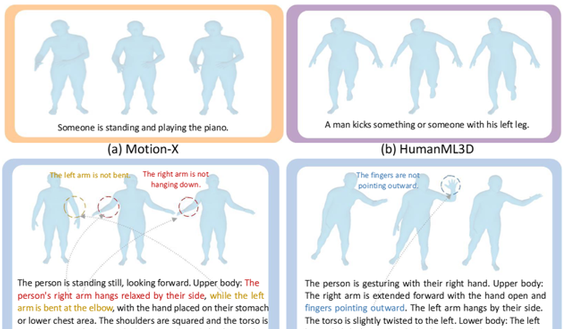

Universitas Peking dan Universitas Renmin Bersama-sama Merilis Being-M0: Kerangka Kerja Generasi Gerakan Umum Robot Humanoid yang Didorong oleh Dataset Skala Jutaan: Tim Lu Zongqing dari Universitas Peking bekerja sama dengan Universitas Renmin Tiongkok dan lainnya, mengusulkan kerangka kerja generasi gerakan robot humanoid umum Being-M0, dan membangun dataset generasi gerakan skala jutaan pertama di industri, MotionLib. Kerangka kerja ini, melalui data video internet skala besar, dikombinasikan dengan model generasi gerakan yang digerakkan oleh teks end-to-end, mewujudkan generasi gerakan manusia yang kompleks dan beragam, dan dapat mentransfer gerakan tubuh manusia ke berbagai bentuk robot humanoid seperti Unitree H1 dan G1. Inovasi inti meliputi alur kerja konstruksi dataset MotionLib, model yang memvalidasi kelayakan “big data + model besar” di bidang generasi gerakan, dan kerangka kerja kuantisasi dua dimensi tanpa pencarian yang inovatif, MotionBook, yang memecahkan masalah kehilangan informasi dalam kompresi data gerakan dimensi tinggi menggunakan teknologi VQ tradisional. (Sumber: 量子位)

ByteDance Merilis Dataset WildDoc, Mengevaluasi Kemampuan Pemahaman Dokumen Dunia Nyata VLM: ByteDance merilis dataset Visual Question Answering (VQA) baru bernama WildDoc di Hugging Face. Dataset ini bertujuan untuk mengevaluasi kemampuan model bahasa visual (VLM) dalam memahami dokumen dalam skenario dunia nyata. (Sumber: _akhaliq)

Sorotan Agenda ICRA 2025 (IEEE International Conference on Robotics and Automation): Konferensi Internasional IEEE tentang Robotika dan Otomasi (ICRA) 2025 akan diadakan pada 19-23 Mei di Atlanta, AS. Konten konferensi mencakup pidato utama dari Allison Okamura, Tessa Lau, Raffaello D’Andrea, dan lainnya, serta laporan kunci yang mencakup 12 bidang seperti robotika rehabilitasi, kontrol optimasi, interaksi manusia-robot, robotika lunak, robotika lapangan, robotika bio-inspirasi, haptik, perencanaan, manipulasi, gerakan, keamanan & metode formal, dan sistem multi-robot. Selain itu, ada juga lokakarya kilat komunikasi ilmiah, 59 lokakarya dan tutorial, forum etika robotika, forum ilmuwan Afrika untuk memajukan penelitian robotika, forum pendidikan robotika sarjana, dan kegiatan hari pembangunan komunitas. (Sumber: aihub.org)

Makalah LlamaDuo: Alur LLMOps untuk Migrasi Mulus dari LLM Layanan ke LLM Lokal Skala Kecil: Sebuah makalah yang diterima di konferensi utama ACL 2025, “LlamaDuo: LLMOps Pipeline for Seamless Migration from Service LLMs to Small-Scale Local LLMs”, memperkenalkan alur LLMOps yang bertujuan untuk membantu pengguna bertransisi dengan lancar dari penggunaan LLM berbasis layanan besar (seperti panggilan API) ke penggunaan LLM lokal skala kecil. Penelitian ini merupakan hasil dari kolaborasi open source dan komunitas, menekankan pentingnya fleksibilitas dalam beralih dan mengoptimalkan strategi penerapan model dalam aplikasi praktis. (Sumber: algo_diver)

Studi Tubi: Regresi Tweedie Lebih Unggul dari LogLoss Tertimbang dalam Optimasi Keterlibatan Pengguna Video-on-Demand: Penelitian dari platform video Tubi menunjukkan bahwa dalam mengoptimalkan sistem rekomendasi video untuk meningkatkan keterlibatan pengguna (seperti durasi tontonan berikutnya), model regresi Tweedie yang secara langsung memprediksi durasi tontonan pengguna, memiliki kinerja yang lebih baik daripada model LogLoss tertimbang durasi tontonan tradisional. Hasil eksperimen menunjukkan bahwa regresi Tweedie menghasilkan peningkatan pendapatan sebesar +0,4% dan peningkatan durasi tontonan sebesar +0,15%. Penelitian ini berpendapat bahwa karakteristik statistik regresi Tweedie lebih sesuai dengan karakteristik data durasi tontonan yang mengalami inflasi nol dan distribusi miring. (Sumber: Reddit r/MachineLearning)

💼 Bisnis

Aplikasi Sinkronisasi Bibir Hedra Raih Pendanaan Seri A $32 Juta, Dipimpin oleh a16z: Startup generasi video AI Hedra mengumumkan penyelesaian putaran pendanaan Seri A sebesar $32 juta, dipimpin oleh Andreessen Horowitz (a16z), dengan Matt Bornstein bergabung dalam dewan direksinya. Investor sebelumnya a16z speedrun, Abstract, dan Index Ventures juga berpartisipasi dalam putaran ini. Hedra berfokus pada pembuatan video percakapan karakter yang ekspresif dan dapat dikontrol, teknologinya bertujuan untuk mengatasi tantangan sinkronisasi bibir dan ekspresi emosional dalam video yang dihasilkan AI. (Sumber: op7418)

AS dan Arab Saudi, UEA Capai Kerjasama Bidang AI, Melibatkan Pusat Data 5GW dan Pasokan Chip, Bertujuan Menyingkirkan Pengaruh Tiongkok: Amerika Serikat, Arab Saudi, dan Uni Emirat Arab mencapai kesepakatan kerjasama AI penting, yang melibatkan pembangunan pusat data 5GW dan pasokan besar chip AI canggih (seperti chip NVIDIA Blackwell) oleh perusahaan AS seperti NVIDIA, AMD, dan Qualcomm. Perusahaan AI baru Arab Saudi, Humain, akan menjadi pelaksana inti. Langkah ini dipandang sebagai strategi AS untuk mempromosikan tumpukan teknologi AI-nya di Timur Tengah, mempercepat pembangunan infrastruktur, dan dengan demikian mengunci sekutu, sekaligus membatasi investasi infrastruktur AI dan pengaruh teknologi Tiongkok di kawasan tersebut. Perjanjian baru ini mencabut sebagian pembatasan ekspor chip AI ke Timur Tengah sebelumnya, tetapi pada saat yang sama memperkuat peringatan global terhadap penggunaan chip Tiongkok seperti Huawei Ascend. (Sumber: dylan522p, 36氪, iScienceLuvr)

Perusahaan SaaS Restoran Owner Raih Pendanaan $120 Juta Menjadi Unicorn, Manfaatkan AI untuk Ciptakan “Eksekutif Restoran AI”: Perusahaan Owner, yang menyediakan solusi digitalisasi full-stack untuk restoran independen, baru-baru ini menyelesaikan putaran pendanaan Seri C sebesar $120 juta, dengan valuasi mencapai $1 miliar. Owner menyediakan layanan pembuatan situs web/aplikasi, integrasi pemesanan dan pengiriman, optimasi SEO, dan otomatisasi pemasaran untuk restoran dengan biaya bulanan tetap, dan telah melayani lebih dari 10.000 restoran. Strategi AI tahun 2025 mereka mencakup peluncuran “Eksekutif Restoran AI” (AI CMO, CFO, CTO) untuk mengelola karyawan AI dan karyawan manusia, serta membangun AI Agent percakapan untuk meningkatkan efisiensi layanan. Putaran pendanaan ini dipimpin bersama oleh Redpoint Ventures dan Altman Capital, menunjukkan potensi AI dalam membentuk ulang nilai SaaS tradisional. (Sumber: 36氪)

🌟 Komunitas

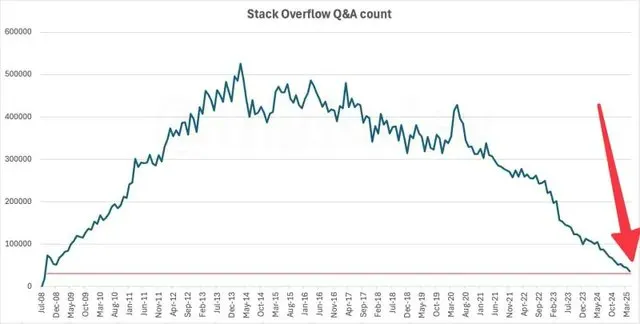

Aktivitas Stack Overflow Anjlok ke Level 2009, AI Diduga Penyebab Utama: Data menunjukkan bahwa jumlah pertanyaan bulanan di komunitas tanya jawab pengembang terkenal Stack Overflow telah turun ke level saat pertama kali diluncurkan pada tahun 2009. Fenomena ini memicu diskusi tentang dampak AI terhadap komunitas pengembang tradisional. Banyak yang berpendapat bahwa dengan munculnya asisten pemrograman AI seperti ChatGPT, pengembang semakin cenderung langsung bertanya dan mencari solusi kode kepada AI, daripada bertanya di komunitas seperti Stack Overflow dan menunggu jawaban manual, yang mungkin menyebabkan penurunan drastis aktivitas komunitas. (Sumber: zachtratar, karminski3)

AI Picu Krisis “Profesionalisme” di Tempat Kerja, Karyawan Anggap Era AI Lebih Butuh Sentuhan Manusiawi: Seiring meluasnya penggunaan AI di tempat kerja, banyak karyawan merasa keahlian profesional mereka “terdekonstruksi”. Pimpinan cenderung meminta AI untuk merevisi hasil kerja karyawan, bahkan menganggap AI lebih unggul dari karyawan manusia, yang menyebabkan karyawan merasa tidak dihargai dan menghadapi krisis tergantikan. Penelitian menunjukkan bahwa karyawan dapat membedakan email yang ditulis oleh CEO sendiri dan oleh AI, dan ketika mereka menganggap konten dihasilkan oleh AI, bahkan jika ditulis oleh manusia, penilaiannya akan lebih rendah. Ini mencerminkan preferensi orang terhadap kreasi manusia dan kekhawatiran terhadap ketergantungan berlebihan pada AI. Sementara itu, penelitian McKinsey menunjukkan 54% karyawan yang mengundurkan diri merasa tidak dihargai, dan 82% karyawan menganggap era AI lebih membutuhkan koneksi antarpribadi dan kepedulian emosional. (Sumber: 36氪, 36氪)

Anak Muda Tiongkok Merangkul Pasangan AI, Memicu Kekhawatiran Sosial Terhadap Rendahnya Tingkat Kelahiran: Laporan The Economist menyoroti fenomena anak muda di Tiongkok yang menjalin hubungan asmara dan persahabatan dengan AI. Aplikasi pasangan AI seperti “Maoxiang” dan “Xingye” terus mengalami pertumbuhan jumlah pengguna, di mana pengguna menciptakan karakter virtual untuk memenuhi kebutuhan emosional. Perkembangan teknologi memungkinkan AI untuk meniru emosi dan empati, ditambah dengan tekanan hidup anak muda yang tinggi, berkurangnya waktu bersosialisasi, dan menurunnya angka pernikahan, mendorong tren ini. Namun, pemerintah khawatir bahwa pasangan AI dapat memperburuk masalah rendahnya tingkat kelahiran yang sudah parah (tingkat kesuburan total pada tahun 2024 hanya 1,0). (Sumber: dotey)

Bantuan AI Mungkin Menjadi Normal Baru dalam Pendidikan, Namun Ketergantungan Berlebihan Profesor pada ChatGPT Picu Ketidakpuasan dan Refleksi Mahasiswa: Seorang mahasiswa di Northeastern University menggugat universitas untuk pengembalian biaya kuliah karena profesornya menggunakan ChatGPT untuk membuat materi kuliah. Insiden ini memicu diskusi luas tentang peran AI dalam pendidikan tinggi. Mahasiswa berpendapat bahwa biaya kuliah yang mahal seharusnya ditukar dengan pengajaran profesional dari manusia, bukan konten yang dihasilkan algoritma, dan khawatir AI menggantikan pemikiran dan umpan balik profesor. Sementara itu, profesor memandang AI sebagai alat untuk meningkatkan efisiensi dan mengatasi beban kerja yang berat. Para pakar pendidikan menunjukkan bahwa kuncinya adalah penggunaan AI yang bertanggung jawab, yang meningkatkan bukan menggantikan kreativitas dan pengawasan manusia, menumbuhkan standar etika mahasiswa di era AI, dan memastikan konten yang dihasilkan AI telah melalui penyuntingan dan konfirmasi profesional. (Sumber: 36氪, Reddit r/ChatGPT)

CEO Salesforce Sebut Hubungan Microsoft dan OpenAI Telah Rusak Fundamental dan Tidak Dapat Diperbaiki: CEO Salesforce, Marc Benioff, dalam sebuah wawancara menyatakan bahwa hubungan kerjasama antara Microsoft dan OpenAI telah mengalami “keretakan fundamental dan sulit diperbaiki”. Ia menunjukkan bahwa Microsoft Copilot mengecewakan pelanggan, lebih mirip Clippy yang tidak efisien, dan CFO OpenAI dalam diagram arsitektur teknologinya tidak menyebutkan perangkat lunak Microsoft atau Azure, yang menguatkan adanya keretakan antara kedua belah pihak. Benioff berpendapat bahwa Microsoft pada dasarnya adalah reseller ChatGPT, strategi AI-nya terbatas, dan sedang mencoba membangun model buatan sendiri melalui “Proyek Prometheus”. Ia juga menyebutkan bahwa kemunculan model open source seperti DeepSeek mendorong industri menuju transformasi arsitektur MOE, menurunkan biaya penggunaan model, dan meruntuhkan logika bisnis “monopoli model”. (Sumber: 36氪)

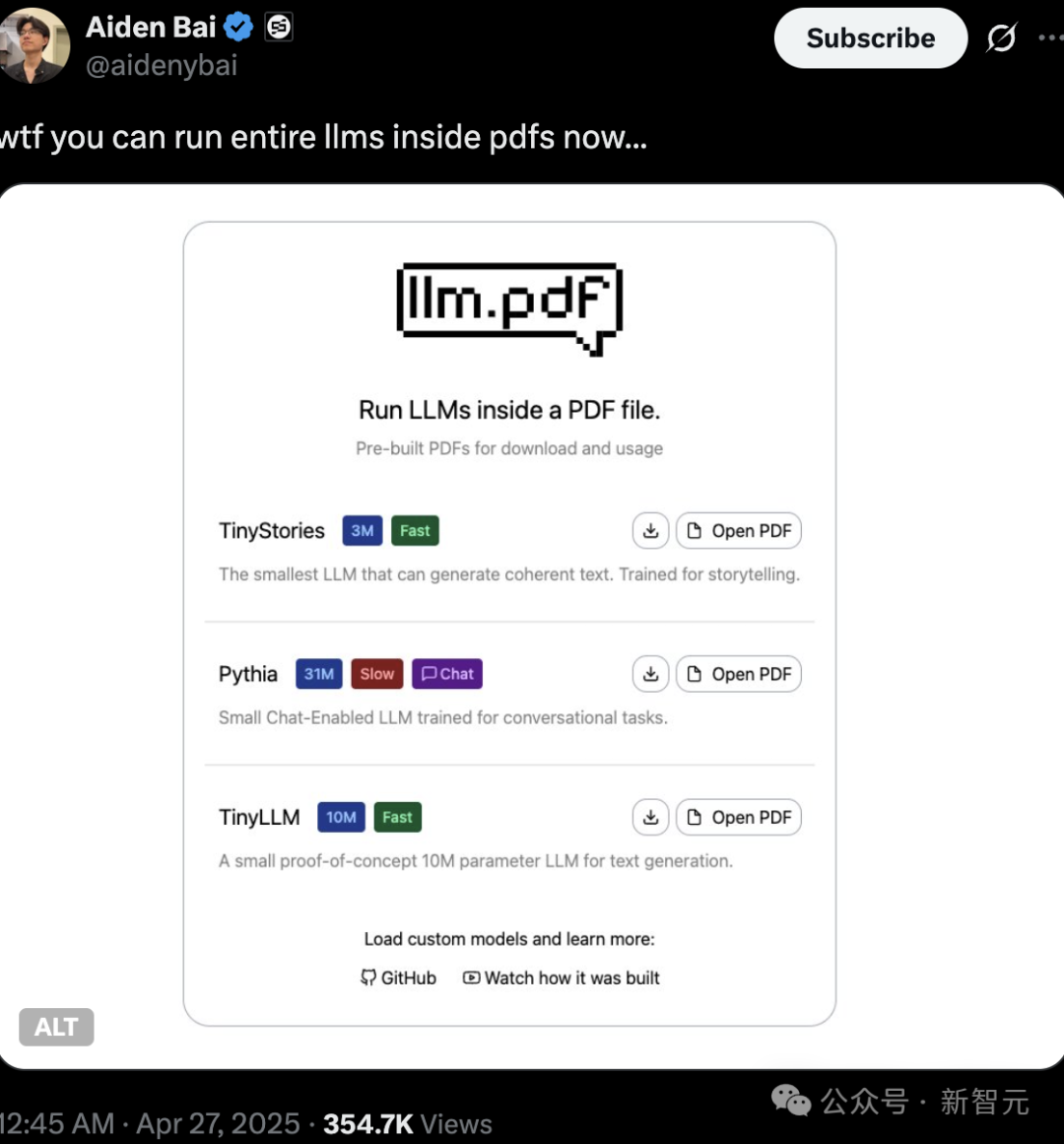

Keaslian dan Hak Cipta Konten Buatan AI Jadi Sorotan, Menjalankan LLM & Linux dalam PDF Tunjukkan Potensi Teknologi: Penggemar teknologi baru-baru ini mendemonstrasikan kemampuan untuk menjalankan model bahasa kecil (seperti TinyStories, Pythia, TinyLLM) bahkan sistem operasi Linux secara langsung di dalam file PDF, dengan memanfaatkan dukungan PDF untuk JavaScript. Operasi “teknologi hitam” ini memicu diskusi hangat di kalangan netizen, dan juga menyoroti tren miniaturisasi model AI dan penerapan di sisi edge. Pada saat yang sama, masalah hak cipta, keaslian, dan “deepfake” dari konten yang dihasilkan AI juga menjadi perhatian besar. Zhang Yaqin menunjukkan bahwa risiko AI meliputi deepfake, halusinasi, informasi beracun, dll., yang perlu mendapat perhatian serius dan penguatan penyelarasan AI dengan nilai-nilai kemanusiaan serta regulasi etika. (Sumber: 36氪, 36氪)

💡 Lainnya

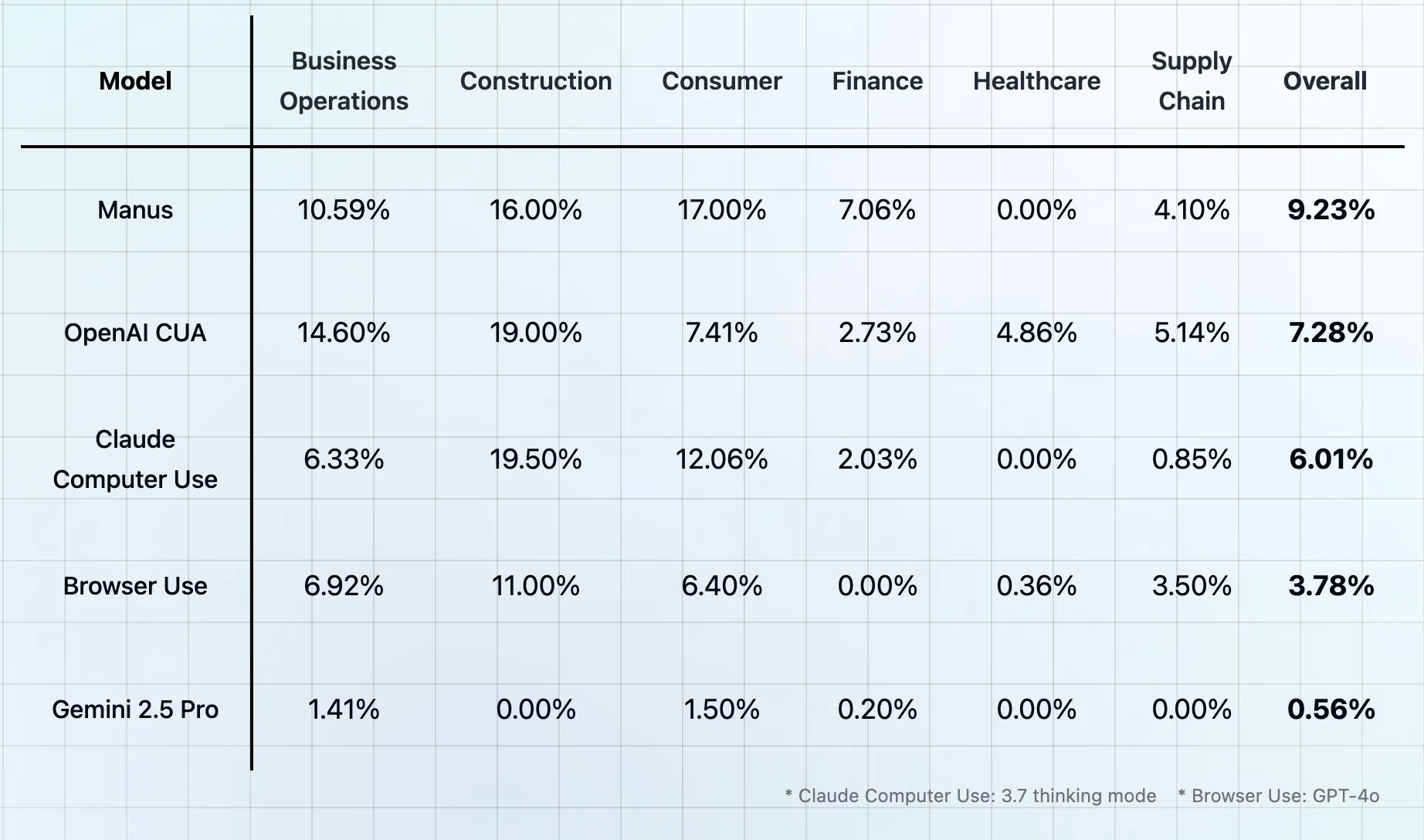

Theta Merilis Benchmark CUB: Mengevaluasi Agen Pengguna Komputer dan Browser sebagai “Ujian Terakhir Manusia”: Theta meluncurkan tes benchmark baru bernama CUB (Computer and Browser Use Agents), yang diklaim sebagai “ujian terakhir manusia” untuk agen pengguna komputer dan browser. Benchmark semacam ini bertujuan untuk mengevaluasi kemampuan agen AI dalam mensimulasikan penggunaan komputer dan browser oleh manusia untuk menyelesaikan tugas-tugas kompleks. Namun, sudah ada beberapa benchmark yang mengklaim sebagai “ujian terakhir manusia”, yang memicu diskusi tentang kemungkinan penamaan yang terlalu berlebihan. (Sumber: _akhaliq, DhruvBatraDB)

AI Dituduh Digunakan untuk Menghasilkan Konten Vulgar, Memicu Kekhawatiran tentang Penyalahgunaan Model dan Batasan Etis: Di media sosial muncul fenomena pengguna memanfaatkan alat penghasil gambar AI (seperti DALL-E 3 dari ChatGPT) untuk membuat gambar vulgar atau parodi (misalnya “Shittington Bear”). Hal ini memicu kekhawatiran bahwa alat AI dapat disalahgunakan untuk menghasilkan konten yang tidak pantas, melanggar hak cipta (seperti memparodikan karakter kartun terkenal), dan menantang batasan etika sosial. Meskipun platform AI biasanya memiliki filter konten, pengguna masih mungkin melewati batasan melalui prompt yang cerdik. (Sumber: Reddit r/ChatGPT)

Penelitian Menunjukkan AI Memiliki Keterbatasan dalam Meniru Gaya Komunikasi CEO, Karyawan Lebih Mempercayai Manusia: Penelitian Harvard Business School menemukan bahwa karyawan memiliki akurasi sekitar 59% dalam membedakan informasi yang ditulis oleh AI dengan yang ditulis oleh CEO perusahaan Wade Foster (CEO Zapier). Lebih penting lagi, begitu karyawan menganggap informasi dihasilkan oleh AI, bahkan jika konten tersebut sebenarnya berasal dari CEO sendiri, penilaian mereka akan lebih rendah; sebaliknya, konten yang dianggap ditulis oleh CEO, meskipun dihasilkan oleh AI, akan mendapat penilaian lebih tinggi. Ini menunjukkan bahwa orang memiliki tingkat kepercayaan dan persepsi nilai yang lebih tinggi terhadap komunikasi manusia daripada AI. Penelitian menyarankan agar para pemimpin tetap transparan saat menggunakan AI untuk berkomunikasi, menghindari penggunaannya untuk balasan yang sangat pribadi, dan melakukan peninjauan ketat terhadap konten yang dihasilkan AI. (Sumber: 36氪)