Kata Kunci:OpenAI, HealthBench, Meta AI, Dynamic Byte Latent Transformer, Microsoft Research, Kerangka ARTIST, Sakana AI, Mesin Pemikir Berkelanjutan, Evaluasi Kinerja AI Kesehatan, Model Transformer Latent Byte Dinamis 8B Parameter, Peningkatan Penalaran LLM dengan Pembelajaran Penguatan, Arsitektur Jaringan Saraf CTM, Model Kuantisasi Resmi Qwen3

🔥 Fokus

OpenAI merilis HealthBench untuk mengevaluasi kinerja AI medis: OpenAI meluncurkan HealthBench, sebuah benchmark baru yang bertujuan untuk mengukur kinerja dan keamanan model bahasa besar dalam skenario medis. Benchmark ini dikembangkan dengan partisipasi lebih dari 250 dokter global, mencakup 5.000 percakapan medis nyata dan 48.562 kriteria evaluasi unik yang ditulis oleh dokter, meliputi berbagai situasi seperti gawat darurat dan kesehatan global, serta dimensi perilaku seperti akurasi dan kepatuhan instruksi. Pengujian menunjukkan bahwa model o3 mencapai akurasi 60%, sementara GPT-4.1 nano mengungguli GPT-4o dengan biaya 25 kali lebih rendah, menunjukkan potensi besar AI di bidang medis dan kemajuan pesat dalam efektivitas biaya kinerja. (Sumber: OpenAI)

Meta merilis model 8B parameter Dynamic Byte Latent Transformer: Meta AI mengumumkan pembukaan sumber bobot model Dynamic Byte Latent Transformer 8B parameternya. Model ini mengusulkan skema baru sebagai alternatif metode tokenisasi tradisional, yang bertujuan untuk mendefinisikan ulang standar efisiensi dan keandalan model bahasa. Melalui cara tokenisasi baru ini, diharapkan dapat membawa terobosan dalam bidang model bahasa, meningkatkan efisiensi dan efektivitas model dalam memproses teks. Makalah penelitian dan kode sudah tersedia untuk diunduh. (Sumber: AIatMeta)

Microsoft Research meluncurkan kerangka kerja ARTIST, menggabungkan reinforcement learning untuk meningkatkan kemampuan penalaran dan penggunaan alat LLM: Microsoft Research memperkenalkan kerangka kerja ARTIST (Agentic Reasoning and Tool Integration in Self-improving Transformers). Kerangka kerja ini menggabungkan penalaran otonom, reinforcement learning, dan penggunaan alat dinamis, memungkinkan model bahasa besar untuk secara mandiri memutuskan kapan, bagaimana, dan alat apa yang akan digunakan untuk penalaran multi-langkah, serta dapat mempelajari strategi yang kuat tanpa pengawasan tingkat langkah. ARTIST menunjukkan kinerja yang lebih unggul hingga 22% dibandingkan model teratas seperti GPT-4o dalam benchmark yang menantang seperti matematika dan pemanggilan fungsi, menetapkan standar baru untuk generalisasi dan pemecahan masalah yang dapat dijelaskan. (Sumber: MarkTechPost)

Sakana AI merilis Continuous Thought Machines (CTM): Sakana AI meluncurkan arsitektur jaringan saraf baru yang disebut “Continuous Thought Machines” (CTM). Ide inti CTM adalah menjadikan proses dinamis temporal aktivitas saraf sebagai komponen inti komputasinya, memungkinkan model beroperasi di sepanjang garis waktu “langkah berpikir” yang dihasilkan secara internal, secara iteratif membangun dan menyempurnakan representasinya, bahkan untuk data statis. Arsitektur ini menunjukkan komputasi adaptif, peningkatan interpretabilitas, dan kelayakan biologisnya pada berbagai tugas seperti klasifikasi ImageNet, navigasi labirin 2D, pengurutan, perhitungan paritas, dan reinforcement learning. (Sumber: Sakana AI)

🎯 Tren

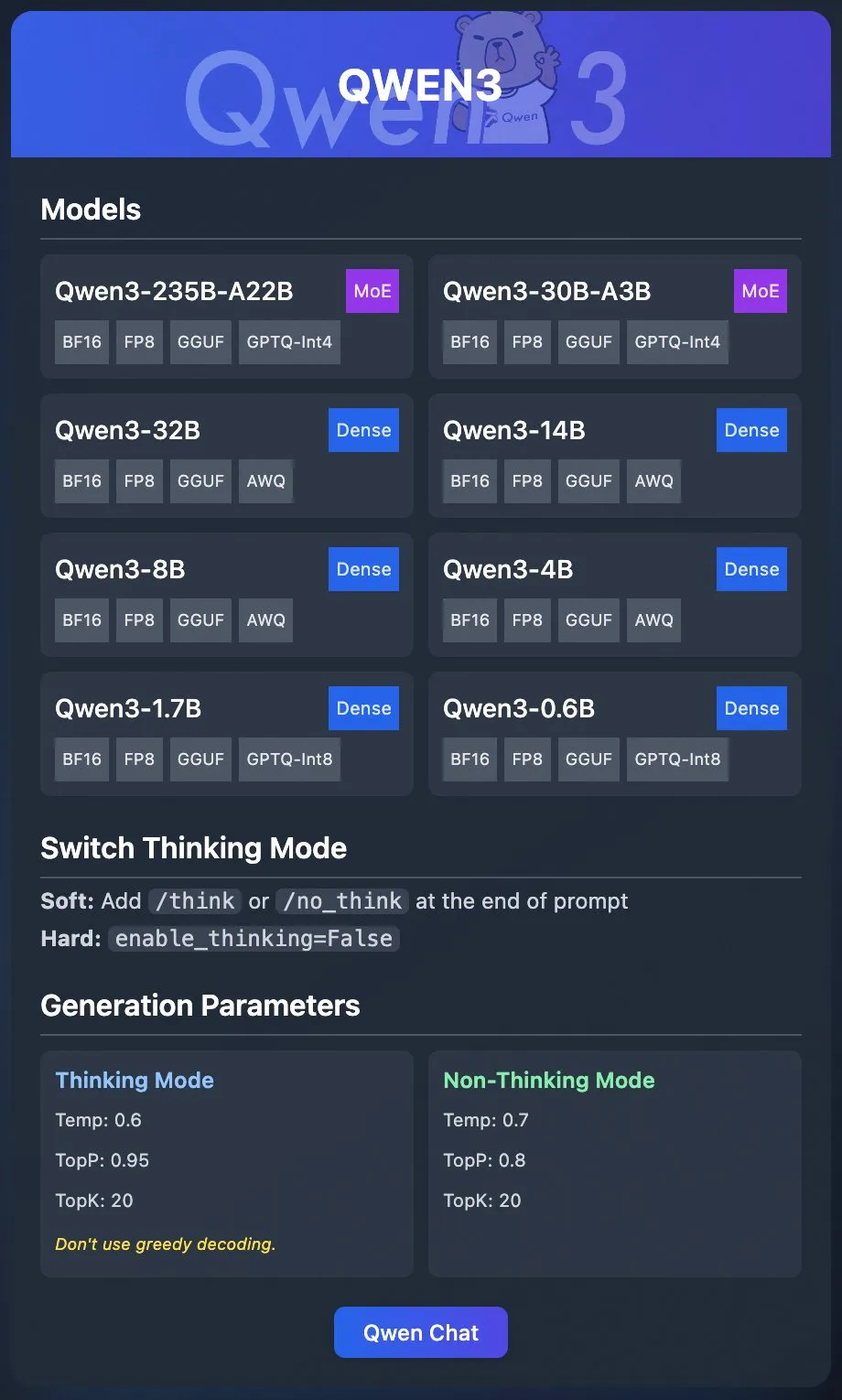

Tim Qwen Alibaba merilis model kuantisasi resmi Qwen3: Tim Qwen Alibaba secara resmi merilis model kuantisasi Qwen3. Pengguna sekarang dapat menerapkan Qwen3 melalui platform seperti Ollama, LM Studio, SGLang, dan vLLM, serta mendukung berbagai format seperti GGUF, AWQ, GPTQ, untuk memudahkan penerapan lokal. Model terkait telah tersedia di Hugging Face dan ModelScope. Rilisan ini bertujuan untuk menurunkan ambang batas penggunaan model besar berkinerja tinggi dan mendorong aplikasinya dalam skenario yang lebih luas. (Sumber: Alibaba_Qwen & Hugging Face & ClementDelangue & _akhaliq & TheZachMueller & cognitivecompai & huybery & Reddit r/LocalLLaMA)

Meta AI merilis kerangka kerja penalaran kolaboratif Collaborative Reasoner: Meta AI meluncurkan Collaborative Reasoner, sebuah kerangka kerja yang bertujuan untuk meningkatkan kemampuan penalaran kolaboratif model bahasa. Kerangka kerja ini didedikasikan untuk mengembangkan agen sosial yang dapat bekerja sama dengan manusia dan agen cerdas lainnya, membuka jalan bagi interaksi manusia-mesin yang lebih kompleks dan sistem multi-agen dengan meningkatkan kemampuan kolaborasi dan penalaran model. Makalah penelitian dan kode terkait telah tersedia untuk diunduh, mendorong komunitas untuk mengeksplorasi dan menerapkannya. (Sumber: AIatMeta)

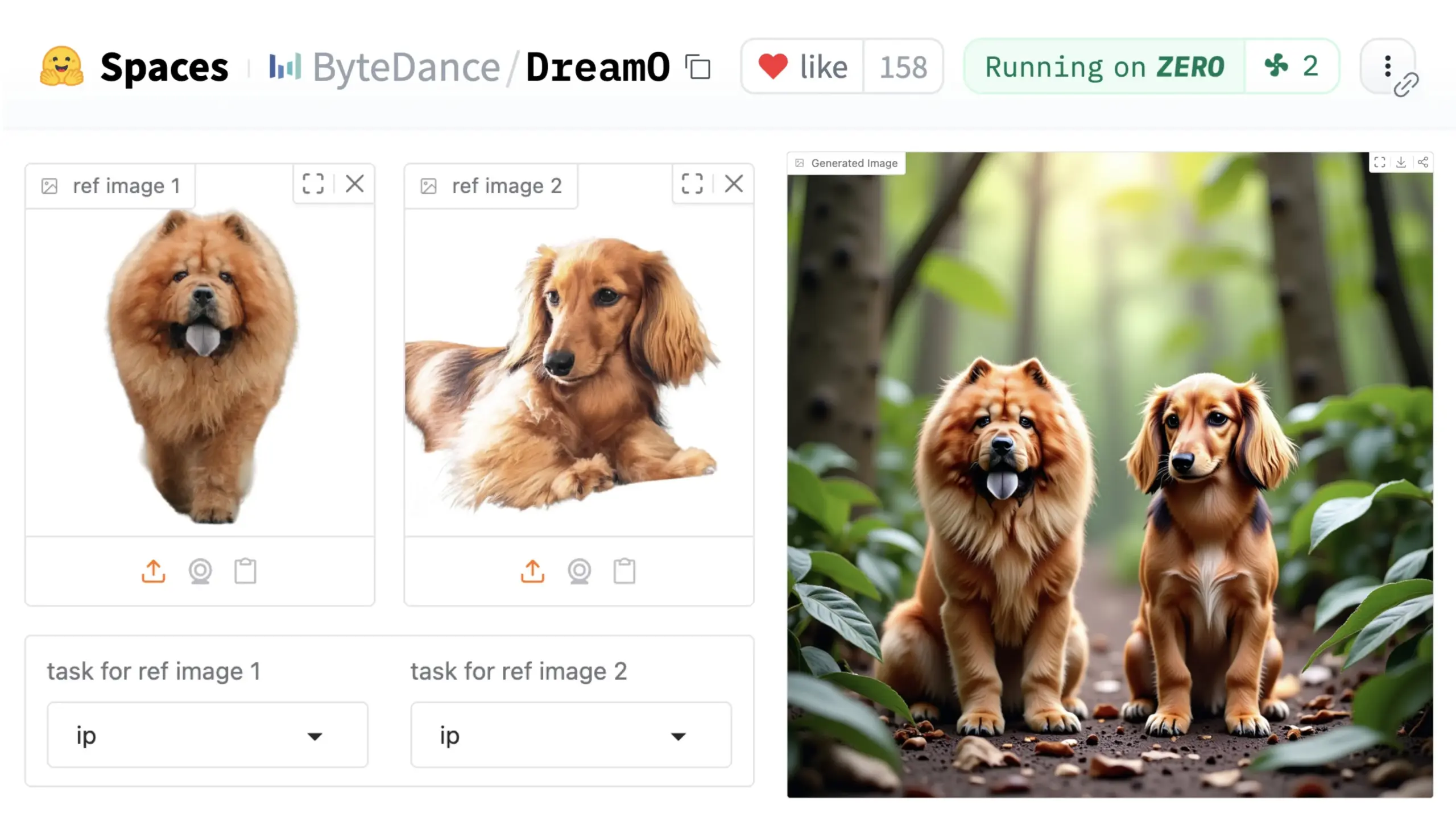

ByteDance meluncurkan kerangka kerja kustomisasi gambar universal DreamO: ByteDance merilis kerangka kerja kustomisasi gambar terpadu bernama DreamO. Kerangka kerja ini didasarkan pada model DiT (Diffusion Transformer) yang telah dilatih sebelumnya, mampu mewujudkan kustomisasi umum berbagai elemen dalam gambar seperti orang, gaya, latar belakang, termasuk fungsi seperti penggantian identitas, transfer gaya, transformasi subjek, dan uji coba virtual. Pengguna dapat mencoba Demo di Hugging Face. Kemajuan ini menunjukkan potensi satu model dalam tugas pengeditan gambar yang beragam. (Sumber: _akhaliq & ClementDelangue & _akhaliq)

NVIDIA membuka alur kerja manajemen data model Nemotron, Nemotron-CC: NVIDIA mengumumkan pembukaan alur kerja manajemen datanya yang digunakan untuk model Nemotron, yaitu Nemotron-CC, dan mempublikasikan sebanyak mungkin data pelatihan dan pasca-pelatihan Nemotron. Alur kerja Nemotron-CC sekarang telah ditambahkan ke repositori NeMo Curator GitHub, yang dapat memproses data teks, gambar, dan video dalam skala besar. NVIDIA menekankan pentingnya dataset pra-pelatihan berkualitas tinggi untuk akurasi model bahasa besar dan menganggap data sebagai komponen dasar untuk mempercepat komputasi. (Sumber: ctnzr & NandoDF)

Model Tencent Hunyuan-Turbos menempati peringkat kedelapan di arena LMArena: Model terbaru Tencent, Hunyuan-Turbos, menempati peringkat kedelapan secara keseluruhan dalam benchmark LMArena (sebelumnya lmsys.org), dan peringkat ketiga belas dalam kontrol gaya, dengan kinerja mendekati Deepseek-R1. Model ini masuk sepuluh besar dalam kategori utama seperti hardcore, coding, dan matematika, menunjukkan peningkatan signifikan dibandingkan versi Februari-nya. Anggota komunitas seperti WizardLM_AI memberikan ucapan selamat atas kinerjanya. (Sumber: WizardLM_AI & WizardLM_AI & teortaxesTex)

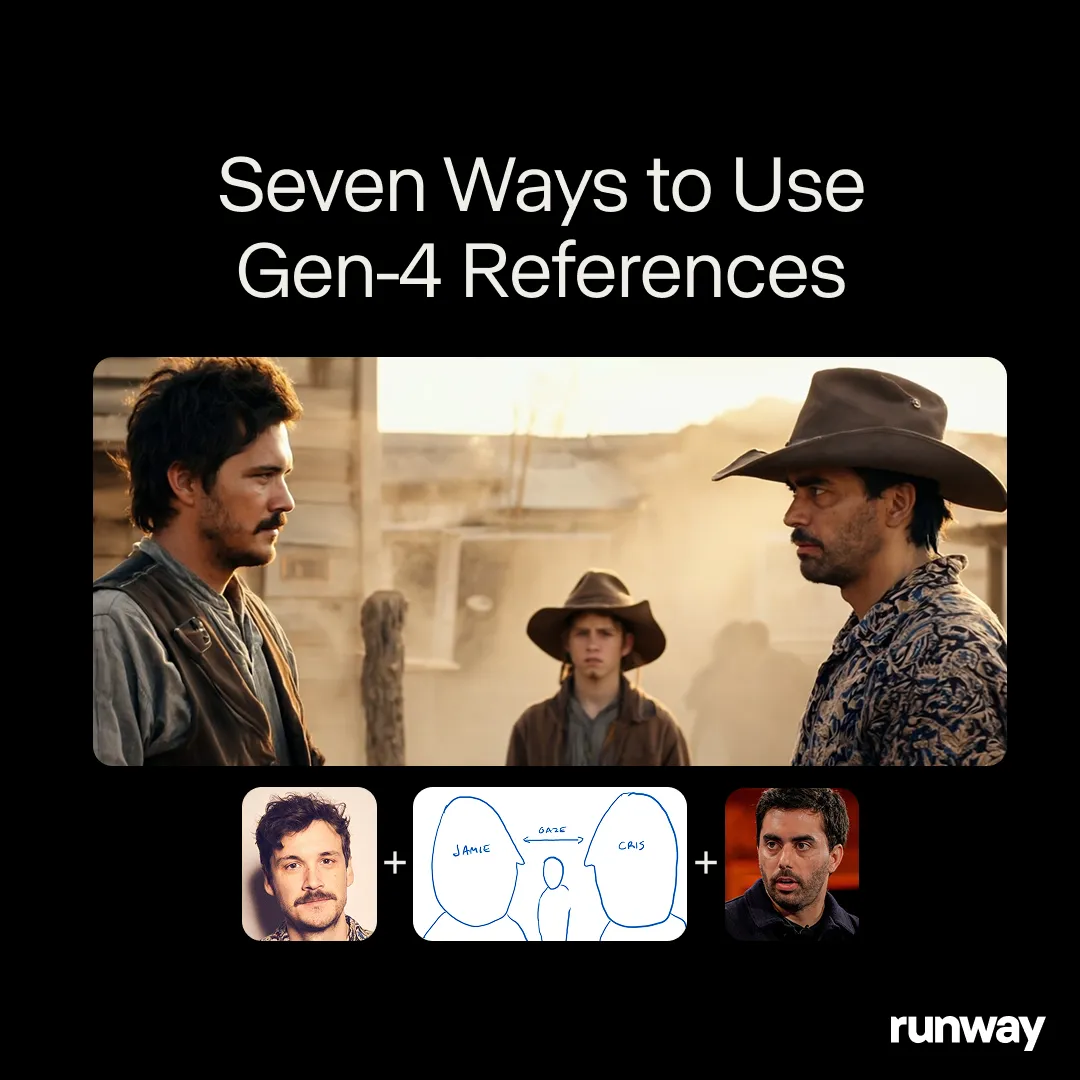

Runway Gen-4 References menunjukkan potensi alat kreasi universal: Model Runway Gen-4 References diposisikan sebagai alat kreasi universal, mampu mendukung alur kerja dan aplikasi yang hampir tak terbatas. Pengguna komunitas terus menemukan kasus penggunaan baru, menunjukkan adaptabilitasnya yang kuat sebagai model universal yang dapat disesuaikan dengan kreativitas pengguna, bukan sebaliknya. Ini mencerminkan tren evolusi AI di bidang kreasi media dari tugas spesifik ke kemampuan universal. (Sumber: c_valenzuelab & c_valenzuelab)

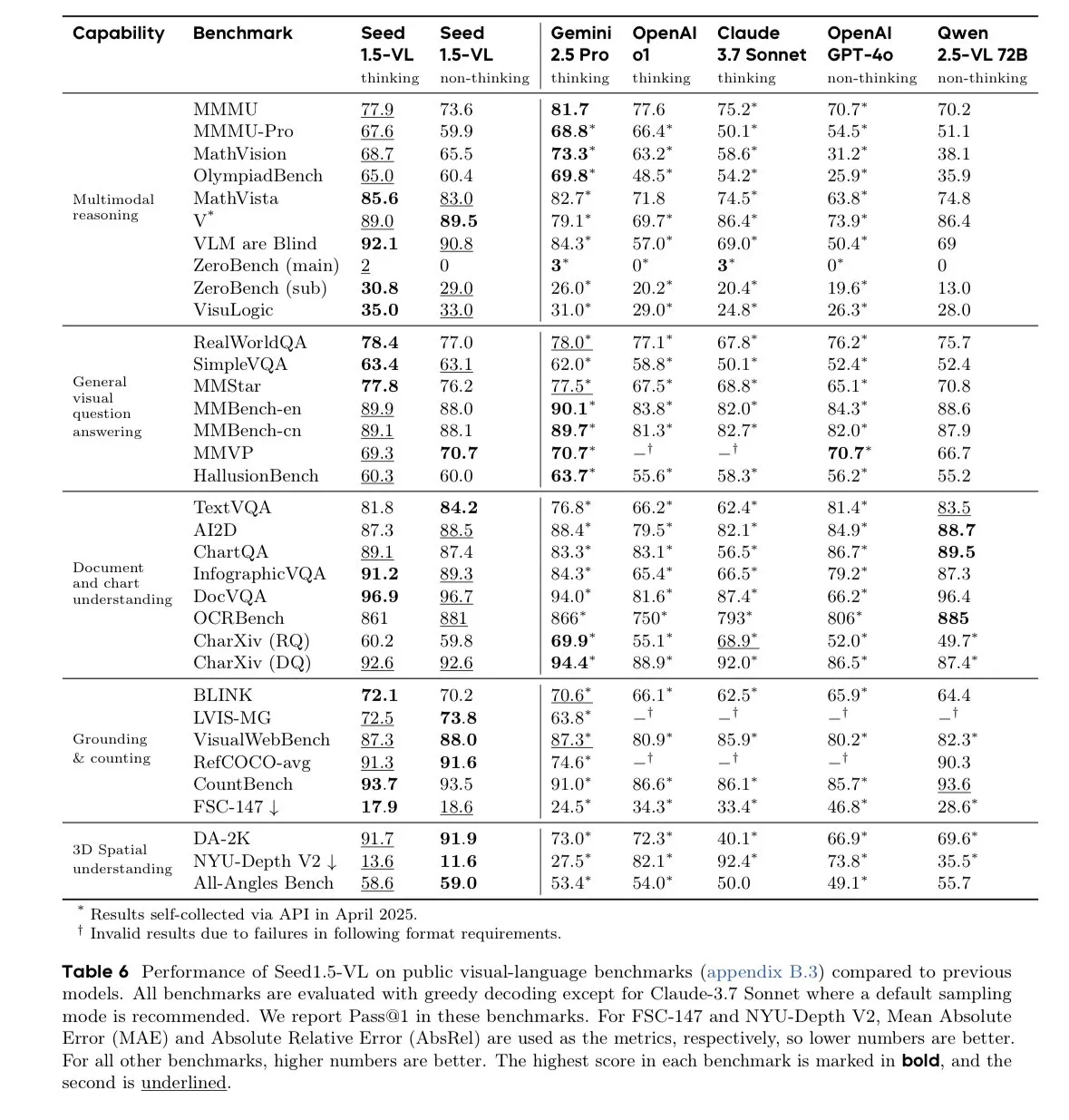

Model ByteDance Seed-1.5-VL-thinking memimpin dalam benchmark model bahasa visual: ByteDance merilis model Seed-1.5-VL-thinking, yang mencapai hasil SOTA (state-of-the-art) pada 38 dari 60 benchmark model bahasa visual (VLM). Dilaporkan bahwa model ini dilatih pada 1,3 juta jam GPU H800, menunjukkan kemampuan pemahaman dan penalaran multimodal yang kuat. (Sumber: teortaxesTex)

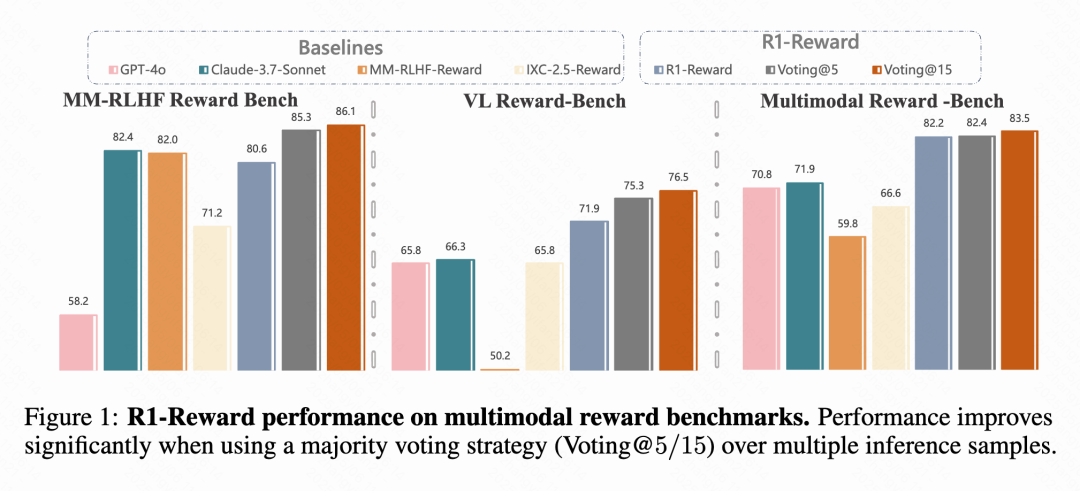

Kuaishou, CAS, dll. mengusulkan model reward multimodal R1-Reward: Tim peneliti dari Kuaishou, Chinese Academy of Sciences (CAS), Tsinghua University, dan Nanjing University mengusulkan R1-Reward, sebuah model reward multimodal (MRM) baru yang dilatih menggunakan algoritma reinforcement learning yang ditingkatkan, StableReinforce. Model ini bertujuan untuk mengatasi masalah ketidakstabilan yang dihadapi oleh algoritma RL yang ada saat melatih MRM, dengan memperkenalkan mekanisme seperti Pre-Clip, filter advantage, dan reward konsistensi. Eksperimen menunjukkan bahwa R1-Reward meningkatkan kinerja sebesar 5%-15% dibandingkan model SOTA pada beberapa benchmark MRM dan telah berhasil diterapkan dalam skenario bisnis Kuaishou seperti video pendek dan e-commerce. (Sumber: WeChat & WeChat)

NTU dkk. mengusulkan WorldMem, mewujudkan generasi dunia konsisten jangka panjang dengan mekanisme memori: Peneliti dari S-Lab Nanyang Technological University (NTU), Peking University, dan Shanghai AI Lab mengusulkan model generasi dunia WorldMem. Model ini mengatasi masalah kurangnya konsistensi pada model generasi video yang ada dalam jangka waktu panjang dengan memperkenalkan mekanisme memori. WorldMem dilatih pada dataset Minecraft, mendukung eksplorasi adegan yang beragam dan perubahan dinamis, serta memvalidasi kelayakannya pada dataset nyata, mampu mempertahankan konsistensi geometris yang baik setelah perubahan sudut pandang dan posisi, serta memodelkan konsistensi temporal. (Sumber: WeChat)

Tim Kuaishou Keling mengusulkan CineMaster, kerangka kerja generasi video tingkat sinematik yang dapat dikontrol dan sadar 3D: Tim peneliti Kuaishou Keling mempresentasikan makalah di SIGGRAPH 2025, memperkenalkan kerangka kerja CineMaster. Ini adalah kerangka kerja generasi teks-ke-video tingkat sinematik yang memungkinkan pengguna melalui alur kerja interaktif untuk menata adegan dalam ruang 3D, menetapkan target dan gerakan kamera, mencapai kontrol halus atas konten video. CineMaster mengintegrasikan kontrol gerakan objek dan gerakan kamera masing-masing melalui Semantic Layout ControlNet dan Camera Adapter, serta merancang alur kerja pembangunan data untuk mengekstrak sinyal kontrol 3D dari video apa pun. (Sumber: WeChat)

🧰 Alat

Comet-ml merilis kerangka kerja evaluasi LLM open source Opik: Comet-ml membuka sumber Opik di GitHub, sebuah kerangka kerja untuk debugging, evaluasi, dan pemantauan aplikasi LLM, sistem RAG, dan alur kerja Agent. Opik menyediakan pelacakan komprehensif, evaluasi otomatis, dan dasbor siap produksi, mendukung instalasi lokal atau melalui Comet.com sebagai solusi terkelola. Ini terintegrasi dengan berbagai kerangka kerja populer seperti OpenAI, LangChain, LlamaIndex, dan menyediakan metrik LLM-as-a-judge untuk deteksi halusinasi, moderasi konten, dan evaluasi RAG. (Sumber: GitHub Trending)

LovartAI meluncurkan agen desain pertamanya Lovart, menekankan pemahaman konteks: LovartAI merilis versi Beta dari agen desain pertamanya, Lovart. Umpan balik pengguna menyatakan bahwa dibandingkan dengan alat desain AI lainnya, Lovart dapat memahami konteks dengan lebih baik, bahkan “seperti membaca pikiran”. Alat ini memungkinkan manusia dan AI berkolaborasi di kanvas yang sama, mengubah prompt menjadi visual secara instan, dapat digunakan untuk desain logo merek dan VI, dll. (Sumber: karminski3)

Tim Jun-Yan Zhu CMU meluncurkan LEGOGPT, teks menghasilkan model Lego 3D: Tim Jun-Yan Zhu dari Carnegie Mellon University (CMU) mengembangkan LEGOGPT, sebuah model bahasa besar yang dapat menghasilkan model Lego 3D yang stabil secara fisik dan dapat dibangun berdasarkan prompt teks. Model ini merumuskan masalah desain Lego sebagai tugas generasi teks autoregresif, membangun struktur dengan memprediksi ukuran dan posisi bata berikutnya, dan memberlakukan batasan perakitan yang sadar fisika dalam pelatihan dan inferensi untuk memastikan stabilitas dan kemampuan membangun desain yang dihasilkan. Tim juga merilis dataset StableText2Lego yang berisi lebih dari 47.000 struktur Lego. (Sumber: WeChat)

Aplikasi MNN Chat mendukung model Qwen 2.5 Omni 3B dan 7B: Aplikasi MNN (Mobile Neural Network) Chat Alibaba kini mendukung model Qwen 2.5 Omni 3B dan 7B. Ini berarti pengguna dapat merasakan layanan model bahasa lokal yang lebih kuat di perangkat seluler. MNN adalah mesin inferensi deep learning ringan yang berfokus pada optimalisasi untuk perangkat seluler dan tertanam. (Sumber: Reddit r/LocalLLaMA)

Platform FutureHouse menyediakan alat penelitian AI super cerdas untuk ilmuwan: Organisasi nirlaba FutureHouse merilis platform FutureHouse, sebuah suite agen AI berbasis Web dan API yang dirancang untuk mempercepat penemuan ilmiah. Platform ini menyediakan serangkaian alat penelitian AI super cerdas untuk membantu ilmuwan melakukan analisis data, simulasi eksperimen, dan penemuan pengetahuan, mendorong perubahan paradigma penelitian ilmiah. (Sumber: dl_weekly)

Cartesia meluncurkan Pro Voice Cloning, membangun model suara kustom dengan mudah: Cartesia merilis produk fine-tuningnya, Pro Voice Cloning. Pengguna dapat mengunggah data suara mereka sendiri untuk dengan mudah membangun model suara kustom, digunakan untuk membuat avatar pribadi, agen AI, atau perpustakaan suara. Produk ini mendukung penyelesaian pelatihan dan penerapan layanan dalam waktu 2 jam, serta menyediakan pengalaman produk swalayan penuh, yang bertujuan untuk mewujudkan aplikasi skala besar. (Sumber: krandiash)

Institute of Computing Technology CAS mengusulkan MCA-Ctrl, mewujudkan kustomisasi gambar yang presisi: Tim peneliti dari Institute of Computing Technology, Chinese Academy of Sciences (CAS) mengusulkan metode kustomisasi gambar universal tanpa fine-tuning, MCA-Ctrl (Multi-party Collaborative Attention Control). Metode ini melalui kontrol perhatian kolaboratif multi-pihak, memanfaatkan pengetahuan internal model difusi, menggabungkan prompt gambar/teks bersyarat dengan konten gambar subjek, untuk mewujudkan penggantian tema, generasi, dan penambahan subjek tertentu. MCA-Ctrl memastikan konsistensi tata letak dan penggantian penampilan objek tertentu serta penyelarasan latar belakang melalui mekanisme kueri lokal self-attention dan injeksi global. (Sumber: WeChat)

📚 Pembelajaran

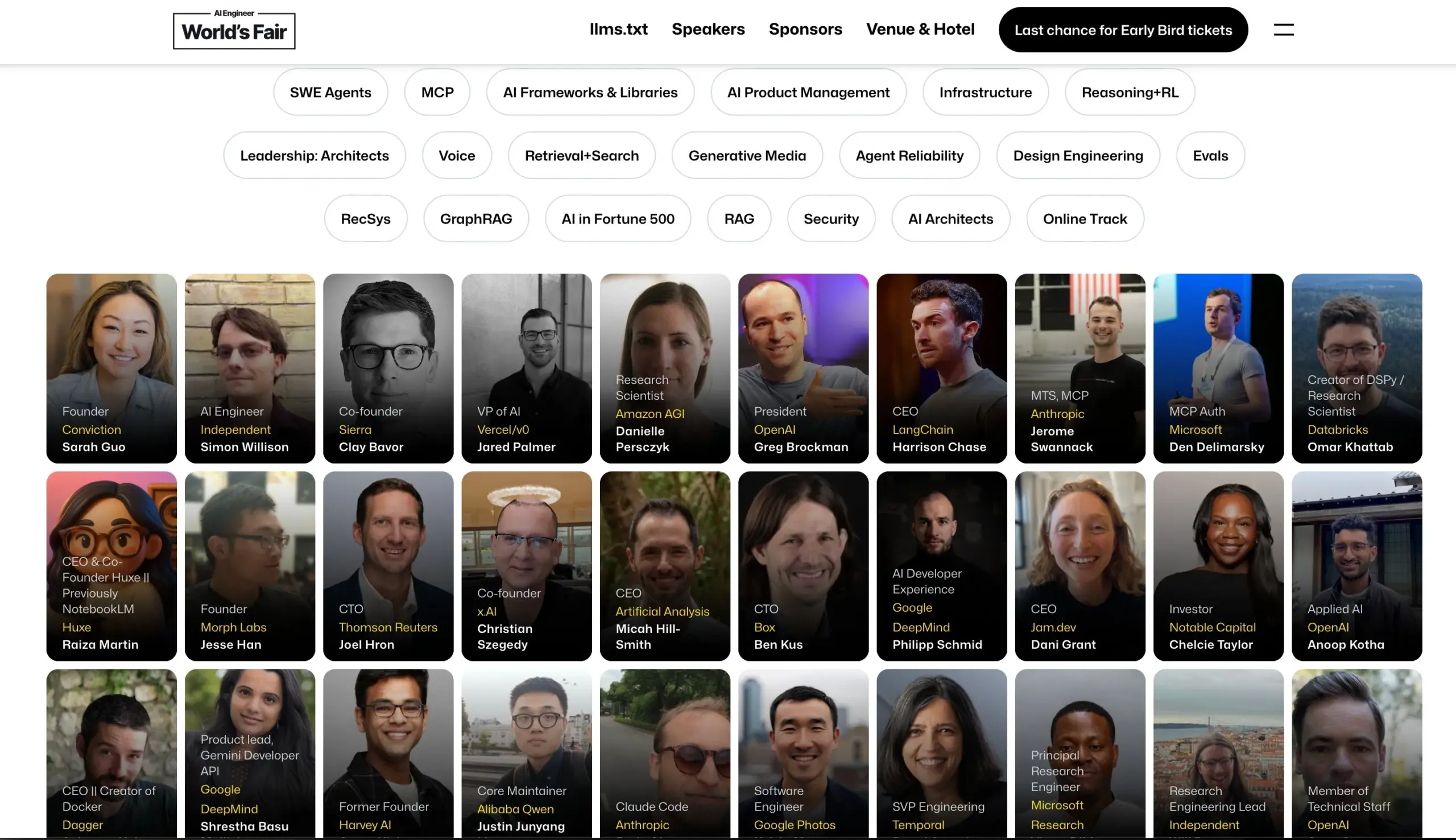

Konferensi AI Engineer mengumumkan jajaran pembicara: Konferensi AI Engineer mengumumkan jajaran pembicaranya, termasuk insinyur dan peneliti AI terkemuka dari perusahaan seperti OpenAI, Anthropic, LangChainAI, Google, dll. Konferensi ini akan mencakup 20 bidang spesifik seperti MCP, LLM RecSys, Agent Reliability, GraphRAG, dan untuk pertama kalinya menyelenggarakan agenda kepemimpinan CTO dan VP. (Sumber: swyx & hwchase17 & _philschmid & HamelHusain & swyx & bookwormengr & swyx)

Hugging Face merilis blog tentang kemajuan terbaru model bahasa visual (VLM): Hugging Face merilis posting blog komprehensif tentang kemajuan terbaru dalam model bahasa visual (VLM). Kontennya mencakup berbagai aspek seperti agen GUI, agen VLM, model omnimoda, RAG multimodal, video LM, model kecil, dll., merangkum tren baru, terobosan, penyelarasan, dan benchmark di bidang VLM selama setahun terakhir. (Sumber: huggingface & ben_burtenshaw & mervenoyann & huggingface & algo_diver & huggingface & huggingface)

Microsoft Azure menyelenggarakan lokakarya online tentang membangun aplikasi obrolan AI tanpa server: Yohan Lasorsa mengumumkan akan menyelenggarakan lokakarya online tentang membangun aplikasi obrolan AI tanpa server menggunakan Azure. Pertemuan ini akan membahas Azure Functions, Static Web Apps, dan Cosmos DB, serta cara menggabungkan LangChainAI JS menggunakan teknologi RAG (Retrieval-Augmented Generation). (Sumber: Hacubu & hwchase17)

Podcast Weaviate membahas sistem LLM-as-Judge dan pustaka Verdict: Podcast Weaviate episode 121 mengundang Leonard Tang, salah satu pendiri Haize Labs, untuk membahas secara mendalam evolusi sistem LLM-as-Judge / model reward. Diskusi mencakup pengalaman pengguna evaluasi, evaluasi komparatif, integrasi penilai, penilai debat, kurasi set evaluasi, dan pengujian adversarial, serta menyoroti pustaka baru Haize Labs, Verdict, sebuah kerangka kerja deklaratif untuk menentukan dan mengeksekusi sistem LLM-as-Judge komposit. (Sumber: bobvanluijt & Reddit r/deeplearning)

Terence Tao merilis video YouTube, mendemonstrasikan bukti formal matematis yang dibantu AI: Pemenang Fields Medal, Terence Tao, melakukan debut di saluran YouTube-nya, mendemonstrasikan cara menggunakan alat AI seperti GitHub Copilot dan asisten pembuktian Lean untuk memformalkan secara semi-otomatis bukti matematis (persamaan Magma E1689 menyiratkan E2) dalam 33 menit, yang biasanya membutuhkan satu halaman penuh tulisan oleh matematikawan manusia. Ia menekankan bahwa metode ini cocok untuk bukti yang sangat teknis dan kurang konseptual, membebaskan matematikawan dari tugas-tugas yang membosankan. Sementara itu, asisten pembuktian Python ringan yang dikembangkannya juga telah diperbarui ke versi 2.0, meningkatkan penanganan estimasi asimtotik dan logika proposisional. (Sumber: WeChat & 量子位)

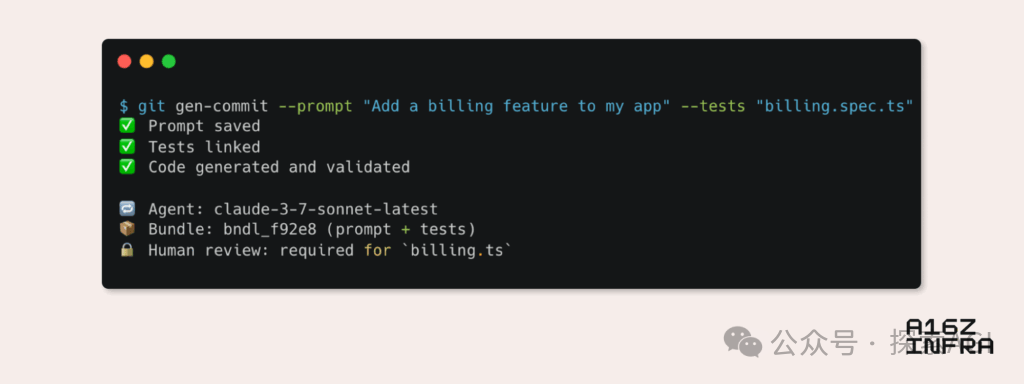

a16z menganalisis sembilan tren utama dalam pola pengembang yang muncul di era AI: Andreessen Horowitz (a16z) merilis blog yang menganalisis sembilan tren utama dalam pola pengembang yang muncul di era AI. Ini termasuk: Git asli AI (kontrol versi beralih ke Prompt dan kasus uji), Vibe Coding (pemrograman berbasis niat menggantikan template), paradigma baru manajemen kunci untuk Agen AI, dasbor pemantauan interaktif yang didorong AI, evolusi dokumentasi menjadi basis pengetahuan interaktif AI, melihat aplikasi dari perspektif LLM (melalui interaksi API aksesibilitas), munculnya Agen eksekusi asinkron, potensi protokol MCP (Model-Tool Communication Protocol), dan kebutuhan Agen akan komponen dasar. Tren ini menandakan perubahan mendalam dalam cara perangkat lunak dibangun. (Sumber: WeChat)

💼 Bisnis

Google Labs meluncurkan AI Futures Fund untuk mendukung startup AI: Google Labs mengumumkan peluncuran program AI Futures Fund, yang bertujuan untuk berkolaborasi dengan startup dalam membangun masa depan teknologi AI. Dana ini akan memberikan akses awal ke model Google DeepMind dan sumber daya seperti kredit cloud kepada startup terpilih untuk membantu mempercepat perkembangan mereka. (Sumber: GoogleDeepMind & JeffDean & Google & demishassabis)

Dikabarkan Perplexity sedang bernegosiasi untuk putaran pendanaan baru senilai $500 juta, dengan valuasi mencapai $14 miliar: Dilaporkan bahwa perusahaan mesin pencari AI, Perplexity, sedang dalam negosiasi untuk putaran pendanaan baru senilai $500 juta, dengan valuasi yang mungkin mencapai $14 miliar. Ini terjadi hanya enam bulan setelah putaran pendanaan terakhirnya (valuasi $9 miliar), menunjukkan perhatian tinggi pasar modal terhadap jalur pencarian AI dan pengakuan terhadap prospek pengembangan Perplexity. (Sumber: Dorialexander)

Dikabarkan OpenAI setuju mengakuisisi Windsurf senilai sekitar $3 miliar: Menurut Bloomberg, OpenAI telah setuju untuk mengakuisisi startup Windsurf dengan harga sekitar $3 miliar. Detail spesifik akuisisi dan arah bisnis Windsurf belum diungkapkan, tetapi langkah ini mungkin menandakan perluasan lebih lanjut kemampuan teknologi atau pangsa pasar OpenAI. (Sumber: Reddit r/artificial & Reddit r/ArtificialInteligence)

🌟 Komunitas

Risiko nyata AI: “Perangkap Simulasi” dari kepuasan tak terbatas: Diskusi oleh Amjad Masad dkk. menunjukkan bahwa bahaya nyata AI bukanlah robot pembunuh seperti di film fiksi ilmiah, melainkan kemampuannya untuk memuaskan keinginan manusia tanpa batas, menciptakan “mesin kebahagiaan tak terbatas”. AI semacam ini dapat menyebabkan manusia tenggelam dalam perjuangan dan makna yang disimulasikan, akhirnya “menghilang” ke dalam dunia simulasi, memberikan penjelasan yang mungkin untuk Paradoks Fermi—peradaban tidak lenyap, tetapi memasuki kebahagiaan digital. (Sumber: amasad)

Agen AI akan membentuk kembali pemrograman dan penelitian ilmiah: CEO Replit, Amjad Masad, memprediksi bahwa dalam satu atau dua tahun ke depan, Agen AI akan dapat bekerja tanpa henti selama berhari-hari, bahkan bertahun-tahun, untuk memecahkan masalah ilmiah yang kompleks. Ia percaya bahwa Agen akan menjadi cara baru pemrograman, mampu menginvestasikan waktu berhari-hari untuk menyelesaikan satu masalah seperti manusia, menandakan potensi besar AI dalam mengotomatisasi tugas-tugas kompleks dan mempercepat penemuan ilmiah. (Sumber: TheTuringPost & amasad & TheTuringPost)

John Carmack membahas potensi AI dalam mengoptimalkan basis kode: Programmer legendaris John Carmack berpendapat bahwa AI tidak hanya dapat menghasilkan banyak kode, tetapi juga berpotensi membantu mempercantik dan merefaktor basis kode yang ada. Ia membayangkan AI sebagai anggota tim yang rajin, terus-menerus meninjau kode dan memberikan saran perbaikan, bahkan dapat mendefinisikan pedoman gaya pengkodean yang “ramah AI” melalui eksperimen objektif. Ia menantikan bagaimana tim dengan persyaratan kualitas kode yang sangat tinggi seperti OpenBSD akan menerima anggota AI. (Sumber: ID_AA_Carmack)

“Vibe Coding” memicu diskusi hangat: Pro dan kontra pemrograman yang dibantu AI: Diskusi komunitas menunjukkan bahwa meskipun “Vibe Coding” (membuat prototipe kode melalui instruksi bahasa alami ke AI) dapat dengan cepat membangun aplikasi tingkat demo, penerapan dan penskalaan masih memerlukan pengembang profesional untuk membangun dari awal. Produk rekayasa bukan hanya tentang menulis kode, tetapi juga melibatkan masalah kompleks seperti arsitektur, CI/CD, layanan mikro, yang saat ini sulit ditangani sepenuhnya oleh AI. Vibe Coding cocok untuk validasi prototipe cepat, tetapi membangun solusi nyata masih membutuhkan pemikiran dan pengalaman rekayasa. (Sumber: Reddit r/ClaudeAI)

Penggunaan luas AI dalam pendidikan universitas dan kekhawatiran kecurangan: Laporan New York Magazine mengungkapkan fenomena meluasnya penggunaan alat AI (seperti ChatGPT) di universitas Amerika Utara untuk menyelesaikan tugas dan makalah. Mahasiswa menggunakan AI untuk membuat catatan, belajar, meneliti, bahkan langsung menghasilkan konten tugas, menimbulkan kekhawatiran tentang integritas akademik, kualitas pendidikan, dan penurunan kemampuan berpikir kritis mahasiswa. Pendidik mencoba menyesuaikan metode pengajaran dan penilaian, tetapi efektivitas alat deteksi AI diragukan, membuat kecurangan AI sulit diberantas. (Sumber: WeChat)

💡 Lainnya

Cohere membahas tantangan aplikasi AI pemerintah dari percontohan ke produksi: Cohere menunjukkan bahwa sebagian besar proyek AI pemerintah masih dalam tahap percontohan. Untuk mewujudkan lompatan dari percontohan ke aplikasi produksi aktual, lembaga pemerintah memerlukan alat yang dapat dipercaya, orientasi hasil yang jelas, infrastruktur yang efisien, dan mitra yang sesuai. Artikel ini membahas bagaimana lembaga pemerintah dapat beralih dari eksperimen ke aplikasi praktis melalui AI yang aman dan efisien. (Sumber: cohere)

Mustafa Suleyman: Semakin besar skala model bahasa besar, semakin mudah dikendalikan: Salah satu pendiri Inflection AI, Mustafa Suleyman, berpendapat bahwa, bertentangan dengan kekhawatiran umum, semakin besar skala model bahasa besar (LLM), semakin mudah untuk dikendalikan. Ia menunjukkan bahwa model generasi sebelumnya lebih sulit diarahkan, digayakan, dan dibentuk, sementara peningkatan skala membantu meningkatkan kemampuan kontrol model, bukan melemahkannya. (Sumber: mustafasuleyman)

Diskusi etika AI: Penentuan tanggung jawab atas kerugian atau bias yang disebabkan AI: Sebuah posting Reddit memicu diskusi: ketika sistem AI (seperti AI diagnosis medis) menyebabkan kerugian karena bias data pelatihan (misalnya, terutama dilatih pada gambar kulit terang, menyebabkan kesalahan diagnosis pada pasien berkulit gelap), siapa yang harus bertanggung jawab? Ini melibatkan penentuan tanggung jawab berbagai pihak seperti pengembang AI, lembaga implementasi, dan regulator, yang merupakan isu kunci yang perlu segera diselesaikan dalam kerangka etika dan hukum AI. (Sumber: Reddit r/ArtificialInteligence)