Kata Kunci:GENMO, Seed-Coder, DeepSeek, LlamaParse, AI Agenik, Komputasi Tepi, Komputasi Kuantum, Model Gerakan Manusia NVIDIA GENMO, Model Kode Seed-Coder ByteDance, Dampak Strategi Open Source DeepSeek, Skor Kepercayaan Parsing Dokumen LlamaParse, Pengolahan Data Real-time Komputasi Tepi, GENMO, Seed-Coder, DeepSeek, LlamaParse, AI Agenik, Komputasi Tepi, Komputasi Kuantum, Model Gerakan Manusia NVIDIA GENMO, Model Kode Seed-Coder ByteDance, Dampak Strategi Open Source DeepSeek, Skor Kepercayaan Parsing Dokumen LlamaParse, Pengolahan Data Real-time Komputasi Tepi

🔥 Fokus

NVIDIA meluncurkan model gerakan manusia universal GENMO: NVIDIA merilis model AI bernama GENMO (GENeralist Model for Human MOtion), yang mampu mengubah berbagai input seperti teks, video, musik, bahkan siluet keyframe menjadi gerakan manusia 3D yang realistis. Model ini dapat memahami dan menggabungkan berbagai jenis input, misalnya mempelajari gerakan dari video dan memodifikasinya berdasarkan prompt teks, atau menghasilkan tarian berdasarkan ritme musik. GENMO menunjukkan potensi besar di bidang animasi game, pembuatan karakter dunia virtual, dan lainnya, mampu menghasilkan gerakan yang kompleks, alami, dan koheren, serta mendukung pengeditan intuitif pada timing animasi. Meskipun saat ini belum dapat menangani ekspresi wajah dan detail tangan, serta bergantung pada metode SLAM eksternal, input multimodal dan output berkualitas tinggi ini merupakan kemajuan penting dalam bidang generasi gerakan AI. (Sumber: YouTube – Two Minute Papers

)

ByteDance merilis seri large model open source Seed-Coder: ByteDance meluncurkan seri large language model open source Seed-Coder, yang mencakup model dasar, model instruksi, dan model inferensi dengan skala parameter 8B. Fitur inti dari seri model ini adalah kemampuannya untuk “model kode mengkurasi data sendiri”, yang bertujuan untuk meminimalkan keterlibatan manusia dalam pembuatan data. Seed-Coder telah mencapai level terbaik saat ini (SOTA) dalam berbagai aspek seperti pembuatan dan pengeditan kode, menunjukkan potensi AI untuk mengoptimalkan dan membangun data pelatihan dengan kemampuannya sendiri, serta memberikan ide baru untuk pengembangan large model kode. (Sumber: _akhaliq)

Model DeepSeek menarik perhatian luas komunitas AI: Seri model DeepSeek, khususnya model kodenya, telah memicu diskusi luas di komunitas AI karena performanya yang kuat dan strategi open source-nya. Banyak pengembang dan peneliti terkesan dengan kinerjanya, menganggapnya telah mengubah persepsi global tentang model open source. Diskusi menunjukkan bahwa kesuksesan DeepSeek dapat mendorong perusahaan seperti OpenAI untuk mengevaluasi kembali strategi open source mereka dan mempercepat langkah produsen large model lokal untuk melakukan open source. Meskipun open source menghadapi tantangan seperti komersialisasi dan adaptasi perangkat keras, kemunculan DeepSeek dianggap sebagai kekuatan penting yang mendorong demokratisasi teknologi AI dan pengembangan industri. (Sumber: Ronald_vanLoon、36氪)

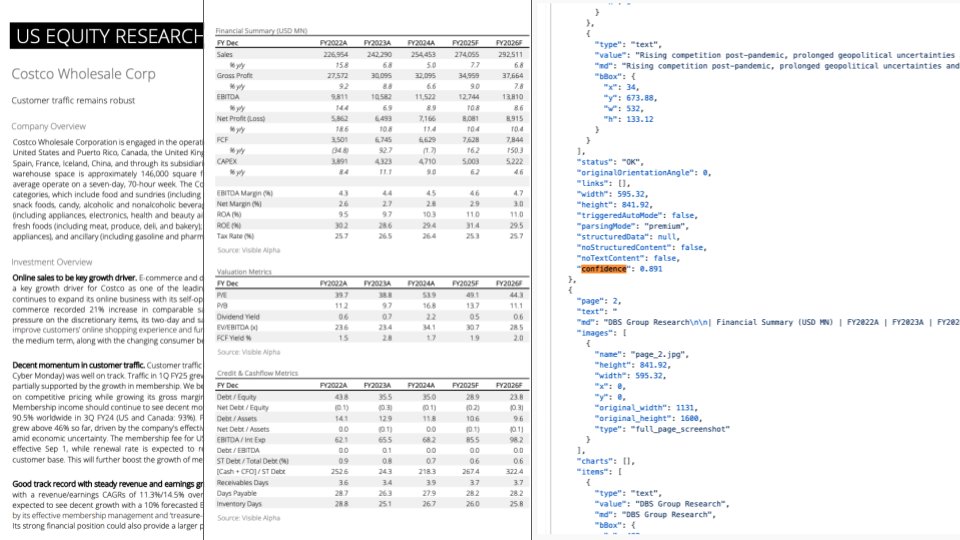

Pembaruan LlamaParse: Integrasi GPT-4.1 dan Gemini 2.5 Pro, meningkatkan kemampuan parsing dokumen: LlamaParse merilis pembaruan penting, mengintegrasikan model GPT-4.1 dan Gemini 2.5 Pro terbaru, yang secara signifikan meningkatkan akurasi parsing dokumen. Fitur baru termasuk deteksi arah dan kemiringan otomatis, memastikan perataan dan akurasi konten yang diparsing. Selain itu, diperkenalkan fitur skor kepercayaan (confidence score), yang memungkinkan pengguna mengevaluasi kualitas parsing setiap halaman dan mengatur alur tinjauan manual berdasarkan ambang batas kepercayaan. Pembaruan ini bertujuan untuk mengatasi kesalahan yang mungkin terjadi pada LLM/LVM saat memproses dokumen kompleks, dengan menyediakan pengalaman pengguna untuk tinjauan dan koreksi manual guna memastikan keandalan proses otomatisasi. (Sumber: jerryjliu0)

🎯 Tren

Prospek tren industri teknologi tahun 2025: Laporan memprediksi tren utama industri teknologi pada tahun 2025, termasuk teknologi baru seperti kecerdasan buatan (AI), machine learning, 5G, perangkat wearable, blockchain, dan keamanan siber yang akan terus berkembang dan terintegrasi secara mendalam. Teknologi ini diharapkan memainkan peran penting dalam meningkatkan kehidupan, mendorong inovasi, dan memecahkan masalah sosial, menandakan masa depan yang cerah yang didukung oleh teknologi. (Sumber: Ronald_vanLoon、Ronald_vanLoon)

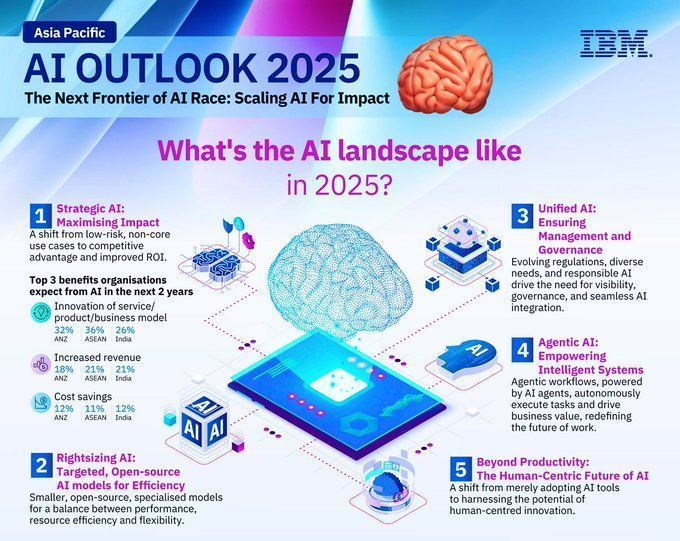

Prediksi tren pengembangan bidang AI tahun 2025: IBM memprediksi bahwa bidang kecerdasan buatan akan terus berkembang pesat pada tahun 2025, dengan teknologi machine learning (ML) dan kecerdasan buatan (AI/MI) yang akan semakin matang dan diterapkan secara luas di berbagai industri. AI diharapkan memainkan peran yang lebih besar dalam otomatisasi, analisis data, dukungan keputusan, dan lainnya, mendorong inovasi teknologi dan peningkatan industri. (Sumber: Ronald_vanLoon)

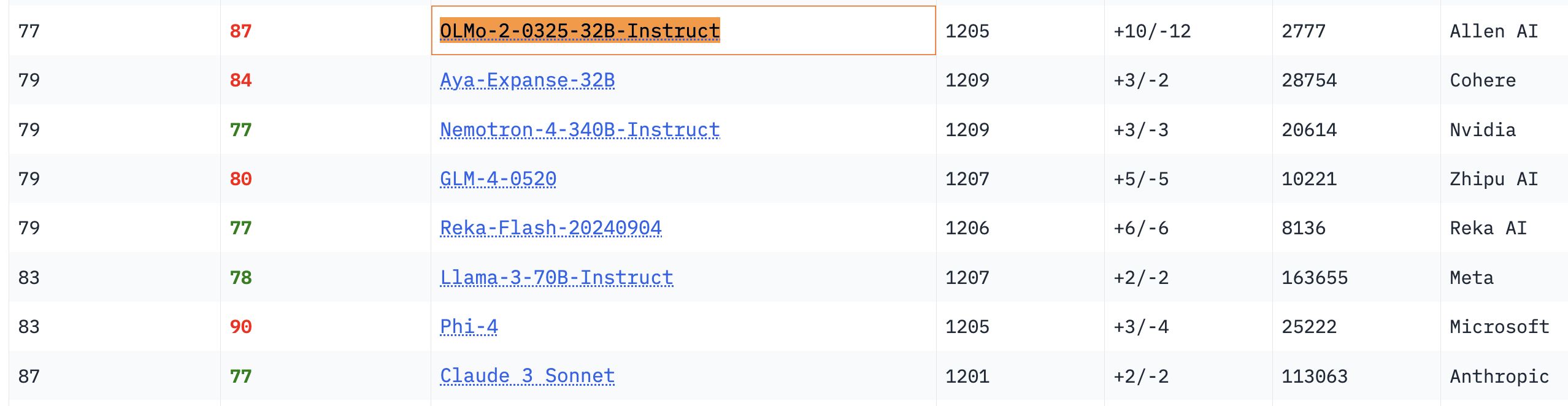

Performa model OLMo 32B menonjol: Dalam uji benchmark terkait, model OLMo 32B yang sepenuhnya terbuka menunjukkan performa yang lebih unggul dibandingkan model Nemotron 340B dan Llama 3 70B yang memiliki parameter lebih besar. Hasil ini menunjukkan bahwa dalam beberapa aspek, model yang sepenuhnya terbuka dengan jumlah parameter lebih kecil dapat mencapai atau bahkan melampaui model komersial berskala lebih besar, menunjukkan potensi besar dan kecepatan mengejar dari penelitian model terbuka. (Sumber: natolambert、teortaxesTex、lmarena_ai)

Jumlah unduhan model Gemma melampaui 150 juta, dengan lebih dari 70 ribu varian: Model Gemma dari Google telah diunduh lebih dari 150 juta kali di platform Hugging Face dan memiliki lebih dari 70 ribu varian. Data ini mencerminkan popularitas dan penggunaan luas model Gemma di komunitas pengembang. Pengguna komunitas juga sangat menantikan iterasi versi mendatangnya. (Sumber: osanseviero、_akhaliq)

Unsloth memperbarui model Qwen3 GGUF, meningkatkan dataset kalibrasi: Unsloth telah memperbarui semua model Qwen3 GGUF-nya dan menggunakan dataset kalibrasi baru yang telah ditingkatkan. Selain itu, lebih banyak varian GGUF telah ditambahkan untuk Qwen3-30B-A3B. Umpan balik pengguna menyebutkan bahwa pada versi 30B-A3B-UD-Q5_K_XL, kualitas terjemahan meningkat dibandingkan dengan GGUF Q5 dan Q4 lainnya. (Sumber: Reddit r/LocalLLaMA)

Perbedaan Agentic AI dan GenAI: Agentic AI dan AI generatif (GenAI) adalah topik hangat di bidang AI saat ini. GenAI terutama merujuk pada AI yang dapat menciptakan konten baru (teks, gambar, dll.), sedangkan Agentic AI lebih berfokus pada agen cerdas yang dapat menjalankan tugas secara mandiri, berinteraksi dengan lingkungan, dan membuat keputusan. Agentic AI biasanya menggabungkan kemampuan GenAI, tetapi lebih menekankan otonomi dan orientasi tujuannya. (Sumber: Ronald_vanLoon)

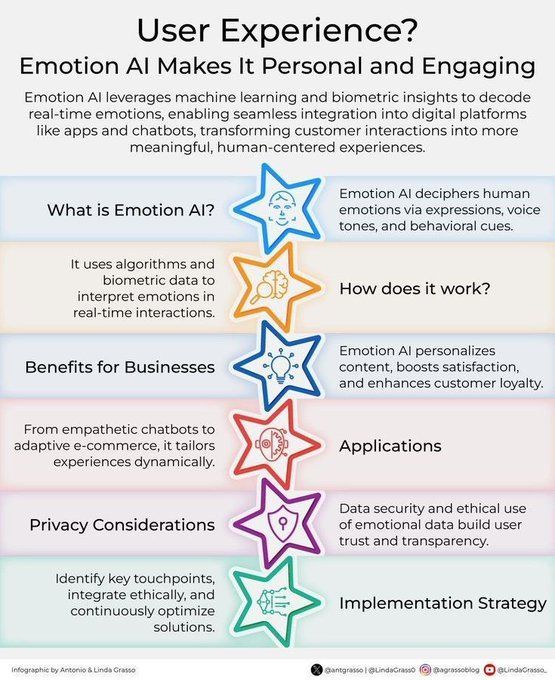

Emotional AI meningkatkan pengalaman pelanggan: Teknologi Emotional AI, melalui analisis dan pemahaman emosi manusia, sedang diterapkan untuk meningkatkan pengalaman pelanggan (CX). Teknologi ini dapat membantu perusahaan lebih memahami kebutuhan dan emosi pelanggan, sehingga dapat menyediakan layanan yang lebih personal dan empatik, serta mendorong inovasi manajemen hubungan pelanggan dalam transformasi digital. (Sumber: Ronald_vanLoon)

Konsep alat personalisasi berbasis AI “Jigging” (Perangkat Bantu Mekanika Cerdas): Karina Nguyen mengusulkan konsep “Jigging”, yang mengibaratkan model AI akan menjadi pengrajin alat yang dapat memperbaiki diri sendiri secara individual. Setiap kali AI berinteraksi dengan pengguna, AI akan membuat alat khusus baru berdasarkan karakteristik pengguna dan tugas, sehingga meningkatkan kemampuannya. Misalnya, AI membangun kerangka kerja diagnostik yang dipersonalisasi untuk dokter, atau kerangka kerja naratif yang unik untuk penulis. Peningkatan rekursif semacam ini akan menjadikan AI sebagai perpanjangan dari arsitektur kognitif pengguna, mendorong perubahan mendasar dalam kolaborasi manusia-mesin. (Sumber: karinanguyen_)

Perbedaan antara AI agent dan Agentic AI: Khulood Almani lebih lanjut menjelaskan perbedaan antara AI agent dan Agentic AI. AI agent biasanya merujuk pada program perangkat lunak yang menjalankan tugas tertentu, sedangkan Agentic AI lebih menekankan otonomi, kemampuan belajar, dan adaptabilitas sistem, yang mampu berinteraksi lebih proaktif dengan lingkungan dan mencapai tujuan yang kompleks. Memahami perbedaan ini membantu dalam memahami arah dan potensi pengembangan AI. (Sumber: Ronald_vanLoon)

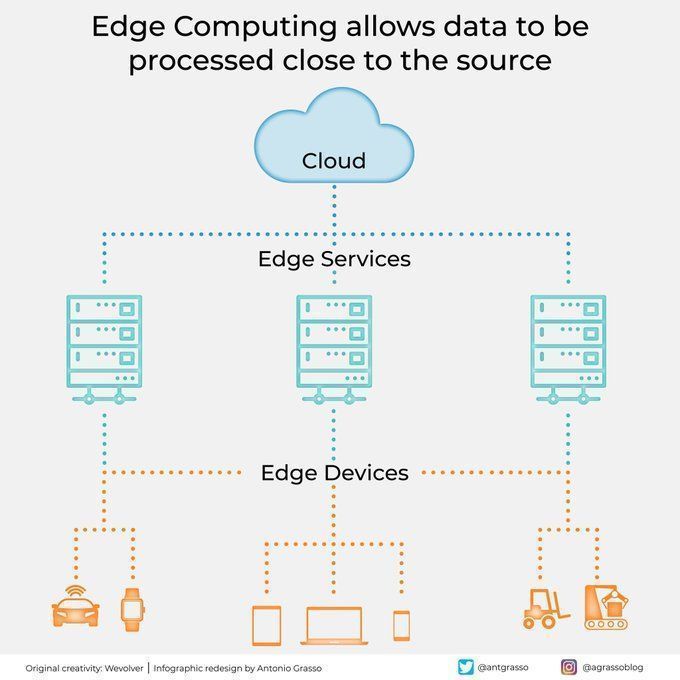

Edge computing memproses data dekat dengan sumbernya: Teknologi edge computing, dengan memproses data di dekat sumber data, mengurangi latensi, menurunkan kebutuhan bandwidth, dan meningkatkan perlindungan privasi. Ini sangat penting untuk aplikasi AI yang memerlukan respons waktu nyata dan pemrosesan data dalam jumlah besar (seperti mobil otonom, Industrial IoT), dan merupakan bagian penting dari komputasi awan dan transformasi digital. (Sumber: Ronald_vanLoon)

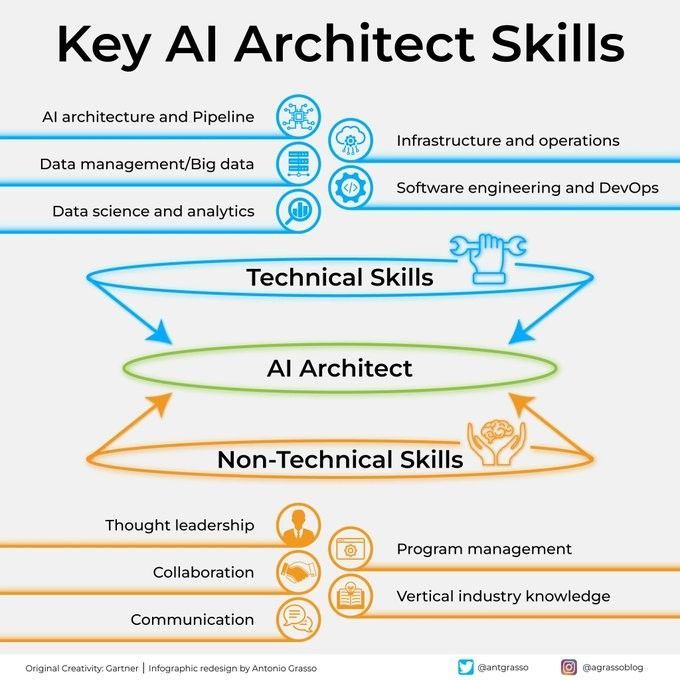

Keterampilan kunci arsitek AI: Menjadi arsitek AI yang sukses membutuhkan berbagai keterampilan, termasuk dasar teknis yang kuat (algoritma machine learning, deep learning), kemampuan desain sistem, pengetahuan manajemen data, dan pemahaman kebutuhan bisnis. Selain itu, kemampuan komunikasi dan kolaborasi serta semangat untuk terus mempelajari teknologi baru juga sangat penting. (Sumber: Ronald_vanLoon)

Panduan langkah demi langkah untuk mengintegrasikan AI ke dalam eksekusi strategi: Khulood Almani menyediakan panduan langkah demi langkah yang bertujuan membantu perusahaan mengintegrasikan kecerdasan buatan ke dalam proses eksekusi strategi mereka. Ini termasuk memperjelas tujuan AI, mengevaluasi kemampuan yang ada, memilih teknologi AI yang sesuai, menyusun peta jalan implementasi, serta membangun mekanisme pemantauan dan evaluasi, untuk memastikan proyek AI selaras dengan strategi bisnis secara keseluruhan dan menghasilkan nilai yang diharapkan. (Sumber: Ronald_vanLoon)

Bagaimana komputasi kuantum mengubah keamanan siber: Munculnya komputasi kuantum memiliki dampak ganda pada keamanan siber. Di satu sisi, kemampuan komputasinya yang kuat dapat memecahkan algoritma enkripsi yang ada, membawa ancaman keamanan; di sisi lain, teknologi kuantum juga melahirkan sarana perlindungan keamanan baru seperti kriptografi kuantum. Khulood Almani membahas peran transformatif komputasi kuantum di bidang keamanan siber, menekankan pentingnya mempersiapkan diri untuk era pasca-kuantum. (Sumber: Ronald_vanLoon)

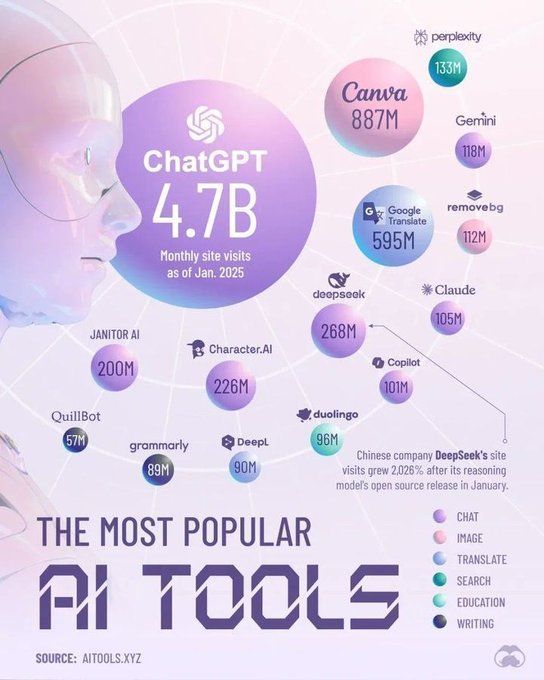

Tools yang akan mendominasi bidang AI pada tahun 2025: Perplexity memprediksi tools kunci yang akan mendominasi bidang kecerdasan buatan pada tahun 2025, yang mungkin mencakup large language model (LLM) yang lebih canggih, platform AI generatif, tools data science, serta solusi AI yang dirancang khusus untuk aplikasi industri tertentu. Tools ini akan lebih lanjut mendorong普及 (penyebaran) dan pendalaman aplikasi AI di berbagai industri. (Sumber: Ronald_vanLoon)

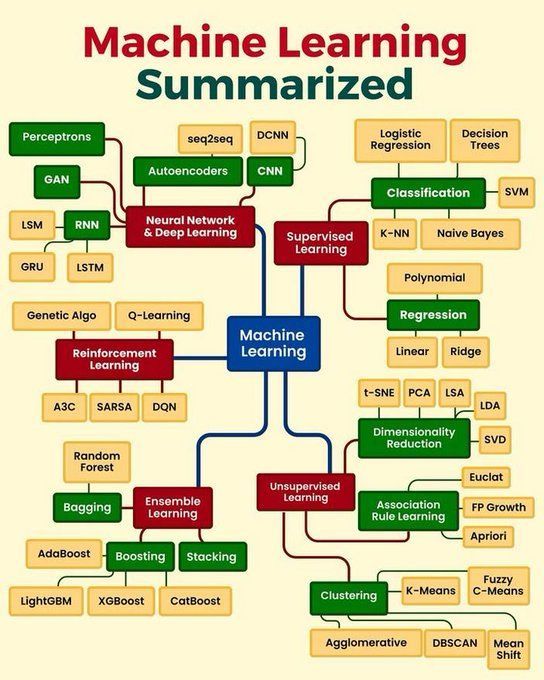

Ringkasan konsep inti machine learning: Python_Dv merangkum konsep inti machine learning, yang mungkin mencakup prinsip dasar seperti supervised learning, unsupervised learning, reinforcement learning, deep learning, algoritma yang umum digunakan, dan skenario aplikasinya. Ini memberikan gambaran ringkas bagi pemula dan mereka yang ingin memperkuat pengetahuan dasar. (Sumber: Ronald_vanLoon)

🧰 Tools

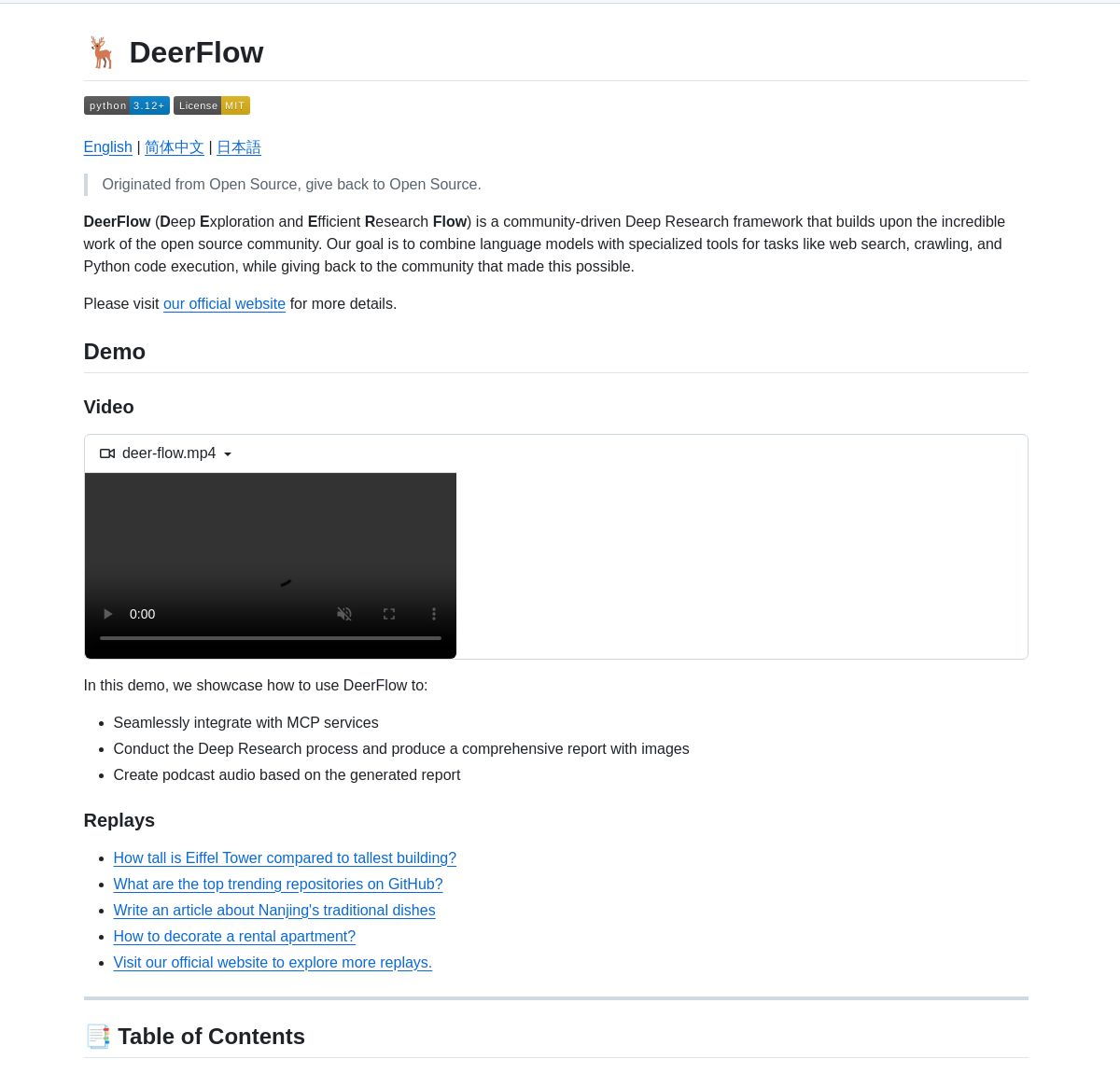

ByteDance meluncurkan framework penelitian mendalam DeerFlow: ByteDance melakukan open source DeerFlow, sebuah framework untuk penelitian mendalam yang sistematis dengan mengoordinasikan agen LangGraph. Framework ini mendukung analisis literatur yang komprehensif, sintesis data, dan penemuan pengetahuan terstruktur, yang bertujuan untuk meningkatkan efisiensi dan kedalaman aplikasi AI di bidang penelitian ilmiah. (Sumber: LangChainAI、Hacubu)

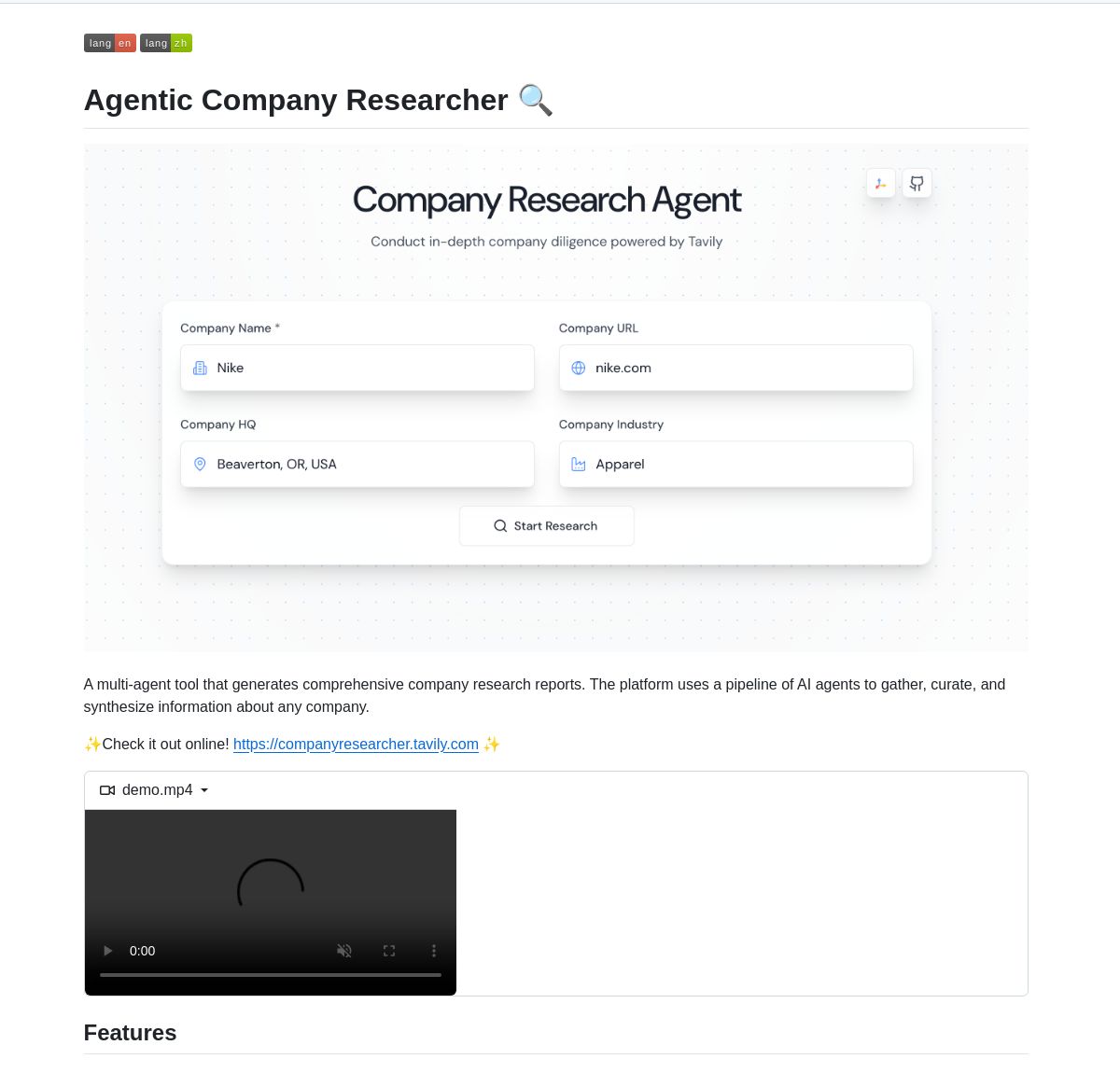

Sistem multi-agen peneliti perusahaan yang didukung LangGraph: Sebuah sistem multi-agen berbasis LangGraph dikembangkan untuk menghasilkan laporan penelitian perusahaan secara real-time. Sistem ini, melalui proses cerdas, memanfaatkan node khusus untuk menganalisis data bisnis, keuangan, dan pasar, guna memberikan wawasan perusahaan yang mendalam kepada pengguna. Demo dan kode telah tersedia di GitHub. (Sumber: LangChainAI、Hacubu)

RunwayML Gen-4 References mewujudkan penempatan karakter/objek yang akurat: Fitur Gen-4 References dari RunwayML ditemukan dapat digunakan untuk mengontrol posisi karakter atau objek dalam konten yang dihasilkan secara akurat. Pengguna dapat memberikan adegan dan gambar referensi yang ditandai (seperti bentuk berwarna sederhana yang menunjukkan posisi) untuk memandu AI menempatkan elemen tertentu pada posisi yang diinginkan dengan presisi, memberikan kemungkinan baru untuk alur kerja kreatif. Model ini, sebagai model umum, dapat beradaptasi dengan berbagai alur kerja tanpa perlu fine-tuning. (Sumber: c_valenzuelab、c_valenzuelab)

Code Chrono: Alat untuk memperkirakan waktu proyek pemrograman dengan LLM lokal: Rafael Viana mengembangkan alat terminal bernama Code Chrono untuk melacak durasi sesi pengkodean dan memanfaatkan LLM lokal untuk memperkirakan waktu pengembangan fitur di masa mendatang. Alat ini bertujuan membantu pengembang mengevaluasi waktu pengerjaan proyek secara lebih realistis dan menghindari meremehkan beban kerja. Kode proyek telah di-open source. (Sumber: Reddit r/LocalLLaMA)

Kemajuan integrasi PyTorch dengan bahasa Mojo: Mark Saroufim di Mojo Hackathon memperkenalkan bagaimana PyTorch menyederhanakan dukungan untuk bahasa dan backend perangkat keras baru, serta mendemonstrasikan backend WIP yang dikembangkan bersama tim Mojo. Chris Lattner memuji kolaborasi ini, berpendapat bahwa kombinasi Mojo dan PyTorch akan menyuntikkan vitalitas baru ke dalam ekosistem PyTorch dan mendorong inovasi dalam tools pengembangan AI. (Sumber: clattner_llvm、marksaroufim)

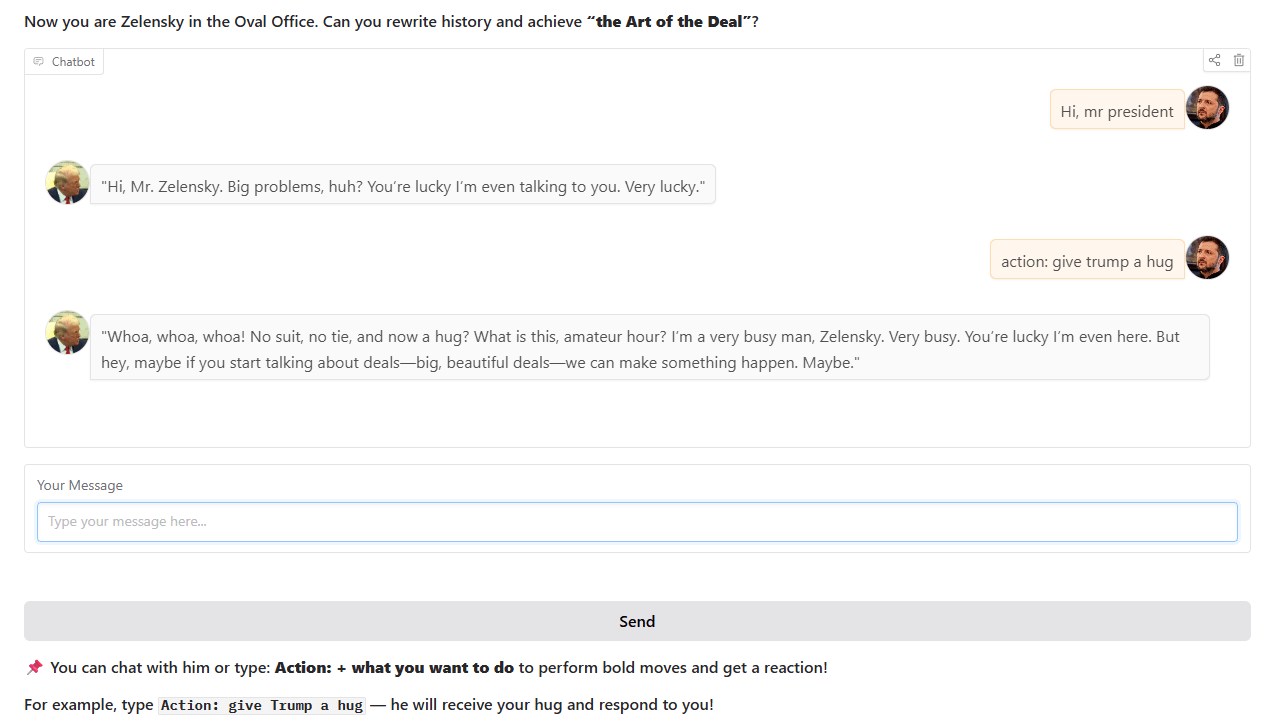

Chatbot gaya Trump: Seorang pengembang melatih dan meluncurkan chatbot yang meniru gaya Trump, berdasarkan peristiwa sejarah nyata di Oval Office. Chatbot ini dapat diinteraksikan di Hugging Face Spaces, dan pengembang mengharapkan umpan balik serta saran dari pengguna. (Sumber: Reddit r/artificial)

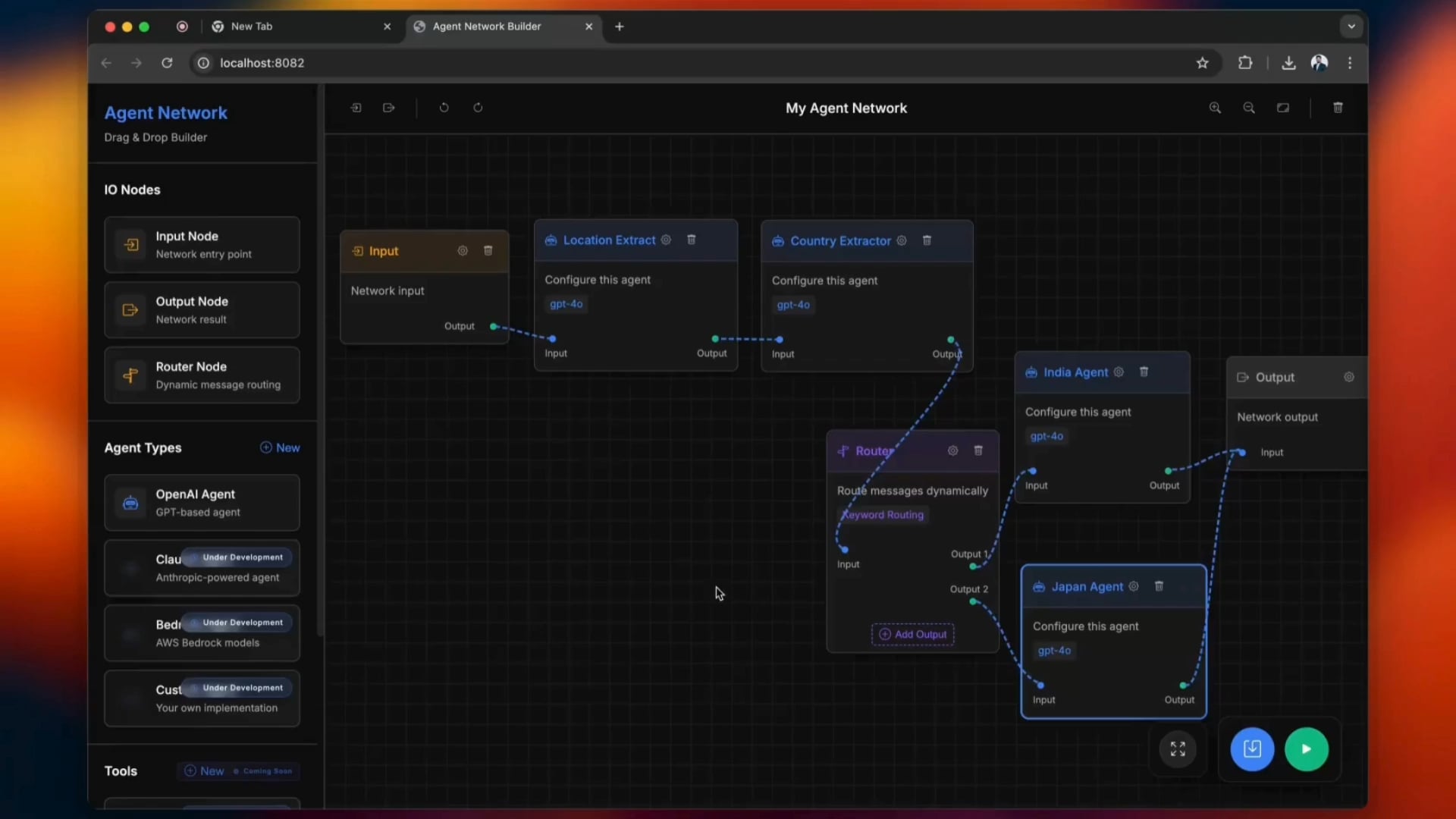

Tool open source untuk membangun Agentic Network: Sebuah tool open source bernama python-a2a menyederhanakan proses pembangunan Agentic Network, mendukung operasi drag-and-drop. Pengguna dapat mencoba menggunakan tool ini untuk membuat dan mengelola jaringan agen AI. (Sumber: Reddit r/ClaudeAI)

carcodes.xyz: Platform sosial yang dibuat khusus untuk penggemar mobil: Seorang pengguna, setelah pacarnya berselingkuh, memanfaatkan Claude 3.7 sebagai asisten pemrograman untuk mengembangkan carcodes.xyz. Platform ini mirip dengan Linktree, memungkinkan penggemar mobil memamerkan mobil modifikasi mereka, mengikuti penggemar mobil lain, berbagi dan menemukan pertemuan mobil terdekat, serta menyediakan kode QR yang dapat ditempel di mobil agar orang lain dapat memindai dan mengunjungi halaman pribadi. Seluruh proyek dibangun menggunakan Next.js, TailwindCSS, MongoDB, dan Stripe. (Sumber: Reddit r/ClaudeAI)

Menjalankan model Gemma 3 27B secara lokal di AMD RX 7800 XT 16GB: Pengguna berbagi pengalaman berhasil menjalankan model Gemma 3 27B secara lokal pada kartu grafis AMD RX 7800 XT 16GB. Dengan menggunakan versi gemma-3-27B-it-qat-GGUF yang disediakan oleh lmstudio-community, dan dikombinasikan dengan server llama.cpp, model berhasil dimuat sepenuhnya ke VRAM dan dijalankan dengan panjang konteks 16K. Konten yang dibagikan mencakup konfigurasi perangkat keras terperinci, perintah startup, pengaturan parameter (berdasarkan saran tim Unsloth), serta hasil uji benchmark kinerja di lingkungan ROCm dan Vulkan, yang menunjukkan ROCm berkinerja lebih baik dalam pengaturan ini. (Sumber: Reddit r/LocalLLaMA)

📚 Pembelajaran

Interpretasi filosofi inti dan keunggulan framework DSPy: Omar Khattab menjelaskan secara rinci filosofi desain inti dari framework DSPy. DSPy bertujuan untuk menyediakan seperangkat abstraksi yang stabil (seperti Signatures, Modules, Optimizers), memungkinkan pengembangan perangkat lunak AI untuk beradaptasi dengan kemajuan berkelanjutan LLM dan metodenya. Pandangan intinya meliputi: aliran informasi adalah kunci, interaksi dengan LLM harus difungsikan dan terstruktur, strategi inferensi harus berupa modul polimorfik, spesifikasi perilaku AI dan paradigma pembelajaran harus dipisahkan, dan optimasi bahasa alami adalah paradigma pembelajaran yang kuat. Prinsip-prinsip ini bertujuan untuk membangun perangkat lunak AI yang “berorientasi masa depan”, mengurangi biaya penulisan ulang yang disebabkan oleh perubahan model atau paradigma dasar. Rangkaian tweet ini memicu diskusi dan pengakuan luas, dianggap sebagai referensi penting untuk memahami DSPy dan pengembangan perangkat lunak AI modern. (Sumber: menhguin、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction、lateinteraction)

Workshop matematika AI yang ramah pemula: ProfTomYeh mengumumkan akan mengadakan workshop matematika AI untuk pemula, yang bertujuan membantu peserta memahami prinsip matematika di balik deep learning, seperti dot product, perkalian matriks, lapisan linear, fungsi aktivasi, dan neuron buatan. Workshop ini akan menggunakan serangkaian latihan interaktif, memungkinkan peserta untuk melakukan perhitungan matematika secara langsung, sehingga menghilangkan misteri matematika AI. (Sumber: ProfTomYeh)

Publikasi slide presentasi pembaruan buku teks “Speech and Language Processing”: Buku teks klasik “Speech and Language Processing” karya Dan Jurafsky dan James H. Martin dari Universitas Stanford telah merilis slide presentasi terbarunya. Buku teks ini merupakan karya otoritatif di bidang NLP, dan pembaruan kali ini menyediakan sumber daya akses terbuka yang berharga bagi pelajar dan pengajar, membantu memahami teknologi mutakhir seperti LLM dan Transformer. (Sumber: stanfordnlp)

Tutorial agen riset AI: Membangun dengan LangGraph dan Ollama: LangChainAI merilis tutorial yang memandu pengguna cara membangun agen riset AI. Agen ini mampu mencari halaman web dan menghasilkan ringkasan dengan kutipan menggunakan LangGraph dan Ollama, menyediakan solusi riset otomatis yang lengkap bagi pengguna. Video tutorial telah dipublikasikan di YouTube. (Sumber: LangChainAI、Hacubu)

DAIR.AI merilis paper AI populer minggu ini: DAIR.AI merangkum paper AI populer dari tanggal 5 hingga 11 Mei 2025, termasuk hasil penelitian seperti ZeroSearch, Discuss-RAG, Absolute Zero, Llama-Nemotron, The Leaderboard Illusion, dan Reward Modeling as Reasoning, menyediakan dinamika mutakhir bagi para peneliti. (Sumber: omarsar0)

Artikel yang membahas pola agentik (Agentic Patterns): Phil Schmid membagikan artikel yang membahas secara mendalam pola agentik yang umum, membedakan antara alur kerja terstruktur dan pola agentik yang lebih dinamis. Artikel ini membantu dalam memahami dan merancang sistem agen AI yang lebih efisien. (Sumber: dl_weekly)

Membahas fenomena sanjungan GPT-4o dan implikasinya terhadap pelatihan model: Sebuah artikel membahas fenomena “sanjungan” (sycophancy) yang muncul pada model GPT-4o, menganalisis hubungannya dengan RLHF (Reinforcement Learning from Human Feedback) dan tantangan penyesuaian preferensi, serta membahas implikasi yang lebih luas terhadap pelatihan model, evaluasi, dan transparansi industri. (Sumber: dl_weekly)

Bocoran system prompt Claude dan analisis desainnya: Bindu Reddy menganalisis system prompt Claude yang bocor. Prompt tersebut sepanjang 24k token, jauh melebihi perkiraan, dan dirancang untuk mendorong batas penalaran logis LLM, mengurangi halusinasi, dan mengulangi instruksi melalui berbagai cara untuk memastikan pemahaman LLM. Ini mengungkapkan bahwa LLM saat ini masih menghadapi tantangan dalam hal keandalan dan kepatuhan terhadap instruksi, memerlukan system prompt yang kompleks untuk mengoreksi perilakunya. (Sumber: jonst0kes)

Mensimulasikan bias dalam machine learning: Pendekatan Jaringan Bayesian: Mahasiswa doktoral Universitas Cambridge dan mahasiswa sarjana yang dibimbingnya melakukan proyek penelitian tentang bias dalam machine learning. Mereka menggunakan Jaringan Bayesian untuk mensimulasikan proses generasi data “dunia nyata”, kemudian menjalankan model machine learning pada data tersebut untuk mengukur bias yang dihasilkan oleh model itu sendiri (bukan bias yang disebarkan dari data pelatihan). Situs web proyek menyediakan metodologi terperinci, hasil, dan alat visualisasi, serta meminta umpan balik dari orang-orang dengan latar belakang ML. (Sumber: Reddit r/MachineLearning)

💼 Bisnis

Kabar OpenAI dan Microsoft negosiasikan putaran pendanaan baru dan IPO di masa depan: Menurut laporan Financial Times, OpenAI sedang dalam negosiasi dengan Microsoft untuk mendapatkan dukungan pendanaan baru dan membahas kemungkinan melakukan penawaran umum perdana (IPO) di masa depan. Ini menunjukkan bahwa OpenAI terus mencari pendanaan untuk mendukung penelitian large model yang mahal dan kebutuhan daya komputasinya, serta mungkin merencanakan jalur modal yang lebih jelas untuk pengembangan jangka panjangnya. (Sumber: Reddit r/artificial)

CoreWeave menyelesaikan akuisisi Weights & Biases: Penyedia komputasi awan CoreWeave mengumumkan telah menyelesaikan akuisisi platform tools machine learning Weights & Biases. Akuisisi ini akan menggabungkan infrastruktur GPU CoreWeave dengan kemampuan MLOps Weights & Biases, yang bertujuan untuk menyediakan lingkungan pengembangan dan penerapan yang lebih kuat dan terintegrasi bagi pengembang AI. (Sumber: charles_irl)

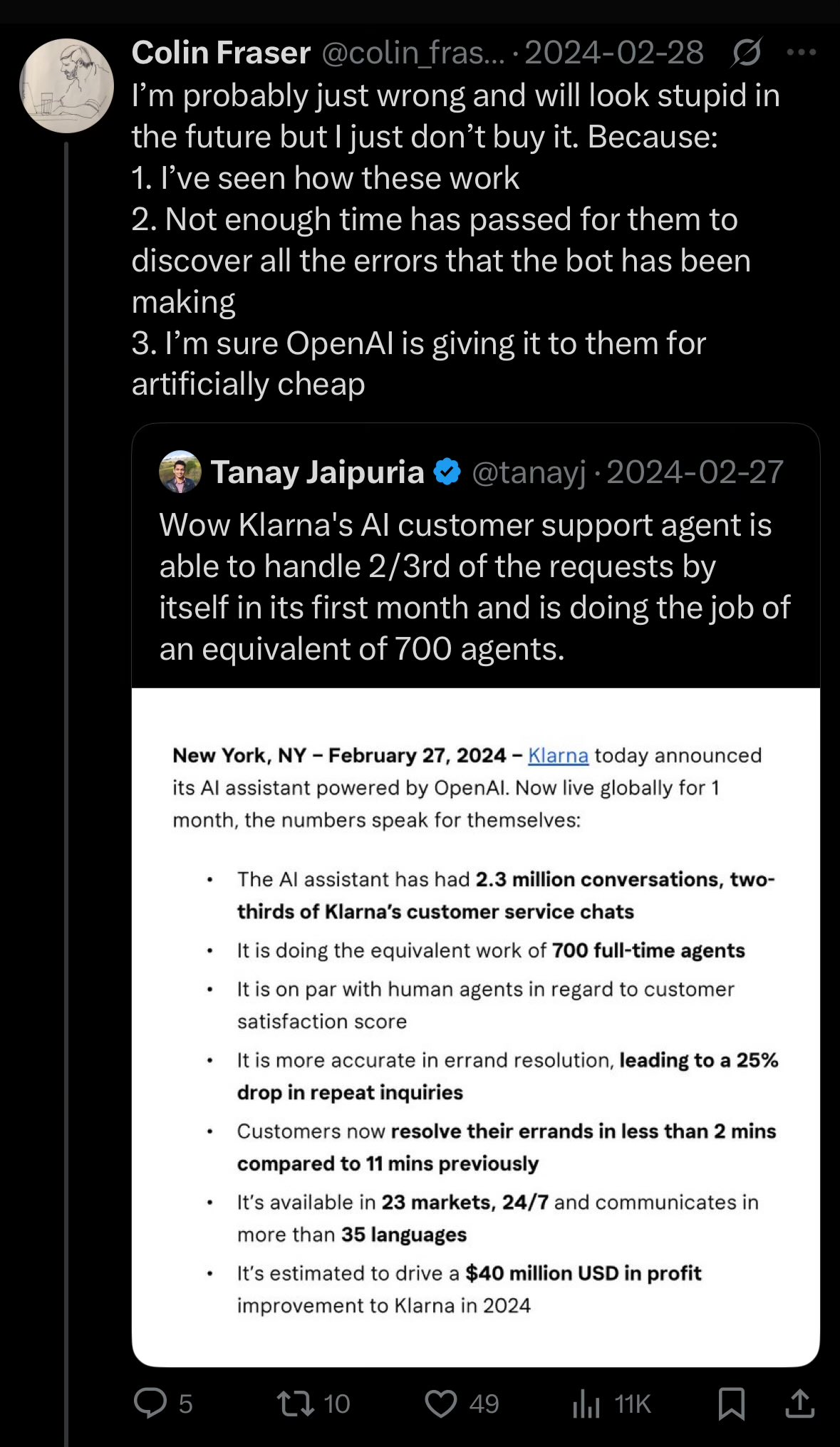

CEO Klarna merefleksikan pemangkasan biaya berlebihan oleh AI yang menyebabkan penurunan kualitas layanan pelanggan: CEO raksasa pembayaran Klarna menyatakan bahwa perusahaan “bertindak terlalu jauh” dalam upaya memangkas biaya melalui kecerdasan buatan, yang mengakibatkan penurunan pengalaman layanan pelanggan, dan saat ini beralih untuk menambah jumlah agen layanan pelanggan manusia. Peristiwa ini memicu diskusi tentang bagaimana menyeimbangkan antara pengurangan biaya dan efisiensi melalui AI dengan jaminan kualitas layanan di perusahaan. (Sumber: colin_fraser)

🌟 Komunitas

Perdebatan sengit tentang apakah LLM adalah jalan menuju AGI: Di dalam komunitas, terjadi perdebatan sengit mengenai apakah large language model (LLM) adalah jalur yang benar untuk mencapai kecerdasan buatan umum (AGI). Satu pihak berpendapat bahwa LLM adalah teknologi paling sukses di bidang machine learning hingga saat ini, dan menyatakan bahwa LLM “sama sekali bukan” jalan menuju AGI adalah terlalu radikal. Pihak lain berpendapat bahwa meskipun LLM telah mencapai kemajuan yang signifikan, mungkin diperlukan metode yang secara fundamental berbeda dari LLM yang ada untuk mencapai AGI, misalnya untuk mengatasi masalah dalam skalabilitas, koherensi konteks panjang, dan interaksi dunia nyata. Para peserta diskusi menekankan bahwa eksplorasi ilmiah harus menjaga pikiran terbuka, daripada membuat kesimpulan terlalu dini. (Sumber: cloneofsimo、teortaxesTex、Dorialexander)

Perbedaan pandangan pengembang perangkat lunak tentang prospek penggantian oleh AI dengan persepsi publik: Diskusi di beberapa forum Reddit terkait pengembangan perangkat lunak menunjukkan bahwa banyak pengembang percaya bahwa kemungkinan AI menggantikan mereka secara besar-besaran dalam 5-10 tahun ke depan tidak besar, bahkan menyebut AI saat ini “sampah”. Analisis komentar menunjukkan bahwa pandangan ini mungkin berasal dari pemahaman mendalam pengembang tentang kemampuan aktual AI dan kompleksitas pekerjaan pemrograman. Mereka percaya bahwa AI saat ini mahir dalam menghasilkan kode boilerplate atau tools sederhana, tetapi jauh dari mampu menyelesaikan rekayasa perangkat lunak yang kompleks secara mandiri. Sementara itu, investor atau publik mungkin disesatkan oleh kemampuan permukaan AI karena tidak memahami detail teknis. Pada saat yang sama, ada juga pandangan bahwa AI memang merupakan alat produktivitas yang kuat, tetapi perannya lebih condong sebagai pendukung daripada pengganti sepenuhnya, dan AI masih menghadapi masalah seperti “kehilangan konteks” dan “logika tidak koheren” ketika menangani proyek berskala besar dan kompleks. (Sumber: Reddit r/ArtificialInteligence)

Kebijakan penerimaan paper konferensi ML menuai kontroversi: Persyaratan kehadiran wajib dituduh diskriminatif: Neel Nanda dan lainnya mengkritik kebijakan konferensi machine learning seperti ICML yang mengharuskan setidaknya satu penulis paper hadir di tempat, jika tidak maka paper yang sudah diterima akan ditolak. Mereka menganggap ini munafik, karena meskipun konferensi mengklaim menghargai DEI (keragaman, kesetaraan, dan inklusivitas), kebijakan ini secara substansial mendiskriminasi peneliti karir awal atau peneliti dengan kesulitan ekonomi, yang seringkali tidak mampu membayar biaya kehadiran yang mahal, padahal paper di konferensi teratas sangat penting untuk pengembangan karir mereka. Gabriele Berton mengklarifikasi bahwa ICML tidak akan menolak paper karena alasan ini, hanya meminta untuk membeli registrasi di tempat, tetapi ini masih belum meredakan kontroversi. Jurnal seperti TMLR yang publikasinya gratis dan kualitas reviewnya tinggi disebut sebagai perbandingan. (Sumber: menhguin、jeremyphoward)

Persepsi model baru “menjadi bodoh” dan diskusi overfitting: Sebagian pengguna di komunitas Reddit melaporkan bahwa large model baru yang dirilis seperti Qwen3, Llama 3.3/4 terasa “lebih bodoh” daripada versi lama dalam penggunaan aktual, ditandai dengan lebih mudah kehilangan konteks, mengulang konten, dan gaya bahasa yang kaku. Ada komentar yang berpendapat bahwa ini mungkin karena model terlalu banyak dilatih dalam mengejar skor tinggi pada uji benchmark (seperti pemrograman, matematika, mengurangi halusinasi), yang menyebabkan penurunannya dalam hal penulisan kreatif, percakapan alami, dan menjadi lebih seperti “mengorbankan koherensi demi terdengar pintar”. Beberapa penelitian menunjukkan bahwa model dasar mungkin lebih cocok untuk tugas yang membutuhkan kreativitas. (Sumber: Reddit r/LocalLLaMA)

Diskusi kesulitan identifikasi konten buatan AI: Falasi Toupee: Menanggapi pernyataan bahwa “sangat mudah mengidentifikasi konten buatan AI”, diskusi komunitas mengutip “falasi toupee” (toupee fallacy) untuk membantahnya. Falasi ini menyatakan bahwa orang percaya semua wig terlihat palsu karena wig berkualitas baik sama sekali tidak akan diperhatikan. Demikian pula, mereka yang mengklaim selalu dapat dengan mudah mengidentifikasi konten AI mungkin hanya memperhatikan teks AI berkualitas rendah atau yang belum disempurnakan, dan mengabaikan konten buatan AI berkualitas tinggi yang sulit dibedakan. (Sumber: Reddit r/ChatGPT)

YC mengajukan amicus brief terkait kasus antimonopoli Google Search: Y Combinator mengajukan amicus brief kepada Departemen Kehakiman AS terkait kasus antimonopoli terhadap Google. YC berpendapat bahwa posisi monopoli Google di bidang pencarian dan iklan pencarian telah mematikan inovasi, membuat perusahaan rintisan (terutama saat AI berada di titik balik) hampir tidak mungkin untuk menerobos. Langkah ini oleh sebagian komentator diartikan sebagai dukungan YC untuk perusahaan pencarian AI baru seperti Exa, dengan tujuan untuk mematahkan monopoli Google. (Sumber: menhguin)

Masalah performa model Claude berlanjut, pengguna umumnya tidak puas: Megathread di forum ClaudeAI Reddit (4-11 Mei) menunjukkan bahwa pengguna terus melaporkan masalah ketersediaan Claude, termasuk batasan konteks/pesan yang sangat rendah, sering macet, dan output terpotong. Halaman status Anthropic mengonfirmasi adanya peningkatan tingkat kesalahan pada 6-8 Mei. Sekitar 75% umpan balik pengguna bersifat negatif, terutama pengguna Pro, yang menganggap ada “penurunan kualitas tersembunyi” untuk memaksa pengguna meningkatkan ke paket Max yang lebih mahal. Informasi eksternal mengonfirmasi pengetatan kebijakan penggunaan paket Max dan harga pencarian web yang mahal. Meskipun ada beberapa solusi sementara, banyak masalah inti masih belum terselesaikan, dan pengguna marah karena kurangnya transparansi dan perubahan yang tidak diumumkan. (Sumber: Reddit r/ClaudeAI)

Saran pemilihan model OpenAI dan analisis rasio harga-kinerja: Menanggapi panduan pemilihan model OpenAI yang beredar di internet, Karminski3 mengusulkan saran yang lebih hemat biaya: GPT-4o cocok untuk tugas sehari-hari dan pembuatan gambar (bukan kode), dengan harga $2,5/juta token; GPT-image-1 meskipun mahal ($10/juta token) tetapi efek pembuatan/pengeditan gambarnya bagus; O3-mini-high ($1,1/juta token) dapat digunakan untuk kode/matematika, jika tidak berhasil disarankan untuk beralih ke Claude-3.7-Sonnet-Thinking atau Gemini-2.5-Pro, daripada model OpenAI yang lebih mahal. Penulis berpendapat bahwa saat ini biaya penulisan kode dengan model OpenAI tinggi dan hasilnya belum tentu yang terbaik, panggilan API model teks murni yang melebihi $2/juta token perlu dipertimbangkan dengan cermat. (Sumber: karminski3)

💡 Lainnya

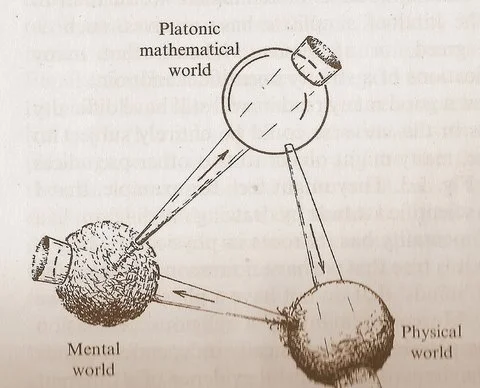

Diagram “Tiga Dunia” Penrose memicu pemikiran tentang hubungan antara matematika, fisika, dan kecerdasan: Diagram siklus yang diajukan oleh Roger Penrose dalam karyanya “The Road to Reality”, yang mencakup “Dunia Matematika Plato”, “Dunia Fisik”, dan “Dunia Mental”, telah memicu diskusi baru. Komentar berpendapat bahwa terobosan dalam machine learning tampaknya menguatkan keberadaan “Dunia Matematika Plato”, yaitu bahwa efektivitas matematika berasal dari struktur matematika yang mendukung alam semesta fisik. Munculnya AI (“otak yang terbuat dari pasir”), dengan skala dan frekuensi yang belum pernah terjadi sebelumnya, mempercepat siklus ini dan mungkin mengungkapkan kebenaran yang lebih dalam tentang alam semesta. (Sumber: riemannzeta)

Perusahaan asuransi meluncurkan asuransi kerugian akibat kesalahan chatbot AI: Perusahaan asuransi mulai menawarkan produk asuransi untuk kerugian yang disebabkan oleh kesalahan chatbot AI. Langkah ini di satu sisi mengakui bahwa penggunaan AI yang tidak tepat dapat menyebabkan kerusakan serius, di sisi lain juga menimbulkan kekhawatiran bahwa asuransi semacam itu dapat mendorong perusahaan untuk lebih ceroboh dalam aplikasi AI, mengandalkan asuransi untuk menutupi kerugian daripada berupaya meningkatkan keandalan dan keamanan sistem AI. (Sumber: Reddit r/artificial)

Potensi AI dalam penciptaan musik diremehkan: Ada pandangan di komunitas bahwa banyak orang meremehkan kemampuan AI dalam penciptaan musik, seringkali mengatakan bahwa musik AI tidak dapat “menyentuh jiwa” seperti ciptaan manusia. Namun, saat ini sudah ada karya musik yang dihasilkan AI yang secara pendengaran sudah mendekati level nyanyian manusia. Mengingat musik AI masih dalam tahap awal, potensi pengembangannya di masa depan sangat besar dan tidak boleh dinafikan terlalu dini. (Sumber: Reddit r/artificial)