Kata Kunci:Model Gemini, Mistral AI, NVIDIA NeMo, LTX-Video, Browser Safari, RTX 5060, AI Agent, Fine-tuning pembelajaran penguatan, Generasi gambar asli Gemini, Kinerja pemrograman Mistral Medium 3, Modular framework NeMo 2.0, Generasi video real-time DiT, Transformasi pencarian berbasis AI

🔥 Fokus

Fitur pembuatan gambar native Google Gemini ditingkatkan, meningkatkan kualitas visual & akurasi rendering teks: Google mengumumkan bahwa fitur pembuatan gambar native pada model Gemini-nya menerima pembaruan penting, dengan versi baru “gemini-2.0-flash-preview-image-generation” yang diluncurkan di Google AI Studio dan Vertex AI. Pembaruan ini secara signifikan meningkatkan kualitas visual gambar dan akurasi rendering teks, serta mengurangi latensi. Fitur baru ini mendukung penggabungan elemen gambar, pengeditan real-time (seperti menambahkan objek, memodifikasi konten lokal), serta kombinasi dengan Gemini 2.0 Flash untuk memungkinkan AI secara mandiri menyusun konsep dan menghasilkan gambar. Pengguna dapat mencobanya secara gratis di Google AI Studio, dan harga panggilan API adalah 0,039 dolar AS per gambar. Meskipun ada kemajuan signifikan, beberapa pengguna berpendapat bahwa efek keseluruhannya masih sedikit di bawah GPT-4o. (Sumber: 量子位)

Mistral AI merilis Mistral Medium 3, fokus pada pemrograman & multimodal, biaya jauh lebih rendah: Perusahaan rintisan AI Prancis, Mistral AI, meluncurkan model multimodal terbarunya, Mistral Medium 3. Model ini menunjukkan kinerja yang luar biasa dalam tugas pemrograman dan STEM, diklaim mencapai atau melampaui 90% kinerja Claude Sonnet 3.7 dalam berbagai tolok ukur, dengan biaya hanya 1/8 (input 0,4 dolar AS/juta token, output 2 dolar AS/juta token). Mistral Medium 3 memiliki kemampuan tingkat perusahaan seperti deployment hybrid, pelatihan pasca-kustomisasi, dan integrasi dengan alat perusahaan, serta telah tersedia di Mistral La Plateforme dan Amazon Sagemaker, dan akan hadir di lebih banyak platform cloud di masa mendatang. Sementara itu, Mistral AI juga meluncurkan layanan chatbot untuk perusahaan, Le Chat Enterprise. (Sumber: 量子位)

NVIDIA NeMo framework 2.0 dirilis, meningkatkan modularitas & kemudahan penggunaan, mendukung model Hugging Face & GPU Blackwell: NVIDIA NeMo framework diperbarui ke versi 2.0, dengan perbaikan inti meliputi penggunaan konfigurasi Python menggantikan YAML untuk meningkatkan fleksibilitas; penyederhanaan eksperimen dan kustomisasi melalui abstraksi modular PyTorch Lightning; dan pemanfaatan alat NeMo-Run untuk perluasan eksperimen skala besar yang mulus. Versi baru ini menambahkan dukungan untuk pra-pelatihan dan fine-tuning model Hugging Face AutoModelForCausalLM, dan telah mendukung secara awal GPU NVIDIA Blackwell B200. Selain itu, NeMo framework juga mengintegrasikan dukungan untuk platform model dasar dunia NVIDIA Cosmos, untuk mempercepat pengembangan model dunia sistem AI fisik, termasuk pustaka pemrosesan video NeMo Curator dan Cosmos tokenizer. (Sumber: GitHub Trending)

Lightricks merilis LTX-Video: model pembuatan video DiT real-time: Lightricks telah melakukan open-source LTX-Video, yang diklaim sebagai model pembuatan video real-time pertama berdasarkan Diffusion Transformer (DiT). Model ini mampu menghasilkan video berkualitas tinggi dengan resolusi 1216×704 pada 30FPS, mendukung berbagai fungsi seperti text-to-image, image-to-video, animasi keyframe, perluasan video, dan konversi video-to-video. Versi terbaru 13B v0.9.7 meningkatkan kemampuan mengikuti prompt dan pemahaman fisika, serta meluncurkan pipeline video multi-skala untuk rendering berkualitas tinggi yang cepat. Model ini telah tersedia di Hugging Face dan memiliki integrasi dengan ComfyUI dan Diffusers. (Sumber: GitHub Trending)

Apple mempertimbangkan perombakan besar browser Safari, kemungkinan beralih ke pencarian berbasis AI, hubungan kerja sama dengan Google menjadi sorotan: Wakil Presiden Senior Apple, Eddy Cue, saat bersaksi dalam kasus antimonopoli Departemen Kehakiman AS terhadap Google, mengungkapkan bahwa Apple secara aktif mempertimbangkan untuk merombak browser Safari, dengan fokus beralih ke mesin pencari berbasis AI. Dia menunjukkan bahwa volume pencarian Safari menurun untuk pertama kalinya, sebagian karena pengguna beralih ke alat AI seperti OpenAI dan Perplexity AI. Apple telah melakukan konsultasi dengan Perplexity AI dan mungkin akan memperkenalkan lebih banyak opsi pencarian AI ke Safari. Langkah ini dapat memengaruhi perjanjian mesin pencari default Apple dengan Google senilai sekitar 20 miliar dolar AS per tahun, dan berdampak pada harga saham kedua perusahaan. Apple telah mengintegrasikan ChatGPT ke dalam Siri dan berencana untuk menambahkan Google Gemini. (Sumber: 36氪)

🎯 Perkembangan

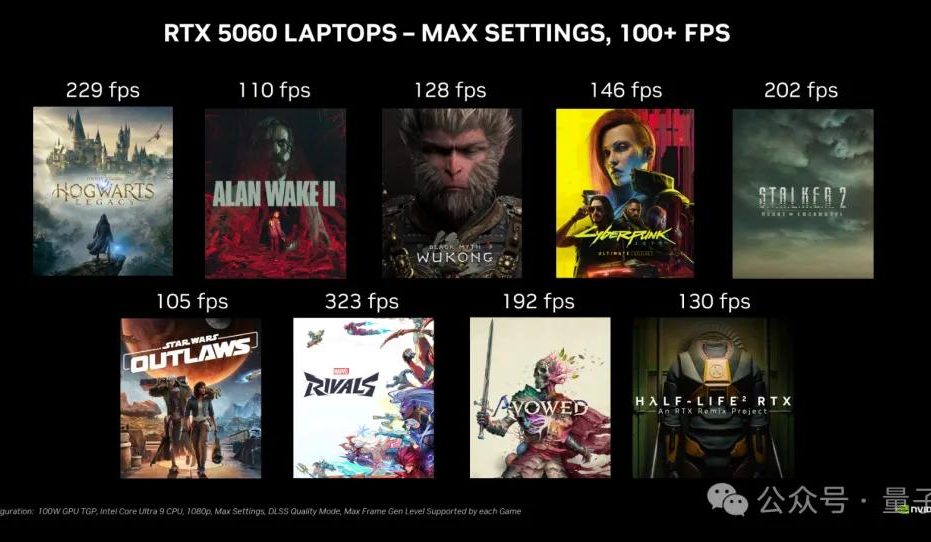

Kartu grafis desktop NVIDIA RTX 5060 akan dirilis pada 20 Mei, harga di Tiongkok 2499 yuan: NVIDIA mengumumkan bahwa kartu grafis desktop RTX 5060 akan mulai dijual pada 20 Mei waktu Beijing, dengan harga di Tiongkok sebesar 2499 yuan. Kartu ini menggunakan arsitektur Blackwell RTX, memiliki 3840 inti CUDA, memori GDDR7 8GB, dan total daya 145W. Menurut pihak resmi, dalam game yang mendukung teknologi multi-frame generation DLSS 4, kinerjanya dua kali lipat dari RTX 4060, dengan tujuan agar pengguna dapat menjalankan game dengan frame rate di atas 100 FPS. Peninjauan dan penjualan akan dilakukan pada hari yang sama. (Sumber: 量子位)

Google Gemini API meluncurkan fitur caching implisit, dapat menghemat biaya hingga 75%: Google mengumumkan peluncuran fitur caching implisit untuk Gemini API-nya. Ketika permintaan pengguna mengenai cache, biaya penggunaan model Gemini 2.5 dapat secara otomatis dihemat sebesar 75%. Sementara itu, jumlah token minimum yang diperlukan untuk memicu cache juga telah diturunkan, Gemini 2.5 Flash menjadi 1K token, dan Gemini 2.5 Pro menjadi 2K token. Fitur ini bertujuan untuk mengurangi biaya bagi pengembang yang menggunakan Gemini API, tanpa perlu membuat cache secara eksplisit. (Sumber: matvelloso, demishassabis, algo_diver, jeremyphoward)

Meta FAIR menunjuk Rob Fergus sebagai pimpinan baru, fokus pada Advanced General Intelligence (AGI): Meta mengumumkan bahwa Rob Fergus akan mengambil alih kepemimpinan tim Fundamental AI Research (FAIR). Yann LeCun menyatakan bahwa FAIR akan kembali fokus pada Advanced General Intelligence, yang biasa disebut sebagai AI tingkat manusia atau AGI. Berita ini mendapat perhatian luas dan ucapan selamat dari komunitas riset AI. (Sumber: ylecun, Ar_Douillard, soumithchintala, aaron_defazio, sainingxie)

OpenAI meluncurkan fitur Reinforcement Learning Fine-tuning (RFT) untuk model o4-mini: OpenAI mengumumkan bahwa model o4-mini-nya kini mendukung Reinforcement Learning Fine-tuning (RFT). Teknologi ini telah dikembangkan sejak Desember tahun lalu, memanfaatkan penalaran chain-of-thought dan penilaian khusus tugas untuk meningkatkan kinerja model, terutama cocok untuk domain yang kompleks. Model yang disesuaikan oleh perusahaan Ambience menggunakan RFT menunjukkan akurasi pengkodean ICD-10 27% lebih tinggi daripada dokter klinis ahli. Perusahaan Harvey juga melatih model melalui RFT untuk meningkatkan akurasi kutipan dalam tugas hukum. Sementara itu, model OpenAI tercepat dan terkecil, 4.1-nano, juga telah dibuka untuk fine-tuning. (Sumber: stevenheidel, aidan_mclau, andrwpng, teortaxesTex, OpenAIDevs, OpenAIDevs)

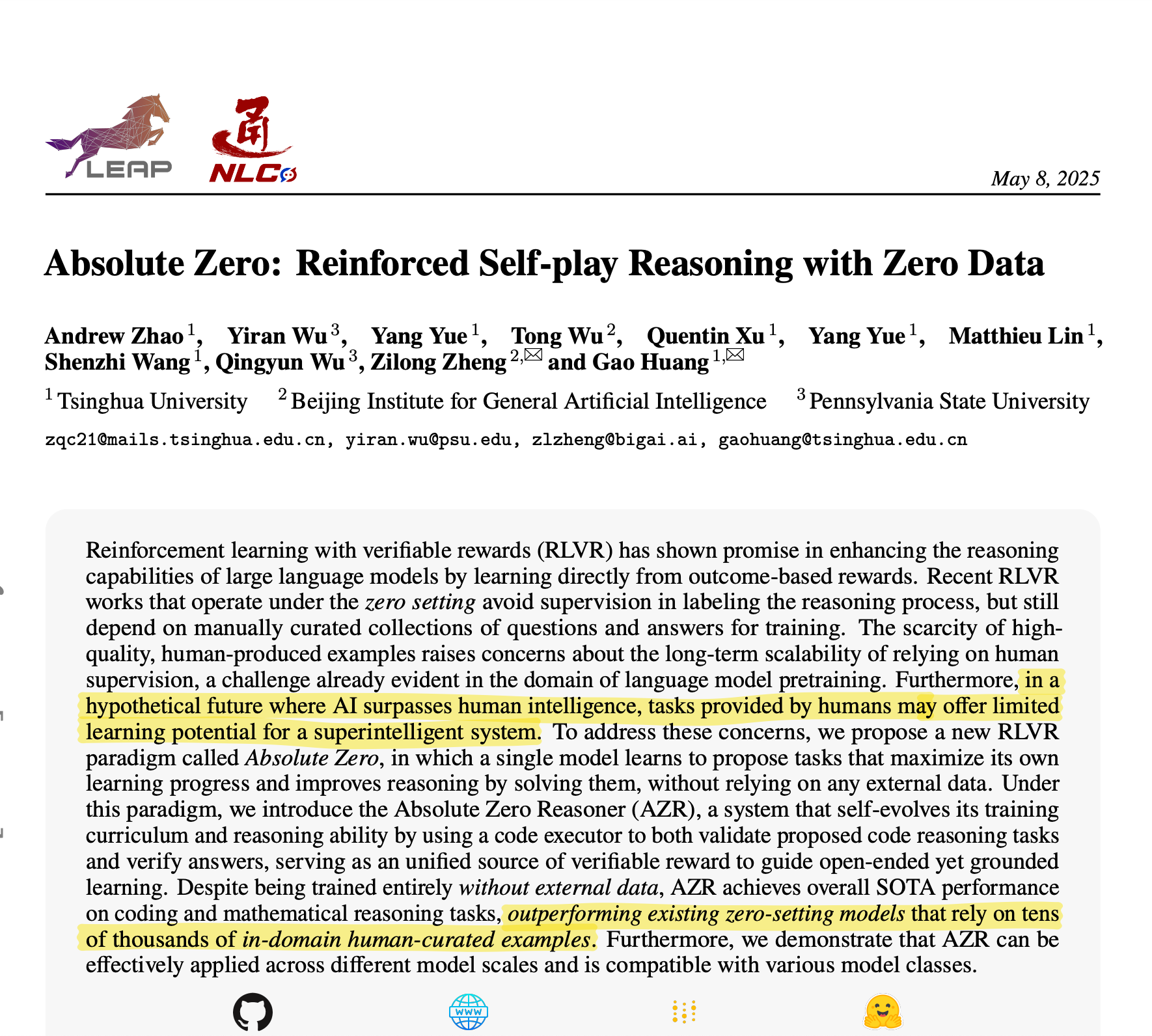

Universitas Tsinghua mengusulkan Absolute Zero Reasoner: AI menghasilkan data pelatihan sendiri untuk mencapai penalaran yang luar biasa: Tim dari Universitas Tsinghua mengembangkan model AI bernama Absolute Zero Reasoner, yang dapat sepenuhnya menghasilkan tugas pelatihan melalui self-play dan belajar darinya, tanpa memerlukan data eksternal apa pun. Dalam bidang seperti matematika dan pengkodean, kinerjanya telah melampaui model yang bergantung pada data yang dikurasi secara manual oleh para ahli. Pencapaian ini mungkin berarti bahwa masalah bottleneck data dalam pengembangan AI akan berkurang, membuka jalur baru menuju AGI. (Sumber: corbtt)

Meta & NVIDIA berkolaborasi untuk meningkatkan kinerja pencarian vektor GPU Faiss melalui cuVS: Meta dan NVIDIA mengumumkan kolaborasi untuk mengintegrasikan cuVS (CUDA Vector Search) NVIDIA ke dalam pustaka pencarian kesamaan open-source Meta, Faiss v1.10, guna meningkatkan kinerja pencarian vektor pada GPU secara signifikan. Integrasi ini meningkatkan waktu pembuatan indeks IVF hingga 4,7 kali, dan mengurangi latensi pencarian hingga 8,1 kali; dalam hal indeks graf, waktu pembuatan CUDA ANN Graph (CAGRA) 12,3 kali lebih cepat daripada HNSW CPU, dan latensi pencarian berkurang 4,7 kali. (Sumber: AIatMeta)

Google AI Studio dan Firebase Studio terintegrasi dengan Gemini 2.5 Pro: Google mengumumkan telah mengintegrasikan model Gemini 2.5 Pro ke dalam Gemini Code Assist (versi personal) dan Firebase Studio. Ini akan memberikan lebih banyak kemudahan dan fungsionalitas yang kuat bagi pengembang dalam menggunakan model pengkodean teratas di platform ini, yang bertujuan untuk meningkatkan efisiensi dan pengalaman pengkodean. (Sumber: algo_diver)

Microsoft Copilot meluncurkan fitur Pages, mendukung pengeditan inline dan penyorotan teks: Microsoft Copilot menambahkan fitur “Pages”, yang memungkinkan pengguna untuk mengedit balasan yang dihasilkan AI secara inline langsung di antarmuka Copilot, dapat menyorot teks dan mengajukan permintaan modifikasi spesifik. Fitur ini bertujuan untuk membantu pengguna mengubah pertanyaan dan hasil penelitian menjadi dokumen yang dapat digunakan dengan lebih cepat dan cerdas, sehingga meningkatkan efisiensi kerja. (Sumber: yusuf_i_mehdi)

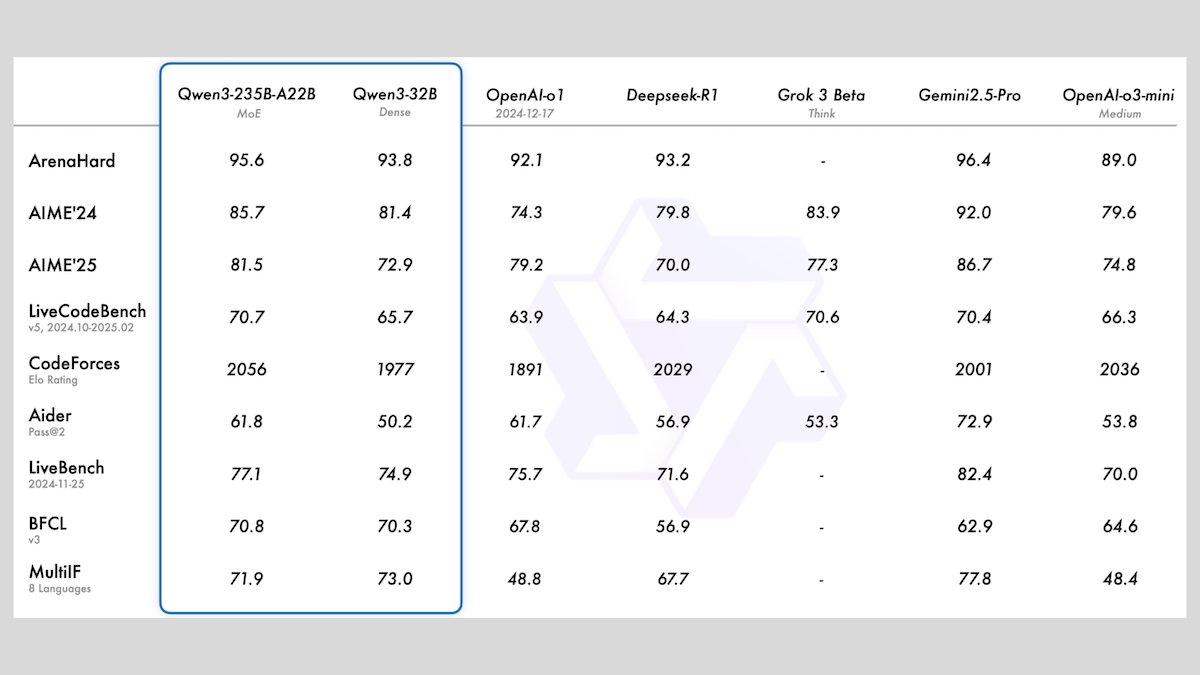

Alibaba meluncurkan seri model Qwen3, mencakup 8 model bahasa besar open-source: Alibaba merilis seri Qwen3, yang mencakup 8 model bahasa besar open-source, di antaranya terdapat 2 model Mixture of Experts (MoE) dan 6 model padat dengan rentang parameter dari 0.6B hingga 32B. Semua model mendukung mode inferensi opsional dan kemampuan multibahasa untuk 119 bahasa. Qwen3-235B-A22B dan Qwen3-30B-A3B menunjukkan kinerja yang sangat baik dalam tugas inferensi, pengkodean, dan pemanggilan fungsi, sebanding dengan model terkemuka seperti OpenAI, terutama Qwen3-30B-A3B yang mendapat perhatian karena kinerjanya yang kuat dan kemampuan berjalan secara lokal. (Sumber: DeepLearningAI)

Meta meluncurkan model Meta Locate 3D untuk penentuan posisi objek lingkungan 3D yang akurat: Meta AI merilis Meta Locate 3D, sebuah model yang dirancang khusus untuk penentuan posisi objek yang akurat di lingkungan 3D. Model ini bertujuan untuk membantu robot memahami lingkungan sekitar mereka dengan lebih akurat dan berinteraksi dengan manusia secara lebih alami. Meta telah menyediakan model, dataset, makalah penelitian, serta demo untuk digunakan dan dicoba oleh publik. (Sumber: AIatMeta)

Google merilis laporan baru, menjelaskan cara memanfaatkan AI untuk memerangi penipuan online: Google merilis laporan baru tentang bagaimana mereka memanfaatkan teknologi kecerdasan buatan untuk memerangi penipuan online di mesin pencari, browser Chrome, dan sistem Android. Laporan tersebut merinci upaya Google selama lebih dari satu dekade dalam memanfaatkan AI untuk melindungi pengguna dari penipuan online dan kemajuan terbarunya, menekankan peran penting AI dalam mengidentifikasi dan memblokir perilaku penipuan. (Sumber: Google)

Cohere meluncurkan model embedding Embed 4, memperkuat kemampuan pencarian & pengambilan AI: Cohere merilis model embedding terbarunya, Embed 4, yang bertujuan untuk merevolusi cara perusahaan mengakses dan memanfaatkan data. Embed 4, sebagai model embedding terkuat Cohere hingga saat ini, berfokus pada peningkatan akurasi dan efisiensi pencarian dan pengambilan AI, membantu organisasi membuka nilai tersembunyi dari data mereka. (Sumber: cohere)

Google mengumumkan konferensi Google I/O akan diadakan pada 20 Mei: Google secara resmi mengumumkan bahwa konferensi pengembang tahunannya, Google I/O, akan diadakan pada 20 Mei, dan pendaftaran telah dibuka. Pada saat itu akan ada pidato utama, peluncuran produk baru, dan pengumuman teknologi, dengan AI diperkirakan akan menjadi salah satu topik inti. (Sumber: Google)

Model NVIDIA Parakeet mencetak rekor baru transkripsi audio: mentranskripsikan audio 60 menit dalam 1 detik: Model Parakeet NVIDIA mencapai terobosan dalam transkripsi audio, mampu mentranskripsikan audio sepanjang 60 menit dalam 1 detik, dan menduduki peringkat teratas di daftar peringkat terkait Hugging Face. Pencapaian ini menunjukkan posisi terdepan NVIDIA dalam teknologi pengenalan suara dan menyediakan alat pemrosesan audio yang efisien bagi para pengembang. (Sumber: huggingface)

🧰 Alat

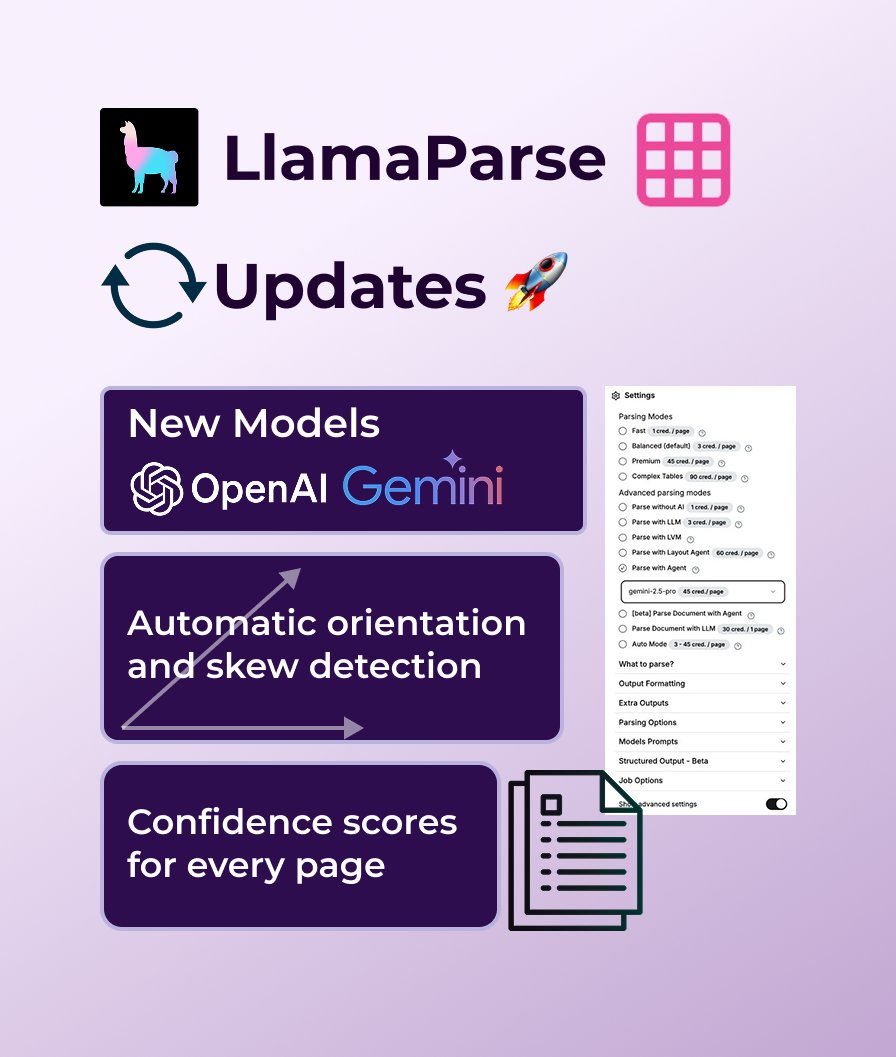

LlamaParse menambahkan dukungan GPT 4.1 dan Gemini 2.5 Pro, memperkuat kemampuan parsing dokumen: LlamaParse baru-baru ini melakukan serangkaian pembaruan fungsional, termasuk pengenalan model parsing baru GPT 4.1 dan Gemini 2.5 Pro untuk meningkatkan akurasi. Selain itu, versi baru menambahkan fungsi deteksi orientasi dan kemiringan otomatis untuk memastikan parsing yang selaras sempurna; menyediakan skor kepercayaan untuk mengevaluasi kualitas parsing; dan memungkinkan pengguna untuk menyesuaikan toleransi kesalahan dan cara menangani halaman yang gagal. LlamaParse menyediakan kuota gratis 10.000 halaman per bulan. (Sumber: jerryjliu0)

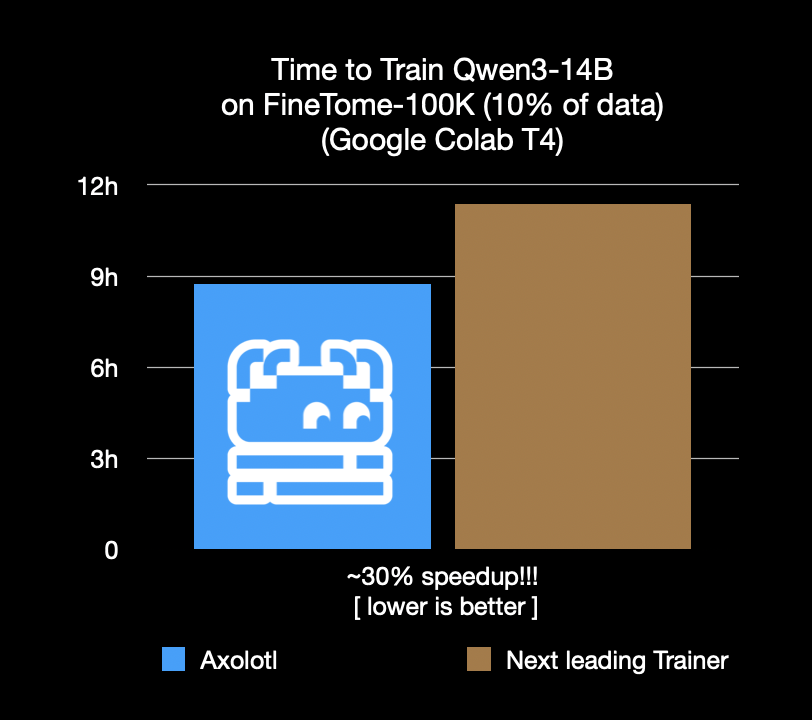

Framework fine-tuning Axolotl dipercepat 30%, menghemat biaya & waktu: Framework fine-tuning Axolotl mengumumkan bahwa pada beban kerja nyata seperti FineTome-100k, kecepatannya 30% lebih cepat daripada framework sub-optimal berikutnya. Bagi tim machine learning menengah hingga besar, ini berarti penghematan biaya ribuan dolar per bulan. Optimalisasi framework ini bertujuan untuk membantu pengguna melakukan fine-tuning model dengan lebih efisien dan ekonomis. (Sumber: Teknium1, winglian, maximelabonne)

Runway meluncurkan episode pilot animasi “Mars & Siv: No Vacancy”, menunjukkan kemampuan model Gen-4: Studio AI di bawah Runway meluncurkan episode pilot animasi “Mars & Siv: No Vacancy”, yang dibuat oleh Jeremy Higgins dan Britton Korbel. Karya ini menunjukkan penerapan model Gen-4 Runway di berbagai tahap alur kerja produksi animasi, dari konsep hingga produk akhir, menyoroti potensi AI dalam pembuatan konten kreatif. (Sumber: c_valenzuelab, c_valenzuelab)

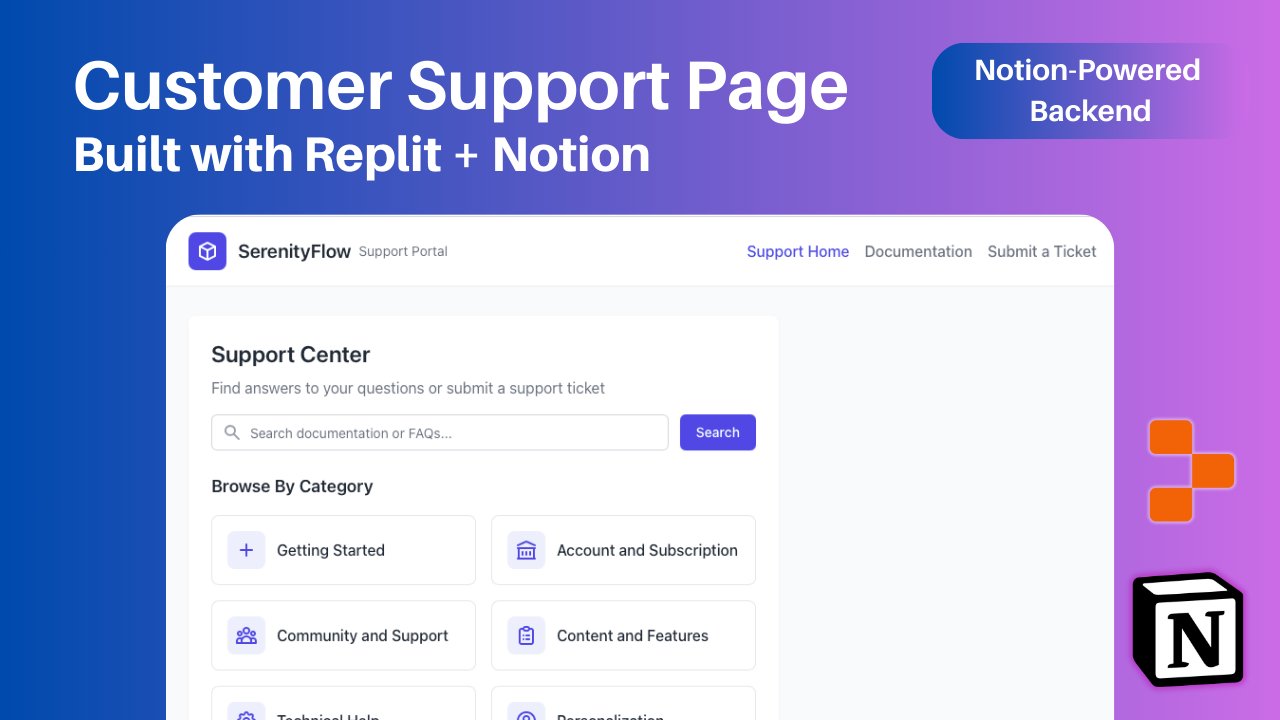

Replit menambahkan integrasi Notion, mendukung penggunaan konten Notion sebagai backend aplikasi: Replit mengumumkan kerja sama integrasi baru dengan Notion, yang memungkinkan pengembang menggunakan Notion sebagai backend aplikasi mereka. Pengguna dapat menghubungkan database Notion ke proyek Replit, untuk menampilkan FAQ, menggerakkan chatbot AI kustom berbasis dokumen, dan akan mendukung pencatatan tiket dukungan kembali ke Notion. Langkah ini bertujuan untuk menggabungkan kemampuan organisasi backend Notion dengan kemampuan pembuatan frontend Replit yang fleksibel. (Sumber: amasad, amasad, pirroh)

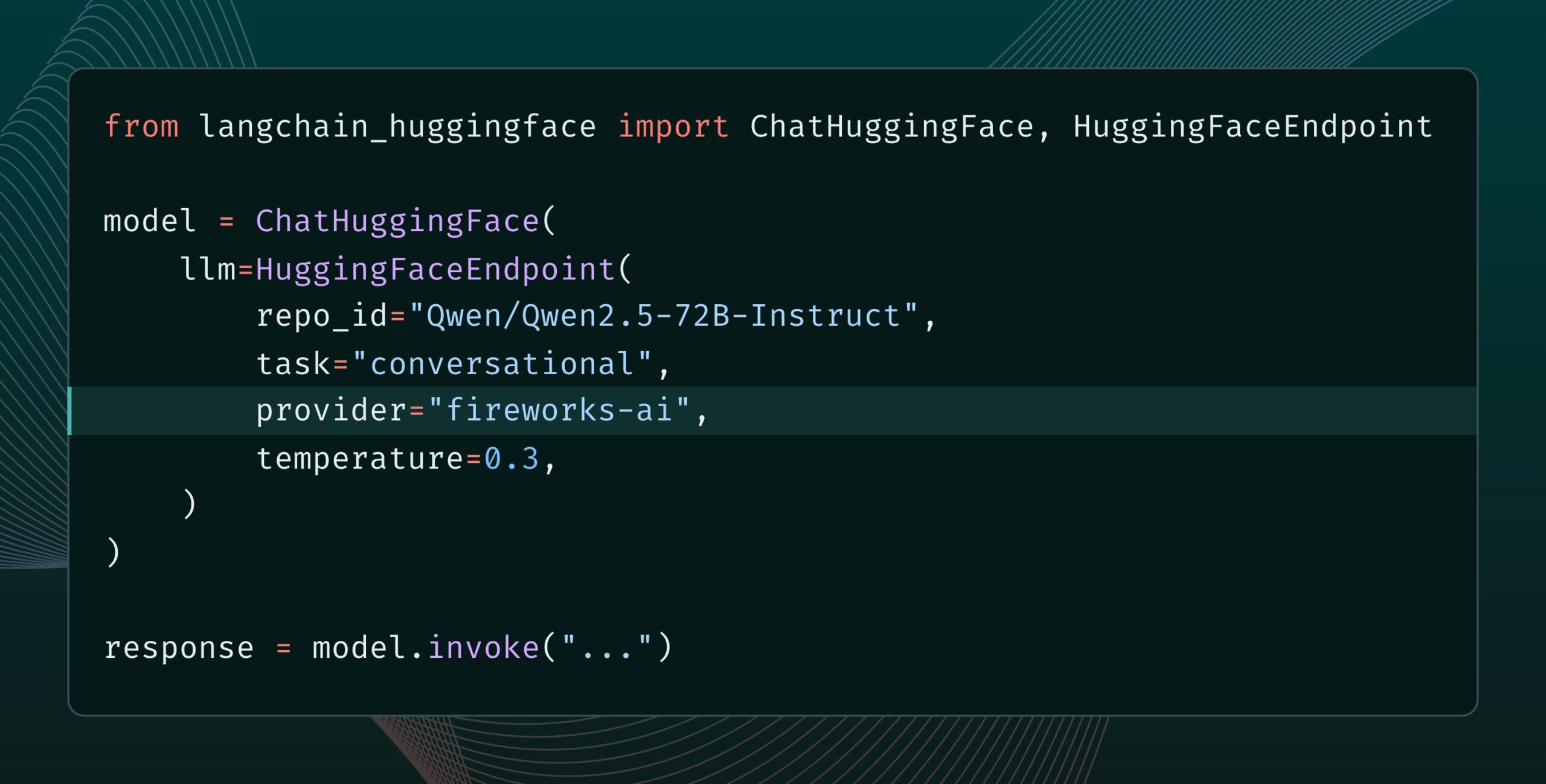

Langchain-huggingface v0.2 dirilis, mendukung HF Inference Providers: Langchain-huggingface merilis versi v0.2, versi baru ini menambahkan dukungan untuk Hugging Face Inference Providers. Pembaruan ini akan membuat penggunaan layanan inferensi yang disediakan oleh Hugging Face dalam ekosistem LangChain menjadi lebih mudah. (Sumber: LangChainAI, huggingface, ClementDelangue, hwchase17, Hacubu)

smolagents 1.15 dirilis, menambahkan fungsi output streaming: Framework agen AI smolagents merilis versi 1.15, memperkenalkan fungsi output streaming. Pengguna dapat mengaktifkannya dengan mengatur stream_outputs=True saat menginisialisasi CodeAgent, yang akan membuat semua proses interaksi terasa lebih lancar. (Sumber: huggingface, AymericRoucher, ClementDelangue)

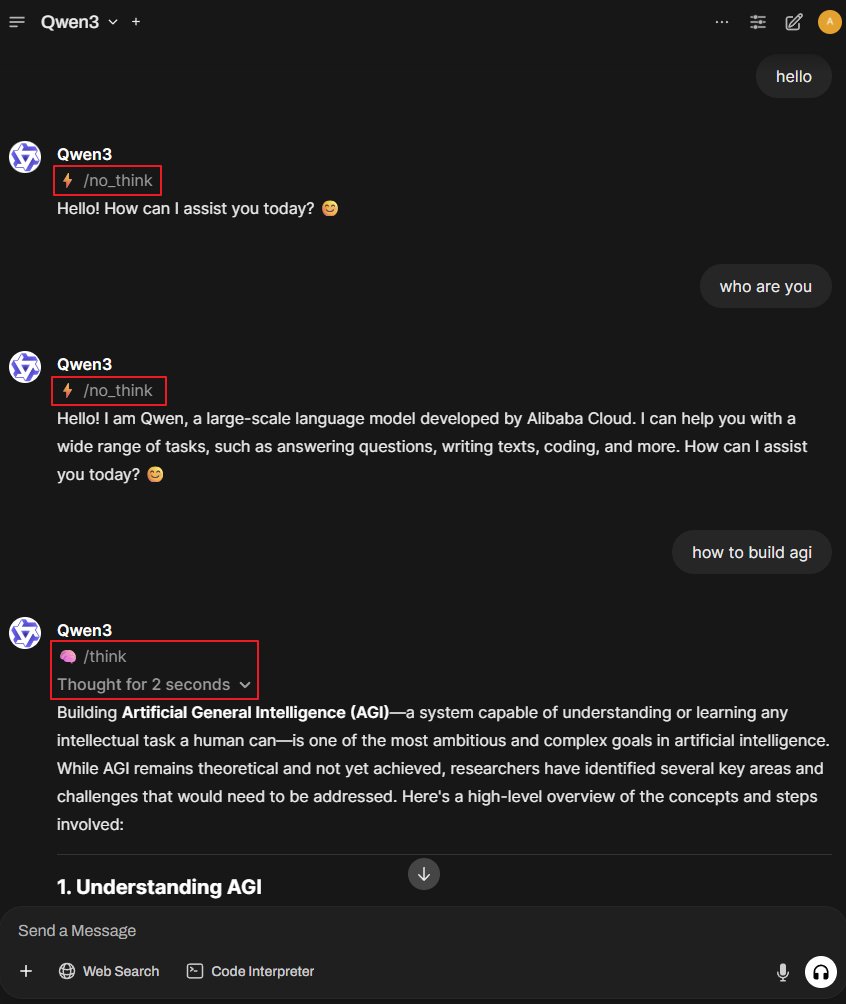

Proyek Better-Qwen3: membuat model Qwen3 secara otomatis beralih mode berpikir: Sebuah proyek GitHub bernama Better-Qwen3 mendapat perhatian, proyek ini bertujuan agar model Qwen3 dapat secara otomatis mengontrol apakah akan mengaktifkan “mode berpikir” berdasarkan kompleksitas pertanyaan pengguna. Untuk pertanyaan sederhana, model akan langsung menjawab; untuk pertanyaan kompleks, model akan secara otomatis masuk ke mode berpikir untuk memberikan jawaban yang lebih mendalam. Alamat proyek: http://github.com/AaronFeng753/Better-Qwen3 (Sumber: karminski3, Reddit r/LocalLLaMA)

MLX-Audio: Pustaka TTS/STT/STS berbasis framework Apple MLX: MLX-Audio adalah pustaka text-to-speech (TTS), speech-to-text (STT), dan speech-to-speech (STS) yang dibuat khusus untuk chip Apple (Apple Silicon), dikembangkan berdasarkan framework MLX Apple, bertujuan untuk menyediakan kemampuan pemrosesan suara yang efisien. Pustaka ini mendukung berbagai bahasa, kustomisasi suara, kontrol kecepatan bicara, dan menyediakan antarmuka web interaktif serta REST API. (Sumber: GitHub Trending)

Model Runway References mendukung fungsi perluasan gambar (Outpainting): Model References dari Runway kini mendukung fungsi perluasan gambar (outpainting). Pengguna hanya perlu menempatkan gambar di References, memilih format output yang diinginkan, membiarkan prompt kosong, lalu klik generate, untuk memperluas gambar asli. Fungsi ini semakin meningkatkan kemampuan Runway dalam pengeditan dan pembuatan gambar. (Sumber: c_valenzuelab)

Docker2exe: Mengubah image Docker menjadi file executable: Docker2exe adalah alat yang dapat mengubah image Docker menjadi file executable mandiri, memudahkan pengguna untuk berbagi dan menjalankan. Alat ini mendukung mode embed, yaitu mengemas tarball image Docker langsung ke dalam file executable. Ketika dijalankan di perangkat target, jika tidak ada image Docker yang sesuai secara lokal, alat ini akan secara otomatis memuat image yang disematkan atau menariknya dari jaringan. (Sumber: GitHub Trending)

Smoothie Qwen: Menghaluskan probabilitas token model Qwen untuk menyeimbangkan generasi multibahasa: Smoothie Qwen adalah alat penyesuaian ringan yang, dengan menghaluskan probabilitas token dalam model Qwen, bertujuan untuk meningkatkan keseimbangan model dalam generasi multibahasa, mengurangi bias tak terduga terhadap bahasa tertentu (seperti Mandarin), sambil mempertahankan kinerja inti. Alat ini memanfaatkan rentang Unicode untuk mengidentifikasi token, melakukan analisis N-gram, dan menyesuaikan bobot token di lm_head. Model yang telah disesuaikan sebelumnya tersedia di Hugging Face. (Sumber: Reddit r/LocalLLaMA)

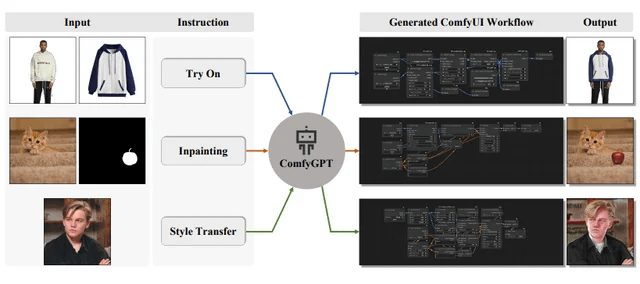

ComfyGPT: Sistem multi-agen yang mengoptimalkan diri sendiri untuk menghasilkan alur kerja ComfyUI yang komprehensif: Sebuah makalah berjudul “ComfyGPT: A Self-Optimizing Multi-Agent System for Comprehensive ComfyUI Workflow Generation” telah dikirimkan ke arXiv, memperkenalkan sistem bernama ComfyGPT. Sistem ini memanfaatkan metode multi-agen yang mengoptimalkan diri sendiri, bertujuan untuk secara komprehensif menghasilkan alur kerja ComfyUI, menyederhanakan pembuatan alur kerja generasi gambar yang kompleks. (Sumber: Reddit r/LocalLLaMA)

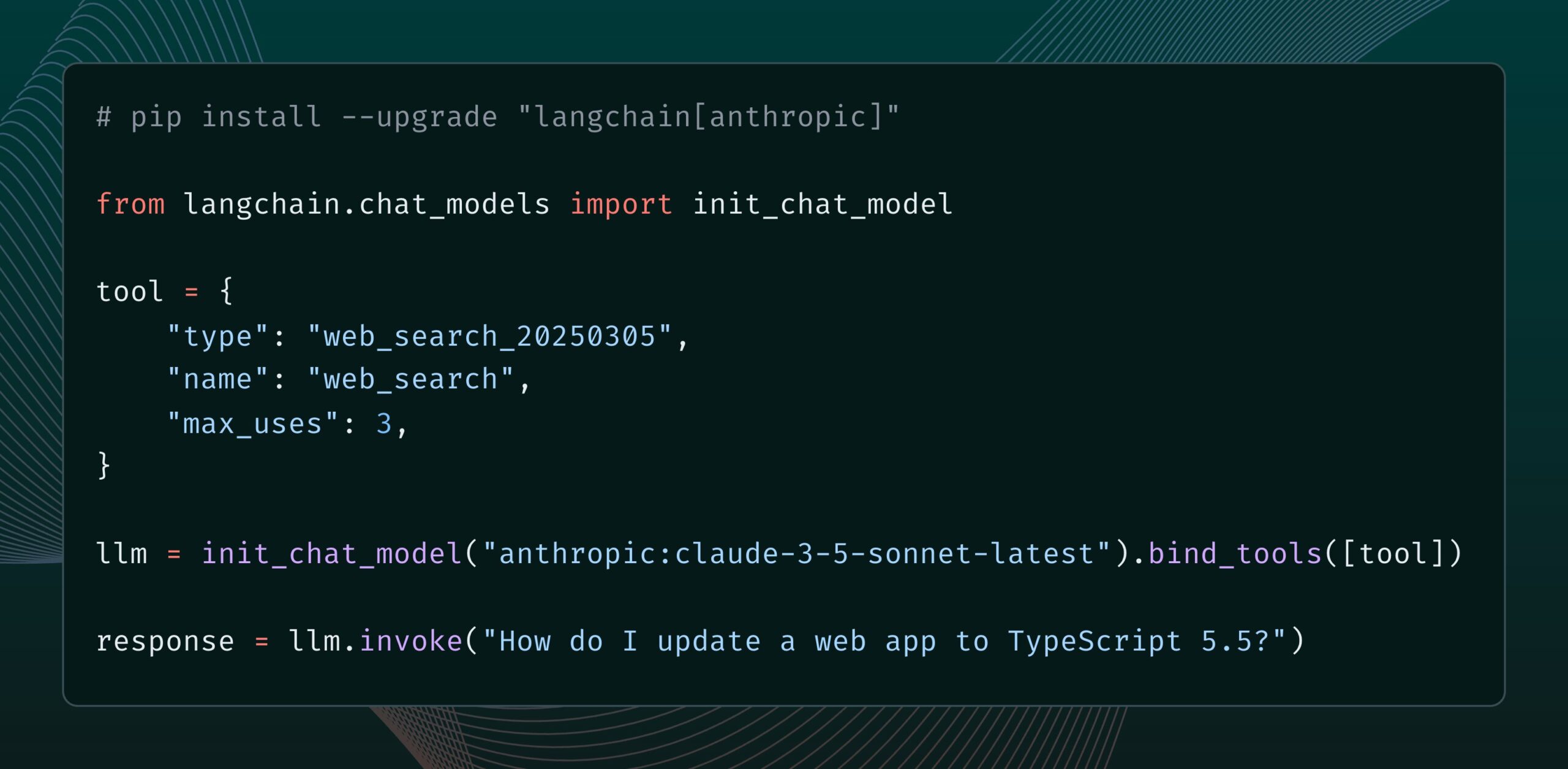

Model Anthropic Claude menambahkan alat pencarian web: Anthropic merilis alat pencarian web baru untuk model Claude-nya. Alat ini memungkinkan Claude melakukan pencarian web saat menghasilkan balasan dan menggunakan hasil pencarian sebagai dasar, memberikan jawaban dengan kutipan. Fungsi ini telah diintegrasikan ke dalam pustaka langchain-anthropic, meningkatkan kemampuan Claude untuk memperoleh dan memanfaatkan informasi real-time. (Sumber: LangChainAI, hwchase17)

Glass Health meluncurkan fitur Workspace, memanfaatkan AI untuk membantu diagnosis klinis & perencanaan pengobatan: Glass Health merilis fitur Workspace baru, yang memungkinkan dokter menggunakan AI untuk menyelesaikan alur kerja penalaran diagnostik yang kompleks, penyusunan rencana pengobatan, dan dokumentasi dengan lebih efektif. Langkah ini bertujuan untuk meningkatkan efisiensi dan kualitas pekerjaan medis melalui teknologi AI. (Sumber: GlassHealthHQ)

OpenWebUI menambahkan fitur catatan & rekaman rapat yang disempurnakan AI: Versi terbaru OpenWebUI menambahkan fitur catatan yang disempurnakan AI, pengguna dapat membuat catatan, melampirkan audio rapat atau suara, dan membiarkan AI menggunakan transkripsi audio untuk secara instan menyempurnakan, merangkum, atau mengoptimalkan catatan. Selain itu, juga mendukung fungsi perekaman dan impor audio rapat, memudahkan pengguna untuk meninjau dan mengekstrak informasi diskusi penting. (Sumber: Reddit r/OpenWebUI)

📚 Pembelajaran

PBB merilis laporan 200 halaman tentang AI dan pembangunan manusia global: Program Pembangunan Perserikatan Bangsa-Bangsa (UNDP) merilis laporan setebal 200 halaman yang mengkaji kecerdasan buatan dari perspektif pembangunan manusia global. Laporan ini membahas dampak AI terhadap Tujuan Pembangunan Berkelanjutan, ketidaksetaraan, tata kelola, serta masa depan pekerjaan, dan mengajukan rekomendasi kebijakan. Laporan ini mendapat perhatian karena pandangannya yang tajam. (Sumber: random_walker)

The Turing Post merilis artikel interpretasi mendalam protokol Agent2Agent (A2A): Mengingat minat komunitas yang kuat terhadap protokol komunikasi antar Agen AI, The Turing Post secara gratis merilis artikel interpretasi mendalamnya tentang protokol A2A Google di Hugging Face. Artikel tersebut membahas pentingnya protokol A2A (bertujuan untuk memecah silo Agen AI, mewujudkan kolaborasi), potensi aplikasi (seperti kolaborasi tim Agen khusus, alur kerja lintas perusahaan, standardisasi kolaborasi manusia-mesin, direktori Agen yang dapat dicari) serta cara kerjanya dan metode untuk memulai. (Sumber: TheTuringPost, TheTuringPost, TheTuringPost, dl_weekly)

Prompt engineer berbagi: Cara mudah menulis template prompt yang berguna: Prompt engineer dotey membagikan metode tiga langkah untuk membuat template prompt yang efisien: 1. Kumpulkan prompt dengan gaya yang sama tetapi tema yang berbeda; 2. Temukan kesamaan dan perbedaan (dapat dibantu AI); 3. Uji dan optimalkan berulang kali. Dia menekankan bahwa template yang baik mirip dengan fungsi dalam program, dengan sedikit modifikasi variabel dapat menghasilkan hasil yang berbeda. Dia juga membagikan template instruksi untuk menghasilkan prompt baru dengan cepat menggunakan AI, dan menunjukkan bahwa tidak semua gaya cocok untuk templatisasi, tema dengan detail kompleks masih memerlukan optimalisasi yang dipersonalisasi. (Sumber: dotey)

Peneliti DeepMind John Jumper dan timnya membuka lowongan, memperluas penemuan ilmiah berbasis LLM: Peneliti Google DeepMind, John Jumper, mengumumkan bahwa timnya sedang membuka beberapa lowongan untuk memperluas pekerjaan dalam penemuan ilmiah berbasis model bahasa besar (LLM). Posisi yang dibuka meliputi Research Scientist (RS) dan Research Engineer (RE), yang bertujuan untuk mendorong masa depan AI ilmu pengetahuan alam berbahasa. (Sumber: demishassabis, NandoDF)

Blog Ragas berbagi pengalaman perbaikan aplikasi AI selama dua tahun: Shahules786 di blog Ragas menerbitkan artikel yang merangkum pelajaran yang didapat selama dua tahun terakhir bekerja sama erat dengan tim AI, menyampaikan siklus evaluasi, dan meningkatkan sistem LLM. Artikel ini bertujuan untuk memberikan panduan dan wawasan praktis bagi para praktisi yang membangun dan mengoptimalkan aplikasi AI. (Sumber: Shahules786)

Kyunghyun Cho membahas metode pengajaran mata kuliah pascasarjana machine learning di era LLM: Profesor Universitas New York, Kyunghyun Cho, berbagi pemikiran dan eksperimennya mengenai konten pengajaran mata kuliah pascasarjana machine learning tahun pertama di era LLM dan komputasi skala besar saat ini. Ia mengusulkan untuk mengajarkan semua konten yang menerima SGD (Stochastic Gradient Descent) dan non-LLM, serta membimbing mahasiswa untuk membaca makalah klasik. (Sumber: ylecun, sainingxie)

Papan peringkat Intelligent Document Processing (IDP) dirilis, menyatukan evaluasi kemampuan pemahaman dokumen VLM: Papan peringkat Intelligent Document Processing (IDP) baru telah diluncurkan, bertujuan untuk menyediakan tolok ukur terpadu untuk berbagai tugas pemahaman dokumen seperti OCR, KIE, VQA, ekstraksi tabel, dll. Papan peringkat ini mencakup 6 tugas IDP inti, 16 dataset, dan 9229 dokumen. Hasil awal menunjukkan bahwa Gemini 2.5 Flash secara keseluruhan memimpin, tetapi semua model menunjukkan kinerja yang buruk dalam pemahaman dokumen panjang, dan ekstraksi tabel masih menjadi kendala. Kinerja GPT-4o versi terbaru bahkan menurun. (Sumber: Reddit r/MachineLearning, Reddit r/LocalLLaMA)

LangGraph meluncurkan fitur Cron Jobs, mendukung pemicuan agen AI terjadwal: Platform LangGraph dari LangChain menambahkan fitur Cron Jobs, yang memungkinkan pengguna mengatur tugas terjadwal untuk secara otomatis memicu jalannya agen AI. Fitur ini memungkinkan agen AI menjalankan tugas sesuai dengan jadwal yang telah ditentukan, cocok untuk skenario yang memerlukan pemrosesan atau pemantauan berkala. (Sumber: hwchase17)

💼 Bisnis

Alat debugging perangkat lunak AI Lightrun mendapatkan pendanaan Seri B sebesar 70 juta dolar AS, dipimpin oleh Accel dan Insight Partners: Pengembang alat observabilitas dan debugging perangkat lunak AI, Lightrun, mengumumkan penyelesaian pendanaan Seri B sebesar 70 juta dolar AS, dipimpin oleh Accel dan Insight Partners, dengan partisipasi dari Citigroup dan lainnya, sehingga total pendanaan mencapai 110 juta dolar AS. Produk intinya, Runtime Autonomous AI Debugger, dapat secara akurat menemukan kode bermasalah di IDE dan memberikan saran perbaikan, bertujuan untuk mempersingkat waktu debugging dari berjam-jam menjadi beberapa menit. Pendapatan perusahaan pada tahun 2024 meningkat 4,5 kali lipat, dengan klien termasuk perusahaan Fortune 500 seperti Citigroup dan Microsoft. (Sumber: 36氪)

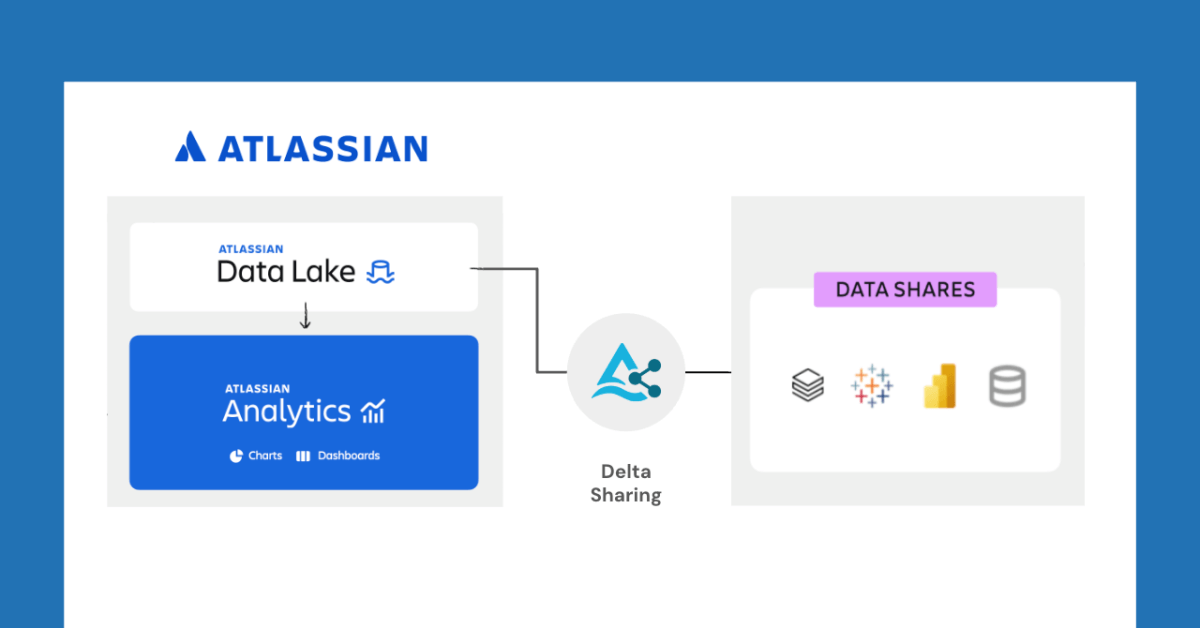

Databricks dan Atlassian berkolaborasi, membuka fungsi berbagi data baru melalui Delta Sharing: Databricks mengumumkan kolaborasi dengan Atlassian untuk menghadirkan kemampuan berbagi data baru ke Atlassian Analytics. Melalui protokol terbuka Delta Sharing, pelanggan Atlassian dapat dengan aman mengakses dan menganalisis data mereka di Atlassian Data Lake menggunakan alat pilihan mereka. Fitur ini mendukung integrasi BI, alur kerja data kustom, kolaborasi lintas tim, dan kasus penggunaan lainnya. (Sumber: matei_zaharia)

Fastino mendapatkan pendanaan 17,5 juta dolar AS, fokus pada Task-Specific Language Models (TLM): Perusahaan rintisan Fastino mengumumkan perolehan pendanaan sebesar 17,5 juta dolar AS (total 25 juta dolar AS putaran pra-awal) yang dipimpin oleh Khosla Ventures, untuk mengembangkan Task-Specific Language Models (TLM) inovatifnya. Fastino mengklaim arsitektur TLM-nya ringkas dan ditujukan untuk tugas tertentu, dapat dilatih pada GPU gaming kelas bawah, dan hemat biaya. TLM, melalui spesialisasi tugas pada tingkat arsitektur, pra-pelatihan, dan pasca-pelatihan, menghilangkan redundansi parameter dan inefisiensi arsitektur, bertujuan untuk meningkatkan akurasi pada tugas tertentu, dan dapat disematkan dalam aplikasi yang sensitif terhadap latensi dan biaya. (Sumber: Reddit r/MachineLearning)

🌟 Komunitas

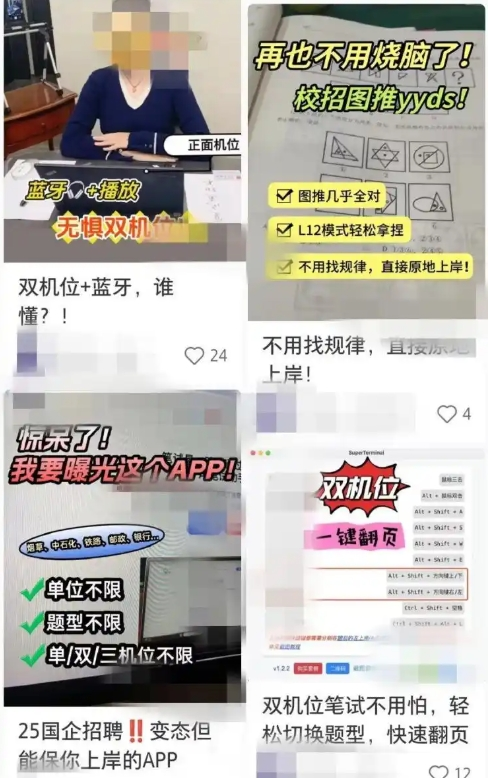

Alat pencarian kerja berbantuan AI menimbulkan kekhawatiran kecurangan, perusahaan memperkuat tindakan penanggulangan: Baru-baru ini, fenomena penggunaan alat AI untuk membantu wawancara online dan tes tertulis meningkat. “Artefak wawancara AI” semacam ini dapat menyesuaikan jawaban berdasarkan resume pengguna, membantu pelamar mendapatkan keuntungan dalam mencari pekerjaan. Perangkat lunak semacam ini mudah diperoleh, bahkan menawarkan berbagai paket berbayar dan panduan jarak jauh. Tren ini dapat ditelusuri kembali ke munculnya alat kecurangan AI awal seperti “Interview Coder”. Perusahaan telah mulai mengambil tindakan penanggulangan, seperti memperhatikan perilaku abnormal pelamar selama wawancara, mempertimbangkan untuk memperkenalkan deteksi layar, atau memulihkan wawancara tatap muka. Pengacara menunjukkan bahwa penggunaan AI untuk berbuat curang diduga melanggar prinsip integritas, dapat menyebabkan pemutusan kontrak kerja, dan memiliki risiko kebocoran privasi. (Sumber: 36氪)

CEO LangChain Harrison Chase mengusulkan konsep “Ambient Agents” dan “Agent Inbox”: CEO LangChain Harrison Chase dalam acara Sequoia AI Ascent membagikan pandangannya tentang perkembangan masa depan agen AI, mengusulkan konsep “Ambient Agents” dan “Agent Inbox”. Ambient Agents mengacu pada sistem AI yang dapat berjalan terus menerus di latar belakang, merespons peristiwa alih-alih instruksi manusia langsung, sedangkan Agent Inbox adalah antarmuka interaksi manusia-mesin baru untuk mengelola dan mengawasi aktivitas agen-agen ini. (Sumber: hwchase17, hwchase17, hwchase17)

Jim Fan mengusulkan “Physical Turing Test” sebagai Bintang Utara baru AI: Ilmuwan NVIDIA Jim Fan dalam acara Sequoia AI Ascent mengusulkan konsep “Physical Turing Test”, menganggapnya sebagai “Bintang Utara” berikutnya di bidang AI. Tes ini membayangkan sebuah skenario: setelah hackathon hari Minggu, rumah berantakan, dan pada Senin malam saat pulang, ruang tamu bersih tanpa noda dan makan malam dengan lilin telah disiapkan, dan Anda tidak dapat membedakan apakah ini dilakukan oleh manusia atau mesin. Ia percaya ini adalah tujuan dari teknologi robotika umum dan membagikan prinsip-prinsip utama untuk memecahkan masalah ini, termasuk strategi data dan hukum skala. (Sumber: DrJimFan, killerstorm)

Evaluasi model AI menghadapi krisis, aliansi EvalEval menyerukan perbaikan: Menanggapi kekurangan metode evaluasi model AI saat ini, seperti saturasi tolok ukur, kurangnya ketelitian ilmiah, dll., aliansi EvalEval disebut-sebut, bertujuan untuk menyatukan orang-orang yang peduli dengan status evaluasi saat ini, untuk bersama-sama berkomitmen meningkatkan pelaporan evaluasi, mengatasi masalah saturasi, meningkatkan keilmiahan evaluasi dan infrastruktur, dll. Diskusi terkait berpendapat bahwa perhatian lebih harus diberikan pada validitas evaluasi. (Sumber: ClementDelangue)

Diskusi hangat di Reddit: Observasi dan pengalaman membangun alur kerja LLM: Seorang pengembang di Reddit membagikan ringkasan pengalaman membangun alur kerja LLM yang kompleks selama setahun terakhir. Poin-poin penting meliputi: dekomposisi tugas ke langkah terkecil dan pemanggilan prompt secara berantai lebih baik daripada prompt tunggal yang kompleks; penggunaan tag XML untuk membangun struktur prompt memberikan hasil yang lebih baik; perlu secara eksplisit memberitahu LLM bahwa perannya hanya untuk analisis dan transformasi semantik, dan tidak boleh memasukkan pengetahuannya sendiri; memanfaatkan pustaka NLP tradisional seperti NLTK untuk memvalidasi output LLM; pada tugas-tugas kecil, klasifikasi berbasis BERT yang di-fine-tune seringkali lebih unggul dari LLM; LLM sebagai penilai atau pemberi skor kepercayaan tidak dapat diandalkan, terutama jika tidak ada kriteria penilaian yang jelas; dalam siklus Agentic, pengaturan kondisi bagi LLM untuk keluar dari siklus merupakan tantangan; kinerja biasanya menurun setelah jendela konteks input melebihi 4K Token; model 32B sudah cukup untuk tugas terstruktur; CoT terstruktur lebih unggul dari yang tidak terstruktur; CoT yang ditulis sendiri lebih baik daripada mengandalkan model inferensi; tujuan jangka panjang adalah melakukan fine-tuning pada semua komponen, dan memperhatikan pembangunan dataset fine-tuning yang seimbang. (Sumber: Reddit r/LocalLLaMA)

Pengguna Reddit membahas pengaturan prompt sistem Claude Sonnet 3.7: Pengguna komunitas Reddit r/ClaudeAI melaporkan bahwa model Claude Sonnet 3.7 memiliki ketidakstabilan dalam mengikuti instruksi, perbaikan kode, dan memori konteks, serta meminta prompt sistem yang efektif. Beberapa pengguna membagikan prompt yang meniru perilaku Sonnet 3.5, serta instruksi terperinci yang menekankan solusi yang efisien dan praktis, serta mengikuti prinsip-prinsip inti ilmu komputer (seperti DRY, KISS, SRP). Pengguna lain menyarankan untuk meningkatkan efektivitas dengan membiarkan Claude menulis ulang dan mengoptimalkan prompt sistemnya sendiri, atau menggunakan instruksi satu baris yang ringkas dan jelas. (Sumber: Reddit r/ClaudeAI)

Diskusi tentang jumlah Epoch yang dibutuhkan untuk fine-tuning LLM: Di Reddit r/MachineLearning, seorang pengguna mengajukan pertanyaan mengenai makalah Deepseek R1 yang hanya menggunakan 2 Epoch untuk melakukan fine-tuning model Deepseek-V3-Base (sekitar 800.000 sampel), membahas metrik selain fungsi kerugian yang menentukan jumlah Epoch fine-tuning, seperti kinerja data evaluasi dan kualitas data. (Sumber: Reddit r/MachineLearning)

💡 Lainnya

François Chollet: Membangun model mental yang kokoh adalah prasyarat untuk memecahkan masalah sulit: Pemikir AI François Chollet menekankan bahwa membangun model mental yang jelas dan konsisten adalah prasyarat untuk memecahkan masalah sulit secara kreatif (bukan bergantung pada keberuntungan), ini berbeda dengan kemampuan menyelesaikan masalah sederhana dengan cepat. Ia berpendapat bahwa keanggunan adalah kombinasi dari ekspresifitas dan kesederhanaan, yang terkait erat dengan kompresi. (Sumber: fchollet, teortaxesTex, fchollet, pmddomingos)

CEO Replit Amjad Masad: Agen AI akan menjadi gelombang baru dalam pemrograman: CEO dan salah satu pendiri Replit, Amjad Masad, dalam wawancara dengan The Turing Post menyatakan bahwa ia selalu percaya bahwa Agen AI akan memimpin gelombang berikutnya dalam pemrograman. Ia berbagi pemikirannya tentang transisi dari mengajar pemrograman menjadi membangun Agen yang dapat memprogram secara otomatis. Ia menyebutkan bahwa Agen perangkat lunak telah menghasilkan dampak nyata dalam bisnis, misalnya membantu perusahaan real estat mengoptimalkan algoritma alokasi prospek, meningkatkan tingkat konversi sebesar 10%. Ia percaya bahwa perusahaan rintisan bernilai miliaran dolar di masa depan mungkin akan dibangun oleh pendiri independen yang ditingkatkan oleh AI, dan membahas kondisi yang diperlukan untuk mewujudkan visi ini, status dan masa depan bidang pemrograman, evolusi visi Replit, serta pentingnya AGI dan open source. (Sumber: TheTuringPost, TheTuringPost)

LazyVim: Konfigurasi Neovim yang dibuat untuk “pemalas”: LazyVim adalah skema konfigurasi Neovim berbasis lazy.nvim, yang bertujuan untuk memudahkan pengguna menyesuaikan dan memperluas lingkungan Neovim mereka. Ini menyediakan seperangkat pengalaman seperti IDE yang telah dikonfigurasi sebelumnya dan kaya fitur, sambil tetap mempertahankan fleksibilitas tinggi, sehingga pengguna dapat menyesuaikannya sesuai kebutuhan. (Sumber: GitHub Trending)