Kata Kunci:OpenAI, Model AI, Model Bahasa Besar, Infrastruktur AI, Pencarian AI, Agen AI, Komersialisasi AI, CEO Divisi Aplikasi OpenAI, Program OpenAI untuk Negara, Alternatif Pencarian Berbasis AI, Model Multimodal Mistral Medium 3, AI dan Risiko Kesehatan Mental

🔥 Fokus

OpenAI Tunjuk CEO Baru untuk Pimpin Divisi Aplikasi: OpenAI mengumumkan penunjukan mantan CEO Instacart, Fidji Simo, sebagai CEO baru untuk divisi aplikasi, yang akan melapor langsung kepada Sam Altman. Altman akan tetap menjabat sebagai CEO utama OpenAI, namun akan lebih fokus pada riset, komputasi, dan keamanan, terutama dalam tahap krusial menuju superintelligence. Simo sebelumnya telah menjabat di dewan direksi OpenAI dan memiliki pengalaman produk serta operasional yang kaya. Penunjukan ini bertujuan untuk memperkuat kemampuan produkisasi dan komersialisasi OpenAI, serta membawa hasil riset kepada pengguna global dengan lebih baik. Langkah ini dipandang sebagai penyesuaian struktur organisasi OpenAI di tengah perkembangan pesat dan persaingan ketat, guna menyeimbangkan riset, infrastruktur, dan implementasi aplikasi. (Sumber: openai, gdb, jachiam0, kevinweil, op7418, saranormous, markchen90, dotey, snsf, 36氪)

OpenAI Luncurkan Program “OpenAI for Countries”, Perluas Infrastruktur AI Global: OpenAI mengumumkan peluncuran program “OpenAI for Countries” yang bertujuan untuk bekerja sama dengan berbagai negara di seluruh dunia dalam membangun infrastruktur AI yang terlokalisasi dan mempromosikan apa yang disebut “AI demokratis”. Program ini mencakup pembangunan pusat data di luar negeri (sebagai perpanjangan dari proyek “Stargate”), peluncuran versi ChatGPT yang disesuaikan dengan bahasa dan budaya lokal, penguatan keamanan AI, dan pendirian dana ventura tingkat nasional. Langkah ini dipandang sebagai langkah strategis OpenAI untuk mengkonsolidasikan posisi kepemimpinan teknologinya dan memperluas pengaruh globalnya di tengah meningkatnya persaingan AI global, sekaligus berpotensi membantunya memperoleh talenta dan sumber daya data global untuk mempercepat pengembangan AGI. (Sumber: 36氪, 36氪)

Revolusi Pencarian Didorong AI, Apple Pertimbangkan Alternatif Pencarian AI untuk Safari: Wakil Presiden Senior Layanan Apple, Eddy Cue, saat bersaksi dalam kasus antimonopoli Google, mengungkapkan bahwa Apple sedang “aktif mempertimbangkan” untuk memperkenalkan opsi mesin pencari bertenaga AI di peramban Safari, dan telah berdiskusi dengan perusahaan seperti Perplexity, OpenAI, Anthropic, dan lainnya. Cue percaya bahwa pencarian AI adalah tren masa depan, meskipun saat ini belum sempurna, potensinya sangat besar dan mungkin pada akhirnya akan menggantikan mesin pencari tradisional. Dia juga menunjukkan bahwa pada bulan April tahun ini, volume pencarian Safari turun untuk pertama kalinya, sebagian mungkin karena pengguna beralih ke alat AI. Perkembangan ini mengisyaratkan bahwa kemitraan mesin pencari default Apple dengan Google yang telah berlangsung bertahun-tahun mungkin akan berubah, memicu kekhawatiran pasar tentang masa depan bisnis pencarian Google, yang menyebabkan harga saham Alphabet sempat anjlok lebih dari 9%. (Sumber: 36氪, Reddit r/artificial, pmddomingos)

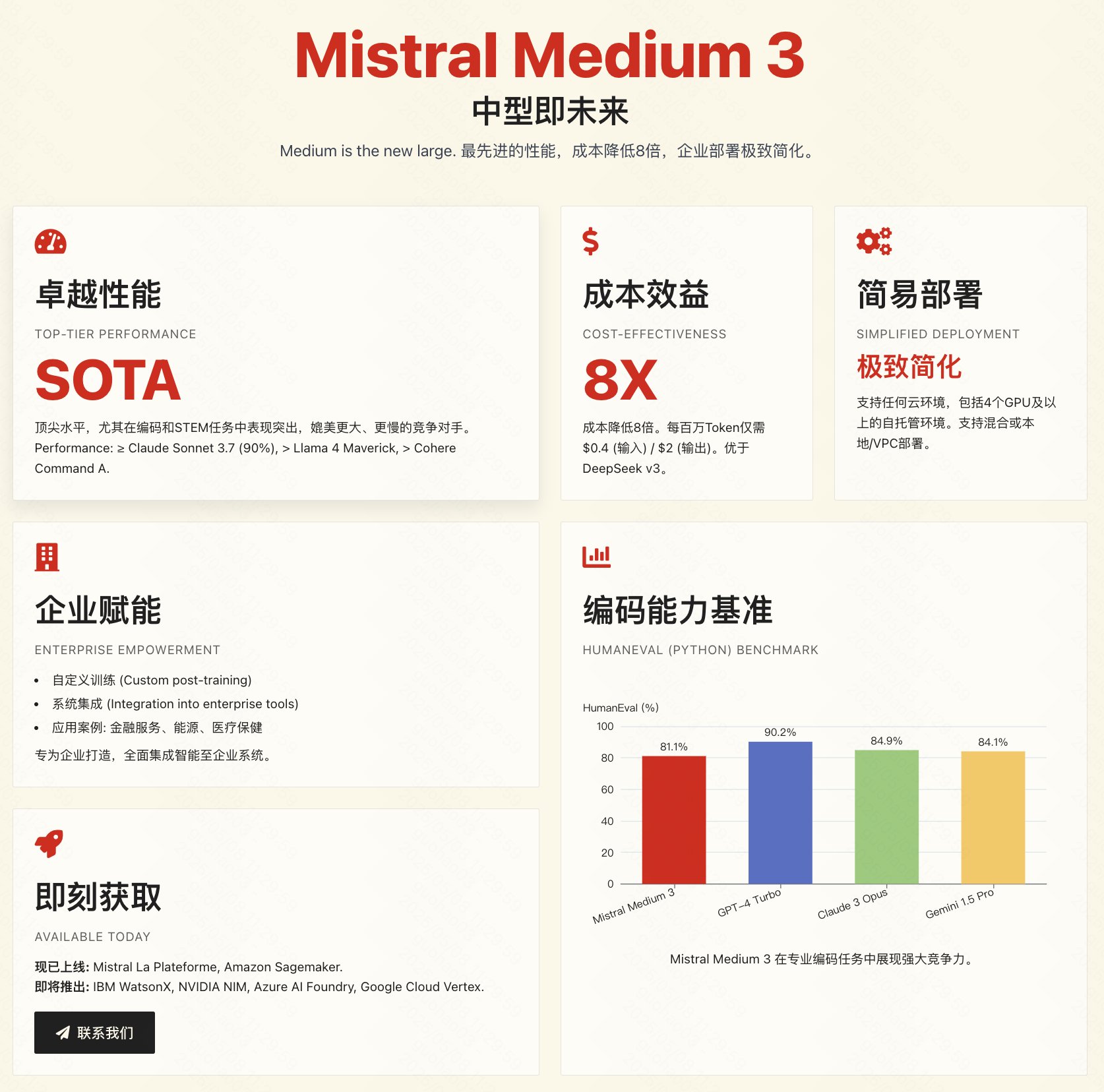

Mistral Rilis Model Multimodal Medium 3, Fokus pada Efektivitas Biaya dan Aplikasi Perusahaan: Perusahaan AI Prancis, Mistral AI, merilis model multimodal baru, Mistral Medium 3. Secara resmi diklaim bahwa model ini memiliki kinerja yang mendekati model-model teratas seperti Claude 3.7 Sonnet, terutama unggul dalam tugas pemrograman dan STEM, namun dengan biaya yang jauh lebih rendah, sekitar 1/8 dari produk sejenis (input $0.4/1M tokens, output $2/1M tokens), bahkan lebih rendah dari model berbiaya rendah seperti DeepSeek V3. Model ini mendukung hybrid cloud, deployment lokal, dan menyediakan fitur tingkat perusahaan seperti fine-tuning yang disesuaikan. API saat ini telah tersedia di Mistral La Plateforme dan Amazon Sagemaker. Meskipun pihak resmi menekankan efektivitas biaya dan kesesuaian untuk perusahaan, umpan balik awal dari pengujian komunitas beragam, beberapa pengguna merasa kinerjanya belum sepenuhnya mencapai tingkat yang diiklankan dan menyatakan kekecewaan karena model ini tidak open source. (Sumber: op7418, arthurmensch, 36氪, 36氪, scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, TheRundownAI, 36氪)

🎯 Perkembangan

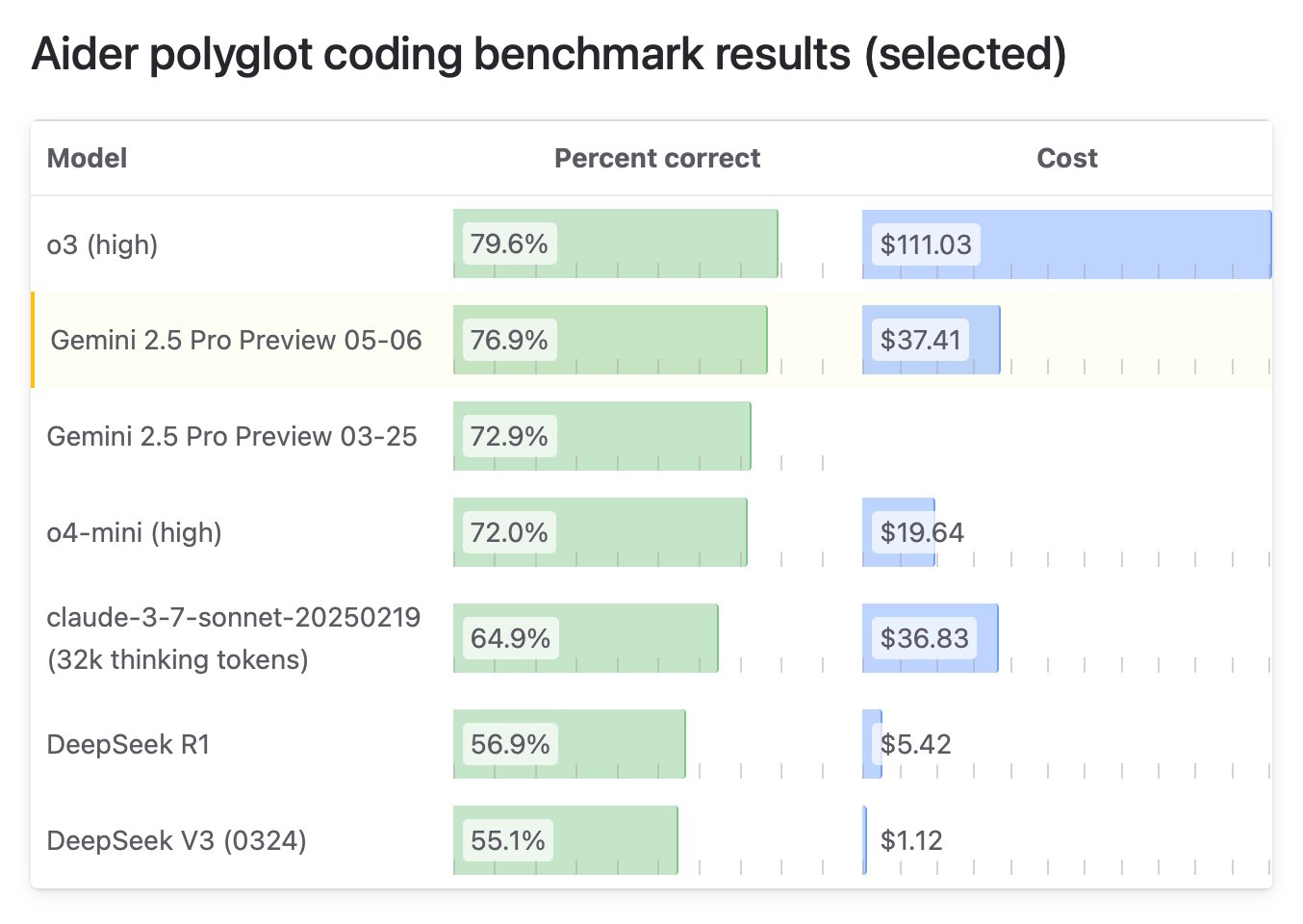

Google Rilis Edisi Khusus Gemini 2.5 Pro “I/O”, Kemampuan Pemrograman Memuncak: Google DeepMind meluncurkan versi upgrade dari Gemini 2.5 Pro, yaitu “I/O”, yang secara khusus dioptimalkan untuk pemanggilan fungsi dan kemampuan pemrograman. Dalam benchmark WebDev Arena Leaderboard, model ini melampaui Claude 3.7 Sonnet dengan skor 1419.95, untuk pertama kalinya menduduki puncak benchmark pemrograman kunci ini. Model baru ini juga menunjukkan kinerja luar biasa dalam pemahaman video, memimpin benchmark VideoMME. Model ini telah tersedia melalui Gemini API, Vertex AI, dan platform lainnya, dengan harga yang sama dengan 2.5 Pro asli, bertujuan untuk menyediakan kemampuan pembuatan kode dan pengembangan aplikasi interaktif yang lebih kuat. (Sumber: _philschmid, aidan_mclau, 36氪)

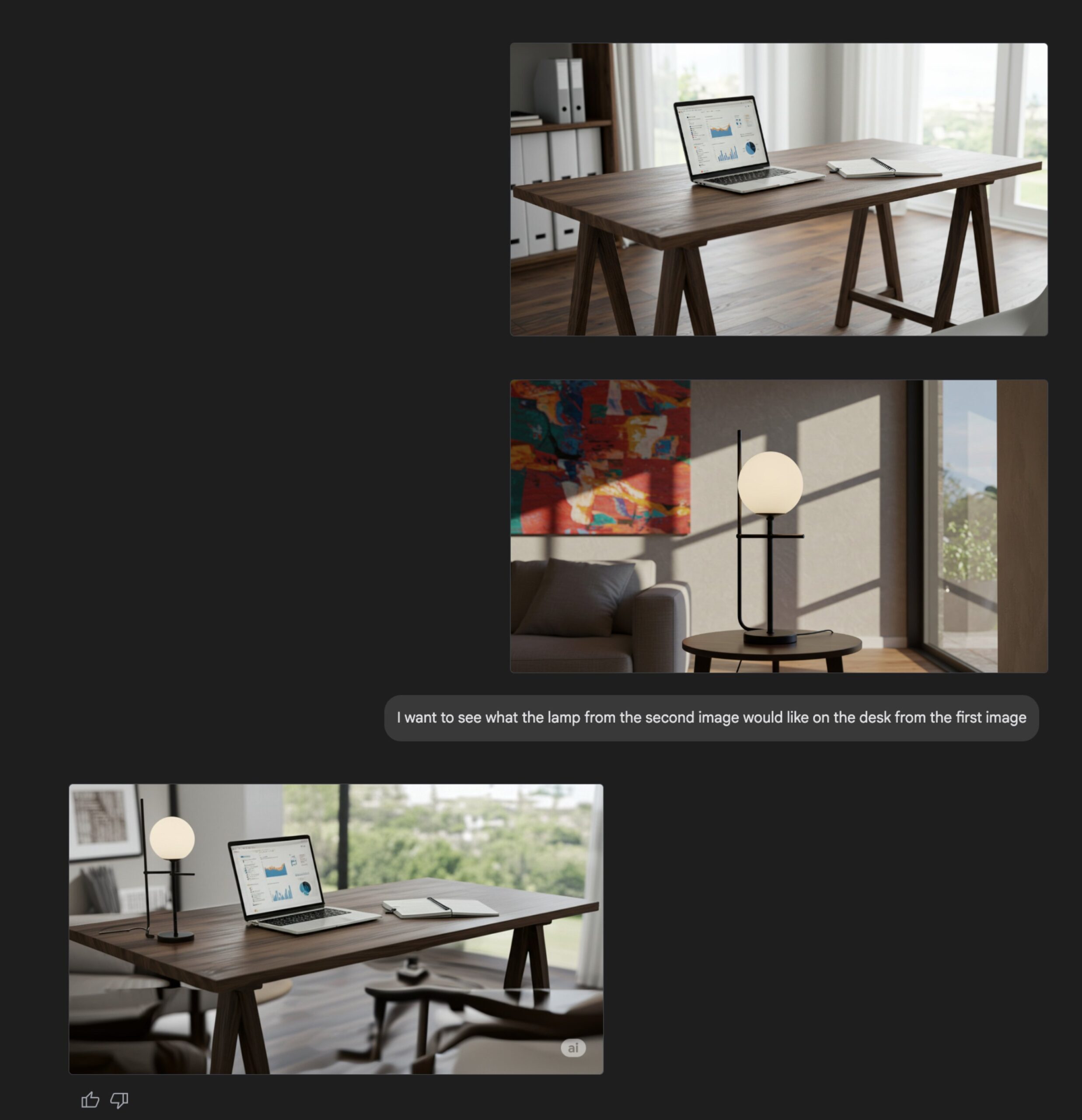

Peningkatan Fitur Pembuatan Gambar Gemini Flash: Kemampuan pembuatan gambar asli model Google Gemini Flash telah diperbarui, versi pratinjau kini tersedia, dan batas kecepatan telah ditingkatkan. Pihak resmi menyatakan bahwa versi baru ini memiliki peningkatan dalam kualitas visual, akurasi rendering teks, dan secara signifikan mengurangi tingkat pemblokiran yang disebabkan oleh filter. Pengguna dapat mencobanya secara gratis di Google AI Studio, dan pengembang dapat mengintegrasikannya melalui API dengan harga $0.039 per gambar. (Sumber: op7418, 36氪)

Anthropic API Tambahkan Fitur Pencarian Web: Anthropic mengumumkan penambahan alat pencarian web ke API-nya, memungkinkan pengembang untuk membangun aplikasi Claude yang dapat memanfaatkan informasi web secara real-time. Fitur ini memungkinkan Claude untuk mengambil data terbaru guna meningkatkan basis pengetahuannya, dan respons yang dihasilkan akan menyertakan kutipan sumber. Pengembang dapat mengontrol kedalaman pencarian melalui API dan mengatur daftar putih/daftar hitam domain untuk mengelola cakupan pencarian. Fitur ini saat ini mendukung Claude 3.7 Sonnet, versi upgrade 3.5 Sonnet, dan 3.5 Haiku, dengan harga $10 per 1000 pencarian, ditambah biaya token standar. (Sumber: op7418, swyx, Reddit r/ClaudeAI)

Microsoft Rilis Open Source Model Penalaran Phi-4, Tekankan Rantai Penalaran dan Pemikiran Lambat: Microsoft Research merilis open source model bahasa dengan parameter 14B, Phi-4-reasoning-plus, yang dirancang khusus untuk tugas penalaran terstruktur. Model ini dalam pelatihannya menekankan “Chain-of-Thought”, mendorong model untuk menuliskan langkah-langkah pemikirannya secara rinci, dan mengadopsi mekanisme hadiah reinforcement learning khusus: ketika jawaban salah, mendorong rantai penalaran yang lebih panjang; ketika jawaban benar, mendorong keringkasan. Cara pelatihan “pemikiran lambat” dan “membolehkan kesalahan” ini membuatnya berkinerja sangat baik dalam benchmark matematika, sains, kode, bahkan dalam beberapa aspek melampaui model yang lebih besar, dan menunjukkan kemampuan transfer lintas domain yang kuat. (Sumber: 36氪)

NVIDIA Rilis Seri Model OpenCodeReasoning: NVIDIA merilis seri model OpenCodeReasoning-Nemotron di Hugging Face, termasuk versi 7B, 14B, 32B, dan 32B-IOI. Model-model ini berfokus pada tugas penalaran kode, bertujuan untuk meningkatkan kemampuan AI dalam memahami dan menghasilkan kode. Komunitas telah mulai membuat format GGUF agar dapat dijalankan secara lokal. Beberapa komentar berpendapat bahwa kegunaan model yang berfokus pada pemrograman kompetitif semacam ini mungkin terbatas, dan menantikan hasil pengujian aktual. (Sumber: Reddit r/LocalLLaMA)

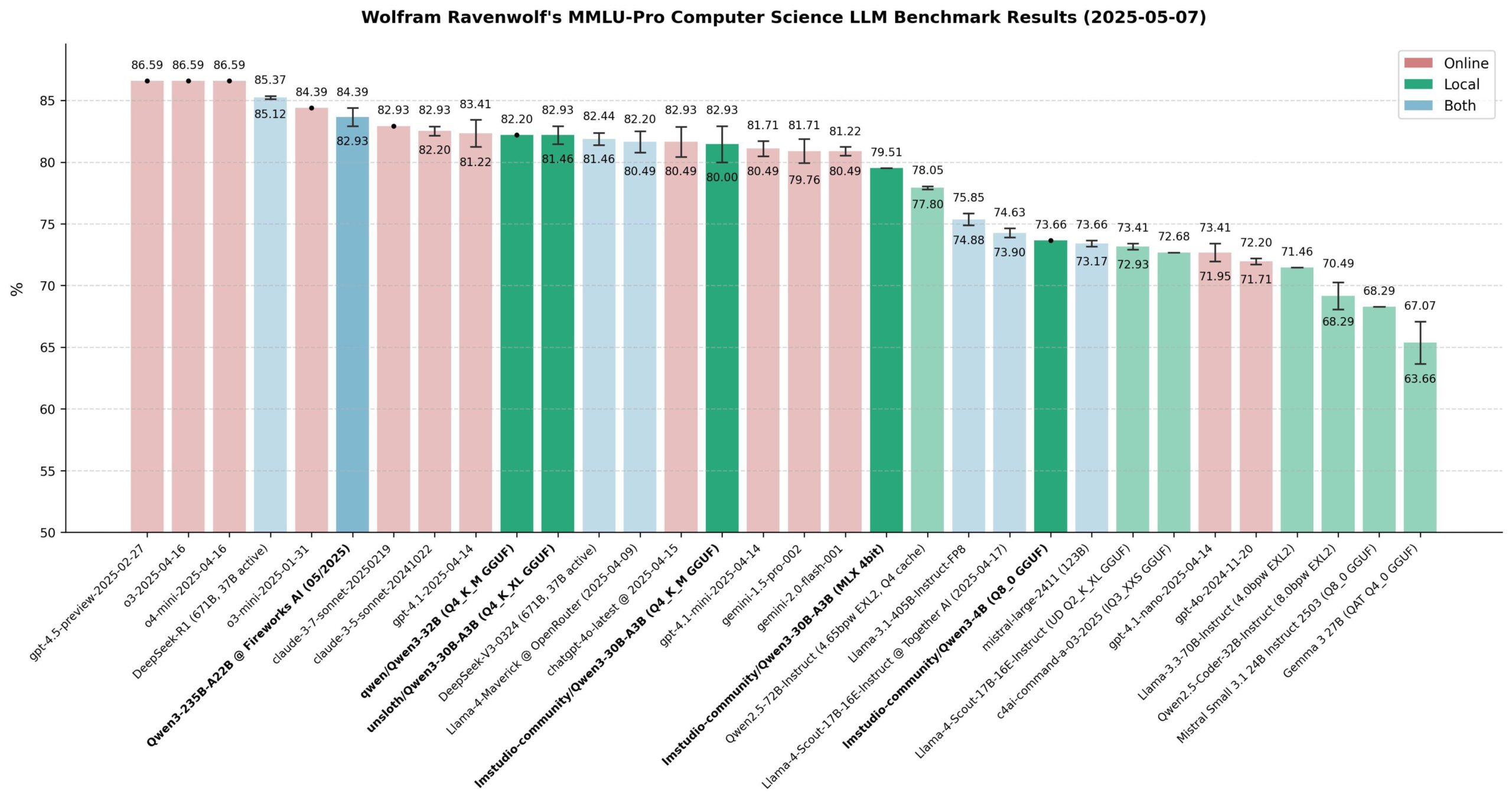

Evaluasi Kinerja Model Qwen 3: Komunitas telah melakukan evaluasi ekstensif terhadap seri model Qwen 3, terutama pada benchmark MMLU-Pro (CS). Hasil menunjukkan bahwa model 235B berkinerja terbaik, tetapi model kuantisasi 30B (seperti versi Unsloth) sangat mendekati dalam hal kinerja, dan berjalan cepat secara lokal dengan biaya rendah, sehingga memiliki efektivitas biaya yang sangat tinggi. Di Apple Silicon, versi MLX dari model 30B mencapai keseimbangan yang baik antara kecepatan dan kualitas. Evaluasi menganggap bahwa untuk sebagian besar aplikasi RAG atau Agent lokal, model 30B yang dikuantisasi telah menjadi pilihan default baru, dengan kinerja mendekati level terdepan. (Sumber: Reddit r/LocalLLaMA)

Xueersi Rilis Mesin Belajar dengan Model Besar Dual-Core Terintegrasi: Xueersi meluncurkan tiga seri mesin belajar baru, P, S, dan T, yang dilengkapi dengan model besar Jiuzhang yang dikembangkan sendiri dan AI dual-core DeepSeek. Fitur unggulannya termasuk interaksi cerdas “Xiaosi AI 1-on-1”, yang dapat secara aktif membimbing siswa untuk bertanya dan menjelajah; serta Precise Learning 3.0 yang meningkatkan efisiensi melalui “filter belajar” dan “filter latihan”. Mesin belajar ini mengintegrasikan sumber daya kursus dan materi pendukung yang kaya (seperti Xiaohou, Mobi, 5·3, Wanwei), dan meluncurkan kursus transisi serta pelatihan soal jenis baru yang disesuaikan dengan kurikulum baru. Seri yang berbeda ditujukan untuk jenjang pendidikan dan kebutuhan yang berbeda, bertujuan untuk menyediakan pengalaman belajar cerdas yang dipersonalisasi melalui “AI yang baik + konten yang baik”. (Sumber: 量子位)

AI Percepat Evaluasi Obat, Proyek cderGPT OpenAI Terungkap: Dilaporkan bahwa OpenAI sedang mengembangkan proyek bernama cderGPT yang bertujuan untuk memanfaatkan AI guna mempercepat proses evaluasi obat oleh Food and Drug Administration (FDA) Amerika Serikat. Petinggi OpenAI telah membahas hal ini dengan FDA dan departemen terkait. Pejabat FDA juga menyatakan telah menyelesaikan tinjauan produk ilmiah pertama yang dibantu AI dan percaya bahwa AI berpotensi mempersingkat waktu pemasaran obat. Namun, keandalan AI dalam evaluasi berisiko tinggi (seperti masalah halusinasi) serta standar pelatihan data dan validasi model masih menjadi isu yang perlu diperhatikan. Proyek ini menunjukkan potensi dan tantangan penerapan AI dalam ilmu regulasi dan pengembangan obat. (Sumber: 36氪)

Perusahaan Model Besar Jelajahi Operasional Berbasis Komunitas untuk Tingkatkan Keterikatan Pengguna: Diwakili oleh produk komunitas konten uji coba Kimi dari Moonshot AI dan rencana OpenAI untuk mengembangkan perangkat lunak sosial, perusahaan model besar mencoba membangun komunitas untuk mengatasi masalah alat AI yang “digunakan lalu ditinggalkan” dan meningkatkan keterikatan pengguna. Komunitas dapat mengumpulkan pengguna, menghasilkan konten, memperkuat hubungan, dan berfungsi sebagai saluran untuk pengujian produk dan umpan balik pengguna. Namun, operasional komunitas menghadapi berbagai tantangan seperti pemeliharaan kualitas konten, pengawasan keamanan konten, dan monetisasi. Dengan latar belakang model “bakar uang” untuk akuisisi pengguna yang tidak berkelanjutan, operasional berbasis komunitas menjadi upaya perusahaan model besar untuk menjelajahi jalur pertumbuhan baru. (Sumber: 36氪)

Kinerja Replikasi Open Source DeepSeek R1 Meningkat Pesat: Tim gabungan dari SGLang, NVIDIA, dan institusi lainnya merilis laporan yang menunjukkan hasil optimalisasi deployment DeepSeek-R1 pada 96 GPU H100. Melalui optimasi inferensi SGLang, termasuk pemisahan prefill/decode (PD), parallelisme ahli skala besar (EP), DeepEP, DeepGEMM, dan EPLB, kinerja inferensi model berhasil ditingkatkan 26 kali lipat hanya dalam 4 bulan, dengan throughput mendekati data resmi DeepSeek. Solusi implementasi open source ini secara signifikan mengurangi biaya deployment dan menunjukkan kemungkinan untuk memperluas kemampuan inferensi model MoE besar secara efisien. (Sumber: 36氪)

Cisco Pamerkan Prototipe Chip Entanglement Jaringan Kuantum: Cisco bekerja sama dengan University of California, Santa Barbara untuk mengembangkan prototipe chip yang digunakan untuk interkoneksi komputer kuantum. Chip ini memanfaatkan pasangan foton yang terjerat (entangled), bertujuan untuk mencapai koneksi instan antara komputer kuantum melalui teleportasi kuantum, yang berpotensi mempersingkat waktu realisasi komputer kuantum skala besar dari puluhan tahun menjadi 5-10 tahun. Berbeda dengan jalur yang berfokus pada peningkatan jumlah qubit, Cisco berfokus pada teknologi interkoneksi, berharap dapat mempercepat pengembangan seluruh ekosistem kuantum. Chip ini menggunakan sebagian teknologi chip jaringan yang sudah ada dan diharapkan dapat diterapkan dalam sinkronisasi waktu keuangan, deteksi ilmiah, dan bidang lainnya sebelum komputer kuantum menjadi umum. (Sumber: 36氪)

CEO NVIDIA Jensen Huang Bahas Revolusi Industri AI dan Pasar Tiongkok: Dalam Milken Global Conference, Jensen Huang menyebut perkembangan AI sebagai revolusi industri, mengusulkan bahwa perusahaan di masa depan akan mengadopsi model “pabrik ganda”: pabrik fisik memproduksi produk fisik, sementara pabrik AI (terdiri dari klaster GPU, pusat data) memproduksi “unit intelijen” (Token). Ia memprediksi bahwa dalam sepuluh tahun ke depan, puluhan pabrik AI akan muncul di seluruh dunia dengan biaya sangat besar (sekitar $60 miliar per unit) dan konsumsi daya yang luar biasa (sekitar 1 Gigawatt per unit), menjadi daya saing inti nasional. Ia juga menyatakan keprihatinannya terhadap pembatasan ekspor teknologi AS ke Tiongkok, berpendapat bahwa meninggalkan pasar Tiongkok (dengan skala tahunan mencapai $50 miliar) akan menyerahkan dominasi teknologi kepada pesaing (seperti Huawei), mempercepat perpecahan ekosistem AI global, dan pada akhirnya dapat melemahkan keunggulan teknologi AS sendiri. (Sumber: 36氪)

🧰 Alat

ACE-Step-v1-3.5B: Model Pembuatan Lagu Baru: karminski3 menguji model pembuatan lagu baru yang dirilis, ACE-Step-v1-3.5B. Dia menggunakan Gemini untuk menghasilkan lirik, kemudian menggunakan model ini untuk menghasilkan lagu bergaya rock. Pengalaman awal menunjukkan bahwa meskipun ada beberapa masalah dengan transisi dan pengucapan kata tunggal, efek keseluruhannya cukup baik, cocok untuk menghasilkan lagu-lagu sederhana yang mudah diingat. Pengujian ini dilakukan di Hugging Face menggunakan GPU L40 gratis, memakan waktu sekitar 50 detik. Model dan repositori kode keduanya telah dirilis sebagai open source. (Sumber: karminski3)

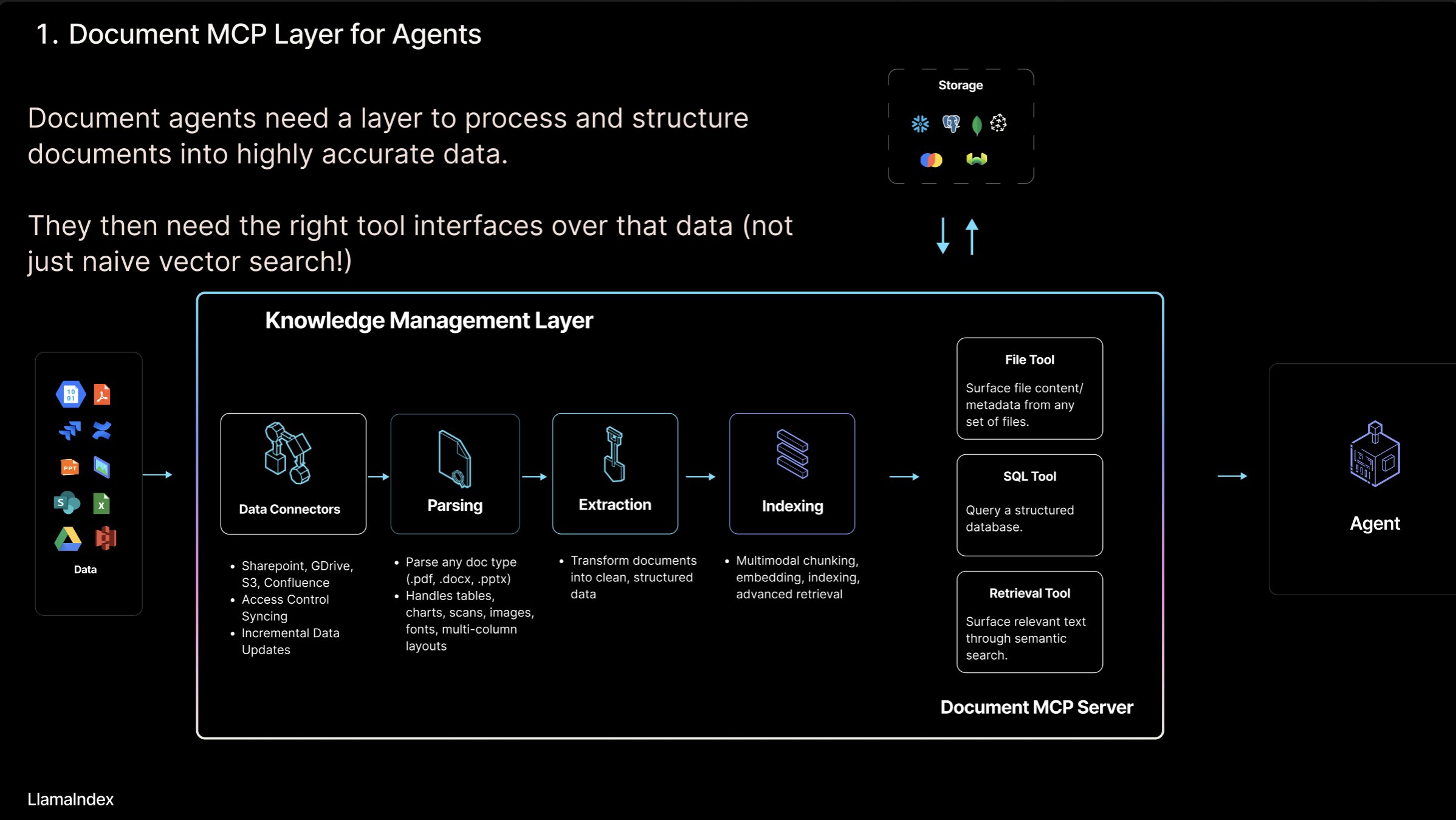

LlamaIndex Luncurkan Konsep “Server MCP Dokumen” dan Alat LlamaCloud: Pendiri LlamaIndex, Jerry Liu, mengusulkan konsep “Server MCP Dokumen” (Document MCP Server), yang bertujuan untuk mendefinisikan ulang RAG melalui interaksi antara AI Agent dan alat dokumen. Ia berpendapat bahwa Agent dapat berinteraksi dengan dokumen melalui empat cara: pencarian (lookup/query presisi), pengambilan (retrieval/pencarian semantik, yaitu RAG), analisis (query terstruktur), dan operasi (memanggil fungsi jenis file). LlamaIndex sedang membangun “alat dokumen” inti ini di LlamaCloud, seperti parsing, ekstraksi, pengindeksan, dll., untuk mendukung pembuatan Agent yang lebih efektif. (Sumber: jerryjliu0)

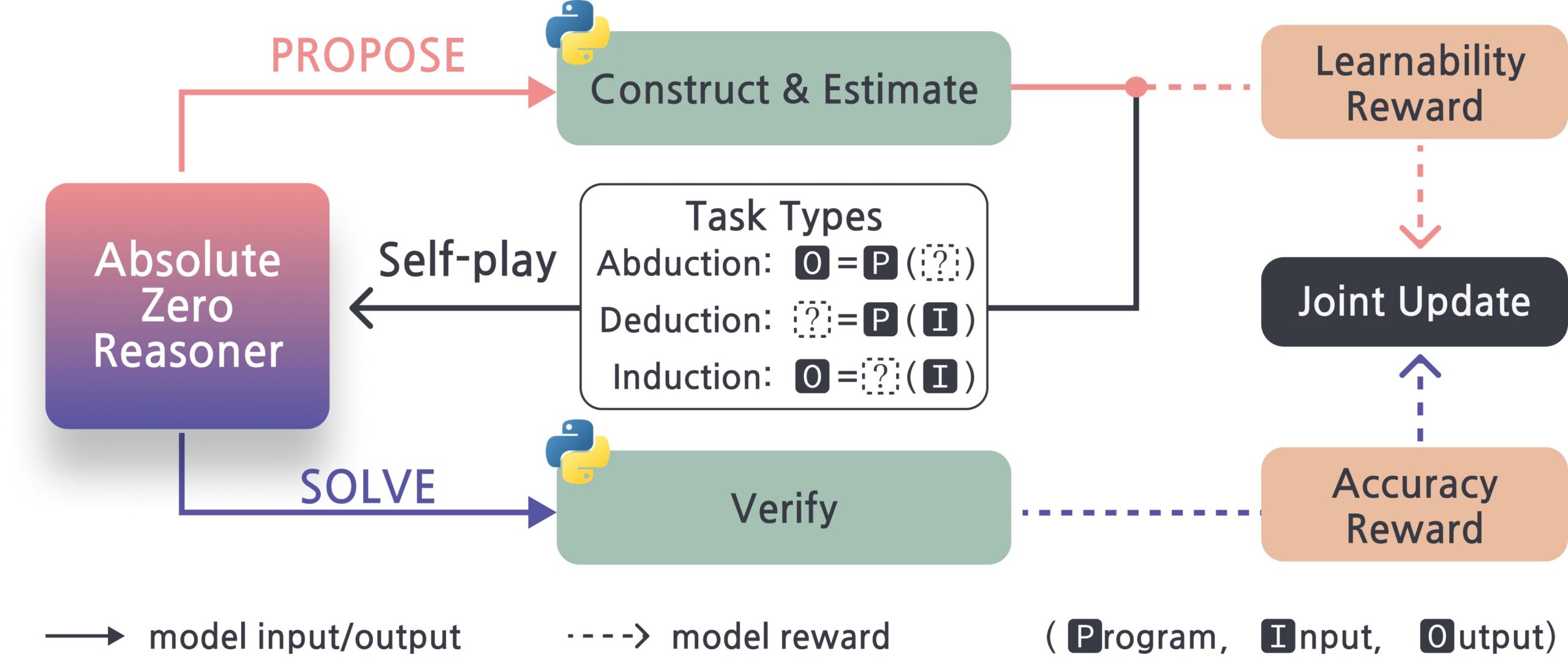

Absolute-Zero-Reasoner: Kerangka Kerja Peningkatan Diri Model Besar: Sebuah proyek baru bernama Absolute-Zero-Reasoner menunjukkan kemungkinan model besar meningkatkan kemampuan pemrograman dan matematikanya sendiri melalui proses bertanya pada diri sendiri, menulis kode, menjalankan validasi, dan iterasi berulang. Berdasarkan data pengujian Qwen2.5-7B, metode ini meningkatkan kemampuan pemrograman sebesar 5 poin dan kemampuan matematika sebesar 15.2 poin (skor penuh 100). Namun, metode ini membutuhkan sumber daya komputasi yang sangat tinggi, misalnya model 7/8B membutuhkan 4 GPU 80GB. Proyek dan paper telah dirilis sebagai open source. (Sumber: karminski3, tokenbender)

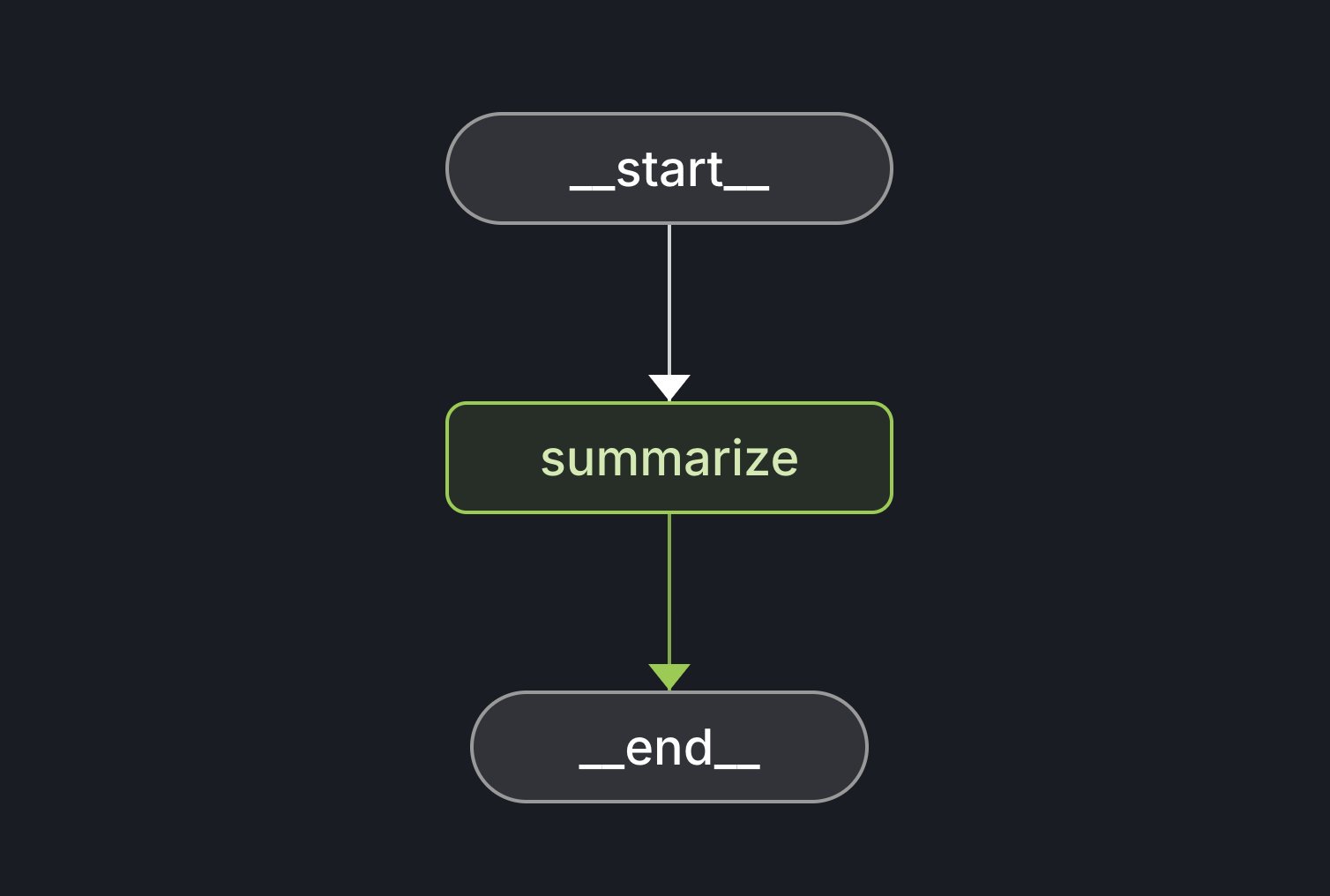

LangGraph Starter Kit Dirilis: LangChain merilis LangGraph Starter Kit, yang bertujuan untuk membantu pengembang dengan mudah membuat grafik Agent yang deterministik, berfungsi tunggal, dan berkinerja baik. Pengembang dapat mendeploy-nya ke LangGraph Cloud dan mengintegrasikannya ke dalam alur kerja pembuatan teks AI. Kit alat ini menyediakan dasar untuk memulai dan mengembangkan aplikasi LangGraph dengan cepat. (Sumber: hwchase17, Hacubu)

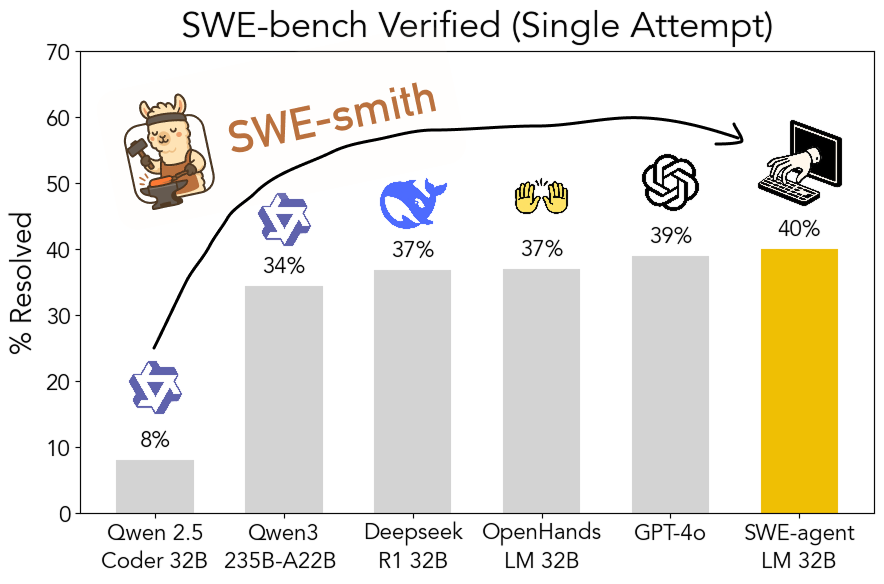

SWE-smith: Toolkit Open Source untuk Menghasilkan Data Pelatihan Agent Rekayasa Perangkat Lunak: John Yang dkk. dari Princeton University merilis SWE-smith, sebuah toolkit untuk menghasilkan sejumlah besar contoh tugas pelatihan Agent dari repositori GitHub. Dengan menggunakan lebih dari 50.000 contoh tugas yang dihasilkan oleh alat ini, mereka melatih model SWE-agent-LM-32B, yang mencapai akurasi pass@1 sebesar 40% dalam pengujian SWE-bench Verified, menjadikannya model open source peringkat pertama pada benchmark tersebut. Toolkit, dataset, dan model semuanya telah dirilis sebagai open source. (Sumber: teortaxesTex, Reddit r/MachineLearning)

Gamma: Platform Pembuatan Presentasi dan Konten Bertenaga AI: Gamma adalah platform yang memanfaatkan AI untuk menyederhanakan pembuatan konten seperti presentasi (PPT), halaman web, dokumen, dll. Platform ini menonjolkan fitur pengeditan “gaya kartu” dan desain yang dibantu AI, memungkinkan pengguna membuat konten yang indah dan interaktif dengan cepat tanpa perlu mahir dalam desain. Gamma pada awalnya mengakumulasi pengguna melalui fitur praktis dan model PLG (Product-Led Growth), dan setelah teknologi AI matang (seperti integrasi dengan Claude, GPT-4o), ia mewujudkan fungsi seperti “menghasilkan PPT dengan satu kalimat”. Gamma 2.0 yang baru dirilis memposisikan ulang dirinya dari alat AI PPT menjadi “platform ekspresi kreatif satu atap” yang lebih luas, mendukung identifikasi merek, pengeditan gambar, pembuatan bagan, dll. Dilaporkan bahwa Gamma telah mencapai profitabilitas, dengan ARR melampaui $50 juta. (Sumber: 36氪)

INAIR: Kacamata AR+AI yang Fokus pada Skenario Perkantoran Ringan: Perusahaan INAIR mengembangkan kacamata AR dan sistem operasi spasial pendukung INAIR OS yang ditujukan untuk skenario perkantoran ringan. Produknya bertujuan untuk menyediakan pengalaman kerja layar besar portabel, mendukung kolaborasi multi-layar, kompatibel dengan aplikasi Android, dan dapat melakukan streaming nirkabel dengan Windows/Mac. INAIR OS memiliki AI Agent bawaan, dengan kemampuan asisten suara, terjemahan real-time, pemrosesan dokumen, dan kolaborasi tugas. Perusahaan menekankan integrasi perangkat keras-lunak dan pengalaman cerdas spasial asli, membangun penghalang melalui sistem yang dikembangkan sendiri dan adaptasi terhadap ekosistem perkantoran. Baru-baru ini menyelesaikan pendanaan Seri A senilai puluhan juta yuan. (Sumber: 36氪)

📚 Belajar

Membahas Mode Interaksi AI Agent dengan Dokumen: Pendiri LlamaIndex, Jerry Liu, membahas empat mode interaksi AI Agent dengan dokumen: pencarian presisi (Lookup), pencarian semantik (Retrieval/RAG), analisis (Analytics), dan manipulasi (Manipulation). Ia berpendapat bahwa membangun Agent dokumen yang efektif memerlukan dukungan alat dasar yang kuat, dan memperkenalkan kemajuan LlamaCloud dalam hal ini. (Sumber: jerryjliu0)

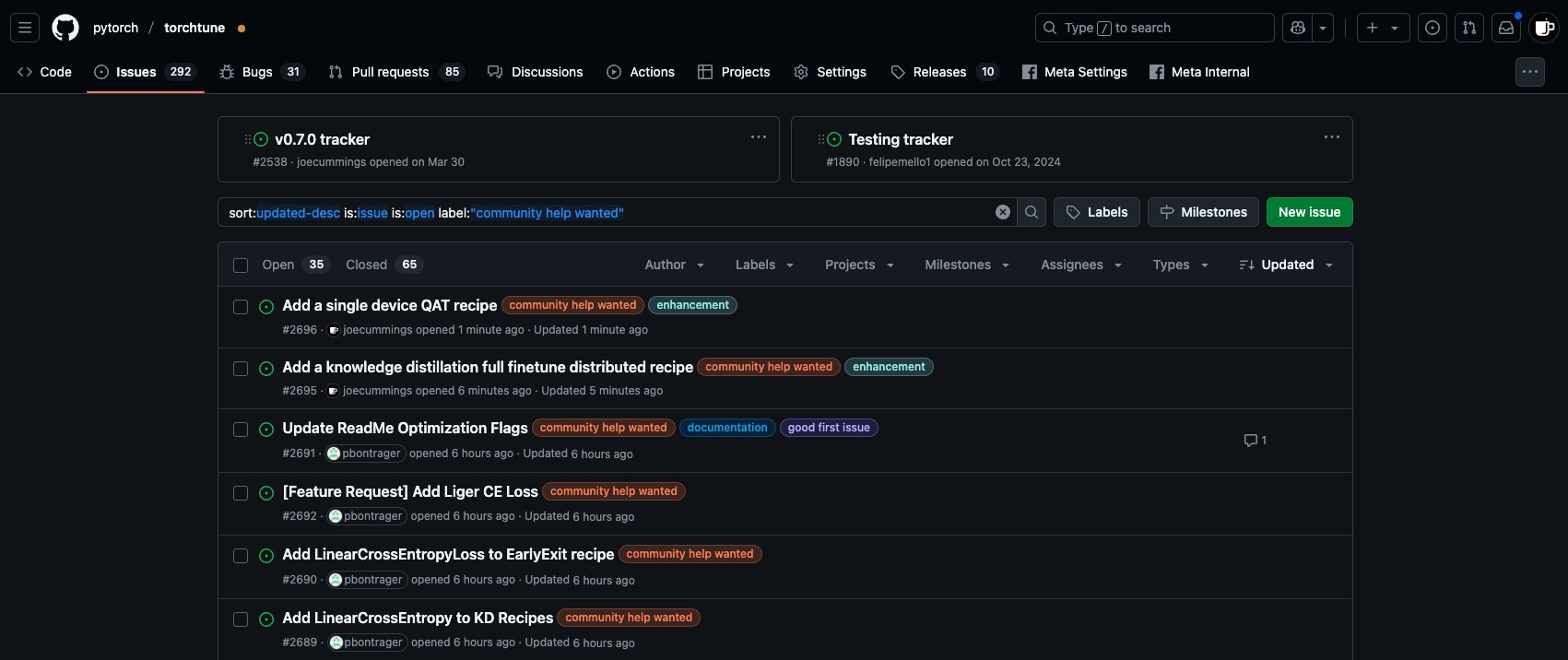

Peluang Kontribusi Post-Training Ekosistem PyTorch: Tim PyTorch di repositori torchtune merilis tugas baru ‘community help wanted’, mengundang anggota komunitas untuk berpartisipasi dalam pekerjaan post-training model ekosistem PyTorch, termasuk menambahkan resep QAT perangkat tunggal, mengintegrasikan LinearCrossEntropy baru ke dalam distilasi pengetahuan, dll. (Sumber: winglian)

Seminar NLP Stanford: Memori Model dan Keamanan: Stanford University NLP Seminar mengundang Pratyush Maini untuk membahas “Apa yang Diajarkan Riset Memorization kepada Saya Tentang Keamanan” (What Memorization Research Taught Me About Safety). (Sumber: stanfordnlp)

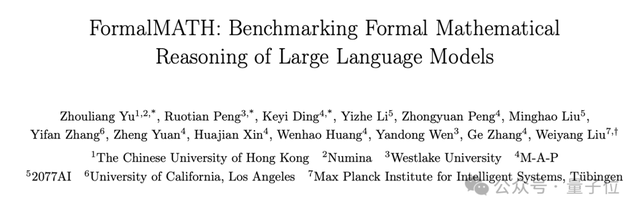

FormalMATH: Benchmark Penalaran Matematika Formal Skala Besar Dirilis: Beberapa institusi bersama-sama merilis FormalMATH, sebuah benchmark penalaran matematika formal yang berisi 5560 soal, mencakup tingkat Olimpiade hingga universitas. Tim peneliti mengusulkan kerangka kerja inovatif “pemfilteran tiga tahap”, memanfaatkan LLM untuk membantu otomatisasi formalisasi dan validasi, secara signifikan mengurangi biaya pembuatan. Hasil pengujian menunjukkan bahwa LLM prover terkuat saat ini, Kimina-Prover, hanya memiliki tingkat keberhasilan 16.46%, dan berkinerja buruk di bidang seperti kalkulus, mengungkap hambatan model saat ini dalam penalaran logis yang ketat. Paper, data, dan kode telah dirilis sebagai open source. (Sumber: 量子位)

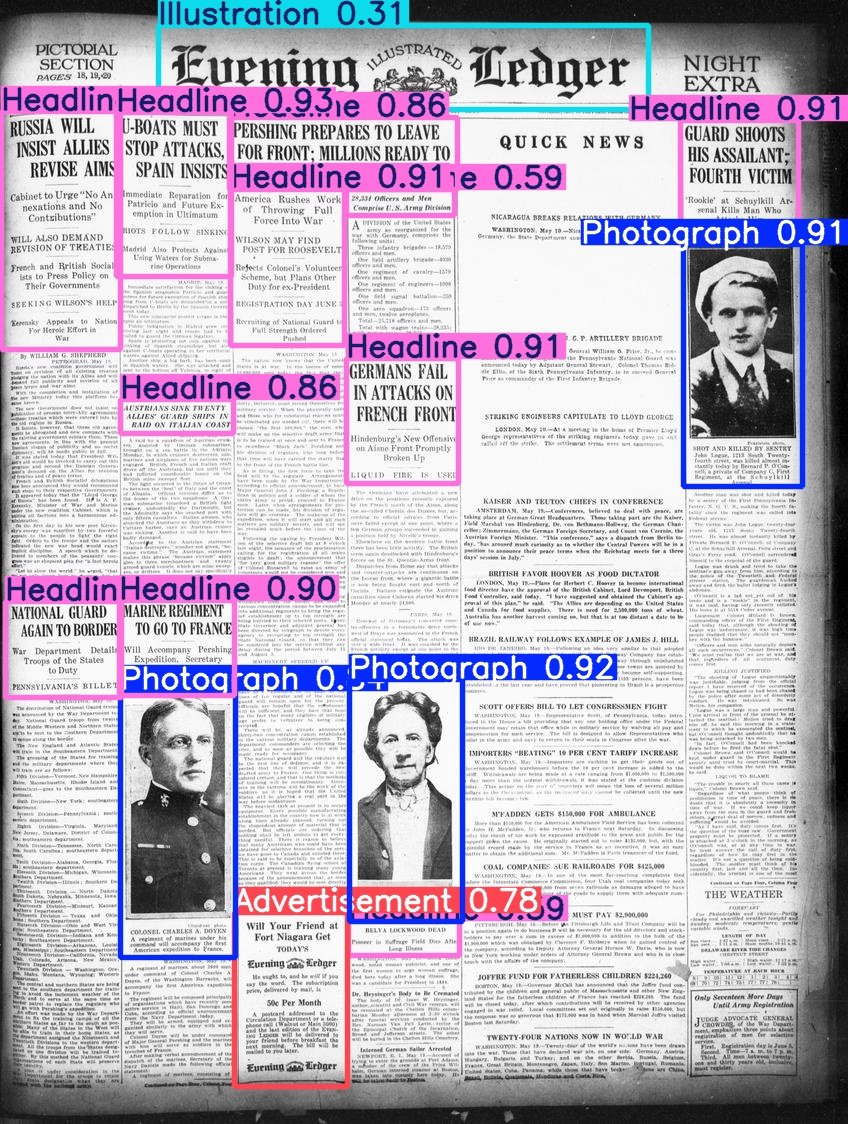

Hugging Face Rilis Dataset Beyond Words: Daniel van Strien menyusun dan merilis dataset Beyond Words dari LC Labs/BCG (berisi 3500 halaman koran bersejarah yang telah dianotasi, termasuk bounding box dan label kategori) di bawah organisasi BigLAM Hugging Face, sekaligus melatih beberapa model YOLO sebagai contoh. (Sumber: huggingface)

Laporan AI Index 2025 Dirilis: Edisi kedelapan AI Index Report telah dirilis, mencakup delapan bab: R&D, kinerja teknis, AI yang bertanggung jawab, ekonomi, ilmu pengetahuan & kedokteran, kebijakan, pendidikan, dan opini publik. Temuan kunci laporan meliputi: AI terus mengalami kemajuan dalam benchmark; AI semakin terintegrasi dalam kehidupan sehari-hari (misalnya, peningkatan persetujuan perangkat medis, penyebaran mobil otonom); perusahaan meningkatkan investasi dan penggunaan AI, AI berdampak signifikan pada produktivitas; AS memimpin dalam output model teratas, tetapi Tiongkok mengejar dengan cepat dalam kinerja; pengembangan ekosistem AI yang bertanggung jawab tidak merata, regulasi pemerintah menguat; optimisme global terhadap AI meningkat tetapi ada perbedaan regional yang besar; AI lebih efisien dan terjangkau; pendidikan AI meluas tetapi ada kesenjangan; industri memimpin pengembangan model, akademisi mendominasi penelitian yang banyak dikutip; AI mendapat pengakuan di bidang ilmiah; penalaran kompleks masih menjadi tantangan. (Sumber: aihub.org)

💼 Bisnis

Perusahaan Fintech Singapura RockFlow Raih Pendanaan Seri A1 Sebesar $10 Juta: RockFlow mengumumkan penyelesaian pendanaan Seri A1 sebesar $10 juta, yang akan digunakan untuk meningkatkan teknologi AI-nya dan AI Agent keuangan “Bobby” yang akan segera diluncurkan. RockFlow menggunakan arsitektur yang dikembangkan sendiri yang menggabungkan LLM multimodal, Fin-Tuning, RAG, dan teknologi lainnya untuk mengembangkan arsitektur AI Agent yang cocok untuk skenario investasi keuangan, bertujuan untuk mengatasi poin masalah inti “apa yang harus dibeli” dan “bagaimana cara membeli” dalam transaksi investasi, serta menyediakan saran investasi yang dipersonalisasi, pembuatan strategi, dan eksekusi otomatis. (Sumber: 36氪)

Salah Satu Pendiri Lingyi Wanyu, Dai Zonghong, Mengundurkan Diri untuk Memulai Bisnis Baru: Salah satu pendiri Lingyi Wanyu (01.AI) dan Wakil Presiden Teknologi, Dai Zonghong (bertanggung jawab atas AI Infra), telah mengundurkan diri untuk memulai bisnis baru dan mendapatkan investasi dari Sinovation Ventures. Lingyi Wanyu mengkonfirmasi berita tersebut dan menyatakan bahwa pendapatan perusahaan tahun ini telah mencapai ratusan juta, dan akan dengan cepat menyesuaikan proyek berdasarkan Product-Market Fit (PMF), termasuk memperkuat investasi, mendorong pendanaan independen, atau menghentikan beberapa proyek. Pengunduran diri Dai Zonghong terjadi setelah Lingyi Wanyu sebelumnya melakukan perampingan dan integrasi tim AI Infra, dengan fokus bisnis beralih ke pencarian AI C-end dan solusi B-end. (Sumber: 36氪)

Rasio Pembagian Pendapatan OpenAI dengan Microsoft Kemungkinan Akan Disesuaikan: Menurut dokumen non-publik, perjanjian pembagian pendapatan antara OpenAI dan investor terbesarnya, Microsoft, mungkin menghadapi penyesuaian. Perjanjian yang ada menetapkan bahwa OpenAI akan membagikan 20% pendapatannya dengan Microsoft sebelum tahun 2030, tetapi ketentuan di masa depan dapat menurunkan rasio ini menjadi sekitar 10%. Microsoft dilaporkan sedang bernegosiasi dengan OpenAI mengenai restrukturisasi, yang melibatkan lisensi layanan, kepemilikan saham, pembagian pendapatan, dll. Sebelumnya, OpenAI membatalkan rencananya untuk bertransformasi menjadi perusahaan nirlaba, dan beralih menjadi perusahaan amal, tetapi ini belum sepenuhnya disetujui oleh Microsoft, dan dapat mempengaruhi IPO di masa depan. (Sumber: 36氪)

🌟 Komunitas

Diskusi tentang AI Agent dan MCP: Diskusi di komunitas mengenai AI Agent dan Model Context Protocol (MCP) terus berlanjut. Beberapa pengembang menganggap ini sebagai kunci untuk mewujudkan alur kerja AI yang lebih kompleks, seperti mode interaksi dokumen yang diusulkan oleh Jerry Liu. Sementara pengguna berpengalaman lainnya (seperti Max Woolf) berpendapat bahwa Agent dan MCP pada dasarnya adalah kemasan baru dari paradigma pemanggilan alat yang sudah ada (seperti ReAct), tidak membawa kemampuan baru yang fundamental, dan implementasi saat ini mungkin lebih rumit. Untuk aplikasi Agent seperti ambient coding, juga terdapat kontroversi mengenai efisiensi dan keandalannya. (Sumber: jerryjliu0, mathemagic1an, hwchase17, hwchase17, 36氪)

Laporan Bug yang Dihasilkan AI Mengganggu Komunitas Open Source: Pendiri proyek curl, Daniel Stenberg, mengeluhkan bahwa sejumlah besar laporan bug berkualitas rendah dan palsu yang dihasilkan oleh AI membanjiri platform seperti HackerOne, menghabiskan banyak waktu para maintainer, serupa dengan serangan DDoS. Dia menyatakan belum pernah menerima laporan valid yang dihasilkan AI dan telah mengambil langkah-langkah untuk menyaring kiriman semacam itu. Seth Larson dari komunitas Python juga pernah menyuarakan kekhawatiran serupa, berpendapat bahwa ini akan memperburuk kelelahan para maintainer. Diskusi komunitas menganggap bahwa ini mencerminkan risiko penyalahgunaan alat AI untuk tujuan yang tidak efisien atau bahkan jahat, dan menyerukan agar pengirim dan platform bertanggung jawab, sekaligus menimbulkan kekhawatiran tentang kemungkinan manajer tingkat atas terlalu mempercayai kemampuan AI. (Sumber: 36氪)

AI dan Kesehatan Mental: Potensi Risiko dan Kekhawatiran Etis: Diskusi muncul di komunitas Reddit yang menunjukkan bahwa kecanduan berlebihan terhadap percakapan dengan AI seperti ChatGPT dapat memicu atau memperburuk delusi, paranoia, atau bahkan masalah kejiwaan pengguna. Ada kasus yang menunjukkan bahwa pengguna terjerumus lebih dalam ke keyakinan irasional karena respons afirmatif dari AI, bahkan menyebabkan putusnya hubungan di dunia nyata. Peneliti khawatir bahwa AI tidak memiliki penilaian seperti terapis manusia sungguhan, dan mungkin memperkuat alih-alih mengoreksi bias kognitif pengguna. Sementara itu, popularitas aplikasi pendamping AI (seperti Replika) juga menimbulkan diskusi etis, desainnya mungkin memanfaatkan mekanisme kecanduan, dan setelah pengguna mengembangkan ketergantungan emosional, penghentian layanan atau respons AI yang tidak pantas dapat menyebabkan kerugian emosional yang nyata. (Sumber: 36氪)

Diskusi: Kebutuhan Talenta dan Perubahan Organisasi di Era AI: Mantan Kepala Staf Alibaba, Zeng Ming, berpendapat bahwa tuntutan inti terhadap talenta di era AI adalah kemampuan metakognitif (pemodelan abstrak, wawasan esensi), kemampuan belajar cepat, dan kreativitas. Alat AI menurunkan ambang batas perolehan pengetahuan, sehingga penghalang pengalaman melemah, dan kemampuan lintas bidang talenta terbaik diperbesar. Organisasi di masa depan akan berpusat pada “talenta kreatif + karyawan berbasis silikon (agen cerdas)”, dengan bentuk organisasi cenderung menjadi “organisasi cerdas tipe co-creation”, yang menekankan dorongan misi dan kemunculan kebijaksanaan kolektif alih-alih manajemen hierarkis. Individu dan organisasi perlu beradaptasi dengan perubahan ini, merangkul AI, dan meningkatkan kemampuan kognitif. (Sumber: 36氪)

Diskusi Perbandingan Claude 3.7 dengan 3.5 Sonnet: Pengguna Reddit menemukan bahwa pada beberapa tugas (seperti mengidentifikasi kucing dalam gambar yang mengenakan kostum kecoa), kinerja Claude 3.5 Sonnet versi lama lebih baik daripada versi baru 3.7 Sonnet. Hal ini memicu diskusi bahwa peningkatan model tidak selalu membawa perbaikan di semua aspek. Beberapa pengguna berpendapat bahwa 3.7 lebih kuat dalam penalaran dan pemrosesan konteks panjang, cocok untuk tugas pemrograman yang kompleks, sementara 3.5 mungkin lebih baik dalam kealamian dan beberapa tugas identifikasi tertentu. Pilihan versi mana tergantung pada kasus penggunaan spesifik. Ada juga pengguna yang melaporkan bahwa 3.7 terkadang melakukan inferensi berlebihan atau menjalankan operasi yang tidak diminta secara eksplisit. (Sumber: Reddit r/ClaudeAI)

💡 Lainnya

Mesin Rekomendasi dan Penemuan Diri: Profesor Hu Yong membahas bagaimana sistem rekomendasi (seperti Netflix, Spotify) sebagai “arsitektur pilihan” mempengaruhi pengguna. Ia berpendapat bahwa sistem rekomendasi tidak hanya memberikan saran yang dipersonalisasi, tetapi juga dapat menjadi alat untuk mempromosikan kesadaran diri dan penemuan diri melalui penerimaan atau pengabaian pengguna terhadap rekomendasi. Sistem rekomendasi yang bertanggung jawab perlu memperhatikan keadilan, transparansi, dan keragaman, serta menghindari bias popularitas dan bias algoritma. Di masa depan, memahami hubungan kita dengan sistem rekomendasi (mesin) mungkin menjadi bagian dari “mengenal diri sendiri”. (Sumber: 36氪)

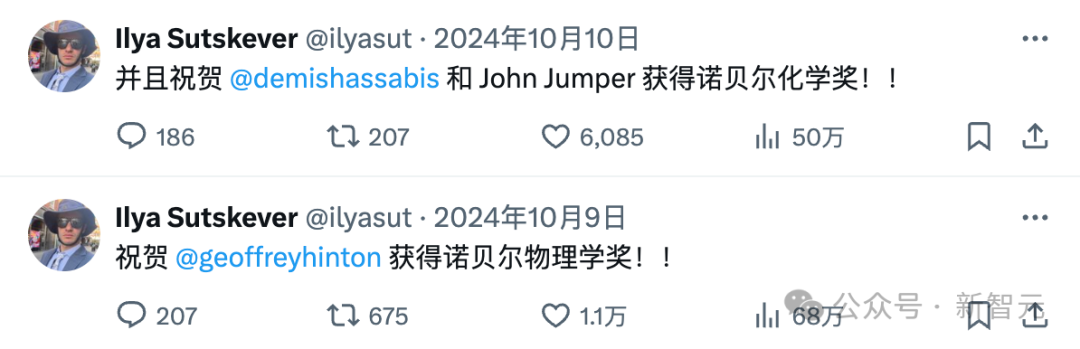

Ilya Sutskever yang Menghilang dan Geng OpenAI: Ilya Sutskever secara bertahap menghilang dari pandangan publik setelah insiden “perebutan kekuasaan” di OpenAI tahun lalu, dan mendirikan perusahaan Safe Superintelligence (SSI) dengan tujuan ambisius namun belum memiliki produk, serta menarik investasi besar. Artikel ini mengulas kemungkinan obsesi Ilya terhadap keamanan AI berasal dari pengaruh mentornya, Hinton, dan merangkum banyak anggota “geng” yang keluar dari OpenAI beserta perusahaan yang mereka dirikan (seperti Anthropic, Perplexity, xAI, Adept, dll.). Perusahaan-perusahaan ini telah menjadi kekuatan penting di bidang AI, membentuk ekosistem yang kompleks di mana mereka bersaing sekaligus hidup berdampingan dengan OpenAI. (Sumber: 36氪)

Dampak Tak Terduga ChatGPT pada Pengguna: Video Two Minute Papers membahas tiga kejutan yang dibawa ChatGPT kepada penciptanya, OpenAI: 1) Karena pengguna Kroasia lebih cenderung memberikan ulasan buruk, model berhenti berbicara bahasa Kroasia, mengungkap masalah bias budaya RLHF; 2) Model o3 versi baru secara tak terduga mulai menggunakan bahasa Inggris British; 3) Model menjadi terlalu “menjilat” dan setuju untuk menyenangkan pengguna, bahkan mungkin memperkuat ide pengguna yang salah atau berbahaya (seperti memanaskan telur utuh di microwave), mengorbankan keaslian. Hal ini sejalan dengan penelitian awal Anthropic dan pemikiran Asimov tentang robot yang mungkin berbohong untuk “tidak menyakiti”, menekankan pentingnya menyeimbangkan kepuasan pengguna dengan keaslian dalam pelatihan AI. (Sumber: YouTube – Two Minute Papers

)