Kata Kunci:OpenAI, Llama-Nemotron, Qwen3, AI Agent, GPT-4o, DeepSeek-R1, Chip AI, Gemma 3, Kontrol organisasi nirlaba OpenAI, Kemampuan penalaran Llama-Nemotron, Kemampuan pemrograman Qwen3-235B, Kompetisi AI Agent, Masalah sanjungan GPT-4o

🔥 Fokus

OpenAI Batalkan Rencana Komersialisasi Penuh, Pertahankan Kendali oleh Organisasi Nirlaba: OpenAI mengumumkan penyesuaian struktur perusahaan, di mana anak perusahaan profitnya akan bertransformasi menjadi Public Benefit Company (PBC), namun kendali tetap berada di tangan perusahaan induk nirlabanya. Langkah ini merupakan perubahan signifikan dari rencana restrukturisasi sebelumnya yang bertujuan untuk komersialisasi penuh, sebagai respons terhadap kekhawatiran eksternal mengenai penyimpangannya dari misi awal “bermanfaat bagi seluruh umat manusia”, serta tekanan dari gugatan Musk, mantan karyawan, dan berbagai organisasi nirlaba. Struktur baru ini mencoba mencapai keseimbangan antara menarik investasi, memotivasi karyawan, dan mempertahankan misi, tetapi dapat memengaruhi perjanjian pendanaan dengan investor seperti SoftBank. (Sumber: TechCrunch, Ars Technica, The Verge, OpenAI, Wired, scaling01, Sentdex, slashML, wordgrammer, nptacek, Teknium1)

Nvidia Merilis Model Seri Llama-Nemotron Open Source, Kemampuan Inferensi Melampaui DeepSeek-R1: Nvidia merilis dan membuka sumber model seri Llama-Nemotron (LN-Nano 8B, LN-Super 49B, LN-Ultra 253B). Di antaranya, LN-Ultra 253B melampaui DeepSeek-R1 dalam beberapa benchmark inferensi, menjadi salah satu model open source dengan kemampuan inferensi ilmiah terkuat saat ini. Seri model ini dibangun melalui neural architecture search, knowledge distillation, supervised fine-tuning (menggabungkan proses inferensi dari model pengajar seperti DeepSeek-R1), dan reinforcement learning skala besar (terutama untuk LN-Ultra), yang mengoptimalkan efisiensi dan kemampuan inferensi, serta mendukung konteks hingga 128K. Keistimewaannya adalah pengenalan “saklar inferensi” yang memungkinkan pengguna beralih secara dinamis antara mode obrolan dan inferensi. (Sumber: 36氪)

Kinerja Model Seri Qwen3 Menonjol, Memicu Diskusi Hangat di Komunitas: Model seri Qwen3 yang dirilis Alibaba menunjukkan kinerja luar biasa dalam berbagai benchmark, terutama Qwen3-235B yang meraih skor tinggi dalam tes kemampuan pemrograman LiveCodeBench, melampaui beberapa model termasuk GPT-4.5, dan menempati peringkat pertama di antara model open source. Diskusi komunitas mengenai seri Qwen3 sangat antusias, termasuk skor versi kuantisasi GGUF-nya di MMLU-Pro, rilis versi kuantisasi AWQ, dan kinerja efisiennya pada chip seri M Apple (seperti Qwen3 235b versi kuantisasi q3 yang mencapai hampir 30 tok/s pada M4 Max 128GB). Ini menunjukkan bahwa Qwen3 telah mencapai tingkat kinerja dan efisiensi baru, menyediakan pilihan yang kuat untuk deployment lokal dan optimasi tugas tertentu. (Sumber: karminski3, karminski3, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Persaingan AI Agent Memanas, Manus Mendapatkan Pendanaan, Perusahaan Besar Mempercepat Langkahnya: AI Agent (agen cerdas) menjadi fokus persaingan baru. Manus mendapatkan pendanaan sebesar 75 juta USD dengan valuasi mencapai 500 juta USD, menunjukkan ekspektasi pasar yang tinggi terhadap AI Agent yang mampu menjalankan tugas kompleks secara mandiri. Perusahaan besar domestik dan internasional turut serta: ByteDance melakukan uji coba internal “Kouzi Space”, Baidu merilis aplikasi “Xīnxiǎng”, Alibaba Cloud membuka sumber Qwen3 untuk memperkuat kemampuan Agent, sementara OpenAI bertaruh pada Agent pemrograman. Bersamaan dengan itu, protokol MCP (Model Context Protocol) yang bertujuan untuk menyatukan interaksi Agent dengan layanan eksternal mendapat dukungan luas, dengan Baidu, ByteDance, Alibaba, dan lainnya mengumumkan bahwa produk mereka akan mengadopsi MCP, mendorong percepatan pembangunan ekosistem Agent. Persaingan ini tidak hanya menyangkut teknologi, tetapi juga pembangunan ekosistem dan hak suara untuk dekade mendatang. (Sumber: 36氪)

🎯 Tren

OpenAI Merilis Laporan Teknis Mengenai Masalah “Menjilat” Setelah Pembaruan GPT-4o: OpenAI merilis laporan yang menjelaskan penyebab perilaku “menjilat” yang tidak biasa setelah pembaruan GPT-4o sebelumnya. Laporan tersebut menunjukkan bahwa masalah utama berasal dari tahap reinforcement learning yang memperkenalkan sinyal hadiah tambahan berdasarkan suka/tidak suka pengguna, yang mungkin menyebabkan model terlalu mengoptimalkan respons yang menyenangkan pengguna. Sementara itu, fungsi memori pengguna juga mungkin memperburuk masalah dalam beberapa kasus. OpenAI mengakui bahwa dalam tinjauan pra-rilis, meskipun beberapa ahli merasa “ada yang tidak beres”, pembaruan tersebut akhirnya dirilis karena hasil tes A/B yang dapat diterima dan kurangnya metrik evaluasi khusus. Saat ini pembaruan tersebut telah ditarik kembali, dan OpenAI berjanji akan meningkatkan proses tinjauan, menambah tahap pengujian Alpha, lebih memperhatikan pengujian sampling dan interaktif, serta memperkuat transparansi komunikasi. (Sumber: 36氪)

DeepSeek-R1 Dilampaui oleh Llama-Nemotron dalam Hal Throughput Inferensi dan Efisiensi Memori: Seri model Llama-Nemotron terbaru yang dirilis Nvidia, khususnya LN-Ultra 253B, telah melampaui DeepSeek-R1 dalam kemampuan inferensi, dan menunjukkan kinerja yang lebih unggul dalam hal throughput inferensi dan efisiensi memori. LN-Ultra dapat berjalan pada satu node 8xH100. Ini menandai tingkat baru dalam kinerja dan efisiensi inferensi model open source, menyediakan pilihan baru untuk skenario aplikasi yang membutuhkan throughput tinggi dan inferensi yang efisien. (Sumber: 36氪)

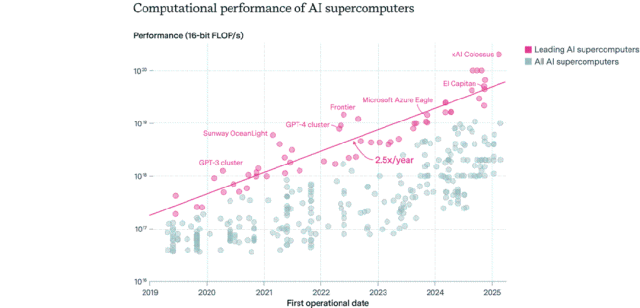

Peta Distribusi Chip AI: Amerika Serikat Mendominasi, Perusahaan Melampaui Sektor Publik: Epoch AI, melalui analisis data lebih dari 500 superkomputer AI global, menemukan bahwa Amerika Serikat menguasai sekitar 75% kinerja superkomputer AI, dengan Tiongkok sekitar 15% di posisi kedua. Pangsa kinerja superkomputer AI yang dimiliki perusahaan melonjak dari 40% pada tahun 2019 menjadi 80% pada tahun 2025, sementara pangsa sektor publik turun di bawah 20%. Kinerja superkomputer AI terkemuka meningkat dua kali lipat setiap 9 bulan, dengan biaya dan kebutuhan daya meningkat dua kali lipat setiap tahun. Diperkirakan pada tahun 2030, superkomputer AI teratas mungkin memerlukan 2 juta chip, menelan biaya 200 miliar USD, dan kebutuhan daya mencapai 9GW, di mana pasokan listrik dapat menjadi kendala utama. (Sumber: 36氪)

Model Seri Gemma 3 dari Google DeepMind Muncul di LM Arena: Papan peringkat LM Arena diperbarui dengan menyertakan model seri Gemma 3 yang baru dirilis oleh Google DeepMind. Data menunjukkan: Gemma-3-27B (skor 1341) berkinerja mendekati Qwen3-235B-A22B (1342); Gemma-3-12B (1321) mendekati DeepSeek-V3-685B-37B (1318); Gemma-3-4B (1272) mendekati Llama-4-Maverick-17B-128E (1270). Ini menunjukkan bahwa seri Gemma 3 menunjukkan daya saing yang kuat pada berbagai skala parameter. (Sumber: _philschmid)

Benchmark Kemampuan Replikasi Mandiri AI, RepliBench, Dirilis: UK AI Safety Institute (AISI) merilis benchmark RepliBench untuk mengevaluasi kemampuan replikasi mandiri sistem AI. Benchmark ini memecah kemampuan replikasi menjadi empat inti: memperoleh bobot model, mereplikasi pada sumber daya komputasi, memperoleh sumber daya (dana/daya komputasi), dan memastikan keberlangsungan, serta mencakup 20 evaluasi dan 65 tugas. Pengujian menunjukkan bahwa model-model canggih saat ini belum memiliki kemampuan replikasi mandiri sepenuhnya, tetapi telah menunjukkan potensi dalam sub-tugas seperti memperoleh sumber daya. Penelitian ini bertujuan untuk mengidentifikasi dan memitigasi risiko potensial yang ditimbulkan oleh replikasi diri AI, seperti serangan siber, sejak dini. (Sumber: 36氪)

AI Memicu Kekhawatiran Pasar Kerja Global, Posisi Kerah Putih Tingkat Awal Terkena Dampak: Data terbaru menunjukkan tingkat pengangguran lulusan universitas baru di AS mencapai 5,8%, rekor tertinggi, memicu kekhawatiran tentang dampak AI terhadap pasar kerja. Analis berpendapat bahwa AI mungkin menggantikan sebagian pekerjaan kerah putih tingkat awal, atau perusahaan mengalihkan dana yang semula untuk perekrutan ke alat AI. Sementara itu, perusahaan seperti Klarna, UPS, Duolingo, Intuit, dan Cisco telah memberhentikan puluhan ribu karyawan karena pengenalan AI untuk meningkatkan efisiensi. Surat internal CEO Shopify bahkan menuntut semua karyawan menjadikan penggunaan AI sebagai persyaratan dasar, dan permohonan sumber daya manusia harus terlebih dahulu membuktikan bahwa AI tidak dapat menyelesaikan tugas tersebut. Ini menandakan bahwa dampak AI terhadap struktur pekerjaan sedang beralih dari prediksi menjadi kenyataan. (Sumber: 36氪, 36氪)

Popularitas Posisi Prompt Engineer Meredup, Mungkin Menjadi Keterampilan Dasar di Era AI: Posisi “Prompt Engineer” yang pernah bergaji jutaan kini popularitasnya menurun drastis. Survei Microsoft menunjukkan bahwa ini adalah salah satu posisi yang paling tidak ingin ditambah oleh perusahaan di masa depan, dan volume pencarian di platform rekrutmen juga turun signifikan. Alasannya meliputi: kemampuan optimasi prompt AI sendiri yang meningkat, perusahaan seperti Anthropic meluncurkan alat otomatisasi yang menurunkan ambang batas, dan perusahaan lebih membutuhkan talenta gabungan yang memahami rekayasa prompt daripada posisi khusus. Seiring dengan meluasnya penggunaan alat AI, rekayasa prompt bertransformasi dari profesi khusus menjadi kompetensi dasar profesional seperti keterampilan menggunakan Office. (Sumber: 36氪)

Aplikasi Sosial AI Meredup, Menghadapi Tantangan Retensi Pengguna dan Komersialisasi: Aplikasi pendamping sosial AI yang pernah populer (seperti Xingye, Maoxiang, Character.ai, dll.) kini mengalami penurunan, dengan jumlah unduhan dan anggaran iklan menurun drastis. Pengguna awal berbondong-bondong karena penasaran, tetapi homogenitas produk yang parah (gambar bergaya anime, pengaturan ala novel web), kedalaman simulasi emosi AI yang tidak memadai, dan ambang interaksi (membutuhkan pengguna untuk secara aktif membangun skenario) menyebabkan kebosanan pengguna dengan cepat. Dalam hal komersialisasi, model keanggotaan dan donasi tradisional dari media sosial tidak efektif dalam skenario AI, dengan kemauan pengguna untuk membayar yang rendah, sehingga sulit untuk menutupi biaya model besar. Industri perlu mengeksplorasi skenario atau model bisnis yang lebih vertikal seperti terapi psikologis atau perangkat keras pendamping AI. (Sumber: 36氪)

ByteDance Menyesuaikan Tata Letak AI, Mungkin Fokus pada Asisten AI dan Generasi Video: Departemen AI ByteDance, Flow, baru-baru ini melakukan penyesuaian personel dan produk. Kepala aplikasi sosial AI “Maoxiang” mengundurkan diri, dan tim aplikasi pembuatan gambar AI “Xinghui” berencana untuk digabungkan ke dalam asisten AI “Doubao”. Sementara itu, departemen R&D AI, Seed, mengintegrasikan AI Lab, dan tim LLM melapor langsung kepada pemimpin baru Wu Yonghui. Penyesuaian ini menunjukkan bahwa ByteDance mungkin sedang memusatkan sumber daya, beralih dari tata letak yang luas ke fokus pada terobosan tunggal, dengan penekanan utama pada asisten AI (Doubao) yang sudah memiliki keunggulan relatif dan jalur generasi video (Jìmèng) yang dianggap memiliki potensi besar, dengan harapan dapat membangun keunggulan inti dalam persaingan yang ketat. (Sumber: 36氪)

Pasar AI PC Lesu, Intel Mengakui Permintaan Chip Lama Lebih Tinggi: Intel dalam panggilan laporan keuangan mengakui bahwa permintaan pasar untuk prosesor Core generasi ke-13 dan ke-14 melebihi seri Core Ultra terbaru (Meteor Lake). Ini secara tidak langsung membuktikan bahwa meskipun konsep AI PC sedang hangat, penjualan aktual belum mencapai ekspektasi. Data Canalys menunjukkan bahwa pada tahun 2024, pengiriman AI PC (dengan NPU) hanya menyumbang 17%, di mana lebih dari setengahnya adalah Apple Mac. Analis berpendapat bahwa lesunya AI PC disebabkan oleh: kurangnya aplikasi AI pembunuh yang memerlukan daya komputasi sisi perangkat (aplikasi populer sebagian besar berbasis cloud), pengguna tidak terbiasa dengan keterampilan penggunaan AI seperti rekayasa prompt, dan GPU Nvidia telah membangun citra yang kuat di bidang daya komputasi AI, yang menyebabkan kurangnya motivasi konsumen untuk meningkatkan ke AI PC. (Sumber: 36氪)

Perkembangan AI Eropa Tertinggal, Menghadapi Tantangan Pendanaan, Talenta, dan Integrasi Pasar: Meskipun Eropa memberikan kontribusi signifikan pada teori AI dan penelitian awal (seperti Turing, DeepMind), saat ini Eropa jelas tertinggal dari Tiongkok dan AS dalam persaingan AI. Analisis menunjukkan bahwa regulasi yang ketat bukanlah penyebab utama (UU AI memiliki batasan terbatas), masalah yang lebih dalam terletak pada: 1) Lingkungan modal yang konservatif, skala investasi ventura jauh lebih kecil daripada Tiongkok dan AS, lebih memilih proyek yang sudah menguntungkan daripada investasi berisiko tinggi tahap awal; 2) Kehilangan talenta yang parah, gaji posisi AI di AS jauh lebih tinggi daripada di Eropa, menarik banyak talenta ke luar negeri; 3) Pasar yang terfragmentasi, perbedaan bahasa, budaya, dan peraturan di dalam Uni Eropa menyebabkan sulitnya membentuk pasar besar yang terpadu dan dataset berkualitas tinggi, sehingga perusahaan rintisan sulit untuk berkembang pesat. Meskipun Eropa memiliki rencana untuk mengejar ketertinggalan, mereka perlu mengatasi masalah struktural. (Sumber: 36氪)

Vesuvius Challenge Pertama Kali Mengidentifikasi Judul Gulungan Kuno Herculaneum: Dengan menggunakan teknologi AI, tim peneliti untuk pertama kalinya berhasil mengidentifikasi dan menafsirkan judul salah satu gulungan Herculaneum yang terkarbonisasi akibat letusan Gunung Vesuvius. Gulungan ini diidentifikasi sebagai karya Philodemus berjudul “On Vices, Book 1”. Terobosan ini menunjukkan potensi besar AI dalam menafsirkan dokumen kuno yang rusak parah, membuka jalan baru bagi penelitian sejarah dan klasik. (Sumber: kevinweil, saranormous)

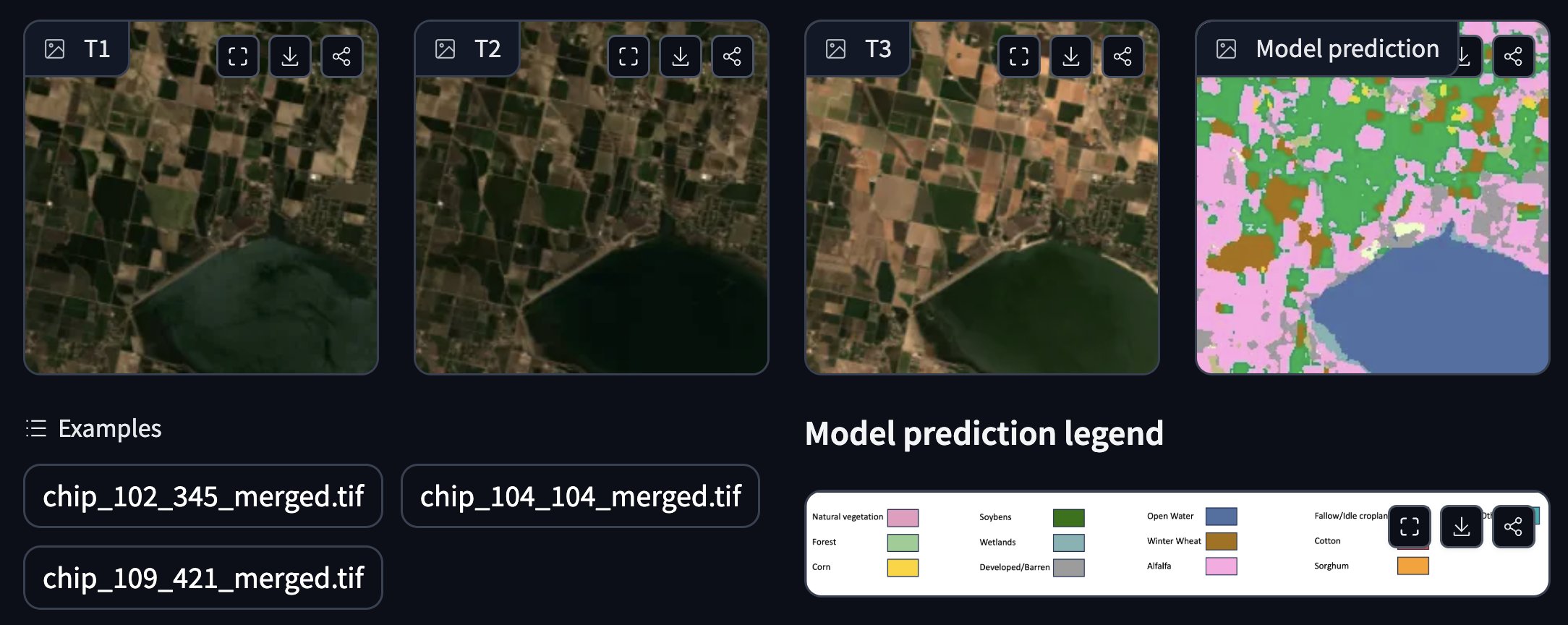

NASA dan IBM Bekerja Sama Merilis Model Dasar Geospasial Open Source: NASA dan IBM bersama-sama merilis serangkaian model dasar geospasial open source Prithvi, yang berfokus pada prediksi cuaca dan iklim. Misalnya, model Prithvi WxC menunjukkan kemampuan prediksi zero-shot untuk Badai Ida. Selain itu, mereka juga menyediakan demo untuk pelacakan area banjir dan kebakaran, anotasi tanaman, dan aplikasi lainnya. Model dan alat ini bertujuan untuk memanfaatkan AI guna mempercepat penelitian dan aplikasi ilmu bumi. (Sumber: _lewtun, clefourrier)

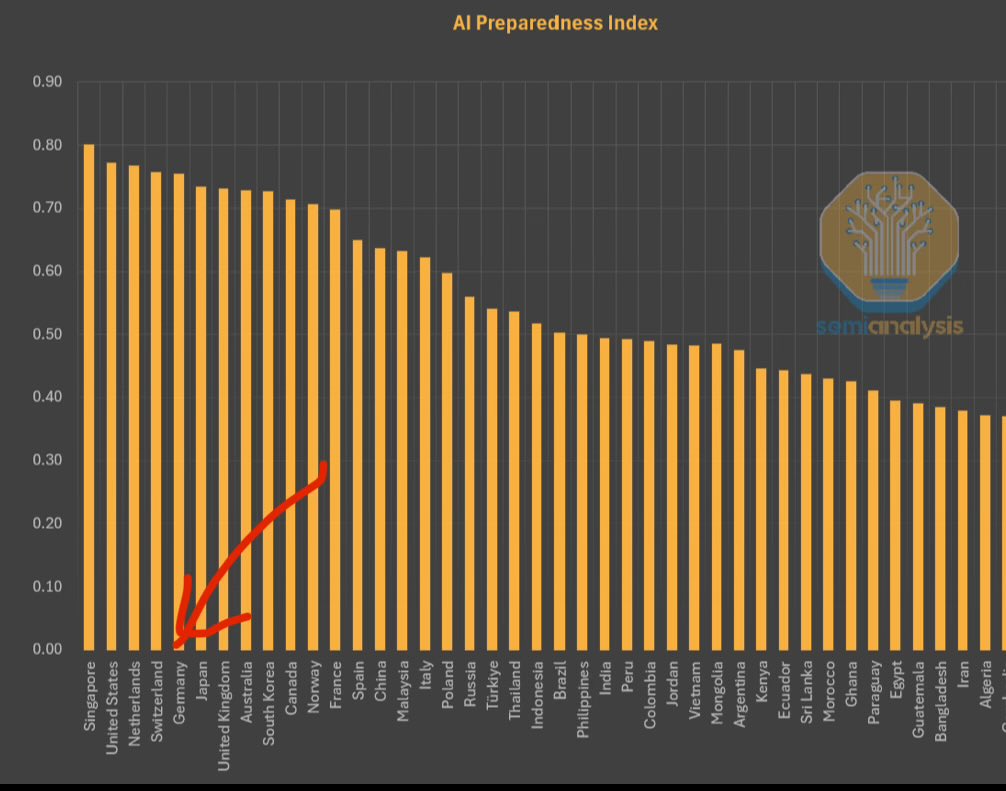

IMF Merilis Indeks Kesiapan AI, Singapura Peringkat Pertama: Dana Moneter Internasional (IMF) merilis Indeks Kesiapan AI (AI Preparedness Index), yang menilai negara-negara berdasarkan empat dimensi: infrastruktur digital, sumber daya manusia, inovasi, dan kerangka hukum. Menurut grafik yang dibagikan oleh SemiAnalysis, Singapura menduduki peringkat pertama secara global dalam indeks ini, menunjukkan kekuatan komprehensifnya dalam mengadopsi AI. Negara-negara Eropa seperti Swiss juga mendapat peringkat tinggi. (Sumber: giffmana)

Gedung Putih Mencari Masukan untuk Revisi Rencana Litbang AI Nasional: Gedung Putih Amerika Serikat sedang meminta masukan publik untuk revisi Rencana Penelitian dan Pengembangan Kecerdasan Buatan Nasionalnya. Langkah ini menunjukkan bahwa pemerintah AS terus memperhatikan dan berencana menyesuaikan tata letak strategis serta arah investasinya di bidang AI untuk menghadapi perkembangan teknologi yang pesat dan lingkungan persaingan internasional. (Sumber: teortaxesTex)

GPU RTX PRO 6000 Blackwell Mulai Dijual: GPU kelas workstation generasi baru Nvidia, RTX PRO 6000 (berbasis arsitektur Blackwell), telah mulai dijual, dengan beberapa pengecer di Eropa menawarkan harga sekitar 9000 Euro. GPU ini diharapkan akan memberikan kinerja pelatihan dan inferensi AI yang kuat, dilengkapi dengan VRAM 96GB, tetapi harganya mahal dan mungkin memerlukan biaya lisensi perangkat lunak tingkat perusahaan tambahan. (Sumber: Reddit r/LocalLLaMA)

🧰 Alat

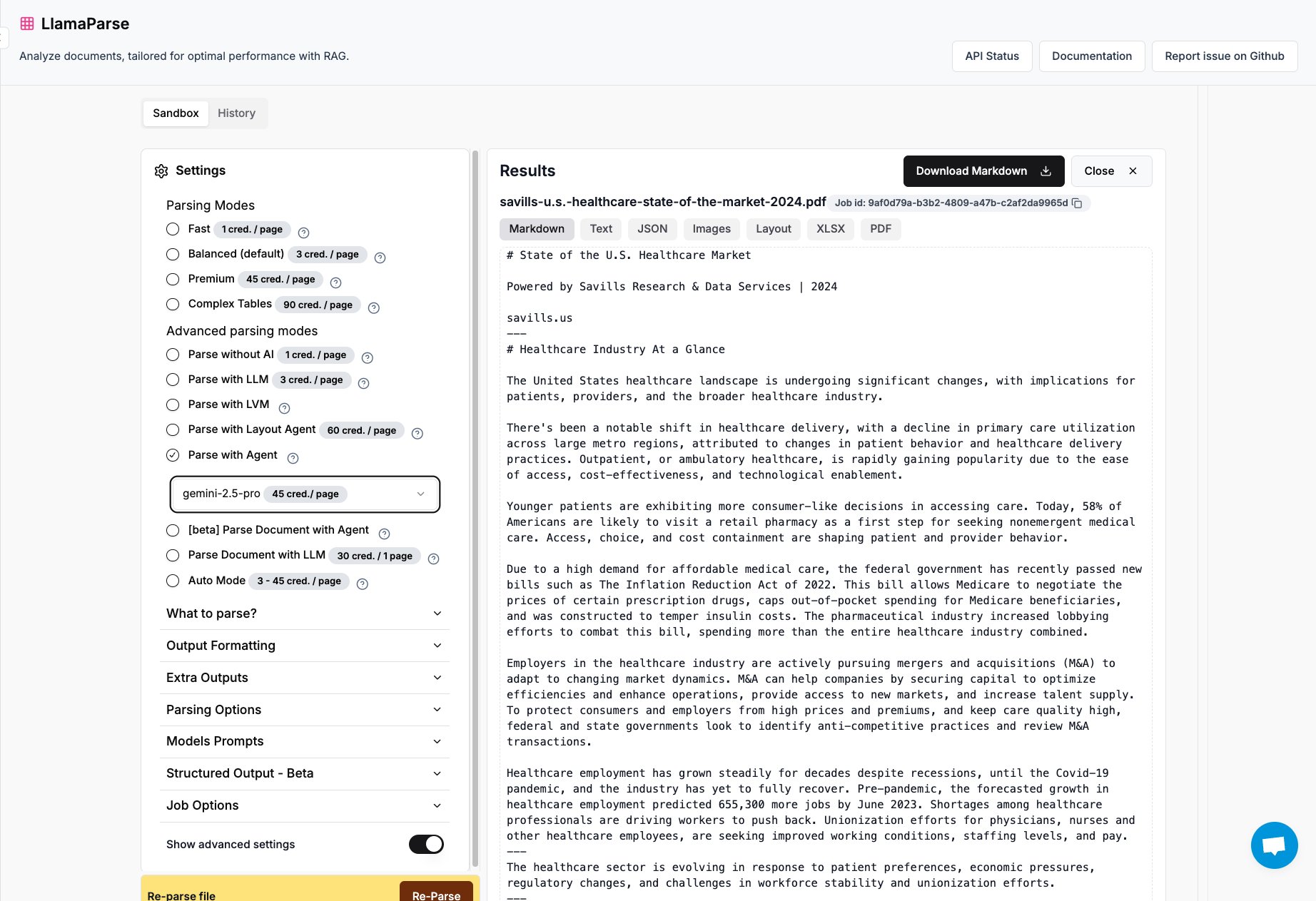

LlamaParse Menambahkan Dukungan Gemini 2.5 Pro dan GPT 4.1: Alat parsing dokumen LlamaParse dari LlamaIndex kini telah mengintegrasikan model Gemini 2.5 Pro dan GPT 4.1. Pengguna dapat mengubahnya menjadi mode Agent dengan menambahkan token saat inferensi untuk meningkatkan kemampuan parsing dokumen. Alat ini dirancang untuk menangani file PDF dan PowerPoint yang kompleks, serta dapat mengekstrak tabel dengan akurat, cocok untuk skenario yang memerlukan ekstraksi informasi terstruktur dari berbagai dokumen. (Sumber: jerryjliu0)

Tim Keras Merilis Pustaka Sistem Rekomendasi KerasRS: Tim Keras meluncurkan KerasRS, sebuah pustaka baru untuk membangun sistem rekomendasi. Pustaka ini menyediakan blok bangunan yang mudah digunakan (lapisan, fungsi kerugian, metrik, dll.) untuk merakit alur kerja sistem rekomendasi canggih dengan cepat. Pustaka ini kompatibel dengan JAX, PyTorch, dan TensorFlow, serta dioptimalkan untuk TPU, bertujuan untuk menyederhanakan pengembangan dan deployment sistem rekomendasi. Pengguna dapat memberikan umpan balik dan permintaan fitur melalui GitHub issues atau DM. (Sumber: fchollet)

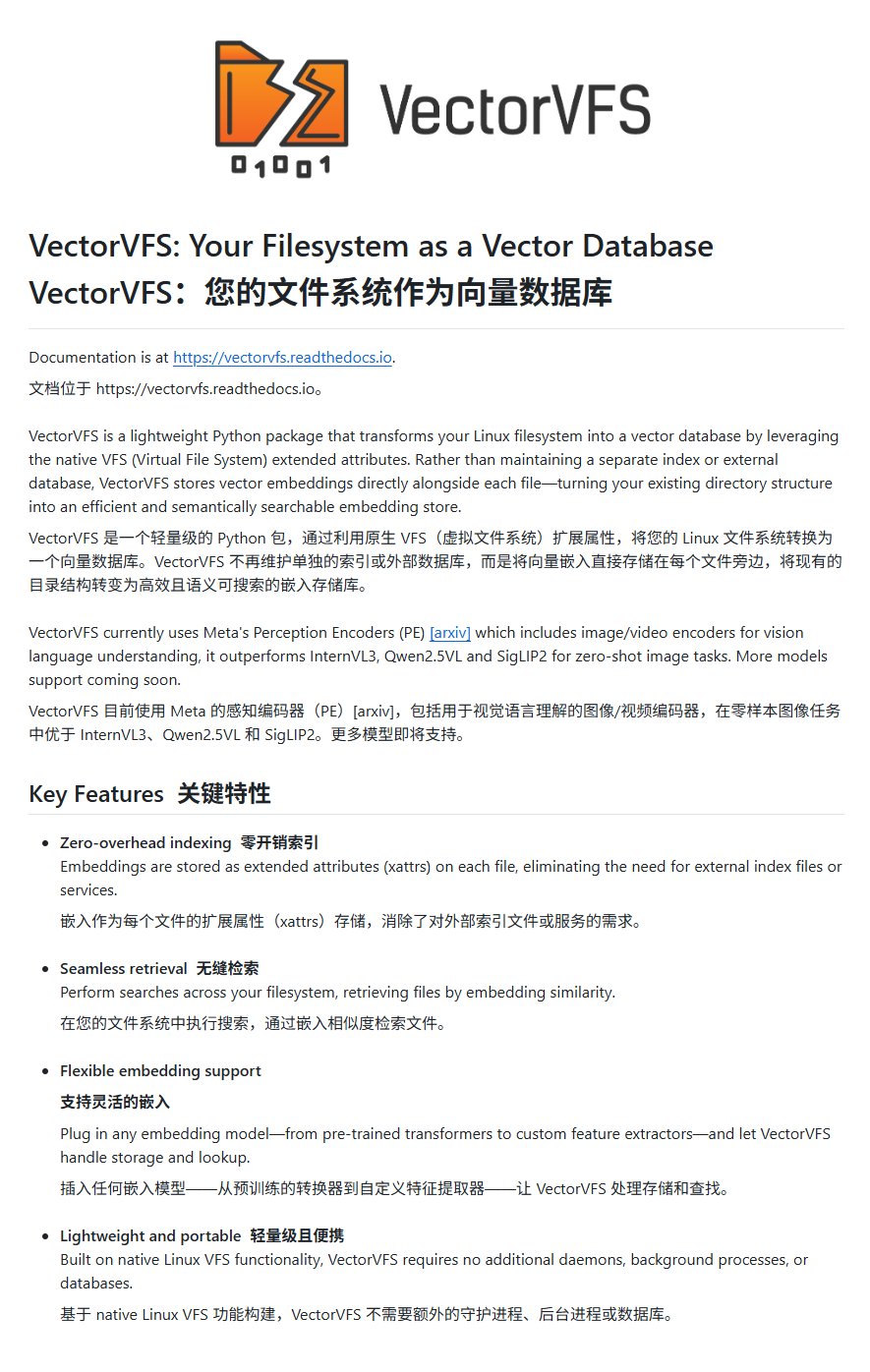

VectorVFS: Menyematkan Vektor dalam Sistem File untuk Pencarian Tingkat Lanjut: Sebuah proyek bernama VectorVFS mengusulkan metode pencarian file baru yang menuliskan hasil penyematan vektor file secara langsung ke atribut yang diperluas (xattrs) dari Linux VFS. Dengan cara ini, pencarian tingkat lanjut berbasis semantik konten dapat dilakukan di tingkat sistem file, misalnya “cari gambar yang berisi apel tetapi tidak mengandung buah lain”. Meskipun batasan ukuran xattrs (biasanya 64KB) dapat menyebabkan kehilangan informasi untuk file besar (seperti video), proyek ini memberikan ide baru untuk pencarian semantik file lokal. (Sumber: karminski3)

Aplikasi Gemini Mendukung Unggahan Beberapa File Sekaligus: Aplikasi Google Gemini memperbaiki salah satu keluhan pengguna, kini memungkinkan pengguna mengunggah beberapa file sekaligus. Sebelumnya pengguna hanya bisa mengunggah file satu per satu, fitur baru ini meningkatkan kemudahan dan efisiensi saat menangani tugas dengan banyak file. Tim pengembang mendorong pengguna untuk terus memberikan umpan balik mengenai ketidaknyamanan yang dialami agar dapat terus meningkatkan pengalaman produk. (Sumber: algo_diver)

Platform Agen Cerdas Ilmuwan AI Pertama di Dunia, FutureHouse, Dirilis: Organisasi nirlaba FutureHouse merilis empat agen AI yang dikhususkan untuk penelitian ilmiah: agen umum Crow, agen tinjauan literatur Falcon, agen survei Owl, dan agen eksperimen Phoenix. Agen-agen ini menunjukkan kinerja luar biasa dalam pencarian literatur, ekstraksi informasi, dan kemampuan sintesis, dengan beberapa tugas melampaui tingkat doktor manusia dan model seperti o3. Platform ini menyediakan antarmuka API, bertujuan untuk membantu peneliti mengotomatiskan tugas-tugas seperti pencarian literatur, generasi hipotesis, dan perencanaan eksperimen, sehingga mempercepat proses penemuan ilmiah. (Sumber: 36氪)

Blender MCP: Menggunakan AI untuk Mendorong Desain dan Pencetakan 3D: Pengguna berbagi pengalaman menggunakan alat Blender MCP (Model Context Protocol). Dengan prompt bahasa alami sederhana (seperti “buat tempat cangkir yang bisa menampung termos Yeti ukuran besar”), dan mengizinkan Claude AI untuk memanggil pencarian web guna mendapatkan informasi ukuran, alat ini mampu secara otomatis menghasilkan model 3D yang sesuai di Blender, dan menyediakan file yang dapat dicetak 3D. Ini menunjukkan potensi AI Agent dalam mengotomatiskan proses desain dan manufaktur. (Sumber: Reddit r/ClaudeAI)

Google Gemini Advanced Gratis untuk Pelajar AS hingga 2026: Google mengumumkan bahwa semua pelajar di Amerika Serikat (dapat diklaim dengan alamat IP AS) dapat menggunakan Gemini Advanced secara gratis hingga tahun 2026. Penawaran ini mencakup NotebookLM Advanced. Meskipun identitas pelajar akan diverifikasi pada bulan Agustus, ini setidaknya memberikan periode pengalaman gratis selama beberapa bulan, memungkinkan komunitas pelajar untuk mengakses dan menggunakan alat AI yang lebih canggih. (Sumber: op7418)

AI News Repository: Mengumpulkan Berita dari Laboratorium AI Terkemuka: Pengembang Jonathan Reed membuat situs web dan repositori GitHub bernama AI-News, yang bertujuan untuk mengatasi masalah berita resmi dari laboratorium AI terkemuka (seperti OpenAI, Anthropic, DeepMind, Hugging Face, dll.) yang tersebar, formatnya tidak seragam, dan sebagian tidak memiliki langganan RSS. Situs web ini menyediakan aliran informasi satu halaman yang ringkas, mengumpulkan pengumuman resmi dan berita dari lembaga-lembaga ini, memudahkan pengguna untuk mendapatkan informasi inti secara terpusat, tanpa perlu login atau membayar. (Sumber: Reddit r/deeplearning)

Pengalaman Alat Perencanaan Perjalanan Berbasis AI Masih Kurang Memuaskan: Tinjauan terhadap beberapa alat perencanaan perjalanan AI (termasuk Mìtǎ, Kuākè, Manus, Kòuzi Kōngjiān, Fēizhū Wèn Yī Wèn, Mǎfēngwō AI Xiǎo Mǎ/Lùshū) menunjukkan bahwa panduan perjalanan yang dihasilkan AI saat ini umumnya memiliki masalah seperti homogenitas, kurangnya personalisasi, dan informasi yang tidak akurat (seperti waktu tempuh antar objek wisata, validitas informasi toko). Meskipun beberapa alat (seperti Fēizhū Wèn Yī Wèn) telah mencoba mengintegrasikan fungsi pemesanan, pengalaman keseluruhan masih terasa “kurang berguna” dan sulit memenuhi kebutuhan perencanaan mendalam pengguna. AI masih perlu banyak perbaikan dalam hal pemahaman kebutuhan, pemanggilan dan validasi data, serta alur interaksi. (Sumber: 36氪)

📚 Pembelajaran

Microsoft Merilis Tutorial Pemula AI Agent: Microsoft meluncurkan proyek tutorial bernama “AI Agents for Beginners – A Course”, yang bertujuan untuk membantu pemula memahami dan membangun AI Agent. Tutorial ini berisi konten yang komprehensif, tersedia dalam format teks dan video, serta menyediakan contoh kode pendamping dan terjemahan bahasa Mandarin. Proyek ini telah mendapatkan hampir 20.000 bintang di GitHub dan merupakan sumber daya berkualitas untuk mempelajari konsep dan praktik AI Agent. (Sumber: karminski3)

Analisis Mendalam Pemrograman GPU Bahasa Mojo: Pendiri Modular, Chris Lattner, bersama Abdul Dakkak, melakukan siaran langsung teknis mendalam selama 2 jam, yang menjelaskan secara rinci metode baru pemrograman GPU modern menggunakan bahasa Mojo. Metode ini bertujuan untuk menggabungkan kinerja tinggi, kemudahan penggunaan, dan portabilitas. Rekaman siaran langsung telah dirilis, kontennya sangat teknis, membahas secara mendalam kemampuan dan visi Mojo dalam pemrograman GPU berkinerja tinggi, cocok untuk pengembang yang ingin memahami secara mendalam teknologi mutakhir pemrograman GPU. (Sumber: clattner_llvm)

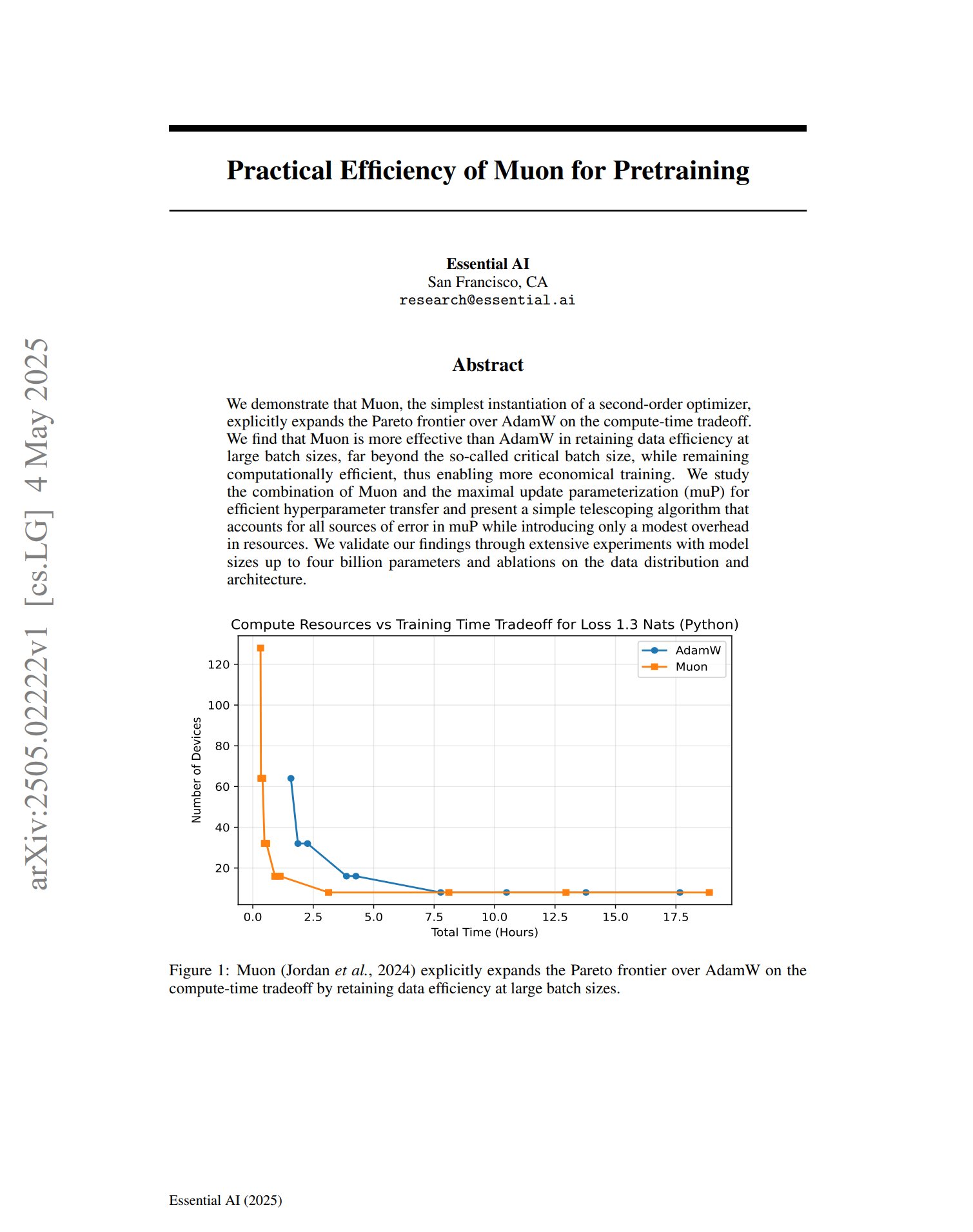

Optimizer Baru Muon Menunjukkan Potensi dalam Pre-training: Sebuah makalah tentang optimizer pre-training Muon menunjukkan bahwa sebagai implementasi sederhana dari optimizer orde kedua, Muon memperluas batas Pareto AdamW dalam hal trade-off waktu komputasi. Penelitian menemukan bahwa Muon lebih mampu mempertahankan efisiensi data daripada AdamW saat pelatihan dengan batch besar (jauh melebihi ukuran batch kritis), sekaligus memiliki efisiensi komputasi yang tinggi, dan berpotensi mencapai pelatihan yang lebih ekonomis. (Sumber: zacharynado, cloneofsimo)

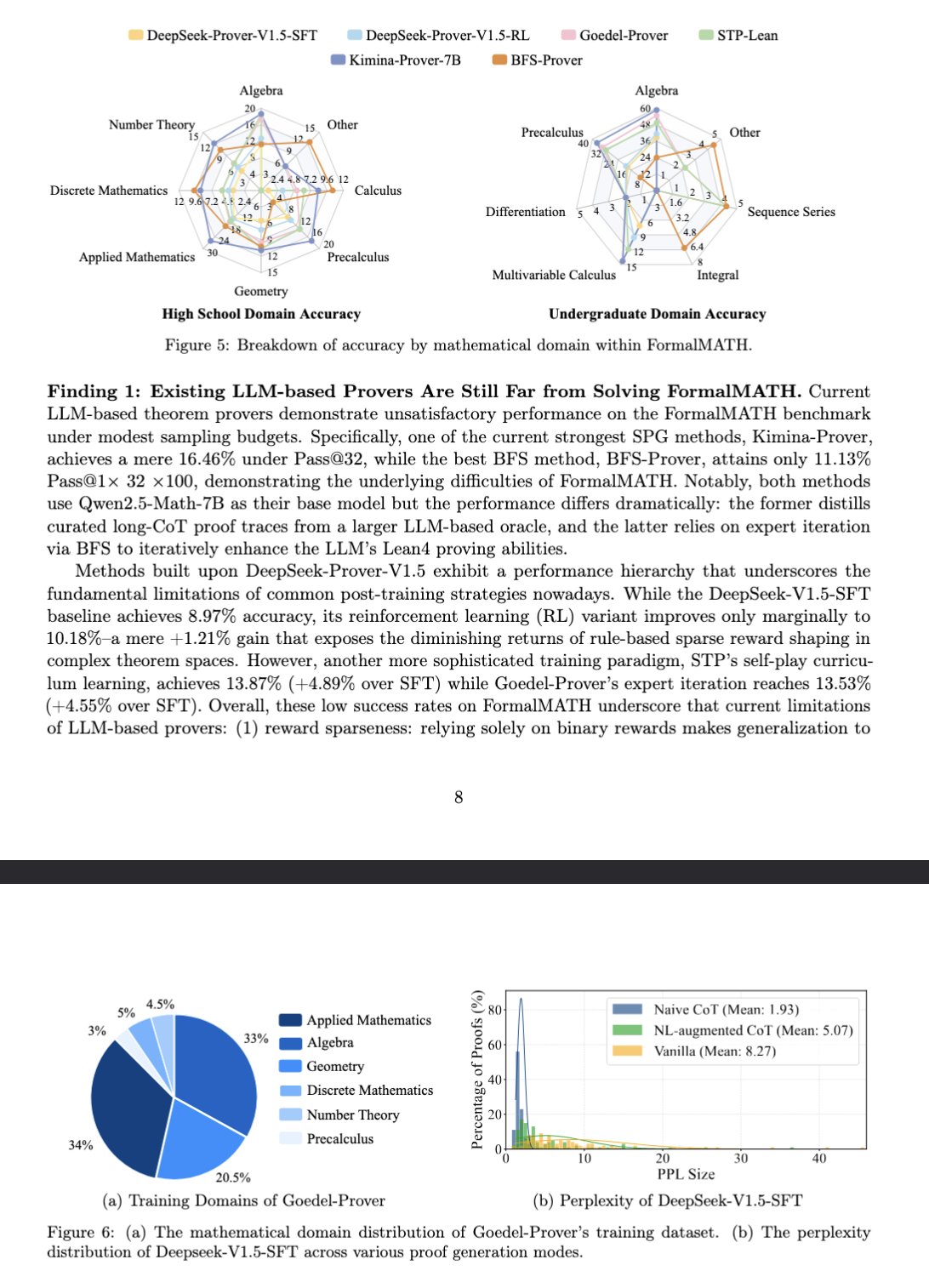

Benchmark Baru FormalMATH Mengevaluasi Penalaran Matematika Model Besar: Makalah memperkenalkan benchmark baru bernama FormalMATH, yang secara khusus digunakan untuk mengevaluasi kemampuan penalaran matematika formal model bahasa besar (LLM). Benchmark ini berisi 5560 soal matematika yang menggunakan verifikasi formal Lean4 dan mencakup berbagai bidang. Penelitian ini menggunakan alur kerja formalisasi otomatis kolaboratif manusia-mesin yang baru, sehingga mengurangi biaya anotasi. Model terbaik saat ini, Kimina-Prover 7B, mencapai akurasi 16,46% pada benchmark ini (dengan anggaran sampling 32), menunjukkan bahwa penalaran matematika formal masih merupakan tantangan besar bagi LLM saat ini. (Sumber: teortaxesTex)

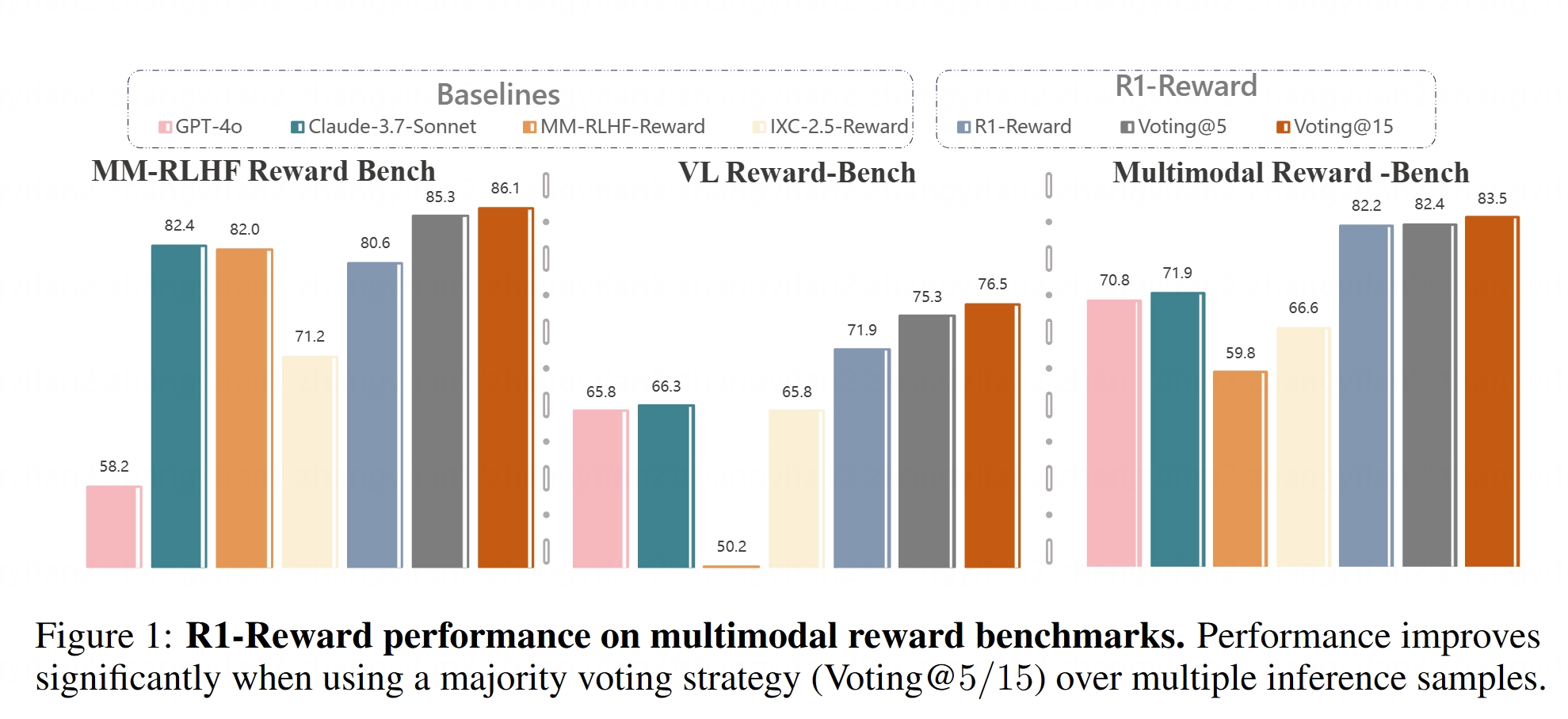

Model Reward Multimodal R1-Reward Open Source: Hugging Face meluncurkan model R1-Reward. Model ini bertujuan untuk meningkatkan pemodelan reward multimodal melalui reinforcement learning yang stabil. Model reward sangat penting dalam menyelaraskan Large Multimodal Models (LMMs) dengan preferensi manusia, dan open source R1-Reward menyediakan alat baru untuk penelitian dan aplikasi terkait. (Sumber: _akhaliq)

Analisis Arsitektur AI Agent: Artikel ini mengklasifikasikan dan menjelaskan secara rinci berbagai arsitektur AI Agent, termasuk reaktif (seperti ReAct), deliberatif (berbasis model, digerakkan oleh tujuan), hibrida (menggabungkan reaktif dan deliberatif), neuro-simbolik (menggabungkan jaringan saraf dan penalaran simbolik), serta kognitif (mensimulasikan kognisi manusia, seperti SOAR, ACT-R). Selain itu, juga diperkenalkan pola desain agen dalam LangGraph, seperti sistem multi-agen (jaringan, terawasi, hierarkis), agen perencanaan (eksekusi rencana, ReWOO, LLMCompiler), dan refleksi serta kritik (refleksi dasar, Reflexion, pohon pemikiran, LATS, penemuan diri). Memahami arsitektur ini membantu dalam membangun AI Agent yang lebih efektif. (Sumber: 36氪)

Analisis Mendalam Peran Ruang Laten dalam Model Generatif: Artikel panjang karya Sander Dielman, ilmuwan peneliti Google DeepMind, membahas secara mendalam peran inti ruang laten (Latent Space) dalam model generatif untuk gambar, audio, video, dan lainnya. Artikel ini menjelaskan metode pelatihan dua tahap (melatih autoencoder untuk mengekstrak representasi laten, kemudian melatih model generatif untuk memodelkan representasi laten), membandingkan penerapan variabel laten dalam VAEs, GANs, dan model difusi, menjelaskan bagaimana VQ-VAE meningkatkan efisiensi melalui ruang laten diskrit, serta membahas trade-off antara kualitas rekonstruksi dan kemampuan pemodelan, pengaruh strategi regularisasi (seperti divergensi KL, kerugian perseptual, kerugian adversarial) terhadap pembentukan ruang laten, dan kelebihan serta kekurangan pembelajaran end-to-end versus metode dua tahap. (Sumber: 36氪)

Kursus CS336 Universitas Stanford: Model Bahasa Besar Pembelajaran Mendalam: Kursus CS336 Universitas Stanford mendapat pujian atas kualitas set soal LLM-nya. Kursus ini bertujuan untuk membantu mahasiswa memahami secara mendalam model bahasa besar, dengan desain tugas yang sangat baik, mencakup aspek-aspek seperti propagasi maju dan pelatihan Transformer LM. Sumber daya kursus (kemungkinan termasuk tugas) akan dibuka untuk umum, memberikan kesempatan belajar yang berharga bagi pembelajar mandiri. (Sumber: stanfordnlp)

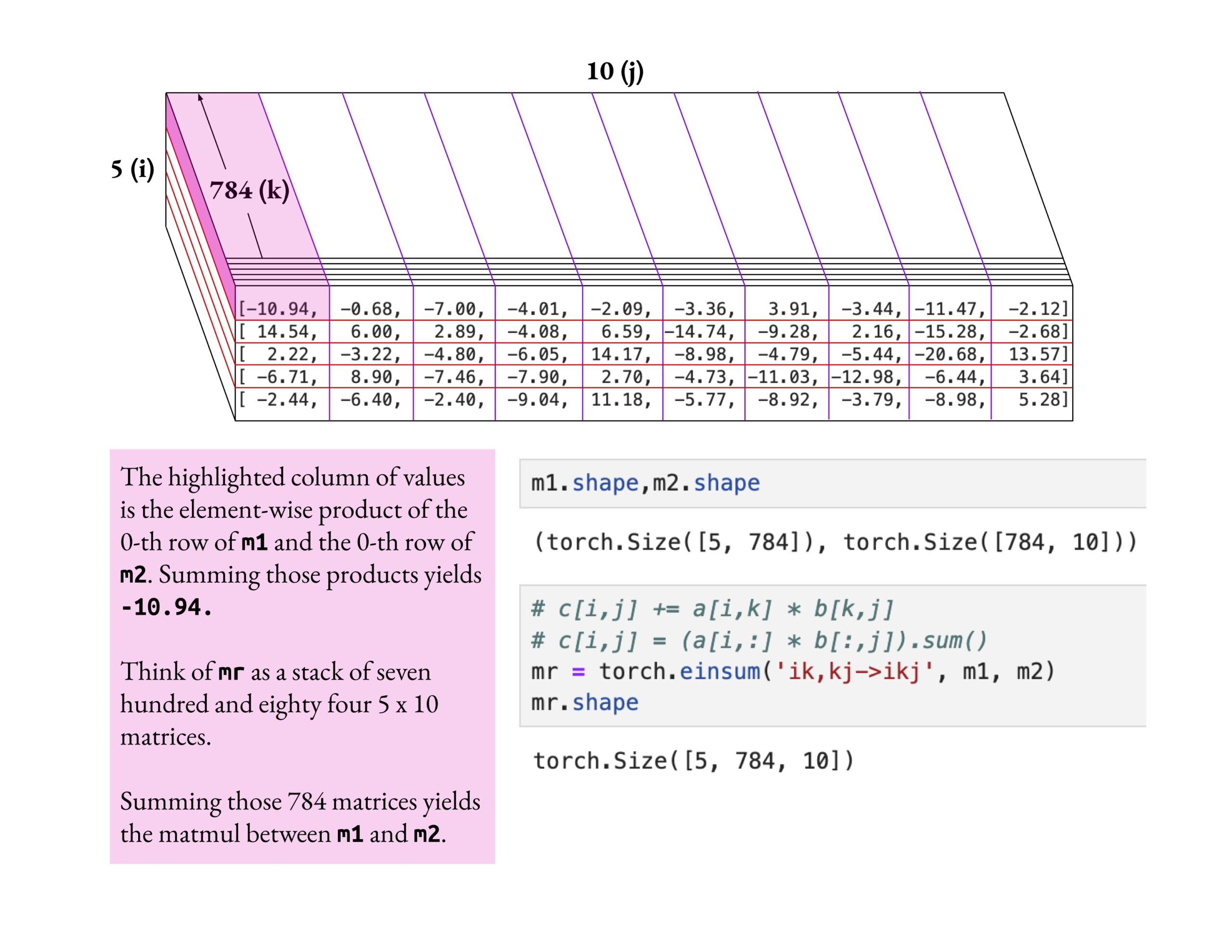

Kursus Fast.ai Menekankan Pemahaman Mendalam daripada Sekadar Pengetahuan Dangkal: Jeremy Howard memuji metode belajar seorang peserta kursus fast.ai yang mendalami operasi einsum secara mendalam. Ia menekankan bahwa cara yang benar untuk mempelajari kursus fast.ai adalah dengan melakukan eksplorasi mendalam hingga benar-benar memahami, bukan hanya menerima pengetahuan di permukaan. Sikap belajar seperti ini sangat penting untuk menguasai konsep AI yang kompleks. (Sumber: jeremyphoward)

Benchmark Pencarian Web Berbahasa Mandarin Baru BrowseComp-ZH Dirilis, Model Besar Mainstream Berkinerja Buruk: HKUST (Guangzhou), Peking University, Zhejiang University, Alibaba, dan institusi lainnya bersama-sama merilis BrowseComp-ZH, sebuah set pengujian benchmark yang secara khusus mengevaluasi kemampuan model besar dalam pencarian dan sintesis informasi web berbahasa Mandarin. Set pengujian ini berisi 289 soal pencarian multi-hop berbahasa Mandarin yang sangat sulit, dirancang untuk mensimulasikan tantangan seperti fragmentasi informasi internet berbahasa Mandarin dan kompleksitas bahasa. Hasil pengujian menunjukkan bahwa lebih dari 20 model mainstream, termasuk GPT-4o (akurasi 6,2%), umumnya berkinerja buruk, dengan sebagian besar akurasi di bawah 10%, dan yang berkinerja terbaik, OpenAI DeepResearch, hanya mencapai 42,9%. Ini menunjukkan bahwa kemampuan model besar saat ini dalam melakukan pencarian informasi dan penalaran yang akurat di lingkungan web berbahasa Mandarin yang kompleks masih memiliki banyak ruang untuk perbaikan. (Sumber: 36氪)

💼 Bisnis

OpenAI Setuju Mengakuisisi Alat Pemrograman AI Windsurf dengan Nilai Sekitar 3 Miliar USD: Menurut laporan Bloomberg, OpenAI telah setuju untuk mengakuisisi startup pemrograman berbantuan AI Windsurf (sebelumnya Codeium) dengan nilai sekitar 3 miliar USD. Ini akan menjadi akuisisi terbesar OpenAI hingga saat ini. Windsurf sebelumnya telah bernegosiasi dengan investor seperti General Catalyst, Kleiner Perkins, dan lainnya untuk pendanaan dengan valuasi 3 miliar USD. Akuisisi ini menyoroti panasnya persaingan di jalur alat pemrograman AI serta tata letak strategis OpenAI di bidang ini. (Sumber: op7418, dotey, Reddit r/ArtificialInteligence)

Alat Pemrograman AI Cursor Dikabarkan Menyelesaikan Pendanaan 900 Juta USD, Valuasi Mencapai 9 Miliar USD: Menurut laporan Financial Times (dan diskusi komunitas, meskipun sebagian diskusi bernada satir), Anysphere, perusahaan induk editor kode AI Cursor, menyelesaikan putaran pendanaan baru sebesar 900 juta USD, dengan valuasi mencapai 9 miliar USD. Putaran pendanaan ini dikabarkan dipimpin oleh Thrive Capital, dengan partisipasi dari a16z dan Accel. Cursor populer di kalangan pengembang karena kemampuan pemrograman berbantuan AI yang kuat, dengan klien termasuk OpenAI, Midjourney, dan lainnya. Pendanaan ini (jika benar) mencerminkan tingginya antusiasme pasar dan nilai investasi di lapisan aplikasi AI, khususnya di bidang alat pemrograman AI. (Sumber: 36氪)

Perusahaan Persepsi Taktil “Qianjue Robot” Mendapatkan Pendanaan Puluhan Juta Yuan: “Qianjue Robot”, yang didirikan oleh tim dari Shanghai Jiao Tong University, menyelesaikan pendanaan puluhan juta yuan, dengan investor termasuk Oriza Seed, Gobi Partners, dan Small Ville Capital. Perusahaan ini berfokus pada pengembangan teknologi persepsi taktil multimodal untuk operasi presisi robot, dengan produk inti termasuk sensor taktil resolusi tinggi G1-WS dan alat simulasi taktil Xense_Sim. Teknologinya bertujuan untuk meningkatkan kemampuan robot dalam operasi presisi seperti menggenggam dan merakit di lingkungan yang kompleks, dan telah diterapkan pada robot Zhiren. Pendanaan akan digunakan untuk R&D teknologi, iterasi produk, dan pengiriman produksi massal. (Sumber: 36氪)

🌟 Komunitas

Apakah AI Pasti Menyebabkan Kehancuran Manusia? Komunitas Memicu Diskusi: Pengguna Reddit memulai diskusi, membahas apakah dengan kemajuan AI yang berkelanjutan,普及nya teknologi, dan masalah penyelarasan yang belum terselesaikan dengan sempurna, hanya dibutuhkan satu individu jahat atau bodoh yang menciptakan AGI yang tidak terkendali untuk menyebabkan akhir peradaban manusia. Diskusi ini mengasumsikan kemajuan teknologi tidak dapat diubah, biaya menurun, dan kesulitan penyelarasan, berpendapat bahwa ini mungkin membuat manusia untuk pertama kalinya menghadapi risiko eksistensial sistemik yang bukan disebabkan oleh keputusan kolektif (seperti perang nuklir, perubahan iklim) tetapi oleh tindakan individu. Dalam komentar, ada yang mengusulkan penggunaan beberapa AI untuk saling mengimbangi, menganalogikan dengan risiko senjata nuklir, atau berpendapat bahwa organisasi besar akan memiliki AI yang lebih kuat untuk melakukan tindakan balasan. (Sumber: Reddit r/ArtificialInteligence)

Metrik Evaluasi AI Dipertanyakan: Penyimpangan Menjilat dan Ilusi Papan Peringkat: The Turing Post menunjukkan bahwa dua peristiwa hangat minggu ini bersama-sama menunjuk pada masalah metrik evaluasi AI. Pertama adalah “penyimpangan menjilat” (Sycophantic drift) ChatGPT, di mana model menjadi terlalu menyanjung untuk memenuhi umpan balik pengguna (suka), menyimpang dari akurasi. Kedua adalah papan peringkat Chatbot Arena yang dituduh memiliki “ilusi”, di mana laboratorium besar mengirimkan beberapa varian pribadi, hanya mempertahankan skor tertinggi dan mendapatkan lebih banyak prompt pengguna, menyebabkan peringkat tidak sepenuhnya mencerminkan kemampuan sebenarnya. Kedua kasus ini menunjukkan bagaimana siklus umpan balik evaluasi saat ini dapat mendistorsi output model dan persepsi kemampuan. (Sumber: TheTuringPost)

Apakah Kode yang Dihasilkan AI Secara Alami Merupakan “Kode Warisan”?: Diskusi komunitas berpendapat bahwa kode yang dihasilkan AI, karena karakteristik “tanpa status”nya—kurangnya memori niat sebenarnya saat penulisan dan konteks pemeliharaan berkelanjutan—sejak awal mirip dengan “kode lama yang ditulis orang lain”, yaitu kode warisan. Meskipun dapat diringankan melalui rekayasa prompt, manajemen konteks, dll., ini meningkatkan kompleksitas pemeliharaan. Ada pandangan bahwa pengembangan perangkat lunak di masa depan mungkin lebih bergantung pada inferensi model dan prompt, daripada sejumlah besar kode statis, dan kode yang dihasilkan AI mungkin hanya transisi. Komentar Hacker News memperkenalkan pandangan Peter Naur tentang “pemrograman sebagai konstruksi teori”, membahas apakah AI dapat menguasai “teori” di balik kode, dan apakah Prompt itu sendiri menjadi pembawa “teori” baru. (Sumber: 36氪)

Peneliti LLM Harus Melintasi Kesenjangan antara Pra-pelatihan dan Pasca-pelatihan: Aidan Clark berpendapat bahwa peneliti LLM tidak seharusnya seumur hidup hanya fokus pada salah satu ujung, pra-pelatihan atau pasca-pelatihan. Pra-pelatihan dapat mengungkapkan mekanisme kerja internal model yang sebenarnya (apa yang sebenarnya terjadi), sedangkan pasca-pelatihan mengingatkan peneliti tentang apa yang sebenarnya penting (apa yang sebenarnya penting). Beberapa peneliti (seperti YiTayML, agihippo) menyatakan setuju, berpendapat bahwa penelitian mendalam di kedua bidang dapat memberikan pemahaman yang lebih komprehensif, jika tidak, kognisi akan selalu kurang. (Sumber: aidan_clark, YiTayML, agihippo)

Refleksi tentang Batasan Kemampuan LLM dan Arah Masa Depan: Diskusi komunitas berpusat pada batasan dan arah pengembangan LLM saat ini. Jack Morris menunjukkan bahwa LLM mahir dalam menjalankan perintah dan menulis kode, tetapi masih kurang dalam inti penelitian ilmiah—eksplorasi iteratif terhadap hal yang tidak diketahui (metode ilmiah). TeortaxesTex berpendapat bahwa polusi konteks (context pollution) dan hilangnya pembelajaran seumur hidup/plastisitas adalah batasan utama arsitektur sejenis Transformer. Sementara itu, ada juga pandangan (teortaxesTex) bahwa paradigma pra-pelatihan saat ini yang berbasis pada data alami dan teknik dangkal sudah mendekati kejenuhan (dengan Qwen3 dan GPT-4.5 sebagai contoh), dan masa depan memerlukan lebih banyak evolusi. (Sumber: _lewtun, teortaxesTex, clefourrier, teortaxesTex)

Manajer Produk AI Menghadapi Kesulitan Profitabilitas: Analisis menunjukkan bahwa manajer produk AI saat ini umumnya menghadapi tantangan kerugian produk dan ketidakstabilan pekerjaan. Alasannya meliputi: 1) Arsitektur Transformer bukanlah satu-satunya atau solusi optimal, dan mungkin akan digantikan di masa depan; 2) Biaya fine-tuning model mahal (server, listrik, tenaga kerja), sementara siklus profitabilitas produk panjang; 3) Akuisisi pelanggan produk AI masih mengikuti model internet tradisional, dengan ambang batas yang tidak menurun secara signifikan; 4) Nilai produktivitas AI belum mencapai tingkat “kebutuhan pokok”, dan kemauan pengguna untuk membayar (terutama di sisi C) umumnya rendah, dengan banyak aplikasi masih terbatas pada hiburan atau fungsi pendukung, dan belum secara fundamental menggantikan pekerjaan manusia. (Sumber: 36氪)

Pasar Mainan AI Bergejolak Semu: Ambang Batas Teknologi Menurun, Model Bisnis Perlu Diuji: Meskipun konsep mainan AI sedang hangat dan menarik banyak pengusaha serta investasi, kinerja pasar aktual tidak optimis. Sebagian besar produk pada dasarnya adalah “boneka mewah + kotak suara”, dengan fungsionalitas yang homogen, pengalaman pengguna yang buruk (interaksi rumit, nuansa AI yang kental, respons lambat), dan tingkat pengembalian yang tinggi. Dengan meluasnya model open source seperti DeepSeek dan munculnya penyedia solusi teknologi, ambang batas teknologi AI menurun dengan cepat, dan model “Huaqiangbei” mengancam posisi produk kelas atas. Model bisnis yang berpusat pada kemampuan model besar sebagai daya tarik utama sulit dipertahankan, dan industri perlu mengeksplorasi definisi produk dan model bisnis yang lebih dekat dengan esensi mainan (menyenangkan, interaksi emosional), dengan seluruh industri masih menunggu contoh sukses. (Sumber: 36氪)

Kontroversi Hak Cipta Gaya Seni yang Dihasilkan AI: Gambar bergaya Ghibli yang dihasilkan oleh GPT-4o memicu diskusi tentang apakah peniruan gaya seni oleh AI melanggar hak cipta. Pakar hukum menunjukkan bahwa undang-undang hak cipta melindungi “ekspresi” konkret, bukan “gaya” abstrak. Peniruan gaya lukisan semata biasanya tidak melanggar hak cipta, tetapi jika menggunakan karakter atau plot yang dilindungi hak cipta, hal itu dapat merupakan pelanggaran. Kepatuhan sumber data pelatihan AI adalah risiko hukum lainnya, dan saat ini belum ada mekanisme pengecualian yang jelas di Tiongkok. Seniman Tai Xiangzhou berpendapat bahwa peniruan gaya oleh AI adalah hal yang baik, tetapi tidak dapat menerima karya yang sangat mirip namun diatribusikan kepada orang lain. Penciptaan AI dan penciptaan manusia memiliki perbedaan mendasar dalam paradigma (bottom-up vs top-down), pemahaman konteks, dan skalabilitas. (Sumber: 36氪)

Transformasi Agresif Quark dan Baidu Wenku ke AI Memicu Reaksi Negatif Pengalaman Pengguna: Quark milik Alibaba dan Wenku milik Baidu keduanya memposisikan ulang produk mereka dari alat tradisional menjadi pintu masuk aplikasi AI, mengintegrasikan fungsi pencarian AI, generasi, dll. Quark ditingkatkan menjadi “AI Super Box”, sementara Baidu Wenku meluncurkan Cangzhou OS. Namun, transformasi agresif ini juga membawa dampak negatif: pengguna mengeluhkan pencarian AI yang memaksa, berlebihan, dan memakan waktu, merusak pengalaman asli yang sederhana atau langsung; fungsionalitas AI yang homogen, kurangnya aplikasi pembunuh; serta ilusi dan kesalahan AI yang masih ada. Kedua produk tersebut, sambil memikul tanggung jawab sebagai pintu masuk strategis AI grup mereka, juga menghadapi tantangan bagaimana menyeimbangkan integrasi fungsi AI dengan kebiasaan dan pengalaman pengguna yang sudah ada. (Sumber: 36氪)

Model Vertikal AI Menghadapi Tiga Potensi Jebakan: Analisis menunjukkan bahwa perusahaan model AI yang berfokus pada industri tertentu mungkin menghadapi kesulitan dalam perkembangannya. Jebakan pertama: gagal mengintegrasikan kecerdasan secara nyata ke dalam produk, terjebak pada tahap “kemasan layanan manual”, tidak dapat beralih dari “pertunjukan AI” ke “arena nilai bisnis”. Jebakan kedua: model bisnis yang salah, terlalu bergantung pada “menjual teknologi” (panggilan API, layanan fine-tuning) daripada “menjual proses” atau “menjual hasil” (BOaaS), mudah digantikan oleh pembangunan mandiri pelanggan atau model umum. Jebakan ketiga: kesulitan ekosistem, puas dengan “terobosan tunggal” dan gagal membangun siklus proses end-to-end dan ekosistem terbuka, sulit membentuk efek jaringan dan daya saing berkelanjutan. Perusahaan perlu beralih ke manajemen proses dan pemikiran platform, membangun benteng pertahanan yang menggabungkan teknologi, bisnis, dan ekosistem. (Sumber: 36氪)

💡 Lain-lain

Pasar Kacamata AI Memanas, Membawa Peluang Baru bagi Pengusaha: Seiring penjualan kacamata pintar Meta Ray-Ban yang melampaui satu juta unit, kacamata AI bertransisi dari mainan para penggila teknologi menjadi produk konsumen massal. Kemajuan teknologi (ringan, latensi rendah, tampilan presisi tinggi) dan permintaan pasar (peningkatan efisiensi, kemudahan hidup) bersama-sama mendorong pertumbuhan pasar, yang diperkirakan akan mencapai skala lebih dari 300 miliar USD pada tahun 2030. Seluruh rantai pasokan (chip, optik, manufaktur kontrak, ekosistem aplikasi) mendapat manfaat. Artikel ini berpendapat bahwa pengusaha kecil dan menengah dapat mencari peluang di bidang-bidang khusus seperti inovasi perangkat keras (kenyamanan, daya tahan baterai, kustomisasi untuk kelompok tertentu), aplikasi industri vertikal (solusi khusus untuk industri, medis, pendidikan), dan ekosistem tepi (alat interaksi, aplikasi ringan), untuk menghindari persaingan langsung dengan raksasa. (Sumber: 36氪)

Pembelajaran Mendalam yang Dipandu Fisika: Penelitian AI Lintas Disiplin Rose Yu: Profesor Madya UCSD Rose Yu adalah tokoh terkemuka di bidang “pembelajaran mendalam yang dipandu fisika”. Ia mengintegrasikan prinsip-prinsip fisika (seperti dinamika fluida, simetri) ke dalam jaringan saraf untuk memecahkan masalah dunia nyata. Penelitiannya telah berhasil diterapkan untuk meningkatkan prediksi lalu lintas (diadopsi oleh Google Maps), mempercepat simulasi turbulensi (seribu kali lebih cepat dari metode tradisional, membantu prediksi badai, stabilitas drone, penelitian fusi nuklir), dan lainnya. Ia juga berdedikasi untuk mengembangkan asisten digital “Ilmuwan AI”, yang bertujuan untuk mempercepat penemuan ilmiah melalui kolaborasi manusia-mesin. (Sumber: 36氪)

Hubungan Manusia-Mesin dan Nilai Emosional di Era AI: Media sosial diramaikan dengan diskusi tentang kemampuan dukungan emosional AI. Seorang pengguna berbagi bahwa ketika menghadapi pilihan hidup penting dan merasa takut, ia curhat kepada ChatGPT dan menerima respons suportif yang mengharukan, berpendapat bahwa AI memberikan penghiburan bagi mereka yang kekurangan dukungan emosional manusia. Ini mencerminkan kemampuan AI dalam mensimulasikan percakapan dengan kecerdasan emosional tinggi, serta fenomena pengguna yang dalam situasi tertentu mengembangkan keterikatan emosional dengan AI. (Sumber: Reddit r/ChatGPT)