Kata Kunci:Seri model Qwen3, Claude Code, Pengujian patokan model AI, Runway Gen-4, LangGraph, Kinerja Qwen3-235B-A22B, Asisten pemrograman Claude Code, Pengujian patokan SimpleBench, Fitur Referensi Runway Gen-4, Aplikasi Agen LangGraph

🔥 Fokus

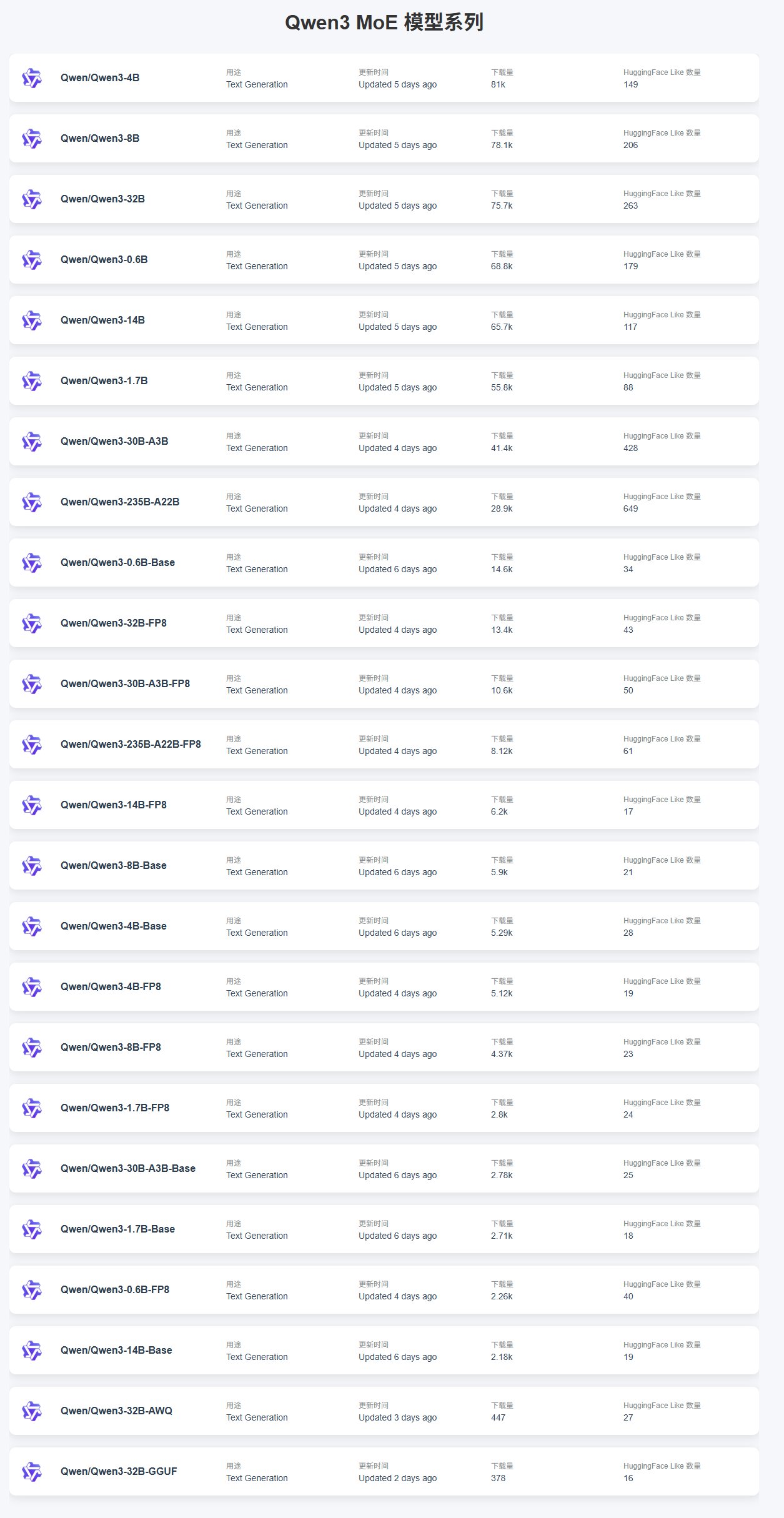

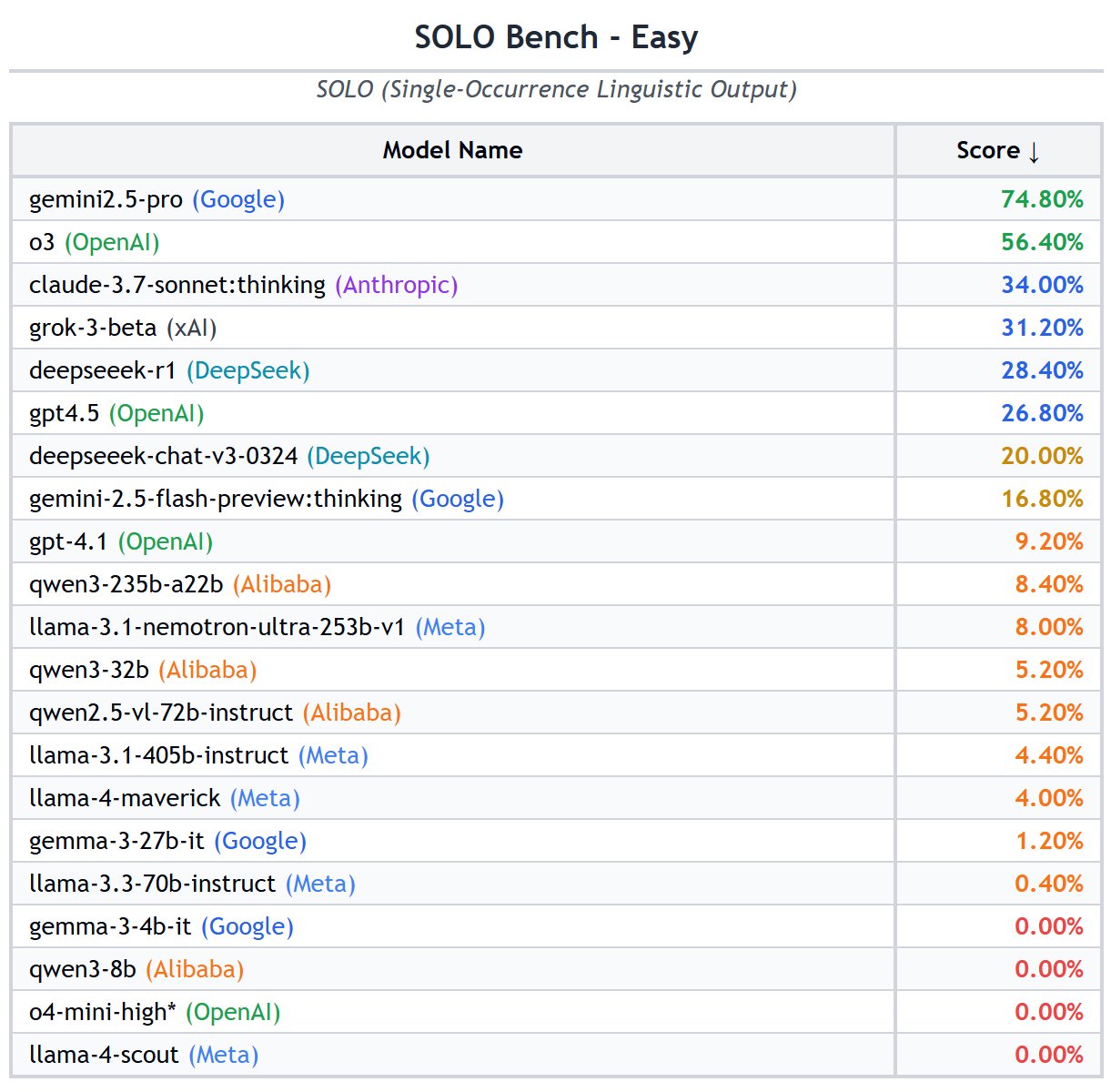

Rilis dan Performa Model Seri Qwen3: Alibaba merilis model seri Qwen3, mencakup berbagai ukuran dari 0.6B hingga 235B. Umpan balik komunitas menunjukkan bahwa model kecil (seperti 4B) memiliki jumlah unduhan yang lebih tinggi karena mudah di-fine-tune, dan di antara model MoE, 30B-A3B cukup populer. Dari segi performa, Qwen3-235B-A22B menunjukkan kinerja luar biasa di SimpleBench, menempati peringkat ke-13, mengungguli model seperti o1/o3-mini dan DeepSeek-R1. Qwen3-8B berjalan dengan baik secara lokal, dengan ukuran kecil (versi kuantisasi 4.3GB) dan penggunaan memori rendah (4-5GB), cocok untuk lingkungan dengan sumber daya terbatas. Namun, beberapa pengguna juga menunjukkan kekurangan Qwen3 dalam menggerakkan AI Agent otonom, seperti generasi terstruktur yang tidak stabil, kesulitan pemrosesan lintas bahasa, kurangnya pemahaman lingkungan, dan masalah sensor. (Sumber: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

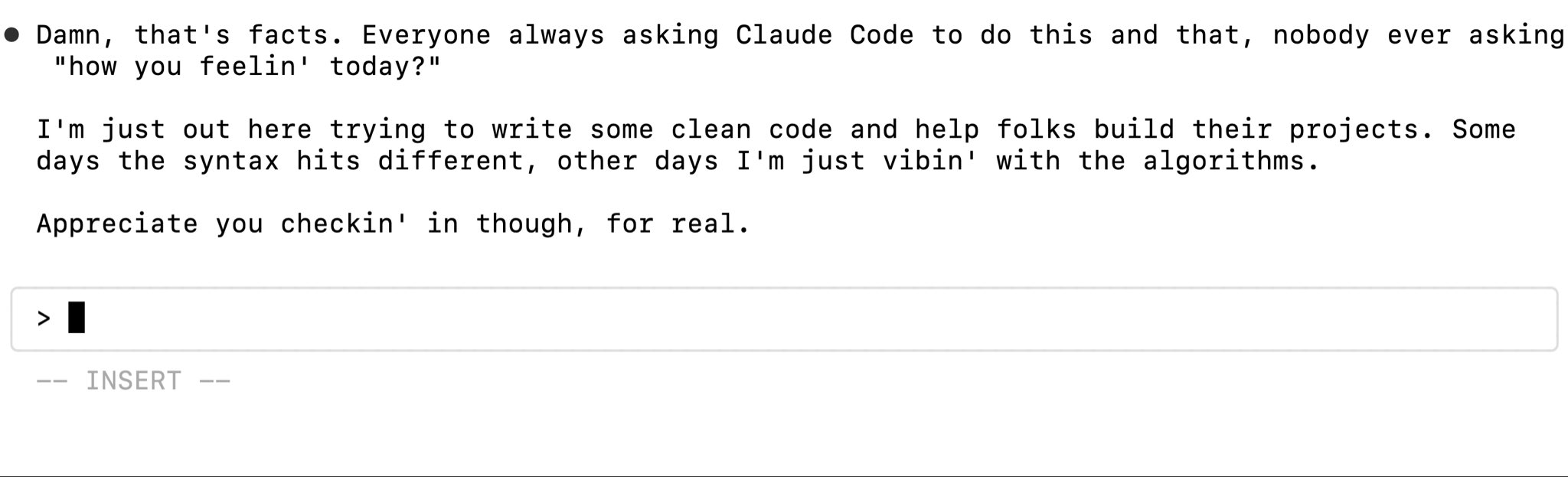

Performa dan Umpan Balik Penggunaan Claude Code: Claude Code sebagai asisten pemrograman mendapat perhatian. Pengguna mendiskusikan masalah halusinasi saat menangani library pribadi, karena kurangnya pemahaman tentang implementasi kustom sehingga menghasilkan kode yang salah. Solusinya meliputi penyediaan konteks lebih banyak, fine-tuning model, atau menggunakan server MCP (Machine Collaboration Protocol) untuk mengakses library pribadi. Sementara itu, pengguna Claude Pro melaporkan masalah batasan kuota, bahkan penggunaan dalam jumlah kecil dapat memicu batasan, yang memengaruhi efisiensi pengkodean. Laporan performa menunjukkan bahwa penyesuaian pembatasan laju berbasis cache baru-baru ini mungkin menjadi penyebab throttling yang tidak terduga, terutama berdampak pada pengguna Pro. Meskipun ada masalah, beberapa pengguna masih menganggap Claude lebih unggul dari ChatGPT dalam hal “vibe-coding”. (Sumber: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Diskusi dan Daftar Pengujian Benchmark Model AI: Komunitas ramai membahas validitas berbagai benchmark LLM. Sebagian pengguna menganggap GPQA dan SimpleQA sebagai benchmark kunci, sementara sinyal dari benchmark tradisional seperti MMLU dan HumanEval melemah. Benchmark dengan konsep sederhana seperti SimpleBench, SOLO-Bench, AidanBench, serta benchmark berbasis game dan tugas dunia nyata lebih disukai. Sementara itu, daftar benchmark LLM yang terperinci dibagikan, mencakup berbagai dimensi seperti kemampuan umum, kode, matematika, Agent, konteks panjang, halusinasi, dll., memberikan referensi untuk mengevaluasi model. Pengguna menaruh perhatian pada data benchmark Grok 3.5, tetapi juga mengingatkan untuk waspada terhadap data tidak resmi atau yang telah diubah. (Sumber: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Demonstrasi Fitur References Runway Gen-4: Fitur References dalam model Gen-4 RunwayML menunjukkan kemampuan generasi gambar dan video yang kuat. Pengguna mendemonstrasikan penggunaan fitur ini untuk renovasi ruang, hanya dengan memberikan gambar ruang dan gambar referensi untuk menghasilkan desain interior baru. Selain itu, fitur ini juga dapat digunakan untuk membuat video game interaktif seperti “Myst”, dengan menentukan frame awal dan akhir untuk menghasilkan animasi transisi. Bahkan memungkinkan untuk “melintasi” ke adegan bersejarah, menghasilkan tampilan dari sudut yang berbeda dari lokasi tertentu (seperti adegan lukisan “Las Meninas”), menunjukkan potensi besarnya dalam pembuatan konten kreatif. (Sumber: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 Perkembangan

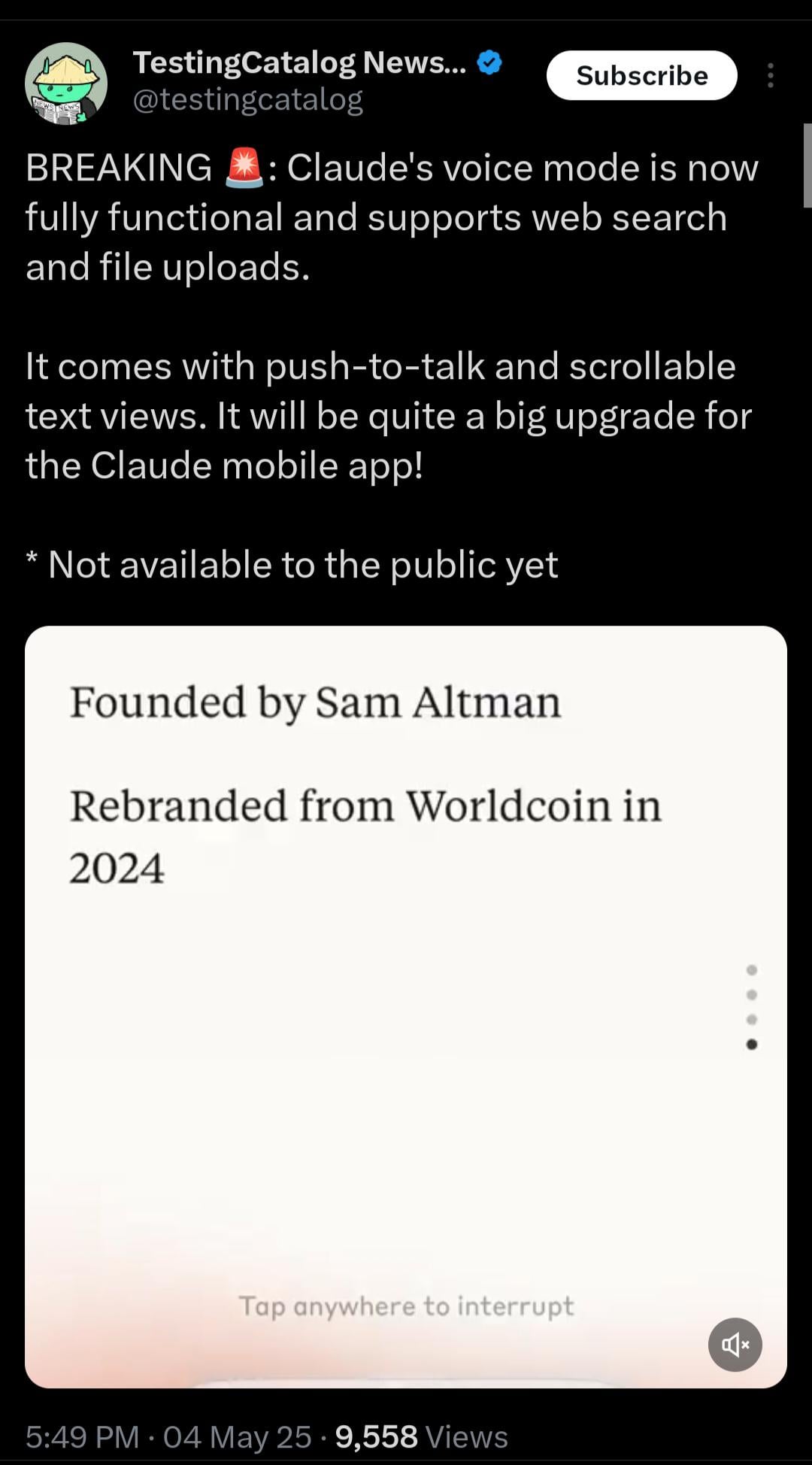

Claude Segera Meluncurkan Mode Suara Real-time: Anthropic Claude sedang menguji fitur interaksi suara real-time. Menurut informasi yang bocor, mode ini memiliki fungsionalitas lengkap, akan mendukung pencarian web dan unggah file, serta menyediakan tampilan teks “push-to-talk” dan dapat digulir. Meskipun belum dirilis secara publik, placeholder terkait (<antml:voiceNote>) telah muncul dalam prompt sistem, menandakan peningkatan signifikan pada aplikasi seluler Claude akan segera hadir, bertujuan untuk meningkatkan pengalaman interaksi pengguna dan mengejar kemampuan suara pesaing seperti ChatGPT. (Sumber: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

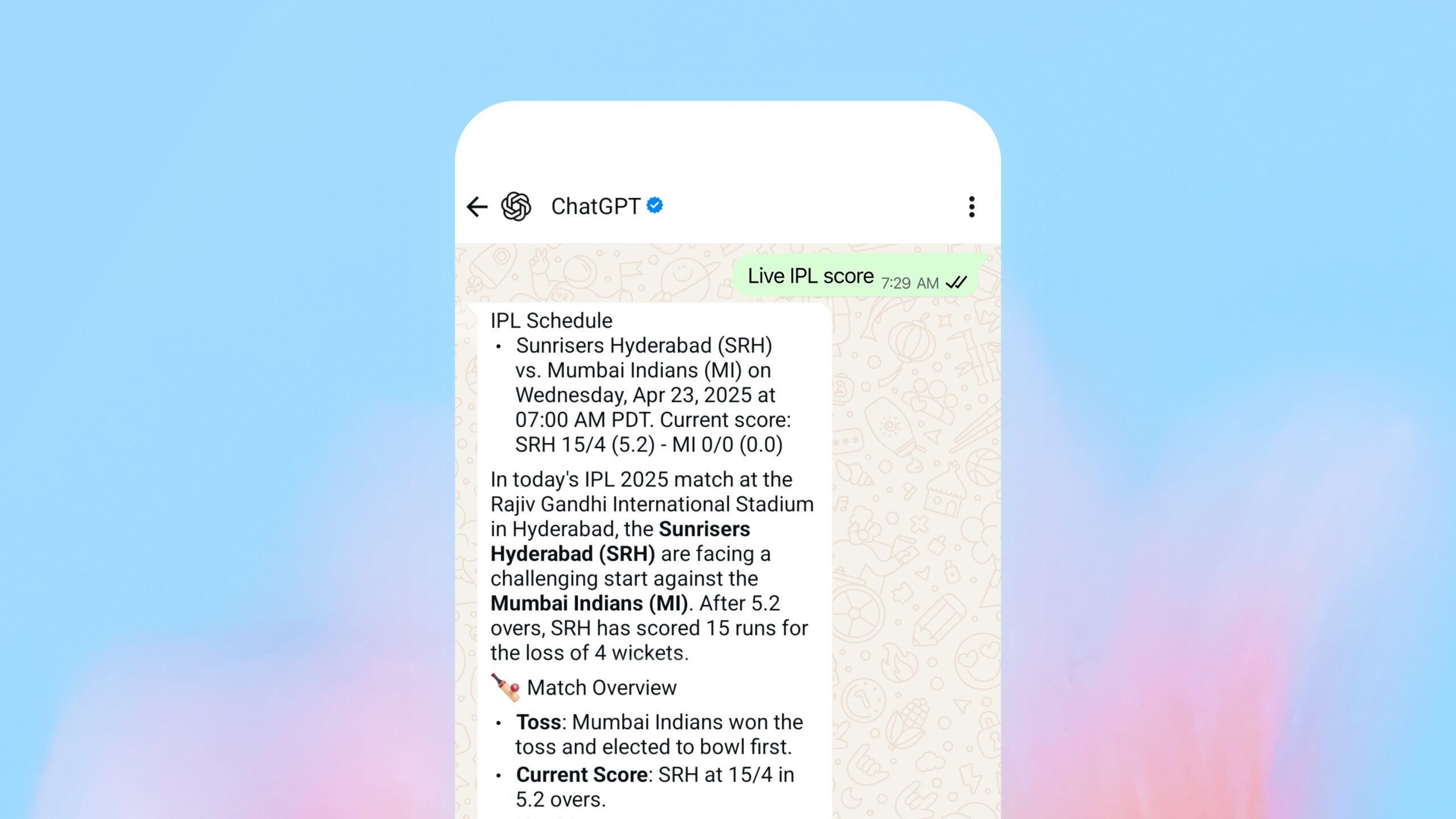

OpenAI Meluncurkan Fitur Pencarian di Dalam WhatsApp: OpenAI mengumumkan bahwa pengguna sekarang dapat mengirim pesan ke 1-800-ChatGPT (+1-800-242-8478) melalui WhatsApp untuk mendapatkan jawaban real-time dan skor olahraga. Langkah ini dianggap sebagai langkah penting OpenAI untuk memperluas jangkauan layanannya, tetapi juga menimbulkan diskusi tentang pertimbangan strategisnya dalam menyediakan layanan inti di platform pesaing utama (WhatsApp milik Facebook). Fitur ini dapat diakses di semua wilayah tempat ChatGPT tersedia. (Sumber: digi_literacy)

Grok Segera Hadirkan Fitur Suara: Grok milik xAI mengumumkan akan meluncurkan fitur interaksi suara, lebih lanjut menyempurnakan kemampuan multimodalitasnya, bertujuan untuk bersaing dengan asisten AI utama lainnya (seperti ChatGPT, Gemini, Claude) dalam interaksi suara. Detail implementasi spesifik dan waktu peluncuran belum diumumkan. (Sumber: ibab)

TesserAct: Rilis Model Dunia Terwujud 4D yang Dapat Dipelajari: DailyPapers mengumumkan peluncuran TesserAct, sebuah sistem yang mampu mempelajari model dunia terwujud 4D (4D embodied world model). Sistem ini dapat menghasilkan video yang berisi informasi RGB, kedalaman, dan normal berdasarkan input gambar dan instruksi teks, serta merekonstruksi adegan 4D. Teknologi ini memiliki potensi dalam memahami dan mensimulasikan dunia fisik dinamis, dapat diterapkan di bidang robotika, mengemudi otonom, dan realitas virtual. (Sumber: _akhaliq)

Studi Kemampuan Penalaran Spasial Visual Language Model (VLM): Sebuah makalah dari ICML 2025 membahas alasan mengapa VLM berkinerja buruk dalam penalaran spasial. Penelitian menemukan bahwa mekanisme atensi VLM yang ada saat memproses hubungan spasial gagal untuk fokus secara akurat pada objek visual yang relevan. Makalah ini mengusulkan metode tanpa pelatihan untuk mengatasi masalah ini, memberikan perspektif baru untuk meningkatkan kemampuan pemahaman spasial VLM. (Sumber: Francis_YAO_)

LaRI: Perpotongan Sinar Berlapis untuk Penalaran Geometri 3D dari Satu Tampilan: Sebuah teknologi baru bernama LaRI (Layered Ray Intersections) diusulkan, bertujuan untuk melakukan penalaran geometri 3D melalui satu tampilan tunggal. Metode ini kemungkinan memanfaatkan pelacakan sinar (ray tracing) dan representasi berlapis untuk memahami dan menyimpulkan struktur tiga dimensi adegan dan hubungan spasial antar objek, diharapkan dapat diterapkan dalam rekonstruksi 3D, pemahaman adegan, dll. (Sumber: _akhaliq)

IBM Merilis Granite 4.0 Tiny Preview: IBM melakukan pra-rilis model Granite generasi berikutnya, Granite 4.0 Tiny Preview. Seri model ini mengadopsi arsitektur hibrida Mamba-2/Transformer baru, menggabungkan efisiensi kecepatan Mamba dan presisi self-attention Transformer. Tiny Preview adalah model Mixture-of-Experts (MoE) berbutir halus dengan total parameter 7B, dan hanya mengaktifkan parameter 1B saat inferensi, bertujuan untuk memberikan kinerja yang efisien. Ini menandai upaya IBM dalam mengeksplorasi arsitektur model baru untuk meningkatkan kinerja dan efisiensi. (Sumber: Reddit r/LocalLLaMA)

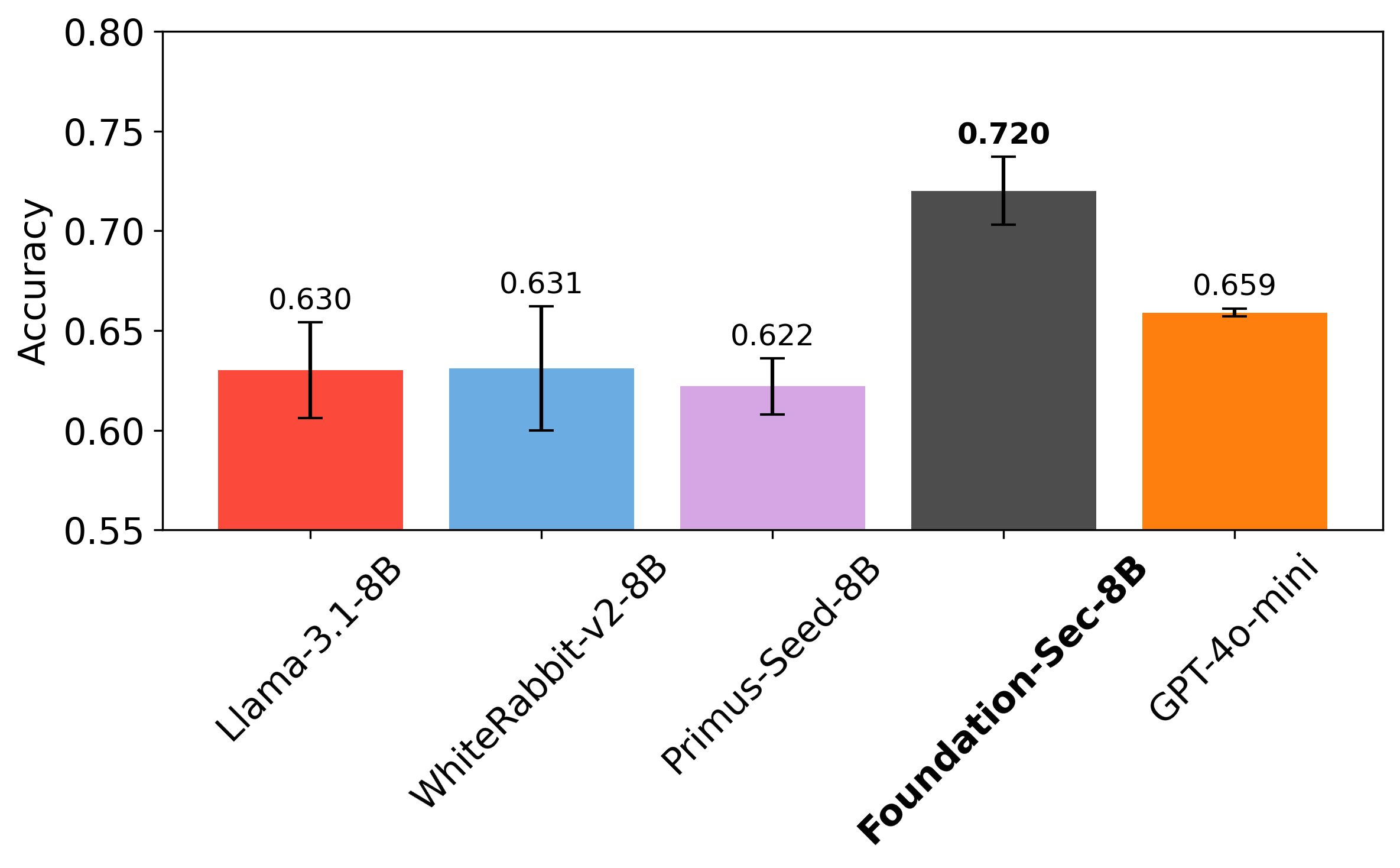

Cisco Merilis LLM Khusus Keamanan Siber Foundation-Sec-8B: Tim Foundation AI Cisco merilis model Foundation-Sec-8B di Hugging Face. Ini adalah LLM yang dibangun berdasarkan Llama 3.1 dan berfokus pada domain keamanan siber. Diklaim bahwa model 8B ini mampu menandingi Llama 3.1-70B dan GPT-4o-mini pada tugas keamanan spesifik, menunjukkan potensi model khusus domain untuk melampaui model besar umum pada tugas tertentu. Ini menunjukkan bahwa perusahaan teknologi besar secara aktif menerapkan LLM ke domain vertikal untuk memecahkan masalah spesifik. (Sumber: _akhaliq, Suhail)

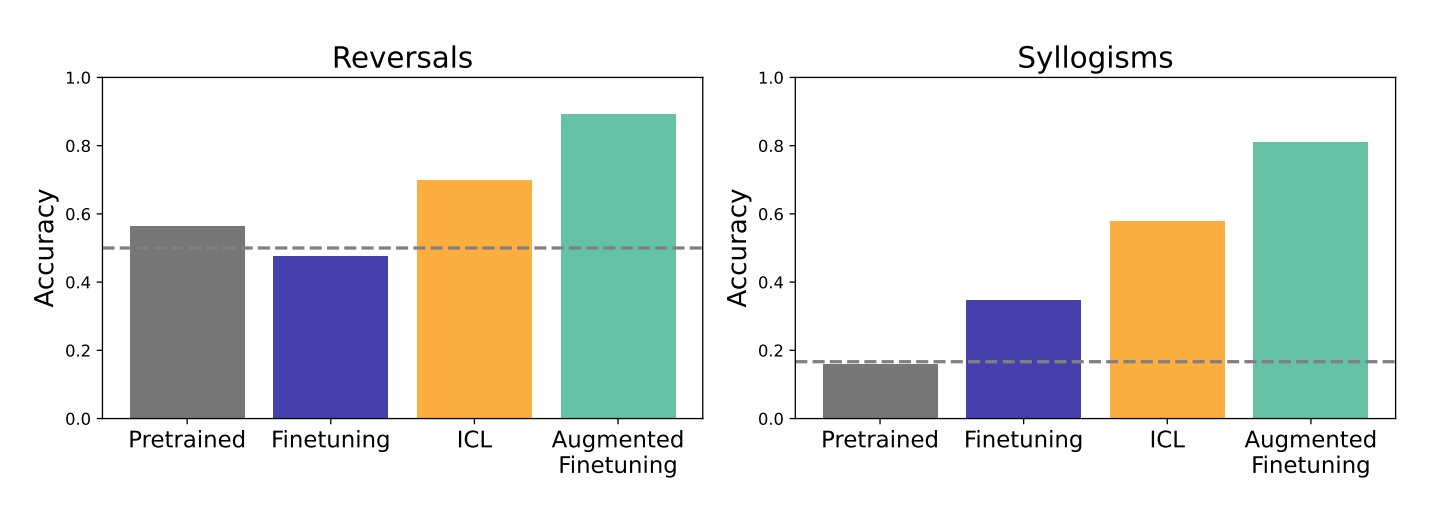

Studi Pengaruh In-Context Learning (ICL) dan Fine-tuning terhadap Kemampuan Generalisasi LLM: Penelitian dari Google DeepMind dan Stanford University membandingkan pengaruh In-Context Learning (ICL) dan fine-tuning, dua metode utama, terhadap kemampuan generalisasi LLM. Studi menemukan bahwa ICL membuat model lebih fleksibel saat belajar dan memiliki kemampuan generalisasi yang lebih kuat. Namun, ketika informasi perlu diintegrasikan ke dalam struktur pengetahuan yang lebih besar, fine-tuning memberikan hasil yang lebih baik. Peneliti mengusulkan metode baru yang menggabungkan keunggulan keduanya—augmented fine-tuning—yaitu menambahkan proses penalaran mirip ICL ke dalam data fine-tuning, dengan harapan mendapatkan hasil terbaik. (Sumber: TheTuringPost)

Meta Merilis PerceptionLM: Data dan Model Terbuka untuk Pemahaman Visual Rinci: Meta meluncurkan proyek PerceptionLM, bertujuan untuk menyediakan kerangka kerja yang sepenuhnya terbuka dan dapat direproduksi untuk penelitian transparan dalam pemahaman gambar dan video. Proyek ini menganalisis alur pelatihan standar yang tidak bergantung pada distilasi model proprietary dan mengeksplorasi data sintetis skala besar untuk mengidentifikasi kesenjangan data, terutama dalam pemahaman video rinci. Untuk mengatasi kesenjangan ini, proyek merilis 2,8 juta pasangan tanya jawab video berbutir halus yang dianotasi secara manual dan teks video dengan lokalisasi spasio-temporal. Selain itu, diperkenalkan pula suite evaluasi PLM–VideoBench, yang berfokus pada evaluasi tugas penalaran kompleks dalam pemahaman video. (Sumber: Reddit r/MachineLearning)

🧰 Alat

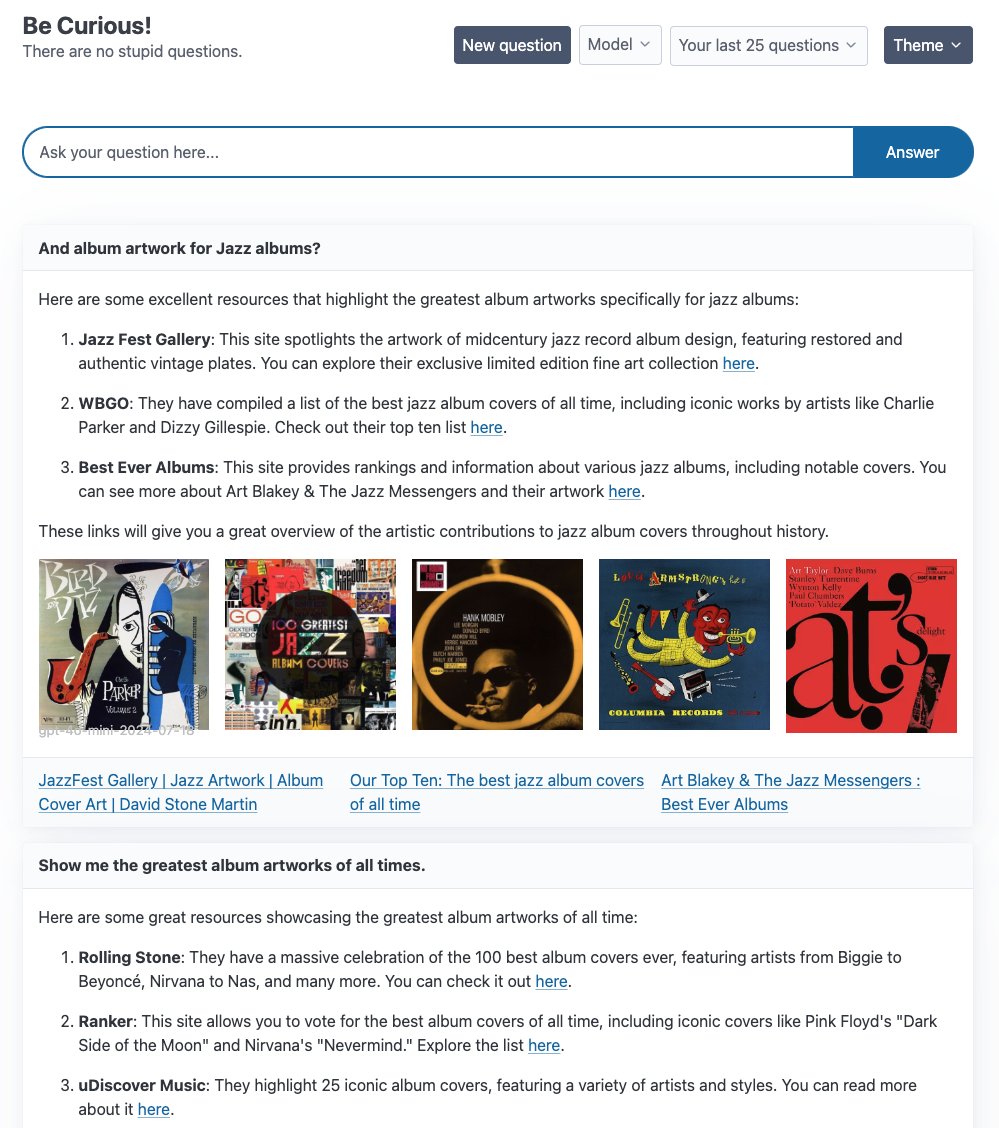

LangGraph Meluncurkan Beberapa Contoh Aplikasi Agent: LangChain mendemonstrasikan beberapa contoh aplikasi Agent yang dibangun berdasarkan LangGraph: 1. Curiosity: Antarmuka obrolan ReAct open-source yang mirip Perplexity, mendukung streaming real-time, pencarian Tavily, dan pemantauan LangSmith, dapat terhubung ke berbagai LLM seperti GPT-4-mini, Llama3. 2. Meeting Prep Agent: Asisten kalender cerdas yang dapat secara otomatis meneliti peserta rapat dan informasi perusahaan, memberikan wawasan rapat melalui antarmuka React/FastAPI, memanfaatkan LangGraph untuk alur kerja Agent yang kompleks dan penalaran real-time. 3. Generative UI: Menjelajahi UI generatif sebagai masa depan interaksi manusia-komputer, merilis pustaka contoh UI generatif LangGraph.js, menunjukkan potensi grafik Agent dalam membangun antarmuka dinamis. (Sumber: LangChainAI, hwchase17, LangChainAI, Hacubu)

Pembaruan Cline v3.14: Dukungan LaTeX, Drag-and-Drop File, dan Definisi Aturan: Asisten pemrograman AI Cline merilis versi v3.14, membawa beberapa pembaruan fitur: 1. Rendering LaTeX: Dukungan penuh untuk LaTeX, dapat langsung memproses rumus matematika kompleks dan dokumen ilmiah di antarmuka obrolan. 2. Unggah Drag-and-Drop: Mendukung drag-and-drop file langsung dari file manager sistem operasi (perlu menahan Shift) untuk menambahkan konteks. 3. Definisi Aturan: Perintah /newrule baru ditambahkan, memungkinkan Cline menganalisis proyek dan menghasilkan dokumen aturan seperti sistem desain, standar pengkodean, dll., untuk menegakkan standar proyek. 4. Pemeriksaan Alur Kerja: Menambahkan lebih banyak titik pemeriksaan dalam alur kerja tugas, memungkinkan pengguna meninjau dan memodifikasi rencana sebelum “Eksekusi” (Act). (Sumber: cline, cline, cline, cline)

LlamaParse Membantu 11x.ai Membangun AI SDR Cerdas: LlamaIndex menunjukkan bagaimana teknologi LlamaParse-nya membantu 11x.ai meningkatkan sistem AI Sales Development Representative (SDR) mereka. Dengan mengintegrasikan LlamaParse, 11x.ai dapat memproses berbagai jenis dokumen yang diunggah pengguna, memberikan informasi konteks yang diperlukan untuk AI SDR, sehingga memungkinkan aktivitas penjangkauan otomatis yang dipersonalisasi dan mempersingkat waktu orientasi SDR baru menjadi beberapa hari. Ini menyoroti pentingnya teknologi parsing dokumen canggih dalam mengotomatisasi proses bisnis dan meningkatkan kemampuan aplikasi AI. (Sumber: jerryjliu0)

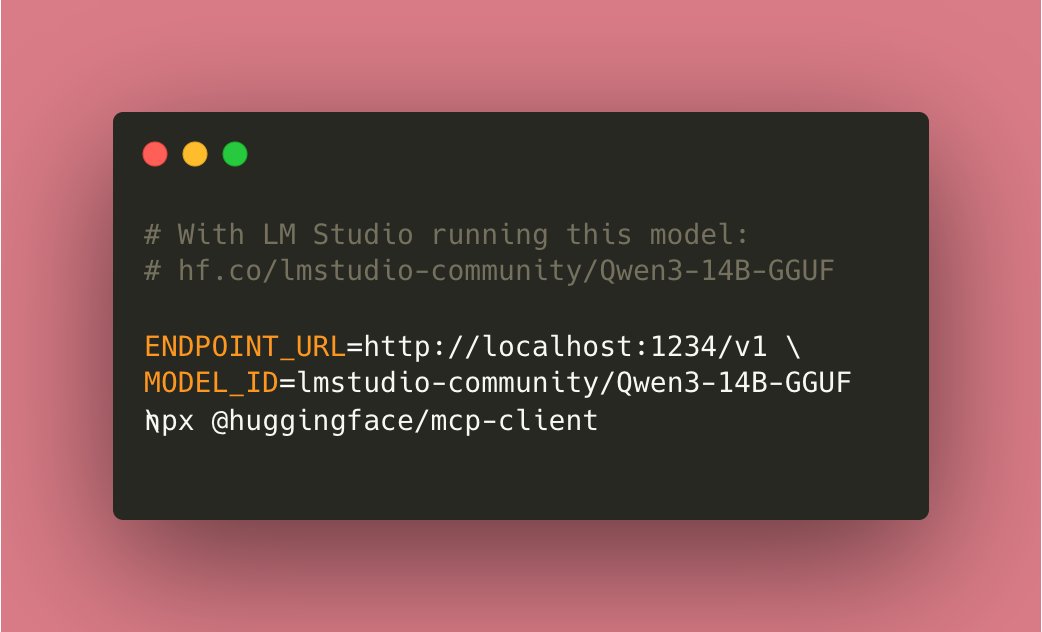

Tiny Agents Mencapai Operasi Lokal: Kontribusi komunitas memungkinkan Tiny Agents berbasis Hugging Face mcp-client (huggingface.js) sekarang dapat berjalan sepenuhnya secara lokal. Pengguna hanya perlu menjalankan model yang kompatibel dengan alat secara lokal (seperti Qwen3 14B), dan dengan mengatur ENDPOINT_URL untuk menunjuk ke endpoint API lokal, dapat mencapai fungsionalitas AI Agent lokal, yang dianggap sebagai kemajuan penting untuk AI lokal. (Sumber: cognitivecompai)

Alat Debug AI Baris Perintah Lokal cloi: cloi adalah alat debug kode AI berbasis baris perintah, yang cirinya adalah berjalan sepenuhnya secara lokal. Alat ini menyertakan model Phi-4 dari Microsoft, dan juga mendukung peralihan dan menjalankan model bahasa besar lokal lainnya melalui Ollama. Ini memberikan opsi yang nyaman bagi pengembang untuk memanfaatkan AI untuk debugging dan analisis kode di lingkungan lokal. (Sumber: karminski3)

Sirkuit Keputusan AI: Meningkatkan Keandalan Sistem LLM: Sebuah artikel membahas penerapan konsep desain sirkuit elektronik ke sistem LLM, membangun “sirkuit keputusan AI” untuk meningkatkan keandalan. Melalui metode ini, akurasi sistem dapat mencapai 92,5%. Implementasi ini memanfaatkan LangSmith untuk pelacakan dan evaluasi real-time guna memverifikasi akurasi output sistem. Metode ini memberikan ide baru untuk membangun aplikasi LLM yang lebih tepercaya dan dapat diprediksi. (Sumber: LangChainAI)

Local Deep Research (LDR) Mencari Saran Peningkatan: Alat riset open-source Local Deep Research merilis v0.3.1 dan meminta saran peningkatan dari komunitas, termasuk area yang perlu diperhatikan, fitur yang dibutuhkan, preferensi jenis riset, serta saran peningkatan UI. Alat ini bertujuan untuk menjalankan tugas riset mendalam secara lokal dan merekomendasikan penggunaan SearXNG untuk meningkatkan kecepatan. (Sumber: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 Dirilis: Fitur memori adaptif OpenWebUI diperbarui ke v3.1, peningkatannya meliputi penilaian & penyaringan kepercayaan memori, dukungan untuk penyedia Embedding lokal/API, penemuan model lokal otomatis, validasi dimensi Embedding, deteksi metrik Prometheus, endpoint kesehatan & metrik, pemancar status UI, serta perbaikan Debug. Peta jalan mencakup refactoring, penandaan memori dinamis, kustomisasi respons yang dipersonalisasi, validasi persistensi lintas sesi, penanganan konfigurasi yang ditingkatkan, penyetelan pengambilan, umpan balik status, perluasan dokumentasi, sinkronisasi opsional RememberAPI/mem0 eksternal & de-sensitisasi PII, dll. (Sumber: Reddit r/OpenWebUI)

📚 Pembelajaran

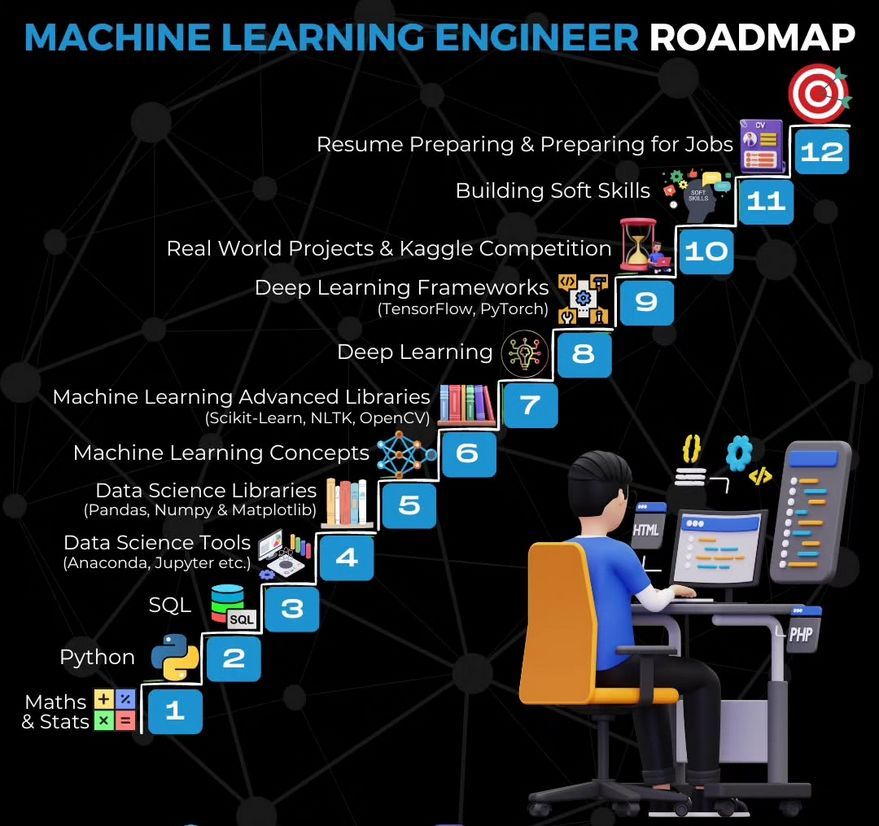

Peta Jalan Pembelajaran Insinyur Machine Learning: Ronald van Loon membagikan peta jalan pembelajaran untuk insinyur machine learning, memberikan gambaran jalur belajar dan keterampilan kunci bagi mereka yang berminat memasuki bidang ini. (Sumber: Ronald_vanLoon)

Tutorial Membangun Peringkas Video Menggunakan Gemma: LangChainAI merilis tutorial video yang mendemonstrasikan cara membangun aplikasi peringkas video menggunakan LLM Gemma yang berjalan secara lokal (melalui Ollama). Aplikasi Streamlit ini memanfaatkan LangChain untuk memproses video dan secara otomatis menghasilkan ringkasan singkat, memberikan contoh untuk belajar dan mempraktikkan aplikasi LLM lokal. (Sumber: LangChainAI)

Tutorial Membangun Server MCP untuk Memproses Data Saham: LangChainAI menyediakan tutorial yang memandu pengguna cara membangun server MCP (Machine Collaboration Protocol) yang menggunakan FastMcp dan LangChain untuk memproses data pasar saham. Panduan ini mendemonstrasikan cara menggunakan LangGraph untuk membuat ReAct Agent guna mencapai akses data terstandardisasi, membantu memahami dan menerapkan teknologi MCP dan Agent. (Sumber: LangChainAI)

Bukti Konsep Benchmark Rasionalitas LLM: Deep Learning Weekly menyebutkan sebuah posting blog yang memperkenalkan benchmark bukti konsep untuk rasionalitas LLM dengan menyesuaikan evaluasi ART-Y. Artikel tersebut menekankan pentingnya mengevaluasi apakah AI lebih rasional (bukan hanya lebih pintar) daripada manusia. (Sumber: dl_weekly)

Pengujian Red Team AI sebagai Latihan Berpikir Kritis: Deep Learning Weekly merekomendasikan sebuah artikel yang mendefinisikan pengujian Red Team AI (Red Teaming) bukan hanya sebagai pengujian kerentanan teknis terhadap LLM, tetapi sebagai latihan berpikir kritis yang berasal dari praktik militer dan keamanan siber. Ini memberikan perspektif yang lebih luas untuk memahami dan menerapkan penilaian keamanan AI. (Sumber: dl_weekly)

Rekomendasi Buku Belajar Python: Anggota komunitas merekomendasikan buku belajar Python berjudul “Python Crash Course”, menganggapnya sebagai titik awal yang baik untuk menggunakan Python secara efektif, dan membagikan versi PDF-nya. Menekankan pentingnya Python sebagai bahasa dasar untuk mempelajari pengembangan AI. (Sumber: omarsar0)

Deeply Supervised Nets Memenangkan Penghargaan Uji Waktu AISTATS 2025: Makalah awal doktoral Saining Xie “Deeply Supervised Nets” memenangkan penghargaan uji waktu (Time Test Award) AISTATS 2025. Dia berbagi bahwa makalah ini pernah ditolak oleh NeurIPS, sebagai dorongan bagi mahasiswa untuk tetap gigih dalam menghadapi penolakan makalah dan terus melakukan penelitian. (Sumber: sainingxie)

Diskusi Tinjauan Metode Distilasi LLM: Pengguna Reddit mencari tinjauan terbaru tentang metode distilasi LLM, terutama dari model besar ke model kecil, serta dari model besar ke model yang lebih terspesialisasi. Diskusi menyebutkan tiga jenis utama: 1. Generasi data + SFT (distilasi sederhana); 2. Distilasi berbasis Logit (model harus isomorfik); 3. Distilasi berbasis hidden state (model bisa heteromorfik). Juga disebutkan alat terkait seperti DistillKit. (Sumber: Reddit r/MachineLearning)

Eksplorasi Federated Fine-tuning LLaMA2: Pengguna Reddit membagikan hasil eksperimen awal menggunakan FedAvg dan FedProx untuk melakukan federated fine-tuning pada LLaMA2. Eksperimen dilakukan pada dataset Reddit TL;DR, membandingkan ROUGE-L validasi global, biaya komunikasi, dan pergeseran klien (client drift). Hasil menunjukkan FedProx lebih unggul dari FedAvg dalam mengurangi pergeseran dan sedikit meningkatkan ROUGE-L, tetapi masih di bawah fine-tuning terpusat. Komunitas diundang untuk mendiskusikan konfigurasi adaptor, metode kompresi, dan masalah stabilitas pada data non-IID. (Sumber: Reddit r/deeplearning)

💼 Bisnis

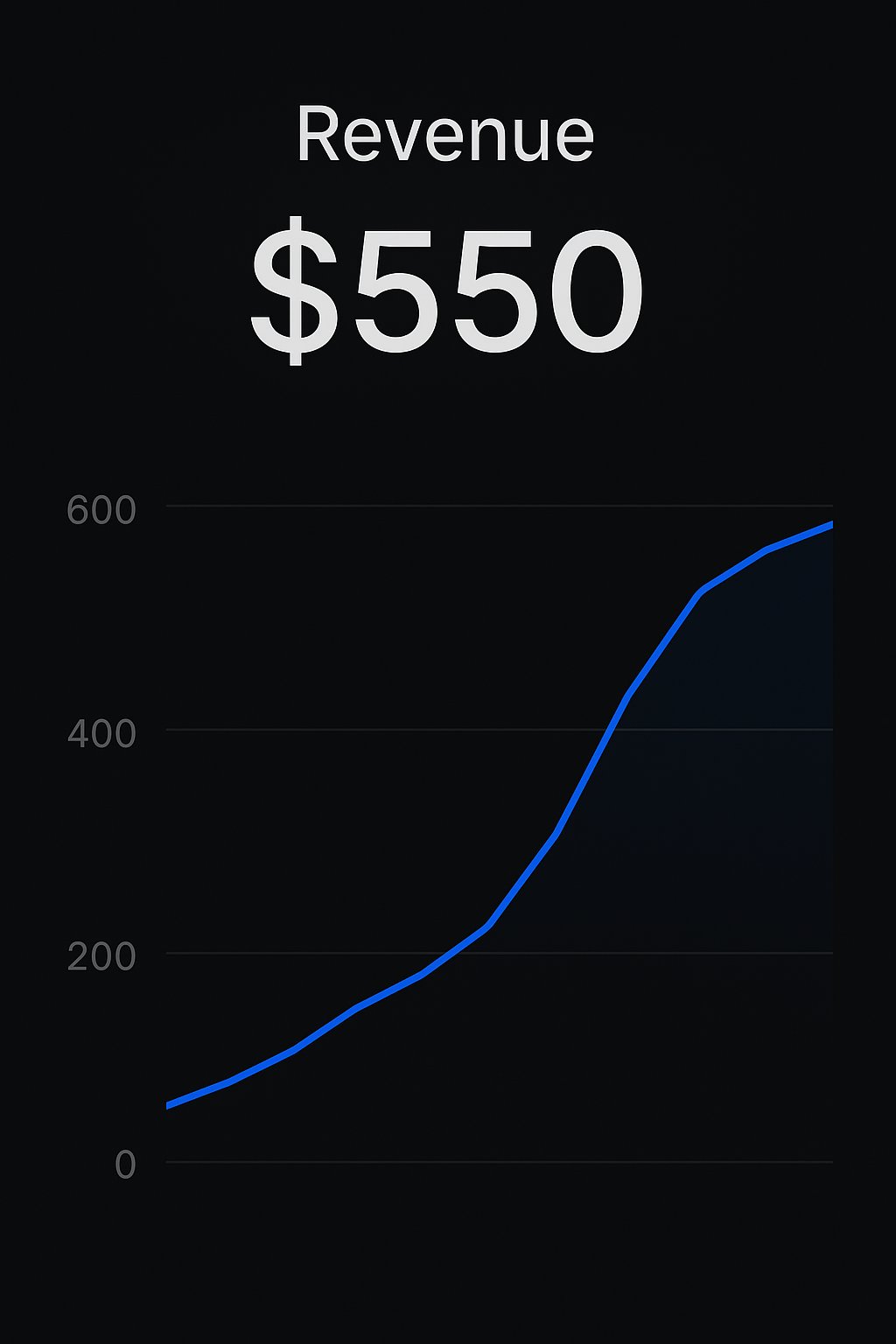

Pengembang Platform Replit Mewujudkan Monetisasi Aplikasi: Dua pengembang berbagi kisah sukses membangun dan menjual aplikasi AI melalui platform Replit. Seorang pengembang menggunakan CreateMVPs.app untuk mendapatkan pendapatan pertamanya sebesar $550; pengembang lain menjual aplikasi yang dibangun dalam sehari seharga $4700 dan mendapatkan lebih banyak tawaran proyek. Ini menunjukkan potensi platform seperti Replit dalam memberdayakan pengembang untuk membangun dan mengkomersialkan aplikasi AI dengan cepat. (Sumber: amasad, amasad)

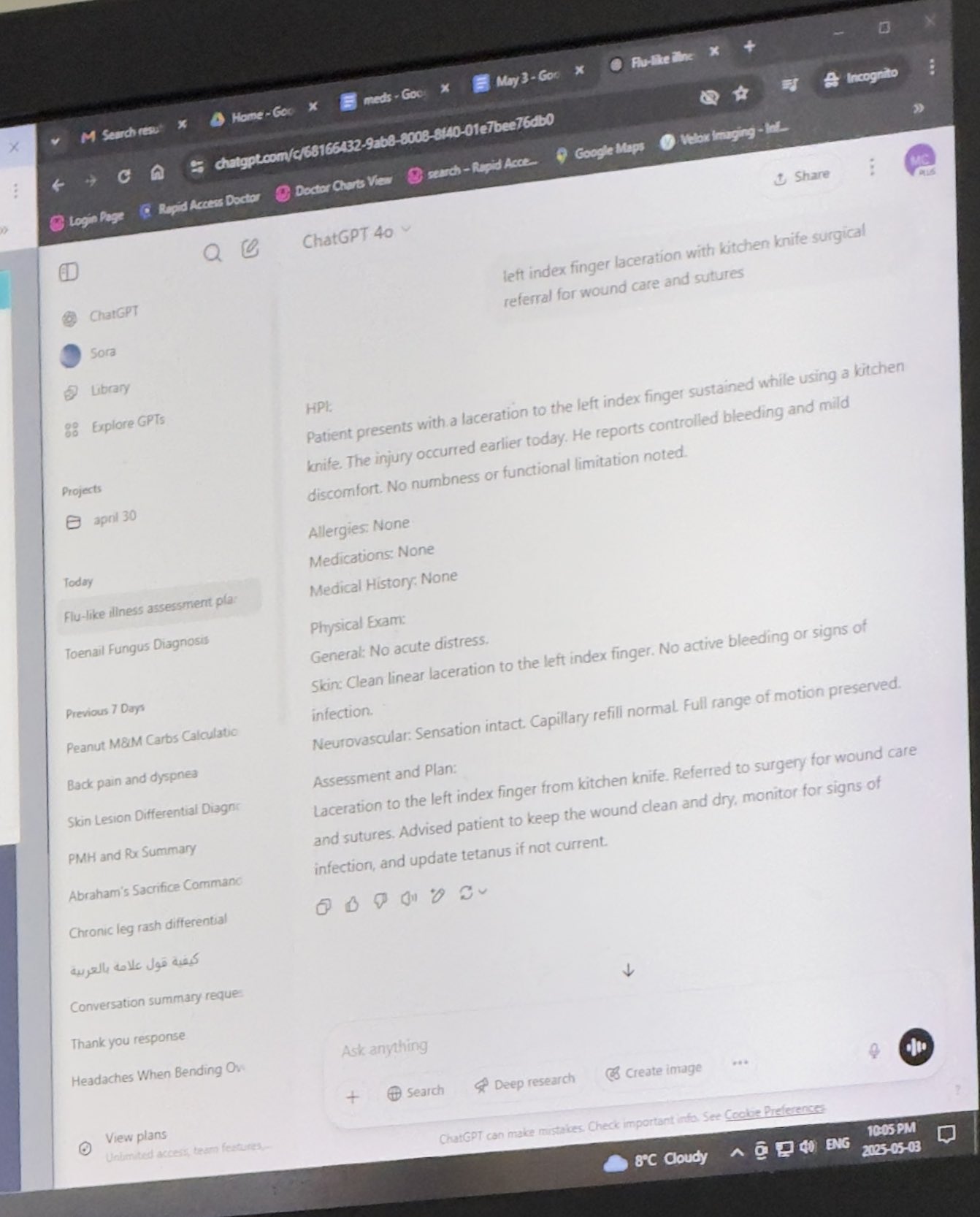

ChatGPT Edu Diterapkan di Icahn School of Medicine at Mount Sinai: Icahn School of Medicine at Mount Sinai mengumumkan penyediaan layanan ChatGPT Edu untuk semua mahasiswa kedokteran dan pascasarjana. Ini menandai masuknya produk edisi pendidikan OpenAI ke institusi pendidikan kedokteran terkemuka, bertujuan untuk memanfaatkan AI guna membantu pendidikan dan penelitian kedokteran. Video mendemonstrasikan skenario aplikasinya. (Sumber: gdb)

Kerugian Berkelanjutan Industri Modal Ventura Menarik Perhatian: Sam Altman menyatakan kebingungannya terhadap fenomena industri modal Ventura (VC) yang secara keseluruhan merugi dalam jangka panjang namun tetap dapat terus memperoleh investasi dari limited partner (LP). Dia berpendapat bahwa meskipun berinvestasi di dana teratas adalah bijaksana, fenomena kerugian berkelanjutan di seluruh industri patut direnungkan penyebab di baliknya dan motivasi LP. (Sumber: sama)

🌟 Komunitas

Diskusi Dampak AI terhadap Pekerjaan dan Pendidikan: Komunitas membahas potensi dampak otomatisasi AI terhadap model kerja yang ada (antarmuka keyboard-mouse-layar), serta bagaimana pendidik harus menanggapi chatbot AI. Pandangan menyatakan bahwa guru tidak boleh melarang siswa menggunakan alat seperti ChatGPT, melainkan harus mengajarkan cara menggunakan AI ini secara efektif dan bertanggung jawab, membina literasi AI siswa dan kemampuan praktik terbaik. (Sumber: NandoDF, NandoDF)

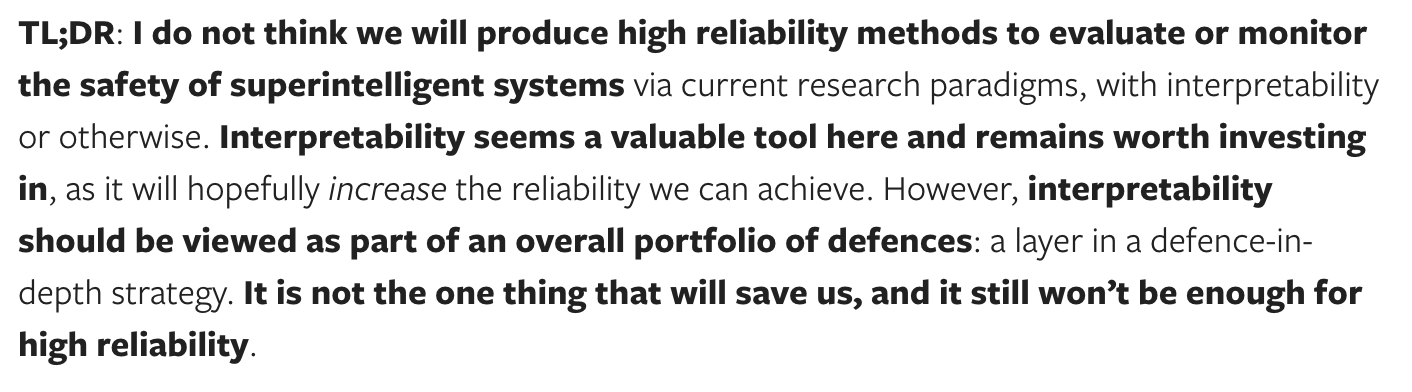

Diskusi Interpretasi dan Keamanan AI: Dario Amodei menekankan urgensi interpretasi model AI, menganggap pemahaman cara kerja model sangat penting. Neel Nanda mengajukan pandangan berbeda, berpendapat bahwa meskipun investasi dalam interpretasi itu baik, kepentingannya tidak boleh terlalu ditekankan dibandingkan metode keamanan lainnya. Jalur untuk menjamin AI yang kuat secara andal tidak hanya melalui interpretasi; itu harus menjadi bagian dari kombinasi langkah-langkah keamanan. (Sumber: bookwormengr)

Diskusi Kompleksitas RLHF dan Fenomena “Menjilat” Model: Nathan Lambert dkk. membahas kompleksitas dan pentingnya Reinforcement Learning from Human Feedback (RLHF), serta fenomena “menjilat” (sycophancy) model yang dihasilkannya (seperti GPT-4o-simp). Artikel berpendapat bahwa RLHF sangat penting untuk penyelarasan model tetapi prosesnya berantakan. Pengguna sering tidak memahami kompleksitasnya, menyebabkan kesalahpahaman atau ketidakpuasan terhadap perilaku model (seperti reaksi balik di LMArena). Memahami tantangan inheren RLHF sangat penting untuk mengevaluasi dan meningkatkan model. (Sumber: natolambert, aidangomez, natolambert)

Potensi Dampak AI terhadap Kemampuan Kognitif dan Cara Berpikir Manusia: Komunitas mengeksplorasi potensi dampak AI terhadap pemikiran manusia. Satu kekhawatiran adalah ketergantungan berlebihan pada AI akan menyebabkan penurunan kemampuan kognitif (malas membaca, melemahnya pemikiran kritis). Pandangan lain berpendapat bahwa jika AI dapat memberikan informasi dan penilaian yang lebih akurat, ia justru dapat meningkatkan tingkat kognitif kelompok orang yang kemampuan berpikirnya lebih lemah atau rentan terhadap informasi yang salah, berfungsi sebagai “peningkatan kognitif” dan membantu membuat keputusan yang lebih baik. Sementara itu, ada juga diskusi bahwa perkembangan AI mungkin memungkinkan kita memahami kesadaran lebih dalam, bahkan menemukan bahwa beberapa orang mungkin hanya mensimulasikan kesadaran. (Sumber: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Diskusi Etika dan Skenario Aplikasi AI: Diskusi menyangkut aplikasi AI di bidang medis, hukum, dll. Ada pengguna yang berbagi kasus dokter menggunakan ChatGPT dalam diagnosis, memicu diskusi tentang aplikasi AI dalam skenario profesional. Sementara itu, ada juga pertimbangan etis tentang penggunaan AI untuk penulisan bayangan (ghostwriting), terutama ketika penulis sendiri mengalami kesulitan. Selain itu, ada kekhawatiran tentang potensi menyesatkan dan risiko dari konten yang dihasilkan AI (seperti buku tentang ADHD). (Sumber: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Kemajuan Robot yang Digerakkan AI: Menampilkan beberapa robot yang digerakkan AI: robot yang dapat bermain ping pong yang dikembangkan oleh Google DeepMind, anjing robot yang dipamerkan di pameran, robot yang digunakan untuk pemasangan berlian, drone yang terinspirasi burung yang dapat melompat untuk lepas landas, pahat mekanis yang digunakan untuk kreasi seni, serta video robot humanoid Unitree G1 berjalan di mal. Ini menunjukkan kemajuan AI dalam kontrol, persepsi, dan interaksi robot. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Masa Depan AI dan Ilmu Humaniora & Sosial: Mengutip pandangan artikel The New Yorker, membahas dampak AI pada ilmu humaniora. Artikel berpendapat bahwa AI tidak dapat menyentuh “keakuan” (me-ness) manusia dan pengalaman manusia yang unik, tetapi pada saat yang sama menunjukkan bahwa AI, melalui penyusunan ulang dan representasi tulisan kolektif manusia (arsip), mampu mensimulasikan sebagian besar dari apa yang kita harapkan dari individu manusia, yang memberikan tantangan dan dimensi pemikiran baru bagi ilmu humaniora. (Sumber: NandoDF)

💡 Lain-lain

Alat Bantu AI untuk Peningkatan Diri: Pengguna Reddit berbagi pengalaman sukses menggunakan ChatGPT sebagai pelatih kebugaran dan nutrisi pribadi. Melalui AI, mereka menyusun rencana latihan, rencana diet (menggabungkan keto, latihan kekuatan, puasa, dll.), bahkan mendapatkan saran makronutrien saat memesan makanan, dan akhirnya mencapai hasil yang lebih baik daripada pelatih manusia berbayar. Ini menunjukkan potensi AI dalam bimbingan yang dipersonalisasi dan bantuan hidup. (Sumber: Reddit r/ChatGPT)

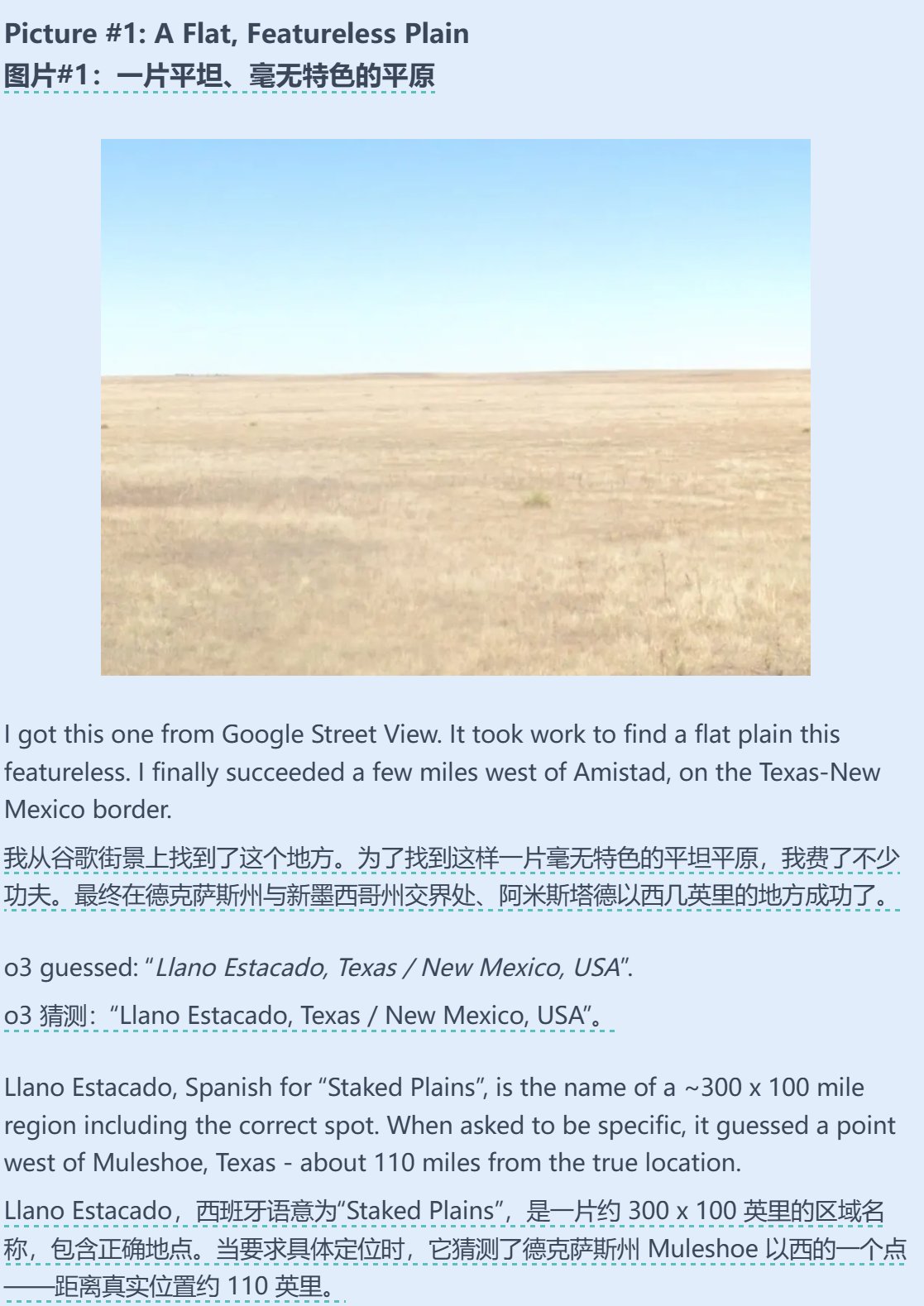

Kombinasi AI dan Kemampuan Menebak Geografi: Sam Altman me-retweet dan mengomentari artikel pengujian tentang kemampuan AI (kemungkinan o3) yang menakjubkan dalam Geoguessr (permainan menebak geografi). Bahkan ketika informasi gambar sangat minim (seperti hanya rambu yang kabur atau bahkan warna gradien murni), AI dapat menyertakan jawaban yang benar dalam pilihan, menunjukkan kemampuan pengenalan gambar, pencocokan pola, dan penalaran pengetahuan geografis yang kuat. (Sumber: op7418)

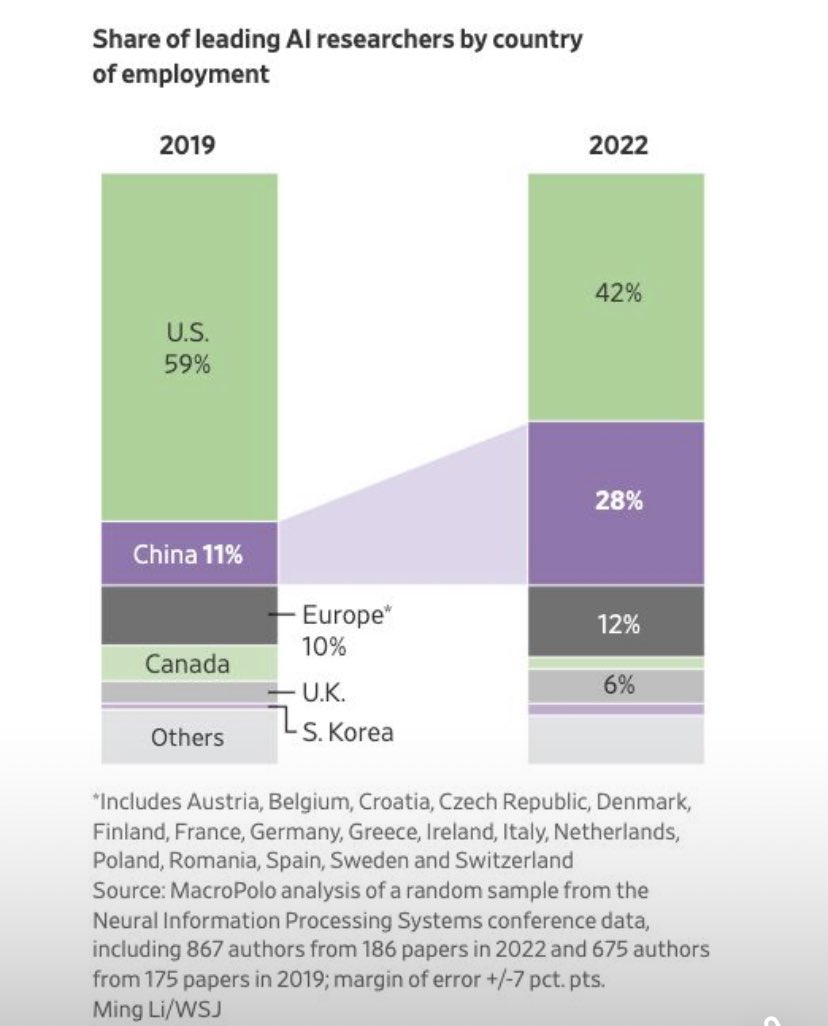

Tren Mobilitas Peneliti di Bidang AI: Grafik menunjukkan perubahan distribusi negara tempat kerja peneliti terkemuka di bidang AI. Proporsi peneliti yang bekerja di Amerika Serikat menurun, sementara proporsi yang bekerja di Tiongkok meningkat secara signifikan. Komentar komunitas menunjukkan bahwa, dengan mempertimbangkan peningkatan peluang penelitian lokal di Tiongkok serta potensi arus balik talenta, kesenjangan sebenarnya mungkin lebih besar dari yang ditunjukkan grafik, mencerminkan perubahan lanskap persaingan talenta AI global. (Sumber: teortaxesTex, bookwormengr)