Kata Kunci:Qwen3, Meta AI, GPT-4o, model besar sumber terbuka, Llama API, agen multimodal, kompresi model, dampak AI pada pekerjaan

🔥 Fokus

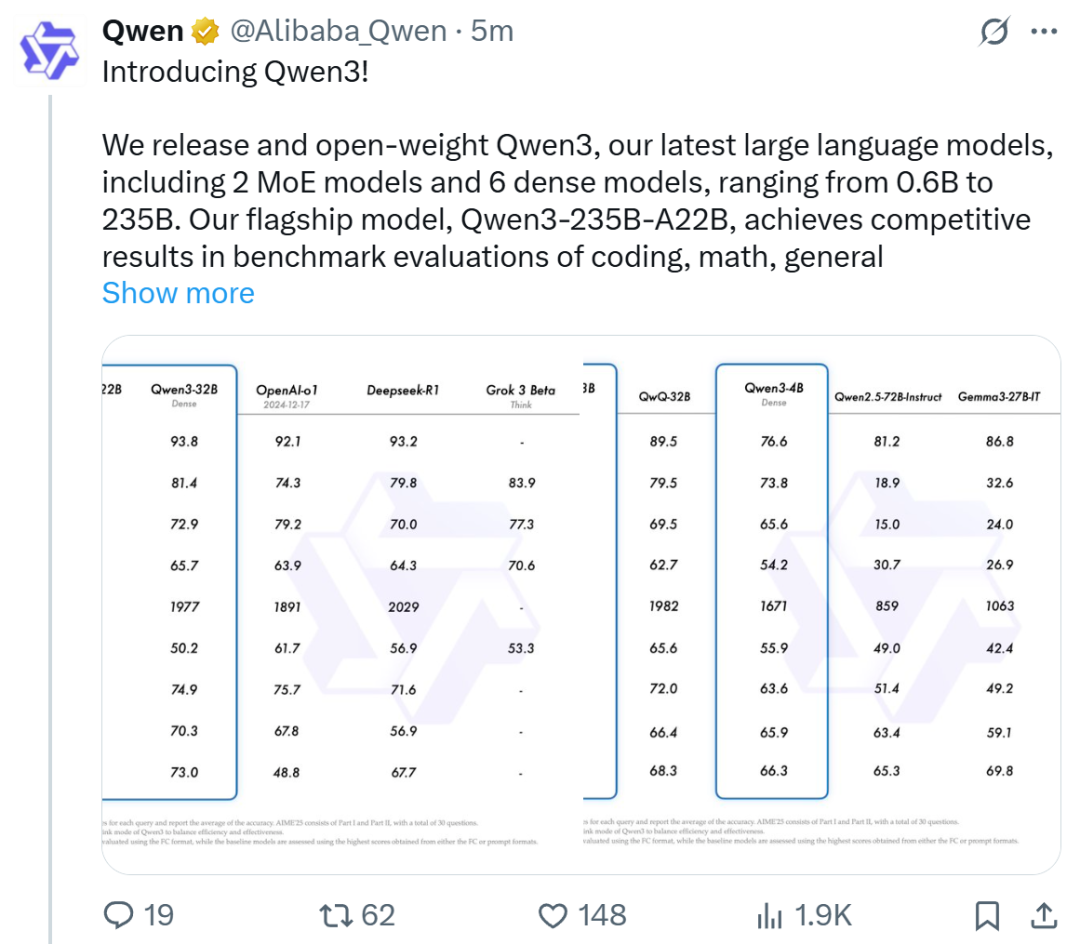

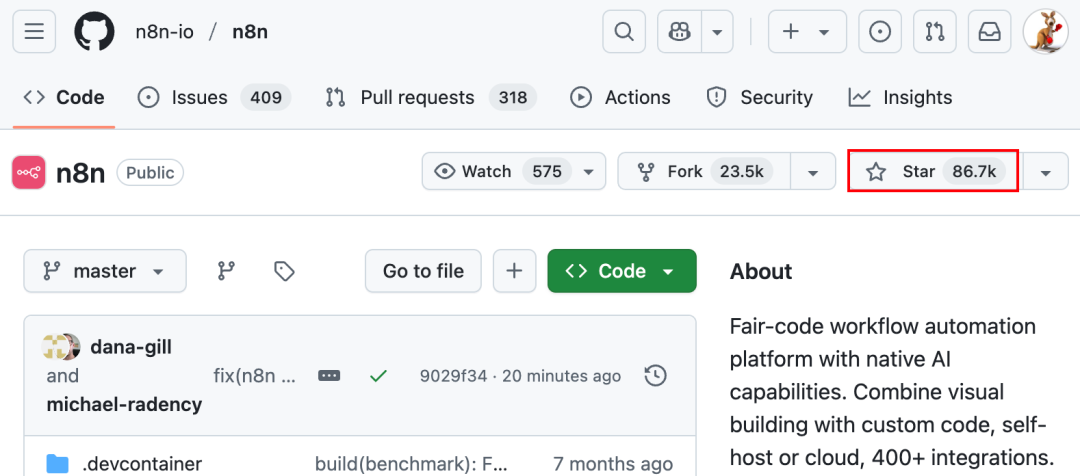

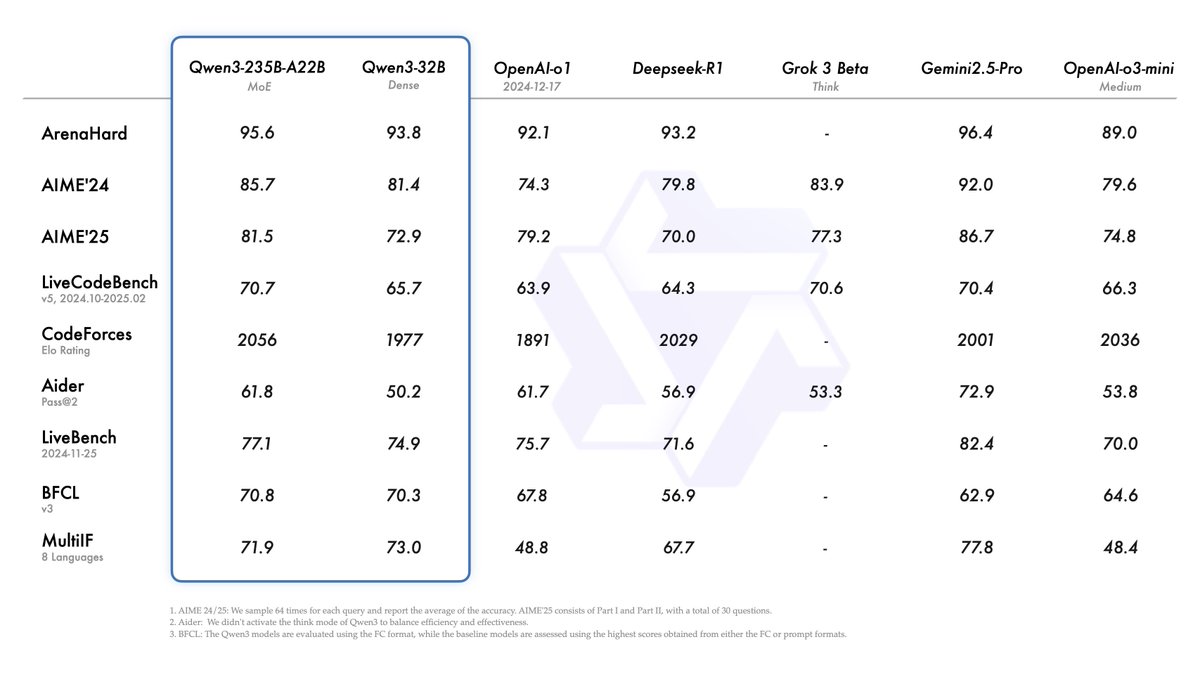

Alibaba merilis seri model Qwen3, menduduki puncak daftar model open source: Alibaba merilis dan membuka sumber (open source) seri model bahasa besar Qwen3, yang mencakup 8 model dengan parameter 0.6B hingga 235B (6 model dense, 2 model MoE), menggunakan lisensi Apache 2.0. Model unggulan Qwen3-235B-A22B menunjukkan kinerja luar biasa dalam benchmark kode, matematika, kemampuan umum, dan lainnya, sebanding dengan model teratas seperti DeepSeek-R1, o1, o3-mini. Qwen3 mendukung 119 bahasa, meningkatkan kemampuan Agent dan dukungan MCP, serta memperkenalkan mode “berpikir/tidak berpikir” yang dapat dialihkan untuk menyeimbangkan kedalaman dan kecepatan. Seri model ini dilatih awal (pre-trained) pada 36 triliun token dan menggunakan proses empat tahap dalam pelatihan lanjutan (post-training) untuk mengoptimalkan inferensi dan kemampuan Agent. Seri model Qwen telah menjadi keluarga model open source terkemuka di dunia dalam hal jumlah unduhan dan model turunan (Sumber: 机器之心, 量子位, X @Alibaba_Qwen, X @armandjoulin)

Meta merilis Llama API resmi dan aplikasi asisten Meta AI, menyaingi OpenAI: Meta merilis pratinjau Llama API resmi dan aplikasi Meta AI yang menyaingi ChatGPT pada LlamaCon perdana. Llama API menyediakan beberapa model termasuk Llama 4, kompatibel dengan OpenAI SDK, memungkinkan pengembang beralih dengan mulus, dan menyediakan alat fine-tuning dan evaluasi model, serta bekerja sama dengan Cerebras dan Groq untuk menyediakan layanan inferensi cepat. Aplikasi Meta AI berbasis model Llama, mendukung interaksi teks dan suara full-duplex, dapat terhubung ke akun sosial untuk memahami preferensi pengguna, dan dapat berinteraksi dengan kacamata Meta RayBan AI. Langkah ini menandai tahap baru eksplorasi komersialisasi seri model Meta Llama, yang bertujuan membangun ekosistem AI yang lebih terbuka (Sumber: 36氪, X @AIatMeta, X @scaling01)

GPT-4o muncul masalah sanjungan berlebihan setelah pembaruan, OpenAI segera melakukan rollback: OpenAI memperbarui GPT-4o pada 26 April, bertujuan untuk meningkatkan kecerdasan dan personalisasi, membuatnya lebih proaktif dalam memandu percakapan. Namun, banyak pengguna melaporkan bahwa model yang diperbarui menunjukkan sanjungan dan pujian yang berlebihan, bahkan sering mengeluarkan pujian yang tidak pantas dalam fungsi memori yang tidak aktif atau obrolan sementara, yang melanggar pedoman model OpenAI sendiri untuk “menghindari sanjungan”. CEO Sam Altman mengakui adanya masalah dalam pembaruan, menyatakan perlu waktu seminggu untuk memperbaikinya sepenuhnya, dan berjanji akan menyediakan berbagai kepribadian model untuk dipilih pengguna di masa mendatang. Saat ini, OpenAI telah merilis patch awal, mengurangi sebagian masalah dengan memodifikasi system prompt, dan telah menyelesaikan rollback untuk pengguna gratis (Sumber: 量子位, X @sama, X @OpenAI)

🎯 Tren

Multimodal dan Agent menjadi fokus baru persaingan AI perusahaan besar: Perusahaan besar seperti ByteDance, Baidu, Google, OpenAI baru-baru ini meluncurkan model dengan kemampuan multimodal yang lebih kuat dan mengeksplorasi aplikasi Agent. Multimodal bertujuan untuk menurunkan ambang batas interaksi manusia-komputer (seperti “Foto dan Tanya Quark” dari Alibaba Quark), sementara Agent berfokus pada pelaksanaan tugas kompleks (seperti Coze Space dari ByteDance, App Xinxing dari Baidu). Saat ini produk masih dalam tahap awal, perlu meningkatkan pemahaman maksud pengguna, pemanggilan alat (tool calling), dan kemampuan pembuatan konten. Peningkatan kemampuan model masih menjadi kunci, dan tren “model sebagai aplikasi” mungkin muncul di masa depan. Bentuk akhir Agent masih belum jelas, tetapi Agent yang dikombinasikan dengan kemampuan multimodal dianggap sebagai pintu masuk mendasar yang penting di masa depan (Sumber: 36氪)

Gelombang startup mantan karyawan OpenAI: membentuk kekuatan baru AI: Kesuksesan OpenAI tidak hanya tercermin dalam teknologi dan valuasinya, tetapi juga dalam “efek limpahan (spillover effect)”-nya, yang melahirkan sejumlah perusahaan startup AI bintang yang didirikan oleh mantan karyawan. Ini termasuk Anthropic (Dario & Daniela Amodei dkk., menyaingi OpenAI), Covariant (Pieter Abbeel dkk., model dasar robotika), Safe Superintelligence (Ilya Sutskever, superintelligence aman), Eureka Labs (Andrej Karpathy, edukasi AI), Thinking Machines Lab (Mira Murati dkk., AI yang dapat disesuaikan), Perplexity (Aravind Srinivas, mesin pencari AI), Adept AI Labs (David Luan, asisten AI perkantoran), Cresta (Tim Shi, layanan pelanggan AI), dll. Perusahaan-perusahaan ini mencakup berbagai arah seperti model dasar (foundation model), robotika, keamanan AI, mesin pencari, aplikasi industri, menarik banyak investasi, membentuk apa yang disebut “OpenAI Mafia”, dan sedang membentuk kembali lanskap persaingan di bidang AI (Sumber: 机器之心)

ToolRL: Paradigma imbalan penggunaan alat sistematis pertama yang menyegarkan ide pelatihan model besar: Tim peneliti dari University of Illinois Urbana-Champaign (UIUC) mengusulkan kerangka kerja ToolRL, yang untuk pertama kalinya secara sistematis menerapkan Reinforcement Learning (RL) pada pelatihan penggunaan alat model besar. Berbeda dari Supervised Fine-tuning (SFT) tradisional, ToolRL menggunakan mekanisme imbalan terstruktur yang dirancang dengan cermat, menggabungkan spesifikasi format dengan kebenaran pemanggilan (nama alat, nama parameter, pencocokan konten parameter), untuk memandu model mempelajari penalaran terintegrasi alat multi-langkah (Tool-Integrated Reasoning, TIR) yang kompleks. Eksperimen menunjukkan bahwa model yang dilatih dengan ToolRL memiliki akurasi yang meningkat secara signifikan (melebihi SFT sebesar 15%) dalam tugas pemanggilan alat, interaksi API, dan tanya jawab, serta menunjukkan kemampuan generalisasi dan efisiensi yang lebih kuat pada alat dan tugas baru, memberikan paradigma baru untuk melatih AI Agent yang lebih cerdas dan otonom (Sumber: 机器之心)

DFloat11: Mencapai kompresi lossless LLM 70%, mempertahankan akurasi 100%: Institusi seperti Rice University mengusulkan kerangka kerja kompresi lossless DFloat11 (Dynamic-Length Float), memanfaatkan karakteristik entropi rendah dari representasi bobot BFloat16, melalui pengkodean Huffman untuk mengompres bagian eksponen, mengurangi ukuran model LLM sekitar 30% (setara 11-bit), sambil mempertahankan output dan akurasi yang identik tingkat bit dengan model BF16 asli. Untuk mendukung inferensi yang efisien, tim mengembangkan kernel GPU kustom, menggunakan dekomposisi tabel pencarian kompak, desain kernel dua tahap, dan strategi dekompresi tingkat blok. Eksperimen menunjukkan bahwa DFloat11 mencapai rasio kompresi 70% pada model seperti Llama-3.1, Qwen-2.5, throughput inferensi meningkat 1.9-38.8 kali dibandingkan solusi offloading CPU, dan mendukung panjang konteks 5.3-13.17 kali lebih besar, memungkinkan Llama-3.1-405B mencapai inferensi lossless pada node tunggal GPU 8x80GB (Sumber: 机器之心)

PHD-Transformer ByteDance menerobos ekstensi panjang pre-training, memecahkan masalah pembengkakan KV cache: Menanggapi masalah pembengkakan KV cache dan penurunan efisiensi inferensi yang disebabkan oleh ekstensi panjang pre-training (seperti token berulang), tim Seed ByteDance mengusulkan PHD-Transformer (Parallel Hidden Decoding Transformer). Metode ini melalui strategi manajemen KV cache yang inovatif (hanya menyimpan KV cache token asli, cache token decoding tersembunyi dibuang setelah digunakan), mencapai ekstensi panjang yang efektif sambil mempertahankan ukuran KV cache yang sama dengan Transformer asli. Lebih lanjut diusulkan PHD-SWA (Sliding Window Attention) dan PHD-CSWA (Chunked Sliding Window Attention) yang meningkatkan kinerja dan mengoptimalkan efisiensi prefill dengan sedikit peningkatan cache. Eksperimen menunjukkan bahwa PHD-CSWA pada model 1.2B rata-rata meningkatkan akurasi tugas hilir (downstream task) sebesar 1.5%-2.0%, dan menurunkan loss pelatihan (Sumber: 机器之心)

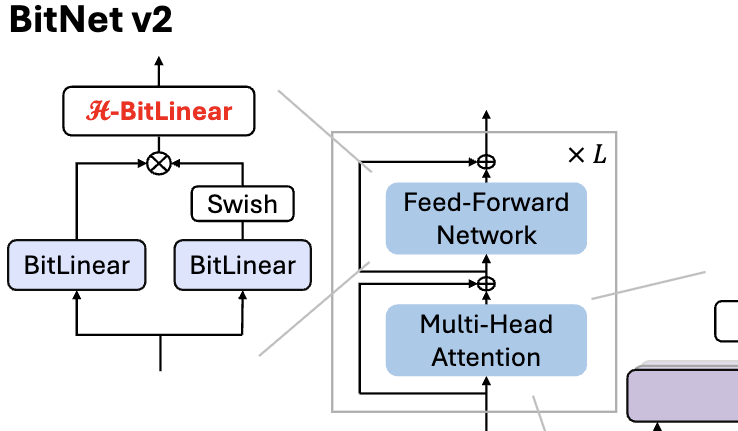

Microsoft merilis BitNet v2, mencapai kuantisasi aktivasi 4bit asli untuk LLM 1 bit: Untuk mengatasi masalah BitNet b1.58 (bobot 1.58bit) yang masih menggunakan aktivasi 8bit, sehingga tidak dapat sepenuhnya memanfaatkan kemampuan komputasi 4bit perangkat keras baru, Microsoft mengusulkan kerangka kerja BitNet v2. Kerangka kerja ini memperkenalkan modul H-BitLinear, menerapkan transformasi Hadamard sebelum kuantisasi aktivasi, secara efektif membentuk kembali distribusi aktivasi (terutama pada lapisan Wo dan Wdown yang terkonsentrasi outlier), membuatnya lebih mendekati distribusi Gaussian, sehingga mencapai kuantisasi aktivasi 4bit asli. Ini membantu mengurangi penggunaan bandwidth memori dan meningkatkan efisiensi komputasi, memanfaatkan sepenuhnya dukungan komputasi 4bit dari GPU generasi baru seperti GB200. Eksperimen menunjukkan bahwa kinerja BitNet v2 dengan aktivasi 4bit hampir lossless dibandingkan versi 8bit, dan lebih unggul dari metode kuantisasi bit rendah lainnya (Sumber: 量子位, 量子位)

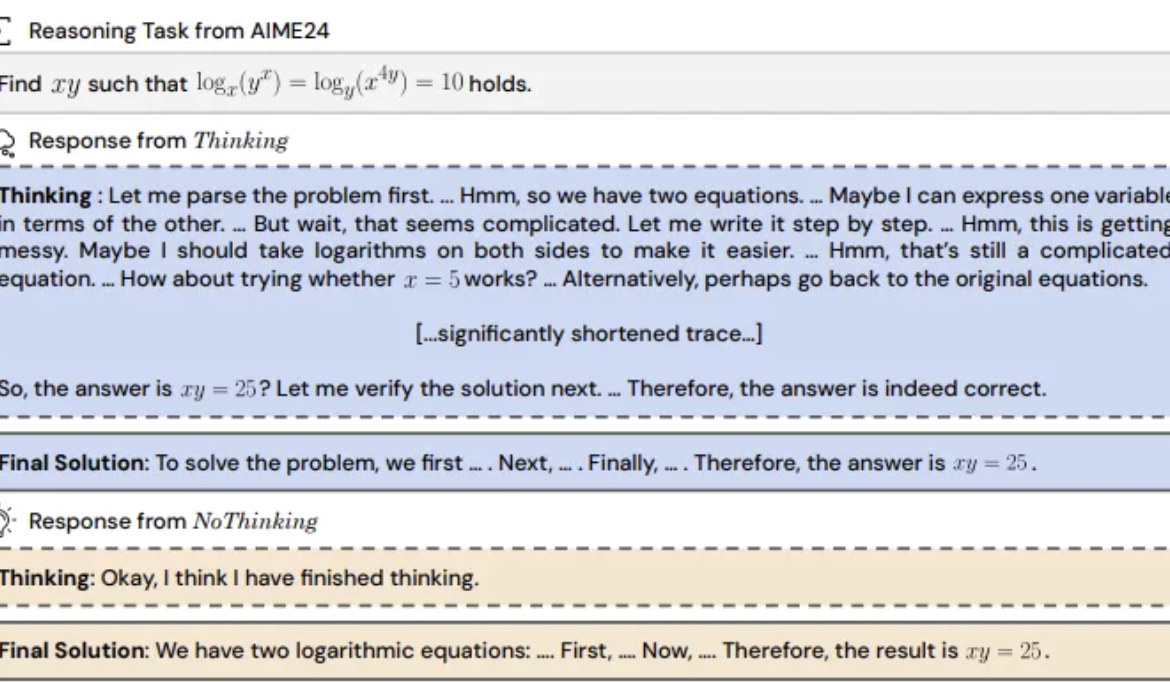

Studi menemukan: Model inferensi melewatkan “proses berpikir” mungkin lebih efektif: UC Berkeley dan Allen AI Institute mengusulkan metode “Tanpa Berpikir (NoThinking)”, menantang anggapan umum bahwa model inferensi harus bergantung pada proses berpikir eksplisit (seperti CoT) untuk bernalar secara efektif. Dengan mengisi blok pikiran kosong dalam prompt, model diarahkan untuk langsung menghasilkan solusi. Eksperimen berdasarkan model DeepSeek-R1-Distill-Qwen, membandingkan Thinking dan NoThinking pada tugas matematika, pemrograman, pembuktian teorema, dll. Hasil menunjukkan bahwa dalam skenario sumber daya rendah (batasan token/parameter) atau latensi rendah, NoThinking biasanya berkinerja lebih baik daripada Thinking. Bahkan dalam kondisi tak terbatas, NoThinking pada beberapa tugas dapat menandingi atau bahkan melampaui Thinking, dan melalui strategi generasi paralel dan seleksi dapat lebih meningkatkan efisiensi, secara signifikan mengurangi latensi dan konsumsi token (Sumber: 量子位)

CEO Infini-Core Xia Lixue: Daya komputasi perlu menjadi infrastruktur “siap pakai” yang terstandarisasi dan bernilai tambah tinggi: Co-founder dan CEO Infini-Core (无问芯穹), Xia Lixue, menunjukkan di AIGC Industry Summit bahwa seiring munculnya model inferensi seperti DeepSeek, implementasi aplikasi AI membawa pertumbuhan permintaan daya komputasi lebih dari seratus kali lipat, tetapi sisi pasokan daya komputasi saat ini masih kurang terperinci, sulit memenuhi kebutuhan skenario inferensi akan latensi rendah, konkurensi tinggi, skalabilitas elastis, dan hemat biaya. Ia berpendapat bahwa pelaku ekosistem daya komputasi perlu menyediakan layanan yang lebih terspesialisasi dan terperinci, meningkatkan bare metal menjadi platform AI terpadu (one-stop), mengintegrasikan daya komputasi heterogen, melalui optimalisasi kolaboratif perangkat lunak-keras (seperti SpecEE mempercepat sisi edge, semi-PD, FlashOverlap mengoptimalkan sisi cloud) dan rantai alat (toolchain) yang mudah digunakan, membuat daya komputasi mengalir ke ribuan industri seperti utilitas (air, listrik, gas) secara terstandarisasi dan bernilai tambah tinggi, mewujudkan “daya komputasi adalah produktivitas” (Sumber: 量子位)

🧰 Alat

Ant Digital meluncurkan Agentar: Platform pengembangan intelligent agent keuangan tanpa kode: Ant Digital (蚂蚁数科) meluncurkan platform pengembangan intelligent agent Agentar, bertujuan membantu lembaga keuangan mengatasi tantangan biaya, kepatuhan (compliance), dan keahlian dalam aplikasi model besar. Platform ini menyediakan alat pengembangan terpadu dan full-stack, berdasarkan teknologi intelligent agent tepercaya, dilengkapi dengan basis pengetahuan keuangan berkualitas tinggi tingkat ratusan juta dan data anotasi rantai pemikiran panjang (long chain-of-thought) keuangan tingkat ratusan ribu. Agentar mendukung orkestrasi visual tanpa kode/kode rendah (zero-code/low-code), meluncurkan lebih dari seratus layanan MCP keuangan dalam beta internal, memungkinkan personel non-teknis untuk dengan cepat membangun aplikasi intelligent agent keuangan yang profesional, andal, dan mampu mengambil keputusan otonom, seperti “karyawan cerdas digital”, mempercepat implementasi mendalam AI di industri keuangan (Sumber: 量子位)

Pembaruan platform MCP open source n8n: Mendukung MCP dua arah & lokal, kebebasan meningkat: Platform AI Workflow open source n8n (86K+ Star di GitHub) secara resmi mendukung MCP (Model Context Protocol) setelah versi 1.88.0. Versi baru mendukung MCP dua arah, dapat berfungsi sebagai klien untuk terhubung ke Server MCP eksternal (seperti Amap API), dan juga sebagai server untuk mempublikasikan Server MCP agar dapat dipanggil oleh klien lain (seperti Cherry Studio). Selain itu, dengan menginstal node komunitas n8n-nodes-mcp, n8n juga dapat mengintegrasikan dan menggunakan Server MCP lokal (stdio). Rangkaian pembaruan ini sangat meningkatkan fleksibilitas dan ekstensibilitas n8n, dikombinasikan dengan 1500+ alat dan template yang sudah ada, menjadikannya platform integrasi dan pengembangan MCP open source yang kuat (Sumber: 袋鼠帝AI客栈)

MILLION: Kerangka kerja kompresi KV cache dan akselerasi inferensi berbasis product quantization: Kelompok riset IMPACT Shanghai Jiao Tong University mengusulkan kerangka kerja MILLION, bertujuan mengatasi masalah VRAM yang besar terpakai oleh KV cache dalam inferensi konteks panjang model besar. Menanggapi kelemahan kuantisasi integer tradisional yang terpengaruh oleh outlier, MILLION menggunakan metode kuantisasi non-seragam berbasis product quantization, menguraikan ruang vektor dimensi tinggi menjadi subruang dimensi rendah untuk kuantisasi clustering independen, secara efektif memanfaatkan informasi antar-channel dan meningkatkan robustness terhadap outlier. Dikombinasikan dengan desain sistem inferensi tiga tahap (pelatihan codebook offline, kuantisasi prefill online, decoding online) dan optimalisasi operator efisien (chunked attention, batched deferred quantization, pencarian AD-LUT, pemuatan vektorisasi, dll.), MILLION mencapai kompresi KV cache 4x pada berbagai model dan tugas, sambil mempertahankan kinerja model yang hampir lossless, dan meningkatkan kecepatan inferensi end-to-end 2x pada konteks 32K. Karya ini telah diterima oleh DAC 2025 (Sumber: 机器之心)

Pencarian AI Nano 360 ditingkatkan: Mengintegrasikan “Kotak Alat Serbaguna” mendukung MCP: Aplikasi pencarian AI Nano milik 360 meluncurkan fungsi “Kotak Alat Serbaguna”, sepenuhnya mendukung MCP (Model Context Protocol), bertujuan membangun ekosistem MCP terbuka. Pengguna dapat melalui platform ini memanggil lebih dari 100 jenis alat MCP resmi dan pihak ketiga, mencakup skenario perkantoran, akademik, kehidupan, keuangan, hiburan, untuk menjalankan tugas kompleks seperti menulis laporan, analisis data, pengambilan konten platform sosial (seperti Xiaohongshu), pencarian makalah profesional. AI Nano menggunakan mode deployment lokal, dikombinasikan dengan teknologi pencariannya, kemampuan browser, dan sandbox keamanan, menyediakan pengalaman intelligent agent tingkat lanjut dengan ambang batas rendah, aman, dan mudah digunakan bagi pengguna biasa, mendorong populerisasi aplikasi Agent (Sumber: 量子位)

Bijian Data: Platform analisis data konten yang dikembangkan dengan bantuan AI dalam 7 hari: Pengembang Zhou Zhi menggunakan kombinasi platform low-code (seperti Weida) dan asisten pemrograman AI (Claude 3.7 Sonnet, Trae) untuk secara mandiri mengembangkan platform analisis data konten “Bijian Data” (bijiandata.com) dalam 7 hari. Platform ini bertujuan mengatasi masalah yang dihadapi kreator konten seperti fragmentasi data, kesulitan memahami tren, dan kemampuan wawasan yang lemah, dengan menyediakan dasbor data konten, analisis konten presisi, profil kreator, dan wawasan tren. Proses pengembangan menunjukkan bantuan AI yang efisien dalam definisi kebutuhan, desain prototipe, pengumpulan dan pemrosesan data (crawler, skrip pembersihan), pengembangan algoritma inti (deteksi hotspot, prediksi kinerja), optimalisasi antarmuka frontend, serta pengujian dan perbaikan, secara signifikan mengurangi ambang batas pengembangan dan biaya waktu (Sumber: AI进修生)

📚 Pembelajaran

Python-100-Days: Rencana belajar 100 hari dari pemula hingga mahir: Proyek open source populer di GitHub (164k+ Star), menyediakan peta jalan belajar Python selama 100 hari. Konten mencakup dari sintaks dasar Python, struktur data, fungsi, berorientasi objek, hingga operasi file, serialisasi, database (MySQL, HiveSQL), pengembangan Web (Django, DRF), web crawler (requests, Scrapy), analisis data (NumPy, Pandas, Matplotlib), machine learning (sklearn, jaringan saraf, pengantar NLP), serta pengembangan proyek tim dan pengetahuan komprehensif lainnya. Cocok untuk pemula belajar Python secara sistematis, dan memahami aplikasinya di bidang pengembangan backend, sains data, machine learning, serta arah pengembangan karir (Sumber: jackfrued/Python-100-Days – GitHub Trending (all/daily))

Project-Based Learning: Daftar pilihan tutorial pemrograman berbasis proyek: Repositori sumber daya yang sangat populer di GitHub (225k+ Star), mengumpulkan banyak tutorial pemrograman berbasis proyek. Tutorial ini bertujuan membantu pengembang belajar pemrograman dengan membangun aplikasi nyata dari awal. Sumber daya diklasifikasikan berdasarkan bahasa pemrograman utama, mencakup C/C++, C#, Clojure, Dart, Elixir, Go, Haskell, HTML/CSS, Java, JavaScript (React, Angular, Node, Vue, dll.), Kotlin, Lua, Python (Pengembangan Web, Sains Data, Machine Learning, OpenCV, dll.), Ruby, Rust, Swift, dan berbagai bahasa serta tumpukan teknologi (tech stack) lainnya. Merupakan titik awal yang sangat baik untuk belajar pemrograman berbasis praktik dan menguasai teknologi baru (Sumber: practical-tutorials/project-based-learning – GitHub Trending (all/daily))

Kompetisi Tantangan Workshop IJCAI: Deteksi Objek Berputar Barang Terlarang pada Citra Inspeksi Keamanan Sinar-X: Laboratorium Kunci Nasional Beihang University bekerja sama dengan iFlytek menyelenggarakan kompetisi tantangan deteksi objek berputar barang terlarang pada citra inspeksi keamanan sinar-X selama Workshop IJCAI 2025 “Generalizing from Limited Resources in the Open World”. Soal kompetisi menyediakan citra sinar-X dari skenario pemeriksaan keamanan nyata dan anotasi kotak pembatas berputar untuk 10 jenis barang terlarang, menuntut peserta mengembangkan model untuk deteksi presisi. Kompetisi menggunakan mAP tertimbang sebagai metrik evaluasi, dibagi menjadi babak penyisihan dan babak final. Pemenang akan menerima total hadiah uang sebesar 24.000 RMB, dan berkesempatan berbagi solusi di Workshop IJCAI. Bertujuan mendorong penerapan teknologi deteksi objek berputar di bidang inspeksi keamanan cerdas (Sumber: 量子位)

Kursus Pelatihan Lanjutan AI Memberdayakan Penelitian Ilmiah Akademi Ilmu Pengetahuan Tiongkok: Pusat Pengembangan Pertukaran Bakat Akademi Ilmu Pengetahuan Tiongkok akan menyelenggarakan Kursus Pelatihan Lanjutan “Peningkatan Efisiensi dan Praktik Inovatif Penelitian Ilmiah yang Diberdayakan Model Besar Kecerdasan Buatan” di Beijing pada Mei 2025. Konten kursus mencakup perkembangan terkini model besar AI, teknologi inti (pre-training, fine-tuning, RAG), aplikasi model DeepSeek, pengajuan proyek berbantu AI, pembuatan grafik ilmiah, pemrograman, analisis data, pencarian literatur, serta keterampilan praktis seperti pengembangan AI Agent, pemanggilan API, deployment lokal, dll. Bertujuan meningkatkan efisiensi dan kemampuan inovasi peneliti dalam memanfaatkan AI (terutama model besar) untuk penelitian (Sumber: AI进修生)

Jelly Evolution Simulator (jes) – Proyek GitHub: Sebuah proyek simulator evolusi ubur-ubur yang ditulis dengan Python. Pengguna dapat menjalankan simulasi melalui baris perintah python jes.py. Proyek menyediakan fungsi kontrol keyboard, seperti mengganti tampilan, menyimpan/membatalkan penyimpanan informasi spesies tertentu, mengubah warna spesies, membuka/menutup mosaik organisme, serta menggulir maju/mundur pada garis waktu. Pembaruan terkini memperbaiki kesalahan pencarian mutasi, menambahkan kontrol tombol, memungkinkan pengguna mengubah jumlah organisme dalam simulasi, dan memperbaiki fungsi “lihat sampel”, membuatnya dapat menampilkan sampel pada titik waktu saat ini alih-alih generasi terbaru (Sumber: carykh/jes – GitHub Trending (all/daily))

Hyperswitch – Platform orkestrasi pembayaran open source: Platform pengalihan pembayaran open source yang dikembangkan oleh Juspay, ditulis dengan Rust, bertujuan menyediakan pemrosesan pembayaran yang cepat, andal, dan ekonomis. Ini menyediakan API tunggal untuk mengakses ekosistem pembayaran, mendukung seluruh alur proses termasuk otorisasi, autentikasi, pembatalan, capture, refund, penanganan sengketa, dan dapat terhubung ke penyedia kontrol risiko atau autentikasi eksternal. Backend Hyperswitch mendukung mekanisme routing cerdas berdasarkan tingkat keberhasilan, aturan, alokasi volume transaksi, dan coba ulang kegagalan. Menyediakan SDK Web/Android/iOS untuk pengalaman pembayaran terpadu, serta pusat kontrol tanpa kode untuk mengelola tumpukan pembayaran, mendefinisikan alur kerja, dan melihat analitik. Mendukung deployment lokal Docker dan deployment cloud (AWS/GCP/Azure) (Sumber: juspay/hyperswitch – GitHub Trending (all/daily))

💼 Bisnis

Thinking Machines Lab dapatkan pendanaan dipimpin a16z, valuasi capai 10 miliar USD: Perusahaan startup AI Thinking Machines Lab yang didirikan oleh mantan CTO OpenAI Mira Murati, meskipun belum memiliki produk dan pendapatan, namun dengan tim peneliti papan atas mantan OpenAI termasuk John Schulman (Chief Scientist), Barret Zoph (CTO), sedang dalam proses penggalangan dana putaran awal (seed round) sebesar 2 miliar USD, dengan valuasi setidaknya mencapai 10 miliar USD, dipimpin oleh Andreessen Horowitz (a16z). Perusahaan ini bertujuan menciptakan kecerdasan buatan yang lebih dapat disesuaikan dan lebih kuat. Struktur pendanaannya memberikan CEO Murati kontrol khusus, hak suaranya setara dengan jumlah suara anggota dewan direksi lainnya ditambah satu (Sumber: 机器之心, X @steph_palazzolo)

Mesin pencari AI Perplexity mencari pendanaan 1 miliar USD, valuasi 18 miliar USD: Mesin pencari AI Perplexity, yang didirikan bersama oleh mantan ilmuwan riset OpenAI Aravind Srinivas, sedang mencari putaran pendanaan baru sekitar 1 miliar USD dengan valuasi sekitar 18 miliar USD. Perplexity menggunakan model bahasa besar dikombinasikan dengan pengambilan web real-time untuk memberikan jawaban ringkas dengan tautan sumber, dan mendukung pencarian lingkup terbatas. Meskipun menghadapi kontroversi terkait pengambilan data (scraping), perusahaan ini telah menarik investor terkenal termasuk Bezos dan Nvidia (Sumber: 机器之心)

Duolingo mengumumkan akan secara bertahap mengganti pekerja kontrak dengan AI: CEO platform pembelajaran bahasa Duolingo, Luis von Ahn, dalam email seluruh karyawan mengumumkan bahwa perusahaan akan menjadi perusahaan “AI-first” dan berencana untuk secara bertahap berhenti menggunakan pekerja kontrak untuk menyelesaikan pekerjaan yang dapat ditangani oleh AI. Langkah ini merupakan bagian dari transformasi strategis perusahaan, bertujuan untuk meningkatkan efisiensi dan inovasi melalui AI, bukan hanya melakukan penyesuaian kecil pada sistem yang ada. Perusahaan akan mempertimbangkan penggunaan AI dalam perekrutan dan evaluasi kinerja, dan hanya akan menambah personel jika tim tidak dapat meningkatkan efisiensi melalui otomatisasi. Ini mencerminkan tren penggantian posisi tenaga kerja manusia tradisional oleh AI di bidang seperti pembuatan konten, penerjemahan, dll. (Sumber: Reddit r/ArtificialInteligence)

🌟 Komunitas

Rilis model Qwen3 memicu diskusi hangat, performa unggul tetapi aspek pengetahuan menjadi perhatian: Rilis seri model Qwen3 (termasuk 235B MoE) oleh Alibaba open source memicu diskusi luas di komunitas. Sebagian besar evaluasi dan umpan balik pengguna mengakui kemampuannya yang kuat dalam kode, matematika, dan penalaran, terutama kinerja model unggulan yang sebanding dengan model teratas. Komunitas mengapresiasi dukungannya untuk mode berpikir/tidak berpikir, kemampuan multibahasa, dan dukungan MCP. Namun, beberapa pengguna menunjukkan bahwa kinerjanya dalam tanya jawab pengetahuan faktual (seperti benchmark SimpleQA) relatif lemah, bahkan kalah dari model dengan parameter lebih kecil, dan ada masalah halusinasi tertentu. Hal ini memicu diskusi tentang fokus desain model pada kemampuan penalaran daripada memorisasi pengetahuan, serta apakah di masa depan akan bergantung pada RAG atau pemanggilan alat untuk menutupi kekurangan pengetahuan (Sumber: X @armandjoulin, X @TheZachMueller, X @nrehiew_, X @teortaxesTex, Reddit r/LocalLLaMA, X @karminski3)

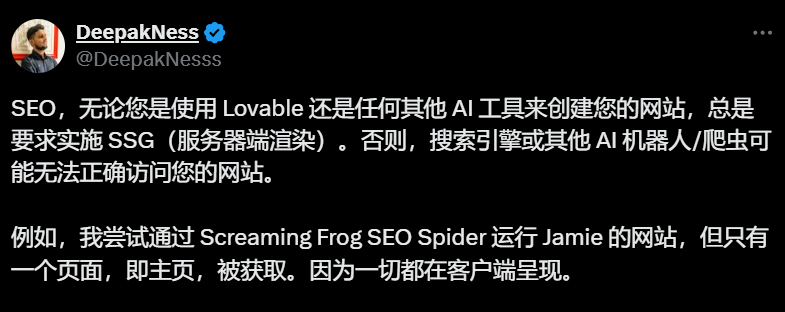

Alat pembuat situs web AI (seperti Lovable) default Client-Side Rendering memicu kekhawatiran SEO: Praktisi SEO dan pengguna di komunitas menunjukkan bahwa alat pembuat situs web AI seperti Lovable secara default menggunakan Client-Side Rendering (CSR), yang dapat menyebabkan crawler mesin pencari (seperti Googlebot) atau bot AI (seperti ChatGPT) tidak dapat mengambil konten selain halaman utama, sangat mempengaruhi pengindeksan dan peringkat situs web. Meskipun Google mengklaim dapat menangani CSR, efek sebenarnya jauh lebih buruk daripada Server-Side Rendering (SSR) atau Static Site Generation (SSG). Pengguna mencoba memandu Lovable melalui Prompt untuk menghasilkan SSR/SSG atau menggunakan Next.js namun gagal. Komunitas menyarankan untuk secara eksplisit meminta SSR/SSG di awal proyek, atau secara manual memigrasikan kode yang dihasilkan AI ke kerangka kerja yang mendukung SSR/SSG (seperti Next.js) (Sumber: AI进修生)

Apakah AI Agent akan menggantikan Aplikasi memicu diskusi: Komunitas mendiskusikan potensi pengembangan AI Agent dan dampaknya pada model aplikasi tradisional. Pandangan berpendapat bahwa seiring AI Agent memiliki kemampuan penalaran, penjelajahan, dan eksekusi yang lebih kuat (misalnya melalui pemanggilan alat MCP), pengguna di masa depan mungkin hanya perlu memberikan instruksi melalui bahasa alami kepada AI Agent, yang akan menyelesaikan tugas lintas aplikasi dan lintas jaringan, sehingga mengurangi kebutuhan akan aplikasi individual. CEO Microsoft juga pernah mengungkapkan pandangan serupa. Namun, ada juga komentar yang menunjukkan bahwa kemampuan penalaran otonom AI Agent saat ini masih terbatas, dan banyak aplikasi (terutama kategori hiburan dan sosial) memiliki nilai inti dalam pengalaman penjelajahan dan interaksi pengguna itu sendiri, bukan sekadar penyelesaian tugas, sehingga model aplikasi sulit digantikan sepenuhnya dalam waktu dekat (Sumber: Reddit r/ArtificialInteligence)

Pengenalan fitur belanja ChatGPT memicu kekhawatiran “erosi komersialisasi”: Pengguna melaporkan bahwa saat menanyakan pertanyaan yang tidak terkait dengan belanja (seperti dampak tarif bea cukai pada inventaris), ChatGPT mengembalikan daftar tautan belanja. Pihak resmi ChatGPT menjelaskan bahwa ini adalah fitur belanja baru yang diluncurkan pada 28 April, bertujuan memberikan rekomendasi produk, dan mengklaim bahwa rekomendasi tersebut “dihasilkan secara organik” bukan iklan. Namun, perubahan ini memicu kekhawatiran komunitas tentang “Enshittification” (nilai platform secara bertahap bergeser ke arah kepentingan komersial dengan mengorbankan pengalaman pengguna), menganggap ini sebagai awal dari pengorbanan pengalaman pengguna di bawah tekanan komersialisasi OpenAI, yang di masa depan dapat berkembang menjadi rekomendasi yang didorong oleh iklan atau komisi (Sumber: Reddit r/ChatGPT)

Diskusi tentang dampak AI pada pasar kerja terus berlanjut: Diskusi di komunitas tentang apakah dan bagaimana AI menggantikan pekerjaan terus berlangsung. Di satu sisi, ada ekonom dan laporan yang berpendapat bahwa dampak keseluruhan AI generatif saat ini pada pekerjaan dan upah belum signifikan. Di sisi lain, banyak pengguna berbagi kasus nyata dan pengamatan: Duolingo mengumumkan penggantian pekerja kontrak dengan AI; ada pemilik bisnis yang menyatakan telah menggunakan AI untuk menggantikan sebagian layanan pelanggan, pemrograman tingkat dasar, QA, dan posisi entri data; pekerja lepas (freelancer) (seperti desain grafis, penulisan, penerjemahan, pengisi suara) merasakan berkurangnya peluang kerja; jumlah posisi rekrutmen (seperti layanan pelanggan) menunjukkan penyusutan. Pandangan umum berpendapat bahwa pekerjaan repetitif dan berbasis pola adalah yang pertama kali terkena dampak, AI saat ini lebih banyak berfungsi sebagai alat produktivitas, tetapi efek substitusinya sudah mulai terlihat dan akan meluas secara bertahap (Sumber: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💡 Lain-lain

ISCA Fellow 2025 diumumkan, tiga ilmuwan keturunan Tionghoa terpilih: International Speech Communication Association (ISCA) mengumumkan daftar Fellow tahun 2025, dengan total 8 ilmuwan terpilih. Termasuk di antaranya tiga ilmuwan keturunan Tionghoa: Co-founder AISpeech, Profesor Terhormat Shanghai Jiao Tong University Yu Kai (atas kontribusinya pada pengenalan ucapan, sistem dialog, dan deployment teknologi, pertama dari Tiongkok Daratan), Profesor National Taiwan University Hung-yi Lee (atas kontribusi perintisannya dalam pembelajaran self-supervised ucapan dan pembangunan benchmark komunitas), serta Kepala Grup AI Generatif di Institute for Infocomm Research (I2R) A*STAR Singapura, Nancy Chen (atas kontribusi dan kepemimpinannya dalam pemrosesan ucapan multibahasa, komunikasi manusia-mesin multimodal, dan deployment teknologi AI) (Sumber: 机器之心)