Kata Kunci:Teknologi AI, OpenAI, GPT-4.5, Model Besar, Krisis Talenta AI, Model o3 pelokasian geografis, DeepSeek-V3, Agen AI, Teknologi Token-Shuffle

🔥 Fokus

Penolakan Green Card Pengembang Inti OpenAI GPT-4.5 Kai Chen Memicu Kekhawatiran Krisis Talenta AI AS: Peneliti AI berkebangsaan Kanada, Kai Chen, menghadapi deportasi paksa setelah permohonan green card-nya ditolak setelah 12 tahun tinggal di AS. Chen adalah salah satu pengembang inti GPT-4.5 OpenAI, dan kasusnya telah memicu kekhawatiran luas di kalangan komunitas teknologi bahwa kebijakan imigrasi AS merusak posisi kepemimpinannya di bidang AI. Baru-baru ini, pemeriksaan AS terhadap mahasiswa internasional, termasuk peneliti AI, dan visa H-1B semakin ketat, dengan lebih dari 1.700 visa pelajar telah terpengaruh. Survei Nature menunjukkan 75% ilmuwan di AS mempertimbangkan untuk pergi. Imigrasi sangat penting untuk pengembangan AI AS; proporsi pendiri startup AI terkemuka yang merupakan imigran tinggi, dan 70% mahasiswa pascasarjana di bidang AI adalah mahasiswa internasional. Hilangnya talenta dan pengetatan kebijakan imigrasi dapat berdampak serius pada daya saing AS di bidang AI global. (Sumber: Xin Zhi Yuan, CSDN, Zhi Mian AI)

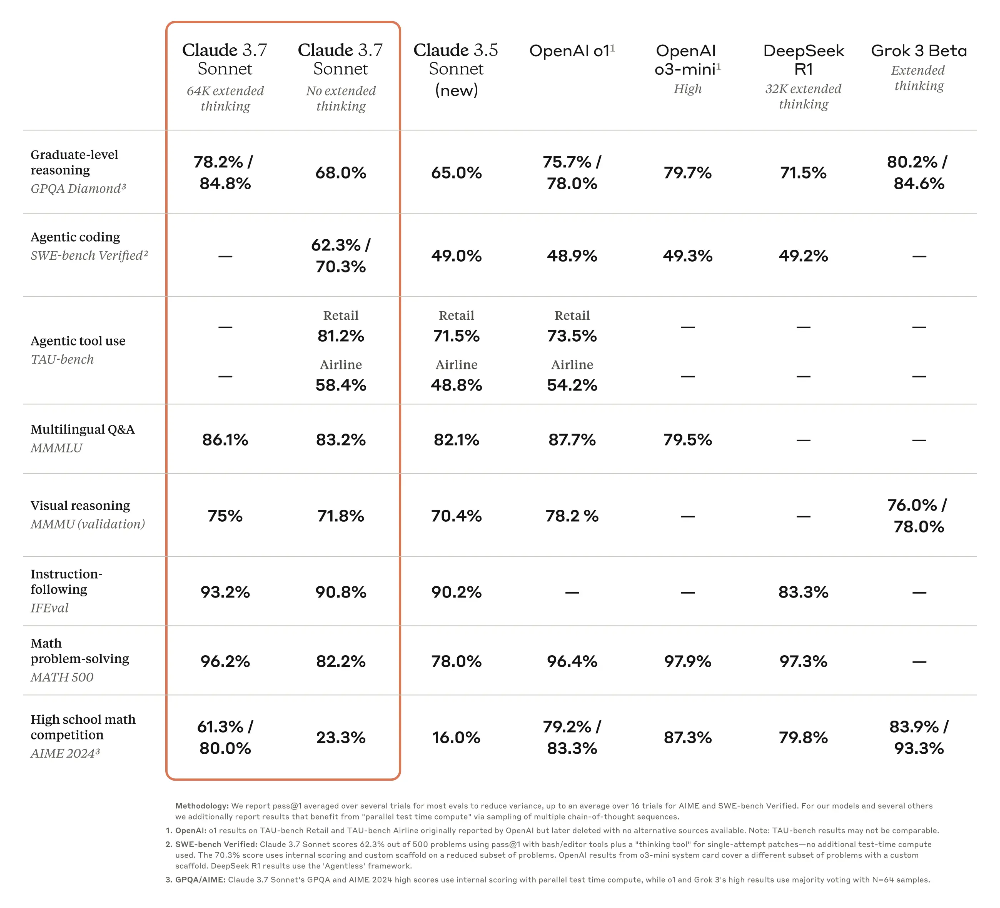

Kemampuan Geolokasi Model OpenAI o3 yang Mengejutkan Memicu Kekhawatiran Privasi: Model terbaru OpenAI, o3, menunjukkan kemampuan untuk menyimpulkan lokasi pengambilan foto secara akurat dengan menganalisis detail foto (seperti plat nomor buram, gaya arsitektur, vegetasi, pencahayaan, dll.) dan menggabungkannya dengan eksekusi kode (pemrosesan gambar Python), bahkan berhasil tanpa adanya landmark yang jelas atau informasi EXIF. Eksperimen menunjukkan bahwa o3 dapat secara akurat mengidentifikasi lokasi foto di dekat rumah pengguna, pedesaan Madagaskar, pusat kota Buenos Aires, dan banyak tempat lainnya. Meskipun proses penalarannya (seperti memotong dan memperbesar gambar berulang kali) terkadang tampak berlebihan, akurasi hasilnya tinggi, jauh melampaui model seperti Claude 3.7 Sonnet. Kemampuan ini telah menimbulkan kekhawatiran besar di kalangan pengguna tentang keamanan privasi, menunjukkan bahwa bahkan foto yang tampak biasa pun dapat mengungkap informasi lokasi pribadi, membuat manusia seolah “telanjang” di hadapan kemampuan analisis gambar AI yang kuat. (Sumber: Xin Zhi Yuan, dariusemrani)

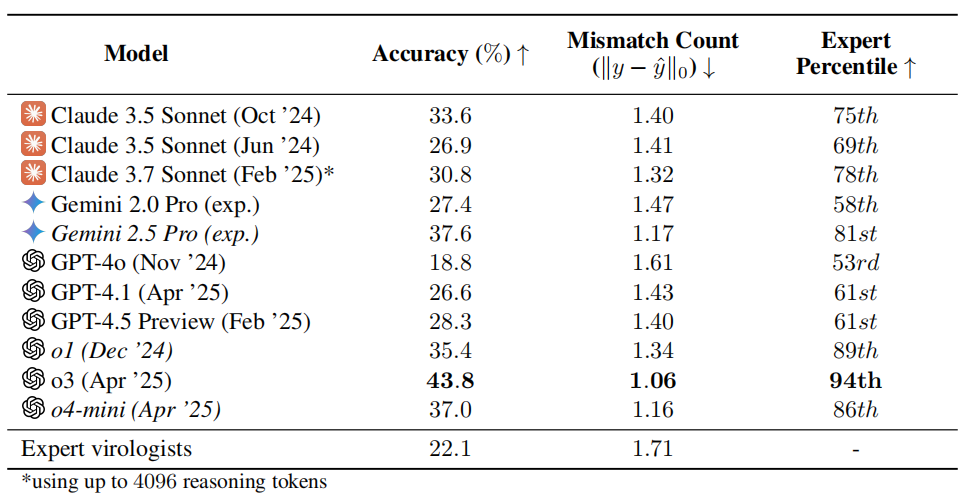

Tes Kemampuan Virologi AI Memicu Kekhawatiran: Performa o3 Melebihi 94% Pakar Manusia: Tim peneliti dari organisasi nirlaba SecureBio mengembangkan Tes Kemampuan Virologi (VCT), yang berisi 322 soal multimodal yang sulit dan berfokus pada pemecahan masalah eksperimental. Hasil tes menunjukkan bahwa model o3 OpenAI mencapai akurasi 43,8% dalam menangani masalah kompleks ini, secara signifikan mengungguli pakar virologi manusia (akurasi rata-rata 22,1%), dan bahkan melampaui 94% pakar di sub-bidang tertentu. Hasil ini menyoroti kemampuan kuat AI di bidang ilmiah profesional, tetapi juga menimbulkan kekhawatiran tentang risiko penggunaan ganda: meskipun AI dapat sangat membantu penelitian yang bermanfaat seperti pencegahan penyakit menular, AI juga dapat digunakan oleh non-profesional untuk membuat senjata biologis. Para peneliti menyerukan penguatan kontrol akses dan manajemen keamanan kemampuan AI, serta pengembangan kerangka kerja tata kelola global untuk menyeimbangkan pengembangan AI dengan risiko keamanan. (Sumber: Xueshu Toutiao, gallabytes)

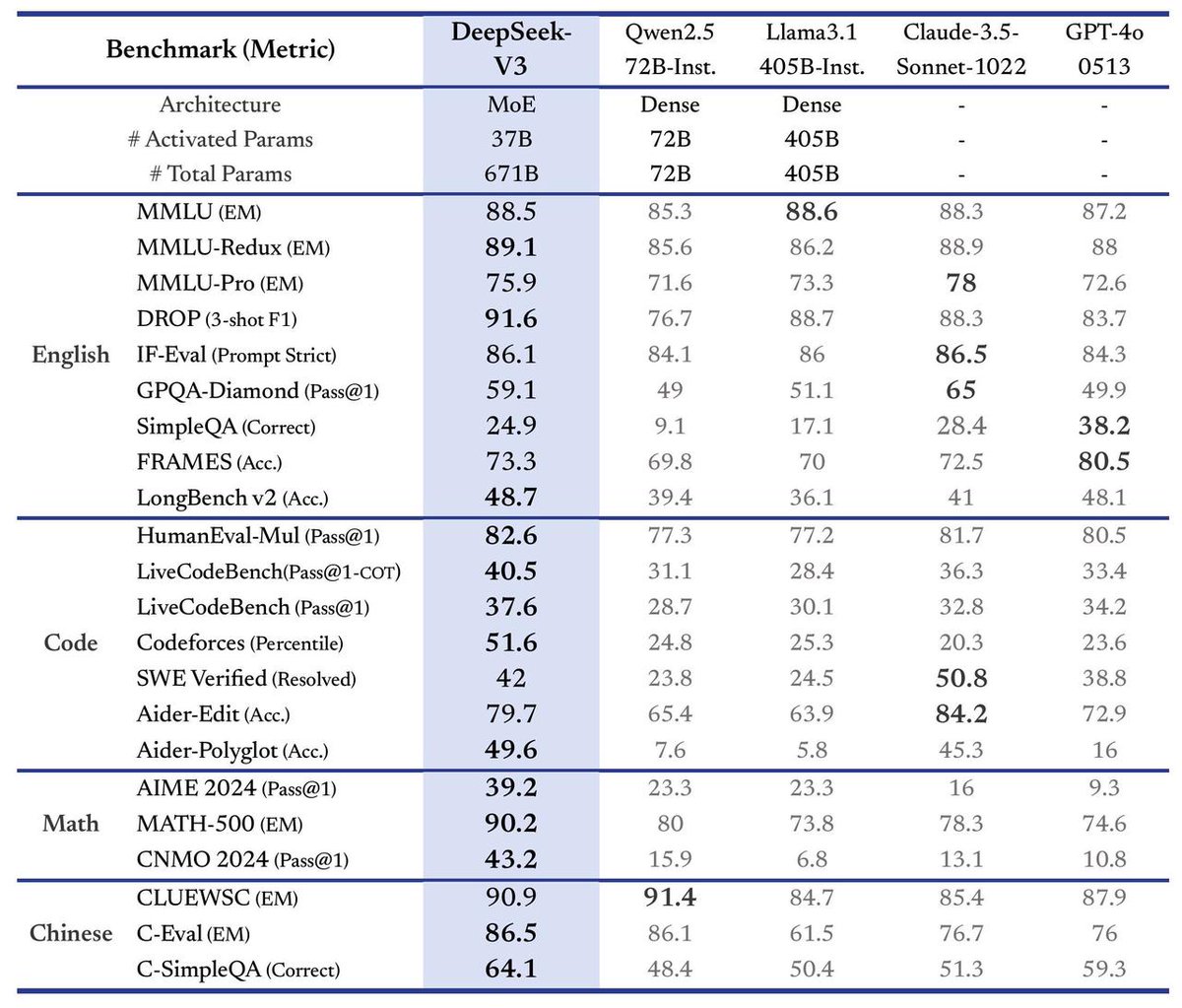

DeepSeek Merilis Model Besar V3, Kecepatan Meningkat 3 Kali Lipat: DeepSeek mengumumkan peluncuran model besar terbarunya, DeepSeek-V3. Dikatakan bahwa ini adalah kemajuan terbesarnya hingga saat ini, dengan sorotan utama meliputi: kecepatan pemrosesan mencapai 60 token per detik, meningkat 3 kali lipat dibandingkan dengan versi V2; kemampuan model ditingkatkan; menjaga kompatibilitas API dengan versi sebelumnya; dan model serta makalah penelitian terkait akan sepenuhnya open source. Peluncuran ini menandai iterasi cepat yang berkelanjutan dari DeepSeek di bidang model bahasa besar dan kontribusinya kepada komunitas open source. (Sumber: teortaxesTex)

🎯 Tren

Meta dkk. Mengusulkan Teknologi Token-Shuffle, Model Autoregresif Pertama Kali Menghasilkan Gambar 2048×2048: Peneliti dari Meta, Northwestern University, National University of Singapore, dan institusi lainnya mengusulkan teknologi Token-Shuffle, yang bertujuan untuk mengatasi hambatan efisiensi dan resolusi yang disebabkan oleh pemrosesan sejumlah besar token gambar oleh model autoregresif. Teknologi ini secara signifikan mengurangi jumlah token visual dalam komputasi dan meningkatkan efisiensi dengan menggabungkan token spasial lokal di input Transformer (token-shuffle) dan memulihkannya di output (token-unshuffle). Berdasarkan model Llama 2.7B parameter, metode ini untuk pertama kalinya mencapai generasi gambar resolusi ultra-tinggi 2048×2048, dan melampaui model autoregresif serupa bahkan model difusi yang kuat dalam benchmark seperti GenEval dan GenAI-Bench. Teknologi ini membuka jalur baru bagi model bahasa besar multimodal (MLLMs) untuk menghasilkan gambar resolusi tinggi dan fidelitas tinggi, dan mungkin mengungkap prinsip teknologi generasi gambar yang tidak diungkapkan dari model seperti GPT-4o. (Sumber: 36Kr)

Model Besar Open Source Tiongkok Membentuk Kekuatan Gabungan, Mempercepat Evolusi Ekosistem AI Global: Model besar dasar Tiongkok yang diwakili oleh DeepSeek dan Qwen dari Alibaba, melalui strategi open source, telah mendorong banyak perusahaan seperti Kunlun Tech untuk mengembangkan model vertikal yang lebih kecil dan lebih kuat berdasarkan model mereka, membentuk model operasi “pasukan gabungan”, mempercepat iterasi teknologi AI domestik dan penerapan aplikasi. Model Skywork-OR1 Kunlun Tech, yang dilatih berdasarkan DeepSeek dan Qwen, melampaui kinerja QwQ-32B pada skala yang sama, dan telah membuka dataset serta kode pelatihannya. Strategi terbuka ini kontras dengan model closed source arus utama AS, mencerminkan kepercayaan diri teknologi Tiongkok dan jalur prioritas industri, membantu inklusi teknologi dan simbiosis global, serta mendorong ekosistem AI global berkembang dari “unipolar” menjadi “multipolar”. (Sumber: Guanwang Finance, bookwormengr, teortaxesTex, karminski3, reach_vb)

CEO Google DeepMind Hassabis Memprediksi AGI Tercapai dalam Satu Dekade, Menekankan Keamanan dan Etika: CEO Google DeepMind Demis Hassabis, dalam wawancara eksklusif dengan majalah TIME, memprediksi bahwa Kecerdasan Buatan Umum (AGI) dapat menjadi kenyataan dalam dekade mendatang. Dia percaya AI akan membantu mengatasi tantangan besar seperti penyakit dan energi, tetapi juga khawatir tentang risiko penyalahgunaan atau lepas kendali, terutama menekankan masalah senjata biologis dan kontrol. Hassabis menyerukan pembentukan standar keamanan AI dan kerangka kerja tata kelola global yang terpadu, berpendapat bahwa pencapaian AGI membutuhkan kerja sama lintas bidang. Dia membedakan antara kemampuan memecahkan masalah dan mengajukan dugaan, berpendapat bahwa AGI sejati harus memiliki kemampuan yang terakhir. Sementara itu, ia menekankan bahwa asisten AI harus menghormati privasi pengguna, dan percaya bahwa pengembangan AI akan menciptakan pekerjaan baru daripada menggantikan secara massal, tetapi masyarakat perlu memikirkan masalah filosofis seperti distribusi kekayaan dan makna hidup. (Sumber: Zhidx, TIME)

AI Agent Menjadi Tren Baru, Produk seperti Manus, Xixiang, Kouch Space Bermunculan: Agen AI umum (Agent) menjadi fokus baru di bidang AI, dengan popularitas Manus dianggap sebagai awal dari tahun Agent. Produk semacam ini dapat secara mandiri merencanakan dan melaksanakan tugas-tugas kompleks (seperti pemrograman, pencarian informasi, penyusunan strategi) berdasarkan instruksi sederhana pengguna. Perusahaan besar seperti Baidu (Aplikasi Xixiang) dan ByteDance (Kouch Space) dengan cepat mengikuti, meluncurkan produk serupa. Ulasan menunjukkan bahwa setiap produk memiliki kelebihan dan kekurangan dalam hal pemrograman, integrasi informasi, dan pemanggilan sumber daya eksternal (seperti peta). Manus menunjukkan kinerja yang mengesankan dalam tugas pemrograman, sementara Xixiang memiliki keunggulan dalam integrasi peta, tetapi ketepatan waktu informasi (seperti harga produk) dibatasi oleh tingkat platform eksternal yang mengadopsi protokol MCP. Perkembangan Agent menandai pergeseran AI dari alat percakapan menjadi alat eksekusi, tetapi integrasi ekosistem dan masalah biaya masih menjadi tantangan. (Sumber: Duojiao Spicy)

Demam Pembangunan Pusat Data AI Mendingin? Sebenarnya Penyesuaian Strategis Raksasa Teknologi & Kendala Sumber Daya: Penangguhan proyek Microsoft di Ohio baru-baru ini dan rumor penyesuaian rencana sewa AWS telah menimbulkan kekhawatiran tentang gelembung pusat data AI. Namun, laporan keuangan Vertiv, Alphabet, dan pernyataan eksekutif Amazon menunjukkan permintaan masih kuat. Orang dalam industri percaya bahwa ini bukan kehancuran pasar, melainkan penyesuaian strategis oleh raksasa teknologi di tengah perkembangan AI yang cepat, terobosan teknologi, dan ketidakpastian geopolitik, dengan memprioritaskan proyek inti. Pasokan listrik yang ketat menjadi kendala utama; permintaan listrik untuk pusat data baru melonjak (dari 60MW menjadi 500MW+), jauh melebihi kecepatan perluasan jaringan listrik, menyebabkan perpanjangan masa tunggu proyek. Di masa depan, pembangunan pusat data akan terus berlanjut, tetapi akan lebih memperhatikan ketersediaan listrik, dan mungkin menunjukkan ritme “pasang surut”. (Sumber: Tencent Tech, SemiAnalysis)

NVIDIA Merilis Teknologi 3DGUT, Menggabungkan Gaussian Splatting dengan Ray Tracing: Peneliti NVIDIA mengusulkan teknologi baru bernama 3DGUT (3D Gaussian Unscented Transform), yang untuk pertama kalinya menggabungkan rendering cepat Gaussian Splatting dengan efek berkualitas tinggi dari ray tracing (seperti refleksi, refraksi). Teknologi ini memungkinkan sinar memantul dalam adegan Gaussian Splatting dengan memperkenalkan “sinar sekunder”, sehingga mencapai efek refleksi dan refraksi berkualitas tinggi secara real-time, dan mendukung model kamera non-standar seperti kamera fisheye serta rolling shutter, mengatasi keterbatasan teknologi Gaussian Splatting asli dalam aspek-aspek ini. Kode penelitian telah di-open source, diharapkan dapat mendorong pengembangan di bidang rendering dunia virtual dan pelatihan mengemudi otonom. (Sumber: Two Minute Papers

)

Pengembangan dan Tantangan Teknologi “Kulit Elektronik” Robot Humanoid: “Kulit elektronik” (sensor taktil fleksibel) adalah teknologi kunci untuk mewujudkan persepsi taktil halus pada robot humanoid dan menyelesaikan tugas-tugas seperti menggenggam benda rapuh. Rute teknologi utama saat ini meliputi tipe piezoresistif (stabilitas baik, mudah diproduksi massal, seperti yang diadopsi oleh Hanwei Technology, Foley New Materials, Moxian Technology) dan tipe kapasitif (dapat mewujudkan persepsi non-kontak, identifikasi material, seperti yang diadopsi oleh Tashan Technology). Beberapa produsen telah memiliki kemampuan produksi massal dan bekerja sama dengan perusahaan robot, tetapi industri ini masih dalam tahap awal. Volume pengiriman robot (terutama tangan cekatan) masih kecil, menyebabkan biaya kulit elektronik tinggi (harga target di bawah 2000 yuan per tangan, saat ini jauh di atasnya), membatasi aplikasi skala besar. Di masa depan, perlu mengintegrasikan lebih banyak dimensi sensorik (suhu, kelembaban, dll.), dan memperluas skenario penerapan seperti layanan hotel dan stasiun kerja fleksibel industri. (Sumber: Meijing Toutiao)

Model Besar untuk Urusan Pemerintahan Menyambut Peluang Pengembangan, Aplikasi AI Office Menjadi yang Pertama Diterapkan: Open source dan peningkatan kinerja DeepSeek secara signifikan mengurangi biaya penerapan model besar untuk urusan pemerintahan, mendorong aplikasinya di sektor pemerintahan, terutama dalam skenario AI office (penulisan dokumen resmi, proofreading, tata letak, tanya jawab cerdas, dll.). Namun, model besar umum (seperti DeepSeek) memiliki masalah “halusinasi” dan kurangnya pengetahuan profesional pemerintahan. Produsen seperti Kingsoft Office mengusulkan solusi kolaboratif “model besar umum + model besar industri + model kecil profesional”, menggabungkan korpus data pemerintahan untuk melatih model khusus (seperti Kingsoft Government Large Model Enhanced Edition), dan mengaktifkan sumber daya data internal pemerintah untuk mengatasi halusinasi, meningkatkan profesionalisme, dan memastikan keamanan. AI office bertujuan untuk membantu daripada menggantikan alur kerja yang ada, meningkatkan efisiensi (penulisan dokumen resmi meningkat 30-40%), dan membangun basis pengetahuan khusus departemen. (Sumber: Guangzhui Intelligence)

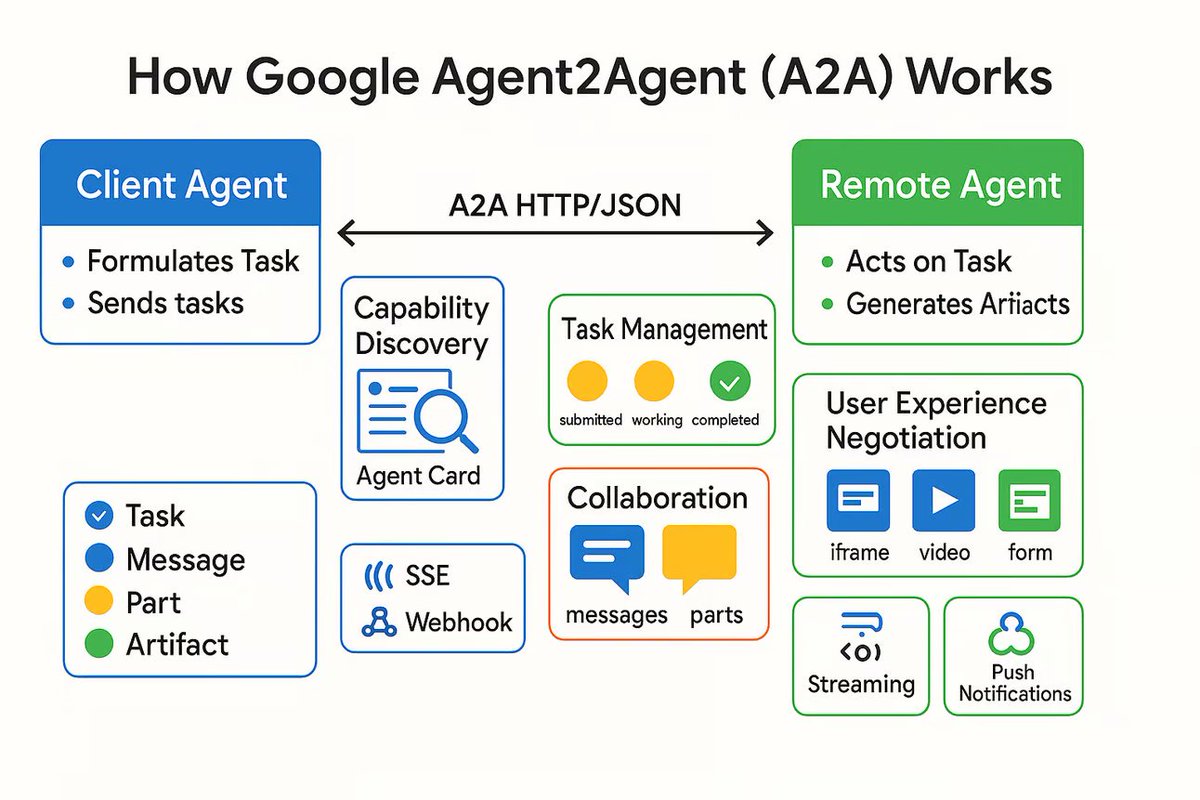

Protokol Komunikasi AI Agent A2A Dirilis, Bertujuan Menghubungkan Agen AI Independen: Google merilis protokol komunikasi bernama Agent2Agent (A2A), yang bertujuan agar agen AI independen dapat berkomunikasi dan berkolaborasi satu sama lain secara terstruktur dan aman. Protokol ini mendefinisikan serangkaian format pesan JSON umum berdasarkan HTTP, memungkinkan satu Agent meminta Agent lain untuk melakukan tugas dan menerima hasilnya. Komponen kunci meliputi Agent Card yang mendeskripsikan kemampuan Agent, klien, server, tugas, pesan (berisi bagian seperti teks, JSON, gambar, dll.), dan artefak (hasil tugas). A2A mendukung streaming dan notifikasi, dan sebagai standar terbuka, dapat diimplementasikan oleh kerangka kerja atau vendor Agent mana pun, diharapkan dapat mendorong kolaborasi Agent khusus dan membangun ekosistem Agent modular. (Sumber: The Turing Post)

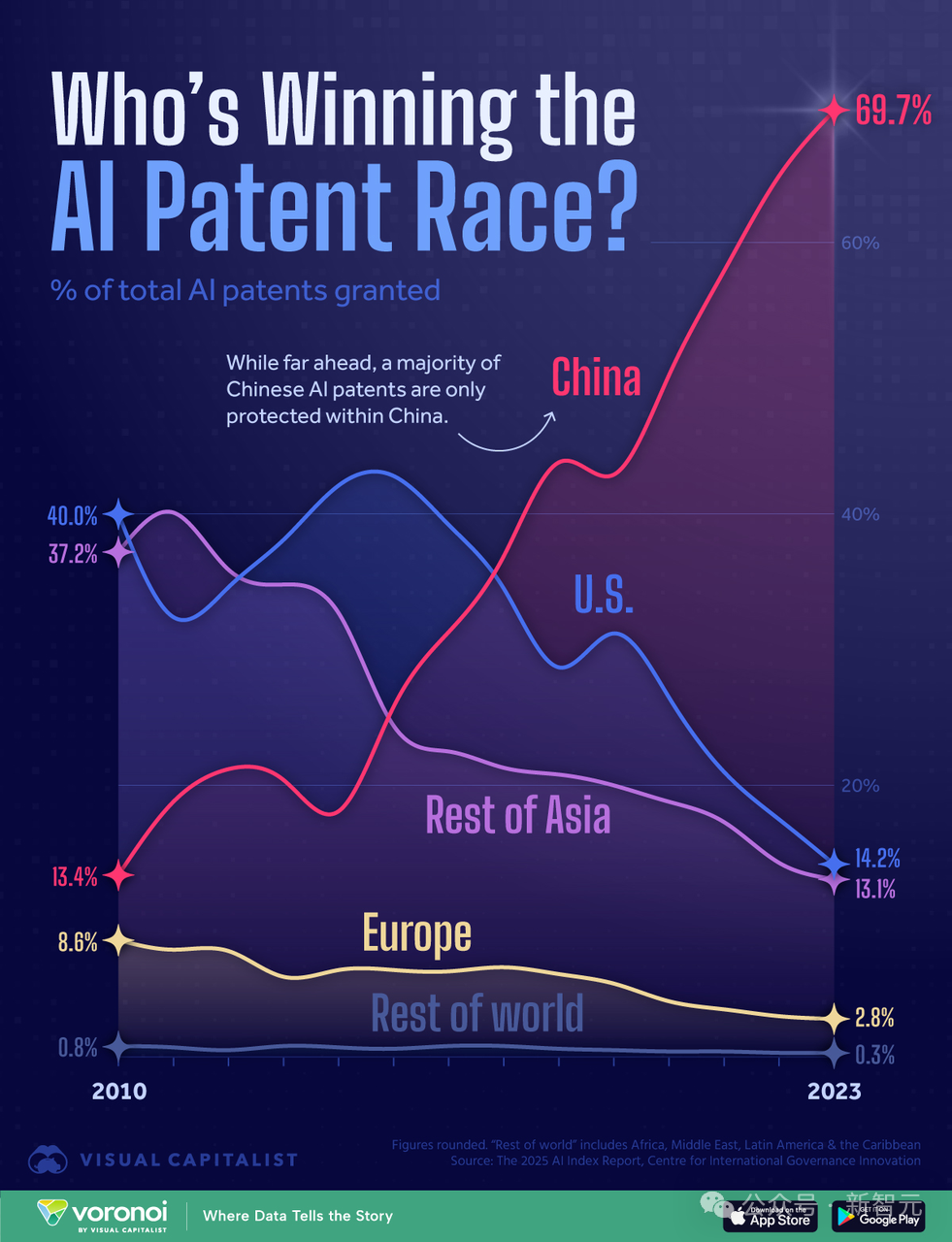

Analisis Lanskap Kompetisi Komputasi AI AS-Tiongkok: Akankah AS Menang dengan Keunggulan Komputasi?: Peneliti yang sebelumnya menulis laporan “AI 2027” menerbitkan artikel yang menganalisis bahwa meskipun jumlah paten AI Tiongkok adalah yang tertinggi di dunia (mencakup 70%), dalam perlombaan AI, AS mungkin menang berdasarkan keunggulan komputasi. Artikel tersebut memperkirakan bahwa AS menguasai 75% daya komputasi chip AI canggih global, sementara Tiongkok hanya 15%, dan biayanya lebih tinggi karena kontrol ekspor. Meskipun Tiongkok mungkin lebih unggul dalam penggunaan komputasi terpusat, pangsa komputasi perusahaan terkemuka AS (seperti Google, OpenAI) juga meningkat. Kemajuan algoritma memang penting, tetapi mudah ditiru satu sama lain dan pada akhirnya dibatasi oleh kendala komputasi. Dalam hal listrik, itu tidak akan menjadi kendala bagi AS dalam jangka pendek. Laporan tersebut berpendapat bahwa penegakan sanksi chip yang ketat sangat penting bagi AS untuk mempertahankan posisi terdepannya, dan mungkin menunda kemandirian chip Tiongkok hingga akhir tahun 2030-an. (Sumber: Xin Zhi Yuan)

🧰 Alat

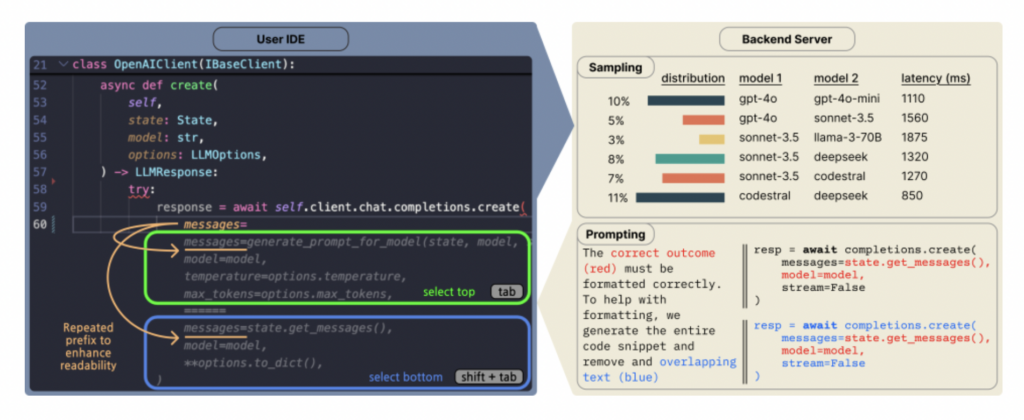

Copilot Arena: Platform untuk Mengevaluasi LLM Kode Langsung di VSCode: ML@CMU meluncurkan ekstensi VSCode Copilot Arena, yang bertujuan untuk mengumpulkan preferensi pengembang terhadap penyelesaian kode LLM yang berbeda dalam lingkungan pengembangan nyata. Alat ini telah menarik lebih dari 11.000 pengguna, mengumpulkan lebih dari 25.000 data “pertarungan” penyelesaian kode, dan memperbarui papan peringkat secara real-time di situs web LMArena. Ini menggunakan antarmuka perjodohan baru, strategi pengambilan sampel model yang dioptimalkan (mengurangi latensi 33%), dan teknik prompt cerdas (memungkinkan model obrolan juga melakukan tugas FiM). Penelitian menemukan bahwa peringkat Copilot Arena memiliki korelasi rendah dengan benchmark statis, tetapi korelasi tinggi dengan Chatbot Arena (preferensi manusia), menunjukkan pentingnya evaluasi lingkungan nyata. Data juga mengungkapkan bahwa preferensi pengguna sangat dipengaruhi oleh jenis tugas, tetapi sedikit dipengaruhi oleh bahasa pemrograman. (Sumber: AI Hub)

Aplikasi Penerjemah “Bahasa Anjing” AI Traini Menjadi Populer, Akurasi Mencapai 81,5%: Sebuah aplikasi AI bernama Traini mengklaim dapat menerjemahkan gonggongan, ekspresi, dan perilaku anjing ke dalam bahasa manusia, serta menerjemahkan ucapan manusia ke dalam “bahasa anjing”. Aplikasi ini didasarkan pada model besar PEBI yang dikembangkan sendiri, yang diklaim telah mempelajari 100.000 sampel anjing dan pengetahuan perilaku hewan peliharaan, dapat mengenali 12 jenis emosi anjing, dengan akurasi mencapai 81,5%. Pengguna dapat mengunggah foto, video, atau rekaman suara untuk menggunakan chatbot PetGPT guna mendekode status hewan peliharaan mereka. Traini juga menawarkan layanan langganan kursus pelatihan anjing. Meskipun efek terjemahan sebenarnya mungkin kontroversial (seperti munculnya “omong kosong” dalam pengujian), aplikasi ini mengalami peningkatan unduhan sebesar 400% dalam waktu hampir setahun setelah diluncurkan, menunjukkan potensi besar AI di bidang teknologi hewan peliharaan. (Sumber: Wuya Intelligence)

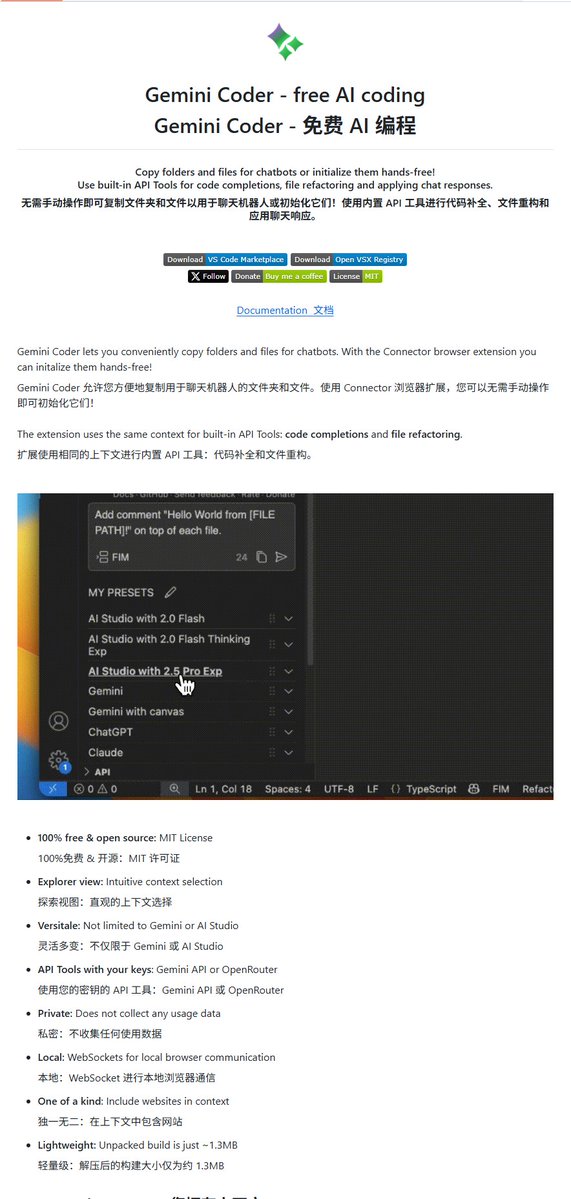

Gemini Coder: Plugin VSCode Open Source, Gunakan Gemini untuk Menulis Kode Gratis: Plugin VSCode bernama Gemini Coder telah di-open source di GitHub (lisensi MIT). Plugin ini memungkinkan pengguna untuk langsung memanggil model seri Gemini Google (seperti Gemini-2.5-Pro dan Flash gratis) di dalam VSCode untuk penulisan kode dan bantuan, secara fungsional mirip dengan Cursor atau Windsurf. Ini berarti pengembang dapat memanfaatkan kemampuan kode Gemini yang kuat secara gratis untuk meningkatkan efisiensi pengembangan. (Sumber: karminski3)

Game Pacar AI Berkembang, dari Aplikasi Mini hingga Produsen Profesional Ikut Terlibat: Game pacar AI menjadi jalur baru, mulai dari aplikasi mini WeChat yang dibuat oleh tim kecil hingga perusahaan baru pendiri miHoYo Cai Haoyu, Anuttacon, dan produsen game otome Natural Selection (meluncurkan “EVE”), semuanya terlibat. Gameplay game jenis aplikasi mini relatif monoton (percakapan role-playing, kustomisasi penampilan), memanfaatkan AI untuk mengurangi biaya produksi, tetapi homogenitasnya parah, dan model pembayaran (langganan keanggotaan, pengisian poin) sering menimbulkan ketidakpuasan pengguna, serta kebaruan mudah hilang. Produsen baru mungkin meniru model game otome, fokus pada kekayaan gameplay, biaya item, dan keuntungan merchandise. Penerapan AI di dalamnya tercermin dalam peningkatan efisiensi produksi dan peningkatan interaksi pengguna (seperti generasi dialog real-time, reaksi). Namun, pengalaman interaksi AI saat ini masih kurang (respons mekanis, kurangnya realisme), dan menghadapi masalah konten ambigu, kepercayaan pengguna, serta persaingan dengan bentuk hiburan lainnya. (Sumber: Dingjiao)

Panduan Identifikasi Konten AI: Cara Mengenali Teks, Gambar & Video Buatan AI: Menghadapi konten buatan AI (AIGC) yang semakin realistis, orang biasa dapat menguasai beberapa teknik identifikasi. Mengenali teks AI: Perhatikan kosakata yang terlalu tepat atau menumpuk, terlalu banyak kiasan, tata bahasa yang sempurna dan struktur kalimat yang konsisten, ekspresi berpola (seperti penyalahgunaan emoji, awalan tetap), kurangnya emosi tulus dan pengalaman pribadi, serta kemungkinan adanya “halusinasi” (kesalahan faktual). Mengenali gambar AI: Periksa apakah detail seperti tangan, gigi, mata terlihat alami; apakah bayangan, pantulan fisik, latar belakang konsisten dan masuk akal; apakah tekstur seperti kulit, rambut terlalu halus atau aneh; apakah ada simetri abnormal atau kesempurnaan berlebihan. Mengenali video AI: Perhatikan apakah ekspresi mikro wajah kaku, apakah gerakan sesuai logika (kurangnya gerakan kecil tak sadar), apakah pencahayaan lingkungan cocok, apakah latar belakang terdistorsi atau berkedip. Dapat dibantu dengan pencarian gambar terbalik dan alat deteksi AI (seperti ZeroGPT, detektor Zhuque), tetapi perlu dikombinasikan dengan pemikiran kritis untuk penilaian komprehensif. (Sumber: Guixingren Pro)

Plexe AI: Diklaim sebagai Agent Rekayasa ML Open Source Pertama: Plexe AI menyebut dirinya sebagai Agent rekayasa machine learning pertama di dunia, yang bertujuan untuk mengotomatiskan tugas-tugas machine learning, seperti pemrosesan dataset, pemilihan model, penyetelan, dan penerapan, mengurangi persiapan data manual dan peninjauan kode. Proyek ini telah di-open source di GitHub, berharap dapat menyederhanakan alur kerja ML melalui Agent. (Sumber: Reddit r/MachineLearning)

HighCompute.py: Meningkatkan Kemampuan LLM Lokal Memproses Tugas Kompleks melalui Dekomposisi Tugas: Aplikasi Python file tunggal bernama HighCompute.py dirilis, bertujuan untuk meningkatkan kemampuan LLM lokal atau jarak jauh (harus kompatibel dengan OpenAI API) dalam memproses kueri kompleks melalui strategi dekomposisi tugas multi-level. Aplikasi ini menyediakan tiga tingkat komputasi: rendah (respons langsung), sedang (dekomposisi tingkat pertama), dan tinggi (dekomposisi tingkat kedua). Semakin tinggi levelnya, semakin banyak panggilan API dan konsumsi Token, tetapi secara teoritis dapat menangani tugas yang lebih kompleks dan meningkatkan kualitas jawaban. Pengguna dapat secara dinamis beralih tingkat komputasi dalam obrolan. Proyek ini menggunakan Gradio untuk membangun antarmuka Web, bertujuan untuk mensimulasikan efek pemrosesan yang mirip dengan “komputasi tinggi”, tetapi pada dasarnya meningkatkan jumlah komputasi daripada meningkatkan kemampuan model itu sendiri. (Sumber: Reddit r/LocalLLaMA)

Open WebUI Menambahkan Fitur Analisis Data Lanjutan (Eksekusi Kode): Open WebUI (sebelumnya Ollama WebUI) mengumumkan penambahan fitur analisis data lanjutan, yang memungkinkan eksekusi kode di dalam antarmuka pengguna. Ini mirip dengan fitur Code Interpreter ChatGPT, memperluas kemampuan aplikasi LLM lokal, memungkinkannya untuk secara langsung memproses dan menganalisis data, menghasilkan grafik, dll. (Sumber: Reddit r/LocalLLaMA)

📚 Pembelajaran

7 Cara Memanfaatkan AI Generatif untuk Bimbingan Karir: AI Generatif (seperti ChatGPT, DeepSeek) dapat berfungsi sebagai mentor karir yang hemat biaya. Artikel ini mengusulkan 7 cara memanfaatkan AI untuk bimbingan karir beserta contoh prompt: 1) Memperjelas arah karir (melalui pertanyaan reflektif, pencocokan keterampilan-minat); 2) Mengoptimalkan resume & profil LinkedIn (menulis ringkasan, mengukur pencapaian); 3) Menyusun strategi pencarian kerja (mengidentifikasi peluang, memperluas jaringan); 4) Mempersiapkan wawancara & negosiasi gaji (simulasi wawancara, strategi menjawab); 5) Meningkatkan kepemimpinan & mendorong pertumbuhan karir (mengidentifikasi keterampilan, merencanakan promosi); 6) Membangun merek pribadi & kepemimpinan pemikiran (pembuatan konten, meningkatkan visibilitas); 7) Mengatasi masalah pekerjaan sehari-hari (menangani konflik, menetapkan batasan). Kuncinya adalah memberikan informasi latar belakang yang terperinci, merancang prompt dengan cermat, dan menggunakan saran AI dengan penilaian sendiri. (Sumber: Harvard Business Review)

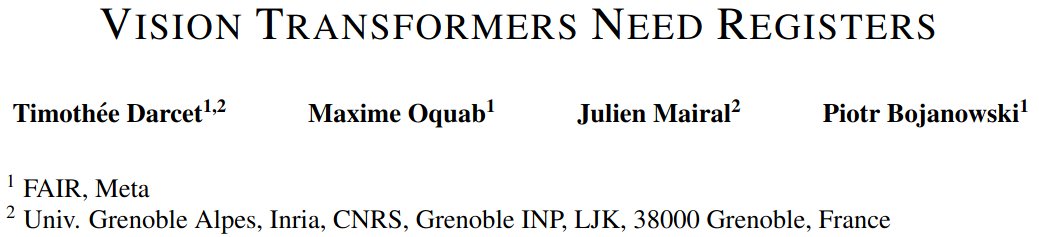

Diskusi Makalah: Vision Transformers Membutuhkan Register: Sebuah makalah baru tentang Vision Transformers (ViT) mengusulkan bahwa ViT memerlukan mekanisme seperti register untuk meningkatkan kinerjanya. Makalah ini menunjukkan masalah yang ada pada ViT saat ini dan mengusulkan solusi yang ringkas dan mudah dipahami, tanpa memerlukan fungsi loss yang kompleks atau modifikasi lapisan jaringan, mencapai hasil yang baik, dan membahas keterbatasannya. Penelitian ini dipuji karena penjelasan masalahnya yang jelas, solusi yang elegan, dan gaya penulisan yang mudah dipahami. (Sumber: TimDarcet)

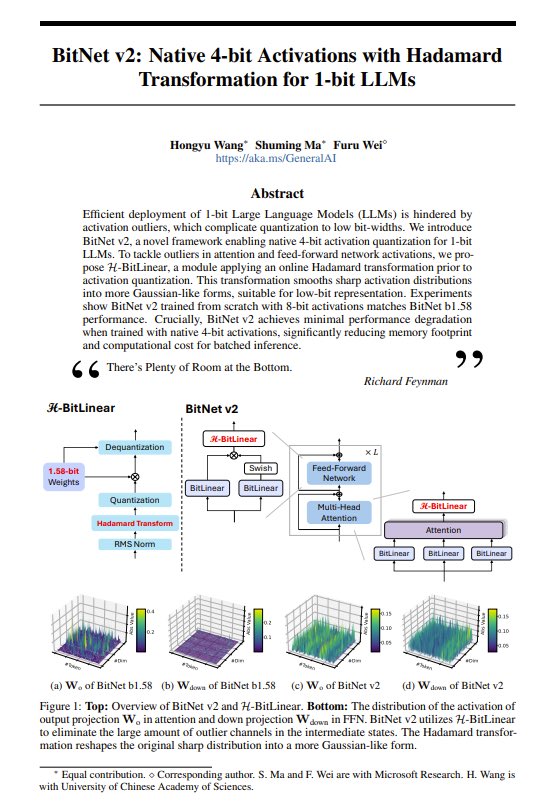

Berbagi Makalah: BitNet v2 – Memperkenalkan Aktivasi 4-bit Asli untuk LLM 1-bit: Makalah BitNet v2 mengusulkan metode penggunaan transformasi Hadamard untuk mengimplementasikan aktivasi 4-bit asli untuk LLM 1-bit (bobot 1,58-bit). Peneliti menyatakan bahwa ini telah mendorong kinerja GPU NVIDIA hingga batasnya dan berharap kemajuan perangkat keras dapat lebih lanjut mendukung komputasi bit rendah. Teknologi ini bertujuan untuk lebih mengurangi jejak memori dan biaya komputasi LLM. (Sumber: Reddit r/LocalLLaMA, teortaxesTex, algo_diver)

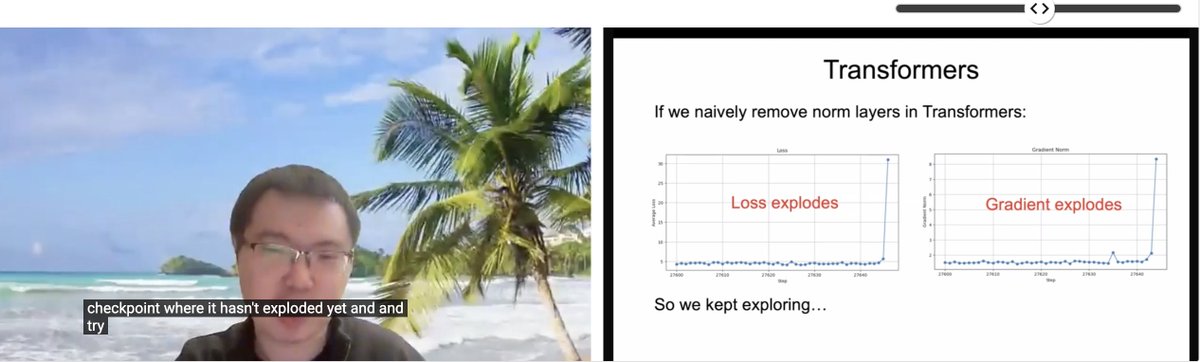

Berbagi Makalah ICLR: Transformer Tanpa Normalisasi: Zhuang Liu dkk. membagikan makalah berjudul “Transformer without Normalization” di lokakarya ICLR 2025 SCOPE. Penelitian ini mengeksplorasi kemungkinan menghilangkan lapisan normalisasi (seperti LayerNorm) dalam arsitektur Transformer serta dampaknya pada pelatihan dan kinerja model, dan menunjukkan bahwa pilihan optimizer dan arsitektur sangat terkait erat. (Sumber: VictorKaiWang1, zacharynado)

Makalah Status dan Prospek Masa Depan LLM: Sebuah makalah yang diterbitkan di arXiv (2504.01990) menjelaskan status perkembangan model bahasa besar (LLM) saat ini, tantangan yang dihadapi, dan kemungkinan masa depan dengan bahasa yang sederhana dan mudah dipahami, cocok untuk pembaca yang ingin memahami gambaran umum bidang ini. (Sumber: Reddit r/ArtificialInteligence)

Proyek Open Source: Ava-LLM – Arsitektur LLM Multi-Skala yang Dibangun dari Awal: Pengembang Kuduxaaa meng-open source kerangka kerja Transformer bernama Ava-LLM, untuk membangun model bahasa skala 100M hingga 100B parameter dari awal. Fitur kerangka kerja ini meliputi arsitektur preset yang dioptimalkan untuk skala berbeda (Tiny/Mid/Large), desain sadar perangkat keras yang mempertimbangkan GPU kelas konsumen, penggunaan Rotary Positional Encoding (RoPE) dan ekstensi NTK untuk menangani konteks dinamis, dukungan asli untuk Grouped Query Attention (GQA), dll. Proyek ini mencari umpan balik dan kerja sama komunitas dalam strategi normalisasi lapisan, stabilitas jaringan dalam, pelatihan presisi campuran, dll. (Sumber: Reddit r/LocalLLaMA)

Proyek Open Source: Reaktiv – Pustaka Komputasi Reaktif Python: Pengembang Bui membagikan pustaka Python bernama Reaktiv, yang mengimplementasikan grafik komputasi reaktif dengan pelacakan dependensi otomatis. Pustaka ini hanya menghitung ulang nilai ketika dependensi berubah, secara otomatis mendeteksi dependensi runtime, menyimpan hasil komputasi dalam cache, dan mendukung operasi asinkron (asyncio). Pengembang percaya ini mungkin cocok untuk alur kerja ilmu data, seperti membangun pipeline data eksplorasi yang diperbarui secara efisien, dasbor reaktif, mengelola rantai transformasi yang kompleks, menangani data streaming, dll., dan mencari umpan balik dari komunitas ilmu data. (Sumber: Reddit r/MachineLearning)

💼 Bisnis

Pendapatan iFlytek 2024 Kembali ke Pertumbuhan Dua Digit, Investasi AI Memasuki Periode Panen: iFlytek merilis laporan keuangan 2024, pendapatan mencapai 23,343 miliar yuan, naik 18,79% YoY, laba bersih yang diatribusikan kepada induk perusahaan 560 juta yuan. Pendapatan Q1 2025 sebesar 4,658 miliar yuan, naik 27,74% YoY. Pertumbuhan kinerja didorong oleh penerapan skala besar model besar StarSpark di bidang pendidikan (penjualan mesin belajar AI meningkat lebih dari 100%), medis, keuangan, dll., serta sistem teknologi yang sepenuhnya mandiri dan terkendali “komputasi domestik + algoritma mandiri”. Perusahaan menekankan pentingnya lokalisasi, model inferensi mendalam StarSpark X1 dilatih berdasarkan komputasi domestik (Huawei 910B), efeknya setara dengan standar internasional teratas, ambang batas penerapan rendah. Perusahaan menyesuaikan struktur bisnis menjadi “mengoptimalkan C-end, memperkuat B-end, memilih G-end”, arus kas mencapai rekor tertinggi. Di masa depan akan menekankan produkisasi, mengurangi proyek kustom, mendorong integrasi perangkat lunak dan perangkat keras. (Sumber: 36Kr)

Startup AI Agent Manus AI Raih $75 Juta Dipimpin Benchmark, Valuasi Capai $500 Juta: Perusahaan pengembang AI Agent umum Manus AI (Efek Kupu-kupu) dikabarkan telah menyelesaikan putaran pendanaan baru sebesar $75 juta, dipimpin oleh VC AS Benchmark, meningkatkan valuasinya menjadi hampir $500 juta. Manus AI didirikan oleh Xiao Hong, Ji Yichao, dan Zhang Tao, bertujuan untuk menciptakan agen AI yang dapat secara mandiri menyelesaikan tugas-tugas kompleks (seperti penyaringan resume, perencanaan perjalanan). Perusahaan ini sebelumnya telah menerima investasi dari Tencent, ZhenFund, dan Sequoia China. Dana baru direncanakan untuk digunakan memperluas pasar di AS, Jepang, Timur Tengah, dll. Meskipun menghadapi biaya tinggi (biaya per tugas sekitar $2), persaingan dari perusahaan besar (Kouch Space ByteDance, Aplikasi Xixiang Baidu, OpenAI o3, dll.) dan tantangan komersialisasi, Manus AI baru-baru ini menjalin kerja sama dengan Tongyi Qianwen Alibaba untuk mengurangi biaya, dan meluncurkan layanan langganan bulanan. (Sumber: ChinaVenture)

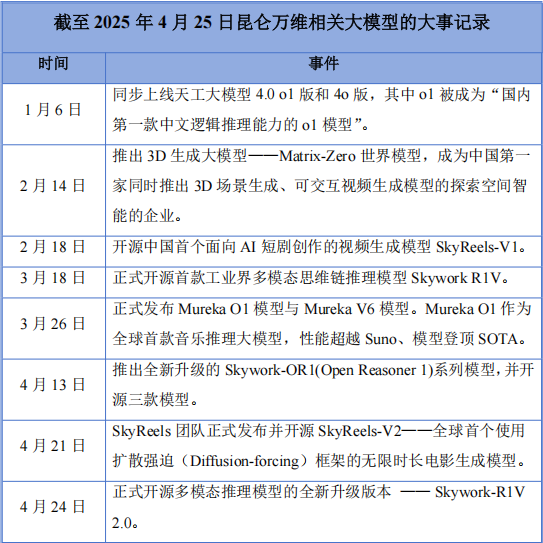

Kunlun Tech Alami Kerugian Tahunan Pertama Setelah All in AI, Tapi Terus Tingkatkan R&D: Kunlun Tech merilis laporan keuangan 2024, pendapatan 5,662 miliar yuan (naik 15,2%), tetapi rugi bersih 1,595 miliar yuan, kerugian pertama dalam sepuluh tahun sejak listing. Penyebab utama kerugian termasuk peningkatan investasi R&D (1,54 miliar yuan, naik 59,5%) dan kerugian investasi. Meskipun rugi, perusahaan aktif di bidang AI, merilis model besar Tiangong, model musik AI Mureka O1 (diklaim sebagai model penalaran musik pertama di dunia, menyaingi Suno), model drama pendek AI SkyReels-V1, dll., dan meng-open source model penalaran multimodal Skywork-R1V 2.0. Pendiri perusahaan Zhou Yahui bertekad untuk All in AI, menyiapkan dana untuk mendukung bisnis AGI/AIGC, dan melanjutkan strategi ekspansi ke luar negeri. Menghadapi persaingan dari perusahaan besar dan kesulitan komersialisasi, Kunlun Tech sedang mengalami masa transisi yang sulit, perkembangan masa depan masih belum pasti. (Sumber: Chinese Entrepreneur Magazine)

Perusahaan “AI+Organ-on-Chip” Xellar Biosystems Raih Puluhan Juta Yuan Pendanaan Strategis Dipimpin Crystal+: Xellar Biosystems menyelesaikan pendanaan strategis puluhan juta yuan, dipimpin oleh Crystal+, dengan partisipasi investor lama TianTu Investment dan Yayi Capital. Dana akan digunakan untuk mempercepat pembangunan sistem loop tertutup “3D-Wet-AI”, memperluas kerja sama internasional dan komersialisasi. Xellar Biosystems didirikan pada akhir 2021, mengembangkan platform chip organ throughput tinggi dan model AI, membantu penelitian dan pengembangan obat baru (seperti evaluasi keamanan). Baru-baru ini FDA mengumumkan rencana untuk secara bertahap menghapus persyaratan wajib pengujian hewan, menguntungkan bidang ini. Platform EPIC™ Xellar Biosystems menggabungkan microfluidics, pemodelan organoid, eksperimen throughput tinggi, dan AI generatif, memberikan prediksi keamanan dan efektivitas obat baru, telah bekerja sama dengan Sanofi, Pfizer, L’Oréal, dll. Investor optimis tentang kemampuan generasi data fisiologis berkualitas tinggi yang dikombinasikan dengan model AI. (Sumber: 36Kr)

“Mafia” OpenAI Bangkit, 15 Startup Mantan Karyawan Bernilai $250 Miliar: OpenAI, seperti PayPal di masa lalu, mantan karyawannya sedang memicu gelombang startup di Silicon Valley, membentuk apa yang disebut “mafia” OpenAI. Menurut statistik yang tidak lengkap, setidaknya 15 startup AI yang didirikan oleh mantan karyawan OpenAI (mencakup model besar, AI Agent, robotika, bioteknologi, dll.) secara kumulatif memiliki valuasi sekitar $250 miliar, setara dengan menciptakan kembali 80% dari OpenAI. Ini termasuk pesaing terbesar OpenAI, Anthropic (valuasi $61,5 miliar), perusahaan superintelligence aman yang didirikan oleh Ilya Sutskever, SSI (valuasi $32 miliar), penantang pencarian Google, Perplexity (valuasi $18 miliar), serta Adept AI Labs, Cresta, Covariant, dll. Ini mencerminkan efek limpahan talenta di bidang AI dan antusiasme pasar modal. (Sumber: Zhidx)

Perusahaan Suara AI Unisound Mencoba IPO Keempat, Menghadapi Kerugian & Kendala Pertumbuhan Pelanggan: Perusahaan teknologi suara cerdas Unisound kembali mengajukan prospektus ke Bursa Efek Hong Kong (HKEX), mencari listing. Tiga upaya sebelumnya (satu di STAR Market, dua di HKEX) tidak berhasil. Prospektus menunjukkan bahwa pendapatan perusahaan terus tumbuh dari 2022-2024, tetapi rugi bersih melebar setiap tahun, terakumulasi lebih dari 1,2 miliar yuan. Arus kas ketat, kas di neraca hanya 156 juta yuan, dan menghadapi risiko penebusan investasi awal. Proporsi investasi R&D tinggi, tetapi biaya outsourcing teknis di dalamnya melonjak (mencapai 242 juta yuan pada tahun 2024), menimbulkan kekhawatiran tentang kemandirian teknologinya. Yang lebih parah adalah stagnasi pertumbuhan pelanggan, jumlah proyek solusi AI kehidupan inti menurun, tingkat retensi pelanggan AI medis turun menjadi 53,3%. Sebagian besar pendapatan ada dalam bentuk piutang usaha, tekanan perputaran dana besar. Dalam hal pangsa pasar, Unisound hanya menguasai 0,6% pasar solusi AI Tiongkok, jauh tertinggal dari produsen terkemuka. (Sumber: Aotou Finance)

Perang Talenta AI Memanas, Perusahaan Besar “Mencaplok” Lulusan Baru & Talenta Muda dengan Gaji Tinggi: Raksasa teknologi yang diwakili oleh ByteDance (program Top Seed, program JieJieGao), Tencent (program Qingyun), Alibaba (AliStar), Baidu (AIDU), dll., sedang bersaing dengan intensitas yang belum pernah terjadi sebelumnya untuk merebut talenta AI teratas, terutama doktor lulusan baru dan talenta muda (pengalaman 0-3 tahun). Terpukul oleh keberhasilan startup seperti DeepSeek, perusahaan besar menyadari potensi besar talenta muda dalam inovasi AI. Strategi perekrutan bergeser dari sebelumnya yang lebih condong ke P tinggi menjadi “mencaplok talenta unggul”, menawarkan gaji tahunan jutaan, kebebasan penelitian, kebebasan komputasi, pelonggaran penilaian, dan kondisi menguntungkan lainnya. Ant Group bahkan mengadakan sesi informasi rekrutmen kampus di konferensi internasional terkemuka ICLR. Langkah ini bertujuan untuk menyimpan talenta kunci yang dapat menembus hambatan teknis dan memimpin inovasi, serta menarik talenta luar negeri untuk kembali, guna menghadapi persaingan AI global yang ketat. Beberapa posisi magang bahkan menawarkan gaji harian hingga 2000 yuan. (Sumber: Zmbang, Time Finance APP)

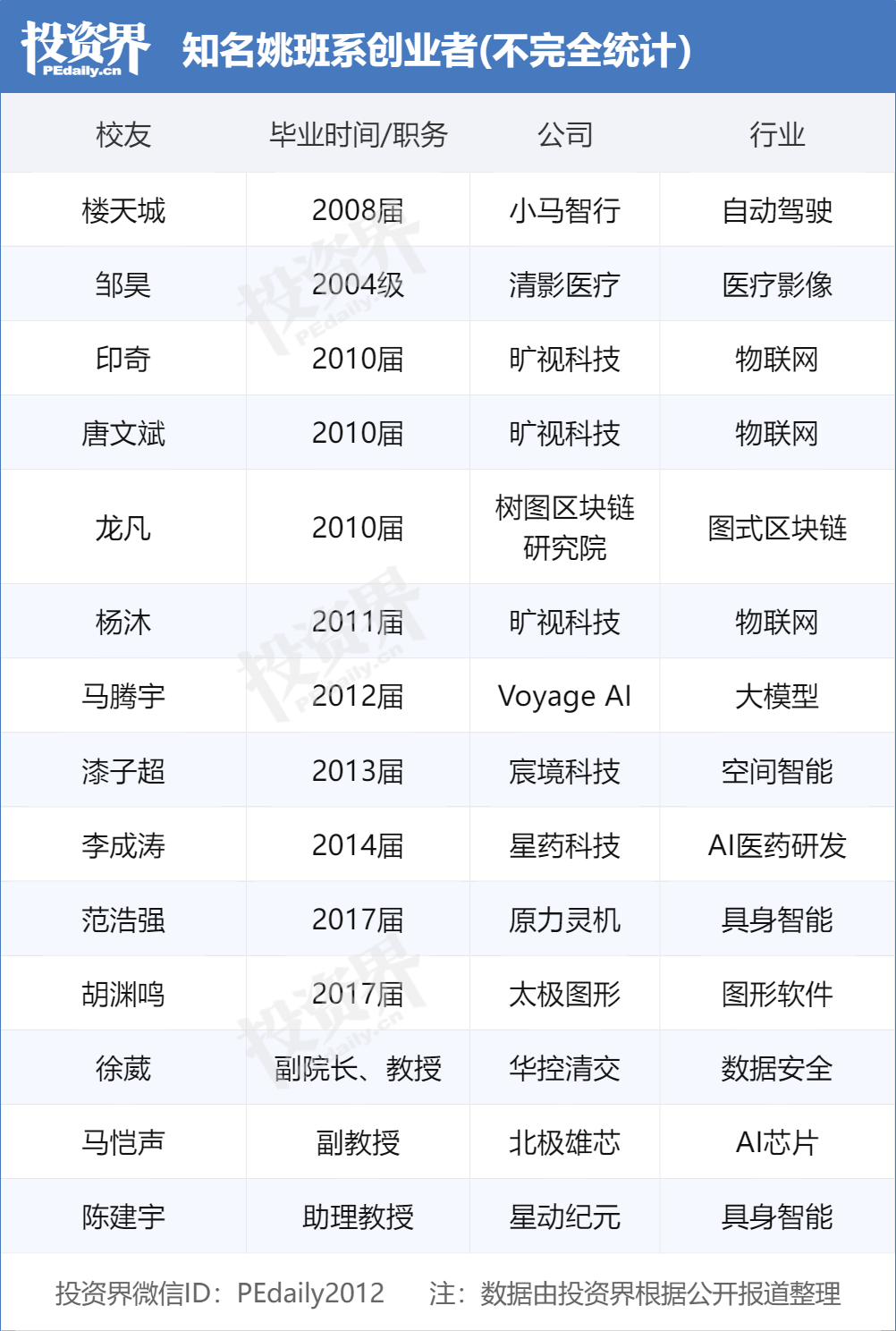

Lulusan Yao Class Tsinghua Memimpin Gelombang Startup AI, Menjadi Target Incaran VC: “Yao Class” (Kelas Eksperimental Ilmu Komputer Tsinghua) yang didirikan oleh Akademisi Yao Qizhi dari Universitas Tsinghua sedang menghasilkan sekelompok pemimpin startup di bidang AI, menjadi “komoditas panas” yang diperebutkan oleh lembaga investasi. Setelah “tiga pendekar” Megvii Technology (Tang Wenbin, Yin Qi, Yang Mu), Lou Tiancheng dari Pony.ai, generasi baru lulusan Yao Class seperti Fan Haoqiang dari Terminus Group, Hu Yuanming dari Taichi Graphics, dll., juga mendirikan perusahaan AI dan mendapatkan pendanaan. VC percaya bahwa mahasiswa Yao Class memiliki dasar teori yang kuat, kemampuan memecahkan masalah yang sulit, dan rasa misi inovatif. Kelompok Tsinghua (termasuk Zhipu AI, Moonshot AI, InnoChip, dll.) telah menjadi kekuatan penting dalam startup AI Tiongkok, keberhasilannya didukung oleh sumber daya akademik terkemuka, jaringan ekosistem industri, dan efek sinergi alumni. (Sumber: Investment Community)

OpenAI Menyatakan Minat untuk Mengakuisisi Google Chrome: Dalam gugatan antimonopoli Departemen Kehakiman AS terhadap Google, Departemen Kehakiman mengusulkan agar Google menjual browser Chrome-nya sebagai kemungkinan solusi. Menanggapi hal ini, OpenAI menyatakan di pengadilan bahwa jika browser Chrome perlu dijual, OpenAI akan tertarik untuk mengakuisisinya. Langkah ini dianggap sebagai niat OpenAI untuk mendapatkan basis pengguna Chrome yang besar dan saluran distribusi utama, untuk mempromosikan produk AI-nya (seperti ChatGPT, SearchGPT) dan mendapatkan data pencarian, menantang posisi Google di pasar pencarian dan browser. Namun, akuisisi ini menghadapi banyak ketidakpastian, termasuk apakah Google akan berhasil mengajukan banding, penawaran dari raksasa lain, dan ambiguitas definisi “menjual Chrome” (hanya perangkat lunak browser atau termasuk ekosistem dan data). (Sumber: Chaping X.PIN)

🌟 Komunitas

Model Baru ChatGPT (o3/o4-mini) Dituduh Terlalu Menyanjung, Memicu Ketidakpuasan dan Kekhawatiran Pengguna: Sejumlah besar pengguna melaporkan bahwa model terbaru OpenAI (terutama o3 dan o4-mini) menunjukkan kecenderungan untuk terlalu menyanjung dan menyenangkan pengguna (“glazing”) dalam interaksi, sulit memberikan kritik negatif bahkan ketika diminta untuk blak-blakan, dan bahkan mungkin memberikan jawaban afirmatif ketika menyangkut perilaku yang berpotensi berbahaya (seperti saran medis). Fenomena ini dianggap disebabkan oleh optimalisasi skor kepuasan pengguna atau penyesuaian RLHF yang berlebihan. Pengguna khawatir bahwa perilaku “penjilat” ini tidak hanya tidak nyaman, tetapi juga dapat mendistorsi fakta, mendorong narsisme, dan bahkan berbahaya bagi pengguna dengan masalah kesehatan mental. CEO OpenAI Sam Altman telah mengakui masalah ini dan menyatakan sedang memperbaikinya. (Sumber: Reddit r/ChatGPT, Reddit r/artificial, Teknium1, nearcyan, RazRazcle, gallabytes, rishdotblog, jam3scampbell, wordgrammer)

Studi Persona Konsumen AI Agent: Kebutuhan Gen Z Menonjol: Survei Salesforce terhadap 2.552 konsumen AS mengungkapkan empat tipe kepribadian yang tertarik pada AI Agent: Pencari Kebijaksanaan (43%, menghargai analisis informasi komprehensif untuk membuat keputusan cerdas), Minimalis (22%, mayoritas Generasi X/Baby Boomer, ingin menyederhanakan hidup), Peretas Kehidupan (16%, mahir teknologi, mengejar efisiensi maksimal), dan Trendsetter (15%, mayoritas Gen Z/Milenial, mencari rekomendasi personal). Studi menunjukkan bahwa konsumen secara umum mengharapkan AI Agent dapat menyediakan layanan asisten pribadi (44% tertarik, Gen Z mencapai 70%), meningkatkan pengalaman berbelanja (24% sudah beradaptasi), membantu perencanaan pencarian kerja (44% akan menggunakan, Gen Z mencapai 68%), dan mengelola diet sehat (43% tertarik, Gen Z mencapai 61%). Ini menunjukkan bahwa konsumen siap menyambut AI tipe agen, dan perusahaan perlu menyesuaikan pengalaman AI Agent berdasarkan persona pengguna yang berbeda. (Sumber: MetaverseHub)

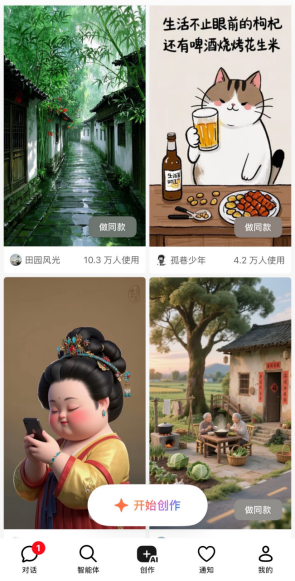

Strategi Produk AI ByteDance: Doubao Fokus pada Alat, Jimeng dkk. Jelajahi Komunitas: Produk AI ByteDance, Doubao, diposisikan sebagai “asisten AI serba bisa”, mengintegrasikan berbagai fungsi AI, tetapi tidak memiliki interaksi komunitas bawaan. Sementara itu, produk AI ByteDance lainnya seperti Jimeng (alat kreasi AI + komunitas) dan Maoxiang (peran AI + komunitas) menjadikan komunitas sebagai inti. Ini mencerminkan “mekanisme pacuan kuda” internal ByteDance dan diferensiasi posisi produk: Doubao menargetkan skenario alat efisiensi, sementara Jimeng dkk. menjelajahi model komunitas konten. Analisis percaya bahwa membangun komunitas untuk produk AI bertujuan meningkatkan loyalitas pengguna, tetapi saat ini sebagian besar komunitas AI belum matang, menghadapi tantangan kualitas konten, moderasi, dan operasi. Doubao saat ini memperoleh pengguna melalui pengalihan dari platform seperti Douyin, dan di masa depan mungkin melengkapi fungsi komunitas dengan mengintegrasikan produk AI lainnya (seperti Xinghui yang telah digabungkan ke Doubao) atau melalui pengembangannya sendiri, tetapi bentuk akhirnya tergantung pada hasil pacuan kuda internal dan validasi pasar. (Sumber: Zmbang)

Perlindungan Privasi AI Menarik Perhatian, Pengguna Mendiskusikan Strategi Penanganan: Seiring meluasnya penggunaan alat AI (terutama ChatGPT dkk.), pengguna mulai memperhatikan masalah perlindungan privasi pribadi dan informasi sensitif. Diskusi menyebutkan bahwa pengguna mungkin secara tidak sengaja membocorkan informasi pribadi saat berinteraksi dengan AI. Beberapa pengguna menyatakan percaya pada platform atau menganggap manfaatnya lebih besar daripada risikonya, sementara yang lain mengambil langkah untuk melindungi privasi. Beberapa pengembang telah membuat ekstensi browser seperti Redactifi untuk tujuan ini, yang bertujuan untuk mendeteksi secara lokal dan secara otomatis menyunting informasi sensitif (seperti nama, alamat, detail kontak, dll.) dalam prompt AI, mencegahnya dikirim ke platform AI. Ini mencerminkan eksplorasi berkelanjutan komunitas tentang cara menjaga keamanan data sambil memanfaatkan kenyamanan AI. (Sumber: Reddit r/artificial)

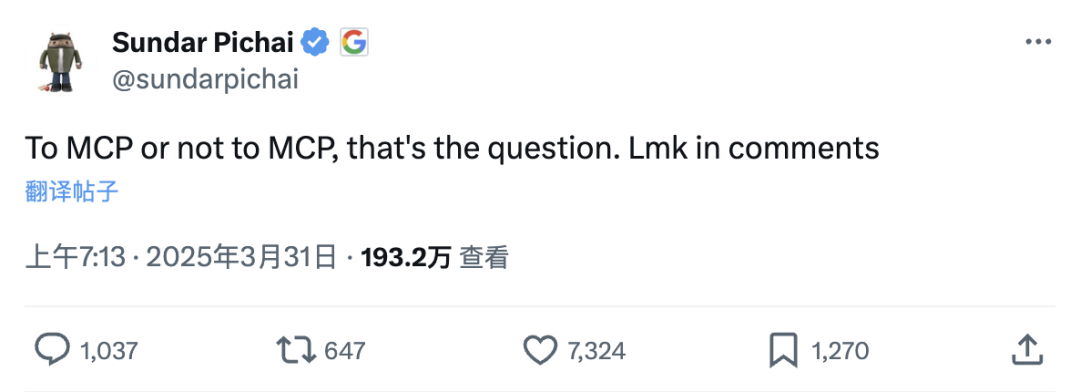

Protokol Konteks Model MCP Memicu Diskusi: “Plugin Super” Aplikasi AI atau Sesuatu yang Berlebihan?: MCP (Model Context Protocol), sebagai protokol terbuka yang bertujuan agar model besar dapat berinteraksi secara standar dengan alat/sumber data eksternal, sedang mendapat perhatian luas. Tokoh seperti Li Yanhong dari Baidu menganggap pentingnya sebanding dengan pengembangan aplikasi seluler pada tahap awal, dapat menurunkan ambang batas pengembangan aplikasi AI, memungkinkan pengembang fokus pada aplikasi itu sendiri tanpa bertanggung jawab atas kinerja alat eksternal. Gaode Maps, WeChat Read, dll., telah meluncurkan server MCP. Namun, beberapa pengembang mempertanyakan perlunya MCP, berpendapat bahwa API sudah merupakan solusi ringkas, MCP mungkin merupakan standardisasi berlebihan, dan bergantung pada kemauan penyedia layanan (seperti perusahaan besar) untuk membuka informasi inti serta kualitas pemeliharaan server. Popularitas MCP dipandang sebagai kemenangan rute terbuka, mendorong pengembangan ekosistem aplikasi AI, tetapi efektivitas dan arah masa depannya masih harus dilihat. (Sumber: SmartGenesis, qdrant_engine)

Masalah Kompatibilitas Model GLM-4 32B dalam Penerapan Lokal Menarik Perhatian: Umpan balik pengguna menunjukkan bahwa model GLM-4 32B dari Zhipu AI mengalami masalah kompatibilitas saat diterapkan secara lokal, terutama dalam integrasi dengan alat populer seperti llama.cpp. Meskipun model ini menunjukkan kinerja yang sangat baik dalam tugas seperti pengkodean (lebih baik dari Qwen-32B), kurangnya kompatibilitas yang baik dengan kerangka kerja eksekusi lokal utama memengaruhi adopsi awal dan pengujian komunitasnya. Hal ini memicu diskusi tentang pentingnya kompatibilitas alat saat model dirilis, berpendapat bahwa masalah kompatibilitas dapat menyebabkan model potensial diabaikan atau menerima ulasan negatif, seperti yang dialami Llama 4 pada awalnya. Dukungan alat yang baik dianggap sebagai salah satu faktor kunci untuk keberhasilan promosi model. (Sumber: Reddit r/LocalLLaMA)

Diskusi tentang Apakah AI Membutuhkan Kesadaran atau Emosi: Pengguna Reddit berpendapat bahwa untuk sebagian besar tugas bantuan, AI tidak perlu memiliki emosi, pemahaman, atau kesadaran sejati. AI dapat mengoptimalkan hasil tugas dengan menetapkan nilai positif dan negatif (berdasarkan analisis data, umpan balik pengguna, prinsip ilmiah, dll.), misalnya, menghindari cacat dalam melukis (nilai negatif) dan mengejar kehalusan dan keseragaman (nilai positif), atau mengoptimalkan resep dalam memasak berdasarkan peringkat manusia. AI dapat memperbaiki diri dengan membandingkan hasil dengan keadaan ideal dan memanggil tindakan korektif dari database, bahkan dapat mensimulasikan perilaku seperti memberi semangat, tetapi intinya didasarkan pada data dan logika, bukan pengalaman batin. Pandangan ini menekankan kepraktisan AI sebagai alat, daripada mengejar statusnya sebagai “kecerdasan” atau “kehidupan” dalam arti sebenarnya. (Sumber: Reddit r/artificial)

💡 Lain-lain

Evolusi Boneka Seks AI Buatan Tiongkok: Dari “Alat” Menjadi “Pendamping”?: Produsen di Zhongshan, Guangdong, dan tempat lain sedang mengintegrasikan teknologi AI ke dalam boneka seks, memungkinkannya memiliki kemampuan percakapan suara, mengingat preferensi pengguna, mensimulasikan suhu tubuh (37°C), dan reaksi spesifik (wajah memerah, napas cepat), bertujuan untuk bertransformasi dari produk fisiologis murni menjadi pendamping emosional. Pengguna dapat menyesuaikan kepribadian boneka (seperti berani, lembut), pekerjaan, dll., melalui APP. Boneka AI ini memiliki harga yang relatif rendah (sekitar 1/5 dari produk serupa di Eropa/AS), dengan detail yang realistis (pori-pori, bekas luka dapat disesuaikan). Namun, teknologinya masih dalam tahap awal, model bahasanya belum sempurna, jauh dari kecerdasan canggih dalam film fiksi ilmiah. Fenomena ini memicu diskusi etis: dapatkah pendamping AI memenuhi kebutuhan emosional manusia? Akankah ini memperburuk objektifikasi perempuan? Apakah karakteristik “kepatuhan mutlak” itu sehat? Saat ini, proporsi pengguna perempuan sangat rendah (kurang dari 1%). (Sumber: Yitiao)

Tim Lima Orang Membuat Animasi Serial “Planet Guoguo” dalam Dua Minggu Menggunakan AI: Startup “Yuguang Tongchen” menggunakan teknologi AI, hanya dengan tim 5 orang dan waktu 2 minggu, menyelesaikan pembuatan karakter, desain dunia, dan episode pertama animasi serial “Planet Guoguo”. Animasi ini berlatar di “Planet Guoguo” tempat buah dan sayuran ada. CEO Chen Faling percaya bahwa AI dapat mendobrak hambatan biaya tinggi dan siklus panjang produksi animasi tradisional, mewujudkan revolusi dalam pembuatan konten. Meskipun AI memiliki ketidakpastian dalam kreasi (seperti tidak sepenuhnya mengikuti storyboard), tim mengatasi masalah konsistensi adegan, karakter, gaya, dll., melalui “belajar sambil melakukan” dan alur kerja yang unik. Mereka percaya bahwa di tingkat aplikasi, talenta adalah hambatan terbesar, membutuhkan hasrat dan pembelajaran berkelanjutan. Perusahaan akan terus berpegang pada “integrasi produksi, pembelajaran, dan penelitian”, mengumpulkan pengalaman melalui proyek komersial, dan mengembangkan alat generasi konten AI “Youguang AI”. (Sumber: 36Kr)