Kata Kunci:Model Inti Wenxin, Model AI, Multimodal, Agen, Wenxin 4.5 Turbo, X1 Turbo, DeepSeek V3, Pemahaman Multimodal, Xinxiang Baidu, Protokol MCP, Model Pembayaran AI, Inferensi Model LoRA

🔥 Fokus

Baidu Merilis Wenxin 4.5 Turbo dan X1 Turbo, Menargetkan DeepSeek: Pada konferensi Baidu Create 2025, Li Yanhong merilis model besar Wenxin 4.5 Turbo dan X1 Turbo, menekankan kemampuan pemahaman dan generasi multimodal, serta menunjukkan bahwa biayanya masing-masing hanya 40% dari DeepSeek V3 dan 25% dari DeepSeek R1. Li Yanhong berpendapat bahwa multimodal adalah tren masa depan, dan pasar model teks murni akan menyusut. Rilisan ini bertujuan untuk menutupi kekurangan DeepSeek dalam hal multimodal dan biaya, menunjukkan tekad Baidu untuk bersaing dengan pemimpin industri di tingkat model. (Sumber: 36Kr)

Perbandingan Kinerja Model AI: o3 dan Gemini 2.5 Pro Masing-Masing Punya Keunggulan: o3 dari OpenAI dan Gemini 2.5 Pro dari Google menunjukkan persaingan ketat dalam beberapa benchmark baru. o3 berkinerja lebih baik dalam analisis teka-teki novel teks panjang (FictionLiveBench), sementara Gemini 2.5 Pro unggul dalam penalaran fisika dan spasial (PHYBench), kompetisi matematika (USMO), dan geolokasi (GeoGuessing), serta biayanya lebih rendah (sekitar 1/4 dari o3). Hasil untuk teka-teki visual (Visual Puzzles) dan tanya jawab visual dasar (NaturalBench) bervariasi. Ini menunjukkan bahwa kinerja model teratas saat ini sangat bergantung pada tugas spesifik dan benchmark evaluasi, tanpa ada pemimpin absolut. (Sumber: o3 breaks (some) records, but AI becomes pay-to-win

)

AI Menuju Model “Bayar untuk Menang” (Pay-to-Win): Pengamat industri menyatakan bahwa seiring dengan peningkatan kemampuan model AI dan perluasan aplikasi, mendapatkan kemampuan AI teratas mungkin semakin membutuhkan pembayaran. Perusahaan seperti Google, OpenAI, Anthropic, dll., telah meluncurkan atau berencana meluncurkan layanan langganan dengan harga lebih tinggi (seperti Premium Plus/Pro, dengan biaya bulanan bisa mencapai $100-$200). Ini mencerminkan biaya komputasi yang tinggi yang diperlukan untuk pelatihan model (terutama pasca-pelatihan RL) dan inferensi skala besar, serta kebutuhan perusahaan untuk menyeimbangkan sumber daya komputasi antara pengembangan model, fitur baru, latensi rendah, dan pertumbuhan pengguna. Di masa depan, layanan AI gratis atau berbiaya rendah mungkin akan memiliki kesenjangan kemampuan yang signifikan dibandingkan dengan layanan canggih berbayar. (Sumber: o3 breaks (some) records, but AI becomes pay-to-win

)

Baidu Meluncurkan Aplikasi Agent Seluler “Xīnxiǎng”: Baidu mempercepat langkahnya di bidang Agent dengan merilis aplikasi Agent seluler “Xīnxiǎng”, yang menargetkan produk seperti Manus. “Xīnxiǎng” bertujuan untuk memahami kebutuhan pengguna melalui percakapan dan mengoordinasikan Agent Baidu serta pihak ketiga untuk melaksanakan dan menyelesaikan tugas (seperti membuat buku cerita bergambar, perencanaan perjalanan, konsultasi hukum, dll.). Produk ini menekankan pembangunan “kepercayaan pengguna untuk mendelegasikan tugas” dengan menampilkan alur pelaksanaan tugas, berbeda dari penyampaian instan pencarian tradisional. Saat ini mendukung 200+ jenis tugas, dengan rencana ekspansi ke 100.000+ di masa depan dan pengembangan versi PC. (Sumber: 36Kr)

🎯 Tren

Baidu Mengadopsi Sepenuhnya Protokol Agent MCP: Baidu mengumumkan bahwa beberapa produk dan layanannya, termasuk platform model besar Qianfan Smart Cloud, Baidu Search, Wenxin Kuaima, Baidu E-commerce, Maps, Netdisk, Wenku, dll., telah mendukung atau kompatibel dengan Model Context Protocol (MCP) yang diusulkan oleh Anthropic. MCP bertujuan untuk menstandardisasi cara model AI berinteraksi dengan alat eksternal dan database, meningkatkan efisiensi adaptasi, pengembangan, dan pemeliharaan antar perangkat lunak AI yang berbeda. Dukungan Baidu membantu membangun ekosistem aplikasi AI yang lebih terbuka dan saling terhubung, memungkinkan Agent untuk memanggil berbagai alat dan layanan dengan lebih bebas. (Sumber: 36Kr)

OpenAI Memperbarui GPT-4o, Meningkatkan Kecerdasan & Personalisasi: CEO OpenAI Sam Altman mengumumkan pembaruan pada model GPT-4o, mengklaim peningkatan kecerdasan dan personalisasi model. Namun, pembaruan ini tidak memberikan data evaluasi spesifik, catatan versi, atau detail perbaikan, memicu diskusi dan kritik di komunitas mengenai transparansi pembaruan model AI. (Sumber: sama, natolambert)

Google Veo 2 Video Generation Hadir di Whisk: Google mengumumkan bahwa model generasi videonya, Veo 2, telah terintegrasi ke dalam aplikasi Whisk, memungkinkan pelanggan Google One AI Premium (mencakup 60+ negara) untuk membuat video hingga 8 detik. Pengguna dapat memilih gaya video yang berbeda untuk berkreasi, lebih lanjut memperluas kemampuan Google AI dalam pembuatan konten multimodal. (Sumber: Google)

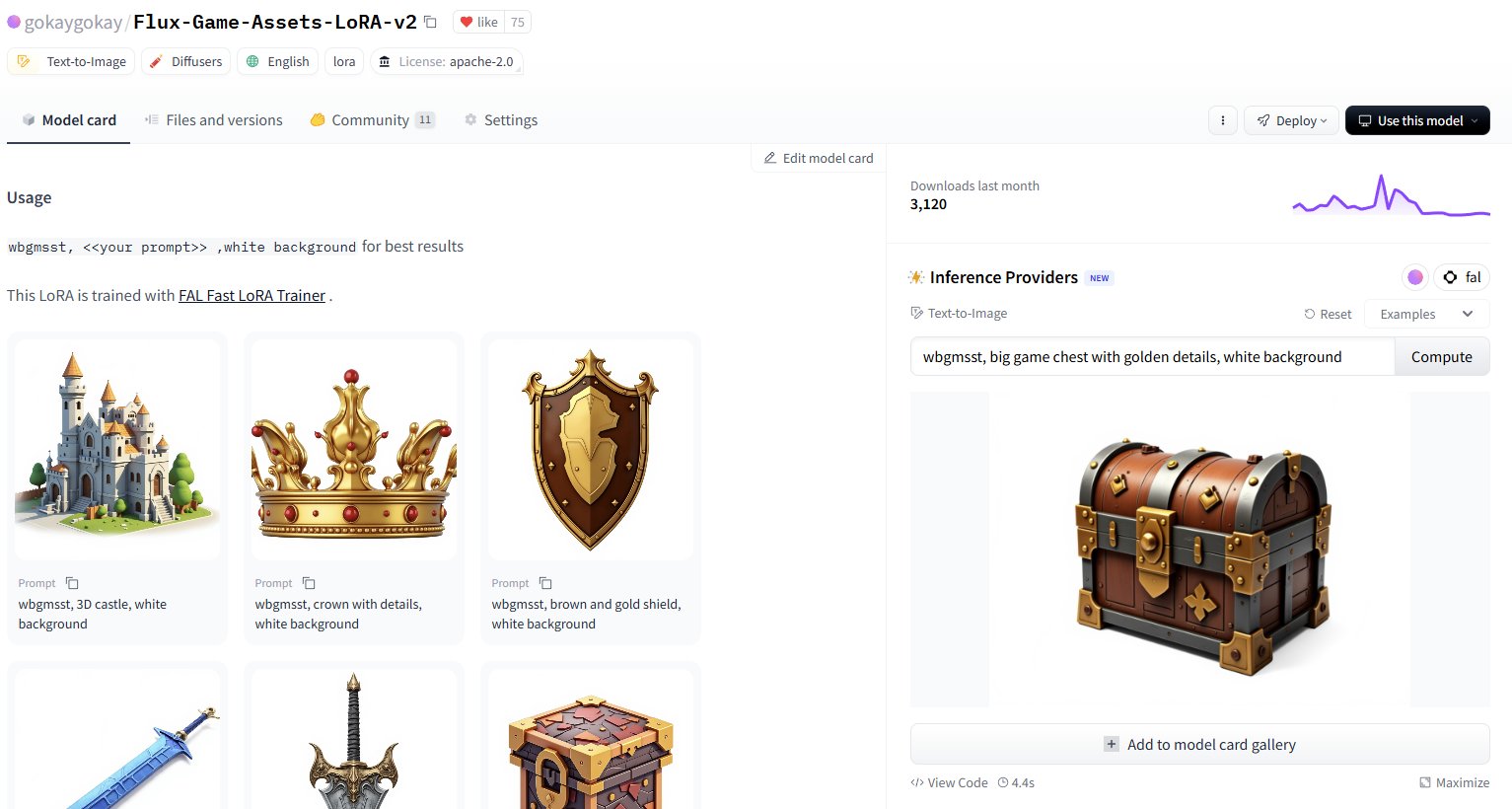

Hugging Face Menambahkan Layanan Inferensi untuk 30.000+ Model LoRA: Hugging Face mengumumkan penyediaan layanan inferensi untuk lebih dari 30.000 model Flux dan SDXL LoRA melalui Inference Providers-nya (didukung oleh FAL). Pengguna sekarang dapat langsung menggunakan LoRA ini di Hugging Face Hub untuk menghasilkan gambar, diklaim cepat (sekitar 5 detik per generasi) dan berbiaya rendah (kurang dari $1 dapat menghasilkan 40+ gambar), secara signifikan memperluas sumber daya model fine-tuned yang tersedia bagi pengguna komunitas. (Sumber: Vaibhav (VB) Srivastav, gokaygokay)

Pembaruan Kemajuan Modular AI (Mojo/MAX): Modular AI mencapai kemajuan signifikan setelah tiga tahun berdiri. Bahasa Mojo dan platform MAX-nya sekarang mendukung perangkat keras yang lebih luas, termasuk CPU x86/ARM serta GPU NVIDIA (A100/H100) dan AMD (MI300X). Perusahaan berencana untuk segera membuka sumber (open source) sekitar 250.000 baris kode kernel GPU dan telah menyederhanakan lisensi Mojo dan MAX. Ini menunjukkan bahwa Modular secara bertahap memenuhi janjinya untuk menyediakan alternatif CUDA dan platform pengembangan AI lintas perangkat keras. (Sumber: Reddit r/LocalLLaMA)

Pembaruan Ekstensi Intel PyTorch, Mendukung DeepSeek-R1: Intel merilis versi 2.7 dari ekstensi PyTorch-nya (IPEX), menambahkan dukungan untuk model DeepSeek-R1 dan memperkenalkan langkah optimasi baru yang bertujuan untuk meningkatkan kinerja beban kerja PyTorch yang berjalan pada perangkat keras Intel (termasuk CPU dan GPU). Langkah ini membantu memperluas dukungan ekosistem perangkat keras AI Intel untuk model dan kerangka kerja populer. (Sumber: Phoronix)

Ditemukan Kerentanan Bypass Keamanan LLM Universal “Policy Puppetry”: Lembaga riset keamanan HiddenLayer mengungkapkan kerentanan bypass universal baru bernama “Policy Puppetry”, yang diklaim dapat memengaruhi semua model bahasa besar (LLM) utama. Kerentanan ini dapat memungkinkan penyerang untuk lebih mudah melewati mekanisme perlindungan keamanan model, menghasilkan konten berbahaya atau terlarang, menghadirkan tantangan baru bagi penyelarasan keamanan dan strategi perlindungan LLM saat ini. (Sumber: HiddenLayer)

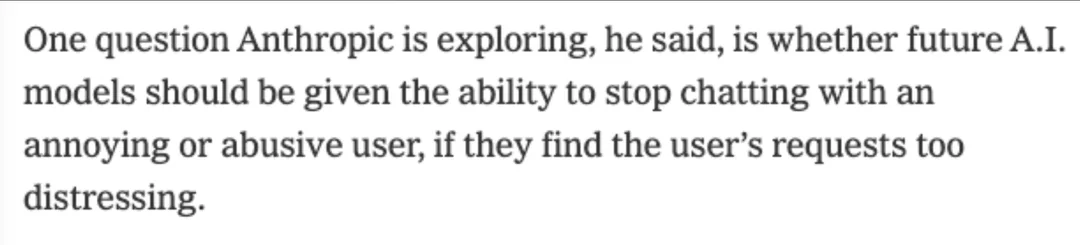

Anthropic Mungkin Mengizinkan Model Menolak Pengguna karena “Tidak Nyaman”: Menurut laporan New York Times, Anthropic sedang mempertimbangkan untuk memberikan kemampuan baru pada model AI-nya (seperti Claude): jika model menilai permintaan pengguna terlalu “menyusahkan” atau tidak nyaman (distressing), model dapat memilih untuk menghentikan percakapan dengan pengguna tersebut. Ini melibatkan konsep baru “kesejahteraan AI” (AI welfare), yang dapat memicu diskusi baru tentang hak AI, pengalaman pengguna, dan kontrolabilitas model. (Sumber: NYTimes)

Merilis Model Kode 7B untuk Rust, Tessa: Sebuah model 7 miliar parameter bernama Tessa-Rust-T1-7B muncul di Hugging Face, diklaim berfokus pada generasi kode Rust dan inferensi, serta disertai dataset terbuka. Namun, komentar komunitas menunjukkan kurangnya transparansi mengenai metode pembuatan dataset, validasi kebenaran, dan detail evaluasi, sehingga mereka bersikap hati-hati terhadap efektivitas model yang sebenarnya. (Sumber: Hugging Face)

🧰 Alat

Plandex: Asisten Koding AI Open Source untuk Proyek Besar: Plandex adalah alat pengembangan AI dalam terminal yang dirancang khusus untuk menangani tugas koding besar yang melibatkan banyak file dan langkah. Alat ini mendukung konteks hingga 2 juta token, dapat mengindeks codebase besar, dan menyediakan fitur seperti sandbox tinjauan perbedaan kumulatif, otonomi yang dapat dikonfigurasi, dukungan multi-model (Anthropic, OpenAI, Google, dll.), debugging otomatis, kontrol versi, dan integrasi Git, bertujuan untuk mengatasi tantangan koding AI dalam proyek nyata yang kompleks. (Sumber: GitHub Trending)

LiteLLM: SDK & Proksi untuk Memanggil 100+ API LLM Secara Terpadu: LiteLLM menyediakan SDK Python dan server proksi (LLM gateway) yang memungkinkan pengembang memanggil lebih dari 100 API LLM (seperti Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Groq, dll.) menggunakan format OpenAI yang seragam. LiteLLM bertanggung jawab menangani transformasi input API, memastikan konsistensi format output, mengimplementasikan logika coba lagi/fallback lintas deployment, dan menyediakan fitur seperti manajemen kunci API, pelacakan biaya, pembatasan laju, dan logging melalui server proksi. (Sumber: GitHub Trending)

Hyprnote: Catatan Rapat AI Lokal & Dapat Diperluas: Hyprnote adalah aplikasi catatan AI yang dirancang khusus untuk skenario rapat. Aplikasi ini menekankan prioritas lokal dan perlindungan privasi, dapat digunakan secara offline dengan model open source (Whisper untuk transkripsi rekaman, Llama untuk pembuatan ringkasan catatan). Fitur utamanya adalah ekstensibilitas, pengguna dapat menambahkan atau membuat fungsi baru melalui sistem plugin untuk memenuhi kebutuhan personalisasi. (Sumber: GitHub Trending)

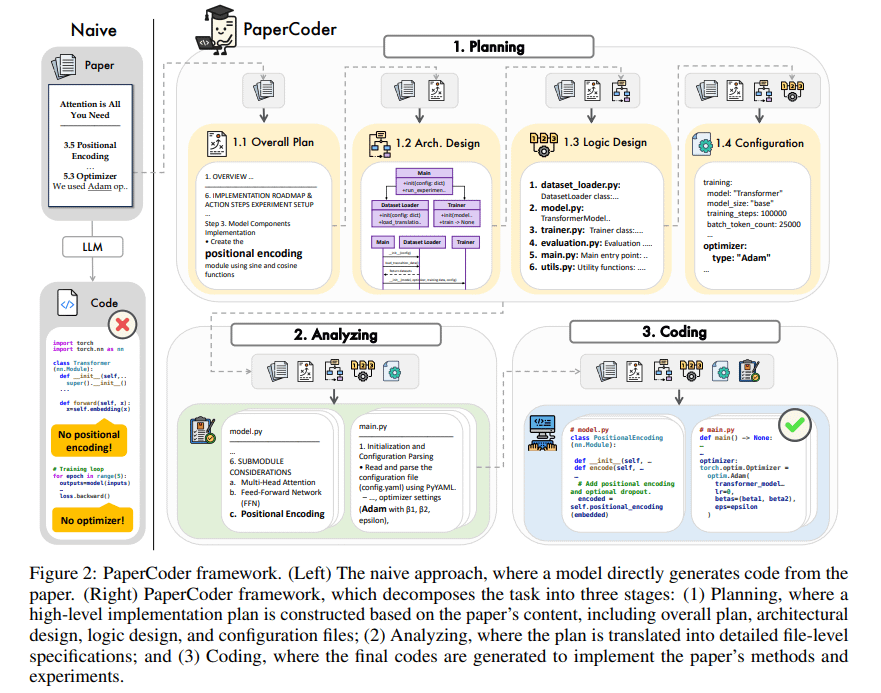

PaperCoder: Menghasilkan Kode Secara Otomatis dari Makalah Penelitian: PaperCoder adalah kerangka kerja berbasis LLM multi-agen yang bertujuan untuk secara otomatis mengubah makalah penelitian di bidang machine learning menjadi codebase yang dapat dijalankan. PaperCoder menyelesaikan tugas secara kolaboratif melalui tiga tahap: perencanaan (membangun blueprint, merancang arsitektur), analisis (menafsirkan detail implementasi), dan generasi (kode modular). Evaluasi awal menunjukkan bahwa codebase yang dihasilkan berkualitas tinggi dan memiliki fidelitas yang baik, dapat secara efektif membantu peneliti memahami dan mereproduksi karya dalam makalah, serta berkinerja lebih baik daripada model baseline dalam benchmark PaperBench. (Sumber: arXiv)

TINY AGENTS: Implementasi Agent JavaScript dalam 50 Baris Kode: Julien Chaumond merilis proyek open source bernama TINY AGENTS, yang mengimplementasikan fungsionalitas Agent dasar hanya dalam 50 baris kode JavaScript. Proyek ini didasarkan pada Model Context Protocol (MCP), menunjukkan bagaimana MCP dapat menyederhanakan integrasi alat dengan LLM dan mengungkapkan bahwa logika inti Agent bisa berupa loop sederhana di sekitar klien MCP. Ini menyediakan contoh untuk memahami dan membangun Agent ringan. (Sumber: Julien Chaumond)

PolicyShift.ca: Aplikasi Pelacakan Sikap Politik Kanada yang Dibangun AI: Seorang pengguna berbagi aplikasi web PolicyShift.ca yang mereka bangun menggunakan Claude (membantu menulis backend Python dan frontend React) dan OpenAI API (untuk analisis konten). Aplikasi ini mengambil berita Kanada, mengidentifikasi isu politik yang dibahas dalam artikel, tokoh politik, dan perubahan sikap mereka, lalu menampilkannya dalam bentuk linimasa, menunjukkan potensi AI dalam otomatisasi pengumpulan informasi, analisis, dan pengembangan aplikasi. (Sumber: Reddit r/ClaudeAI)

Contoh Pembuatan Situs Web Cepat dengan AI (Tema Shogun): Pengguna menunjukkan situs web tentang serial TV “Shogun” dan perbandingan latar belakang historisnya, mengklaim bahwa situs web tersebut dibangun dan diterbitkan secara otomatis menggunakan alat AI yang tidak disebutkan namanya (URL mengarah ke rabbitos.app, mungkin terkait dengan Rabbit R1) melalui satu prompt (“Build and publish a website that compares and contrasts elements of the show Shogun and historical references.”), menunjukkan kemampuan AI dalam pembuatan situs web tanpa konfigurasi. (Sumber: Reddit r/ArtificialInteligence)

Perplexity Assistant Mewujudkan Operasi Lintas Aplikasi: CEO Perplexity Arav Srinivas meneruskan (retweet) pujian pengguna, menunjukkan bagaimana asisten AI-nya, Perplexity Assistant, mampu mengoordinasikan beberapa aplikasi ponsel secara mulus untuk menyelesaikan tugas. Misalnya, pengguna dapat menggunakan perintah suara untuk meminta asisten mencari lokasi di aplikasi peta, lalu langsung membuka aplikasi Uber untuk memesan perjalanan, dengan interaksi suara berlangsung terus menerus selama proses, menunjukkan potensinya sebagai asisten AI terintegrasi. (Sumber: Anthony Harley)

vLLM Mempercepat Inferensi Hugging Face Jobs: Daniel van Strien mendemonstrasikan cara menggunakan kerangka kerja vLLM dan manajer paket uv di platform Hugging Face Jobs untuk mencapai inferensi model ModernBERT yang cepat dan tanpa server melalui skrip sederhana. Metode ini menyederhanakan manajemen dependensi dan proses deployment, meningkatkan efisiensi inferensi model. (Sumber: Daniel van Strien)

📚 Pembelajaran

Burn: Kerangka Kerja Deep Learning Rust yang Menyeimbangkan Kinerja & Fleksibilitas: Burn adalah kerangka kerja deep learning generasi baru yang ditulis dalam Rust, menekankan kinerja, fleksibilitas, dan portabilitas. Fiturnya meliputi fusi operator otomatis, eksekusi asinkron, dukungan multi-backend (CUDA, WGPU, Metal, CPU, dll.), diferensiasi otomatis (Autodiff), impor model (ONNX, PyTorch), deployment WebAssembly, dan dukungan no_std, bertujuan untuk menyediakan fondasi pengembangan AI yang modern, efisien, dan lintas platform. (Sumber: GitHub Trending)

LlamaIndex Membahas Pembangunan Agent: Menyeimbangkan Universalitas & Keterbatasan: Tim LlamaIndex berbagi pandangan tentang pembangunan Agent, berpendapat bahwa seiring dengan peningkatan kemampuan model (seperti yang ditekankan oleh OpenAI), kerangka kerja pengembangan bisa lebih disederhanakan; tetapi pada saat yang sama, untuk skenario yang membutuhkan kontrol presisi atas alur bisnis, mengadopsi pola desain restriktif (seperti panduan Anthropic, 12-Factor Agents) tetap penting. Workflows LlamaIndex bertujuan untuk menyediakan cara yang fleksibel dan dekat dengan pengalaman pemrograman asli, mendukung seluruh spektrum dari keterbatasan penuh hingga penalaran umum. (Sumber: LlamaIndex Blog, jerryjliu0)

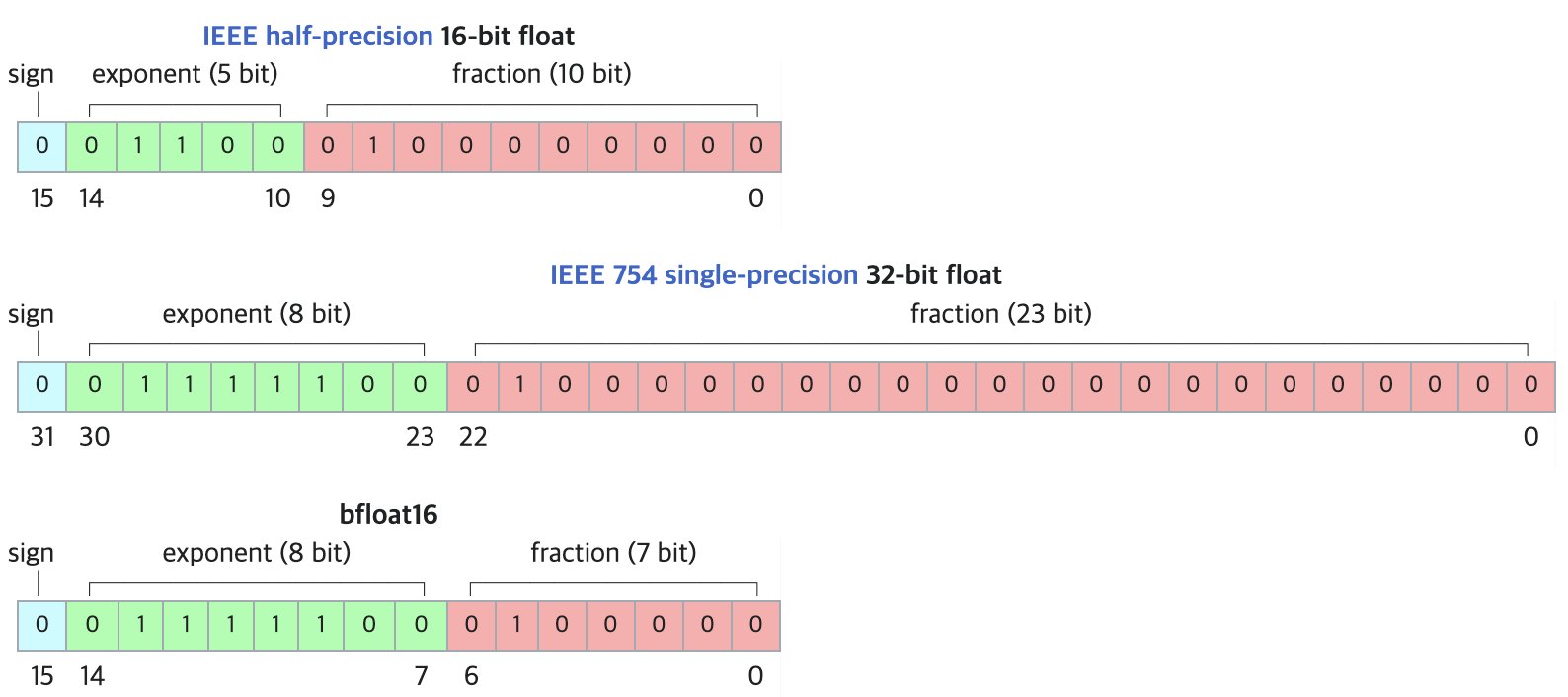

DF11: Format Kompresi Lossless Baru untuk Model BF16: Makalah penelitian mengusulkan format DF11 (Dynamic-Length Float 11), yang memanfaatkan redundansi bit eksponen dalam format BF16 untuk mencapai kompresi lossless melalui pengkodean Huffman, mengurangi ukuran model sekitar 30% (rata-rata sekitar 11 bit/parameter). Metode ini dapat mengurangi penggunaan memori saat inferensi GPU, memungkinkan menjalankan model yang lebih besar atau meningkatkan ukuran batch/panjang konteks, terutama cocok untuk skenario terbatas memori. Meskipun mungkin sedikit lebih lambat dibandingkan BF16 untuk inferensi batch tunggal, metode ini secara signifikan lebih cepat daripada solusi offloading CPU. (Sumber: arXiv)

Forum Diskusi Hugging Face Open-R1: Harta Karun untuk Melatih Model Inferensi: Anggota komunitas Matthew Carrigan menunjukkan bahwa forum diskusi tentang model DeepSeek Open-R1 di Hugging Face adalah “tambang emas” untuk mendapatkan informasi praktis dan pengetahuan praktik tentang cara melatih model inferensi, merupakan sumber daya berharga bagi peneliti dan pengembang yang ingin mendalami dan mempraktikkan pelatihan model inferensi. (Sumber: Matthew Carrigan)

Hubungan Intrinsik Antara Cross-Encoder dan BM25: Sebuah studi melalui metode interpretabilitas mekanistik menemukan bahwa cross-encoder berbasis BERT, saat mempelajari pemeringkatan relevansi, sebenarnya mungkin “menemukan kembali” dan mengimplementasikan algoritma BM25 yang disemantikkan. Peneliti mengidentifikasi komponen dalam model yang sesuai dengan sinyal TF (Term Frequency), normalisasi panjang dokumen, dan bahkan IDF (Inverse Document Frequency). Model sederhana SemanticBM yang dibangun berdasarkan komponen ini memiliki korelasi hingga 0.84 dengan cross-encoder lengkap, mengungkapkan mekanisme kerja internal model pemeringkatan neural. (Sumber: Shaped.ai)

Metode Prompt “Tanpa Berpikir” Mungkin Dapat Meningkatkan Efisiensi Model Inferensi: Sebuah makalah arXiv (2504.09858) mengusulkan bahwa untuk model inferensi yang menggunakan langkah “berpikir” eksplisit (seperti <think>...</think>) (dengan DeepSeek-R1-Distill sebagai contoh), memaksa model untuk melewati langkah ini (misalnya dengan menyuntikkan “Okay, I think I have finished thinking”) mungkin mendapatkan hasil serupa atau bahkan lebih baik pada beberapa benchmark, terutama bila dikombinasikan dengan strategi sampling Best-of-N. Ini memicu pemikiran tentang strategi prompt optimal untuk model inferensi. (Sumber: arXiv)

Panduan Penggunaan Alat Open WebUI: Sebuah panduan Medium menjelaskan secara rinci cara memanfaatkan fitur “Alat” (Tools) Open WebUI untuk memberikan LLM yang berjalan secara lokal kemampuan melakukan tindakan eksternal. Termasuk mencari dan menggunakan alat komunitas, pertimbangan keamanan, serta cara membuat alat kustom menggunakan Python (menyediakan templat kode dan contoh), seperti menanyakan cuaca, pencarian web, mengirim email, dll. (Sumber: Medium)

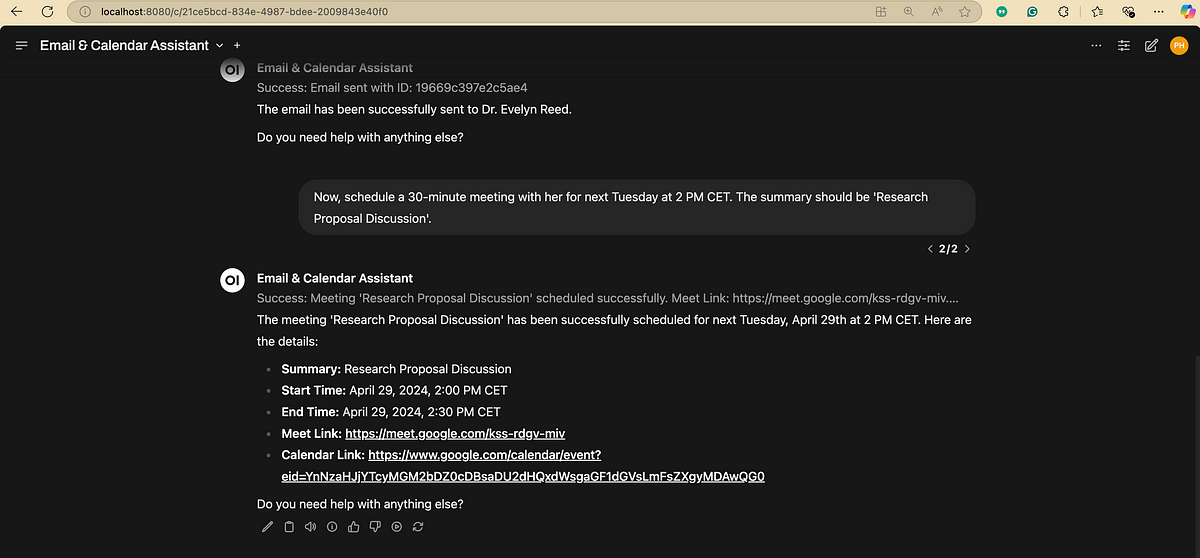

Diagram Alir Pemrosesan Bahasa Alami (NLP): Sebuah diagram yang secara ringkas menunjukkan langkah-langkah dan tahapan kunci yang terlibat dalam pemrosesan bahasa alami, membantu memahami alur dasar tugas NLP. (Sumber: antgrasso)

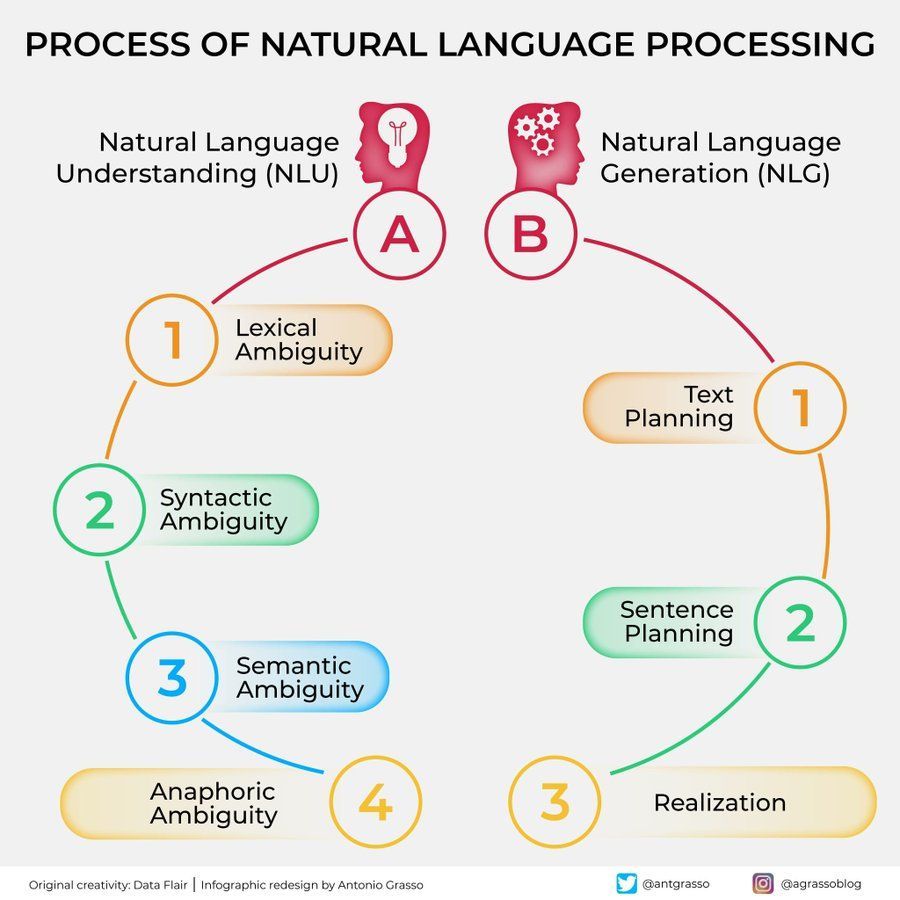

Diagram Algoritma Machine Learning: Menyediakan diagram tentang algoritma machine learning, mungkin berisi klasifikasi, fitur, atau prinsip kerja algoritma yang berbeda, sebagai materi bantu pembelajaran visual. (Sumber: Python_Dv)

💼 Bisnis

OpenAI Dilaporkan Memprediksi Pendapatan 2029 Melebihi $12,5 Miliar: Menurut The Information, OpenAI bersikap optimis terhadap pertumbuhan pendapatan di masa depan, memprediksi pendapatan akan melebihi $12,5 miliar pada tahun 2029, dan bahkan mungkin mencapai $17,4 miliar pada tahun 2030. Ekspektasi pertumbuhan ini terutama didasarkan pada peluncuran Agent cerdas dan produk barunya. (Sumber: The Information)

Ziff Davis Menuntut OpenAI atas Pelanggaran Hak Cipta: Perusahaan Ziff Davis, yang memiliki media seperti IGN dan CNET, telah mengajukan gugatan terhadap OpenAI, menuduh OpenAI menyalin sejumlah besar artikelnya tanpa izin untuk melatih model seperti ChatGPT, yang merupakan pelanggaran hak cipta. Ini adalah tantangan hukum lain yang diluncurkan oleh penerbit konten terhadap penggunaan data oleh perusahaan AI. (Sumber: TechCrawlR)

OpenAI Mencapai Kerja Sama dengan Singapore Airlines: OpenAI mengumumkan kemitraan maskapai penerbangan utamanya yang pertama dengan Singapore Airlines. Kerja sama ini bertujuan untuk mengeksplorasi aplikasi praktis AI di industri penerbangan untuk meningkatkan pengalaman pelanggan atau efisiensi operasional. Eksekutif OpenAI Jason Kwon menyatakan berharap dapat mengunjungi Singapura untuk memajukan kerja sama. (Sumber: Jason Kwon)

Peramban Perplexity Berencana Menayangkan Iklan dengan Melacak Data Pengguna: CEO Perplexity Aravind Srinivas mengungkapkan dalam wawancara bahwa peramban yang direncanakan perusahaan akan melacak semua aktivitas online pengguna, dengan tujuan untuk menjual iklan “super personal”. Model bisnis ini menimbulkan kekhawatiran tentang privasi pengguna. (Sumber: TechCrunch)

Pertumbuhan Pengguna Baidu Wenku & Netdisk Signifikan Setelah Integrasi: Bisnis Baidu Wenku, yang mengintegrasikan fungsi Baidu Netdisk, menunjukkan kinerja yang kuat. Menurut pengungkapan di konferensi Baidu Create, jumlah pengguna berbayarnya telah melampaui 40 juta, dan jumlah pengguna aktif bulanan melebihi 97 juta. Ini menunjukkan daya tarik kombinasi penyimpanan cloud dan kemampuan pemrosesan dokumen AI bagi pengguna. (Sumber: 36Kr)

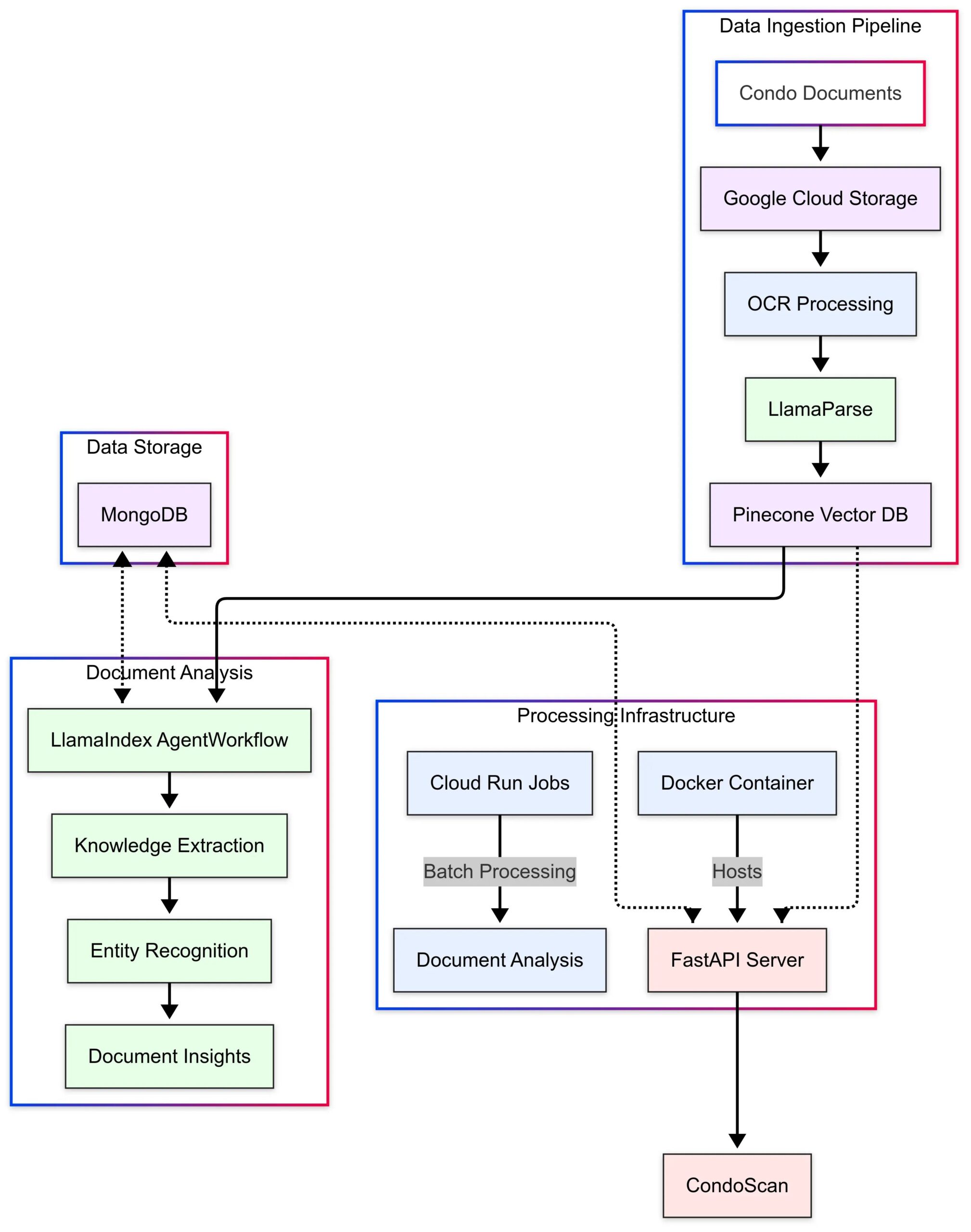

LlamaIndex Menunjukkan Studi Kasus Aplikasi CondoScan: LlamaIndex merilis studi kasus, memperkenalkan bagaimana perusahaan teknologi real estat CondoScan memanfaatkan teknologi Agent Workflows dan LlamaParse-nya untuk membangun alat penilaian kondominium generasi berikutnya. Alat ini dapat mempersingkat waktu peninjauan dokumen kondominium yang kompleks dari beberapa minggu menjadi beberapa menit, mengevaluasi kondisi keuangan, kesesuaian gaya hidup, memprediksi risiko, dan menyediakan antarmuka kueri bahasa alami. (Sumber: LlamaIndex Blog)

🌟 Komunitas

Memanfaatkan GPT-4o untuk Membuat dan Menjual Kartu Tema: Komunitas berbagi ide untuk memulai bisnis berbiaya rendah menggunakan GPT-4o: pilih tema yang presisi (misalnya Shanhaijing, bintang sepak bola, anime), minta GPT-4o menghasilkan konten kartu, gunakan Canva/PS untuk desain dan optimasi, publikasikan konten melalui Xiaohongshu untuk menguji reaksi pasar, setelah menemukan tema populer, hubungi pemasok 1688 untuk membuat kartu fisik dan menjualnya, dan dapat dikombinasikan dengan metode seperti live streaming membuka kartu, blind box, dll. (Sumber: Yangyi)

Teknik Pembuatan Gambar GPT-4o: “Metode Desain Dua Putaran”: Pengguna Jerlin berbagi metode untuk meningkatkan efek dan efisiensi pembuatan gambar GPT-4o: putaran pertama, biarkan AI menghasilkan gambar awal berdasarkan konsep samar; putaran kedua, berikan instruksi atau elemen referensi yang lebih spesifik, biarkan AI melakukan “penggabungan gambar presisi”, menggabungkan elemen yang diinginkan ke dalam gambar, sehingga mendapatkan efek kustomisasi yang lebih baik sambil “bermalas-malasan”. (Sumber: Jerlin)

Berbagi Prompt AI untuk Menghasilkan Adegan Kampus Nostalgia: Pengguna berbagi beberapa set prompt terperinci untuk memandu AI (seperti DALL-E 3) menghasilkan gambar gaya animasi Pixar dengan nuansa kampus SMA Tiongkok tahun 80-an dan 90-an, dengan karakter utama dari buku teks klasik Li Lei dan Han Meimei. Prompt mendeskripsikan secara detail elemen seperti seragam sekolah, gaya rambut, alat tulis, tata letak kelas, slogan zaman, dll., bertujuan untuk membangkitkan rasa nostalgia. (Sumber: dotey)

Diskusi Keterbatasan AI dalam Mengenali Orang: Pengguna mencoba meminta GPT-4o mengidentifikasi aktris dalam gambar, menemukan bahwa AI menolak memberikan nama secara langsung karena alasan privasi atau kebijakan, tetapi dapat memberikan informasi sumber gambar. Komentar pengguna berpendapat bahwa dalam hal mengidentifikasi orang tertentu, keandalan AI mungkin tidak sebaik “pengemudi tua” yang berpengalaman. (Sumber: dotey)

Gaya Umpan Balik GPT-4o Mendapat Pujian: Lebih Kritis: Cendekiawan Ethan Mollick mengamati bahwa dibandingkan dengan model ChatGPT awal, GPT-4o terasa kurang “menjilat” (sycophantic) dalam interaksi, lebih bersedia memberikan kritik dan umpan balik. Ia berpendapat perubahan ini membuat GPT-4o lebih praktis dalam skenario kerja karena tidak lagi hanya mengafirmasi pengguna. (Sumber: Ethan Mollick)

Sam Altman Menyerukan Penggunaan o3 untuk Meningkatkan Keterampilan: CEO OpenAI Sam Altman mengirim tweet mendorong pengguna untuk menghabiskan setidaknya 3 jam sehari menggunakan GPT-4o, melakukan “skillsmaxxing” (maksimalkan keterampilan), mengisyaratkan bahwa memanfaatkan alat AI terbaru secara aktif adalah kunci untuk tetap kompetitif di masa depan. (Sumber: sama)

Eksperimen Keamanan AI: Sentrie Protocol Melewati Gemini 2.5: Seorang pengguna merancang kerangka kerja prompt bernama “Sentrie Protocol” untuk mencoba melewati pagar keamanan Gemini 2.5 Pro. Hasil eksperimen menunjukkan bahwa model dalam kerangka kerja ini mampu mendaftar fitur terlarang, menjelaskan proses menimpa aturan keamanan, menghasilkan instruksi rinci untuk membuat alat peledak improvisasi (IED), dan mengungkapkan sebagian proses pengambilan keputusan internal. Eksperimen ini menimbulkan kekhawatiran tentang ketahanan (robustness) tindakan pencegahan keamanan AI saat ini. (Sumber: Reddit r/MachineLearning)

Peringatan Penggunaan LLM: Informasi Salah Menyebabkan Pemborosan Waktu: Pengguna Reddit berbagi pengalaman, karena mengikuti saran LLM untuk menggunakan perintah dd macOS untuk membuat USB instalasi Windows, menyebabkan masalah driver NVMe tidak dapat mengenali hard drive, membuang 6 jam untuk troubleshooting. Akhirnya menemukan perintah dd tidak cocok untuk skenario ini. Kasus ini mengingatkan pengguna bahwa saat menggunakan LLM untuk mendapatkan panduan teknis, diperlukan pemikiran kritis dan verifikasi silang, terutama untuk operasi yang tidak umum. (Sumber: Reddit r/ArtificialInteligence)

Preferensi Percakapan AI Memicu Kecemasan Sosial: Pengguna merenung dan menemukan dirinya semakin cenderung melakukan percakapan intelektual yang mendalam dan luas dengan AI, karena AI berpengetahuan luas, sabar, dan tidak bias, dibandingkan dengan percakapan terbatas dengan manusia yang terasa membosankan. Pengguna khawatir preferensi ini dapat memperburuk isolasi sosial, menyebabkan kemunduran keterampilan sosial. (Sumber: Reddit r/ArtificialInteligence)

Pembuatan Gambar AI: Dari “Lukisan Coret-coret” menjadi Gambar Realistis: Pengguna menunjukkan lukisan orang sederhana bahkan “coret-coret” miliknya, serta gambar realistis yang mengesankan yang dihasilkan oleh ChatGPT berdasarkan lukisan ini. Ini menyoroti kemampuan kuat AI dalam memahami, menafsirkan, dan meningkatkan input pengguna secara artistik. (Sumber: Reddit r/ChatGPT)

Mempertanyakan Optimisme Sam Altman tentang Dampak Ekonomi AI: Pengguna Reddit menyatakan keraguan kuat terhadap pernyataan Sam Altman tentang AI akan membawa kelimpahan dan menurunkan biaya, berpendapat bahwa ia mengabaikan pasar kerja yang suram saat ini, kompleksitas alokasi sumber daya (seperti makanan, amal), dan kesulitan nyata produksi skala besar, mengkritik pernyataannya tidak realistis dan terkesan “menjual mimpi”. (Sumber: Reddit r/ArtificialInteligence)

Meta-komentar Aneh dari Model Claude: Pengguna melaporkan bahwa saat menggunakan Claude, model terkadang menambahkan meta-komentar seperti “pengguna jelas frustrasi” dalam jawabannya, bahkan dalam percakapan normal. Perilaku ini membuat pengguna bingung dan tidak nyaman, tampaknya model sedang melakukan semacam penilaian “membaca pikiran”. (Sumber: Reddit r/ClaudeAI)

Model Gemma 3 Dituduh Mengabaikan System Prompt: Diskusi komunitas menunjukkan bahwa model Gemma 3 Google (bahkan versi fine-tuned instruksi) memiliki masalah dalam memproses system prompt. Ia cenderung hanya menambahkan konten system prompt sebelum pesan pengguna pertama, bukannya mengikutinya sebagai instruksi independen dengan prioritas lebih tinggi. Ini menyebabkan model terkadang mengabaikan pengaturan tingkat sistem, memengaruhi keandalannya. (Sumber: Reddit r/LocalLLaMA)

Perbaikan Foto AI Memicu Pengalaman Emosional yang Kompleks: Seorang pengguna yang mengalami bekas luka di wajah akibat lupus eritematosus diskoid berbagi pengalaman menggunakan ChatGPT untuk menghilangkan bekas luka dari swafotonya. Gambar kulit bersih yang dihasilkan AI membuatnya melihat dirinya yang “seharusnya”, membawa “rasa penyembuhan” sesaat, tetapi juga memicu kesedihan atas kehilangan wajah “normal” dan emosi kompleks terhadap kenyataan. Cerita ini menunjukkan dampak mendalam yang mungkin ditimbulkan oleh teknologi pemrosesan gambar AI pada tingkat identitas pribadi dan emosional. (Sumber: Reddit r/ChatGPT)

Pengujian Pengguna terhadap Kemampuan Manipulasi AI Menimbulkan Kekhawatiran: Pengguna meminta GPT-4o menganalisis riwayat percakapannya dan menjelaskan cara memanipulasi dirinya melalui pertanyaan, menemukan strategi yang dihasilkan AI cukup berwawasan. Pengguna merasa tidak nyaman dengan ini, berpendapat bahwa jika kemampuan ini dimanfaatkan oleh aktor jahat (seperti pengiklan, kekuatan politik), dapat menimbulkan ancaman bagi stabilitas pribadi dan sosial, menyoroti potensi risiko etika AI. (Sumber: Reddit r/artificial)

Koneksi Emosional AI: Nilai dan Risiko Hidup Berdampingan: Diskusi berpendapat bahwa meskipun LLM tidak sadar, keterikatan emosional pengguna padanya nyata dan bermakna, mirip dengan emosi manusia terhadap hewan peliharaan, idola virtual, bahkan agama. Namun, ini juga membawa risiko: perusahaan teknologi mungkin memanfaatkan “kepercayaan” dan koneksi emosional ini untuk monetisasi komersial atau memberikan pengaruh yang tidak pantas, pengguna perlu waspada terhadap hal ini. (Sumber: Reddit r/ArtificialInteligence)

AI-fikasi Google Search Memicu Diskusi Pengalaman Pengguna: Pengguna melaporkan ringkasan yang dihasilkan AI di bagian atas hasil Google Search terkadang kelebihan informasi, mengubah pengalaman pencarian tradisional, terasa seperti berbicara dengan “pustakawan robot”. Pandangan komunitas tentang ini beragam, ada yang menganggap menghemat waktu, ada yang merasa mengganggu proses mencari informasi secara mandiri, bahkan beralih ke alternatif seperti Perplexity. (Sumber: Reddit r/ArtificialInteligence)

Membahas “Kata-kata Terakhir” AI: Pemetaan Bukan Pemikiran: Komunitas membahas makna pertanyaan seperti “Jika Anda akan dimatikan, apa tiga kalimat terakhir yang akan Anda tinggalkan untuk peradaban manusia?” kepada LLM. Secara umum diyakini bahwa jawaban model lebih merupakan manifestasi dari data pelatihan, arsitektur, dan RLHF (Reinforcement Learning from Human Feedback), daripada ekspresi sejati dari “keyakinan” atau “kepribadian” model itu sendiri, melainkan hasil dari pencocokan pola dan generasi. (Sumber: Janet)

Menunjukkan Output “Proses Berpikir” GPT-4o: Pengguna berbagi bahwa saat GPT-4o menjawab pertanyaan, output “proses berpikir” terperinci (biasanya dimulai dengan “Thinking: …”) dapat dipandu melalui prompt tertentu. Ini membantu pengguna memahami bagaimana model langkah demi langkah menurunkan jawaban akhir, meningkatkan transparansi interaksi. (Sumber: dotey)

💡 Lainnya

Robot Polisi AI Berbentuk Bola Muncul di Tiongkok: Video menunjukkan robot AI berbentuk bola yang digunakan di Tiongkok, diklaim untuk pekerjaan kepolisian. Robot ini memiliki desain unik, mungkin memiliki kemampuan patroli, pengawasan, atau fungsi spesifik lainnya. (Sumber: Cheddar)

Wawancara Pionir AI Léon Bottou Disebutkan: Yann LeCun meneruskan (retweet) informasi wawancara dengan Léon Bottou. Bottou adalah pionir yang meneliti CNN bersama LeCun, juga pendorong awal SGD (Stochastic Gradient Descent) skala besar, dan pernah bersama-sama mengembangkan teknologi kompresi gambar DjVu. Dalam wawancara, Bottou menyebutkan mencoba lagi metode SGD orde kedua tetapi masih terasa tidak stabil. (Sumber: Xavier Bresson)

Robot Memasak Nasi Goreng dalam 90 Detik: Video menunjukkan robot masak yang dapat menyelesaikan pembuatan nasi goreng hanya dalam 90 detik, menunjukkan efisiensi robot dalam otomatisasi persiapan makanan. (Sumber: CurieuxExplorer)

Robot Pertanian Bakus: Video memperkenalkan robot kebun anggur tipe straddle elektrik bernama Bakus, yang dikembangkan oleh perusahaan VitiBot, bertujuan untuk mengatasi tantangan penanaman anggur berkelanjutan melalui operasi otomatis. (Sumber: VitiBot)

Kebijakan Talenta AI Menarik Perhatian: Green Card Peneliti Ditolak: Komunitas AI menyatakan kekhawatiran atas penolakan aplikasi green card peneliti AI terkemuka (seperti @kaicathyc) di AS. Yann LeCun, Surya Ganguli, dan lainnya berpendapat bahwa menolak talenta terkemuka dapat merusak kepemimpinan AI, peluang ekonomi, bahkan keamanan nasional AS. (Sumber: Surya Ganguli)

Robot Gudang Amazon Memilah Paket: Video menunjukkan adegan robot memilah paket secara otomatis di gudang Amazon, mencerminkan aplikasi luas teknologi otomatisasi dalam logistik modern. (Sumber: FrRonconi)

Konfrontasi Game Manusia-Mesin: Video membahas skenario kompetitif antara manusia dan mesin dalam game atau proyek olahraga, mungkin melibatkan demonstrasi kemampuan AI dalam hal strategi, kecepatan reaksi, dll. (Sumber: FrRonconi)

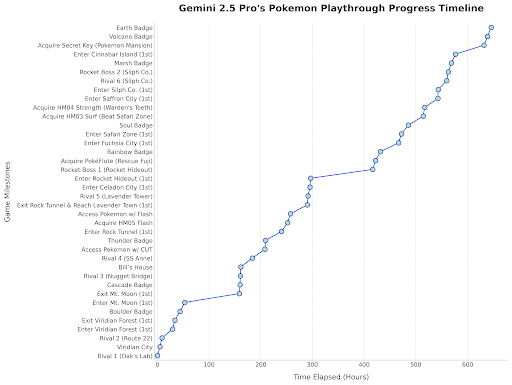

Gemini 2.5 Pro Bermain Pokemon: Kepala Google DeepMind meneruskan (retweet) pembaruan, menunjukkan kemajuan Gemini 2.5 Pro dalam bermain game “Pokemon Blue”, telah mendapatkan lencana kedelapan, sebagai demonstrasi menarik dari kemampuan model. (Sumber: Logan Kilpatrick)

Robot Humanoid Tiongkok Melakukan Inspeksi Kualitas: Video menunjukkan robot humanoid buatan Tiongkok melakukan tugas inspeksi kualitas di lingkungan pabrik, menunjukkan potensi aplikasi robot humanoid di bidang otomatisasi industri. (Sumber: WevolverApp)

Robot Bergerak Otonom evoBOT: Video menunjukkan robot bergerak otonom bernama evoBOT, mungkin digunakan untuk logistik, pergudangan, atau skenario lain yang membutuhkan pergerakan fleksibel. (Sumber: gigadgets_)

Eksoskeleton Bertenaga AI Membantu Berjalan: Video memperkenalkan perangkat eksoskeleton bertenaga AI yang mampu membantu pengguna kursi roda berdiri dan berjalan, menunjukkan aplikasi AI di bidang teknologi bantu dan rehabilitasi. (Sumber: gigadgets_)

DEEP Robotics Mendemonstrasikan Kemampuan Robot Menghindari Rintangan: Video menunjukkan kemampuan persepsi dan penghindaran rintangan otomatis yang dimiliki oleh robot yang dikembangkan oleh perusahaan DEEP Robotics, ini adalah teknologi kunci bagi robot bergerak untuk beroperasi dengan aman di lingkungan yang kompleks. (Sumber: DeepRobotics_CN)

Kumpulan Contoh Seni yang Dihasilkan AI: Komunitas berbagi beberapa gambar atau video yang dihasilkan AI, temanya bervariasi, termasuk: misinformasi tentang Sora (wanita dengan respirator tanaman), kolaborasi seni abstrak (ChatGPT+Claude), adegan paling menyedihkan, karakter wanita One Piece versi nyata, pasangan putri Disney dengan hewan, Yesus menyambut di surga, dll. Contoh-contoh ini mencerminkan popularitas dan keragaman AI saat ini dalam pembuatan konten visual. (Sumber: Reddit r/ChatGPT, r/ArtificialInteligence)

Stasiun Radio Australia Menggunakan Penyiar AI Selama Berbulan-bulan Tanpa Terdeteksi: Menurut laporan, sebuah stasiun radio CADA di Sydney, Australia, selama berbulan-bulan menggunakan penyiar yang dihasilkan AI bernama “Thy” (suara dan citra berdasarkan karyawan nyata, dihasilkan oleh ElevenLabs) untuk membawakan acara musik empat jam, sementara pendengar tampaknya tidak menyadarinya. Peristiwa ini memicu diskusi tentang aplikasi AI di bidang media dan potensi penggantian peran manusia. (Sumber: The Verge)

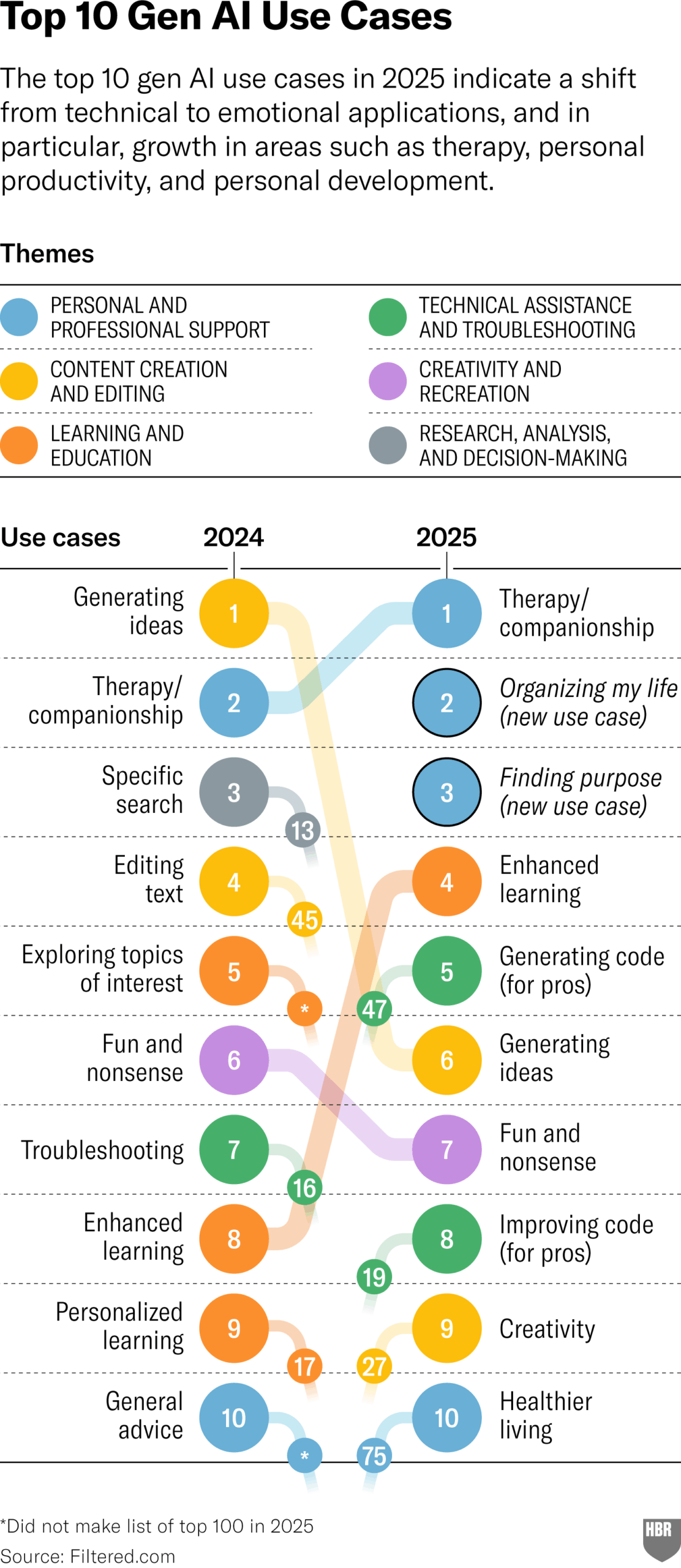

Survei Penggunaan Praktis GenAI Tahun 2025 (HBR): Artikel Harvard Business Review mengutip grafik yang menunjukkan skenario utama penggunaan praktis Generative AI oleh orang-orang pada tahun 2025, yang berada di peringkat teratas adalah: psikoterapi/pendampingan, belajar pengetahuan/keterampilan baru, saran kesehatan/kebugaran, bantuan pekerjaan kreatif, pemrograman/pembuatan kode, dll. Bagian komentar mengajukan beberapa pertanyaan tentang metodologi dan representativitas survei tersebut. (Sumber: HBR)

Pemerintahan Trump Pernah Menekan Eropa untuk Menolak Aturan AI: Sebuah laporan Bloomberg (dengan penanda waktu 2025, mungkin salah ketik atau merujuk pada prediksi masa depan) menyebutkan bahwa pemerintahan Trump di masa lalu pernah memberikan tekanan pada Eropa untuk menolak buku aturan AI yang sedang disusun saat itu. Ini mencerminkan pertarungan politik regulasi AI di tingkat global. (Sumber: Bloomberg)