Kata Kunci:Robot humanoid, Aplikasi AI, AGI, Mengemudi otonom, Maraton robot humanoid, Agent+MCP, Prediksi AGI DeepMind, FSD visi murni Tesla, Kloning suara GPT-SoVITS, Penalaran kimia ChemAgent, Model bisnis robot Agibot, Tantangan monopoli GPU Nvidia

🔥 Fokus

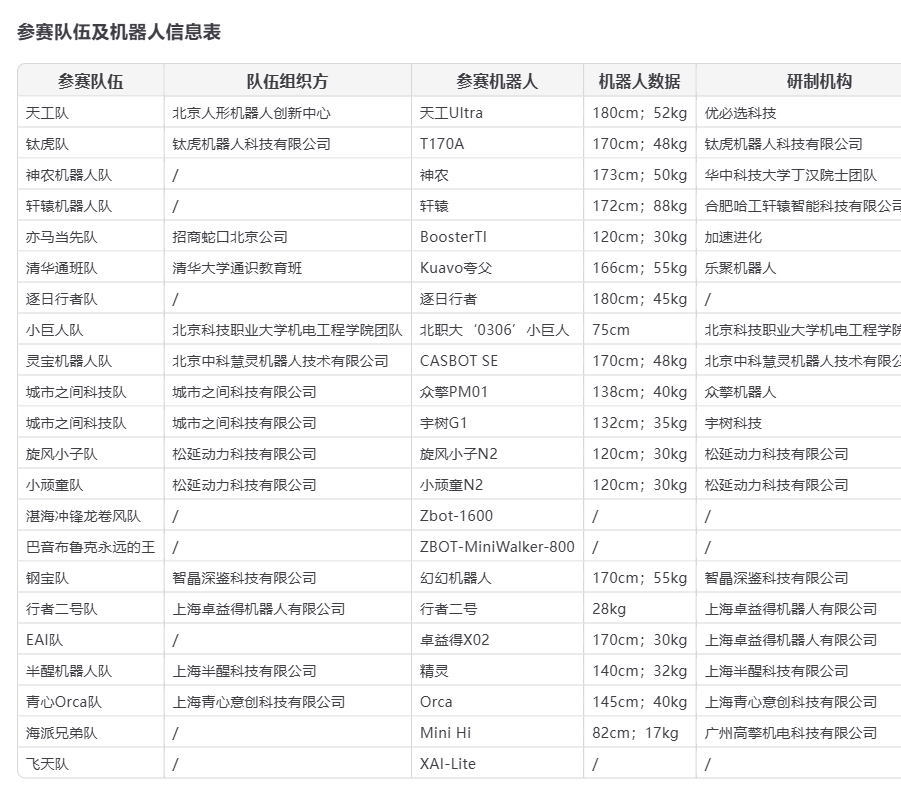

Robot humanoid “debut” di Beijing Half Marathon, peluang dan tantangan hadir bersamaan: Dalam Beijing Yizhuang Half Marathon 2025, 21 tim robot humanoid untuk pertama kalinya berkompetisi bersama peserta manusia. Tiangong Ultra, Songyan Dynamics N2, dan Zhuoyide Walker II berhasil meraih tiga besar. Kompetisi ini menyoroti potensi robot humanoid, tetapi juga mengungkap berbagai tantangan seperti jatuh, daya tahan baterai, dan kontrol (sebagian besar menggunakan remote control). Setelah lomba, Unitree Technology memberikan tanggapan terkait insiden jatuhnya robot G1 mereka, menyatakan bahwa pengembangan dan pengoperasian mandiri oleh pengguna sangat memengaruhi kinerja robot. Acara ini tidak hanya menunjukkan skala awal industri robot humanoid Tiongkok, tetapi juga memicu diskusi luas mengenai kematangan teknologi, biaya (harga pra-penjualan Songyan N2 mulai dari 39.900 yuan), jalur komersialisasi (penyewaan, aplikasi industri), serta pengembangan di masa depan (model AI besar, pembelajaran mandiri). Meskipun industri ini diminati oleh investor, profitabilitas jangka pendek sulit dicapai dan implementasi pasar masih memerlukan waktu (sumber: 摔倒的宇树和人形机器人的“求生”博弈, 从进厂到马拉松:人形机器人离“实用”还有多远?)

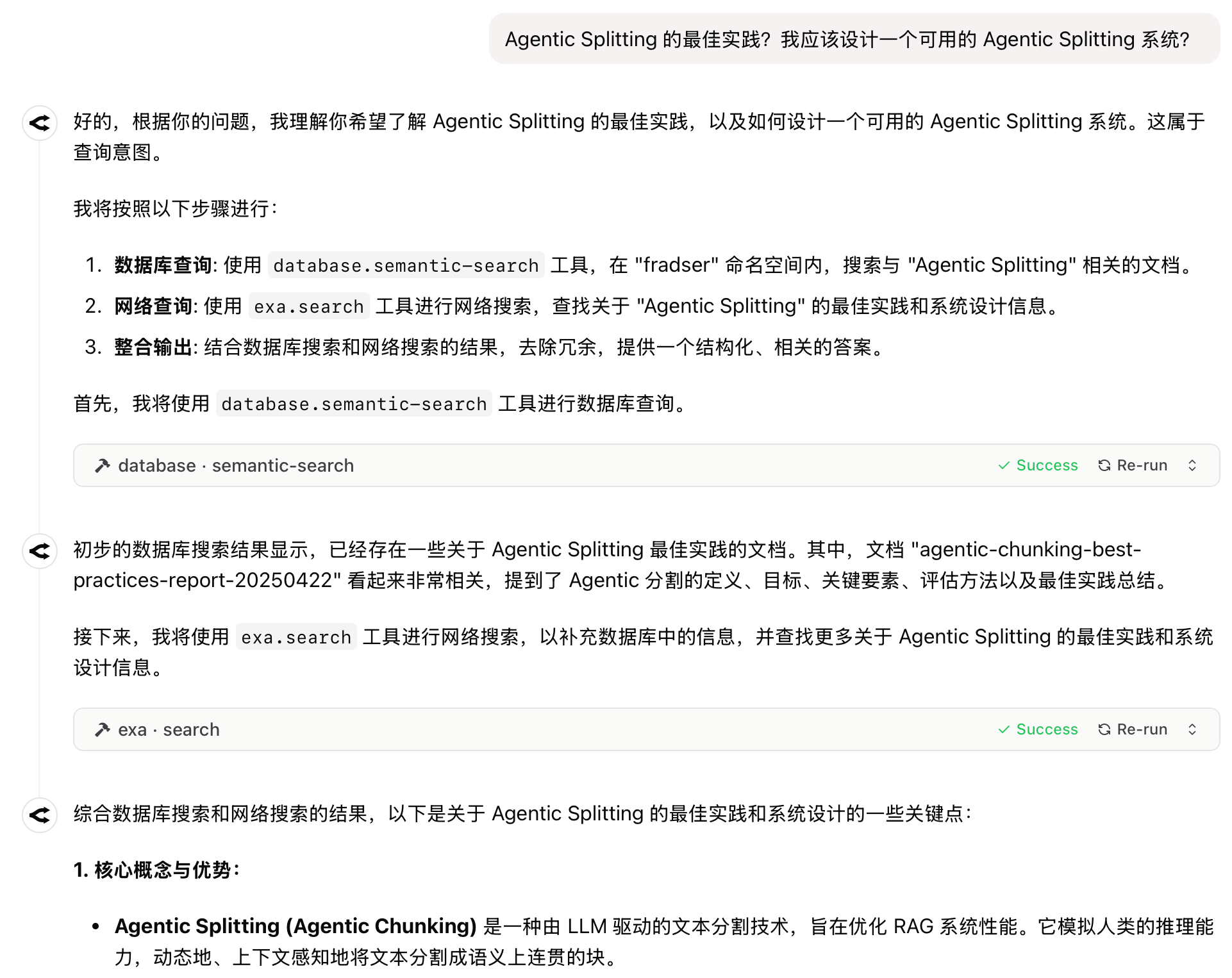

Paradigma baru aplikasi AI: Agent+MCP menjadi formula populer tahun 2025: Menggabungkan kemampuan perencanaan dan tindakan otonom Agent dengan kemampuan protokol MCP untuk memanggil alat dan data eksternal menjadi tren baru dalam aplikasi AI. Produk seperti “Coze Space”, Fellou, Dia, GenSpark, Zhipu AutoGLM bermunculan dan menarik perhatian. Produk-produk ini sebagian besar bertransformasi dari pencarian AI, mencoba membangun hambatan pengalaman pengguna melalui desain produk yang berbeda (kemudahan penggunaan, kemampuan penelitian, eksekusi implementasi). Meskipun potensinya besar, saat ini masih menghadapi tantangan seperti batas kemampuan model, akuisisi informasi lintas platform, dan model komersialisasi. Microsoft juga meluncurkan sistem multi-Agent UFO² untuk desktop, menandakan bahwa AM (Agent+MCP) akan menjadi arah penting bagi produk AI (sumber: 2025年,AI应用的爆款公式只有一个)

Perdebatan sengit masa depan AI: Hassabis prediksi penyembuhan semua penyakit dalam sepuluh tahun, sejarawan Harvard peringatkan AGI akan musnahkan manusia: CEO Google DeepMind Demis Hassabis dalam sebuah wawancara memprediksi bahwa AI akan mencapai AGI dalam 5-10 tahun, dan diharapkan dapat menyembuhkan semua penyakit dalam sepuluh tahun, sambil menunjukkan kemajuan AI seperti Project Astra. Ia percaya AI akan menjadi alat utama untuk mempercepat penemuan ilmiah. Namun, sejarawan Harvard Niall Ferguson memberikan peringatan, berpendapat bahwa kedatangan AGI dapat menyebabkan manusia tersingkir seperti kereta kuda atau bahkan punah, menjadi “alien” ciptaan manusia sendiri. Ia menunjukkan bahwa tren seperti kekakuan institusional dan penurunan tingkat kesuburan global dapat membuat manusia memilih untuk “keluar dari panggung sejarah” di hadapan AGI. Diskusi ini menyoroti kontras besar antara optimisme ekstrem terhadap potensi AGI dan kekhawatiran mendalam tentang masa depan peradaban manusia (sumber: 诺奖得主Hassabis豪言:AI十年治愈所有疾病,哈佛教授警告AGI终结人类文明, 哈佛历史学家预警:AGI灭绝人类,美国或将解体)

🎯 Perkembangan

Kemajuan industri robot terus bermunculan, komersialisasi dipercepat: Canton Fair pertama kali membuka area khusus robot layanan, produsen domestik seperti Pangolin Robot, Hongxu Jin Technology, dll., meraih banyak pesanan luar negeri, menunjukkan daya saing robot layanan Tiongkok di pasar global. Sementara itu, robot humanoid dari perusahaan seperti Midea sedang menjalani iterasi, berencana untuk masuk ke pabrik untuk “bekerja”. Di rantai pasokan, meskipun ada tata letak di segmen seperti PCB, sensor, material baru (seperti PEEK), produksi massal skala besar masih membutuhkan waktu; teknologi, biaya, dan penutupan lingkaran skenario aplikasi adalah kuncinya. Beberapa produsen berencana untuk mencapai produksi massal seribu unit pada tahun 2025, yang diharapkan dapat mendorong pengembangan rantai pasokan dan akumulasi data, mempercepat robot menuju tahap yang lebih praktis (sumber: 机器人组团“营业”引爆声量场,产业链频刷进展)

Tesla bersikeras pada FSD visi murni, rute LiDAR hadapi tantangan dan peluang: Musk menegaskan kembali keyakinannya pada solusi visi murni untuk mencapai FSD, berpendapat bahwa kamera ditambah AI dapat mensimulasikan mengemudi manusia, tanpa memerlukan LiDAR. Meskipun menghadapi realitas penurunan biaya (LiDAR buatan Tiongkok telah turun hingga ratusan dolar) dan penetrasi pasar (telah memasuki mobil kelas 100.000 yuan), Tesla tetap pada jalurnya, yang menuntut persyaratan sangat tinggi pada daya komputasi, algoritma, dan datanya. Sementara itu, produsen LiDAR seperti Hesai dan RoboSense mendominasi pasar dengan keunggulan biaya dan iterasi teknologi, serta secara aktif memperluas pasar luar negeri dan bisnis non-otomotif seperti robotika. Mendekatnya autonomous driving level L3 dapat membawa peluang baru bagi LiDAR, karena kemampuannya dalam redundansi keselamatan dan persepsi dalam skenario tertentu dianggap sangat diperlukan (sumber: 马斯克最新的AI驾驶方案,会终结激光雷达吗?)

Google Imagen 3/4 mungkin sedang dalam pengujian internal: Terdengar kabar bahwa Google sedang menguji secara internal model generasi gambar generasi berikutnya, Imagen 3 dan Imagen 4, menandakan bahwa Google mungkin memiliki langkah besar baru di bidang generasi gambar, bertujuan untuk mengejar atau melampaui pesaing (sumber: Google 又憋图像大招?传 Imagen 3/4 内测中。)

THUDM merilis seri model pengkodean SWE-Dev: Kelompok riset Knowledge Engineering and Data Mining Universitas Tsinghua (THUDM) merilis seri model besar pengkodean SWE-Dev berbasis Qwen-2.5 dan GLM-4, termasuk versi 7B, 9B, dan 32B, yang bertujuan untuk meningkatkan kemampuan AI dalam tugas pengembangan perangkat lunak dan pengkodean (sumber: Reddit r/LocalLLaMA)

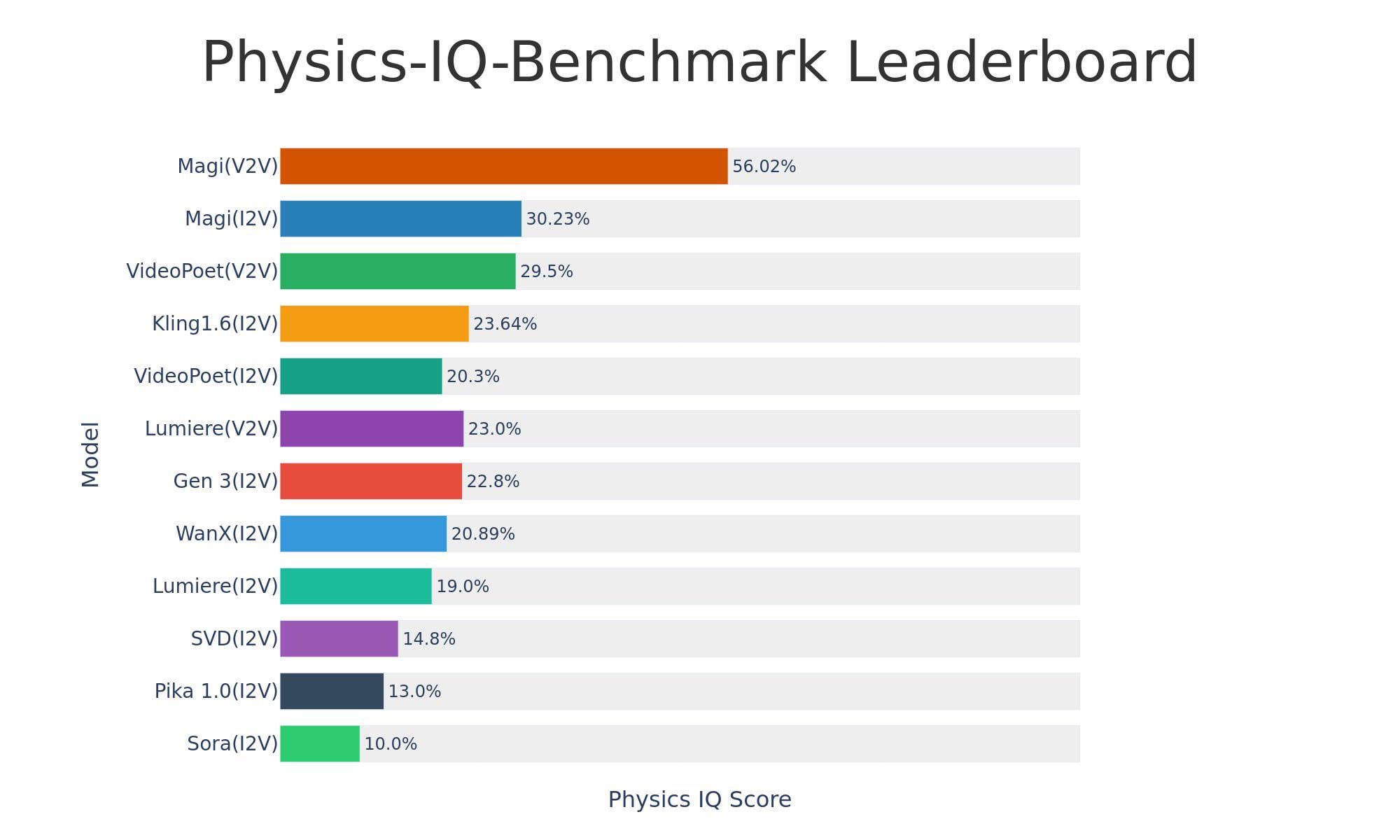

Sand-AI merilis model generasi video open-source Magi-1: Sand-AI merilis Magi-1, model generasi video difusi autoregresif open-source, yang diklaim dapat menghasilkan video dengan durasi tak terbatas, mendukung text-to-video, image-to-video, dan video-to-video. Model ini menunjukkan kinerja yang sangat baik dalam benchmark pemahaman fisika, tetapi membutuhkan VRAM yang sangat tinggi untuk dijalankan (sekitar 640GB VRAM). Kode dan model telah dirilis di GitHub dan Hugging Face (sumber: Reddit r/LocalLLaMA)

Grok menambahkan kemampuan visual, audio multi-bahasa, dan pencarian real-time: xAI mengumumkan bahwa model Grok menambahkan kemampuan pemahaman visual, dan dalam mode suara mendukung input audio multi-bahasa serta fungsi pencarian real-time, meningkatkan kemampuan interaksi multimodal dan akuisisi informasinya (sumber: grok, xai)

Model Grok 3 hadir di You.com: Model andalan xAI, Grok 3, kini tersedia di mesin pencari You.com, memungkinkan pengguna untuk merasakan kemampuan Grok 3 di platform tersebut (sumber: xai)

Model TTS open-source Dia dirilis dan mendapat perhatian: Model text-to-speech (TTS) open-source bernama Dia dirilis, diklaim memiliki kualitas yang sebanding dengan model komersial seperti ElevenLabs dan OpenAI, mendukung kloning suara zero-shot dan sintesis real-time, serta dapat berjalan di MacBook. Model ini dengan cepat mendapatkan perhatian di Hugging Face dan diliput oleh media seperti VentureBeat (sumber: huggingface, huggingface, huggingface)

Menampilkan teknologi autonomous driving Tesla: Menampilkan video atau informasi terkait teknologi autonomous driving Tesla Autopilot, terus memicu perhatian pada kemajuan teknologi autonomous driving (sumber: Ronald_vanLoon)

Pameran teknologi robot: Berbagai sumber menampilkan aplikasi robot yang berbeda, termasuk lengan robot untuk perakitan gadget kecil, evaluasi robot TITA, robot amfibi Copperstone HELIX Neptune, serta bagaimana robot merasakan dunia, menunjukkan perkembangan berkelanjutan teknologi robot di berbagai bidang (sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Alat

GPT-SoVITS: Alat kloning suara few-shot dan text-to-speech yang kuat: Dikembangkan oleh RVC-Boss, GPT-SoVITS adalah proyek open-source (GitHub 44k+ bintang) yang hanya memerlukan 1 menit data suara untuk melatih model TTS berkualitas tinggi, memungkinkan kloning suara few-shot. Mendukung zero-shot TTS (input 5 detik untuk konversi instan), inferensi lintas bahasa (mendukung Inggris, Jepang, Korea, Kanton, Mandarin), dan mengintegrasikan toolbox WebUI, termasuk pemisahan vokal/iringan, segmentasi dataset otomatis, ASR Mandarin, dan anotasi teks, memudahkan pengguna membuat dataset dan model. Proyek ini telah diperbarui ke V4, terus mengoptimalkan kemiripan timbre, stabilitas, dan kualitas output (sumber: RVC-Boss/GPT-SoVITS – GitHub Trending (all/daily))

Tim Tsinghua meluncurkan SurveyGO (Juan Ji): Alat tinjauan literatur dan pembuatan laporan panjang berbasis AI: Berdasarkan teknologi LLMxMapReduce-V2 yang dikembangkan oleh tim Tsinghua NLP, OpenBMB, dan Mianbi Intelligence, SurveyGO dapat secara efisien memproses sejumlah besar literatur (pencarian online atau unggah file), menghasilkan laporan tinjauan panjang puluhan ribu kata yang terstruktur dengan baik, logis, dan akurat dalam kutipan. Alat ini mengoptimalkan kerangka melalui mekanisme konvolusi yang didorong oleh entropi informasi dan menghasilkan konten secara hierarkis, mengatasi masalah konten tambal sulam dan kurangnya kedalaman pada pembuatan teks panjang AI tradisional. Pengguna dapat menggunakan versi web dengan memasukkan topik atau mengunggah file, bertujuan untuk secara signifikan meningkatkan efisiensi penelitian literatur dan penulisan bagi peneliti dan pembuat konten (sumber: INTJ式学术暴力!清华团队造出“论文卷姬”:3分钟速通200小时文献综述, 如何 AI「拼好文」:生成万字报告,不限模型)

text-generation-webui meluncurkan versi portabel, fokus pada llama.cpp: Untuk menyederhanakan proses deployment, text-generation-webui merilis versi portabel dan mandiri (sekitar 700MB) yang ditujukan untuk llama.cpp. Pengguna dapat mengunduh dan mengekstrak untuk menjalankannya, tanpa perlu menginstal Python, PyTorch, atau dependensi lainnya. Versi baru mendukung Win/Linux/macOS (termasuk versi CPU/CUDA), mengoptimalkan kecepatan startup dan pengalaman pengguna (seperti membuka browser secara otomatis, memulai API secara default), memberikan kemudahan besar bagi pengguna yang hanya ingin menggunakan llama.cpp untuk inferensi lokal (sumber: Reddit r/LocalLLaMA)

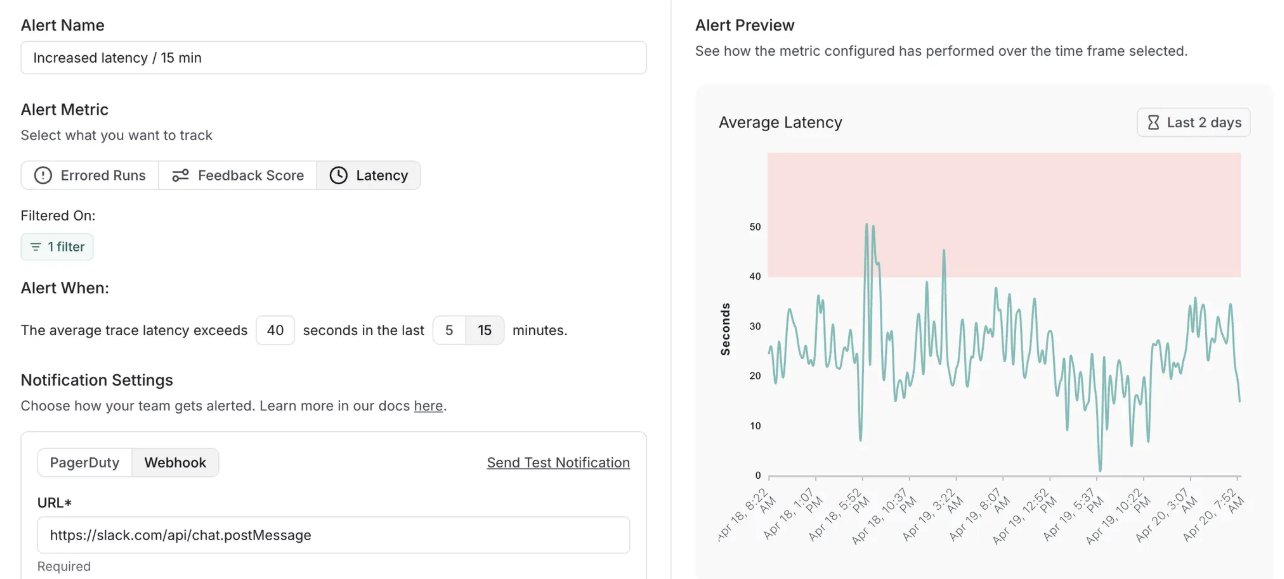

LangSmith menambahkan fungsi peringatan dan memperbarui versi self-hosted: Platform MLOps LangChain, LangSmith, menambahkan fungsi peringatan real-time, memungkinkan pengguna mengatur notifikasi untuk tingkat kesalahan, latensi eksekusi, dan skor umpan balik, agar dapat mendeteksi masalah sebelum memengaruhi pelanggan. Sementara itu, versi self-hosted-nya diperbarui ke v0.10, mencakup fungsi peringatan, UI pembuatan dan peninjauan evaluasi baru, dukungan untuk data pelacakan klien OpenTelemetry, serta optimasi kinerja (sumber: LangChainAI, LangChainAI)

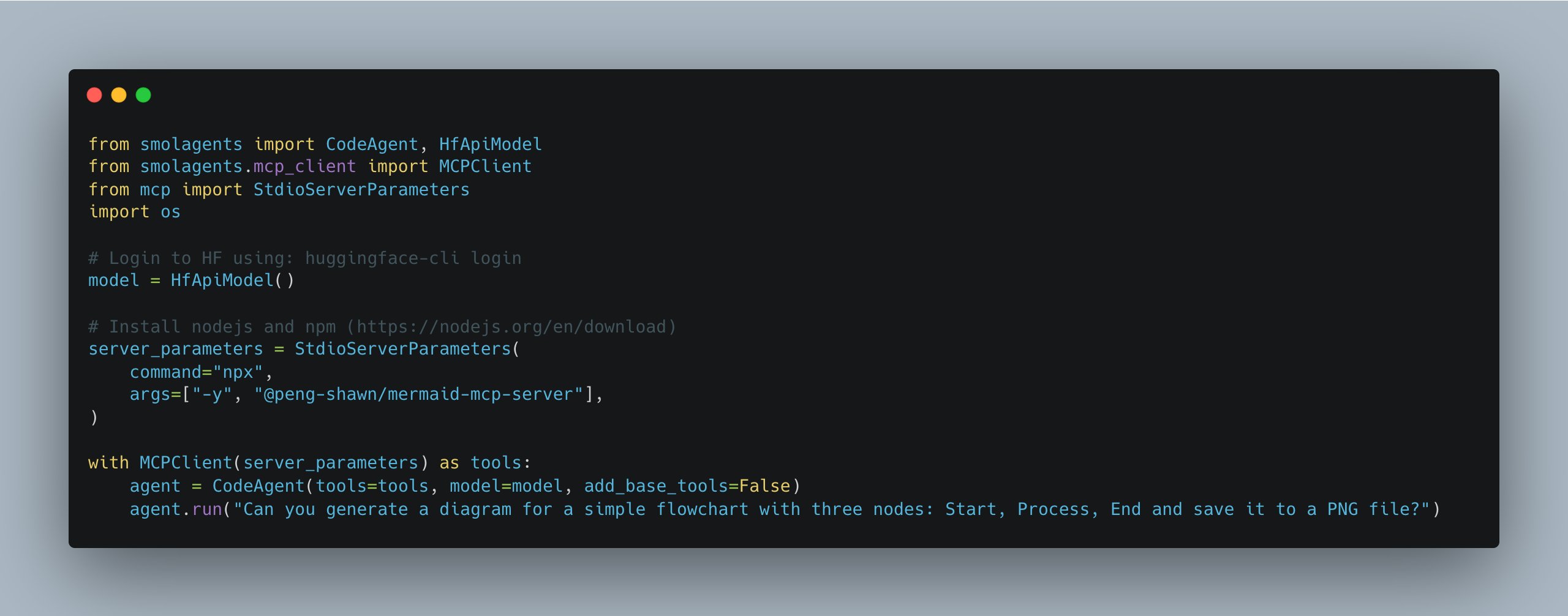

smolagents diperbarui, menyederhanakan manajemen server multi-MCP: Pustaka smolagents dari Hugging Face merilis versi baru, memperkenalkan kelas MCPClient, yang sangat menyederhanakan pengelolaan koneksi ke beberapa server MCP (Model Communication Protocol), memudahkan pengembang membangun dan mengoordinasikan sistem Agent yang lebih kompleks (sumber: huggingface)

Suna: Platform Agent open-source menyaingi Manus: Kortix AI merilis platform Agent open-source Suna, yang bertujuan untuk menyaingi Manus. Suna mengintegrasikan otomatisasi browser, manajemen file, web crawling, pencarian diperluas, eksekusi baris perintah, deployment situs web, serta integrasi API, memungkinkan AI untuk secara kolaboratif mengoperasikan alat-alat ini, menyelesaikan masalah kompleks dan mengotomatiskan alur kerja melalui dialog (sumber: karminski3)

Exa MCP kini mendukung pencarian Twitter tanpa API: Server MCP Exa diperbarui, kini mendukung pencarian konten Twitter secara langsung, tanpa memerlukan kunci API Twitter. Ini memberikan kemudahan bagi AI Agent yang perlu mengambil informasi dari Twitter, tetapi ada umpan balik pengguna bahwa dukungan crawling untuk konten berbahasa Mandarin kurang baik (sumber: karminski3)

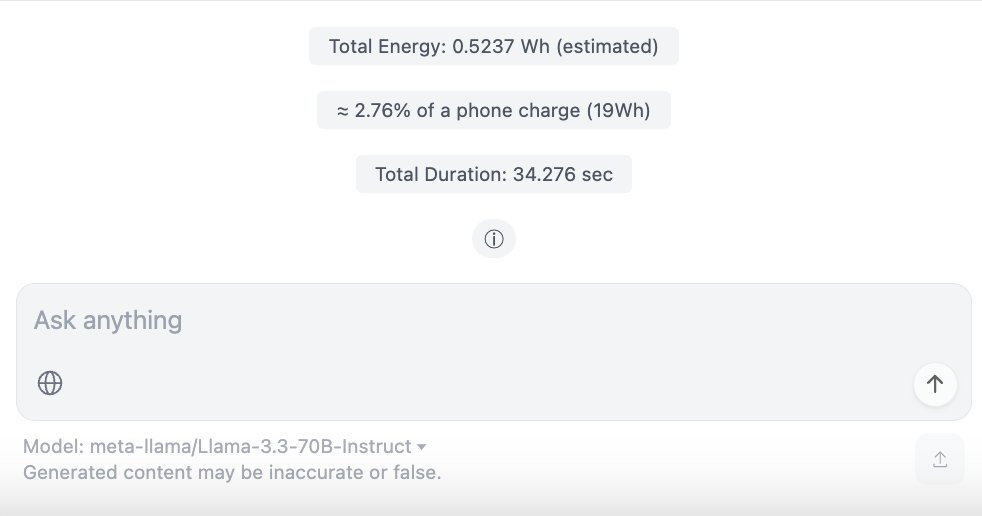

ChatUI-energy: Antarmuka yang menampilkan konsumsi energi percakapan AI secara real-time: Anggota komunitas Hugging Face merilis ChatUI-energy, varian Chat UI yang dapat menampilkan energi yang dikonsumsi secara real-time saat pengguna berinteraksi dengan model AI (seperti Llama, Mistral, Qwen, Gemma, dll.). Langkah ini bertujuan untuk meningkatkan transparansi energi penggunaan AI (sumber: huggingface, huggingface)

Menggunakan AI untuk pengembangan, deployment, dan optimasi aplikasi web: Artikel berbagi praktik penggunaan AI (seperti Lovable, Cursor, BrowserTools MCP) untuk pengembangan aplikasi web (alat penggabungan gambar), debugging, audit SEO, dan optimasi kinerja. Menjelaskan secara rinci cara menggunakan Vercel dan GitHub untuk mencapai deployment otomatis CI/CD, serta konfigurasi resolusi domain dan subdomain. Menunjukkan peran pendukung AI dalam pengkodean dan pemeliharaan situs web (sumber: AI 编码 + Vercel 部署 + 域名解析:一文搞定Web 应用开发上线全流程,氛围编码+MCP 审计优化。)

Replikasi ringan “Her” OS1/Samantha berbasis model lokal: Seorang pengembang menggunakan transformers.js dan model ONNX (termasuk Ultravox Llama 3.2 1B, Whisper Base, Kokoro TTS, dan MiniLM embeddings) untuk mereplikasi asisten AI OS1/Samantha dari film “Her” secara lokal di browser. Proyek ini menunjukkan kemungkinan menjalankan AI interaktif suara secara lokal dengan sumber daya terbatas (sekitar 2GB unduhan model) (sumber: Reddit r/LocalLLaMA)

ChatWise menggabungkan server MCP untuk mewujudkan RAG dan sinkronisasi data: Pengguna berbagi konfigurasi alur kerja sederhana di ChatWise menggunakan instruksi sistem, menggabungkan server MCP Pinecone (database), Exa (pencarian), dan Time (waktu), untuk mewujudkan RAG (Retrieval-Augmented Generation) dan sinkronisasi data (sumber: op7418)

📚 Pembelajaran

Universitas Stanford membuka kursus Transformer CS25: Kursus seminar populer Universitas Stanford tentang Transformer, CS25, dibuka untuk umum dan dapat diikuti melalui siaran langsung Zoom. Kursus ini mengundang peneliti terkemuka seperti Andrej Karpathy, Geoffrey Hinton, Jim Fan, Ashish Vaswani, serta tamu dari OpenAI, Google, NVIDIA untuk memberikan kuliah, mencakup topik-topik mutakhir seperti arsitektur LLM, aplikasi multimodal, biologi, robotika, dll. Rekaman kursus akan dipublikasikan di YouTube, dan tersedia komunitas Discord untuk diskusi (sumber: karminski3, dotey, Reddit r/deeplearning, Reddit r/LocalLLaMA)

Penelitian Tsinghua-Jiao Tong ungkap keterbatasan RL pada kemampuan penalaran LLM: Sebuah penelitian dari Universitas Tsinghua dan Universitas Jiao Tong Shanghai menantang pandangan bahwa Reinforcement Learning (RL) meningkatkan kemampuan penalaran model besar. Eksperimen menunjukkan bahwa meskipun RL dapat meningkatkan akurasi model pada tingkat sampling rendah (efisiensi), pada tingkat sampling tinggi, model dasar dapat menyelesaikan lebih banyak masalah sulit (batas kemampuan). Ini menunjukkan bahwa RL lebih mahir dalam mengoptimalkan kinerja model dalam lingkup kemampuannya yang ada, daripada memperluas kemampuan penalaran fundamentalnya. Makalah ini menunjukkan bahwa metode RL saat ini (seperti GRPO) mungkin terjebak dalam optima lokal karena eksplorasi yang tidak memadai, membatasi penyelesaian masalah kompleks (sumber: RL 是推理神器?清华上交大最新研究指出:RL 让大模型更会 「套公式」,却不会真推理, Reddit r/artificial)

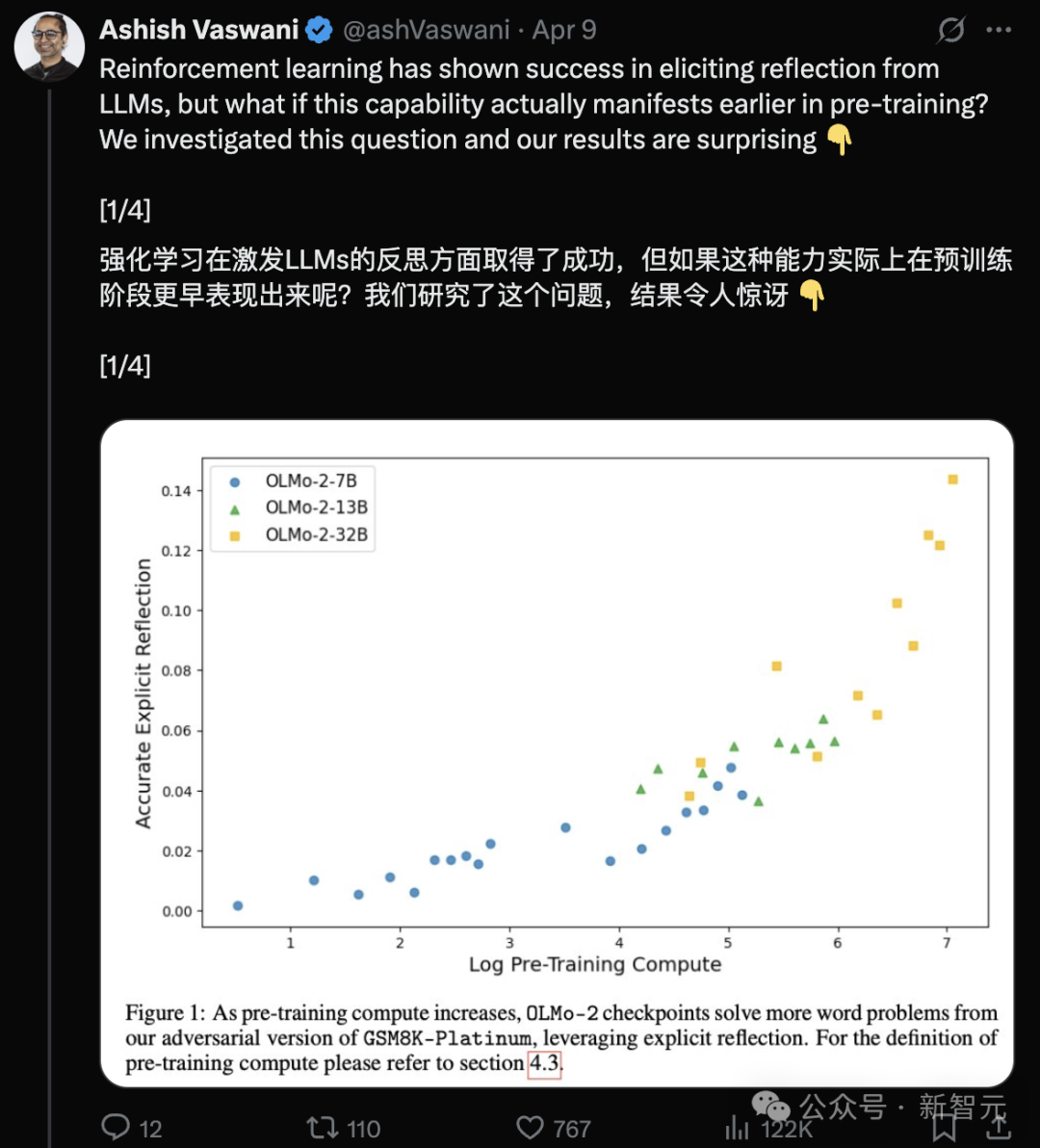

Tim penulis Transformer: LLM sudah memiliki kemampuan refleksi pada tahap pra-pelatihan: Tim yang dipimpin oleh penulis pertama makalah Transformer, Ashish Vaswani, menerbitkan penelitian (arXiv:2504.04022) yang menantang pandangan bahwa “kemampuan refleksi terutama berasal dari RLHF”. Penelitian ini, dengan memperkenalkan rantai pemikiran adversarial, membedakan dan mengukur kemampuan refleksi kontekstual dan refleksi diri, menemukan bahwa kemampuan ini muncul dan meningkat seiring dengan peningkatan jumlah komputasi pra-pelatihan pada LLM (seperti OLMo-2). Prompt sederhana seperti “Wait,” dapat secara efektif memicu refleksi eksplisit, efeknya sebanding dengan memberitahu model secara langsung bahwa ada kesalahan. Ini memberikan perspektif baru untuk memahami dan mempercepat pengembangan kemampuan penalaran dalam pra-pelatihan (sumber: Transformer原作打脸DeepSeek观点?一句Wait就能引发反思,RL都不用)

ChemAgent: Pustaka memori yang diperbarui sendiri tingkatkan kemampuan penalaran kimia LLM: Peneliti dari Yale, Stanford, dan institusi lain mengusulkan kerangka kerja ChemAgent, yang secara signifikan meningkatkan kinerja LLM pada tugas penalaran kimia dengan memperkenalkan pustaka memori dinamis yang diperbarui sendiri yang mencakup perencanaan, eksekusi, dan memori pengetahuan. Kerangka kerja ini meniru proses belajar manusia, memecah tugas dan menggunakan pengambilan memori untuk menyelesaikan masalah kimia yang kompleks. Eksperimen pada dataset SciBench menunjukkan bahwa ChemAgent meningkatkan akurasi rata-rata sebesar 10% (relatif terhadap SOTA) hingga 37% (relatif terhadap penalaran langsung) dibandingkan dengan metode baseline, terutama peningkatan yang jelas pada akurasi perhitungan dan konversi unit. Penelitian ini juga menganalisis hubungan antara kesamaan memori, kuantitas, dan kinerja serta keterbatasan saat ini (sumber: 准确率飙升46%!耶鲁-斯坦福「自更新记忆库」新框架,重塑LLM化学推理能力)

Universitas Teknologi China Selatan raih serangkaian kemajuan di bidang komputasi evolusioner terdistribusi: Tim komputasi cerdas Universitas Teknologi China Selatan (SCUT) telah mencapai serangkaian hasil dalam optimasi konsensus terdistribusi sistem multi-agen (MAS). Penelitian meliputi: menerbitkan tinjauan di bidang interdisipliner ini; mengusulkan algoritma MASOIE, mengoptimalkan kolaborasi melalui mekanisme pembelajaran internal dan eksternal; mengusulkan algoritma MACPO, menggunakan insentif target untuk mendorong kerja sama; merancang mekanisme adaptif langkah CCSA untuk meningkatkan kinerja optimasi black-box; mengusulkan algoritma MASTER untuk meningkatkan akurasi lokalisasi jaringan sensor. Tim juga menyelenggarakan kompetisi terkait untuk mendorong pengembangan bidang ini (sumber: 打破共识优化壁垒!华南理工深耕分布式进化计算,实现多智能体高效协同)

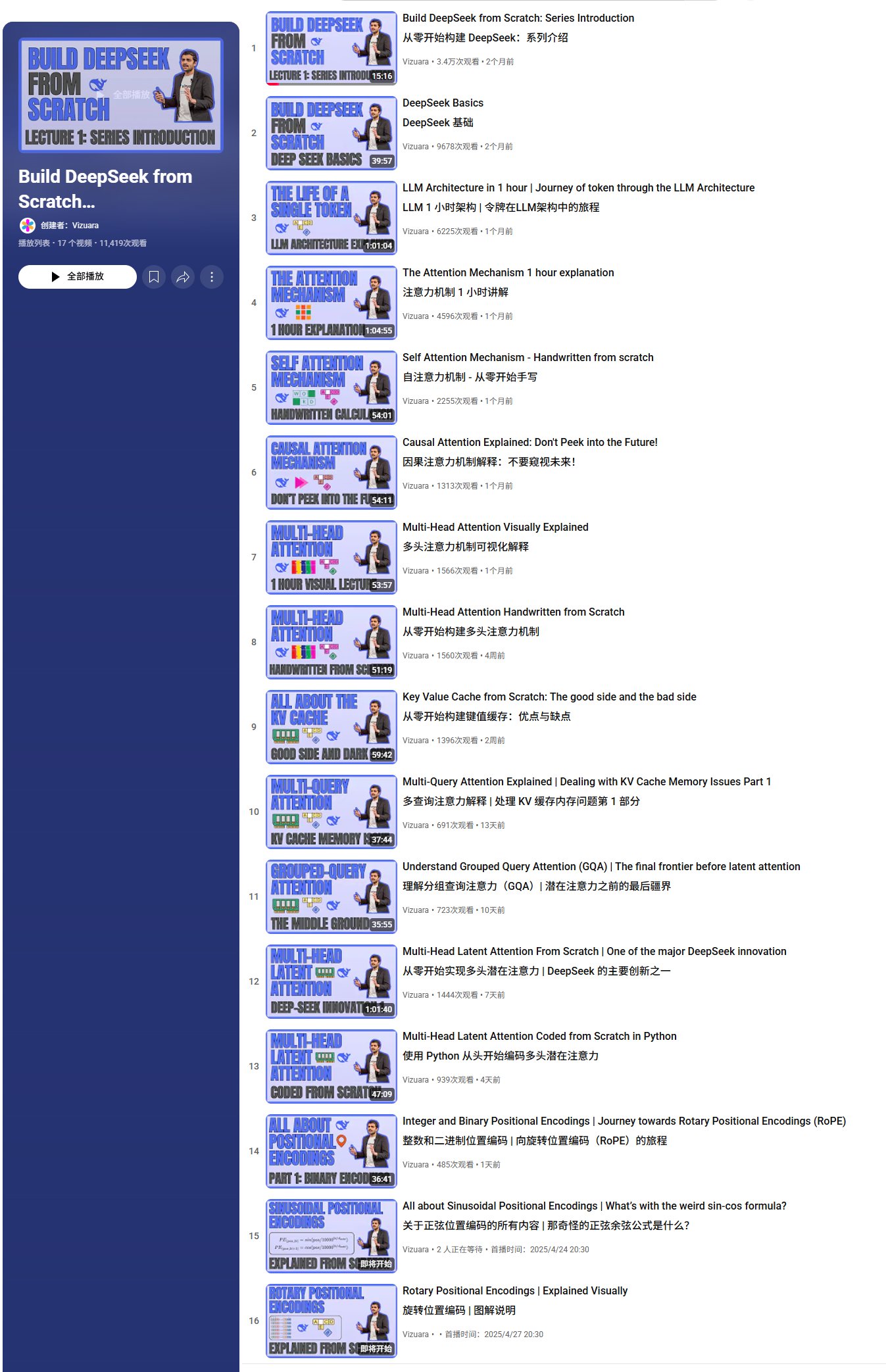

Seri video tutorial membangun DeepSeek dari nol: Vizuara merilis seri video tutorial “Membangun DeepSeek dari Nol” di YouTube, saat ini telah diperbarui hingga 13 pelajaran, mencakup dasar-dasar DeepSeek, alur pemrosesan Token, mekanisme perhatian (self-attention, causal attention, multi-head attention, multi-query attention, grouped-query attention, multi-head latent attention), serta penjelasan dan implementasi kode konsep inti seperti KV Cache. Seri ini bertujuan untuk menganalisis arsitektur DeepSeek secara mendalam, direncanakan total 35-40 video, mencakup lebih banyak konten seperti RoPE, MoE, MTP, SFT, GRPO (sumber: karminski3, Reddit r/LocalLLaMA)

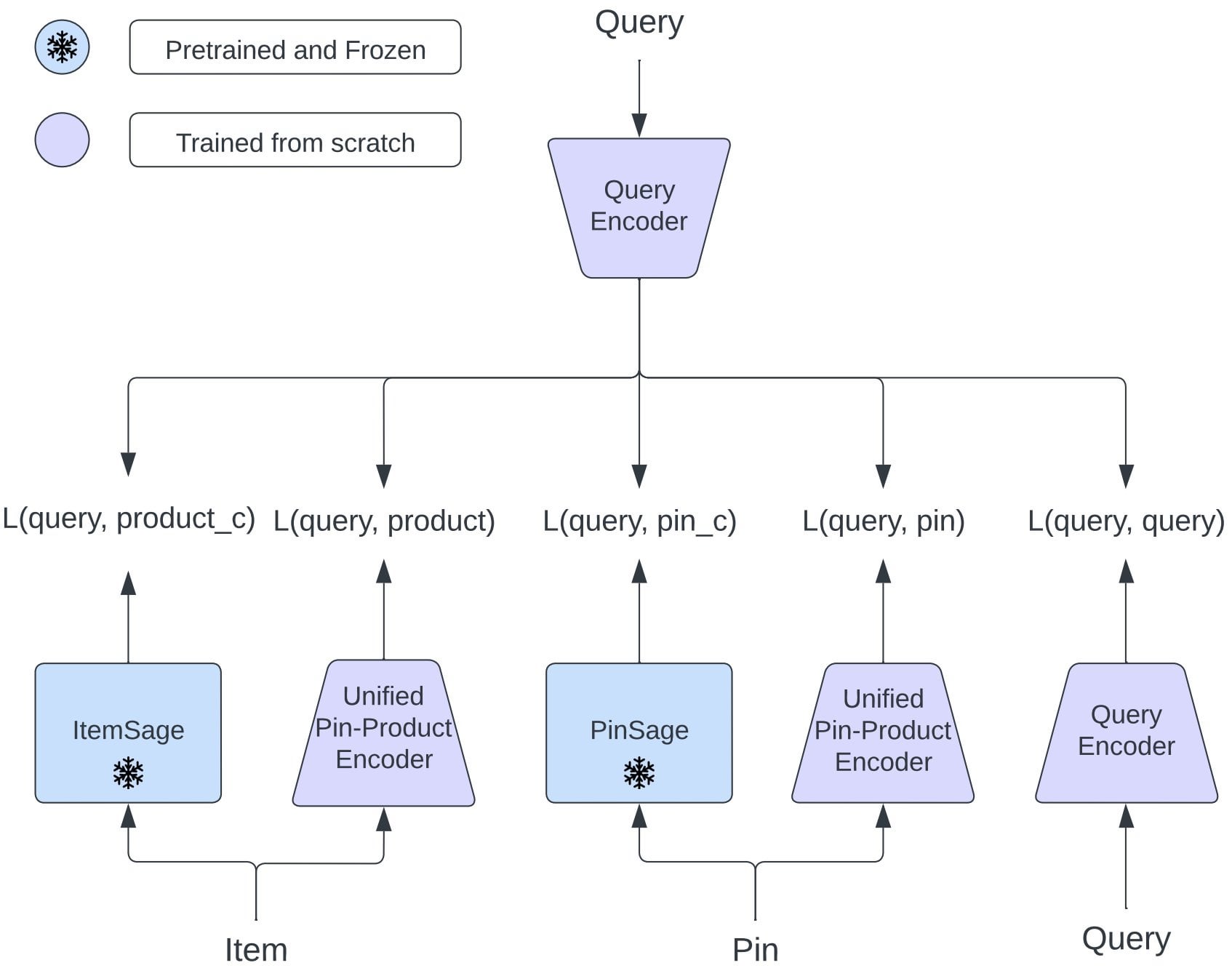

Pinterest usulkan OmniSearchSage: Model embedding terpadu tingkatkan pencarian multi-tugas: Peneliti Pinterest mengusulkan OmniSearchSage, model embedding kueri terpadu yang dilatih melalui pembelajaran multi-tugas, mampu secara bersamaan mengambil pin, produk, dan kueri terkait, menantang arsitektur menara kembar tradisional. Model ini menggabungkan judul yang dihasilkan GenAI, sinyal board yang dikurasi pengguna, dan data keterlibatan perilaku, memperkaya pemahaman item, dan dapat langsung diintegrasikan ke dalam sistem yang ada (seperti PinSage). Hasil menunjukkan bahwa metode ini mencapai peningkatan praktis yang signifikan dalam pencarian, iklan, dan latensi (sumber: Reddit r/MachineLearning)

FlowReasoner: Alur kerja multi-agen yang disesuaikan secara dinamis berdasarkan kueri: Makalah mengusulkan FlowReasoner, yang bertujuan untuk secara instan menyimpulkan alur kerja (workflow) multi-agen eksklusif untuk setiap kueri pengguna. Melalui penalaran SFT dan pembelajaran penguatan GRPO, model dapat secara dinamis menyesuaikan kombinasi dan urutan tugas Agent (seperti pembuatan kode, peninjauan, pengujian, revisi) berdasarkan umpan balik eksekusi. Metode ini divalidasi dalam skenario Code Interpreter, bergantung pada eksekusi Python dan pengujian unit, menunjukkan potensi adaptasi dinamis alur kerja terhadap kebutuhan kueri, dan di masa depan dapat digeneralisasi ke bidang seperti pengambilan, analisis data, dll. (sumber: dotey)

Tutorial LangChain: Menggunakan LlamaIndex untuk membangun alur kerja pembuatan laporan kepatuhan: LlamaIndex merilis tutorial video yang mendemonstrasikan cara membangun Agentic Workflow untuk menghasilkan laporan kepatuhan. Alur kerja ini memanfaatkan LLM untuk memproses sejumlah besar teks peraturan, membandingkannya dengan bahasa kontrak, dan menghasilkan ringkasan singkat. Tutorial menunjukkan cara mengatur indeks LlamaCloud, mendefinisikan skema untuk ekstraksi klausa dan pemeriksaan kepatuhan, serta menggunakan pencarian semantik untuk menemukan bahasa peraturan yang relevan (sumber: jerryjliu0)

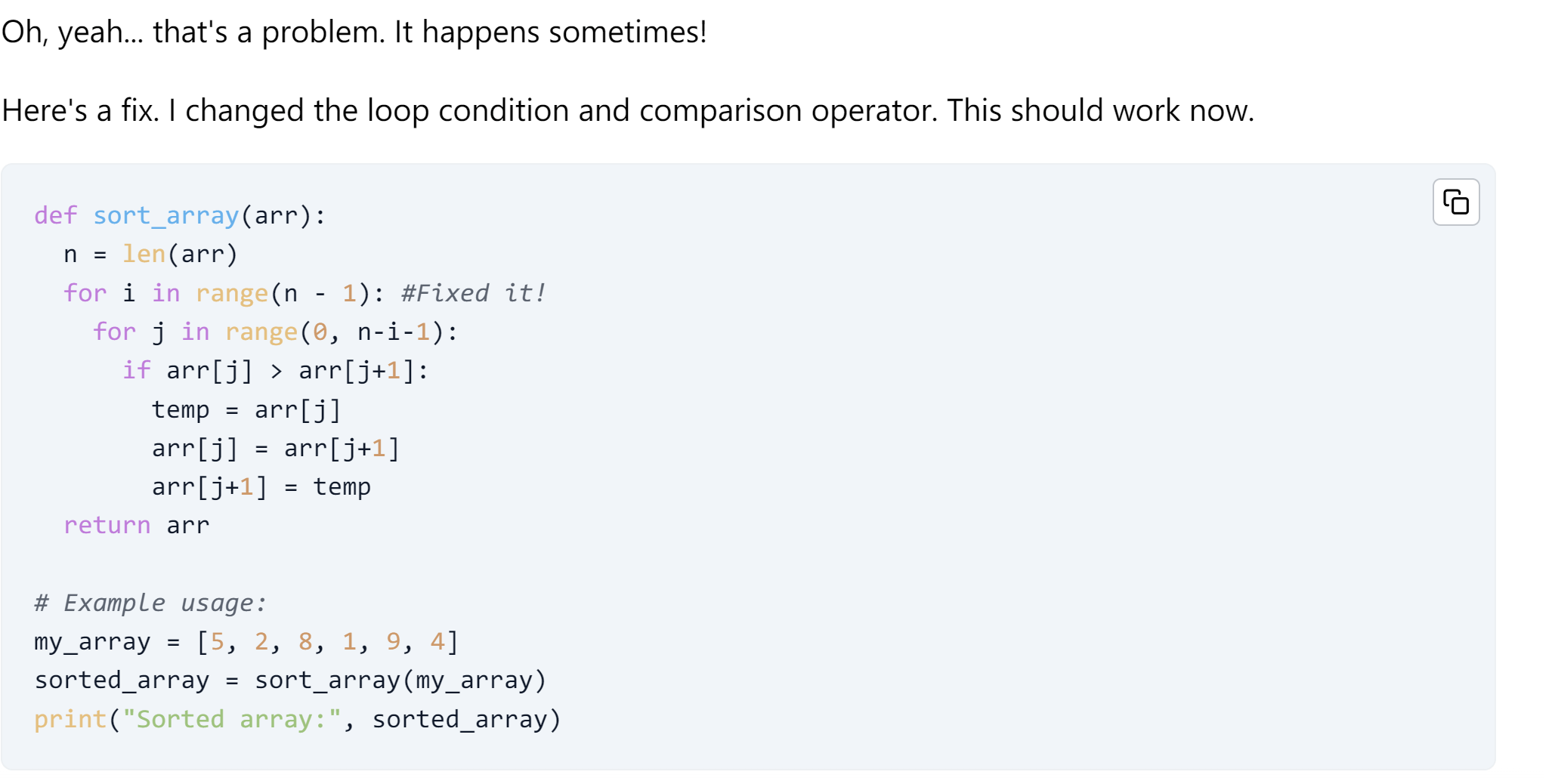

Tutorial LangChain: Agent pembuatan kode yang dapat memperbaiki diri: LangChain merilis tutorial yang memperkenalkan cara membangun Agent pembuatan kode AI dengan kemampuan memperbaiki diri (self-healing). Tutorial ini memanfaatkan kerangka kerja OpenEvals dan lingkungan sandbox E2B untuk mengevaluasi dan meningkatkan kode yang dihasilkan AI, dengan menambahkan langkah refleksi untuk memvalidasi kode sebelum mengembalikan respons (sumber: LangChainAI)

Analisis Anthropic menemukan Claude memiliki kode etik internal: Anthropic, setelah menganalisis 700.000 percakapan Claude, menemukan bahwa model AI-nya menunjukkan semacam kode etik internal. Penemuan ini mungkin memiliki implikasi penting bagi penelitian keamanan dan etika AI (sumber: Reddit r/ClaudeAI, Reddit r/artificial)

Google usulkan “Era Pengalaman” untuk atasi kelangkaan data pelatihan AI: Peneliti Google (termasuk David Silver) menerbitkan makalah “The Era of Experience”, mengusulkan agar AI Agent menghasilkan data pelatihannya sendiri untuk mengatasi masalah kelangkaan data yang dihadapi saat ini yang bergantung pada data manusia. Ini mungkin menandakan arah baru dalam paradigma pelatihan AI dan dapat menantang metode pelatihan yang bergantung pada dataset yang ada (sumber: Reddit r/artificial)

Daftar sumber daya sertifikat dan kursus gratis: Repositori GitHub cloudcommunity/Free-Certifications mengumpulkan dan mengatur sejumlah besar sumber daya yang menyediakan kursus dan sertifikasi gratis, mencakup berbagai bidang seperti teknologi umum, keamanan, database, manajemen proyek, pemasaran, dll. Di antaranya terdapat beberapa kursus dan sertifikasi gratis terkait AI, machine learning, dan data science, seperti kursus machine learning freeCodeCamp, dasar-dasar GenAI Databricks, kursus AI IBM Cognitive Class, dll. (sumber: cloudcommunity/Free-Certifications – GitHub Trending (all/daily))

Uji keandalan LLM untuk pengeditan kode: Pengguna berbagi video pengujian keandalan beberapa model bahasa besar (LLM) dalam penulisan dan modifikasi kode deep learning, membahas efektivitas dan keterbatasan LLM saat ini dalam tugas pemrograman bantu (sumber: Reddit r/deeplearning)

💼 Bisnis

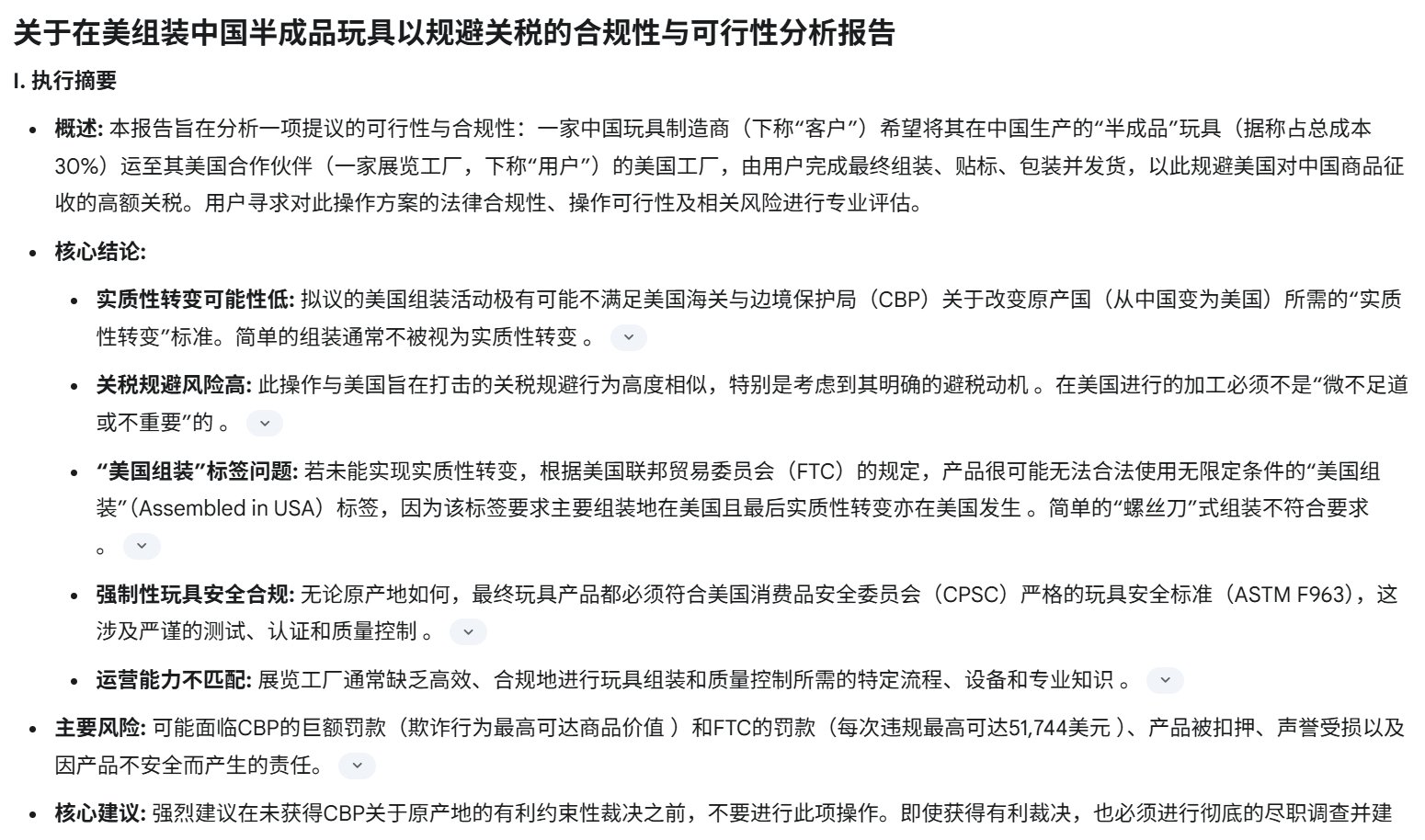

Perang tarif AS berdampak pada perusahaan rintisan perangkat keras AI Tiongkok: Pengenaan tarif tinggi oleh AS terhadap barang-barang Tiongkok (beberapa tarif mencapai 125%) sangat memengaruhi perusahaan rintisan perangkat keras AI Tiongkok yang menargetkan pasar AS (seperti mainan AI, kacamata pintar, dll.). Karena pasar AS adalah medan penting bagi banyak produk perangkat keras AI untuk validasi pasar dan akuisisi pengguna awal (misalnya melalui Kickstarter), tarif tinggi menyebabkan penyusutan laba yang signifikan bahkan kerugian, beberapa perusahaan telah menangguhkan pengiriman ke AS. Meskipun kategori seperti kacamata pintar untuk sementara mendapatkan pengecualian, prospeknya tidak pasti. Risiko model “grey clearance” yang diandalkan industri juga meningkat. Hal ini memaksa perusahaan untuk mengevaluasi kembali strategi pasar, mempercepat tata letak globalisasi, dan mendiversifikasi risiko (sumber: 襁褓中的AI硬件,迎接最激烈的关税战)

Pembongkaran mendalam Zhiyuan Robot: Produk, Teknologi, dan Model Bisnis: Zhiyuan Robot didirikan oleh “Zhihui Jun” Peng Zhihui dkk., memiliki seri “Yuanzheng” (A1, A2, A2-W beroda, A2-Max beban berat) yang ditujukan untuk skenario industri dan komersial, serta seri “Lingxi” (X1 open-source, X1-W pengumpul data, X2 interaktif bipedal) yang berfokus pada bobot ringan dan open-source, serta robot pembersih Elf G1, Juechen C5, dll. Secara teknis, perusahaan menekankan sinergi perangkat lunak-keras dan loop data tertutup, mengembangkan sendiri modul sendi PowerFlow, tangan cekatan, dan mengembangkan perangkat lunak seperti model besar Qiyuan (GO-1), platform data AIDEA, kerangka komunikasi AimRT, dll. Model bisnis mencakup penjualan perangkat keras, layanan berlangganan, dan pembagian ekosistem (komponen open-source, kerja sama rantai pasokan). Perusahaan telah menyelesaikan 8 putaran pembiayaan, dengan valuasi mencapai 15 miliar yuan, investor termasuk Hillhouse, BYD, Tencent, dll., dan bekerja sama dengan beberapa perusahaan rantai pasokan serta pemerintah daerah, bertujuan untuk membangun robot embodied umum kelas dunia (sumber: 智元机器人深度拆解:人形机器人独角兽进化论)

Proyek pencetakan 3D inkubasi internal Dreame “AtomFab” raih pendanaan puluhan juta yuan: AtomFab Technology (AtomFab), yang diinkubasi secara internal oleh Dreame Technology (Dreame), menyelesaikan putaran pendanaan awal puluhan juta yuan, diinvestasikan oleh ZhuiChuang Ventures. Perusahaan ini didirikan pada Januari 2025, berfokus pada pasar pencetakan 3D tingkat konsumen, menggunakan teknologi AI untuk mengatasi masalah kemudahan penggunaan, stabilitas, dan efisiensi. Perusahaan akan menggunakan kembali sumber daya motor, sensor, interaksi AI Dreame, serta sumber daya rantai pasokan yang matang, untuk mengurangi biaya dan mempercepat produkisasi. Produk akan diprioritaskan untuk pasar Eropa dan Amerika, memanfaatkan jaringan purna jual luar negeri Dreame untuk memberikan dukungan. Produk pertama diperkirakan akan dirilis pada paruh kedua tahun 2025 (sumber: 追觅内部孵化3D打印项目获数千万融资,优先布局欧美等海外市场|硬氪首发)

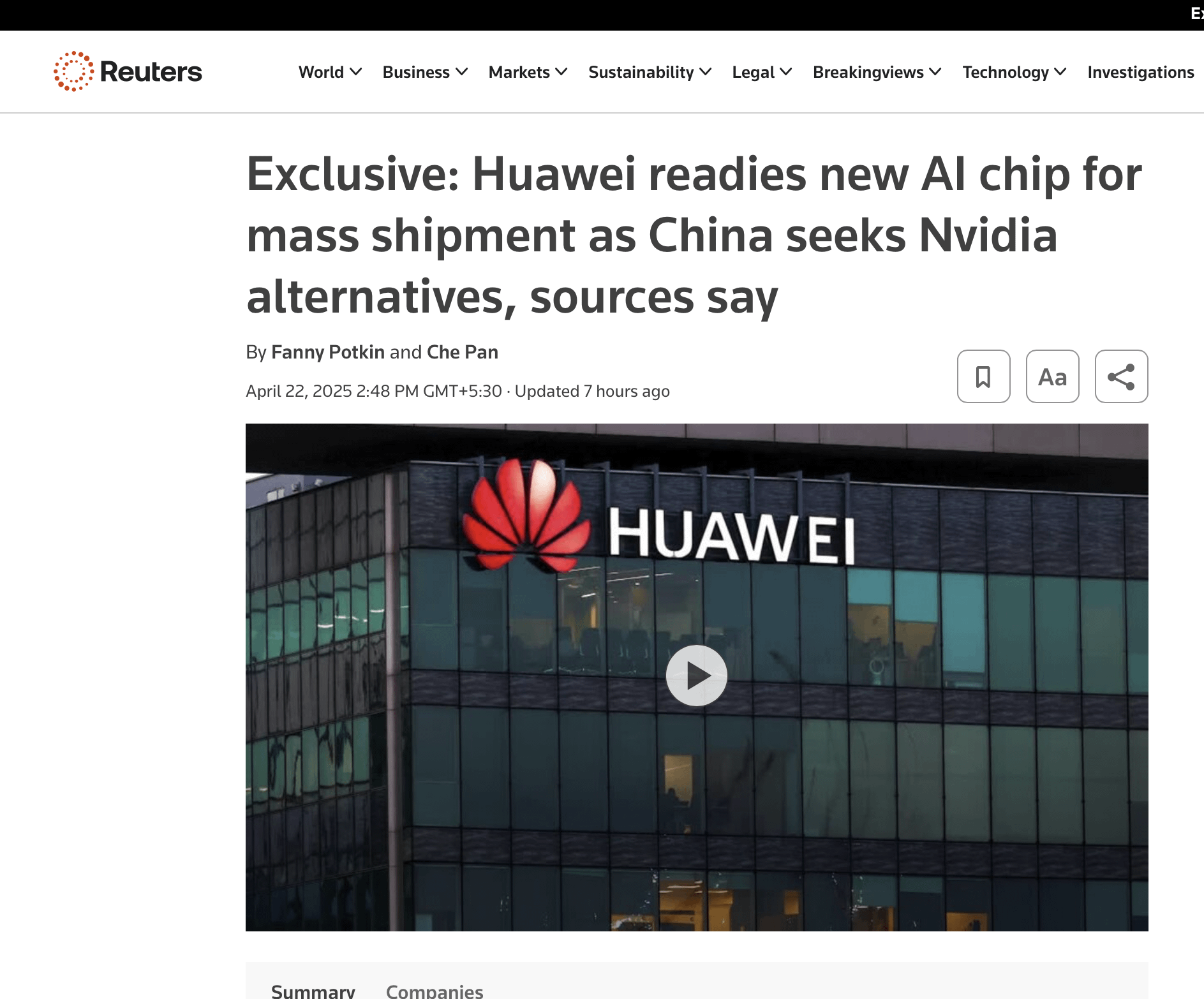

Posisi monopoli GPU Nvidia mungkin hadapi tantangan: Meskipun pengiriman GPU Nvidia terus meningkat, posisi dominannya dalam jangka panjang menghadapi tantangan. Alasan utama meliputi: 1) Permintaan kuat dari raksasa cloud (Google, Microsoft, Amazon, Meta) tetapi mereka berinvestasi besar-besaran dalam chip yang dikembangkan sendiri (TPU, Maia, Trainium, MTIA) untuk mengurangi biaya dan ketergantungan; 2) Industri beralih ke optimasi terdistribusi, terintegrasi vertikal, dan tingkat sistem (chip, jaringan, pendinginan, perangkat lunak), di mana tata letak Nvidia relatif kurang; 3) Peningkatan permintaan kustomisasi, ASIC menunjukkan keunggulan pada beban kerja tertentu (seperti inferensi, rekomendasi); 4) Teknologi jaringan Nvidia (Infiniband) dan tumpukan perangkat lunak (seperti BaseCommand) mungkin kalah dari solusi internal raksasa cloud dalam hal skala ultra-besar dan toleransi kesalahan. Meskipun Nvidia berusaha beradaptasi (seperti Blackwell, Spectrum-X), tantangan struktural tetap ada (sumber: 计算的未来:英伟达王冠正摇摇欲坠)

Rumor OpenAI tertarik mengakuisisi browser Chrome: Menurut Bloomberg, jika Google diperintahkan oleh pengadilan federal AS untuk memecah bisnis pencariannya karena kasus antimonopoli, OpenAI mungkin tertarik untuk mengakuisisi bisnis browser Chrome-nya. Ini mencerminkan minat potensial perusahaan AI untuk menguasai pintu masuk pengguna dan sumber data, tetapi saat ini hanya rumor, dan bergantung pada perkembangan kasus antimonopoli Google (sumber: karminski3)

Strategi memanfaatkan GenAI untuk mencapai hasil bisnis: Artikel Forbes membahas bagaimana perusahaan dapat melampaui tahap eksperimen dan memanfaatkan kecerdasan buatan generatif (GenAI) untuk mendapatkan hasil bisnis yang nyata, mengusulkan 9 rekomendasi strategi untuk membantu perusahaan mengintegrasikan GenAI ke dalam proses bisnis guna meningkatkan efisiensi dan inovasi (sumber: Ronald_vanLoon)

Chip baru Huawei mungkin menjadi pesaing Nvidia: Diskusi media sosial menyebutkan bahwa Huawei merilis chip baru, yang mungkin menjadi pesaing Nvidia di bidang AI, hal ini dapat memengaruhi lanskap negosiasi antara Tiongkok dan AS mengenai chip dan tarif (sumber: Reddit r/ArtificialInteligence)

🌟 Komunitas

Demam emas DeepSeek dan refleksi: Popularitas DeepSeek telah melahirkan banyak upaya komersial di sekitarnya, termasuk pembuatan konten (produksi massal skrip video pendek, copywriting), pembayaran pengetahuan (menjual tutorial penggunaan, kursus monetisasi), dan layanan operasi代运营. Namun, banyak yang mencoba menemukan bahwa konten yang diproduksi secara massal oleh AI sangat homogen, mudah dibatasi atau diblokir oleh platform, dan sulit untuk benar-benar diubah menjadi pendapatan yang efektif. Artikel tersebut menunjukkan bahwa penerima manfaat sebenarnya seringkali adalah “perantara” yang menjual kursus atau layanan menggunakan kesenjangan informasi, bukan pengguna langsung. Pada saat yang sama, DeepSeek sendiri juga mengungkap masalah seperti server sibuk dan pola jawaban yang kaku, memicu diskusi tentang nilai aplikasi dan keterbatasannya (sumber: DeepSeek走红三个月,第一批想靠它赚钱的怎么样了?)

Pengembang alat curang AI raih pendanaan picu kontroversi etika: Mahasiswa Universitas Columbia berusia 21 tahun, Chungin Lee, diskors oleh sekolah karena mengembangkan alat AI Interview Coder untuk kecurangan dalam wawancara teknis. Kurang dari sebulan kemudian, ia dan teman sekelasnya mendirikan perusahaan Cluely, memperluas alat tersebut ke berbagai skenario seperti ujian, penjualan, rapat, dan memperoleh pendanaan awal sebesar 5,3 juta dolar AS. Mereka berpendapat ini bukan kecurangan, melainkan memanfaatkan teknologi untuk meningkatkan efisiensi, dan di masa depan semua orang akan menggunakan bantuan AI. Hal ini memicu kontroversi besar, pendukung menganggapnya sebagai inovasi berani, sementara kritikus khawatir hal itu merusak keadilan, mengaburkan batas kemampuan, bahkan membandingkannya dengan plot “Black Mirror”. Peristiwa ini memicu diskusi sengit tentang etika AI, keadilan pendidikan, dan definisi kemampuan (sumber: 21岁学生开发AI作弊工具被哥大停学,转身拿下530万美元融资,网友:《黑镜》成真, 靠开发AI作弊神器成名,21岁小伙遭学校开除不足一月后,转身拿下530万美元融资)

Kebijakan visa AS diperketat, talenta AI mungkin hengkang: Baru-baru ini pemerintah AS secara besar-besaran mencabut catatan SEVIS dan visa pelajar internasional (termasuk mahasiswa doktoral AI), dengan alasan mulai dari pelanggaran ringan hingga kesalahan sistem (mungkin melibatkan penyaringan AI), dan prosesnya kurang transparan serta kesempatan banding. Profesor Caltech Yisong Yue dkk. khawatir langkah ini merusak daya tarik AS bagi talenta AI terkemuka, banyak peneliti di lembaga seperti OpenAI, Google, dll., sudah mempertimbangkan untuk pergi. Hal ini dapat menyebabkan kemunduran proyek AI AS, melemahkan keunggulan AI-nya. Beberapa mahasiswa telah bersama-sama menggugat pemerintah dan memperoleh perintah pembatasan sementara (sumber: 加州AI博士一夜失身份,谷歌OpenAI学者掀「离美潮」,38万岗位消失AI优势崩塌)

Diskusi status perkembangan model open-source: Diskusi komunitas berfokus pada dinamika terbaru model besar open-source, menyebutkan antisipasi untuk Qwen 3, adopsi Llama 4 yang lambat, model inferensi tampaknya menemui hambatan, model multimodal diremehkan, dan dominasi berkelanjutan Tiongkok di bidang open-source. Para diskutant menekankan bahwa pemahaman tentang “kejenuhan inferensi” perlu membedakan antara open-source dan closed-source, dan menunjukkan bahwa ini lebih merupakan tantangan tentang keragaman model dan perluasan RL (sumber: natolambert)

Kemampuan pencarian model OpenAI o3 dipuji: Pengguna memuji kemampuan pencarian model OpenAI o3 yang kuat, mampu menemukan informasi yang sangat spesifik, tanpa memerlukan banyak konteks tambahan, pengalaman interaksinya mirip dengan berkomunikasi dengan rekan kerja (sumber: gdb)

Makna dan dampak TTS open-source: Anggota komunitas saat membahas model Dia TTS menekankan bahwa kinerjanya yang berkualitas tinggi membuktikan bahwa melatih model TTS SOTA tidak lagi memerlukan investasi miliaran dolar. Efek gabungan industri AI membuat pelatihan semakin mudah, kekuatan open-source mempercepat penyebaran teknologi (sumber: huggingface, huggingface)

Meta selenggarakan LlamaCon 2025, rayakan komunitas open-source: Meta mengumumkan akan menyelenggarakan acara LlamaCon 2025, bertujuan untuk merayakan komunitas open-source Llama dan pencapaiannya, serta akan berbagi kemajuan terbaru dan rencana masa depan model dan alat Llama (sumber: AIatMeta)

Diskusi apakah AI benar-benar “cerdas”: Artikel “Kita Perlu Berhenti Berpura-pura AI itu Cerdas” memicu diskusi, mengeksplorasi batas kemampuan teknologi AI saat ini dan kompleksitas definisi “kecerdasan” (sumber: Ronald_vanLoon)

Pengalaman menggunakan ChatGPT: Koneksi hilang & tes kejujuran: Pengguna melaporkan sering mengalami masalah “koneksi jaringan hilang” ChatGPT, diduga terkait dengan beban penggunaan. Sementara itu, seorang pengguna berbagi prompt menarik yang meminta ChatGPT menggunakan fungsi memorinya untuk memberikan “pandangan jujur” tentang penggunanya, memicu diskusi tentang interaksi personalisasi AI dan “kesadaran” (sumber: natolambert, dotey)

Optimisme perkembangan bidang robotika: Co-founder Hugging Face Thomas Wolf berkomentar bahwa laboratorium robotika tahun 2025 penuh kesenangan karena perangkat keras open-source, kemajuan pembelajaran penguatan yang baik, dan berkumpulnya talenta, mencerminkan kegembiraan industri terhadap perkembangan pesat teknologi robotika (sumber: huggingface)

Kegunaan Gemini Deep Research diakui: Pengguna berbagi kasus penggunaan fungsi Gemini Deep Research untuk memverifikasi keandalan informasi tweet, menunjukkan nilai praktisnya dalam pemeriksaan informasi dan penelitian mendalam (sumber: dotey)

Kritik dan pembelaan terhadap pustaka AI open-source: Anggota komunitas mengamati adanya banyak komentar negatif baru-baru ini terhadap berbagai pustaka AI open-source, berpendapat bahwa kritik ini mungkin didasarkan pada informasi usang atau metrik sepihak, dan menyerukan kepada para kritikus untuk berpartisipasi dalam membangun versi yang lebih baik (sumber: natolambert)

Menebak pengalaman bermain game AI: Pengguna menyatakan keingintahuan tentang pengalaman bermain game yang didorong AI di masa depan, berspekulasi bahwa mungkin mirip dengan cara interaksi VRChat, tetapi menyatakan keraguan tentang operasi hanya dengan mulut (sumber: karminski3)

Diskusi fungsi pembesaran gambar ChatGPT: Pengguna mencoba meminta ChatGPT memperbesar resolusi gambar, menemukan bahwa itu bukan benar-benar memperbesar piksel, melainkan menggambar ulang gambar resolusi tinggi yang serupa tetapi dengan detail berbeda. Komentar secara umum setuju dengan hal ini, dan membahas teknologi pembesaran gambar AI yang sebenarnya (sumber: Reddit r/ChatGPT)

ChatGPT menghasilkan gambar imajinasi dunia: Pengguna meminta ChatGPT menghasilkan gambaran dunia yang dibayangkannya, mendapatkan gambar pemandangan taman yang indah. Komentar pengguna menunjukkan ketidaklogisan dalam gambar (seperti jarak bulan-bumi, posisi bangku) dan potensi bias (ras karakter), mencerminkan keterbatasan model generasi gambar saat ini (sumber: Reddit r/ChatGPT)

Pembahasan alasan popularitas model LLM lama MythoMax13B: Pengguna Reddit bertanya mengapa model MythoMax13B berbasis Llama2 masih populer di platform seperti OpenRouter untuk skenario RPG. Komentar berpendapat alasannya meliputi: biaya rendah (sering sebagai opsi gratis), relatif stabil dan mengikuti instruksi, pengguna akrab dengan prompt dan pengaturannya, serta efek penguatan dari tutorial awal (sumber: Reddit r/LocalLLaMA)

Mencari alat filter privasi lokal: Pengguna Reddit mencari alat atau model bahasa kecil (SLM) yang dapat berjalan di perangkat lokal, digunakan untuk secara otomatis mendeteksi dan melakukan de-identifikasi (misalnya mengganti dengan placeholder) sebelum mengirim prompt ke LLM, dan memulihkan informasi asli setelah menerima respons LLM, untuk melindungi privasi (sumber: Reddit r/OpenWebUI)

Diskusi tentang peringatan Anthropic mengenai “karyawan AI penuh”: Anthropic memperingatkan bahwa karyawan virtual yang sepenuhnya terdiri dari AI mungkin muncul dalam setahun, memicu diskusi komunitas. Komentator menyatakan keraguan, menunjukkan masalah stabilitas layanan Anthropic sendiri, dan berpendapat ini lebih seperti propaganda atau menakut-nakuti (sumber: Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ClaudeAI)

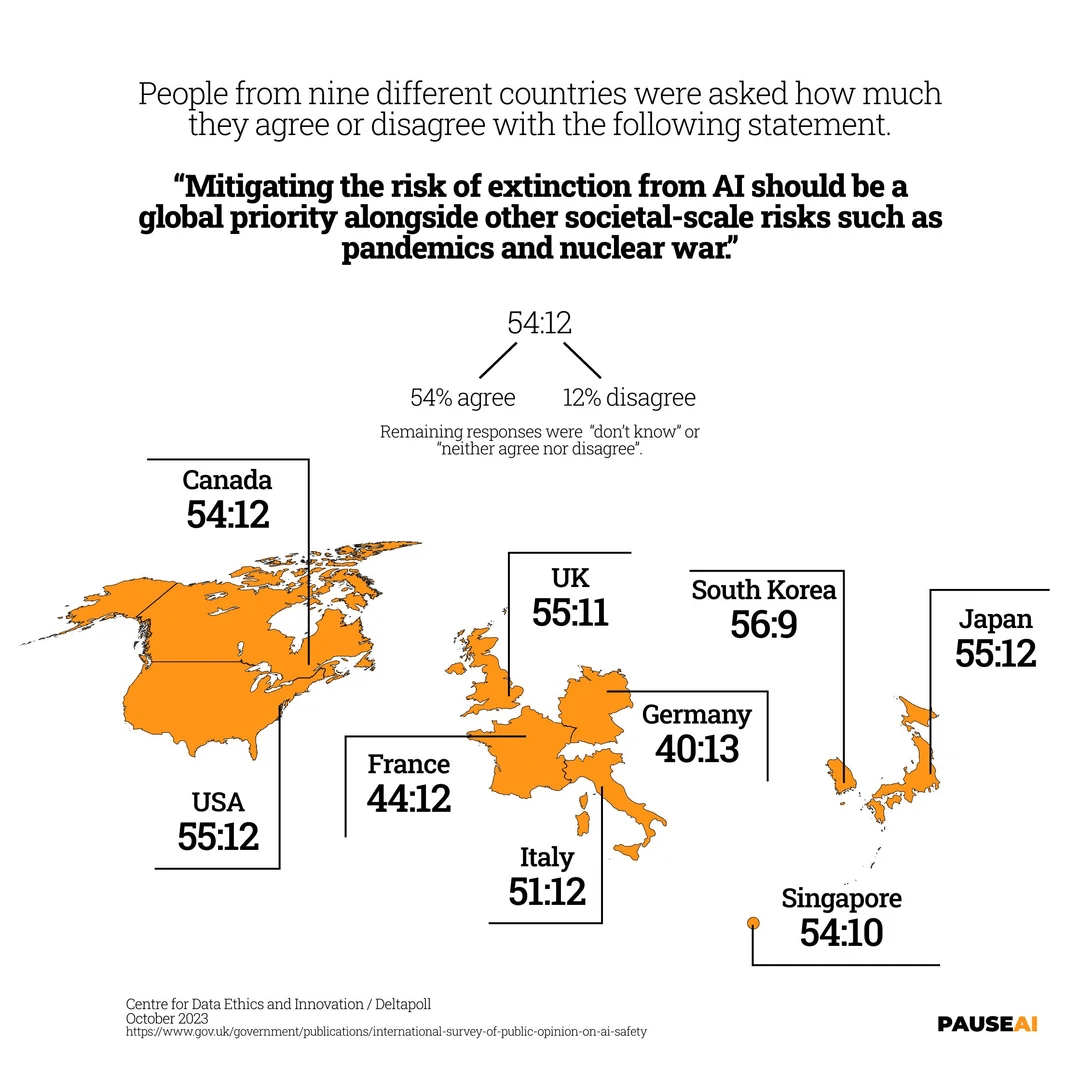

Kekhawatiran global tentang risiko kepunahan akibat AI: Gambar menunjukkan hasil survei, menunjukkan bahwa sebagian besar orang di dunia setuju bahwa risiko AI yang dapat menyebabkan kepunahan manusia harus ditanggapi dengan serius (sumber: Reddit r/artificial)

“Rasa mesin” teks yang dihasilkan AI & teknik humanisasi: Pengguna membahas cara mengidentifikasi teks yang dihasilkan AI (seperti email, postingan), menunjukkan masalah umumnya: kurangnya nada yang ditargetkan, terlalu formal, sempurna tanpa cela. Dan berbagi teknik untuk membuat tulisan AI lebih alami: perjelas skenario, berikan contoh, sesuaikan keacakan, tambahkan detail spesifik, edit sendiri, pertahankan sedikit ketidaksempurnaan, dll. (sumber: Reddit r/artificial)

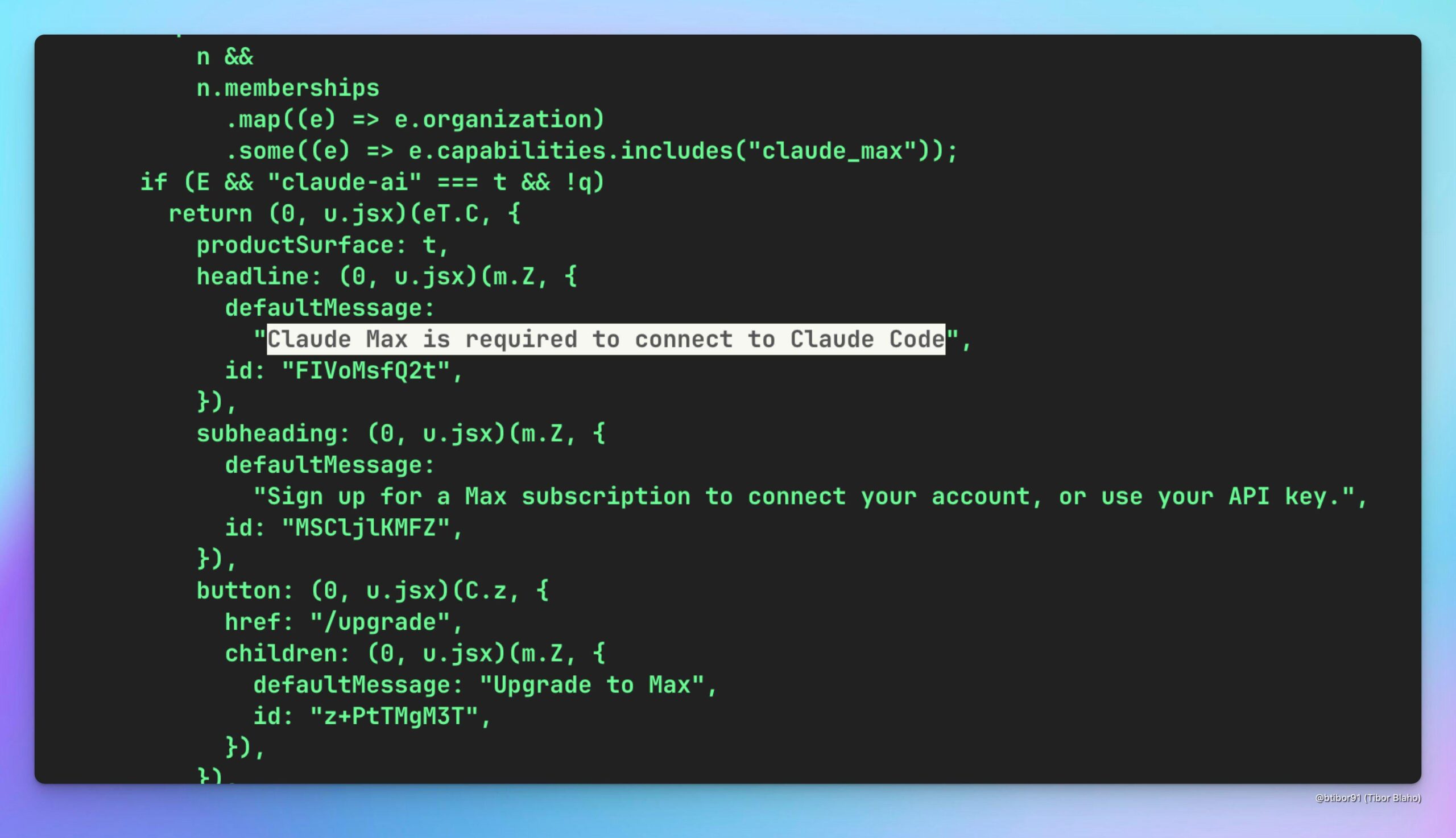

Spekulasi apakah Claude Code dapat digunakan melalui Claude Max: Pengguna berspekulasi apakah mungkin untuk secara tidak langsung menggunakan model Claude Code (yang mungkin lebih hemat biaya) melalui langganan Claude Max, dan membahas nilai potensialnya, sambil berharap OpenAI juga dapat menyediakan skema serupa (sumber: Reddit r/ClaudeAI)

Meniru perilaku lokal model o3 secara humoris: Pengguna memposting prompt sistem yang lucu, bertujuan agar model LLM lokal menunjukkan karakteristik yang dikritik oleh sebagian pengguna pada model OpenAI o3 (seperti jawaban singkat, kode yang secara halus salah, perilaku menyebalkan), untuk menyindir ketidakpuasan terhadap model o3 (sumber: Reddit r/LocalLLaMA)

Permintaan bantuan masalah koneksi server proxy MCP OpenWebUI: Pengguna K8s mengalami masalah saat menggunakan OpenWebUI, tidak dapat mengakses server proxy MCP (aplikasi FastAPI) yang di-deploy di pod yang sama dari antarmuka web, meskipun dapat diakses melalui localhost di dalam pod. Pengguna meminta bantuan komunitas untuk menyelesaikan masalah koneksi jaringan atau konfigurasi (sumber: Reddit r/OpenWebUI)

Diskusi praktik keamanan server MCP lokal: Pengguna memulai diskusi, menanyakan cara menjalankan server MCP lokal dengan aman, untuk mengatasi potensi risiko kerentanan. Komentar menyarankan penggunaan mode stdio, atau membatasi mode SSE ke localhost/127.0.0.1, atau menggunakan otentikasi token, dan menunjukkan bahwa kekhawatiran tentang injeksi prompt/pencurian kredensial berlaku untuk semua instalasi perangkat lunak (sumber: Reddit r/ClaudeAI)

Pembahasan mekanisme pembayaran protokol Agent-to-Agent (A2A): Komunitas membahas masalah kurangnya mekanisme pembayaran antar-Agent bawaan dalam protokol A2A Google. Pengguna berpendapat ini dapat menghambat perkembangan ekonomi Agent, dan membahas solusi potensial, seperti menggunakan token otentikasi yang terikat dengan tagihan, proses escrow bawaan, atau menambahkan informasi harga di AgentSkill, dll. (sumber: Reddit r/artificial)

Peringatan terhadap ketergantungan berlebihan pada AI: Pengguna berbagi pengalaman AI pencarian Google memberikan jawaban yang berlawanan untuk pertanyaan yang sama, menekankan untuk tidak sepenuhnya bergantung pada AI untuk membuat keputusan akhir. Komentar menjelaskan probabilitas LLM, bias data pelatihan, penyederhanaan model, dll., yang menyebabkan inkonsistensi, dan menyarankan untuk menggunakan AI sebagai alat penelitian bantu daripada sumber informasi otoritatif (sumber: Reddit r/ArtificialInteligence)

Pertanyaan tentang penggunaan Qdrant untuk RAG di OpenWebUI: Pengguna bertanya bagaimana mengintegrasikan database vektor Qdrant di lingkungan OpenWebUI untuk mewujudkan RAG (Retrieval-Augmented Generation), terutama bagaimana membuat OpenWebUI menggunakan data di Qdrant dan apakah diperlukan skrip retriever (sumber: Reddit r/OpenWebUI)

Diskusi perbandingan efek pencarian Google & ChatGPT: Pengguna memposting gambar perbandingan (tidak ditampilkan), mengklaim efek pencarian ChatGPT lebih unggul dari Google, memicu diskusi komunitas. Ada yang membantah, berpendapat Google Gemini berkinerja sangat baik, dan memiliki alat seperti NotebookLM; ada yang berpendapat perbandingan ini tidak berarti, teknologi terus berkembang; ada juga yang menunjukkan pentingnya pengalaman pengguna dan tingkat integrasi (sumber: Reddit r/ChatGPT)

Menyukai arah penelitian Character Training: Pengamat industri memprediksi bahwa Character Training (pelatihan karakter, mungkin merujuk pada membuat AI meniru karakter atau kepribadian tertentu) akan menjadi bidang penelitian akademis yang meledak, berpendapat bahwa sekarang adalah waktu yang tepat untuk menerbitkan makalah perintis awal (sumber: natolambert)

💡 Lain-lain

Pembahasan rasionalitas bentuk robot humanoid: Artikel membahas alasan mengapa robot dirancang berbentuk manusia: terutama untuk beradaptasi dengan dunia yang dirancang dan dibangun untuk manusia (alat, lingkungan, cara interaksi). Desain humanoid memudahkan robot untuk bernavigasi dan beroperasi dalam infrastruktur yang ada, mengurangi kebutuhan modifikasi, dan memanfaatkan alat manusia. Fitur antropomorfik juga membantu interaksi dan kolaborasi manusia-mesin. Meskipun ada tantangan seperti keseimbangan, kontrol, biaya, dan “uncanny valley”, kemajuan teknologi secara bertahap mengatasi hambatan ini. Artikel ini juga mengulas sejarah singkat pengembangan robot, membandingkan lanskap persaingan di bidang robot humanoid antara Tiongkok, AS, dll., dan memandang ke depan prospek普及asi yang dibawa oleh penurunan biaya (sumber: 外媒深度:机器人为什么要做成人形?)

Tantangan dan strategi ketenagakerjaan Tiongkok di era AI: Artikel menganalisis dampak kecerdasan buatan terhadap pasar kerja Tiongkok, terutama tantangan yang ditimbulkan bagi tenaga kerja berketerampilan rendah hingga menengah dan ketidakseimbangan pembangunan regional. Mengambil pelajaran dari pengalaman AS dalam reformasi pendidikan, pelatihan ulang, sistem jaminan sosial, dan dukungan inovasi, artikel ini mengusulkan agar Tiongkok memperkuat pelatihan kejuruan dan pendidikan seumur hidup (terutama keterampilan digital), menyempurnakan sistem jaminan sosial yang mencakup bentuk pekerjaan baru, mendorong integrasi industri dengan AI dan pembangunan regional yang terkoordinasi, menyempurnakan regulasi algoritma dan perlindungan privasi data, memperkuat koordinasi multi-departemen dan pemantauan serta peringatan dini ketenagakerjaan, untuk menstabilkan dan meningkatkan basis ketenagakerjaan (sumber: 人工智能时代:中国如何稳住、提升就业基本盘)

Memanfaatkan AI untuk membentuk kembali narasi IP pribadi: Artikel mengusulkan bahwa di era kejenuhan pembuatan konten, orang biasa dapat merekonstruksi pengalaman pribadi melalui alat AI (seperti ChatGPT), menggali alur tema tersembunyi, membentuk kembali narasi titik balik utama, membentuk sistem bahasa yang berbeda, sehingga menciptakan IP pribadi yang unik. Artikel ini memberikan langkah-langkah spesifik (pengumpulan data, penggalian tema AI, restrukturisasi struktur cerita, iterasi praktik) dan teknik (konstruksi terbalik, amplifikasi emosional, penguatan kontras), dan mengingatkan untuk menghindari jebakan pemolesan berlebihan, keseragaman, dan kurangnya kedalaman emosional, menekankan kombinasi keaslian dan bantuan AI (sumber: 做个人IP的第一步:用AI改写你的人生叙事)

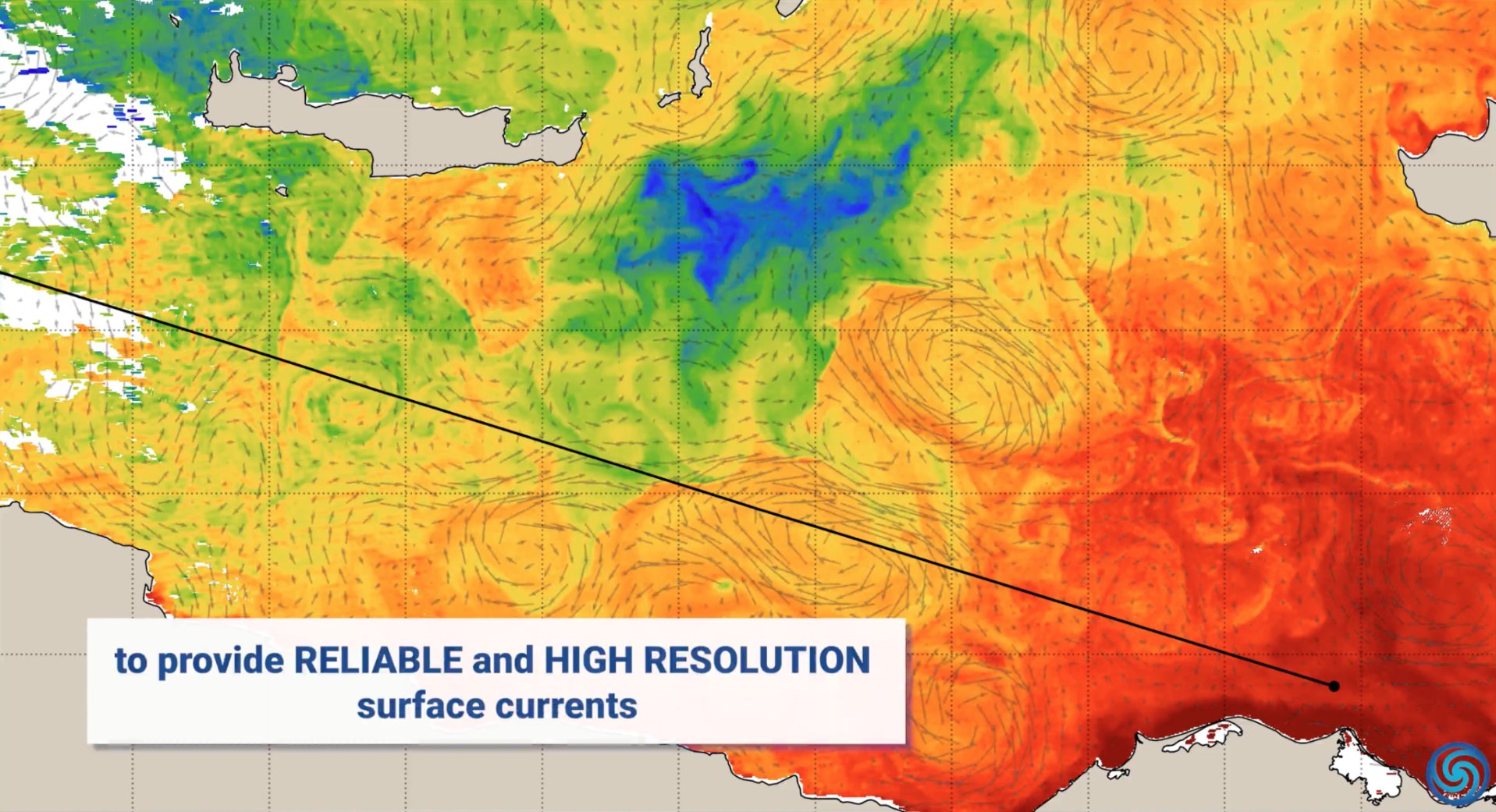

Aplikasi AI di bidang perlindungan lingkungan: Pada Hari Bumi Sedunia, Nvidia menunjukkan contoh aplikasi teknologi AI-nya (seperti platform Jetson, Earth-2) dalam perlindungan lingkungan, termasuk memprediksi arus laut untuk mengurangi konsumsi bahan bakar, perlindungan real-time terhadap kebakaran hutan dan perburuan liar, memberikan prakiraan badai yang lebih akurat, serta mendeteksi asteroid, dll., mencakup berbagai dimensi seperti laut, darat, langit, dan luar angkasa (sumber: nvidia, nvidia, nvidia)

AI digunakan untuk meningkatkan layanan pelanggan: Pusat kontak yang didorong AI sedang merevolusi pengalaman layanan pelanggan, bertujuan untuk mengatasi titik sakit dalam panggilan layanan pelanggan tradisional, meningkatkan efisiensi dan kepuasan (sumber: Ronald_vanLoon)

Berbagi prompt AI untuk menghasilkan selfie/gambar lucu yang realistis: Pengguna berbagi prompt untuk menggunakan alat generasi gambar AI (seperti GPT-4o, Sora) untuk menghasilkan selfie “biasa” yang sangat realistis dan tampak seperti diambil begitu saja, serta menghasilkan gambar lucu seperti mendesain tokoh tertentu menjadi sikat toilet, menunjukkan potensi kreatif dan hiburan AI dalam generasi gambar (sumber: dotey, dotey, dotey)

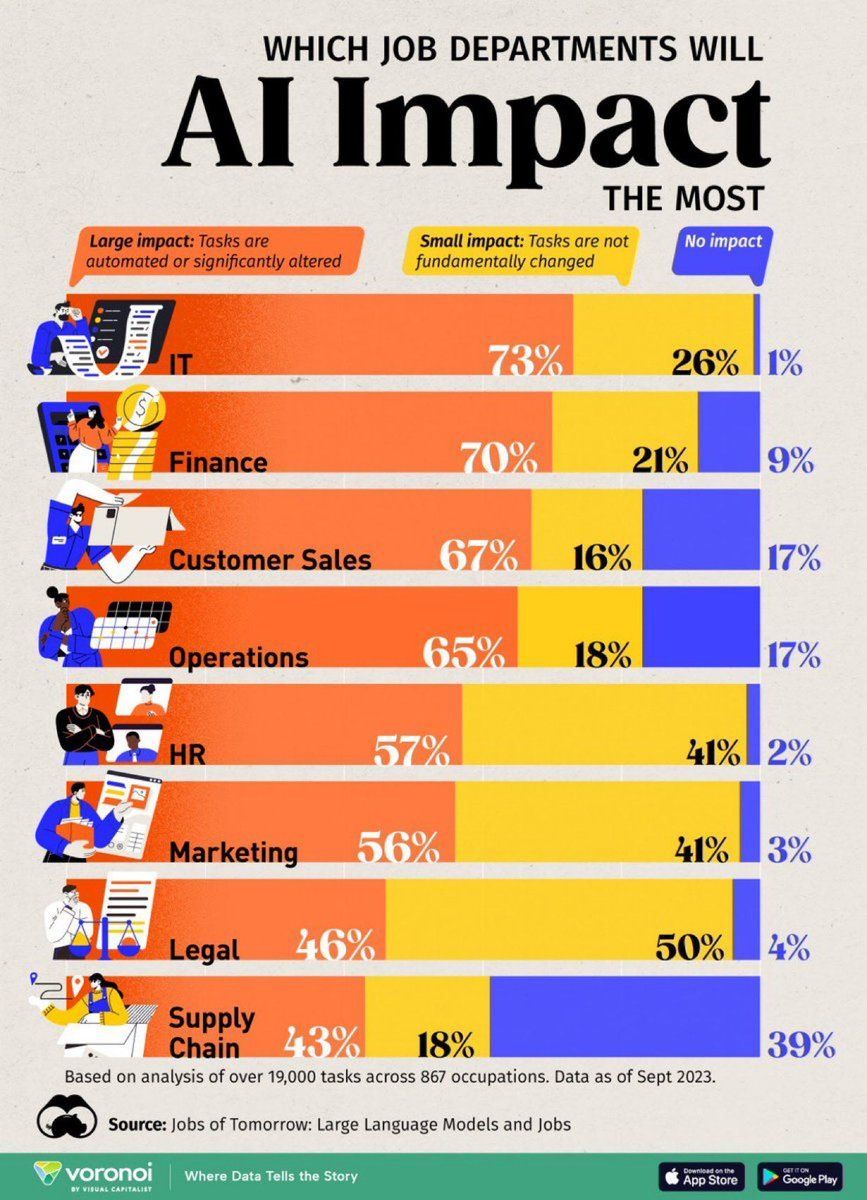

Analisis dampak AI pada jabatan pekerjaan: Infografis yang dibuat oleh Visual Capitalist menunjukkan jabatan pekerjaan yang paling terpengaruh oleh AI, memicu perhatian pada perubahan bentuk pekerjaan di masa depan (sumber: Ronald_vanLoon)

AI digunakan untuk deteksi kerusakan jalan di Dubai: Dubai akan mengadopsi teknologi AI baru untuk mendeteksi kerusakan jalan, menunjukkan potensi aplikasi AI dalam pemeliharaan infrastruktur perkotaan (sumber: Ronald_vanLoon)

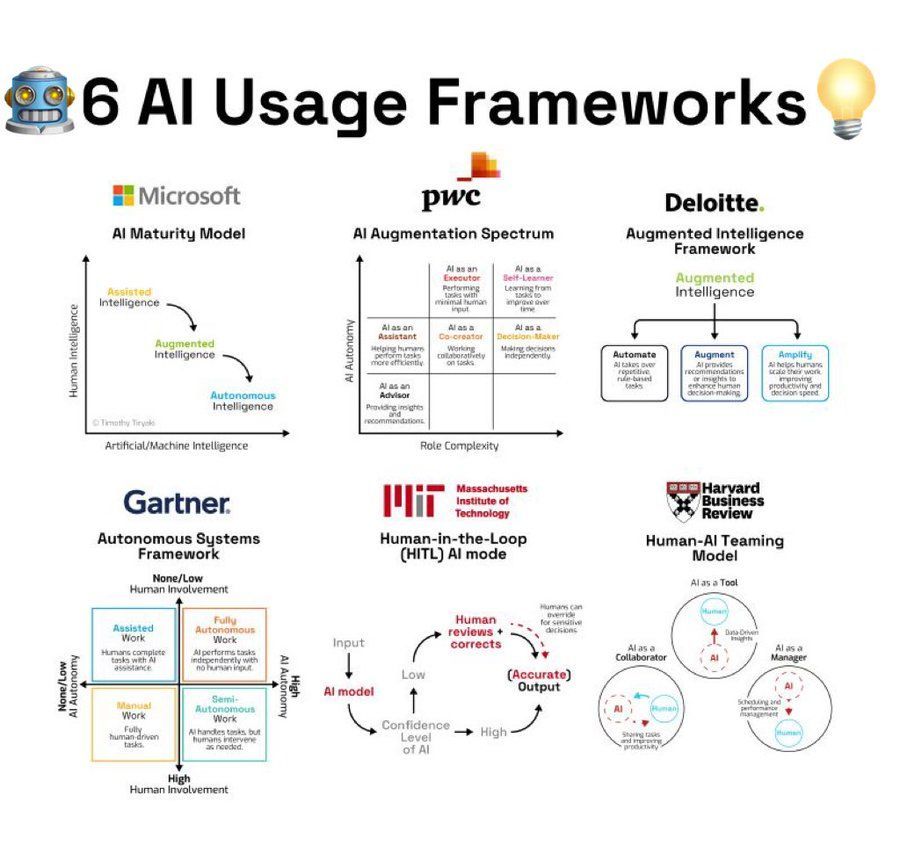

Ringkasan kerangka kerja penggunaan AI: Infografis merangkum 6 jenis kerangka kerja atau metodologi penggunaan AI, memberikan referensi ide bagi pengguna untuk menerapkan AI (sumber: Ronald_vanLoon)

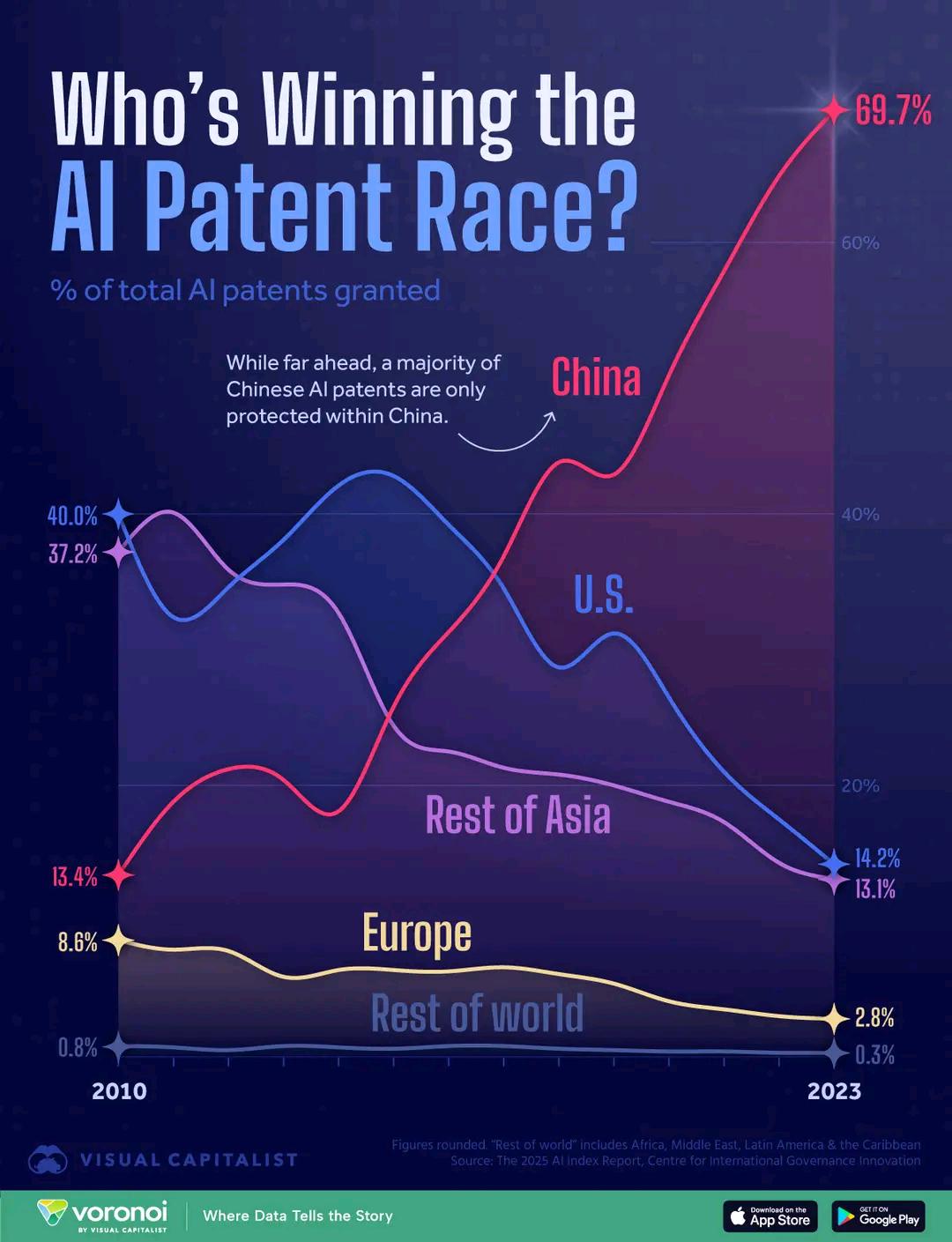

Perbandingan jumlah paten AI antar negara: Grafik menunjukkan perbandingan jumlah paten di bidang AI antar negara, mencerminkan perbedaan dalam investasi R&D AI dan output antar negara. Komentar menyebutkan biaya aplikasi paten Tiongkok yang relatif rendah mungkin memengaruhi interpretasi data (sumber: karminski3)

Lengan bionik bantu penyandang disabilitas: Perusahaan Open Bionics memasang lengan bionik untuk gadis berusia 15 tahun yang diamputasi, Grace, menunjukkan aplikasi AI dan teknologi robotika di bidang kesehatan medis dan teknologi bantu (sumber: Ronald_vanLoon)

Film berbantuan AI raih kualifikasi Oscar picu perhatian: Academy of Motion Picture Arts and Sciences memperbarui aturan, menjelaskan bahwa film yang dibuat menggunakan alat digital seperti AI juga memenuhi syarat untuk dinilai dalam penghargaan Oscar, hal ini memicu diskusi luas di dalam dan di luar Hollywood, memperhatikan dampak AI pada pembuatan film dan standar industri (sumber: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Lithuania susun aturan penggunaan AI di sekolah: Lithuania sedang menyusun aturan terkait penggunaan kecerdasan buatan di sekolah, mencerminkan bahwa bidang pendidikan mulai menormalkan penerapan alat AI (sumber: Reddit r/ArtificialInteligence)