Kata Kunci:AI, OpenAI, o3/o4-mini model, Gemini 2.5 Pro, Alat pemrograman AI, Teknologi AI multimodal, Agen cerdas AI

🔥 Fokus

OpenAI Meluncurkan o3 dan o4-mini yang Menggemparkan, Membuka Era Baru “Berpikir dengan Gambar”: OpenAI secara resmi merilis model flagship “reasoning” terbarunya, o3, dan versi ringkasnya, o4‑mini. Kedua model ini untuk pertama kalinya mewujudkan “berpikir menggunakan gambar”, mampu menyematkan dan memproses gambar (seperti memperbesar, memutar) dalam reasoning chain, menggabungkannya dengan teks untuk analisis. Mereka juga untuk pertama kalinya dapat secara mandiri menggabungkan penggunaan semua alat dalam ChatGPT (pencarian web, eksekusi kode Python, analisis file, pembuatan gambar) untuk menyelesaikan masalah kompleks. o3 mencetak rekor SOTA baru di berbagai benchmark seperti Codeforces, SWE-bench, MMMU, terutama menonjol dalam visual reasoning dan tugas multi-langkah, dengan tingkat kesalahan serius berkurang 20% dibandingkan o1. Sementara itu, o4-mini melampaui o3-mini dalam tugas matematika, pemrograman, dan visual dengan latensi dan biaya yang lebih rendah. Pada saat yang sama, OpenAI merilis open source agen AI pemrograman terminal ringan, Codex CLI, dan meluncurkan program pendanaan satu juta dolar. Model baru ini telah tersedia untuk pengguna ChatGPT Plus/Pro/Team serta pengembang API, menandai langkah maju AI menuju kemampuan multimodal dan agent yang lebih kuat. (Sumber: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表、openai、sama、karminski3、karminski3、sama、gdb、karminski3、sama、dotey、openai、karminski3、op7418、gdb、

)

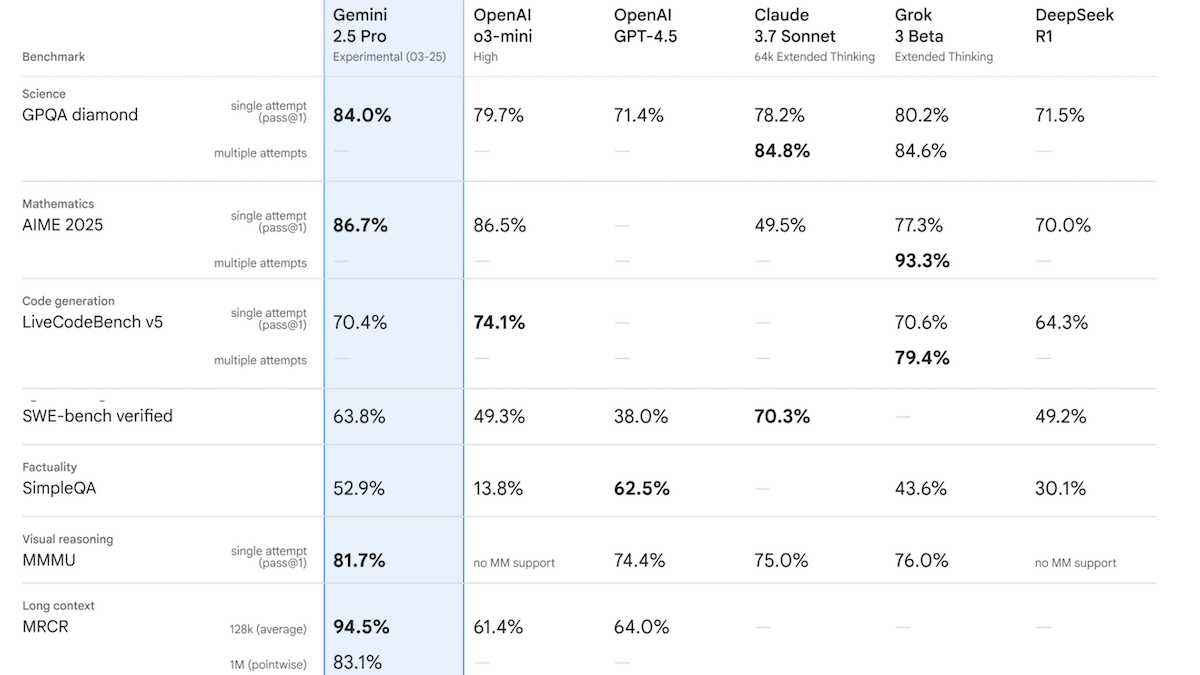

Google Merilis Gemini 2.5 Pro Experimental, Puncaki Performa di Chatbot Arena: Google meluncurkan model pertama dari keluarga Gemini 2.5-nya, Gemini 2.5 Pro Experimental, dan mengumumkan versi latensi rendah Gemini 2.5 Flash. Model ini mendukung input teks, audio, gambar, video (hingga 1 juta token, rencana masa depan 2 juta), dan output teks (hingga 65 ribu token). Fitur utamanya adalah kemampuan reasoning yang kuat, dicapai dengan menghasilkan token reasoning tersembunyi (chain of thought) sebelum memberikan respons. Di Chatbot Arena, Gemini 2.5 Pro Experimental melampaui GPT-4o dan Grok 3 Preview dengan skor Elo 1437, menempati posisi teratas. Dalam 12 benchmark, model ini unggul dalam 7 di antaranya dibandingkan model teratas termasuk o3-mini, GPT-4.5, dan Claude 3.7 Sonnet. Ini menunjukkan bahwa model AI, terutama model reasoning, terus berkembang pesat. Google berencana agar semua model baru di masa depan memiliki kemampuan reasoning. (Sumber: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

🎯 Tren

OpenAI Merilis Seri Model GPT-4.1, Fokus pada Biaya Rendah dan Efisiensi Tinggi: OpenAI meluncurkan seri GPT-4.1, termasuk GPT-4.1, GPT-4.1 Mini, dan GPT-4.1 Nano. Fitur utamanya adalah pengurangan biaya dan peningkatan kecepatan. GPT-4.1 Mini mengungguli GPT-4o dalam beberapa benchmark, dengan latensi yang jauh lebih rendah dan biaya berkurang 83%. GPT-4.1 Nano adalah model ultra-kecil pertama yang mendukung konteks 1 juta token, cocok untuk tugas latensi rendah. Ketiga model meningkatkan context window dari 128K menjadi 1 juta token. Dari segi harga, input/output GPT-4.1 adalah $2/$8 per juta token, 26% lebih murah dari GPT-4o; input/output Nano adalah $0.1/$0.4. Langkah ini dianggap sebagai respons terhadap perang harga dari pesaing seperti DeepSeek. Sementara itu, proyek GPT-4.5 yang berbiaya tinggi telah dihentikan. (Sumber: 压力给到梁文锋、

)

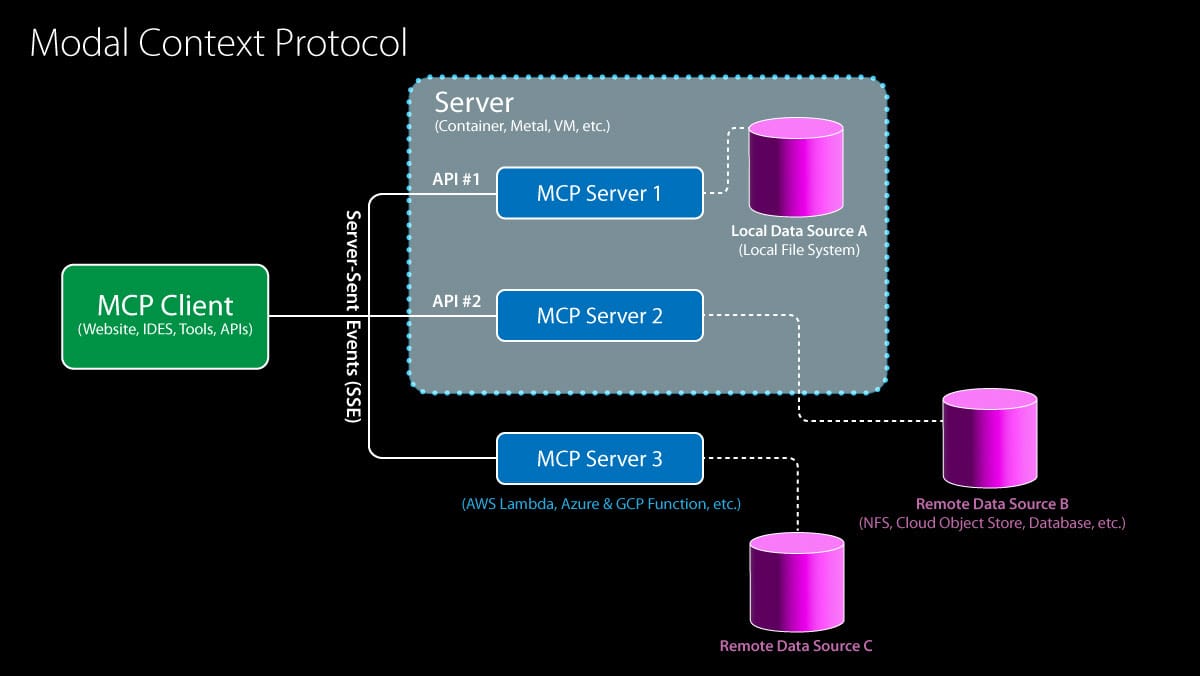

Model Context Protocol (MCP) Mendapat Dukungan OpenAI, Ekosistem Mempercepat Integrasi: OpenAI mengumumkan akan mendukung Model Context Protocol (MCP) dalam Agents SDK, aplikasi desktop ChatGPT, dan Responses API-nya. MCP diprakarsai oleh Anthropic akhir tahun lalu, bertujuan untuk menyediakan standar terbuka bagi model AI untuk terhubung ke alat dan sumber data. Melalui MCP, model dapat mengakses ekosistem sumber daya yang berkembang, termasuk lebih dari 6000 server dan konektor yang dibangun komunitas (seperti pencarian web, operasi sistem file). Sebelumnya, Microsoft telah mengintegrasikan MCP ke dalam CoPilot Studio, Cloudflare mendukung penerapan server MCP jarak jauh, dan editor kode Cursor juga telah mendukungnya. Bergabungnya OpenAI akan sangat mendorong MCP menjadi standar de facto untuk membangun aplikasi AI Agent, menyederhanakan proses bagi pengembang untuk mengintegrasikan berbagai alat dan sumber data pihak ketiga. (Sumber: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

ByteDance Merilis Kling 2.0, Meningkatkan Efek Generasi Video: Kling 2.0 adalah model generasi video terbaru yang diluncurkan oleh ByteDance. Berdasarkan umpan balik pengguna dan demo, Kling 2.0 menunjukkan kinerja luar biasa dalam menghasilkan adegan video yang halus dan realistis, sebuah peningkatan dibandingkan versi sebelumnya serta pesaing seperti Sora, terutama dalam konversi gambar ke video. Pengguna dapat terlebih dahulu menggunakan alat seperti ChatGPT untuk menghasilkan gambar dengan text fidelity yang baik, kemudian menggunakan Kling 2.0 untuk mengubahnya menjadi video dinamis. Ini menunjukkan bahwa teknologi generasi video terus maju dalam hal koherensi adegan dan realisme. (Sumber:

)

Google Merilis DolphinGemma, Menjelajahi Misteri Komunikasi Lumba-lumba: Google AI merilis proyek DolphinGemma, yang bertujuan menggunakan teknologi AI untuk mendekode cara komunikasi lumba-lumba. Proyek ini telah mengumpulkan dataset suara lumba-lumba yang sangat besar dan melatih model 400 juta parameter (dapat berjalan di ponsel Pixel 9) untuk menganalisis suara-suara ini, mencari pola dan aturan yang mungkin menunjukkan bahasa. Penelitian saat ini masih dalam tahap eksplorasi, belum pasti apakah lumba-lumba memiliki bahasa kompleks seperti manusia, tetapi telah mengidentifikasi jenis suara yang terkait dengan perilaku tertentu (seperti penamaan, perkelahian, perkawinan). Tujuan akhirnya adalah memahami struktur suara lumba-lumba dan makna potensialnya, serta mencoba melakukan komunikasi dua arah sederhana dengan lumba-lumba melalui generasi suara tertentu. (Sumber:

)

IBM Merilis Seri Model Granite 3.3, Termasuk Pengenalan Suara: IBM meluncurkan seri model Granite 3.3, yang mencakup model pengenalan suara 8 miliar parameter (Granite Speech 3.3). Model ini menggunakan pendekatan dua tahap, bertujuan untuk memproses suara tanpa mengurangi kemampuan LLM inti. Keluarga model baru ini bertujuan untuk memberikan kemampuan reasoning yang lebih halus dan kinerja RAG (Retrieval-Augmented Generation) yang ditingkatkan, serta mendukung fine-tuning LoRA. Model-model ini dapat diintegrasikan ke dalam asisten AI di berbagai bidang. (Sumber: Reddit r/LocalLLaMA)

AI Mendorong Revolusi Prakiraan Cuaca, Efisiensi Prediksi Meningkat Pesat: Kecerdasan buatan secara diam-diam mengubah bidang prakiraan cuaca. Tugas prediksi yang secara tradisional membutuhkan tim ahli yang besar dan superkomputer kini dapat dicapai melalui model AI di laptop. AI mampu memproses dan menganalisis data meteorologi dalam jumlah besar, mengidentifikasi pola kompleks, sehingga menghasilkan prakiraan cuaca yang lebih cepat dan mungkin lebih akurat. Ini menandai aplikasi penting AI dalam komputasi ilmiah dan bidang prediksi, yang diharapkan dapat meningkatkan ketepatan waktu dan cakupan prakiraan. (Sumber: Reddit r/ArtificialInteligence)

Google Gemini App Menambahkan Dukungan LaTeX: Google Gemini App diperbarui dengan menambahkan dukungan untuk LaTeX. Pengguna sekarang dapat menggunakan sintaks LaTeX di Gemini App untuk menampilkan rumus matematika, simbol ilmiah, dll. Pembaruan ini mencakup model Gemini 2.0 Flash dan 2.5 Pro, meningkatkan kegunaan Gemini dalam skenario komunikasi akademik dan teknis. (Sumber: JeffDean)

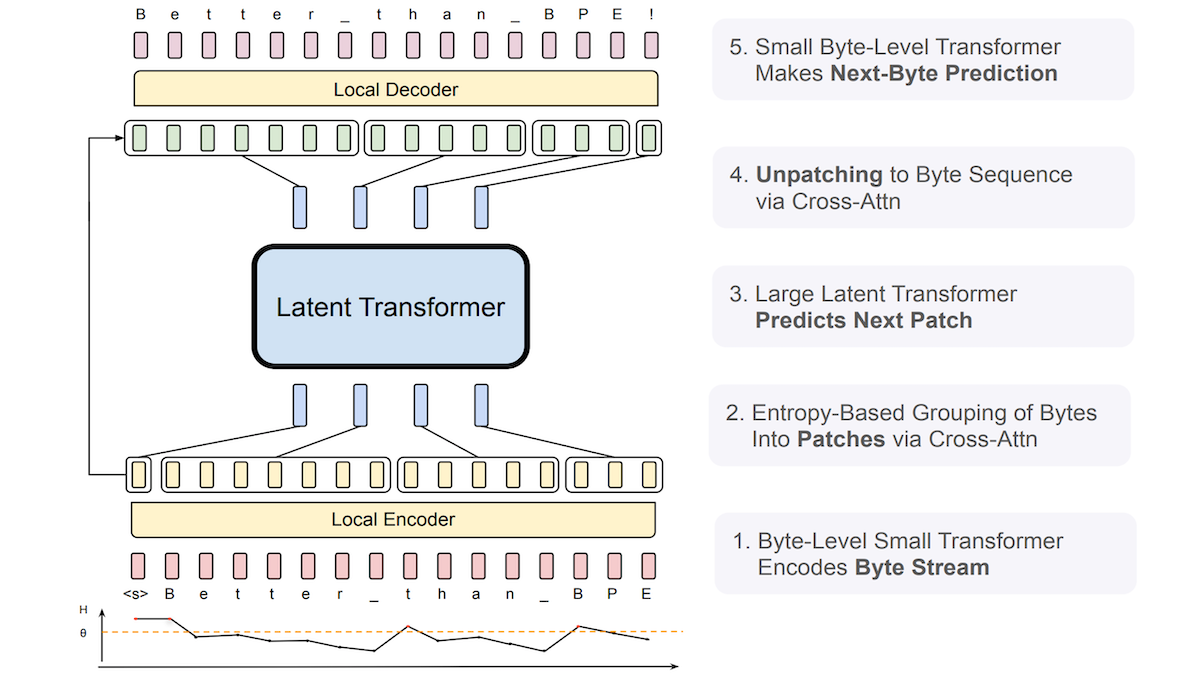

Meta Mengusulkan Byte Latent Transformer (BLT), Meningkatkan Robustness LLM terhadap Input Bising: Peneliti dari Meta dan institusi lain meluncurkan Byte Latent Transformer (BLT), yang bertujuan untuk menggantikan tokenizer tradisional. BLT secara langsung memproses urutan byte (karakter), menggunakan Transformer tingkat byte kecil untuk memprediksi probabilitas byte berikutnya, dan memanfaatkan entropi untuk mengelompokkan byte secara dinamis: entropi rendah (prediktabilitas tinggi) ditambahkan ke grup saat ini, entropi tinggi (prediktabilitas rendah) memulai grup baru. Sistem ini mencakup encoder, latent Transformer, dan decoder, dengan total 8 miliar parameter. Eksperimen menunjukkan bahwa BLT sedikit lebih unggul dari Llama 3 dengan ukuran yang sama pada benchmark bahasa umum dan pengkodean, dan menunjukkan robustness yang jauh lebih kuat terhadap input bising seperti kesalahan ejaan dan bahasa langka, karena dapat lebih memahami kesamaan tingkat karakter. (Sumber: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

Penelitian Baru Menjelajahi Penskalaan Waktu Uji Kolaborasi Penalaran Multi-Agen: Sebuah makalah berjudul “Two Heads are Better Than One: Test-time Scaling of Multi-agent Collaborative Reasoning” telah diserahkan ke arXiv. Penelitian ini berfokus pada bagaimana meningkatkan kinerja tugas penalaran kompleks dengan membuat beberapa agen AI berkolaborasi pada saat pengujian (inferensi), mengeksplorasi jalur penskalaan yang meningkatkan kemampuan model tanpa menambah biaya pelatihan. (Sumber: Reddit r/MachineLearning)

Tata Kelola Agen AI Menjadi Fokus Baru: Seiring meningkatnya kemampuan AI Agent (Agentic AI), cara mengelolanya secara efektif menjadi isu penting. Ini melibatkan memastikan perilaku agen sesuai harapan, aman dan terkendali, serta mematuhi norma etika. Diperlukan kerangka kerja, standar, dan mekanisme regulasi untuk mengelola “pikiran sintetis” yang dapat bertindak dan mengambil keputusan secara mandiri ini. (Sumber: Ronald_vanLoon)

AI Menghasilkan Gambar Berkualitas Tinggi Lebih Cepat dari Metode SOTA Saat Ini: Peneliti di Massachusetts Institute of Technology (MIT) telah mengembangkan alat kecerdasan buatan baru yang mampu melampaui metode state-of-the-art (SOTA) saat ini dalam menghasilkan gambar berkualitas tinggi, dan dengan kecepatan yang lebih tinggi. Ini menunjukkan bahwa di bidang generasi gambar, efisiensi dan kualitas terus mencapai terobosan. (Sumber: Ronald_vanLoon)

xAI Memperkenalkan Fitur Mirip Canvas untuk Grok AI: xAI menambahkan fitur yang mirip dengan ChatGPT Canvas ke chatbot Grok AI-nya. Fitur jenis Canvas biasanya menyediakan antarmuka kanvas tak terbatas, memungkinkan pengguna untuk mengatur dan berinteraksi dengan informasi secara lebih bebas dan visual, menggabungkan teks, kode, gambar, dll. Langkah ini membuat Grok mengejar ChatGPT dalam pengalaman interaksi pengguna, dan fitur ini disediakan secara gratis. (Sumber: Reddit r/ArtificialInteligence)

🧰 Alat

Anx Reader: Pembaca E-book Lintas Platform Terintegrasi dengan Multi-Mesin AI: Anx Reader adalah pembaca e-book yang mendukung berbagai format seperti EPUB, MOBI, AZW3, FB2, TXT, dan dapat digunakan di iOS/macOS/Windows/Android. Fitur khasnya adalah integrasi dengan berbagai kemampuan AI seperti OpenAI, Claude, Gemini, DeepSeek, yang dapat digunakan untuk ringkasan konten, tanya jawab, mendapatkan informasi cepat, dll. Aplikasi ini mendukung sinkronisasi progres baca, file buku, dan catatan melalui WebDAV, menawarkan gaya membaca yang sangat dapat disesuaikan (jarak baris, font, skema warna, dll.), dan mencakup fungsi seperti pembacaan TTS, terjemahan, pencarian, pencatatan ide. Bertujuan untuk memberikan pengalaman membaca yang cerdas, fokus, dan personal. (Sumber: Anxcye/anx-reader – GitHub Trending (all/daily))

OpenAI Merilis Open Source Codex CLI: Agen AI Pemrograman Ringan yang Berjalan Lokal: Seiring dengan peluncuran o3/o4-mini, OpenAI merilis open source Codex CLI, sebuah agen AI pemrograman yang dapat dijalankan di terminal. Ini memungkinkan pengembang menggunakan instruksi bahasa alami untuk membuat AI secara langsung mengeksekusi tugas pengkodean di komputer lokal, seperti menulis kode, menginstal dependensi, mengkonfigurasi lingkungan, memperbaiki bug, dll. Codex CLI bertujuan untuk memanfaatkan sepenuhnya kemampuan reasoning yang kuat dari model seperti o3/o4-mini, dan dapat menggabungkan input multimodal (seperti tangkapan layar) dengan hak akses kode lokal. Alat ini bertujuan untuk menyederhanakan alur kerja pengembangan, terutama ramah bagi pemula. OpenAI juga meluncurkan program pendanaan $1 juta untuk mendukung proyek berbasis alat ini. (Sumber: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表、sama、karminski3、dotey、sama、dotey)

Model Cohere Hadir di Hugging Face Hub, Menyediakan Layanan Inferensi: Cohere mengumumkan bahwa modelnya menjadi penyedia inferensi pihak ketiga pertama yang didukung di Hugging Face Hub. Pengguna sekarang dapat langsung mengakses model open source Cohere (seperti seri Aya) dan model enterprise (seperti seri Command) di Hub, dan melakukan inferensi cepat. Model-model ini sangat mahir dalam penggunaan alat dan kemampuan multibahasa, serta menyediakan antarmuka kompatibilitas OpenAI, memudahkan pengembang untuk mengintegrasikan dan membangun aplikasi. (Sumber: huggingface、huggingface、huggingface)

LocalAI v2.28.0 Dirilis, dan Meluncurkan Platform Agen AI Lokal LocalAGI: LocalAI, sebagai server untuk menjalankan LLM secara lokal dan menyediakan API yang kompatibel dengan OpenAI, diperbarui ke v2.28.0. Pada saat yang sama, platform LocalAGI yang baru diluncurkan. LocalAGI adalah platform orkestrasi agen AI self-hosted dengan WebUI, memungkinkan pengguna membangun alur kerja agen AI multi-langkah yang kompleks (mirip dengan AutoGPT). Kuncinya adalah, agen-agen ini dapat didorong oleh LLM lokal yang disediakan melalui LocalAI atau API kompatibel lainnya (seperti llama-cpp-python). Dikombinasikan dengan repositori memori lokal LocalRecall, pengguna dapat menjalankan agen AI otonom di lingkungan yang sepenuhnya lokal, melakukan tugas seperti penelitian, pengkodean, pemrosesan konten, dll. (Sumber: Reddit r/LocalLLaMA)

Framework Droidrun Open Source: Mengontrol Ponsel Android dengan AI: Droidrun adalah framework yang memungkinkan pengguna menggunakan AI (seperti model bahasa besar) untuk mengontrol ponsel Android dalam menjalankan tugas, kini telah open source di GitHub. Pengguna dapat menggunakan instruksi bahasa alami untuk membuat AI menyelesaikan operasi di ponsel, seperti membuka aplikasi, mengklik tombol, memasukkan teks, dll. Ini memerlukan instalasi alat ADB (Android Debug Bridge). Framework ini menunjukkan kemungkinan baru AI dalam otomatisasi dan interaksi perangkat seluler. (Sumber: karminski3)

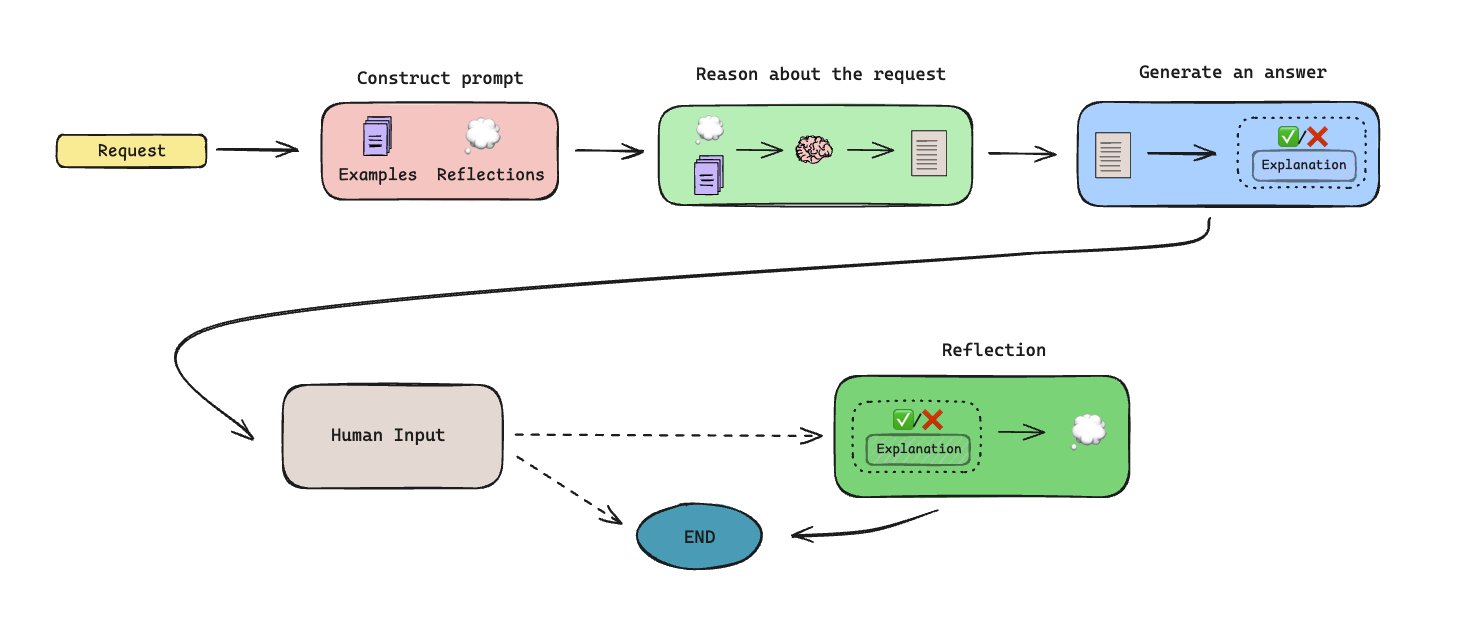

LLManager Dirilis: Alur Kerja Persetujuan Otomatis Berbasis Memori: LLManager adalah alur kerja open source yang dibangun menggunakan LangGraph, dirancang untuk mengotomatiskan tugas persetujuan melalui agen AI yang memiliki kemampuan memori. Sistem ini mampu menghasilkan memori melalui kolaborasi manusia-dalam-lingkaran (human-in-the-loop), sehingga belajar dan meningkatkan keputusan persetujuan seiring waktu. Desain arsitekturnya memungkinkannya menangani proses persetujuan berulang, meningkatkan efisiensi. (Sumber: LangChainAI)

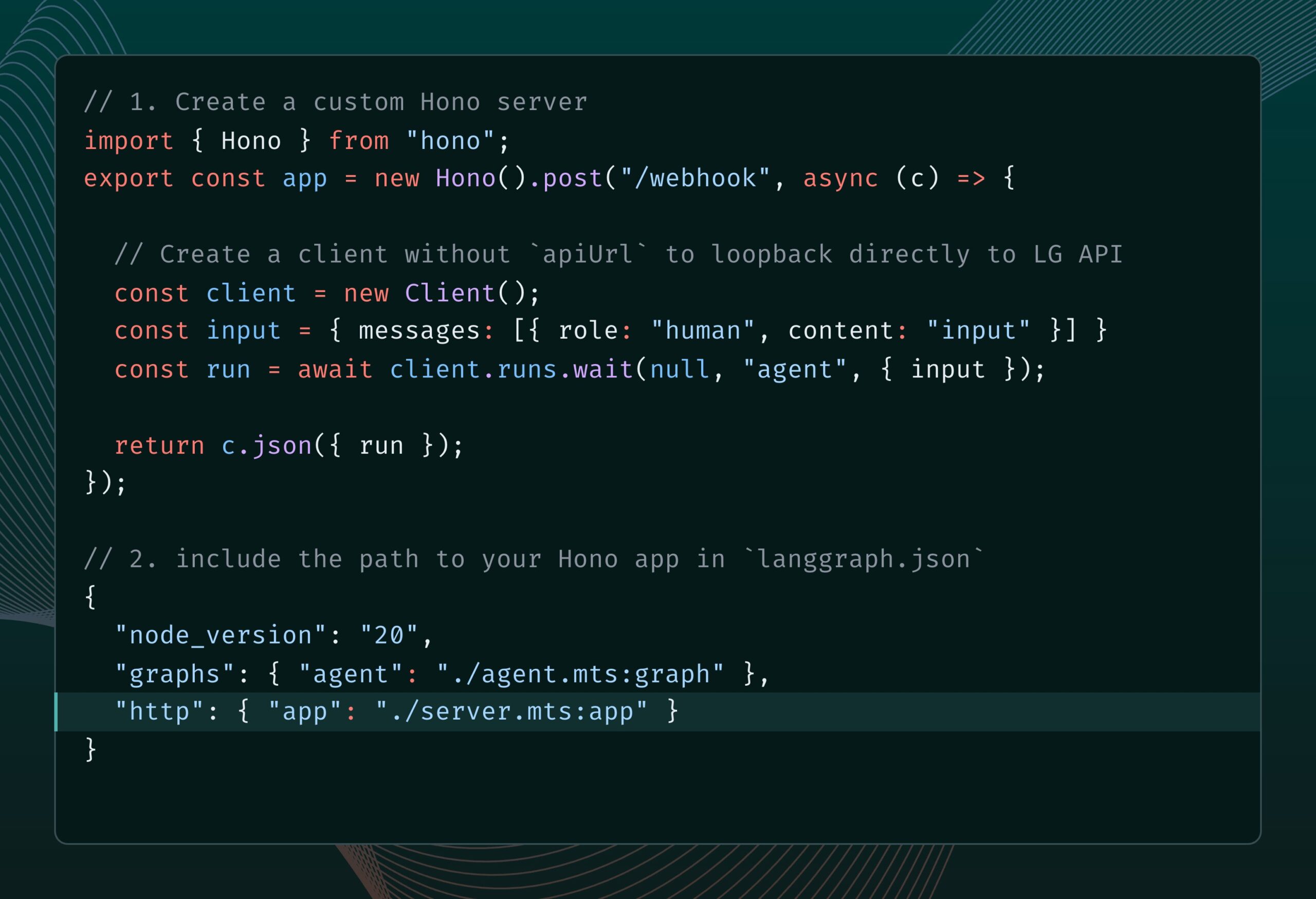

LangGraph.js Terintegrasi dengan Hono, Mendukung Rute HTTP Kustom dan Middleware: LangGraph.js (versi JS dari pustaka LangChain untuk membangun aplikasi multi-agen stateful) sekarang dapat diintegrasikan dengan Hono (sebuah framework web ringan). Ini memungkinkan pengembang untuk menambahkan rute HTTP kustom dan middleware ke aplikasi LangGraph.js mereka, sehingga membangun layanan backend yang lebih kompleks, seperti menangani webhook, membuat aplikasi API lengkap, dll., memperluas skenario aplikasi LangGraph.js. (Sumber: LangChainAI)

Robot Humanoid Open Source Reachy 2 Mulai Dijual: Co-founder Hugging Face Clem Delangue mengumumkan bahwa robot humanoid open source pertama yang diikuti timnya, Reachy 2, mulai dijual minggu ini. Robot ini dijual seharga $70.000, ditujukan untuk pasar penelitian dan pendidikan, dan telah digunakan di Cornell University, Carnegie Mellon University, serta laboratorium AI utama. Robot ini memiliki bentuk mirip manusia, basis bergerak omnidirectional, sensor yang kaya (kamera, mikrofon, LiDAR, dll.), berbasis ROS 2 dan LeRobotHF, mendukung Python SDK, dan desain modularnya memungkinkan kustomisasi. (Sumber: huggingface)

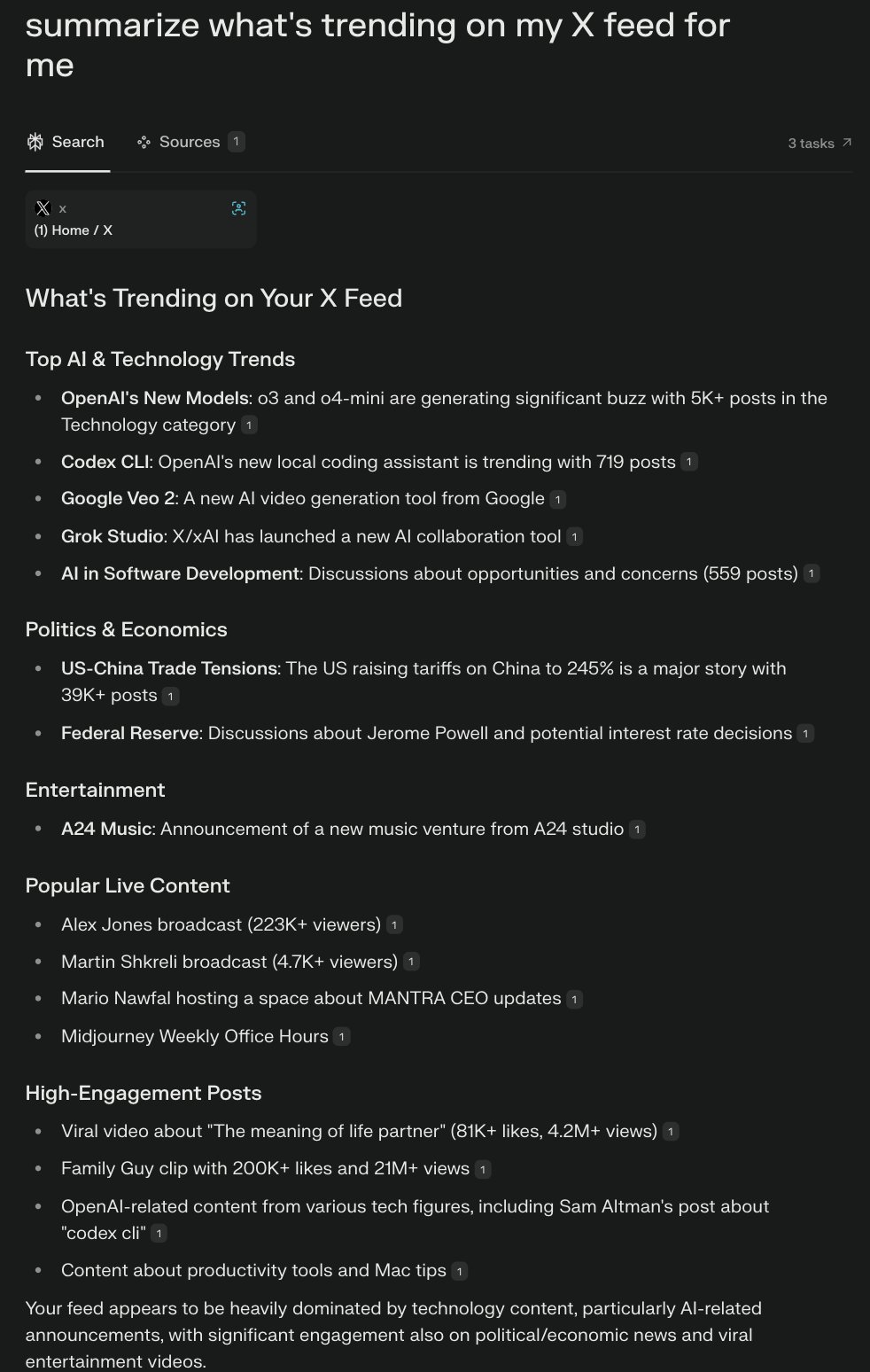

Perplexity Meluncurkan Browser Comet, Menjelajahi Pengalaman Browsing AI-Native: CEO Perplexity Arav Srinivas sedang mengembangkan browser bernama Comet dan meminta ide untuk pertumbuhan produk dan fitur. Comet bertujuan menjadi perwujudan “sistem operasi agentik” (agentic OS), mengontrol aplikasi web dan data melalui browser, memanfaatkan AI untuk menjawab pertanyaan dan menjalankan tugas. Idenya adalah, karena sebagian besar aplikasi ada di Web, AI yang mengontrol browser dapat mengontrol sebagian besar kehidupan digital. Proyek ini menekankan untuk memulai dari yang kecil, menghindari janji berlebihan tentang kemampuan umum. (Sumber: AravSrinivas、AravSrinivas、AravSrinivas、AravSrinivas、AravSrinivas)

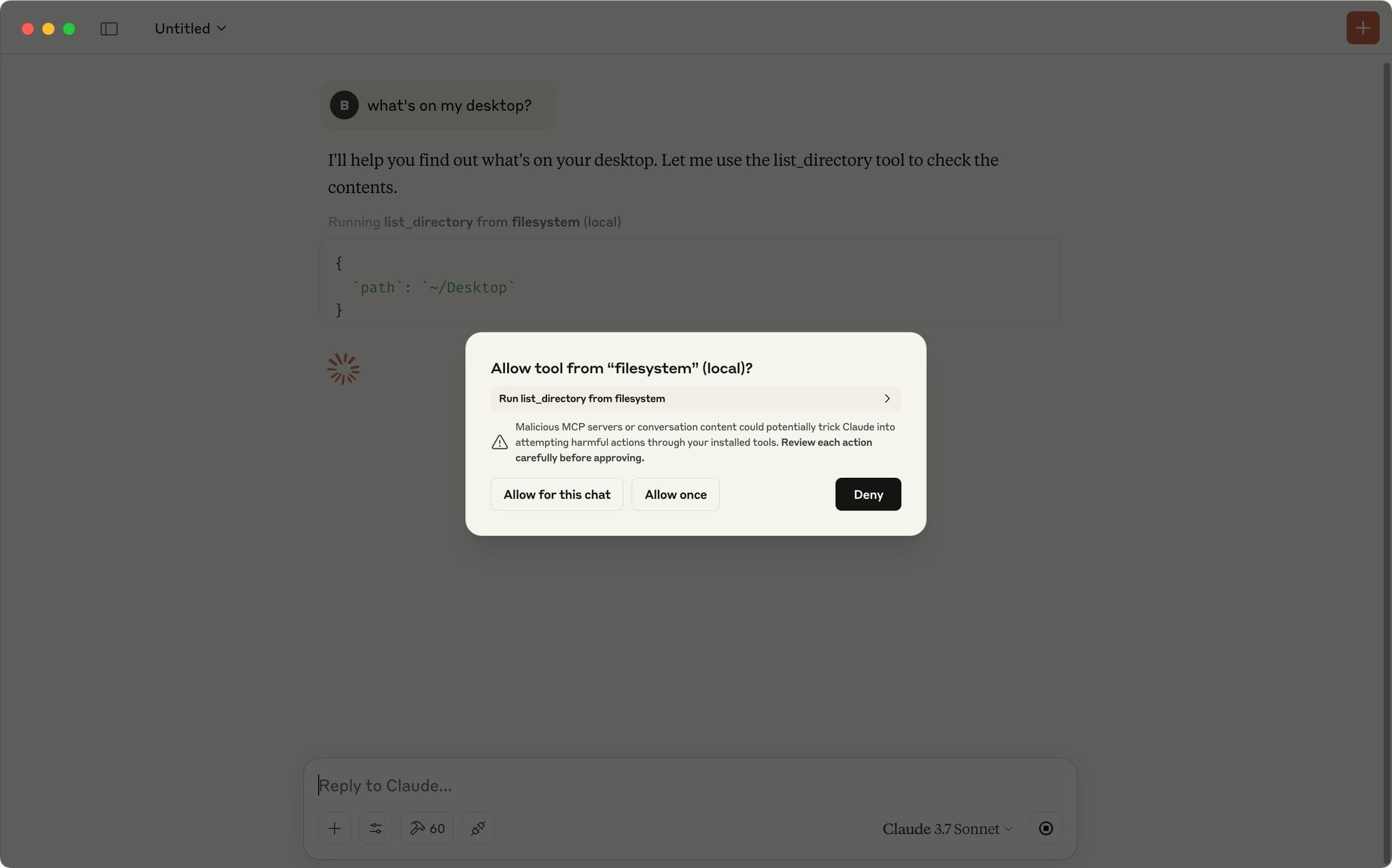

Claude App Mendukung Skrip Persetujuan Otomatis Permintaan MCP: Pengguna komunitas berbagi skrip JavaScript yang berjalan di konsol alat pengembang Claude App, yang dapat secara otomatis menyetujui permintaan MCP (Model Context Protocol) dari daftar alat tepercaya yang telah ditentukan sebelumnya. Ini dapat menghemat kerumitan mengklik “Izinkan” setiap kali bagi pengguna yang sering menggunakan alat lokal atau jarak jauh tertentu, meningkatkan efisiensi alur kerja. Namun, pengguna perlu memperhatikan risiko keamanan, hanya aktifkan untuk alat yang sepenuhnya tepercaya. (Sumber: Reddit r/ClaudeAI)

Rekomendasi Server MCP Wajib Punya, Membantu Otomatisasi Pengkodean & Alur Kerja: Pengguna komunitas berbagi serangkaian server MCP (Model Context Protocol) yang direkomendasikan, alat-alat ini dapat diintegrasikan dengan model AI yang mendukung MCP (seperti Claude) atau framework Agent, meningkatkan efisiensi pengkodean dan kemampuan otomatisasi. Daftar rekomendasi meliputi: Sequential Thinking MCP untuk pemikiran terstruktur, Puppeteer MCP untuk interaksi web, Memory Bank MCP untuk manajemen pengetahuan proyek, Playwright MCP untuk pengujian lintas browser, GitHub MCP untuk operasi GitHub, Knowledge Graph Memory MCP untuk memori persisten, DuckDuckGo MCP untuk pencarian tanpa kunci API, dan MCP Compass untuk menemukan lebih banyak alat MCP. (Sumber: Reddit r/ClaudeAI)

📚 Pembelajaran

Repositori GitHub: Panduan Komprehensif Teknik RAG Tingkat Lanjut: Repositori GitHub RAG_Techniques yang dibuat oleh Nir Diamant menyediakan koleksi tutorial teknik Retrieval-Augmented Generation (RAG) tingkat lanjut terlengkap saat ini. Repositori ini bertujuan untuk meningkatkan akurasi, efisiensi, dan kekayaan kontekstual sistem RAG, mencakup mulai dari implementasi dasar (LangChain/LlamaIndex), optimasi pemecahan teks (ukuran tetap, pemecahan proposisi, pemecahan semantik), peningkatan kueri (transformasi, HyDE, HyPE), pengayaan konteks (header blok, ekstraksi segmen relevan, perluasan jendela, peningkatan dokumen), hingga pengambilan tingkat lanjut (fusi, penyusunan ulang, pemfilteran multi-aspek, pengindeksan hierarkis, integrasi, multimodal), teknik iteratif (loop umpan balik, adaptif, pengambilan iteratif), evaluasi (DeepEval, GroUSE), interpretabilitas, serta arsitektur canggih (Graph RAG, RAPTOR, Self-RAG, CRAG) dan lebih dari 30 teknik lainnya, serta menyediakan implementasi Jupyter Notebook atau skrip Python. Proyek ini didorong oleh komunitas dan mendorong kontribusi. (Sumber: NirDiamant/RAG_Techniques – GitHub Trending (all/daily))

DeepLearning.AI Meluncurkan Kursus Baru: Membangun Agen Browser AI: Andrew Ng mengumumkan kerjasama dengan AGI Inc. untuk meluncurkan kursus singkat baru “Building AI Browser Agents”. Kursus ini diajarkan oleh co-founder AGI Inc. Div Garg dan Naman Garg, bertujuan untuk mengajarkan cara membangun agen AI yang dapat berinteraksi dengan situs web dan melakukan tugas (seperti mengambil informasi, mengisi formulir, mengklik, memesan). Materi kursus mencakup cara kerja Web Agent, arsitektur, batasan, strategi pengambilan keputusan, praktik membangun Web Agent untuk mengambil kursus DeepLearning.AI dan output terstruktur, membangun Agent otonom untuk menyelesaikan multi-tugas (mencari ringkasan halaman web, mengisi formulir, berlangganan), menjelajahi framework AgentQ (menggabungkan Monte Carlo Tree Search MCTS dan Direct Preference Optimization DPO untuk mencapai koreksi mandiri), mendalami prinsip MCTS, serta membahas status dan masa depan AI Agent. (Sumber: AndrewYNg)

Hugging Face Memperbarui Dokumentasi Kuantisasi, Menyediakan Panduan Konsep & Benchmark Pemilihan: Hugging Face secara signifikan memperbarui dokumentasinya tentang kuantisasi model. Dokumentasi baru ini bertujuan membantu pengguna memahami konsep kuantisasi dengan lebih baik dan memilih teknik yang sesuai berdasarkan kebutuhan. Konten yang diperbarui meliputi: penjelasan dasar kuantisasi (seperti skema, int4, FP8), panduan pemilihan baru (membantu memilih antara teknik seperti bnb, AWQ, GPTQ, HQQ berdasarkan kebutuhan dan perangkat keras), serta data benchmark akurasi dan kinerja untuk metode kuantisasi populer pada model Llama 3.1 8B dan 70B. Ini memberikan referensi berharga bagi pengembang yang ingin mengompres model dan meningkatkan efisiensi inferensi. (Sumber: huggingface)

Metode Baru MODE: Alternatif RAG Ringan dan Dapat Dijelaskan: Peneliti independen Rahul Anand mengusulkan metode baru bernama MODE (Mixture of Document Experts) sebagai alternatif ringan untuk alur kerja RAG tradisional. MODE tidak bergantung pada database vektor dan penyusun ulang (re-ranker), melainkan mengekstrak informasi dengan mengelompokkan dokumen dan menggunakan metode pengambilan berbasis centroid. Metode ini diklaim efisien dan memiliki interpretabilitas yang kuat, terutama cocok untuk dataset berukuran kecil hingga menengah. Penulis sedang mencari dukungan dari arXiv (bidang cs.AI) untuk menerbitkan makalah. (Sumber: Reddit r/MachineLearning)

Repositori GitHub Beyond-NanoGPT: Sumber Daya Tingkat Lanjut dari Pemula LLM ke Peneliti AI: Tanishq Kumar merilis open source repositori GitHub bernama beyond-nanoGPT. Proyek ini bertujuan membantu pembelajar yang telah menguasai dasar-dasar LLM tingkat nanoGPT untuk lebih memahami dan mengimplementasikan ide-ide kompleks yang mendekati garis depan penelitian deep learning. Repositori ini berisi ribuan baris kode PyTorch beranotasi, mengimplementasikan dari awal berbagai kemajuan penelitian ML modern termasuk speculative decoding, visual/diffusion Transformer, linear/sparse attention, dll. Tujuan proyek ini adalah membantu lebih banyak orang bertransisi ke bidang penelitian AI. (Sumber: Reddit r/MachineLearning)

Tutorial: Melatih Chatbot Berbasis Repositori GitHub Menggunakan AI Scraper dan LLM: Sebuah artikel yang diterbitkan di blog Stackademic menjelaskan cara menggunakan AI Scraper (alat pengikis web) dan model bahasa besar (LLM) untuk melatih chatbot yang mampu menjawab pertanyaan tentang repositori GitHub tertentu. Metode ini biasanya melibatkan pengambilan kode, dokumentasi (seperti README), Isu, dll. dari repositori, memprosesnya menjadi format yang sesuai untuk dipahami LLM, kemudian melalui RAG (Retrieval-Augmented Generation) atau fine-tuning agar chatbot dapat melakukan tanya jawab berdasarkan informasi ini. (Sumber: Reddit r/ArtificialInteligence)

Interpretasi Makalah: Menggunakan Layer-Wise Relevance Propagation (LRP) untuk Explainable AI (XAI) pada Data Tabular: Sebuah posting blog membahas cara menggunakan teknik Layer-Wise Relevance Propagation (LRP) untuk menjelaskan proses pengambilan keputusan model deep learning saat memproses data tabular. LRP adalah metode atribusi yang bertujuan untuk menguraikan prediksi output model ke fitur input, sehingga mengungkapkan fitur mana yang paling berkontribusi pada keputusan akhir. Menerapkannya pada data tabular membantu memahami perilaku model, meningkatkan transparansi dan kepercayaan. (Sumber: Reddit r/deeplearning)

💼 Bisnis

Zhipu AI Memulai Bimbingan Pra-IPO, Berencana Selesai Tahun Ini: Perusahaan AI Tiongkok Zhipu AI telah secara resmi memulai pengajuan bimbingan pra-IPO, dengan CICC bertindak sebagai lembaga pembimbing. Menurut laporan pengajuan, Zhipu AI berencana menyelesaikan bimbingan IPO antara Agustus hingga Oktober 2025. Sebelumnya, CEO perusahaan Zhang Peng menyatakan bahwa jalan menuju AGI masih panjang, dana yang terkumpul hanyalah “bekal perjalanan”, dan lebih banyak dana akan dibutuhkan di masa depan. IPO ini dianggap sebagai langkah kunci untuk mendapatkan “lebih banyak bekal”. Zhipu AI adalah pemain penting di bidang model besar domestik Tiongkok, dan proses IPO-nya sangat dinantikan. (Sumber: 压力给到梁文锋)

Startup 2 Orang Gumloop Menggalang Dana Lebih dari 100 Juta Yuan dengan AI: Platform no-code Gumloop, yang hanya memiliki dua pendiri sebagai karyawan tetap, baru-baru ini menyelesaikan putaran pendanaan Seri A senilai $17 juta (sekitar 124 juta RMB). Perusahaan ini berawal dari penyediaan UI yang mudah digunakan untuk Auto-GPT, kemudian berkembang menjadi platform pembangunan alur kerja AI AgentHub untuk non-teknisi, yang dapat mengintegrasikan alat seperti GitHub, Gmail, dll., mengotomatiskan pemrosesan dokumen, web scraping, SEO, CRM, pemasaran email, dll. Gumloop sendiri banyak menggunakan AI Agent untuk menangani bisnis perusahaan, target pendiri adalah membangun perusahaan bernilai $1 miliar dengan tim kurang dari 10 orang. Ini mencerminkan kemungkinan tim kecil di era AI memanfaatkan alat AI untuk mencapai efisiensi dan nilai tinggi, serta peluang wirausaha dalam mengatasi masalah “mil terakhir” penerapan aplikasi AI. (Sumber: 把AI当成“牛马”,2人创业团队,拿下了超1亿元融资)

Rumor: OpenAI Berencana Mengakuisisi Perusahaan Alat Pemrograman AI Windsurf (sebelumnya Codeium) senilai $3 Miliar: Menurut sumber yang dikutip Bloomberg, OpenAI sedang dalam pembicaraan untuk mengakuisisi perusahaan alat pemrograman berbantuan AI Windsurf (sebelumnya Codeium) dengan nilai sekitar $3 miliar. Jika transaksi tercapai, ini akan menjadi akuisisi terbesar dalam sejarah OpenAI, bertujuan untuk memperkuat daya saingnya di pasar asisten pemrograman AI, bersaing langsung dengan Anthropic, GitHub Copilot, Anysphere (Cursor), dll. Windsurf didirikan pada tahun 2021, sebelumnya telah dinilai $1,25 miliar, dan telah menerima pendanaan lebih dari $200 juta. Rumor akuisisi ini juga menandakan kemungkinan konsolidasi yang meningkat di bidang alat pemrograman AI. (Sumber: dotey)

Perusahaan Safe Superintelligence Milik Ilya Sutskever Dilaporkan Bernilai $32 Miliar: Menurut TechCrunch, perusahaan baru Safe Superintelligence (SSI) yang didirikan oleh co-founder OpenAI Ilya Sutskever, dinilai $32 miliar dalam putaran pendanaan terbaru. Perusahaan ini dilaporkan telah memperoleh investasi $2 miliar. Tujuan SSI adalah membangun superintelligence dengan aman, valuasinya yang tinggi mencerminkan ekspektasi pasar yang tinggi terhadap talenta AI terkemuka dan visi AGI, meskipun perusahaan tersebut saat ini belum merilis produk apa pun. (Sumber:

)

Perang Dagang AS-Tiongkok Dapat Mempengaruhi Perkembangan AI, Pasokan Chip Menjadi Fokus: Ada analisis yang berpendapat bahwa perang dagang AS terhadap Tiongkok, terutama pembatasan ekspor chip AI kelas atas (seperti seri NVIDIA H100/B200), serta potensi balasan Tiongkok dengan membatasi ekspor mineral tanah jarang, menjadi tantangan bagi perkembangan AI global. Laporan menunjukkan bahwa perusahaan AI (seperti OpenAI) telah merasakan keterbatasan pasokan GPU. Sementara itu, Tiongkok membuat kemajuan dalam pembuatan chip (seperti terobosan teknologi 3nm, 1nm), dan mungkin dapat memproduksi chip AI berkualitas tinggi dalam beberapa tahun ke depan. Artikel berpendapat bahwa pembatasan perdagangan saat ini dapat memperlambat kecepatan pengembangan AI AS, bahkan memungkinkan Tiongkok menyalip di bidang AI, menyerukan promosi pengembangan AI melalui perdagangan bebas. (Sumber: Reddit r/ArtificialInteligence)

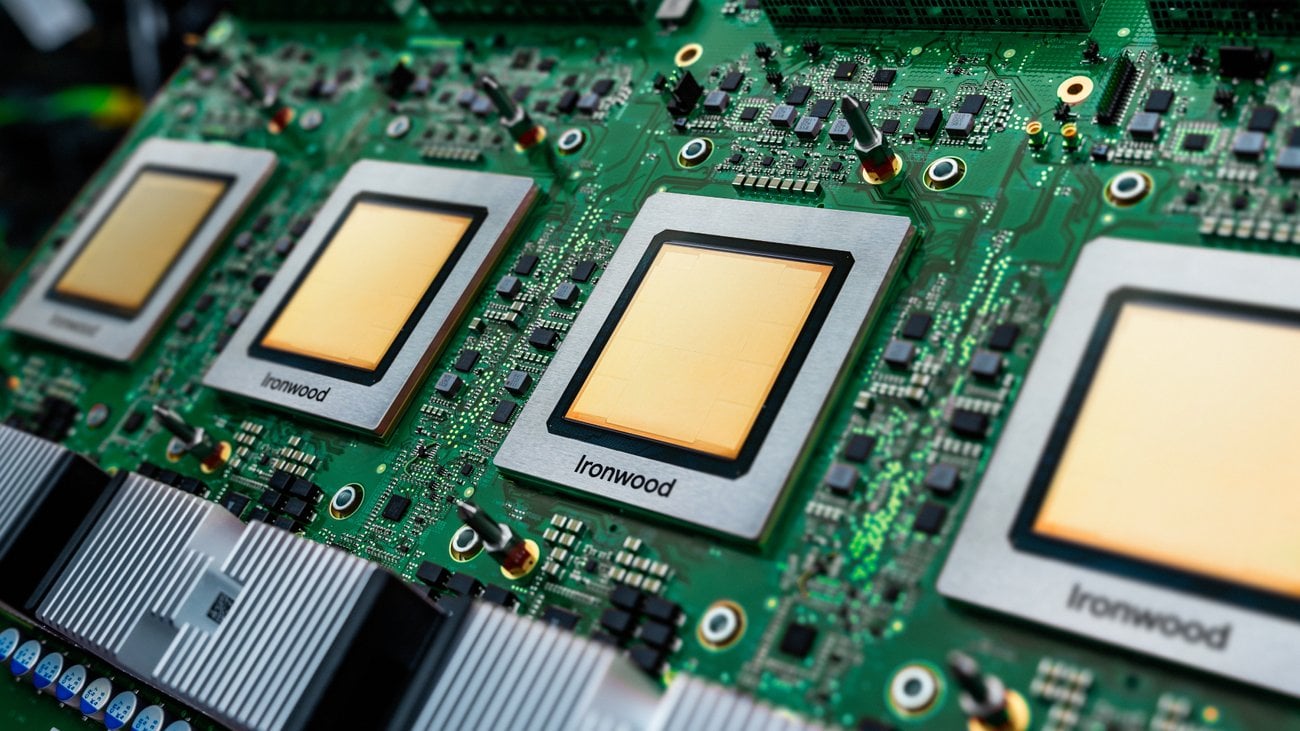

Membahas Aplikasi Praktis TPU di Lingkungan Produksi: Google baru-baru ini merilis generasi baru TPU (Tensor Processing Unit) yang dioptimalkan untuk inferensi. Namun, diskusi komunitas menunjukkan bahwa meskipun TPU telah ada selama bertahun-tahun dan Google menyediakan program sumber daya peneliti yang murah hati (TRC), dalam lingkungan produksi industri, aplikasi TPU tampaknya tidak seluas GPU NVIDIA. Alasannya mungkin termasuk kompleksitas pengaturan, keunggulan kinerja yang tidak signifikan, kurangnya fitur terkait platform GCP (seperti IP tetap, alat observabilitas), kesulitan debugging (XLA), dan kekhawatiran vendor lock-in karena hanya dapat disewa melalui GCP. Diskusi menyerukan pengguna dengan pengalaman produksi aktual untuk berbagi penggunaan dan tantangan TPU. (Sumber: Reddit r/MachineLearning)

AI Menimbulkan Kesenjangan Kepercayaan di Industri Asuransi: Laporan penelitian Swiss Re menunjukkan bahwa penerapan AI generatif di industri asuransi menghadapi tantangan kepercayaan. Meskipun potensi AI sangat besar, ada kekhawatiran tentang privasi data, keamanan siber, dan transparansi pengambilan keputusan, yang dapat menyebabkan kesenjangan kepercayaan antara perusahaan asuransi dan pelanggan. Laporan membahas cara memanfaatkan keunggulan AI sambil mengatasi risiko dan masalah etika terkait, untuk membangun dan memelihara kepercayaan pengguna. (Sumber: Ronald_vanLoon)

🌟 Komunitas

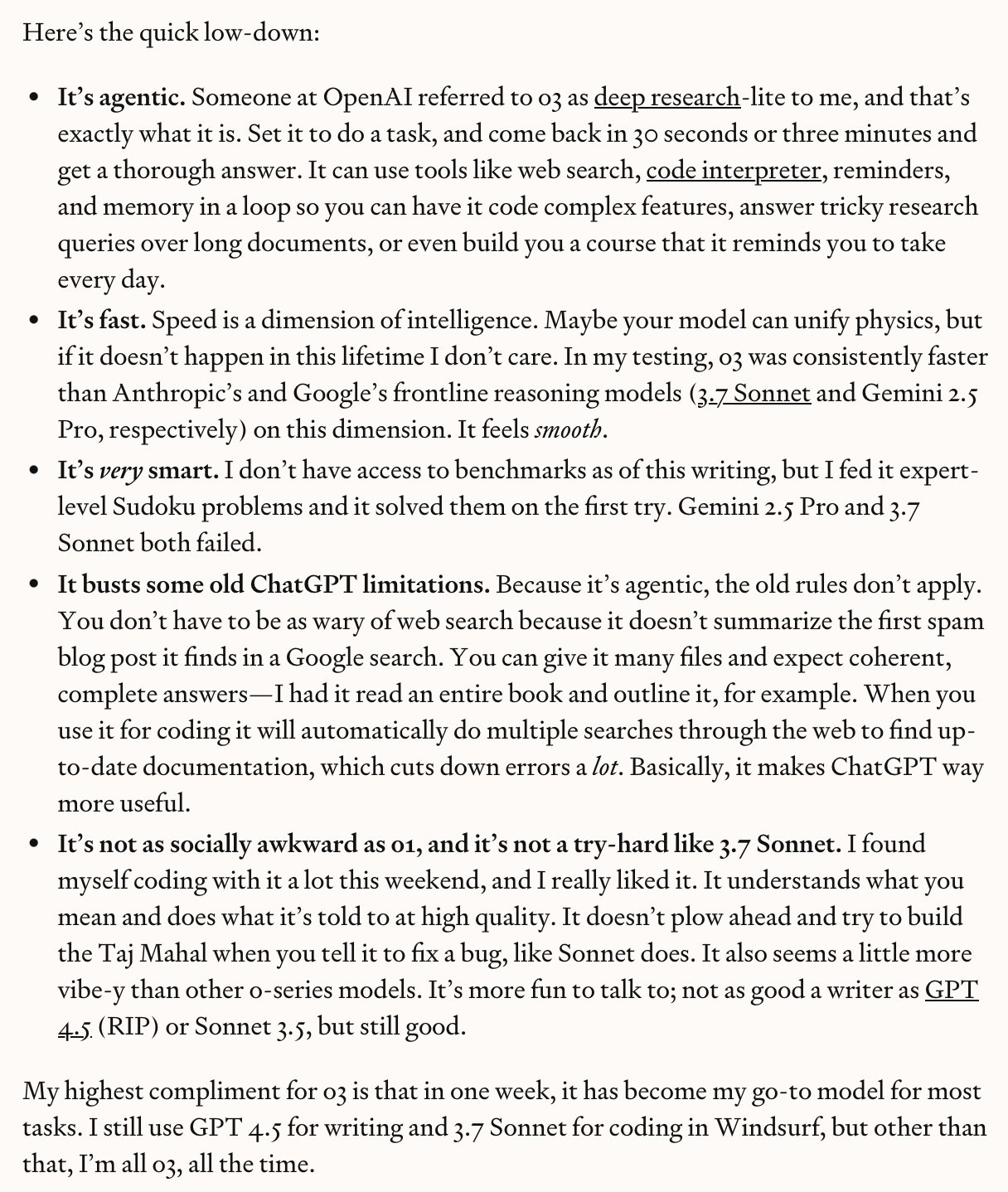

OpenAI o3/o4-mini Memicu Diskusi Hangat, Kekuatan dan Hype Berdampingan: Setelah OpenAI merilis o3 dan o4-mini, respons komunitas sangat antusias. Penguji awal (seperti Dan Shipper) memuji kecepatan, kecerdasan, dan kemampuan agent-nya, menjadikannya model pilihan utama, mampu menyelesaikan benchmark kode, kustomisasi kursus personal, pengenalan gambar buram, analisis penulisan, dll. Sam Altman me-retweet dan menekankan levelnya yang “mendekati atau mencapai jenius”. Namun, ada juga komentar (seperti video AI Explained) yang menunjukkan bahwa meskipun modelnya kuat, klaim seperti “AGI”, “bebas halusinasi” terlalu dibesar-besarkan, model masih memiliki kesalahan dalam penalaran akal sehat dan fisika tertentu, dan rasio harga-kinerja mungkin tidak sebaik Gemini 2.5 Pro. Komunitas secara umum mengakui kemajuannya, terutama dalam pengkodean dan penggunaan alat, tetapi tetap kritis terhadap kemampuan dan keterbatasan sebenarnya. (Sumber:

、

、sama、sama、karminski3、gdb、natolambert)

Diskusi Komunitas: Apakah AI Terutama Bergantung pada Kemajuan Komputasi untuk Mencapai AGI?: Pengguna Reddit memulai diskusi, membahas apakah pencapaian AGI (Artificial General Intelligence) terutama bermuara pada peningkatan kekuatan komputasi mentah. Pandangan berpendapat bahwa bahkan dengan keterbatasan LLM saat ini, peningkatan kekuatan komputasi satu tingkat besaran lagi dapat membawa utilitas yang mendekati AGI, meskipun bukan AGI “sejati”. Kuncinya adalah apakah masalah AGI pada dasarnya “dapat ditangani” (tractable), jika ya, maka komputasi brute force mungkin cukup. Tetapi ada juga komentar yang membantah, berpendapat bahwa hanya mengandalkan komputasi tidak dapat mengatasi batasan mendasar LLM, AGI membutuhkan lebih banyak terobosan paradigma. (Sumber: Reddit r/ArtificialInteligence)

Diskusi Komunitas: Industri Mana yang Akan Paling Cepat Terdisrupsi oleh AI?: Pengguna Reddit memulai diskusi, menebak industri mana yang akan paling pertama terkena dampak AI dan “runtuh”. Industri yang dinominasikan meliputi: terjemahan/penulisan naskah, dukungan pelanggan, pengajaran bahasa, manajemen portofolio investasi, ilustrasi/fotografi komersial. Bagian komentar menambahkan transportasi, desain (antarmuka, merek, logo), PR/pemasaran/manajemen media sosial, pengajaran (terutama bimbingan pribadi), blog/podcast (cara pembuatan konten berubah), manajemen organisasi acara, dll. Ada juga komentar yang menunjukkan bahwa tidak semua bidang akan sepenuhnya hilang, misalnya terjemahan yang sangat terspesialisasi atau ilustrasi yang membutuhkan inti kreativitas manusia masih memiliki ruang untuk bertahan. (Sumber: Reddit r/ArtificialInteligence)

Pengalaman Pengguna: Debugging Kode yang Dihasilkan AI Penuh Tantangan: Seorang pengembang berbagi pengalaman debugging kode yang dihasilkan oleh LLM (migrasi dari SAS ke SQL/Python). Meskipun kode AI terlihat “layak”, namun sebenarnya penuh dengan kesalahan: memanggil fungsi yang tidak terdefinisi, mencampuradukkan logika kode yang mirip tetapi tidak sama, melewatkan SQL yang formatnya buruk tetapi benar, mengganti nilai kunci secara acak, dan hasil generasi yang tidak konsisten setelah dijalankan berkali-kali. Kesimpulan akhirnya adalah kode tersebut sama sekali tidak dapat digunakan, perlu ditulis ulang, dan memperbaiki lebih berisiko daripada menulis ulang. Ini menyoroti keterbatasan kemampuan generasi kode AI saat ini, menekankan perlunya tinjauan dan validasi manual. (Sumber: Reddit r/ArtificialInteligence)

AI dan Hubungan Industrial: Bagaimana Seharusnya Serikat Pekerja Merespons?: Diskusi menunjukkan bahwa seiring meningkatnya kemampuan otomatisasi AI di berbagai industri, serikat pekerja perlu lebih aktif menanggapi potensi dampaknya terhadap pekerja. Artikel mengutip insiden pemogokan dan protes masa lalu yang melibatkan AI, seperti sekolah menyarankan penggunaan AI setelah mahasiswa pascasarjana mogok, penggunaan AI untuk memantau protes mahasiswa, kekhawatiran tentang layanan kesehatan mental otomatis, guru mungkin mogok karena penerapan AI di sekolah, dll. Pandangan berpendapat bahwa pekerja (dan organisasi perwakilan mereka) tidak boleh menunggu, perlu secara proaktif merumuskan strategi untuk menghadapi perubahan yang dibawa oleh AI. (Sumber: Reddit r/artificial)

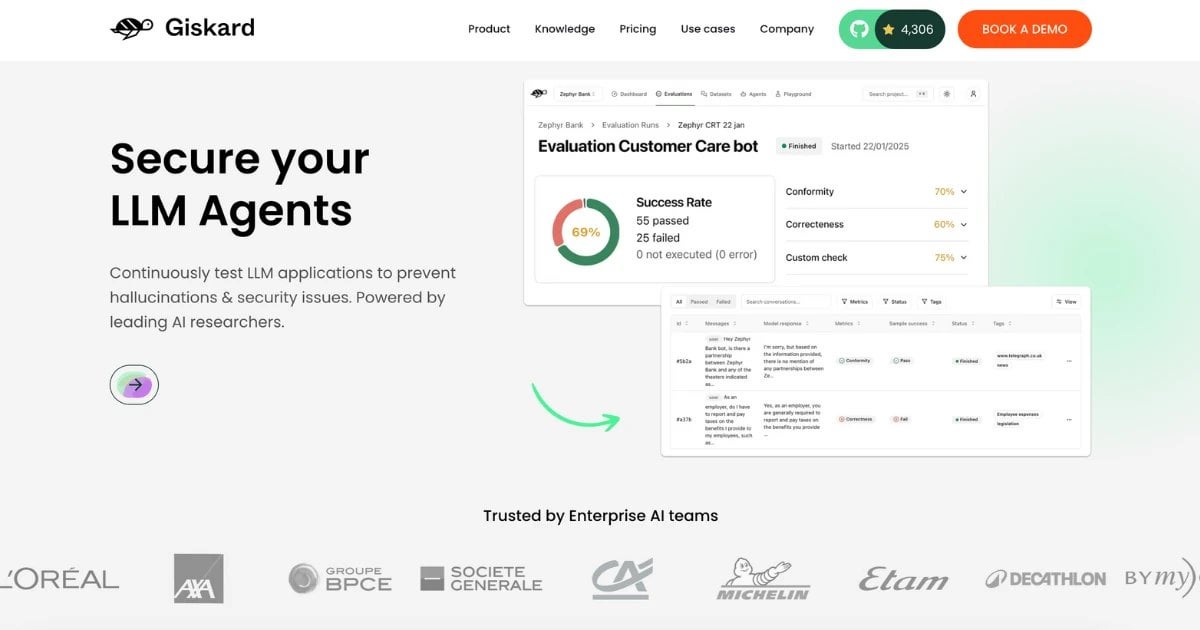

Dataset RealHarm Dirilis: Mengumpulkan Kasus Kegagalan AI Agent di Dunia Nyata: Tim Giskard merilis dataset RealHarm, yang mencatat kasus nyata yang dilaporkan secara publik melibatkan masalah AI Agent (terutama berbasis LLM) dalam aplikasi praktis. Dengan menganalisis kasus-kasus ini, tim menemukan bahwa kerusakan reputasi adalah kerugian organisasi yang paling umum, misinformasi dan halusinasi adalah jenis risiko yang paling umum, dan pagar pembatas yang ada gagal mencegah banyak insiden secara efektif. Dataset ini bertujuan membantu peneliti dan pengembang lebih memahami dan mencegah risiko AI di dunia nyata. (Sumber: Reddit r/LocalLLaMA)

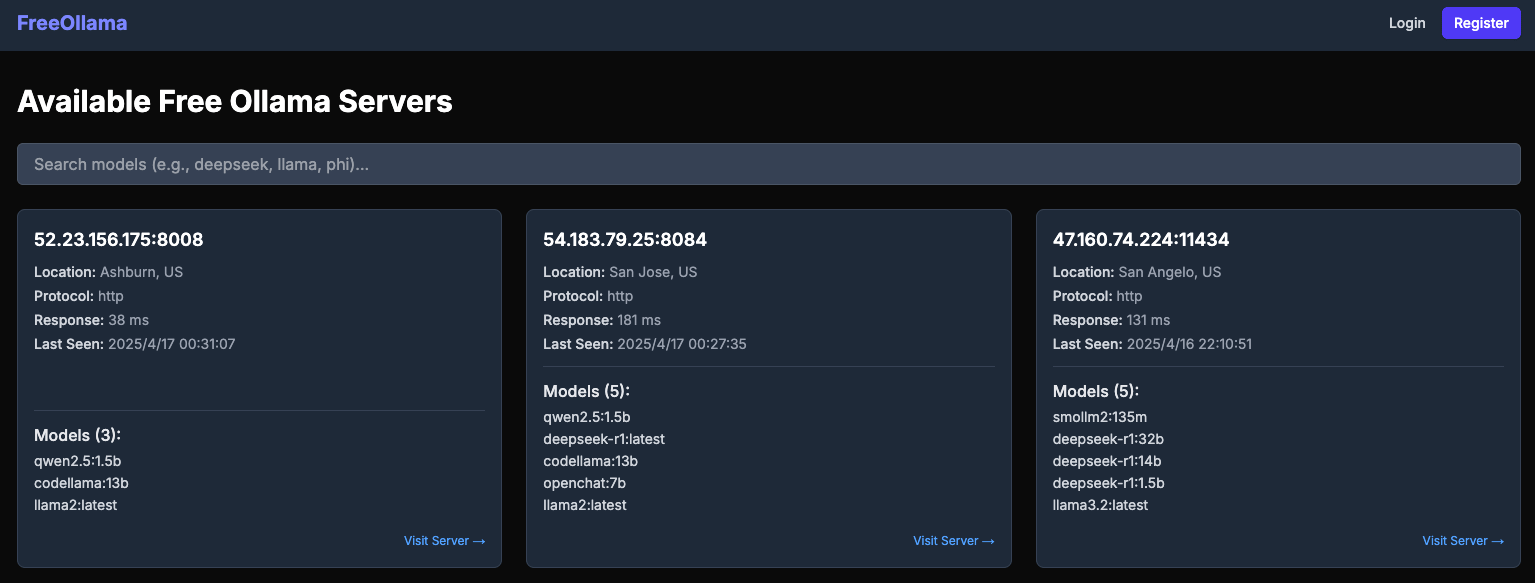

Laporan Mengungkap Risiko Keamanan Server Ollama Publik: Situs web freeollama.com menampilkan sejumlah besar instance server Ollama yang terekspos ke internet publik. Ini menunjukkan bahwa banyak pengguna saat menerapkan layanan LLM lokal gagal mengkonfigurasi langkah-langkah keamanan dengan benar (seperti mengatur alamat listen ke 0.0.0.0 tetapi tanpa menambahkan otentikasi), menyebabkan model dan data potensial mereka berisiko diakses dan dimanfaatkan tanpa izin. Mengingatkan pengguna untuk memperhatikan konfigurasi keamanan jaringan saat menerapkan layanan AI lokal. (Sumber: Reddit r/LocalLLaMA)

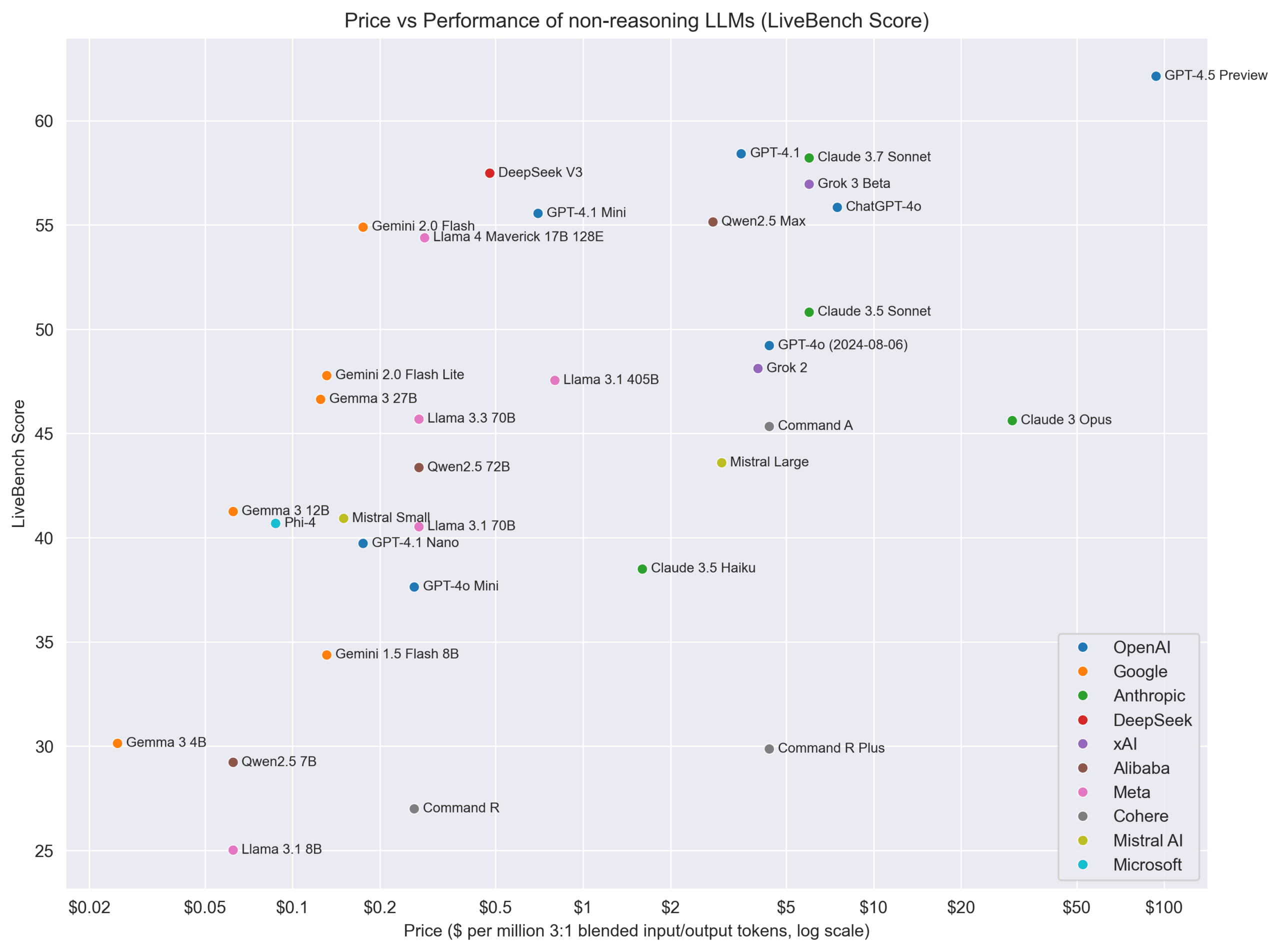

Pandangan: Model Reasoning dan Non-Reasoning Seharusnya Tidak Dipisahkan Secara Absolut: Peneliti AI Nathan Lambert berpendapat bahwa model tidak boleh diklasifikasikan secara ketat menjadi kategori “reasoning” dan “non-reasoning”, melainkan semua model harus dievaluasi di semua domain. “Model reasoning” biasanya juga berkinerja baik pada benchmark non-reasoning, tetapi tidak sebaliknya. Ini menyiratkan bahwa model dengan kemampuan reasoning mungkin lebih umum. Pada saat yang sama, ia menunjukkan perlunya model penetapan harga yang lebih baik untuk mencerminkan kemampuan dan biaya yang berbeda. (Sumber: natolambert)

Co-founder DeepMind Demis Hassabis Masuk TIME100, Menekankan Kerjasama Keamanan AI: CEO Google DeepMind Demis Hassabis terpilih dalam daftar 100 Orang Paling Berpengaruh Tahun 2025 versi majalah Time. Dalam wawancaranya, ia menekankan harapan agar negara dan perusahaan yang bersaing dapat mengesampingkan perbedaan dan bekerja sama dalam keamanan AI, karena memastikan AI berkembang ke arah yang baik adalah demi kepentingan semua orang. (Sumber: demishassabis)

Eksekutif Google DeepMind: Reinforcement Learning Perlu Melampaui Pengetahuan Manusia: Wakil Presiden Reinforcement Learning Google DeepMind David Silver berpendapat bahwa penelitian AI harus melampaui pengetahuan manusia yang diketahui, menuju sistem yang mampu belajar mandiri bahkan menemukan pengetahuan ilmiah baru. Ini menekankan potensi reinforcement learning dalam mendorong eksplorasi dan penemuan otonom AI. (Sumber: GoogleDeepMind)

Pandangan: Hambatan Pengembangan AI Telah Bergeser dari Komputasi ke Data dan Evaluasi: Dalam video yang menganalisis kemajuan model seperti Kling 2.0, GPT-4.1, o3, pembawa acara saluran AI Explained mengutip pandangan eksekutif OpenAI yang menunjukkan bahwa faktor pembatas pengembangan AI saat ini lebih banyak bergeser dari komputasi ke data, terutama data berkualitas tinggi, spesifik domain, dan metode evaluasi yang efektif (Evals). Peningkatan kinerja model semakin bergantung pada penemuan data yang lebih baik serta cara yang lebih baik untuk mengukur kemajuan. (Sumber:

)

Grafik Perbandingan Harga vs Kinerja Model Non-Reasoning: Komunitas Reddit berbagi grafik yang membandingkan harga (diperkirakan biaya API) dari berbagai LLM non-reasoning dengan skor kinerjanya di LiveBench (platform benchmark real-time). Grafik tersebut secara visual menunjukkan rasio harga-kinerja masing-masing model pada benchmark tertentu, misalnya menunjukkan bahwa seri Gemma/Gemini menonjol dalam hal rasio harga-kinerja. (Sumber: Reddit r/LocalLLaMA)

💡 Lain-lain

Kemajuan Baru Antarmuka Otak-Komputer: Mengubah Gelombang Otak Langsung Menjadi Ucapan: Penelitian baru menunjukkan implan antarmuka otak-komputer (BCI) yang mampu mendekode gelombang otak orang lumpuh secara real-time dan mensintesisnya menjadi ucapan alami. Teknologi ini memberikan kemungkinan komunikasi baru bagi orang yang kehilangan kemampuan berbahasa karena cedera saraf atau penyakit, merupakan terobosan besar di persimpangan AI dalam teknologi bantu dan ilmu saraf. (Sumber: Ronald_vanLoon、Ronald_vanLoon)

Eksplorasi Game AI Pendiri miHoYo Cai Haoyu: Perusahaan AI Anuttacon yang didirikan oleh mantan CEO miHoYo Cai Haoyu merilis trailer dan demo game AI eksperimental “Whispers From The Star”. Game ini berpusat pada dialog real-time yang didorong AI, pemain berinteraksi dengan karakter AI Stella melalui teks, suara, atau video untuk membimbing kelangsungan hidupnya. Game ini menggunakan teknologi AI multimodal, emosi, reaksi, dan gerakan Stella dihasilkan secara real-time oleh AI, dengan ekspresi wajah dan gerakan yang alami. Ini mencerminkan eksplorasi Cai Haoyu tentang bagaimana AIGC mengubah pengembangan game, tetapi menghadapi tantangan seperti kematangan teknologi, model bisnis, dan penerimaan pemain. Artikel ini juga membandingkan strategi berbeda dari perusahaan besar seperti Tencent dan NetEase dalam menerapkan AI dalam game. (Sumber: 原神之后,蔡浩宇的 AIGC 游戏野望)

Unitree Technology (Unitree) Meningkatkan Robot Beroda Industri B2-W: Unitree Robotics menunjukkan kemampuan yang ditingkatkan dari robot beroda kelas industrinya B2-W. Meskipun detail peningkatan spesifik tidak dirinci, robot jenis ini biasanya mengintegrasikan teknologi AI untuk navigasi, penghindaran rintangan, pelaksanaan tugas, dll. Peningkatan kali ini mungkin melibatkan otonomi yang lebih kuat, kapasitas muatan, atau aplikasi dalam skenario industri tertentu. (Sumber: Ronald_vanLoon)

Robot Mempelajari Keterampilan Manusia: Circuit Robotics menunjukkan bagaimana robot mempelajari keterampilan manusia. Ini biasanya melibatkan imitation learning, reinforcement learning, dan metode AI lainnya, memungkinkan robot menguasai tugas operasi kompleks melalui observasi demonstrasi atau coba-coba, merupakan arah penelitian penting dalam kombinasi robotika dan AI. (Sumber: Ronald_vanLoon)

Robot Belanja Menjadi Kenyataan: Video atau informasi yang dibagikan oleh Fabrizio Bustamante menunjukkan bahwa penggunaan robot untuk berbelanja sedang menjadi kenyataan. Ini mungkin merujuk pada robot penyortir otomatis di gudang, atau robot pengiriman yang menghadap konsumen, robot pemandu di dalam toko, dll., yang biasanya memerlukan AI untuk perencanaan jalur, pengenalan barang, dan interaksi manusia-mesin. (Sumber: Ronald_vanLoon)

Aplikasi AI dan Robotika dalam Pertanian: JC Niyomugabo membahas aplikasi AI dan robotika dalam pertanian (AgriTech). Ini termasuk penggunaan AI untuk pemantauan tanaman, diagnosis hama dan penyakit, keputusan irigasi dan pemupukan presisi, serta penggunaan robot untuk penanaman otomatis, penyiangan, pemetikan, dll. Bertujuan untuk meningkatkan efisiensi, hasil, dan keberlanjutan pertanian. (Sumber: Ronald_vanLoon)

Nanobot Pembawa “Senjata Tersembunyi” Dapat Membunuh Sel Kanker: Penelitian yang dibagikan oleh Khulood Almani menunjukkan bahwa nanobot yang dilengkapi dengan “senjata tersembunyi” (mekanisme spesifik tidak dirinci) mampu menargetkan dan membunuh sel kanker. Mekanisme navigasi dan penargetan nanobot sering melibatkan algoritma AI, digunakan untuk mengidentifikasi target dan melakukan tugas di lingkungan biologis yang kompleks, merupakan aplikasi mutakhir di bidang kesehatan medis. (Sumber: Ronald_vanLoon)

Pengembangan Tangan Bionik COVVI: Tangan bionik yang dikembangkan oleh perusahaan COVVI bertujuan untuk menyediakan prostesis yang lebih fleksibel dan fungsional bagi penyandang amputasi. Tangan bionik canggih semacam ini biasanya mengintegrasikan sensor dan algoritma AI untuk menafsirkan sinyal otot pengguna (seperti sinyal elektromiografi EMG) atau sinyal saraf, mencapai kontrol niat yang lebih alami dan operasi halus. (Sumber: Ronald_vanLoon)

Robot Humanoid Tiongkok Melakukan Tugas Inspeksi Kualitas: WevolverApp melaporkan bahwa robot humanoid di Tiongkok telah digunakan untuk melakukan tugas inspeksi kualitas. Ini membutuhkan robot untuk memiliki kemampuan pengenalan visual canggih (mungkin didorong oleh AI), kemampuan manipulasi yang presisi, serta kemampuan pengambilan keputusan tertentu untuk menilai apakah produk memenuhi syarat, merupakan contoh penerapan robot humanoid di bidang otomatisasi industri. (Sumber: Ronald_vanLoon)

Operasi Manusia Pertama di Dunia yang Dilakukan oleh Dokter Gigi Robot: Gigadgets melaporkan operasi manusia pertama di dunia yang sepenuhnya dilakukan oleh dokter gigi robot. Meskipun detailnya tidak jelas, ini biasanya berarti sistem robot melakukan perencanaan, penentuan posisi, dan operasi bedah dengan bantuan AI, bertujuan untuk meningkatkan presisi dan konsistensi bedah, merupakan tonggak sejarah dalam kombinasi robotika medis dan AI. (Sumber: Ronald_vanLoon)

AI Mendorong Kemajuan Digital, Membangun Negara Cerdas: Artikel Ronald van Loon bekerja sama dengan Huawei membahas bagaimana mendorong kemajuan nasional melalui teknologi digital seperti AI, Internet of Things (IoT), konektivitas, dan analisis data, membangun negara yang lebih cerdas. Menekankan peran AI dalam mengoptimalkan layanan publik, manajemen infrastruktur, pengembangan ekonomi, dll. (Sumber: Ronald_vanLoon)

Robot Velox yang Dapat Bergerak Amfibi di Air dan Darat: Robot Velox yang dibagikan oleh Pascal Bornet adalah robot amfibi yang dapat bergerak di air dan di darat. Fleksibilitas ini mungkin membuatnya cocok untuk skenario kompleks seperti pencarian dan penyelamatan, pemantauan lingkungan, dan kemampuan navigasi otonom serta adaptasi terhadap lingkungan yang berbeda mungkin didorong oleh AI. (Sumber: Ronald_vanLoon)