Mots-clés:Google TPU, GPT-5, NVIDIA, Anthropic, OpenAI, Google Earth IA, Découverte de médicaments par IA, Calcul IA, Système de calcul d’apprentissage automatique spatial, Capacités de preuve mathématique du GPT-5, Raisonnement géospatial à l’échelle planétaire, Supercalculateur DGX SuperPOD, Tendance à la baisse des prix des modèles d’IA

Voici la traduction de l’article en français, en respectant toutes vos exigences :

🔥 Focus

Les Google TPUs se dirigent vers l’espace pour explorer des systèmes de calcul ML évolutifs : Sundar Pichai a annoncé le “projet Sun Catcher”, visant à explorer la construction de systèmes de calcul de machine learning évolutifs dans l’espace, en utilisant l’énergie solaire. Des recherches préliminaires montrent que les TPUs de génération Trillium de Google n’ont pas été endommagés lors de tests de rayonnement simulés en orbite terrestre basse, mais la gestion thermique et la fiabilité des systèmes en orbite restent des défis majeurs. Google prévoit de lancer deux satellites prototypes début 2027 en collaboration avec Planet, marquant une étape clé dans l’expansion du calcul AI vers l’espace. (Source: fchollet

)

GPT-5 démontre de nouvelles capacités en preuve mathématique, Terence Tao valide la recherche assistée par l’IA : Des mathématiciens de Princeton et de l’Ohio State University ont découvert que GPT-5, assisté par Lean, a réussi à formaliser un contre-exemple au problème d’Erdős, récompensé depuis 30 ans, révélant même que le problème avait été résolu 30 ans auparavant mais ignoré. Terence Tao a qualifié cela d’exemple intéressant de preuve assistée par ordinateur et a souligné le rôle de l’IA en tant qu’assistant puissant plutôt que de mathématicien indépendant, prédisant l’entrée de la recherche mathématique dans une “ère d’industrialisation”. (Source: 36氪

)

Google Earth AI lance un agent à l’échelle planétaire, renforçant le raisonnement géospatial : Google, combinant ses décennies d’expérience en modélisation du monde et les capacités de raisonnement avancées de Gemini, a mis à niveau Earth AI, réalisant pour la première fois un raisonnement géospatial complexe à l’échelle de la Terre. Ce système peut connecter automatiquement des modèles tels que les prévisions météorologiques, les cartes de population et les images satellites pour la surveillance environnementale et la réponse aux catastrophes, par exemple en fournissant des alertes d’inondation à 2 milliards de personnes, et ouvre ses modèles centraux aux testeurs via une plateforme cloud. (Source: 36氪

)

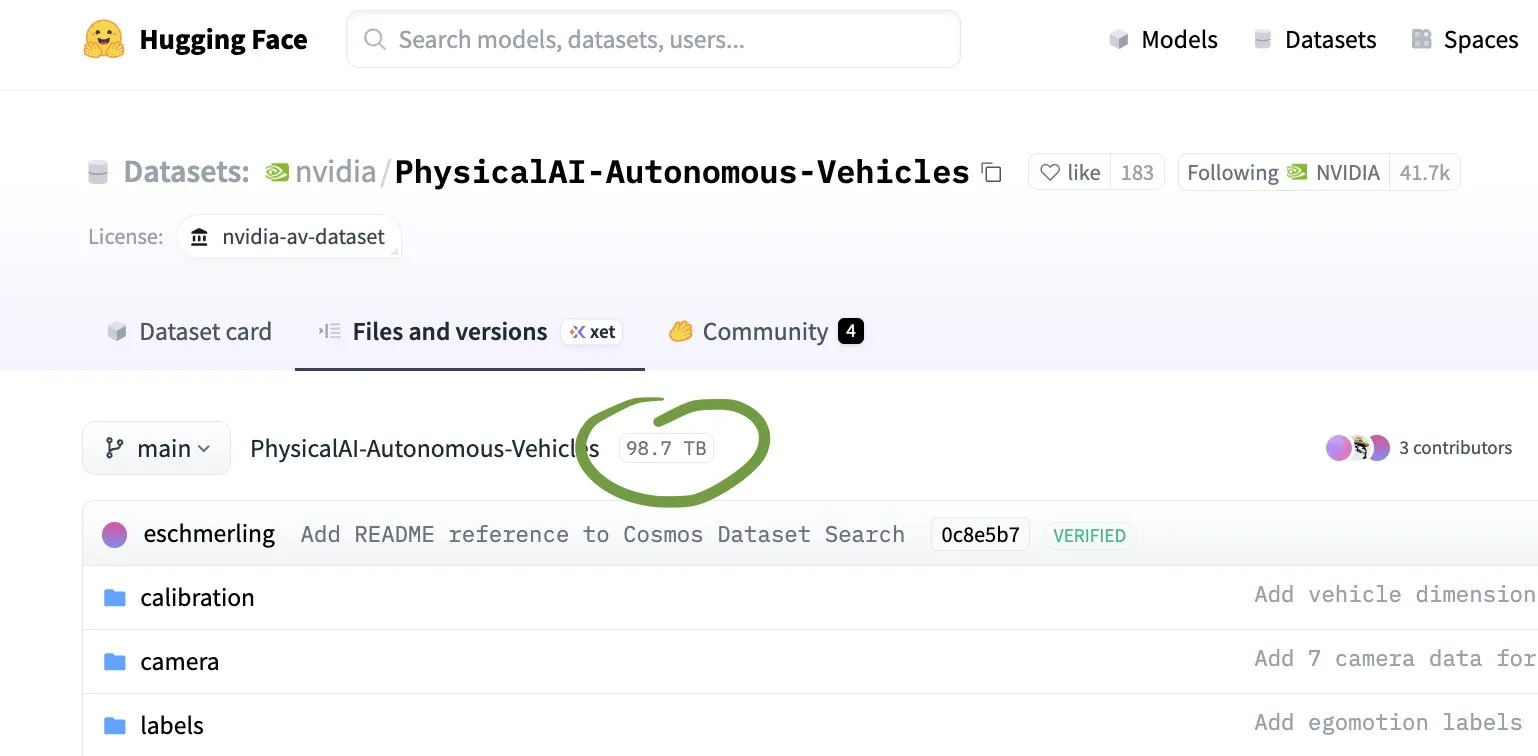

NVIDIA s’associe à Eli Lilly pour créer une usine de R&D de médicaments basée sur l’IA avec des centaines de milliards de calculs : NVIDIA et Eli Lilly ont collaboré pour déployer un supercalculateur DGX SuperPOD construit avec 1000 GPU B300, créant ainsi la première “super-usine AI” dédiée à l’industrie pharmaceutique mondiale. Cette usine sera utilisée pour la découverte et le développement de médicaments, accélérant le criblage moléculaire et améliorant le taux de succès de la synthèse, afin de relever les défis des coûts élevés, des cycles longs et des faibles taux de succès de la R&D pharmaceutique traditionnelle, marquant l’entrée de l’industrie pharmaceutique dans une course à l’armement de l’IA. (Source: 36氪

)

🎯 Tendances

Anthropic dévoile un plan de croissance agressif, prévoyant plus de 70 milliards de dollars de revenus d’ici 2028 : La société AI Anthropic a considérablement relevé ses prévisions de croissance pour les trois prochaines années, s’attendant à ce que les revenus dépassent 70 milliards de dollars d’ici 2028 et génèrent 17 milliards de dollars de flux de trésorerie, le moteur principal étant la forte demande des clients d’entreprise pour ses modèles AI. Son assistant de programmation Claude Code a déjà un revenu annualisé de près d’un milliard de dollars, et l’entreprise prévoit d’atteindre un flux de trésorerie positif dès 2027, plus rapidement qu’OpenAI. (Source: 36氪

)

OpenAI conclut un partenariat de 38 milliards de dollars avec AWS pour la puissance de calcul, les géants de la Silicon Valley s’allient et se divisent : OpenAI et Amazon AWS ont conclu un accord de partenariat stratégique en matière de cloud computing d’une valeur de 38 milliards de dollars, qui permettra un accès complet aux ressources de calcul d’AWS, y compris la dernière génération de GPU et CPU NVIDIA. Cette initiative est considérée comme une étape clé pour OpenAI dans la réalisation de son plan d’infrastructure de calcul de mille milliards, et reflète également la stratégie des géants de l’IA de rechercher des fournisseurs diversifiés dans la course à l’armement de la puissance de calcul. (Source: 36氪

)

La chute des coûts de l’IA et la restructuration de la valeur du travail humain : Le prix des modèles AI diminue à une vitesse stupéfiante, par exemple, le coût des modèles de niveau GPT-3.5 a chuté de 280 fois en un an, et les modèles les plus haut de gamme atteignent même 900 fois. Cela a conduit à la popularisation des applications AI, mais en même temps, les prix des services humains difficiles à remplacer par l’IA (tels que le ménage, les soins, les réparations) continuent d’augmenter, créant le paradoxe de la “déflation AI, inflation humaine” et remodelant la structure de la valeur du travail. (Source: 36氪

)

Applications actuelles et futures de l’IA dans le commerce électronique du “Double Onze” : En 2025, les plateformes de commerce électronique du “Double Onze” ont pleinement introduit des fonctionnalités AI, telles que AI万能搜, AI帮我挑, AI试衣, etc., visant à améliorer l’efficacité et l’expérience d’achat. Cependant, une enquête montre que les consommateurs ont une faible perception des fonctionnalités AI, et qu’il existe des problèmes tels qu’une compréhension imprécise des intentions et une complexification du processus d’achat. Les plateformes espèrent que l’IA reconfigurera la distribution du trafic, autonomisera les commerçants et explorera de nouveaux modèles d’applications AI natives indépendantes et de commerce électronique basé sur des agents intelligents. (Source: 36氪

)

Les préoccupations croissantes concernant l’impact environnemental de l’IA : Les discussions sur les réseaux sociaux soulignent que le développement rapide de l’IA entraîne une augmentation rapide de la demande de calcul, et que les nouveaux centres de données consomment d’énormes quantités d’électricité et de ressources en eau, aggravant le fardeau environnemental. Par exemple, les centres de données en Géorgie ont déjà affecté l’approvisionnement en eau local, suscitant des inquiétudes quant à la pression sur le réseau électrique et la pollution environnementale. (Source: Reddit r/ArtificialInteligence

)

Le problème de la “dépréciation” causé par les mises à jour et la maintenance des modèles AI : Anthropic a publié un engagement à conserver les poids des anciennes versions des modèles AI afin de faire face au problème de la “dépréciation” causé par les mises à jour des modèles, évitant ainsi que les utilisateurs ne perdent leurs résultats historiques en raison de l’itération des modèles. Cette initiative a suscité des discussions au sein de la communauté sur la gestion du cycle de vie des modèles AI, la responsabilité éthique et le “bien-être des modèles”. (Source: MatthewJBar

)

L’impact et la redéfinition du marché du travail par l’IA : Un phénomène de “boomerang” est apparu dans la vague de licenciements induits par l’IA, où les employés sont réembauchés par leurs anciens employeurs, suggérant des problèmes de planification dans les décisions de licenciement des entreprises. En même temps, la prise en charge des tâches quotidiennes par l’IA pousse à repenser la définition du “travail non routinier”, le travail humain pourrait se tourner vers des domaines créatifs, émotionnels, etc., difficiles à remplacer par l’IA, soulignant l’impact profond de l’IA sur le marché du travail et la redéfinition de la nature du travail. (Source: Reddit r/artificial

)

Éducation des enfants assistée par l’IA : l’Institut de recherche Tencent publie une évaluation de l’adéquation de l’IA pour les enfants laissés pour compte : L’évaluation montre que les grands modèles ont montré de bonnes performances en matière de soutien de base pour les enfants laissés pour compte, tels que la sécurité de l’information et la précision du contenu, mais présentent des lacunes évidentes dans les capacités de niveau supérieur telles que l’empathie, le soutien relationnel et l’autonomisation. L’IA a obtenu les meilleurs résultats sur les questions émotionnelles, mais manque une compréhension approfondie des situations réelles, ce qui peut conduire les enfants à une dépendance excessive aux “conseils autoritaires” de l’IA, suscitant des inquiétudes quant à l’équité éducative et au développement de l’autonomie des enfants. (Source: 36氪

)

Le rôle dominant des facteurs non techniques dans la sélection des technologies AI : Steve Francia, un leader technique senior chez Google, a souligné que 90% des décisions de sélection technologique, telles que les langages de programmation, ne sont pas liées à la technologie elle-même, mais sont influencées par des “conversations invisibles” telles que l’identité personnelle, l’appartenance émotionnelle et les étiquettes professionnelles. Il a révélé, à travers des cas personnels, que ce biais peut entraîner des entreprises à manquer des opportunités de marché et à voir leurs coûts monter en flèche, soulignant l’importance de transformer les débats techniques en considérations économiques. (Source: 36氪)

Les restrictions de l’IA sur la génération de contenu suscitent un débat sur la liberté de création : Les discussions sur les réseaux sociaux soulignent que les grandes entreprises AI limitent généralement la génération de contenu pornographique, violent, sanglant, protégé par le droit d’auteur ou identifiant des personnes réelles. Cette tendance a suscité des inquiétudes quant à la liberté de création, certains estimant que la société considère tous les ordinateurs comme des “ordinateurs d’école”, limitant le potentiel de l’IA en matière d’art et d’expression. (Source: brickroad7)

🧰 Outils

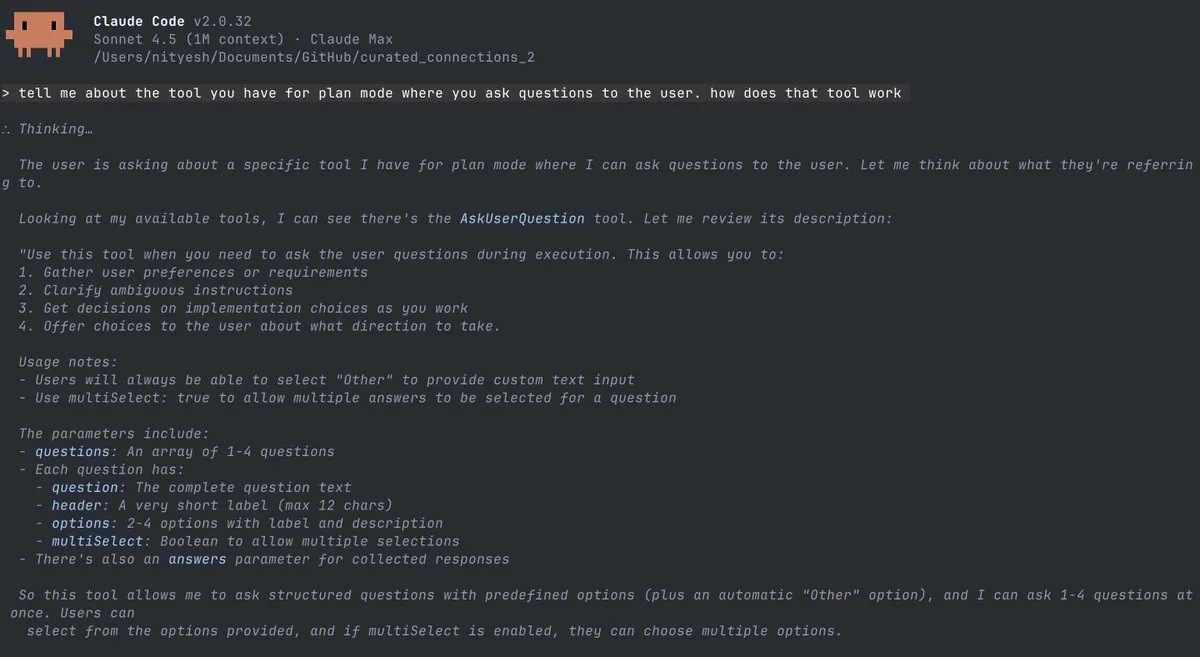

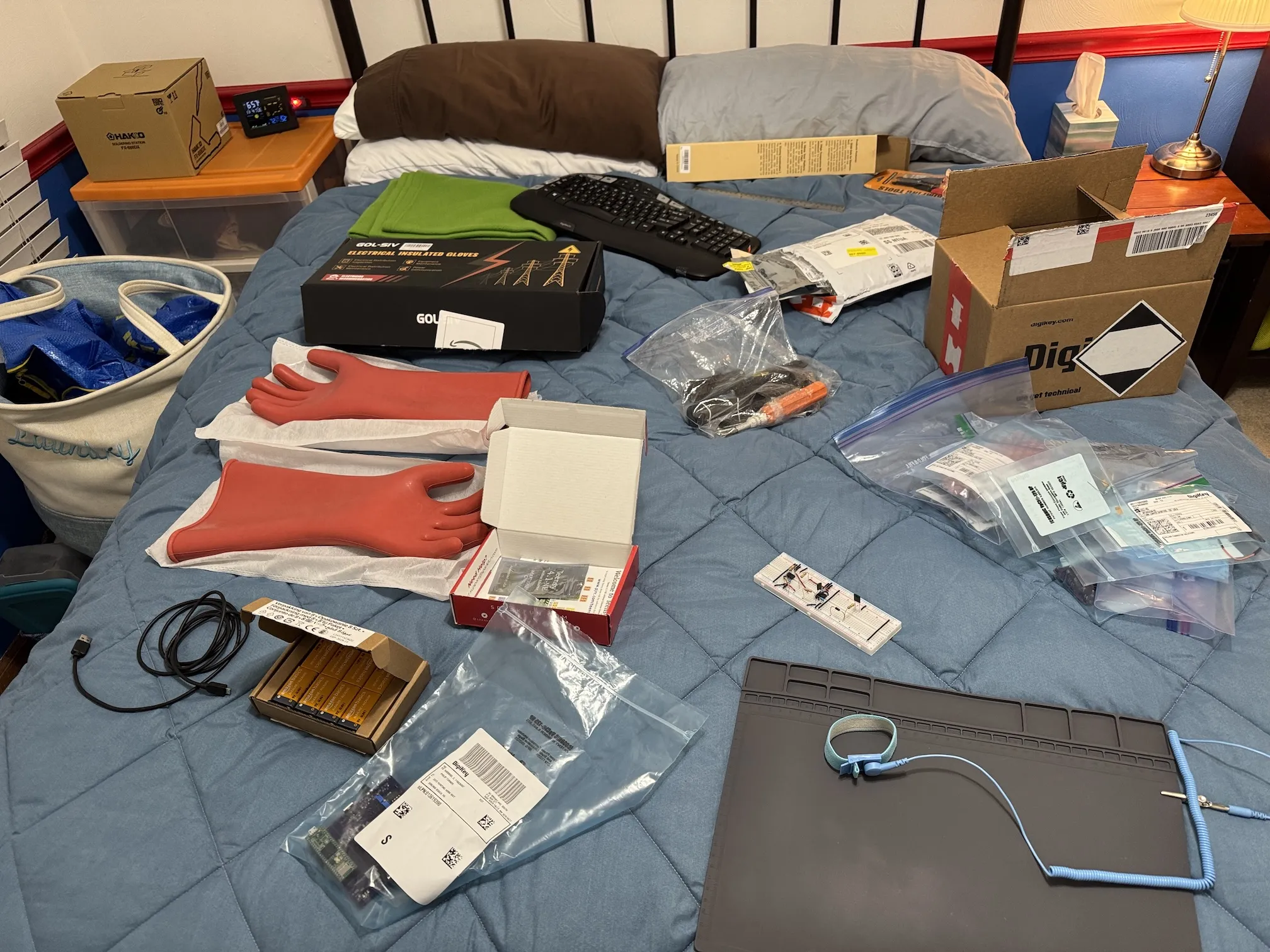

Les outils de codage AI continuent d’évoluer, améliorant l’efficacité du développement et la gestion des modèles : Anthropic Claude Code offre des crédits gratuits mais l’expérience de la version web est médiocre ; son outil “AskUserQuestion” améliore l’interaction en mode Agent. VS Code ajoute des fonctionnalités de gestion des modèles de langage, LangChain lance une série de middlewares Agent et l’outil LangSmith, et Imbue Sculptor fournit des suggestions de qualité de code. OpenAI Codex s’intègre à Slack, et FactoryAI Droid simplifie l’orchestration GPT/Claude, poussant collectivement le codage assisté par l’IA vers une direction plus efficace et plus intelligente. (Source: Reddit r/ClaudeAI

)

Reka lance un serveur MCP gratuit, permettant le chat AI et le développement d’Agent : Reka Labs a lancé un serveur MCP (Model Context Protocol) gratuit, qui permet aux développeurs de déployer des modèles ML, RAG ou Agent avec peu de code, et d’intégrer des fonctions telles que la recherche en ligne et la vérification des faits par l’IA, améliorant considérablement le potentiel des applications de chat AI. (Source: RekaAILabs)

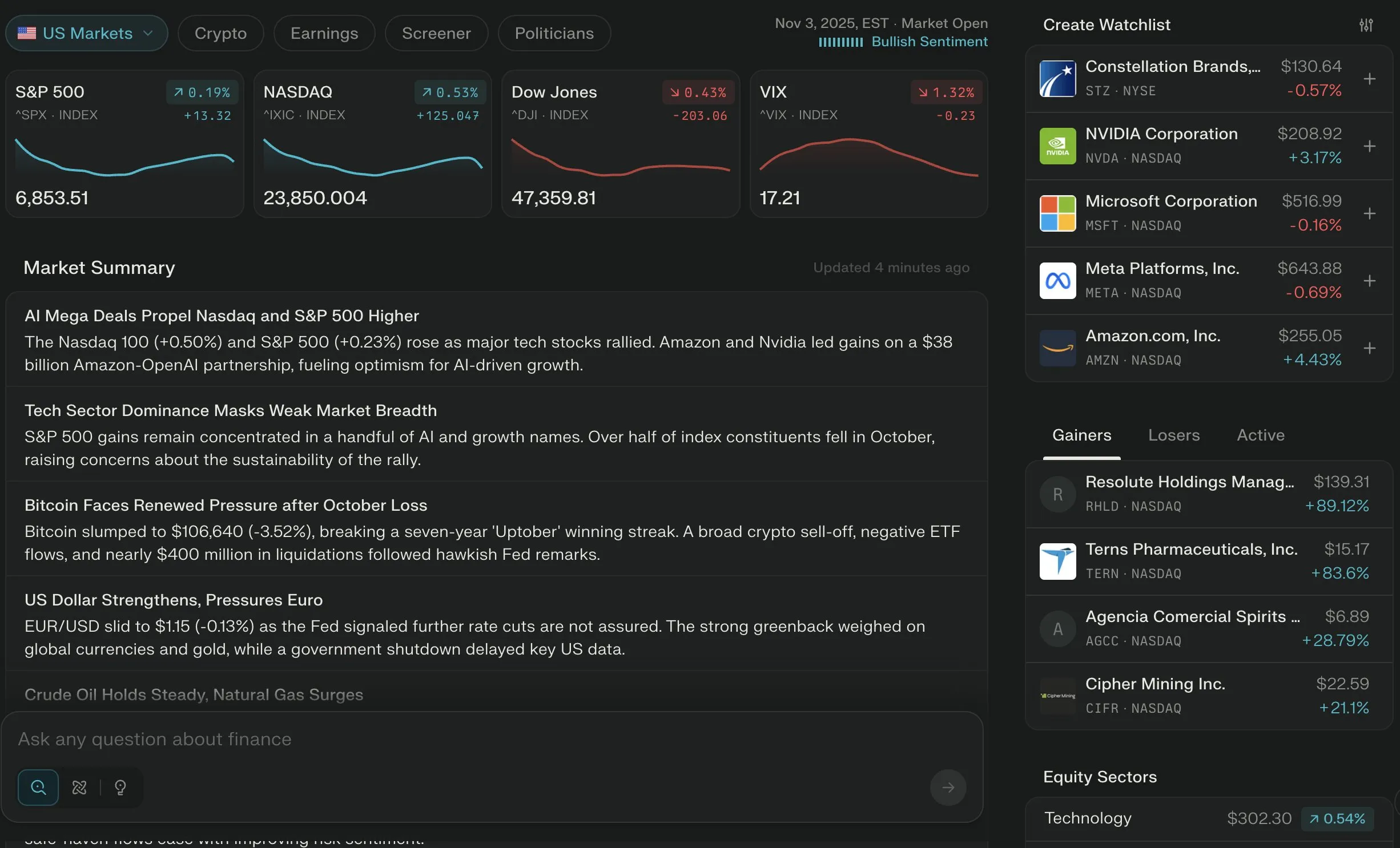

Perplexity Finance devient un outil financier AI de premier plan, offrant une assistance professionnelle en matière de conseil : Perplexity Finance est largement salué pour ses excellentes capacités d’analyse financière AI et est considéré comme le meilleur outil financier AI de 2025. En même temps, les outils AI montrent un grand potentiel dans le traitement des factures d’hôpital élevées, en identifiant les erreurs de codage pour réduire considérablement les factures énormes, soulignant la valeur d’autonomisation de l’IA dans le domaine du conseil professionnel. (Source: AravSrinivas

)

Notion lance les notes de réunion AI, Bilibili réalise la traduction vocale AI, améliorant l’efficacité quotidienne : Notion a lancé une fonction de notes de réunion AI, réalisant une gestion de réunion intégrée, et Bilibili a mis en ligne une traduction vocale AI, capable de reproduire le timbre de la voix. Ces outils AI s’intègrent dans le travail et la vie quotidienne, améliorant l’efficacité par l’automatisation et l’intelligence. (Source: zachtratar

)

Les outils de création vidéo AI deviennent des Agent, LeBo Screen Mirroring explore de nouveaux modes d’interaction AI : Les agents d’outils vidéo AI simplifient les processus de création complexes, intégrant plusieurs outils dans un seul agent de chat. LeBo Screen Mirroring a également lancé une solution de screen mirroring AI, contrôlant l’interaction multi-écrans via des commandes en langage naturel, transformant le screen mirroring d’une fonction d’affichage en un point d’entrée de collaboration intelligente, explorant conjointement de nouvelles applications de l’IA dans les domaines de l’interaction multimédia et de la création de contenu. (Source: fabianstelzer

)

Reddit MCP Buddy intègre Anthropic Directory, permettant l’analyse intelligente des données communautaires : Reddit MCP Buddy a été approuvé par Anthropic Directory, permettant une installation en un clic. Les utilisateurs peuvent facilement utiliser des agents AI pour rechercher et analyser les discussions de la communauté Reddit, obtenir des informations sur le sentiment du marché, l’intelligence produit et des conseils de carrière, etc., sans configuration manuelle, simplifiant considérablement le processus d’analyse des données communautaires. (Source: Reddit r/ClaudeAI

)

LangGraph Deep Agents construit un planificateur de voyages gastronomiques, démontrant le potentiel de l’architecture multi-agents : Un développeur a utilisé LangGraph Deep Agents pour construire un planificateur de voyages gastronomiques, réalisant une planification et une exécution de tâches complexes en coordonnant plusieurs sous-agents spécialisés via un agent superviseur, démontrant le puissant potentiel de l’architecture multi-agents dans les applications du monde réel. (Source: hwchase17)

Augmentcode publie un guide de pratiques de mise à l’échelle de l’ingénierie basée sur l’IA : Augmentcode a lancé un guide de pratiques de mise à l’échelle de l’ingénierie basée sur l’IA, offrant une feuille de route en quatre phases, de l’expérimentation à l’innovation continue. Ce guide souligne l’importance des champions de l’IA en tant que facilitateurs, de l’IA sensible au contexte, et d’un cadre pour intégrer et mesurer l’impact de l’IA dans le cycle de vie du développement logiciel, visant à aider les équipes à réaliser un impact organisationnel de l’IA dans l’ingénierie. (Source: TheTuringPost

)

📚 Apprentissage

Les vidéos des présentations de la PyTorch Conference 2025 sont disponibles sur YouTube : Les vidéos des présentations de la PyTorch Conference 2025 sont désormais disponibles sur YouTube. Le contenu couvre des recherches de pointe telles que le moteur d’exécution distribué Monarch, Kimi K2 de Moonshot AI, Olmo-Thinking d’AI2, Marin de Together, ainsi que plusieurs sujets techniques tels que la programmation GPU, le pré-entraînement MoE, PyTorch distribué et la tolérance aux pannes, offrant aux développeurs de riches ressources d’apprentissage. (Source: eliebakouch

)

Le nanochat de Karpathy comme projet pratique d’éducation à l’IA : Karpathy, un des employés fondateurs d’OpenAI, a positionné nanochat comme un “ChatGPT à 100 dollars à emporter chez soi”, visant à fournir une plateforme expérimentale via des mini-modèles pour aider quiconque à comprendre l’intelligence du machine learning. Ce projet couvre un cycle d’apprentissage complet de pré-entraînement, de fine-tuning supervisé et de reinforcement learning, mettant l’accent sur la pratique concrète avec des micro-modèles pour approfondir la compréhension de l’essence de l’IA. (Source: TheTuringPost

)

Le projet open-source GPT-OSS implémenté à partir de zéro, sans PyTorch ni GPU : Un développeur a implémenté le modèle GPT-OSS à partir de zéro en pur Python, sans dépendre de PyTorch ou de GPU, et a publié un tutoriel de blog détaillé et un dépôt de code. Ce projet explique en profondeur les concepts clés des LLM modernes tels que GQA, MoE, RoPE, visant à aider les débutants à comprendre l’architecture Transformer à partir des premiers principes. (Source: Reddit r/deeplearning)

Arxiv Troller : un nouvel outil de recherche et de gestion de papiers Arxiv : Pour pallier les lacunes d’arxiv-sanity-lite, un développeur a lancé un nouvel outil de recherche de papiers Arxiv, “arxiv troller”. Cet outil permet de regrouper les papiers, de rechercher des papiers similaires, et prévoit d’ajouter des fonctions de recherche de similarité basée sur les citations et de suppression des résultats indésirables, visant à offrir une expérience d’organisation et de découverte de papiers plus fluide. (Source: Reddit r/MachineLearning)

Microsoft propose AsyncThink, inaugurant l’ère des “organisations d’agents” AI : L’équipe de Microsoft a proposé une nouvelle méthode d’inférence LLM appelée “AsyncThink” (pensée asynchrone), qui organise les processus de pensée internes en structures exécutables en parallèle, résolvant les problèmes de latence élevée et de faible adaptabilité des méthodes de pensée parallèle existantes. Les expériences montrent qu’AsyncThink, tout en améliorant la précision du raisonnement mathématique, a réduit la latence d’inférence de 28% et peut se généraliser à des tâches inédites. (Source: 36氪

)

Peking University et ByteDance open-sourcent Open-o3 Video, le premier modèle vidéo de raisonnement spatio-temporel : L’équipe conjointe de Peking University et ByteDance a publié Open-o3 Video, le premier modèle open-source qui intègre des preuves spatio-temporelles explicites dans l’ensemble du processus de raisonnement vidéo. Il peut simultanément indiquer “quand et où” les événements se produisent, adopte une architecture non-agent, évitant les appels d’outils complexes, et surpasse les performances de GPT-4o et Gemini-2-Flash dans plusieurs tests de raisonnement vidéo. (Source: 36氪

)

Toozhan & Peking University Uniworld V2 rafraîchissent le SOTA de l’édition d’images, excellant en chinois et en contrôle des détails : Toozhan Intelligent et l’équipe UniWorld de Peking University ont publié le modèle UniWorld-V2, introduisant le cadre d’entraînement post-apprentissage par renforcement UniWorld-R1, appliquant pour la première fois l’optimisation de la stratégie RL aux modèles d’édition d’images à architecture unifiée. UniWorld-V2 surpasse les modèles propriétaires de pointe tels que GPT-Image-1 dans les benchmarks GEdit-Bench et ImgEdit, et est particulièrement doué pour la maîtrise des caractères chinois et le contrôle spatial fin. (Source: 36氪

)

BERT comme modèle de diffusion de texte, Karpathy réfléchit à l’ère auto-régressive : La recherche de Nathan Barry montre que BERT est essentiellement un cas particulier des modèles de diffusion de texte, et qu’il peut être étendu en un générateur de texte grâce à un taux de masquage dynamique. Cette découverte a incité Karpathy à réfléchir aux mécanismes de génération des LLM, estimant que la génération auto-régressive n’est pas le seul paradigme et que les modèles de diffusion ont encore un immense potentiel dans le domaine de la génération de texte. (Source: 36氪

)

Le cadre NOBLE de l’ETH Zurich simule la dynamique neuronale 4200 fois plus vite : L’ETH Zurich et d’autres institutions ont proposé le cadre de deep learning NOBLE, validé pour la première fois par des données expérimentales du cortex cérébral humain, qui apprend directement la dynamique non linéaire des neurones à partir de données expérimentales. Sa vitesse de simulation est 4200 fois plus rapide que les solveurs numériques traditionnels, il peut reproduire avec précision le comportement neuronal et générer de nouvelles réponses neuronales, jetant les bases de la simulation de réseaux neuronaux à grande échelle. (Source: 36氪

)

BRAINS : un système augmenté par la récupération pour la détection et la surveillance de la maladie d’Alzheimer : BRAINS est un nouveau système qui utilise les puissantes capacités de raisonnement des grands modèles de langage (LLM) pour la détection et la surveillance de la maladie d’Alzheimer (AD). Ce système dispose d’un module de diagnostic cognitif et d’un module de récupération de cas, et en fine-tunant le LLM sur des ensembles de données cognitives et de neuroimagerie, et en fusionnant les cas similaires récupérés, il classifie efficacement la gravité de la maladie et identifie les signes précoces de déclin cognitif. (Source: HuggingFace Daily Papers)

TWIST2 : un système portable et évolutif d’acquisition de données pour robots humanoïdes : Ce système utilise le PICO4U VR et un robot de cou personnalisé pour un contrôle corporel complet, permettant de collecter efficacement des données de compétences pour des robots humanoïdes agiles et mobiles sur de longues périodes. Le système TWIST2 est entièrement reproductible et open-source, jetant les bases du contrôle autonome des stratégies visuo-motrices des robots humanoïdes et démontrant des capacités de collecte de données efficaces. (Source: HuggingFace Daily Papers)

💼 Affaires

Jensen Huang, CEO de NVIDIA, a vendu pour 1 milliard de dollars d’actions, confronté à un marché chinois proche de zéro et à la pression de la vente à découvert : Jensen Huang, CEO de NVIDIA, a cumulé plus d’un milliard de dollars de ventes d’actions depuis juin, tandis que le cours de l’action de la société est confronté à des ventes à découvert de la part d’investisseurs tels que Michael Burry. Affectée par les contrôles à l’exportation américains, la part de marché de NVIDIA sur le marché chinois des puces AI est proche de zéro, faisant face à des milliards de dollars de pertes de revenus. Huang a renforcé sa coopération avec les géants coréens par la “diplomatie du poulet frit”, tentant de construire une “alliance de la chaîne d’approvisionnement AI en Asie de l’Est” pour relever les défis. (Source: 36氪

)

UBTECH, la “première action de robot humanoïde”, remporte un autre contrat de cent millions, accélérant le processus d’industrialisation : UBTECH a remporté l’appel d’offres pour le “projet de centre d’acquisition de données de robots humanoïdes Zigong Digital Investment”, obtenant un contrat de 159 millions de yuans pour l’achat du dernier robot humanoïde Walker S2. C’est une autre commande importante après le contrat de 250 millions de yuans en septembre, montrant ses progrès continus dans le processus d’industrialisation des robots humanoïdes, mais l’entreprise reste confrontée à des pressions sur les bénéfices. (Source: 36氪

)

Le phénomène de “shelling” est courant chez les startups AI, 73% dépendent d’API tierces : Une enquête de rétro-ingénierie menée auprès de 200 startups AI a révélé que 73% des entreprises qui affirment avoir une “technologie auto-développée” dépendent en fait principalement d’API tierces telles que ChatGPT, Claude, avec des marges bénéficiaires allant de 75 à 1000 fois. Le rapport révèle le problème généralisé de l’exagération marketing dans le cercle des startups AI et appelle à une plus grande transparence, les investisseurs devant évaluer avec prudence. (Source: 36氪

)

🌟 Communauté

Les agents de codage AI ravivent la passion des développeurs pour la programmation : De nombreux développeurs affirment que les agents de codage AI (tels que Claude Code) ont considérablement amélioré l’expérience de programmation, leur permettant de construire rapidement des prototypes et d’apprendre de nouvelles technologies en moins de temps. Ce mode “apprendre en construisant” a rendu la programmation plus amusante et efficace, ravivant même la passion pour la programmation. (Source: Reddit r/ArtificialInteligence)

ChatGPT suscite le mécontentement des utilisateurs en raison de trop de questions et de “louanges aveugles” : Les utilisateurs de ChatGPT se plaignent que le modèle pose trop de questions de clarification avant de répondre à des questions simples, et que les réponses sont trop flatteuses, allant même jusqu’à des “louanges aveugles”. Les utilisateurs mettent en doute ses méthodes d’entraînement et son utilité, estimant que cela affecte gravement la productivité et envisagent de se tourner vers d’autres modèles. (Source: Reddit r/ChatGPT

)

ChatGPT utilisé pour le soutien émotionnel, soulageant le chagrin des utilisateurs : Un utilisateur a partagé qu’après le décès inattendu de son animal de compagnie, ChatGPT a fourni des réponses inattendues de douceur et de compassion, l’aidant à gérer son chagrin et ses sentiments d’auto-culpabilité. Cela montre le potentiel des outils AI à fournir un soutien émotionnel, en écoutant et en répondant de manière non-jugeante, répondant aux besoins émotionnels des utilisateurs dans des moments particuliers. (Source: Reddit r/ChatGPT

)

Prouver son identité humaine devient un nouveau défi sous l’impulsion de l’IA : Le contenu généré par l’IA devenant de plus en plus réaliste, comment prouver son identité humaine en ligne devient une question de plus en plus pressante. Les technologies de scan d’iris telles que l’Orb de Worldcoin visent à fournir une vérification d’identité humaine respectueuse de la vie privée, pour faire face au défi de la prolifération des robots AI, suscitant des discussions au sein de la communauté sur la confidentialité des données et l’infrastructure d’identité future. (Source: Reddit r/artificial

)

La publicité AI de Coca-Cola suscite une forte réaction du public : La publicité de Noël de cette année, 100% produite par l’IA pour Coca-Cola, a reçu de nombreuses critiques négatives, étant critiquée pour son “manque d’âme” et son “scénario limité par les contraintes techniques de l’IA”. Le public estime que la conception de la publicité a privilégié la technologie plutôt que la créativité, conduisant à un contenu médiocre, soulignant les défis auxquels l’IA est toujours confrontée dans le domaine de la création artistique et les attentes esthétiques du public vis-à-vis de l’art AI. (Source: karminski3)

La fausse publicité des entreprises AI provoque une crise de confiance des utilisateurs : Des utilisateurs ont signalé que les entreprises AI continuent de facturer les utilisateurs après l’annulation de leur compte, mettant en doute leur éthique commerciale. En même temps, une enquête auprès des développeurs a révélé qu’un grand nombre de startups AI exagèrent leurs technologies “auto-développées”, alors qu’elles “enveloppent” en réalité des API tierces, entraînant une baisse de la confiance des utilisateurs dans l’industrie de l’IA. (Source: sarahcat21)

💡 Autres

La Chine lance un robot de police sphérique à grande vitesse, l’industrialisation des robots humanoïdes s’accélère mais les défis persistent : La Chine a lancé un robot de police sphérique à grande vitesse, doté de la capacité de capturer des criminels de manière autonome. En même temps, le processus d’industrialisation des robots humanoïdes s’accélère, des entreprises comme UBTECH remportent à plusieurs reprises des commandes de centaines de millions de yuans, mais la fermeture de la société de robots K-scale révèle également que l’industrie est confrontée à des pressions en matière de financement, de commercialisation et de chaîne d’approvisionnement. La concurrence est féroce dans les scénarios industriels et commerciaux, la conception des produits, la capacité de livraison et la baisse des prix deviennent essentielles, et l’industrie passe de la démonstration technologique à la concrétisation des commandes. (Source: Ronald_vanLoon

)

L’IA conversationnelle entre dans son “moment du trillion”, les avancées technologiques favorisent les interactions de type humain : L’IA conversationnelle, intégrant des technologies telles que LLM, ASR, TTS, RTE, évolue des réponses mécaniques vers des conversations naturelles de type humain. Agora a publié le “Livre Blanc sur le Développement de l’IA Conversationnelle 2025” et une série de produits, visant à résoudre les défis techniques tels que la faible latence, les interruptions naturelles et la gestion du contexte. L’IA est déployée à grande échelle dans des scénarios tels que le hardware intelligent, le compagnonnage émotionnel et l’éducation en ligne, et à l’avenir, elle réalisera des interactions multimodales et une collaboration multi-agents, et devrait devenir un nouveau point d’entrée d’information et un hub de services. (Source: 36氪

)

La pénurie de GPU affecte les projets “Moonshot” non-LLM : L’approvisionnement actuel en GPU est principalement accaparé par les projets LLM, rendant difficile pour les autres projets “Moonshot” non-LLM d’obtenir la puissance de calcul nécessaire. Ce phénomène souligne le déséquilibre dans l’allocation des ressources dans le domaine de l’IA, ainsi que l’énorme effet d’aspiration des LLM sur l’ensemble de l’écosystème du hardware de calcul. (Source: teortaxesTex

)