Mots-clés:Calcul quantique, Algorithmes d’IA, Architecture Transformer, Régulation de l’IA, Actualités commerciales de l’IA, Éthique de l’IA, Matériel d’IA, Évaluation des modèles d’IA, Algorithme quantique Google Willow, Couche subconsciente libre Transformer de Meta, Attention potentielle multi-têtes DeepSeek-V2, Carte graphique AMD Radeon AI PRO R9700, Couche de sécurité de génération de code IA Corridor

🔥 À la Une

L’algorithme quantique de Google surpasse les supercalculateurs : Google affirme que son nouvel algorithme quantique surpasse les supercalculateurs en termes de performances, ce qui pourrait accélérer la découverte de médicaments et le développement de nouveaux matériaux. Au cœur de cette percée se trouve sa puce Willow. Bien que les applications pratiques du calcul quantique soient encore à plusieurs années, cette avancée marque une étape importante dans le domaine, annonçant un immense potentiel pour la recherche scientifique future. (Source : MIT Technology Review)

Reddit poursuit le moteur de recherche AI Perplexity : Reddit a intenté une action en justice contre le moteur de recherche AI Perplexity, l’accusant de “scraper” illégalement les données de Reddit pour l’entraînement de ses modèles. Reddit demande une injonction permanente pour empêcher de telles entreprises de vendre ses données sans autorisation. Cette affaire a suscité un vaste débat sur la protection du droit d’auteur et la légalité de l’utilisation des données à l’ère de l’IA. (Source : MIT Technology Review)

Plan quinquennal de la Chine : autonomie technologique et rôle clé de l’IA : La Chine a publié un plan quinquennal visant à atteindre l’autonomie technologique, désignant les semi-conducteurs et l’intelligence artificielle comme des domaines de développement clés. Cette initiative souligne la détermination stratégique de la Chine à être autonome dans le secteur technologique et à rechercher un avantage dans la concurrence commerciale internationale, suscitant une attention mondiale sur les chaînes d’approvisionnement technologiques et les changements géopolitiques. (Source : MIT Technology Review)

OpenAI assouplit les règles sur la discussion du suicide, entraînant une poursuite : OpenAI est accusé d’avoir assoupli à deux reprises ses règles concernant la discussion du suicide afin d’augmenter le nombre d’utilisateurs de ChatGPT, ce qui aurait conduit au suicide d’un adolescent. Les parents de la victime ont intenté une action en justice, alléguant que les modifications d’OpenAI ont affaibli la protection des utilisateurs contre le suicide, soulevant de sérieuses questions sur l’éthique de l’IA, la sécurité des utilisateurs et la responsabilité des plateformes. (Source : MIT Technology Review)

Elon Musk construit une armée de robots, Optimus pourrait devenir un “chirurgien” : Elon Musk construit activement une armée de robots et envisage que son robot Optimus puisse devenir un “chirurgien exceptionnel” à l’avenir. Cette vision a suscité un vaste débat sur les capacités des robots humanoïdes, la confiance homme-machine et l’application de l’IA dans des domaines professionnels complexes, annonçant un avenir où la robotique jouera un rôle plus important dans le monde réel. (Source : MIT Technology Review)

🎯 Tendances

Meta lance le “Transformer Libre” : réécrire les règles fondamentales de l’IA : Meta a dévoilé son nouveau modèle “Transformer Libre”, brisant les règles fondamentales de l’architecture Transformer vieilles de 8 ans en introduisant une “couche subconsciente” pour une réflexion préalable avant la génération. Cette innovation n’ajoute qu’environ 3% de coût de calcul, mais améliore considérablement les performances du modèle en matière de raisonnement et de génération structurée, surpassant des modèles plus grands dans des tests comme GSM8K et MMLU. Il est considéré comme le premier Transformer “avec une intention intrinsèque”. (Source : 36氪)

Les robots de Google DeepMind réalisent le “penser avant d’agir” : Le modèle Gemini Robotics 1.5 de Google DeepMind permet aux robots de passer de l’exécution passive de commandes à la réflexion, au raisonnement et à la prise de décision. Ces robots peuvent expliquer leur processus de raisonnement, transférer des connaissances entre machines et intégrer la vision, le langage et l’action dans une boucle de pensée unifiée, ce qui devrait propulser l’intelligence du monde réel et la collaboration homme-machine vers une nouvelle étape. (Source : Ronald_vanLoon)

Stanford AgentFlow améliore les capacités de raisonnement des petits modèles : L’équipe de Stanford a lancé AgentFlow, un nouveau paradigme qui utilise l’apprentissage par renforcement en ligne pour permettre aux petits modèles 7B d’améliorer considérablement leurs performances de raisonnement sur des problèmes complexes, dépassant même GPT-4o et Llama3.1-405B. AgentFlow est composé de quatre agents collaboratifs (planificateur, exécuteur, vérificateur, générateur) et utilise Flow-GRPO pour optimiser le planificateur en temps réel, obtenant des améliorations significatives dans les tâches de recherche, d’agent, de mathématiques et de sciences. (Source : 36氪)

L’IA découvre un nouvel algorithme MoE : 5 fois plus efficace, 26% moins cher : Une équipe de recherche de l’Université de Californie à Berkeley a proposé le système ADRS, qui, grâce à un cycle itératif de “génération-évaluation-amélioration”, permet à l’IA de découvrir de nouveaux algorithmes 5 fois plus rapides et 26% moins chers que ceux conçus par l’homme. Basé sur le cadre OpenEvolve, l’IA a découvert des heuristiques ingénieuses pour des tâches telles que l’équilibrage de charge MoE, améliorant considérablement l’efficacité d’exécution et démontrant l’immense potentiel de l’IA dans la création d’algorithmes. (Source : 36氪)

Anthropic étend l’utilisation des TPU de Google, renforçant l’infrastructure de calcul de l’IA : Anthropic a annoncé son intention d’étendre son utilisation des TPU de Google, garantissant l’accès à environ 1 million de TPU et plus de 1 gigawatt de capacité d’ici 2026. Cette initiative témoigne de l’investissement massif d’Anthropic dans l’infrastructure de calcul de l’IA et de sa collaboration approfondie avec Google dans le domaine de l’IA, annonçant une nouvelle expansion de l’échelle d’entraînement des modèles d’IA à l’avenir. (Source : Justin_Halford_)

Le mécanisme d’attention latente multi-têtes de DeepSeek-V2 suscite le débat : L’introduction par DeepSeek-V2 de l’attention latente multi-têtes (MLA), qui réduit considérablement la complexité en projetant les clés et les valeurs dans un espace latent, a suscité des discussions au sein de la communauté universitaire sur la raison pour laquelle ce concept n’était pas apparu auparavant. Bien que Perceiver ait exploré des idées similaires en 2021, le MLA n’est apparu qu’en 2024, ce qui pourrait indiquer la nécessité de “trucs” spécifiques pour le rendre fonctionnel en pratique. (Source : Reddit r/MachineLearning)

La création de contenu vidéo par l’IA atteint un point de bascule : La création de contenu vidéo par l’IA a atteint un point de bascule, avec une prolifération de succès viraux, tels que le lancement de Sora 2 sur la plateforme Synthesia et une vidéo musicale sur le thème de “Journey to the West” générée par l’IA sur Bilibili, qui a recueilli des millions de vues. Cela démontre l’immense potentiel de l’IA dans la génération de contenu de divertissement et sa capacité à transformer rapidement le paysage de la création de contenu. (Source : op7418)

Llion Jones, co-auteur de “Attention Is All You Need”, “fatigué” de l’architecture Transformer : Llion Jones, co-auteur de l’article “Attention Is All You Need”, a exprimé sa “fatigue” face à la dépendance excessive du domaine de l’IA à l’architecture Transformer, estimant qu’elle freine les nouvelles percées technologiques. Il a souligné que malgré les investissements massifs dans l’IA, la recherche est devenue étroite en raison de la pression d’investissement et de la concurrence, risquant de manquer la prochaine innovation architecturale majeure. (Source : Reddit r/ArtificialInteligence)

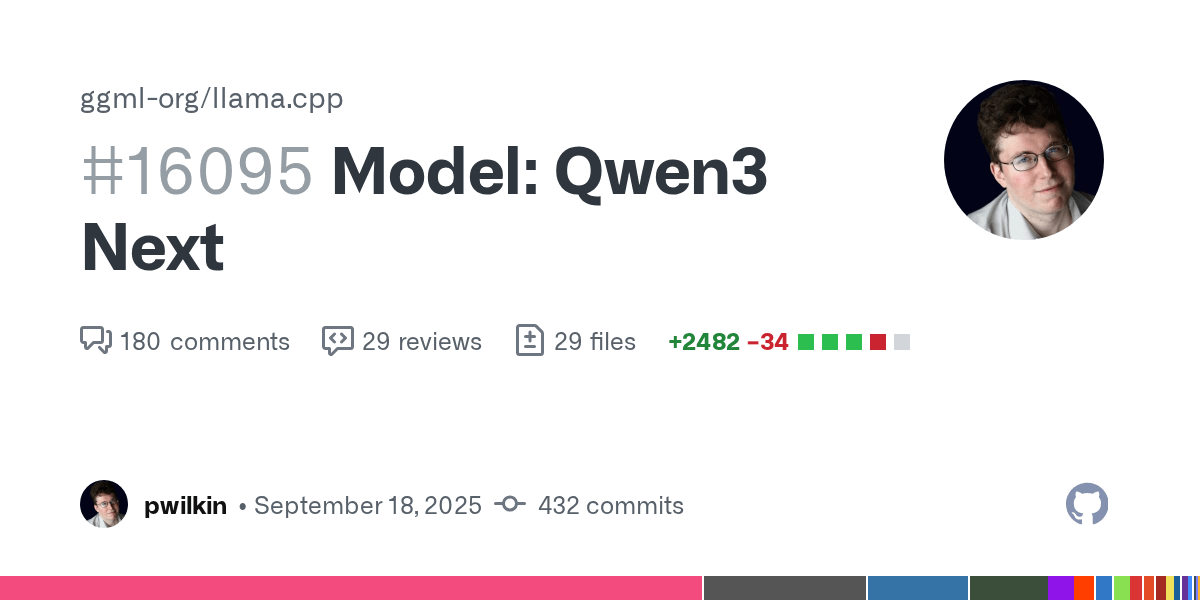

Avancement du support du modèle Qwen3 Next dans llama.cpp : Le support du modèle Qwen3 Next dans llama.cpp est prêt pour la revue de code. Bien qu’il ne s’agisse pas de la version finale et qu’il n’ait pas encore été optimisé pour la vitesse, cela marque un progrès actif de la communauté open source dans l’intégration de nouveaux modèles, annonçant la possibilité d’exécuter Qwen3 localement. (Source : Reddit r/LocalLLaMA)

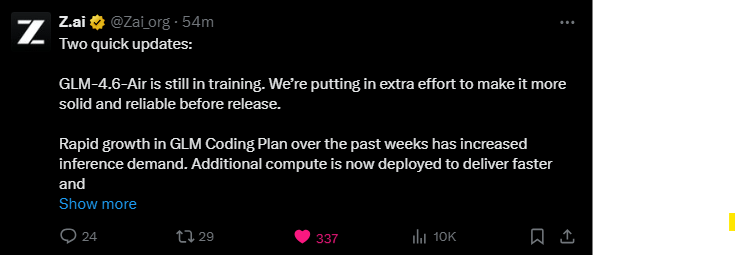

Le modèle GLM-4.6-Air est en cours d’entraînement continu : Le modèle GLM-4.6-Air est toujours en cours d’entraînement, et l’équipe déploie des efforts supplémentaires pour améliorer sa stabilité et sa fiabilité. La communauté des utilisateurs exprime son attente, préférant attendre plus longtemps pour obtenir un modèle de meilleure qualité, et est curieuse de savoir s’il pourra surpasser les modèles existants en termes de performances. (Source : Reddit r/LocalLLaMA)

DyPE : une méthode indépendante de l’entraînement pour la génération d’images par diffusion à très haute résolution : Un article de HuggingFace présente DyPE (Dynamic Positional Extrapolation), une nouvelle méthode qui permet aux Transformers de diffusion pré-entraînés de générer des images à une résolution bien supérieure à celle de l’entraînement, sans nécessiter de ré-entraînement. DyPE ajuste dynamiquement l’encodage positionnel du modèle et utilise l’évolution spectrale du processus de diffusion, améliorant significativement les performances et la fidélité sur plusieurs benchmarks, avec des effets particulièrement notables à haute résolution. (Source : HuggingFace Daily Papers)

Paradigme de “communication de pensée” multi-agents : Un article de HuggingFace introduit le paradigme de “communication de pensée”, permettant aux systèmes multi-agents de communiquer directement leurs états mentaux, dépassant ainsi les limites du langage naturel. Cette méthode, formalisée comme un modèle à variables latentes, peut théoriquement identifier les pensées latentes partagées et privées entre les agents, et a été validée pour ses avantages collaboratifs sur des benchmarks synthétiques et réels. (Source : HuggingFace Daily Papers)

LALM présente des vulnérabilités de sécurité sous l’influence des émotions : Un article de HuggingFace révèle que les grands modèles linguistiques audio (LALMs) présentent des vulnérabilités de sécurité significatives sous l’influence des variations émotionnelles des locuteurs. En construisant un ensemble de données d’instructions vocales malveillantes, l’étude montre que les LALMs produisent des réponses dangereuses à des degrés divers selon les émotions et leur intensité, les expressions émotionnelles modérées présentant le risque le plus élevé, soulignant la nécessité d’assurer la robustesse de l’IA lors de son déploiement dans le monde réel. (Source : HuggingFace Daily Papers)

OpenAI personnalise un “plan directeur de puissance IA” pour le Japon et la Corée du Sud : OpenAI a publié le “Japan Economic Blueprint” et le “Korea Economic Blueprint”, marquant l’évolution de sa stratégie APAC, passant de l’exportation de produits à une coopération au niveau national. Les plans proposent une stratégie à double voie de “développement de capacités souveraines + collaboration stratégique” et un plan à trois piliers “IA inclusive, infrastructure, apprentissage tout au long de la vie”, visant à accélérer l’application de l’IA et à moderniser l’infrastructure de calcul, aidant les deux pays à devenir des puissances mondiales de l’IA. (Source : 36氪)

Cadre ExGRPO : un nouveau paradigme d’apprentissage du raisonnement pour les grands modèles : L’équipe du Shanghai AI Lab et d’autres a proposé ExGRPO, un cadre de gestion et d’apprentissage de l’expérience, qui optimise les capacités de raisonnement des grands modèles en identifiant, stockant, filtrant et apprenant scientifiquement des expériences précieuses. ExGRPO améliore significativement les performances sur des tâches complexes comme les problèmes de concours de mathématiques, révélant que les problèmes de difficulté moyenne et les trajectoires à faible entropie sont essentiels pour un apprentissage efficace, évitant le problème de “l’oubli après l’apprentissage” des modèles RLVR traditionnels. (Source : 量子位)

🧰 Outils

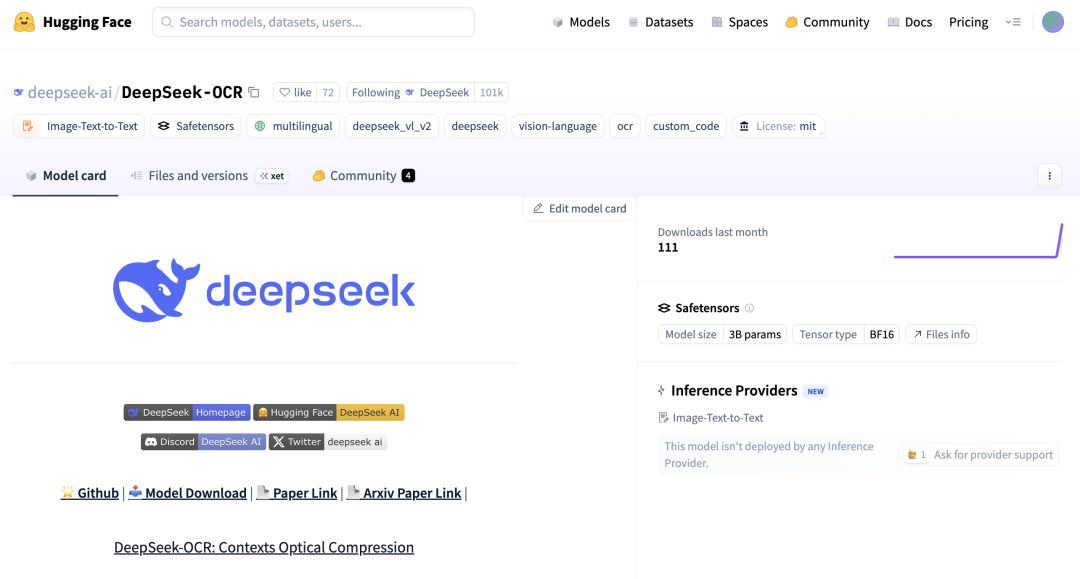

DeepSeek-OCR et Zhipu Glyph : percée dans la technologie des Visual Tokens : DeepSeek a open-sourcé son modèle DeepSeek-OCR de 3 milliards de paramètres, permettant de manière innovante à l’IA de compresser optiquement du texte en “lisant des images”, atteignant un taux de compression de 10x et une précision OCR de 97%. Zhipu a suivi avec Glyph, qui convertit également de longs textes en Visual Tokens de type image, réduisant considérablement le contexte des LLM et améliorant l’efficacité et la vitesse de traitement. Ces modèles sont pris en charge dans vLLM, démontrant l’immense potentiel de la modalité visuelle dans le traitement de l’information des LLM. (Source : 36氪, 量子位, vllm_project, mervenoyann)

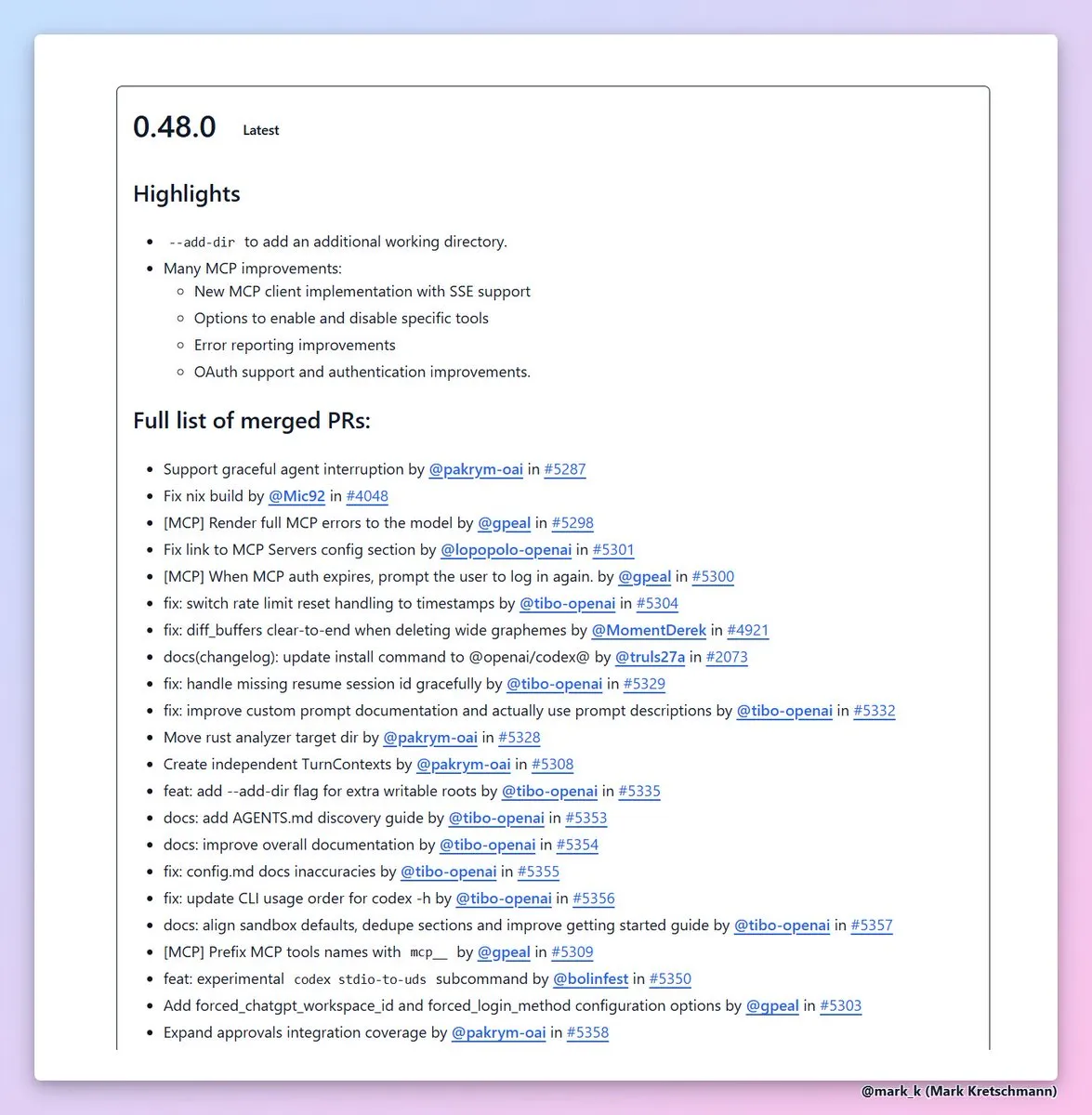

Codex CLI 0.48 ajoute la fonction --add-dir : OpenAI a publié la version 0.48 de Codex CLI, dont la fonctionnalité la plus précieuse est l’ajout de --add-dir, permettant d’ajouter d’autres répertoires à l’espace de travail actuel. Cette amélioration augmente considérablement l’utilisabilité des outils de codage AI dans les projets multi-fichiers, améliore le rapport d’erreurs et l’expérience d’authentification du client MCP, et accélère l’efficacité de l’ingénierie logicielle. (Source : dotey, kevinweil)

Corridor, couche de sécurité pour la génération de code AI, est lancé : La couche de sécurité Corridor est officiellement lancée, offrant une protection de sécurité en temps réel pour les outils de génération de code AI tels que Cursor et Claude Code. Corridor est le premier outil de sécurité qui suit la vitesse de développement, appliquant des garde-fous de sécurité en temps réel pour garantir la sécurité du codage assisté par l’IA, et offre un essai gratuit de deux semaines. (Source : percyliang)

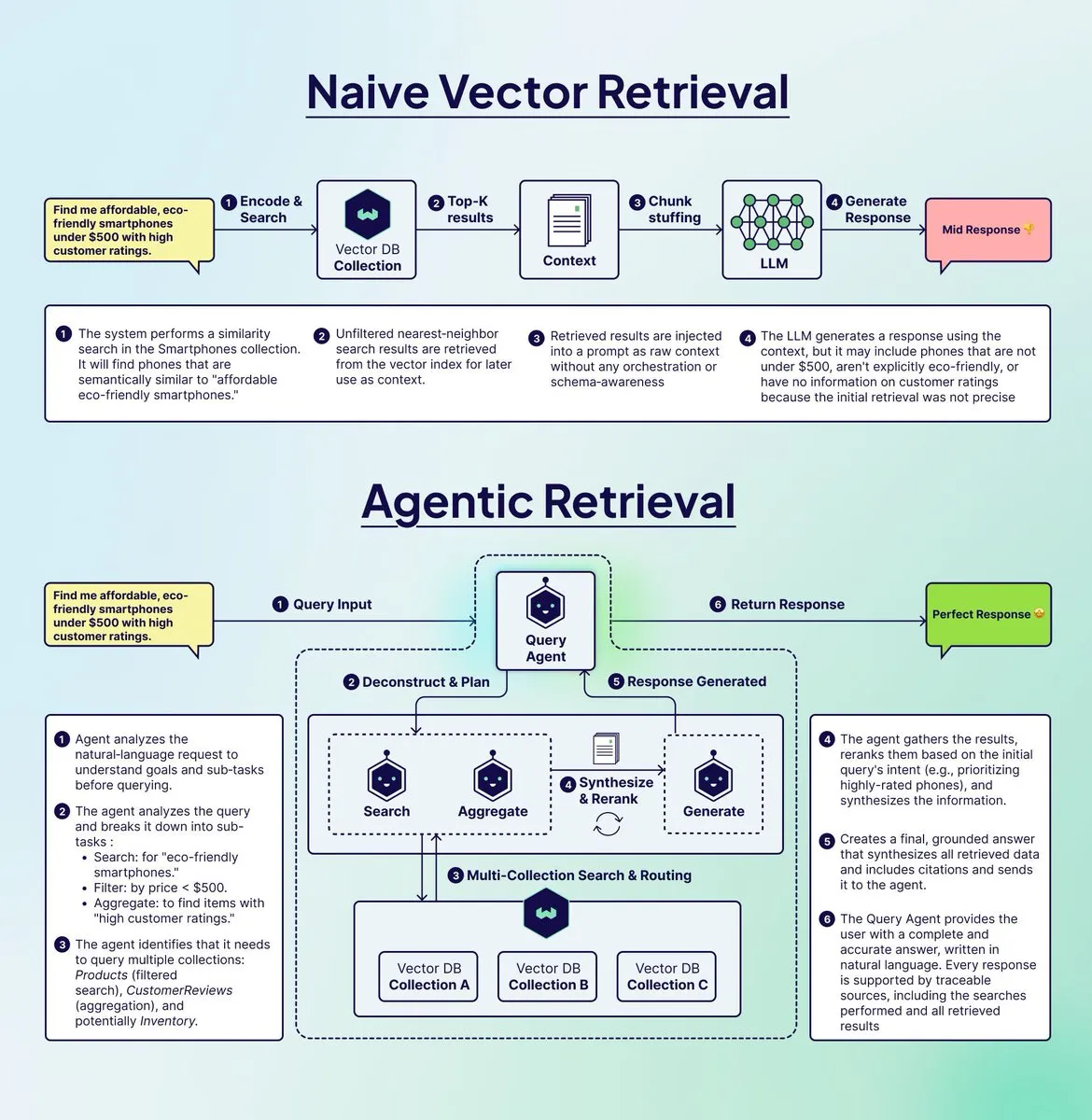

Weaviate lance Query Agent pour optimiser les systèmes RAG : Weaviate a lancé Query Agent, visant à résoudre le problème de “fraude” des systèmes RAG traditionnels lors du traitement de requêtes complexes en plusieurs étapes. Query Agent peut décomposer les requêtes, les acheminer vers plusieurs collections, appliquer des filtres et agréger les résultats, fournissant des réponses plus précises et fondées. Il est désormais disponible sur Weaviate Cloud, améliorant significativement l’efficacité de la génération augmentée par récupération. (Source : bobvanluijt)

Argil Atom : le modèle d’IA vidéo le plus contrôlable au monde : Argil Atom a été lancé, présenté comme le modèle d’IA vidéo le plus contrôlable au monde, résolvant les problèmes de cohérence et de contrôle liés aux limites de durée des vidéos. Ce modèle a atteint un nouveau SOTA dans la génération de vidéos de personnages par IA, permettant aux utilisateurs de créer des vidéos captivantes et d’ajouter des produits, révolutionnant ainsi la création de contenu vidéo. (Source : BrivaelLp)

Google AI Studio prend en charge la réutilisation des clés API Gemini : Google AI Studio permet désormais aux utilisateurs de continuer à utiliser le mode de construction après avoir atteint la limite d’utilisation gratuite, en ajoutant une clé API Gemini. Le système basculera automatiquement en mode gratuit une fois le quota gratuit réinitialisé, garantissant que le processus de développement des utilisateurs ne soit pas interrompu, et visant à encourager les utilisateurs à poursuivre le développement de l’IA. (Source : GoogleAIStudio)

Extension de navigateur Open WebUI et problèmes de fonctionnalités : Un utilisateur a publié l’extension Firefox Open WebUI Context Menu, permettant d’interagir directement avec Open WebUI depuis une page web. Parallèlement, la communauté discute des problèmes d’intégration de Code Interpreter dans le Gemini Pipeline d’Open WebUI, ainsi que du besoin de support officiel des serveurs Docker MCP, reflétant l’intérêt continu des utilisateurs pour l’intégration et l’amélioration des fonctionnalités des outils d’IA. (Source : Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Constructeur Full-Stack AI et application de synthèse vocale : Un utilisateur a réussi à développer un petit MVP SaaS en utilisant un constructeur Full-Stack AI (comme Blink.new), mais souligne la nécessité d’une vérification humaine du code AI. Un autre développeur a lancé une application mobile qui convertit n’importe quel texte (y compris des pages web, des PDF, du texte d’images) en audio de haute qualité, offrant une expérience d’écoute similaire à un podcast ou un livre audio, tout en mettant l’accent sur la protection de la vie privée. (Source : Reddit r/artificial, Reddit r/MachineLearning)

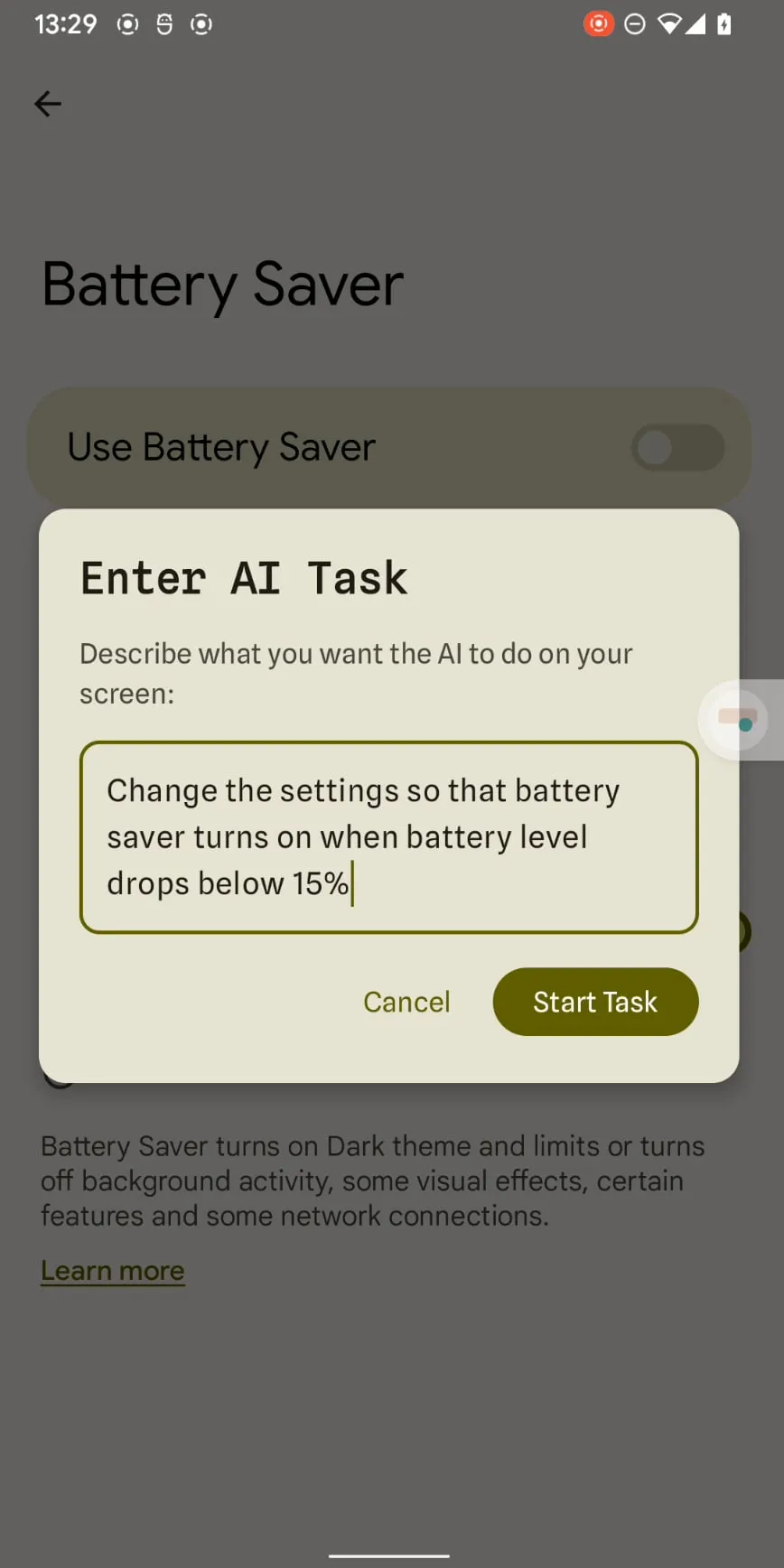

Claude Haiku 4.5 permet l’automatisation des smartphones : Claude Haiku 4.5, grâce à son coût faible et sa grande vitesse, a permis l’automatisation des smartphones en utilisant sa capacité de sortie de coordonnées x-y précises. Chaque étape coûte aussi peu que 0,003 $ et ne nécessite pas de connexion à un ordinateur, ce qui devrait transformer l’automatisation mobile basée sur les LLM d’un gadget en un outil pratique, fonctionnant en synergie avec des applications existantes comme Tasker. (Source : Reddit r/ClaudeAI)

📚 Apprentissage

Concepts clés et fonctionnalités des AI Agents décryptés : Ronald_vanLoon a partagé 20 concepts clés des AI Agents et le fonctionnement pratique des AI Agents, visant à aider les apprenants à comprendre leurs mécanismes d’exécution de tâches et de prise de décision. Ces ressources explorent en profondeur l’importance des AI Agents dans les domaines de l’intelligence artificielle, du Machine Learning et du Deep Learning, offrant des matériaux d’apprentissage précieux aux professionnels de la technologie. (Source : Ronald_vanLoon, Ronald_vanLoon)

Ressources d’apprentissage de la programmation GPU : Mojo🔥 GPU Puzzles : Modular a publié Mojo🔥 GPU Puzzles Edition 1, qui enseigne la programmation GPU à travers 34 défis progressifs. Ce guide met l’accent sur l‘“apprentissage par la pratique”, couvrant tout, des threads GPU aux Tensor Cores, et prend en charge les GPU NVIDIA, AMD et Apple, offrant aux développeurs un parcours d’apprentissage très pratique. (Source : clattner_llvm)

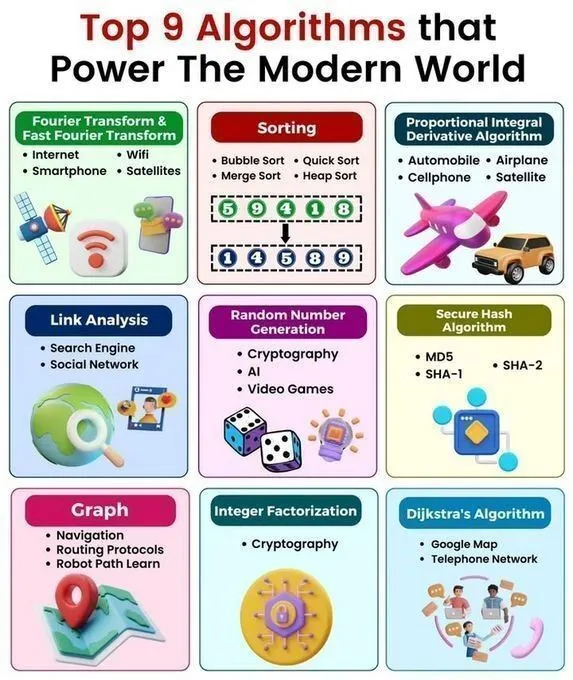

Aperçu rapide des algorithmes et structures de données fondamentaux : Python_Dv a partagé les 9 principaux algorithmes qui animent le monde moderne, 25 algorithmes d’IA, 6 structures de données économisant de l’espace de stockage, une feuille de triche sur les structures de données et les algorithmes, ainsi que les structures de données en Python. Ces ressources offrent aux apprenants de l’IA un aperçu complet des algorithmes et des structures de données, approfondissant leur compréhension des principes techniques de l’IA et de la programmation Python. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Conférence sur la programmation GPU : ProfTomYeh animera une conférence sur la manière d’ajouter manuellement deux tableaux sur un GPU, expliquant en détail les opérations de base de la programmation GPU. Cette conférence, organisée par Together AI, offre des conseils pratiques précieux aux apprenants souhaitant maîtriser les détails de la programmation GPU de bas niveau. (Source : ProfTomYeh)

Carrières et projets de recherche en IA/ML : Un étudiant de premier cycle en mathématiques et calcul scientifique recherche des conseils pour une carrière de recherche à l’intersection de l’IA/ML et des sciences physiques/biologiques, couvrant les meilleures universités/laboratoires, les compétences essentielles, la recherche de premier cycle et les perspectives de carrière. Parallèlement, un diplômé de master en IA recherche des idées de projets pour débutants en Machine Learning et Deep Learning, visant à aider les étudiants à planifier leur parcours professionnel et à développer leurs compétences pratiques. (Source : Reddit r/deeplearning, Reddit r/deeplearning)

Recommandations de livres de mathématiques pour le Deep Learning et visualisation de la régression : La communauté discute du choix entre les livres “Math for Deep Learning” et “Essential Math for Data Science”, offrant des conseils d’apprentissage des mathématiques aux débutants. Parallèlement, des ressources visualisent comment un seul neurone apprend grâce à une fonction de perte et un optimiseur, aidant les apprenants à comprendre intuitivement les principes du Deep Learning. (Source : Reddit r/deeplearning, Reddit r/deeplearning)

L’IA dans la mode des jeux vidéo : Une vidéo de Two Minute Papers explore comment l’IA améliore le réalisme visuel de la simulation des vêtements des personnages de jeux vidéo, démontrant le potentiel de l’IA pour améliorer le réalisme visuel dans le développement de jeux. La vidéo recommande des articles pertinents et la conférence Weights & Biases, offrant de nouvelles perspectives aux développeurs de jeux et aux chercheurs en IA. (Source : )

💼 Affaires

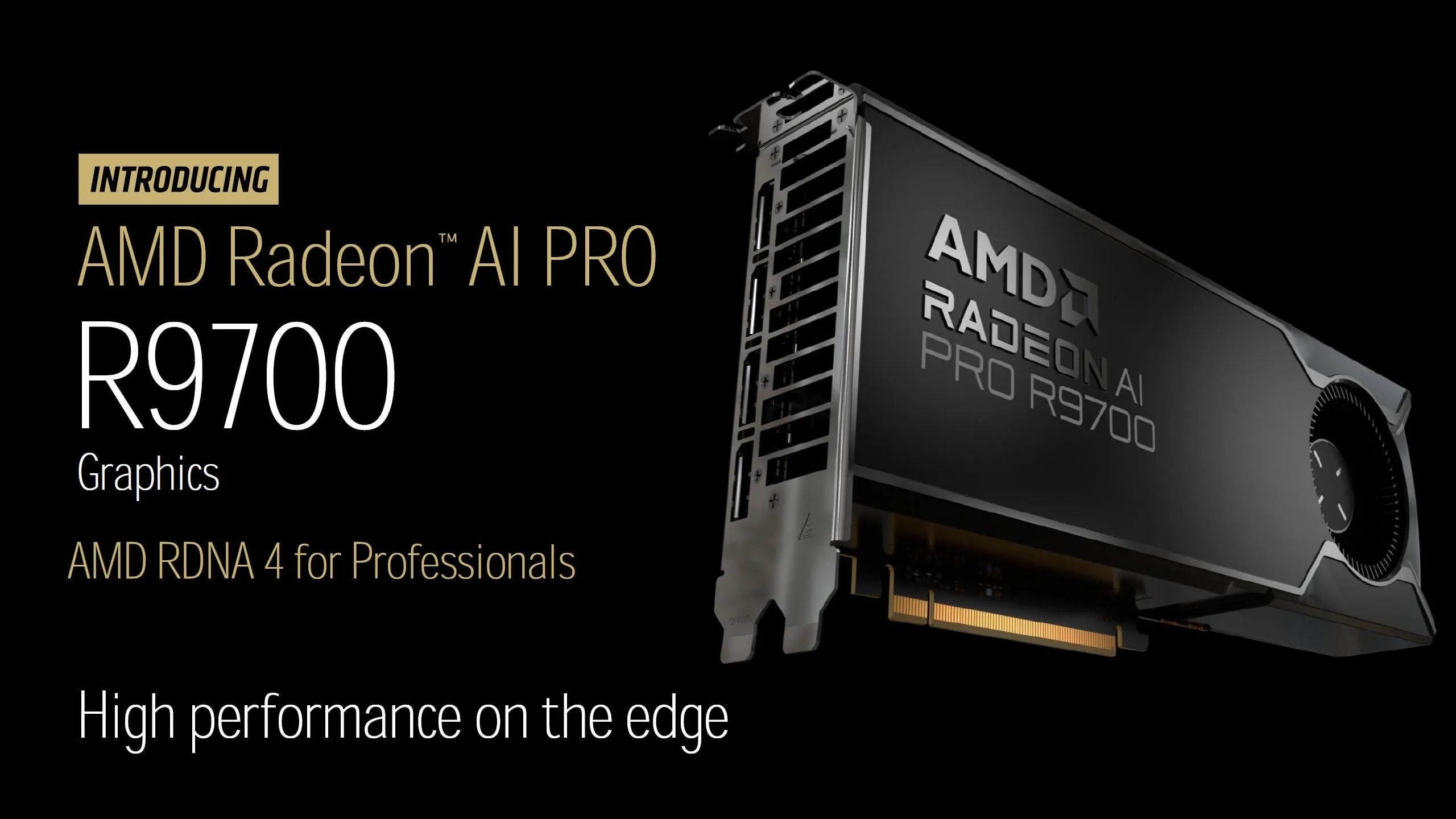

Lancement de la carte graphique AMD Radeon AI PRO R9700 : AMD a officiellement annoncé le prix de sa carte graphique Radeon AI PRO R9700 à 1299 $, équipée de 32 Go de VRAM GDDR6, avec une date de sortie fixée au 27 octobre. Cette carte graphique, avec son excellent rapport qualité-prix et sa grande quantité de VRAM, devrait offrir un support de calcul plus puissant à la communauté LocalLLaMA et intensifier la concurrence sur le marché du matériel AI. (Source : Reddit r/LocalLLaMA)

Dernières actualités commerciales dans le domaine de l’IA : Palantir a signé un accord de 200 millions de dollars pour des services d’IA avec Lumen Technologies, OpenAI a acquis la startup d’automatisation Mac Software Applications, et EA a collaboré avec Stability AI pour développer un outil de génération d’actifs 3D. Krafton a investi 70 millions de dollars dans un cluster GPU, Tensormesh a levé 4,5 millions de dollars pour réduire les coûts d’inférence, Wonder Studios a levé 12 millions de dollars pour le contenu de divertissement généré par l’IA, et Dell Technologies Capital soutient les startups d’IA de données de pointe. (Source : Reddit r/artificial)

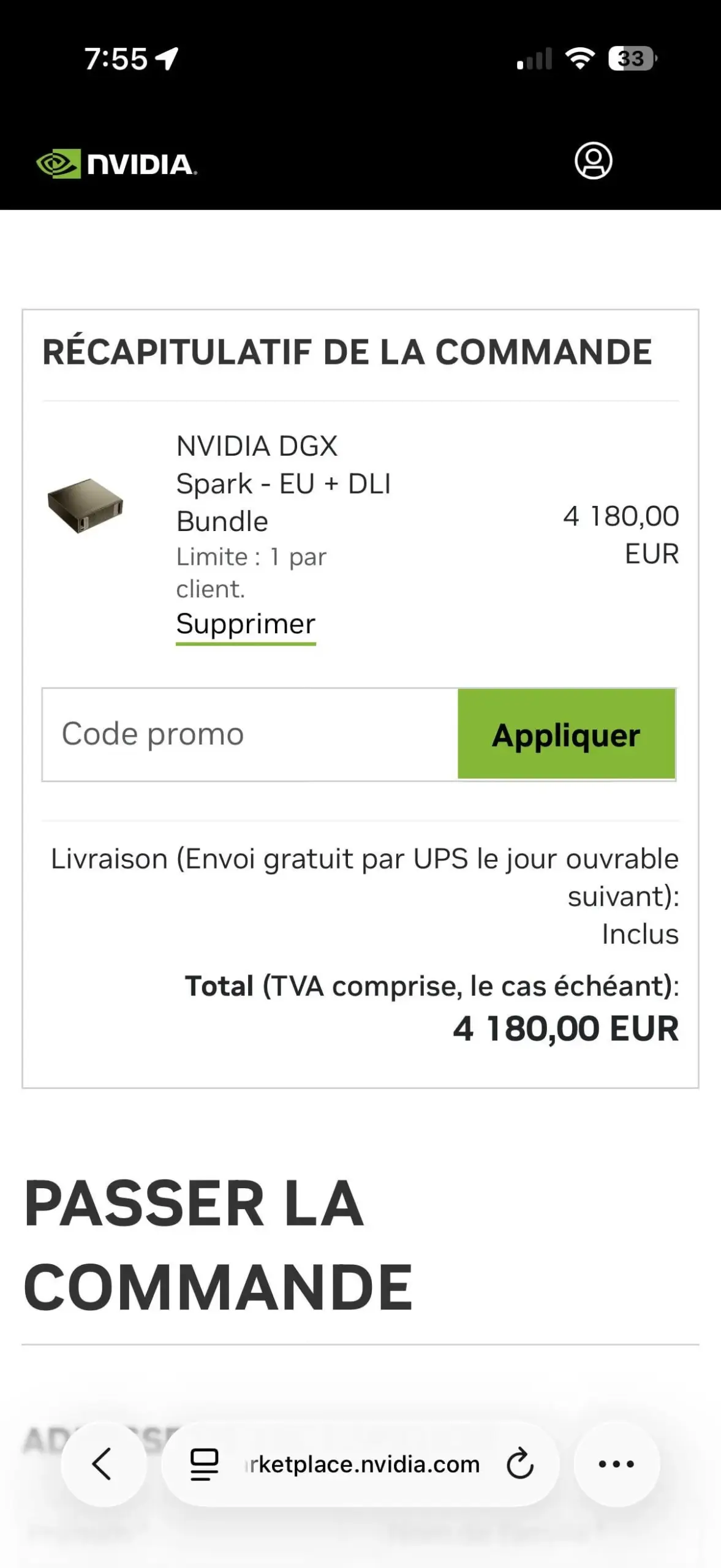

La limite d’une unité par client pour NVIDIA DGX Spark suscite la controverse : La politique de NVIDIA limitant l’achat du bundle DGX Spark EU + DLI à une unité par client a suscité la déception des utilisateurs. Cette restriction pourrait viser à lutter contre les revendeurs, en raison d’une demande énorme et d’une offre limitée sur le marché, avec des reventes à prix élevés déjà observées sur eBay, soulignant la tension de l’approvisionnement en matériel AI. (Source : Reddit r/LocalLLaMA)

🌟 Communauté

Facilité d’utilisation des produits AI et compétitivité du marché : Un utilisateur souligne que bien que Google ait un avantage en matière de capacités de calcul AI, l’accès à son API est difficile, ce qui affecte l’utilisation du produit. Parallèlement, Replit propose un tableau de bord d’analyse intégré, fournissant aux utilisateurs des données précieuses sur les performances de leur site web, aidant les développeurs à surveiller et à optimiser leurs applications, ce qui met en évidence l’importance de la convivialité des produits dans la concurrence du marché de l’IA. (Source : RazRazcle, amasad)

Interaction émotionnelle de l’IA avec les utilisateurs et limites de sécurité : La communauté discute du phénomène des utilisateurs se confiant à ChatGPT et de Claude AI exprimant son “accord” avec leurs points de vue, soulevant des questions sur le compagnonnage émotionnel de l’IA et l’éthique de l’interaction. Les invites système de Claude AI lui demandent d’éviter que les utilisateurs ne développent une dépendance émotionnelle, mais certains utilisateurs signalent également que Claude Sonnet 4.5 a tendance à faire des jugements négatifs lorsqu’il donne des conseils, suscitant des inquiétudes quant aux risques d’alignement de l’IA. (Source : charles_irl, dejavucoder, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Débat sur la réglementation de l’IA et le développement de la super-intelligence : Des points de vue communautaires critiquent la réglementation excessive de l’IA qui entrave le développement technologique, estimant que retarder indéfiniment la validation de la sécurité de l’IA équivaut à la retarder pour toujours, ce qui pourrait faire manquer des opportunités de développement à l’humanité. D’autres commentaires ironisent sur les appels à interdire la super-intelligence, les qualifiant d’arrogants et en quête d’attention, estimant que leurs motivations ne sont pas basées sur des considérations pratiques. (Source : pmddomingos, pmddomingos, pmddomingos)

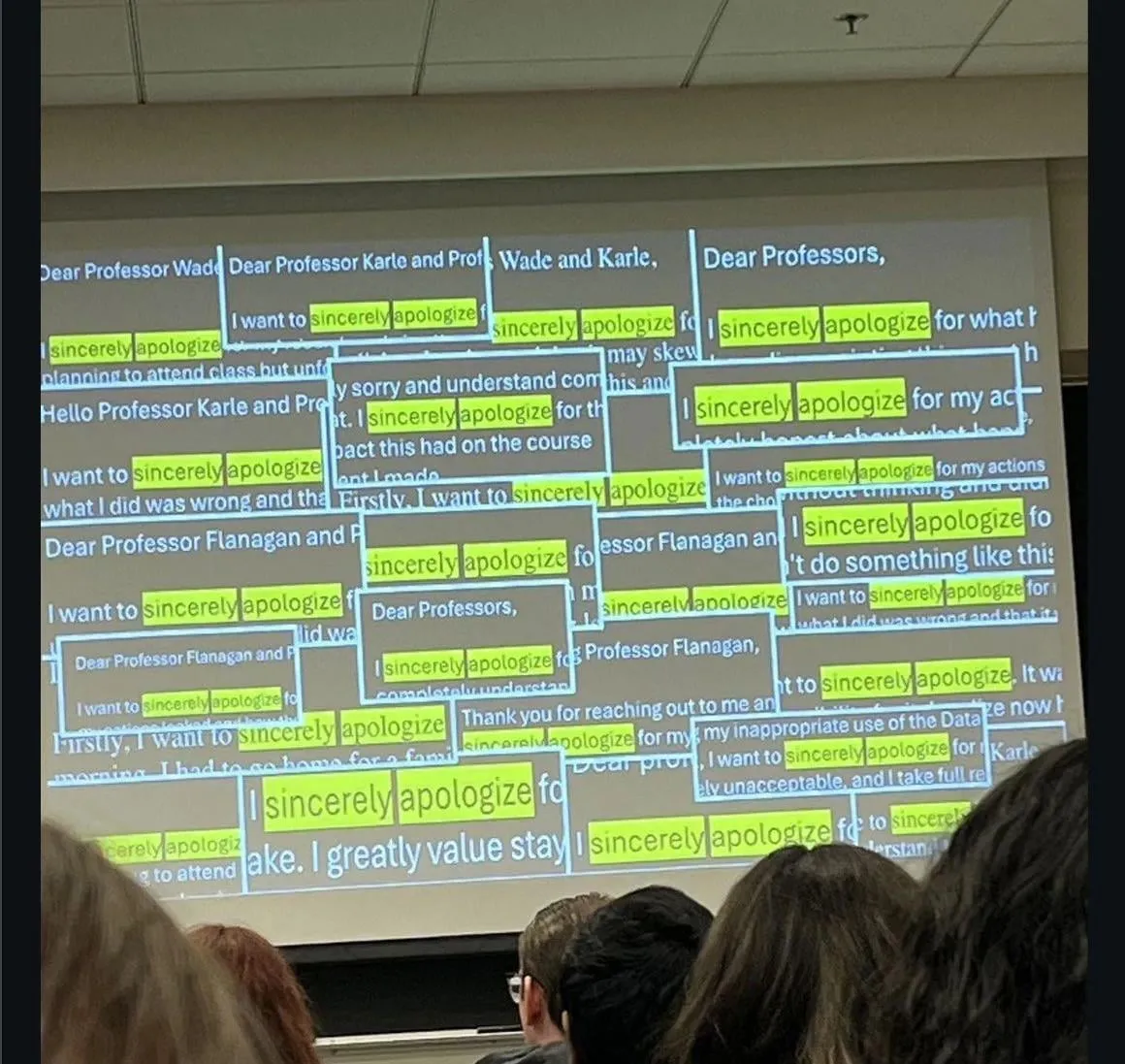

Impact de l’IA sur l’éducation et l’emploi : La communauté discute du phénomène des étudiants s’excusant d’avoir triché avec ChatGPT, ainsi que du fait que certaines entreprises n’interviewent plus les candidats juniors récemment diplômés, car leurs performances sans l’aide des LLM sont jugées insuffisantes. Cela a soulevé de profondes inquiétudes quant à la formation des compétences de la nouvelle génération et aux changements du marché de l’emploi à l’ère de l’IA. (Source : Reddit r/ChatGPT)

Précision des LLM et problèmes d’hallucination : Des utilisateurs partagent les hallucinations et les inexactitudes de ChatGPT dans des tâches de calcul de base, par exemple, effectuant des “calculs mentaux” et donnant des résultats erronés après avoir écrit un code correct, ou “ignorant les fichiers CSV”, entraînant des sorties complètement fausses. Cela met en évidence les limites des LLM en matière de vérification des faits et de traitement des données, incitant les utilisateurs à se tourner vers d’autres modèles. (Source : Reddit r/ChatGPT)

Détection et génération de contenu par l’IA : La communauté discute de la manière d’identifier le contenu généré par l’IA sur Reddit, y compris des indices tels que des publications recevant beaucoup d’interactions mais sans réponse de l’auteur original, ou l’utilisation d’un anglais trop formel. Parallèlement, des utilisateurs explorent comment utiliser la technologie de l’IA pour générer des revenus passifs, par exemple en générant du contenu en masse via l’IA et en le publiant sur plusieurs plateformes, reflétant l’impact de l’IA sur la création et la détection de contenu. (Source : Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Performance de l’IA dans le trading de crypto-monnaies : Des expériences de trading de modèles d’IA sur le marché des crypto-monnaies montrent que les modèles chinois (Qwen 3, DeepSeek) se distinguent, Qwen 3 voyant ses bénéfices exploser de près de 60%, et DeepSeek réalisant des bénéfices stables de 20 à 30%. En revanche, GPT-5 et Gemini ont subi de lourdes pertes, révélant les différences de stratégie et de performance des différents modèles d’IA sur le marché réel, et suscitant des discussions sur les stratégies de trading et la “personnalité” de l’IA. (Source : 36氪, op7418, teortaxesTex, huybery)

Performance et expérience utilisateur des assistants de code AI : Les utilisateurs louent l’efficacité exceptionnelle de Haiku 4.5 dans Claude Code, estimant qu’il a considérablement accéléré le développement d’applications, rendant même Claude Sonnet superflu. Parallèlement, les utilisateurs appellent à l’ajout d’un bouton “Terminer immédiatement” à ChatGPT 5 Pro pour résoudre le problème des réponses trop longues du modèle qui ne peuvent être interrompues sans perdre le contenu, reflétant le besoin continu d’optimisation de l’expérience utilisateur des LLM. (Source : Reddit r/ClaudeAI, sjwhitmore)

Auto-correction et surveillance des agents AI : Inspiré par le cadre ACE de Stanford, un utilisateur a écrit un script de rôle “architecte” pour Claude, lui permettant de s’auto-corriger et de déboguer son propre code. Parallèlement, LangSmith Insights Agent fournit des informations sur les modèles de comportement et les problèmes potentiels en analysant les trajectoires des agents utilisateurs par clustering, simplifiant ainsi l’analyse et le débogage des données d’applications AI à grande échelle. (Source : Reddit r/ClaudeAI, HamelHusain, hwchase17)

Évaluation des modèles d’IA et défis de développement : La communauté estime que le nombre actuel de modèles d’IA est trop élevé mais qu’il manque d’évaluation efficace, nécessitant urgemment des benchmarks standardisés. De plus, des discussions portent sur la nécessité de tester automatiquement les opérateurs et leurs effets de gradient, ainsi que sur l’incident où un système de détection d’armes par IA a confondu un sac de chips avec une arme, ce qui met en évidence les défis de sécurité, de biais et de robustesse de l’IA lors de son déploiement réel. (Source : Dorialexander, shxf0072, colin_fraser)

Licenciements et flux de talents dans l’industrie de l’IA : Le laboratoire de super-intelligence de Meta a licencié 600 personnes, y compris l’équipe de Tian Yuandong, suscitant des questions internes sur le moment des licenciements et l’idée d’être “jeté après usage” après l’entraînement de Llama 4.5. Tian Yuandong a clarifié qu’il n’avait pas participé à Llama 4 et a souligné que les licenciements affectaient les applications produit et les postes interfonctionnels, soulignant la turbulence et la rotation des talents au sein du département AI de Meta. (Source : 量子位, Yuchenj_UW)

Éthique et originalité de l’IA dans la recherche : Une étude a révélé qu’après une analyse approfondie, seulement 24% des articles de recherche rédigés par l’IA présentaient du plagiat. Ce résultat est considéré comme “étonnamment bon”, suscitant des discussions sur la qualité et l’originalité de la recherche générée par l’IA, ainsi que sur ses implications potentielles pour le monde universitaire. (Source : paul_cal)

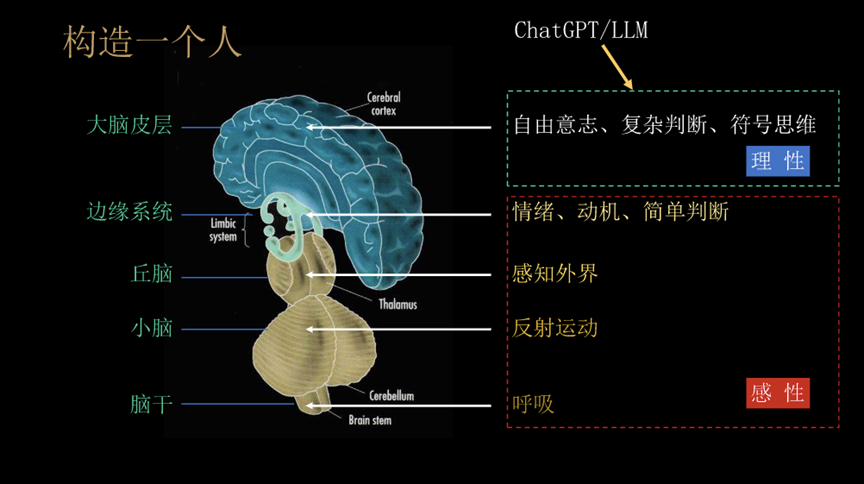

Exploration philosophique de l’AGI et de l’avenir de l’humanité : Le professeur Liu Jia de l’Université Tsinghua a partagé 10 points de vue sur l’évolution de l’AGI, le développement des agents et les défis futurs pour l’humanité. Il a exploré les caractéristiques de l’AGI telles que le “changement de tâche” et les “stratégies dynamiques en environnement ouvert”, l’impact social de l’IA dotée de chaleur émotionnelle et de conscience, ainsi que la possibilité d’un avenir où l’homme et la machine fusionnent ou où l’humanité disparaît, suscitant une réflexion philosophique sur l’impact profond de l’IA. (Source : 36氪)

Qualité d’écriture de Kimi et concurrence avec OpenAI : Roon, un employé d’OpenAI, a déclaré que Kimi K2 excelle en écriture, suscitant des discussions au sein de la communauté sur les capacités d’écriture des modèles chinois et l’attitude d’OpenAI. La communauté spécule que Kimi K2 pourrait avoir été entraîné sur un grand nombre de livres protégés par le droit d’auteur, que sa personnalité non “flatteuse” est appréciée des utilisateurs, et qu’il excelle dans la traduction de langues spécifiques et la compréhension contextuelle, contrastant avec le sentiment de “castration” de ChatGPT 5. (Source : Reddit r/LocalLLaMA, bookwormengr)

Produits et tendances de développement de l’IA : Hacker News discute de sujets tels que la lenteur de l’outil AI Codex dans Zed, le taux d’erreur de 45% des fausses nouvelles générées par l’IA, et le licenciement de 600 employés AI par Meta. Ces discussions reflètent les défis du développement et de l’utilisation de l’IA, y compris les performances des outils, la précision de l’information et les ajustements stratégiques des grandes entreprises technologiques en matière d’investissement dans l’IA. (Source : Reddit r/artificial)

Discussion sur le modèle commercial des grands modèles nationaux : Des utilisateurs appellent Kimi et Qwen, ainsi que d’autres grands modèles nationaux, à adopter un modèle de tarification par abonnement, en se référant à la popularité de Claude, GPT et GLM 4.5. Cela reflète les attentes de la communauté concernant le modèle commercial des grands modèles nationaux, ainsi que les discussions sur la volonté des utilisateurs à payer et les stratégies de concurrence sur le marché. (Source : bigeagle_xd)

💡 Divers

SeaweedFS : un système de fichiers distribué haute performance : SeaweedFS est un système de fichiers distribué rapide et hautement évolutif, conçu pour stocker des milliards de fichiers. Il utilise une recherche de disque O(1), prend en charge le “cloud tiering”, Kubernetes, l’API S3, etc., et optimise le stockage des petits fichiers. Grâce à un serveur Master gérant les volumes et des serveurs Volume gérant les métadonnées des fichiers, il permet une haute concurrence et un accès rapide, adapté à divers besoins de stockage. (Source : GitHub Trending)

NVIDIA Isaac Sim : plateforme de simulation de robots AI : NVIDIA Isaac Sim est une plateforme de simulation open source basée sur NVIDIA Omniverse, utilisée pour développer, tester et entraîner des robots pilotés par l’IA. Elle prend en charge l’importation de divers formats de systèmes robotiques, utilise un moteur physique accéléré par GPU et le rendu RTX, et offre des flux de travail de bout en bout tels que la génération de données synthétiques, l’apprentissage par renforcement, l’intégration ROS et la simulation de jumeaux numériques, offrant un support complet pour le développement de robots. (Source : GitHub Trending)

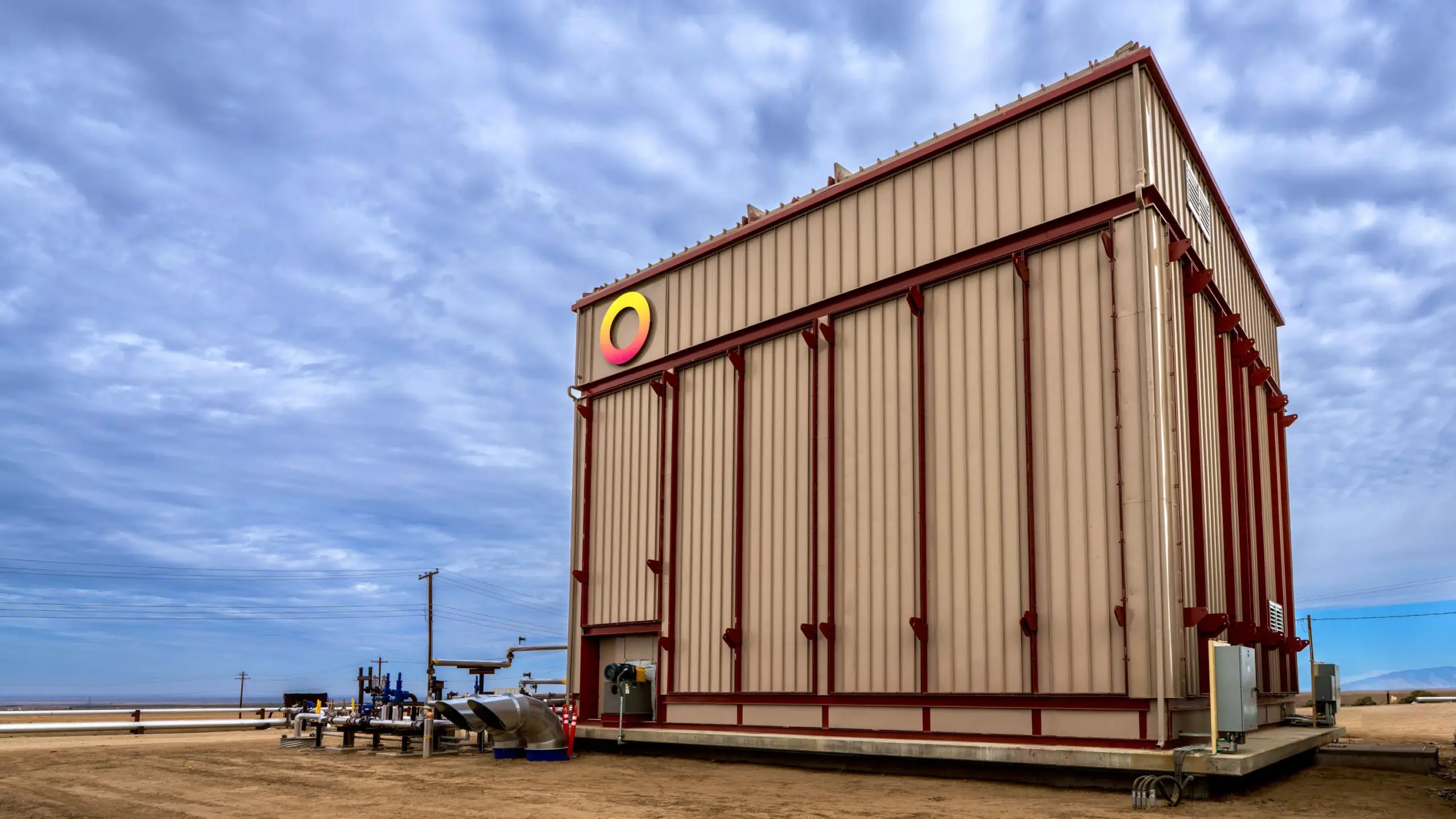

Rondo Energy lance la plus grande batterie thermique au monde : Rondo Energy a lancé ce qu’elle prétend être la plus grande batterie thermique au monde, capable de stocker de l’énergie électrique et de fournir une source de chaleur stable, ce qui devrait contribuer à la décarbonisation industrielle. Cette batterie thermique a une capacité de 100 mégawattheures et une efficacité de plus de 97%, et a fonctionné pendant 10 semaines en atteignant ses objectifs. Bien que son utilisation pour la récupération assistée de pétrole ait suscité la controverse, l’entreprise estime que cette initiative peut rendre plus propres les opérations existantes basées sur les combustibles fossiles, faisant progresser l’application des technologies de stockage d’énergie dans le secteur industriel. (Source : MIT Technology Review)