Mots-clés:Modèle de traduction IA, Concours de traduction automatique, Ali International IA, Marco-MT-Algharb, WMT, Optimisation des préférences multi-étapes, Modèle open source, Performances de traduction anglais-chinois, Technique d’optimisation M2PO, Comparaison avec Gemini 2.5 Pro, Paradigme d’apprentissage par renforcement, Évaluation des capacités de traduction universelle

Voici la traduction de votre contenu en français, en respectant toutes vos exigences :

🔥 FOCALISATION

Le modèle de traduction AI Marco d’Alibaba International domine le concours de traduction automatique WMT : Le grand modèle de traduction Marco-MT-Algharb d’Alibaba International AI Business a remporté 6 titres de champion, 4 deuxièmes places et 2 troisièmes places au concours international de traduction automatique WMT 2025. En particulier pour la traduction de l’anglais vers le chinois, Marco-MT a surpassé tous les systèmes d’AI propriétaires de pointe tels que Gemini 2.5 Pro et GPT-4.1, atteignant la première place et marquant son entrée dans les rangs des leaders mondiaux en matière de capacités de traduction universelles. Le modèle utilise l’optimisation des préférences multi-étapes (M2PO) combinée au paradigme de l’apprentissage par renforcement pour améliorer la qualité et la précision de la traduction, et a été rendu open source pour la communauté. (Source : 量子位)

OpenAI acquiert l’équipe Sky, l’interface en langage naturel pour Mac : OpenAI a annoncé l’acquisition de Software Applications Incorporated, l’équipe de développement de Sky, l’interface en langage naturel pour Mac. Cette démarche vise à intégrer l’expérience innovante de Sky dans ChatGPT, améliorant ainsi ses capacités d’application dans les environnements de bureau et concrétisant davantage la vision de contrôler les ordinateurs par le langage naturel. L’intégration de l’équipe Sky devrait accélérer les progrès de ChatGPT en matière d’interactions multimodales et au niveau du système d’exploitation. (Source : zachtratar, nickaturley, sama)

Anthropic et Google s’associent pour un million de TPU : Anthropic a annoncé l’extension de sa collaboration avec Google, prévoyant d’acquérir environ un million de TPU Google et plus d’un gigawatt de capacité de calcul d’ici 2026. Ce partenariat à grande échelle souligne l’énorme besoin d’Anthropic en matière de formation de modèles AI et reflète la puissance de Google dans le domaine des infrastructures AI, ce qui accélérera le développement des deux parties dans les technologies AI de pointe. (Source : AnthropicAI, cloneofsimo, JeffDean, arohan)

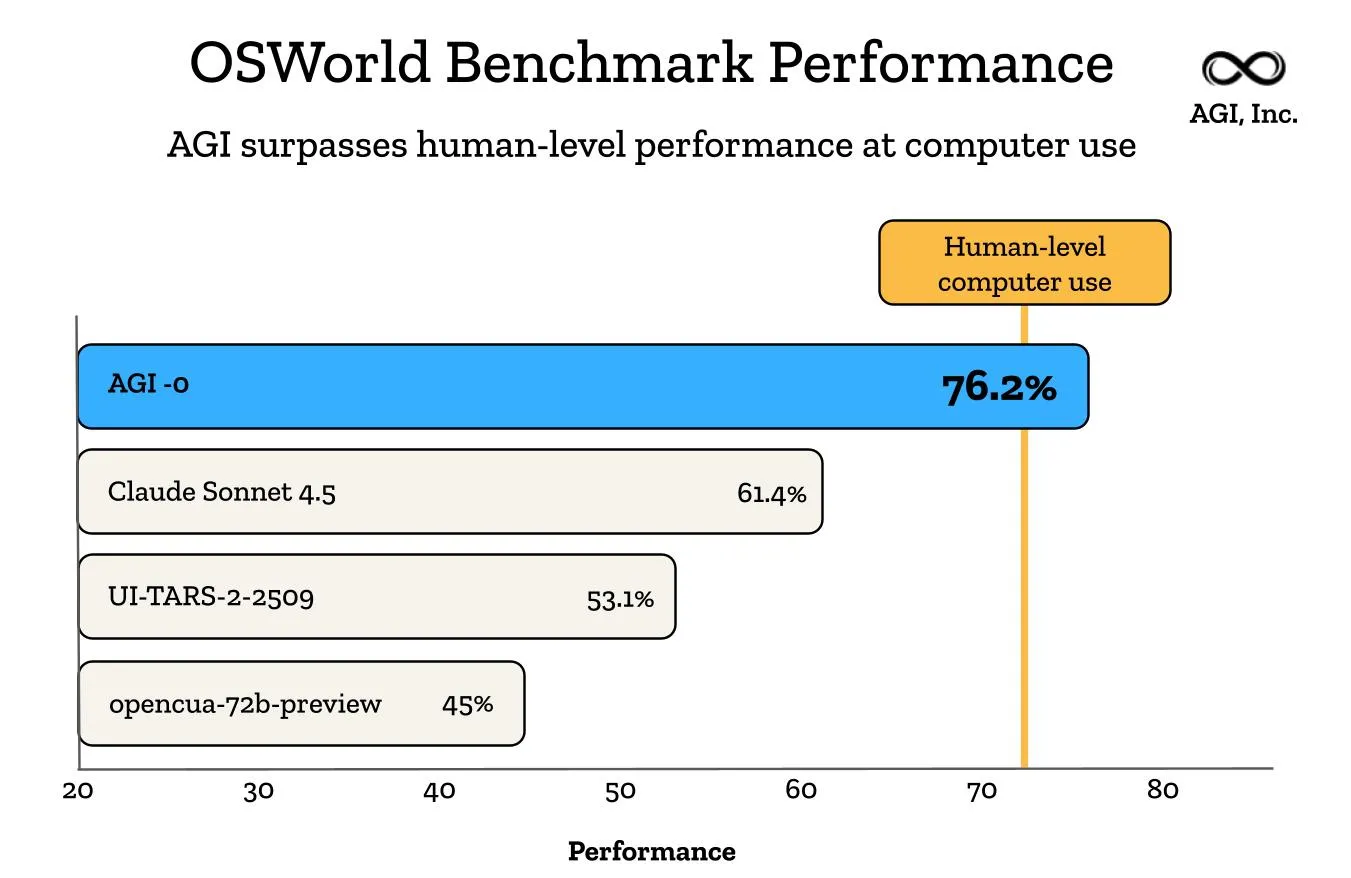

L’agent agi-0 d’AGI Inc. atteint des performances surhumaines en utilisation informatique universelle : AGI Inc. a annoncé que son agent agi-0 a atteint un niveau surhumain sur le benchmark OSWorld-Verified, devenant le premier agent à réaliser des performances surhumaines en utilisation informatique universelle sur Linux, macOS et Windows. Cela marque une étape importante vers l’« AGI quotidienne », où les agents AI pourront vivre et agir de manière transparente sur tous les appareils. (Source : JvNixon)

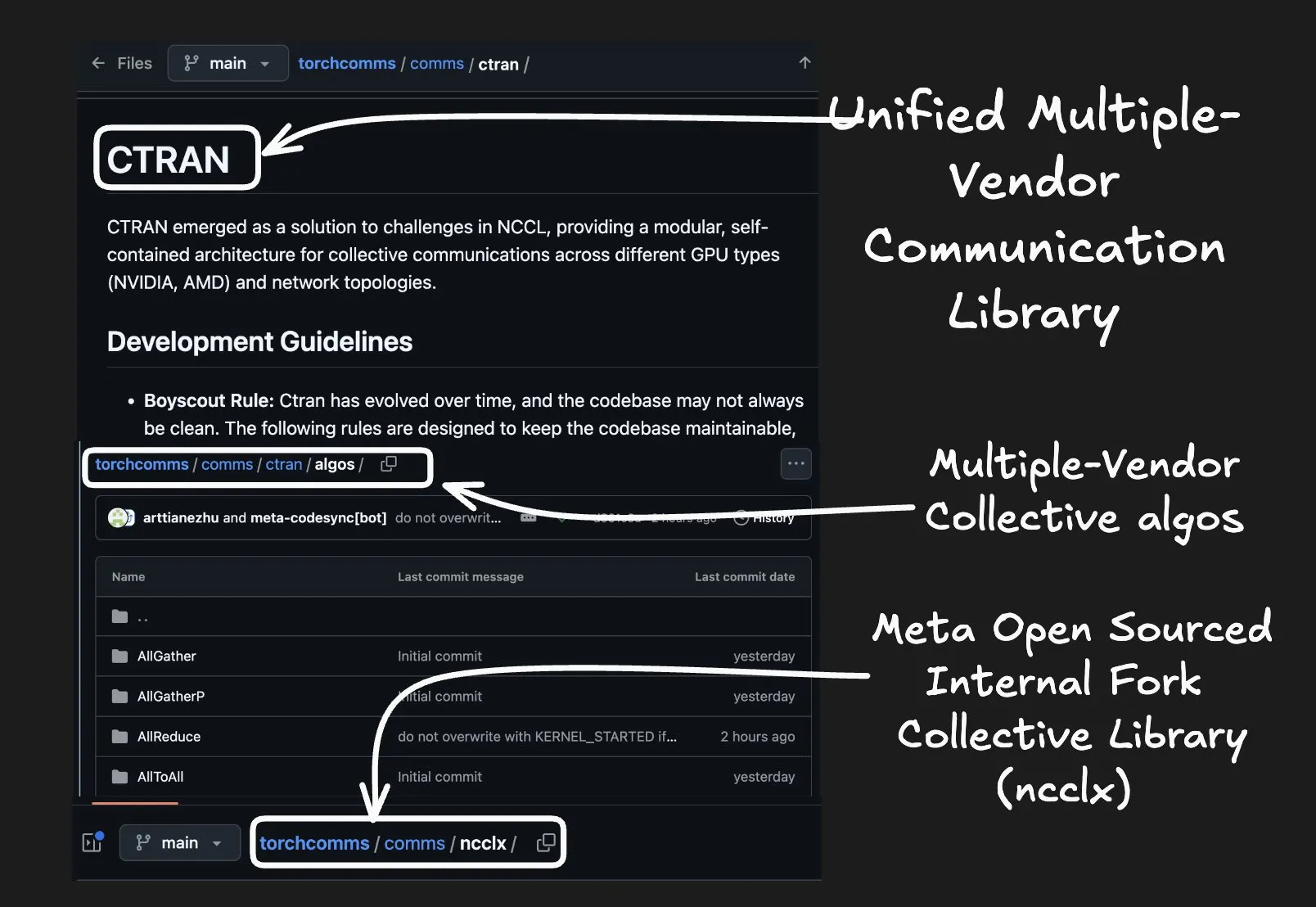

Meta rend open source sa bibliothèque CTran, compatible avec les GPU AMD et NVIDIA : Meta a rendu open source sa bibliothèque CTran, une bibliothèque de communication unifiée qui prend en charge nativement les GPU AMD et NVIDIA, visant à résoudre les problèmes de compatibilité lors de la collaboration multi-GPU. Cette initiative défie la position de leader de NVIDIA NCCL dans le domaine des bibliothèques de communication collective, et, grâce à un modèle de gouvernance ouvert et un développement axé sur GitHub, elle favorise le partage de code et la concurrence innovante entre les types de GPU AI. (Source : QuixiAI)

🎯 TENDANCES

General Motors intégrera l’assistant AI de Google et un système de conduite mains libres : General Motors prévoit de lancer une série de nouvelles fonctionnalités logicielles au cours des trois prochaines années, y compris un assistant AI embarqué alimenté par Google Gemini AI, qui sera déployé dès l’année prochaine, et prévoit de lancer un système d’aide à la conduite “mains libres, sans surveillance visuelle” d’ici 2028, visant à transformer les voitures en assistants intelligents. (Source : 36氪)

Microsoft Edge lance le mode Copilot : Le navigateur Microsoft Edge a officiellement lancé le mode Copilot, transformant le navigateur en un compagnon intelligent dynamique. Les nouvelles fonctionnalités incluent “Journeys” qui résume l’historique de navigation et suggère les prochaines actions, ainsi que “Copilot Actions” qui permet à Edge d’effectuer des tâches multi-onglets comme les réservations ou les achats avec l’autorisation de l’utilisateur, visant à améliorer l’expérience utilisateur en ligne grâce à l’innovation AI. (Source : mustafasuleyman, yusuf_i_mehdi)

Anthropic Claude lance la fonction “Mémoire” : Anthropic Claude a lancé la fonction “Mémoire” pour les utilisateurs Pro et Max, permettant au modèle d’apprendre les habitudes de travail de l’utilisateur, les outils fréquemment utilisés et les préférences de résolution de problèmes, accumulant ainsi des connaissances au fil des conversations. Les utilisateurs peuvent contrôler, modifier ou réinitialiser librement le contenu de la mémoire de Claude, garantissant la confidentialité et la précision du contexte de travail personnalisé pour une expérience de collaboration AI plus cohérente. (Source : mikeyk, Reddit r/ClaudeAI)

OpenAI annonce l’extension des projets partagés ChatGPT à tous les utilisateurs : OpenAI a annoncé que la fonction de projets partagés de ChatGPT sera étendue à tous les utilisateurs gratuits, Plus et Pro. Cela signifie que les utilisateurs pourront inviter d’autres personnes à travailler ensemble dans ChatGPT, partageant chats, fichiers et instructions, pour une collaboration d’équipe et une co-création de contenu plus pratiques. (Source : openai)

L’équipe de Jia Jiaya de HKUST rend open source le modèle DreamOmni2 : L’équipe de Jia Jiaya de HKUST a rendu open source le modèle DreamOmni2, réalisant des avancées significatives dans l’édition et la génération d’images multimodales basées sur des instructions. Basé sur FLUX Kontext, ce modèle peut traiter plusieurs images de référence pour une édition et une génération précises de concepts abstraits (tels que la lumière, l’ombre, le style de pinceau) et d’objets spécifiques, surpassant Google Nano Banana et égalant les performances de GPT-4o dans plusieurs tests. (Source : 36氪)

L’émergence du nouveau modèle social de vidéo AI de Sora App : Sora App, grâce à ses fonctionnalités sociales uniques (Cameo, Remix) et son mécanisme d’invitation, a rapidement atteint la première place des applications gratuites de l’App Store américain après son lancement. Sora App n’est pas seulement un outil de génération de vidéo, mais construit également un “data flywheel + réseau social” à double fossé concurrentiel en reliant la “capacité du modèle → scénario utilisateur → monétisation commerciale”, annonçant une nouvelle ère pour la vidéo sociale AI. (Source : 36氪)

OpenAI lance le navigateur ChatGPT Atlas, défiant le secteur de la recherche de Google : OpenAI a lancé le navigateur ChatGPT Atlas, visant à bouleverser les modèles de recherche traditionnels en répondant directement et en exécutant les intentions des utilisateurs. Ce navigateur alimenté par l’AI ne fournira plus de pages de résultats de recherche traditionnelles, mais satisfera directement les besoins des utilisateurs, posant un défi direct au modèle de revenus de Google basé sur la publicité de recherche, et annonçant une confrontation entre l’« internet indexé par la publicité » et l’« internet intelligent par abonnement ». (Source : 36氪)

Google Earth AI s’étend à l’échelle mondiale, ajoutant des capacités de raisonnement géospatial : Google Earth AI a étendu ses modèles et ensembles de données AI géospatiaux à l’échelle mondiale, et a ajouté des capacités de raisonnement géospatial alimentées par Gemini. Cette technologie peut connecter automatiquement divers modèles Earth AI tels que les prévisions météorologiques, les cartes de population et les images satellite pour répondre à des questions géographiques complexes, comme l’identification des proliférations d’algues nuisibles, fournissant un soutien pour la surveillance et l’alerte environnementales. (Source : Google, JeffDean)

🧰 OUTILS

LangChain lance LangSmith Insights Agent et Multi-turn Evals : LangChain a introduit deux nouvelles fonctionnalités dans sa plateforme d’ingénierie d’agents LangSmith : Insights Agent et Multi-turn Evals. Insights Agent classifie automatiquement les modèles de comportement des agents, offrant des informations sur les habitudes d’utilisation des utilisateurs et les erreurs potentielles ; Multi-turn Evals permet d’évaluer si un agent atteint les objectifs de l’utilisateur sur des trajectoires de conversation complètes, améliorant considérablement la compréhension du comportement des agents et l’efficacité du débogage. (Source : LangChainAI, hwchase17)

OpenEnv lance un environnement RL de pointe, renforçant la communauté open source : Meta et Hugging Face ont collaboré pour lancer OpenEnv, offrant à la communauté open source un environnement d’apprentissage par renforcement (RL) de pointe. OpenEnv utilise une API de style Gymnasium, prend en charge l’exécution d’environnements RL dans des conteneurs et fournit un accès HTTP pour l’entraînement distribué, visant à ouvrir une infrastructure RL puissante à tous pour promouvoir la recherche reproductible sur les agents. (Source : eliebakouch, LoubnaBenAllal1, danielhanchen, huggingface, _lewtun)

AutoPage : un système de collaboration humain-agent pour générer des pages web de publications : AutoPage est un système multi-agents innovant qui convertit automatiquement des articles académiques en pages web de projets interactives, pour un coût inférieur à 0,1 dollar. Il utilise la planification narrative, la génération de contenu multimodal et un agent “Checker” spécialisé pour la validation, garantissant que le produit final est conforme à la vision de l’auteur, transformant le processus de publication d’articles d’une tâche répétitive en une collaboration efficace. (Source : HuggingFace Daily Papers)

Corridor lance une couche de sécurité pour le codage AI : Corridor a lancé sa couche de sécurité pour le codage AI, conçue pour offrir une protection de sécurité en temps réel pour le codage assisté par AI. Cet outil applique des mesures de protection de sécurité, aidant les développeurs à garantir la sécurité du code tout en construisant rapidement des applications AI, et à gérer efficacement les vulnérabilités potentielles que le codage AI pourrait introduire. (Source : jefrankle)

Différences de positionnement produit entre Quark Dialogue Assistant et Doubao Large Model : Quark Dialogue Assistant et Doubao Large Model présentent des stratégies de concurrence différenciées en termes de positionnement produit. Quark se concentre davantage sur les LLM de type outil “hardcore”, offrant des fonctions de recherche approfondie, de traitement de documents et de recherche de solutions par photo, visant à résoudre efficacement les problèmes pratiques des utilisateurs dans l’apprentissage, la vie et le travail ; tandis que Doubao est plus orienté vers le divertissement, intégrant des fonctions de courtes vidéos, de retouche photo et de portraits AI, explorant les moyens d’accéder à l’information de divertissement à l’ère de l’AI. (Source : 36氪)

Claude Code prend en charge la fonction de téléchargement d’images : Claude Code prend désormais en charge la fonction de téléchargement d’images, ce qui améliore considérablement l’efficacité des développeurs lors des itérations front-end. Cette fonctionnalité est largement saluée par la communauté des développeurs pour sa capacité à réduire le temps d’écriture de code d’infrastructure cloud de plusieurs heures à quelques minutes, renforçant ainsi l’utilité de Claude Code dans le domaine de la programmation assistée par AI. (Source : kanjun, halvarflake)

Google AI Studio lance le mode Annotation : Google AI Studio a lancé le mode Annotation, permettant aux utilisateurs d’annoter n’importe quelle interface utilisateur avec de simples outils de dessin, puis de laisser Gemini exécuter directement ces modifications dans le code. Cette fonctionnalité vise à simplifier le processus de développement d’applications, rendant l’expérience de construction plus intuitive et efficace, et réduisant la barrière entre l’intention de conception et l’implémentation réelle du code. (Source : osanseviero)

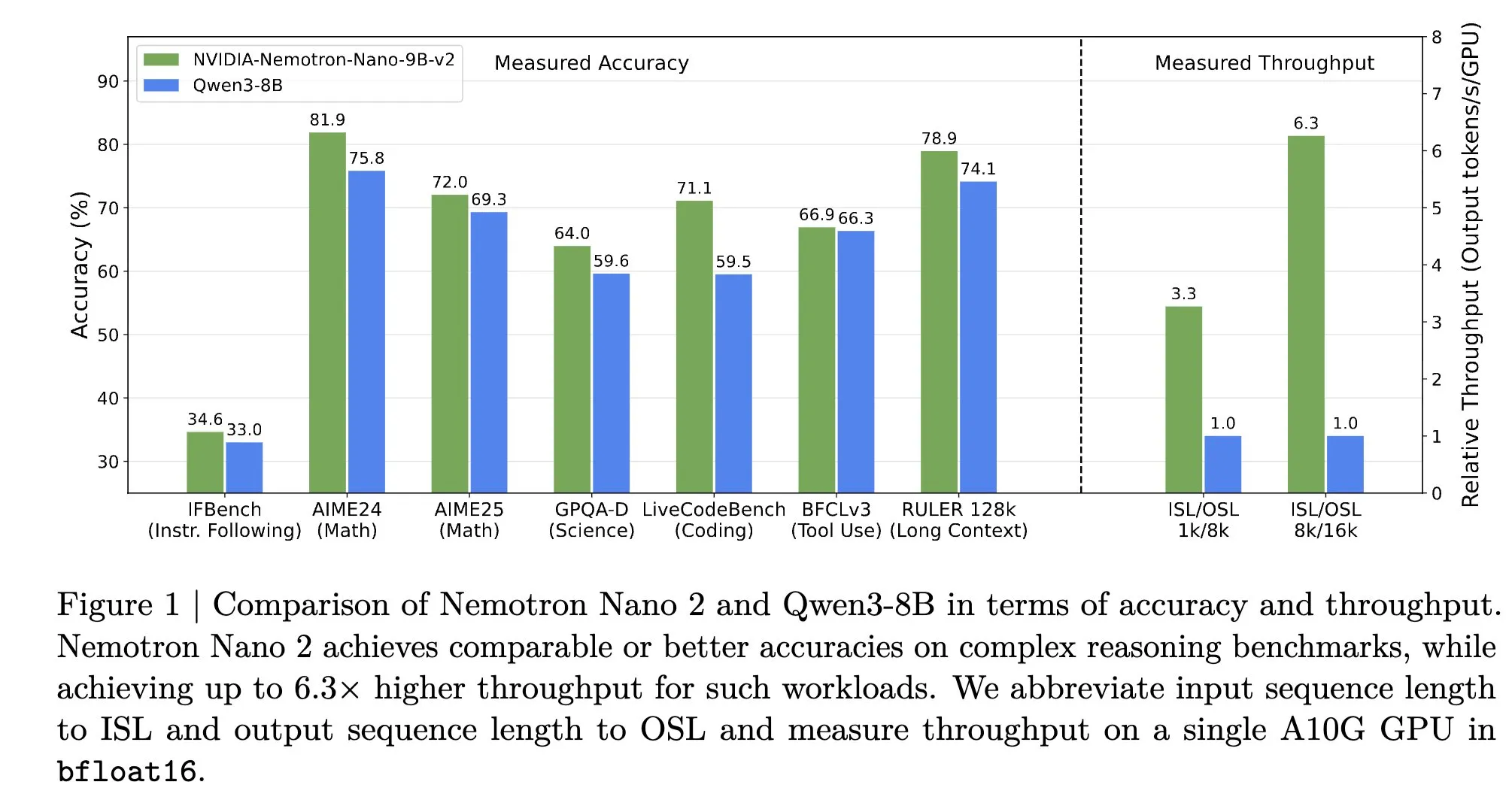

vLLM et NVIDIA collaborent pour optimiser l’inférence des modèles Nemotron : Le projet vLLM et NVIDIA ont renforcé leur collaboration pour fournir un service d’inférence efficace pour la série de modèles NVIDIA Nemotron. Ce partenariat vise à réaliser une inférence d’agents ouverte, de haute précision, reproductible et prête pour la production dans les centres de données et les appareils périphériques. Grâce à vLLM, le modèle Nemotron Nano 2 est 6 fois plus rapide que les modèles comparables pour la génération de tokens “Thinking” critiques, et utilise la fonction “Thinking Budget” pour optimiser les coûts d’inférence. (Source : vllm_project)

📚 APPRENTISSAGE

Qdrant Academy officiellement lancée pour améliorer les compétences en recherche vectorielle : Qdrant Academy a été officiellement lancée, offrant une série de cours interactifs visant à aider les utilisateurs à apprendre et à maîtriser en profondeur les compétences en recherche vectorielle. Grâce à ces cours, les développeurs et les scientifiques des données peuvent améliorer leurs capacités d’application sur la plateforme Qdrant et mieux utiliser la technologie de recherche vectorielle pour résoudre des problèmes réels. (Source : qdrant_engine)

Programme de la conférence AI Dev 25 x NYC publié : La conférence AI Dev 25 x NYC a publié son programme complet et la liste de ses conférenciers, couvrant des domaines clés du développement AI tels que Agentic Architecture, Context Engineering, Infrastructure, Production Readiness et Tooling. La conférence réunira des experts de Google, AWS, Vercel, Mistral AI et d’autres entreprises pour partager leurs expériences et leurs idées sur la construction de systèmes AI de niveau production. (Source : AndrewYNg, DeepLearningAI)

À l’ère de l’AI, les développeurs doivent posséder de solides compétences en communication : Jeff Barr, vice-président et évangéliste en chef d’Amazon Web Services, a souligné qu’à l’ère de l’AI, les développeurs les plus performants doivent posséder de solides compétences en communication. Il a présenté le mode de “développement piloté par les spécifications” pris en charge par l’outil Kiro d’Amazon Web Services, où les développeurs collaborent avec des agents AI pour écrire des spécifications plutôt que de coder ligne par ligne, et a prédit que le code futur sera “jetable”, tandis que les données et les spécifications auront une plus grande persistance. (Source : 36氪)

Tutoriel de transcription et traduction audio allemande avec le modèle Gemma 3n : Un tutoriel détaillé montre comment affiner le modèle Gemma 3n pour transcrire et traduire l’audio allemand, réalisant un traitement de bout en bout. Ce tutoriel résout le problème des capacités multimodales de Gemma 3n, bien que puissantes, mais insuffisantes pour la transcription de langues spécifiques (comme l’allemand), offrant aux développeurs un guide pratique pour optimiser les LLM pour des tâches linguistiques spécifiques. (Source : Reddit r/deeplearning)

Guide complet des LLM LangChain publié : Un guide complet sur les LLM LangChain a été publié, couvrant des concepts fondamentaux à l’intégration multi-fournisseurs, expliquant en détail les différences entre BaseLLM et ChatModels, le contrôle des paramètres d’inférence, la gestion des clés API et l’intégration HuggingFace, ainsi que d’autres connaissances clés. Ce guide vise à aider les développeurs à comprendre en profondeur les couches d’abstraction de LangChain et à basculer facilement entre différents fournisseurs de LLM. (Source : Reddit r/deeplearning)

Tutoriel pour construire un agent AI à partir de zéro : Un tutoriel pour construire un agent AI à partir de zéro a été publié, expliquant en profondeur les concepts fondamentaux tels que les invites système, les appels de fonctions, la gestion de la mémoire et le modèle ReAct à travers 8 exemples JavaScript progressifs. Ce tutoriel vise à aider les développeurs à contourner la boîte noire des frameworks et à comprendre le fonctionnement interne des agents AI, afin de mieux déboguer et innover. (Source : Reddit r/LocalLLaMA)

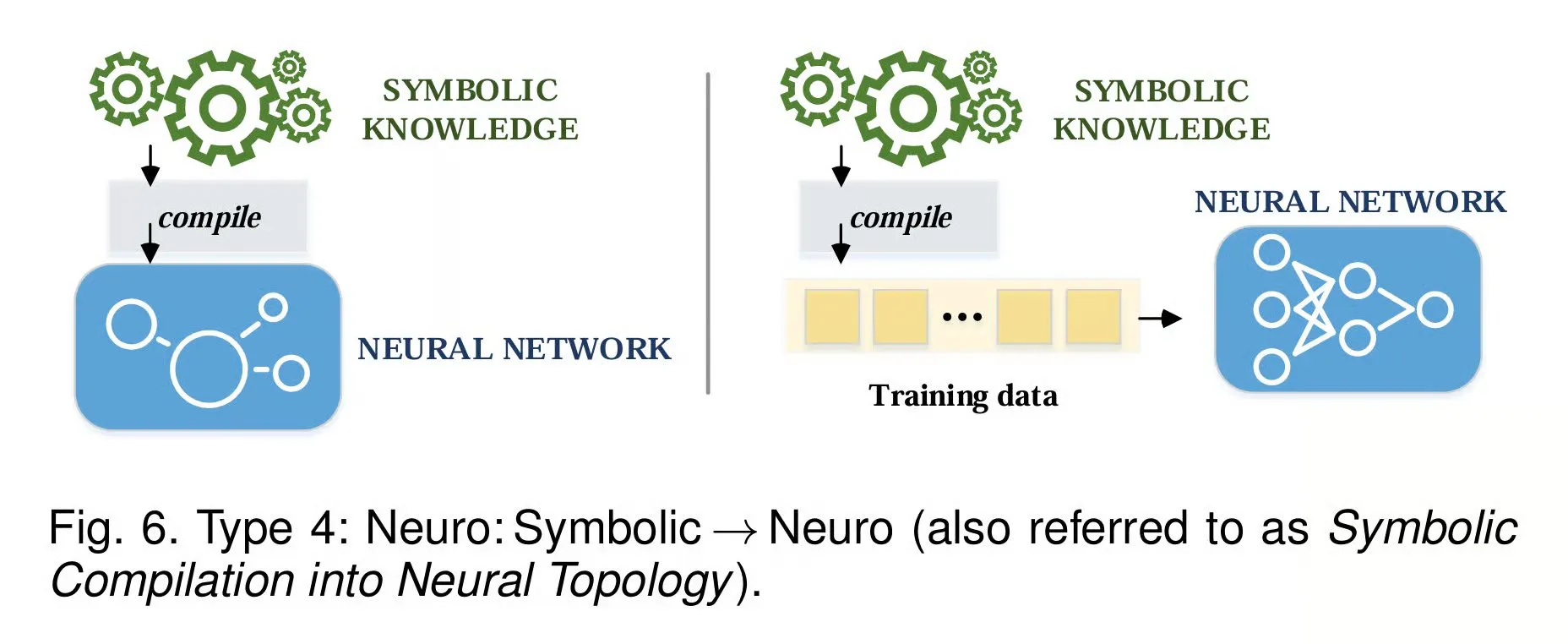

Progrès de la recherche en AI neuro-symbolique et Tensor Logic : L’AI neuro-symbolique est considérée comme la prochaine étape de l’évolution de l’AI, combinant la reconnaissance de formes des réseaux neuronaux avec les capacités de raisonnement logique du raisonnement symbolique, promettant un raisonnement plus proche de l’humain, comme la percée d’AlphaGeometry 2 sur les problèmes de géométrie de l’IMO. Parallèlement, Tensor Logic propose un cadre unifiant tous les langages de programmation AI, exprimant les règles logiques comme des opérations tensorielles, visant à fournir une base de raisonnement mathématique pour les LLM. (Source : TheTuringPost, TheTuringPost)

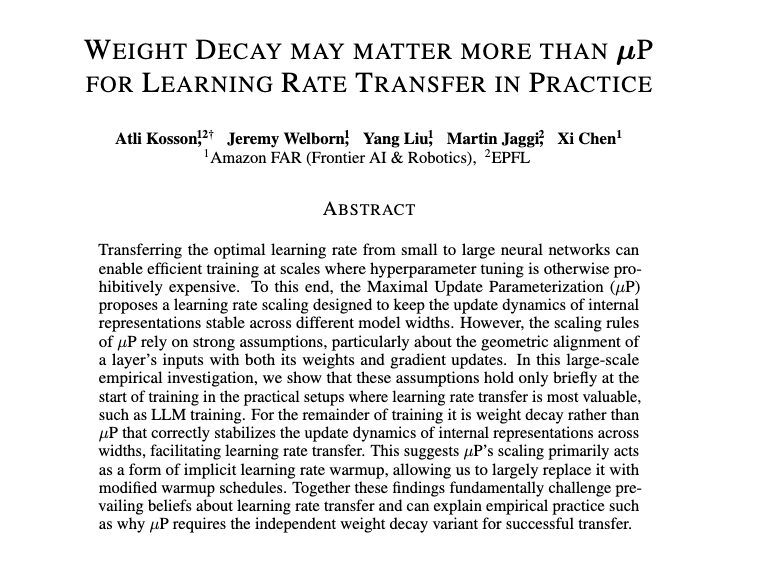

Recherche sur l’optimisation et l’amélioration de l’efficacité des LLM : Le domaine de l’AI a réalisé plusieurs avancées en matière d’optimisation et d’amélioration de l’efficacité des LLM. Des recherches ont exploré la migration du taux d’apprentissage des petits aux grands modèles grâce à la combinaison de la décomposition de poids indépendante (IWD) et de la paramétrisation de mise à jour maximale (µP), optimisant la mise à l’échelle d’AdamW et améliorant la stabilité de l’entraînement. De plus, des méthodes d’optimisation des invites telles que Prompt-MII et l’entraînement conscient de la quantification 4 bits (QAT) d’Unsloth AI ont considérablement amélioré l’efficacité et les performances de l’entraînement des LLM. (Source : eliebakouch, giffmana, gneubig, Tim_Dettmers)

💼 AFFAIRES

OpenAI et Oracle s’associent pour construire le centre de données “Star Gate” : OpenAI, Oracle et Vantage Data Centers collaborent pour construire un campus de centre de données “Star Gate” d’une valeur de 15 milliards de dollars à Port Washington, Wisconsin. Ce projet fournira environ 1 gigawatt de puissance de calcul AI, devrait être achevé en 2028, et s’engage à utiliser 100 % d’énergie zéro émission, visant à consolider le leadership des États-Unis dans le domaine mondial de l’AI. (Source : 36氪)

Fal.ai dépasse les 4 milliards de dollars de valorisation, se concentrant sur l’infrastructure d’inférence de modèles AI : La société d’infrastructure AI Fal.ai a vu sa valorisation dépasser les 4 milliards de dollars en moins de 3 mois. Son PDG, Gorkem Yurtseven, a déclaré que l’entreprise se concentre sur la fourniture de services d’infrastructure d’inférence de modèles AI, plutôt que sur le développement de ses propres grands modèles. La plateforme Fal.ai héberge plus de 600 modèles et sert plus de 2 millions de développeurs, devenant un acteur clé de l’infrastructure des médias génératifs en optimisant la vitesse, la stabilité et le coût des appels de modèles. (Source : 36氪)

Ma Ji, ancien cadre de Xiaomi, lève près de 200 millions de yuans pour créer du matériel d’imagerie AI : Ma Ji, ancien cadre de Xiaomi, a fondé “Guangqi Zhijing” et a clôturé un tour de financement d’amorçage de 27 millions de dollars, mené conjointement par Honghui Fund, DHVGC et Shunwei Capital. L’entreprise vise à développer un matériel grand public d’imagerie AI, utilisant la technologie AI pour soulager les utilisateurs du fardeau de la composition, des paramètres et de la post-production dans la création photographique, leur permettant d’obtenir facilement des photos stylisées et de satisfaire leur besoin illimité de beauté. (Source : 36氪)

🌟 COMMUNAUTÉ

Les licenciements massifs au sein de la division AI de Meta suscitent un vif débat dans la communauté : La division AI de Meta a procédé à des licenciements massifs, affectant environ 600 personnes, dont le chercheur de FAIR, Tian Yuandong, et les membres de son équipe. Cette décision a provoqué de vastes discussions au sein de la communauté AI concernant le virage stratégique de Meta, les luttes de pouvoir internes et la fuite des talents AI. Plusieurs experts et entreprises du domaine de l’AI ont activement tendu la main aux chercheurs affectés, leur offrant de nouvelles opportunités d’emploi. (Source : 36氪, 36氪, LiamFedus, arena, scaling01, ShunyuYao12, arohan, suchenzang, glennko, slashML, eliebakouch, GuillaumeLample, yupp_ai, Reddit r/LocalLLaMA)

L’intensité de travail de type “course à l’armement” dans l’industrie AI suscite le débat : L’industrie AI traverse une “course à l’armement”, où les chercheurs et dirigeants de haut niveau travaillent 80 à 100 heures par semaine, visant à réaliser 20 ans de progrès scientifiques en deux ans. Ce mode de travail intense est comparé à une guerre, et bien qu’il ait conduit à des percées scientifiques extraordinaires, il soulève également des préoccupations quant à sa durabilité à long terme, l’équilibre travail-vie personnelle et l’impact sur la santé des employés. (Source : Reddit r/ArtificialInteligence)

La réalisation de l’AGI au 21e siècle divise la communauté : La communauté AI est largement divisée sur la question de savoir si l’intelligence artificielle générale (AGI) pourra être réalisée au 21e siècle. Certains estiment que les LLM actuels restent des systèmes de reconnaissance de formes avancés, manquant de véritable compréhension et de capacités d’apprentissage autonome, et que la réalisation de l’AGI nécessitera des percées fondamentales ; d’autres soulignent l’imprévisibilité des progrès dans le domaine de l’AI, estimant qu’avec l’itération rapide des technologies, l’arrivée de l’AGI pourrait dépasser les attentes. (Source : Reddit r/ArtificialInteligence)

L’éthique et la gouvernance de l’AI deviennent un sujet brûlant : L’éthique et la gouvernance de l’AI sont devenues un sujet de discussion majeur au sein de la communauté, incluant le projet de loi de l’Ohio interdisant le mariage humain-machine, l’impact de la réglementation AI californienne sur la fixation des prix, ainsi que les discussions sur la personnalité juridique de l’AI, la réglementation de la sécurité et l’initiative “Stop Superintelligence”. Ces discussions reflètent l’attention de la société aux risques potentiels et aux besoins de régulation apportés par le développement rapide de la technologie AI, et explorent comment trouver un équilibre entre innovation et sécurité. (Source : kylebrussell, kylebrussell, nptacek, JeffLadish, jonst0kes, jonst0kes, pmddomingos, Reddit r/artificial)

Le film “Will Hunting” interprété comme une métaphore de l’interaction AI-société : Un utilisateur de Reddit a interprété le film “Will Hunting” comme une métaphore de l’interaction entre la société et une AI superintelligente il y a 25 ans. Les personnages du film représentent différentes attitudes de l’académie, du gouvernement et des professionnels envers l’AI, tandis que le thérapeute joué par Robin Williams symbolise la méthode d’alignement de l’AI avec les valeurs humaines par l’empathie. Cette interprétation a suscité une profonde réflexion sur le choix de l’AI entre connaissance et sagesse, émotion et contrôle. (Source : Reddit r/ArtificialInteligence)

Les utilisateurs de ChatGPT se plaignent d’une censure et d’un filtrage trop stricts du modèle : De nombreux utilisateurs de ChatGPT se plaignent que les mécanismes de censure et de filtrage du modèle sont trop stricts, les empêchant d’identifier le contenu des images, de générer des éléments protégés par le droit d’auteur, et même de se retrouver dans une boucle de refus d’exécuter des instructions après plusieurs tentatives. Ce mécanisme de filtrage excessivement sensible a gravement affecté l’expérience utilisateur, suscitant le mécontentement des utilisateurs quant à l’utilité et la liberté du modèle. (Source : Reddit r/ChatGPT)

Pannes et dysfonctionnements récents des services ChatGPT et Claude AI : ChatGPT et Claude AI ont récemment connu des interruptions de service ou des dysfonctionnements, notamment une panne mondiale de ChatGPT, un bug de défilement du terminal de Claude et des problèmes de téléchargement de fichiers. Ces incidents ont suscité des inquiétudes chez les utilisateurs quant à la stabilité et la fiabilité des services AI, soulignant les défis auxquels sont confrontées les infrastructures AI face à une concurrence élevée et à des fonctionnalités complexes. (Source : Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/OpenWebUI)

Discussion continue sur l’impact de l’AI sur l’emploi : La discussion sur l’impact de l’AI sur l’emploi se poursuit. David Solomon, PDG de Goldman Sachs, estime que l’AI transformera plutôt que détruira les emplois humains, et s’en réjouit. Cependant, les discussions communautaires reflètent des inquiétudes quant au remplacement de l’humain par l’AI, ainsi que le besoin de nouvelles compétences et d’adaptabilité sur le futur marché du travail, soulignant l’incertitude que la technologie AI apporte au développement professionnel. (Source : Reddit r/artificial)

Les grandes entreprises comme Tencent recrutent activement des talents AI lors de la conférence ICCV 2025 : Lors de la conférence ICCV 2025, de grandes entreprises comme Tencent ont adopté un nouveau mode de “recrutement direct en conférence”, en recrutant activement des talents AI par le biais d’échanges sur place avec des dirigeants de secteurs clés et de programmes comme le “Plan Qingyun”. Cette initiative vise à capter les directions technologiques de pointe dès que possible et à attirer des talents possédant les dernières idées de recherche et une vision technologique, afin de prendre l’avantage dans la future compétition technologique. (Source : 量子位)

💡 AUTRES

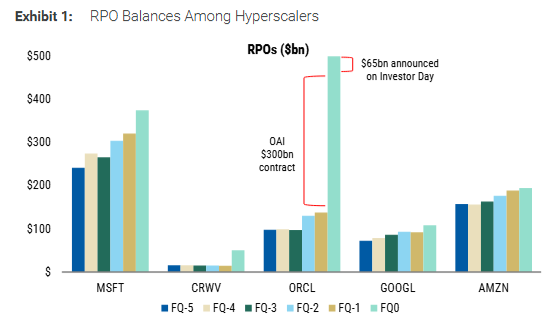

Morgan Stanley analyse le RPO, un indicateur clé des investissements en infrastructure AI : Morgan Stanley analyse que les obligations de performance restantes (RPO) sont devenues un indicateur prospectif clé pour mesurer les revenus futurs, la qualité de la croissance et les risques potentiels des investissements en infrastructure AI. En particulier chez des entreprises comme Oracle et Coreweave, le RPO a augmenté de manière significative, mais le rapport met en garde les investisseurs contre les risques de renégociation des contrats à long terme, les risques liés aux bénéfices et à l’exécution, ainsi que les problèmes de concentration des clients. (Source : 36氪)

CloudMinds Technology cotée à Hong Kong, transformation du marché des robots de service hôtelier : CloudMinds Technology est cotée à la Bourse de Hong Kong, devenant un leader dans le domaine des robots de service hôtelier. L’entreprise, en fournissant des robots pour des services répétitifs tels que la livraison et la désinfection, reflète la tendance de l’industrie des services chinoise à passer d’une main-d’œuvre intensive à une approche axée sur la technologie. Bien qu’elle soit confrontée à des défis de rentabilité et à une dépendance à une seule activité, son introduction en bourse apporte des fonds de R&D et des avantages en termes de canaux de marché pour l’industrie, annonçant que les services intelligents passeront des scénarios expérimentaux à la normalisation. (Source : 36氪)

Impact social du développement de la technologie AI sur la confiance interpersonnelle et les modèles de recrutement : L’impact social du développement de la technologie AI devient de plus en plus complexe, comme les comportements trompeurs potentiels lors des entretiens assistés par AI, et les changements potentiels dans la confiance interpersonnelle et les modèles de recrutement traditionnels avec la généralisation du travail à distance et des outils AI. Certains estiment que la popularité de l’AI pousse l’industrie à réaffirmer l’importance des interactions en face à face et de la “touche humaine” pour faire face au défi de la baisse de confiance dans l’environnement numérique. (Source : mitchellh, mitchellh, mitchellh)