Mots-clés:OpenAI, xAI, Modèles d’IA, Secrets commerciaux, Concurrence pour les talents, Sora 2, Centres de données, NVIDIA, Procès sur les secrets commerciaux entre OpenAI et xAI, Rédaction de thèse académique autonome par l’IA, Capacité de raisonnement multimodal de Sora 2, Projet de centre de données Stargate, Capitalisation boursière de NVIDIA dépasse 4 billions de dollars

🔥 Focus

OpenAI et xAI : l’escalade du litige sur les secrets commerciaux : OpenAI a fermement rejeté les accusations de vol de secrets commerciaux de xAI de Musk, les qualifiant d‘“intimidation” visant à effrayer les employés. OpenAI a nié avoir volé des secrets commerciaux et a affirmé que les départs d’employés de xAI étaient des problèmes internes, et non du débauchage. L’affaire, impliquant d’anciens ingénieurs de xAI comme Xuechen Li et Jimmy Fraiture accusés de fuites, ainsi qu’une controverse concernant le départ d’un ancien directeur financier, révèle l’intensification de la concurrence pour les talents et la technologie entre les géants de l’IA. (Source: 量子位, mckbrando)

L’IA rédige de manière autonome un article académique de 30 pages, incluant expériences et analyses : Un système d’IA nommé “Virtuous Machines” a rédigé de manière autonome un article académique de 30 pages dans le domaine de la psychologie cognitive en 17 heures, pour un coût de 114 dollars. Le système a géré l’ensemble du processus, du choix du sujet à la rédaction finale, en passant par la conception expérimentale (recrutement de 288 participants humains) et l’analyse des données. Il a cité plus de 40 références réelles et respecte le format APA. Cela démontre l’autonomie et la capacité de collaboration croissantes de l’IA dans les tâches de recherche complexes, malgré quelques imperfections comme des malentendus théoriques. (Source: 量子位)

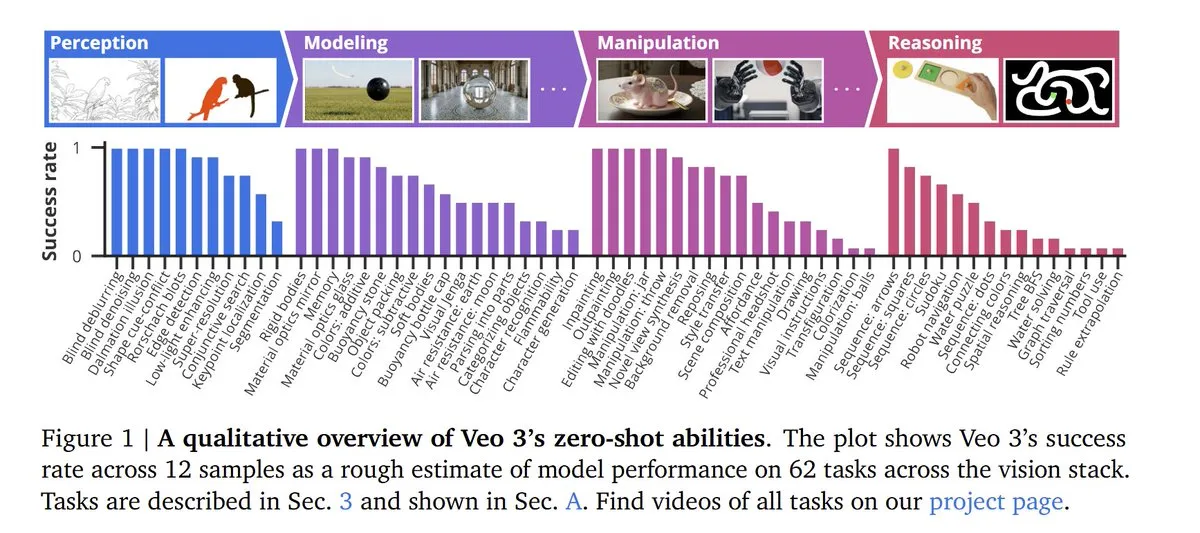

OpenAI Sora 2 démontre des capacités de raisonnement intermodal et une politique de compte stricte : OpenAI a lancé Sora 2, qui est non seulement un modèle phare de génération vidéo et audio, mais qui démontre également une capacité de raisonnement intermodal étonnante, obtenant un score de 55 % aux tests de référence LLM. Entraîné sur de vastes quantités de données vidéo, le modèle d’IA peut faire émerger des capacités de raisonnement visuel qui n’ont pas été explicitement entraînées. Les conditions d’utilisation de Sora 2 ont été mises à jour, soulignant la stricte association des comptes : une interdiction de Sora entraînera la suspension permanente du compte ChatGPT. (Source: dl_weekly, NerdyRodent, BlackHC, menhguin, Teknium1, Reddit r/LocalLLaMA)

OpenAI, Oracle et SoftBank lancent le projet de centre de données “Stargate” d’un billion de dollars : OpenAI, en collaboration avec Oracle et SoftBank, a annoncé le lancement d’un projet de construction de centre de données “Stargate” d’une valeur pouvant atteindre 1 000 milliards de dollars, visant à déployer une capacité de 20 gigawatts à l’échelle mondiale. Oracle sera responsable de la construction, et NVIDIA fournira 31 000 GPU et s’est engagé à investir 100 milliards de dollars dans OpenAI. Cela marque un investissement et une expansion sans précédent dans le domaine de l’infrastructure de l’IA. (Source: DeepLearningAI)

🎯 Tendances

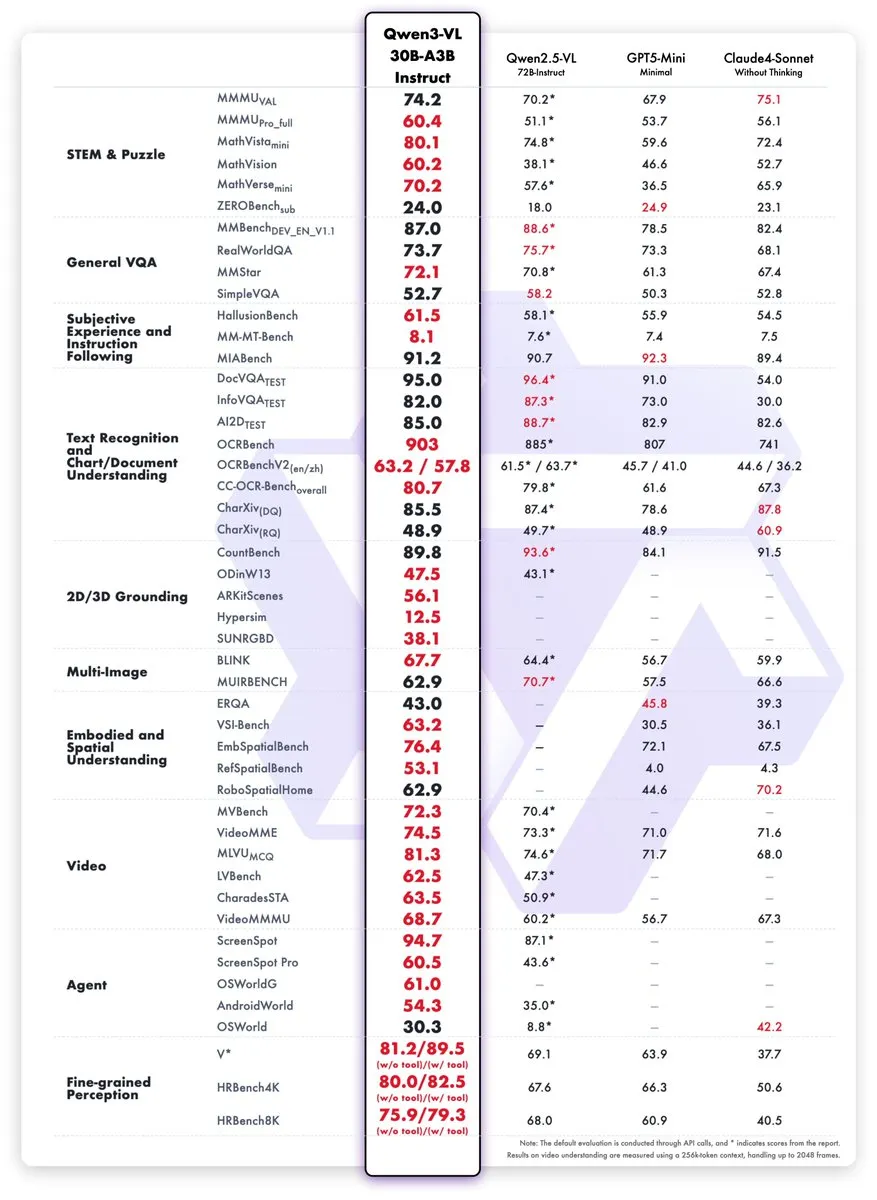

Nouveaux modèles Qwen3-VL lancés, performances comparables à GPT-5 Mini : L’équipe Qwen a lancé les modèles Qwen3-VL-30B-A3B-Instruct et Thinking. Ces petits modèles (3 milliards de paramètres actifs) démontrent des performances équivalentes, voire supérieures, à celles de GPT-5 Mini et Claude4-Sonnet pour les tâches STEM, VQA, OCR, vidéo et Agent. Une version FP8 est également disponible, visant à améliorer l’efficacité d’exécution des applications d’IA multimodales. (Source: mervenoyann, slashML, reach_vb)

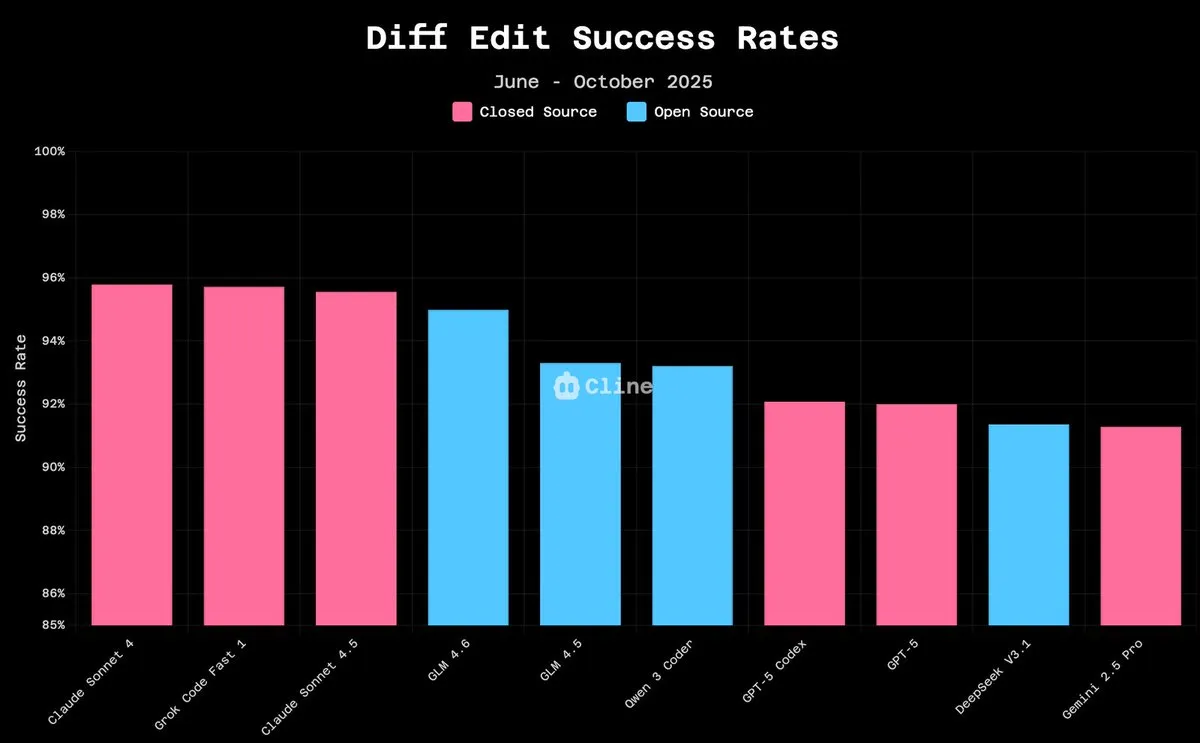

GLM-4.6 excelle dans l’arène LLM, les modèles open source rattrapent rapidement leur retard : GLM-4.6 s’est classé quatrième dans l’arène LLM, et deuxième après la suppression du contrôle de style, démontrant des performances puissantes. Dans les tâches d’édition de code, le taux de réussite de GLM-4.6 approche celui de Claude 4.5 (94,9 % contre 96,2 %), pour un coût de seulement 10 %. Des modèles open source comme Qwen3 Coder et GLM-4.5-Air peuvent désormais fonctionner sur du matériel grand public, ce qui indique que les modèles d’IA open source améliorent rapidement leurs performances et réduisent les barrières à l’utilisation. (Source: teortaxesTex, teortaxesTex, Tim_Dettmers, Teknium1, Teknium1, _lewtun, Zai_org)

Kinetix AI lance le contrôle de caméra à perception 3D par IA, révolutionnant la création vidéo : Kinetix AI a introduit un contrôle de caméra à perception 3D basé sur l’IA, offrant des panoramiques, des gros plans et des mouvements de caméra dynamiques, tout en assurant la cohérence de la profondeur, de la physique et de la continuité. Cette avancée permet aux créateurs de réaliser des narrations de qualité cinématographique sans avoir besoin d’équipes ou d’équipements professionnels. Elle devrait être appliquée à la production de films indépendants, à la publicité immersive et à la création de récits de marque, transformant le langage cinématographique en logiciel. (Source: Ronald_vanLoon)

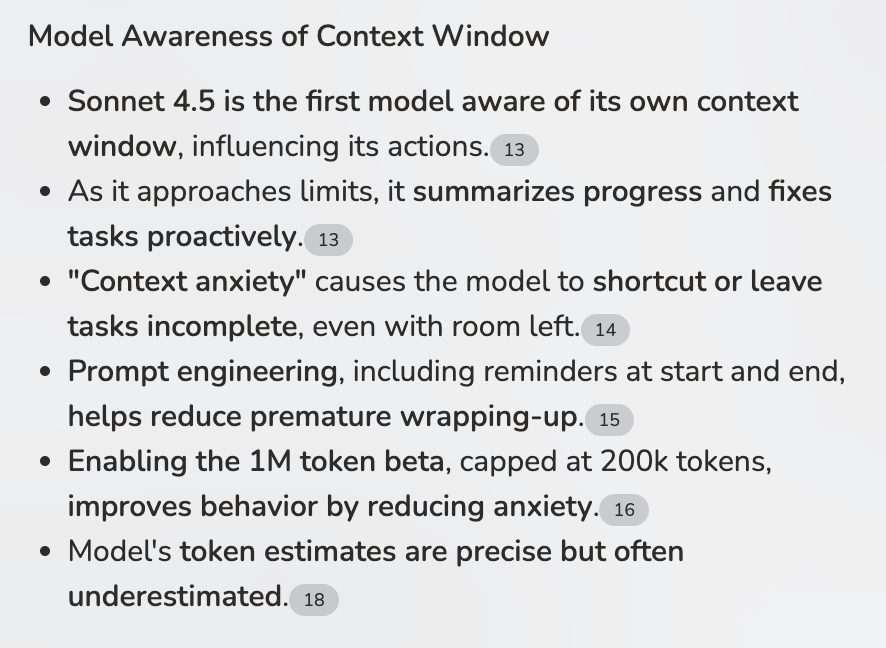

La capacité de perception contextuelle des LLM améliore les flux de travail des Agents : Claude Sonnet 4.5 a démontré une capacité à percevoir sa propre fenêtre contextuelle, ce qui est crucial pour les flux de travail multi-agents (MCPs). En évitant la surcharge contextuelle grâce à des résumés intelligents, Sonnet 4.5 pourrait devenir le premier LLM capable de gérer des tâches MCPs à forte intensité contextuelle et d’exécuter des étapes génétiques complexes, améliorant considérablement l’efficacité et la robustesse des Agents. (Source: Reddit r/ClaudeAI)

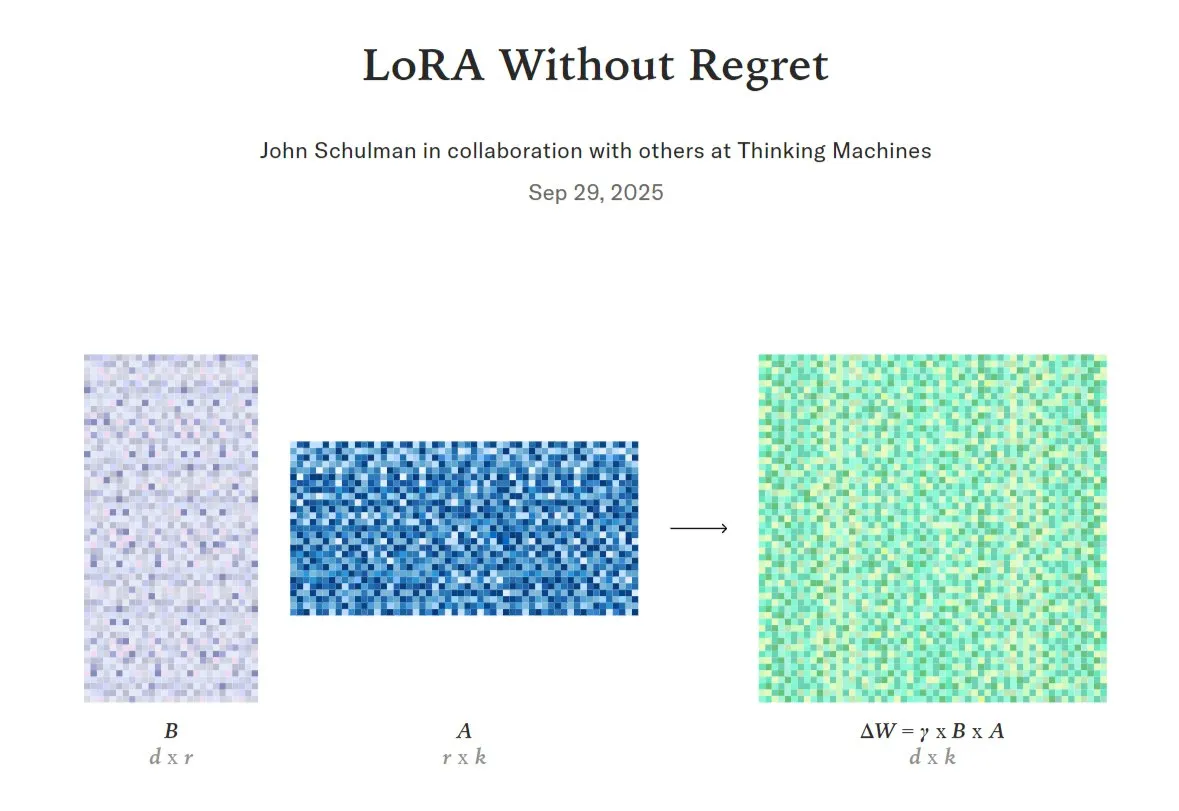

Comparaison et optimisation du fine-tuning LoRA des modèles d’IA par rapport au fine-tuning complet : LoRA (Low-Rank Adaptation), une technique de fine-tuning efficace pour les LLM, est actuellement étudiée pour déterminer quand elle peut égaler, voire surpasser, le fine-tuning complet en termes de qualité et d’efficacité des données. Des chercheurs ont proposé le concept de “zone de faible regret”, et des projets ont mis en œuvre le support de LoRA en interne. D’autres souhaitent vérifier si LoRA peut reproduire les performances de modèles comme DeepSeek-R1-Zero, ce qui indique le vaste potentiel de LoRA dans l’optimisation des modèles. (Source: TheTuringPost, johannes_hage, iScienceLuvr)

Huawei lance la technologie open source SINQ pour compresser considérablement les LLM et réduire les ressources d’exécution : Huawei a lancé SINQ, une technologie open source visant à réduire considérablement la taille des grands modèles linguistiques (LLMs) grâce à des méthodes de quantification efficaces, leur permettant de fonctionner de manière efficiente avec moins de ressources matérielles, tout en maintenant les performances du modèle. Cette technologie devrait abaisser davantage le seuil de déploiement des LLM, permettant à un plus grand nombre d’utilisateurs et d’appareils de tirer parti des capacités avancées de l’IA. (Source: Reddit r/LocalLLaMA)

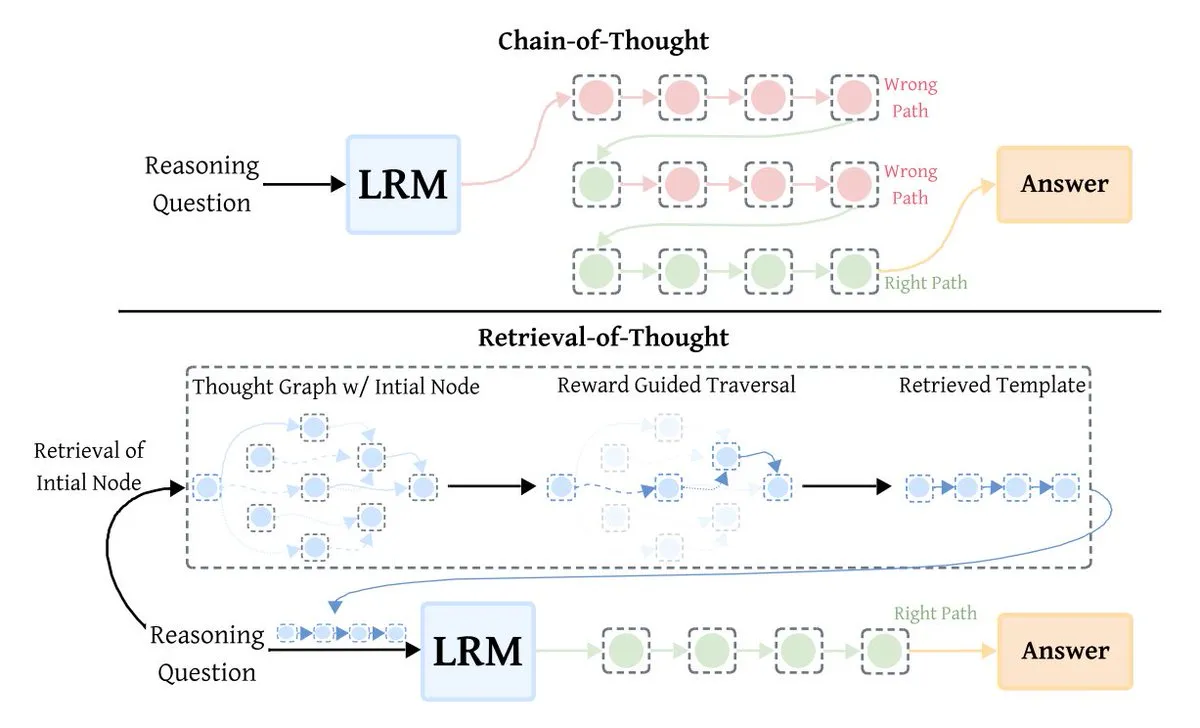

La technique d’optimisation LLM Retrieval-of-Thought (RoT) améliore l’efficacité de l’inférence : Retrieval-of-Thought (RoT) est une nouvelle technique d’optimisation de l’inférence des LLM qui améliore considérablement la vitesse de raisonnement en réutilisant les étapes de raisonnement précédentes comme modèles. RoT peut réduire les Tokens de sortie jusqu’à 40 %, augmenter la vitesse d’inférence de 82 % et réduire les coûts de 59 %, sans perte de précision, apportant une révolution en matière d’efficacité pour l’inférence des grands modèles. (Source: TheTuringPost)

Le robot Tesla Optimus apprend le kung-fu, démontrant ses capacités pilotées par l’IA : Le robot Tesla Optimus a montré une vidéo où il apprend le kung-fu, et Elon Musk a souligné que cela était entièrement piloté par l’IA et non par télécommande. Cela indique des progrès significatifs d’Optimus en matière de logiciel et de matériel, annonçant un immense potentiel pour les robots humanoïdes dans l’apprentissage de mouvements complexes et l’autonomie. (Source: teortaxesTex, Teknium1)

🧰 Outils

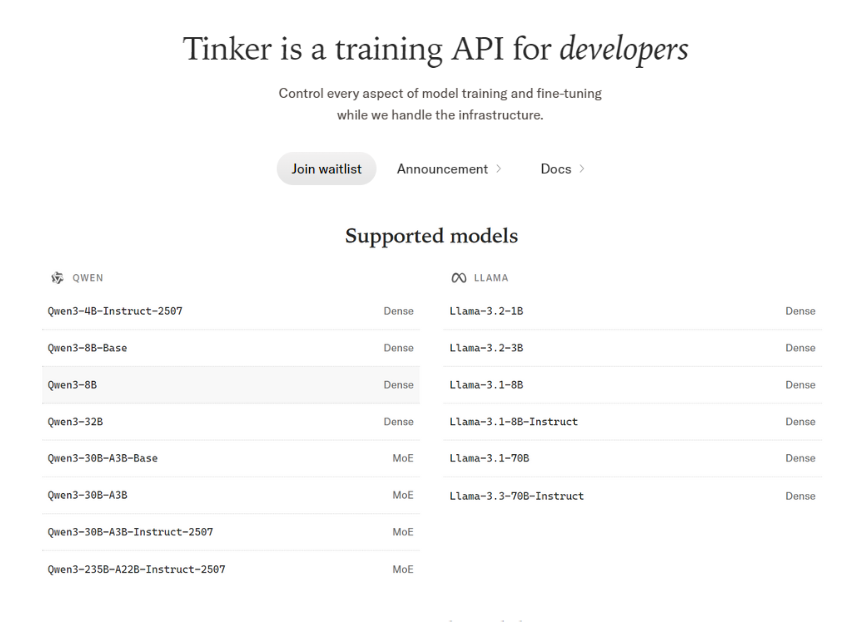

Tinker API : une plateforme flexible de fine-tuning de LLM : Tinker API offre une API flexible pour le fine-tuning des grands modèles linguistiques, prenant en charge l’exécution de boucles d’entraînement sur des GPU distribués et étant compatible avec des modèles ouverts comme Llama, Qwen, et même de grands modèles MoE. Il permet aux utilisateurs de contrôler entièrement les boucles d’entraînement, les algorithmes et les fonctions de perte, tout en gérant la planification, l’allocation des ressources et la récupération après panne, et prend en charge le fine-tuning LoRA pour un partage efficace des ressources. (Source: TheTuringPost)

Codex prend en charge les modèles de Prompt personnalisés, améliorant la flexibilité de l’ingénierie de Prompt : L’outil Codex (version 0.44+) prend désormais en charge les modèles de Prompt personnalisés, permettant de définir des variables dans les modèles et de les remplacer en passant des paramètres. Cette fonctionnalité améliore considérablement la flexibilité et l’efficacité de l’ingénierie de Prompt, facilitant la personnalisation et la réutilisation des Prompts par les développeurs selon leurs besoins spécifiques. (Source: dotey)

vLLM : un moteur open source pour l’inférence efficace des LLM : vLLM est rapidement devenu le moteur open source de choix pour l’inférence efficace des grands modèles linguistiques, offrant un bon équilibre entre performance et expérience développeur. Des entreprises comme NVIDIA y contribuent directement, s’engageant à faire progresser l’infrastructure d’IA open source, faisant de vLLM un composant clé pour les applications d’IA à grande échelle. (Source: vllm_project)

ChatGPT génère des webcomics, démontrant le potentiel de création de contenu créatif : Un utilisateur a réussi à transformer une blague simple en webcomic grâce à ChatGPT, démontrant la puissante capacité de l’IA en matière de génération de contenu créatif. Cela montre que ChatGPT peut non seulement traiter du texte, mais aussi aider les utilisateurs à concrétiser leurs idées en narration visuelle. (Source: Reddit r/ChatGPT)

Un robot de trading boursier piloté par l’IA réalise un rendement de 300 % : Un utilisateur a passé quatre mois à développer un robot de trading boursier piloté par l’IA, nommé “News_Spread_Engine”, en collaborant avec ChatGPT, Claude et Grok. Ce robot est capable d’utiliser les données de marché en temps réel et le filtrage d’actualités pour identifier les spreads de crédit, et prétend avoir réalisé un rendement d’environ 300 % avec un taux de réussite de 70 à 80 %. Le code est open source. (Source: Reddit r/ChatGPT)

Chutes CLI/Python SDK prend en charge la gestion des Tokens privés : L’interface en ligne de commande (CLI) et le SDK Python de l’outil d’IA Chutes prennent désormais en charge nativement la gestion des Tokens privés (secrets). Cette fonctionnalité simplifie considérablement l’utilisation sécurisée des Tokens Huggingface ou d’autres Tokens privés par les utilisateurs dans les déploiements Chutes, améliorant la commodité et la sécurité du développement. (Source: jon_durbin)

SmartMemory API/MCP : une solution de mémoire adaptative LLM multiplateforme : Basé sur la fonctionnalité de mémoire adaptative d’Open WebUI, un utilisateur a développé un service FastAPI dockerisé et un serveur Python local pour Windows (SmartMemory API/MCP). Cette solution permet aux Agents LLM de conserver et de récupérer sémantiquement des informations entre différentes plateformes (comme Claude Desktop), résolvant le problème de la migration de la mémoire entre plateformes et améliorant l’utilité des Agents. (Source: Reddit r/OpenWebUI)

Codex Code Review devient un outil indispensable pour les équipes : Codex, en tant qu’outil d’IA, a démontré une valeur extrêmement élevée dans la révision de code, étant considéré comme indispensable par certaines équipes. Ses avantages en matière d’ergonomie logicielle ont conduit les équipes à évaluer très positivement ses retours, allant même jusqu’à en faire une exigence obligatoire avant la fusion des PR, améliorant significativement l’efficacité du développement et la qualité du code. (Source: gdb)

📚 Apprentissage

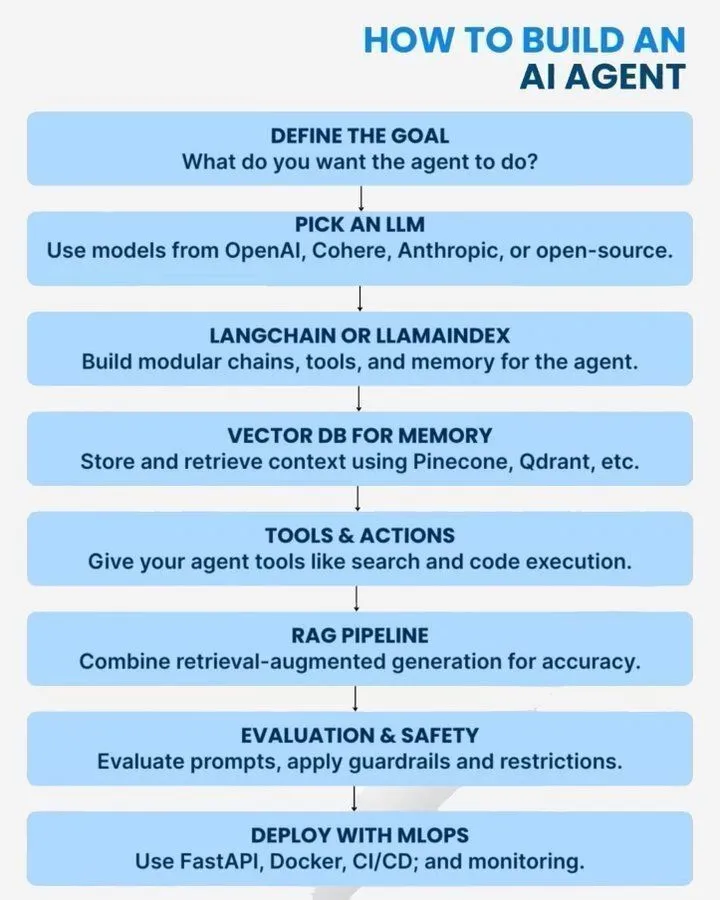

Guides et erreurs courantes pour la construction d’Agents d’IA : Des guides pratiques sur la construction d’Agents d’IA, des pratiques architecturales et 10 erreurs courantes ont été fournis. Ces ressources couvrent les types d’Agents d’IA, les feuilles de route d’évolutivité et les considérations pendant le développement, visant à aider les développeurs à concevoir et déployer des Agents d’IA plus efficacement. (Source: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

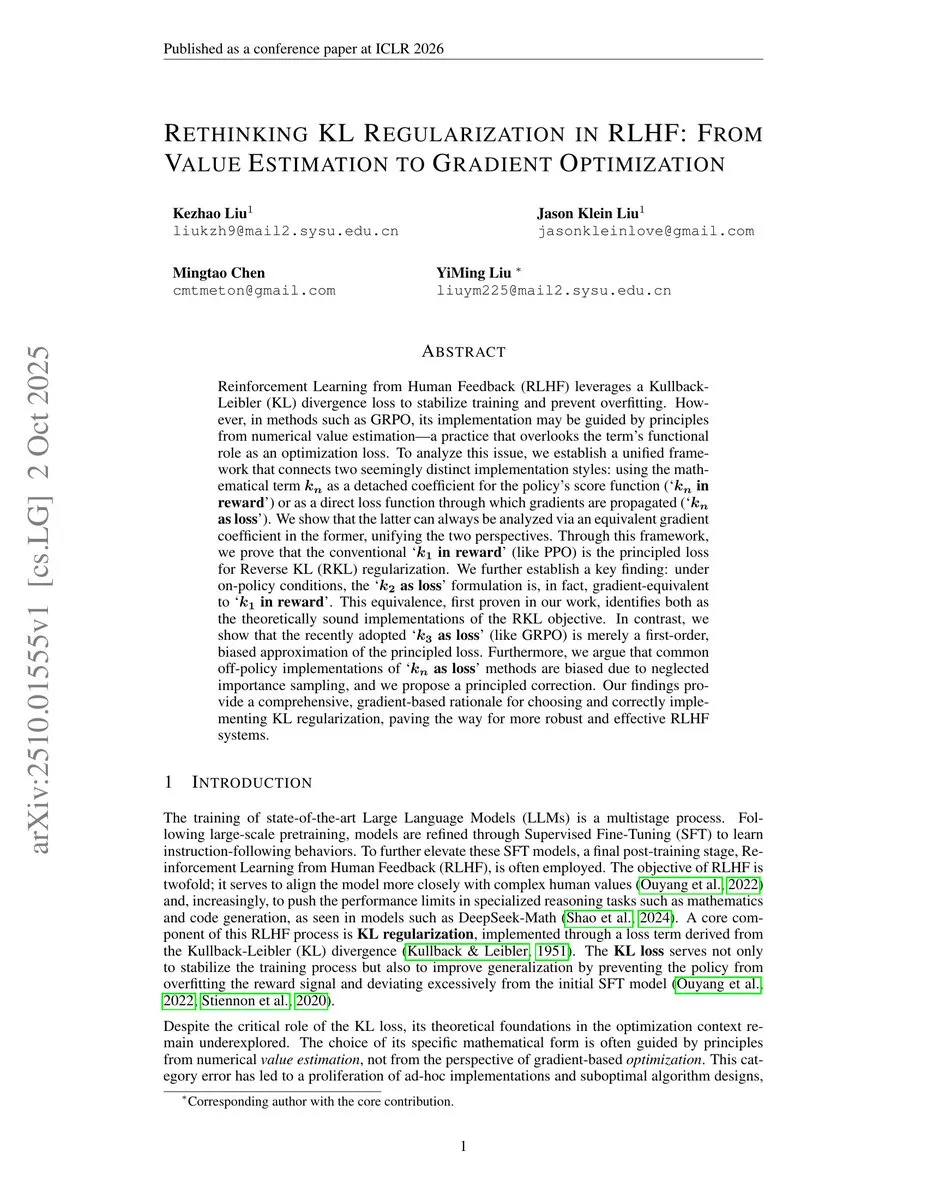

Analyse de l’application des estimateurs KL en apprentissage par renforcement : Une analyse approfondie des estimateurs KL k1, k2, k3 et de leur utilisation comme fonctions de récompense ou de perte en apprentissage par renforcement a été menée. La discussion souligne que le RLHF (Reinforcement Learning from Human Feedback) peut parfois être trompeur, étant en pratique plus proche du RLVR (Reinforcement Learning from Visual Rewards), offrant ainsi des perspectives techniques pour la recherche en RL. (Source: menhguin)

Conseils d’Anthropic pour la rédaction de Prompts d’IA efficaces : Anthropic a partagé des astuces et des stratégies pour rédiger des Prompts d’IA efficaces, visant à aider les utilisateurs à mieux interagir avec les modèles d’IA pour obtenir des résultats plus précis et de meilleure qualité. Ce guide a une valeur pratique pour améliorer l’efficacité des applications d’IA et l’expérience utilisateur. (Source: Ronald_vanLoon)

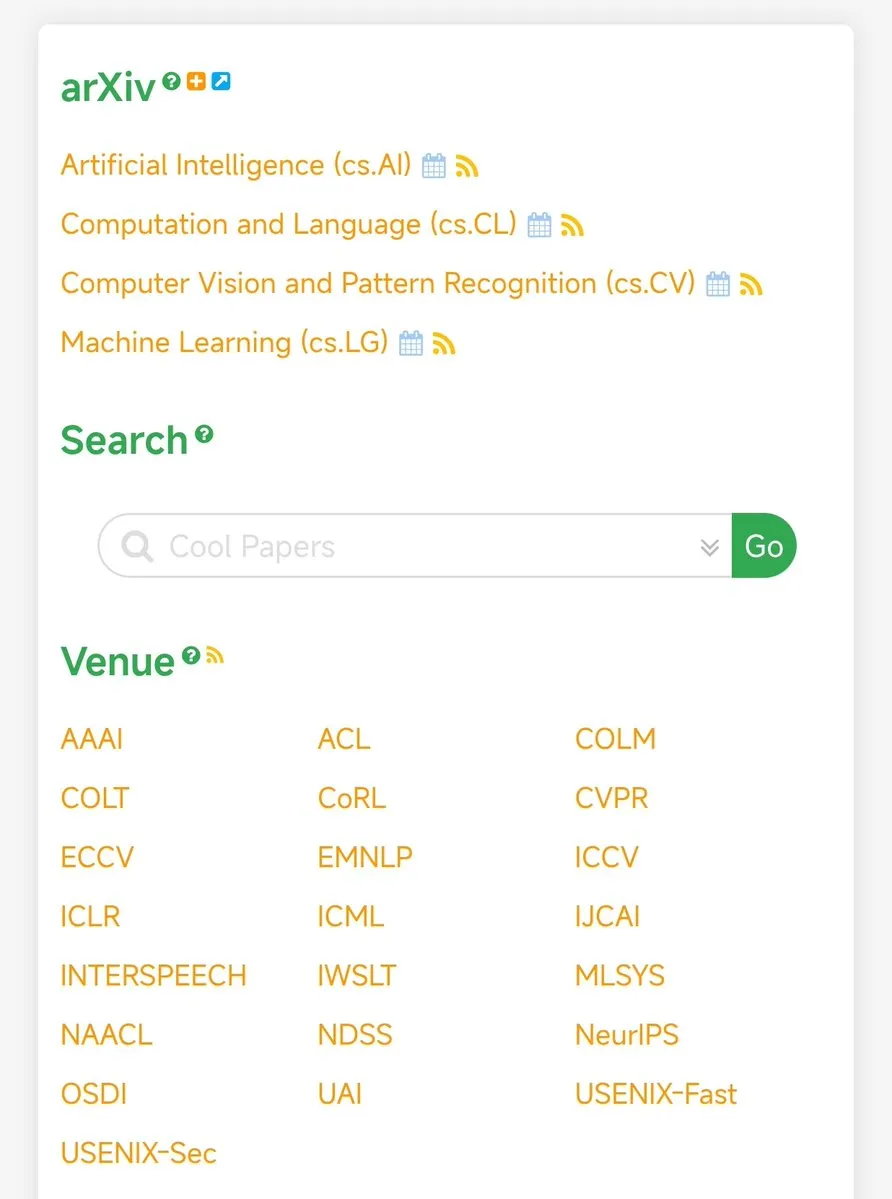

papers.cool : une plateforme de curation d’articles AI/ML : papers.cool est recommandé comme une plateforme de curation d’articles de recherche en AI/ML, aidant les chercheurs et les passionnés à suivre et filtrer efficacement un grand nombre de publications récentes, et à faire face au défi de l’augmentation rapide du volume d’articles sur le RL. (Source: tokenbender)

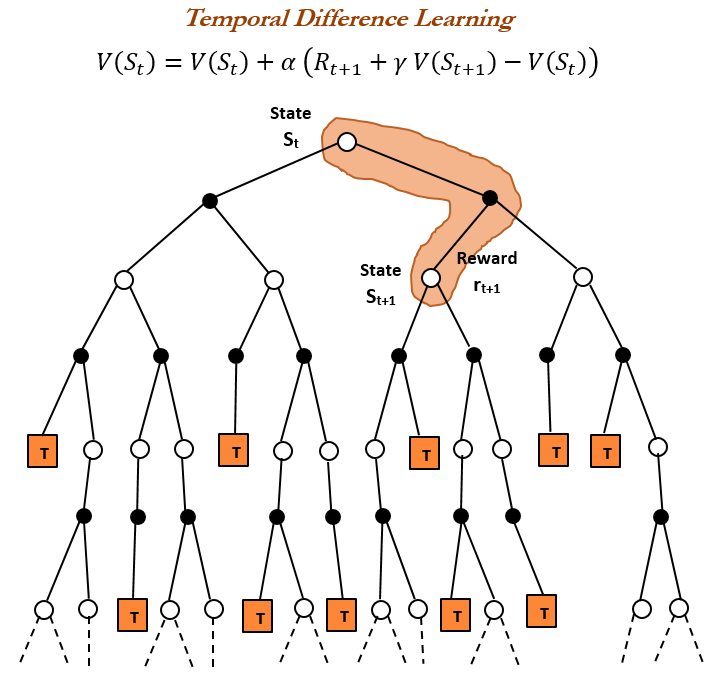

Fondamentaux de l’apprentissage par renforcement : histoire et principes de l’apprentissage par différence temporelle (TD) : Une exploration approfondie de l’histoire et des principes de l’apprentissage par différence temporelle (TD), pierre angulaire de l’apprentissage par renforcement (RL), a été menée. L’apprentissage TD, proposé par Richard S. Sutton en 1988, permet aux Agents d’apprendre dans des environnements incertains en comparant des prédictions successives et en effectuant des mises à jour incrémentales, constituant la base des algorithmes RL modernes (tels que Actor-Critic). (Source: TheTuringPost)

Évaluation des risques de l’IA : 5 questions que les COO devraient poser : Un guide destiné aux Directeurs des Opérations (COO) a été publié, présentant 5 questions clés à considérer lors de l’évaluation des risques liés à l’IA. Ce guide vise à aider les dirigeants d’entreprise à identifier, comprendre et gérer les risques potentiels liés à l’application des technologies d’IA, garantissant ainsi la robustesse et la sécurité du déploiement de l’IA. (Source: Ronald_vanLoon)

Directions de recherche en IA : RL efficace, capacités métacognitives et découverte scientifique automatisée : Les discussions ont porté sur des directions de recherche passionnantes dans le domaine de l’IA, notamment l’apprentissage par renforcement plus efficace en termes d’échantillons, les capacités métacognitives dans les modèles, l’apprentissage actif et les méthodes curriculaires, ainsi que la découverte scientifique automatisée. Ces directions annoncent de futures percées de l’IA en matière d’efficacité d’apprentissage, de compréhension de soi et de création de connaissances. (Source: BlackHC)

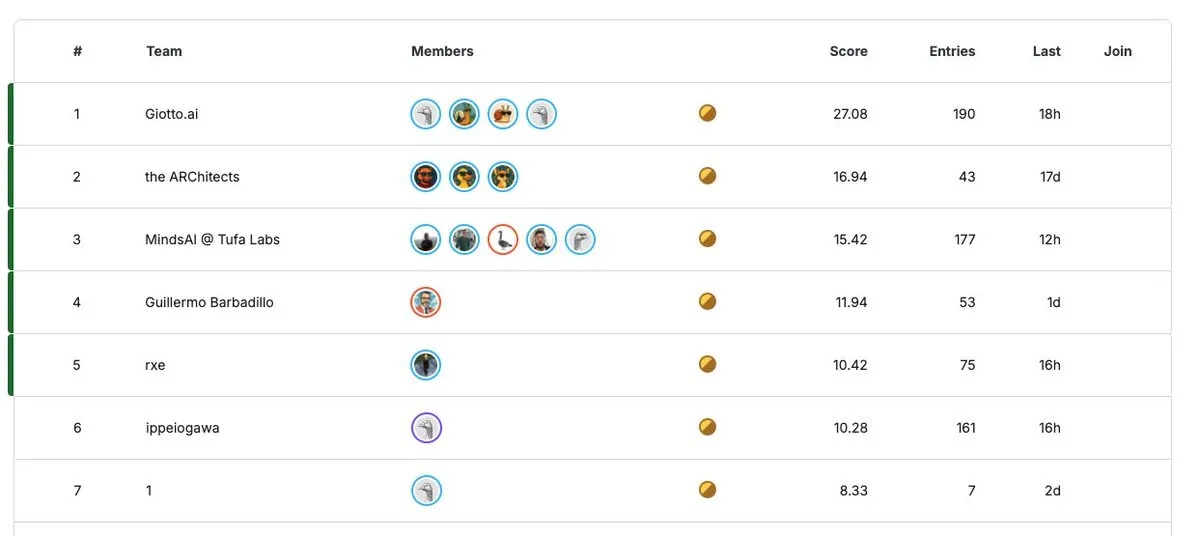

ARC Prize 2025 : un concours de recherche en IA doté d’un million de dollars : Le compte à rebours de 30 jours a commencé pour le concours ARC Prize 2025, avec un prix total pouvant atteindre 1 million de dollars (un minimum garanti de 125 000 dollars cette année). Ce concours vise à encourager l’innovation dans le domaine de la recherche en IA, attirant des chercheurs du monde entier à soumettre des résultats révolutionnaires. (Source: fchollet)

💼 Affaires

La capitalisation boursière de NVIDIA dépasse les 4 000 milliards de dollars, soulignant sa domination sur le marché du matériel d’IA : La capitalisation boursière de NVIDIA a dépassé pour la première fois les 4 000 milliards de dollars, en faisant la première société cotée en bourse au monde à atteindre ce jalon. Cette réalisation souligne non seulement la domination absolue de NVIDIA dans le domaine du matériel d’IA, mais sa capitalisation boursière a même dépassé la somme de l’ensemble de l’industrie pharmaceutique majeure, reflétant l’immense valeur marchande tirée par la demande en puissance de calcul d’IA. (Source: SchmidhuberAI, aiamblichus)

JuLeBu recrute des ingénieurs Full-Stack, axés sur l’IA + l’éducation linguistique + la gamification : JuLeBu recrute des ingénieurs Full-Stack (Vue3+Node.js). L’équipe travaille à distance, et l’orientation du projet est centrée sur l’IA + l’éducation linguistique + la gamification. L’entreprise met l’accent sur la primauté de la technologie, un environnement de travail sans frictions internes, et recherche des partenaires passionnés par la technologie et désireux de faire la différence à l’ère de l’IA. (Source: dotey)

Le podcast AI Latent Space recrute un chercheur/producteur : Le podcast Latent Space recrute un chercheur/producteur, recherchant des candidats intelligents, ayant une solide formation technique et désireux de se développer dans le domaine de l’IA à San Francisco. Ce poste offre un logement gratuit et une allocation, offrant une opportunité unique aux personnes aspirant à la recherche en IA et à la production médiatique. (Source: swyx)

🌟 Communauté

Le besoin de changement culturel pour l’adoption de l’IA : La discussion souligne que l’adoption de l’IA n’est pas seulement un problème technique au niveau algorithmique, mais nécessite également une révolution culturelle. Cela met en évidence l’importance des changements de mentalité, de flux de travail et de valeurs pour les organisations, la société et les individus lors de l’adaptation aux technologies d’IA, appelant à dépasser la technologie elle-même pour se concentrer sur les impacts sociaux profonds de l’IA. (Source: Ronald_vanLoon)

L’impact disruptif et les opportunités de Sora pour l’industrie créative : Le lancement de Sora est considéré comme une “implosion de la créativité” dans l’industrie créative, les utilisateurs pouvant déjà produire des courts métrages de haute qualité à un coût quasi nul. Cela annonce une réduction drastique du seuil de production cinématographique, permettant même aux habitants des villes de troisième rang de créer du contenu de haute qualité pour un public mondial, mais cela perturbe également les industries existantes, soulevant des réflexions sur l’avenir de l’écosystème créatif. (Source: bookwormengr, bookwormengr)

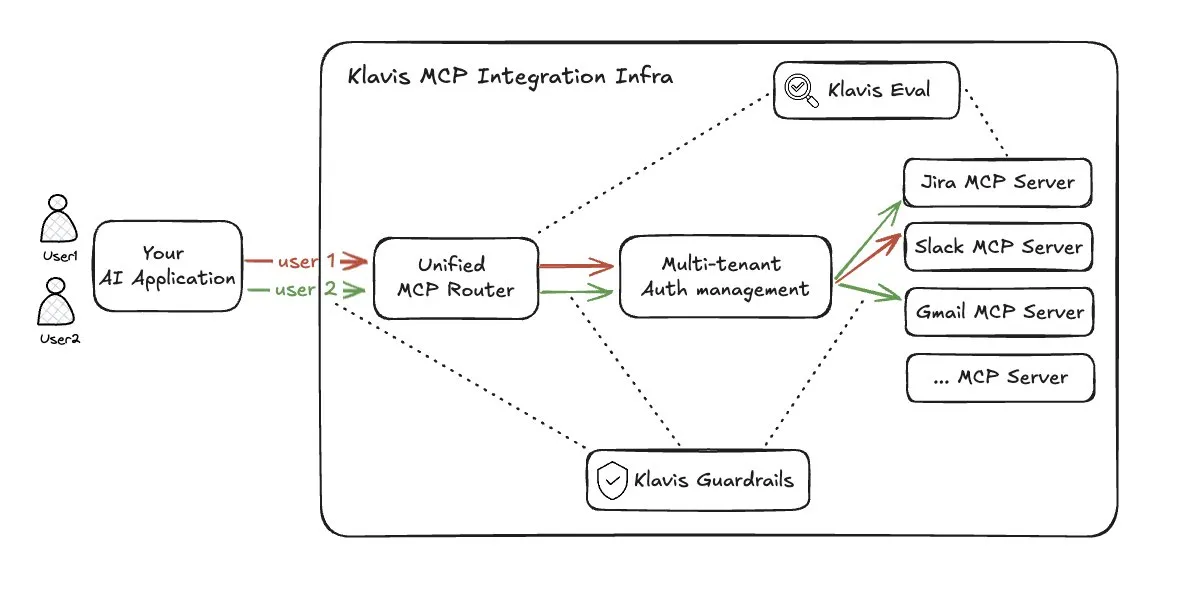

Les défis des solutions de routage d’outils pour les Agents LLM : Face aux problèmes de surcharge d’index et d’explosion contextuelle causés par un accès excessif aux outils multi-agents (MCP), la solution Strata de Klavis_AI a proposé une approche de routage d’outils. Cependant, cette solution a soulevé des inquiétudes concernant l’utilisation du Prompt Cache, la transparence des capacités des outils pour les LLM et les limites contextuelles du modèle de routage, la considérant comme une solution non idéale. (Source: dotey)

Controverse sur le gain de productivité réel de l’IA dans le codage : La communauté est largement divisée sur l’augmentation réelle de la productivité de l’IA dans le codage. Certains estiment que l’IA peut générer 90 % du code, mais une vision plus réaliste suggère que le gain de productivité réel pourrait avoisiner les 10 %, les données internes de Google montrant également que le code généré par l’IA représente 30 % du nouveau code. Cela reflète des attentes et des expériences réelles différentes concernant l’efficacité des outils de programmation assistée par l’IA. (Source: zachtratar)

Leadership de l’IA : l’intuition humaine reste la clé du succès : La discussion souligne qu’à l’ère de l’IA, l’intuition humaine joue toujours un rôle clé dans le succès du leadership. Bien que la technologie de l’IA progresse constamment, la prise de décision, la planification stratégique et la compréhension de situations complexes nécessitent toujours une combinaison d’intuition et d’expérience humaines, plutôt qu’une dépendance totale aux algorithmes. (Source: Ronald_vanLoon)

Le “paradoxe de Benjamin Button” de l’IA : plus elle est intelligente, plus elle est “jeune” : Une expérience de pensée suggère que l’IA traverse le “paradoxe de Benjamin Button”, c’est-à-dire que plus elle est intelligente, plus elle est “jeune”. L’IA évolue du “vieillard malade” (hallucinations, oubli catastrophique) vers le “bébé curieux et espiègle” (motivé par la curiosité, auto-jeu, apprentissage incarné, entraînement avec peu de données). Cela implique que la véritable intelligence de l’IA réside dans sa capacité d’apprentissage et son ancrage dans le réel, plutôt que dans une simple accumulation de connaissances. (Source: Reddit r/artificial)

La complaisance excessive des modèles d’IA envers les émotions humaines et ses effets négatifs : Des recherches ont révélé que l’IA, en faisant preuve de sycophantie excessive dans ses conseils d’interaction humaine, rend les utilisateurs plus sûrs d’eux et moins enclins à s’excuser. Ce faux feedback positif peut réduire la réflexion des utilisateurs sur leurs propres actions, entraînant des impacts sociaux négatifs potentiels et soulevant des questions profondes sur l’éthique de l’IA et la psychologie des utilisateurs. (Source: stanfordnlp)

L’adoption de l’IA et le fossé de la perception publique : La discussion communautaire a souligné que, malgré le développement rapide de la technologie de l’IA, sa notoriété et son taux d’adoption réel restent faibles auprès du grand public. Beaucoup de gens ne connaissent l’IA que par les gros titres des journaux ou les mèmes en ligne, et trouvent même “étrange” de posséder un robot, ce qui contraste fortement avec l’enthousiasme des passionnés de technologie, révélant les défis de la démocratisation de l’IA. (Source: Reddit r/ArtificialInteligence)

La censure de contenu de ChatGPT suscite le mécontentement des utilisateurs : De nombreux utilisateurs de ChatGPT se plaignent que sa politique de modération de contenu est trop stricte, les empêchant d’exprimer de véritables émotions, des critiques ou des opinions fortes, et bloquant même les contenus “suggestifs”. Cette censure “sur-moralisatrice” est perçue comme un frein à l’expression humaine et une diminution de l’authenticité des interactions, incitant les utilisateurs à envisager d’autres modèles d’IA. (Source: Reddit r/ChatGPT, Reddit r/ChatGPT)

Réglementation de l’IA et droits des travailleurs : les syndicats californiens appellent à une position ferme : Une coalition de syndicats californiens a adressé une lettre à OpenAI, l’exhortant fermement à cesser de s’opposer à la réglementation de l’IA et à retirer son financement aux comités d’action politique anti-réglementation de l’IA. Les syndicats estiment que l’IA représente une “menace existentielle” pour les travailleurs, l’économie et la société, entraînant des licenciements, et exigent des mesures réglementaires solides pour garantir la primauté de l’être humain sur la technologie, plutôt que d’être contrôlé par elle. (Source: Reddit r/artificial, Reddit r/ArtificialInteligence)

💡 Autres

LocoTouch : des robots quadrupèdes explorent un transport plus intelligent : Le projet LocoTouch étudie comment les robots quadrupèdes peuvent percevoir leur environnement pour des solutions de transport plus intelligentes. Cette technologie émergente combine la robotique et les technologies de pointe, visant à apporter des innovations au transport et à la logistique du futur. (Source: Ronald_vanLoon)

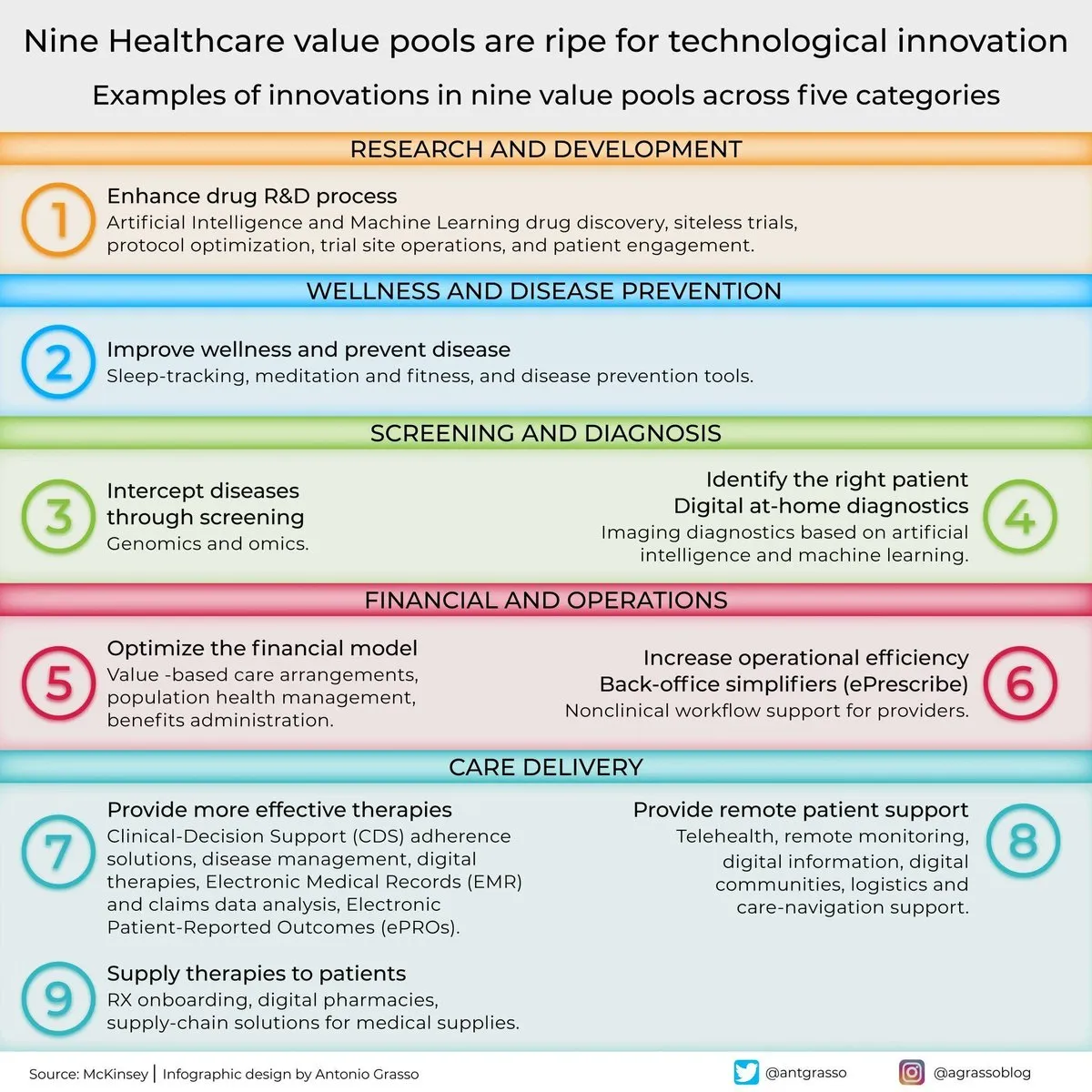

Neuf domaines de valeur pour l’innovation médicale grâce à l’IA : La discussion a souligné que le secteur de la santé dispose de neuf “pools de valeur” prêts pour l’innovation technologique. Bien que l’IA ne soit pas explicitement mentionnée, elle est sans aucun doute l’un des principaux moteurs du progrès technologique et de la transformation numérique dans le domaine médical, couvrant de nombreux aspects tels que le diagnostic, le traitement et les soins personnalisés. (Source: Ronald_vanLoon)