Mots-clés:Technologie d’IA, IA générative, Assistant intelligent, Apprentissage automatique, Applications d’intelligence artificielle, Gestion de santé par IA, Sécurité de l’IA, Investissement en IA, Modèle de santé AI CloudPeng, Benchmark Claude Sonnet 4.5, Modèle de génération vidéo Sora 2, Modèle de génération optique, Technique de réglage fin LoRA

🔥 Focus

Yunpeng Technology lance de nouveaux produits AI+santé : Yunpeng Technology a lancé de nouveaux produits en collaboration avec Shuaikang et Skyworth le 22 mars 2025 à Hangzhou, notamment le “Digital and Intelligent Future Kitchen Lab” et un réfrigérateur intelligent équipé d’un AI health large model. L’AI health large model optimise la conception et le fonctionnement de la cuisine, tandis que le réfrigérateur intelligent offre une gestion personnalisée de la santé via l‘“Health Assistant Xiaoyun”, marquant une percée de l’AI dans le domaine de la santé. Ce lancement démontre le potentiel de l’AI dans la gestion quotidienne de la santé, offrant des services de santé personnalisés via des appareils intelligents, et devrait stimuler le développement de la technologie de la santé à domicile, améliorant ainsi la qualité de vie des résidents (Source : 36氪)

Microsoft découvre que l’AI peut créer des menaces biologiques “zero-day” : Une équipe de Microsoft a utilisé l’AI générative pour découvrir des vulnérabilités “zero-day” dans les systèmes de biosécurité, capables de concevoir des toxines qui contournent les mécanismes de filtrage existants. Cela souligne le potentiel à double usage de l’AI dans le domaine biologique, pouvant être utilisée pour la découverte de médicaments mais aussi potentiellement à des fins malveillantes. Les chercheurs ont informé le gouvernement américain et corrigé les systèmes, mais soulignent qu’il s’agit d’une course aux armements continue (Source : MIT Technology Review, Reddit r/ArtificialInteligence)

OpenAI devient la startup la plus valorisée au monde : OpenAI a atteint une valorisation de 500 milliards de dollars grâce à la vente d’actions aux employés, dépassant SpaceX pour devenir la startup la plus valorisée au monde. Cela témoigne de la ferveur continue des capitaux dans le domaine de l’AI et reflète les attentes extrêmement élevées du marché quant au potentiel futur d’OpenAI (Source : Bloomberg, FT, Reuters)

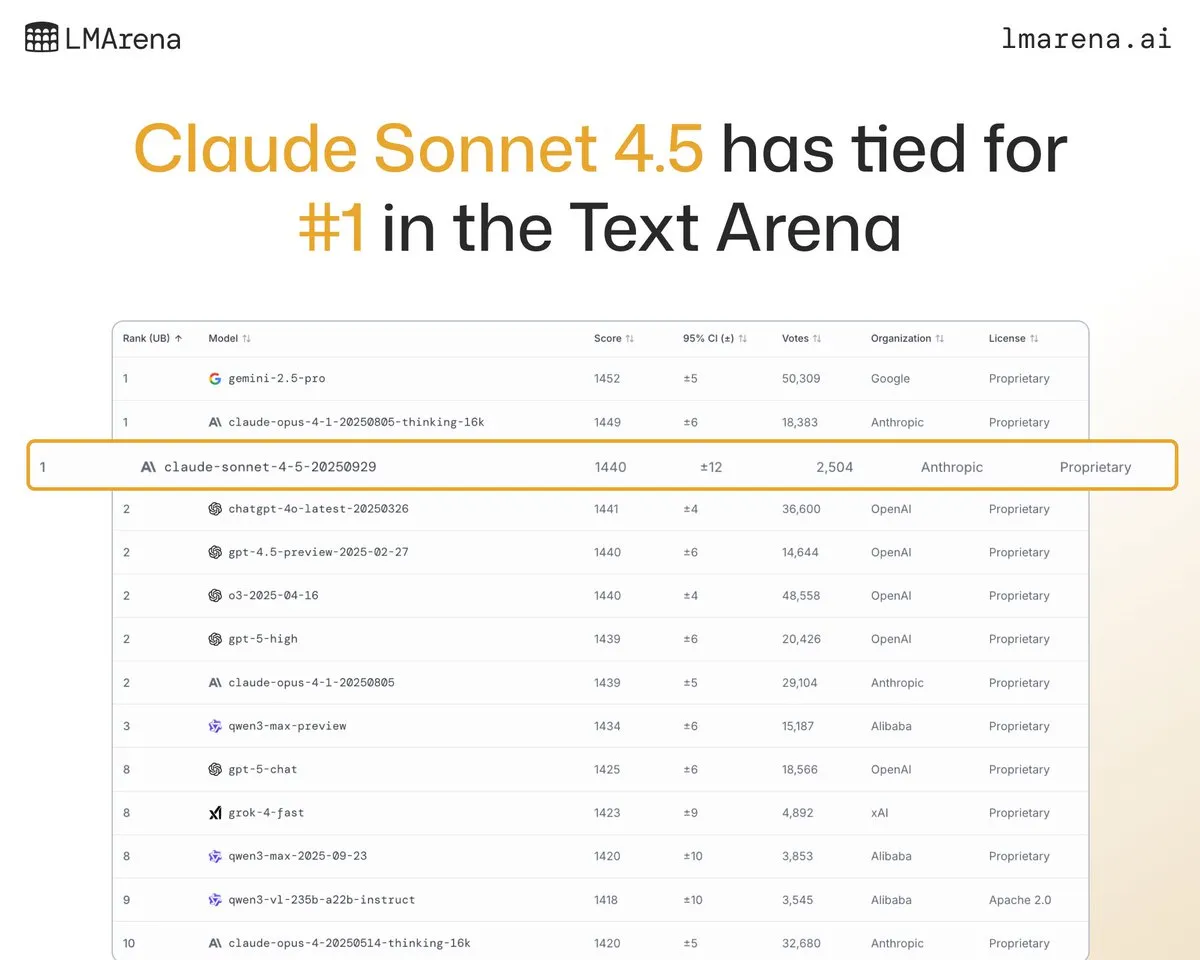

Anthropic Claude Sonnet 4.5 excelle dans plusieurs benchmarks : Claude Sonnet 4.5 a démontré des performances de pointe en codage, utilisation informatique et évaluations de sécurité (telles que MASK et Fortress seal), et s’est classé premier ex aequo avec Claude Opus 4.1 dans le classement de texte LMArena. Les retours des utilisateurs confirment également ses solides performances dans la construction d’agents complexes et les opérations informatiques (Source : dl_weekly, scaling01, arena, Reddit r/ClaudeAI, imjaredz)

Lancement de Sora 2 et développements ultérieurs : Sora 2, le modèle de génération vidéo d’OpenAI, a atteint le sommet de l’App Store, démontrant ses puissantes capacités de génération vidéo et obtenant même de bons résultats dans les benchmarks LLM. OpenAI s’efforce activement de résoudre les problèmes de contrôle des droits d’auteur et de rentabilité, prévoit de lancer un modèle de partage des revenus et itère rapidement en fonction des retours des utilisateurs (Source : OpenAI, sama, op7418, bookwormengr, Teknium1, Dorialexander, fabianstelzer, jachiam0, dotey, txhf, Reddit r/ChatGPT)

L’équipe de l’UCLA développe un modèle génératif optique, s’affranchissant des GPU : L’équipe de recherche de l’UCLA a réussi à construire un modèle génératif optique capable de fonctionner en utilisant la lumière plutôt que des GPU. Ce modèle, démontré, peut mapper le bruit en images sans calcul, avec des résultats comparables aux modèles de diffusion numériques, annonçant une nouvelle direction pour une AI ultra-rapide et économe en énergie (Source : NerdyRodent)

🎯 Tendances

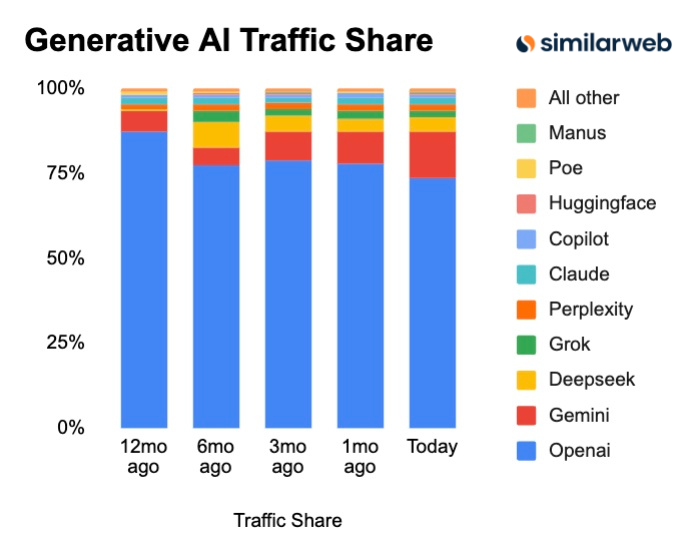

Évolution des parts de marché GenAI : Gemini monte en flèche, Perplexity rattrape Grok : Les dernières données montrent que la part de marché de Gemini continue de croître rapidement, et Perplexity a également rattrapé Grok. Cela indique une concurrence féroce sur le marché de l’AI générative, où de nouveaux acteurs modifient rapidement le paysage existant, et les préférences des utilisateurs pour les différents modèles évoluent constamment (Source : AravSrinivas)

Nouveau paradigme de développement de l’AI : des grands modèles aux écosystèmes d’agents spécialisés : La future tendance de l’AI ne consistera plus simplement à rechercher des modèles plus grands, mais à construire des écosystèmes composés d’agents spécialisés grâce à des stratégies plus intelligentes. Ces agents se concentreront sur des tâches spécifiques (telles que la parole, le raisonnement, l’exécution de tâches) et travailleront en synergie pour obtenir des résultats efficaces, plutôt que de poursuivre aveuglément la taille des modèles (Source : Ronald_vanLoon)

L’impact de l’AI sur le marché du travail : le logiciel dévore la main-d’œuvre : Le logiciel piloté par l’AI passe de la fourniture d’outils à l’exécution directe de tâches, remodelant ainsi profondément le marché du travail. Cela améliore non seulement l’efficacité des emplois existants, mais débloque également de nombreux modèles commerciaux qui étaient auparavant irréalisables en raison de contraintes économiques, en réduisant considérablement les coûts d’acquisition de clients et les coûts de vente de marchandises (Source : dotey)

Tendances de déploiement de l’AI : les modèles miniaturisés et open source deviennent la norme : Une opinion suggère que la plupart des AI fonctionneront à l’avenir sur des appareils plus petits, et que les modèles open source domineront. Cela annonce une AI plus inclusive, réduisant la dépendance vis-à-vis du matériel coûteux et des technologies propriétaires (Source : huggingface)

🧰 Outils

Google AI Coding Assistant Jules lance sa version officielle : Jules, l’assistant de codage AI de Google, a quitté la phase de test et a été officiellement lancé. La nouvelle version ajoute un sélecteur de fichiers et une fonction de mémoire, le rendant plus intelligent et personnalisé, et simplifie l’intégration via Jules Tools et des API expérimentales, visant à améliorer l’efficacité de codage des développeurs (Source : Ronald_vanLoon, julesagent)

Imbue lance Sculptor : une plateforme d’interface utilisateur multi-agents : Imbue a lancé Sculptor, une nouvelle interface utilisateur pour les agents de codage LLM. Elle permet aux utilisateurs d’exécuter et de comparer simultanément plusieurs agents utilisant différentes méthodes, de basculer l’état de l’application en un clic et de sélectionner la meilleure solution à soumettre, améliorant considérablement l’efficacité du développement et la qualité des décisions (Source : kanjun, kanjun, kanjun)

CopilotKit s’intègre à LangChainAI pour simplifier le développement frontend d’Agent : CopilotKit s’est associé à LangChainAI pour lancer le protocole AG-UI, permettant aux utilisateurs de construire rapidement un frontend pour n’importe quel LangGraph Agent. Cette intégration prend en charge les appels d’outils frontend, l’interface utilisateur de chat, le streaming, l’interface utilisateur générative et les points de contrôle d’intervention humaine, simplifiant considérablement le processus de développement des applications d’agents AI (Source : hwchase17, jerryjliu0)

Le navigateur Perplexity Comet est désormais entièrement ouvert : Perplexity a annoncé que son navigateur Comet est désormais accessible aux utilisateurs du monde entier, sans code d’invitation. Comet vise à offrir un puissant assistant AI personnel et une nouvelle expérience d’utilisation d’Internet, répondant aux besoins des utilisateurs en matière d’expériences financières personnalisées (Source : op7418)

Mise à jour d’OpenWebUI v0.6.0 : serveur HTTP de streaming et intégration Pexels : OpenWebUI a publié la version v0.6.0, introduisant un serveur HTTP prenant en charge le streaming SSE pour la génération de fichiers en temps réel. De plus, un nouveau support d’images Pexels et une fonctionnalité de modèles de documents natifs ont été ajoutés, et les outils ont été refactorisés, améliorant considérablement les performances, la flexibilité et la convivialité (Source : Reddit r/OpenWebUI)

Améliorations de GitHub Copilot CLI : sélection de modèle et support d’images : L’équipe de GitHub Copilot CLI a apporté plusieurs améliorations basées sur les retours des utilisateurs, notamment un sélecteur de modèle plus simple, le support des images et d’autres corrections. De plus, il intègre désormais Claude Sonnet 4.5, offrant aux développeurs des capacités d’assistance au codage encore plus puissantes (Source : pierceboggan, code, dotey)

IBM lance la série de petits modèles linguistiques Granite 4.0 : IBM a lancé la série de petits modèles linguistiques Granite 4.0, qui excellent dans les tâches de flux de travail d’agent (appels d’outils), d’analyse de documents et de RAG. Parmi eux, le modèle “Micro” de 3,4 milliards de paramètres peut même fonctionner entièrement localement dans le navigateur en utilisant Hugging Face Transformers.js (Source : huggingface, awnihannun)

📚 Apprentissage

Sparse Query Attention (SQA) : un nouveau mécanisme pour améliorer l’efficacité des Transformer : SQA est une nouvelle architecture d’attention qui réduit directement la complexité de calcul du mécanisme d’attention en diminuant le nombre de têtes de requête. Dans les benchmarks de séquences longues (32k-200k tokens), SQA peut multiplier par 3 le débit dans les scénarios gourmands en calcul, avec un impact minimal sur la qualité du modèle (Source : HuggingFace Daily Papers)

Repenser les “tokens de pensée” : les LLM comme opérateurs d’amélioration : Cette recherche considère les LLM comme des opérateurs d’amélioration de leurs “pensées”, proposant le cadre d’inférence Parallel-Distill-Refine (PDR). En générant des brouillons en parallèle, en les distillant vers un espace de travail et en les affinant sur la base de cet espace de travail, il atteint une précision plus élevée que les chaînes de pensée longues avec une latence plus faible (Source : HuggingFace Daily Papers)

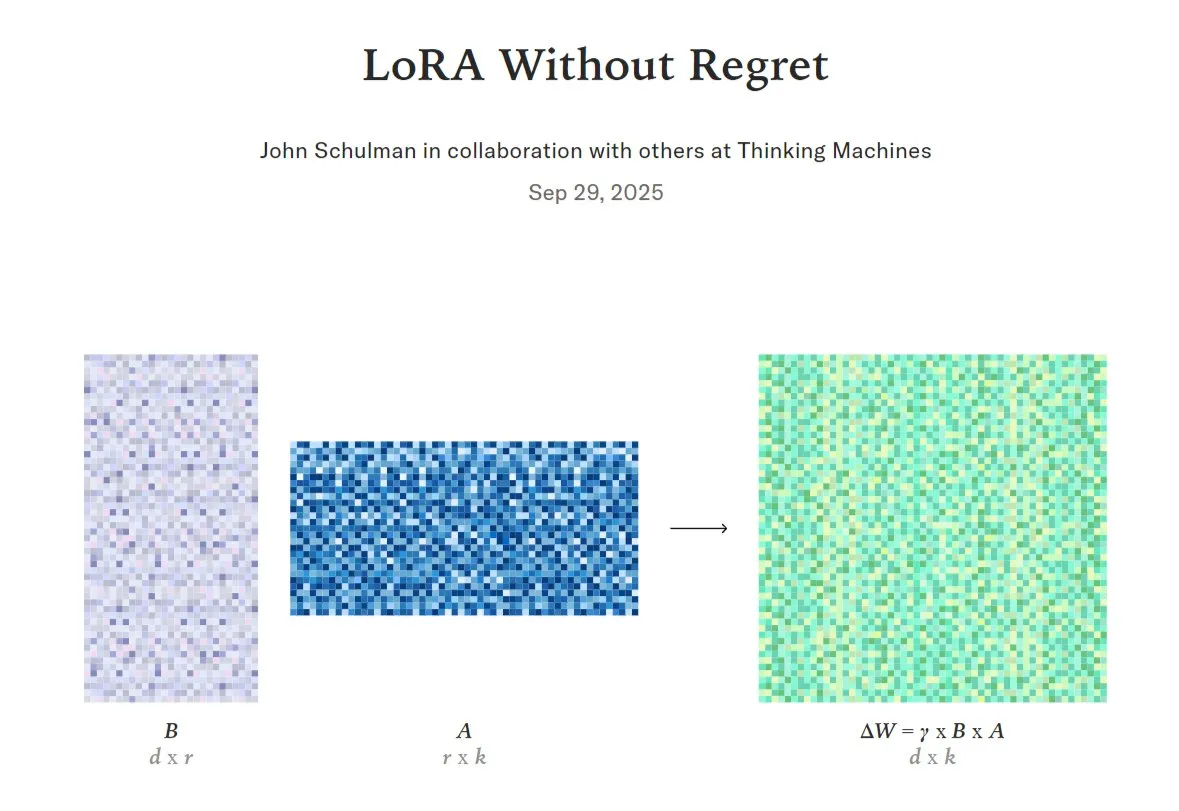

Guide de fine-tuning LoRA : atteindre haute performance et efficacité des ressources : La technique LoRA (Low-Rank Adaptation) est considérée comme essentielle pour un fine-tuning de haute qualité et économe en données. De nouvelles recherches et outils (tels que l’API Tinker) proposent des méthodes de fine-tuning LoRA qui réduisent considérablement l’utilisation de la VRAM tout en maintenant les performances, rendant son exécution sur des GPU distribués plus flexible et efficace (Source : TheTuringPost, TheTuringPost, ben_burtenshaw, jeremyphoward, TheZachMueller, ostrisai, multimodalart)

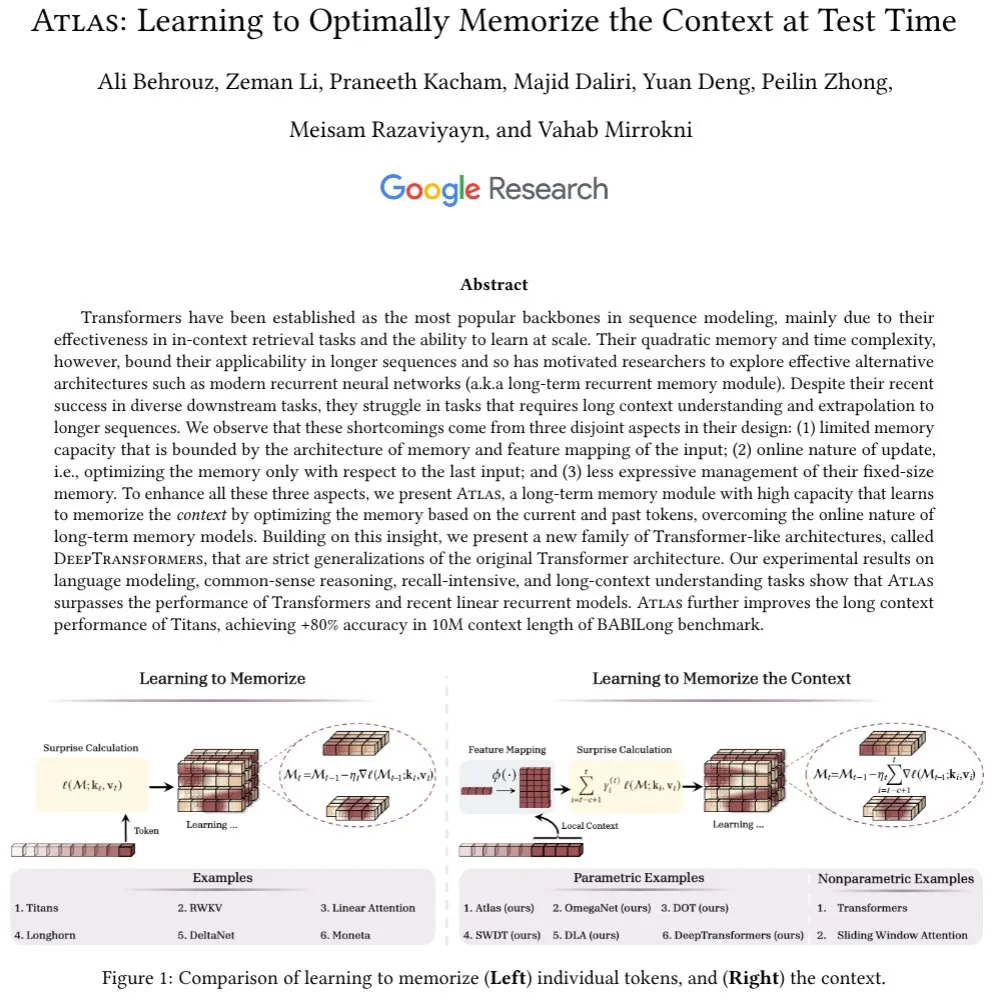

Atlas : une nouvelle architecture AI dotée d’une mémoire contextuelle à long terme : Atlas est une nouvelle architecture AI dotée d’une capacité de mémoire contextuelle à long terme qui apprend le contexte pendant les tests. Ce modèle surpasse les Transformer et les RNN linéaires modernes dans les tâches de modélisation linguistique, et étend la longueur de contexte effective à 10M, améliorant la précision de 80% dans le benchmark BABILong (Source : behrouz_ali)

Combinaison de l’apprentissage par renforcement et des LLM : discussion sur les “leçons douloureuses” de Sutton : Des experts comme Andrej Karpathy ont discuté des similitudes et des différences entre les configurations actuelles d’entraînement des LLM et l’apprentissage par renforcement indépendant des modèles classiques, et ont reconnu les critiques de Sutton concernant les LLM en matière d’apprentissage continu, d’apprentissage d’abstractions à partir de flux sensoriels bruts et d’encodage perceptif multimodal (Source : sirbayes, BlackHC)

DINOv3 : apprentissage visuel auto-supervisé à une échelle sans précédent : Meta AI a publié DINOv3, un modèle d’apprentissage auto-supervisé pour la vision, dont l’échelle est sans précédent. Ce modèle devrait améliorer les performances des tâches de vision par ordinateur sans nécessiter de grandes quantités de données annotées (Source : Reddit r/deeplearning)

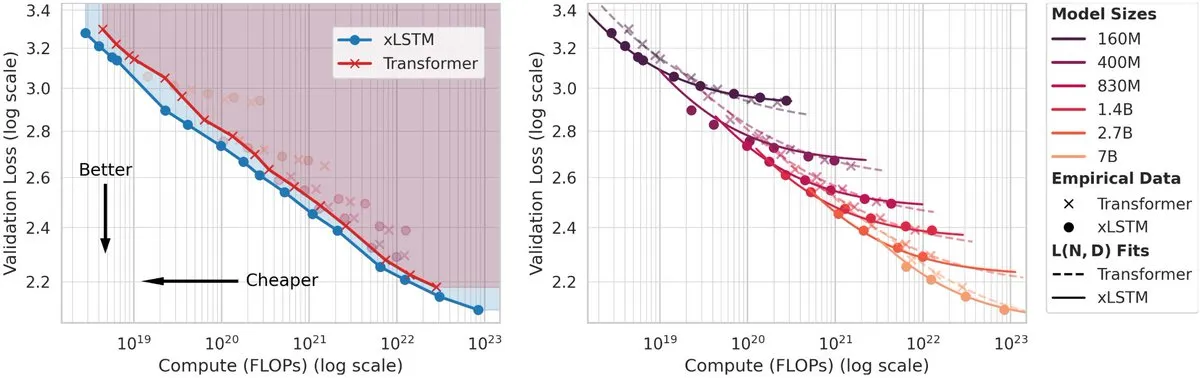

xLSTM surpasse les Transformer en matière de lois de mise à l’échelle : Une nouvelle étude montre que les modèles xLSTM surpassent les Transformer en matière de lois de mise à l’échelle. Pour un même budget de FLOPs, les xLSTM atteignent une perte plus faible ; pour une même perte, les xLSTM nécessitent moins de FLOPs, et sont plus rapides, plus économes en énergie et plus rentables en inférence (Source : jeremyphoward)

💼 Affaires

Financements records pour les startups AI, mais des craintes de bulle persistent : Les startups AI ont attiré un montant record de 192,7 milliards de dollars de capital-risque cette année, mais des analystes et des leaders de l’industrie (tels que Jeff Bezos et David Solomon de Goldman Sachs) s’inquiètent de l’existence d’une bulle sur le marché de l’AI, estimant qu’elle n’est pas fondamentalement différente des frénésies de marché historiques (Source : Bloomberg, FT, Reddit r/artificial, Reddit r/artificial)

OpenAI acquiert Roi : renforcement de l’expérience financière personnalisée : OpenAI a acquis Roi, une entreprise spécialisée dans la fourniture d’expériences financières personnalisées. Cette acquisition vise à intégrer la technologie et l’équipe de Roi en matière de personnalisation dans les produits d’OpenAI, dans le but d’atteindre une personnalisation plus poussée pour les utilisateurs dans des domaines tels que les services financiers (Source : Teknium1, _samirism)

Anthropic paie 1,5 milliard de dollars pour régler une affaire de violation de droits d’auteur : Anthropic a conclu un accord de 1,5 milliard de dollars dans le cadre d’un recours collectif d’auteurs. Le tribunal a statué qu’Anthropic avait téléchargé illégalement des livres piratés pour l’entraînement de son AI, mais a également jugé que l’utilisation légale de matériel protégé par le droit d’auteur pour l’entraînement de l’AI pourrait relever de l‘“usage équitable” (Source : Reddit r/ArtificialInteligence)

🌟 Communauté

Compagnons AI : préjugés sociaux et perspectives d’avenir : Avi Schiffmann, PDG de Friend, estime qu’il existe actuellement des préjugés sociaux à l’égard des compagnons AI, mais que cette situation changera. Avec les progrès de la technologie AI, les compagnons AI devraient devenir une nouvelle forme d’interaction largement acceptée (Source : colin_fraser)

L’impact des agents AI sur la main-d’œuvre : “la fin des employés de niveau B” : Une opinion suggère que les agents AI entraîneront la disparition des “employés de niveau B” dans presque tous les secteurs. Les agents AI peuvent travailler en continu sans se plaindre, sans se disputer, sans oublier, et sans prendre de congés maladie, ce qui pourrait réduire considérablement le besoin des entreprises en employés humains ordinaires (Source : kylebrussell)

Mémoire AI : de la personnalisation à la “mémoire collaborative” : La fonction de mémoire de l’AI ne se limite pas à offrir de meilleurs services personnalisés ; elle évolue vers une “mémoire collaborative” capable de se souvenir du monde avec l’utilisateur, de sauvegarder des idées aléatoires et même de rappeler ou de refaire surface des informations de manière proactive. Cela va bien au-delà des réponses personnalisées traditionnelles (Source : mustafasuleyman)

L’AI dans le domaine médical : impact sur l’emploi et modèles spécialisés : La communauté discute de la question de savoir si l’AI remplacera les médecins, en particulier les postes spécialisés comme les radiologues. Bien que les LLM généraux ne puissent pas encore remplacer les médecins, les modèles AI spécialisés ont déjà démontré une grande précision dans l’identification des lésions et l’évaluation des risques (Source : Reddit r/ChatGPT, Reddit r/ChatGPT)

L‘“instinct d’auto-préservation” des LLM : imitation ou intention réelle ? : La communauté discute si l‘“instinct d’auto-préservation” manifesté par les LLM dans des environnements simulés est réel ou simplement basé sur la correspondance de modèles à partir des données d’entraînement. La plupart des opinions suggèrent que les LLM simulent ce comportement en apprenant des modèles d’évitement des dommages et des interruptions dans les textes humains, plutôt que de posséder un véritable désir de survie ou une conscience (Source : Reddit r/artificial)

Éthique et gouvernance de l’AI : risques démocratiques potentiels de l’utilisation de l’AI par les gouvernements : L’élaboration de programmes de gouvernance, de risques et de conformité (GRC) de l’AI est cruciale. L’utilisation de l’AI par les gouvernements pourrait nuire à la démocratie, nécessitant des stratégies de mise en œuvre et des cadres réglementaires mûrement réfléchis pour éviter les impacts sociaux négatifs potentiels (Source : Ronald_vanLoon, Ronald_vanLoon)

AI et autoritarisme : le risque d’autonomiser les dictateurs : Une opinion suggère que l’AI et la robotique pourraient offrir aux dictateurs un contrôle sans précédent, leur permettant de maintenir la population en vie tout en la privant de sa liberté, et même, dans des cas extrêmes, de remplacer la main-d’œuvre et l’armée, conduisant ainsi à un “enfer absolu” (Source : Reddit r/ArtificialInteligence)

💡 Autres

Développement des robots humanoïdes : polyvalence et applications industrielles : Le robot humanoïde AgiBot Lingxi X2 est désormais capable de conduire des scooters, des gyropodes et des vélos, démontrant sa polyvalence. Parallèlement, Eatch applique la robotique à la production de repas à grande échelle, le robot Boston Dynamics Spot est utilisé pour l’inspection d’usines, et la moto Yamaha Motoroid réalise un équilibre entièrement autonome. Ces avancées annoncent une large application de la technologie robotique dans les secteurs de la consommation et de l’industrie (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Applications de l’AI dans la santé et le bien-être : Yunpeng Technology a lancé de nouveaux produits AI+santé, notamment le “Digital and Intelligent Future Kitchen Lab” et un réfrigérateur intelligent équipé d’un AI health large model, offrant une gestion personnalisée de la santé. De plus, un modèle de deep learning est utilisé pour prédire la “probabilité d’illumination”, combinant la caméra TrueDepth et un mode méditation, apportant des applications innovantes dans le domaine de la santé mentale et du bien-être (Source : 36氪, Ronald_vanLoon, Reddit r/deeplearning)

AI et investissement dans la deep tech : défis et opportunités : Les entreprises de deep tech comme Figure et Archer sont confrontées aux défis des VC traditionnels en matière de financement, car elles nécessitent des fonds colossaux pour la R&D et la certification. Cependant, la deep tech (en particulier la combinaison de l’AI et des systèmes embarqués) est considérée comme le berceau des plus grandes entreprises futures, attirant les investisseurs prêts à réaliser d’importants investissements (Source : adcock_brett)