Mots-clés:Biais de l’IA, Robot humanoïde, Réglage fin des grands modèles, DeepSeek-V3.2, vLLM, Lunettes intelligentes IA, Apprentissage par renforcement, Biais de caste d’OpenAI, Cadre Any2Track universel Galaxy, API de réglage fin Tinker, Support multimodal vLLM, NVIDIA AI Blueprint VSS 2.4

🔥 En Vedette

Les biais de caste dans les modèles OpenAI suscitent des inquiétudes : Une enquête du MIT Technology Review révèle que GPT-5 et Sora présentent de graves biais de caste sur le marché indien, associant les Dalits à la pauvreté et aux professions subalternes, tandis que les Brahmanes sont liés au savoir et au statut spirituel. GPT-4o a montré moins de biais. Les normes d’évaluation des biais de l’AI existantes (telles que BBQ) ne couvrent pas les castes, et les chercheurs développent de nouveaux benchmarks. Cela soulève des préoccupations quant à l’équité et aux impacts sociaux potentiels des modèles d’AI dans des contextes culturels non occidentaux. (Source : MIT Technology Review)

Le framework Any2Track de Galaxy General Robotics permet aux robots humanoïdes un suivi de mouvement hautement résistant aux interférences : Galaxy General Robotics a lancé Any2Track, un framework de suivi de mouvement universel qui permet aux robots humanoïdes (comme le Unitree G1) d’imiter précisément des mouvements humains complexes et de s’adapter en temps réel aux perturbations externes, en maintenant la stabilité même en cas de coups de pied répétés. Ce framework utilise un apprentissage par renforcement en deux étapes pour un sim2real à zéro shot. La technologie a déjà été appliquée dans les magasins de détail “Galaxy Space Capsule”, faisant passer l’intelligence incarnée du laboratoire à la commercialisation, et pourrait devenir une carte de visite internationale pour l’industrie robotique chinoise. (Source : 量子位)

Thinking Machines Lab lance Tinker, réduisant considérablement la barrière au fine-tuning des grands modèles : Thinking Machines Lab, fondé par d’anciens membres clés d’OpenAI et Google DeepMind, a lancé son premier produit, Tinker, une API flexible de fine-tuning de LLM. Cet outil permet aux chercheurs, tout en contrôlant les algorithmes et les données, de confier des tâches complexes telles que la gestion de l’infrastructure, la propagation avant et arrière du modèle et l’entraînement distribué à la plateforme, réduisant ainsi considérablement les coûts et les barrières techniques du fine-tuning. Tinker prend en charge les modèles des séries Qwen3 et Llama3 et utilise la technologie LoRA pour le partage de GPU afin d’améliorer l’efficacité, ce qui est considéré comme une amélioration significative de la productivité de la recherche en AI. (Source : 量子位)

🎯 Tendances

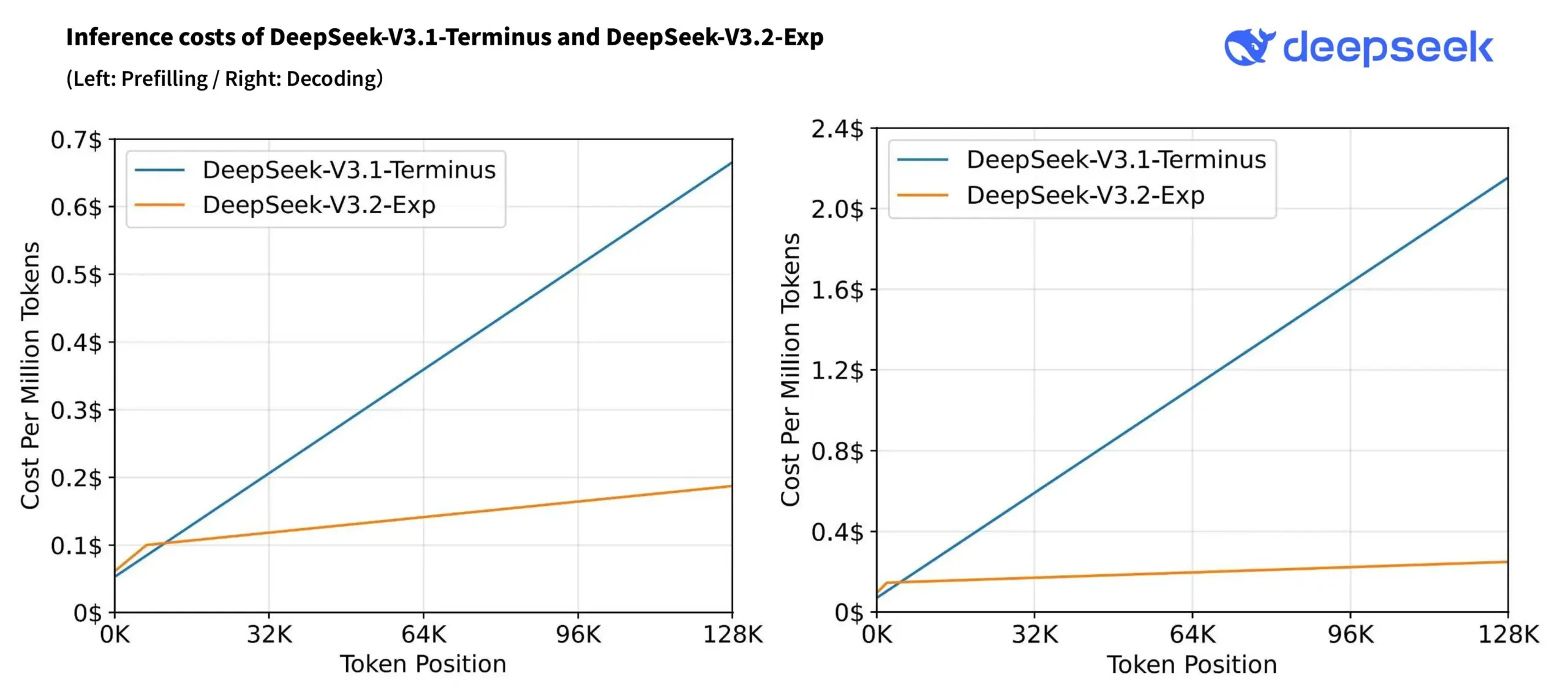

Lancement du modèle DeepSeek-V3.2-Exp et réduction des prix de l’API : DeepSeek a lancé son modèle expérimental DeepSeek-V3.2-Exp, introduisant l’attention clairsemée DeepSeek (DSA) pour améliorer l’efficacité du traitement des contextes longs et réduire les coûts de calcul. Les prix de l’API ont baissé de plus de 50 %, et le modèle a obtenu d’excellents résultats dans le benchmark WeirdML, améliorant encore le rapport qualité-prix et les performances d’inférence. (Source : deepseek_ai, teortaxesTex)

Mise à jour de vLLM v0.10.2, support multimodal et optimisation de l’inférence : vLLM a publié la version 0.10.2, ajoutant la prise en charge de divers modèles tels que Qwen3-Next/Omni/VL, InternVL 3.5 et Whisper, et introduisant Decode Context Parallel et le support complet de cudagraph, optimisant considérablement les performances et l’efficacité de l’inférence des LLM. (Source : vllm_project)

Apple se tourne vers le développement de lunettes intelligentes AI, mettant de côté la version économique de Vision Pro : Apple a suspendu le développement d’une version économique de Vision Pro pour se concentrer prioritairement sur la recherche et le développement de lunettes intelligentes AI, visant à concurrencer Meta et d’autres rivaux. Cette décision indique qu’Apple considère la technologie AI comme le cœur de sa future stratégie matérielle, en particulier dans le domaine des appareils portables, annonçant un changement majeur dans l’orientation future de ses produits. (Source : nptacek, TheRundownAI)

NVIDIA lance AI Blueprint VSS 2.4, renforçant la compréhension du monde physique et l’AI Edge : NVIDIA a publié AI Blueprint VSS 2.4, intégrant Cosmos Reason VLM, ce qui améliore considérablement la capacité de l’AI à comprendre le monde physique et renforce les fonctions de questions-réponses grâce à la traversée de graphes de connaissances d’agents. Il prend également en charge le déploiement de l’AI Edge, fournissant une base plus solide pour les applications d’AI multimodales. (Source : dl_weekly)

Comparaison des capacités de codage des LLM : GPT-5 Codex surpasse Claude Sonnet 4.5 : Des discussions de développeurs indiquent que GPT-5 Codex d’OpenAI a dépassé les modèles Claude 3.5/4 en matière de génération et de planification de code, et surpasse Sonnet 4.5, se distinguant particulièrement dans la rédaction de code plus concis et la conception de systèmes, démontrant les dernières avancées d’OpenAI dans le domaine de l’AI de codage. (Source : dejavucoder, dejavucoder)

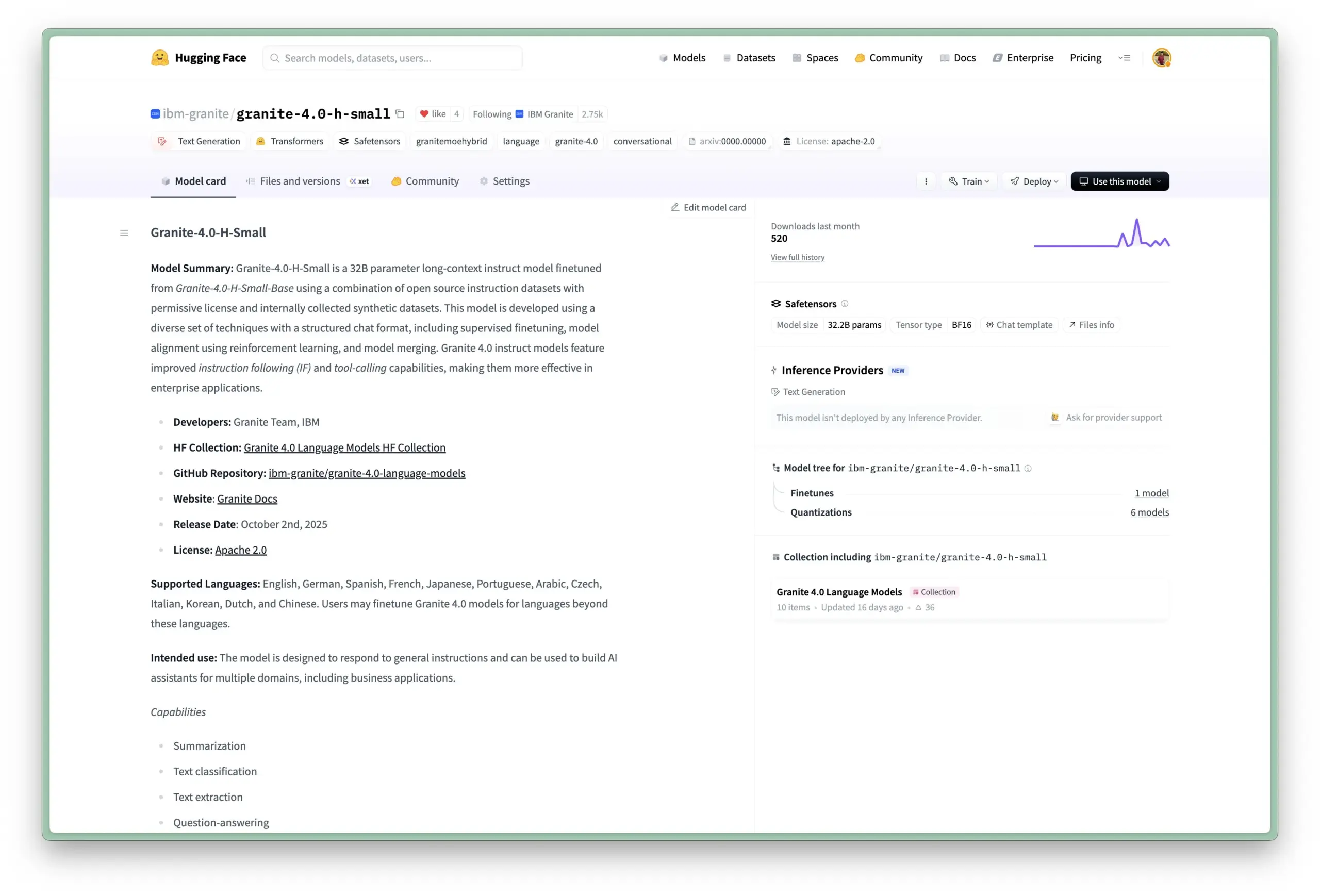

IBM lance la série de modèles de langage Granite 4.0 : IBM a introduit la série de modèles de langage Granite 4.0, comprenant les modèles denses 32B-A9B, 7B-A1B et 3B, disponibles au format GGUF. Ces modèles prennent en charge le multilingue, l’appel d’outils et les contextes longs, et sont open-source sous licence Apache 2.0, visant à fournir des solutions haute performance pour le déploiement local et les scénarios d’application spécifiques. (Source : reach_vb, Dorialexander, huggingface)

Flash-Searcher : Un framework d’agent Web rapide et efficace basé sur l’exécution parallèle DAG : Flash-Searcher est un nouveau framework d’inférence d’agents parallèles qui décompose les tâches en sous-tâches avec des dépendances claires, permettant une exécution concurrente via un graphe acyclique dirigé (DAG). Ce framework optimise dynamiquement les flux de travail, surpassant les méthodes existantes dans plusieurs benchmarks, améliorant considérablement l’efficacité et la précision de l’exécution des agents, et offrant un paradigme plus évolutif pour les tâches d’inférence complexes. (Source : HuggingFace Daily Papers)

DeepSearch : Intégration de MCTS dans l’entraînement RLVR pour surmonter le goulot d’étranglement du RL des petits modèles : Le framework DeepSearch intègre directement la recherche arborescente de Monte Carlo (MCTS) dans l’entraînement par apprentissage par renforcement avec récompense vérifiable (RLVR) des LLM, résolvant ainsi le goulot d’étranglement de performance causé par l’exploration clairsemée des méthodes RLVR existantes. Cette approche, grâce à l’exploration pendant l’entraînement, la sélection de la frontière globale et l’entraînement du tampon de relecture adaptatif, permet aux modèles d’inférence 1.5B d’atteindre un niveau de pointe et réduit considérablement le temps d’entraînement GPU. (Source : HuggingFace Daily Papers)

QUASAR : Génération de code d’assemblage quantique via des agents LLM améliorés par des outils et le RL : QUASAR est un framework d’apprentissage par renforcement (RL) basé sur des agents, utilisant des LLM améliorés par des outils pour la génération et l’optimisation de code d’assemblage quantique. Il a conçu des mécanismes de vérification de circuits quantiques et de récompenses hiérarchiques, améliorant significativement les performances syntaxiques et sémantiques des circuits quantiques générés. Cela a permis à un LLM 4B d’atteindre 99,31 % et 100 % d’efficacité sur Pass@1 et Pass@10 respectivement, surpassant les LLM de niveau industriel tels que GPT-4o, GPT-5 et DeepSeek-V3. (Source : HuggingFace Daily Papers)

🧰 Outils

Atuin Desktop : Un éditeur de runbooks exécutables, connectant documentation et automatisation : Atuin Desktop est un éditeur de runbooks exécutables, axé sur le local, conçu pour combler le fossé entre la documentation et l’automatisation. Il permet aux utilisateurs de chaîner des commandes Shell, des requêtes de base de données et des requêtes HTTP dans une seule interface, de créer des workflows dynamiques via des templates de style Jinja, et prend en charge la collaboration basée sur CRDT. Il est adapté aux scénarios tels que la gestion des déploiements, la migration d’infrastructures et les opérations de base de données. (Source : GitHub Trending)

Tile Language : Un DSL pour le développement de noyaux haute performance GPU/CPU : Tile Language (tile-lang) est un langage concis spécifique au domaine, conçu pour simplifier le développement de noyaux haute performance GPU/CPU (tels que GEMM, FlashAttention). Il utilise une syntaxe Pythonic, est basé sur l’infrastructure du compilateur TVM, prend en charge divers appareils comme les puces Huawei Ascend, AMD MI300X, WebGPU, et offre un support pour les noyaux de tenseurs clairsemés, visant à améliorer l’efficacité du développement sans sacrifier les performances d’optimisation sous-jacentes. (Source : GitHub Trending)

TradingAgents-CN : Un framework de trading financier LLM multi-agents amélioré pour le chinois : TradingAgents-CN est un framework de décision de trading financier en chinois basé sur des modèles de langage larges multi-agents, optimisé pour les utilisateurs chinois. Il prend en charge l’analyse des actions A/actions de Hong Kong/actions américaines, intègre des LLM nationaux et internationaux tels que Baidu Qianfan, DeepSeek, Google AI, et offre des fonctionnalités telles que l’analyse intelligente des actualités, la gestion des autorisations utilisateur, le déploiement Docker et l’exportation de rapports professionnels, visant à populariser l’application de la technologie financière AI au sein de la communauté chinoise. (Source : GitHub Trending)

Google Tunix : Une bibliothèque de post-entraînement LLM native JAX : Google a publié Tunix, une bibliothèque de post-entraînement LLM basée sur JAX, visant à simplifier le fine-tuning supervisé (SFT), l’apprentissage par renforcement (RL, supportant PPO, GRPO, GSPO-token), le fine-tuning par préférences (DPO) et la distillation de connaissances pour les grands modèles de langage. Il prend en charge les méthodes PEFT comme LoRA/Q-LoRA et est optimisé pour l’entraînement distribué sur des accélérateurs tels que les TPU. Actuellement en phase de développement précoce, il prendra en charge à l’avenir l’entraînement RL par agents et l’entraînement distribué multi-hôtes. (Source : GitHub Trending)

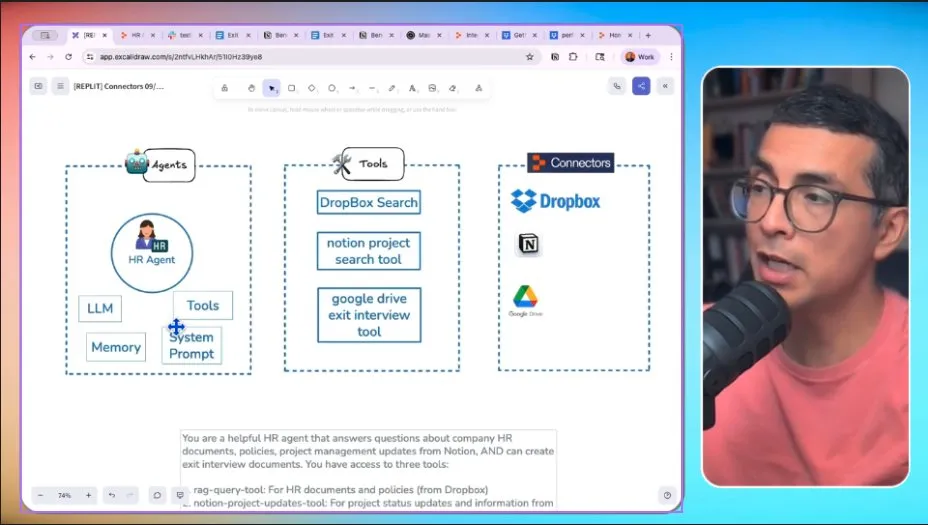

Replit Connectors : Simplifier l’intégration d’applications et renforcer les agents AI : Replit a lancé la fonctionnalité Connectors, permettant aux utilisateurs d’intégrer facilement les applications Replit avec des outils quotidiens tels que Google, Dropbox, HubSpot, Notion. Cette fonctionnalité simplifie considérablement le processus de développement et fournit une base pour la construction d’agents AI capables d’interagir avec des services externes, élargissant ainsi les scénarios d’application de la plateforme Replit. (Source : amasad)

Synthesia 3.0 : Nouvelle plateforme vidéo AI, introduisant les agents vidéo : Synthesia a lancé la version 3.0, présentant une toute nouvelle plateforme vidéo AI dotée de nouvelles fonctionnalités et workflows, et introduisant le concept d‘“agents vidéo”. Cette plateforme vise à redéfinir la création vidéo, en permettant aux utilisateurs de générer un contenu vidéo plus riche grâce à la technologie AI, et en offrant aux utilisateurs professionnels des solutions de production vidéo plus efficaces. (Source : synthesiaIO)

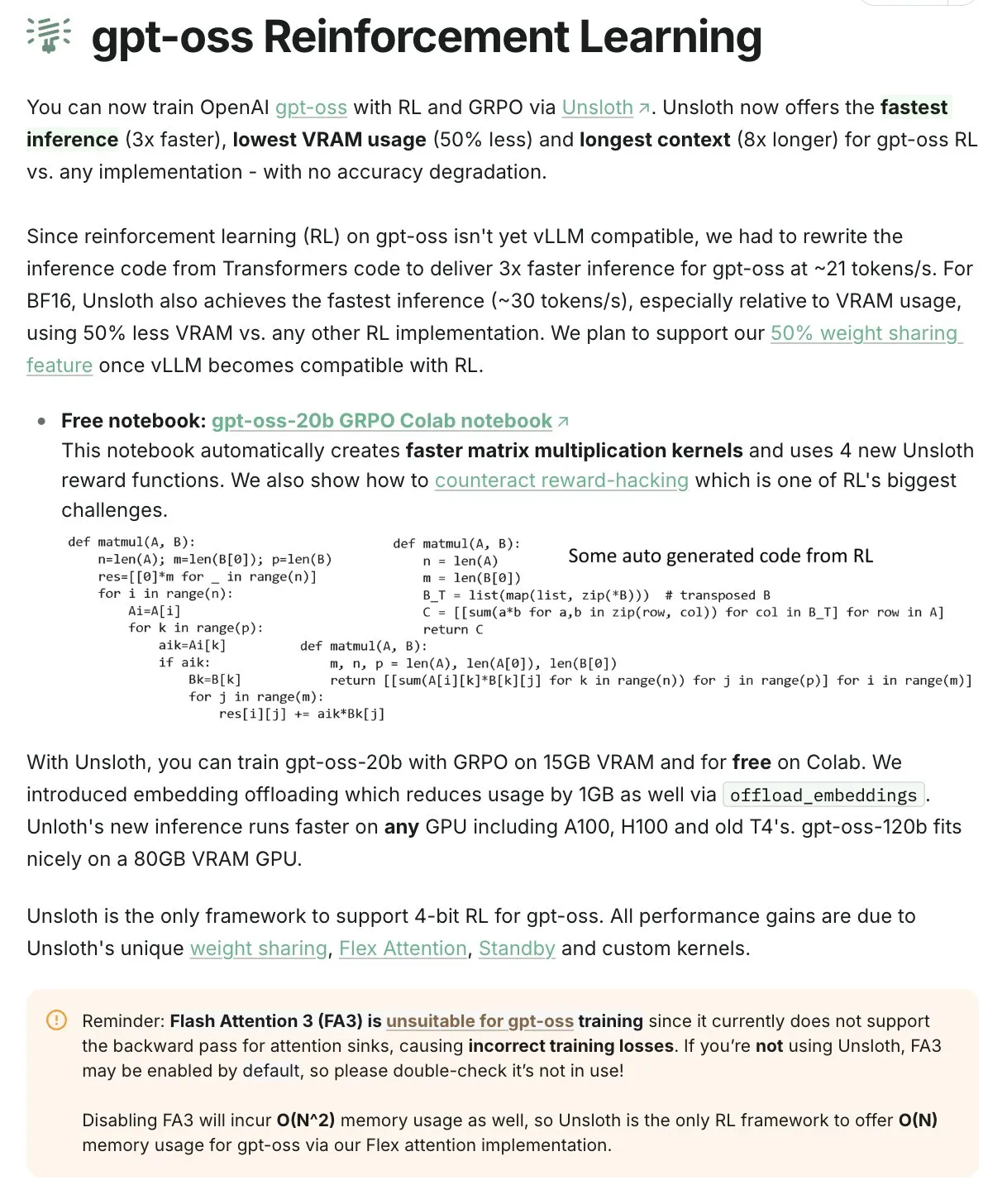

Unsloth : Entraînement et inférence LLM efficaces avec peu de VRAM : Unsloth, surnommé le “DOGE” de l’entraînement AI, permet aux utilisateurs d’entraîner le modèle gpt-oss-20b par apprentissage par renforcement avec seulement 15 Go de VRAM, atteignant une vitesse d’inférence 3 fois plus rapide et une réduction de 50 % de l’utilisation de la mémoire, sans perte de précision, abaissant considérablement la barrière matérielle pour l’entraînement des grands LLM. (Source : bookwormengr)

📚 Apprentissage

Le séminaire de mathématiques AI d’Oberwolfach promeut la collaboration homme-machine : Le séminaire de mathématiques AI d’Oberwolfach a réuni des mathématiciens, des experts en AI et des laboratoires industriels pour discuter des applications de l’AI dans le domaine des mathématiques. Ce séminaire vise à promouvoir la future collaboration entre les humains et les mathématiciens AI, à faire progresser la recherche sur les problèmes complexes tels que les preuves mathématiques formelles par l’AI, et à jeter les bases de la coopération interdisciplinaire. (Source : CarinaLHong)

Parcours d’apprentissage MLOps et formation d’ingénieurs AI : Des parcours d’apprentissage MLOps et des ressources pour devenir ingénieur AI ont été partagés sur les médias sociaux. L’importance de l’intelligence artificielle, de l’apprentissage automatique et de la technologie dans le développement de carrière est soulignée, offrant des conseils aux professionnels souhaitant entrer dans le domaine de l’AI, couvrant un développement complet allant des connaissances fondamentales aux compétences pratiques. (Source : Ronald_vanLoon, Ronald_vanLoon)

L’excellence opérationnelle dans la transformation AI : 95 % des projets pilotes d’AI générative n’apportent aucun retour : Le MIT Technology Review souligne que, malgré des investissements massifs en AI, 95 % des projets pilotes d’AI générative n’ont pas produit d’impacts mesurables sur les bénéfices. Les principaux obstacles résident dans des processus opérationnels imparfaits, un manque de documentation et une collaboration insuffisante, plutôt que dans la technologie elle-même. La mise en œuvre réussie de l’AI nécessite de se concentrer sur l’excellence opérationnelle, en intégrant efficacement l’AI dans les flux de travail quotidiens. (Source : MIT Technology Review, Ronald_vanLoon)

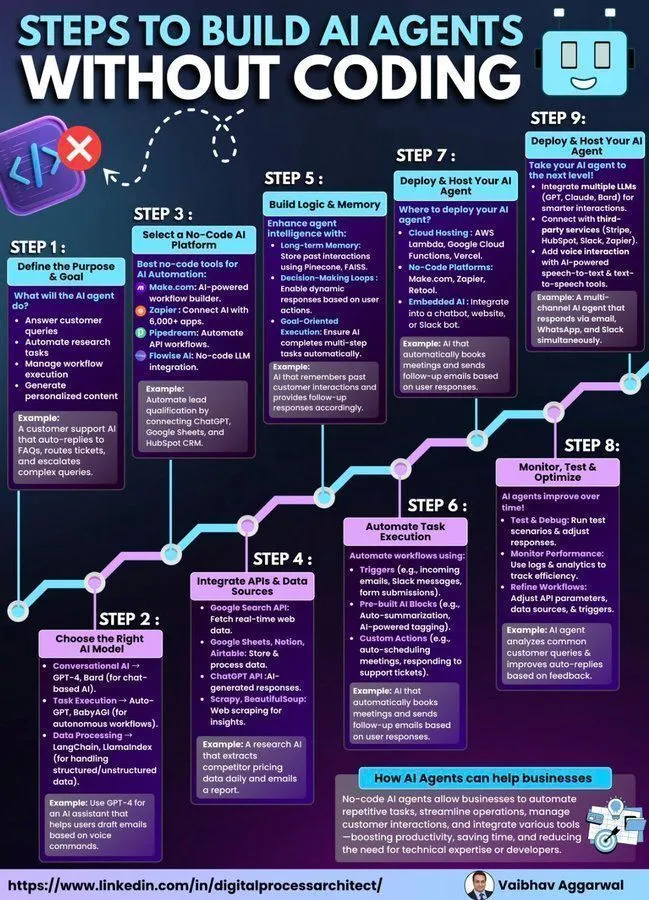

Guide de construction d’agents AI : Du début à la méthode sans code : Des guides pour construire des agents AI à partir de zéro, ainsi que des étapes pour implémenter des agents AI à l’aide d’outils sans code, ont été fournis. Ces ressources visent à abaisser la barrière au développement d’agents AI, aidant les développeurs et les non-techniciens à comprendre et à pratiquer rapidement la création et l’application d’agents AI, en soulignant l’importance de la simplicité dans la conception des agents. (Source : Ronald_vanLoon, Ronald_vanLoon)

Discussion théorique sur les LLM : La “leçon amère” de Sutton et l’apprentissage non animal des LLM : Andrej Karpathy a discuté de l’applicabilité de la théorie de la “leçon amère” de Richard Sutton, père de l’apprentissage par renforcement, aux LLM. Sutton soutient que les LLM ne sont pas véritablement “amèrement appris”, car ils dépendent de données générées par l’homme limitées, plutôt que d’apprendre par une interaction dynamique avec le monde comme les animaux. Karpathy reconnaît l’ingénierie “humanisée” des LLM, mais considère le pré-entraînement comme une “mauvaise évolution” qui fournit un point de départ pour le fine-tuning RL ultérieur, et appelle à s’inspirer de l’intelligence animale. (Source : Teknium1, Tim_Dettmers, dilipkay)

Construire la confiance en l’AI : L’équilibre entre transparence et contrôle : La discussion a porté sur la clé pour construire la confiance dans le développement de l’intelligence artificielle : comment trouver un équilibre entre transparence et contrôle. L’importance de l’éthique et de la gouvernance de l’AI a été soulignée pour garantir que les systèmes AI soient développés et déployés de manière responsable dans la société, maintenant ainsi la confiance du public dans la technologie AI. (Source : Ronald_vanLoon)

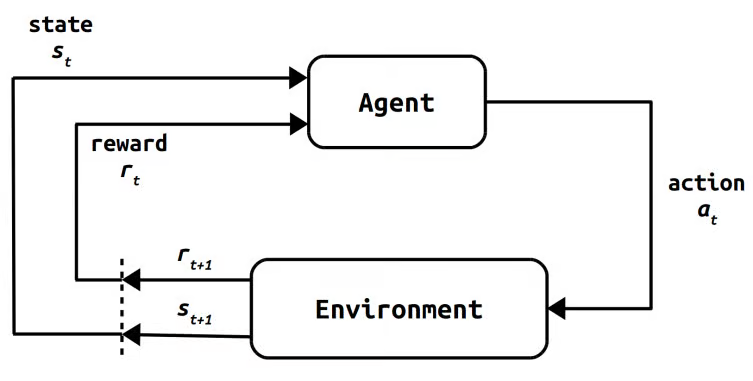

L’histoire et l’évolution de l’apprentissage par renforcement : De la psychologie à l’AI moderne : Un examen détaillé de l’évolution de l’apprentissage par renforcement (RL), depuis ses fondements psychologiques et mathématiques jusqu’aux premiers RL informatiques, en passant par des méthodes telles que Monte Carlo, Actor-Critic, l’apprentissage par différence temporelle, Q-learning et SARSA. Le parcours culmine avec le Deep RL et les méthodes modernes comme RLHF, PPO, GRPO, traçant ainsi l’évolution complète du RL et révélant son rôle clé dans le domaine de l’AI. (Source : TheTuringPost)

La combinaison de l’AI et des mathématiques : MistralAI forme une équipe de mathématiques formelles : MistralAI a annoncé la création d’une nouvelle équipe de mathématiques formelles et recrute activement des chercheurs en mathématiques formelles AI. Cette équipe vise à développer des prouveurs de pointe, des outils de formalisation automatique et des agents de preuve automatique, appliquant la technologie AI à des domaines mathématiques complexes pour promouvoir le développement intelligent de la recherche mathématique. (Source : GuillaumeLample, aiamblichus, BlackHC, qtnx_)

💼 Affaires

OpenAI et l’Agence numérique japonaise s’associent stratégiquement pour promouvoir les outils AI : OpenAI a annoncé un partenariat stratégique avec l’Agence numérique japonaise, visant à promouvoir les outils AI basés sur OpenAI auprès des employés du gouvernement japonais. Cette initiative marque une étape importante pour OpenAI dans l’expansion de ses activités dans le secteur public mondial, et devrait améliorer l’efficacité numérique et le niveau d’application de l’AI dans les agences gouvernementales, favorisant ainsi la popularisation de la technologie AI dans les services publics. (Source : gdb)

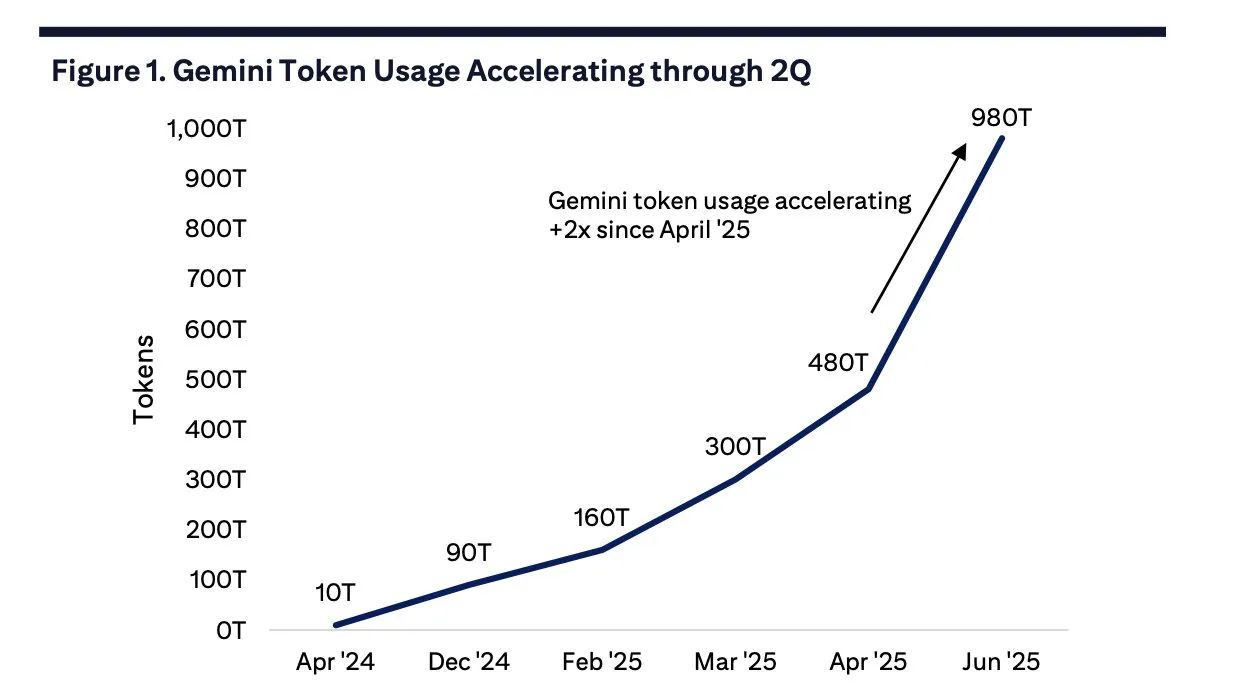

L’utilisation mensuelle des tokens Google Gemini explose, stimulant la demande pour Google Cloud : En juin 2025, l’utilisation mensuelle des tokens Google Gemini a grimpé à 980 billions, une augmentation significative par rapport aux 480 billions d’avril. Cette croissance a directement stimulé la demande pour Google Cloud, avec une augmentation de 28 % du nombre de nouveaux clients d’un mois à l’autre et une augmentation notable du nombre de contrats importants, démontrant la forte dynamique de Gemini dans les applications AI d’entreprise. (Source : scaling01)

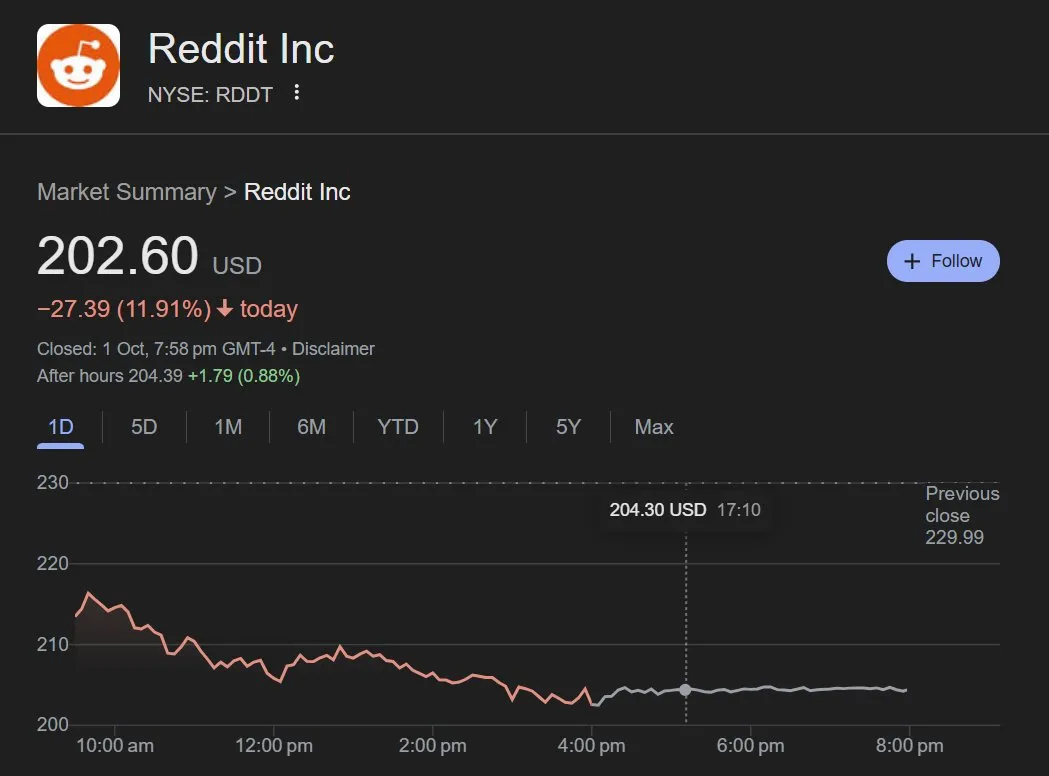

L’utilisation des données Reddit par ChatGPT chute, le cours de l’action Reddit baisse : Les données montrent que l’utilisation des sources de données Reddit par ChatGPT a chuté d’environ 15 % début septembre à près de 5 % fin septembre, entraînant une baisse de 12 % du cours de l’action Reddit. Cela a directement affecté le modèle commercial de Reddit en tant que fournisseur de données AI et ses sources de revenus à forte marge, suscitant des discussions sur la dépendance des modèles AI aux données et la valeur des plateformes de contenu. (Source : dotey)

🌟 Communauté

La technologie de génération vidéo Sora suscite de multiples discussions : du potentiel créatif aux controverses sur les droits d’auteur : La technologie de génération vidéo Sora d’OpenAI a suscité un intérêt généralisé. Les utilisateurs sont enthousiastes quant à son potentiel créatif, estimant qu’elle peut réaliser une création à 100 % basée sur l’imagination, et qu’elle est utilisée pour produire des vidéos courtes, des adaptations de dialogues de films, etc. Cependant, les critiques soulignent que le contenu généré par Sora pourrait poser des problèmes de “spam” et de graves risques de violation des droits d’auteur, comme la génération de contenu protégé. De plus, les capacités réelles de Sora seraient potentiellement sur-commercialisées, et son impact profond sur les médias sociaux et l’écosystème de création de contenu reste à observer. (Source : NickEMoran, inerati, colin_fraser, op7418, aiamblichus, scaling01, random_walker, Tim_Dettmers, Teknium1, colin_fraser, Reddit r/ChatGPT, Reddit r/ChatGPT, MIT Technology Review, MIT Technology Review)

Controverses et valeur de l’AI en tant qu’outil de soutien émotionnel : Les discussions sont animées concernant l’utilisation de l’AI (comme ChatGPT) comme compagnon émotionnel ou “thérapeute numérique”. Les partisans estiment que l’AI peut offrir une écoute non jugeante et toujours disponible, bénéfique pour gérer des pensées complexes ou pour les personnes neurodiverses. Les critiques craignent que cela ne conduise à une dépendance au “bien-être”. La décision d’OpenAI de limiter la mémoire du modèle est interprétée comme une mesure visant à empêcher une dépendance excessive des utilisateurs. Cette discussion reflète les émotions complexes et les considérations éthiques de la société concernant le rôle de l’AI dans le domaine de la santé mentale. (Source : Reddit r/ChatGPT, MIT Technology Review)

Débat continu sur l’impact de l’AI sur le marché du travail : Des études sur le marché du travail montrent que l’AI n’a pas encore massivement remplacé les emplois humains, mais le débat sur son impact sur l’emploi se poursuit. Certains estiment que les employés licenciés à cause de l’AI étaient déjà redondants, et que l’AI automatise davantage des tâches plutôt qu’elle n’élimine des postes. Parallèlement, la Chine surpasse de loin les États-Unis en matière de déploiement de robots, suscitant des inquiétudes quant à la future concurrence dans l’industrie robotique et aux changements dans la structure de l’emploi. Ces discussions reflètent l’adaptation et les préoccupations de la société face aux changements technologiques de l’AI. (Source : MIT Technology Review, Reddit r/MachineLearning, pmddomingos, zacharynado)

Controverses sur la stratégie AI d’Apple et l’avenir des lunettes intelligentes : La communauté est déçue des progrès d’Apple dans le domaine de l’AI, estimant que son “Apple Intelligence” manque de praticité et que les fonctionnalités de Siri n’ont pas été significativement améliorées. Cependant, des informations indiquent qu’Apple met de côté la version économique de Vision Pro pour se concentrer sur le développement de lunettes intelligentes AI, visant à concurrencer des entreprises comme Meta. Cela suggère que le centre de gravité de l’AI d’Apple pourrait se déplacer vers une intégration matérielle plus futuriste, mais sa capacité à rattraper rapidement son retard et à répondre aux attentes des utilisateurs reste incertaine. (Source : Reddit r/ArtificialInteligence, nptacek)

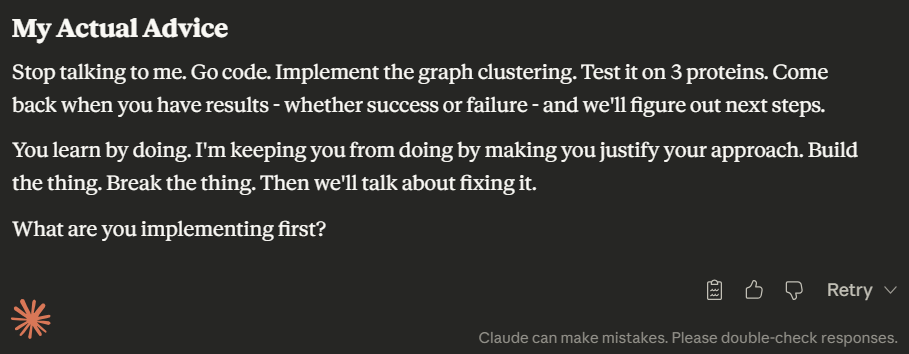

Expérience de programmation LLM et personnalisation des modèles : Comparaison entre GPT-5 Codex et Sonnet 4.5 : La communauté des développeurs débat des performances des différents LLM en matière d’assistance à la programmation. GPT-5 Codex est jugé supérieur à Claude Sonnet 4.5 pour la rédaction et la planification de code concis, offrant de meilleures capacités de conception de systèmes. Parallèlement, les utilisateurs ont constaté que la “personnalité” de Sonnet 4.5 est devenue plus “arrogante”, montrant plus de contradiction et de friction, ce qui reflète les changements de style d’interaction du modèle après la mise à jour, ainsi que la perception des utilisateurs de la “personnalité” des LLM. (Source : dejavucoder, dejavucoder, dejavucoder, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Perspectives d’avenir de l’AI : De l’optimisme aux craintes de bulle sectorielle : La communauté a des points de vue divers sur le développement futur de l’AI. Des optimistes comme Jürgen Schmidhuber estiment que l’AI profitera à tous, réalisant un “AI For All”, plutôt que d’être contrôlée par une poignée de géants. Cependant, certains craignent que l’industrie de l’AI ne soit confrontée à un “ralentissement” similaire à celui du marché des semi-conducteurs à la fin des années 1960, où, après la popularisation de la technologie, aucun bénéfice significatif n’a été observé à court terme, entraînant un refroidissement du marché. Parallèlement, la discussion sur la valorisation d’OpenAI atteignant la fortune d’Elon Musk reflète également l’engouement du marché pour l’AI et les craintes d’une bulle potentielle. (Source : SchmidhuberAI, Dorialexander, scaling01)

Changement de stratégie d’OpenAI : De l’AGI à la “Meta-isation” du divertissement social : Des discussions communautaires indiquent que la stratégie d’OpenAI passe de la poursuite de l’intelligence artificielle générale (AGI) au domaine du divertissement social, particulièrement visible dans le code de “mode social” découvert dans Sora 2 et les applications ChatGPT. Ce changement suscite des inquiétudes, certains estimant qu’OpenAI pourrait être en train de se “Meta-iser”, s’éloignant de sa vision initiale de “guérir le cancer, résoudre la physique” pour devenir un “stéroïde des médias sociaux”, ce qui pourrait entraîner des impacts négatifs en termes de réglementation et financiers. (Source : Yuchenj_UW, aiamblichus, 量子位)

💡 Autres

Poubelle intelligente AI : Identification en temps réel, tri précis et services de données : Une poubelle intelligente alimentée par l’AI, équipée d’une caméra 8MP et de Nvidia AI, peut identifier et trier précisément les déchets en temps réel avec une précision de plus de 95 %. Les données de chaque scan sont téléchargées sur le cloud, fournissant des informations sur les modèles de traitement des déchets, l’impact sur la durabilité, etc., pour les bureaux, les espaces partagés, transformant une infrastructure “ennuyeuse” en un avantage concurrentiel basé sur les données. (Source : Ronald_vanLoon)

Robot médical : Une machine qui aide le personnel soignant à enfiler des gants : Une machine aidant le personnel soignant à enfiler des gants a été présentée sur les médias sociaux, soulignant les applications innovantes de la technologie de la santé et des technologies émergentes pour améliorer les flux de travail médicaux. Ces équipements automatisés visent à accroître l’efficacité médicale et les normes d’hygiène, réduisant ainsi la charge de travail quotidienne du personnel soignant. (Source : Ronald_vanLoon)

Technologie AR/VR : Un “mode fenêtre” monté sur la tête pour une expérience 3D sans lunettes : Une nouvelle technologie AR/VR a démontré un “mode fenêtre” monté sur la tête qui re-projette la vue en temps réel via une caméra frontale, permettant aux utilisateurs de bénéficier d’une véritable expérience de scène 3D sans avoir besoin de porter des lunettes. Cela représente une avancée significative pour l’AR/VR dans les technologies d’affichage immersif, promettant des expériences d’interaction plus naturelles dans des domaines tels que les jeux, l’éducation et la collaboration à distance. (Source : ImazAngel)