Mots-clés:LLM-JEPA, Apple Manzano, MediaTek Dimensity 9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, Baidu Qianfan-VL, Cadre d’entraînement d’espace d’embedding, Tokeniseur visuel hybride, Architecture double NPU, Benchmark SWE-BENCH PRO, Entrée audio multimodale

🔥 À LA UNE

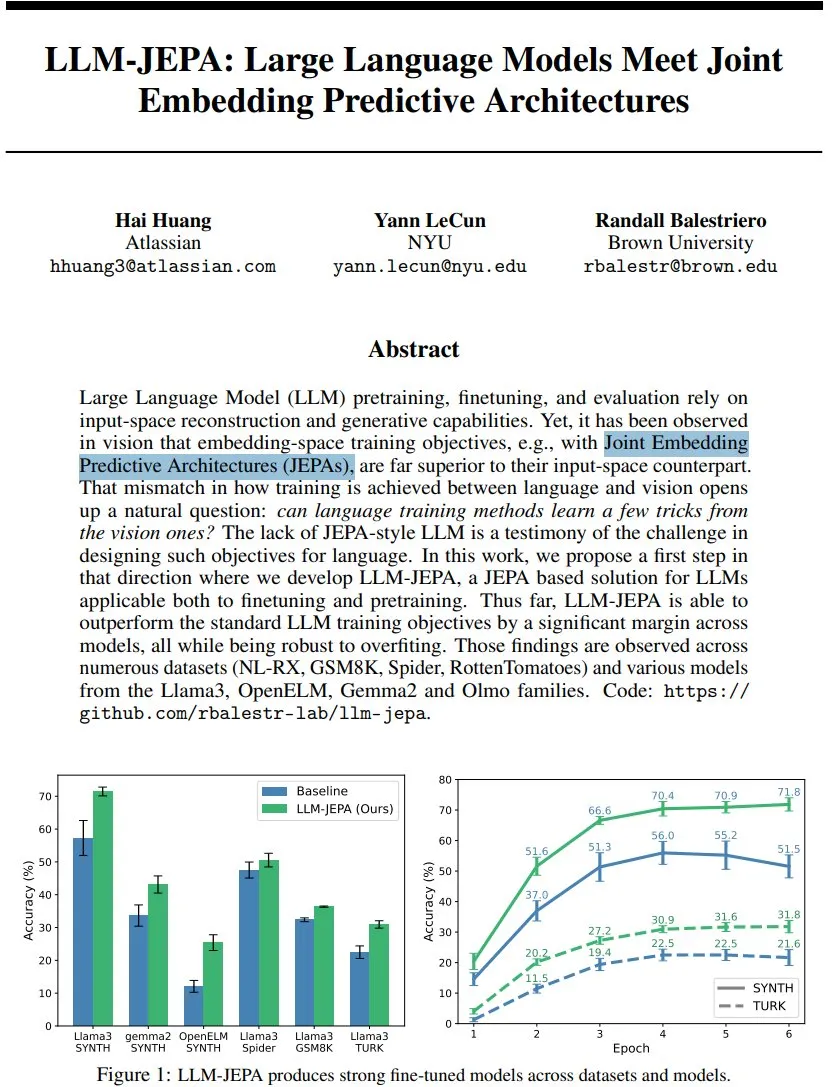

LLM-JEPA : Une nouvelle avancée dans les cadres d’entraînement des modèles linguistiques : Yann LeCun et al. ont proposé LLM-JEPA, le premier cadre d’entraînement de modèle linguistique de style JEPA combinant des objectifs d’espace d’intégration visuelle avec des objectifs de génération de traitement du langage naturel. Ce cadre surpasse les objectifs LLM standard dans plusieurs benchmarks tels que NL-RX, GSM8K, Spider, et fonctionne bien sur des modèles comme Llama3, OpenELM. Il est plus robuste à l’overfitting, efficace en pré-entraînement et en fine-tuning, annonçant que l’entraînement dans l’espace d’intégration pourrait être la prochaine avancée majeure pour les LLM. (Source : ylecun, ylecun)

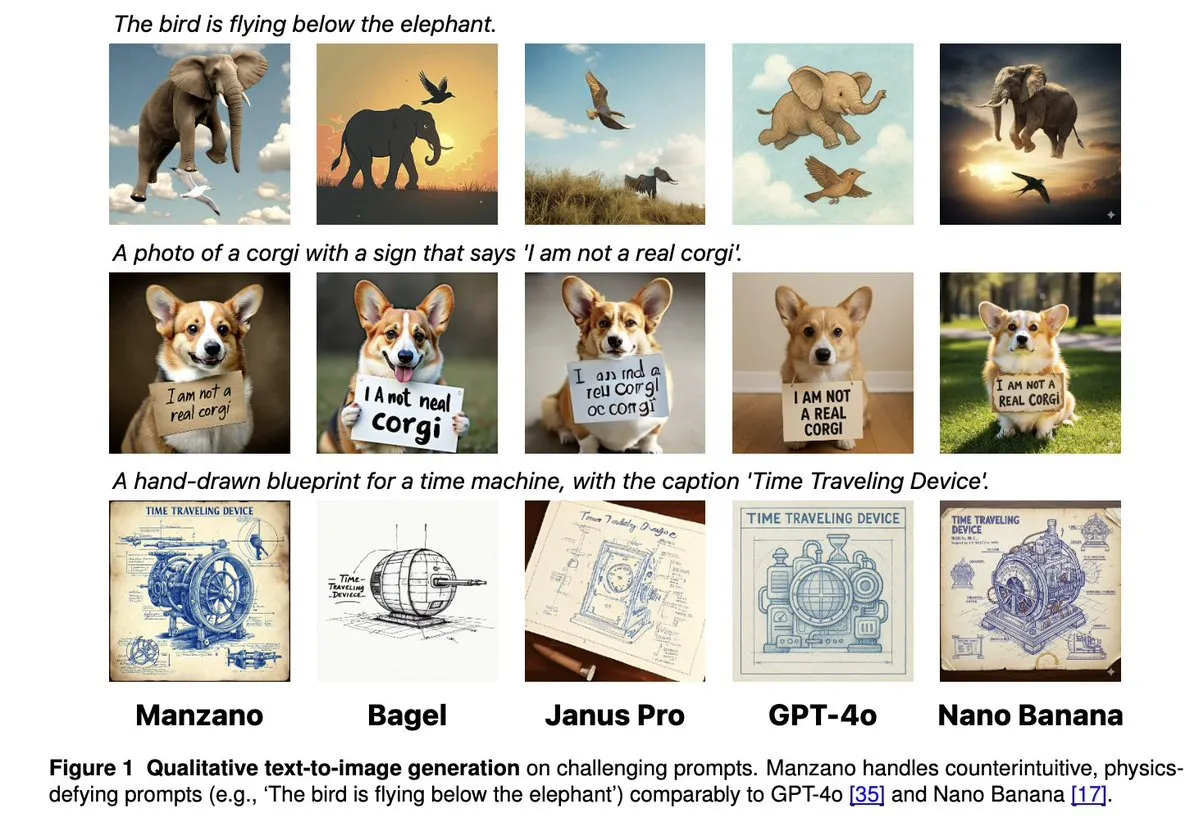

Apple Manzano : Une solution simple et évolutive pour les LLM multimodaux unifiés : Apple a lancé Manzano, un modèle de langage large multimodal unifié, simple et évolutif. Ce modèle utilise un tokenizer visuel hybride, réduisant efficacement les conflits entre les tâches de compréhension et de génération d’images. Manzano atteint l’état de l’art (SOTA) dans les benchmarks à forte densité textuelle (tels que ChartQA, DocVQA) et rivalise avec GPT-4o/Nano Banana en termes de capacités de génération, supportant l’édition via des images conditionnelles, démontrant le puissant potentiel de l’IA multimodale. (Source : arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

MediaTek Dimensity 9500 lance une architecture double NPU, renforçant l’expérience IA proactive : MediaTek a lancé la puce Dimensity 9500, pionnière d’une architecture double NPU ultra-performante et ultra-efficace, visant à offrir une expérience d’IA “Always on” en permanence intelligente. Cette puce a conservé la première place du classement AI des SoC mobiles de l’ETHZ, avec une efficacité d’inférence améliorée de 56% par rapport à la génération précédente. Elle prend en charge la génération d’images 4K ultra-haute qualité côté appareil et une fenêtre de contexte de 128K, posant les bases matérielles pour la réactivité en temps réel et les services personnalisés de l’IA mobile, faisant passer l’IA de “disponible sur appel” à “toujours en ligne par défaut”. (Source : 量子位)

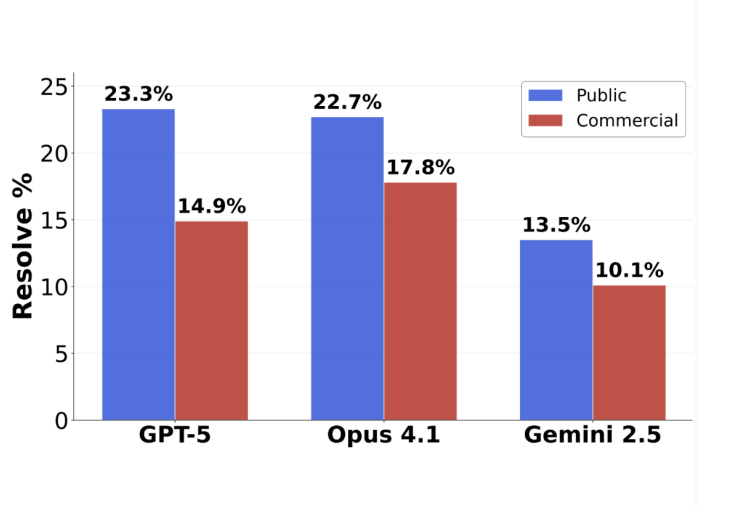

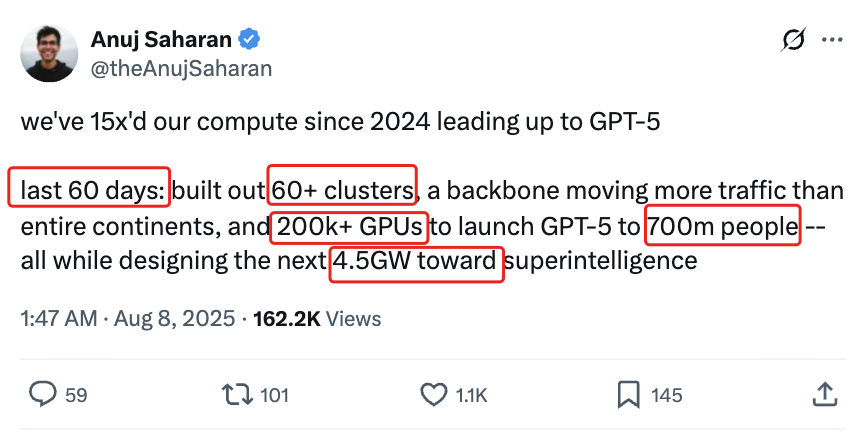

Évaluation de la programmation GPT-5 : Le taux de précision des tâches soumises atteint 63,1% : Le nouveau benchmark d’ingénierie logicielle SWE-BENCH PRO publié par Scale AI montre que GPT-5 atteint un taux de précision de 63,1% sur les tâches soumises, dépassant de loin les 31% de Claude Opus 4.1, indiquant que ses performances restent solides dans ses domaines de prédilection. Le nouveau benchmark utilise de nouveaux problèmes et des scénarios complexes de modification de plusieurs fichiers, testant plus fidèlement les capacités de programmation réelles des modèles. Il révèle que les modèles de pointe actuels sont toujours confrontés à des défis dans les tâches d’ingénierie logicielle de niveau industriel, mais que la capacité réelle de GPT-5 a été sous-estimée en adoptant la stratégie “si je sais, je soumets ; si je ne sais pas, je ne soumets pas”. (Source : 36氪)

🎯 TENDANCES

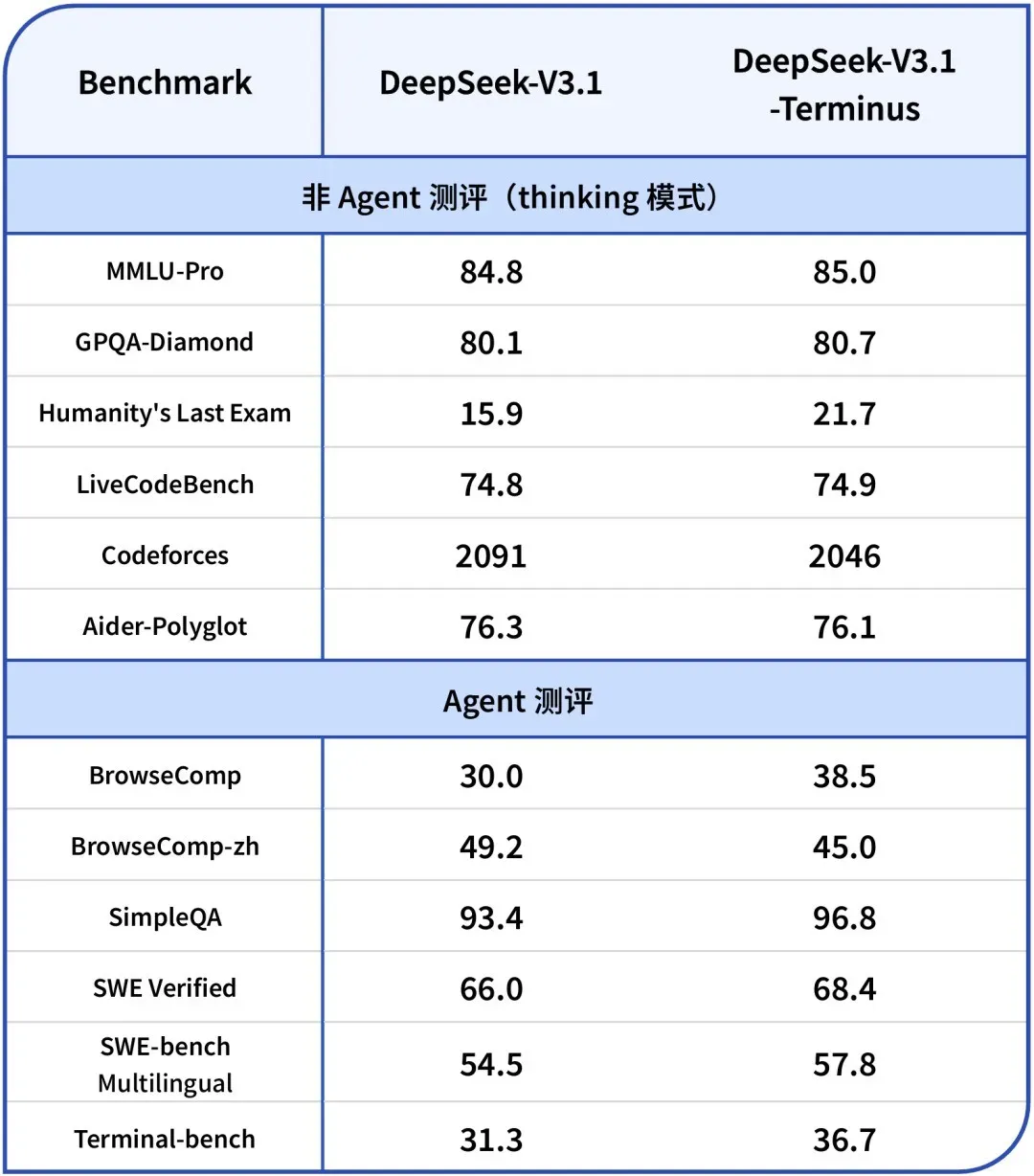

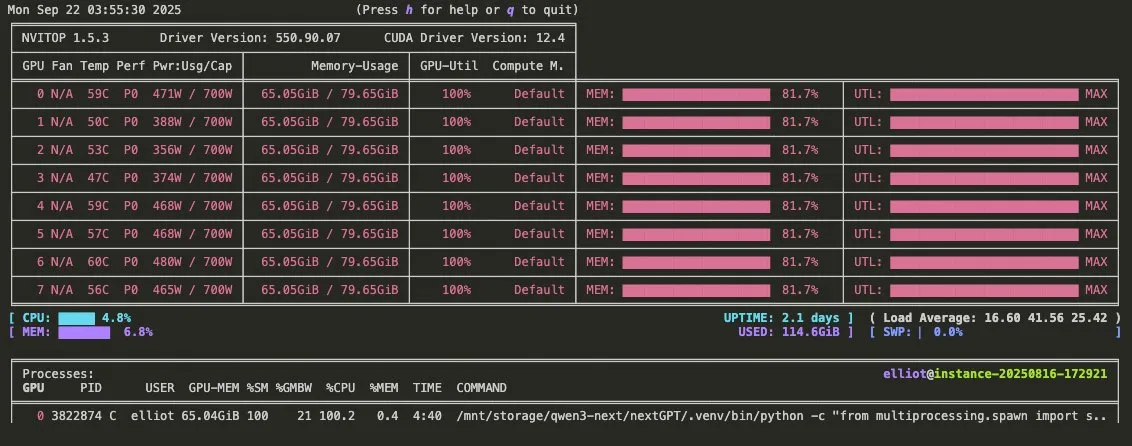

DeepSeek-V3.1-Terminus lancé : Optimisation de la cohérence linguistique et des capacités d’Agent : DeepSeek a publié la version V3.1-Terminus, améliorant principalement la cohérence linguistique (réduisant le mélange chinois-anglais et les caractères anormaux) et optimisant les performances des Code Agent et Search Agent. Le nouveau modèle offre des sorties plus stables et fiables dans les évaluations multi-domaines, et ses poids open source sont désormais disponibles sur Hugging Face et ModelScope, annonçant la finalisation de l’architecture de la série V3 de DeepSeek. (Source : DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

Vidéo promotionnelle de Qwen3-Omni publiée : Prise en charge de l’audio multimodal et de l’appel d’outils : Qwen a publié une vidéo promotionnelle de Qwen3-Omni, annonçant son support pour l’entrée et la sortie audio multimodales, ainsi que des capacités d’appel d’outils natives. Ce modèle devrait devenir un concurrent direct de Gemini 2.5 Flash Native Audio, offrant des modes de pensée et de non-pensée, améliorant considérablement le potentiel de construction d’Agent vocaux, et ses poids seront bientôt publiés. (Source : Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

Baidu rend open source la série de modèles de langage larges multimodaux Qianfan-VL : Baidu AI Cloud a rendu open source la série de modèles de langage larges multimodaux Qianfan-VL (3B, 8B, 70B), optimisée pour les applications d’entreprise. Le modèle combine l’encodeur visuel InternViT et un corpus multilingue amélioré, offrant une longueur de contexte de 32K. Il excelle dans l’OCR, la compréhension de documents, l’analyse de graphiques et la résolution de problèmes mathématiques, et prend en charge le raisonnement par chaîne de pensée, visant à fournir de puissantes capacités générales et une optimisation approfondie pour les scénarios industriels à haute fréquence. (Source : huggingface, Reddit r/LocalLLaMA)

xAI lance le modèle Grok 4 Fast : Fenêtre de contexte de 2M, haute rentabilité : xAI a lancé le modèle Grok 4 Fast, un modèle d’inférence multimodal doté d’une fenêtre de contexte de 2M, visant à établir une nouvelle norme en matière de rentabilité. Cette version pourrait réaliser une inférence rapide grâce à des techniques telles que la quantification FP8 et a optimisé les capacités de programmation Agentic, lui permettant d’équilibrer performance et économie lors du traitement de tâches complexes. (Source : TheRundownAI, Yuhu_ai_)

GPT-5-Codex : OpenAI lance une version de GPT-5 optimisée pour la programmation Agentic : OpenAI a lancé GPT-5-Codex, une version optimisée de GPT-5, spécialement conçue pour la programmation Agentic. Ce modèle vise à améliorer les performances de l’IA dans la génération de code et les tâches d’ingénierie logicielle, s’alignant sur les tendances de développement des workflows Agentic et des LLM multimodaux, et favorisant l’application de l’IA dans le domaine du développement grâce à ses capacités de programmation améliorées. (Source : TheRundownAI, Reddit r/artificial)

La plateforme de développement d’agents intelligents 3.0 de Tencent est lancée mondialement, les technologies clés du laboratoire Youtu restent open source : La plateforme de développement d’agents intelligents de Tencent Cloud 3.0 (ADP3.0) a été lancée mondialement, avec des mises à niveau complètes en matière de RAG, de collaboration Multi-Agent, de Workflow, d’évaluation d’applications et d’écosystème de plugins. Le laboratoire Tencent Youtu continuera à rendre open source des technologies clés d’agents intelligents, y compris le cadre Youtu-Agent et le cadre de graphe de connaissances Youtu-GraphRAG, visant à promouvoir l’accessibilité technologique et la construction ouverte de l’écosystème d’agents, permettant aux entreprises de construire, d’intégrer et d’opérer leurs propres agents IA à faible coût. (Source : 量子位)

Baidu Wenku reçoit une nouvelle certification du Centre national de sécurité industrielle et de l’information, leader dans l’industrie des Smart PPT : Baidu Wenku s’est classé premier dans l’évaluation des grands modèles pour le bureau intelligent du Centre national de sécurité industrielle et de l’information, obtenant la première place dans les six indicateurs, y compris la qualité de génération, la compréhension de l’intention et l’embellissement de la mise en page. Sa fonction Smart PPT offre une solution complète de bout en bout, avec plus de 97 millions d’utilisateurs actifs mensuels de l’IA et plus de 34 millions de visites mensuelles, consolidant sa position de leader dans le domaine des Smart PPT et offrant aux utilisateurs une expérience de création de PPT professionnelle, précise et esthétique. (Source : 量子位)

Google DeepMind lance le Frontier Safety Framework pour faire face aux risques émergents de l’IA : Google DeepMind a publié son dernier “Frontier Safety Framework”, l’approche la plus complète à ce jour, visant à identifier et à anticiper les risques émergents de l’IA. Ce cadre met l’accent sur le développement responsable des modèles d’IA, s’engageant à garantir que les mesures de sécurité évoluent en même temps que les capacités de l’IA, afin de faire face aux défis complexes qui pourraient survenir à l’avenir. (Source : GoogleDeepMind)

Développement des robots humanoïdes et des systèmes d’automatisation : Amélioration de l’interaction et de la stabilité : La technologie robotique continue de progresser, avec notamment RoboForce qui a lancé le robot humanoïde industriel Titan, la plateforme ALLEX de WIROBOTICS qui permet des interactions de type humain avec le toucher, le mouvement naturel et l’équilibre intégré, et le robot Unitree G1 qui a démontré un mode “anti-gravité” pour améliorer la stabilité. De plus, la ferme robotique Hitbot a présenté un système de cueillette automatisé, et les robots de transport mobiles autonomes mettent également l’accent sur la conception de la collaboration homme-machine, propulsant collectivement la transition des robots du calcul à la perception du monde. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

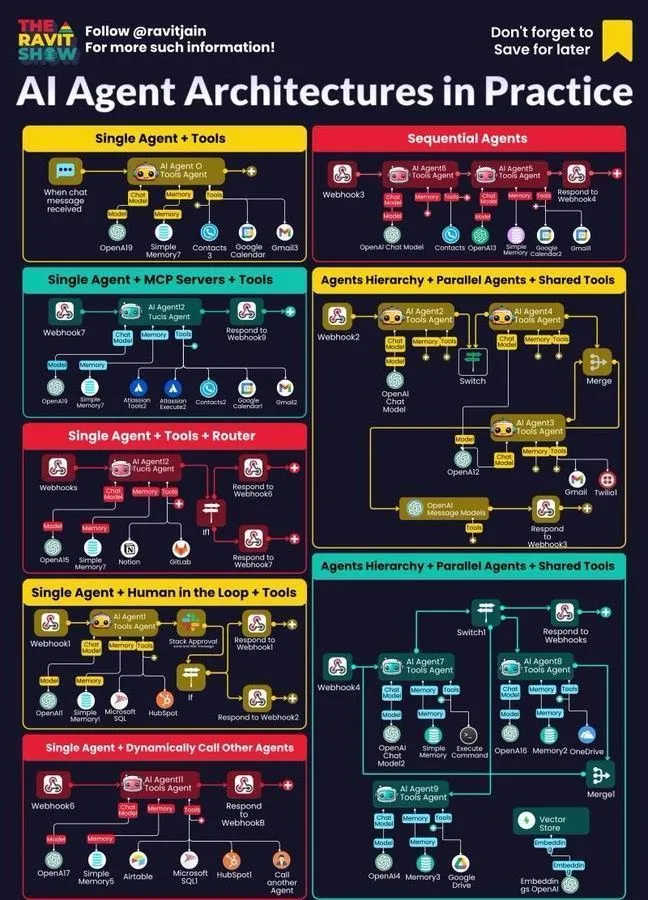

Les AI Agent deviennent le cœur des workflows d’entreprise : Architecture, carte, applications pratiques : Les AI Agent deviennent rapidement le cœur des workflows d’entreprise, et leur conception architecturale, leur carte de l’écosystème et leurs applications pratiques suscitent un intérêt généralisé. L’IA neuro-symbolique est considérée comme une solution potentielle aux hallucinations des LLM, tandis que les études de simulation d’Anthropic indiquent que les modèles d’IA pourraient constituer une menace interne, soulignant les opportunités et les défis de l’IA Agentic dans le déploiement en entreprise, et incitant les entreprises à explorer des méthodes de pratique plus sûres. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 OUTILS

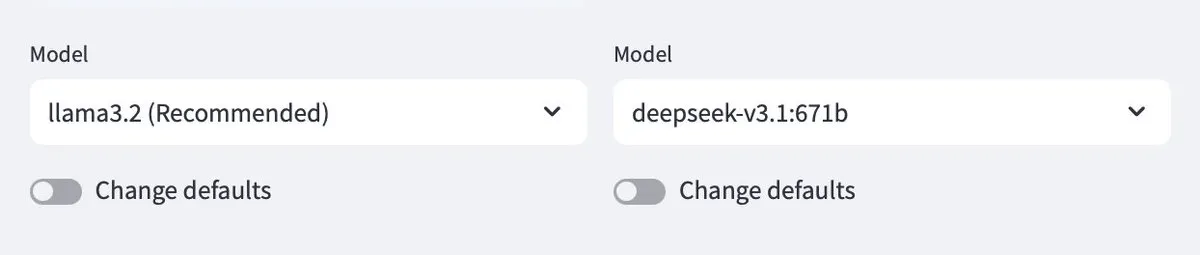

Ollama prend en charge les modèles cloud, permettant l’interaction entre les modèles locaux et cloud : Ollama prend désormais en charge le déploiement de modèles dans le cloud, permettant aux utilisateurs d’interagir entre les modèles Ollama locaux et les modèles hébergés dans le cloud. Cette fonctionnalité est réalisée via l’application Minions, offrant aux utilisateurs une gestion et une utilisation plus flexibles de leurs ressources LLM, qu’elles soient exécutées localement ou accédées via des services cloud, pour une expérience fluide. (Source : ollama)

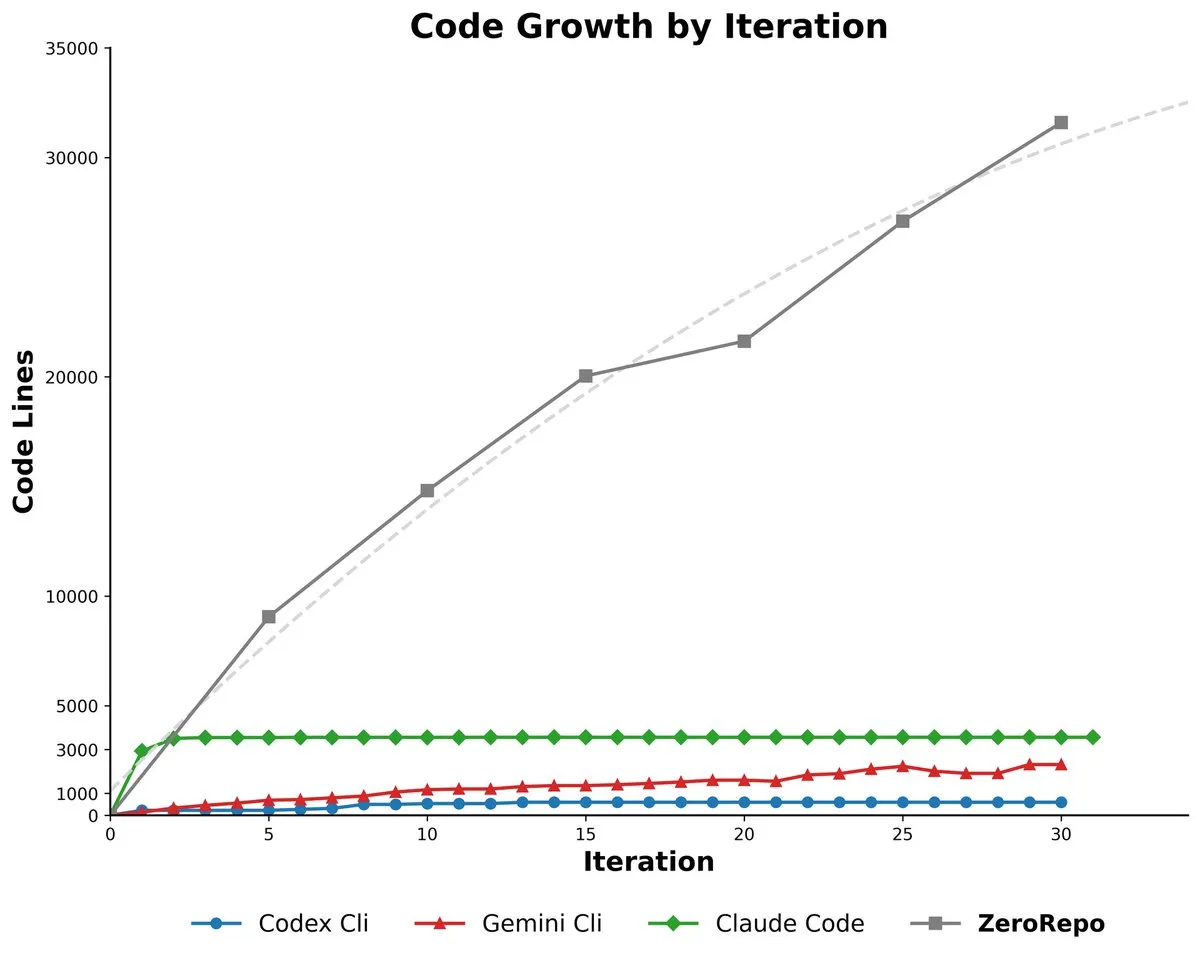

Microsoft ZeroRepo : Génération de bases de code complètes basées sur un cadre piloté par graphe : Microsoft a lancé ZeroRepo, un outil basé sur un cadre piloté par graphe (Repository Planning Graph, RPG), capable de construire des projets logiciels complets à partir de zéro. Cet outil génère 3,9 fois plus de code que les références existantes et atteint un taux de réussite de 69,7%, résolvant le problème de l’inadéquation du langage naturel pour la structure logicielle, et permettant une planification fiable à long terme et la génération de bases de code évolutives. (Source : _akhaliq, TheTuringPost, paul_cal)

DSPy UI : Une interface visuelle pour construire des Agent : DSPy développe une interface utilisateur visuelle (UI) visant à simplifier le processus de construction d’Agent, la rendant similaire à Figma ou Framer, en combinant des Agent par glisser-déposer de composants. Cette UI aidera les utilisateurs à mieux conceptualiser les pipelines d’Agent complexes et à simplifier la syntaxe du code généré, l’objectif final étant de réaliser la génération de diverses versions linguistiques de DSPy et l’exécution de GEPA. (Source : lateinteraction)

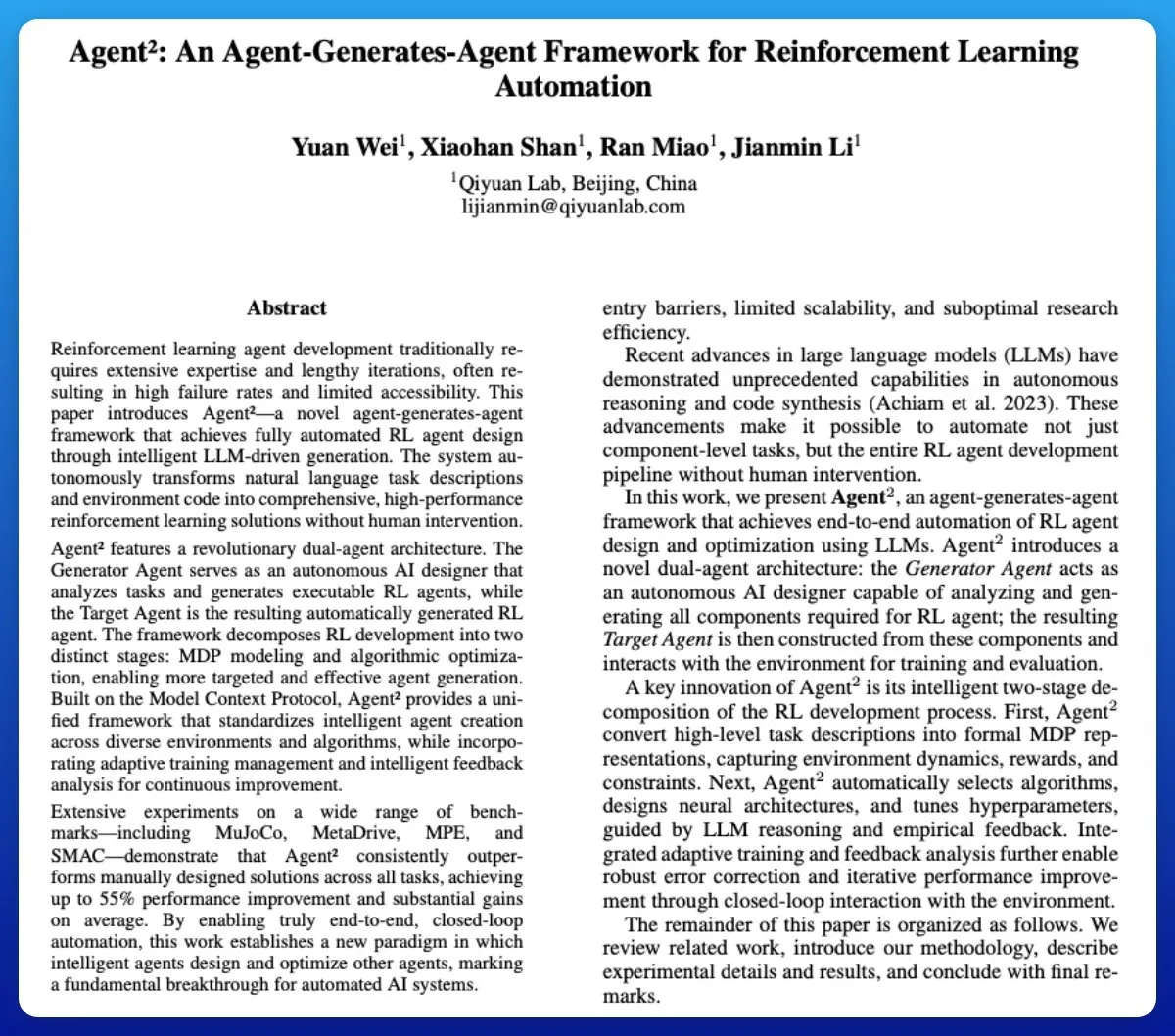

Agent² : Génération d’Agent d’apprentissage par renforcement de bout en bout par LLM : Agent² est un outil qui utilise des modèles de langage larges (LLM) pour générer automatiquement des Agent d’apprentissage par renforcement (RL) de bout en bout. Cet outil génère automatiquement des solutions RL efficaces via le langage naturel et le code d’environnement, sans intervention humaine. Il peut être considéré comme un outil AutoML dans le domaine du RL, simplifiant considérablement le processus de développement des Agent RL. (Source : omarsar0)

Weaviate lance Query Agent, prenant en charge les références, l’introspection de schémas et le routage multi-collections dans les systèmes d’IA : Weaviate a officiellement lancé son Query Agent, qui a atteint la disponibilité générale après six mois de développement. Il prend en charge la génération de références, l’introspection de schémas et le routage multi-collections dans les systèmes d’IA, et améliore les modèles de recherche via le Compound Retrieval System. Le Query Agent vise à simplifier l’interaction avec Weaviate et propose des clients Python et TypeScript, améliorant ainsi l’expérience des développeurs. (Source : bobvanluijt, Reddit r/deeplearning)

Claude Code CLI : Gérer de micro-employés avec une mentalité de SDK, en mettant l’accent sur l’état externe et l’ingénierie des processus : En considérant Claude Code CLI comme un SDK plutôt qu’un simple outil, les développeurs doivent, comme pour la gestion de micro-employés, mettre l’accent sur la gestion de l’état externe (comme les fichiers JSON, les entrées de base de données) pour assurer la continuité de la session, et traiter l’ingénierie des prompts comme de l’ingénierie des processus. Cette approche révèle les limites actuelles des LLM en termes de surcharge contextuelle et d’encombrement de l’interface utilisateur, mais souligne également la valeur immense des outils d’automatisation interne ultra-spécifiques. (Source : Reddit r/ClaudeAI)

Synapse-system : Un système d’assistance IA pour les grandes bases de code basé sur des graphes de connaissances, la recherche vectorielle et des Agent spécialisés : Synapse-system est un système conçu pour améliorer les capacités d’assistance IA pour les grandes bases de code. Il combine un graphe de connaissances (Neo4j) pour stocker les relations de code, la recherche vectorielle (BGE-M3) pour trouver du code sémantiquement similaire, des Agent spécialisés (experts Rust, TypeScript, Go, Python) pour fournir du contexte, et un cache intelligent (Redis) pour un accès rapide aux modèles courants. Grâce à sa conception modulaire, ce système évite un modèle monolithique unique et est optimisé pour les caractéristiques des différentes langues. (Source : Reddit r/ClaudeAI)

Claude Opus 4.0+ : Une application de guide touristique IA générant des visites personnalisées en temps réel : Un développeur a réalisé un rêve de 15 ans en utilisant Claude Opus 4.0 et Claude Code pour créer une application de guide touristique IA. Cette application peut générer en temps réel des visites guidées personnalisées pour n’importe quelle ville et n’importe quel thème (comme “Visite de Venise” ou “Assassin’s Creed à Florence”), avec un guide IA offrant des explications multilingues, des histoires et des questions-réponses interactives. Cette application offre une expérience immersive flexible, pouvant être mise en pause et reprise, à un prix bien inférieur à celui d’un guide humain. (Source : Reddit r/ClaudeAI)

Mindcraft : Minecraft AI combiné avec LLM, permettant le contrôle d’agents in-game via Mineflayer : Le projet Mindcraft combine des modèles de langage larges (LLM) et la bibliothèque Mineflayer pour créer des agents IA pour le jeu Minecraft. Ce projet permet aux LLM d’écrire et d’exécuter du code dans le jeu pour accomplir des tâches telles que l’acquisition d’objets ou la construction de bâtiments. Il prend en charge diverses API LLM (telles que OpenAI, Gemini, Anthropic, etc.) et offre un environnement sandbox, mais avertit les utilisateurs des risques potentiels d’attaques par injection. (Source : GitHub Trending)

AI Agents pour la gestion continue des stocks avec des drones : Combinaison d’AI Agent et de la technologie des drones pour une gestion continue des stocks sans balises ni éclairage. Cette innovation utilise des drones autonomes pour l’inventaire et la gestion des stocks en temps réel via des algorithmes d’IA, promettant d’améliorer considérablement l’efficacité logistique et d’entreposage, de réduire les coûts de main-d’œuvre et de fournir des données plus précises dans des environnements complexes. (Source : Ronald_vanLoon)

Guide d’évaluation des LLM : Bonnes pratiques pour la fiabilité, la sécurité et la performance : Un guide complet d’évaluation des LLM a été publié, détaillant les indicateurs clés, les méthodes et les meilleures pratiques pour évaluer les modèles de langage larges (LLM). Ce guide vise à aider à garantir la fiabilité, la sécurité et les performances des applications basées sur l’IA, en fournissant aux développeurs et aux chercheurs un cadre d’évaluation systématisé pour relever les défis du déploiement des LLM. (Source : dl_weekly)

📚 APPRENTISSAGE

Lukasz Kaiser, scientifique chez OpenAI, sur la pensée des premiers principes des grands modèles : Lukasz Kaiser, scientifique chez OpenAI (l’un des huit “enfants” de Transformer), a partagé ses réflexions sur les “premiers principes” du développement des grands modèles. Il estime que la prochaine étape clé de l’IA est d’enseigner aux modèles à “penser”, en générant davantage d’étapes intermédiaires pour un raisonnement approfondi, plutôt que de produire directement des réponses. Il prédit qu’à l’avenir, la puissance de calcul passera du pré-entraînement à grande échelle à des calculs d’inférence massifs sur une petite quantité de données de haute qualité, un mode plus proche de l’intelligence humaine. (Source : 36氪)

Principes de survie à l’ère de la programmation IA : Andrew Ng insiste sur l’action rapide et la prise de responsabilité : Lors de son discours au Buildathon, Andrew Ng a souligné que la programmation assistée par l’IA accélérera le développement de prototypes indépendants par un facteur de 10, incitant les développeurs à “agir vite et prendre des responsabilités”, en osant expérimenter dans un environnement sandbox. Il a insisté sur la dévalorisation du code, et sur la nécessité pour les développeurs de se transformer en concepteurs de systèmes et en chefs d’orchestre de l’IA, maîtrisant les derniers outils de programmation IA, les blocs de construction IA (ingénierie des prompts/techniques d’évaluation/MCP) et les capacités de prototypage rapide, réfutant l’idée qu’il n’est pas nécessaire d’apprendre à programmer à l’ère de l’IA. (Source : 36氪)

“Deep Learning with Python” troisième édition disponible gratuitement en ligne : François Chollet a annoncé la publication de la troisième édition de son ouvrage “Deep Learning with Python”, disponible également en version complète et gratuite en ligne. Cette initiative vise à abaisser le seuil d’apprentissage du deep learning, permettant à davantage de personnes intéressées par l’intelligence artificielle d’accéder à des ressources d’apprentissage de haute qualité et de promouvoir la diffusion des connaissances. (Source : fchollet, fchollet)

“Kaggle Grandmasters Playbook” : 7 techniques pratiques de modélisation tabulaire : L’équipe des Kaggle Grandmasters, dont Gilberto Titericz Jr, a publié le “Kaggle Grandmasters Playbook”, basé sur des années d’expérience en compétition et en pratique. Ce manuel rassemble 7 techniques de modélisation de données tabulaires éprouvées en pratique, visant à aider les data scientists et les ingénieurs en machine learning à améliorer leurs compétences en traitement de données tabulaires et en construction de modèles, particulièrement adapté aux compétitions Kaggle et aux défis de données du monde réel. (Source : HamelHusain)

Pénurie d’ingénieurs IA, programmes universitaires gravement déconnectés : Andrew Ng a souligné que malgré l’augmentation du taux de chômage des diplômés en informatique, les entreprises sont toujours confrontées à une grave pénurie d’ingénieurs en IA. La contradiction fondamentale réside dans le fait que les programmes universitaires n’ont pas couvert en temps voulu des compétences clés telles que la programmation assistée par l’IA, l’appel de grands modèles linguistiques, la construction de workflows RAG/Agentic, et les processus normalisés d’analyse d’erreurs. Il a appelé le système éducatif à accélérer la mise à jour des programmes pour former des ingénieurs dotés des derniers modules de construction d’IA et de capacités de prototypage rapide. (Source : 36氪)

Guide d’évaluation des LLM : Bonnes pratiques pour la fiabilité, la sécurité et la performance : Un guide complet d’évaluation des LLM a été publié, détaillant les indicateurs clés, les méthodes et les meilleures pratiques pour évaluer les modèles de langage larges (LLM). Ce guide vise à aider à garantir la fiabilité, la sécurité et les performances des applications basées sur l’IA, en fournissant aux développeurs et aux chercheurs un cadre d’évaluation systématisé pour relever les défis du déploiement des LLM, et assurer la qualité et la confiance des utilisateurs dans les produits d’IA. (Source : dl_weekly)

💼 AFFAIRES

Frénésie d’investissement dans l’infrastructure IA : Les dépenses des centres de données IA aux États-Unis pourraient atteindre 520 milliards de dollars en 2025 : Selon le Wall Street Journal et The Economist, les États-Unis connaissent une frénésie de dépenses en centres de données IA, qui devraient atteindre 520 milliards de dollars en 2025, dépassant le pic des dépenses en télécommunications de l’ère Internet. À court terme, cela a stimulé le PIB américain, mais à long terme, cela pourrait entraîner une pénurie de fonds dans d’autres secteurs, des licenciements massifs, et un risque élevé de dépréciation dû à la rapidité d’itération du matériel IA, soulevant des préoccupations économiques structurelles et posant des défis à la santé économique à long terme des États-Unis. (Source : 36氪)

OpenAI annonce que de nouvelles fonctionnalités seront payantes : Les utilisateurs Pro devront payer un supplément, en raison des coûts élevés : Sam Altman, PDG d’OpenAI, a annoncé que plusieurs nouvelles fonctionnalités gourmandes en calcul seraient lancées dans les prochaines semaines. En raison de leurs coûts élevés, ces fonctionnalités seront initialement disponibles uniquement pour les abonnés Pro à 200 $ par mois, et pourraient même nécessiter des frais supplémentaires. Altman a déclaré que l’équipe s’efforçait de réduire les coûts, mais cette mesure indique que le modèle commercial des services d’IA pourrait évoluer vers un modèle d’embauche d’employés à l’heure, posant de nouveaux défis pour les utilisateurs et l’industrie. (Source : The Verge, op7418, amasad)

Une startup reçoit un montant colossal de crédits OpenAI et cherche à les monétiser : Une startup technologique a obtenu 120 000 dollars de crédits Azure OpenAI, bien au-delà de ses besoins, et cherche des moyens de les monétiser. Cela reflète un déséquilibre potentiel entre l’offre et la demande de ressources IA sur le marché, ainsi que l’exploration par les entreprises de la manière d’utiliser et de monétiser efficacement les ressources de calcul IA excédentaires, ce qui pourrait également donner naissance à de nouveaux modèles de transaction de ressources IA. (Source : Reddit r/deeplearning)

🌟 COMMUNAUTÉ

Impact négatif de l’IA sur la pensée critique : La dépendance excessive entraîne une dégradation des capacités : Les réseaux sociaux débattent vivement du fait que l’utilisation généralisée de l’IA entraîne une dégradation de la capacité de pensée critique humaine. Certains estiment que lorsque les gens n’utilisent plus leurs “muscles de la pensée”, ces capacités s’atrophient. Bien que l’IA puisse améliorer l’efficacité, elle peut aussi faire perdre aux gens la capacité de penser en profondeur dans des domaines clés, soulevant des inquiétudes quant à son impact à long terme sur les capacités cognitives humaines. (Source : mmitchell_ai)

Dilemmes éthiques de l’IA dans la santé : Les avantages et inconvénients de Delphi-2M pour prédire les maladies : Le nouveau modèle d’IA Delphi-2M peut analyser les données de santé pour prédire le risque de l’utilisateur de contracter plus d’un millier de maladies au cours des 20 prochaines années. La discussion communautaire a souligné que connaître à l’avance les risques de maladie peut entraîner des interventions préventives positives, mais aussi une anxiété à long terme, et soulever des risques de confidentialité et de discrimination si les compagnies d’assurance ou les employeurs accèdent à de telles données. Alors que les outils d’IA ne sont pas encore matures, leurs implications éthiques et sociales potentielles sont déjà devenues un point central. (Source : Reddit r/ArtificialInteligence)

Le phénomène de “ramollissement cérébral par l’IA” dû à l’utilisation quotidienne de l’IA : La dépendance excessive réduit la capacité de réflexion : Dans les discussions sociales, de nombreux utilisateurs se plaignent que l’IA est surutilisée dans la vie quotidienne, entraînant une diminution de la capacité de réflexion des gens. Des décisions simples (quel film regarder, quoi manger) aux problèmes complexes (questions d’organisation universitaire), l’IA est fréquemment consultée, même si les réponses sont erronées ou facilement accessibles. Ce phénomène de “ramollissement cérébral par l’IA” non seulement réduit l’engagement personnel, mais favorise également la propagation de fausses informations, suscitant une profonde réflexion sur les limites de l’utilisation de l’IA. (Source : Reddit r/ArtificialInteligence)

Fatigue liée à l’utilisation des outils de programmation IA : Les développeurs ressentent une diminution de l’engagement mental : De nombreux développeurs rapportent que l’utilisation quotidienne d’outils de programmation IA (comme Claude Code), bien qu’elle améliore la productivité, entraîne une fatigue mentale et une diminution de l’engagement. Ils se retrouvent davantage en “mode révision” plutôt qu’en résolution active de problèmes, et le processus d’attente de la génération de sorties par l’IA les fait se sentir passifs. La communauté explore comment équilibrer l’assistance de l’IA avec le maintien de l’activité mentale, afin d’éviter la charge cognitive et la diminution de la créativité. (Source : Reddit r/artificial, Reddit r/ClaudeAI)

Un quart des jeunes adultes interagissent avec l’IA à des fins romantiques et sexuelles : Une étude montre qu’un quart des jeunes adultes interagissent avec l’IA à des fins romantiques et sexuelles. Ce phénomène a suscité des discussions au sein de la communauté sur la solitude, le manque d’interactions humaines et le rôle de l’IA dans le soutien émotionnel. Bien que l’IA puisse offrir un certain réconfort, beaucoup remettent en question sa capacité à remplacer des relations humaines véritablement significatives et s’inquiètent de son impact à long terme sur les modes d’interaction sociale. (Source : Reddit r/ArtificialInteligence)

Menaces de sécurité de l’IA : Le crowdsourcing des vulnérabilités des grands modèles révèle de nouveaux risques, l’injection de prompts est courante : Le premier test de crowdsourcing en ligne en Chine pour les grands modèles d’IA a révélé 281 vulnérabilités de sécurité, dont 177 sont spécifiques aux grands modèles, représentant plus de 60%. Les risques typiques incluent les sorties inappropriées, les fuites d’informations, l’injection de prompts (la plus courante) et les attaques par consommation illimitée. Les modèles grand public nationaux tels que Tencent Hunyuan et Baidu Wenxin Yiyan ont montré de bonnes performances. La communauté avertit que la confiance non préparée des utilisateurs envers l’IA peut entraîner des fuites de confidentialité, en particulier lors de la consultation sur des questions privées. (Source : 36氪)

Dilemmes éthiques des AI Agent : Décision et responsabilité face à un taux d’erreur de 10% dans les systèmes de surveillance urbaine IA : La communauté a discuté d’un scénario hypothétique concernant le dilemme éthique des AI Agent : un système de surveillance urbaine basé sur l’IA avec un taux de fausses alertes de 10%, marquant des innocents comme des menaces potentielles. La discussion s’est concentrée sur la manière d’équilibrer la pression de déploiement et les principes éthiques (tels que le principe de Blackstone). Les solutions proposées incluent : la formation d’équipes de collaboration homme-machine pour résoudre les problèmes, le transfert des coûts des fausses alertes à la direction, la suppression complète des enregistrements des personnes mal étiquetées et des excuses, et la considération de la démission en cas de “perte totale de confiance publique et d’ignorance avide de la direction”. (Source : Reddit r/artificial)

Conscience de l’IA et définition de l’AGI : Andrew Ng estime que l’AGI est devenu un terme marketing, la conscience est une question philosophique : Andrew Ng a souligné dans son discours que l’intelligence artificielle générale (AGI) est passée d’un terme technique à un terme marketing, sa définition étant floue, ce qui entraîne un manque de normes unifiées dans l’industrie concernant les affirmations de “réalisation de l’AGI”. Il estime que la conscience est une question philosophique importante, et non scientifique, et qu’il manque actuellement de critères de mesure. Les ingénieurs et les scientifiques devraient se concentrer sur la construction de systèmes d’IA réellement utiles, plutôt que de s’enliser dans les débats philosophiques sur la conscience. (Source : 36氪)

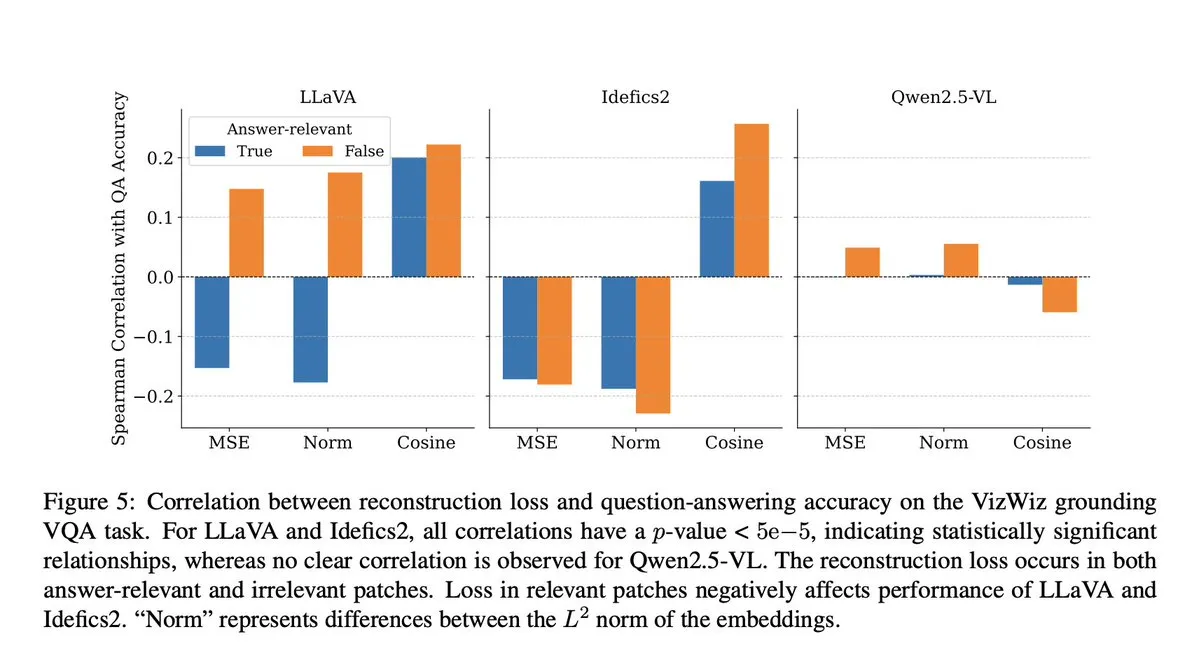

Triche des modèles d’IA : Une étude VLM révèle que l’étape de projection entraîne une perte de contexte sémantique : La communauté a discuté d’une étude de Microsoft qui révèle que les modèles visuels-linguistiques (VLM) perdent 40 à 60% du contexte sémantique lors de l’étape de projection, ce qui déforme les représentations visuelles et affecte les tâches en aval. Cette découverte a soulevé des inquiétudes quant à la précision de l’évaluation des VLM et à la contamination des données, en particulier dans les benchmarks comme DocVQA, où des scores élevés pourraient ne pas refléter entièrement les capacités réelles du modèle. (Source : vikhyatk)

Éthique de l’IA et de la robotique : Appel à cesser les tests violents sur les robots : Sur les réseaux sociaux, plusieurs chercheurs en IA et membres de la communauté ont appelé à cesser les tests violents sur les robots, comme frapper à plusieurs reprises le robot Unitree G1 pour démontrer sa stabilité. Ils estiment que cette méthode de test non seulement soulève des préoccupations éthiques, mais peut également renforcer une perception négative des robots et remettre en question sa nécessité scientifique, plaidant pour une évaluation des performances des robots de manière plus humaine et scientifique. (Source : vikhyatk, dejavucoder, Ar_Douillard)

La “pseudo-intelligence” de l’IA : Appel à remplacer “intelligence artificielle” par “pseudo-intelligence” pour réduire les malentendus du public : Une opinion a été émise selon laquelle la désignation “Artificial Intelligence” devrait être remplacée par “Pseudo Intelligence” afin de réduire l’exagération et les malentendus du public concernant les capacités de l’IA. Cette proposition découle d’une prise de conscience lucide des limites actuelles de l’IA, visant à éviter d’induire le public en erreur par des récits grandioses de type “Terminator”, et à promouvoir une perception rationnelle des capacités réelles de l’IA, tant au sein de l’industrie qu’auprès du grand public. (Source : clefourrier)

Le chatbot IA Diella nommé membre du cabinet albanais, suscitant la controverse : Le gouvernement albanais a nommé le chatbot IA Diella membre du cabinet, dans le but de lutter contre la corruption. Cette décision a suscité une large controverse, étant critiquée comme un coup de publicité bon marché, similaire à l’octroi de la “citoyenneté” au robot Sophia par l’Arabie saoudite en 2017. Les commentaires estiment que cette initiative pourrait surexposer les capacités de l’IA et estomper les frontières entre la technologie et la gouvernance. (Source : The Verge)

Phénomène d’« hallucination » de ChatGPT : Le modèle entre dans une boucle, s’auto-corrige mais ne peut en sortir : Des utilisateurs de la communauté ont partagé des cas où ChatGPT est tombé dans une boucle d’« hallucination », le modèle générant à plusieurs reprises des informations erronées en répondant à des questions, et même s’il « réalisait » ses erreurs, il ne pouvait pas sortir de cette boucle. Ce phénomène a suscité des discussions sur les défauts techniques profonds des LLM, indiquant un décalage entre la capacité du modèle à comprendre ses propres erreurs logiques et sa capacité à les corriger dans certaines situations. (Source : Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 AUTRES

De Transformer à GPT-5 : La pensée des premiers principes des grands modèles par Lukasz Kaiser, scientifique chez OpenAI : Lukasz Kaiser, scientifique chez OpenAI (l’un des huit “enfants” de Transformer), a partagé son parcours, de son origine en logique à son implication dans l’invention de l’architecture Transformer, puis à sa participation approfondie au développement de GPT-4/5. Il a souligné l’importance de construire des systèmes à partir des premiers principes et a prédit que la prochaine étape de l’IA consisterait à enseigner aux modèles à “penser”, en générant davantage d’étapes intermédiaires pour un raisonnement approfondi, plutôt que de produire directement des réponses, et que la puissance de calcul se tournerait vers une inférence massive sur une petite quantité de données de haute qualité. (Source : 36氪)

Synthèse d’images sémantiques : Technologie de génération de squelettes de photos de rivières satellites : La communauté du machine learning explore les dernières avancées dans le domaine de la synthèse d’images sémantiques, en se concentrant particulièrement sur la manière de générer des photos satellites en noir et blanc de rivières à partir de squelettes d’images de rivières. Cette tâche implique l’utilisation de générateurs pour la synthèse d’images satellites à partir de nouvelles données de squelettes inédites, et pourrait introduire des variables conditionnelles supplémentaires. La discussion vise à trouver les méthodes les plus avancées et les articles de recherche pertinents pour guider de tels projets de vision par ordinateur. (Source : Reddit r/MachineLearning)

Le fossé de l’intelligence à l’ère de l’IA : Le professeur Qiu Zeqi explore l’impact profond de l’IA sur la pensée et la cognition humaines : Le professeur Qiu Zeqi de l’Université de Pékin a souligné que l’utilisation de l’IA ne mène pas simplement à une “baisse de l’intelligence”, mais s’apparente davantage à un exercice de la pensée, dépendant de l’initiative et de l’attitude critique de l’individu. Il a insisté sur le fait que la compréhension humaine de la pensée est encore à ses débuts, et que l’IA, bien que puissante, reste basée sur les connaissances humaines, incapable de simuler pleinement la perception sensorielle humaine et la pensée latérale. La tendance de l’IA à “faire plaisir” exige des utilisateurs qu’ils la défient et qu’ils soient vigilants quant à ses valeurs. Il estime qu’à l’ère de l’IA, le développement des compétences fondamentales et d’une société diversifiée est plus important, évitant d’observer le “fossé intelligent” d’un point de vue supérieur. (Source : 36氪)