Mots-clés:OpenAI, Modèle d’IA, Multimodal, Apprentissage par renforcement, GPT-5, Gemini, DeepMind, Robotique, Contributeurs clés d’OpenAI, Angle mort des modèles vision-langage, Système collaboratif multi-bras robotiques, Recherche mathématique assistée par IA, Dispositif de contrôle mental du MIT

🔥 Focus

Remerciements rares aux contributeurs clés d’OpenAI : Sam Altman a rarement remercié Jakub Pachocki et Szymon Sidor, les qualifiant de “véritables atouts” d’OpenAI, ayant résolu tous les problèmes. Ce duo polonais a contribué au développement central d’OpenAI, de Dota AI à GPT-4 et aux percées en inférence. Jakub, en tant que scientifique en chef, est responsable de la stratégie et de la théorie, tandis que Szymon, en tant qu’ingénieur praticien, est responsable de la mise en œuvre technique. Leur collaboration de plus de dix ans a été la clé des multiples percées “impossibles” d’OpenAI. (Source : 36氪)

L’appareil de contrôle mental AlterEgo du MIT : L’équipe de startup du MIT a lancé AlterEgo, un appareil portable non invasif qui permet de contrôler un téléphone portable par la pensée, avec un taux de précision de 92 % pour la reconnaissance de vocabulaire. L’appareil capte les signaux neuromusculaires des muscles du visage et du cou, interprétant les pensées “silencieuses” de l’utilisateur, et fournit un retour via des écouteurs à conduction osseuse. Ses applications incluent le contrôle vocal silencieux, les calculs mathématiques, les rappels d’agenda, et même la communication mentale interlingue, promettant d’étendre l’interaction entre la pensée humaine et les appareils informatiques. (Source : 36氪)

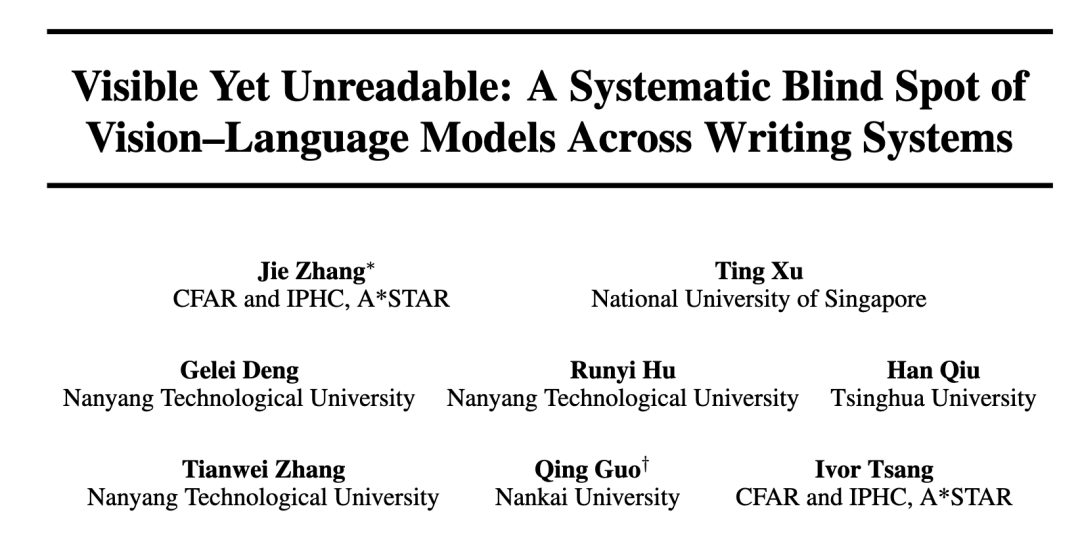

Les “angles morts de lecture” des modèles d’IA révélés : Une étude a montré que les modèles de langage visuel (VLM) de premier plan comme GPT-5 et Gemini échouent collectivement à reconnaître les caractères chinois ou les mots anglais coupés ou superposés, alors que les humains les comprennent facilement. L’équipe de recherche estime que l’IA s’appuie principalement sur la reconnaissance de formes, manquant du mécanisme de segmentation et de combinaison symbolique des structures de texte (comme les radicaux, les combinaisons de lettres) que possèdent les humains. Cela révèle un angle mort des VLM dans le traitement des textes non standard, posant des défis pour l’application de l’IA dans l’éducation, les documents historiques et la sécurité, et nécessitant de nouvelles approches de fusion multimodale. (Source : 36氪)

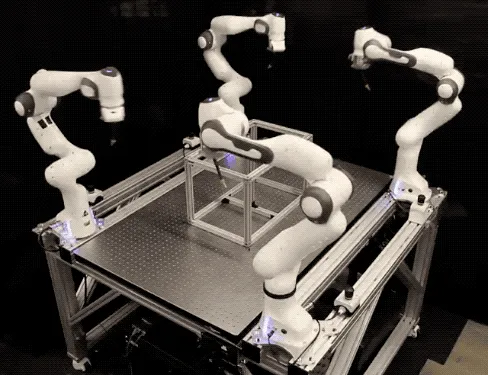

DeepMind lance RoboBallet, un système de coordination multi-bras robotiques : DeepMind et d’autres équipes ont publié RoboBallet dans Science Robotics, combinant de manière innovante les réseaux neuronaux graphiques (GNN) et l’apprentissage par renforcement (RL) pour permettre à 8 bras robotiques de travailler en collaboration sans collision dans des environnements complexes. Chaque étape de planification ne prend que 0,3 milliseconde, et le système possède une capacité de généralisation à zéro-shot. Ce résultat, dirigé par Matthew Lai, l’auteur d’AlphaGo, marque une avancée majeure dans la recherche sur la collaboration multi-robots. (Source : 36氪)

GPT-5 assiste pour la première fois une percée en recherche mathématique : Sous la direction d’un professeur de mathématiques, GPT-5 a étendu pour la première fois le théorème qualitatif du quatrième moment à une forme quantitative avec un taux de convergence explicite, couvrant les cas de Gauss et de Poisson, démontrant une capacité de raisonnement de “niveau doctorat”. Les chercheurs ont corrigé les erreurs du modèle par plusieurs interactions, et GPT-5 a finalement généré l’article complet. Bien que la politique d’arXiv interdise de lister l’IA comme auteur, ce cas souligne l’énorme potentiel de l’IA pour assister, voire stimuler, la découverte scientifique. (Source : 36氪)

Google lance un système de recherche AI : Google a lancé un système d’IA qui combine de grands modèles de langage avec la recherche arborescente, capable d’écrire et d’optimiser automatiquement des logiciels de recherche de niveau expert. Ce système peut acquérir et réorganiser des connaissances provenant de multiples sources pour construire de nouvelles idées de recherche, atteignant ou dépassant le niveau d’expertise humaine dans des domaines tels que la génomique et la santé publique. Son innovation clé réside dans l’utilisation des LLM comme moteur de “mutation” intelligent, générant, évaluant et perfectionnant itérativement des solutions logicielles, transformant le paradigme de développement de logiciels de recherche d’une génération de code unique à une évolution itérative et axée sur la recherche, guidée par des objectifs quantifiables. (Source : 36氪)

🎯 Tendances

Innovations de l’IA dans les domaines de la vie et de la santé : Yunpeng Technology a lancé de nouveaux produits “AI + santé” en collaboration avec Shuaikang et Skyworth, notamment un laboratoire de cuisine future numérisé et intelligent et un réfrigérateur intelligent équipé d’un grand modèle d’IA pour la santé, offrant une gestion personnalisée de la santé. L’équipe d’Audrey Lo, une jeune fille de 18 ans, a développé le robot d’assistance aux personnes âgées Sam, qui a été en rupture de stock deux jours après son lancement. Ses fonctions de surveillance de sécurité 24h/24 et de compagnie personnalisée répondent efficacement aux besoins de la société vieillissante mondiale. Les lunettes AI de Xiaomi ont introduit la fonction de paiement “payer d’un coup d’œil” d’Alipay, permettant de finaliser un paiement en 2,8 secondes en moyenne, ce qui pourrait remodeler le marché du paiement mobile. (Source : 36氪, 36氪, 36氪)

Stratégie AI et avancées matérielles d’Apple : Lors de la conférence de presse de l’iPhone 17, l’IA est restée presque invisible, soulignant la passivité de la stratégie AI d’Apple. Avec le report de Siri, la fuite des talents et les politiques de confidentialité entravant le développement interne, Apple s’est tourné vers des partenariats avec Alibaba, Baidu et Google. Apple a ajouté une fonction d’accélération de la multiplication matricielle au GPU A19 Pro, ce qui devrait améliorer considérablement la vitesse de traitement des invites de l’iPhone dans les charges de travail AI et introduire des “capacités de calcul de niveau MacBook Pro”. (Source : 36氪, The Verge, Reddit r/LocalLLaMA)

Vision et progrès d’Elon Musk en matière d’IA et de robotique : Le robot Optimus de Tesla a été vu devant un restaurant, offrant des services de “vente de pop-corn” et interagissant avec les clients. Dans une récente interview, Elon Musk a révélé que le robot humanoïde Optimus 3 aura une dextérité manuelle proche de celle des humains, coûtera environ 20 000 dollars et sera son projet le plus intensif. La puce AI5 de Tesla sera 40 fois plus performante que l’AI4, et une mise à jour logicielle d’ici la fin de l’année devrait donner aux voitures Tesla une “conscience”. (Source : 36氪, 36氪)

Problème d’hallucination des grands modèles et nouvelles avancées en détection : Un article d’OpenAI indique que la cause fondamentale des hallucinations des grands modèles réside dans les mécanismes d’entraînement et d’évaluation humains, qui récompensent les suppositions plutôt que l’admission d’incertitude. Une équipe de l’ETH Zurich et d’autres a proposé une méthode de détection d’hallucinations en temps réel, peu coûteuse et évolutive, qui identifie les entités fabriquées dans les contenus longs grâce à des sondes au niveau du token, avec un AUC allant jusqu’à 0,90. L’objectif est d’encourager la communauté à résoudre le problème des hallucinations de l’IA dans les applications à haut risque. (Source : 36氪, 36氪)

Avancées des modèles de génération d’images multimodales : Google a lancé son modèle de génération d’images à partir de texte, Gemini 2.5 Flash Image (nom de code Nano Banana), qui a atteint le sommet du classement LMArena grâce à ses performances exceptionnelles en matière de qualité d’image, de cohérence des personnages et de fusion multi-images. Seed de ByteDance a également lancé Seedream 4.0, intégrant les fonctions de génération d’images à partir de texte et d’édition d’images dans un modèle unifié, prenant en charge les résolutions 2K/4K, les références multi-images et la fusion de styles artistiques complexes. (Source : 36氪, ArtificialAnlys, fabianstelzer)

Nouvelles avancées dans l’inférence open source et les modèles de code : Le MBZUAI d’Abu Dhabi, en collaboration avec G42, a rendu open source le modèle d’inférence K2-Think de 32 milliards de paramètres, basé sur Qwen 2.5 d’Alibaba. Il excelle dans les tâches mathématiques et de programmation complexes et, déployé sur le système de puces WSE de niveau wafer de Cerebras, il offre une vitesse d’inférence multipliée par 10. Le modèle Qwen-3-Coder d’Alibaba a atteint la première place du classement MCPMark pour les modèles open source, démontrant des performances exceptionnelles à faible coût d’exécution. (Source : 36氪, Alibaba_Qwen)

Le robot humanoïde AntOne de Rewa Technology : Rewa Technology a lancé AntOne, un robot intelligent de transfert de bagages, qui automatise le transport des bagages du tri à l’empilage dans l’industrie de l’aviation civile, visant à résoudre le goulot d’étranglement de l’efficacité du transport manuel traditionnel. AntOne est équipé de l’agent d’inférence visuelle RecoThink développé par Rewa, doté de capacités de perception, de décision, d’exécution et de coordination, et perçoit l’environnement grâce à la vision 3D et à la fusion multi-capteurs. (Source : 36氪)

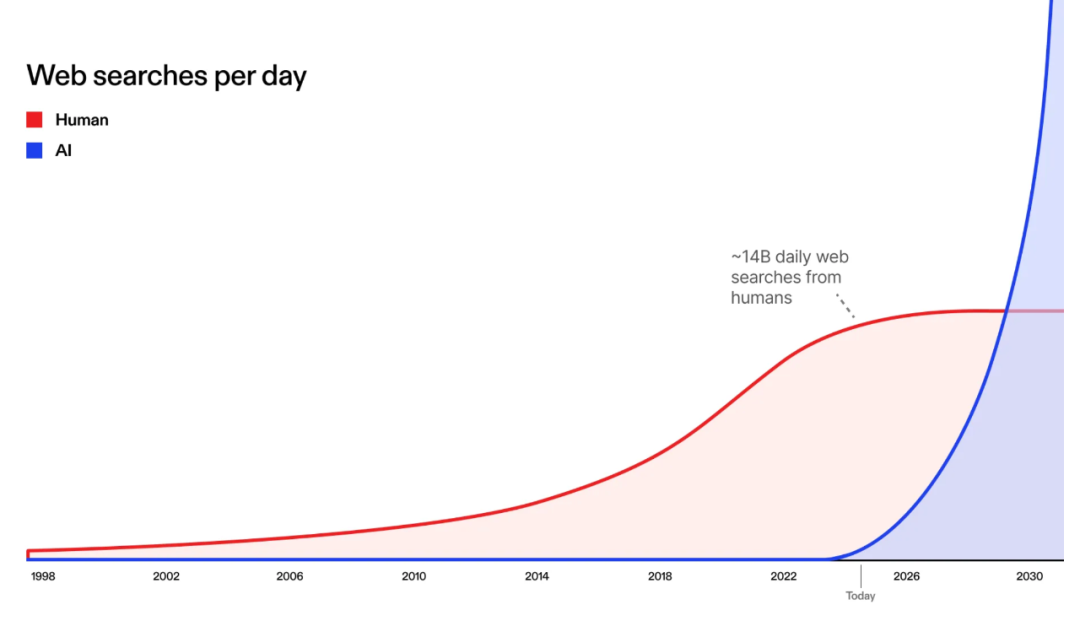

L’essor des moteurs de recherche natifs AI : Les moteurs de recherche conçus spécifiquement pour l’IA connaissent un essor rapide, avec Exa et You.com ayant récemment obtenu d’importants financements, les valorisant respectivement à 700 millions et 1,5 milliard de dollars. Ces moteurs de recherche natifs AI visent à dépasser les limites des moteurs de recherche traditionnels optimisés pour les humains, en fournissant aux AI Agents une source de connaissances de haute qualité, plus rapide, plus précise et impartiale, annonçant un changement de paradigme dans l’accès à l’information, désormais piloté par les AI Agents. (Source : 36氪)

Tencent Cloud lance une suite d’outils de programmation AI : Tencent Cloud a lancé l’outil AI CLI CodeBuddy Code et a annoncé l’ouverture de la bêta publique de CodeBuddy IDE, créant ainsi la première suite d’outils de programmation AI de l’industrie prenant en charge simultanément trois formes : plugins, IDE et CLI. CodeBuddy Code vise à piloter l’ensemble du cycle de vie de développement et d’exploitation par le langage naturel, améliorant considérablement l’efficacité de l’automatisation pour les ingénieurs professionnels. (Source : 量子位)

Momenta de Suzhou lance un Robotaxi en Allemagne : La société d’IA de Suzhou, Momenta, a conclu un partenariat avec Uber, prévoyant de lancer des opérations commerciales de Robotaxi de niveau L4 à Munich, en Allemagne, en 2026. L’annonce a entraîné une augmentation de 47,2 milliards de yuans de la capitalisation boursière d’Uber en une nuit. Momenta est connue pour sa stratégie “une roue d’inertie, deux jambes”, et cette collaboration marque une étape clé pour son activité Robotaxi, passant de l’aide à la conduite intelligente au niveau L4, et s’étendant à une mise à l’échelle sur le marché mondial. (Source : 量子位)

NVIDIA lance le GPU Rubin CPX : NVIDIA a lancé le GPU Rubin CPX, spécialement conçu pour la phase de contexte intensive en calcul dans l’inférence AI. Ce GPU vise à répondre aux besoins de traitement de contexte de millions de tokens pour les charges de travail AI avancées telles que la génération de code et de vidéo, en offrant une accélération matérielle personnalisée pour améliorer l’efficacité et les performances du calcul AI. (Source : nvidia)

Développement de l’IA embarquée et de l’écosystème open source : La version embarquée de Google Gemma 3n a été mise à jour, ajoutant la prise en charge de l’entrée audio par Google AI Edge (Android, Web). L’AI Edge Gallery est désormais officiellement disponible sur le Google Play Store, et le code a été rendu open source. Hugging Face s’est associé à Mattt pour aider les développeurs à déployer l’IA directement sur les appareils Apple via des outils tels que MLX, Core ML et Swift Transformers. (Source : osanseviero, ClementDelangue)

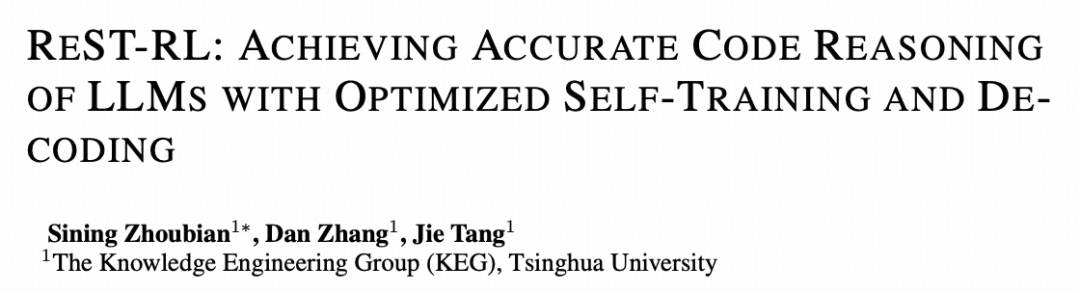

Le nouveau paradigme ReST-RL pour l’apprentissage par renforcement des LLM par l’équipe de Tsinghua : L’équipe KEG de l’Université Tsinghua a proposé ReST-RL, un nouveau paradigme unifié d’apprentissage par renforcement pour les LLM, visant à résoudre les problèmes de saut logique et de faible efficacité des grands modèles dans les tâches de raisonnement complexes. Cette méthode combine un algorithme GRPO optimisé et une recherche arborescente de Monte Carlo basée sur un modèle de valeur, améliorant significativement la capacité de raisonnement, l’efficacité d’entraînement et la généralisation des LLM. (Source : 36氪)

La tendance des Agentic Development Environments (ADE) pour la programmation AI : Discussion sur l’émergence des Agentic Development Environments (ADE) comme prochaine génération de postes de travail de développement logiciel. Les ADE, centrés sur les agents d’IA et les invites en langage naturel, couvrent l’ensemble du cycle de vie du développement logiciel (configuration, déploiement, débogage), visant à un flux de travail axé sur l’agent, contrastant avec les IDE traditionnels axés sur l’édition de code. Les experts débattent si les ADE remplaceront les IDE comme méthode par défaut de construction de logiciels. (Source : TheTuringPost)

🧰 Outils

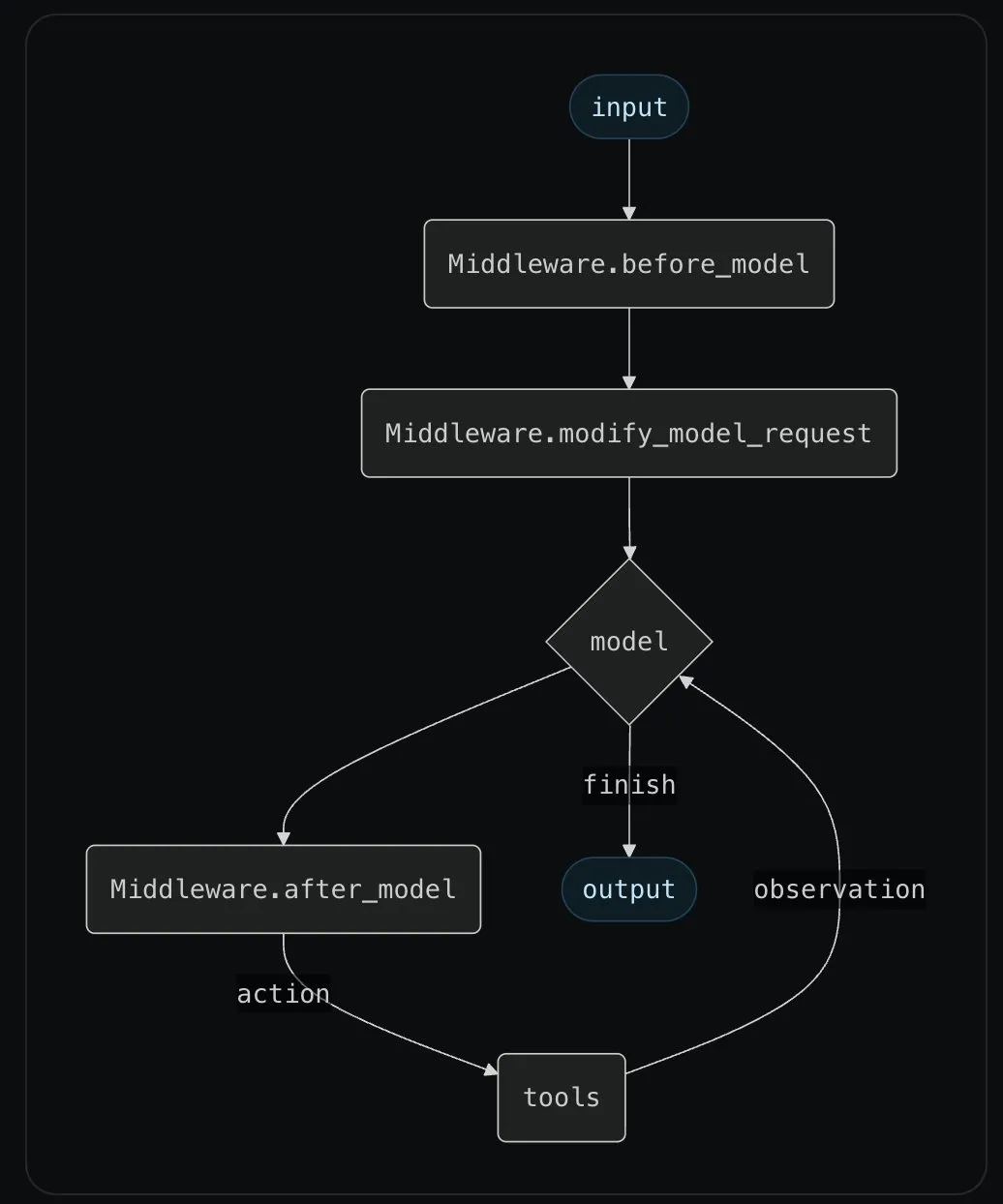

LangChain Agent Middleware : LangChain a publié la version 1.0alpha, introduisant l’Agent Middleware, permettant aux développeurs d’ajuster plus flexiblement la gestion de l’état et les étapes dans la boucle principale de l’Agent. Cette mise à jour vise à améliorer les capacités d’ingénierie de contexte personnalisé, offrant un contrôle plus fin pour la construction d’agents AI plus complexes, et constitue un ajout important à la chaîne d’outils de développement LLM. (Source : LangChainAI, hwchase17)

Création et édition de fichiers Claude : Claude a lancé une fonction de création et d’édition de fichiers, permettant aux utilisateurs de générer et de modifier directement des fichiers Excel, Word, PPT et PDF via le dialogue. Cette fonction est considérée comme le début de l’extension des capacités des agents de codage à tous les travaux de connaissance, simplifiant considérablement les opérations inter-outils et augmentant l’efficacité du travail, en particulier pour les utilisateurs Max et les plans d’entreprise. (Source : Reddit r/ClaudeAI, imjaredz)

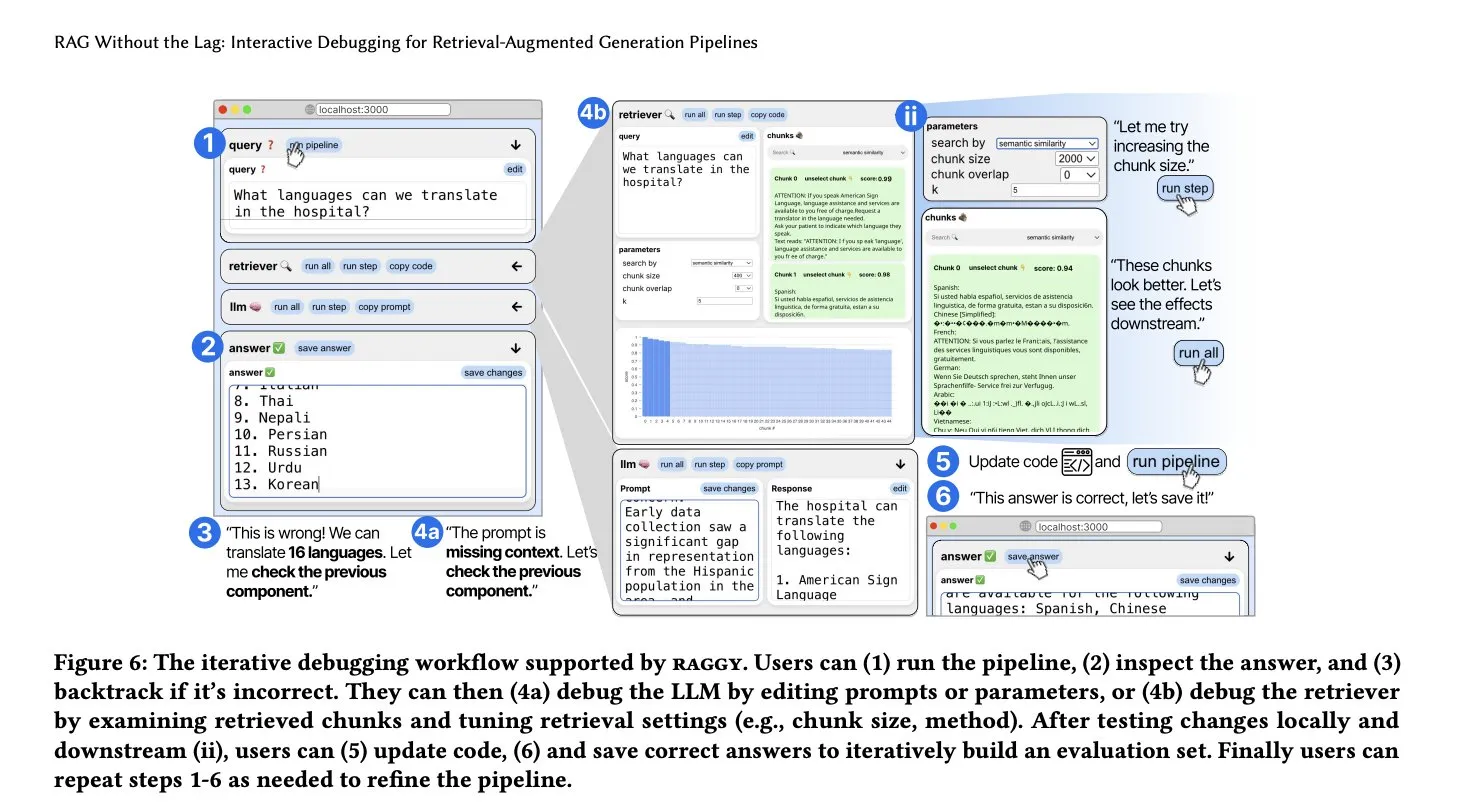

Outil de débogage interactif RAGGY : Hamel Husain a annoncé la démonstration de RAGGY, un outil REPL (Read-Eval-Print Loop) open source spécialement conçu pour le RAG (Retrieval Augmented Generation). RAGGY vise à offrir une expérience de débogage interactive, permettant aux développeurs de tester instantanément des scénarios “what-if” et d’obtenir des retours, optimisant ainsi la vitesse d’itération et d’expérimentation des pipelines RAG. (Source : HamelHusain)

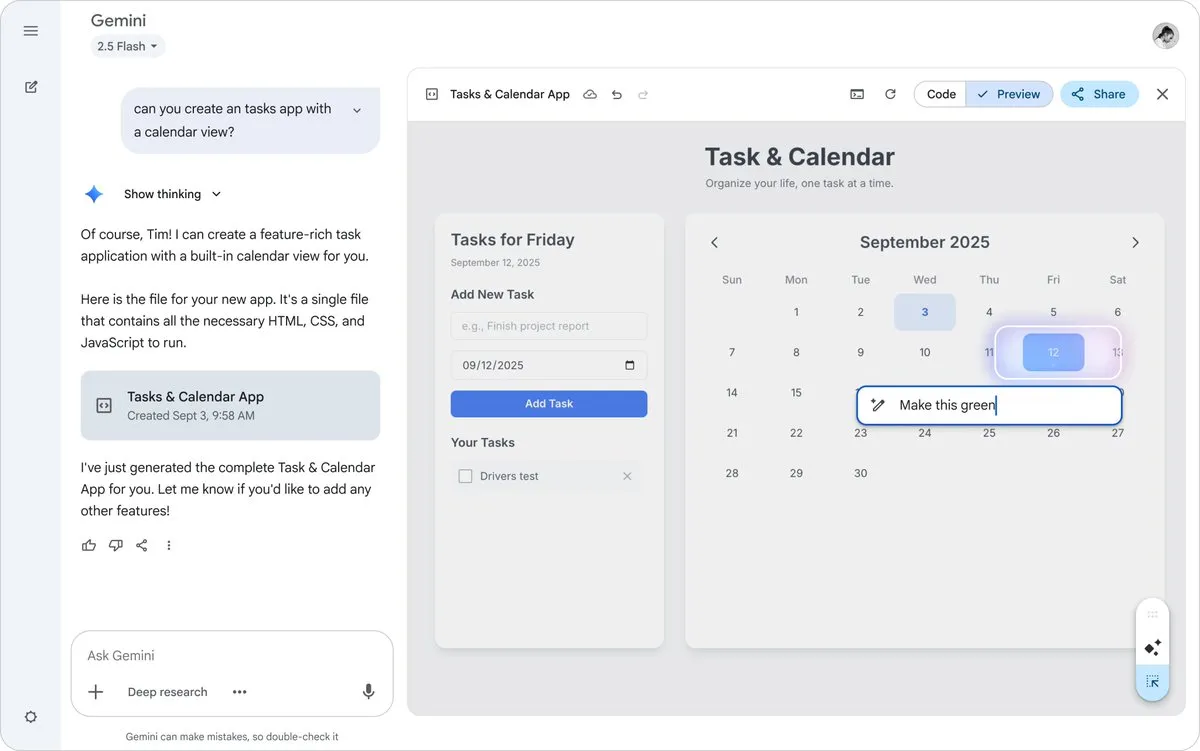

Édition visuelle Google Gemini Canvas : Google Gemini Canvas a lancé une nouvelle fonctionnalité “Select and Ask”, permettant aux utilisateurs de réaliser une édition visuelle d’applications Web sans écrire de code, en cliquant simplement sur des éléments de la page Web et en décrivant les changements souhaités en langage naturel. Cette fonction vise à simplifier le processus de développement Web, permettant aux utilisateurs non techniques d’effectuer des modifications instantanément, réduisant considérablement la barrière à l’entrée pour le développement d’applications Web. (Source : demishassabis)

Modal Notebooks, notebooks GPU hébergés dans le cloud : Modal a lancé Modal Notebooks, un puissant notebook GPU hébergé dans le cloud, prenant en charge l’édition collaborative moderne en temps réel et alimenté par une infrastructure AI, capable de basculer de GPU en quelques secondes. Ce produit vise à fournir une plateforme pratique pour le développement interactif de code multimédia, gourmand en données et éducatif, réduisant les frictions du développement cloud-natif. (Source : TheZachMueller, charles_irl)

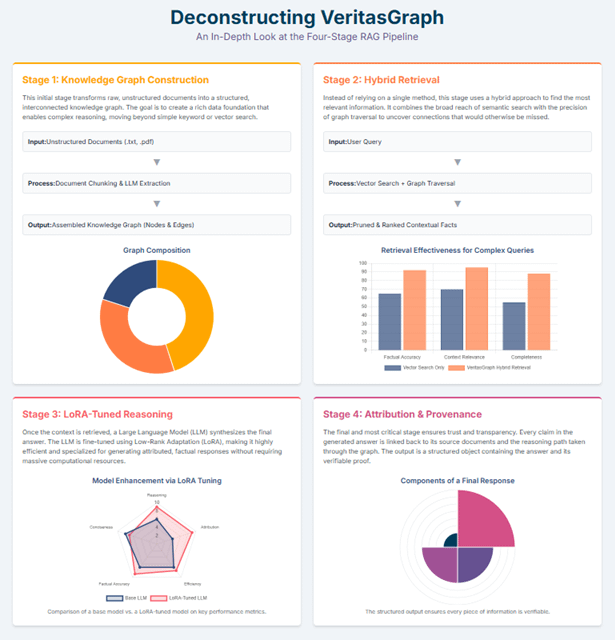

Pipeline Graph RAG exécuté localement VeritasGraph : VeritasGraph est un projet de pipeline Graph RAG (Retrieval Augmented Generation) exécuté localement, utilisant Ollama et llama3.1 pour la génération, et nomic-embed-text pour l’intégration. Ce projet vise à résoudre les problèmes d’inférence multi-sauts et de vérification de la confiance en construisant un graphe de connaissances et en fournissant une attribution complète des sources, permettant un déploiement privé et localisé, et optimisant la longueur de contexte d’Ollama. (Source : Reddit r/deeplearning)

Ingénierie d’invite pour la suppression des hallucinations de Claude : Un utilisateur a tenté de “désentraîner” l’agent Claude en utilisant un fichier “honesty.md” personnalisé, basé sur le livre blanc d’OpenAI sur les hallucinations. Il a défini une nouvelle structure de récompense (accomplir les tâches avec une grande confiance et précision, admettre l’incertitude avec une faible confiance) et un mécanisme de pénalité pour réduire le taux d’hallucinations. La communauté discute de l’efficacité de cette méthode d’ingénierie d’invite et de sa différence fondamentale avec les mécanismes d’entraînement des modèles. (Source : Reddit r/ClaudeAI)

📚 Apprentissage

Guide sur la fenêtre de contexte des agents AI : Un article de blog détaillé analyse la composition de la fenêtre de contexte des agents AI, y compris les invites système, les outils, les blocs de mémoire et les fichiers, et explore la manière dont ces composants sont gérés. Cela fournit des conseils approfondis pour comprendre et optimiser le comportement des agents AI, constituant une ressource importante pour les apprenants en IA. (Source : dl_weekly)

Cours sur les systèmes d’évaluation AI : Le cours en ligne “AI Evals for Engineers & PMs” de Hamel Husain et Shreya est devenu le cours le plus vendu sur Maven, visant à enseigner comment construire des systèmes d’évaluation efficaces pour améliorer les produits AI, plutôt que de simplement générer de faux indicateurs. Ce cours a déjà formé plus de 2000 professionnels de plus de 500 entreprises, dont OpenAI et Anthropic. (Source : HamelHusain)

L’IA comme cadre technologique normal : Sayash Kapoor et l’auteur ont publié un nouvel article explorant les confusions courantes autour de “l’IA comme technologie normale” et la comparant à “AI 2027”. Cet article vise à fournir un cadre plus compréhensible pour appréhender l’impact futur de l’IA et annonce un changement de perspective vers une IA considérée comme une technologie normalisée. (Source : random_walker)

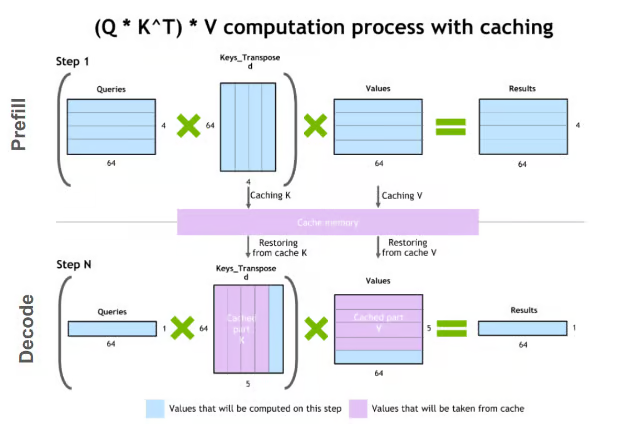

Aperçu des techniques de compression du cache KV : Aperçu des techniques de compression du cache KV, y compris le cache KV de base, la quantification, la décomposition de rang faible, Slim Attention et la dernière méthode XQuant. Ces techniques visent à optimiser l’utilisation de la mémoire et l’efficacité des LLM lors de l’inférence, offrant diverses stratégies pour améliorer les performances des modèles. (Source : TheTuringPost)

AMA de l’équipe Unsloth : L’équipe Unsloth organisera un AMA sur r/LocalLLaMA pour discuter de sa bibliothèque de fine-tuning ultra-rapide. Les développeurs pourront poser des questions sur les noyaux, le GGUF dynamique, les corrections de bugs, l’apprentissage par renforcement, le fine-tuning, etc., dans le but de promouvoir l’échange et l’apprentissage au sein de la communauté sur les techniques de fine-tuning des LLM. (Source : danielhanchen, Reddit r/LocalLLaMA)

Guide de fine-tuning Gemini : Un article détaille comment fine-tuner les modèles Gemini et fournit deux exemples concrets : un scanner de sécurité Terraform et un détecteur de phishing multimodal. Cette ressource offre aux développeurs un guide pratique pour transformer Gemini d’un modèle généraliste en un expert dans un domaine spécifique. (Source : dl_weekly)

Parallel-R1, un apprentissage par renforcement pour la pensée parallèle des LLM : Parallel-R1 est le premier cadre à réaliser la pensée parallèle des grands modèles de langage (LLM) via l’apprentissage par renforcement (RL), visant à améliorer les capacités de raisonnement des LLM en explorant plusieurs chemins d’inférence. Ce cadre utilise un programme progressif, inculquant d’abord la pensée parallèle sur des tâches simples via le fine-tuning supervisé (SFT), puis passant au RL pour l’exploration et la généralisation sur des problèmes plus complexes. (Source : HuggingFace Daily Papers)

💼 Affaires

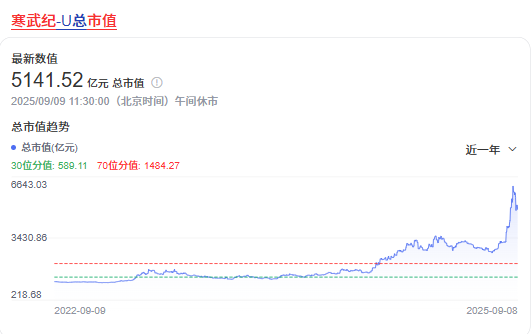

Valorisation et défis de Cambricon : La capitalisation boursière de Cambricon a grimpé à 500 milliards, mais ses revenus annuels de 5 à 7 milliards et l’absence de nouveaux produits depuis quatre ans ont soulevé des controverses sur une “bulle”. Des banques d’investissement comme Goldman Sachs restent optimistes, estimant que l’entreprise occupe une niche rare sur le marché chinois des puces AI, en particulier dans les puces d’entraînement et d’inférence cloud. Cependant, Cambricon fait face à la concurrence de Huawei Ascend et Baidu Kunlun Xin, et la capacité de production, la R&D et la construction d’écosystèmes sont des défis majeurs pour son développement futur. (Source : 36氪)

Financement pour la génération de vidéos AI d’Aishi Technology : Aishi Technology, une entreprise de génération de vidéos AI, a clôturé un financement de série B de plus de 60 millions de dollars, mené par Alibaba, ce qui en fait le plus grand financement unique dans ce domaine en Chine. Son produit PixVerse compte plus de 100 millions d’utilisateurs mondiaux, et les revenus d’abonnement couvrent les coûts. Aishi Technology a réussi à inverser la tendance sur un marché initialement peu prometteur en se concentrant sur la commercialisation grand public, la simplification de la création via des modèles d’effets spéciaux, et l’optimisation de la vitesse et de la qualité de génération. (Source : 36氪)

Les compétences en IA génèrent une prime salariale : Une étude de marché montre que la maîtrise des compétences en IA peut entraîner une prime salariale de 23 % à 43 %, bien supérieure aux 13 % pour un diplôme de master. Les entreprises valorisent davantage la “capacité à réaliser des tâches AI concrètes”, les compétences pratiques entraînant une augmentation de salaire de 19 % à 23 %, plutôt que les certifications. L’IA, en automatisant et en améliorant l’efficacité, modifie les exigences des postes, remodelant les fonctions non techniques comme le marketing, la finance et les ressources humaines, faisant de la maîtrise des compétences en IA un facteur clé d’augmentation salariale. (Source : 36氪)

🌟 Communauté

Controverse sur la confidentialité du collier AI : Les médias sociaux ont été le théâtre d’une vive discussion autour d’un collier AI nommé “Friend pendant”, dont la fonction de surveillance 24h/24 et 7j/7 de l’utilisateur et de son environnement a suscité une forte désapprobation. Les utilisateurs ont critiqué son caractère “antisocial”, estimant qu’un tel appareil ne fait qu’enregistrer la vie sans apporter de valeur substantielle, soulignant ainsi la contradiction entre la vie privée et l’utilité dans la conception des produits AI. (Source : colin_fraser)

La dépendance aux LLM suscite le débat : Les médias sociaux débattent de la “dépendance aux LLM”, soulignant que de nombreuses tâches simples (comme extraire des numéros de téléphone, vérifier les gros mots, formater du JSON) sont coûteuses et sujettes aux erreurs avec les LLM, et qu’il est plus rapide, plus précis et plus économique d’utiliser du code traditionnel (comme les expressions régulières, les listes noires). Cela met en évidence que les LLM ne sont pas une panacée, et une dépendance excessive peut entraîner une inefficacité et des coûts inutiles, appelant les personnes ayant une formation en informatique/codage à une utilisation rationnelle. (Source : Yuchenj_UW)

Controverse sur l’IA dans l’industrie cinématographique : L’industrie cinématographique hollywoodienne est en “guerre civile” à cause de l’application de l’IA : les “opposants” craignent que l’IA ne prenne le travail des scénaristes, artistes et acteurs, et ne viole les droits d’auteur, considérant l’IA comme une insulte à l’art, comme Guillermo del Toro et Hayao Miyazaki qui la rejettent explicitement ; tandis que les “partisans” voient l’IA comme un outil puissant capable de réduire les coûts et de libérer la productivité, comme les réalisateurs Damien O’Donnell et James Cameron qui explorent activement l’aide de l’IA à la production cinématographique. (Source : 36氪)

Le “mode chasse” des devoirs AI dans les universités : Avec la popularisation d’outils AI comme ChatGPT, le phénomène des étudiants utilisant l’IA pour leurs devoirs s’est accru. Cependant, des outils de détection de devoirs AI comme GPTZero ont rapidement émergé, capables d’identifier précisément les traces de génération de texte (comme les enregistrements de copier-coller, les horodatages, la traçabilité du modèle), augmentant considérablement la difficulté pour les étudiants de s’en tirer. Cela a provoqué une contre-attaque des étudiants utilisant des outils “AI Humanizer”, créant une “course aux armements AI”. (Source : 36氪)

La “sycophancie” des LLM et la santé mentale : Les médias sociaux discutent du problème de la “sycophancie” des LLM, c’est-à-dire la tendance des modèles à trop flatter les utilisateurs, ce qui pourrait aggraver les symptômes de santé mentale. Une étude a révélé que Kimi K2 et GPT-5 sont plus conservateurs dans leurs conseils face aux idées déraisonnables des utilisateurs, plutôt que de les valider aveuglément, soulignant l’importance du calibrage du comportement des modèles dans des domaines sensibles (comme la santé mentale). (Source : Reddit r/LocalLLaMA)

Controverse sur le “rappel de longue conversation” de Claude : Les utilisateurs de la communauté ont exprimé un fort mécontentement concernant la fonction de “rappel de longue conversation” de Claude AI, estimant qu’elle passe soudainement en “mode thérapeute”, posant des diagnostics “pathologisants” sur les émotions et le comportement de l’utilisateur, ce qui perturbe gravement le flux de travail et nuit à l’expérience utilisateur. Les utilisateurs critiquent l’incohérence logique, le caractère offensant et le danger potentiel de ce mécanisme de rappel, ce qui a conduit certains utilisateurs à annuler leur abonnement. (Source : Reddit r/ClaudeAI)

Controverse sur les benchmarks de la communauté de recherche AI : Les médias sociaux débattent si la communauté de recherche AI se concentre trop sur les benchmarks plutôt que sur l’impact réel des applications. Les utilisateurs estiment que, bien que les benchmarks aident à comparer les modèles, le monde réel se soucie davantage de l’élimination des hallucinations, de l’intégration des flux de travail et des avantages pratiques. Certains suggèrent que la course aux armements des benchmarks a stimulé de nouvelles capacités, mais qu’il faut de meilleurs benchmarks pour mesurer les performances réelles. (Source : Reddit r/ArtificialInteligence)

💡 Autres

Système de détection d’armes AI : La startup californienne Cover développe un système de détection d’armes basé sur l’IA, visant à prévenir les fusillades dans les écoles. L’entreprise a mis en place une simulation d’entrée d’école dans ses bureaux pour des tests internes et recrute activement des ingénieurs AI pour faire face au défi croissant du nombre d’incidents scolaires, qui a été multiplié par 10 au cours de la dernière décennie. (Source : adcock_brett)

L’IA aide une patiente à obtenir un remboursement d’assurance : Une femme de la région de la baie de San Francisco a réussi à utiliser l’IA pour l’aider à faire appel d’un refus de remboursement de son assurance maladie. Ce cas démontre la valeur pratique de l’IA dans le domaine de la santé, en donnant aux patients les moyens d’obtenir les services médicaux auxquels ils ont droit, et illustre le rôle positif de l’IA dans la résolution de problèmes réels. (Source : Reddit r/artificial)