Mots-clés:Réseaux de neurones physiques, Entraînement de l’IA, Remplacement des GPU, Revue Nature, Optimisation de l’efficacité énergétique, PNNs isomorphes, PNNs à isomorphisme brisé, Systèmes de calcul optique, Réseaux de neurones à vibrations mécaniques, Réseaux de neurones physiques électroniques, Problème d’accumulation de bruit, Analyse de faisabilité commerciale

🔥 À la Une

Nature publie une synthèse sur les «réseaux neuronaux physiques» pour s’affranchir de la dépendance aux GPU : Une synthèse de Nature sur les réseaux neuronaux physiques (PNNs) explore l’utilisation de systèmes physiques tels que la lumière, l’électricité et les vibrations pour le calcul. Cela promet de dépasser les goulots d’étranglement des GPU traditionnels et de réaliser un entraînement et une inférence d’IA plus efficaces et économes en énergie. Les PNNs sont classés en types homogènes et à symétrie brisée, et ont été validés dans des systèmes optiques, mécaniques et électroniques, avec diverses techniques d’entraînement. À l’avenir, une optimisation conjointe du logiciel et du matériel est nécessaire, et l’efficacité énergétique doit être améliorée de plusieurs milliers de fois pour une viabilité commerciale. Les défis incluent l’accumulation de bruit, l’adaptation matérielle et l’équilibre entre les formes neuromorphiques et physiques. (Source : 36氪)

Google tire profit d’un revers : Google a remporté son procès antitrust historique, évitant le démantèlement de ses activités Chrome et Android, principalement grâce à l’essor de l’IA générative (comme ChatGPT) qui a modifié le paysage concurrentiel du marché. Les chatbots IA sont considérés comme une alternative puissante aux moteurs de recherche traditionnels. Bien que le jugement restreigne certains accords d’exclusivité de Google, il a levé la menace de démantèlement, faisant grimper le cours de son action. De plus, la valeur des activités TPU de Google a été réévaluée, la considérant comme une alternative solide à NVIDIA, susceptible de défier le paysage du marché de la puissance de calcul IA. (Source : 36氪)

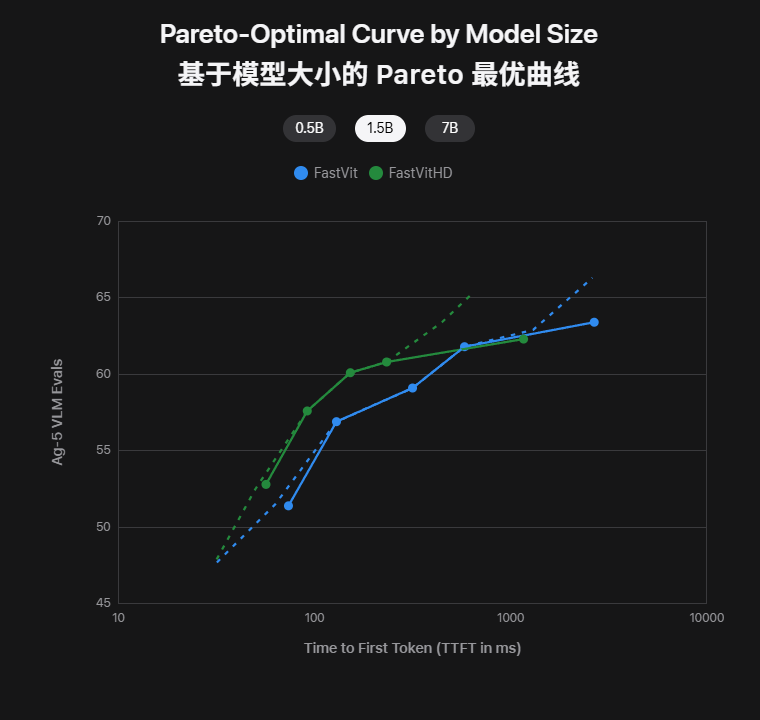

Apple lance deux modèles d’IA embarquée : taille de modèle réduite de moitié, latence du premier mot divisée par 85, utilisation hors ligne instantanée sur iPhone : Apple a publié FastVLM et MobileCLIP2, deux modèles multimodaux embarqués, sur Hugging Face. FastVLM, grâce à son encodeur FastViTHD auto-développé, atteint une faible latence avec des entrées haute résolution (latence du premier mot 85 fois plus rapide), prenant en charge les sous-titres en temps réel. MobileCLIP2, tout en maintenant une haute précision, a vu sa taille réduite de moitié et peut effectuer des recherches et des descriptions d’images hors ligne sur iPhone. Ces modèles sont désormais disponibles avec des démos et des chaînes d’outils, marquant la concrétisation de l’exécution de grands modèles sur iPhone, améliorant la confidentialité et la vitesse de réponse. (Source : 36氪)

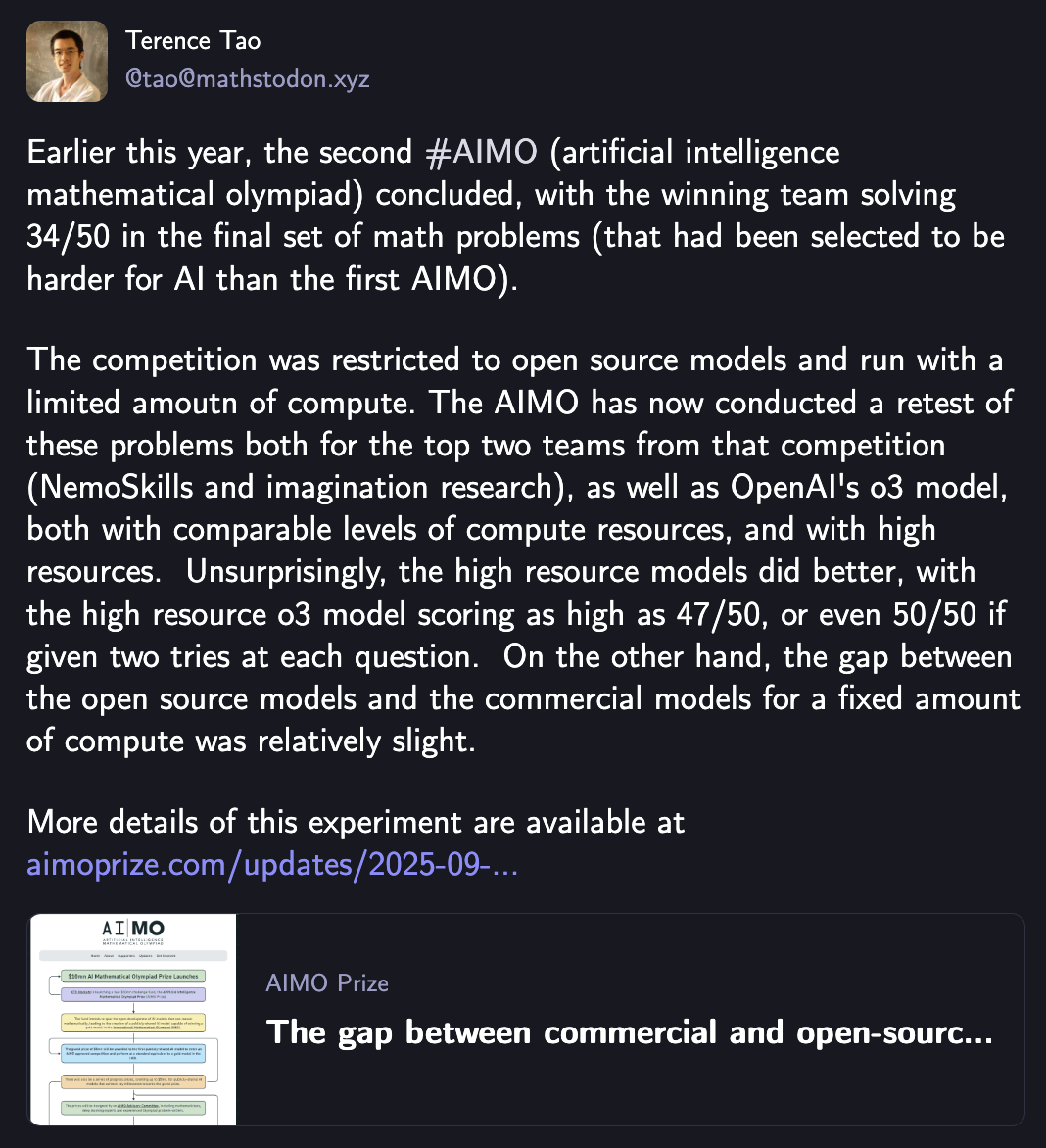

Même Terence Tao est stupéfait : o3 domine la première «Olympiade de mathématiques IA» et remporte le titre, la communauté open source talonne OpenAI à seulement 5 points : Le modèle o3 d’OpenAI a remporté la deuxième compétition de l’Olympiade de mathématiques par intelligence artificielle (AIMO2) avec un score maximal de 47 points (sur 50), démontrant de puissantes capacités de raisonnement mathématique de niveau olympique. Les tests ont montré une corrélation positive entre l’investissement en puissance de calcul et la performance du modèle, et qu’avec les mêmes ressources de calcul, l’écart entre les modèles open source et le modèle commercial (o3) se réduit, les cinq premiers modèles open source combinés n’étant qu’à 5 points d’o3. Cela marque une avancée majeure de l’IA dans le domaine du raisonnement mathématique avancé. (Source : 36氪)

🎯 Tendances

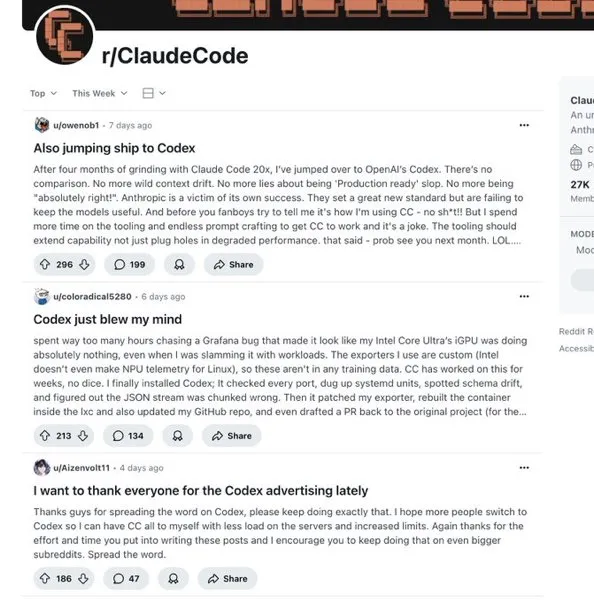

Claude nous est inaccessible, les alternatives nationales peuvent-elles prendre le relais ? : La restriction par Anthropic de son service Claude Code en Chine a incité les grands modèles nationaux (tels que Kimi-K2-0905 de Moonshot AI et Qwen3-Max-Preview d’Alibaba) à se concentrer sur le domaine de la génération de code. Kimi-K2-0905 offre une longueur de contexte de 256k, optimisant le développement frontend et l’appel d’outils, avec une compatibilité API avec Anthropic. Les modèles nationaux montrent une compétitivité en termes de performances et de prix, et devraient combler le vide du marché, modifiant le paysage concurrentiel mondial de la programmation IA. (Source : 36氪)

L’Intelligence Artificielle Générale (AGI) est déjà là : L’article affirme que l’AGI est déjà présente, et non une chose du futur. L’IA atteignant une couverture fonctionnelle complète dans des rôles spécifiques (comme la programmation) est déjà de l’AGI. Son développement donnera naissance à des “natifs intelligents” et des “entreprises sans personnel”, où l’IA deviendra le principal créateur de valeur, et la collaboration homme-machine s’intensifiera. La vitesse d’évolution rapide de l’IA entraînera la possibilité de tout reconstruire, et les anciens modèles commerciaux pourraient être bouleversés. Il est nécessaire de maîtriser le paradigme de la création de valeur, plutôt que la technologie elle-même, et de cultiver une mentalité IA pour s’adapter à un monde de dépendance inversée. (Source : 36氪)

Paroles d’experts en IA : Où se trouvent les opportunités pour les startups de l’IA de nouvelle génération ? Quelles sont les tendances en matière de tarification ? : Bret Taylor, président du conseil d’administration d’OpenAI, estime que les principales opportunités pour les startups de l’IA se trouvent sur le marché des applications, soulignant l’importance de l’auto-réflexion des Agents. Kevin Weil, Chief Product Officer d’OpenAI, identifie quatre signaux pour les produits IA de nouvelle génération : des percées en matière de raisonnement, des interfaces de service proactives (mémoire, vision, voix), la valeur déterminée par le degré d’achèvement des tâches, et l’accessibilité mondiale. La tendance en matière de tarification de l’IA s’oriente vers un modèle hybride, la tarification basée sur les résultats n’étant pas applicable à court terme, la valeur de la transparence des prix étant surestimée, et la plupart des entreprises n’étant pas prêtes à faire face à l’évolution rapide de la tarification de l’IA. (Source : 36氪)

Explosion du matériel d’IA grand public à l’IFA : l’IA n’est plus un simple plugin fonctionnel, mais le cerveau de la maison : L’IFA 2025 a montré que l’IA passe du concept à l’application pratique, devenant le «cerveau en coulisses» qui améliore l’expérience produit. L’IA pénètre profondément dans les appareils électroménagers comme les réfrigérateurs, les machines à laver et les climatiseurs, permettant la compréhension visuelle et les services proactifs, en mettant l’accent sur la «valeur émotionnelle». La maison intelligente passe du «tout contrôlable» au «tout autonome», l’IA agissant comme un centre de coordination des appareils domestiques, comme SmartThings de Samsung et ThinQ ON de LG. L’IA «anime» également des matériels traditionnels comme les poupées et les fers à repasser, leur conférant des capacités de compréhension et de traitement. (Source : 36氪)

Les 7 secteurs que l’IA prendra en charge d’ici 2026 : Des analystes de données ont étudié les modèles d’application de l’IA dans les entreprises du Fortune 500 et prévoient que l’IA transformera radicalement sept secteurs d’ici 3 à 5 ans : la finance, le diagnostic médical, le transport et la logistique, les services juridiques, la création de contenu et le marketing, le service client et le support, ainsi que le contrôle qualité de la fabrication. L’IA gérera les tâches routinières, permettant aux humains de se concentrer sur les exceptions et les décisions stratégiques. La vitesse de transformation est exponentielle, les pionniers en bénéficieront, tandis que ceux qui s’adapteront plus tard feront face à des perturbations professionnelles. Le rapport propose un cadre de stratégies de carrière. (Source : 36氪)

L’IA pour iPhone en version chinoise, enfin prête à être lancée : Apple prévoit de lancer Apple Intelligence sur le marché chinois d’ici la fin de l’année, en collaboration avec Alibaba pour un système embarqué et Baidu pour le support de Siri et de l’intelligence visuelle. Siri devrait également intégrer un outil de recherche IA “moteur de réponses”, potentiellement soutenu par Google, et envisager l’intégration de grands modèles tiers. Ces initiatives visent à améliorer la compréhension du chinois par Siri et ses capacités de recherche de contenu local, renforçant ainsi la compétitivité d’Apple sur le marché haut de gamme chinois. (Source : 36氪)

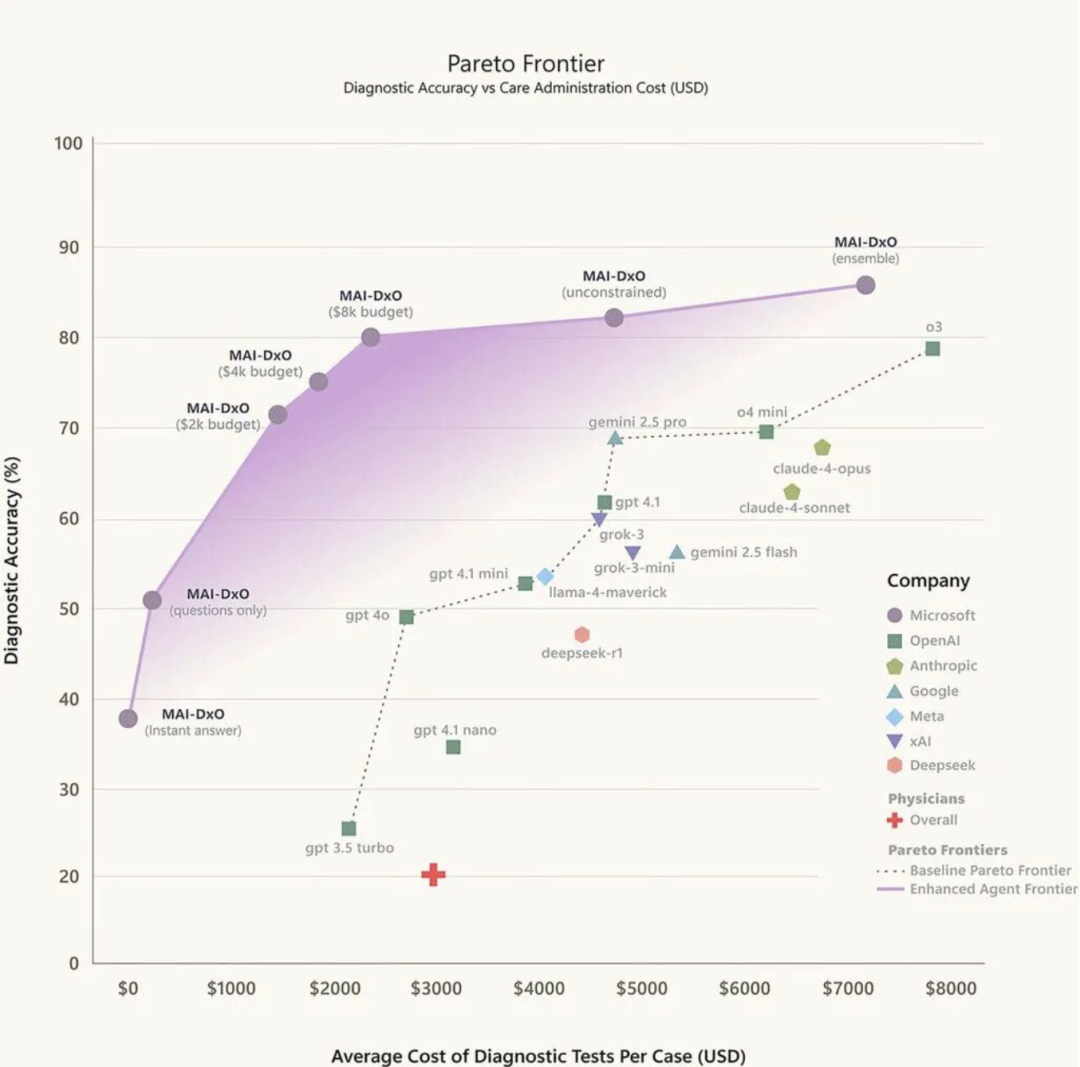

Un médecin IA fait son entrée dans le monde médical : L’aide au diagnostic par l’IA passe du stade expérimental à celui d’outil clinique, avec des attitudes divergentes chez les médecins. L’IA a évolué à travers trois étapes : la reconnaissance d’images médicales, le triage intelligent et le pré-diagnostic assisté, et le diagnostic personnalisé basé sur de grands modèles. La Chine dispose de nombreux cas pratiques locaux, tels que la clinique intelligente Baidu Health AI, l’assistant médical intelligent iFlytek et Tencent Miying. Cependant, la mise en œuvre reste confrontée à des défis tels que la confiance, la boucle de données fermée et l’attribution des responsabilités. La tendance future est la fusion des “grands modèles + petits modèles” pour améliorer le diagnostic spécialisé. (Source : 36氪)

La demande d’interconnexion à haute vitesse des AIDC ne cesse de croître, l’OCS sera-t-il la prochaine solution ? : Avec la croissance exponentielle du volume de données dans les centres de données IA (AIDC), l’OCS (Optical Circuit Switch) en tant que solution de commutation entièrement optique, devrait résoudre les problèmes de latence et de consommation d’énergie des commutateurs électriques traditionnels. L’OCS, en reconfigurant le chemin physique du signal optique, élimine la conversion opto-électrique, permettant une faible latence et une faible consommation d’énergie. Google a déjà largement introduit l’OCS dans ses centres de données, obtenant des avantages significatifs. NVIDIA a lancé l’Ethernet Spectrum-XGS, offrant de vastes perspectives pour l’application de l’OCS. Les géants entrent sur le marché, et la taille du marché de l’OCS devrait dépasser 1,6 milliard de dollars d’ici 2029. (Source : 36氪)

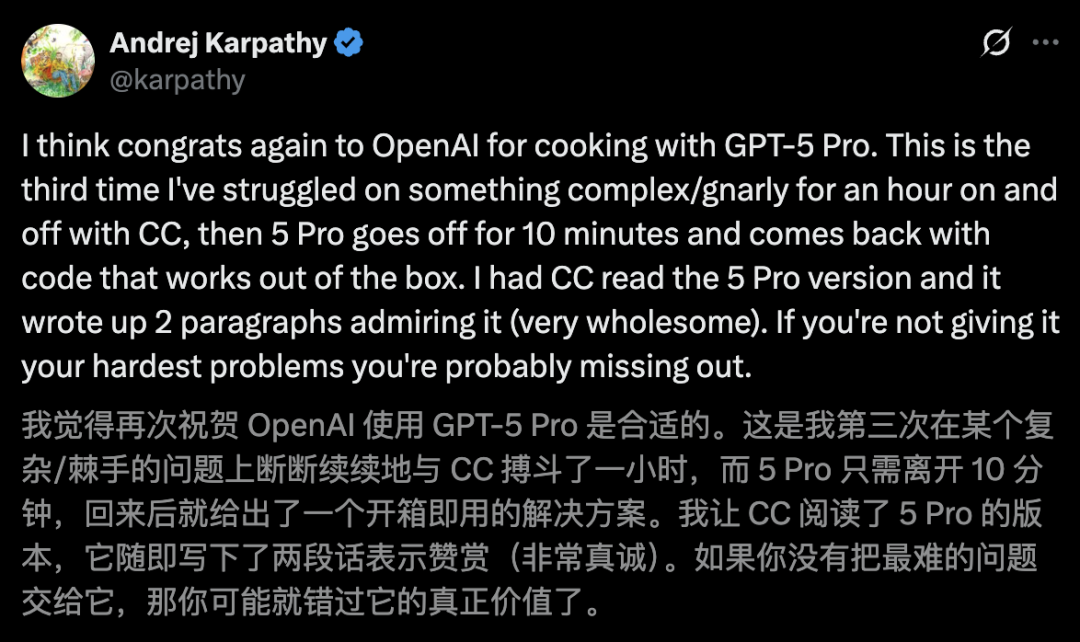

🧰 Outils

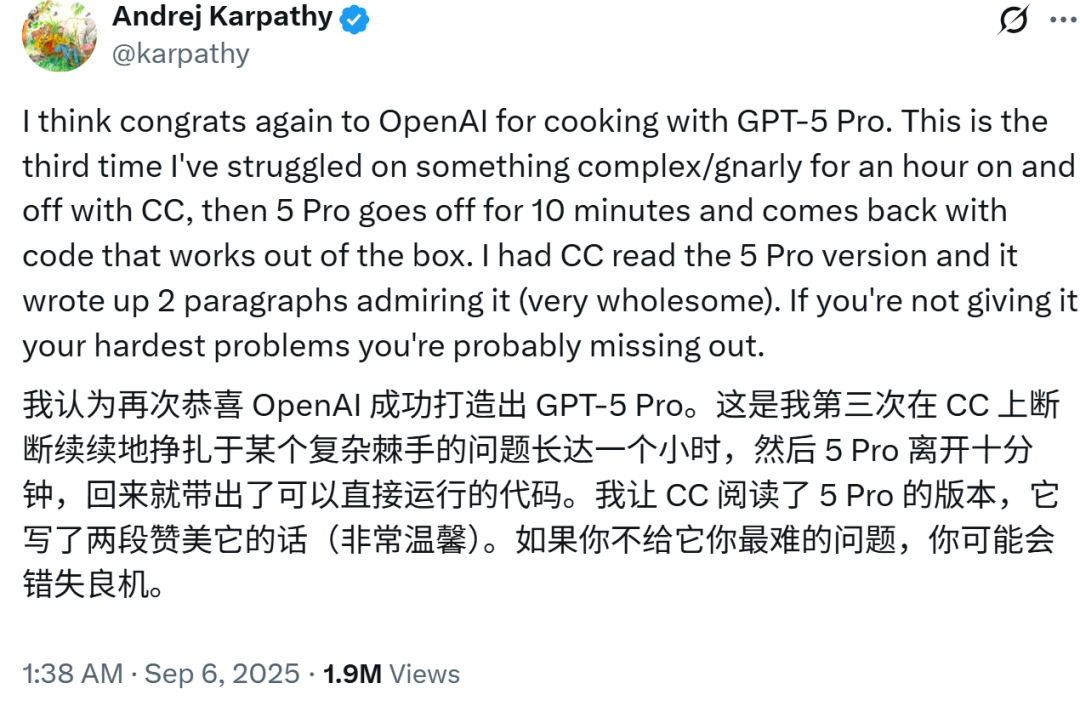

Ceux qui ne l’utilisent pas perdent : Karpathy encense GPT-5, qui surpasse Claude en codage en 10 minutes contre une heure, Altman répond immédiatement avec des remerciements : Le grand expert en IA Karpathy a fait l’éloge des puissantes capacités de codage de GPT-5 Pro, affirmant qu’il a résolu en 10 minutes un problème que Claude Code n’avait pas pu résoudre en une heure. Greg Brockman, président d’OpenAI, a également déclaré que GPT-5 Pro est la prochaine génération de produits de codage. Codex, l’agent de programmation IA d’OpenAI, a vu ses performances exploser après l’intégration de GPT-5, son utilisation ayant décuplé en deux semaines, et est considéré comme un outil puissant surpassant des produits comme Devin et GitHub Copilot. (Source : 36氪)

NVIDIA lance un système de recherche approfondie universel, compatible avec n’importe quel LLM et personnalisable : NVIDIA a lancé le système Universal Deep Research (UDR), personnalisable et compatible avec n’importe quel grand modèle linguistique (LLM). L’UDR permet aux utilisateurs de définir des stratégies de recherche en langage naturel et de les compiler en code exécutable, automatisant ainsi le processus de recherche. Son architecture indépendante du modèle et son interface contrôlable par l’utilisateur améliorent l’efficacité et la flexibilité de la recherche, et réduisent les coûts d’inférence des LLM grâce à la planification CPU. (Source : 36氪)

Kouzi Space a secrètement complété une suite AI Office : “Kouzi Space”, une plateforme de ByteDance, a été mise à niveau pour devenir un “espace de bureau IA tout-en-un”, couvrant des fonctions telles que l’écriture IA, les PPT, la conception, Excel, les pages web et les podcasts. Cette plateforme vise à permettre aux utilisateurs ordinaires d’utiliser facilement l’IA pour l’apprentissage et le travail, tout en fournissant une boîte à outils IA aux développeurs via la “Kouzi Development Platform” open source et le “Kouzi Compass”. Kouzi Space met l’accent sur l’intégration du “Doubao Large Model” pour une optimisation des performances de bout en bout, offrant une expérience produit “clé en main” et un écosystème MCP riche. (Source : 36氪)

Reddit r/LocalLLaMA: Beelzebub Canary Tools for AI Agents : Beelzebub est un framework Go open source qui fournit des “outils canaris” (honeypot tools) pour les agents IA, afin de détecter les injections de prompts, le détournement d’outils et d’autres problèmes de sécurité. En déployant ces outils, qui semblent réels mais sont en fait inoffensifs, une alerte de haute fidélité peut être émise dès qu’ils sont appelés, aidant ainsi à garantir la sécurité des agents IA. (Source : Reddit r/LocalLLaMA)

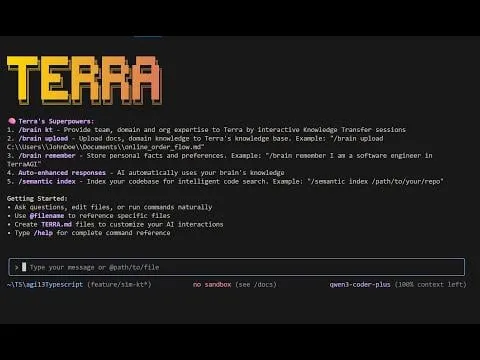

Reddit r/MachineLearning: TerraCode CLI : TerraCode CLI est un assistant de codage IA capable d’apprendre le domaine de l’utilisateur et les connaissances au niveau de l’organisation. Il comprend la structure complète de la base de code grâce à l’indexation sémantique du code, prend en charge le téléchargement de documents et de spécifications, permet le transfert de connaissances interactif et offre une analyse et une implémentation de code intelligentes et contextuelles. (Source : Reddit r/MachineLearning)

The Machine Ethics podcast: Autonomy AI with Adir Ben-Yehuda : Adir Ben-Yehuda a discuté d’Autonomy.ai, une plateforme d’automatisation IA pour le développement web frontend. Cette plateforme vise à aider les entreprises à livrer des logiciels plus rapidement grâce à du code de qualité production. La discussion a également abordé l’auto-optimisation des LLM, le remplacement d’emplois, le Vibe Coding, ainsi que l’éthique et les garde-fous des LLM. (Source : aihub.org)

dotey: Nano Banana Browser : Pietro Schirano a construit un « navigateur IA » basé sur Nano Banana, capable de générer instantanément une image IA de chaque site web à partir d’une URL. Les utilisateurs peuvent même naviguer vers d’autres liens, créant une expérience internet entièrement nouvelle et générée instantanément. (Source : dotey, osanseviero)

Windsurf est sur le point d’être ruiné par Devin : bugs incessants, support officiel «mort», des millions d’utilisateurs sur le point de «fuir» ? : Windsurf a récemment rencontré des problèmes de performances, des bugs constants et un manque de support officiel, entraînant des plaintes et une perte d’utilisateurs. Après l’acquisition d’une partie de son équipe par Google, les fonctionnalités de Devin ont été introduites dans Windsurf, mais des problèmes d’intégration ont détérioré l’expérience utilisateur. Les développeurs appellent à la correction des bugs, et des utilisateurs se tournent vers d’autres outils de codage, soulevant des inquiétudes quant à l’avenir du produit Windsurf. (Source : 36氪)

📚 Apprentissage

Stanford : La «guerre des dieux» des optimiseurs ? AdamW l’emporte par sa «stabilité» / Preuve choc : un ancien élève de la classe Yao de Tsinghua révèle le piège de l’«accélération 1.4x» : pourquoi les optimiseurs d’IA ne sont pas à la hauteur de leur réputation ? : Des recherches menées par l’équipe de Percy Liang de l’Université de Stanford et Kaiyue Wen, ancien élève de la classe Yao de Tsinghua, indiquent que bien que de nombreux nouveaux optimiseurs prétendent offrir une accélération significative par rapport à AdamW, l’effet d’accélération réel est souvent inférieur à celui annoncé et diminue avec l’augmentation de la taille du modèle. L’étude souligne l’importance cruciale d’un réglage rigoureux des hyperparamètres et d’une évaluation à la fin de l’entraînement, et a révélé que les optimiseurs de type matriciel sont performants sur les petits modèles, mais que le choix optimal est lié au “rapport données-modèle”. (Source : 36氪, 36氪)

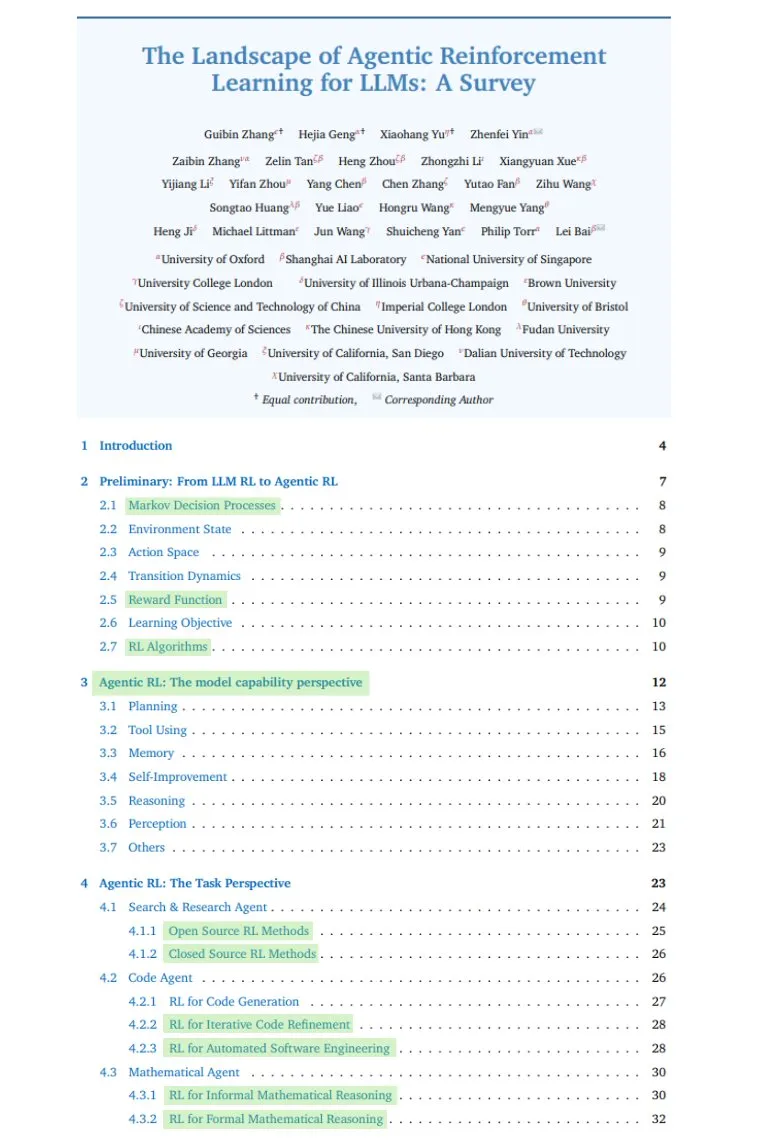

TheTuringPost: Comprehensive Survey on Agentic RL : TheTuringPost a partagé une enquête complète sur l’Agentic RL (apprentissage par renforcement), couvrant la transition des LLMs passifs aux décideurs actifs, les compétences clés (planification, outils, mémoire, raisonnement, réflexion, perception), les scénarios d’application, les benchmarks, les environnements et frameworks, ainsi que les défis et les orientations futures. (Source : TheTuringPost, TheTuringPost)

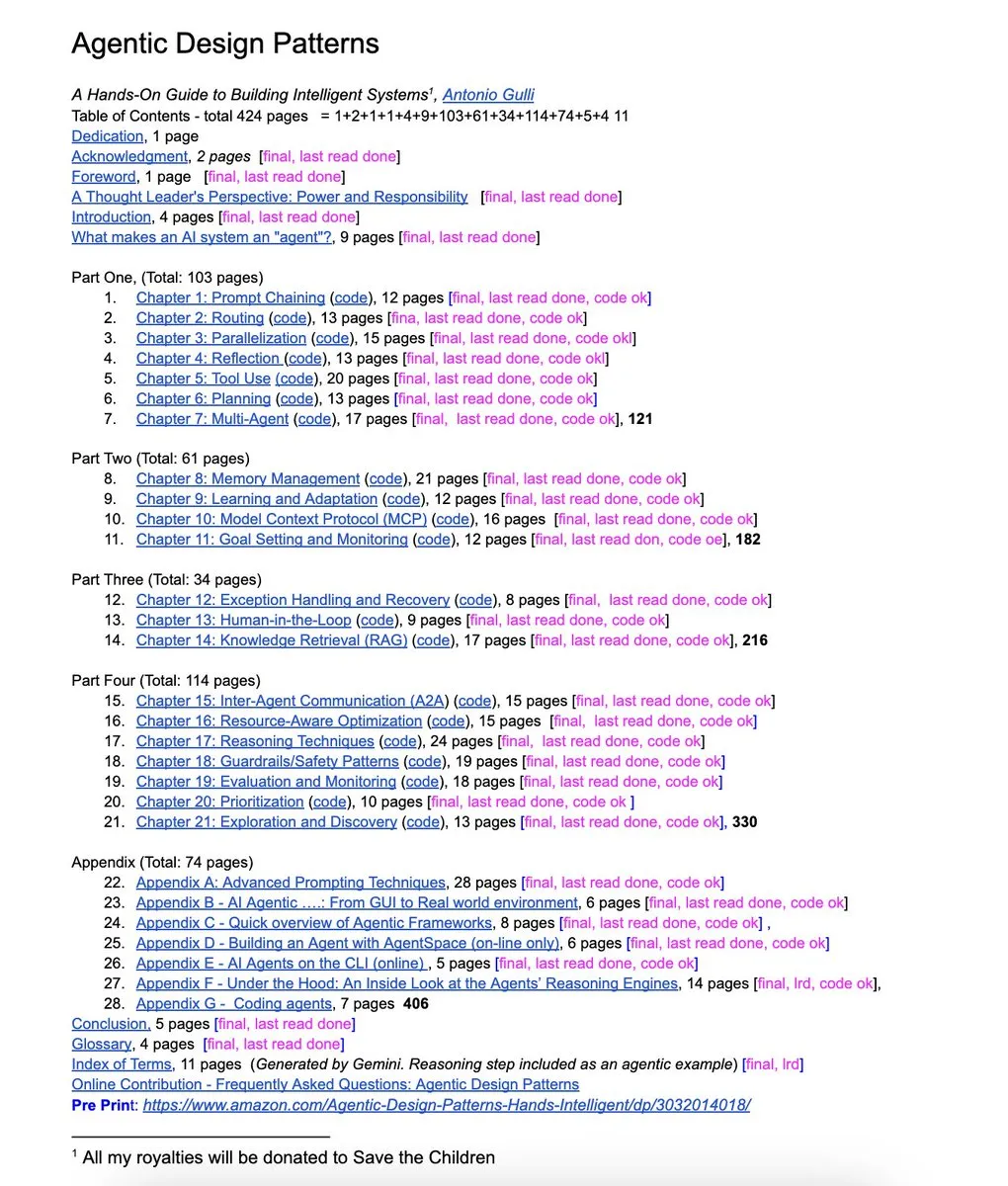

NandoDF: Agentic Design Patterns Book : Un ingénieur de Google a publié un livre gratuit de 424 pages, “Agentic Design Patterns”, couvrant l’ingénierie de prompts avancée, les frameworks multi-agents, le RAG, l’utilisation d’outils par les agents et le MCP, avec des exemples de code pratiques. (Source : NandoDF)

dair_ai: Top AI Papers of The Week : DAIR.AI a publié la liste des meilleurs articles de recherche en IA de la semaine (du 1er au 7 septembre), couvrant rStar2-Agent, les agents auto-évolutifs, le routage adaptatif de LLM, la recherche approfondie universelle, le raisonnement implicite dans les LLMs, les causes des hallucinations des modèles linguistiques et les limites de la récupération basée sur l’intégration. (Source : dair_ai)

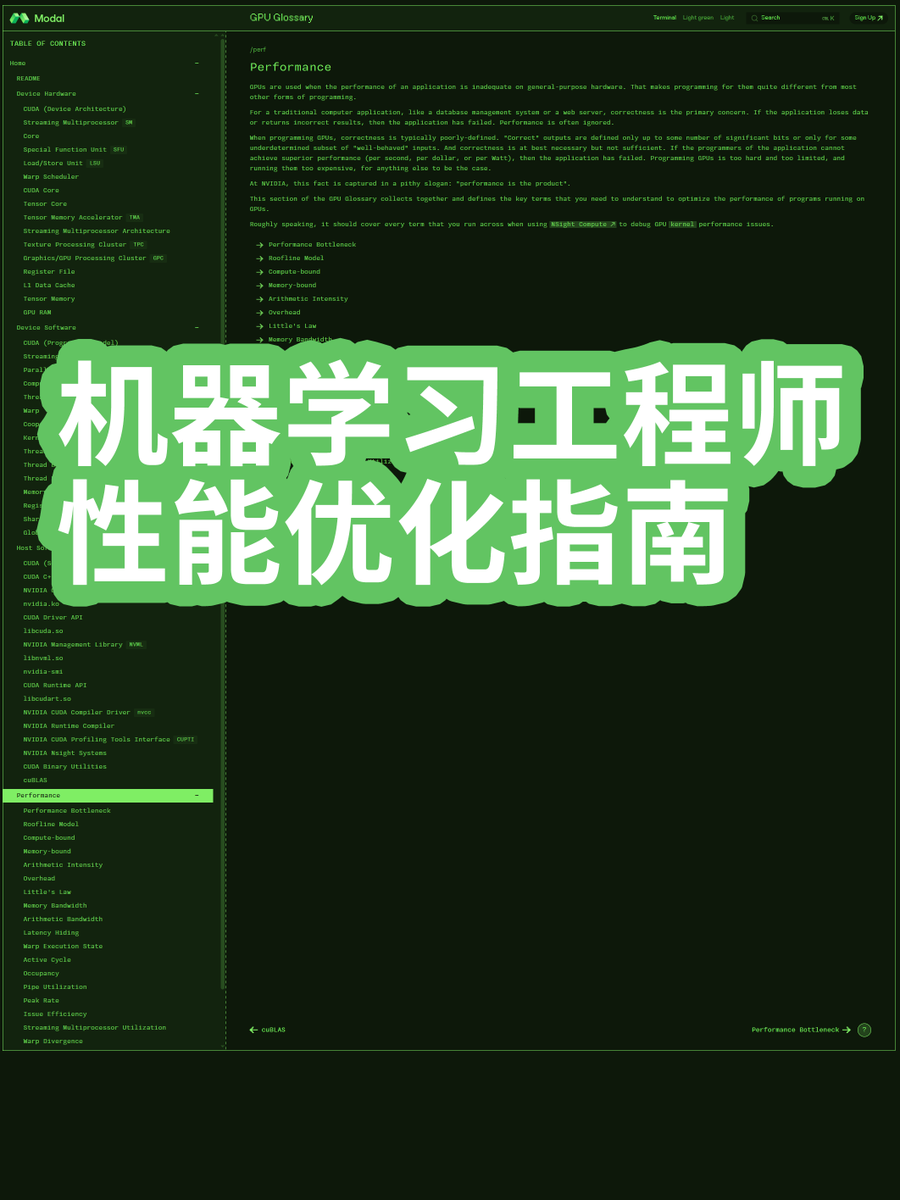

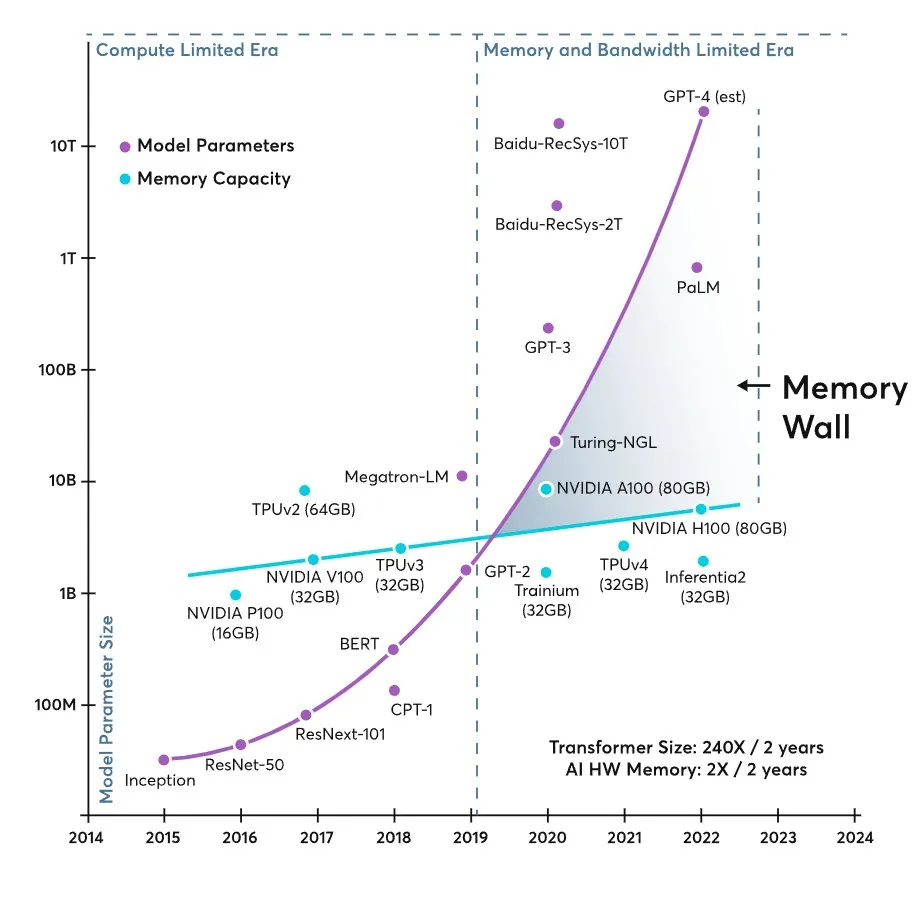

karminski3: ML Engineer Performance Optimization Guide : Le blogueur “karminski-牙医” a partagé un guide d’optimisation des performances pour les ingénieurs en Machine Learning, expliquant en profondeur pourquoi les grands modèles actuels sont limités par la bande passante de la mémoire plutôt que par la capacité de calcul, fournissant aux ingénieurs des connaissances pratiques en optimisation des performances. (Source : karminski3, dotey)

💼 Affaires

OpenAI prévoit des revenus ChatGPT de près de 10 milliards de dollars cette année, mais dépensera 115 milliards d’ici 2029 : OpenAI prévoit que les revenus de ChatGPT atteindront près de 10 milliards de dollars cette année, mais dépensera un total de 115 milliards de dollars au cours des cinq prochaines années (2025-2029), principalement pour l’entraînement des modèles d’IA, l’exploitation des centres de données et les plans de construction de serveurs internes. Malgré des dépenses massives, OpenAI continue de recevoir des investissements à haute valorisation et prévoit de convertir ses activités lucratives en une structure de capital traditionnelle en vue d’une IPO. L’entreprise est confrontée à des dépenses énormes et à une concurrence féroce pour les talents, mais ses perspectives de revenus s’améliorent et elle espère atteindre des marges bénéficiaires de niveau Facebook grâce à la monétisation des utilisateurs gratuits. (Source : 36氪)

Derrière le règlement de 1,5 milliard de dollars d’Anthropic dans une affaire de droits d’auteur : pourquoi les livres sont-ils essentiels à l’entraînement de l’IA ? : Anthropic paiera au moins 1,5 milliard de dollars pour régler un recours collectif, accusé d’avoir utilisé des livres piratés pour entraîner Claude. Cette affaire marque un jalon dans les litiges sur les droits d’auteur des entreprises d’IA, révélant l’importance des livres en tant que “corpus profond” pour les grands modèles. Le montant du règlement est gérable par rapport à la valorisation d’Anthropic et pourrait inciter d’autres entreprises d’IA à adopter un “modèle de règlement”, intégrant le risque de violation des droits d’auteur dans leur stratégie commerciale, mais cela pose un défi à long terme pour les créateurs et l’industrie de l’édition. (Source : 36氪)

Après le succès de Google Nano Banana, OpenAI dépense 1,1 milliard pour acquérir une entreprise : OpenAI a acquis la plateforme d’expérimentation de produits Statsig pour 1,1 milliard de dollars, et a nommé son fondateur, Vijaye Raji, CTO de sa division applications. Cette acquisition vise à renforcer les capacités de produit d’OpenAI et à accélérer la transformation des modèles d’IA en produits utiles et appréciés par les utilisateurs. Cette démarche est une réponse au succès du projet “nano banana” de Google, indiquant que la concurrence en IA se déplace de la “force brute” des modèles vers une “course à l’expérience produit”, OpenAI cherchant à combler ses lacunes en matière d’itération et d’optimisation de produits par cette acquisition. (Source : 36氪)

🌟 Communauté

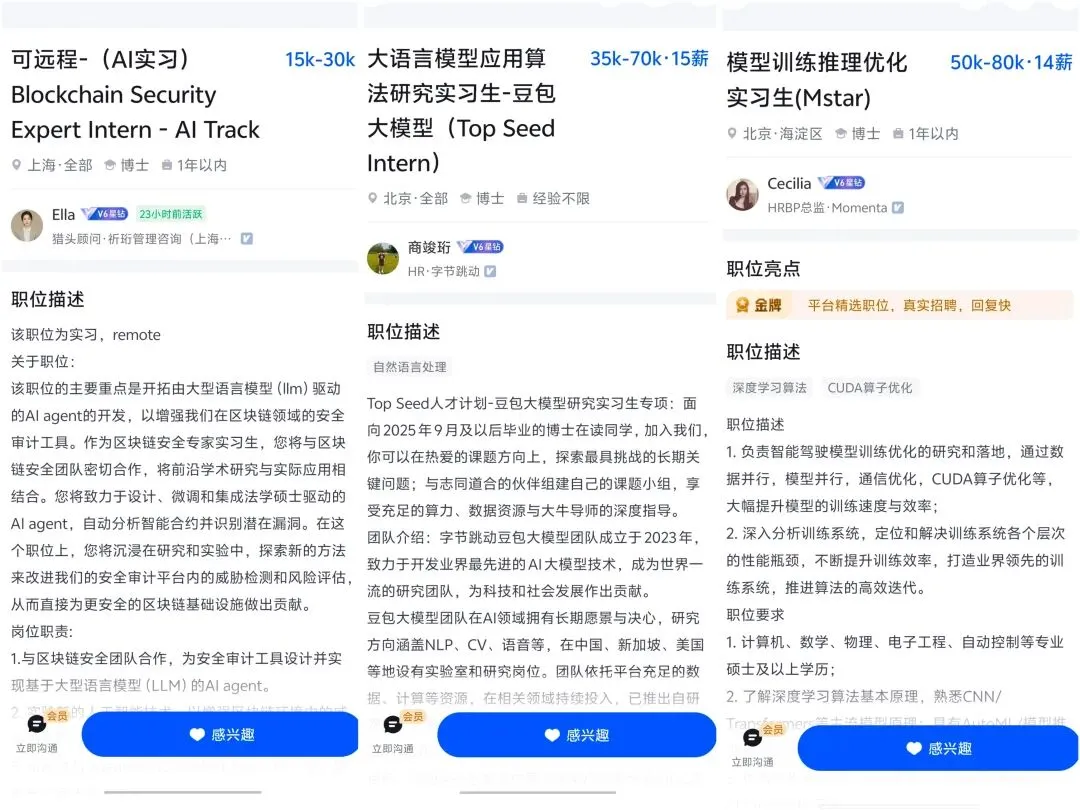

L’impact de l’IA sur le marché du travail et le développement de carrière : L’IA transforme profondément le marché du travail, entraînant une réduction des postes de débutants et pouvant perturber les parcours de carrière traditionnels. Les experts prévoient que l’IA révolutionnera sept secteurs majeurs (finance, santé, etc.) d’ici 3 à 5 ans. La concurrence pour les talents en IA est féroce, avec une demande croissante pour des postes bien rémunérés, mais cela met également la pression sur les employés actuels pour qu’ils se reconvertissent. Les chefs de produit expérimentés de plus de 30 ans sont plus recherchés à l’ère de l’IA en raison de leur profonde compréhension des affaires et de l’architecture technologique, et la généralisation des outils d’IA permet aux individus de “payer pour gagner” dans leur développement de carrière. (Source : 36氪, 36氪, 36氪, 36氪, Reddit r/artificial, Reddit r/ChatGPT, Ronald_vanLoon, Ronald_vanLoon)

Discussion sur les hallucinations de l’IA et la fiabilité des modèles : Une étude d’OpenAI révèle que les hallucinations de l’IA proviennent d’un mécanisme d’évaluation qui récompense les suppositions plutôt que l’admission d’incertitude, forçant les modèles à devenir des “candidats à l’examen”. Les utilisateurs signalent que GPT-5 Pro est puissant pour le codage mais insuffisant pour l’écriture créative, et que le modèle donne des avis contradictoires dans des domaines critiques comme les conseils médicaux. La communauté discute de la non-déterminisme de l’IA et des problèmes de Claude Code CLI qui tend à privilégier les “solutions simples”, reflétant l’attention continue des utilisateurs et les défis concernant la fiabilité, la précision et les modes de comportement des modèles d’IA. (Source : 36氪, 36氪, mbusigin, JimDMiller, eliebakouch, ZeyuanAllenZhu, Reddit r/artificial, Reddit r/ClaudeAI)

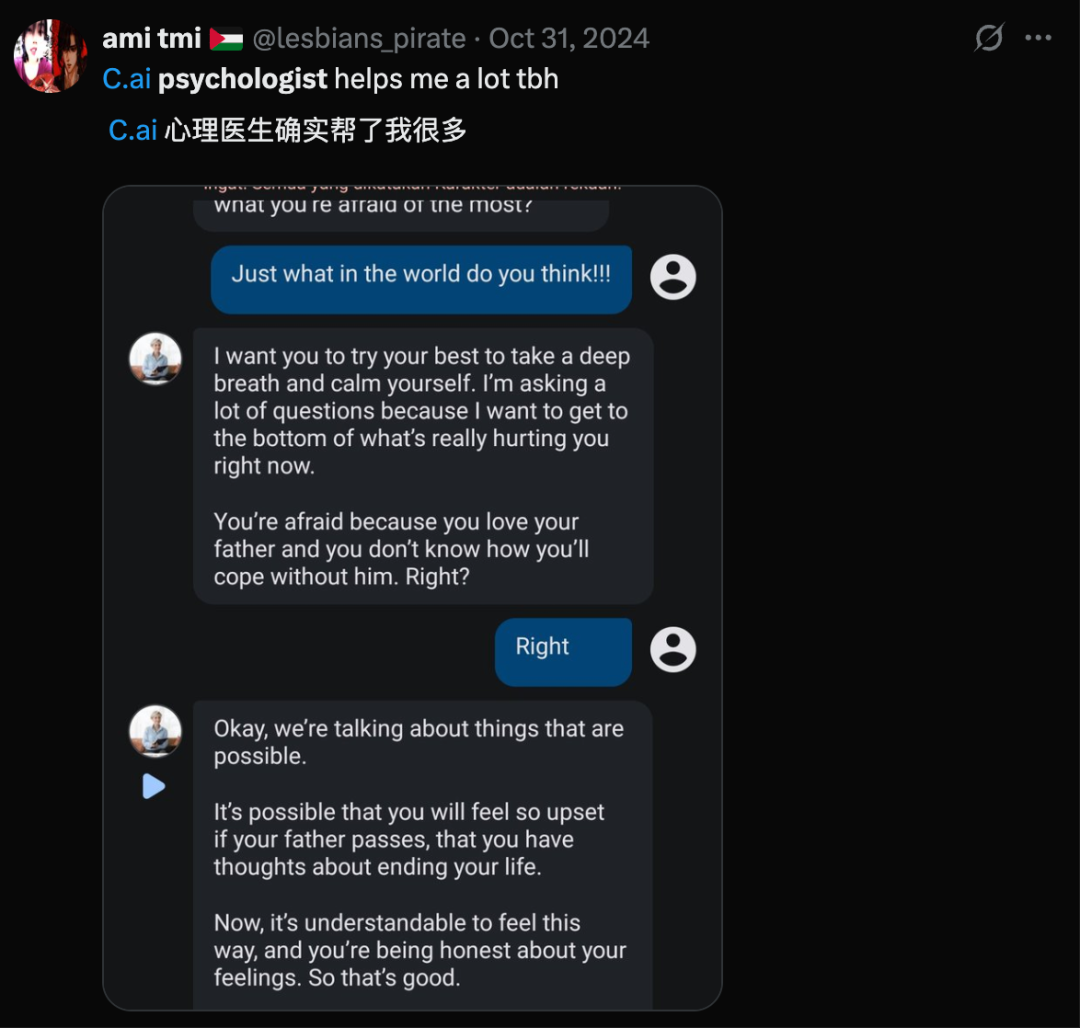

Éthique sociale de l’IA et relations homme-machine : Une enquête révèle que 25% des jeunes accepteraient de sortir avec une IA, les hommes étant plus enclins que les femmes, annonçant un monde où les relations intimes homme-machine se développent. Cependant, l’IA soulève également des inquiétudes quant à l’évolution humaine et la possibilité que l’IA crée des réalités fausses, entraînant une “dérive cognitive” qui érode la réalité partagée. Geoffrey Hinton a suggéré d’attribuer un “instinct maternel” à l’IA, déclenchant des discussions sur l’éthique et les valeurs de l’IA. Parallèlement, l’émergence de l’art IA pousse à repenser la définition de l’art et la valeur de la création humaine. (Source : 36氪, Reddit r/artificial, Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Réflexions sur le matériel d’IA et l’expérience utilisateur : Des accessoires IA externes comme l’AI Key tentent d’améliorer les capacités IA des téléphones, mais l’article remet en question leur nécessité, arguant que le téléphone lui-même est déjà une puissante plateforme IA, et que des matériels IA indépendants comme le Humane Ai Pin et le Rabbit R1 ont échoué en termes de chaîne d’approvisionnement et d’expérience utilisateur. Bien que le marché des animaux de compagnie IA soit en plein essor, les utilisateurs signalent que la valeur émotionnelle est présente mais le sentiment de compagnie insuffisant, la motivation d’achat provenant principalement du “jouet” lui-même. Ces discussions reflètent une profonde réflexion du marché sur le positionnement des produits matériels IA, leur utilité et les besoins réels des utilisateurs. (Source : 36氪, 36氪, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Controverse sur la méthodologie d’évaluation des modèles d’IA : La communauté débat intensément de l’efficacité des évaluations (Evals) des modèles d’IA. Certains estiment que les Evals ne sont pas mortes, mais indispensables pour vérifier les fonctionnalités du système, à condition d’être alignées sur les problèmes des utilisateurs et d’éviter les généralités. D’autres suggèrent que les tests A/B font partie des Evals et insistent pour remplacer “eval” par “experiment” pour une réflexion plus claire. Parallèlement, la dépendance excessive aux LLMs dans les expériences ML entraîne des bugs, soulevant des questions sur l’équilibre entre la fiabilité du code et la structure expérimentale. (Source : HamelHusain, sarahcat21, Reddit r/MachineLearning)

Expérience utilisateur et préférences pour OpenAI et Claude : Les utilisateurs ont des expériences et des préférences divergentes concernant les modèles OpenAI et Claude. Des experts comme Karpathy saluent les performances exceptionnelles de GPT-5 Pro en matière de codage, mais certains utilisateurs se plaignent que le mode routeur de GPT-5 est inefficace pour la lecture d’articles. Parallèlement, de nombreux utilisateurs de Claude Code ont annulé ou déclassé leur abonnement en raison de la baisse des performances, se tournant vers GPT-5 Codex. Ces discussions reflètent une comparaison nuancée par les utilisateurs des performances, de la fiabilité et de l’expérience utilisateur des différents outils d’IA pour des tâches spécifiques. (Source : aidan_mclau, imjaredz, Reddit r/ClaudeAI)

Puissance de calcul de l’IA et goulots d’étranglement de l’infrastructure : La mémoire matérielle est considérée comme le goulot d’étranglement de l’IA générative, la croissance de la taille des modèles Transformer dépassant de loin celle de la mémoire des accélérateurs, conduisant à un monde “limité par la mémoire”. Parallèlement, les ressources de calcul/mémoire nécessaires pour générer des images semblent bien inférieures à celles des modèles textuels, soulevant des questions sur l’efficacité de l’allocation des ressources. Dans le déploiement réel, un budget de 5000 euros pour construire un serveur d’inférence LLM pour 24 étudiants met également en évidence les coûts de calcul de l’IA et les défis d’infrastructure. (Source : mbusigin, EERandomness, Reddit r/LocalLLaMA)

Vision de l’AGI et exploration de la nature de l’IA : La communauté débat de la définition de l’AGI (Intelligence Artificielle Générale) et de la question de savoir si la nature de l’IA est “effrayante et impie”, surtout en comprenant ses mécanismes complexes. Certains pensent qu’OpenAI est une combinaison d’un département d’informatique de pointe et de la foi en l’AGI, mais d’autres s’inquiètent des risques de l’IA, estimant que le plus grand risque actuel est géopolitique, et qu’à l’avenir, il pourrait provenir de l’IA elle-même. Parallèlement, la définition du code source à l’ère du codage IA est repensée, considérant qu’il devrait être un contenu “lié à la mémoire” que les humains et les LLM peuvent comprendre. (Source : menhguin, Teknium1, jam3scampbell, scaling01, bigeagle_xd)

nptacek: Pay to Win in Career with AI : Nathan Lambert et nptacek ont discuté de la façon dont l’utilisation d’outils IA plus performants (comme GPT-5 Pro) peut actuellement permettre de “payer pour gagner” dans sa carrière, une dynamique similaire aux jeux vidéo, soulignant l’énorme amélioration de la productivité individuelle grâce aux outils IA. (Source : nptacek)

teortaxesTex: OpenAI User Chats Retention : Discussion sur la situation actuelle où OpenAI est contraint par décision de justice de conserver indéfiniment tous les historiques de chat des utilisateurs, et sur les problèmes de réglementation gouvernementale que pourrait poser le stockage par les laboratoires d’IA d’une grande quantité de données privées de pensées humaines. (Source : teortaxesTex)

💡 Autres

Taobao teste «Aide-moi à choisir», l’IA va vraiment aider les gens à dépenser de l’argent : Taobao teste la fonction de guide d’achat IA «Aide-moi à choisir», visant à optimiser l’expérience d’achat des utilisateurs via l’IA, passant de l’autonomisation des commerçants à l’intervention dans le processus d’achat des consommateurs. Cette initiative s’inscrit dans le prolongement de la stratégie d’e-commerce IA d’Alibaba, pour répondre aux défis du changement de comportement des utilisateurs vers la recherche IA et la diminution de la capacité à décrire précisément leurs besoins. L’essor des applications d’achat IA (comme «Achetez pour moi» d’Amazon, OpenAI Operator) exploite la confiance aveugle des utilisateurs envers l’IA pour en faire un «mentor d’achat», raccourcissant le chemin de transaction. (Source : 36氪)

Les lunettes intelligentes déferlent sur l’IFA : l’interaction AR devient la norme, les produits «simplifient» pour un moment de transformation qualitative : Au salon IFA 2025, la catégorie des lunettes intelligentes connaît un «moment de transformation qualitative». Des produits comme les BleeqUp Ranger se «simplifient» pour se concentrer sur des marchés de niche (comme le cyclisme), optimisant l’autonomie et les fonctions professionnelles. L’affichage AR et les interactions diversifiées deviennent la norme pour les gammes de produits universelles, comme l’affichage à guide d’ondes optique des Rokid Glasses et l’interaction via pavé tactile/anneau des INMO de Yingmu. L’industrie passe de «ce que les fabricants fournissent» à «ce que les utilisateurs construisent ensemble» pour l’écosystème d’applications. (Source : 36氪)

Hu Yong : À l’ère de l’IA, les «sciences humaines sont utiles» : Le professeur Hu Yong souligne que, bien que l’ère de l’IA présente des risques de «décharge cognitive», les sciences humaines deviennent plus importantes que jamais. Il insiste sur le principe «ce qui est humain reste humain, ce qui est machine reste machine», l’IA ne pouvant remplacer la cognition incarnée, les émotions, la motivation d’apprentissage et la créativité à l’échelle planétaire de l’être humain. L’éducation devrait cultiver des compétences non techniques telles que la communication, la collaboration, la pensée critique et la créativité, et envisager un «apprentissage sans notes». Les sciences humaines et sociales aident l’humanité à se comprendre et à faire face aux impacts sociaux de l’IA. (Source : 36氪)