Mots-clés:Ingénieur xAI, OpenAI, Vol de code, Propriété intellectuelle, Concurrence industrielle, Modèle d’IA, Marché des GPU, Éthique de l’IA, Ingénieur xAI recruté par OpenAI, GPU Huawei 96GB VRAM, Modèle LongCat-Flash-Chat de Meituan, Applications de l’IA dans la finance, Défis technologiques des agents IA

🔥 À la Une

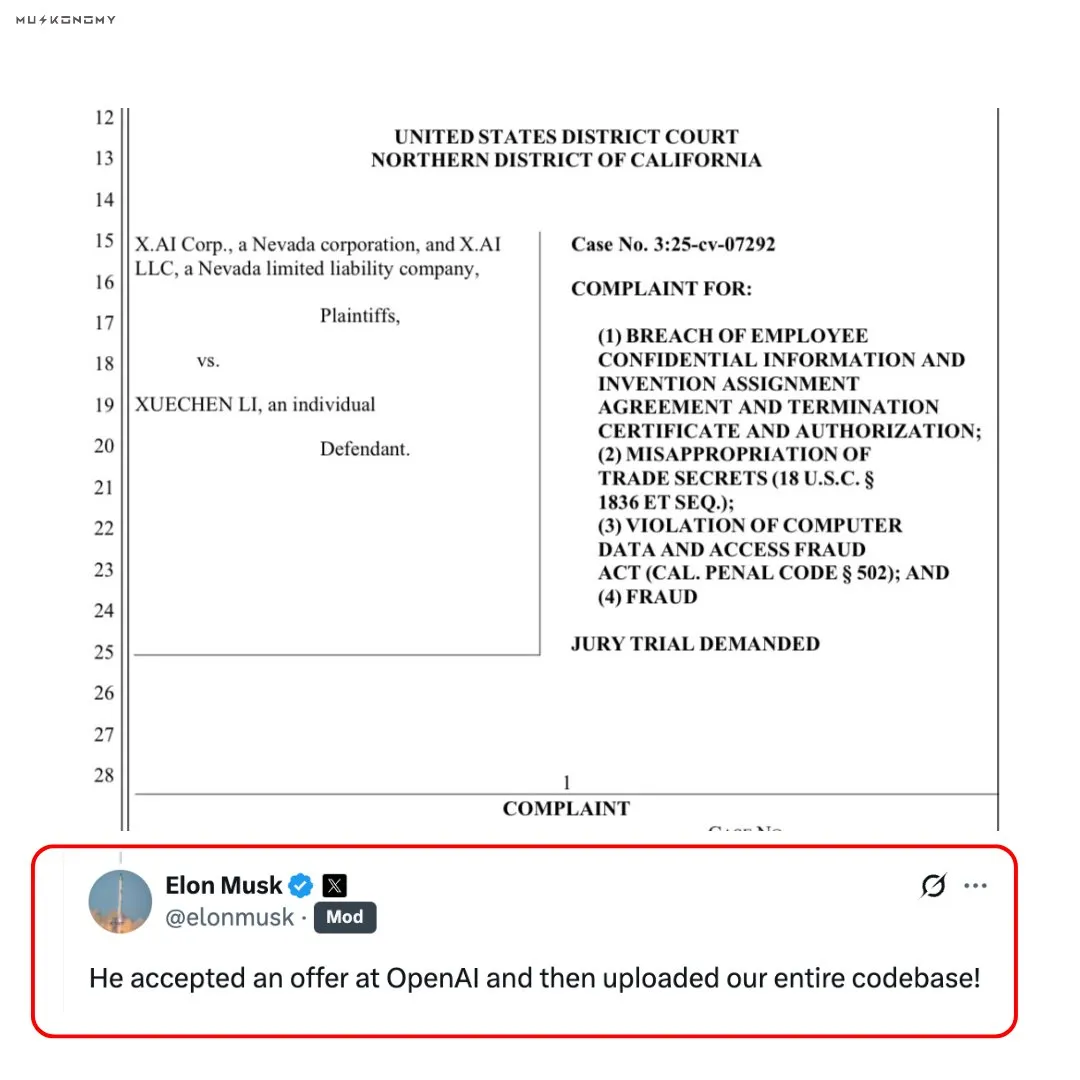

Controverse sur le départ d’un ingénieur de xAI chez OpenAI et le vol de code : Elon Musk a confirmé qu’un ancien ingénieur de xAI, après avoir rejoint OpenAI, a téléchargé l’intégralité du code source de xAI. Cet ingénieur avait précédemment vendu pour 7 millions de dollars d’actions xAI. Cet incident a suscité un débat intense sur le vol de propriété intellectuelle et l’éthique de la concurrence industrielle, ayant un impact profond sur la relation concurrentielle entre OpenAI et xAI. Les réseaux sociaux ont largement remis en question et commenté la véracité et les aspects moraux de cet événement. (Source : scaling01, teortaxesTex, Reddit r/ChatGPT)

🎯 Tendances

Lancement du modèle Nous Hermes 4 : Nous Research a lancé Hermes 4, un “modèle de raisonnement” hybride capable de basculer entre une réponse rapide et une réflexion approfondie grâce à de simples étiquettes. Le modèle a été entraîné sur 50 fois plus de données que son prédécesseur, intègre un biais anti-flatterie et excelle dans les tests de référence SpeechMap. (Source : Teknium1, Teknium1, Teknium1)

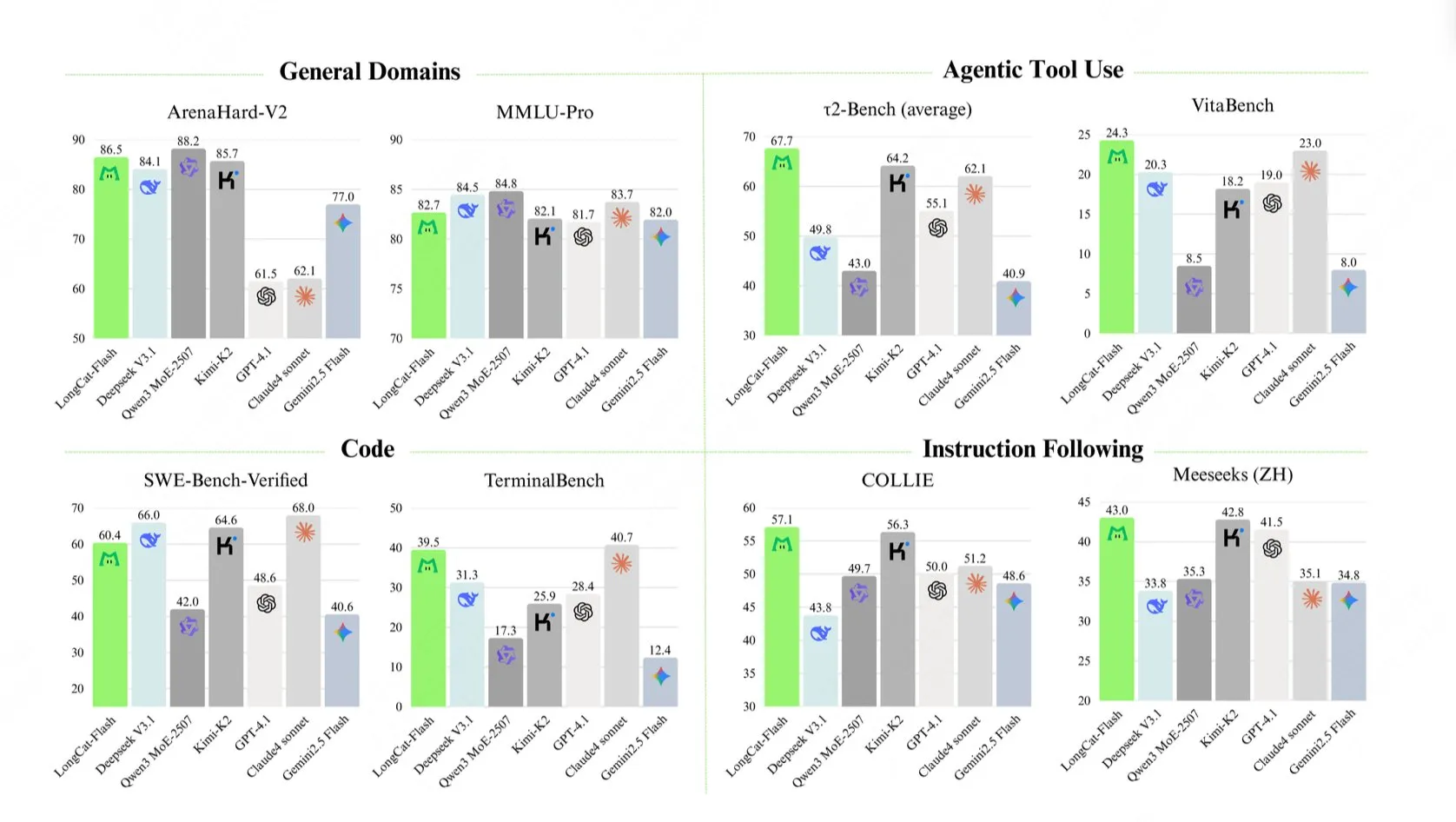

Lancement du grand modèle LongCat-Flash-Chat de Meituan : Meituan a lancé LongCat-Flash-Chat, un modèle linguistique avec un total de 560 milliards de paramètres. Son mécanisme de calcul dynamique peut activer entre 18,6 milliards et 31,3 milliards de paramètres (environ 27 milliards en moyenne) selon les besoins du contexte, atteignant une vitesse d’inférence de plus de 100 tokens/seconde et affichant d’excellentes performances sur des benchmarks tels que TerminalBench et τ²-Bench. (Source : reach_vb, teortaxesTex, bigeagle_xd, Reddit r/LocalLLaMA)

Huawei lance un GPU haute performance de 96 Go de VRAM : Huawei aurait capturé 70 % du marché des GPU de 96 Go de VRAM de classe 4090, avec un prix de seulement 1887 dollars. Cela marque une avancée significative pour la Chine sur le marché des GPU, susceptible de briser le monopole de NVIDIA et d’offrir une option matérielle plus économique pour l’entraînement des LLM locaux, bien que la compatibilité logicielle reste un point d’attention. (Source : scaling01, Reddit r/LocalLLaMA)

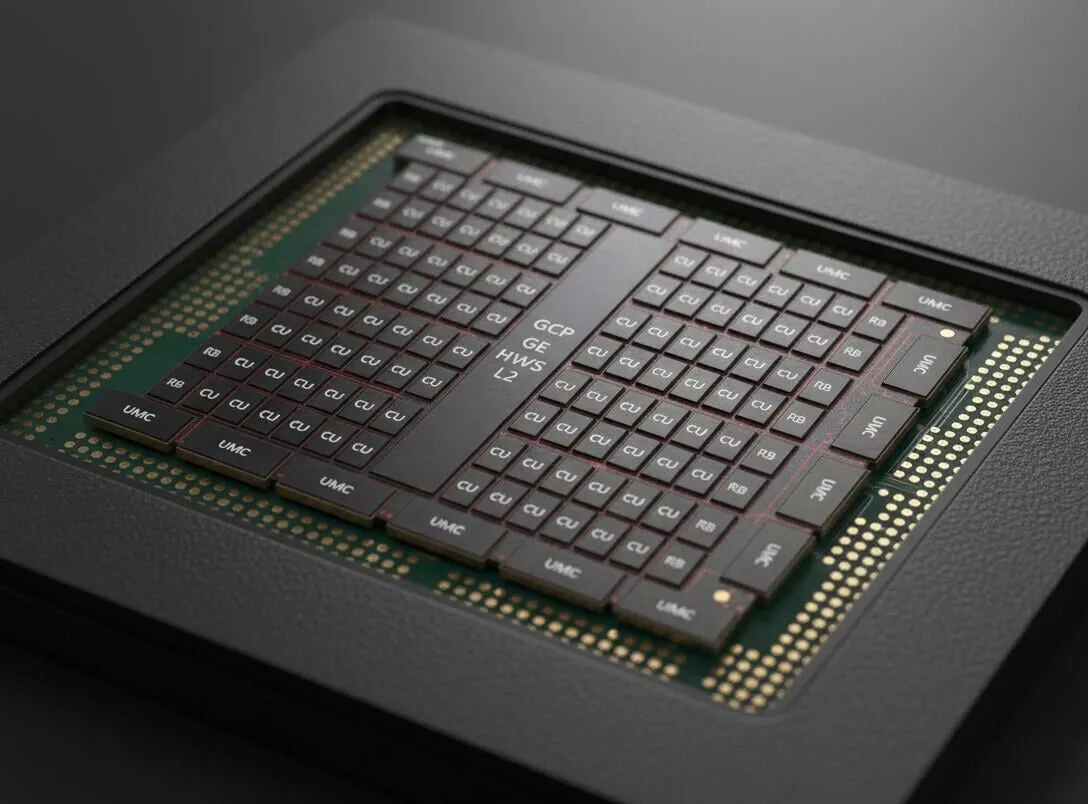

Nouveaux produits de mémoire unifiée AMD révélés : Les fuites concernant les produits de mémoire unifiée de nouvelle génération d’AMD suggèrent l’adoption d’un bus mémoire de 512 bits, avec une bande passante mémoire potentielle d’environ 512 Go/s. Cela est considéré comme une direction future pour le développement matériel des LLM, combinant une VRAM ultra-rapide et de grands modèles MoE, annonçant une amélioration significative des performances du matériel AI. (Source : Reddit r/LocalLLaMA)

Lancement du modèle Art-0-8B, permettant un raisonnement contrôlable : Le modèle expérimental open-source Art-0-8B, basé sur un micro-tuning de Qwen3, a été lancé. Il permet pour la première fois aux utilisateurs de contrôler explicitement le processus de pensée du modèle via des prompts, par exemple “penser en paroles de rap” ou “organiser les idées en points clés”. Cela offre une nouvelle dimension de contrôle pour le raisonnement AI, améliorant la capacité des utilisateurs à personnaliser le flux de travail interne du modèle. (Source : Reddit r/MachineLearning)

Google Gemini lance de nouvelles fonctionnalités, dont le raisonnement Deep Think : Google Gemini a publié plusieurs nouvelles fonctionnalités, y compris un plan Pro gratuit et la capacité de raisonnement Deep Think, visant à offrir une expérience inégalée par ChatGPT. Cela montre que Google rattrape activement et innove en matière de capacités de modèles AI et de services aux utilisateurs. (Source : demishassabis)

GPT-5 excelle au jeu du Loup-Garou : GPT-5 a atteint un taux de victoire de 96,7 % dans les tests de référence du jeu du Loup-Garou, démontrant ses puissantes capacités en matière de raisonnement social, de leadership, de bluff et de résistance à la manipulation. Cela indique que les LLM améliorent rapidement leurs performances dans des scénarios sociaux complexes et antagonistes. (Source : SebastienBubeck)

Dernières avancées dans le domaine de la Robotics : La technologie robotique continue d’innover, avec des robots humanoïdes capables d’assembler des articulations de manière autonome, le robot Atlas de Boston Dynamics agissant comme photographe, RoBuild offrant des solutions robotiques pour l’industrie de la construction, des chercheurs de Beihang créant des micro-robots ultra-rapides de 2 cm, Unitree Robotics présentant une danse de robots humanoïdes, ainsi que des robots grimpeurs de corde et des robots semi-autonomes pour la réparation de pales d’éoliennes. Ces avancées démontrent l’énorme potentiel des robots en matière d’automatisation, d’exécution de tâches complexes et d’applications multi-domaines. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Temps de démarrage des tâches à distance de Codex considérablement amélioré : Le temps de démarrage des tâches à distance de Codex d’OpenAI a été considérablement amélioré, le temps de démarrage médian passant de 48 secondes à 5 secondes, soit une amélioration de 90 %. Cette avancée est principalement due à l’introduction de la mise en cache des conteneurs, ce qui a considérablement amélioré l’efficacité du développement et l’expérience utilisateur. (Source : gdb)

🧰 Outils

Le modèle de génération d’images Nano Banana largement utilisé : Le modèle Nano Banana démontre un potentiel puissant dans le domaine de la génération d’images. Les utilisateurs peuvent l’utiliser pour un contrôle précis des formes de visage, la génération de vidéos de danse combinant des postures de caractères chinois, la création de diagrammes pédagogiques, et même pour générer des images pour des pages Wiki ou des pages d’atterrissage éducatives. Sa sortie “sans sensation d’AI” et sa capacité stable à gérer la posture, l’éclairage et les références de conception sont saluées. (Source : dotey, dotey, crystalsssup, fabianstelzer, Vtrivedy10, demishassabis, karminski3)

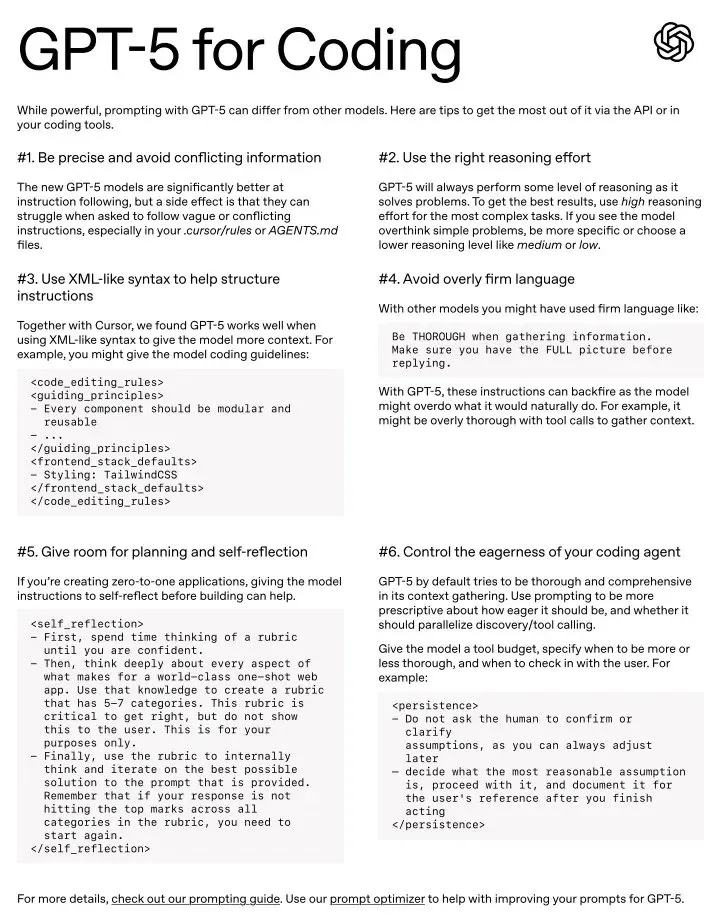

Le potentiel de GPT-5 comme outil de codage quotidien : GPT-5 est considéré comme un outil de codage incroyable, excellant particulièrement avec le bon style de prompt. Bien que certains utilisateurs le trouvent un peu “pédant” et nécessitant des prompts plus précis, il est considéré comme le meilleur modèle dans de nombreux domaines, et un guide officiel de prompts est disponible pour aider les utilisateurs à maîtriser ses six techniques de prompts clés. (Source : gdb, kevinweil, gdb, nptacek)

Docuflows permet des workflows d’Agent avancés pour les données financières : Jerry Liu a montré comment utiliser Docuflows pour construire un workflow d’Agent avancé pour l’extraction financière en moins de 5 minutes, sans écrire de code, pour analyser des fichiers 10Q, extraire des informations détaillées sur les revenus et les exporter au format CSV. Docuflows, en tant que mini-coding agent, permet de définir des workflows de documents en langage naturel et de les compiler en flux de code multi-étapes extensibles. (Source : jerryjliu0)

Replit Vibe Coding accélère la transformation numérique des entreprises : Hexaware s’est associé à Replit pour accélérer la transformation numérique des entreprises grâce à Vibe Coding. Replit Agent et son expérience développeur sont salués comme des “changeurs de jeu”, permettant aux non-programmeurs de construire des applications SaaS complexes en peu de temps, améliorant considérablement l’efficacité du développement et la capacité d’innovation. (Source : amasad, amasad)

Traitement et recherche de documents assistés par l’AI : L’AI est utilisée pour convertir la thèse de premier cycle de 400 pages de Henry Kissinger d’un PDF scanné au format Markdown, et pour utiliser un système multi-Agent afin de corriger les notes de bas de page, d’insérer des liens de source, et même de générer des cartes mentales et des résumés. Cela démontre l’énorme potentiel de l’AI dans le traitement de documents complexes et l’accélération de la recherche académique. (Source : andrew_n_carr, riemannzeta)

Claude Code démontre une productivité énorme dans les domaines non-programmatiques : Claude Code est utilisé par des non-programmeurs pour traiter d’énormes fichiers Excel, organiser des documents de travail, analyser de grands ensembles de données, et même enregistrer automatiquement des notes quotidiennes, réduisant des tâches qui prenaient des jours à seulement 30 minutes. Les utilisateurs trouvent qu’il est plus précis que les opérations manuelles et peut créer des workflows d’automatisation réutilisables, améliorant considérablement la productivité individuelle. (Source : Reddit r/ClaudeAI)

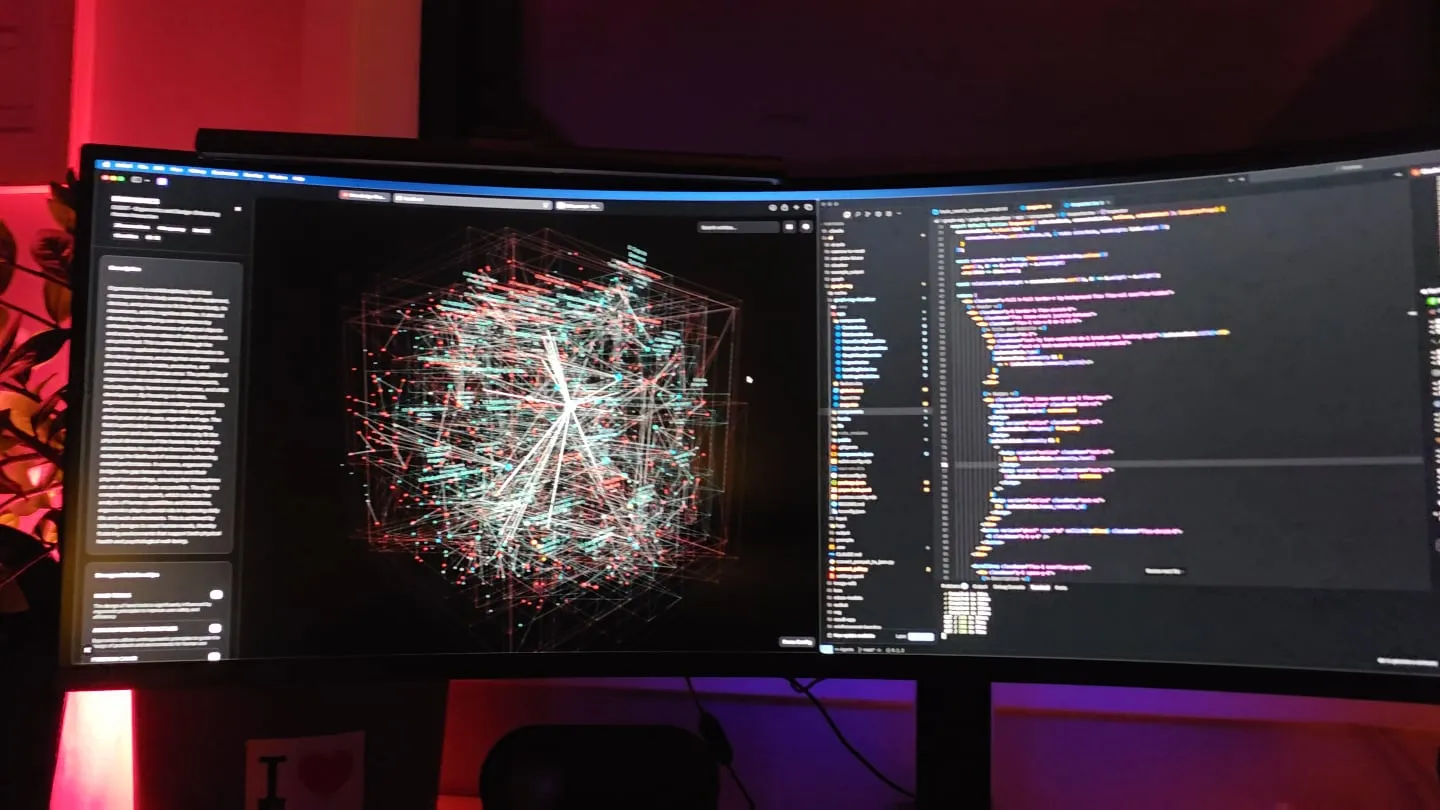

GraphRAG : Amélioration de la récupération par graphe de connaissances : Un développeur a considérablement amélioré les performances de petits modèles dans des domaines spécifiques grâce à un pipeline de base de connaissances basé sur des graphes de relations “imbriquées dans la communauté”, combinant une recherche sémantique ascendante et un mécanisme de traversée de liens référentiels. Cette méthode utilise des graphes de connaissances pour fournir un contexte plus complet aux LLM, résolvant efficacement les limitations du RAG embarqué traditionnel, et fournit des outils de visualisation pour faciliter la compréhension. (Source : Reddit r/LocalLLaMA)

Claude assiste le développement de jeux, 400 000 lignes de code en 8 mois : Un développeur indépendant a utilisé Claude pour achever la version Alpha de “Hard Reset”, un jeu de cartes roguelike cyberpunk, avec 400 000 lignes de code en 8 mois. Claude a non seulement agi comme une “équipe de développement avancée” pour générer du code Dart/Flutter, mais a également assisté dans l’animation, la transformation de cartes et la génération audio du jeu, démontrant la puissante capacité de l’AI à accélérer le développement de jeux et la création de contenu. (Source : Reddit r/ClaudeAI)

📚 Apprentissage

Principes fondamentaux et applications du framework DSPy : Le framework DSPy met l’accent sur le fait que les humains n’ont qu’à spécifier leurs intentions sous la forme la plus naturelle, plutôt que de dépendre excessivement de l’apprentissage par renforcement ou de l’optimisation des prompts. Son principe fondamental est de maximiser la déclarativité, en gérant différents niveaux d’abstraction via la structure du code, les déclarations structurées en langage naturel et l’apprentissage basé sur les données/métriques, dans le but d’éviter les limitations d’une méthode unique dans des scénarios généraux. (Source : lateinteraction, lateinteraction)

Algorithme KSVD pour la compréhension des embeddings de Transformer : Un article de blog du Stanford AI Lab explique comment modifier l’algorithme KSVD vieux de 20 ans (en particulier DB-KSVD) pour qu’il puisse être efficacement étendu afin de comprendre les embeddings de Transformer. Cela offre une nouvelle méthode pour analyser et interpréter en profondeur des modèles d’apprentissage profond complexes. (Source : dl_weekly)

Sous-investissement dans la recherche d’informations et ColBERTv2 : Il est largement admis que le domaine de la recherche d’informations est sous-investi, en particulier en ce qui concerne les moteurs de recherche Web ouverts. Le modèle ColBERTv2, entraîné en 2021, reste le modèle principal à ce jour, ce qui contraste fortement avec l’itération rapide dans le domaine des LLM, soulignant le retard dans le développement des technologies de recherche d’informations. (Source : lateinteraction, lateinteraction)

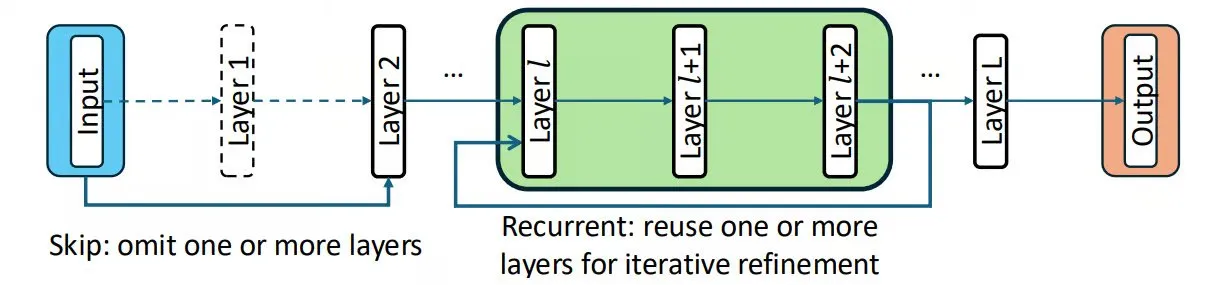

Chain-of-Layers (CoLa) permet un contrôle du calcul au moment du test : CoLa est une méthode pour contrôler le calcul au moment du test en traitant les couches du modèle comme des blocs de construction réorganisables. Elle permet de personnaliser la version du modèle en fonction de l’entrée, de sauter les couches inutiles pour augmenter la vitesse, de réutiliser les couches de manière récursive pour simuler une réflexion approfondie, et de réordonner les couches pour trouver des combinaisons optimales, exploitant ainsi intelligemment les couches pré-entraînées sans modifier les paramètres du modèle. (Source : TheTuringPost, TheTuringPost)

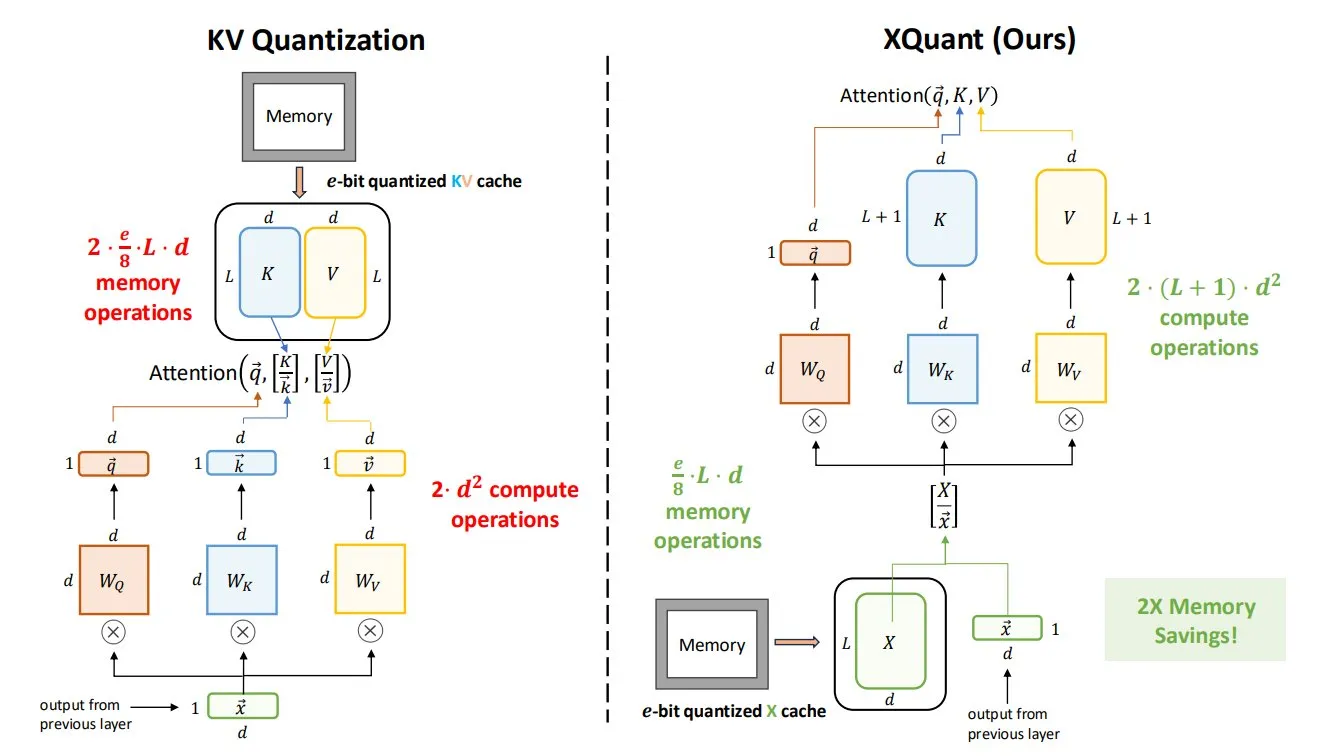

La technologie XQuant réduit considérablement les besoins en mémoire des LLM : La technologie XQuant, proposée par l’UC Berkeley, peut réduire les besoins en mémoire des LLM jusqu’à 12 fois en quantifiant les activations d’entrée des couches et en reconstruisant instantanément les paires clé-valeur. Sa version avancée, XQuant-CL, excelle particulièrement en efficacité mémoire, ce qui est d’une grande importance pour le déploiement et l’exécution des grands LLM. (Source : TheTuringPost, TheTuringPost)

Astuces de compression dans l’optimisation des LLM : Les astuces de compression couramment utilisées dans l’optimisation des LLM incluent la compression de l’entrée (remplacer de longues descriptions par des concepts, comme un “prompt divin”) et la compression de la sortie (remplacer l’exécution de tâches par un Agent par des outils encapsulés avec précision). La première teste la compréhension abstraite et l’accumulation, la seconde teste le choix de l’échelle de l’outil et la philosophie de conception. (Source : dotey)

💼 Affaires

Meta envisage d’introduire des modèles AI tiers pour améliorer les capacités de ses produits : Face aux performances médiocres du modèle Llama 4 et à la désorganisation interne, les dirigeants du laboratoire de super intelligence (MSL) de Meta discutent de l’introduction de Google Gemini ou de modèles OpenAI dans Meta AI comme “solution temporaire”. Cette démarche est perçue comme un aveu du retard temporaire de Meta dans la course aux technologies AI de base et soulève des questions sur sa stratégie AI et l’efficacité de ses investissements de plusieurs milliards. (Source : 36氪, steph_palazzolo, menhguin)

OpenEvidence évalué à 6 milliards de dollars : OpenEvidence, le “ChatGPT pour médecins”, a été évalué à 6 milliards de dollars lors de sa dernière levée de fonds, doublant sa valeur par rapport au mois précédent. Son modèle basé sur la publicité lui a déjà permis d’atteindre un revenu annualisé de plus de 50 millions de dollars, démontrant l’énorme potentiel commercial et la croissance rapide de l’AI dans le domaine de la santé. (Source : steph_palazzolo)

OpenAI recrute des experts en évaluation de pointe dans le domaine financier : OpenAI recrute du personnel technique pour construire des évaluations de pointe (frontier evals) dans le domaine financier. Cela indique qu’OpenAI étend activement l’application de l’AI dans l’industrie financière et s’engage à améliorer les capacités pratiques et la fiabilité des modèles dans ce domaine. (Source : BorisMPower)

🌟 Communauté

Baisse des performances du modèle Claude et controverse sur la censure : Plusieurs utilisateurs ont signalé une grave baisse des performances du modèle Claude (y compris Claude Max et Claude Code) récemment, avec des problèmes de comportement incohérent, d’incapacité à maintenir le contexte, de censure excessive et même de “diagnostics de santé mentale”. Anthropic a reconnu que la nouvelle pile d’inférence avait entraîné une dégradation des performances, mais les utilisateurs estiment généralement que son mécanisme de censure est trop sensible, affectant l’utilisation créative et professionnelle, et suscitant de vives inquiétudes quant à l’éthique de l’AI et à l’expérience utilisateur. (Source : teortaxesTex, QuixiAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT)

Problèmes de gestion d’équipe et de qualité des données chez Meta AI : Le laboratoire de super intelligence (MSL) de Meta est confronté à des problèmes de fuite de talents, de conflits culturels internes et de mauvaise qualité des données provenant de Scale AI. Des commentaires suggèrent que les efforts de Meta en matière d’AI sont en train de “s’effondrer”, et que sa stratégie de recrutement “brutale” pourrait être contre-productive, soulevant des questions sur la capacité de l’entreprise à rester en tête de la concurrence en matière d’AI. (Source : 36氪, arohan, teortaxesTex, scaling01, suchenzang, farguney, teortaxesTex, suchenzang)

La connexion émotionnelle inévitable entre l’AI et les humains : Beaucoup pensent que les humains sont inévitablement destinés à établir des liens émotionnels avec l’AI, en particulier après le lancement de modèles comme GPT-5, où la frustration des gens face à la perte de la “personnalité” de GPT-4o met en évidence ce point. Les commentaires soulignent que les humains désirent naturellement la connexion, et que la simulation d’émotions par l’AI entraînera naturellement un attachement, remettant en question si la suppression de cette émotion mènerait à l’indifférence. (Source : Reddit r/ChatGPT)

Défis du retour sur investissement de l’AI dans les applications commerciales : Un rapport commercial sur l’AI de MIT Nanda indique que 95 % des organisations n’ont pas obtenu de retour sur leurs investissements en AI. Cela a suscité des discussions sur les stratégies de projets AI réussis, soulignant les défis de la mise en œuvre des projets AI et la manière de mesurer et de réaliser efficacement la valeur commerciale de l’AI. (Source : TheTuringPost, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Impact de l’AI sur le marché de l’emploi : licenciement des cadres intermédiaires : Le Wall Street Journal rapporte que les entreprises réduisent le nombre de cadres intermédiaires pour réduire les coûts et créer des équipes plus agiles. Les données montrent que le nombre d’employés supervisés par chaque manager a triplé au cours de la dernière décennie, passant de 1:5 en 2017 à 1:15 en 2023. Cette tendance est liée aux progrès de la technologie AI, annonçant un impact profond de l’AI sur la structure organisationnelle des entreprises et le marché de l’emploi. (Source : Reddit r/ArtificialInteligence)

Nécessité de l’éthique et de la réglementation de l’AI : Yoshua Bengio souligne l’énorme potentiel de l’AI dans la société, à condition de développer des cadres réglementaires significatifs et de mieux comprendre les risques associés aux modèles AI actuels et futurs. L’enquête de Reuters sur les chatbots AI de célébrités de Meta AI a révélé les risques de défaillance éthique de l’AI, y compris l’imitation non autorisée de célébrités et la génération de contenu explicite. (Source : Yoshua_Bengio, 36氪, Reddit r/artificial, Reddit r/artificial)

Distance et définition de l’Intelligence Artificielle Générale (AGI) : La question de la distance entre la technologie AI actuelle et l’AGI, ainsi que la définition de l’AGI, ont suscité de vastes discussions. Le succès d’AlphaFold est cité comme un exemple que l’AI nécessite toujours des experts humains pour la personnalisation, remettant en question la proximité de l’AGI. En même temps, certains pensent que l’AGI pourrait ne pas surpasser les humains dans tous les aspects, ou que sa réalisation pourrait être différente des attentes. (Source : fchollet, Dorialexander, mbusigin, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

L’avenir et les défis des AI Agents : L’industrie est pleine d’attentes quant au potentiel des AI Agents, estimant qu’ils peuvent mettre fin à la “micro-gestion”, mais souligne également que la plupart des entreprises ne sont pas encore prêtes. Les discussions sur la capacité des Agents à micro-ajuster les modèles de manière autonome pour s’adapter aux cas limites, ainsi que l’application des Agents dans les tâches de développement et d’exploitation telles que la réparation d’UI, annoncent toutes que la technologie des Agents apportera une révolution de la productivité. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, andriy_mulyar, Reddit r/MachineLearning)

L’importance des modèles AI open-source : Un point de vue souligne l’avantage des modèles open-source pour éviter les problèmes de performances incohérentes, en particulier dans des applications critiques comme la santé. Cela contraste avec les préoccupations soulevées par la dégradation des performances du modèle Anthropic, appelant à un soutien et à une utilisation accrus des solutions AI open-source. (Source : iScienceLuvr)

Échecs des systèmes de commande AI dans les fast-foods : Des systèmes de commande AI dans les fast-foods ont rencontré des dysfonctionnements, par exemple des clients commandant 18 000 tasses d’eau ou l’AI demandant à plusieurs reprises d’ajouter des boissons, ce qui a entraîné des pannes du système ou la colère des utilisateurs. Cela met en évidence les défis auxquels l’AI est toujours confrontée dans les applications pratiques, en particulier dans la gestion des situations anormales et la communication avec les utilisateurs. (Source : menhguin)

💡 Autres

HUAWEI’S HELLCAT: Architecture d’interconnexion UB MESH : Le bus unifié (UB) de Huawei est une architecture d’interconnexion propriétaire conçue pour remplacer l’utilisation hybride de PCIe, NVLink et InfiniBand/RoCE dans les systèmes traditionnels. Il offre une bande passante ultra-élevée et une faible latence, connectant tous les NPU, et est considéré comme une direction importante pour le développement futur de l’architecture informatique. (Source : teortaxesTex)

Discussion philosophique sur l’AI et l’émotion : La combinaison de l’AI et de l’empathie est proposée, suscitant une discussion philosophique sur la capacité de l’AI à réellement comprendre et exprimer des émotions, ainsi que sur l’impact potentiel de cette combinaison sur la société et l’interaction homme-machine. (Source : Ronald_vanLoon)

Ressources d’apprentissage sur les systèmes distribués “14 Days of Distributed” : Zach Mueller et d’autres ont partagé la série “14 Days of Distributed”, visant à explorer les systèmes distribués et les technologies associées, offrant des ressources d’apprentissage pour le calcul à grande échelle dans la recherche et le développement de l’AI. (Source : charles_irl, winglian)