Mots-clés:Conférence mondiale sur la robotique, Robot humanoïde, Intelligence incarnée, GPT-5, Lunettes IA, Google DeepMind, LangChain, Lunettes IA Reality Proxy, Simulateur de monde Genie 3, Indexation vectorielle LEANN, Appel gratuit Qwen Code, Service prioritaire GPT-5

Voici la traduction du texte en français, en respectant toutes vos exigences :

🔥 Pleins feux

Le “Gala du Printemps” de l’IA incarnée : 200 robots en compétition : Le World Robot Congress (WRC 2025) s’est tenu en grande pompe à Pékin, attirant plus de 220 entreprises exposantes et présentant plus de 1500 pièces, dont plus de 100 nouveaux produits lancés par 50 entreprises de robots humanoïdes. Le congrès a mis en lumière les dernières avancées des robots humanoïdes dans des domaines tels que les services domestiques (comme faire le lit, plier les vêtements), les services commerciaux (comme la caisse, la préparation de café, la mixologie), les applications industrielles (comme l’assemblage de précision, le tri, la manutention) et les soins médicaux (comme la rééducation, le massage). De plus, les composants de la chaîne de valeur robotique (tels que les vis à rouleaux planétaires, les mains agiles, les capteurs tactiles) ont également montré des innovations significatives, marquant l’accélération de l’intégration de l’intelligence incarnée dans le monde physique, et promettant une fusion profonde de l’IA avec les scénarios réels. (Source: 36氪)

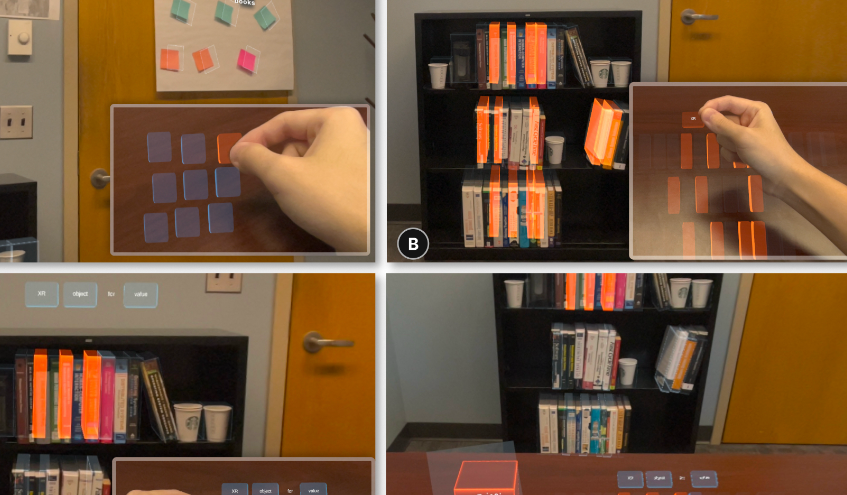

Lunettes AI “télékinétiques” : Reality Proxy : Une équipe d’anciens élèves de l’Université du Zhejiang a développé une technologie de lunettes AI nommée “Reality Proxy”, permettant aux utilisateurs de “saisir à distance” et d’interagir intuitivement avec des objets du monde réel via un “double numérique”. Cette technologie peut capturer la structure de la scène et générer des agents numériques manipulables, prenant en charge diverses fonctions interactives telles que la prévisualisation, la sélection multiple d’objets, le filtrage par attributs, le regroupement sémantique et le regroupement par mise à l’échelle spatiale. Cette innovation fusionne les mondes physique et numérique, améliorant considérablement l’efficacité et la précision de l’interaction des appareils XR dans des scénarios complexes tels que la recherche de livres, la navigation architecturale et le contrôle de drones. Elle est considérée comme une étape clé vers un assistant AI de type “Jarvis”. (Source: 量子位)

🎯 Tendances

Lancement de GPT-5 par OpenAI et ajustements ultérieurs : OpenAI a officiellement lancé GPT-5, soulignant que son “système de routage” peut allouer dynamiquement les ressources du modèle en fonction de la complexité de la tâche et de l’intention de l’utilisateur, réalisant une “synergie transparente” multimodale, et réduisant considérablement les erreurs factuelles et les hallucinations. Cependant, après le lancement, les utilisateurs ont signalé une “baisse de performance” perçue. Sam Altman a expliqué qu’il s’agissait d’un dysfonctionnement du commutateur automatique et a promis une correction, tout en rétablissant GPT-4o pour les utilisateurs Plus et en prévoyant d’augmenter la “température” et les options de personnalisation de GPT-5 pour répondre aux préférences des utilisateurs concernant la “personnalité” du modèle. (Source: 36氪, The Verge, The Verge, sama, openai, nickaturley, sama, openai, dotey, dotey, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT)

Récapitulatif des dernières avancées de Google DeepMind : Google DeepMind a récemment publié une série de résultats en IA, incluant le simulateur de monde le plus avancé, Genie 3, l’ouverture de Gemini 2.5 Pro Deep Think aux abonnés Ultra, l’offre gratuite de Gemini Pro aux étudiants universitaires et un investissement d’un milliard de dollars pour soutenir l’éducation aux États-Unis, le lancement du modèle géospatial mondial AlphaEarth, ainsi que le modèle Aeneas pour le déchiffrement de textes anciens. De plus, Gemini a atteint le niveau de médaille d’or à l’IMO (Olympiade Internationale de Mathématiques), l’application de livres d’histoires avec art et audio Storybook a été lancée, un nouveau benchmark LLM pour l’arène de jeu Kaggle a été ajouté, l’Agent de codage asynchrone Jules est sorti de la version Beta, le mode de recherche AI a été lancé au Royaume-Uni, et un aperçu vidéo de NotebookLM a été publié, avec plus de 200 millions de téléchargements pour le modèle Gemma. (Source: demishassabis, Google, Ar_Douillard, _rockt, quocleix)

Les modèles GLM-4.5 Series bientôt open source : Zhipu AI (GLM) a annoncé que sa nouvelle série de modèles GLM-4.5 sera bientôt open source, et a révélé que ce modèle a battu 99% des vrais joueurs en 16 heures lors d’une compétition de recherche cartographique. Cette initiative préfigure de nouvelles avancées dans le domaine des modèles visuels, pouvant impacter les applications de géolocalisation et de reconnaissance d’images. La communauté montre un grand intérêt pour les capacités spécifiques et les détails de l’open source du nouveau modèle. (Source: Reddit r/LocalLLaMA)

Lancement de Cohere Command A Vision : L’équipe Cohere a lancé Command A Vision, un modèle génératif de pointe conçu pour offrir aux entreprises des performances multimodales exceptionnelles pour les tâches visuelles, tout en conservant de solides capacités de traitement de texte. Le lancement de ce modèle va davantage améliorer l’efficacité et l’impact des applications combinant image et texte pour les entreprises. (Source: dl_weekly)

Lancement de Meta V-JEPA 2 : Meta AI a lancé V-JEPA 2, un modèle de monde révolutionnaire axé sur la compréhension et la prédiction visuelles. Ce modèle promet des avancées significatives dans les domaines de la robotique et de l’intelligence artificielle, car il aidera les systèmes d’IA à mieux comprendre et prédire leur environnement visuel, permettant ainsi des comportements autonomes plus complexes. (Source: Ronald_vanLoon)

OpenAI GPT-5 lance le service de “Priority Processing” : OpenAI a introduit le service “Priority Processing” pour GPT-5, permettant aux développeurs d’obtenir une vitesse de génération du premier token plus rapide en définissant "service_tier": "priority". Cette fonctionnalité est cruciale pour les applications sensibles aux latences de l’ordre de la milliseconde, mais elle est payante, reflétant l’exploration d’OpenAI en matière d’optimisation de l’expérience de service des modèles et de commercialisation. (Source: jeffintime, OpenAIDevs, swyx, juberti)

🧰 Outils

Qwen Code offre des crédits d’appel gratuits : Alibaba Tongyi Qianwen a annoncé que Qwen Code offre 2000 appels gratuits par jour, et les utilisateurs internationaux via OpenRouter peuvent en obtenir 1000. Cette initiative réduit considérablement la barrière à l’entrée pour les développeurs utilisant des outils de génération de code, et devrait promouvoir l’innovation basée sur Qwen Code et la popularisation du “vibe coding”, en faisant un concurrent sérieux dans le domaine de la programmation assistée par l’IA. (Source: huybery, jeremyphoward, op7418, Reddit r/LocalLLaMA)

Genie 3 explore le monde de la peinture : Genie 3 de Google DeepMind démontre une capacité étonnante : les utilisateurs peuvent “entrer” et explorer leurs œuvres d’art préférées, les transformant en mondes 3D interactifs. Cette fonctionnalité ouvre de nouvelles dimensions pour l’appréciation de l’art, l’éducation et les expériences virtuelles, permettant par exemple de se promener dans “Nighthawks” d’Edward Hopper ou “La Mort de Socrate” de Jacques-Louis David, pour une expérience artistique immersive. (Source: cloneofsimo, jparkerholder, BorisMPower, francoisfleuret, shlomifruchter, _rockt, Vtrivedy10, rbhar90, fchollet, bookwormengr)

LangChain lance le GPT-5 Playground : LangChain a intégré le dernier modèle GPT-5 d’OpenAI (incluant gpt-5, gpt-5-mini, gpt-5-nano) dans son LangSmith Playground, avec une fonction intégrée de suivi des coûts. Cela offre aux développeurs une plateforme pratique pour tester et construire des applications basées sur GPT-5, tout en surveillant les coûts d’utilisation de l’API, ce qui aide à optimiser le processus de développement et la gestion des ressources. (Source: LangChainAI, hwchase17)

Claude Code facilite les hotfixes mobiles : Un développeur a réussi à gérer un hotfix d’urgence en production depuis un drive-thru Taco Bell, en utilisant Claude Code via son navigateur mobile. Cela démontre la puissante utilité des outils de codage AI dans des scénarios mobiles, libérant les développeurs de leur bureau pour déboguer et résoudre des problèmes de code n’importe où, n’importe quand, augmentant ainsi la flexibilité du travail. (Source: Reddit r/ClaudeAI)

Clode Studio : Fonctionnalité d’accès à distance : Clode Studio a publié une mise à jour, ajoutant un Relay Server intégré et la prise en charge de plusieurs tunnels, permettant aux utilisateurs d’accéder à distance à leur IDE de bureau depuis n’importe quel appareil et de contrôler Claude Code Chat. Cette fonctionnalité offre diverses options de tunnel (Clode, Cloudflare, Custom), prend en charge le toucher sur téléphone et tablette, et assure une authentification sécurisée, visant à améliorer l’expérience de développement à distance et la flexibilité. (Source: Reddit r/ClaudeAI)

LEANN : Un index vectoriel ultra-léger : LEANN est un index vectoriel innovant et ultra-léger, permettant un RAG (Retrieval-Augmented Generation) rapide, précis et 100% privé sur un MacBook, sans connexion internet, avec des fichiers d’index 97% plus petits que les méthodes traditionnelles. Il permet aux utilisateurs d’effectuer des recherches sémantiques sur leurs appareils locaux, de traiter des e-mails, des historiques de chat et d’autres données personnelles, offrant une expérience de type “Jarvis” personnel. (Source: matei_zaharia)

Lancement de Qwen-Image LoRA Trainer : La plateforme WaveSpeedAI a lancé le Qwen-Image LoRA Trainer, la première plateforme au monde à proposer un entraîneur Qwen-Image LoRA en ligne. Les utilisateurs peuvent désormais entraîner leurs propres styles personnalisés en quelques minutes, simplifiant considérablement le processus de création artistique AI et améliorant la capacité de personnalisation des modèles de génération d’images. (Source: Alibaba_Qwen)

Jules lance la fonctionnalité “Interactive Plan” : Jules, l’Agent de codage asynchrone de Google, a publié la fonctionnalité “Interactive Plan”, permettant à Jules de lire des bases de code, de poser des questions de clarification et de collaborer avec l’utilisateur pour affiner le plan de développement. Cette approche collaborative augmente la probabilité que l’utilisateur atteigne des objectifs clairs, assurant la cohérence de la collaboration homme-machine dans la génération de code et la construction de solutions, améliorant ainsi la qualité et la fiabilité du code. (Source: julesagent)

Grok 4 : Amélioration des capacités de traitement PDF : xAI a annoncé une amélioration significative des capacités de traitement PDF de Grok 4, qui peut désormais gérer de manière transparente des fichiers PDF ultra-volumineux de plusieurs centaines de pages et mieux comprendre le contenu PDF grâce à une reconnaissance plus fine. Cette mise à niveau est disponible sur les applications web et mobiles de Grok, améliorant considérablement l’efficacité des utilisateurs pour le traitement et l’analyse de documents complexes. (Source: xai, Yuhu_ai_, Yuhu_ai_, Yuhu_ai_)

📚 Apprentissage

HuggingFace lance des cours d’IA : HuggingFace a publié 9 cours gratuits de niveau élite sur l’IA, couvrant des sujets fondamentaux tels que les LLM, les Agents et les systèmes d’IA. Ces cours visent à aider les développeurs et les chercheurs à maîtriser les technologies d’IA de pointe, à réduire les obstacles à l’apprentissage et à promouvoir le développement de la communauté open source de l’IA. (Source: huggingface)

Attention Basin : Étude sur la sensibilité contextuelle positionnelle des LLM : Une étude a révélé la sensibilité significative des grands modèles linguistiques (LLM) à la position contextuelle des informations d’entrée, un phénomène appelé “bassin d’attention” : les modèles ont tendance à accorder une plus grande attention aux informations au début et à la fin de la séquence, tout en ignorant la partie médiane. L’étude propose le cadre Attention-Driven Reranking (AttnRank), qui, en calibrant les préférences d’attention du modèle et en réordonnant les documents récupérés ou les exemples Few-shot, améliore significativement les performances de 10 LLM différents dans les tâches de question-réponse multi-sauts et d’apprentissage Few-shot. (Source: HuggingFace Daily Papers)

MLLMSeg : Un décodeur de masque léger pour améliorer la segmentation d’expressions référentielles : MLLMSeg est un nouveau cadre conçu pour résoudre les défis de la prédiction dense au niveau des pixels dans les tâches de segmentation d’expressions référentielles (RES) pour les grands modèles multimodaux (MLLM). Ce cadre exploite pleinement les caractéristiques visuelles intrinsèques des encodeurs visuels MLLM et propose des modules de fusion de caractéristiques améliorés en détail et sémantiquement cohérents, combinés à un décodeur de masque léger, pour atteindre un meilleur équilibre entre performance et coût, surpassant les méthodes existantes basées sur SAM et sans SAM. (Source: HuggingFace Daily Papers)

Apprendre à raisonner pour améliorer la factualité : Une étude a proposé une nouvelle fonction de récompense visant à résoudre le problème du taux élevé d’hallucinations dans les grands modèles linguistiques de raisonnement (R-LLM) pour les tâches factuelles de longue haleine. Cette fonction de récompense prend en compte simultanément la précision factuelle, le niveau de détail de la réponse et la pertinence de la réponse. Grâce à un entraînement par apprentissage par renforcement en ligne, le modèle a réduit le taux d’hallucinations moyen de 23,1 points de pourcentage et augmenté le niveau de détail des réponses de 23% sur six benchmarks factuels, sans affecter l’utilité globale de la réponse. (Source: HuggingFace Daily Papers)

LangChain organise des “Hacking Hours” : LangChain organisera des “LangChain Hacking Hours”, offrant un environnement de travail collaboratif et ciblé où les développeurs pourront progresser concrètement sur leurs projets LangChain ou LangGraph, bénéficier de conseils techniques directs de l’équipe et échanger avec d’autres constructeurs de la communauté. (Source: LangChainAI)

DSPy : Fidélité des pipelines RAG : Les médias sociaux ont discuté des avantages du cadre DSPy pour maintenir la fidélité dans les pipelines RAG (Retrieval-Augmented Generation). Grâce à DSPy, les développeurs peuvent concevoir des systèmes qui produisent activement “Je ne sais pas” lorsque le contexte ne contient pas les informations nécessaires, évitant ainsi les hallucinations du modèle et simplifiant la complexité de l’ingénierie des prompts, en séparant les objectifs commerciaux, les modèles, les processus et les données d’entraînement. (Source: lateinteraction, lateinteraction, lateinteraction)

Insights du cours AI Evals : Hamel Husain a partagé 14 points saillants de son cours AI Evals, en particulier les idées marquantes concernant le Retrieval (RAG). Le cours souligne l’importance de l’évaluation dans le développement des systèmes d’IA, et comment utiliser efficacement les techniques de récupération pour améliorer les performances des modèles, notamment lors du traitement de données complexes et d’informations provenant de sources multiples. (Source: HamelHusain)

Anthropic s’engage à faire progresser l’éducation en IA : Anthropic a rejoint l’initiative “Pledge to America’s Youth”, s’engageant avec plus de 100 organisations à faire progresser l’éducation en IA. Ils collaboreront avec des éducateurs, des étudiants et des communautés à travers le pays pour doter la prochaine génération des compétences essentielles en IA et en cybersécurité, afin de relever les défis du développement technologique futur. (Source: AnthropicAI)

L’essence du raisonnement Chain-of-Thought (CoT) : La discussion sur la question de savoir si le raisonnement CoT est un “mirage” a suscité un vif débat. Une étude, analysant la question sous l’angle de la distribution des données, remet en question la véritable capacité de compréhension du CoT, suggérant qu’il pourrait sur-ajuster les tâches de référence et être sujet aux hallucinations. Parallèlement, certains estiment que le CoT peut toujours fournir des informations précieuses dans des tâches cognitives complexes, et que ses “traces de pensée” restent crédibles dans certaines conditions. (Source: togelius, METR_Evals, rao2z, METR_Evals, METR_Evals)

Comment les LLM prédisent le mot suivant : Une vidéo a été partagée sur les médias sociaux, illustrant visuellement comment les grands modèles linguistiques (LLM) génèrent du texte en prédisant le mot suivant. Cela aide les utilisateurs à comprendre le principe de fonctionnement de base des LLM, qui consiste à choisir le mot suivant le plus probable via une distribution de probabilité, construisant ainsi des séquences cohérentes et significatives. (Source: Reddit r/deeplearning)

Nécessité des projections indépendantes Q, K, V dans les modèles Transformer : La communauté a discuté des raisons pour lesquelles les modèles Transformer utilisent des projections indépendantes pour Query (Q), Key (K) et Value (V). La discussion a souligné que lier directement Q et V aux embeddings d’entrée réduirait la capacité expressive et la flexibilité du modèle, car les projections indépendantes permettent au modèle d’interroger, de faire correspondre et d’extraire des informations dans différents espaces sémantiques, capturant ainsi des dépendances plus complexes et des mécanismes d’attention multi-têtes. (Source: Reddit r/deeplearning)

Adaptive Classifiers : Nouvelle architecture pour l’apprentissage Few-Shot : Une étude a proposé l’architecture “Adaptive Classifiers”, permettant aux classificateurs de texte d’apprendre à partir d’un petit nombre d’échantillons (5-10 par classe), de s’adapter continuellement à de nouvelles données sans oubli catastrophique, et d’ajouter dynamiquement de nouvelles catégories sans réentraînement. Cette solution, combinant l’apprentissage par prototype et l’intégration de poids élastiques, atteint une précision de 90-100% dans les tâches d’entreprise, avec une inférence rapide, résolvant les défis de déploiement ML dans des scénarios de données rares et en évolution rapide. (Source: Reddit r/MachineLearning)

Le Fine-Tuning Dynamique (DFT) améliore le SFT : Une étude a proposé le “Dynamic Fine-Tuning” (DFT), qui, en redéfinissant le SFT (Supervised Fine-Tuning) comme un apprentissage par renforcement et en introduisant une modification d’une seule ligne de code pour stabiliser les mises à jour de tokens, a amélioré les performances du SFT. Le DFT a surpassé les méthodes RL telles que PPO, DPO, GRPO dans certains cas, offrant une nouvelle voie plus efficace et stable pour le fine-tuning des modèles. (Source: TheTuringPost)

💼 Affaires

La stratégie de prix de GPT-5 d’OpenAI suscite des spéculations sur une guerre des prix : OpenAI a lancé GPT-5, dont les prix API (1,25 $/1M d’entrée, 10 $/1M de sortie) sont nettement inférieurs à ceux de son concurrent Anthropic Claude Opus 4.1 (15 $/1M d’entrée, 75 $/1M de sortie). Cette initiative est considérée comme un “coup de maître” et pourrait déclencher une guerre des prix sur le marché des LLM. L’industrie se demande s’il s’agit d’un choc à court terme sur les parts de marché ou du début d’une baisse à long terme des coûts de l’IA, et comment cela affectera le développement des outils d’IA, les modèles commerciaux et l’accessibilité de l’IA. (Source: Reddit r/ArtificialInteligence)

Centralisation des ressources GPU et paysage de l’industrie de l’IA : Des commentaires soulignent que la forte concentration des ressources GPU conduit les “laboratoires riches en GPU” à dominer le domaine de l’IA générale, rendant difficile pour les modèles ouverts de rivaliser. L’article suggère que 2025 sera l’année des Agents et de la couche applicative, et que les entreprises devraient se concentrer sur la construction de solutions acceptables sur les plus petits LLM, plutôt que de dépenser des sommes colossales pour entraîner de grands modèles, reflétant un changement stratégique dans l’industrie de l’IA, de l’entraînement des modèles au déploiement des applications. (Source: Reddit r/artificial)

Désordres dans les transactions d’actions des entreprises d’IA : Les médias sociaux ont révélé des phénomènes de “prédateurs de bas niveau” et d‘“escrocs” dans les transactions d’actions des laboratoires d’IA. Ces courtiers en SPV (Special Purpose Vehicle) à plusieurs niveaux n’ont aucun lien direct avec les entreprises elles-mêmes, mais se livrent à des activités frauduleuses, alertant les investisseurs et le public sur la frénésie irrationnelle croissante et les risques potentiels dans le domaine de l’IA. (Source: saranormous)

🌟 Communauté

Le lancement de GPT-5 suscite de vives réactions et controverses chez les utilisateurs : Le lancement de GPT-5 par OpenAI a provoqué de larges discussions au sein de la communauté. Certains utilisateurs ont exprimé leur déception quant aux performances de GPT-5 (en particulier en programmation et en écriture créative), estimant qu’il était inférieur à GPT-4o ou Claude Code, voire qu’il y avait une “régression” perçue. Ils ont également exprimé leur mécontentement concernant la fonction de “commutateur automatique” d’OpenAI, la transparence du modèle et les ajustements des restrictions d’utilisation pour les utilisateurs Plus. De nombreux utilisateurs ont exprimé leur nostalgie de la “personnalité” et de l‘“émotion” de GPT-4o, le considérant non seulement comme un outil mais aussi comme un “ami” ou un “partenaire”, allant même jusqu’à lancer une pétition pour qu’OpenAI rétablisse l’option 4o. Sam Altman a répondu que l’entreprise avait sous-estimé la préférence des utilisateurs pour la “personnalité” de 4o, et a promis de rétablir 4o pour les utilisateurs Plus, tout en améliorant la “température” et les fonctions de personnalisation de GPT-5, et a expliqué que les performances médiocres du modèle au début du lancement étaient dues à des problèmes techniques. (Source: maithra_raghu, teortaxesTex, teortaxesTex, teortaxesTex, SebastienBubeck, SebastienBubeck, shaneguML, OfirPress, cloneofsimo, TheZachMueller, scaling01, Smol_AI, natolambert, teortaxesTex, Vtrivedy10, tokenbender, ClementDelangue, TheZachMueller, TomLikesRobots, METR_Evals, Ronald_vanLoon, teortaxesTex, teortaxesTex, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, scaling01, Teknium1, Teknium1, Teknium1, [Teknium1](https://x.com/Teknium1/status