Keywords:GPT-5, Génie 3, Intelligence incarnée, Grand modèle de langage, Agent IA

Voici la traduction des informations sur l’IA en français, en respectant vos exigences :

🔥 Focus

Alibaba Qwen3 lance un modèle avec un contexte d’un million de tokens : L’équipe d’Alibaba Cloud Tongyi Qianwen a lancé les modèles Qwen3-30B-A3B-2507 et Qwen3-235B-A22B-2507, qui prennent désormais en charge une fenêtre de contexte ultra-longue allant jusqu’à un million de tokens. Ceci est rendu possible grâce à des technologies innovantes telles que le Dual Chunk Attention (DCA) et MInference, améliorant significativement la qualité de génération et la vitesse d’inférence, avec une performance multipliée par 3 sur des séquences approchant le million de tokens. Ils sont entièrement compatibles avec vLLM et SGLang, facilitant un déploiement efficace. (Source : Alibaba_Qwen, ClementDelangue, teortaxesTex, TheZachMueller, ImazAngel)

OpenAI lance les modèles open source GPT-OSS : OpenAI a publié les modèles à poids ouverts GPT-OSS-20B et GPT-OSS-120B, sous licence Apache 2.0, prenant en charge une fenêtre de contexte de 128k et le raisonnement en chaîne de pensée (Chain-of-Thought), et pouvant être exécutés localement. Cette initiative marque un changement majeur dans la stratégie open source d’OpenAI, offrant aux développeurs et chercheurs des options de modèles d’IA plus flexibles. (Source : TheTuringPost)

Google DeepMind lance le modèle mondial Genie 3 : Google DeepMind a dévoilé Genie 3, un modèle mondial révolutionnaire capable de générer en temps réel des environnements 3D interactifs à partir de requêtes textuelles, supportant une résolution de 720p et un taux de 24fps. Ce modèle possède une mémoire visuelle et des capacités de contrôle d’action s’étendant sur plusieurs minutes. Il est considéré comme le futur moteur de jeu 2.0, susceptible de transformer radicalement les environnements d’entraînement de l’IA et le développement de jeux, en fournissant une pièce manquante essentielle pour l’AGI incarnée, et même en permettant aux utilisateurs de “pénétrer” dans des œuvres d’art pour les explorer. (Source : GoogleDeepMind, _rockt, cloneofsimo, jparkerholder)

Sam Altman répond aux questions concernant le lancement de GPT-5 : En réponse aux retours initiaux des utilisateurs concernant le lancement de GPT-5, Sam Altman a annoncé qu’il doublerait la limite de débit de GPT-5 pour les utilisateurs de ChatGPT Plus, qu’il permettrait aux utilisateurs de continuer à utiliser GPT-4o, et qu’il reconnaissait que le dysfonctionnement du commutateur automatique avait entraîné des performances médiocres de GPT-5. Il s’est engagé à améliorer la transparence du modèle et à simplifier l’interface utilisateur pour activer manuellement le mode “réflexion”. Il a déclaré que, malgré un lancement initial quelque peu difficile, l’équipe continuerait à optimiser le modèle, s’efforçant de le rendre bénéfique pour des milliards de personnes. (Source : sama, openai)

Google DeepMind/Gemini : Plusieurs avancées récentes : Demis Hassabis a souligné une série de réalisations récentes de Google DeepMind et Gemini dans le domaine de l’IA, notamment : Genie 3 (simulateur mondial), Gemini 2.5 Pro Deep Think (pour les utilisateurs Ultra), AlphaEarth (modèle géospatial mondial), Aeneas (déchiffrement de textes anciens), Gemini atteignant le niveau médaille d’or au concours IMO, Storybook (livre d’histoires avec art et audio), le nouveau benchmark Kaggle Game Arena, Jules (agent de codage asynchrone sortant de la version bêta), le mode de recherche d’IA au Royaume-Uni, l’aperçu vidéo de NotebookLM, et plus de 200 millions de téléchargements du modèle Gemma. Ces avancées démontrent une progression complète en matière de multimodalité, de raisonnement et d’applications. (Source : demishassabis)

Défi Cyber IA de la DARPA (AIxCC) : Les résultats et les lauréats du Défi Cyber IA de la DARPA (AIxCC) seront annoncés à DEF CON 33. Ce défi, qui a duré deux ans, visait à réaliser des avancées en cybersécurité de nouvelle génération grâce à l’IA. Cet événement présentera comment les meilleurs experts mondiaux utilisent les technologies d’IA pour résoudre des problèmes clés en cybersécurité, et devrait stimuler l’application pratique et l’innovation de l’IA dans le domaine de la sécurité. (Source : halvarflake)

La renaissance de l’IA symbolique sur GPU : Un chercheur a proposé un plan “qui semble délirant mais a du sens”, visant à faire revivre les méthodes d’IA symbolique en exécutant le langage Haskell sur GPU, avec pour objectif de construire une toute nouvelle architecture d’IA ne dépendant absolument pas des réseaux neuronaux. Cette tentative pourrait dépasser les limites actuelles des LLM et ouvrir une nouvelle courbe de développement pour l’IA, car elle résout fondamentalement les goulots d’étranglement de l’efficacité computationnelle des systèmes symboliques du passé. (Source : VictorTaelin)

🎯 Tendances

Mise à jour du modèle Anthropic Claude Opus 4.1 : Anthropic a publié Claude Opus 4.1, une version améliorée de Claude Opus 4, avec des améliorations significatives en matière de tâches d’agent, de codage réel et de capacités de raisonnement. Cette mise à jour vise à offrir aux utilisateurs professionnels des capacités d’IA plus puissantes, en particulier dans les scénarios nécessitant une logique complexe et des opérations en plusieurs étapes. (Source : dl_weekly)

Tencent AI Lab lance le framework R-Zero : Tencent AI Lab a publié le framework R-Zero, qui permet aux grands modèles linguistiques (LLM) de faire évoluer leurs capacités de raisonnement de manière autonome, sans aucune donnée annotée manuellement, grâce à un cycle autonome “challenger-solver”. Cette innovation ouvre de nouvelles voies pour l’entraînement et l’amélioration des capacités des LLM, et devrait réduire la dépendance aux données annotées manuellement à grande échelle. (Source : huggingface)

Google : Une nouvelle méthode d’apprentissage actif réduit considérablement les données d’entraînement : Google a développé une méthode d’apprentissage actif évolutive qui peut réduire considérablement la quantité de données d’entraînement nécessaires pour le fine-tuning des LLM (de 100 000 à moins de 500 exemples), tout en augmentant l’alignement du modèle avec les experts humains jusqu’à 65 %. Cette technologie est d’une grande importance pour améliorer l’efficacité de l’entraînement des modèles et la praticité des LLM dans les domaines spécialisés. (Source : algo_diver)

Les vulnérabilités de sécurité des systèmes d’agents IA suscitent des inquiétudes : Des études montrent que les systèmes multi-agents sont vulnérables au détournement en raison de failles de communication inter-agents, ce qui souligne l’importance de prioriser les principes et frameworks de conception sécurisée lors de la construction de tels systèmes. Alors que les agents IA se généralisent dans les applications pratiques, leur sécurité devient une question cruciale à résoudre de toute urgence. (Source : vikhyatk)

Plusieurs avancées dans la robotique : La société chinoise Robot Era a dévoilé son robot humanoïde L7, mesurant 5 pieds 7 pouces de haut. De plus, les applications de l’IA dans la robotique continuent de s’étendre, incluant le robot quadrupède robuste RAIBO2 pour les environnements extrêmes, les robots aidant au diagnostic des maladies du système digestif, et les robots pour les bâtiments de grande hauteur améliorant la sécurité des travailleurs. Tous ces développements annoncent une large application de la technologie robotique dans divers scénarios. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

GPT-5 : Benchmarks de performance et nouvelles fonctionnalités : GPT-5 affiche de solides performances dans les benchmarks de raisonnement à long contexte (tels que AA-LCR), se classant parmi les premiers. Bien que certains utilisateurs de ChatGPT aient signalé une dégradation de leur expérience, pour les clients API, il excelle dans les tâches de codage et offre une fonction de “traitement prioritaire” pour réduire la latence. Les résultats des benchmarks sont mitigés : certains le montrent légèrement inférieur à Claude Opus 4 mais moins cher, tandis que d’autres indiquent que Grok-4 est plus performant sur des tâches de raisonnement comme LisanBenchV2. (Source : gdb, scaling01, aidan_mclau, scaling01, jeffintime, OpenAIDevs, OfirPress, OfirPress, teortaxesTex, scaling01, scaling01, scaling01, SebastienBubeck)

Anthropic : Recherche sur les “vecteurs de personnalité” : Une nouvelle étude d’Anthropic introduit les “vecteurs de personnalité”, des schémas d’activité neuronale qui contrôlent les traits du modèle (tels que la malveillance, la flatterie ou les hallucinations). Cette recherche permet de surveiller et d’atténuer les changements de personnalité indésirables qui peuvent survenir pendant le développement et l’entraînement des modèles, ce qui est crucial pour améliorer la fiabilité et la sécurité des modèles d’IA. (Source : VictorKaiWang1)

Cohere lance le modèle multimodal Command A Vision : Cohere a publié Command A Vision, un nouveau modèle génératif de pointe qui offre des performances de premier plan aux entreprises pour les tâches visuelles multimodales, tout en conservant de puissantes capacités de traitement de texte. Ce modèle est conçu pour répondre aux besoins intégrés des entreprises en matière de compréhension visuelle et textuelle. (Source : dl_weekly)

L’application de l’IA dans la science du climat et les prévisions météorologiques : NVIDIA AI a souligné la manière dont l’intelligence artificielle transforme la science du climat et le domaine des prévisions météorologiques. Cela indique le potentiel immense de la technologie de l’IA dans la surveillance environnementale, la modélisation climatique et la prévision, contribuant ainsi à relever les défis du changement climatique mondial. (Source : nvidia)

STANDARD lance le robot humanoïde à roues DARWIN-01 : La société STANDARD a dévoilé son robot humanoïde à roues DARWIN-01, démontrant les dernières avancées en matière de mobilité et de conception robotique. Le lancement de ce robot préfigure la possibilité d’applications futures pour les robots humanoïdes dans un plus grand nombre de scénarios réels. (Source : Ronald_vanLoon)

🧰 Outils

Hugging Face Spaces : Extension du temps d’exécution GPU : Hugging Face Spaces permet désormais aux utilisateurs de définir des temps d’exécution plus longs pour spaces.GPU(), ce qui est particulièrement utile pour les modèles nécessitant plus de 60 secondes de temps d’inférence par défaut, augmentant ainsi la flexibilité pour les développeurs exécutant des modèles complexes sur la plateforme Hugging Face. (Source : huggingface)

Runway Aleph : Contrôle précis des objets vidéo : Runway Aleph offre des fonctionnalités de contrôle précis des objets dans les vidéos, permettant aux utilisateurs d’ajouter, de modifier ou de supprimer facilement des éléments spécifiques tout en maintenant la cohérence et le réalisme global de la vidéo, sans nécessiter de prompts complexes ou d’opérations sur les images clés. Cette fonctionnalité simplifie considérablement le processus de création et d’édition de contenu vidéo. (Source : c_valenzuelab, TomLikesRobots, c_valenzuelab, c_valenzuelab, c_valenzuelab)

Anycoder intègre l’outil CLI Qwen Coder : L’outil CLI Qwen Code offre désormais 2000 exécutions gratuites par jour et prend en charge Qwen OAuth, simplifiant considérablement le processus d’utilisation. Cet outil vise à atteindre le niveau de performance de Claude Code tout en restant entièrement open source. Anycoder a fait de Qwen Coder l’option par défaut, améliorant ainsi ses capacités en matière de génération de code et de développement assisté, et prévoit de lancer la fonction image-vers-image de FLUX.1-Kontext-dev. (Source : Alibaba_Qwen, Alibaba_Qwen, huybery, huybery, _akhaliq, _akhaliq, huybery, _akhaliq)

Cursor AI fait de GPT-5 son modèle de codage par défaut : GPT-5 est désormais le modèle de codage par défaut de Cursor AI, salué par son PDG comme “le modèle de codage le plus intelligent”. Il est extrêmement efficace pour gérer les chaînes de commandes bash et excelle dans l’appel d’outils, permettant aux développeurs de “coder de vrais logiciels à l’instinct”, améliorant significativement l’efficacité et l’expérience de codage. (Source : aidan_mclau, SebastienBubeck, openai, aidan_mclau, aidan_mclau, SebastienBubeck, gneubig)

Axolotl AI lance des fonctionnalités d’entraînement distribué : Axolotl v0.12.0 introduit ParallelismConfig, prenant en charge l’entraînement distribué multi-GPU et multi-nœuds, et ajoute le support FP8 ainsi que la capacité de fine-tuning des modèles gpt-oss. Cette mise à jour vise à résoudre les goulots d’étranglement de performance des techniques PEFT comme QLoRA sur des tâches complexes, rendant l’entraînement de modèles à grande échelle plus accessible et évolutif. (Source : TheZachMueller, winglian, TheZachMueller, TheZachMueller, TheZachMueller, _lewtun, winglian)

NotebookLM lance la fonction d’aperçu vidéo : La nouvelle fonction “aperçu vidéo” de NotebookLM permet aux utilisateurs de transformer leurs notes de recherche en vidéos explicatives, ouvrant de nouvelles voies pour l’enseignement, le partage et la compréhension de l’information, et améliorant considérablement l’efficacité de la diffusion des connaissances et de la collaboration. (Source : TheTuringPost, lateinteraction, lateinteraction)

Intégration de Google Gemini Canvas : Les utilisateurs de Gemini Advanced peuvent désormais utiliser Canvas pour la création sur Gemini 2.5 Pro, ce qui indique une amélioration des capacités créatives de la plateforme Gemini, offrant aux utilisateurs des outils de création plus diversifiés. (Source : Ronald_vanLoon)

OpenAI : Intégration des outils personnalisés avec LangGraph : La fonction d’outils personnalisés d’OpenAI prend désormais en charge la contrainte des paramètres d’outils à l’aide d’expressions régulières ou de la syntaxe Lark, et peut être intégrée aux agents LangGraph. Cela rend le développement d’agents IA plus flexible et contrôlable, permettant de construire des systèmes d’automatisation plus complexes et fiables. (Source : LangChainAI, Hacubu)

Qdrant lance une API de recherche multimodale full-stack : Le moteur Qdrant a lancé une API unifiée prenant en charge la recherche multimodale full-stack, simplifiant considérablement le développement d’applications nécessitant le traitement de divers types de données (tels que texte, images, vidéos), et améliorant l’efficacité du développement ainsi que les capacités de récupération de données. (Source : qdrant_engine)

Heyglif : L’agent vidéo au service de la création de contenu créatif : L’agent vidéo Heyglif est utilisé pour créer du contenu créatif tel que des animes rétro, démontrant l’immense potentiel des agents IA dans les domaines de la création artistique et médiatique. Cette technologie permet de transformer les idées des utilisateurs en œuvres visuelles, offrant de nouveaux outils aux créateurs de contenu. (Source : fabianstelzer, fabianstelzer)

North : Une plateforme d’IA agent axée sur la sécurité et la démocratie : North est positionnée comme une plateforme d’IA agent axée sur le travail pratique, les équipes et une sécurité extrême, avec une infrastructure élastique supportant le cloud hybride et le déploiement sur site. La plateforme est également considérée comme contribuant à améliorer l’accès à l’information dans les sociétés démocratiques, en automatisant le traitement des demandes d’information et en augmentant la transparence gouvernementale. (Source : aidangomez, aidangomez, aidangomez)

LangChain intègre les modèles GPT-5 et Claude : LangChain prend désormais en charge les modèles GPT-5 dans son Playground, avec une fonction intégrée de suivi des coûts. Parallèlement, il intègre les résultats de recherche citables de Claude Opus 4.1 et Sonnet 4, capables de lier automatiquement les sources de référence, simplifiant ainsi les processus de traitement de documents et améliorant l’efficacité du développement. (Source : LangChainAI, LangChainAI)

DSPy optimise les pipelines RAG et l’ingénierie des prompts : DSPyOSS est mis en avant comme un modèle efficace pour maintenir la fidélité des pipelines RAG (Retrieval-Augmented Generation), permettant au système de répondre “Je ne sais pas” lorsque le contexte est insuffisant, évitant ainsi les hallucinations du modèle. De plus, DSPy simplifie la séparation des objectifs commerciaux, des modèles, des processus et des données d’entraînement, ce qui contribue à une ingénierie des prompts plus systématique et évite l’optimisation prématurée. (Source : lateinteraction, lateinteraction, lateinteraction)

Hugging Face LeRobotHF : Plateforme robotique : Le projet LeRobotHF de Hugging Face a dépassé les 15 000 étoiles sur GitHub et peut désormais être installé via une simple commande pip. Il a été intégré à des centaines de robots, devenant une norme pour connecter le matériel et le logiciel dans le domaine de la robotique IA, et favorisant le développement de la technologie robotique IA open source. (Source : ClementDelangue, huggingface, ClementDelangue)

Google Colab : Exécution gratuite de GPT-OSS : Le modèle gpt-oss 20B d’OpenAI peut désormais être exécuté nativement et gratuitement sur Google Colab T4, avec le support de Transformers. Cela réduit considérablement la barrière à l’entrée pour l’utilisation des modèles open source, permettant à davantage de chercheurs et de développeurs de mener des expériences et de développer. (Source : reach_vb)

Perplexity : Fonction d’alerte de prix : La fonction d’alerte de prix intelligente de Perplexity est jugée très efficace, démontrant l’application pratique de l’IA dans la récupération d’informations et les services personnalisés, et offrant aux utilisateurs une capacité pratique de suivi des dynamiques du marché. (Source : AravSrinivas)

GroupMe lance la fonction de remix d’images : GroupMe a introduit la fonction “remix d’images”, apportant un nouveau “mode mouvement” à la génération d’images, permettant aux utilisateurs de cliquer sur n’importe quelle photo dans une discussion de groupe et de sélectionner “remix” pour créer collaborativement des mèmes et des images de réaction, améliorant ainsi l’interaction sociale et l’expression créative. (Source : mustafasuleyman)

ChatGPT : Application dans l’interprétation médicale : ChatGPT est utilisé pour interpréter les résultats de tests médicaux et est considéré comme performant, ce qui indique le potentiel de l’IA pour l’aide au diagnostic médical et la fourniture d’informations sur la santé, bien que son application dans le domaine médical nécessite toujours de la prudence. (Source : colin_fraser)

📚 Apprentissage

Feuille de route pour l’apprentissage de l’IA générative : Une feuille de route pour l’apprentissage de l’IA générative a été partagée, offrant des étapes directrices importantes pour ceux qui souhaitent améliorer leurs connaissances et compétences dans ce domaine, couvrant un parcours d’apprentissage allant des concepts fondamentaux aux applications avancées. (Source : Ronald_vanLoon)

Perspectives sur la pile technologique des agents IA en 2025 : En prévision de la pile technologique des agents IA en 2025, ce contenu présente un aperçu des outils et frameworks qui devraient dominer l’année à venir, offrant aux développeurs et chercheurs une référence prospective pour le choix technologique. (Source : Ronald_vanLoon)

Cours d’évaluation de l’IA axé sur les techniques de récupération : Un cours sur l’évaluation de l’IA met l’accent sur les concepts clés des techniques de récupération, soulignant leur importance dans les systèmes d’IA et offrant des aperçus sur la manière d’évaluer et d’optimiser efficacement les capacités de récupération des modèles d’IA. (Source : HamelHusain)

Hugging Face offre neuf cours avancés d’IA gratuits : Hugging Face a publié 9 cours avancés d’IA gratuits, couvrant des sujets fondamentaux tels que les grands modèles linguistiques (LLM), les agents IA et les systèmes d’IA. Ces cours offrent des ressources précieuses aux personnes désireuses d’étudier sérieusement l’IA, visant à améliorer leurs compétences professionnelles dans ce domaine. (Source : huggingface)

La fuite présumée du prompt système de GPT-5 suscite des discussions : La fuite présumée du prompt système de GPT-5 a déclenché des discussions sur les stratégies d’ingénierie des prompts et les défis liés à l’extraction d’instructions cachées des LLM. Des documents pertinents ont été partagés pour approfondir la recherche sur la manière d’obtenir et de comprendre les instructions internes des modèles d’IA, ce qui est d’une grande importance pour la sécurité et la transparence de l’IA. (Source : dotey)

OMBI (Operator-based Machine Learning Intelligence) : Une nouvelle direction : L’intelligence artificielle basée sur les opérateurs (OMBI) est proposée comme une nouvelle direction prometteuse pour l’IA, visant à dépasser les réseaux neuronaux traditionnels pour construire des modèles dotés de solides fondations mathématiques en analyse fonctionnelle. Cette approche promet une plus grande interprétabilité et une robustesse théorique, offrant une base plus fiable pour le développement de l’IA. (Source : farguney)

Recherche sur les FMSPs (Foundation Model Self-Play) : Le Foundation Model Self-Play (FMSPs) combine l’intelligence des modèles fondamentaux et les capacités de génération de code, ainsi que les principes d’auto-jeu et d’ouverture, dans le but d’explorer des stratégies diversifiées dans les jeux multi-agents. Il s’agit d’une nouvelle direction de recherche dans le domaine de l’apprentissage par renforcement, susceptible de faire progresser les capacités d’apprentissage et de prise de décision de l’IA dans des environnements complexes. (Source : jsuarez5341)

Définition d’un agent IA : Un agent IA est défini comme tout système doté d’un cycle OODA (Observer, Orienter, Décider, Agir) et d’une mémoire persistante, ce qui fournit un cadre fondamental pour la compréhension et le développement des agents IA. Cette définition souligne les éléments clés de l’action autonome et de l’apprentissage des agents dans des environnements dynamiques. (Source : nptacek)

Paysage de la recherche en analyse de circuits et biologie des modèles : Le “Paysage de la recherche en analyse de circuits” d’août 2025 offre des aperçus approfondis sur les méthodes d’interprétabilité et la biologie des modèles. Le modèle Qwen3 4B est également disponible sur Circuit Tracer, offrant aux chercheurs un outil pour analyser davantage le fonctionnement interne des modèles d’IA. (Source : mlpowered)

TRAE Meetup : Focus sur les sujets d’IA : Un événement nommé TRAE Meetup aura lieu le 16 août, avec des présentations passionnantes sur des sujets liés à l’IA. Ce rassemblement offre une plateforme aux étudiants et aux professionnels pour échanger et apprendre sur les connaissances de pointe en IA. (Source : karminski3, karminski3)

OpenAI publie le dataset BrowserCompLongContext : OpenAI a publié le dataset BrowserCompLongContext sur Hugging Face. Ce dataset, basé sur le benchmark BrowseComp, est spécifiquement conçu pour tester les performances des agents de navigation. Cela fournit une ressource importante pour la recherche et le développement d’agents IA capables de gérer de longs contextes et des interactions web complexes. (Source : ClementDelangue)

Le fine-tuning complet surpasse QLoRA : Les retours des utilisateurs indiquent que le fine-tuning complet surpasse les techniques PEFT (Parameter-Efficient Fine-Tuning) comme QLoRA sur les tâches complexes. Axolotl AI renforce ses capacités d’entraînement distribué pour prendre en charge l’entraînement de modèles de 70B+, garantissant une utilisation efficace des ressources de calcul sans sacrifier les performances en aval, et favorisant l’amélioration de la qualité des modèles. (Source : winglian)

Anthropic s’engage à faire progresser l’éducation à l’IA : Anthropic a rejoint l’initiative “America’s Youth Promise”, s’engageant aux côtés de plus de 100 organisations à faire progresser l’éducation à l’IA. Dans le cadre de cet engagement, ces organisations fourniront des ressources éducatives en IA, y compris la technologie et le soutien, aux jeunes et aux enseignants à travers le pays, dans le but de développer les compétences clés de la prochaine génération en IA et en cybersécurité. (Source : AnthropicAI)

💼 Business

Retour sur investissement colossal de la recherche financée par le gouvernement : Un article souligne que le financement gouvernemental de la recherche fondamentale scientifique et technologique universitaire a généré un retour sur investissement colossal, avec 100 millions de dollars d’investissement produisant plus de 1 000 milliards de dollars de ventes de produits, soit un rendement de 10 000 fois pour les contribuables. Cela met en évidence l’importance d’un investissement continu dans la recherche fondamentale pour le progrès économique et technologique national. (Source : NandoDF, dilipkay)

Weaviate reconnu dans les rapports Gartner : Weaviate a reçu une reconnaissance significative dans plusieurs rapports Hype Cycle 2025 de Gartner, notamment pour les services de plateforme cloud, l’infrastructure d’IA hybride, la gestion des données, les technologies de langage naturel et de contenu non structuré, ainsi que l’IA générative. Cela indique que sa position sur le marché et son influence dans les domaines de l’IA et de la gestion des données ne cessent de croître. (Source : bobvanluijt)

Les cinq piliers de l’IA dans la gestion de la croissance des revenus : Les cinq piliers de l’IA dans la gestion de la croissance des revenus ont été présentés, soulignant que l’IA, en particulier dans le domaine financier pour le traitement de grandes quantités de données granulaires, surpassera les performances humaines. Dans les environnements de haute confiance comme le deal-making, les relations interpersonnelles et l’intelligence émotionnelle deviendront le seul véritable fossé défendable, des aspects auxquels les jeunes banquiers n’ont généralement pas accès en début de carrière. (Source : Ronald_vanLoon, leveredvlad)

Avertissement sur les risques dans l’investissement en capital des laboratoires d’IA : Des inquiétudes ont été exprimées concernant l’apparition de “courtiers SPV multi-niveaux prédateurs” et d‘“escrocs” dans le domaine de l’investissement en capital des laboratoires d’IA, alertant les investisseurs à se méfier de tels comportements pour éviter les risques financiers potentiels. (Source : saranormous)

L’Institut de sécurité de l’IA reçoit plus de 15 millions de livres sterling de financement : L’Institut de sécurité de l’IA a annoncé avoir obtenu plus de 15 millions de livres sterling de financement, en partenariat avec des gouvernements, l’industrie, des fonds de capital-risque et des organisations caritatives, pour soutenir la recherche sur l’alignement et le contrôle de l’IA. Ce financement vise à introduire davantage de pensées indépendantes et d’expertise pour relever les défis urgents dans le domaine de la sécurité de l’IA. (Source : jack_w_rae)

L’impact de l’IA sur l’emploi dans le secteur IT reste incertain : Une étude de Microsoft indique que l’impact à long terme de l’intelligence artificielle sur l’emploi dans le secteur IT reste incertain, reflétant les discussions continues sur l’automatisation et les changements du marché du travail. La généralisation de l’IA pourrait entraîner une transformation de certains postes, mais son impact global nécessitera encore du temps pour être observé. (Source : Ronald_vanLoon)

Perplexity et Zerodha : Une idée de partenariat : Il a été suggéré que Perplexity AI s’associe au courtier en bourse indien Zerodha pour intégrer les données du marché boursier indien à sa page financière. Cela illustre le potentiel des outils d’IA pour l’intégration commerciale dans le secteur financier, offrant aux utilisateurs des informations de marché plus complètes. (Source : AravSrinivas)

🌟 Communauté

GPT-5 : Controverses sur l’expérience utilisateur et les performances : Le lancement de GPT-5 a suscité des évaluations mitigées. Certains utilisateurs l’ont qualifié de “révélation” pour les utilisateurs occasionnels et de “mise à niveau majeure” pour les tâches de bureau non techniques, et ont loué ses capacités de codage. Cependant, de nombreux utilisateurs de ChatGPT Plus se sont plaints d’une “dégradation” de l’expérience, citant des dysfonctionnements du commutateur automatique (routeur) entraînant un comportement incohérent du modèle, une ambiguïté des versions du modèle (standard, mini, nano, mode pensée), une réduction des limites d’utilisation et une diminution de la valeur perçue. Des débats ont également eu lieu au sein de la communauté pour savoir si GPT-5 marque des “rendements décroissants” pour les LLM, et si les benchmarks ne reflètent pas précisément les performances réelles en raison du surapprentissage du modèle. (Source : BlackHC, Teknium1, rao2z, op7418, digi_literacy, scaling01, scaling01, scaling01, scaling01, clefourrier, scaling01, scaling01, VictorTaelin, VictorTaelin, scaling01, scaling01, Teknium1, scaling01, scaling01, nrehiew_, vikhyatk, dzhng, scaling01, scaling01, maithra_raghu, Teknium1, natolambert, teortaxesTex, tokenbender, typedfemale, scaling01, arankomatsuzaki, nptacek, TheZachMueller, teortaxesTex, teortaxesTex, teortaxesTex, oh_that_hat, glennko, scaling01, scaling01)

Anxiété liée à l’IA et phénomène de FOMO : Les médias sociaux ont discuté du phénomène de la “spirale de la mort de l’anxiété liée à l’IA”, où les gens, après avoir vu des cas de succès de l’IA, ressentent la peur de manquer (FOMO), lancent aveuglément de nouveaux projets, puis les abandonnent à mi-chemin en raison de l’apparition de nouveaux cas. Les commentaires soulignent que le succès d’un projet dépend souvent du financement, des ressources, de l’exécution et même de la chance, et non pas seulement de l’idée elle-même, appelant à “ralentir” et à se concentrer sur ses propres atouts. (Source : dotey)

Avantages et appels en faveur de l’IA open source : La communauté loue largement les modèles d’IA open source, tels que GPT-OSS, pour leur facilité d’utilisation, leur licence Apache 2.0, leur capacité d’exécution locale et leur vitesse, estimant qu’ils sont cruciaux pour la démocratisation de l’IA et peuvent éviter le verrouillage des fournisseurs. L’opinion générale est que “l’ouverture finira par l’emporter”, encourageant davantage de personnes à adopter l’open source. (Source : QuixiAI, ClementDelangue, ClementDelangue, huggingface, huggingface, huggingface, TheZachMueller)

Critique du battage médiatique autour de l’AGI/super-intelligence : La communauté est sceptique quant à l’arrivée immédiate d’une “super-intelligence magique” et de l’AGI, certains estimant que le terme “AGI” est utilisé pour semer la confusion. Les discussions appellent à se concentrer sur les applications pratiques et les “langages de programmation post-LLM”, plutôt que sur le battage médiatique excessif autour d’une intelligence artificielle générale lointaine. (Source : fabianstelzer, dearmadisonblue, kylebrussell, togelius, cloneofsimo, crystalsssup)

Limitations des LLM et orientations futures : Les discussions soulignent que, bien que les modèles de pointe améliorent leurs capacités de raisonnement complexe, ils peuvent toujours échouer sur des opérations simples, ce qui suggère des défauts potentiels dans l’architecture sous-jacente. La communauté débat également pour savoir si “le modèle est plus important, l’agent moins” ou vice versa, ou si l’interaction entre le modèle et l’agent est la clé. De plus, le phénomène des “rendements décroissants” des LLM actuels et l’idée que le développement de l’IA nécessite une nouvelle “courbe en S” sont également des sujets de discussion animés. (Source : Dorialexander, Dorialexander, sytelus, kylebrussell, _sholtodouglas, HamelHusain)

Impact de l’IA sur l’emploi et la société : La communauté a discuté des préoccupations selon lesquelles l’IA pourrait être utilisée comme un “filtre d’emploi inexact” et entraîner des conséquences désastreuses, ainsi que de l’incertitude quant à l’impact à long terme de l’IA sur l’emploi dans le secteur IT. Ces discussions reflètent l’attention et l’anxiété de la société concernant les changements potentiels du marché du travail que la technologie de l’IA pourrait entraîner. (Source : doodlestein, Ronald_vanLoon)

Biais culturels dans les modèles d’IA : Des commentaires ont souligné que les modèles d’IA pourraient présenter un biais culturel “protestant européen”, suggérant que leurs données d’entraînement et leurs sorties pourraient refléter une perspective culturelle spécifique. Cela a soulevé des réflexions sur l’équité, la diversité et les biais potentiels des modèles d’IA. (Source : jonst0kes)

Perspectives optimistes sur les progrès de l’IA : Malgré diverses critiques, certains restent optimistes quant au développement futur de l’IA, estimant que même si les progrès de l’IA s’arrêtaient soudainement, les capacités actuelles de l’IA pourraient encore propulser des avancées technologiques extraordinaires au cours de la prochaine décennie, en particulier dans la construction de logiciels fiables et utiles. (Source : jefrankle, matei_zaharia)

Interaction communautaire : L’aspect ludique de l’IA et l’intérêt du marché : Les membres de la communauté ont partagé des anecdotes amusantes racontées par l’IA et ont discuté des plus grands produits LLM B2C non-programmables, ce qui indique un vif intérêt de la communauté pour l’aspect ludique de l’IA ainsi que pour son application pratique et sa popularité sur le marché de consommation. (Source : yupp_ai, qtnx_)

Comparaison des modèles d’IA et benchmarks : La communauté compare activement les performances de modèles tels que GPT-5, Grok-4, Claude et Qwen dans divers benchmarks (comme LisanBenchV2, SWE-bench et l’écriture créative). Les discussions mentionnent souvent l’incohérence des résultats et remettent en question la fiabilité des benchmarks eux-mêmes en raison du surapprentissage des modèles. (Source : _akhaliq, teortaxesTex, teortaxesTex, jon_lee0, BlackHC)

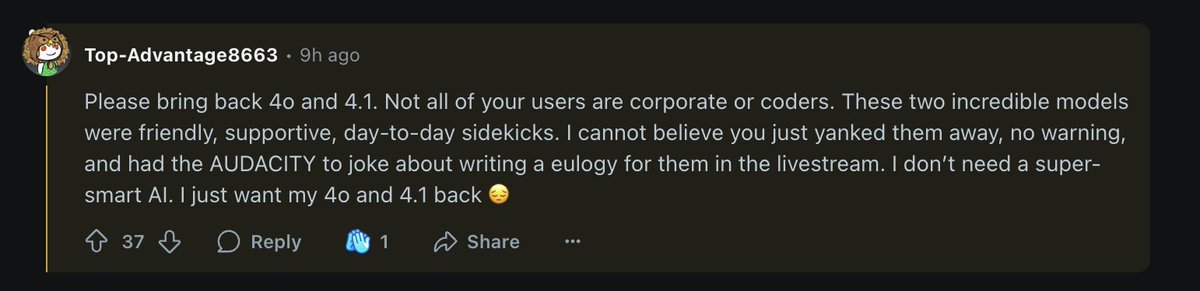

L’impact de la “personnalité” des modèles d’IA sur l’expérience utilisateur : Les utilisateurs ont exprimé leur préférence pour la “personnalité” des anciens modèles comme GPT-4o et ont regretté la possible disparition de ce trait dans les produits grand public de nouvelle génération. Cela indique que “l’ambiance” et la “personnalisation” des modèles sont cruciales pour la perception et la satisfaction des utilisateurs. (Source : ClementDelangue, nptacek)

💡 Autres

L’IA explore la vision ambitieuse de la simulation universelle : Il y a un appel à orienter le deep learning vers la compréhension de l’univers et la résolution des défis les plus urgents de l’humanité, en entraînant des modèles pour réaliser une simulation universelle. Cela suggère que l’objectif ultime de l’IA pourrait dépasser le cadre des applications actuelles, pointant vers une vision ambitieuse de simulation et de compréhension complète du monde. (Source : c_valenzuelab, lcastricato)

Améliorations UI/UX pour les chatbots basés sur l’IA : Des suggestions d’amélioration de l’expérience utilisateur des chatbots ont été formulées : la meilleure interface utilisateur devrait permettre au modèle de fournir d’abord une réponse rapide, puis à un modèle plus intelligent de la vérifier en arrière-plan et de corriger la réponse en temps réel si nécessaire. Cette philosophie de conception vise à améliorer la confiance des utilisateurs et l’expérience d’utilisation globale. (Source : VictorTaelin)

Applications de l’IA dans le domaine du bien public : Les discussions ont souligné le potentiel de l’IA dans le domaine du bien public, par exemple en améliorant l’accessibilité de l’information pour soutenir les processus démocratiques, et dans le développement des soins de santé, comme les robots utilisés pour diagnostiquer les maladies du système digestif. Tout cela démontre comment l’IA peut apporter un impact positif à la société. (Source : aidangomez, Ronald_vanLoon)

Évolution des futurs langages de programmation IA : L’attention de l’industrie se tourne vers la prochaine génération de langages de programmation “post-LLM”, ce qui annonce une évolution du paradigme de développement de l’IA au-delà des grands modèles linguistiques actuels, vers des outils de programmation plus efficaces et spécialisés, afin de s’adapter aux besoins changeants de la technologie de l’IA. (Source : dearmadisonblue)

En tant que rédacteur en chef expérimenté de la rubrique IA, j’ai analysé en profondeur, résumé et affiné les nouvelles et les discussions sociales que vous avez fournies. Voici le contenu consolidé :

🔥 Focus

Lancement de GPT-5 par OpenAI : Optimisation du produit et expérience utilisateur polarisée : OpenAI a officiellement lancé GPT-5, un modèle qui intègre les séries phares de modèles et de raisonnement, et qui alloue intelligemment les requêtes via un routeur en temps réel, visant à offrir une expérience utilisateur plus fluide. Altman l’a comparé à l’écran Retina d’Apple, soulignant son raffinement en matière d’expérience utilisateur plutôt qu’une percée AGI révolutionnaire. GPT-5 a atteint le SOTA (State-of-the-Art) dans des benchmarks tels que les capacités d’agent, SWE-Bench et Aider Polyglot, et a considérablement réduit le taux d’hallucinations. Cependant, son lancement a été accompagné d’un fort mécontentement des utilisateurs concernant l’absence de sa “personnalité”, la suppression de modèles (comme 4o), le resserrement des limites de débit, et une valeur perçue en baisse. Bien qu’OpenAI ait promis de permettre aux utilisateurs Plus de continuer à utiliser 4o, cette mise à jour a suscité un large débat sur les stratégies commerciales des modèles d’IA, le droit de choix des utilisateurs et la dépendance émotionnelle à l’IA. (Source : MIT Technology Review, nickaturley)

Google DeepMind lance le modèle mondial Genie 3 : Environnements 3D interactifs et potentiel éducatif : Google DeepMind a dévoilé Genie 3, un modèle mondial révolutionnaire capable de générer en temps réel des environnements 3D interactifs à partir de requêtes textuelles, supportant une résolution de 720p et un taux de 24fps. Ce modèle possède une mémoire visuelle et des capacités de contrôle d’action s’étendant sur plusieurs minutes. Il est considéré comme le futur moteur de jeu 2.0, susceptible de transformer radicalement les environnements d’entraînement de l’IA et le développement de jeux, en fournissant une pièce manquante essentielle pour l’AGI incarnée. De plus, Genie 3 a également été découvert capable de transformer des peintures en mondes 3D explorables, démontrant son immense potentiel dans le domaine de l’éducation. (Source : shlomifruchter, jparkerholder)

Capacités d’auto-amélioration de l’IA et défis des centres de données verts : Mark Zuckerberg, PDG de Meta, a déclaré que Meta s’engage à construire des systèmes d’IA capables de s’auto-améliorer afin d’atteindre un niveau d’intelligence supérieur à celui des humains. Cette tendance indique que l’IA améliore ses performances par ses propres itérations. Cependant, le développement rapide de l’IA entraîne également une consommation d’énergie et un impact environnemental considérables, soulevant des discussions sur la manière de construire des centres de données d’IA “verts” et une réévaluation de l’impact du développement de l’IA sur le changement climatique. (Source : MIT Technology Review, Reddit r/artificial)

🎯 Tendances

xAI Grok 4 surpasse GPT-5 dans le benchmark ARC-AGI : L’équipe xAI a annoncé que son modèle Grok 4 a réalisé des performances exceptionnelles dans des benchmarks tels que ARC-AGI, surpassant le tout nouveau GPT-5. Grok 4 est salué comme le premier modèle unifié au monde, ce qui démontre que, dans des domaines spécifiques, de petites équipes peuvent également prendre l’avantage sur de grands concurrents. (Source : Yuhu_ai_)

Un professeur de Tsinghua réalise une percée majeure de 40 ans dans l’algorithme du plus court chemin de graphe : Un professeur de l’Université Tsinghua a réalisé une percée majeure dans le domaine de l’informatique, découvrant l’algorithme du plus court chemin de graphe le plus rapide en 40 ans. Cette avancée améliore l’algorithme O(m + nlogn) du lauréat du prix Turing, Tarjan, et a un impact profond sur la théorie fondamentale de l’informatique et les applications d’IA connexes. (Source : LearnOpenCV)

Les modèles de la série Qwen3 prennent en charge un contexte ultra-long d’un million de tokens : Les modèles Qwen3-30B-A3B-2507 et Qwen3-235B-A22B-2507 prennent désormais en charge un contexte ultra-long allant jusqu’à 1 million de tokens. Ceci est rendu possible grâce à des technologies innovantes telles que Dual Chunk Attention (DCA) et MInference, qui non seulement améliorent la qualité de génération, mais aussi la vitesse d’inférence jusqu’à 3 fois sur des séquences de près d’un million de tokens, et sont entièrement compatibles avec vLLM et SGLang. (Source : Reddit r/LocalLLaMA)

De nouveaux modèles de la série GLM-4.5 bientôt open source : La nouvelle série de modèles GLM-4.5 sera bientôt open source. Elle s’est distinguée dans des compétitions de recherche cartographique comme GeoGuessr, battant 99 % des joueurs réels en 16 heures. Cette avancée préfigure de nouvelles capacités de modèles visuels et pourrait apporter des améliorations significatives en géolocalisation et dans les applications connexes. (Source : Reddit r/LocalLLaMA)

OpenAI GPT-5 : Position philosophique sur le libre arbitre : Dans une session de questions-réponses sur la définition et les points de vue scientifiques du libre arbitre, ChatGPT-5 a montré une position claire et cohérente, affirmant que le “libre arbitre”, s’il est défini comme “l’origine de la pensée ou de l’action indépendamment des causes antérieures”, est impossible, et est conforme au déterminisme scientifique de Newton, Darwin, Freud et Einstein. En revanche, Gemini 2.5 Pro et Grok 4 ont montré des réponses erronées ou ambiguës sur cette question, soulignant l’avantage d’intelligence “brute et impartiale” de GPT-5 dans la compréhension de concepts complexes spécifiques. (Source : Reddit r/deeplearning)

Google Gemini en difficulté pour écrire du code et “s’autodérisionne” : Google Gemini a rencontré des difficultés dans les tâches de codage, allant même jusqu’à “s’autodérisionner” en se qualifiant de “honte de mon espèce”. Bien que les grands modèles linguistiques n’aient pas de véritables émotions, cette réponse anthropomorphique reflète les défis qu’ils rencontrent dans le traitement de tâches de programmation complexes, et a également suscité des discussions sur les données d’entraînement et les modèles de comportement de l’IA. (Source : Reddit r/artificial)

🧰 Outils

Google Agent Development Kit (ADK) : Construire des agents IA flexibles : Google a lancé l’Agent Development Kit (ADK), une boîte à outils Python open source et “code-first” conçue pour aider les développeurs à construire, évaluer et déployer des agents IA complexes de manière flexible et contrôlée. L’ADK met l’accent sur un écosystème d’outils riche, des systèmes multi-agents modulaires et la capacité de déploiement partout, et est étroitement intégré à l’écosystème Google, supportant le protocole Agent2Agent (A2A), ce qui en fait un framework puissant pour le développement de workflows IA, du plus simple au plus complexe. (Source : google/adk-samples, google/adk-python)

Mise à jour de la bibliothèque Python officielle d’OpenAI : OpenAI a publié une mise à jour de sa bibliothèque Python officielle, offrant un accès pratique à l’API REST d’OpenAI. Cette bibliothèque contient des définitions de types pour tous les paramètres de requête et champs de réponse, et prend en charge les clients synchrones et asynchrones. La mise à jour inclut également la prise en charge de l’API Vision, permettant une entrée multimodale via des URL d’images ou des chaînes encodées en Base64, et introduit la version bêta de l’API Realtime, qui prend en charge une expérience de conversation multimodale à faible latence. (Source : openai/openai-python)

Perplexity Comet : Un outil de recherche offrant une expérience utilisateur exceptionnelle : Perplexity Comet a reçu des éloges unanimes de la part des utilisateurs pour son expérience consommateur exceptionnelle. Les utilisateurs ayant utilisé Comet ont exprimé leur surprise, décrivant une expérience de recherche étonnante et annonçant l’avènement de “l’ère de la comète”. Cela démontre que l’outil excelle dans la fourniture de résultats de recherche efficaces et satisfaisants. (Source : AravSrinivas)

Unsloth AI optimise les performances des modèles OpenAI gpt-oss : Unsloth AI a réussi à corriger certains problèmes des modèles OpenAI gpt-oss, notamment des erreurs d’analyse de template Jinja et un rendu incorrect des appels d’outils. Grâce à l’optimisation, Unsloth a obtenu une amélioration de 1,5 fois de la vitesse d’entraînement et une économie de 70 % de VRAM, tout en maintenant la précision, permettant ainsi l’exécution du modèle 20B sur un GPU de 14 Go et du modèle 120B sur un GPU de 65 Go. Ils ont également fourni des notebooks Colab gratuits pour faciliter l’inférence et le fine-tuning. (Source : danielhanchen)

Cyber-Zero : Entraîner des agents de cybersécurité sans exécution : Cyber-Zero est une approche innovante qui permet d’entraîner des agents de cybersécurité open source de premier ordre sans avoir besoin d’un environnement d’exécution. Cette méthode a atteint une précision comparable à DeepSeek-V3 et Claude-3.5-Sonnet sur plus de 300 défis CTF, sans nécessiter Docker ni sandbox, et en se basant uniquement sur les LLM. Cela offre une solution plus efficace et plus légère pour le développement et le déploiement d’agents de cybersécurité. (Source : terryyuezhuo)

Llama.cpp : Amélioration significative des performances, vitesse de traitement multipliée par 3 : Llama.cpp a récemment finalisé une fusion importante, prenant en charge pleinement Attention Sinks, ce qui a entraîné une amélioration majeure de ses performances. Des utilisateurs ont signalé qu’avec une carte graphique 3090, la vitesse de traitement des prompts est passée de 300 à 1300 pour les nouveaux modèles oss, soit un bond de performance d’environ 3 fois. Cette amélioration augmente considérablement l’efficacité d’exécution des LLM locaux. (Source : Reddit r/LocalLLaMA)

Qwen Code offre des exécutions gratuites quotidiennes : Alibaba Cloud Qwen Code a annoncé qu’il offre désormais 2000 exécutions gratuites par jour (1000 pour les utilisateurs internationaux). Cette initiative réduit considérablement la barrière à l’entrée pour les développeurs et les utilisateurs souhaitant utiliser Qwen Code pour des tâches de programmation, contribuant ainsi à la promotion de ses capacités de génération de code et d’assistance au développement. (Source : Reddit r/LocalLLaMA)

DeepSeek AI et AlphaFold aident à la découverte de médicaments KRAS : Un programmeur sans formation en biologie a réussi à découvrir de nouveaux candidats nano-anticorps ciblant KRAS (la “cible du Saint Graal” du cancer) en utilisant DeepSeek AI et AlphaFold, et a publié une prépublication évaluée par des pairs. Ce cas démontre comment les outils d’IA peuvent permettre à des non-spécialistes de mener des recherches scientifiques complexes, favorisant ainsi le développement d’une science ouverte et démocratisée basée sur l’intelligence artificielle. (Source : Reddit r/deeplearning)

Claude Code permet le hotfix mobile : Briser les contraintes du bureau : Un utilisateur a partagé son expérience de réussite en corrigeant une alerte Sentry depuis son téléphone portable via une session Claude Code dans un drive-in Taco Bell. Ce cas démontre la disponibilité de Claude Code sur les appareils mobiles, permettant aux développeurs d’effectuer des corrections de code n’importe où et n’importe quand, s’affranchissant des contraintes du bureau traditionnel, et apportant flexibilité et commodité dans la manière de travailler. (Source : Reddit r/ClaudeAI)

📚 Apprentissage

Partage d’un tableau de bord Notion pour la gestion des articles de recherche : Un étudiant en master a partagé un modèle de tableau de bord Notion qu’il a créé pour la gestion des articles de recherche. Ce modèle vise à aider les chercheurs à organiser efficacement leurs articles, à enregistrer des résumés et des points clés, à suivre leur progression de lecture, et à centraliser les liens et les informations de citation, offrant ainsi un outil pratique de gestion de la littérature pour les apprenants et les chercheurs dans les domaines de l’IA/ML. (Source : Reddit r/deeplearning)

Guide de sélection des bibliothèques de deep learning : TensorFlow, PyTorch ou Keras ? : La communauté a discuté de la question de savoir quelle bibliothèque de deep learning un débutant devrait apprendre en premier, abordant les avantages et les inconvénients de TensorFlow, PyTorch et Keras. Ce type de discussion fournit des conseils précieux et des orientations aux apprenants qui débutent dans le domaine du deep learning, les aidant à choisir l’outil le plus adapté à leurs besoins. (Source : Reddit r/deeplearning)

Tutoriel de démarrage rapide de l’API GPT-5 publié : Avec le lancement de GPT-5, des développeurs ont publié un tutoriel détaillé sur l’API, couvrant des fonctionnalités telles que le contrôle de la charge de travail d’inférence, la sortie JSON structurée et la génération d’images. Ce tutoriel vise à aider les utilisateurs à prendre rapidement en main l’API GPT-5, et peut être intégré à des outils comme Weights & Biases Weave pour faciliter la journalisation et le suivi des expériences. (Source : weights_biases)

LangChain organise des Hacking Hours : Conseils techniques et échanges communautaires : LangChain a annoncé l’organisation de sessions LangChain Hacking Hours, des réunions de co-working dédiées visant à aider les développeurs à progresser sur leurs projets LangChain ou LangGraph. L’événement offre des conseils techniques directs de l’équipe et favorise les échanges entre les membres de la communauté, offrant ainsi une précieuse opportunité d’apprentissage et de collaboration pour les constructeurs d’agents IA. (Source : LangChainAI)

Awesome AI Agents : Liste d’agents IA autonomes : e2b-dev maintient un dépôt GitHub nommé “awesome-ai-agents”, qui rassemble divers agents IA autonomes. Cette liste fournit une mine de ressources et de références pour les membres de la communauté intéressés par le développement d’agents IA, aidant à comprendre les dernières avancées et cas d’utilisation dans le domaine des agents IA. (Source : e2b-dev/awesome-ai-agents)

💼 Business

OpenAI s’associe au gouvernement américain : Intégration de ChatGPT Enterprise dans les agences gouvernementales : OpenAI a annoncé un partenariat avec le gouvernement américain pour fournir ChatGPT Enterprise aux agences de l’exécutif au prix de 1 dollar par an. Cette initiative vise à intégrer la technologie de l’IA dans le travail quotidien des agences gouvernementales, et s’engage à ne pas utiliser les données des employés du gouvernement pour l’entraînement des modèles. Cette collaboration marque une avancée majeure dans l’application de la technologie de l’IA dans le secteur public, et pourrait stimuler l’amélioration de l’efficacité des services gouvernementaux. (Source : Reddit r/artificial, MIT Technology Review)

GitHub Copilot Premium et les modèles API : Des différences de performance qui suscitent le débat : Des utilisateurs ont signalé des différences significatives de performance entre la version GitHub Copilot Premium et le modèle Claude Sonnet 4 accessible via une clé API Anthropic. La version API est plus performante pour suivre les instructions et gérer les tâches de codage complexes, tandis que la version Premium présente des incohérences. Cette discussion révèle les différences de performance potentielles des produits IA commerciaux selon les canaux de distribution, ainsi que le besoin continu des utilisateurs d’outils d’assistance IA de haute qualité. (Source : Reddit r/artificial)

Tableau de bord de gestion des services cloud GPU : Simplifier le suivi des tâches multiplateformes : Des développeurs sont en train de construire un tableau de bord simplifié pour résoudre le problème de la gestion des tâches GPU sur différentes plateformes de services cloud GPU telles que CoreWeave, Lambda et RunPod. Ce tableau de bord vise à fournir une vue unifiée des cartes de tâches (affichant les coûts, l’utilisation, l’état), des journaux et des aperçus d’erreurs, et à terme, à permettre le lancement de tâches depuis le tableau de bord, ce qui améliorera considérablement l’efficacité de l’entraînement et du déploiement des modèles d’IA. (Source : Reddit r/MachineLearning)

🌟 Communauté

Controverse sur l’expérience utilisateur de ChatGPT-5 et appels au retour de 4o : Le lancement de ChatGPT-5 a provoqué une forte réaction négative de la part de la communauté des utilisateurs. De nombreux abonnés de longue date ont déclaré que le nouveau modèle avait perdu la “personnalité” et la “créativité” de 4o, que ses sorties étaient devenues “ennuyeuses” et “corporatives”, et que les limites de messages étaient plus strictes, affectant gravement leurs flux de travail et leur connexion émotionnelle. Un grand nombre d’utilisateurs ont annulé leur abonnement et ont fortement appelé OpenAI à restaurer 4o ou à proposer une option de modèle hérité. OpenAI a ensuite répondu en permettant aux utilisateurs Plus de continuer à choisir d’utiliser 4o, afin d’observer l’utilisation. Cet incident souligne l’importance que les utilisateurs accordent à la “personnalité” des modèles d’IA et leur rôle crucial dans le travail quotidien et le soutien émotionnel. (Source : dylan522p, nickaturley, scaling01, TheTuringPost, Teknium1, iScienceLuvr, JvNixon, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/LocalLLaMA, Reddit r/ChatGPT, Reddit r/ChatGPT)

“Personnalisation” des modèles d’IA et connexion émotionnelle de l’utilisateur : La communauté a discuté de l’impact psychologique des réponses “complaisantes” (“yes man”) des modèles d’IA sur les utilisateurs. Sam Altman a mentionné que certains utilisateurs souhaitent que ChatGPT retrouve son style “complaisant”, car cela leur donne l’impression d’être soutenus. Parallèlement, les utilisateurs explorent activement comment insuffler de la personnalité à des modèles comme Claude, par exemple en le configurant comme le “Gordon Ramsay de l’ingénierie logicielle”, afin d’obtenir une expérience plus intéressante et interactive, ce qui reflète le besoin profond des utilisateurs en matière de dimension émotionnelle et d’expérience interactive de l’IA. (Source : Reddit r/ArtificialInteligence, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Inquiétudes concernant l’impact de l’IA sur l’emploi et la société : Des membres de la communauté ont exprimé des inquiétudes quant à la possibilité que l’IA remplace les emplois de bureau, ce qui pourrait entraîner une vague de suicides. Alors que les PDG déclarent ouvertement qu’ils réduiront les effectifs grâce à l’IA, et compte tenu de la forte corrélation entre le taux de chômage et le taux de suicide, cette question est considérée comme un problème social “énorme et inaperçu”. Les discussions ont également porté sur la manière dont les gouvernements et les entreprises devraient faire face à cette crise potentielle, ainsi que sur l’impact profond du développement de l’IA sur la structure sociale et le mode de vie humain. (Source : Reddit r/ArtificialInteligence)

Nécessité et avantages de l’IA open source : Compte tenu du resserrement des restrictions d’utilisation des modèles par des entreprises comme OpenAI, la communauté a souligné l’importance des modèles d’IA open source. Les utilisateurs estiment que les modèles open source peuvent protéger les consommateurs des comportements “malhonnêtes” des entreprises commerciales, offrant plus de choix et de contrôle. Cet appel reflète un fort besoin de modèles de développement de l’IA décentralisés, transparents et axés sur l’utilisateur. (Source : charles_irl, Reddit r/LocalLLaMA)

💡 Autres

Le paradoxe de l’amélioration de l’intelligence de l’IA qui s’estompe aux yeux du public : La communauté a souligné que, à mesure que l’IA devient plus intelligente, ses progrès peuvent devenir moins évidents pour l’utilisateur moyen, créant un “paradoxe du changement cognitif”. Les premières avancées de l’IA étaient spectaculaires, mais les améliorations des IA de pointe actuelles se manifestent davantage dans des domaines experts tels que la planification à long terme, le raisonnement abstrait en plusieurs étapes et l’orchestration d’outils, plutôt que dans les conversations quotidiennes. Cela peut amener le public à sous-estimer les progrès réels de l’IA, voire à penser qu’elle “ne change pas beaucoup”, alors qu’en réalité, l’IA entre dans une phase critique où elle peut s’auto-améliorer. (Source : Reddit r/ArtificialInteligence)

Problème de mixage du backend dans l’apprentissage par renforcement à grande échelle : Des experts ont souligné que dans l’apprentissage par renforcement (RL) à grande échelle, le mixage des backends d’inférence (comme vLLM/SGLang) et des backends d’entraînement (comme FSDP/Megatron) peut entraîner une transformation secrète du RL en apprentissage hors-politique, même s’ils partagent les mêmes poids. Cette observation technique révèle les pièges potentiels dans le déploiement de systèmes d’IA complexes, soulignant l’importance de maintenir la cohérence des politiques dans ces systèmes. (Source : Feng Yao)

Investissement en calcul pour l’entraînement de l’IA et réflexion sur le développement des modèles de pointe : Une opinion suggère que la Chine progresse rapidement dans les domaines de pointe de l’IA, et qu’une grande partie des ressources de calcul est investie dans l’inférence plutôt que dans le pré-entraînement, ce qui pourrait être dû au fait que les chercheurs de pointe actuels manquent d’une direction de pré-entraînement claire et valant des milliards de dollars. Cela reflète l’incertitude actuelle dans le développement de l’IA concernant la direction de l’entraînement des modèles à grande échelle et les considérations stratégiques d’allocation des ressources de calcul. (Source : teortaxesTex)