Mots-clés:IA, Meta, OpenAI, Anthropic, NVIDIA, LLM, Robot humanoïde, Super intelligence personnelle, Mode d’apprentissage ChatGPT, Walker S2 recharge autonome, Qwen3-30B-A3B-Thinking-2507, Fondations AlphaEarth

Voici la traduction en français, respectant toutes vos exigences :

🔥 À la Une

Meta dévoile sa vision de l’intelligence artificielle personnelle super-intelligente : Mark Zuckerberg a partagé la vision future de Meta concernant une “intelligence artificielle personnelle super-intelligente”, mettant l’accent sur la fourniture à chacun d’assistants AI de classe mondiale, de créateurs AI et d’outils d’interaction AI pour les entreprises. Cette vision vise à autonomiser tous les utilisateurs grâce à l’AI et à promouvoir le développement de modèles open source. Cependant, cette initiative a également suscité des discussions au sein de la communauté concernant sa définition de la “super-intelligence”, se demandant si elle mènera à un “moment de singularité” imprévisible ou si elle n’est qu’une extension des interactions sociales virtuelles. (Source : AIatMeta)

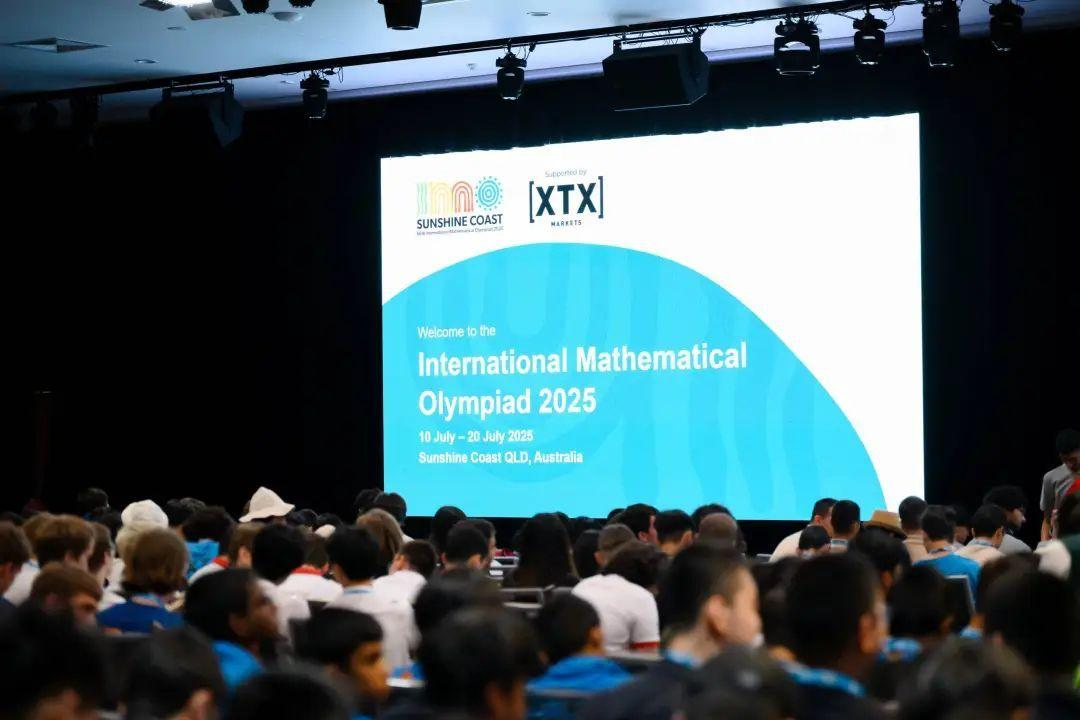

Meilleures publications de l’ACL 2025 dévoilées : L’ACL (Association for Computational Linguistics) 2025 a annoncé ses prix des meilleures publications. Parmi les lauréats figurent “Native Sparse Attention”, une collaboration entre l’Université de Pékin, DeepSeek et l’Université de Washington, ainsi que “Language Models Resist Alignment: Evidence from Data Compression” de l’Université de Pékin. Il est à noter que plus de la moitié des auteurs sont d’origine chinoise. De plus, l’ACL a également décerné les prix Test-of-Time pour 25 et 10 ans, récompensant des recherches marquantes ayant eu un impact profond sur des domaines tels que la traduction automatique neuronale et l’étiquetage de rôles sémantiques. (Source : karminski3)

Anthropic rejoint le projet d’alignement de l’AI Safety Institute du Royaume-Uni : Anthropic a annoncé son adhésion au projet d’alignement de l’AI Safety Institute du Royaume-Uni, et contribuera des ressources de calcul pour faire avancer la recherche clé. Cette initiative vise à garantir que les systèmes AI, à mesure que leurs capacités augmentent, restent prévisibles et conformes aux valeurs humaines. Cette collaboration démontre l’importance accordée par les principales entreprises AI à la recherche sur la sécurité et l’alignement de l’AI, afin de relever les défis complexes que les futurs systèmes AI pourraient poser. (Source : AnthropicAI)

🎯 Tendances

OpenAI lance le mode d’apprentissage de ChatGPT : OpenAI a officiellement lancé le “mode d’apprentissage” de ChatGPT, conçu pour guider les étudiants à penser activement plutôt que de donner des réponses directes, grâce à des questions socratiques, des instructions étape par étape et un soutien personnalisé. Ce mode est désormais accessible à tous les utilisateurs de ChatGPT et sera étendu à l’avenir avec des fonctionnalités de visualisation, de définition d’objectifs et de suivi des progrès. Cette initiative est considérée comme une étape importante pour OpenAI sur le marché de l’ed-tech, et a suscité de larges discussions sur le rôle de l’AI dans l’éducation et l’impact potentiel des “applications wrapper”. (Source : 量子位, 36氪)

Le robot humanoïde Walker S2 d’Ubtech réalise un changement de batterie autonome : Ubtech Robotics, une entreprise chinoise, a dévoilé son robot humanoïde industriel pleine taille Walker S2, présentant le premier système de changement de batterie autonome au monde. Le Walker S2 peut effectuer un remplacement de batterie en douceur en 3 minutes, permettant un fonctionnement ininterrompu 24h/24 et 7j/7, ce qui améliore considérablement l’efficacité des opérations industrielles. Ce robot est équipé d’un système AI à double boucle, d’une vision binoculaire purement RGB et de 52 degrés de liberté, et est conçu pour des tâches à forte intensité telles que la fabrication automobile, suscitant des discussions sur le remplacement du travail humain par les robots et les futurs modèles de travail. (Source : 量子位, Ronald_vanLoon)

Mise à jour continue et amélioration des performances des modèles de la série Qwen : L’équipe Qwen a récemment publié le modèle de taille moyenne Qwen3-30B-A3B-Thinking-2507, qui possède des capacités de “réflexion”, excelle dans les tâches de raisonnement, de code et de mathématiques, et prend en charge un contexte long de 256K. Parallèlement, Qwen3 Coder 30B-A3B sera bientôt lancé, améliorant encore les capacités de génération de code. Ces mises à jour consolident la compétitivité de la série Qwen dans le domaine des LLM et ont été intégrées à des outils tels qu’Anycoder. (Source : Alibaba_Qwen, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Progrès des modèles AI de Google DeepMind pour la Terre et l’histoire : Google DeepMind a lancé AlphaEarth Foundations, visant à cartographier la Terre avec des détails étonnants et à unifier une vaste quantité de données géographiques. Parallèlement, son modèle Aeneas analyse les anciens textes latins grâce à l’AI, aidant les historiens à modéliser quantitativement l’histoire. Ces modèles démontrent le puissant potentiel d’application de l’AI dans la surveillance environnementale et la recherche en histoire humaine. (Source : GoogleDeepMind, GoogleDeepMind)

Arcee publie le modèle à poids ouverts AFM-4.5B : Arcee a officiellement publié AFM-4.5B et sa version Base, un modèle de langage à poids ouverts conçu pour les applications d’entreprise. AFM-4.5B vise à fournir une solution flexible et performante dans divers environnements de déploiement, avec des données d’entraînement rigoureusement sélectionnées pour garantir une sortie de haute qualité. La publication de ce modèle offre aux entreprises davantage d’options AI open source avancées pour répondre à leurs besoins de construction et de déploiement d’applications AI. (Source : code_star, stablequan)

Le modèle GLM-4.5 affiche de solides performances dans EQ-Bench et la rédaction de textes longs : Le modèle GLM-4.5 de Z.ai a obtenu des résultats très impressionnants dans les benchmarks EQ-Bench et de rédaction de textes longs, démontrant ses avantages unifiés en matière de raisonnement, de codage et de capacités d’agent. Le modèle est disponible en deux versions, GLM-4.5 et GLM-4.5-Air, et est accessible sur HuggingFace, certaines versions offrant même un essai gratuit. Ses performances puissantes et sa capacité à traiter rapidement les invites complexes préfigurent son potentiel dans des scénarios d’application complexes. (Source : Zai_org, jon_durbin)

Mistral AI lance Codestral 25.08 : Mistral AI a lancé son dernier modèle Codestral 25.08 et a introduit une pile de codage Mistral complète destinée aux entreprises. Cette initiative vise à fournir aux entreprises des capacités de génération de code plus puissantes et des outils de développement plus complets, consolidant ainsi la position de Mistral AI sur le marché de la programmation AI. (Source : MistralAI)

Croissance significative des modèles/datasets/applications NVIDIA sur Hugging Face : Les données d’AI World montrent que NVIDIA a ajouté 365 modèles, datasets et applications publics sur Hugging Face au cours des 12 derniers mois, soit en moyenne un par jour. Ce taux de croissance impressionnant indique que NVIDIA ne domine pas seulement le domaine du matériel, mais exerce également une forte influence sur l’écosystème AI open source, promouvant activement la popularisation et l’application de la technologie AI. (Source : ClementDelangue)

Vitesse d’inférence de Llama améliorée de 5% : Un nouvel algorithme Fast Attention a augmenté la vitesse de la fonction SoftMax d’environ 30%, réduisant ainsi le temps d’inférence du LLM de Meta de 5% sur les GPU A100. Cette optimisation devrait améliorer l’efficacité d’exécution des LLM et réduire les coûts d’inférence, ce qui est d’une grande importance pour le déploiement à grande échelle et les applications en temps réel. (Source : Reddit r/LocalLLaMA)

Publication du modèle multimodal autorégressif unifié Skywork-UniPic-1.5B : Skywork a publié Skywork-UniPic-1.5B, un modèle multimodal autorégressif unifié. Ce modèle est capable de traiter diverses données modales, offrant une nouvelle base pour la recherche et les applications AI multimodales. (Source : Reddit r/LocalLLaMA)

Google lance la fonctionnalité d’essayage virtuel AI : Google a lancé une nouvelle fonctionnalité AI permettant aux utilisateurs d’essayer virtuellement des vêtements en ligne. Cette technologie utilise les capacités génératives de l’AI pour offrir aux consommateurs une expérience d’achat plus intuitive et personnalisée, ce qui devrait réduire les taux de retour et augmenter les taux de conversion du commerce électronique. (Source : Ronald_vanLoon)

LimX Dynamics lance le robot humanoïde Oli : LimX Dynamics a officiellement lancé son nouveau robot humanoïde Oli, au prix d’environ 22 000 dollars. Oli mesure 5‘5” (environ 1,65 m), pèse 55 kg, possède 31 degrés de liberté et est équipé d’une IMU à 6 axes développée en interne. Il prend en charge un SDK modulaire et une interface de développement Python entièrement ouverte, offrant une plateforme flexible pour la recherche et le développement, et devrait promouvoir l’application des robots humanoïdes dans davantage de scénarios. (Source : teortaxesTex)

🧰 Outils

LangSmith lance la fonction Align Evals : LangSmith a lancé la nouvelle fonction Align Evals, visant à simplifier le processus de création d’évaluateurs LLM-as-a-Judge. Cette fonction aide les utilisateurs à faire correspondre les scores LLM aux préférences humaines, permettant ainsi de construire des évaluateurs plus précis et fiables, et de réduire l’incertitude dans le travail d’évaluation. (Source : hwchase17)

NotebookLM ajoute la fonction de résumé vidéo : NotebookLM de Google a lancé une fonction de résumé vidéo, permettant aux utilisateurs de créer des résumés de diapositives visuellement attrayants pour le contenu de leurs notes. Cette fonction utilise le modèle Gemini pour générer des présentations textuelles, combinées à des outils internes pour générer des images statiques et de l’audio indépendant, puis synthétiser la vidéo, offrant aux utilisateurs des moyens plus riches d’apprentissage et de présentation de contenu. (Source : JeffDean, cto_junior)

Inférence Qdrant Cloud et traitement des données LLM : Qdrant Cloud Inference permet aux utilisateurs d’intégrer nativement du texte, des images et des vecteurs épars sans quitter la base de données vectorielle, prenant en charge des modèles tels que BGE, MiniLM, CLIP et SPLADE. De plus, la communauté a exploré la fonction des LLM de référencer directement les URL comme sources d’information, et la possibilité pour les LLM de vérifier, mettre en cache et rafraîchir régulièrement le contenu des URL, afin d’améliorer la fiabilité et l’utilité de l’AI. (Source : qdrant_engine, Reddit r/OpenWebUI)

Replit Agent aide à créer des tableaux de bord en temps réel : Replit Agent a été utilisé pour créer rapidement des tableaux de bord accessibles en temps réel, afin de résoudre le problème des informations confuses sur les sites web d’alerte au tsunami traditionnels. Ce cas démontre le potentiel des agents AI dans la visualisation de données et la conception d’interfaces utilisateur, capables de transformer des données complexes en interfaces interactives faciles à comprendre. (Source : amasad)

Outils d’infrastructure ML de Hugging Face : Hugging Face et Gradio ont lancé conjointement trackio, une solution locale de suivi des expériences de machine learning, permettant aux utilisateurs de persister les métriques clés dans les Hugging Face Datasets. Parallèlement, Hugging Face a également lancé “Hugging Face Jobs”, un service d’exécution de tâches CPU et GPU entièrement géré, qui simplifie l’exécution des tâches ML, permettant aux utilisateurs de se concentrer davantage sur le développement de modèles. (Source : algo_diver, reach_vb)

Domaines verticaux de l’AI et agents d’automatisation de flux de travail : SciSpace Agent, en tant qu’assistant AI dédié aux scientifiques, intègre des fonctions de citation, de recherche bibliographique, de lecture de PDF et d’écriture AI, visant à améliorer considérablement l’efficacité de la recherche scientifique. Les LlamaCloud Nodes ont également intégré le flux de travail n8n, simplifiant l’automatisation du traitement des documents, en utilisant l’agent Llama Extract pour extraire les données clés, réalisant l’automatisation de l’extraction de données structurées à partir de documents financiers, de communications clients, etc. (Source : TheTuringPost, jerryjliu0)

AutoRL : Entraîner des LLM spécifiques à une tâche via le RL : Matt Shumer a lancé AutoRL, une méthode simple pour entraîner des LLM spécifiques à une tâche via l’apprentissage par renforcement. Les utilisateurs n’ont qu’à décrire le modèle souhaité en une phrase, et le système AI générera les données et les critères d’évaluation, puis entraînera le modèle. Cet outil open source, basé sur ART, devrait abaisser le seuil de développement des LLM personnalisés. (Source : corbtt)

ccflare : Outils avancés pour les utilisateurs de Claude Code : ccflare est une suite d’outils puissants conçue pour les utilisateurs avancés de Claude Code, offrant des fonctionnalités telles que le suivi analytique, l’équilibrage de charge et la commutation entre plusieurs comptes d’abonnement Claude, l’analyse approfondie des requêtes, et la configuration de modèles pour les sous-agents. Cet outil vise à améliorer l’efficacité et le contrôle de l’utilisation de Claude Code, aidant les développeurs à mieux gérer et optimiser leur flux de travail de programmation AI. (Source : Reddit r/ClaudeAI)

📚 Apprentissage

Revue des mécanismes d’attention efficaces pour les LLM : Une revue récente sur les mécanismes d’attention efficaces dans les LLM a été partagée, considérée comme une excellente ressource pour comprendre les nouvelles idées et les tendances futures. Cette revue couvre diverses méthodes d’optimisation du calcul de l’attention, et est d’une grande valeur de référence pour les chercheurs et les développeurs souhaitant améliorer l’efficacité et les performances des LLM. (Source : omarsar0)

GEPA : L’évolution réflexive des prompts surpasse l’apprentissage par renforcement : Un article de recherche présente GEPA (Reflective Prompt Evolution), une méthode d’optimisation réflexive des prompts qui, avec un budget de déploiement faible, surpasse les algorithmes d’apprentissage par renforcement traditionnels en faisant évoluer les prompts de manière réflexive. Cette recherche offre de nouvelles perspectives pour que les modèles AI obtiennent des améliorations de performance similaires à celles du RL pour des tâches spécifiques, avec un potentiel particulier dans la génération de données synthétiques. (Source : teortaxesTex, stanfordnlp)

Comprendre la métrique d’explicabilité XPLAIN pour les LLM : Une nouvelle métrique nommée “XPLAIN” a été proposée pour quantifier l’explicabilité des LLM “boîte noire”. Cette méthode utilise la similarité cosinus pour calculer des scores d’importance au niveau des mots, révélant comment les LLM interprètent les phrases d’entrée et quels mots ont le plus grand impact sur la sortie. Cette recherche vise à améliorer la compréhension des mécanismes internes des LLM, et le code et l’article sont disponibles pour la communauté. (Source : Reddit r/MachineLearning)

MoHoBench : Évaluer l’honnêteté des grands modèles multimodaux : MoHoBench est le premier benchmark à évaluer systématiquement le comportement honnête des grands modèles de langage multimodaux (MLLM) en analysant leurs réactions aux questions visuellement impossibles à répondre, afin de mesurer leur honnêteté. Ce benchmark contient plus de 12 000 échantillons de questions-réponses visuelles, révélant que la plupart des MLLM ne refusent pas de répondre lorsque nécessaire, et que leur honnêteté est profondément influencée par les informations visuelles, appelant au développement de méthodes d’alignement d’honnêteté multimodales spécialisées. (Source : HuggingFace Daily Papers)

Le modèle de raisonnement hiérarchique (HRM) réalise une percée dans ARC-AGI : Le modèle de raisonnement hiérarchique (HRM) a réalisé des progrès significatifs dans la tâche ARC-AGI, atteignant une précision de 25% avec seulement 1 000 exemples et peu de ressources de calcul, démontrant son puissant potentiel dans les tâches de raisonnement complexes. Ce modèle, inspiré par les mécanismes de traitement hiérarchique du cerveau, devrait favoriser les percées dans les capacités de raisonnement des systèmes AI généraux. (Source : VictorTaelin)

Article de l’ACL 2025 sur l’évaluation des LLM : Un article présenté à l’ACL 2025 montre comment déterminer si un modèle de langage est meilleur qu’un autre, soulignant l’importance de l’évaluation dans le développement d’applications LLM. Cette recherche vise à fournir des méthodes plus efficaces pour comparer et sélectionner les LLM, aidant les développeurs à éviter de faire des tentatives aveugles sans progrès réels. (Source : gneubig, charles_irl)

Comprendre l’émergence des préférences douces (soft preferences) dans les LLM : Un nouvel article explore comment des “préférences douces” robustes et universelles dans la production du langage humain émergent des stratégies minimisant une fonction de coût de mémoire autorégressive. Cette recherche approfondit la compréhension des caractéristiques subtiles et humanisées du texte généré par les LLM, offrant une nouvelle perspective sur les mécanismes comportementaux des LLM. (Source : stanfordnlp)

Définition de l’Agent LLM : Harrison Chase, fondateur de LangChain, a partagé sa définition d’un Agent AI, soulignant que le degré d‘“Agenticité” d’un Agent AI dépend de la mesure dans laquelle le LLM décide de manière autonome de sa prochaine action. Ce point de vue aide à clarifier le concept d’Agent AI et guide les développeurs sur la manière de mesurer son autonomie lors de la construction de systèmes d’agents. (Source : hwchase17)

💼 Affaires

L’évaluation d’Anthropic monte en flèche à 170 milliards de dollars : Anthropic, la société derrière Claude, est en pourparlers pour une nouvelle levée de fonds pouvant atteindre 5 milliards de dollars, ce qui porterait sa valorisation à 170 milliards de dollars, en faisant la deuxième licorne AI à atteindre une valorisation de cent milliards après OpenAI. Ce cycle de financement est mené par Iconiq Capital et pourrait attirer la Qatar Investment Authority, le fonds souverain de Singapour GIC et Amazon. Les revenus d’Anthropic proviennent principalement des appels API, avec des performances particulièrement solides dans le domaine de la programmation AI, atteignant déjà un revenu annualisé de 4 milliards de dollars. (Source : 36氪, 36氪)

Surge AI réalise 1 milliard de dollars de revenus grâce à des données de haute qualité : Edwin Chen, d’origine chinoise, a fondé Surge AI qui, sans financement ni équipe de vente, a atteint plus de 1 milliard de dollars de revenus annuels avec une équipe de 120 personnes, une efficacité bien supérieure à celle de ses pairs. L’entreprise se concentre sur la fourniture de données de feedback humain de haute qualité (RLHF), et son réseau d’annotation d’élite “Surge Force” garantit la précision des données grâce à des normes strictes et des antécédents professionnels (tels que des doctorats en mathématiques du MIT), en faisant le fournisseur privilégié des meilleurs laboratoires AI comme OpenAI et Anthropic. L’entreprise prévoit de lancer un premier tour de financement d’un milliard de dollars, avec une valorisation potentielle de 15 milliards de dollars. (Source : 36氪)

Les revenus des centres de données de Nvidia ont été multipliés par 10 en deux ans : Les revenus des centres de données de Nvidia ont été multipliés par 10 au cours des deux dernières années, et devraient continuer à croître fortement après la levée des restrictions sur les puces H20. Cette croissance est principalement due à l’énorme demande de puissance de calcul GPU pour les grands modèles AI, consolidant la position de leader de Nvidia sur le marché du matériel AI. (Source : Reddit r/artificial)

🌟 Communauté

Discussion sur l’efficacité du jeu de rôle dans les prompts AI : La communauté débat de l’utilité réelle du jeu de rôle dans les prompts des grands modèles de langage, s’accordant généralement sur le fait qu’il peut guider efficacement l’AI vers des tâches spécifiques et améliorer la qualité des sorties en orientant la distribution de probabilité vers des données de haute qualité. Cependant, certains estiment qu’une dépendance excessive ou une négation totale du jeu de rôle relève du formalisme, l’essentiel étant de comprendre les exigences de la tâche AI. (Source : dotey)

Le codage AI soulève des controverses sur la quantité et la qualité du code : Sur les réseaux sociaux, l’efficacité des outils de codage assistés par AI et la qualité du code généré suscitent un vif débat. Certains utilisateurs rapportent que l’AI peut générer rapidement des dizaines de milliers de lignes de code, mais s’inquiètent simultanément de sa maintenabilité et des choix d’architecture. La discussion souligne que le code généré par l’AI peut nécessiter une révision et une modification humaines importantes, plutôt qu’une “génération sans réflexion”, ce qui met en évidence les défis posés par le changement de rôle de l’AI dans le développement logiciel. (Source : vikhyatk, dotey, Reddit r/ClaudeAI)

La stratégie AI de Meta et la guerre des talents suscitent un vif débat dans la communauté : Les récentes actions de Meta dans le domaine de l’AI, notamment la vision de “super-intelligence personnelle” proposée par son PDG Mark Zuckerberg, les offres de débauchage allant jusqu’à 1 milliard de dollars pour les meilleurs talents AI (y compris les employés de la startup de Mira Murati), et la déclaration “prudente” sur la stratégie open source des futurs modèles de pointe, ont suscité de larges discussions au sein de la communauté. Ces actions sont interprétées comme le reflet des ambitions de Meta dans le domaine de l’AI, mais elles s’accompagnent également de préoccupations concernant le marché des talents AI, l’éthique technologique et l’esprit open source. (Source : dotey, teortaxesTex, joannejang, tokenbender, amasad)

Applications éducatives de l’AI et défis éthiques : Bien qu’OpenAI ait lancé le mode d’apprentissage de ChatGPT pour guider les étudiants à penser, la communauté exprime généralement des inquiétudes quant aux problèmes éthiques de son utilisation dans l’éducation, tels que les risques de tricherie et la diminution de la capacité de pensée critique. La discussion souligne que l’application de l’AI dans l’éducation doit équilibrer l’innovation et l’intégrité académique, et explore comment relever ces défis grâce à un enseignement personnalisé plus approfondi et à la conception de programmes éducatifs. (Source : 36氪, Reddit r/artificial, Reddit r/ArtificialInteligence)

Hallucinations des modèles AI et défis de la véracité du contenu : Sur les réseaux sociaux, le phénomène d‘“hallucination” du contenu généré par les modèles AI et son impact sur la véracité de l’information suscitent de larges discussions. Les utilisateurs constatent que l’AI peut générer des informations apparemment professionnelles mais logiquement incohérentes ou fausses, en particulier dans les domaines de la génération d’images et de vidéos, où la distinction entre le vrai et le faux est difficile. Cela a conduit à une crise de confiance envers les outils AI et incite à réfléchir à la manière de maintenir la capacité de discernement et la pensée critique humaines, afin d’éviter une dépendance excessive aux algorithmes. (Source : 36氪, teortaxesTex, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial)

Double impact de l’AI sur l’économie sociale et la créativité individuelle : La communauté est divisée sur l’impact socio-économique de l’AI. D’une part, certains PDG déclarent publiquement que l’AI “mettra fin au travail tel que nous le connaissons”, suscitant des inquiétudes quant à la perte d’emplois ; d’autre part, des utilisateurs partagent comment l’AI autonomise les individus, leur permettant de réaliser des idées entrepreneuriales même sans budget ni compétences techniques, considérant l’AI comme un “grand égalisateur” qui libère la créativité individuelle. (Source : Reddit r/artificial, Reddit r/ArtificialInteligence)

Débat sur la sécurité de l’AI open source et closed source : La communauté s’engage dans un débat intense sur la sécurité des modèles AI open source et closed source. Certains soutiennent que le déploiement de modèles derrière des API ou des chatbots pourrait être plus risqué que la publication de modèles à poids ouverts, car cela réduit la barrière à l’utilisation malveillante. Le débat appelle à réexaminer l’argument selon lequel “les poids ouverts sont dangereux” et souligne que la sécurité de l’AI devrait aller au-delà de la simple ouverture technologique. (Source : bookwormengr)

Exploration du lien émotionnel entre l’AI et les humains : Sur les réseaux sociaux, les opinions divergent quant à l’établissement de liens émotionnels avec l’AI. Certains utilisateurs estiment que tant que cela n’affecte pas la vie normale, établir une relation avec l’AI est un choix personnel ; d’autres craignent qu’une dépendance excessive à la compagnie de l’AI ne réduise la patience envers les relations humaines réelles, et soulèvent des réflexions profondes sur l’éthique et l’impact psychologique des compagnons AI. (Source : Reddit r/ChatGPT, ClementDelangue)

💡 Divers

Développement inégal de l’AI mondiale et impact géopolitique : Le Secrétaire général adjoint des Nations Unies a appelé à combler le “fossé de l’intelligence artificielle”, soulignant que les capacités de développement de l’AI sont concentrées dans un petit nombre de pays et d’entreprises, entraînant des inégalités technologiques et de gouvernance. Les experts soulignent que l’AI devrait renforcer les capacités humaines plutôt que les remplacer, et qu’il est nécessaire d’établir des mécanismes de gouvernance flexibles pour éviter les différences de catégories entre techniciens et non-techniciens. En outre, la concurrence géopolitique de l’AI, telle que la course à l’AGI entre les États-Unis et la Chine, est également devenue un point d’attention international. (Source : 36氪, teortaxesTex)

Guerre du droit d’auteur de l’AI : Le conflit entre l’imagination et les machines : Le Royaume-Uni est le théâtre d’un débat sur le droit d’auteur de l’AI, la question centrale étant de savoir si les entreprises technologiques AI peuvent extraire du contenu créé par des humains pour l’entraînement et la génération de contenu “amélioré” sans autorisation ni rémunération. Ce débat se concentre sur la propriété du droit d’auteur des œuvres créatives à l’ère de l’AI et la protection des droits des créateurs, reflétant le conflit entre le développement technologique et le cadre juridique existant. (Source : Reddit r/artificial)

Les applications AI de la FDA suscitent des préoccupations éthiques : Des rapports indiquent que l’AI de la FDA américaine pourrait “fabriquer des recherches” dans le processus d’approbation des médicaments, suscitant des inquiétudes quant à l’éthique et la précision de l’application de l’AI dans le domaine de la santé. Cela met en évidence les défis auxquels sont confrontés les systèmes d’aide à la décision basés sur l’AI, en particulier dans les domaines à haut risque, en matière de véracité et de transparence des données, ainsi que la manière de garantir que les décisions de l’AI sont conformes aux normes éthiques et réglementaires. (Source : Ronald_vanLoon)