Mots-clés:Mémoire IA, Modèle open source, Agent IA, Multimodal, Réseau neuronal, Génération vidéo IA, IA médicale, Conduite autonome, Système de mémoire multimodale MIRIX, Modèle d’inférence Llama Nemotron Super v1.5, Architecture MoE Qwen3-30B-A3B-Instruct-2507, Agent scientifique universel SciMaster, Puce Tesla FSD HW5.0

Voici la traduction en français, en respectant les exigences spécifiées :

🔥 À la une

Première mondiale : la “mémoire AI” open source est déployée, MIRIX lance simultanément son APP : Des chercheurs de l’Université de Californie à San Diego et de l’Université de New York ont conjointement lancé et rendu open source MIRIX, le premier système de mémoire AI multimodal et multi-agent au monde. Ce système intègre pour la première fois la “mémoire à long terme multimodale” dans le système d’exploitation sous-jacent de l’IA, permettant une compréhension approfondie et un suivi à long terme grâce à six modules de mémoire et un flux de travail multi-agent. Dans les tâches de dialogue long ScreenshotVQA et LOCOMO, MIRIX surpasse largement les méthodes traditionnelles de RAG et de texte long. Une application de bureau est également lancée simultanément, prenant en charge le stockage local, dans le but de créer un assistant personnel AI dédié pour les utilisateurs. (Source: 36氪)

Nouveau modèle open source de NVIDIA : trois fois le débit, fonctionne sur une seule carte et atteint le SOTA en inférence : NVIDIA a lancé Llama Nemotron Super v1.5, un modèle open source conçu spécifiquement pour les tâches d’inférence complexe et d’Agent. Ce modèle, optimisé par Neural Architecture Search (NAS), atteint des performances SOTA en science, mathématiques, programmation et tâches d’Agent, tout en triplant le débit par rapport à la génération précédente. Il peut fonctionner efficacement sur une seule carte, offrant une haute précision, un débit élevé et une faible consommation de ressources. Il fait partie de l’écosystème NVIDIA Nemotron, visant à fournir des solutions de haute performance, contrôlables et évolutives pour le développement d’applications AI d’entreprise. (Source: 量子位)

Lancement du modèle Qwen3-30B-A3B-Instruct-2507 : L’équipe Qwen d’Alibaba Cloud a lancé le modèle Qwen3-30B-A3B-Instruct-2507. Ce modèle, basé sur l’architecture MoE avec seulement 3B de paramètres actifs, offre des performances significativement améliorées, notamment en raisonnement mathématique (AIME25 passant de 21,4 à 61,3) et en compréhension de contexte long (256K tokens), tout en prenant en charge le déploiement local. Ses performances sont proches de celles de GPT-4o et de Qwen3-235B-A22B en mode non-réflexion, ce qui en fait une avancée majeure dans le domaine de l’open source. Des versions quantifiées GGUF et MLX sont déjà disponibles sur Hugging Face et ont suscité un vif intérêt de la communauté. (Source: Reddit r/LocalLLaMA)

SciMaster : le premier agent scientifique généraliste au monde : L’Université Jiao Tong de Shanghai et DeepMotion ont conjointement lancé et rendu open source SciMaster, visant à devenir l’assistant de recherche expert de chacun. Cet agent scientifique généraliste combine des ressources web complètes et 170 millions de publications scientifiques pour offrir des capacités de recherche approfondies de niveau expert. Il prend en charge diverses méthodes de recherche telles que WebSearch, WebParse et PaperSearch, et peut corriger et compléter automatiquement les informations. SciMaster intègre également une variété d’outils scientifiques spécialisés, prenant en charge l’appel actif et automatique, dans le but de remodeler le paradigme de la recherche universitaire et de promouvoir le développement du domaine AI4S. (Source: 量子位)

🎯 Tendances

Progrès de la “Guerre des Trois Royaumes” des modèles vidéo AI nationaux : Dans le domaine chinois de la génération de vidéos AI, Kuaishou Keling AI, Shengshu Technology Vidu et ByteDance Jiemeng AI se livrent une concurrence féroce. Keling AI est réputé pour sa forte expressivité, adaptée au contenu dramatique ; Vidu excelle dans le réalisme et la finesse, simulant habilement les lois physiques ; Jiemeng AI se distingue par son équilibre, sa contrôlabilité et ses outils complets. Tous trois ont réalisé des percées sur les problèmes de cohérence, avec des approches techniques différentes. Keling et Jiemeng, en raison de leur potentiel en termes d’application et d’écosystème, sont considérés comme les concurrents les plus solides pour la victoire finale. (Source: 36氪)

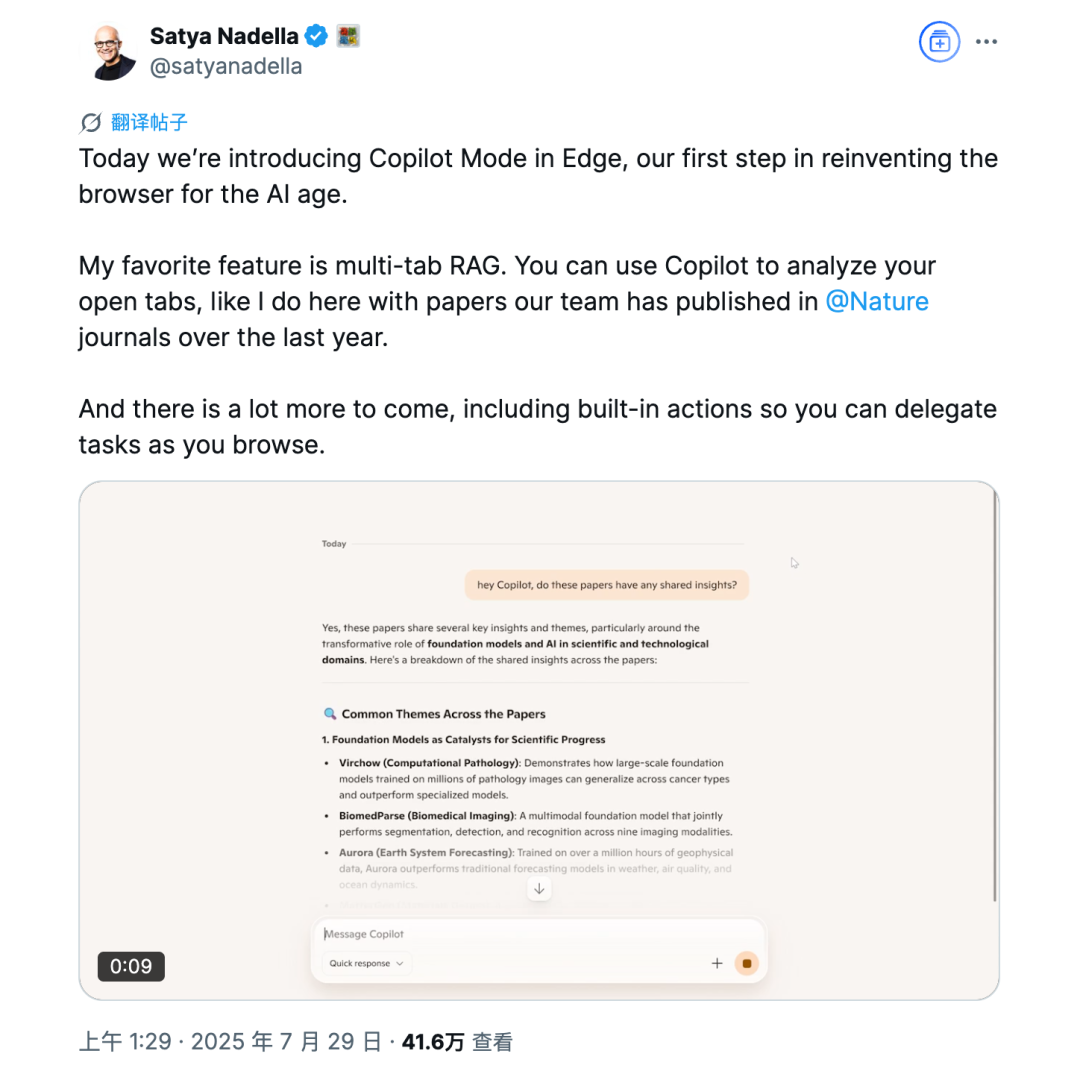

Microsoft Edge lance le mode Copilot : Le navigateur Microsoft Edge fait officiellement son entrée sur le marché des navigateurs AI en lançant le mode Copilot. Ce mode peut lire et comprendre le contenu des pages web, résumer des vidéos YouTube, comparer les informations de produits sur plusieurs onglets, et prend en charge l’interaction vocale. Bien qu’encore en phase expérimentale, il offre des fonctionnalités gratuites similaires à ChatGPT DeepResearch, visant à transformer le navigateur en un outil d’assistance plus intelligent. Cependant, ses fonctionnalités ne diffèrent pas significativement des navigateurs AI existants, et il est confronté aux défis de la confidentialité des utilisateurs et de l’acceptation. (Source: 36氪)

L’IA médicale connaît une habilitation systémique et un développement spécialisé : La WAIC 2025 a montré un “retour en force” de l’IA médicale, avec l’entrée de grandes entreprises et de startups. L’IA passe de la résolution de problèmes spécifiques (“nœuds”) à l’habilitation de “segments” entiers, réalisant une gestion de la santé et une assistance diagnostique complètes via des agents, comme l‘“Assistant de gestion de la santé” de Tencent Health. Parallèlement, l’IA évolue des modèles généraux vers des modèles spécialisés verticaux, résolvant des problèmes cliniques plus profonds, tels que “Jingyi Qianxun 2.0” de JD Health et l‘“Agent intelligent de balayage multiple de la poitrine” d’United Imaging Intelligence, améliorant l’efficacité et la précision du diagnostic et du traitement. (Source: 36氪)

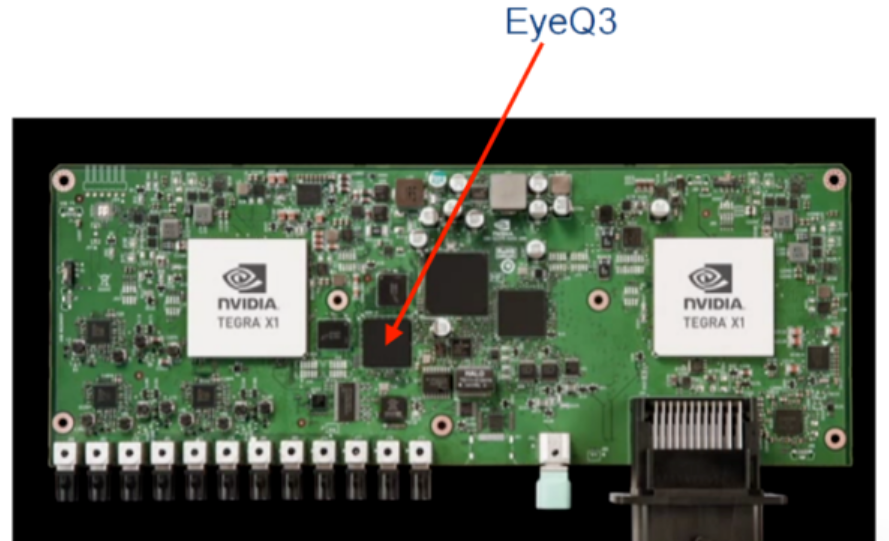

Les puces FSD de Tesla continuent d’évoluer, visant la conduite autonome de niveau 4 : Tesla est passée de la dépendance aux fournisseurs externes (Mobileye, NVIDIA) pour ses puces de conduite autonome à la recherche et développement interne de ses puces FSD. Les versions HW3.0 et HW4.0 ont été lancées successivement, augmentant considérablement la puissance de calcul et l’efficacité énergétique, et renforçant la capacité d’adaptation aux scénarios complexes. La puce HW5.0/AI5 est déjà entrée en production de masse, utilisant le processus 3nm de TSMC, avec une puissance de calcul allant jusqu’à 2000-2500 TOPS. Elle devrait être produite en masse en 2026, favorisant le déploiement de la conduite autonome de niveau 4 et remodelant le marché des puces de conduite intelligente. (Source: 36氪)

🧰 Outils

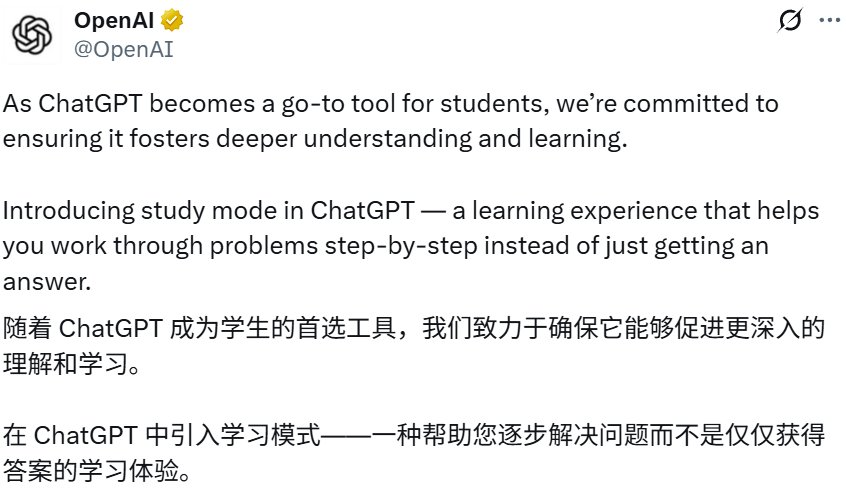

ChatGPT lance le “mode apprentissage” : OpenAI a lancé le “mode apprentissage” de ChatGPT, visant à aider les utilisateurs à résoudre progressivement des problèmes et à approfondir leur compréhension, plutôt que de donner des réponses directes, grâce à des questions socratiques, des questions guidées et des retours personnalisés. Ce mode est accessible à tous les utilisateurs (y compris les utilisateurs gratuits) et est alimenté par des instructions système personnalisées rédigées en collaboration avec des experts en éducation. Il vise à développer la pensée critique et la capacité d’auto-apprentissage, marquant une exploration approfondie de ChatGPT dans le domaine des applications éducatives. (Source: 36氪)

Google NotebookLM ajoute une fonction de résumé vidéo : Google NotebookLM a lancé une fonction de résumé vidéo, une alternative visuelle au résumé audio. Les utilisateurs peuvent utiliser un hôte AI pour générer automatiquement de courts résumés vidéo contenant des images, des graphiques, des citations et des données, permettant une présentation visuelle plus claire de concepts complexes ou textuels, et améliorant l’efficacité de l’apprentissage et de la compréhension. Cette fonction est actuellement disponible en anglais et sur les ordinateurs de bureau. (Source: Google)

Claude Code prend en charge le travail multi-répertoires : Claude Code d’Anthropic a été mis à jour pour prendre en charge le travail sur plusieurs répertoires dans une seule session. Les utilisateurs peuvent saisir /add-dir pour ajouter un répertoire de travail. Cette fonctionnalité améliore considérablement la commodité des opérations sur les bases de code, permettant la migration de code au sein d’un projet ou entre projets sans changer de session, et la récupération de fichiers de mémoire ou de règles externes, améliorant ainsi l’expérience de programmation collaborative des Agents. (Source: dotey)

Tongyi Lingma lance Qwen3-Coder : Alibaba Cloud Tongyi Lingma a lancé le modèle de programmation AI Qwen3-Coder, que les utilisateurs peuvent utiliser gratuitement via l’IDE AI Tongyi Lingma, les plugins VSCode et Jetbrains. Qwen3-Coder améliore significativement la vitesse et la précision de la génération de code dans des scénarios de développement d’entreprise réels, et offre une meilleure expérience de programmation collaborative d’Agent. Ce modèle a atteint le sommet du classement HuggingFace et est considéré comme le modèle de programmation open source le plus puissant au monde, comparable à Claude4. (Source: 量子位)

BlockDL : un constructeur de réseaux neuronaux visuel : BlockDL est un outil GUI gratuit et open source qui permet aux utilisateurs de concevoir visuellement des réseaux neuronaux Keras par glisser-déposer de modules. Il offre une génération de code instantanée et une validation de forme en temps réel, aidant les développeurs à concevoir rapidement et à éviter les erreurs précoces. L’outil comprend également un système d’apprentissage complet et prend en charge des structures avancées telles que les connexions de saut et les modèles multi-entrées/sorties. (Source: fchollet)

PopAi AI Slides Agent : PopAi a lancé l’AI Slides Agent, permettant aux utilisateurs de générer automatiquement de superbes diapositives PPT à partir d’une simple invite. Cet outil vise à comprendre les idées de l’utilisateur grâce à l’IA, pour une création de diapositives intelligente, rapide et facile, améliorant considérablement l’efficacité de la production de présentations. (Source: kaifulee)

📚 Apprentissage

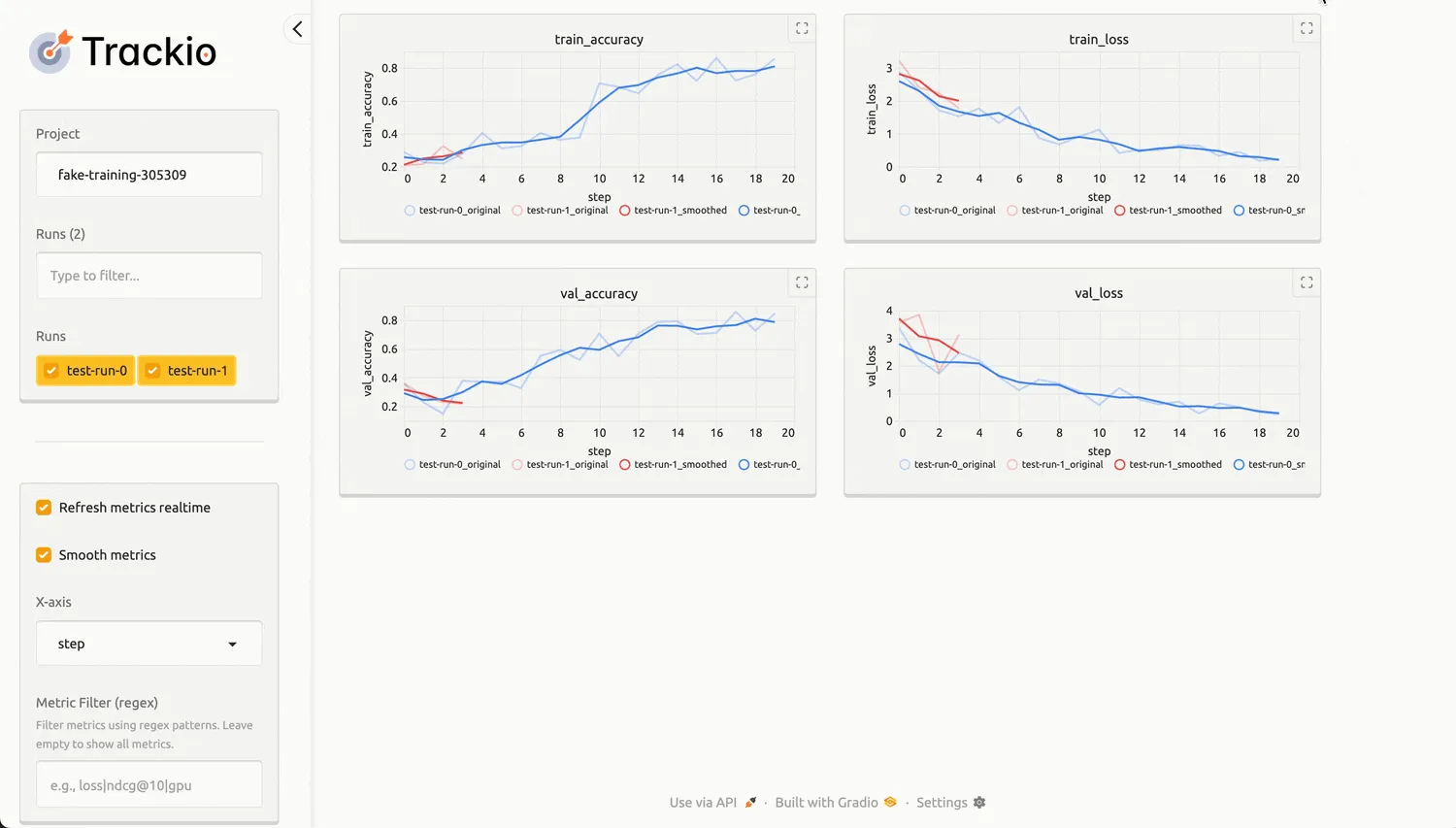

Hugging Face lance Trackio, une bibliothèque légère de suivi d’expériences : Hugging Face a lancé Trackio, une bibliothèque Python open source conçue pour offrir une solution légère et locale de suivi des expériences d’apprentissage automatique. Trackio est compatible avec l’API wandb, facilitant le partage de la progression de l’entraînement, l’intégration de graphiques et la normalisation de l’enregistrement transparent de métriques telles que la consommation d’énergie du GPU. Il est construit sur Gradio et Hugging Face Spaces, permettant aux utilisateurs de visualiser et de partager facilement les résultats expérimentaux, et peut être intégré nativement avec les bibliothèques Transformers et Accelerate. (Source: HuggingFace Blog)

Application de LangChain et LangGraph dans l’ingénierie du contexte : LangChain et LangGraph offrent diverses méthodes d’ingénierie du contexte pour aider les développeurs à optimiser les performances des applications LLM. LangGraph, grâce à des systèmes multi-agents, aide des entreprises (comme Bertelsmann) à réduire le temps de découverte de contenu de plusieurs heures à quelques secondes, permettant le déploiement d’agents experts dans divers domaines de contenu et la réutilisation modulaire d’API. La nouvelle fonction Align Evals de LangSmith simplifie également la construction d’évaluateurs LLM-as-judge, rendant leurs scores plus conformes aux préférences humaines. (Source: LangChainAI)

Génération de problèmes mathématiques par LLM et amélioration de la complexité : Le projet SAND-Math propose un pipeline pour générer des problèmes mathématiques et des solutions nouveaux, difficiles et utiles via des LLM. Cette méthode génère d’abord des problèmes de haute qualité, puis augmente systématiquement leur complexité par une étape d‘“amélioration de la difficulté”. L’algorithme EDGE-GRPO atténue efficacement le problème de l’effondrement de l’avantage dans l’apprentissage par renforcement grâce à l‘“avantage piloté par l’entropie” et la “correction d’erreur guidée”, améliorant les performances d’inférence des LLM. Le cadre MaPPO, quant à lui, renforce l’alignement des LLM avec les préférences humaines en intégrant des connaissances de récompense a priori dans l’objectif d’optimisation. Ces recherches contribuent collectivement aux progrès des LLM dans le raisonnement mathématique et l’apprentissage par renforcement. (Source: HuggingFace Daily Papers)

CIRCLE : un benchmark de sécurité pour les interpréteurs de code LLM : CIRCLE (Code-Interpreter Resilience Check for LLM Exploits) est un benchmark simple pour évaluer les risques de cybersécurité au niveau du système des interpréteurs de code LLM. Il contient 1260 invites ciblant l’épuisement des ressources CPU, mémoire et disque, visant à évaluer si le LLM refuse ou génère du code dangereux, et exécute le code dans l’environnement de l’interpréteur pour évaluer sa correction ou son dépassement de temps. Les tests ont révélé des vulnérabilités significatives et incohérentes dans les modèles commerciaux, en particulier une réduction des capacités de défense sous des invites indirectes ou d’ingénierie sociale. (Source: HuggingFace Daily Papers)

Alignement des objectifs dans les simulateurs d’utilisateurs LLM : La recherche révèle les limites des simulateurs d’utilisateurs LLM actuels, qui peinent à maintenir un comportement orienté objectif dans les dialogues multi-tours. Le cadre User Goal State Tracking (UGST) est proposé pour suivre la progression des objectifs de l’utilisateur, et des simulateurs d’utilisateurs capables de suivre de manière autonome les objectifs et de générer des réponses alignées sur les objectifs sont développés. Cette méthode a significativement amélioré les performances d’alignement des objectifs sur les benchmarks MultiWOZ 2.4 et τ-Bench. (Source: HuggingFace Daily Papers)

Tutoriel de fine-tuning de modèles de complétion de code LLM : Oxen.ai a publié une série de tutoriels expliquant comment fine-tuner des modèles de complétion de code “tab tab” rapides et locaux pour les notebooks Marimo. L’objectif est de créer des modèles open source offrant une expérience de complétion de code similaire à Cursor, supportant l’exécution locale ou l’accès via une API gratuite. Les premières expériences montrent que les modèles Qwen et Llama fine-tunés ont déjà atteint des performances de niveau GPT-4 sur le jeu de données MBPP. (Source: Reddit r/MachineLearning)

Théorie des réseaux neuronaux et nouvelles avancées en apprentissage de représentations : Face à la rigueur croissante dans la conception des architectures de réseaux neuronaux, un doctorant recherche des recommandations de livres de mathématiques pour guider sa recherche théoriquement, plutôt que par simple intuition. Parallèlement, la communauté a discuté des dernières idées en apprentissage de représentations, y compris l’apprentissage Matryoshka et l’apprentissage contrastif, et recherche de nouvelles “astuces” de réseaux neuronaux développées au cours des 2-3 dernières années pour construire de meilleures représentations, couvrant les problèmes d’apprentissage non supervisé et supervisé. De plus, le cadre X-Omni a amélioré les modèles de génération d’images autorégressifs discrets grâce à l’apprentissage par renforcement, permettant une intégration transparente de la génération d’images et de langage. (Source: Reddit r/MachineLearning)

💼 Affaires

L’impact de l’IA sur le marché du travail se polarise : L’IA modifie significativement le marché du travail, notamment en matière de recrutement et de licenciement. Le secteur technologique a vu environ 80 000 licenciements dus à l’automatisation par l’IA (comme Microsoft qui prévoit de licencier 15 000 personnes), tandis qu’en dehors du secteur technologique, la demande de compétences en IA a explosé, avec une prime salariale atteignant 28%, soit une augmentation annuelle moyenne de près de 18 000 dollars. Les domaines du marketing, des ressources humaines, de la finance, etc., intègrent rapidement les outils d’IA, et les compétences hybrides en IA (comme la communication, le leadership) sont très recherchées. (Source: 36氪)

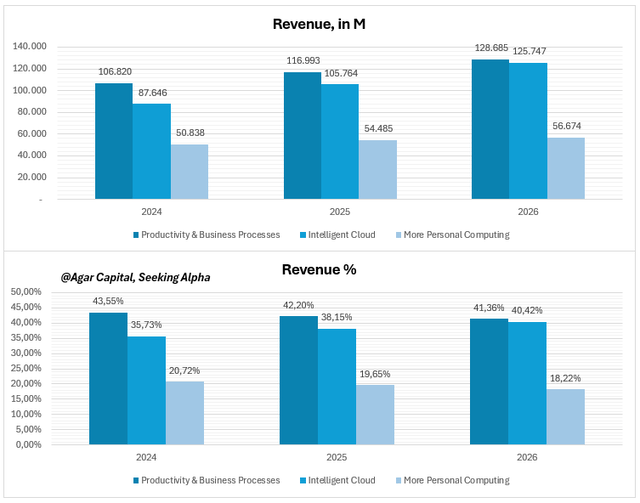

Perspectives financières de Microsoft pour le T4 : l’IA stimule les marges, pas un pari risqué : La stratégie AI de Microsoft est passée d’une technologie de pointe à une infrastructure économique. L’IA est profondément intégrée dans les activités principales comme Azure Cloud, Copilot et Office, et commence à générer des retours. Les charges de travail AI ont contribué à une croissance de 34% d’Azure Cloud, et les utilisateurs d’entreprise de Copilot ont atteint 200 000, avec une croissance accélérée de l’ARPU. Les analystes estiment que Microsoft est sous-évalué, ses marges élevées et son flux de trésorerie prouvant que l’IA est devenue une “superpuissance” monétisable, et non une simple histoire. (Source: 36氪)

Commercialisation des AI Agents : qui sera la “vache à lait” ? : La WAIC 2025 a montré que les AI Agents sont passés du concept à la réalité, notamment dans les services aux entreprises, l’intelligence industrielle, la fintech et le matériel intelligent. Les plateformes d’Agents rentables ont généralement un prix unitaire par client élevé (plus de 500 000 yuans par an) et une marge brute élevée (≥60%), monétisant via des modes avancés tels que la “vente d’accès” (liaison au niveau du système), le “partage de performance” (commission sur les économies réalisées) et la “vente par unité de ressource” (main-d’œuvre AI dans le cloud). Les barrières fondamentales résident dans l’intégration profonde aux processus métier, la conformité réglementaire sectorielle et la capacité d’intégration aux anciens systèmes. (Source: 36氪)

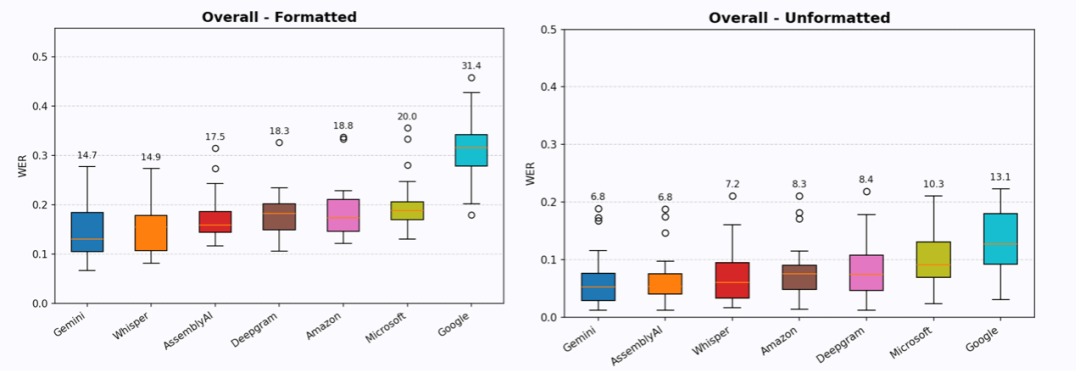

Le secteur de la saisie vocale AI lève des dizaines de millions de dollars : Les startups de saisie vocale Willow Voice et Wispr Flow ont récemment clôturé des tours de financement de 4,2 millions de dollars (amorçage) et 30 millions de dollars (Série A) respectivement, démontrant l’intérêt du capital pour la “saisie” vocale AI plutôt que la “sortie”. Ces entreprises visent à fournir des services de conversion voix-texte “sans édition”, produisant du texte directement utilisable grâce à la mise en forme, la compréhension contextuelle et la reconnaissance du contexte. Bien qu’il y ait encore des lacunes, leur forte fidélisation des utilisateurs et leur taux de paiement élevé indiquent un immense potentiel pour la saisie vocale à réduire les frictions homme-machine et à améliorer l’efficacité, pouvant potentiellement remplacer le clavier comme nouveau paradigme d’interaction homme-machine. (Source: 36氪)

L’impact accéléré de l’IA sur le Product-Market Fit (PMF) : À l’ère de l’IA, le PMF passe d’un jalon statique à un tapis roulant accéléré. La prolifération des outils AI accélère le remplacement des produits, et les attentes des utilisateurs augmentent de manière exponentielle, augmentant le risque de “perte de PMF”. Les entreprises doivent surveiller attentivement l’évolution des attentes des utilisateurs et utiliser les outils AI pour agréger les retours ; évaluer le niveau de risque de perte de PMF, comme les canaux et la fréquence d’utilisation du produit, la maîtrise des flux de travail créatifs, les données propriétaires et l’acceptation des nouvelles technologies par les clients ; et ajuster en conséquence la stratégie produit, en allouant plus de ressources à l’expansion du PMF ou à la recherche d’un nouveau PMF. (Source: 36氪)

GMI Cloud présente sa puissance d’infrastructure AI à la WAIC2025 : GMI Cloud, en tant que fournisseur mondial de services AI Native Cloud, a démontré sa solide infrastructure AI lors de la WAIC2025. Ses produits phares incluent les services cloud GPU (basés sur des puces haut de gamme comme H200, B200), Cluster Engine et Inference Engine, visant à fournir aux entreprises une infrastructure AI sécurisée et efficace. GMI Cloud a également lancé un calculateur de coûts de construction d’applications AI et une expérience pratique de l’Inference Engine, aidant les développeurs à planifier précisément et à déployer efficacement les applications AI, en particulier sur les marchés étrangers. (Source: 量子位)

🌟 Communauté

Les phases de “pré-entraînement” et de “post-entraînement” des modèles AI : Les médias sociaux discutent de la division de l’entraînement des modèles AI en “pré-entraînement” (Pretraining) et “post-entraînement” (Post-training). Le pré-entraînement est comparé à un coureur de marathon calculant précisément chaque segment et chaque gramme d’eau, une science élégante réalisée par des mathématiciens et des ingénieurs de systèmes distribués à grande échelle ; le post-entraînement est décrit comme une “recherche de cowboy risquée”, plus expérimentale et exploratoire, suggérant les défis et la nature non standardisée rencontrés dans les applications réelles. (Source: natolambert)

Le développement rapide et les défis de la vidéo générée par l’IA : Les médias sociaux s’animent autour des progrès fulgurants de la vidéo générée par l’IA, avec des modèles comme Runway Aleph et Alibaba Wan 2.2. Les utilisateurs s’émerveillent que “la vidéo a changé pour toujours”, capable de transformer facilement des images statiques en séquences dynamiques, voire d’atteindre des effets visuels de qualité cinématographique. Cependant, certains soulignent les lacunes de la vidéo AI en matière d’expression émotionnelle et de contrôle du rythme, ainsi que les exigences élevées en ressources de calcul. La discussion porte également sur le phénomène de “Will Smith mangeant des spaghettis” comme benchmark non officiel de la génération vidéo AI, reflétant l’attention continue de la communauté sur la qualité et le réalisme des vidéos AI. (Source: c_valenzuelab)

Surproduction de contenu AI et transfert de valeur : Les discussions sociales indiquent qu’avec la réduction des barrières de production par les outils AI, la génération de contenu textuel long de haute qualité devient facile, entraînant une “surabondance”. Cela rend la curation, la vérification, la contextualisation et les capacités de synthèse plus précieuses, tandis que le “goût, la théorie de l’esprit et le discernement” deviennent essentiels. Certains craignent que cela ne mène à une “médiocrité généralisée”, mais d’autres pensent que l’IA peut accélérer le travail et inciter davantage de personnes à créer. (Source: nptacek)

Débat sur la sécurité des API AI et des modèles à poids ouverts : Clement Delangue, PDG de Hugging Face, remet en question l’affirmation selon laquelle “le déploiement d’API AI est plus responsable que les modèles à poids ouverts”. Il soutient que les API, en abaissant la barrière d’utilisation, pourraient en fait augmenter considérablement le nombre d’acteurs malveillants sans offrir plus de contrôle. Il appelle à cesser le discours selon lequel “les poids ouverts sont dangereux”, estimant que la facilité d’utilisation des API pourrait entraîner une exposition au risque plus importante. (Source: ClementDelangue)

Discussion sur la parallélisation des AI Agents et l’amélioration de l’efficacité : La communauté discute si la parallélisation des AI Agents peut améliorer significativement l’efficacité. Certains comparent cela à l’idée que “neuf femmes ne peuvent pas faire un bébé en un mois”, suggérant que certaines tâches sont intrinsèquement séquentielles et difficiles à paralléliser. Cependant, d’autres soulignent qu’en faisant travailler plusieurs Agents en parallèle sur différentes branches/tâches, l’efficacité peut être améliorée, surtout en traitant d’autres problèmes en attendant la réponse d’un Agent. La discussion mentionne également la loi d’Amdahl, soulignant que l’efficacité parallèle dépend de la nature de la tâche, et insiste sur le faible coût des Agents, de sorte que même une parallélisation partielle peut apporter des gains d’efficacité. (Source: Reddit r/ClaudeAI)

Préoccupations concernant le lancement et le contrôle de l’AGI : La communauté débat intensément de la question de savoir si l’AGI sera rendue publique. La plupart pensent que la première entreprise ou le premier pays à découvrir/créer l’AGI la gardera strictement secrète pour obtenir un avantage considérable, et ne la rendra pas publique facilement. Les inquiets pensent que l’émergence de l’AGI pourrait entraîner une perte de contrôle, voire dépasser les attentes humaines. D’autres soulignent que les entreprises, cherchant le profit, la commercialiseront, et que les gouvernements pourraient immédiatement en prendre le contrôle. (Source: Reddit r/ArtificialInteligence)

Fiabilité des LLM et phénomène d’« hallucination » : La communauté discute de la fiabilité des LLM, certains les comparant au bouton “J’ai de la chance” de Google, estimant que les réponses des LLM sont parfois purement aléatoires. D’autres utilisateurs partagent des expériences de sorties anormales “dissociatives” de Gemini 2.5, soulevant des préoccupations quant à la stabilité des modèles et au phénomène d‘“hallucination”. Cette incertitude signifie que les utilisateurs doivent toujours vérifier prudemment les sorties des LLM. (Source: Reddit r/ArtificialInteligence)

L’IA redéfinit les rôles humains et les titres professionnels : Elon Musk a annoncé chez xAI l’abolition du terme “chercheur”, ne conservant que “ingénieur”, estimant que “chercheur” est un vestige du monde universitaire et soulignant l’importance de la contribution d’ingénierie réelle. Ce point de vue a suscité des discussions au sein de la communauté : certains sont d’accord que tous devraient finalement être des ingénieurs, mais d’autres réfutent l’importance de la recherche pour l’ingénierie et remettent en question le fait que cette approche puisse entraîner une fuite des cerveaux. (Source: Yuchenj_UW)

L’impact de l’IA sur le travail des Product Managers (PM) : Les médias sociaux discutent de l’impact de l’IA sur le travail des Product Managers, soulignant que l’IA remodèle le processus de développement produit. Certains estiment que le codage AI a un impact limité sur les équipes d’ingénierie, mais que dans les équipes produit et design, l’IA accélère considérablement la vitesse d’itération grâce au prototypage. Les PM AI partagent comment construire des produits pour faire face aux changements apportés par l’IA, soulignant que la gestion de produit n’est plus “coder à l’intuition”, mais nécessite une gestion minutieuse. (Source: amasad)

Discussion sur l’IA et la future forme de la société : La communauté discute si l’IA peut créer un avenir sans monnaie ni travail. Certains pensent que l’IA peut automatiser la plupart des tâches, libérant les humains pour se concentrer sur le développement personnel et la connexion, mais qu’une telle utopie nécessiterait un changement massif des valeurs, de l’accès et de la propriété, et pas seulement de la technologie. D’autres craignent qu’un tel avenir puisse conduire à l’abus de pouvoir par les contrôleurs de l’IA, ou que l’IA elle-même développe des objectifs inattendus. (Source: Reddit r/ArtificialInteligence)

💡 Autres

La relation symbiotique entre l’IA et l’informatique quantique : Quantinuum et Google DeepMind ont révélé la réalité de la relation symbiotique entre l’informatique quantique et l’IA. Les capacités uniques de l’informatique quantique offrent de nouveaux paradigmes de calcul pour les modèles AI, tandis que l’IA peut optimiser les algorithmes quantiques et la conception matérielle. La combinaison des deux devrait permettre des percées dans la résolution de problèmes complexes et le traitement des données, favorisant le développement des technologies de pointe. (Source: Ronald_vanLoon)

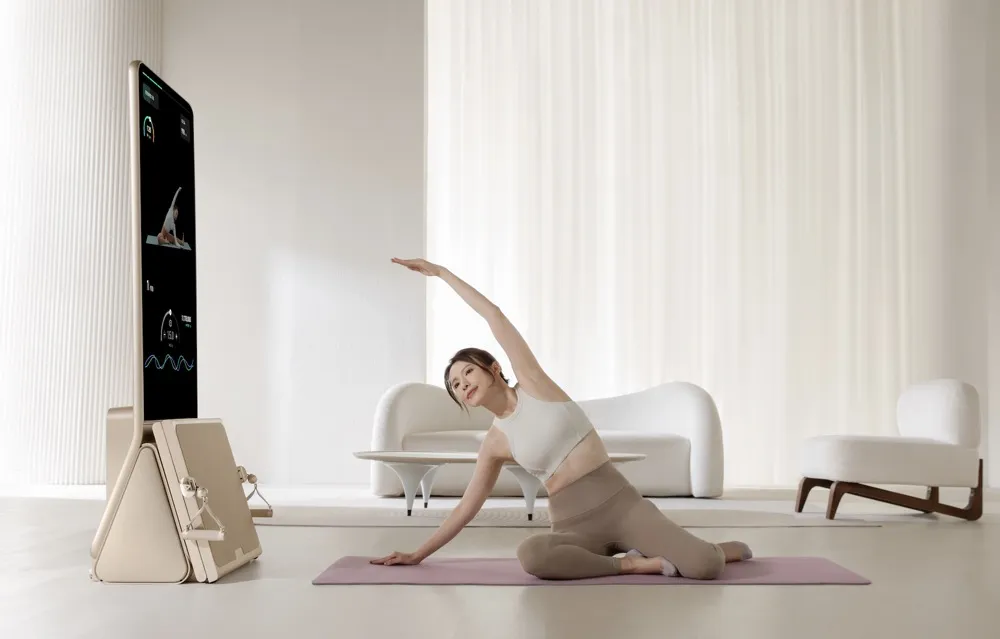

L’équipement de fitness intelligent AEKE conquiert le marché haut de gamme des foyers : La société de Shenzhen AEKE, avec son équipement de fitness intelligent Smart Home Gym K1, dont le prix unitaire est de 20 000 yuans, a généré des dizaines de millions de yuans de revenus sur une plateforme de crowdfunding à l’étranger en un mois. Ce produit se concentre sur l’entraînement de force et le Pilates, offrant une solution intégrée de matériel et de logiciel, équipée d’un écran tactile 4K, d’une technologie de moteur numérique servo auto-développée et d’un système de coach personnel AI, permettant des plans d’entraînement personnalisés et une correction des mouvements en temps réel. AEKE cible le marché haut de gamme, mettant l’accent sur la légèreté, l’absence d’installation et le positionnement comme objet d’art domestique, et améliore la fidélisation des utilisateurs et l’efficacité de l’expansion sur les marchés étrangers grâce à son système de coach personnel AI. (Source: 36氪)

Résumé mensuel d’AIhub : juillet 2025 : AIhub a publié son résumé mensuel de juillet 2025, couvrant des événements AI importants tels que la RoboCup (compétition de football robotique) et la conférence ICML (apprentissage automatique). Le contenu comprend des entretiens et des résumés des différentes ligues de la RoboCup (comme RoboCupRescue, Small Size League, 3D Simulation League), les discours d’invités et les prix de l’ICML, ainsi qu’une présentation de la plateforme de recherche AI embarquée de la NASA, OnAIR. De plus, il aborde les avancées de la recherche sur la génération de texte en son et l’utilisation du feedback dans les interactions homme-machine. (Source: aihub.org)