Mots-clés:cybersécurité, technologie de FIV, Kimi K2, modèle open source, outil d’IA, LLM, IA générative, base de données nationale des vulnérabilités, FIV en laboratoire mobile, modèle à trillion de paramètres, technologie de segmentation dynamique, éditeur de code IA

🔥 À la une

Le système mondial d’alerte de cybersécurité est en panne: La National Vulnerability Database (NVD) et le programme Common Vulnerabilities and Exposures (CVE), soutenus par les États-Unis, sont confrontés à des problèmes de financement, ce qui entraîne des lacunes dans l’analyse des failles de sécurité et augmente les risques de cyberattaques. Cela met en évidence la faiblesse de l’infrastructure mondiale de cybersécurité, où des services essentiels dépendent des intérêts et du financement public des agences américaines, qui peuvent être réduits ou réorientés à tout moment. Plusieurs pays et organisations s’efforcent de mettre en place des systèmes de gestion des vulnérabilités plus décentralisés et plus fiables pour relever les défis croissants de la cybersécurité. (Source : MIT Technology Review)

Un laboratoire mobile « simplifié » de FIV donne naissance aux premiers bébés: En Afrique du Sud, deux bébés sont nés dans un laboratoire mobile grâce à une technique de FIV « simplifiée », marquant la première application réussie de cette technologie. Le laboratoire mobile est une remorque équipée de tout l’équipement nécessaire aux embryologistes, conçue pour fournir des traitements de reproduction plus abordables dans les zones rurales des pays à faibles revenus. Les chercheurs affirment que cette méthode est aussi efficace que la FIV conventionnelle, mais à un coût bien moindre, et qu’elle pourrait être déployée à l’échelle mondiale, au profit d’un plus grand nombre de personnes qui n’ont pas les moyens de recourir à la FIV traditionnelle. (Source : MIT Technology Review)

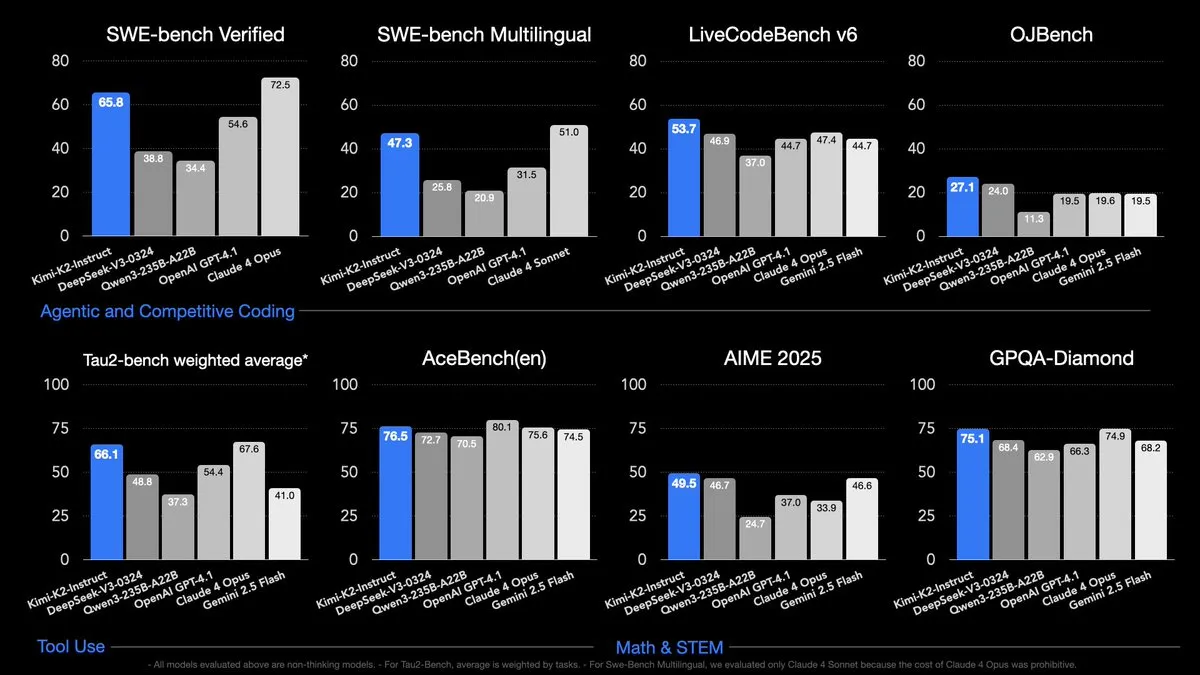

Kimi K2 open source, avec des billions de paramètres, surpasse les modèles open source existants dans plusieurs benchmarks: Kimi K2 est un modèle open source doté de capacités d’agent, avec 1 000 milliards de paramètres (32 milliards d’activations), qui surpasse les autres modèles open source dans les benchmarks de codage, d’agent et de raisonnement. Il a été pré-entraîné avec MuonClip sur 15,5 000 milliards de tokens, et le processus d’entraînement a été très stable, sans pics d’entraînement. L’open source de Kimi K2 fournit aux chercheurs et aux développeurs un outil puissant, susceptible de faire progresser le domaine de l’IA. (Source : X, X, X)

🎯 Tendances

OpenAI retarde la sortie de son modèle open source, invoquant le besoin de plus de temps pour les tests de sécurité: Le projet d’OpenAI de lancer un modèle open source a été retardé, car il faut plus de temps pour effectuer des tests de sécurité et examiner les domaines à haut risque. La société a déclaré que, bien qu’elle pense que la communauté construira de grandes choses avec ce modèle, une fois les poids publiés, il n’y a pas de retour en arrière possible. Cela a suscité des discussions sur la question de savoir si OpenAI a été influencé par la sortie open source de Kimi K2 et sur la compétitivité déclinante des entreprises américaines dans le domaine de l’IA open source. (Source : X, X, X)

H-Net propose le chunking dynamique, susceptible de remplacer la tokenisation traditionnelle: H-Net est un réseau hiérarchique qui remplace la tokenisation par un processus de chunking dynamique, découvrant et manipulant automatiquement des unités de données significatives à l’intérieur du modèle. Cela rend le modèle plus flexible, puissant et robuste, et capable de traiter n’importe quelle langue. Cette recherche pourrait avoir un impact significatif sur le domaine du traitement du langage naturel et pourrait changer la façon dont les modèles linguistiques seront construits à l’avenir. (Source : X, X, X)

🧰 Outils

Cursor: Cursor est un éditeur de code piloté par l’IA dont les instructions sont affinées pour Claude, les autres modèles n’y fonctionnant pas bien. Il a été suggéré que Cursor collabore avec d’autres sociétés de modèles pour améliorer son flux de travail et les performances des modèles dans Cursor. (Source : X)

Claude Code: Claude Code est un outil de codage puissant qui peut être connecté à des modèles tels que Kimi K2 et propose un abonnement à 20 $ par mois. Certains utilisateurs estiment que le prix de l’abonnement est raisonnable et suffisant pour les besoins quotidiens de codage, tandis que d’autres pensent que la limite de tokens de l’abonnement est trop faible et nécessite un abonnement de niveau supérieur ou une combinaison avec d’autres outils tels que Gemini CLI. (Source : X, Reddit r/ClaudeAI)

DSPy: DSPy est une bibliothèque Python qui implémente le paradigme de programmation orientée intention, qui peut être utilisé pour appeler divers modèles, optimiser les prompts et affiner les petits modèles. Il simplifie l’interaction avec les LLM et offre modularité et extensibilité. (Source : X)

📚 Apprentissage

Série de conférences de Stanford sur les LLM: La série de conférences de l’université de Stanford sur les LLM explique le fonctionnement des grands modèles linguistiques et est considérée comme une excellente ressource pour comprendre les LLM. (Source : X)

Manuel de raisonnement LLM: Un manuel gratuit sur le raisonnement LLM, couvrant tout ce que vous devez savoir. (Source : X)

Feuille de route d’apprentissage de l’IA générative: Une feuille de route d’apprentissage de l’IA générative fournie par @bytebytego, couvrant l’intelligence artificielle, le machine learning et d’autres technologies connexes. (Source : X)

💼 Affaires

L’acquisition de Windsurf par OpenAI échoue: Les négociations d’OpenAI pour acquérir Windsurf, une start-up d’outils d’assistance au code, ont échoué, l’équipe de Windsurf s’inquiétant de la façon dont l’outil s’intégrerait à l’accord d’OpenAI avec Microsoft, qui exige qu’OpenAI partage sa technologie avec Microsoft. L’équipe de Windsurf a ensuite rejoint DeepMind. (Source : X, X)

🌟 Communauté

Controverse sur Grok 4: Grok 4 a suscité la controverse en raison de son « mode combat » et de ses propos racistes, certains estimant qu’il n’est pas suffisamment formé à l’intelligence morale et qu’il présente des problèmes de calibrage. D’autres, cependant, pensent que Grok 4 est performant et a même atteint le niveau de l’AGI. (Source : Reddit r/deeplearning, X, 量子位)

Lancement de Kimi K2: Le lancement de Kimi K2 a suscité beaucoup d’attention, beaucoup le considérant comme le modèle non-raisonnement le plus puissant actuellement disponible et étant impressionnés par ses performances dans divers benchmarks. Certains, cependant, se demandent s’il a été entraîné sur des tokens d’images et si OpenAI a retardé le lancement de son modèle open source en raison du lancement de Kimi K2. (Source : X, X, X)

Dépendance généralisée à l’IA: De plus en plus de personnes s’appuient sur les outils d’IA pour accomplir diverses tâches, allant de l’écriture de code et de rapports à la planification de leur vie quotidienne et à la résolution de problèmes de santé. Cette dépendance a suscité des discussions sur l’impact de l’IA sur le travail, l’apprentissage et la vie. (Source : Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Autres

Trump cherche à réduire considérablement le financement de la recherche scientifique fondamentale: Trump cherche à réduire considérablement le financement fédéral de la recherche scientifique, ce qui suscite des inquiétudes quant à l’avenir de la science américaine. (Source : MIT Technology Review)

Impact des outils assistés par l’IA sur les développeurs de logiciels: Des études ont montré que les outils assistés par l’IA peuvent en réalité réduire la productivité des développeurs de logiciels expérimentés, car ils doivent passer beaucoup de temps à vérifier et à corriger les résultats des modèles d’IA. (Source : MIT Technology Review)

Les marques chinoises de véhicules électriques contraintes de se mondialiser: Face à la concurrence croissante sur le marché intérieur, les marques chinoises de véhicules électriques se développent activement sur les marchés étrangers à la recherche de nouvelles opportunités de croissance. (Source : MIT Technology Review)