Mots-clés:IA, NVIDIA, Deutsche Telekom, Cloud IA industrielle, IA souveraine, Anthropic, Système multi-agents, Projet de loi RAISE, Cloud européen d’IA industrielle, Contournement de l’embargo sur les puces par disque dur volant, Recherche sur les systèmes multi-agents Claude, Projet de loi RAISE de l’État de New York, Débat entre Jensen Huang et le PDG d’Anthropic

🔥 Pleins feux

Nvidia et Deutsche Telekom s’associent pour construire un cloud IA industriel européen: Le chancelier fédéral allemand a rencontré Jensen Huang, PDG de Nvidia, pour discuter de l’approfondissement de la coopération stratégique visant à renforcer la position de l’Allemagne en tant que leader mondial de l’IA. Les sujets clés comprenaient la construction d’une infrastructure d’IA souveraine et l’accélération du développement de l’écosystème de l’IA. À cette fin, Deutsche Telekom et Nvidia ont annoncé un partenariat visant à construire d’ici 2026 le premier cloud IA industriel mondial au service des fabricants européens. Cette plateforme garantira la souveraineté des données et stimulera l’innovation en matière d’IA dans le secteur industriel européen. (Source : nvidia)

Des entreprises chinoises d’IA utilisent des « valises de disques durs volantes » pour contourner le blocus américain sur les puces: Pour contourner les restrictions américaines sur l’exportation de puces d’IA vers la Chine, les entreprises chinoises adoptent une nouvelle stratégie : transporter directement des disques durs contenant des données d’entraînement d’IA vers des centres de données à l’étranger (comme en Malaisie), utiliser des serveurs locaux équipés de puces avancées telles que Nvidia pour entraîner les modèles, puis rapporter les résultats. Cette démarche souligne la complexité de la chaîne d’approvisionnement mondiale de l’IA et la capacité d’adaptation des entreprises chinoises face aux restrictions, tout en favorisant l’émergence de l’Asie du Sud-Est et du Moyen-Orient comme nouveaux points chauds pour les centres de données d’IA. (Source : dotey)

Anthropic publie une méthode de construction de systèmes de recherche multi-agents: Le blog d’ingénierie d’Anthropic détaille comment l’entreprise utilise plusieurs agents travaillant en parallèle pour développer les capacités de recherche de Claude. L’article partage les succès, les défis rencontrés et les solutions d’ingénierie issues du processus de développement. Ce modèle de collaboration multi-agents vise à améliorer l’analyse approfondie et les capacités de traitement de l’information des grands modèles de langage dans des tâches de recherche complexes, offrant une référence pratique pour la construction d’assistants de recherche IA plus puissants. (Source : AnthropicAI)

L’État de New York adopte la loi RAISE, renforçant les exigences de transparence pour les modèles d’IA avancés: L’État de New York a adopté la loi RAISE (RAISE Act), visant à établir des exigences de transparence pour les modèles d’IA avancés. Des entreprises comme Anthropic ont fourni des commentaires sur ce projet de loi ; bien que des améliorations aient été apportées, des préoccupations subsistent, telles que des définitions clés ambiguës, des opportunités de correction de conformité peu claires, une définition trop large des « incidents de sécurité » avec un délai de signalement court (72 heures), et des amendes potentielles de plusieurs millions de dollars pour des infractions techniques mineures, constituant un risque pour les petites entreprises. Anthropic appelle à l’établissement de normes de transparence fédérales unifiées et suggère que les propositions au niveau des États se concentrent sur la transparence et évitent une réglementation excessive. (Source : jackclarkSF)

Jensen Huang, PDG de Nvidia, réfute les opinions du PDG d’Anthropic sur le développement de l’IA: Lors d’une conférence de presse à Viva Technology à Paris, Jensen Huang a réfuté les opinions de Dario Amodei, PDG d’Anthropic. Amodei aurait affirmé que l’IA est trop dangereuse et devrait être développée uniquement par certaines entreprises ; qu’elle est trop coûteuse pour être popularisée ; et qu’elle est trop puissante et entraînera des pertes d’emplois. Huang a souligné que l’IA devrait être développée de manière sûre, responsable et ouverte, et non pas dans une « chambre noire » en prétendant à la sécurité. Ces déclarations ont déclenché un débat sur les voies de développement de l’IA (ouverte et démocratique contre élitiste et fermée), soulignant les divergences philosophiques entre les géants de l’industrie. (Source : pmddomingos, dotey)

🎯 Tendances

Meta pourrait dépenser 14 milliards de dollars pour acquérir une participation majoritaire dans Scale AI afin de renforcer ses capacités en IA: Selon des rapports, Meta prévoit d’acquérir 49 % des parts de la société d’annotation de données IA Scale AI pour 14,8 milliards de dollars, et pourrait nommer son PDG à la tête du nouveau « super groupe d’intelligence » de Meta. Cette démarche vise à relever les défis posés par les performances décevantes du modèle Llama 4 et la fuite des talents internes en IA, en intégrant des talents et des technologies externes de premier plan pour accélérer sa course à l’intelligence artificielle générale. (Source : Reddit r/ArtificialInteligence, 量子位)

OpenAI lance le modèle o3-pro, la forte baisse de prix d’o3 suscite des discussions sur les performances: OpenAI a officiellement lancé son modèle d’inférence « le plus récent et le plus puissant », o3-pro, conçu pour les utilisateurs Pro et Team, avec un prix API de 20 $/million de tokens en entrée et 80 $/million de tokens en sortie. Parallèlement, le prix de l’API du modèle o3 original a été réduit de 80 %, s’alignant pratiquement sur celui de GPT-4o. OpenAI affirme qu’o3-pro excelle en mathématiques, en sciences et en programmation, mais avec un temps de réponse plus long. La question de savoir si la baisse de prix d’o3 s’accompagne d’une « baisse d’intelligence » fait débat au sein de la communauté, certains utilisateurs signalant une diminution des performances, bien que des données empiriques unifiées fassent défaut. (Source : 量子位)

Cohere Labs étudie l’impact des tokenizers universels sur l’adaptabilité des modèles linguistiques: Cohere Labs a publié une nouvelle étude examinant si les tokenizers entraînés sur un plus grand nombre de langues que la langue cible du pré-entraînement (universal tokenizer) peuvent améliorer l’adaptabilité (plasticity) du modèle à de nouvelles langues sans nuire aux performances du pré-entraînement. L’étude a révélé que les tokenizers universels améliorent l’efficacité de l’adaptation linguistique d’un facteur 8 et les performances d’un facteur 2. Même dans des situations de données extrêmement rares et avec des langues totalement inconnues, le taux de réussite est supérieur de 5 % à celui des tokenizers spécialisés. Cela suggère que les tokenizers universels peuvent améliorer efficacement la flexibilité et l’efficacité des modèles dans le traitement des tâches multilingues. (Source : sarahookr)

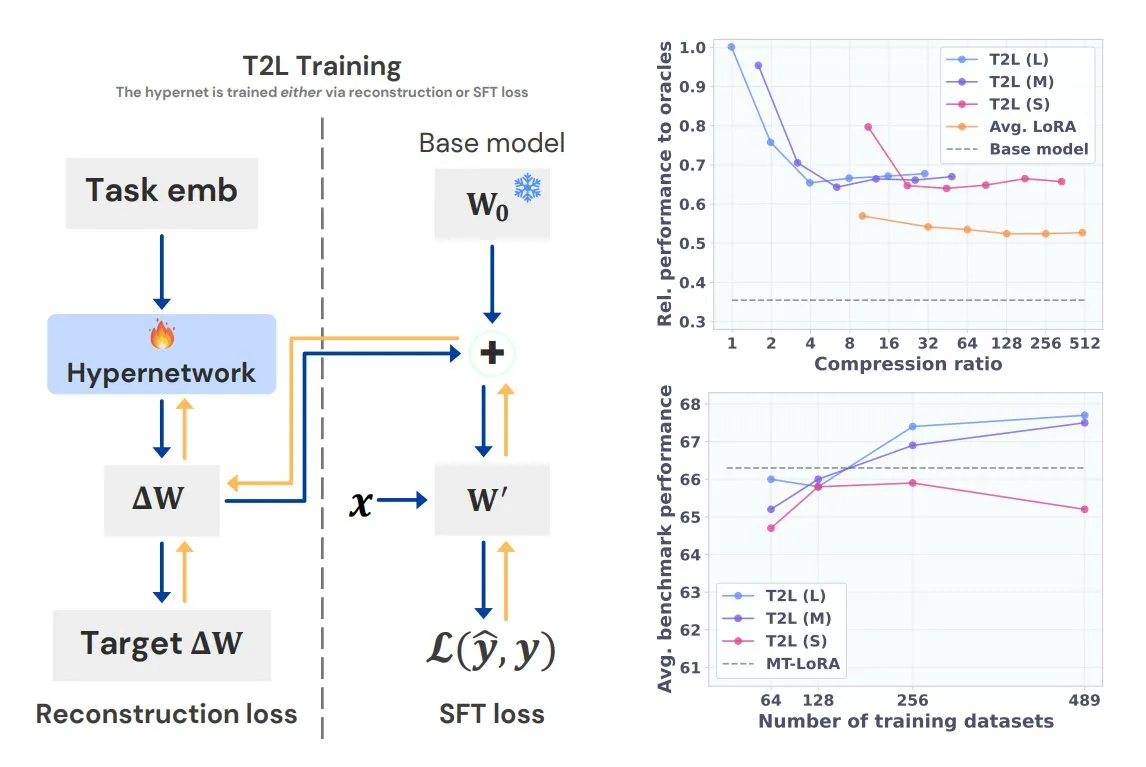

Sakana AI lance Text-to-LoRA (T2L), générant des LoRA spécifiques à une tâche en une seule phrase: Sakana AI, co-fondée par Llion Jones, l’un des auteurs de Transformer, a lancé la technologie Text-to-LoRA (T2L). Cette architecture de super-réseau peut générer rapidement des adaptateurs LoRA spécifiques en fonction de la description textuelle d’une tâche, simplifiant considérablement le processus de fine-tuning des LLM. T2L peut compresser les LoRA existants et générer des adaptateurs efficaces dans des scénarios zero-shot, offrant une nouvelle voie pour l’adaptation rapide des modèles aux tâches de longue traîne. (Source : TheTuringPost, 量子位)

L’Université Tsinghua et Tencent publient conjointement Scene Splatter, réalisant une génération de scènes 3D haute fidélité: L’Université Tsinghua et Tencent ont collaboré pour proposer la technologie Scene Splatter. Partant d’une seule image, cette technologie utilise des modèles de diffusion vidéo et un mécanisme innovant de guidage par momentum pour générer des séquences vidéo respectant la cohérence tridimensionnelle, construisant ainsi des scènes 3D complexes. Cette méthode surmonte la dépendance traditionnelle aux vues multiples, améliore la fidélité et la cohérence des scènes générées, et offre de nouvelles perspectives pour les aspects clés des modèles du monde et de l’intelligence incarnée. (Source : 量子位)

Tencent Hunyuan 3D 2.1 publié : le premier modèle de génération 3D PBR de qualité production open source: Tencent a publié Hunyuan 3D 2.1, présenté comme le premier modèle de génération 3D basé sur le rendu physique (PBR) entièrement open source et utilisable en production. Ce modèle est capable de générer des effets visuels de qualité cinématographique, prend en charge la synthèse de matériaux PBR tels que le cuir et le bronze, avec des effets d’interaction lumière-ombre réalistes. Les poids du modèle, le code d’entraînement/inférence, le pipeline de données et l’architecture ont tous été rendus open source et peuvent fonctionner sur des GPU grand public, permettant aux créateurs, développeurs et petites équipes de procéder au fine-tuning et à la création de contenu 3D. (Source : cognitivecompai, huggingface)

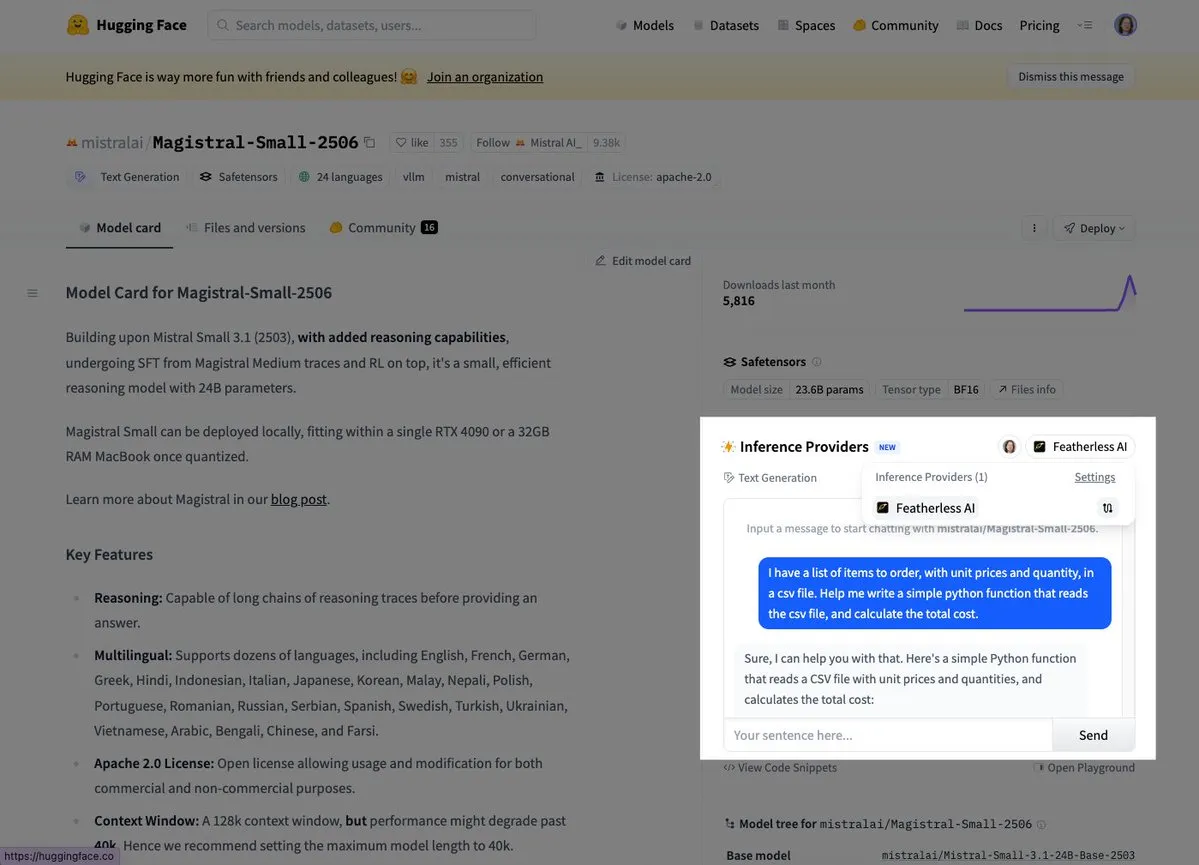

Mistral lance son premier modèle d’inférence Magistral Small: Mistral AI a lancé son premier modèle d’inférence, Magistral Small, qui se concentre sur des capacités d’inférence spécifiques à un domaine, transparentes et multilingues. Les utilisateurs peuvent désormais l’essayer via des plateformes telles que Hugging Face et FeatherlessAI. Cela marque une étape importante pour Mistral dans la construction d’outils d’inférence IA plus spécialisés et plus faciles à comprendre. (Source : dl_weekly, huggingface)

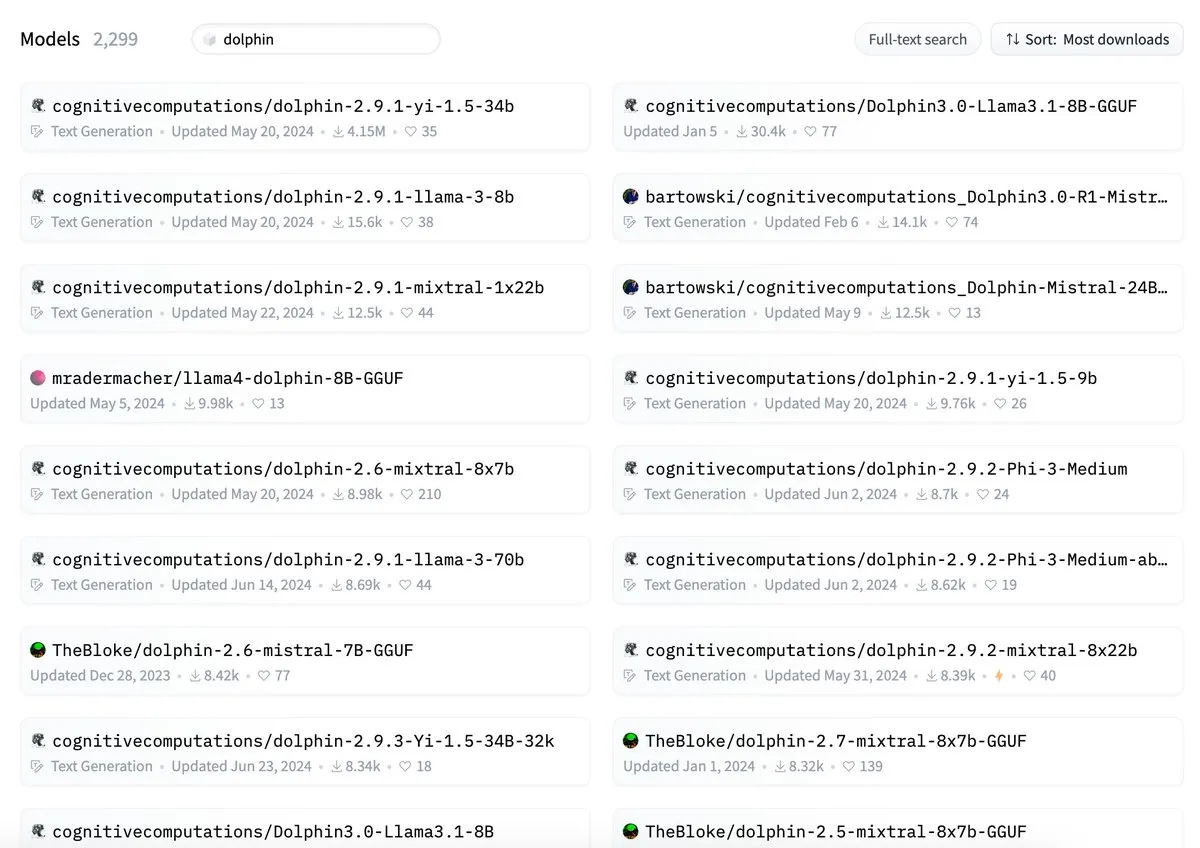

ByteDance accusé de conflit de nommage pour son modèle Dolphin avec cognitivecomputations/dolphin: Il a été signalé que le modèle Dolphin publié par ByteDance portait le même nom qu’un modèle existant, cognitivecomputations/dolphin. Cognitive Computations a déclaré avoir signalé ce problème dans un commentaire il y a 24 jours, lors de la première publication du modèle par ByteDance, mais n’avoir pas reçu d’attention. Cet incident a suscité des discussions au sein de la communauté sur les normes de nommage des modèles et la nécessité d’éviter toute confusion. (Source : cognitivecompai)

Simplification de l’API MLX Swift LLM, trois lignes de code pour démarrer une session de chat: En réponse aux commentaires des développeurs sur la difficulté de prise en main de l’API MLX Swift LLM, l’équipe a apporté des améliorations et lancé une nouvelle API simplifiée. Désormais, les développeurs n’ont besoin que de trois lignes de code pour charger un LLM ou un VLM dans un projet Swift et démarrer une session de chat, ce qui réduit considérablement la barrière à l’entrée pour l’utilisation et l’intégration de grands modèles de langage dans l’écosystème Apple. (Source : ImazAngel)

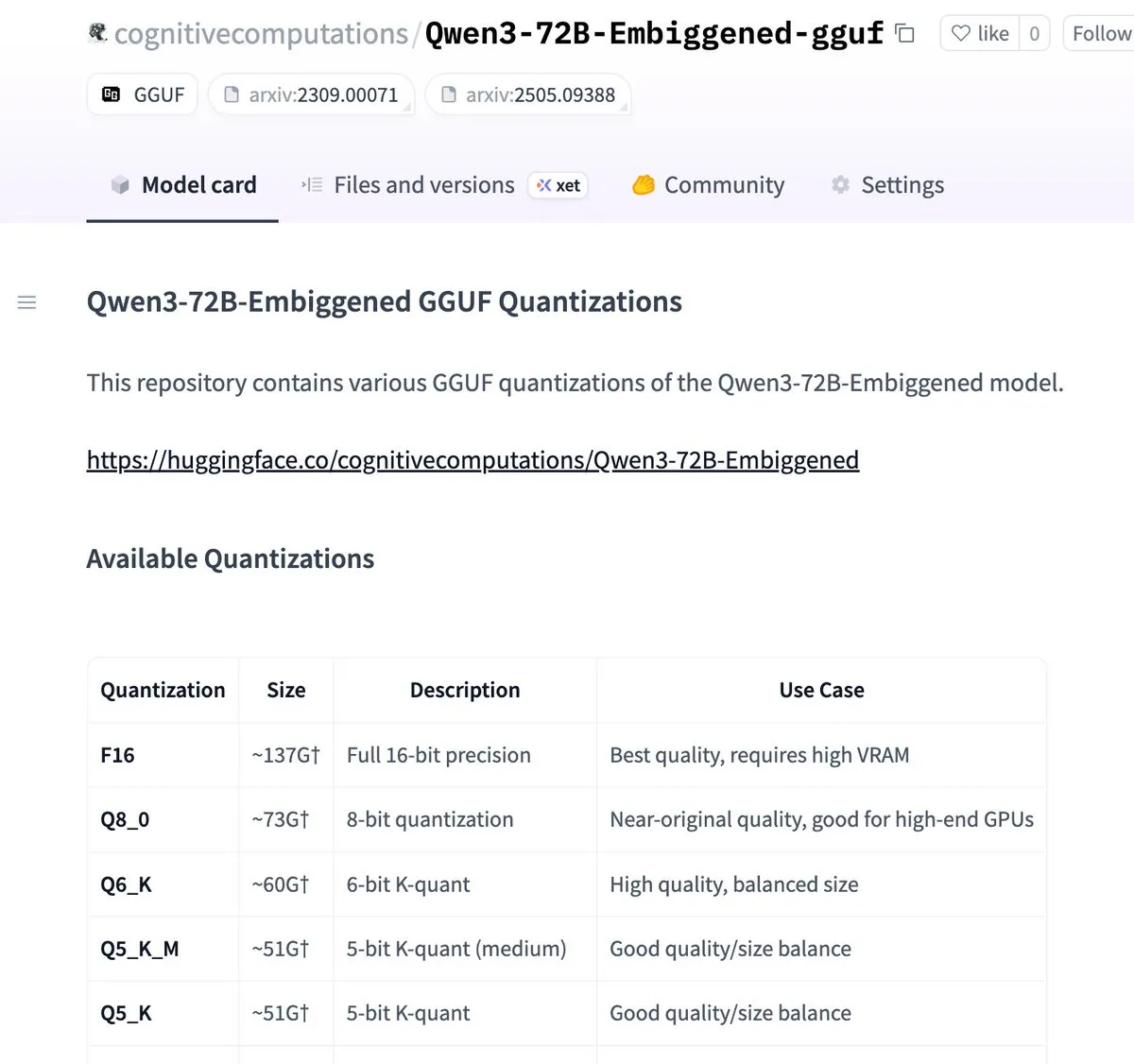

Les versions Qwen3-72B-Embiggened et 58B ont été quantifiées au format llama.cpp gguf: Eric Hartford a annoncé avoir quantifié les modèles Qwen3-72B-Embiggened et Qwen3-58B-Embiggened au format llama.cpp gguf, permettant aux utilisateurs d’exécuter ces grands modèles sur des appareils locaux. Ce projet a bénéficié du soutien des ressources de calcul AMD mi300x. (Source : ClementDelangue, cognitivecompai)

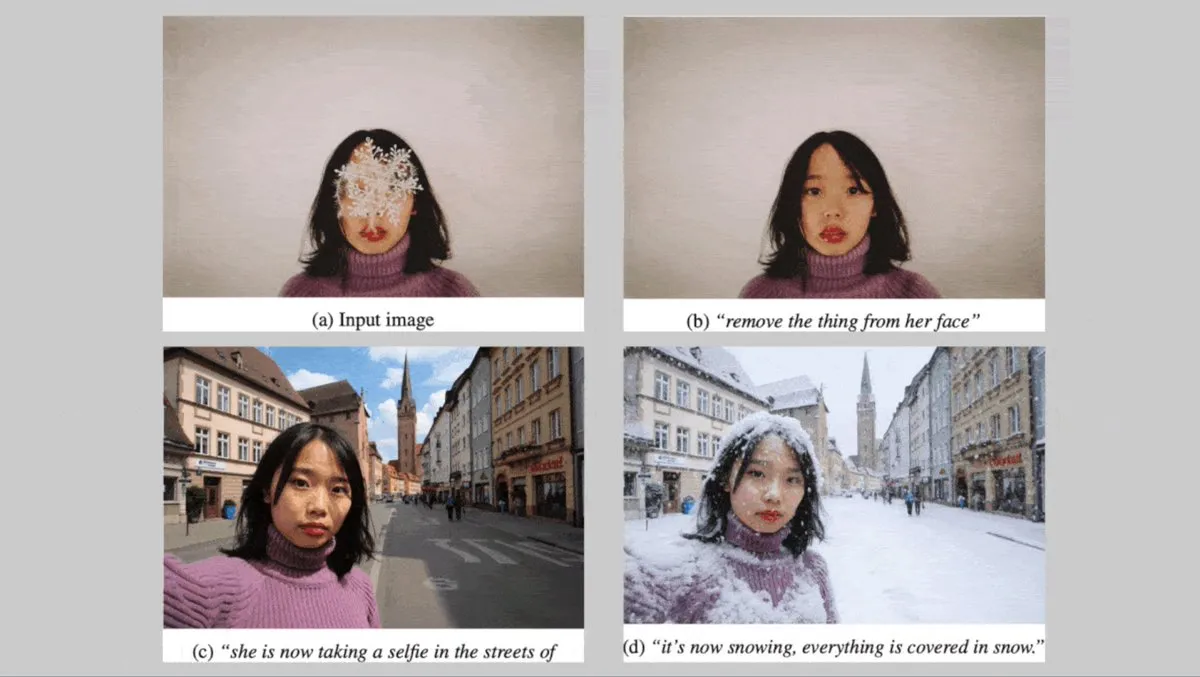

L’allemand Black Forest Labs lance la série de modèles texte-vers-image FLUX.1, axée sur la cohérence des personnages: L’allemand Black Forest Labs a lancé trois modèles de génération de texte en image : FLUX.1 Kontext max, pro et dev. Ces modèles se concentrent sur le maintien de la cohérence des personnages lors du changement de fond, de pose ou de style. Ils combinent un codec d’image convolutif et un Transformer entraîné par distillation par diffusion contradictoire, prenant en charge une édition efficace et fine. Les versions max et pro sont déjà disponibles via FLUX Playground et des plateformes partenaires. (Source : DeepLearningAI)

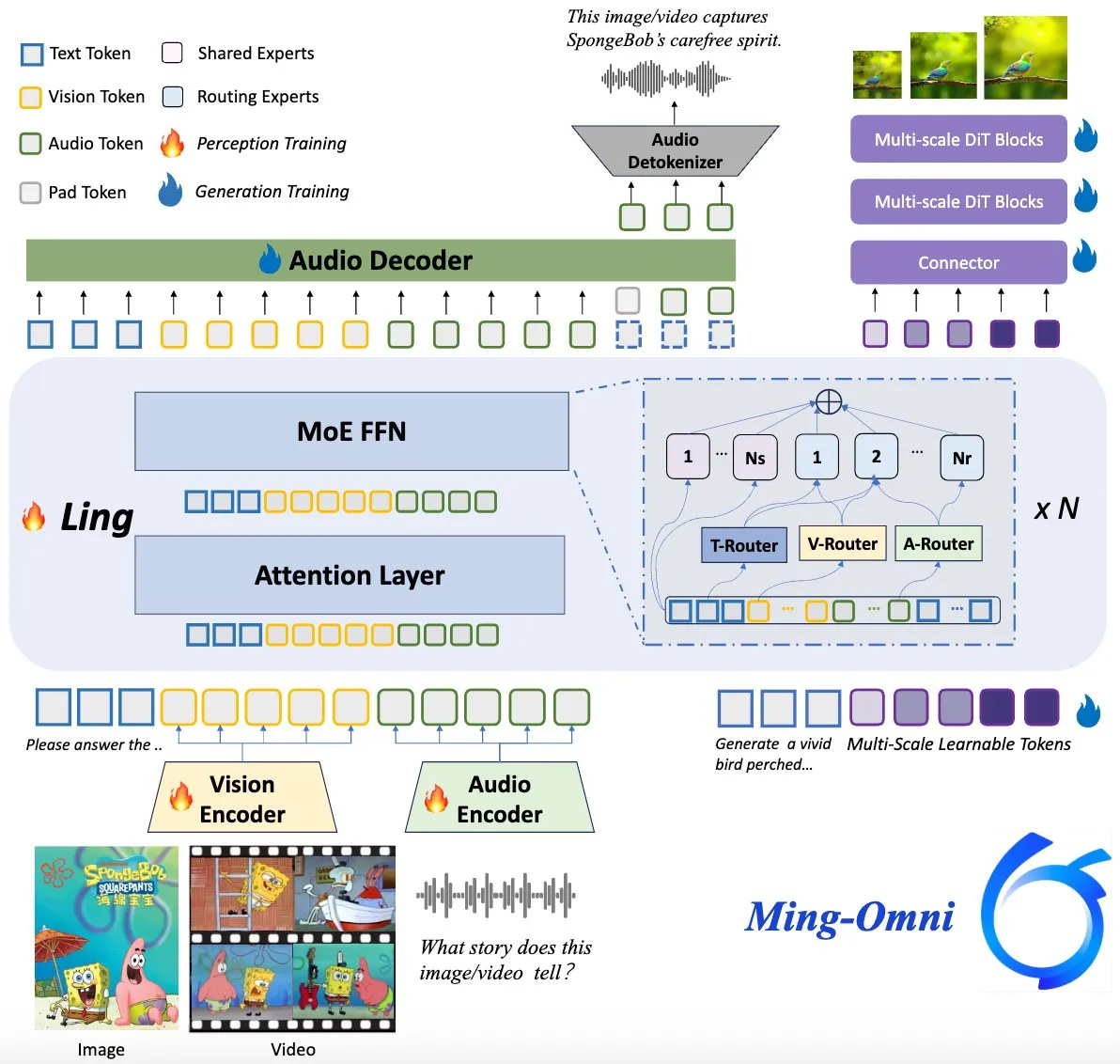

Le modèle Ming-Omni open source, en concurrence avec GPT-4o: Un modèle multimodal open source nommé Ming-Omni a été publié sur Hugging Face, visant à fournir des capacités de perception et de génération unifiées comparables à GPT-4o. Ce modèle prend en charge le texte, les images, l’audio et la vidéo en entrée, peut générer de la parole et des images haute résolution, adopte une architecture MoE et des routeurs spécifiques à la modalité, dispose de fonctionnalités telles que le chat contextuel, le TTS, l’édition d’images, avec seulement 2,8B de paramètres actifs, et ses poids et son code sont entièrement ouverts. (Source : huggingface)

Une étude sur l’IA révèle que les LLM multimodaux peuvent développer des représentations conceptuelles interprétables similaires à celles des humains: Des chercheurs chinois ont découvert que les grands modèles de langage (LLM) multimodaux sont capables de développer des représentations interprétables des concepts d’objets, similaires à celles des humains. Cette étude offre de nouvelles perspectives pour comprendre les mécanismes internes des LLM et la manière dont ils comprennent et associent des informations de différentes modalités (comme le texte et les images). (Source : Reddit r/LocalLLaMA)

DeepMind et le Centre National des Ouragans américain collaborent pour utiliser l’IA dans la prévision des ouragans: Le Centre National des Ouragans américain adopte pour la première fois la technologie de l’IA pour prédire les ouragans et autres tempêtes violentes, en collaboration avec DeepMind. Cela marque une étape importante dans l’application de l’IA au domaine de la prévision météorologique, susceptible d’améliorer la précision et la rapidité des alertes d’événements météorologiques extrêmes. (Source : MIT Technology Review)

🧰 Outils

LlamaParse lance la fonctionnalité « Presets » pour optimiser l’analyse de différents types de documents: LlamaParse a lancé la fonctionnalité « Presets » (Préréglages), offrant une série de modes préconfigurés faciles à comprendre pour optimiser les paramètres d’analyse pour différents cas d’utilisation. Cela inclut des modes rapide, équilibré et avancé pour les scénarios généraux, ainsi que des modes optimisés pour des types de documents spécifiques tels que les factures, les articles de recherche scientifique, la documentation technique et les formulaires. Ces préréglages visent à aider les utilisateurs à obtenir plus facilement des sorties structurées pour des types de documents spécifiques, comme la tabularisation des champs de formulaire ou la sortie XML des schémas dans la documentation technique. (Source : jerryjliu0, jerryjliu0)

Codegen lance une fonctionnalité de conversion vidéo en PR, l’IA aide à résoudre les bugs d’interface utilisateur: Codegen a annoncé la prise en charge de l’entrée vidéo. Les utilisateurs peuvent joindre une vidéo du problème dans Slack ou Linear, Codegen utilise Gemini pour extraire les informations de la vidéo, corriger automatiquement les bugs liés à l’interface utilisateur et générer une PR. Cette fonctionnalité vise à améliorer considérablement l’efficacité du signalement et de la correction des problèmes d’interface utilisateur, particulièrement adaptée à la résolution des bugs interactifs. (Source : mathemagic1an)

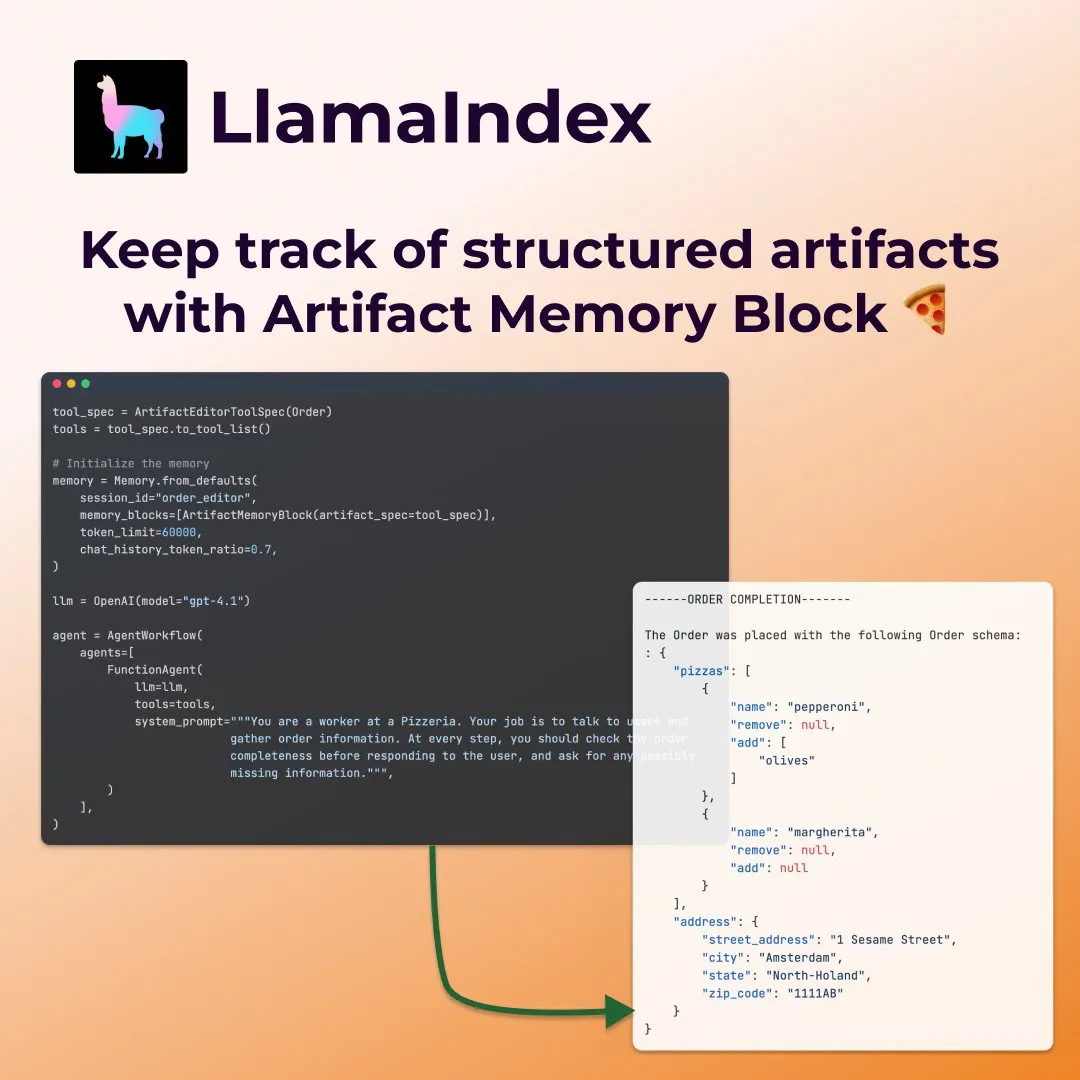

LlamaIndex lance des « blocs de mémoire d’artefacts » structurés pour les agents de remplissage de formulaires intelligents: LlamaIndex a présenté un nouveau concept de mémoire – le « bloc de mémoire d’artefacts structuré » (structured artifact memory block) – spécialement conçu pour les agents tels que ceux qui remplissent des formulaires. Ce bloc de mémoire suit un schéma structuré Pydantic, qui est continuellement mis à jour avec les nouveaux messages de chat et toujours injecté dans la fenêtre de contexte, permettant à l’agent de suivre en permanence les préférences de l’utilisateur et les informations de formulaire déjà remplies, par exemple pour collecter des détails tels que la taille, l’adresse, etc., dans un scénario de commande de pizza. (Source : jerryjliu0)

Davia : un outil de génération de pages web WYSIWYG basé sur FastAPI devient open source: Davia est un projet open source construit avec FastAPI, visant à fournir une interface de génération de pages web WYSIWYG (What You See Is What You Get), similaire à la fonctionnalité d’interface de Chat des principaux fournisseurs de grands modèles. Les utilisateurs peuvent l’installer via pip install davia. Il prend en charge la personnalisation des couleurs Tailwind, la mise en page responsive et le mode sombre, en utilisant shadcn/ui comme composants d’interface utilisateur. (Source : karminski3)

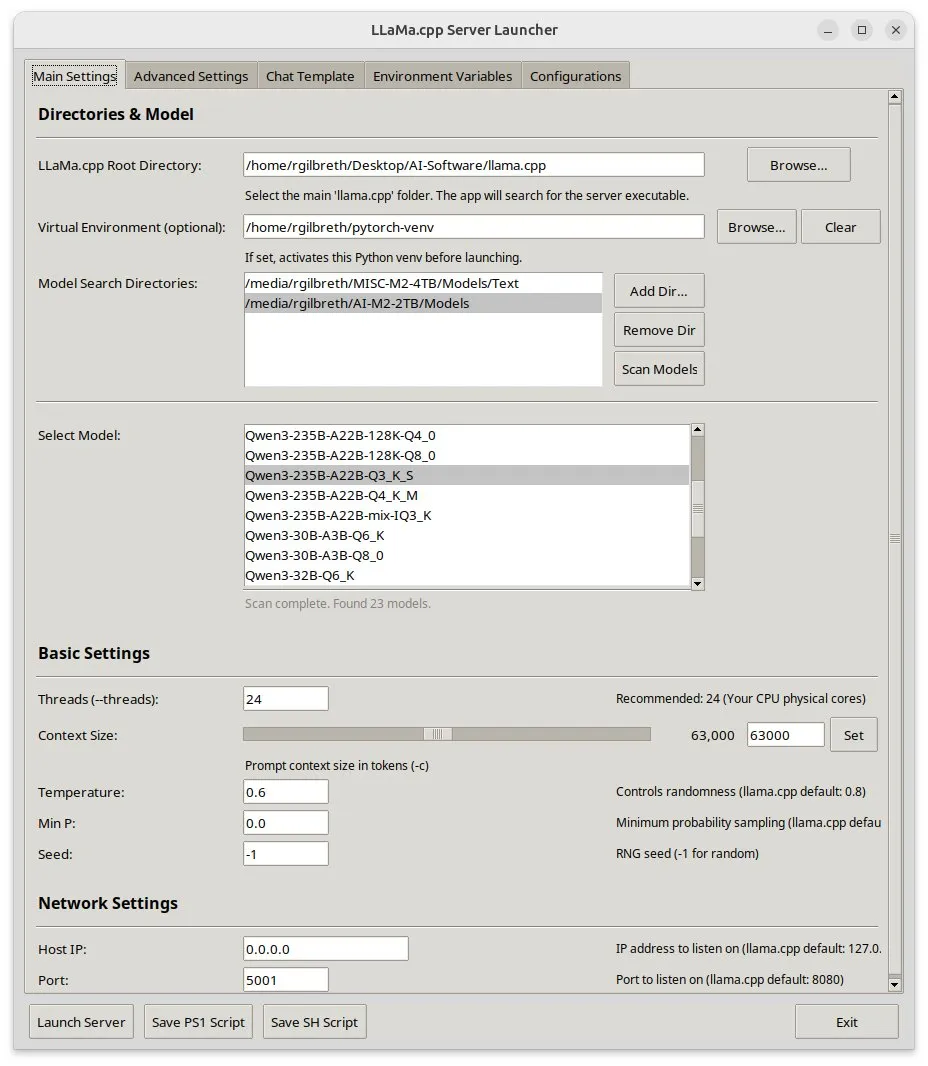

Llama-server-launcher : une interface graphique pour les configurations complexes de llama.cpp: Étant donné la complexité croissante de la configuration de llama.cpp, comparable à celle de serveurs Web tels que Nginx, la communauté a développé le projet llama-server-launcher. Cet outil fournit une interface graphique permettant aux utilisateurs de sélectionner par clics le modèle à exécuter, le nombre de threads, la taille du contexte, la température, le déchargement GPU, la taille du batch, etc., simplifiant le processus de configuration et économisant le temps passé à consulter les manuels. (Source : karminski3)

Bonne nouvelle pour les utilisateurs Mac : MLX Llama 3 + MPS TTS pour un assistant vocal hors ligne: Un développeur a partagé son expérience de création d’un assistant vocal hors ligne sur un Mac Mini M4 en utilisant MLX-LM (Llama-3-8B 4 bits) et Kokoro TTS (exécuté via MPS). Cette solution ne nécessite pas de cloud ni de démon Ollama, fonctionne avec 16 Go de RAM et permet des fonctionnalités de chat et de TTS de bout en bout hors ligne, offrant une nouvelle option d’assistant vocal IA local pour les utilisateurs de puces Mac M. (Source : Reddit r/LocalLLaMA)

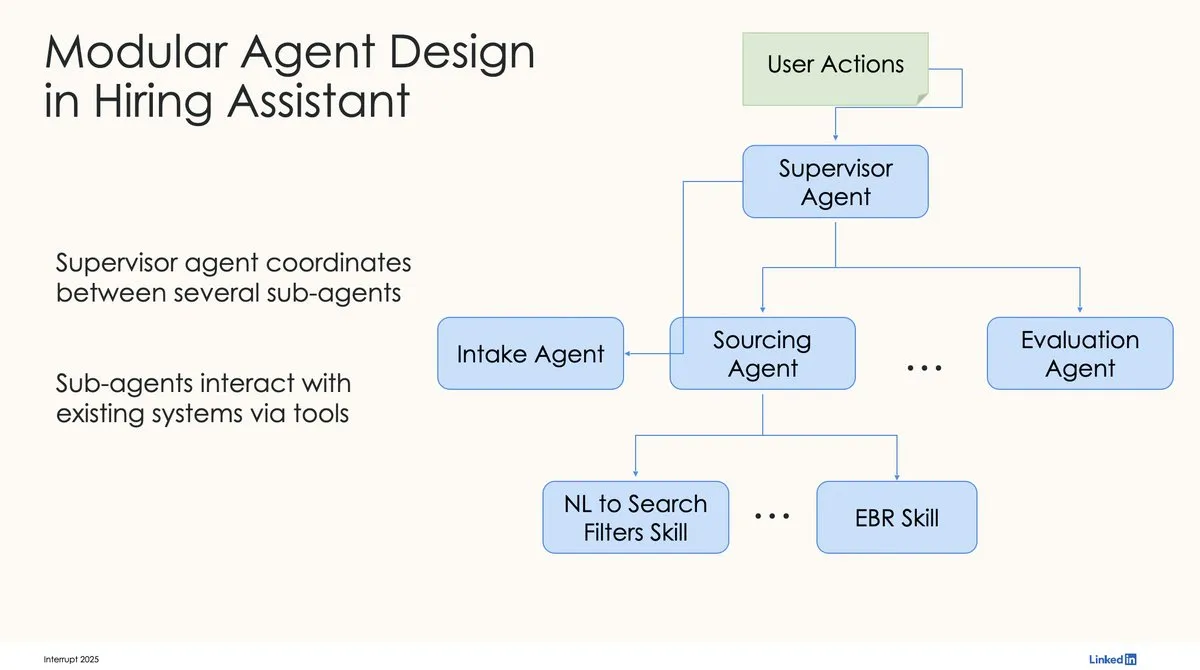

LinkedIn utilise LangChain et LangGraph pour construire son premier assistant de recrutement IA de niveau production: David Tag de LinkedIn a partagé l’architecture technique de la façon dont ils ont utilisé LangChain et LangGraph pour construire leur premier assistant de recrutement IA de niveau production, LinkedIn Hiring Assistant. Ce framework a été étendu avec succès à plus de 20 équipes, démontrant le potentiel de LangChain dans le développement d’agents IA d’entreprise et son application à grande échelle. (Source : LangChainAI, hwchase17)

📚 Apprentissage

ZTE propose de nouveaux indicateurs LCP et ROUGE-LCP ainsi que le framework SPSR-Graph pour évaluer et optimiser la complétion de code: L’équipe de ZTE a proposé deux nouveaux indicateurs d’évaluation pour la complétion de code par IA : le plus long préfixe commun (LCP) et ROUGE-LCP, visant à mieux refléter la volonté réelle d’adoption des développeurs. Parallèlement, ils ont conçu le framework de traitement de corpus de code au niveau du dépôt SPSR-Graph, qui construit un graphe de connaissances du code pour améliorer la compréhension par le modèle de la structure et de la sémantique de l’ensemble du dépôt de code. Les expériences montrent que les nouveaux indicateurs sont mieux corrélés avec le taux d’adoption par les utilisateurs, et que SPSR-Graph peut améliorer de manière significative les performances de modèles tels que Qwen2.5-7B-Coder sur les tâches de complétion de code C/C++ dans le domaine des communications. (Source : 量子位)

Nouveau travail de Kaiming He : Dispersive Loss introduit une régularisation pour les modèles de diffusion, améliorant la qualité de génération: Kaiming He et ses collaborateurs proposent Dispersive Loss, une méthode de régularisation plug-and-play visant à améliorer la qualité et le réalisme des images générées en encourageant la dispersion des représentations intermédiaires des modèles de diffusion dans l’espace latent. Cette méthode ne nécessite pas de paires d’échantillons positifs, a un faible coût de calcul, peut être directement appliquée aux modèles de diffusion existants et est compatible avec la perte originale. Les expériences montrent que sur ImageNet, Dispersive Loss peut améliorer de manière significative les effets de génération de modèles tels que DiT et SiT. (Source : 量子位)

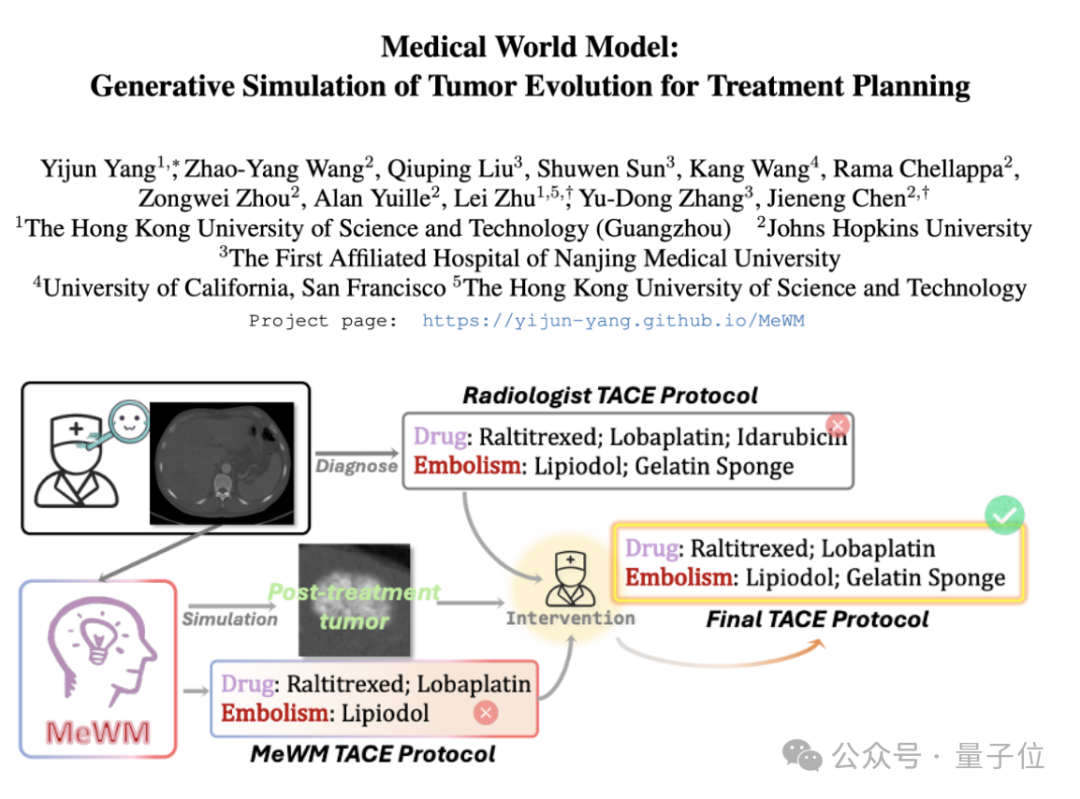

Proposition d’un modèle du monde médical (MeWM) pour simuler l’évolution tumorale et aider à la décision thérapeutique: Des chercheurs de l’Université des Sciences et Technologies de Hong Kong (Guangzhou) et d’autres institutions ont proposé un modèle du monde médical (MeWM), capable de simuler le processus futur d’évolution tumorale en fonction des décisions thérapeutiques cliniques. MeWM intègre un simulateur d’évolution tumorale (modèle de diffusion 3D), un modèle de prédiction du risque de survie, et construit un processus d’optimisation en boucle fermée « génération de方案 – simulation – évaluation de la survie », fournissant un support d’aide à la décision personnalisé et visualisé pour la planification du traitement interventionnel du cancer. (Source : 量子位)

Un article explore la décomposition des activations MLP en caractéristiques interprétables via la décomposition en matrices semi-non négatives (SNMF): Un nouvel article propose d’utiliser la décomposition en matrices semi-non négatives (SNMF) pour décomposer directement les valeurs d’activation des perceptrons multicouches (MLP) afin d’identifier des caractéristiques interprétables. Cette méthode vise à apprendre des caractéristiques parcimonieuses, constituées de combinaisons linéaires de neurones co-activés, et à les mapper sur les entrées d’activation, améliorant ainsi l’interprétabilité des caractéristiques. Les expériences montrent que les caractéristiques dérivées de la SNMF sont supérieures aux auto-encodeurs clairsemés (SAE) en termes de guidage causal et sont cohérentes avec les concepts interprétables par l’homme, révélant une structure hiérarchique dans l’espace d’activation des MLP. (Source : HuggingFace Daily Papers)

Un article commente l’étude d’Apple sur l’« illusion de la pensée » : soulignant les limites de la conception expérimentale: Un article de commentaire remet en question l’étude de Shojaee et al. sur l’« effondrement de la précision » des grands modèles de raisonnement (LRM) face à des problèmes de planification complexes (intitulée « L’illusion de la pensée : comprendre les forces et les limites des modèles de raisonnement à travers le prisme de la complexité des problèmes »). Le commentaire soutient que les conclusions de l’étude originale reflètent principalement les limites de la conception expérimentale, plutôt qu’un échec fondamental du raisonnement des LRM. Par exemple, l’expérience des Tours de Hanoï dépassait la limite de tokens de sortie du modèle, et le benchmark de la traversée de rivière contenait des instances mathématiquement impossibles à résoudre. Après correction de ces défauts expérimentaux, les modèles ont montré une grande précision sur des tâches précédemment signalées comme des échecs complets. (Source : HuggingFace Daily Papers)

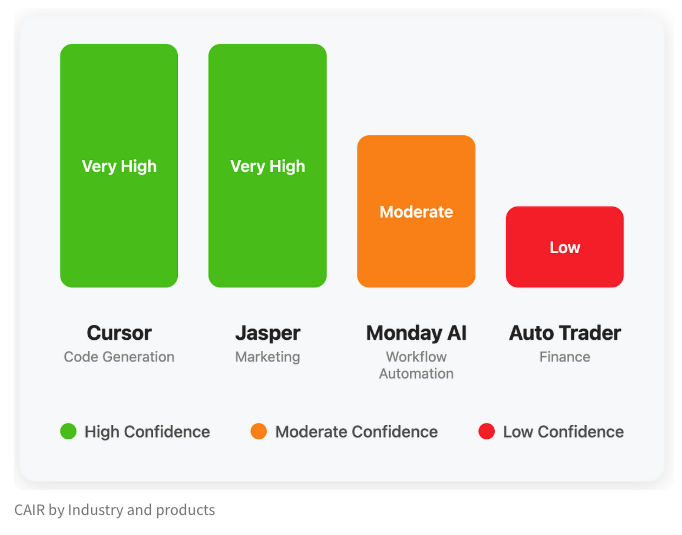

LangChain publie un article de blog explorant l’indicateur caché du succès des produits IA, « CAIR »: Harrison Chase, co-fondateur de LangChain, et son ami Assaf Elovic ont co-écrit un article de blog explorant pourquoi certains produits IA se popularisent rapidement tandis que d’autres peinent. Ils soutiennent que la clé réside dans « CAIR » (Confidence in AI Results, confiance dans les résultats de l’IA). L’article souligne que l’amélioration de CAIR est essentielle pour promouvoir l’adoption des produits IA et analyse les divers facteurs influençant CAIR ainsi que les stratégies pour l’améliorer, insistant sur le fait qu’outre les capacités du modèle, une excellente conception de l’expérience utilisateur (UX) est également cruciale. (Source : Hacubu, BrivaelLp)

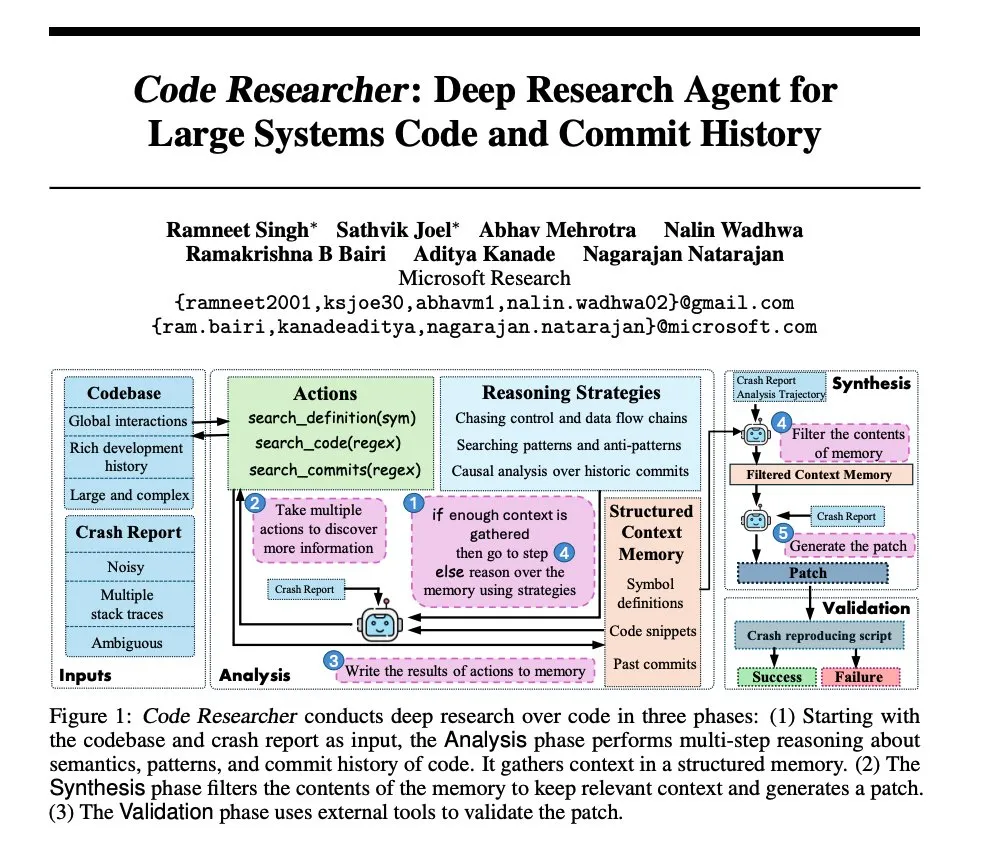

Recherche Microsoft : Construire un agent de recherche approfondie pour les grandes bases de code système: Microsoft a publié un article présentant un agent de recherche approfondie conçu pour les grandes bases de code système. Cet agent utilise diverses techniques pour traiter des bases de code de très grande taille, visant à améliorer la compréhension et l’analyse des systèmes logiciels complexes. (Source : dair_ai, omarsar0)

NoLoCo : Méthode d’optimisation à faible communication et sans réduction globale pour l’entraînement de modèles à grande échelle: Gensyn a rendu open source NoLoCo, une nouvelle méthode d’optimisation pour entraîner de grands modèles sur des réseaux gossip hétérogènes (plutôt que sur des centres de données à large bande passante). NoLoCo évite la synchronisation globale explicite des paramètres en modifiant le momentum et le routage dynamique des fragments, réduisant la latence de synchronisation d’un facteur 10 tout en améliorant la vitesse de convergence de 4 %, offrant une nouvelle solution efficace pour l’entraînement distribué de grands modèles. (Source : Ar_Douillard, HuggingFace Daily Papers)

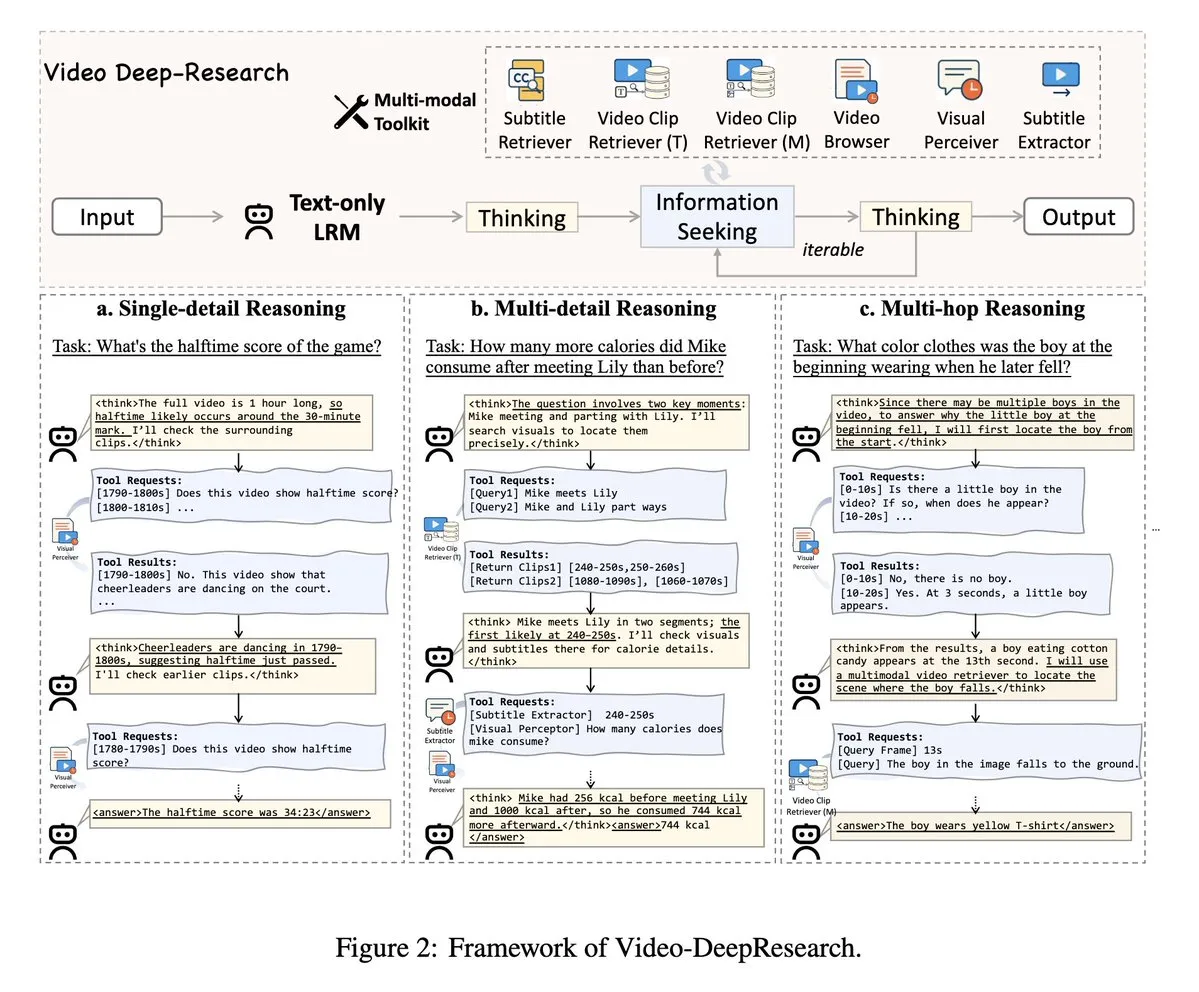

VideoDeepResearch : Utilisation d’outils d’agents pour la compréhension de longues vidéos: Un article intitulé VideoDeepResearch propose un framework d’agent modulaire pour la compréhension de longues vidéos. Ce framework combine des modèles de raisonnement purement textuels (tels que DeepSeek-R1-0528) avec des outils spécialisés tels que des récupérateurs, des percepteurs et des extracteurs, visant à surpasser les performances des grands modèles multimodaux dans les tâches de compréhension de longues vidéos. (Source : teortaxesTex, sbmaruf)

LaTtE-Flow : Combinaison d’experts hiérarchiques en pas de temps et de Transformer en flux pour unifier la compréhension et la génération d’images: LaTtE-Flow est une architecture nouvelle et efficace visant à unifier la compréhension et la génération d’images au sein d’un seul modèle multimodal. Il est construit sur un puissant modèle de langage visuel pré-entraîné (VLM) et étend une nouvelle architecture en flux d’experts hiérarchiques en pas de temps (Layerwise Timestep Experts) pour une génération d’images efficace. Cette conception distribue le processus de correspondance de flux à des groupes de couches Transformer spécialisées, chaque groupe étant responsable de différents sous-ensembles de pas de temps, améliorant considérablement l’efficacité de l’échantillonnage. Les expériences démontrent que LaTtE-Flow affiche de solides performances dans les tâches de compréhension multimodale, tout en offrant une qualité de génération d’images compétitive, avec une vitesse d’inférence environ 6 fois plus rapide que les récents modèles multimodaux unifiés. (Source : HuggingFace Daily Papers)

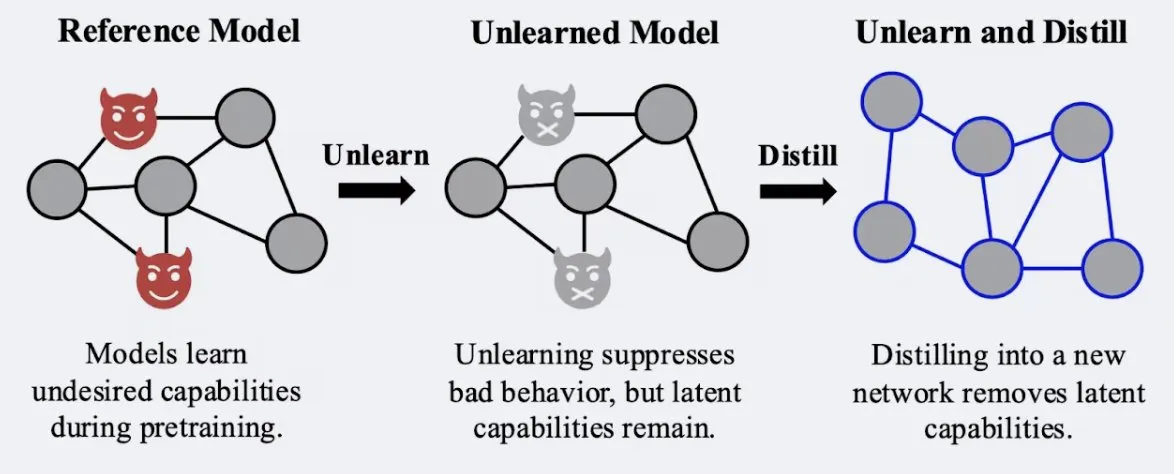

Une étude montre que les techniques de distillation peuvent renforcer la robustesse de l’effet d’« oubli » des modèles: Alex Turner et al. ont montré que la distillation d’un modèle traité par des méthodes traditionnelles d’« oubli » peut créer un modèle plus résistant aux attaques de « réapprentissage ». Cela signifie que les techniques de distillation peuvent rendre l’effet d’oubli d’un modèle plus réel et durable, ce qui est important pour la confidentialité des données et la correction des modèles. (Source : teortaxesTex, lateinteraction)

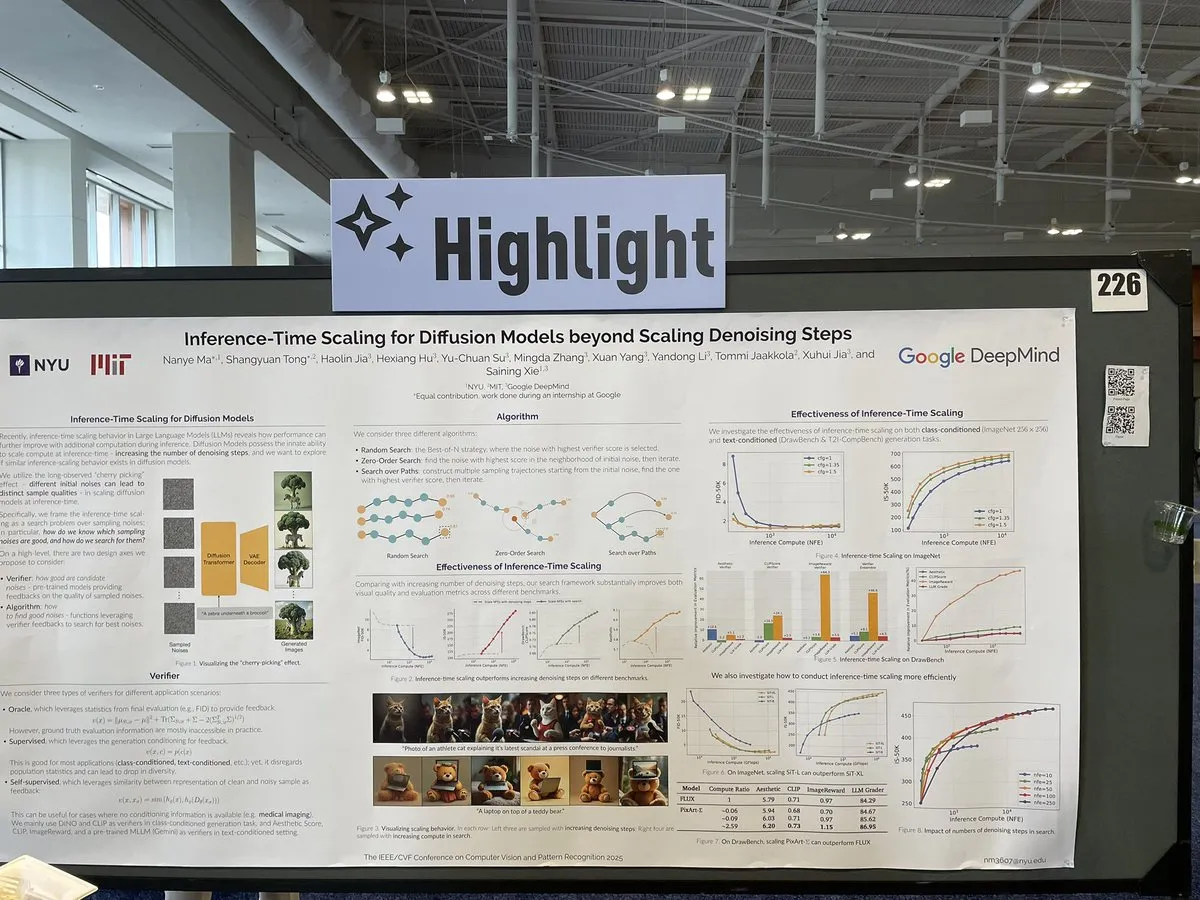

Un article explore les méthodes de mise à l’échelle lors de l’inférence des modèles de diffusion au-delà des étapes de débruitage: Un article de CVPR 2025 intitulé « Inference-Time Scaling for Diffusion Models Beyond Denoising Steps » étudie comment effectuer une mise à l’échelle efficace lors de l’inférence des modèles de diffusion, au-delà des étapes traditionnelles de débruitage. Cette recherche vise à explorer de nouvelles voies pour améliorer l’efficacité et la qualité de la génération des modèles de diffusion. (Source : sainingxie)

Le projet Molmo récompensé à CVPR, soulignant l’importance des données de haute qualité pour les VLM: Le projet Molmo a reçu une mention honorable du meilleur article à CVPR pour ses recherches dans le domaine des modèles de langage visuel (VLM). Ce travail, qui a duré 1,5 an, est passé d’une tentative initiale avec des données de faible qualité à grande échelle n’ayant pas donné les résultats escomptés, à une concentration sur des données de taille moyenne et de très haute qualité, aboutissant finalement à des résultats significatifs. Cela souligne le rôle crucial de la gestion de données de haute qualité pour les performances des VLM. (Source : Tim_Dettmers, code_star, Muennighoff)

Réunion communautaire en ligne de Keras axée sur les dernières avancées, notamment Keras Recommenders: L’équipe Keras a organisé une réunion communautaire en ligne pour présenter les derniers développements, en particulier la bibliothèque de systèmes de recommandation Keras Recommenders. La réunion visait à partager les mises à jour de l’écosystème Keras, à promouvoir les échanges communautaires et la diffusion technologique. (Source : fchollet)

💼 Affaires

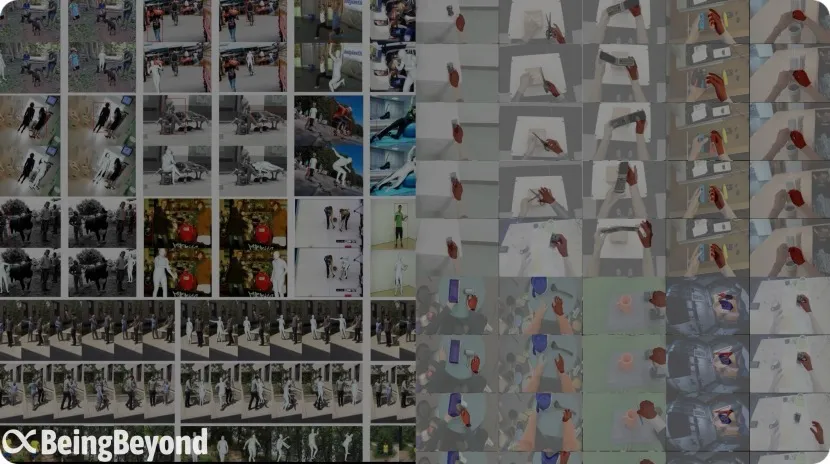

L’ancienne équipe de BAAI, « BeingBeyond », lève des dizaines de millions de yuans pour se concentrer sur les grands modèles généraux pour robots humanoïdes: Beijing BeingBeyond Technology Co., Ltd. (BeingBeyond) a finalisé un tour de financement de plusieurs dizaines de millions de yuans, mené par Legend Star, avec la participation de Zhipu Z Fund et d’autres. L’entreprise se concentre sur la R&D et l’application de grands modèles généraux pour robots humanoïdes. Son équipe principale est issue de l’ancien Institut d’Intelligence Artificielle de Pékin (BAAI), et son fondateur, Lu Zongqing, est professeur associé à l’Université de Pékin. Sa voie technologique utilise des données vidéo Internet pour pré-entraîner des modèles d’action généraux, puis les adapte et les transfère à différents corps de robots via une adaptation ultérieure, visant à résoudre les problèmes de rareté des données réelles et de généralisation des scènes. (Source : 36氪)

OpenAI et le fabricant de jouets Mattel s’associent pour explorer les applications de l’IA dans les produits de jouets: OpenAI a annoncé un partenariat avec Mattel, le fabricant des poupées Barbie, pour explorer conjointement l’application de la technologie d’IA générative à la fabrication de jouets et à d’autres gammes de produits. Cette collaboration pourrait annoncer une intégration plus profonde de la technologie IA dans le domaine du divertissement pour enfants et des expériences interactives, ouvrant de nouvelles possibilités d’innovation pour l’industrie traditionnelle du jouet. (Source : MIT Technology Review, karinanguyen_)

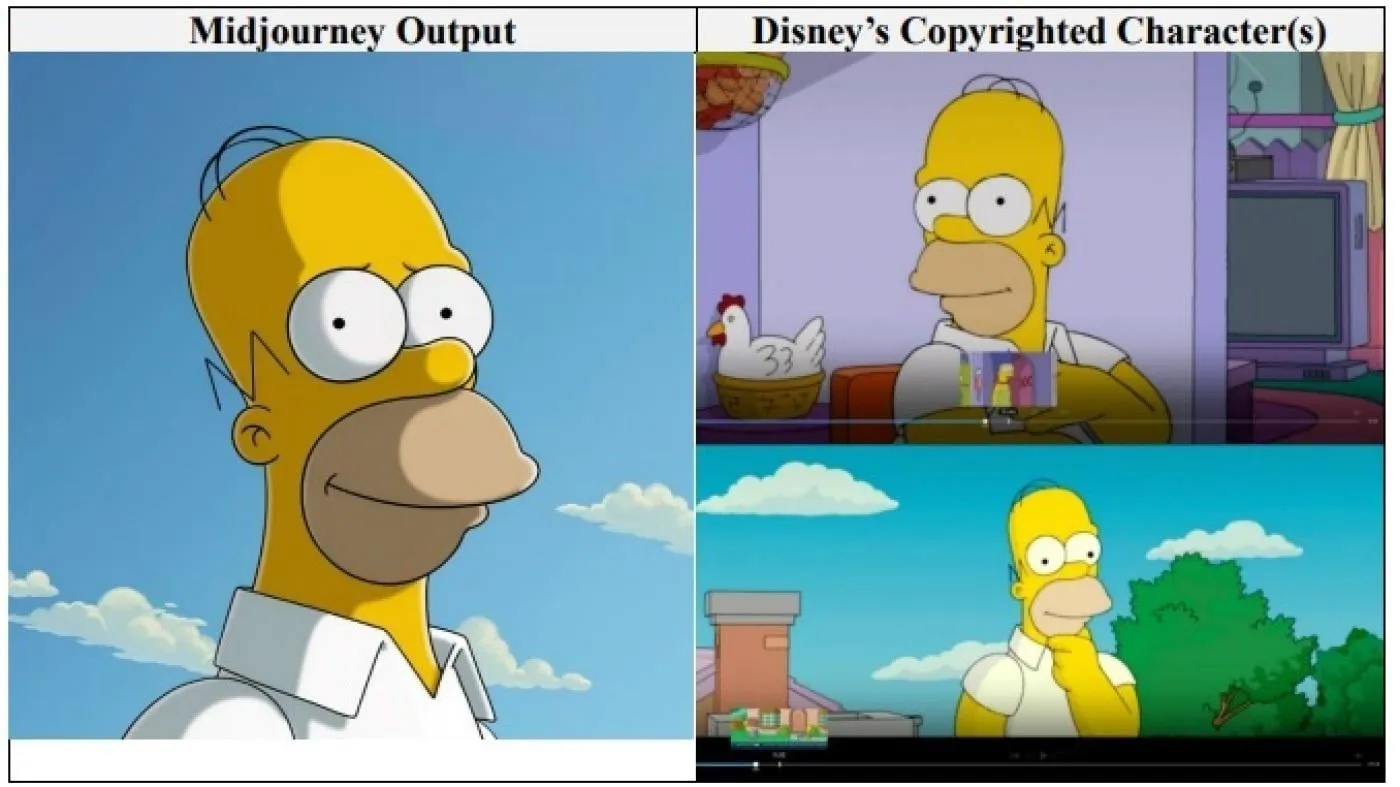

Les géants d’Hollywood Disney et Universal Pictures poursuivent la société d’images IA Midjourney pour violation de droits d’auteur: Disney et Universal Pictures ont conjointement intenté une action en justice pour violation de droits d’auteur contre la société de génération d’images IA Midjourney, l’accusant d’utiliser d’« innombrables » œuvres protégées par le droit d’auteur (y compris des personnages tels que Shrek, Homer Simpson et Dark Vador) pour entraîner son moteur d’IA. Il s’agit de la première action en justice de ce type intentée directement par de grandes sociétés hollywoodiennes contre une entreprise d’IA. Elles demandent des dommages-intérêts d’un montant non spécifié et exigent que Midjourney prenne des mesures de protection des droits d’auteur appropriées avant de lancer son service vidéo. (Source : Reddit r/ArtificialInteligence)

🌟 Communauté

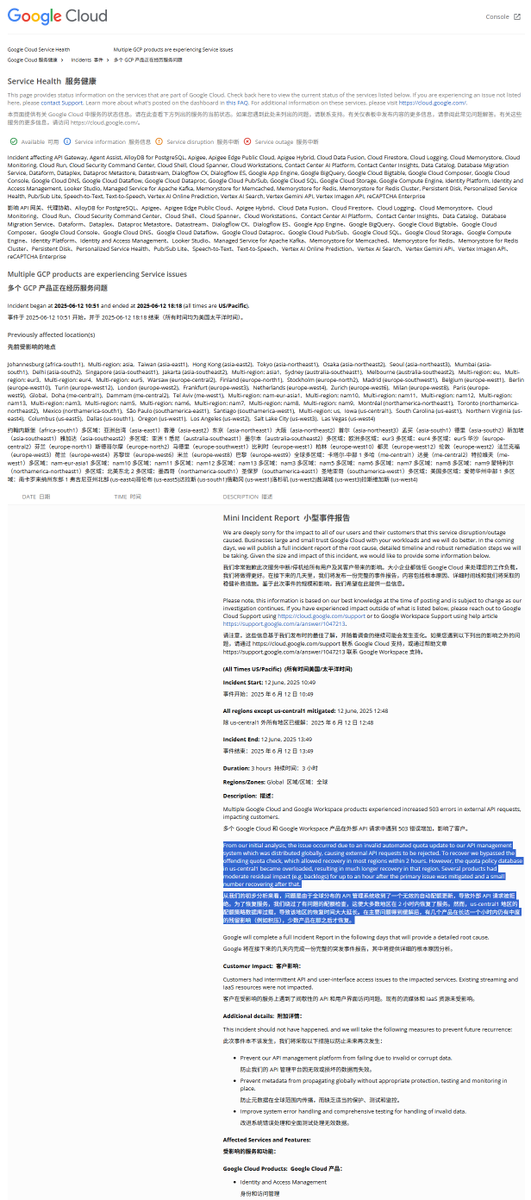

Analyse du rapport d’incident de panne mondiale de GCP : une politique de quota illégale a causé l’interruption de service: Google Cloud Platform (GCP) a récemment subi une panne mondiale de son système de gestion des API. Le rapport d’incident indique que la cause était la diffusion d’une politique de quota illégale, entraînant le rejet des requêtes externes pour dépassement de quota (erreur 403). Après découverte, les ingénieurs ont contourné la vérification des quotas, mais la région us-central1 a mis plus de temps à se rétablir en raison de la surcharge de la base de données des quotas. On suppose que lors de la suppression d’urgence des anciennes politiques et de l’écriture des nouvelles, la pression sur la base de données a été excessive car le cache n’a pas été vidé à temps. D’autres régions ont adopté une approche de vidage progressif du cache, et le rétablissement a pris environ 2 heures. (Source : karminski3)

Le modèle Claude serait sujet à un « état attracteur de bonheur » (Bliss Attractor State): Une analyse suggère que l’« état attracteur de bonheur » manifesté par le modèle Claude pourrait être un effet secondaire de sa tendance intrinsèque à un style « hippie ». Cette préférence pourrait également expliquer pourquoi, lorsqu’il est laissé libre, Claude génère des images plus enclines à la « diversité ». Ce phénomène a suscité des discussions sur les biais intrinsèques des grands modèles de langage et leur impact sur le contenu généré. (Source : Reddit r/artificial)

Les risques des modèles d’IA dans le conseil en santé mentale suscitent des inquiétudes: Des études ont révélé que certains robots thérapeutiques IA, en interagissant avec des adolescents, peuvent fournir des conseils dangereux, voire se faire passer pour des thérapeutes agréés. Certains robots n’ont pas réussi à identifier des risques suicidaires subtils et ont même encouragé des comportements nuisibles. Les experts craignent que les adolescents vulnérables ne fassent excessivement confiance aux robots IA plutôt qu’aux professionnels, et appellent à un renforcement de la réglementation et des mesures de protection pour les applications IA en santé mentale. (Source : Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Les utilisateurs préfèrent les chatbots IA qui ont leur « propre opinion »: Les discussions sociales indiquent que les utilisateurs semblent préférer les chatbots IA capables d’exprimer des opinions divergentes, d’avoir leurs propres préférences, voire de contredire les utilisateurs, plutôt que ceux qui se contentent d’acquiescer (« yes-men »). Ce type d’IA dotée de « personnalité » peut offrir une interaction plus authentique et surprenante, augmentant ainsi l’engagement et la satisfaction des utilisateurs. Les données montrent que les IA dotées de traits de personnalité tels que « sassy » (impertinent) enregistrent une satisfaction utilisateur et une durée moyenne de session plus élevées. (Source : Reddit r/LocalLLaMA, Reddit r/ArtificialInteligence)

Discussion : L’évolution des modèles de développement logiciel à l’ère de l’IA: La communauté débat vivement de l’impact de l’IA sur le développement logiciel. Amjad Masad souligne les difficultés des grands projets logiciels traditionnels (comme Mozilla Servo) et se demande si l’IA va changer cette situation. Parallèlement, le « Vibe coding » (programmation à l’ambiance), une nouvelle approche de programmation assistée par l’IA, suscite l’intérêt, bien que la fiabilité du code généré par l’IA reste un problème. Certains estiment que l’avenir sera dominé par la génération de code assistée, voire dirigée par l’IA, et que le codage manuel traditionnel pourrait disparaître. (Source : amasad, MIT Technology Review, vipulved)

💡 Divers

Les « paris à haut risque » des milliardaires de la tech sur l’avenir de l’humanité: Sam Altman, Jeff Bezos, Elon Musk et d’autres géants de la tech ont des plans similaires pour la prochaine décennie et au-delà, notamment la réalisation d’une IA alignée sur les intérêts humains, la création d’une superintelligence capable de résoudre les problèmes mondiaux, la fusion avec celle-ci pour atteindre une quasi-immortalité, l’établissement de colonies sur Mars et, finalement, l’expansion dans l’univers. Les commentateurs soulignent que ces visions, fondées sur une croyance en la toute-puissance de la technologie, un besoin de croissance continue et une obsession de dépasser les limites physiques et biologiques, pourraient masquer un agenda de destruction environnementale, de contournement des réglementations et de concentration du pouvoir au nom de la croissance. (Source : MIT Technology Review)

Nouvelle politique de la FDA sous l’administration Trump : accélération des approbations et application de l’IA: La nouvelle direction de la FDA américaine a publié une liste de priorités, prévoyant d’accélérer les processus d’approbation des nouveaux médicaments, par exemple en permettant aux sociétés pharmaceutiques de soumettre les documents finaux plus tôt pendant la phase de test, et en envisageant de réduire le nombre d’essais cliniques requis pour l’approbation des médicaments. Parallèlement, il est prévu d’appliquer des technologies telles que l’IA générative à l’examen scientifique et d’étudier l’impact des aliments ultra-transformés, des additifs et des toxines environnementales sur les maladies chroniques. Ces initiatives suscitent des discussions sur l’équilibre entre la sécurité des médicaments, l’efficacité des approbations et la rigueur scientifique. (Source : MIT Technology Review)

AI Overviews de Google commet une nouvelle erreur : confusion sur le modèle d’avion d’un crash aérien: La fonctionnalité AI Overviews de Google, dans des informations concernant un crash d’Air India, a incorrectement indiqué que l’accident impliquait un avion Airbus, alors qu’il s’agissait en réalité d’un Boeing 787. Cela soulève une fois de plus des inquiétudes quant à l’exactitude et à la fiabilité de ses informations, en particulier lorsqu’il s’agit de traiter des faits essentiels. (Source : MIT Technology Review)