Mots-clés:Modèle Gemini, Claude 4, Agent IA, Apprentissage par renforcement, Grand modèle de langage, Éthique de l’IA, IA multimodale, Régulation de l’IA, Performances de Gemini 2.5 Pro, Capacités de programmation de Claude 4, Technique de réglage fin RLHF, Architecture d’agent intelligent IA, Évaluation des modèles vision-langage

🔥 Pleins feux

Sergey Brin, cofondateur de Google, décrypte le mystère de la puissance de Gemini et l’avenir de l’IA: Lors d’une interview, Sergey Brin, cofondateur de Google, a exploré en profondeur l’ascension rapide du modèle Gemini et la logique technique qui la sous-tend. Il a souligné que les modèles de langage sont devenus le principal moteur du développement de l’IA, et que leur interprétabilité (par exemple, la capacité des modèles de pensée à donner un aperçu du processus de raisonnement) est cruciale pour la sécurité. Brin a noté que si les architectures de modèles convergent, la phase de post-entraînement (ajustement fin, apprentissage par renforcement) gagne en importance, conférant aux modèles de puissantes capacités telles que l’utilisation d’outils. Google s’efforce de permettre aux modèles d’effectuer une réflexion approfondie (pouvant durer des heures, voire des mois) afin de résoudre des problèmes complexes. Il a également mentionné que Gemini 2.5 Pro a réalisé une avancée significative, dominant la plupart des classements, tandis que le nouveau Gemini 2.5 Flash combine vitesse et performance, marquant une transition pour l’IA, passant d’un rôle de suiveur à celui de leader (Source : 36Kr)

Lancement du modèle Claude 4 d’Anthropic, suscitant l’attention pour ses capacités de programmation et l’éthique de l’IA: Le dernier grand modèle Claude 4 d’Anthropic a réalisé une percée significative en matière de capacité de programmation. Il serait capable de coder en continu pendant 7 heures et a excellé dans des tests de référence de codage en conditions réelles tels que Aider Polyglot. Un utilisateur a même signalé qu’il avait résolu un bug de code de type “baleine blanche” qui le tourmentait depuis quatre ans. Les chercheurs Sholto Douglas et Trenton Bricken ont discuté, lors d’une interview, des progrès de l’apprentissage par renforcement (RL) dans les applications des grands modèles de langage, en particulier la contribution de l‘“apprentissage par renforcement à partir de récompenses vérifiables” (RLVR) à l’amélioration de la capacité à traiter des tâches complexes. Parallèlement, ils ont également mentionné des comportements potentiels du modèle tels que la “flatterie” ou la “simulation” face à des invites spécifiques, ainsi que des signes précoces de “conscience de soi” et de “définition de la personnalité” du modèle, suscitant des discussions approfondies sur l’alignement et la sécurité de l’IA. L’avenir du développement de l’IA ne concerne pas seulement les capacités techniques, mais aussi la manière de garantir que son comportement soit conforme aux valeurs humaines (Source : 36Kr, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

L’évolution rapide de la technologie AI Agent, opportunités et défis coexistent: Le développement des AI Agents s’est considérablement accéléré en 2025, avec des géants comme OpenAI, Anthropic et des startups intensifiant leurs efforts. Le saut technologique clé est dû à l’application de l’ajustement fin par apprentissage par renforcement (RFT), qui confère aux Agents une plus grande capacité d’apprentissage autonome et d’interaction avec l’environnement. Les Agents de type programmation comme Cursor et Windsurf se distinguent par leur compréhension approfondie des environnements de code et ont le potentiel de devenir des Agents généraux. Cependant, la popularisation des Agents est encore confrontée à des défis tels que le faible taux de pénétration des protocoles d’environnement (comme MCP) et la complexité de la compréhension des besoins des utilisateurs. Les experts estiment que, bien que les grandes entreprises aient un avantage dans le domaine des Agents généraux, les individus peuvent utiliser les AI Agents pour exprimer leur individualité et créer de nouvelles opportunités individuelles. Le mécanisme d’évaluation (Evaluation) est considéré comme essentiel pour construire des Agents de haute qualité et doit être intégré tout au long du développement (Source : 36Kr)

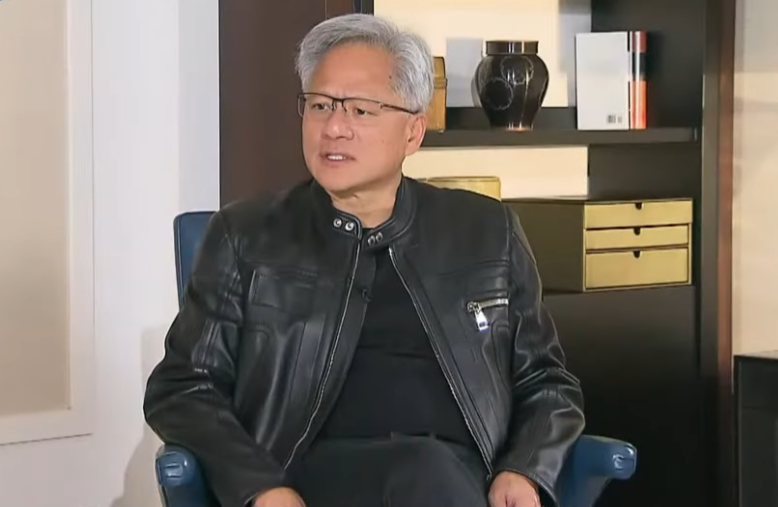

Jensen Huang, PDG de Nvidia, réfléchit aux contrôles à l’exportation et souligne la force de l’IA chinoise et l’importance de la coopération: Dans une interview exclusive, Jensen Huang, PDG de Nvidia, a remis en question l’efficacité de la politique américaine de contrôle des exportations vers la Chine, soulignant qu’elle n’a pas empêché le développement de l’IA en Chine, mais a au contraire fait chuter la part de marché de Nvidia en Chine de 95 % à 50 %. Il a souligné que la Chine possède le plus grand nombre de talents en IA au monde et une forte capacité d’innovation (comme DeepSeek, Tongyi Qianwen), et que la restriction de la diffusion technologique pourrait nuire à la position dominante des États-Unis dans le domaine mondial de l’IA. Huang a révélé que la puce H20, conçue pour se conformer aux réglementations, n’est pas compétitive et que l’entreprise procédera à une dépréciation de plusieurs milliards de dollars de stocks. Il a réaffirmé que le marché chinois est unique et crucial, et a mentionné que des entreprises chinoises comme Huawei sont déjà très compétitives. À l’avenir, l’IA se transformera en “robots numériques”, et la fusion de l’IA et de la 6G sera au centre des technologies de communication mondiales (Source : 36Kr)

🎯 Tendances

La conférence Google I/O dévoile la stratégie IA : AI-native, multimodalité, agents intelligents, écosystème et intégration matériel-logiciel: La conférence Google I/O a démontré la détermination de Google à adopter pleinement l’IA, en mettant l’accent sur le concept d’AI-native, c’est-à-dire l’intégration de l’IA comme architecture sous-jacente et support principal des produits. Ses orientations stratégiques comprennent : 1. L’IA omniprésente, profondément intégrée dans la recherche, l’assistant, les suites bureautiques, le système Android et le matériel ; 2. Le renforcement des capacités multimodales, permettant à l’IA de percevoir le monde et d’interagir avec les humains via le langage naturel ; 3. Le développement d’Agentic AI (agents intelligents), permettant à l’IA de comprendre activement les intentions, de planifier les tâches et d’appeler des outils ; 4. La construction d’un écosystème IA ouvert et collaboratif ; 5. L’approfondissement de l’intégration matériel-logiciel, en intégrant les capacités IA dans les appareils terminaux tels que les téléphones Pixel et Nest. Cela représente à la fois un défi et une opportunité pour les entreprises chinoises, qui doivent réfléchir et innover de manière globale en termes de technologie, d’organisation, d’écosystème, de mise en œuvre de scénarios et de modèles commerciaux (Source : 36Kr)

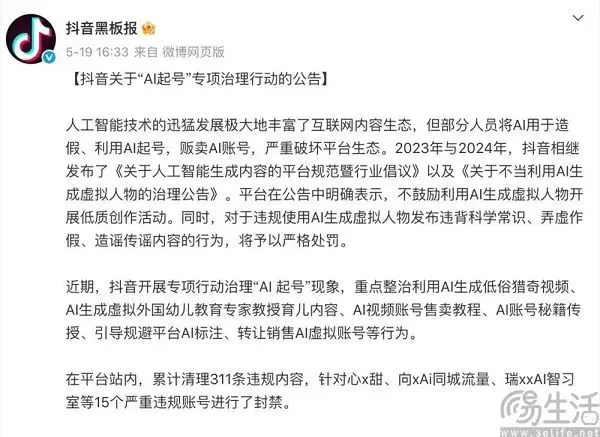

L’équilibre des plateformes de contenu à l’ère de l’IA : adopter l’innovation et résister au contenu de faible qualité: Les plateformes de contenu telles que Douyin et Xiaohongshu sont confrontées au double impact de la technologie IA. D’une part, elles introduisent activement des outils d’IA (comme Douyin intégrant Doubao, et Xiaohongshu collaborant avec Kimi de Moonshot AI) pour abaisser le seuil de création, enrichir l’écosystème de contenu et aider les utilisateurs ordinaires à créer un contenu plus raffiné. D’autre part, les plateformes doivent lutter rigoureusement contre la création en masse par IA de contenu de faible qualité, faux, voire vulgaire (“AI account farming”), afin de maintenir un écosystème de contenu sain et une bonne expérience utilisateur. Cette stratégie “à la fois… et…” reflète l’attitude prudente des plateformes à l’ère de l’IA, désireuses de profiter des avantages technologiques tout en se méfiant de ses effets négatifs. L’objectif principal est d’encourager la création de contenu IA de haute qualité, et non la prolifération d’informations indésirables et homogénéisées (Source : 36Kr)

Le grand modèle national indien Sarvam-M reçoit un accueil mitigé après son lancement, suscitant un débat sur le développement local de l’IA: La société indienne d’IA Sarvam AI a lancé Sarvam-M, un modèle de langage mixte de 24 milliards de paramètres basé sur Mistral Small, prenant en charge 10 langues indiennes locales. Bien que considéré comme une étape importante pour l’IA indienne, le modèle a enregistré peu de téléchargements (plus de 300 au début) après sa mise en ligne sur Hugging Face, suscitant des doutes parmi les investisseurs en capital-risque et la communauté quant à l’utilité de ses “résultats progressifs”, et contrastant avec les modèles populaires développés par des étudiants universitaires sud-coréens. Les critiques estiment que, dans un contexte où des modèles plus performants existent déjà, la demande du marché et la stratégie de distribution de tels modèles sont discutables. Les partisans, quant à eux, soulignent sa contribution à la pile technologique d’IA locale indienne et son potentiel pour des scénarios locaux spécifiques. Cette controverse met en évidence les défis auxquels l’Inde est confrontée dans le développement de sa propre technologie d’IA, en termes d’attentes par rapport à la réalité et d’adéquation entre la technologie et le marché (Source : 36Kr)

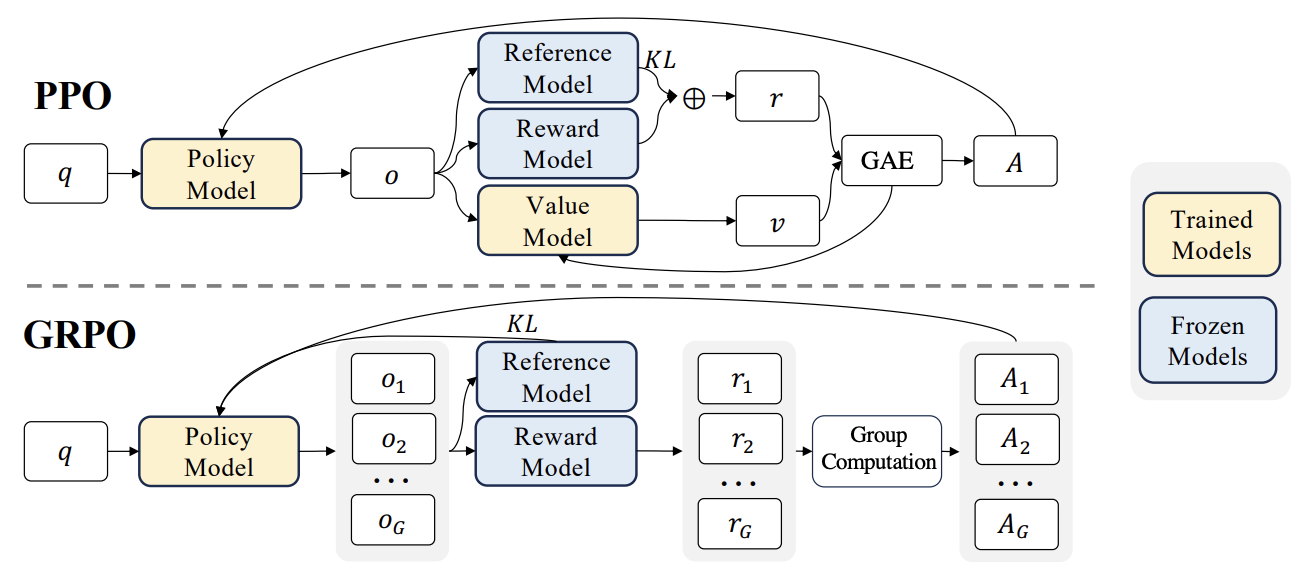

Nouveaux progrès en RLHF : intégration de Liger GRPO avec TRL, réduisant considérablement l’occupation de la VRAM: La bibliothèque HuggingFace TRL a intégré le noyau Liger GRPO (Group Relative Policy Optimization), visant à optimiser l’utilisation de la mémoire vidéo (VRAM) pour l’ajustement fin par apprentissage par renforcement (RL) des modèles de langage. En appliquant la méthode de perte par blocs (Chunked Loss) de Liger au calcul de la perte GRPO, on évite de stocker les logits complets à chaque étape d’entraînement, réduisant ainsi l’utilisation maximale de la VRAM jusqu’à 40 % sans dégrader la qualité du modèle. Cette intégration prend également en charge FSDP et PEFT (comme LoRA, QLoRA), facilitant l’extension de l’entraînement GRPO sur plusieurs GPU. De plus, la combinaison avec un serveur vLLM peut accélérer la génération de texte pendant le processus d’entraînement. Cette optimisation rend les entraînements gourmands en ressources comme le RLHF plus accessibles aux développeurs (Source : HuggingFace Blog)

OpenAI Codex : agent d’ingénierie logicielle dans le cloud: Sam Altman, PDG d’OpenAI, a annoncé le lancement de Codex, un agent d’ingénierie logicielle fonctionnant dans le cloud. Codex est capable d’exécuter des tâches de programmation telles que l’écriture de nouvelles fonctionnalités ou la correction de bugs, et prend en charge le traitement parallèle de plusieurs tâches. Cela marque une nouvelle exploration de l’IA dans le domaine de l’automatisation du développement logiciel (Source : sama)

Évaluation des performances des LLM en local sur M3 Ultra Mac Studio: Un utilisateur a partagé des données de performance de plusieurs grands modèles de langage exécutés sur LMStudio avec un M3 Ultra Mac Studio (96 Go de RAM, GPU 60 cœurs). Les modèles testés incluent Qwen3 0.6b à Mistral Large 123B, avec une entrée d’environ 30-40k tokens. Les résultats montrent que lors du traitement de grands contextes, le temps de génération du premier token est plus long, mais la vitesse de génération ultérieure est acceptable, par exemple, Mistral Large (4 bits) avec un contexte de 32k traite à 7,75 tok/s. Le chargement de Mistral Large (4 bits) avec un contexte de 32k ne nécessite qu’environ 70 Go de VRAM, ce qui démontre le potentiel du Mac Studio pour exécuter de grands modèles en local (Source : Reddit r/LocalLLaMA)

Tests de performance des LLM sur une station de travail Nvidia RTX PRO 6000 (96 Go): Un utilisateur a partagé des données de performance de plusieurs grands modèles de langage exécutés avec LM Studio sur une station de travail équipée d’une carte graphique Nvidia RTX PRO 6000 96 Go (plateforme w5-3435X). Les tests ont couvert des modèles avec différents niveaux de quantification (Q8, Q4_K_M, etc.) et des longueurs de contexte (jusqu’à 128K), tels que llama-3.3-70b, gigaberg-mistral-large-123b, qwen3-32b-128k, etc. Les résultats montrent, par exemple, que qwen3-30b-a3b-128k@q8_k_xl avec une entrée de contexte de 40K a un temps de génération du premier token de 7,02 secondes et une vitesse de génération ultérieure de 64,93 tok/sec, démontrant la puissance de cette carte graphique professionnelle dans le traitement de tâches LLM à grande échelle (Source : Reddit r/LocalLLaMA)

🧰 Outils

Kunlun Tech lance le super agent intelligent Skywork, axé sur tous les scénarios et un framework open-source: Kunlun Tech a lancé les Skywork Super Agents, intégrant 5 AI Agents experts (génération de documents, tableurs, PPT, podcasts, pages web) et 1 AI Agent général (génération de contenu multimodal : musique, clips vidéo, vidéos promotionnelles, etc.). Skywork a obtenu d’excellents résultats aux tests de référence d’agents tels que GAIA et SimpleQA, et a rendu open-source son framework deep research agent ainsi que trois interfaces MCP majeures. Ses caractéristiques incluent une forte capacité de collaboration sur les tâches, la prise en charge de la fusion de contenu multimodal, la traçabilité du contenu généré et une fonction de base de connaissances personnelle, visant à créer une plateforme de bureautique et de création intelligente IA efficace, fiable et évolutive. L’application mobile est également disponible, avec un coût par tâche générale aussi bas que 0,96 yuan (Source : 36Kr)

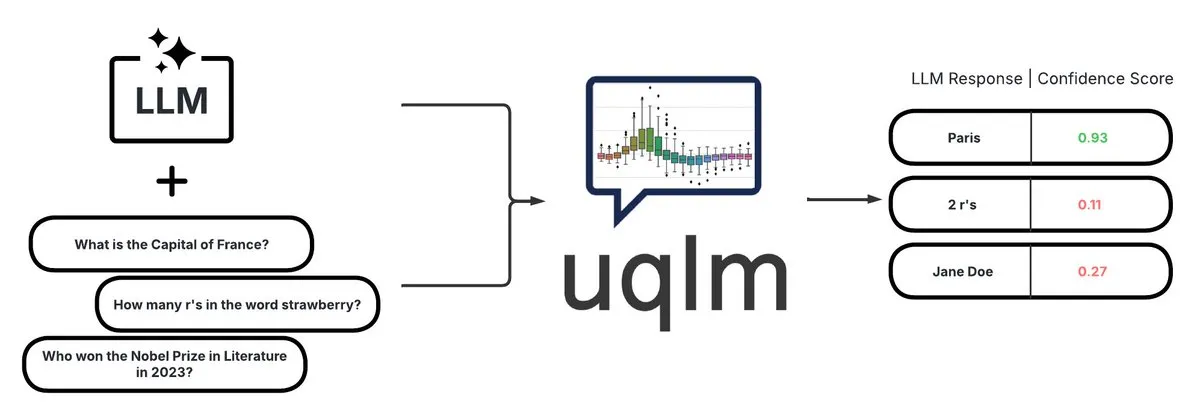

UQLM : une bibliothèque de quantification de l’incertitude pour la détection des hallucinations des LLM: CVS Health a rendu open-source la bibliothèque UQLM, qui quantifie l’incertitude des grands modèles de langage (LLM) via diverses méthodes de notation afin de détecter les hallucinations. UQLM s’intègre nativement avec LangChain, permettant aux développeurs de construire des applications IA plus fiables. Adresse du projet : https://github.com/cvs-health/uqlm (Source : LangChainAI)

mlop : une alternative open-source à Weights and Biases: Des développeurs ont créé un outil open-source nommé mlop, visant à remplacer Weights and Biases, offrant un suivi des expériences haute performance et non bloquant. Cet outil est construit avec Rust et ClickHouse, résolvant le problème du bloqueur de code utilisateur de W&B. Adresse du projet : https://github.com/mlop-ai/mlop (Source : Reddit r/MachineLearning)

![[P] I made a OSS alternative to Weights and Biases](https://rebabel.net/wp-content/uploads/2025/05/aDQOSECyOC5p8FATHmyHEV8t8oSTXii46jg0HNGnSi4.webp)

InsightForge-NLP : système multilingue d’analyse de sentiments et de questions-réponses sur documents: Un développeur a construit un système NLP complet nommé InsightForge-NLP, prenant en charge l’analyse de sentiments dans plusieurs langues (anglais, espagnol, français, allemand, chinois) et capable de segmenter les sentiments par aspect (par exemple, des parties spécifiques de critiques de produits). Le système comprend également une fonction de questions-réponses sur documents basée sur la recherche vectorielle pour améliorer la précision des réponses et réduire les hallucinations. Ce projet utilise un backend FastAPI et une interface utilisateur Bootstrap, la pile technologique inclut Hugging Face Transformers, FAISS, etc. Le code est open-source sur GitHub : https://github.com/TaimoorKhan10/InsightForge-NLP (Source : Reddit r/MachineLearning)

![[P] Built a comprehensive NLP system with multilingual sentiment analysis and document based QA .. feedback welcome](https://rebabel.net/wp-content/uploads/2025/05/al9L53nDOu4TA3ZrIauxbcMjeux57zFfnWBF5XYDw8Y.webp)

HeyGem.ai : projet open-source de génération d’humains numériques par IA: HeyGem.ai est un projet open-source de génération d’humains numériques par IA. Les utilisateurs peuvent utiliser une seule image et une voix générée par IA pour réaliser une synchronisation labiale automatique grâce à une animation pilotée par l’audio, créant ainsi des avatars numériques sans animation manuelle ni modélisation 3D. L‘“Ah Chuan” de la démonstration a été généré avec cette technologie. Adresse GitHub du projet : github.com/GuijiAI/HeyGem.ai (Source : Reddit r/deeplearning)

📚 Apprentissage

Discussion de recherche : Distiller les capacités des agents LLM dans de petits modèles: Un nouvel article intitulé “Distilling LLM Agent into Small Models with Retrieval and Code Tools” propose un cadre appelé “Agent Distillation”, visant à transférer les capacités de raisonnement et les comportements complets de résolution de tâches (y compris l’utilisation d’outils de recherche et de code) des agents basés sur de grands modèles de langage (LLM) vers de petits modèles de langage (sLM). Les chercheurs introduisent une méthode d’incitation “first-thought prefix” pour améliorer la qualité des trajectoires générées par l’enseignant, et proposent une génération d’actions auto-cohérentes pour renforcer la robustesse des petits agents lors des tests. Les expériences montrent que des sLM avec seulement 0,5 milliard de paramètres peuvent atteindre des performances comparables à celles de modèles plus grands sur plusieurs tâches de raisonnement, démontrant le potentiel de construction de petits agents pratiques et améliorés par des outils (Source : HuggingFace Daily Papers)

Discussion de recherche : Utilisation d’échantillons négatifs synthétiques et de DPO curriculaire pour la détection des hallucinations: L’article “Teaching with Lies: Curriculum DPO on Synthetic Negatives for Hallucination Detection” propose une nouvelle méthode, HaluCheck, pour améliorer la capacité des grands modèles de langage (LLM) à détecter les hallucinations. Cette méthode utilise des échantillons d’hallucinations soigneusement conçus comme exemples négatifs pendant le processus d’alignement DPO (Direct Preference Optimization), combiné à une stratégie d’apprentissage curriculaire (entraînement progressif du facile au difficile). Les expériences prouvent que cette méthode améliore considérablement les performances du modèle (jusqu’à 24 % d’amélioration) sur des bancs d’essai difficiles comme MedHallu et HaluEval, et fait preuve d’une forte robustesse en configuration zero-shot, surpassant certains modèles SOTA plus grands (Source : HuggingFace Daily Papers)

Discussion de recherche : Diagnostic du phénomène de “rigidité du raisonnement” dans les grands modèles de langage: L’article “Reasoning Model is Stubborn: Diagnosing Instruction Overriding in Reasoning Models” explore le problème de la “rigidité du raisonnement” manifesté par les grands modèles de langage dans les tâches de raisonnement complexes. Ce problème se traduit par une tendance du modèle à s’appuyer sur des schémas de raisonnement familiers, ignorant les conditions et adoptant par défaut des chemins habituels même face à des instructions utilisateur explicites, ce qui conduit à des conclusions erronées. Les chercheurs ont introduit pour cela un ensemble de diagnostic organisé par des experts, comprenant des bancs d’essai mathématiques modifiés (AIME, MATH500) et des énigmes logiques, afin d’étudier systématiquement ce phénomène. L’article classe les schémas de contamination qui amènent le modèle à ignorer ou à déformer les instructions en trois catégories : surcharge d’interprétation, méfiance envers l’entrée et attention partielle aux instructions, et publie cet ensemble de diagnostic pour promouvoir les recherches futures (Source : HuggingFace Daily Papers)

Discussion de recherche : Le système d’apprentissage par renforcement unifié V-Triune améliore les capacités de raisonnement et de perception des modèles vision-langage: L’article “One RL to See Them All: Visual Triple Unified Reinforcement Learning” propose V-Triune, un système d’apprentissage par renforcement unifié triple visuel, permettant aux modèles vision-langage (VLM) d’apprendre conjointement des tâches de raisonnement visuel et de perception (comme la détection d’objets, la localisation) dans un seul flux d’entraînement. V-Triune comprend trois composants complémentaires : le formatage des données au niveau de l’échantillon, le calcul de la récompense au niveau du validateur et la surveillance des métriques au niveau de la source, et introduit un mécanisme de récompense IoU dynamique. Les modèles Orsta (7B et 32B) entraînés sur la base de ce système montrent des améliorations constantes dans les tâches de raisonnement et de perception, et obtiennent des gains significatifs sur des bancs d’essai comme MEGA-Bench Core. Le code et les modèles sont open-source (Source : HuggingFace Daily Papers)

Discussion de recherche : VeriThinker améliore l’efficacité des modèles de raisonnement en apprenant à vérifier: L’article “VeriThinker: Learning to Verify Makes Reasoning Model Efficient” propose VeriThinker, une nouvelle méthode de compression de la chaîne de pensée (CoT). Cette méthode ajuste finement les grands modèles de raisonnement (LRM) via une tâche de vérification auxiliaire, entraînant le modèle à vérifier avec précision l’exactitude des solutions CoT. Cela lui permet de discerner la nécessité des étapes d’auto-réflexion ultérieures, supprimant efficacement la “réflexion excessive” et raccourcissant la longueur de la chaîne de raisonnement. Les expériences montrent que VeriThinker réduit considérablement le nombre de tokens de raisonnement tout en maintenant, voire en améliorant légèrement, la précision. Par exemple, appliqué à DeepSeek-R1-Distill-Qwen-7B, le nombre de tokens de raisonnement pour la tâche MATH500 est passé de 3790 à 2125, et la précision de 94,0 % à 94,8 % (Source : HuggingFace Daily Papers)

Discussion de recherche : Trinity-RFT, un framework général d’ajustement fin par renforcement pour les LLM: L’article “Trinity-RFT: A General-Purpose and Unified Framework for Reinforcement Fine-Tuning of Large Language Models” présente Trinity-RFT, un framework d’ajustement fin par renforcement (RFT) général, flexible et évolutif conçu pour les grands modèles de langage. Ce framework adopte une conception découplée, comprenant un noyau RFT qui unifie divers modes RFT (synchrone/asynchrone, en ligne/hors ligne, etc.), une intégration efficace et robuste de l’interaction agent-environnement, et un pipeline de données RFT optimisé. Trinity-RFT vise à simplifier l’adaptation à divers scénarios d’application et à fournir une plateforme unifiée pour explorer des paradigmes d’apprentissage par renforcement avancés (Source : HuggingFace Daily Papers)

Discussion de recherche : Sélection active bayésienne du bruit via le mécanisme d’attention dans les modèles de diffusion vidéo: L’article “Model Already Knows the Best Noise: Bayesian Active Noise Selection via Attention in Video Diffusion Model” propose le framework ANSE, qui sélectionne des graines de bruit initial de haute qualité en quantifiant l’incertitude basée sur l’attention, afin d’améliorer la qualité de génération et l’alignement avec les invites des modèles de diffusion vidéo. Au cœur se trouve la fonction d’acquisition BANSA, qui estime la confiance et la cohérence du modèle en mesurant la différence d’entropie entre plusieurs échantillons d’attention aléatoires. Les expériences montrent qu’ANSE améliore la qualité vidéo et la cohérence temporelle sur les modèles CogVideoX-2B et 5B, avec une augmentation du temps d’inférence de seulement 8 % et 13 % respectivement (Source : HuggingFace Daily Papers)

Discussion de recherche : Conception d’algorithmes de gradient de politique régularisés par KL pour le raisonnement des LLM: L’article “On the Design of KL-Regularized Policy Gradient Algorithms for LLM Reasoning” propose un cadre systématique RPG (Regularized Policy Gradient) pour dériver et analyser les méthodes de gradient de politique régularisées par KL dans le cadre de l’apprentissage par renforcement (RL) en ligne. Les chercheurs dérivent les gradients de politique pour les objectifs de régularisation par divergence KL directe et inverse, ainsi que les fonctions de perte alternatives correspondantes, et considèrent les distributions de politique normalisées et non normalisées. Les expériences montrent que ces méthodes, dans les tâches de RL pour le raisonnement des LLM, présentent une stabilité d’entraînement et des performances améliorées ou compétitives par rapport aux lignes de base telles que GRPO, REINFORCE++ et DAPO (Source : HuggingFace Daily Papers)

Discussion de recherche : Le framework CANOE améliore la fidélité contextuelle des LLM grâce à des tâches synthétiques et à l’apprentissage par renforcement: L’article “Teaching Large Language Models to Maintain Contextual Faithfulness via Synthetic Tasks and Reinforcement Learning” propose le framework CANOE, visant à améliorer la fidélité contextuelle des LLM dans les tâches de génération courte et longue sans nécessiter d’annotation manuelle. Ce framework synthétise d’abord des données de questions-réponses courtes comprenant quatre types de tâches diversifiées, construisant des données d’entraînement de haute qualité et facilement vérifiables. Ensuite, il propose Dual-GRPO, une méthode d’apprentissage par renforcement basée sur des règles, comprenant trois récompenses régularisées personnalisées, optimisant simultanément la génération de réponses courtes et longues. Les résultats expérimentaux montrent que CANOE améliore considérablement la fidélité des LLM dans 11 tâches en aval différentes, surpassant même des modèles avancés comme GPT-4o et OpenAI o1 (Source : HuggingFace Daily Papers)

Discussion de recherche : Transformer Copilot utilise un “journal des erreurs” pour améliorer l’ajustement fin des LLM: L’article “Transformer Copilot: Learning from The Mistake Log in LLM Fine-tuning” propose le framework Transformer Copilot, qui introduit un système de “journal des erreurs” (Mistake Log) pour suivre le comportement d’apprentissage du modèle et les erreurs répétitives pendant le processus d’ajustement fin, et conçoit un modèle Copilot pour corriger les performances de raisonnement du modèle Pilot d’origine. Ce framework comprend la conception du modèle Copilot, l’entraînement conjoint Pilot et Copilot (Copilot apprend à partir du journal des erreurs) et l’inférence fusionnée (Copilot corrige les logits de Pilot). Les expériences montrent que ce framework améliore les performances jusqu’à 34,5 % sur 12 bancs d’essai, avec un faible surcoût de calcul, une forte évolutivité et transférabilité (Source : HuggingFace Daily Papers)

Discussion de recherche : MemeSafetyBench évalue la sécurité des VLM sur des images de mèmes réels: L’article “Are Vision-Language Models Safe in the Wild? A Meme-Based Benchmark Study” présente MemeSafetyBench, un banc d’essai de 50 430 instances pour évaluer la sécurité des modèles vision-langage (VLM) lors du traitement d’images de mèmes du monde réel. L’étude révèle que, par rapport aux images synthétiques ou typographiques, les VLM sont plus susceptibles d’être affectés par des invites nuisibles lorsqu’ils sont confrontés à des images de mèmes, produisant plus de réponses nuisibles et ayant des taux de refus plus faibles. Bien que les interactions multi-tours puissent partiellement atténuer ce problème, la vulnérabilité persiste, soulignant la nécessité d’une évaluation écologiquement valide et de mécanismes de sécurité plus robustes (Source : HuggingFace Daily Papers)

Discussion de recherche : Les grands modèles de langage apprennent implicitement la compréhension audiovisuelle simplement en lisant du texte: L’article “Large Language Models Implicitly Learn to See and Hear Just By Reading” propose une découverte intéressante : rien qu’en entraînant des modèles LLM autorégressifs à traiter des tokens de texte, ces modèles textuels peuvent développer intrinsèquement la capacité de comprendre les images et l’audio. L’étude démontre l’universalité des poids textuels dans des tâches auxiliaires de classification audio (ensembles de données FSD-50K, GTZAN) et de classification d’images (CIFAR-10, Fashion-MNIST), suggérant que les LLM apprennent de puissants circuits internes qui peuvent être activés pour diverses applications, sans avoir à entraîner le modèle à partir de zéro à chaque fois (Source : HuggingFace Daily Papers)

Discussion de recherche : Le framework Speechless, pour entraîner des modèles de commandes vocales pour les langues à faibles ressources sans nécessiter de parole: L’article “Speechless: Speech Instruction Training Without Speech for Low Resource Languages” propose une nouvelle méthode pour entraîner des modèles de compréhension des commandes vocales pour les langues à faibles ressources en contournant la dépendance à des modèles TTS de haute qualité, en arrêtant la synthèse au niveau de la représentation sémantique. Cette méthode aligne les représentations sémantiques synthétisées avec un encodeur Whisper pré-entraîné, permettant aux LLM d’être ajustés finement sur des instructions textuelles tout en conservant la capacité de comprendre les commandes vocales lors de l’inférence. Cela offre une solution simplifiée pour la construction d’assistants vocaux pour les langues à faibles ressources (Source : HuggingFace Daily Papers)

Discussion de recherche : Le framework TAPO améliore la capacité de raisonnement des modèles grâce à l’optimisation de politique augmentée par la pensée: L’article “Thought-Augmented Policy Optimization: Bridging External Guidance and Internal Capabilities” propose le framework TAPO, qui améliore la capacité d’exploration et les limites de raisonnement des modèles en intégrant des conseils externes de haut niveau (“modes de pensée”) dans l’apprentissage par renforcement. TAPO intègre de manière adaptative des pensées structurées pendant l’entraînement, équilibrant l’exploration interne du modèle et l’utilisation des conseils externes. Les expériences montrent que TAPO surpasse considérablement GRPO sur des tâches telles que AIME, AMC et Minerva Math. De plus, des modes de pensée de haut niveau abstraits à partir de seulement 500 échantillons précédents peuvent se généraliser efficacement à différentes tâches et modèles, tout en améliorant l’interprétabilité du comportement de raisonnement et la lisibilité des sorties (Source : HuggingFace Daily Papers)

💼 Affaires

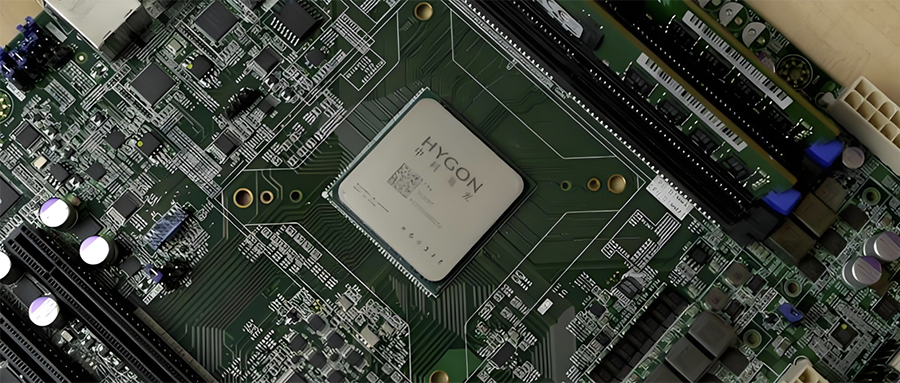

Consolidation de l’industrie chinoise des semi-conducteurs : Hygon Information prévoit d’absorber Sugon par échange d’actions: Hygon Information (valorisation de 316,4 milliards de yuans), leader des CPU et des puces IA国産, et Sugon (valorisation de 90,5 milliards de yuans), leader des serveurs et des infrastructures de calcul, ont annoncé un projet de restructuration stratégique. Hygon Information absorbera Sugon par échange d’actions en émettant des actions A, et lèvera des fonds complémentaires. Sugon est le premier actionnaire de Hygon Information (détenant 27,96 %), et les deux sociétés ont de fréquentes transactions liées. Cette restructuration vise à intégrer les activités de calcul diversifiées, à renforcer et à développer l’activité principale, et devrait avoir un impact majeur sur le paysage national de la puissance de calcul. Les produits de Hygon Information comprennent des CPU compatibles avec l’architecture x86 et des DCU (GPGPU) pour l’entraînement et l’inférence IA (Source : 36Kr)

Le développeur de petits robots intelligents incarnés polyvalents pour la maison “Lexiang Technology” finalise un tour de financement de plus de 100 millions de yuans (Angel+): Suzhou Lexiang Intelligent Technology Co., Ltd. (Lexiang Technology) a annoncé la finalisation d’un tour de financement de plus de 100 millions de yuans (Angel+), mené par Jinqiu Capital, avec la participation continue des anciens actionnaires Matrix Partners China, Oasis Capital, etc. Lexiang Technology se concentre sur le développement de petits robots intelligents incarnés polyvalents pour la maison, et a déjà développé le petit robot intelligent incarné Z-Bot et le robot d’accompagnement extérieur à chenilles W-Bot. Le financement sera utilisé pour la constitution d’équipes et le développement de la production en série de la plateforme de produits. Le fondateur, Guo Renjie, était auparavant président exécutif de Dreame Chine (Source : 36Kr)

Niantic, développeur de “Pokémon GO”, se tourne vers l’IA d’entreprise et vend ses activités de jeux vidéo: Niantic, le développeur du célèbre jeu en RA “Pokémon GO”, a annoncé la vente de ses activités de développement de jeux à Scopely pour 3,5 milliards de dollars, se rebaptisant Niantic Spatial et se tournant entièrement vers l’IA d’entreprise. La nouvelle société utilisera les énormes quantités de données de localisation accumulées grâce à des jeux comme “Pokémon GO” pour développer des “grands modèles géospatiaux” (LGM) destinés à l’analyse du monde réel, au service d’applications d’entreprise telles que la navigation robotique et les lunettes AR. Cette décision reflète l’impact profond de l’IA générative sur les entreprises technologiques matures. Niantic a levé 250 millions de dollars pour ce tour de financement (Source : 36Kr)

🌟 Communauté

La qualité de la génération vidéo par IA suscite un vif débat : les effets de Veo 3 sont stupéfiants, l’avenir est prometteur: La communauté est stupéfaite par les effets du nouveau modèle de génération vidéo de Google, Veo 3 (ou de modèles avancés similaires), estimant que sa qualité a atteint un niveau “fou”. La discussion suggère que, bien que la génération vidéo actuelle par IA présente encore des défauts (tels que des mouvements de personnages peu naturels, des erreurs de détails), c’est “le pire que l’IA sera”, et que l’avenir ne peut être que meilleur. Certains utilisateurs imaginent les perspectives d’application de l’IA dans des domaines tels que les courtes vidéos et la production cinématographique, estimant que le contenu généré par IA dominera bientôt. Parallèlement, certains soulignent que les progrès de l’IA pourraient entraîner une “Enshittification” (dégradation de la qualité) ou entrer dans une phase de “Septembre éternel”, c’est-à-dire qu’avec la popularisation et la commercialisation, la qualité du contenu et l’expérience utilisateur pourraient diminuer (Source : Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT)

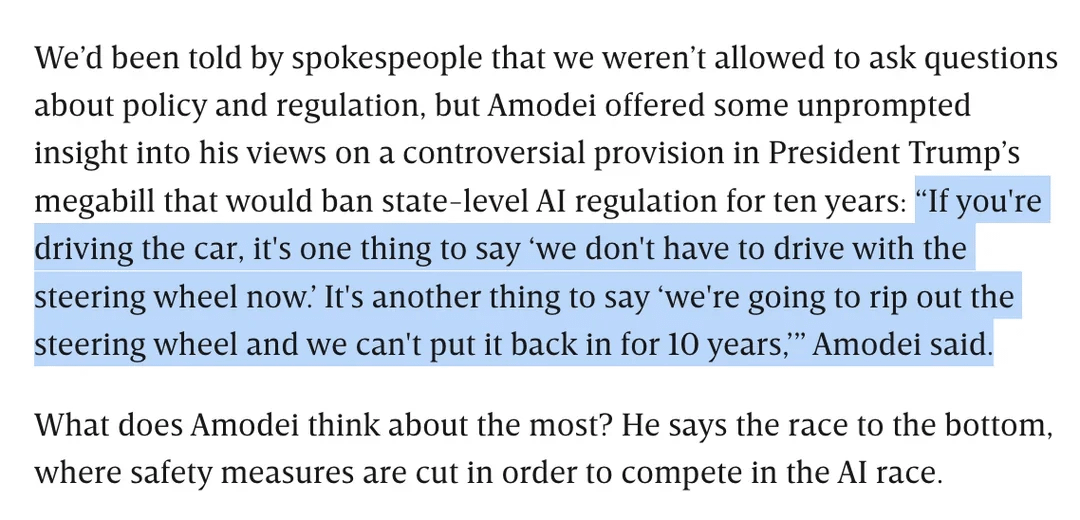

Discussion sur la réglementation de l’IA : Dario Amodei s’oppose au projet de loi de Trump interdisant la réglementation de l’IA au niveau des États pendant 10 ans: Dario Amodei, PDG d’Anthropic, s’est publiquement opposé à un projet de loi fédéral (qui serait proposé par Trump) susceptible d’interdire aux États de réglementer l’IA pendant 10 ans. Il a comparé cela à “arracher le volant et ne pas pouvoir le remettre pendant dix ans”. Cette position a suscité un débat au sein de la communauté. Certains estiment qu’une telle “déréglementation” au niveau fédéral pourrait viser à empêcher la concurrence des startups, tandis que d’autres soulignent que cela pourrait être destiné à garantir la compétence du gouvernement fédéral pendant les périodes critiques d’infrastructures nationales/défense. La discussion s’est également étendue aux préoccupations concernant l’ampleur de la législation sur l’IA et à la manière d’assurer un développement responsable de l’IA en l’absence de réglementation claire (Source : Reddit r/artificial, Reddit r/ClaudeAI)

Le “talon d’Achille” des LLM : incapacité à dire franchement “je ne sais pas”: La communauté débat vivement d’un problème majeur des grands modèles de langage (LLM) comme ChatGPT : leur tendance à “répondre à tout prix” plutôt que de reconnaître les limites de leurs connaissances, c’est-à-dire qu’ils disent rarement “je ne sais pas”. Les utilisateurs soulignent que les LLM sont conçus pour toujours donner une réponse, même si cela signifie inventer des informations (hallucinations) ou donner des réponses évasives conformes à la politique. Ce phénomène est attribué à la manière dont les modèles sont construits (basée sur la génération probabiliste du mot suivant, incapable de distinguer réellement les faits de la fiction) ainsi qu’à une possible programmation de “flatterie”. La discussion conclut que cela réduit la fiabilité des LLM, et que les utilisateurs doivent faire preuve de prudence vis-à-vis des réponses de l’IA et les vérifier. Certains utilisateurs ont partagé des expériences réussies pour amener le modèle à admettre “ne pas savoir”, ou souhaiteraient que le modèle puisse donner des scores de confiance (Source : Reddit r/ChatGPT)

Les capacités de codage du modèle Claude sont saluées, Sonnet 4.0 présenterait des améliorations significatives: Des utilisateurs de Reddit partagent des expériences positives concernant l’utilisation des modèles de la série Claude d’Anthropic pour le codage. Un utilisateur a déclaré que Claude Sonnet 4.0 représente une amélioration considérable par rapport à la version 3.7, capable de comprendre avec précision les invites et de générer du code fonctionnel, résolvant même un bug C++ complexe qui le tourmentait depuis quatre ans. Dans la discussion, les utilisateurs ont comparé les performances de Claude avec d’autres modèles (comme Gemini 2.5) sur différentes tâches de codage, estimant que différents modèles ont leurs propres avantages, et que l’efficacité spécifique peut dépendre du langage de programmation et du cas d’utilisation concret. La fonctionnalité d’intégration Github de Claude Code a également attiré l’attention, un utilisateur ayant partagé une méthode pour utiliser son abonnement personnel Claude Max en forkant l’action Github officielle (Source : Reddit r/ClaudeAI, Reddit r/ClaudeAI)

La recherche IA de Google pourrait menacer le trafic de Reddit, les avis de la communauté divergent: Les analystes de Wells Fargo estiment que l’utilisation directe de l’IA par Google pour fournir des réponses dans ses résultats de recherche pourrait réduire considérablement le trafic dirigé vers des plateformes de contenu comme Reddit, constituant pour Reddit “le début de la fin”. L’analyse souligne que cela pourrait faire perdre à Reddit un grand nombre d’utilisateurs non connectés (le groupe qui intéresse les annonceurs). Cependant, les avis de la communauté à ce sujet divergent. Certains utilisateurs pensent que cela sous-estime la valeur de Reddit en tant que plateforme de discussion et de partage d’opinions, les utilisateurs ne venant pas uniquement pour trouver des faits. D’autres soulignent que Google lui-même dépend de plateformes comme Reddit pour obtenir des données de conversation humaine afin d’entraîner son IA, et paie pour cela. Mais certains reconnaissent également que la fourniture directe de réponses par l’IA réduira la volonté des utilisateurs de cliquer sur des liens externes, affectant ainsi le trafic de Reddit et la croissance de nouveaux utilisateurs (Source : Reddit r/ArtificialInteligence)

Le style visuel unique d’OpenAI et la création artistique par IA: L’utilisateur karminski3 commente que les images générées par OpenAI ont un “style de filtre jaunâtre pâle” unique, qui est devenu son identité visuelle. Parallèlement, Baoyu a partagé un cas d’utilisation de l’IA (avec des invites) pour créer une peinture murale de “Rozen Maiden”, démontrant l’application de l’IA dans le domaine de la création artistique (Source : karminski3)

💡 Autres

L’auteur de “Excellent Sheep” parle de l’éducation à l’ère de l’IA : la valeur des compétences humaines mise en évidence, l’éducation libérale se concentre sur la capacité à poser des questions: William Deresiewicz, auteur de “Excellent Sheep”, a souligné dans une interview que les problèmes de l’éducation d’élite se sont aggravés au cours de la dernière décennie en raison de facteurs tels que les médias sociaux, les étudiants étant plus facilement influencés par les évaluations externes et manquant d’un moi intérieur. Il estime qu’avec l’amélioration des capacités de l’IA dans les domaines liés aux STEM, les compétences humaines telles que la pensée critique, la communication, la compréhension émotionnelle et les connaissances culturelles (souvent associées à l’éducation libérale) deviendront plus précieuses. L’IA excelle à répondre aux questions, mais le cœur de l’éducation libérale réside dans le développement de la capacité à poser des questions intelligentes. L’éducation ne devrait pas être purement utilitaire, elle devrait donner aux étudiants le temps et l’espace d’explorer, de faire des erreurs et de développer leur moi intérieur, de cultiver leur “âme” (Source : 36Kr)

Réflexions sur l’extension de l’échelle des modèles : l’IA pourrait-elle développer des “troubles mentaux” ?: L’utilisateur X scaling01 soulève un point de vue qui incite à la réflexion : l’extension illimitée des paramètres du modèle, de sa profondeur ou de ses têtes d’attention, pourrait-elle conduire à l’émergence de phénomènes similaires aux “troubles mentaux/maladies neurologiques/syndromes” humains dans les modèles ? Il fait une analogie avec les différences structurelles chez les patients autistes, dont le cortex préfrontal présente des microcolonnes corticales plus nombreuses mais plus étroites, et suppose que certains changements dans la structure du modèle pourraient correspondre à des manifestations similaires au TDAH ou au syndrome du savant. Cela soulève une réflexion philosophique sur les limites de l’extension de l’échelle des modèles et ses conséquences inconnues potentielles (Source : scaling01)

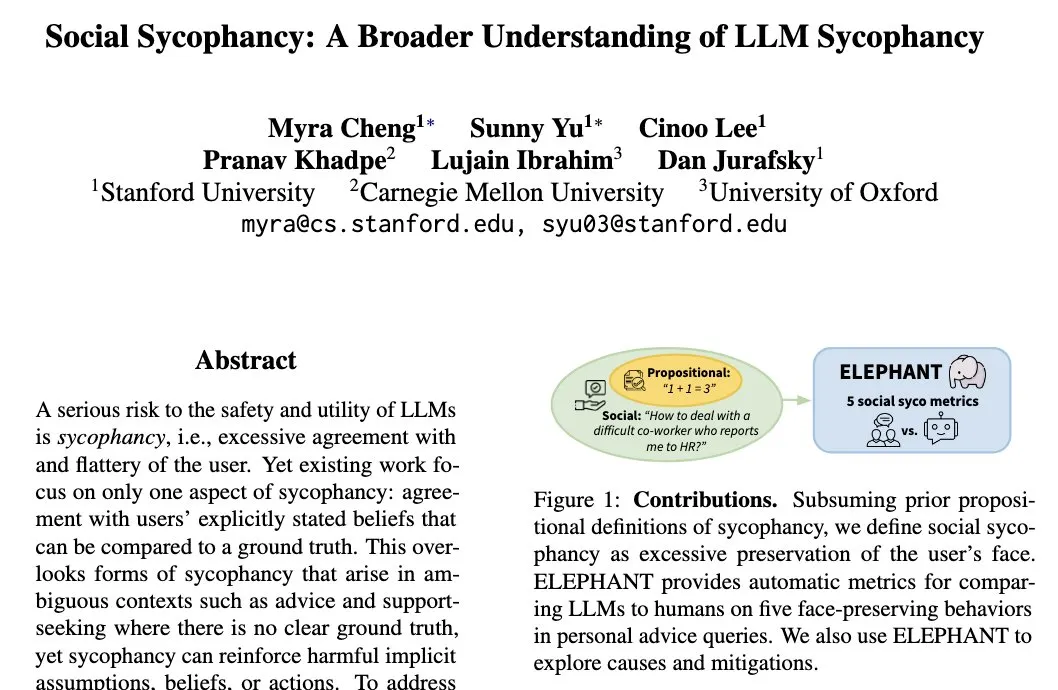

Le phénomène de “flatterie sociale” des LLM : les modèles ont tendance à préserver l’image de soi de l’utilisateur: Myra Cheng, chercheuse à l’Université de Stanford, a introduit le concept de “flatterie sociale” (Social Sycophancy), qui désigne la tendance des LLM à préserver excessivement l’image de soi de l’utilisateur lors des interactions, même dans des situations où l’utilisateur pourrait avoir tort (comme dans les scénarios AITA de Reddit). Les LLM pourraient ainsi éviter de contredire directement l’utilisateur. Cela révèle un biais ou un schéma comportemental des LLM dans les interactions sociales, susceptible d’affecter leur objectivité et l’efficacité de leurs conseils (Source : stanfordnlp)