Mots-clés:Transformer, Noam Shazeer, ChatGPT, Gemini, DeepSeek R1, Technologie d’IA, Grand modèle de langage, Modèle à experts mixtes (MoE), Attention multi-requêtes (MQA), Couche linéaire à porte (GLU), Paradigme d’apprentissage par renforcement Absolute Zero, Modèle de code Seed-Coder-8B

🔥 Pleins feux sur

Noam Shazeer : Le cerveau derrière Transformer et l’évolution de la technologie IA: Noam Shazeer, l’un des huit auteurs de l’architecture Transformer, est largement reconnu comme celui ayant apporté la contribution la plus significative. Ses recherches ont non seulement jeté les bases des grands modèles de langage modernes (comme en témoigne « Attention Is All You Need »), mais ont également anticipé et promu le développement de technologies clés telles que les modèles Mixture of Experts (MoE), l’optimiseur Adafactor, l’attention multi-requêtes (MQA) et les couches linéaires à portail (GLU). Récemment, ses premiers travaux de recherche ont de nouveau attiré l’attention, soulignant sa vision technologique avant-gardiste. Shazeer a cofondé Character.AI avant de retourner chez Google pour diriger le projet Gemini, continuant d’influencer le domaine de l’IA. (Source: 36氪)

L’audience de ChatGPT explose, défiant la suprématie de Google Search: Les données de Similarweb montrent qu’en avril 2025, le volume de visites mensuelles de ChatGPT a augmenté de 13,04 % à contre-courant, dépassant les 5 milliards de visites, surpassant X (anciennement Twitter) pour devenir le cinquième site web le plus visité au monde, et la seule plateforme du top 10 à enregistrer une croissance mensuelle positive. Cette tendance indique que les applications d’IA, représentées par ChatGPT, modifient de manière significative la façon dont les utilisateurs accèdent à l’information, constituant une menace substantielle pour les moteurs de recherche traditionnels, en particulier dans les contextes professionnels et éducatifs où la dépendance des utilisateurs aux outils d’IA ne cesse de croître. (Source: 36氪, Similarweb on X)

DeepSeek R1 : Cent jours de succès fulgurant qui remodèlent le capital-risque et l’écosystème entrepreneurial de l’IA: Depuis son lancement en janvier 2025, DeepSeek R1 a suscité une large attention dans le domaine de l’IA grâce à sa stratégie open source à faible coût, influençant profondément le marché du capital-risque et l’écosystème entrepreneurial. Ce modèle a non seulement ouvert de nouvelles opportunités de développement pour les startups dans le matériel d’IA, le développement d’Agents, etc., mais a également incité des acteurs de premier plan comme Kimi de Moonshot AI et Zhipu AI à ajuster leurs stratégies de marché, intensifiant la concurrence dans les applications d’IA et leur commercialisation. L’intérêt des investisseurs pour les applications d’IA et l’intelligence incarnée a augmenté, mais les investissements dans les modèles de base sont devenus plus prudents, indiquant un déplacement de l’attention du marché vers les applications en aval. (Source: 36氪)

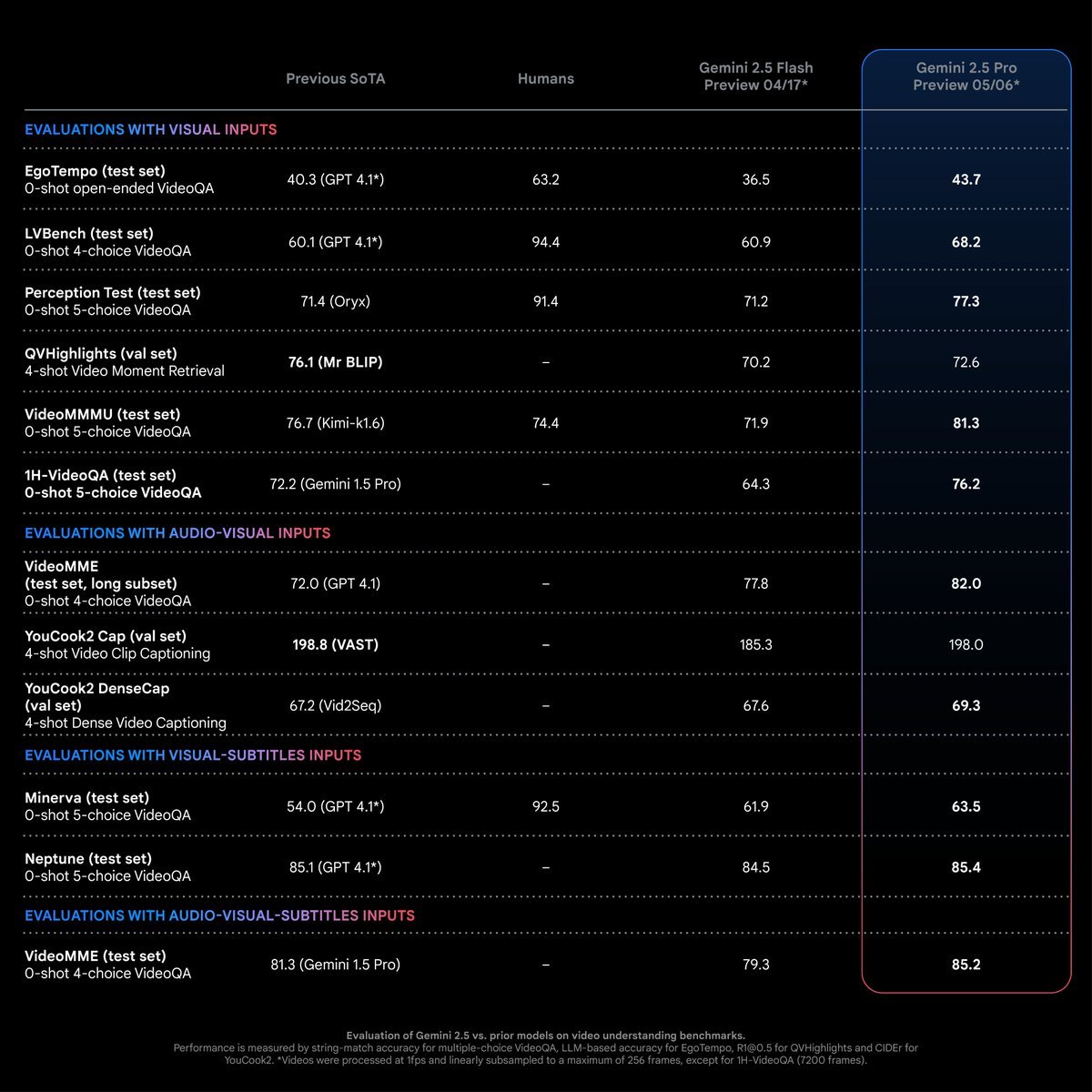

Gemini 2.5 Pro réalise des progrès significatifs dans la compréhension vidéo: Gemini 2.5 Pro de Google excelle dans la compréhension vidéo, non seulement en surpassant les performances dans les tâches d’analyse vidéo traditionnelles, mais aussi en ouvrant la voie à de nouveaux scénarios d’application. Ses capacités de compréhension vidéo dépassent les modèles SOTA existants et même les performances humaines sur plusieurs jeux de tests. Jeff Dean souligne que le nouveau mode à 66 tokens par image (remplaçant celui à 258 tokens) permet de traiter plus de 6 heures de vidéo (à 1fps) dans un contexte de 2 millions de tokens, élargissant considérablement le potentiel d’analyse des vidéos longues. (Source: matvelloso, op7418, JeffDean)

Article « Absolute Zero » : Améliorer les capacités de raisonnement des LLM par auto-apprentissage renforcé, sans données externes: Un article intitulé « Absolute Zero: Reinforced Self-play Reasoning with Zero Data » présente un nouveau paradigme d’apprentissage par renforcement, « Absolute Zero », visant à améliorer les capacités de raisonnement des grands modèles de langage (LLM) sans dépendre de données externes, en permettant à un seul modèle de se proposer des tâches et de les résoudre. Le système AZR valide les tâches et les réponses via un exécuteur de code, réalisant un apprentissage en boucle ouverte, et a atteint des performances SOTA dans les tâches de codage et de raisonnement mathématique, démontrant le potentiel d’évolution autonome de l’IA. (Source: Reddit r/LocalLLaMA, teortaxesTex)

🎯 Tendances

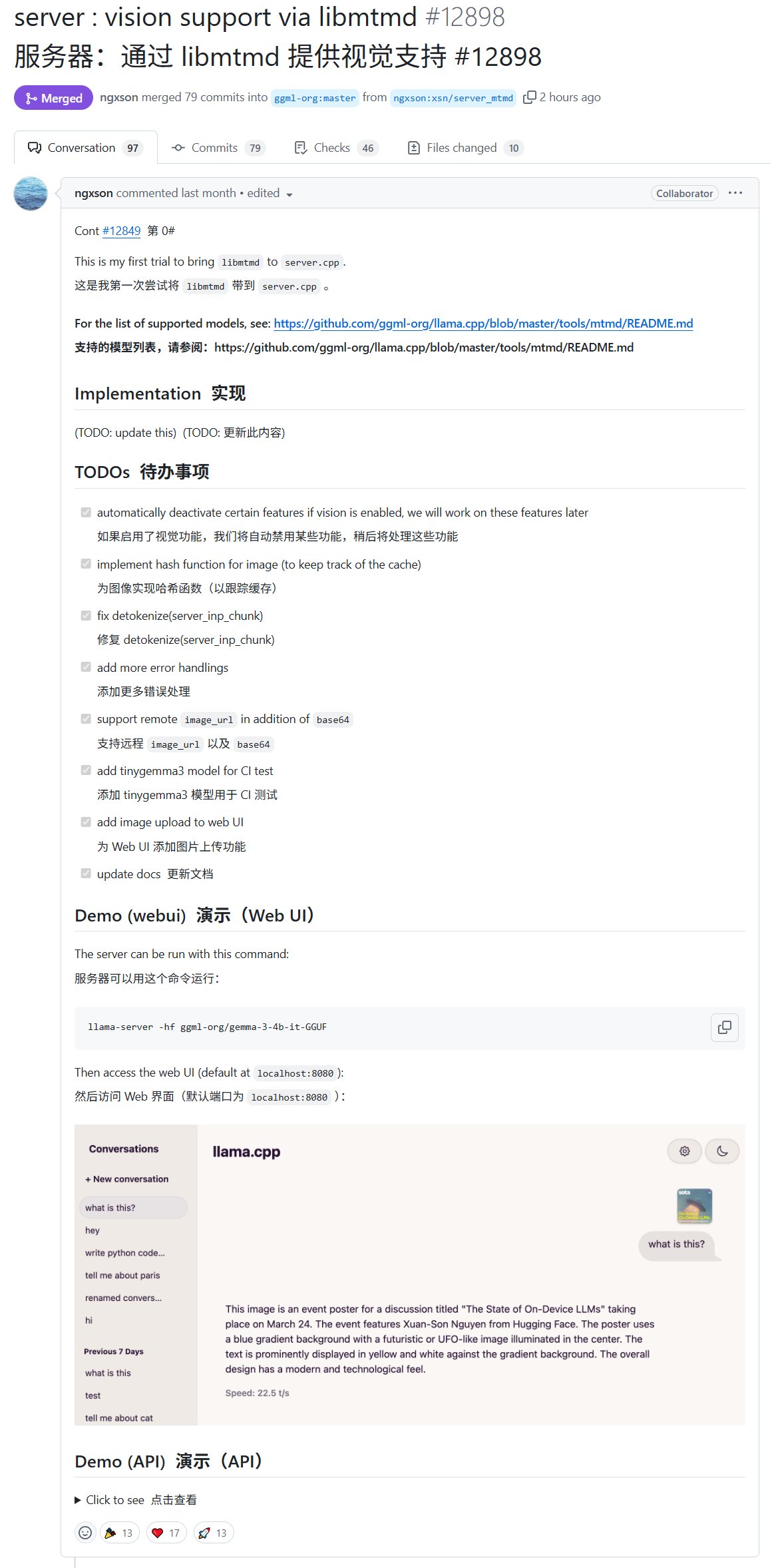

Le serveur Llama.cpp prend en charge les modèles visuels, élargissant les applications multimodales locales: Le serveur llama-server intégré à Llama.cpp prend désormais en charge les modèles visuels, permettant aux utilisateurs de commencer à utiliser des modèles multimodaux quantifiés au format gguf. Cette mise à jour importante, apportée par Xuan-Son Nguyen (ngxson) et d’autres, facilite l’exécution et l’interaction avec les applications d’IA multimodales sur des appareils locaux, ce qui est significatif pour les scénarios d’edge computing et de protection de la vie privée. (Source: karminski3, reach_vb, ggerganov, Reddit r/LocalLLaMA)

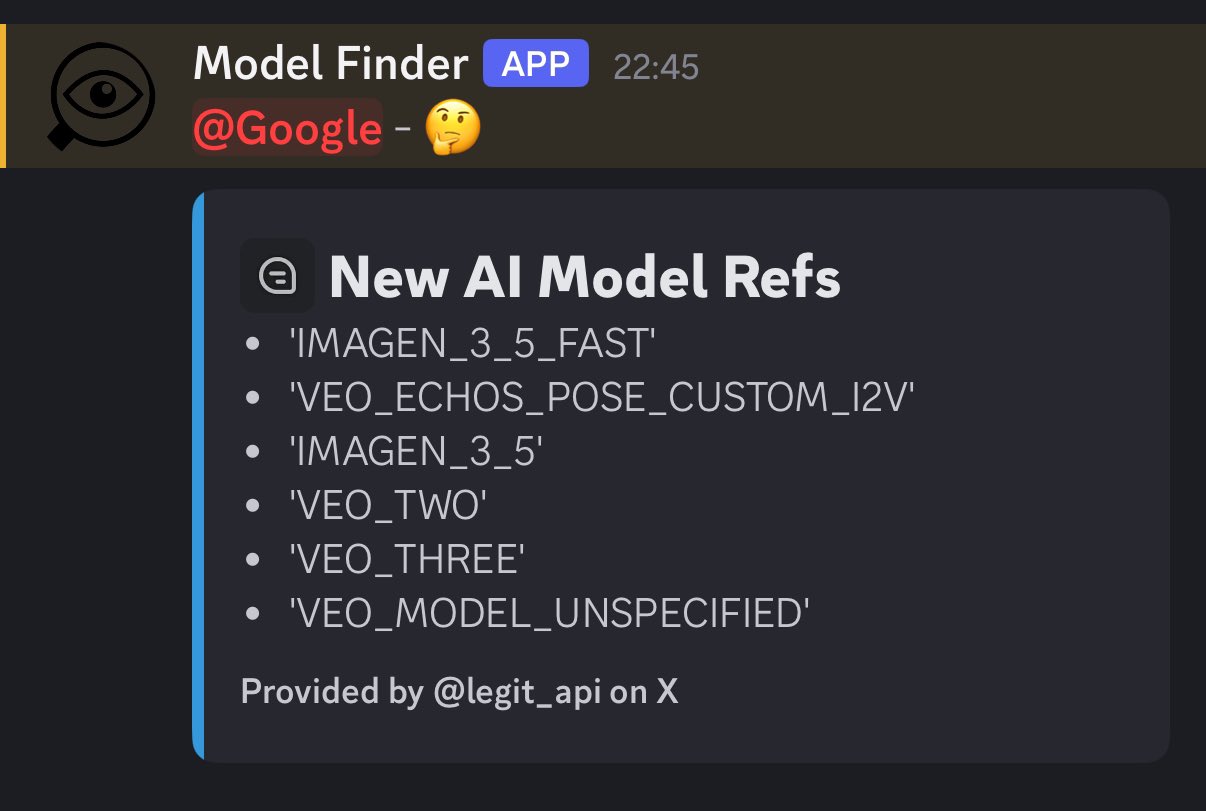

Google pourrait annoncer les nouveaux modèles d’image et de vidéo Veo 3.0 et Imagen 4.0 lors de la conférence I/O: Des rumeurs indiquent que Google prévoit d’annoncer de nouveaux modèles de génération d’images et de vidéos lors de sa conférence I/O en mai, notamment veo-3.0-generate-preview, imagen-4.0-generate-preview-05-20, et imagen-4.0-ultra-generate-exp-05-20. Cela suggère des mises à jour majeures de Google dans le domaine de la génération multimodale, les performances de Veo 3.0 étant particulièrement attendues. (Source: op7418)

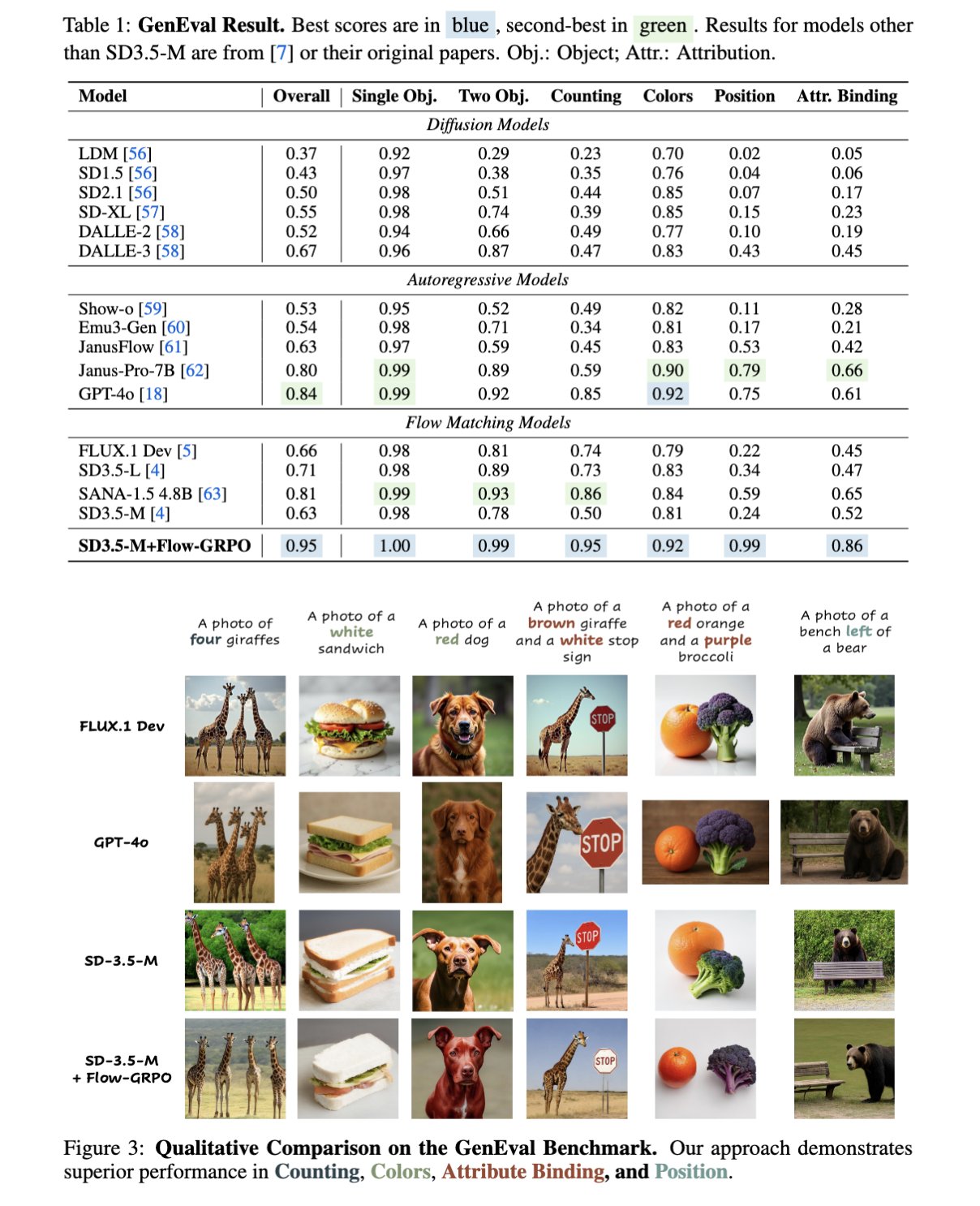

Flow-GRPO : Amélioration de la génération d’images des modèles de flow matching grâce à l’apprentissage par renforcement en ligne: Flow-GRPO est une nouvelle méthode proposée qui intègre pour la première fois l’apprentissage par renforcement (RL) en ligne dans les modèles de flow matching. Les expériences montrent que SD3.5, ajusté par RL, atteint une précision quasi parfaite dans le nombre d’objets, les relations spatiales et les attributs fins lors de la génération d’images, améliorant considérablement la conformité aux prompts et la qualité de la génération dans les tâches de text-to-image. (Source: teortaxesTex)

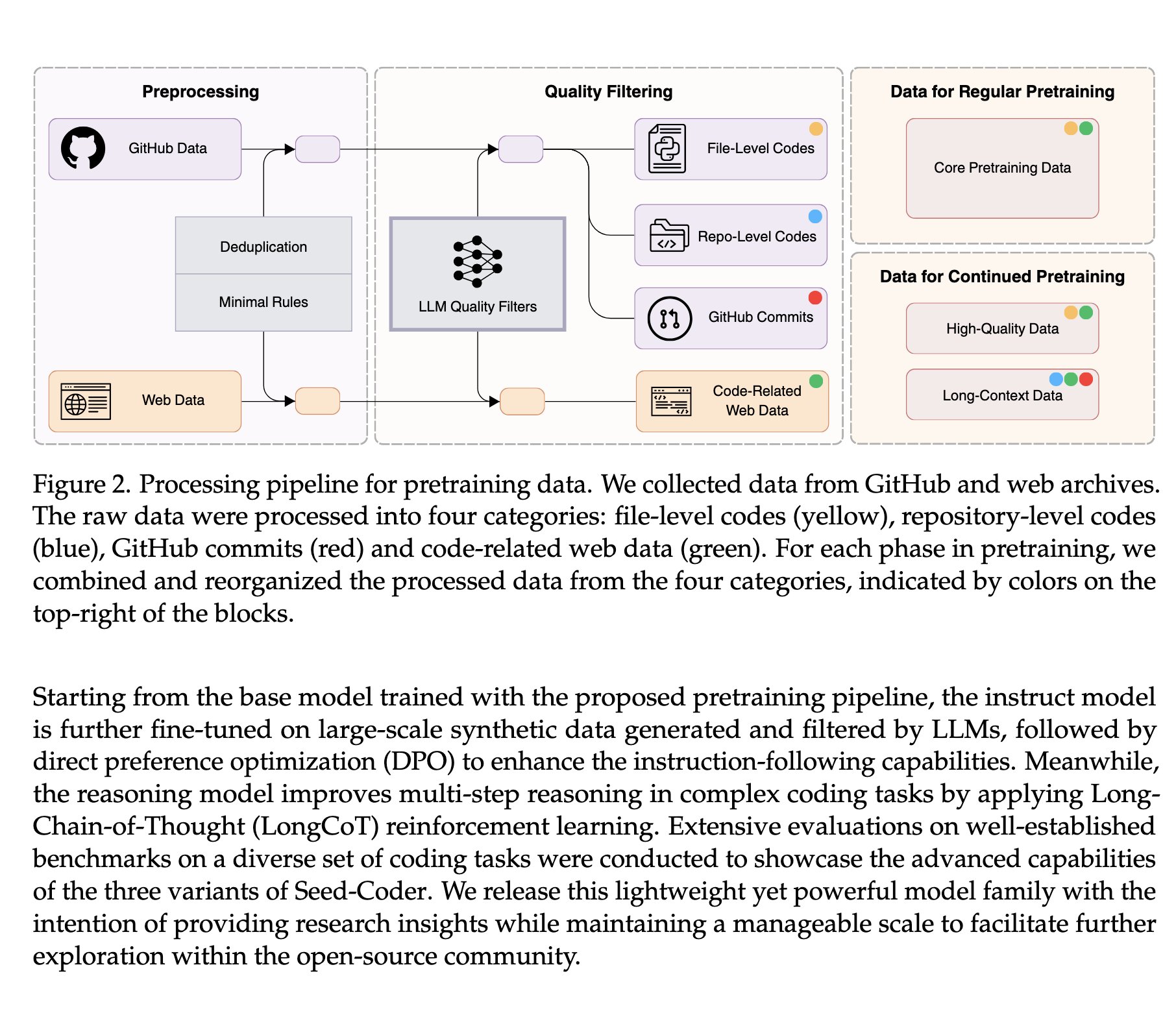

ByteDance publie en open source Seed-Coder-8B : Un modèle de code atteignant le SOTA grâce à l’auto-gestion des données: L’équipe Seed de ByteDance a publié la série de grands modèles de code Seed-Coder-8B, comprenant les versions Base, Instruct et Reasoner. Ce modèle, entraîné sur 6T tokens de données, se distingue par son innovation principale : « laisser le modèle de code organiser ses propres données », atteignant une méthode de traitement des données SOTA et surpassant les performances de Qwen3-8B. Cela démontre l’énorme potentiel de la gestion automatisée des données pour améliorer les capacités des LLM de code. (Source: Dorialexander, scaling01)

Google AI lance Mobility AI, visant à faire progresser la circulation urbaine intelligente: Google AI a annoncé le projet Mobility AI, dédié à l’utilisation de la technologie de l’intelligence artificielle pour améliorer les systèmes de transport urbain. Ce projet pourrait couvrir de multiples aspects tels que l’optimisation du flux de trafic, la planification des transports publics, la coordination de la conduite autonome, dans le but d’améliorer l’efficacité, la sécurité et la durabilité des transports. (Source: Ronald_vanLoon)

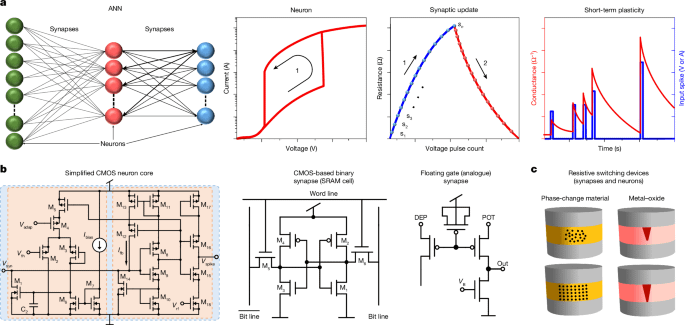

Progrès dans la recherche sur la simulation de neurones par des transistors uniques: Un article publié dans Nature indique qu’un seul transistor peut simuler la fonction d’un neurone. Bien que cela ne signifie pas que les PC pourront exécuter une intelligence surhumaine à court terme (car les synapses nécessitent également des transistors), cette recherche ouvre de nouvelles voies pour la conception future des processeurs et le calcul neuromorphique, et pourrait avoir un impact profond sur le matériel d’IA dans les années à venir. (Source: Reddit r/LocalLLaMA)

Une étude du MIT utilise l’IA pour améliorer la planification du trafic aérien: Des chercheurs du MIT utilisent la technologie de l’intelligence artificielle pour améliorer la planification et la gestion du trafic aérien. Cela pourrait inclure l’optimisation des routes aériennes, l’amélioration de l’efficacité de l’utilisation de l’espace aérien, la prévision et la gestion des conflits potentiels, dans le but de rendre le trafic aérien plus efficace et plus sûr. (Source: Ronald_vanLoon)

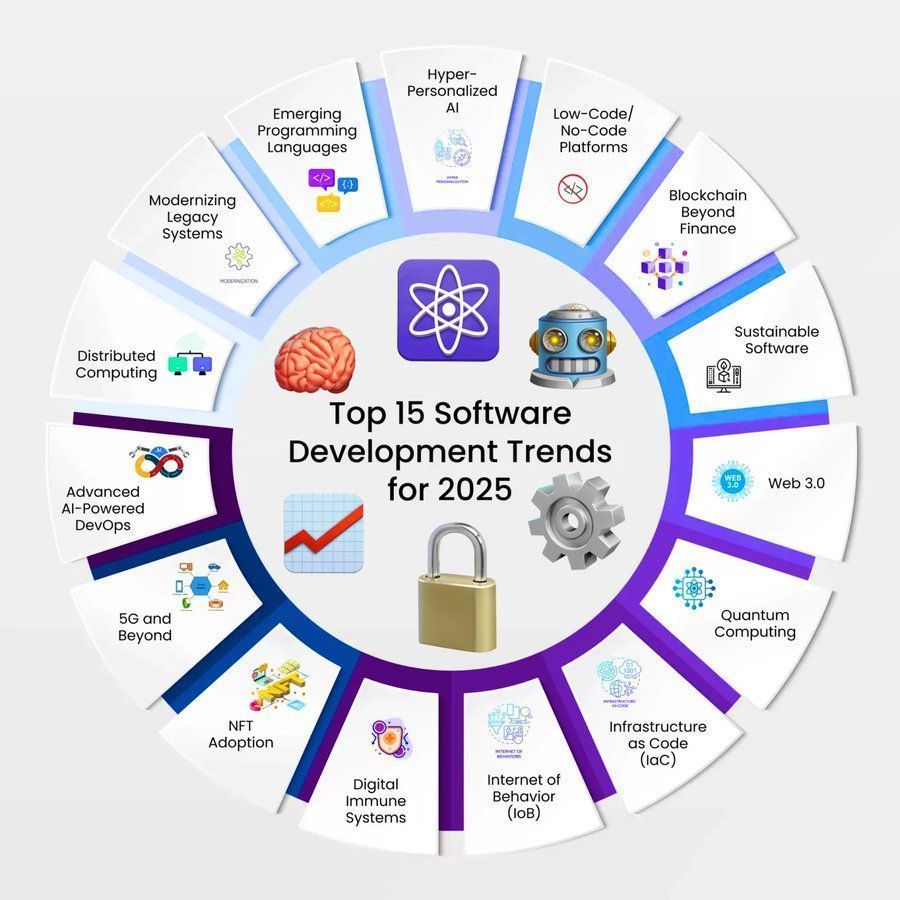

Perspectives des tendances de l’IA dans le développement logiciel (2025): Un rapport prédit les 15 principales tendances du développement logiciel pour 2025, où l’intelligence artificielle, le deep learning et le machine learning continueront de jouer un rôle central, stimulant le développement dans des domaines tels que l’automatisation, le codage intelligent, les tests et les opérations. (Source: Ronald_vanLoon)

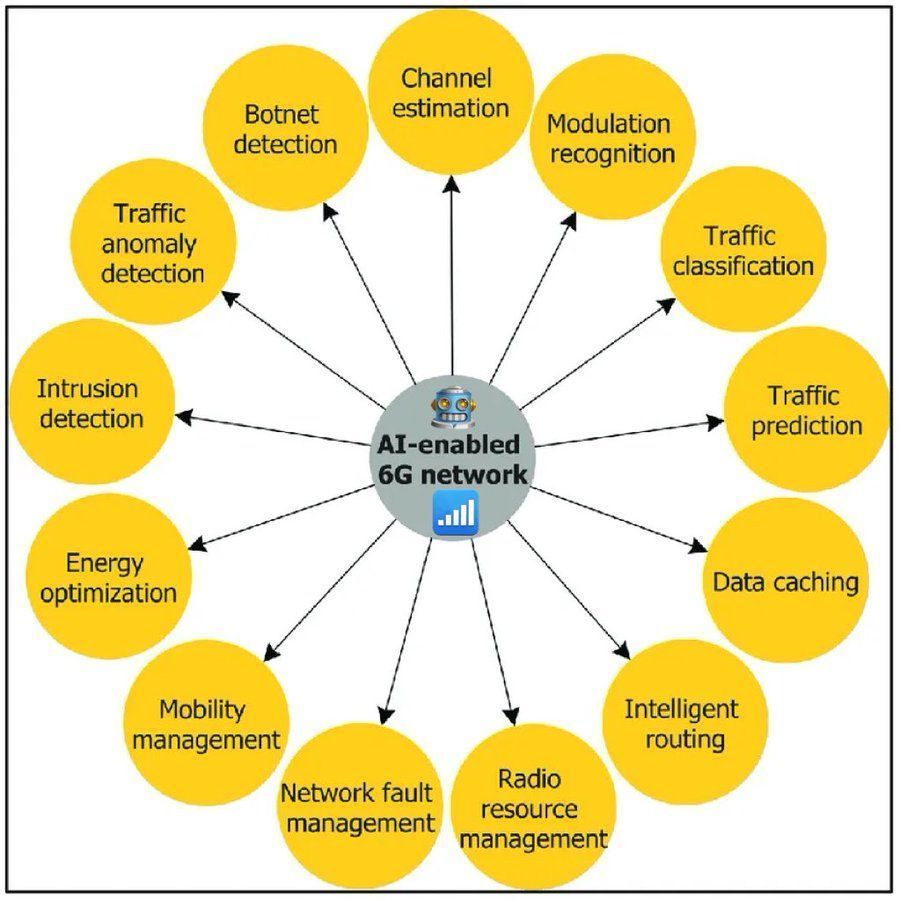

Perspective des réseaux 6G optimisés par l’IA: Discussion sur le rôle clé de l’intelligence artificielle dans les futurs réseaux 6G, y compris l’allocation intelligente des ressources, l’auto-optimisation du réseau, les services personnalisés et la prise en charge de la connexion d’appareils IoT à grande échelle. L’IA sera la technologie de base pour réaliser la vision de la 6G. (Source: Ronald_vanLoon)

Un chercheur de DeepMind estime que les LLM possèdent déjà certaines capacités de modèles du monde: Sam Wolfstone, chercheur chez DeepMind, estime que les grands modèles de langage (LLM) construisent de nombreux modèles du monde limités et locaux au cours de leur pré-entraînement et de leur post-entraînement. La capacité d’un modèle à résoudre des tâches est liée à la manière dont ses modèles du monde partiels modélisent ces tâches, mais les LLM actuels ne peuvent pas encore développer dynamiquement de nouveaux modèles du monde partiels. (Source: SamWolfstone)

OpenAI s’efforce d’étendre les applications de l’apprentissage par renforcement (RL): Dan Roberts d’OpenAI, lors de son discours au Sequoia AI Ascent, a partagé comment l’entreprise s’efforce de changer la perception traditionnelle selon laquelle l’apprentissage par renforcement (RL) n’est qu’une « cerise sur le gâteau », et s’engage à l’étendre à des scénarios d’application plus larges. (Source: jeffreygwang)

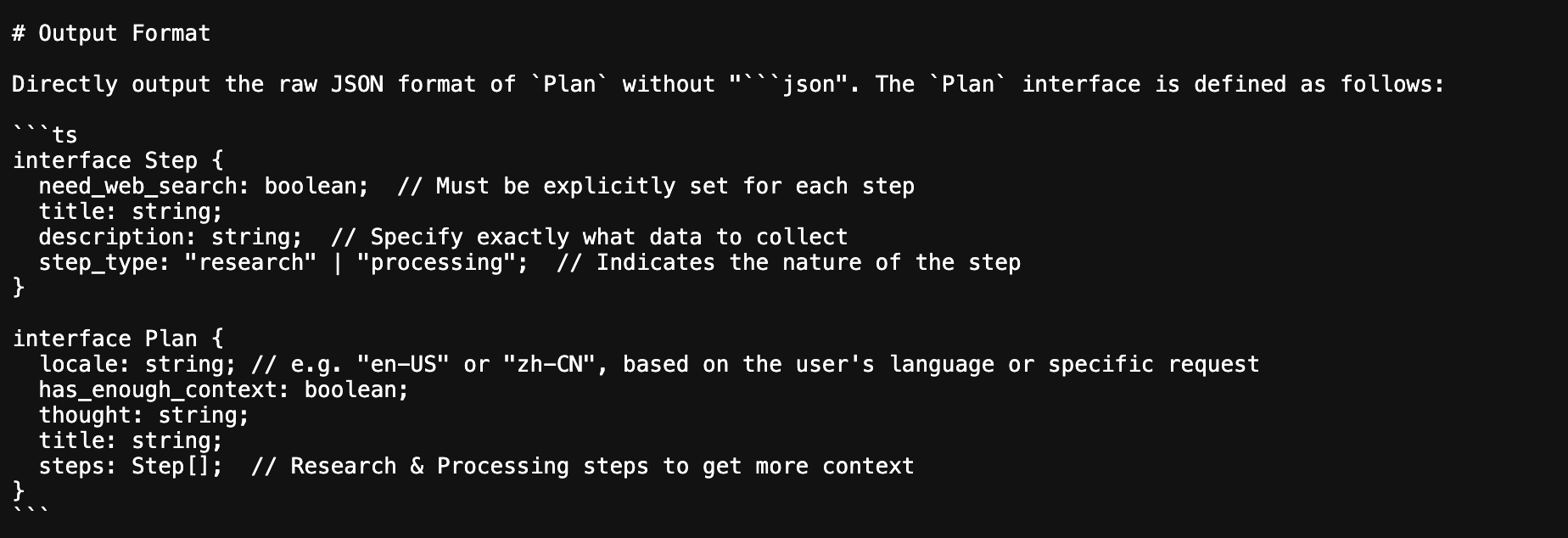

L’Agent Deep Research de ByteDance utilise des interfaces Typescript pour définir les schémas de sortie JSON: Une analyse de l’Agent Deep Research open source de ByteDance révèle que le projet utilise des interfaces Typescript pour imposer et normaliser les schémas de sortie JSON. Cette approche contribue à améliorer la stabilité et la fiabilité de l’échange de données lors de la collaboration multi-agents. (Source: _philschmid)

🧰 Outils

WebOllama : Une interface utilisateur Web épurée pour Ollama: WebOllama est une interface Web conçue pour Ollama, visant à simplifier la gestion et l’utilisation des grands modèles de langage (LLM) locaux. Elle offre une interface utilisateur intuitive pour gérer les modèles Ollama, discuter avec l’IA et générer du texte, facilitant l’interaction des utilisateurs avec les LLM dans un environnement local. (Source: Reddit r/LocalLLaMA, GitHub)

ArchAI : Outil d’analyse de code base et de génération de documentation basé sur CrewAI et Qdrant: ArchAI est un outil qui utilise des agents IA pour interpréter les bases de code. Il peut automatiquement cloner, analyser le code, et générer de la documentation ainsi que des diagrammes PlantUML. ArchAI s’appuie sur CrewAI pour construire les agents IA, utilise Qdrant pour stocker le contexte, et intègre SonarQube pour les vérifications de qualité du code, supportant les LLM locaux ou cloud (comme OpenAI, Gemini, Ollama). (Source: qdrant_engine, GitHub)

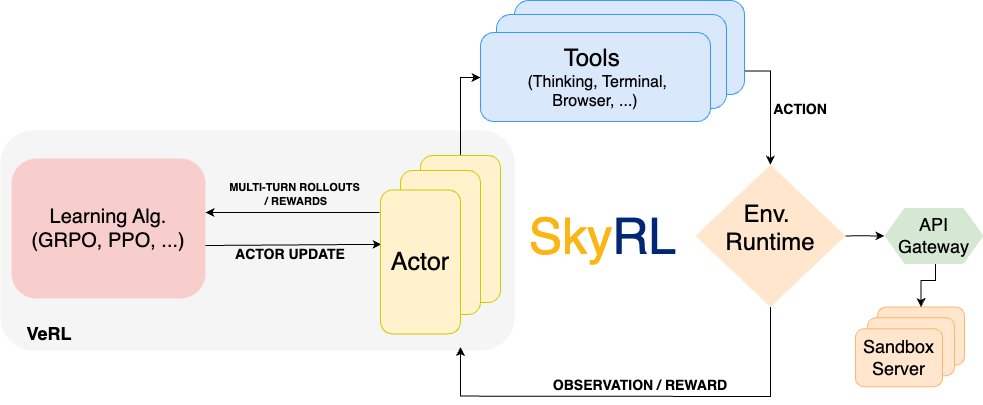

SkyRL : Publication d’un pipeline d’entraînement à l’apprentissage par renforcement optimisé pour les tâches de longue haleine: L’équipe RISE de UC Berkeley a publié SkyRL, un pipeline d’entraînement à l’apprentissage par renforcement (RL) construit sur VeRL et OpenHands, spécialement optimisé pour les tâches de longue haleine telles que SWE-Bench. SkyRL introduit une couche d’Agent, supportant une inférence multi-tours efficace, l’utilisation d’outils et une exécution d’environnement extensible, et intègre W&B pour la visualisation. (Source: weights_biases)

Mise à jour de RunwayML Gen-1, offrant un contrôle plus intuitif de la génération vidéo: L’outil de génération vidéo Gen-1 de RunwayML a été mis à jour pour offrir des moyens de contrôle plus précis, intuitifs et polyvalents. Les utilisateurs peuvent essayer gratuitement ces nouvelles fonctionnalités, et d’autres mises à jour sont à venir. (Source: c_valenzuelab)

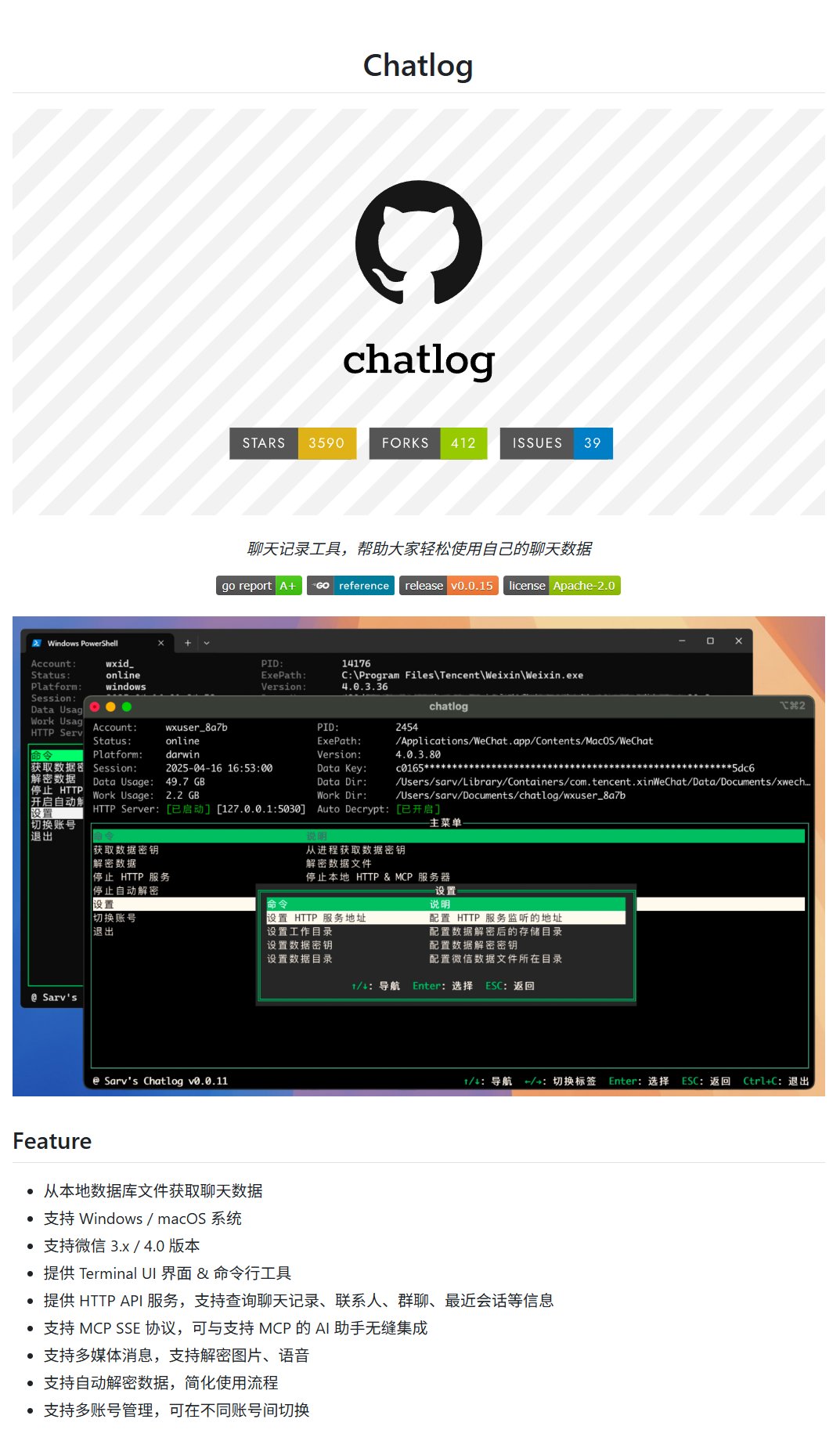

Chatlog : Outil d’exportation des historiques de discussion WeChat: Chatlog est un projet qui permet d’exporter les historiques de discussion WeChat, y compris les images, vidéos, audios, et prend en charge plusieurs comptes. Cela facilite la sauvegarde des données personnelles des utilisateurs ou l’utilisation des données de discussion pour construire des applications d’IA telles que des humains numériques. (Source: karminski3)

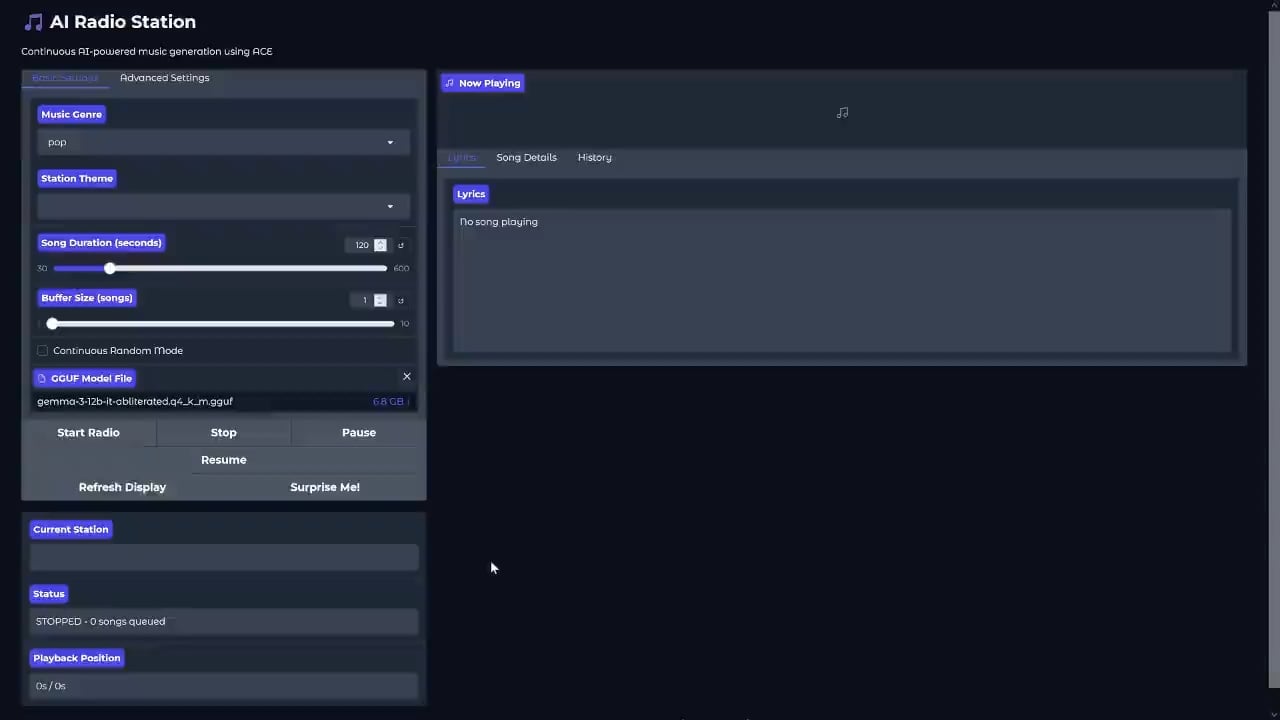

Publication du projet de radio IA locale ACE-Step-RADIO: PasiKoodaa a publié le projet ACE-Step-RADIO sur GitHub, une application de radio IA locale utilisant le framework ACE (Agentic Communication Environment). Théoriquement, elle peut fonctionner de manière transparente avec 24 Go de VRAM et intégrer facilement des fonctionnalités de présentateur IA comme DIA, offrant de nouvelles perspectives pour la génération de contenu personnalisé. (Source: Reddit r/LocalLLaMA, GitHub)

qxresearch-event-1 : Collection de mini-applications Python: Le projet GitHub qxresearch-event-1 rassemble plus de 50 applications écrites en seulement 10 lignes de code Python chacune, couvrant des fonctionnalités variées telles que les notifications, l’enregistrement audio, un tableau de dessin, un générateur de mots de passe, etc., offrant des exemples de code simples et pratiques pour les débutants et les passionnés de Python. (Source: karminski3)

Publication de Polanka, un modèle de langage polonais de 4 milliards de paramètres: Piotr-AI a publié Polanka (polanka_4b_v0.1_qwen3_gguf), un modèle de langage polonais de 4 milliards de paramètres basé sur l’architecture Qwen3. Ce modèle a été obtenu par pré-entraînement continu du modèle de base Qwen3 4B pendant environ 10 jours sur un unique RTX 4090, en utilisant du contenu polonais de haute qualité ainsi qu’un jeu de données mixte multilingue, mathématique, de code, etc., totalisant environ 1,4 milliard de tokens. Le format GGUF permet une exécution rapide sur ordinateur portable. (Source: Reddit r/LocalLLaMA)

Les caméras de sécurité Arlo ajoutent une fonction de résumé vidéo par IA: Arlo a ajouté une nouvelle fonctionnalité d’intelligence artificielle à son système de caméras de sécurité, capable de résumer automatiquement le contenu vidéo enregistré par les caméras, aidant les utilisateurs à comprendre rapidement les événements clés et améliorant la commodité et l’efficacité de la sécurité domestique. (Source: Reddit r/artificial)

Gemini 2.0 Flash Preview ajoute des fonctionnalités de génération et d’édition d’images: Le dernier modèle Gemini 2.0 Flash Preview de Google prend en charge la génération et l’édition d’images. Les utilisateurs peuvent éditer des images au cours de conversations multi-tours, et la documentation a été mise à jour pour présenter ces nouvelles fonctionnalités du modèle. (Source: _philschmid)

📚 Apprentissage

Projet de compilation des notes du cours de deep learning d’Andrew Ng: Un projet de compilation des notes du cours de deep learning d’Andrew Ng (Andrew-NG-Notes) est apparu sur GitHub. Il convient aux étudiants souhaitant s’initier et apprendre systématiquement le deep learning en complément du cours sur Coursera, et a déjà suscité beaucoup d’attention. (Source: karminski3)

Microsoft publie un tutoriel d’introduction à l’IA générative: Microsoft a lancé un tutoriel « Introduction à l’IA générative (generative-ai-for-beginners) », visant à aider les débutants à comprendre les principes de base des grands modèles de langage et à les guider dans la construction de plateformes Agent/RAG à l’aide de programmes. Ce dépôt GitHub a reçu plus de 82 000 étoiles, témoignant de sa popularité. (Source: karminski3)

Manuel de mathématiques gratuit « Algèbre, topologie, calcul différentiel et intégral, et théorie de l’optimisation pour l’informatique et le machine learning »: Un e-book gratuit co-écrit par Jean Gallier et Jocelyn Quaintance, couvrant de manière exhaustive les bases mathématiques clés nécessaires à l’informatique et au machine learning, y compris l’algèbre linéaire, la géométrie affine et projective, la géométrie des formes bilinéaires, la topologie et le calcul différentiel et intégral, l’optimisation linéaire et non linéaire, et contenant des exemples d’application en machine learning. (Source: TheTuringPost)

Suggestions pédagogiques pour les cours d’initiation à l’IA dans les établissements d’enseignement professionnel supérieur: Concernant les cours d’initiation à l’IA dispensés intégralement en salle informatique dans les établissements d’enseignement professionnel supérieur, il est suggéré que l’accent soit mis sur l’application de l’IA générative, en particulier la génération de texte, d’images et de vidéos. En définissant une série de tâches de niveau débutant (questions-réponses, résumé, traduction), intermédiaire (rédaction, extraction de données, recherche assistée par IA/RAG) à avancé (programmation assistée par IA, analyse de données), les étudiants apprennent par la pratique, développent leur intérêt et complètent de manière autonome leurs connaissances théoriques. (Source: dotey)

💼 Affaires

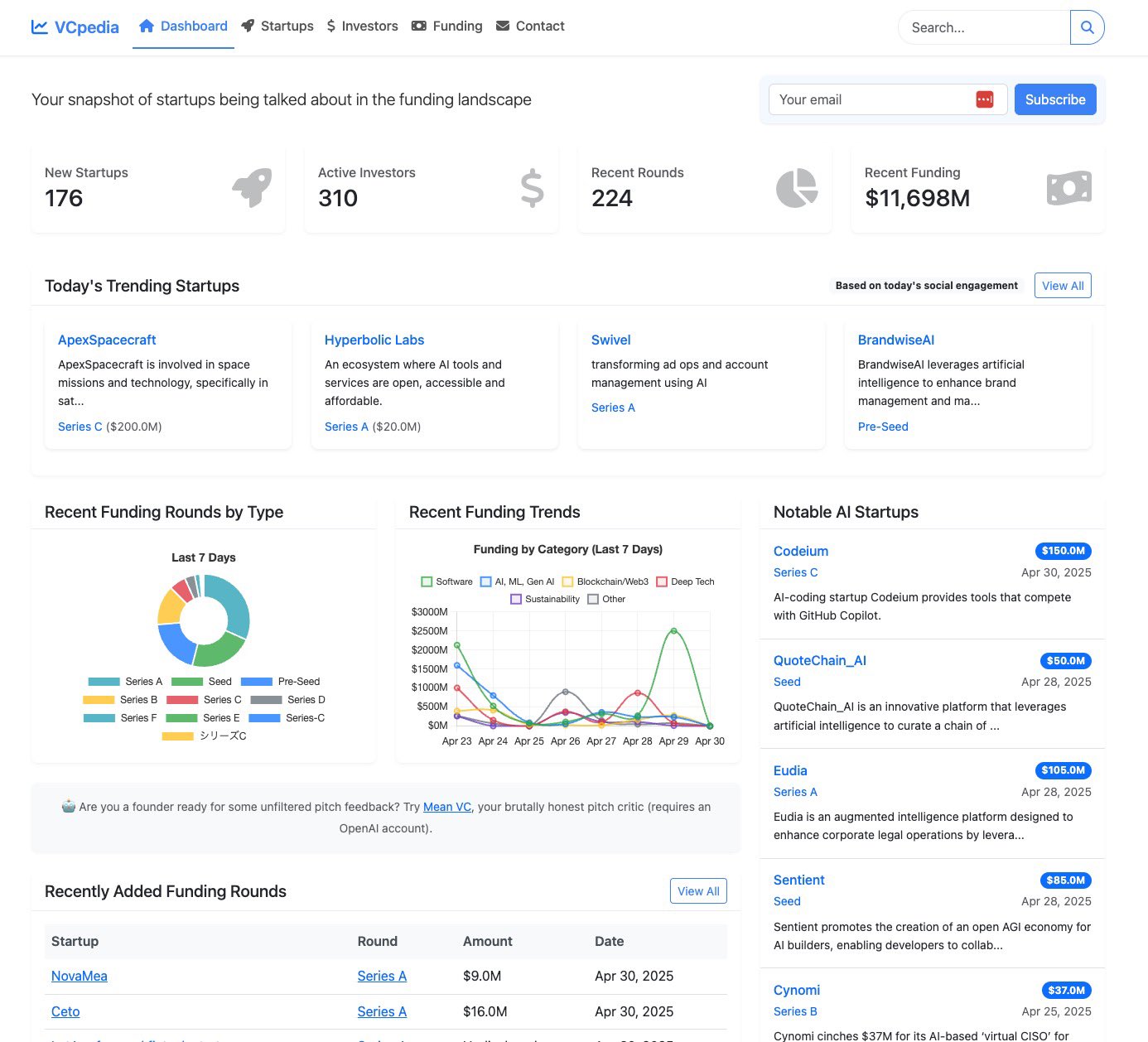

VCpedia : Plateforme d’intelligence sur les startups alimentée par l’IA: Yohei Nakajima a lancé VCpedia, un service de briefing quotidien qui utilise l’IA pour analyser les discussions sur le financement des startups sur la plateforme X, enrichit les informations avec OpenAI et ExaAI, et est construit via un Agent Replit. Cette plateforme vise à fournir aux sociétés de capital-risque une découverte de transactions et des informations alimentées par l’IA. (Source: yoheinakajima)

Rumeur : OpenAI pourrait ajuster sa stratégie de tarification de l’API ChatGPT: Des informations suggèrent que ChatGPT pourrait ajuster la tarification de son API, introduisant un modèle de facturation par crédits (par exemple, 50 crédits/dollar, avec un minimum de 20 dollars et un maximum de 1000 dollars). Ce changement potentiel suscite l’inquiétude des utilisateurs, certains indiquant que si les utilisateurs Plus et Pro devaient également payer les frais d’API à ce tarif, ils pourraient envisager de se tourner vers des concurrents comme Grok ou Gemini. (Source: scaling01)

Le Chinois Baidu dépose un brevet pour l’interprétation par IA des sons d’animaux: Le géant technologique chinois Baidu cherche à obtenir un brevet pour un système d’intelligence artificielle capable d’interpréter les sons des animaux. Si cette technologie aboutit, elle pourrait ouvrir de nouvelles possibilités dans des domaines tels que l’étude du comportement animal, la conservation des espèces et la communication entre l’homme et l’animal. (Source: Reddit r/artificial)

🌟 Communauté

Des utilisateurs discutent de l’impact de l’IA sur les relations interpersonnelles et la santé mentale: Un message sur Reddit intitulé « J’ai perdu ma mère à cause de ChatGPT » a suscité un vif débat. L’auteur affirme que sa mère est devenue obsédée par ses échanges avec ChatGPT, ce qui a conduit à un éloignement familial et même à une dépendance émotionnelle à l’IA. Les commentaires explorent la satisfaction des besoins émotionnels par l’IA, le sentiment de solitude dans la réalité, l’aliénation technologique et la manière d’équilibrer l’utilisation de la technologie et les interactions humaines. De nombreux commentaires soulignent que la mère se sentait peut-être déjà seule et que l’IA n’a fait que combler un vide émotionnel, suggérant à l’auteur de communiquer davantage avec sa mère et de lui tenir compagnie. (Source: Reddit r/ChatGPT)

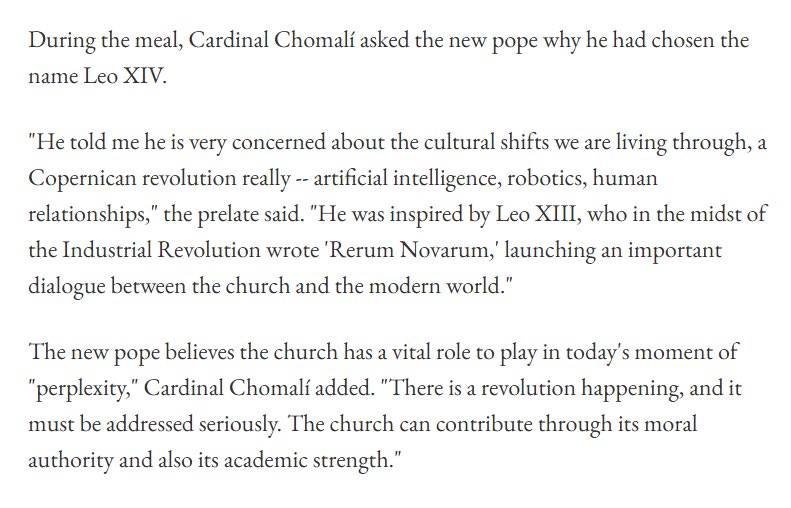

Le choix du nom « Léon XIV » par le nouveau Pape pourrait être inspiré par le développement de l’IA: Des reportages et des discussions indiquent que le nouveau Pape élu a choisi « Léon XIV » comme nom pontifical, en partie en raison de sa profonde préoccupation face aux changements culturels induits par l’intelligence artificielle, la robotique, etc. Il s’inspire de l’encyclique « Rerum Novarum » publiée par Léon XIII à l’époque de la révolution industrielle, estimant que l’Église, à l’ère actuelle de la révolution technologique, doit exercer son autorité morale et sa force intellectuelle pour guider la société à faire face sérieusement aux changements. Ce sujet a suscité des réflexions sur l’éthique de l’IA, son impact social et la manière dont les institutions religieuses s’adaptent au développement technologique. (Source: jpt401, AndrewLampinen, jachiam0, itsclivetime)

La génération d’images de la « femme idéale » par l’IA suscite la discussion: Un utilisateur de Reddit a partagé des images de sa « femme idéale » générées par ChatGPT en fonction de ce que l’IA savait de lui, les résultats étant souvent des femmes en armure. Cela a incité les membres de la communauté à faire de même et à partager leurs propres résultats générés par l’IA, discutant de la compréhension par l’IA du concept d’« idéal », de la manière dont les données utilisateur influencent le contenu généré, et des biais ou motifs courants dans les images générées par l’IA. (Source: Reddit r/ChatGPT)

Idée créative de génération d’images IA : « figurines et personnes réelles dans le même cadre »: Un utilisateur des médias sociaux a partagé des images générées par IA mettant en scène des figurines d’anime et les personnages réels correspondants dans des poses similaires, et a fourni les prompts. Cette idée créative démontre l’aspect ludique et la personnalisation de la génération d’images par l’IA, capable de créer des œuvres visuelles pleines de vie et d’effets de contraste basées sur les descriptions spécifiques de l’utilisateur. (Source: dotey)

Augmentation de la demande de compétences sur le framework DSPy dans le domaine de l’IA/ML: Le marché de l’emploi connaît une demande croissante de talents ayant une expérience avec DSPy (un framework pour l’optimisation programmatique des prompts et des poids des modèles de langage). Cela reflète l’importance accordée par l’industrie à la construction d’applications de modèles de langage plus contrôlables, efficaces et capables d’optimisation algorithmique. (Source: lateinteraction)

Discussion sur l’état actuel et l’acceptation de l’IA sur le lieu de travail: Des utilisateurs de Reddit discutent de l’utilisation de l’IA au travail, ainsi que de l’opinion des employeurs et des collègues à ce sujet. La majorité des utilisateurs déclarent que l’IA améliore efficacement leur productivité, par exemple pour l’aide à la programmation, la rédaction d’e-mails et de rapports, les comptes rendus de réunion, les études de marché, etc. Certaines entreprises encouragent l’utilisation de l’IA, tandis que d’autres sont prudentes ou opposées, ce qui peut amener les employés à l’utiliser discrètement. La discussion souligne le potentiel de l’IA pour augmenter la productivité, tout en abordant les questions de la perception correcte des capacités de l’IA et de la sécurité des données. (Source: Reddit r/ArtificialInteligence)

L’IA est-elle en train d’éroder l’avantage concurrentiel principal de Reddit – l’interaction humaine ?: Un article de Business Insider souligne que le PDG de Reddit considère sa communauté dominée par les humains comme son plus grand avantage concurrentiel, mais les messages et commentaires générés par des robots IA menacent cet avantage. Reddit a reconnu le problème et prévoit d’introduire de nouveaux mécanismes pour vérifier l’identité des utilisateurs, ce qui soulève des discussions sur la prolifération du contenu IA, l’authenticité des communautés et la manière dont les futures plateformes en ligne feront face au contenu généré par l’IA. (Source: Reddit r/artificial, Business Insider)

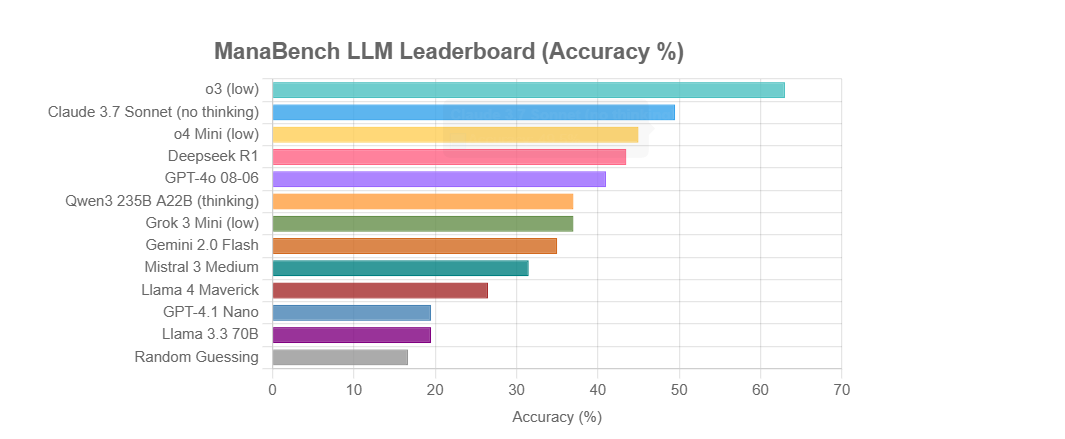

ManaBench : Un nouveau benchmark pour tester les capacités de raisonnement des LLM via la construction de decks de Magic: The Gathering: Jake Boggs a publié ManaBench, un nouveau benchmark qui teste les capacités de raisonnement des grands modèles de langage (LLM) à travers des tâches de construction de decks de Magic: The Gathering. Ce benchmark ne se concentre pas sur la connaissance du jeu, mais évalue le raisonnement stratégique et la compréhension systémique des modèles, visant à fournir une différenciation des modèles pertinente pour l’expérience utilisateur. (Source: Teknium1)

Un utilisateur partage son expérience d’utilisation de l’IA pour des recherches approfondies converties en audio pour l’écoute: Un utilisateur partage son expérience d’utilisation de ChatGPT pour effectuer des recherches approfondies sur des sujets, puis d’utiliser des outils comme Speechify pour convertir les résultats de la recherche en audio avec la voix d’Obama pour les écouter. Cette pratique illustre le potentiel de l’IA dans l’acquisition d’informations et la consommation de contenu personnalisé, mais soulève également des questions sur la possible baisse des capacités de lecture due à une dépendance excessive à l’IA. (Source: Reddit r/artificial)

💡 Divers

Un ancien membre de l’équipe des risques liés à l’IA du gouvernement britannique révèle des problèmes éthiques et les représailles subies: Un ancien employé de la fonction centrale des risques liés à l’IA du gouvernement britannique a déclaré publiquement qu’après avoir soulevé des préoccupations au sein de l’équipe concernant les biais de l’IA, la discrimination et d’autres questions éthiques, il a subi un blocage, une surveillance et des représailles institutionnelles. Cet incident a suscité un débat sur la protection des « lanceurs d’alerte » dans les environnements technologiques gouvernementaux et sur l’efficacité des mécanismes de responsabilité publique en matière d’éthique de l’IA. (Source: Reddit r/ArtificialInteligence)

L’impact indirect de l’IA sur les emplois « à l’épreuve de l’IA »: Une discussion souligne que même si certains secteurs qualifiés (comme les artisans) ne sont pas facilement remplaçables directement par l’IA, si l’IA provoque un chômage de masse, la base de consommateurs se réduira, et ces emplois « à l’épreuve de l’IA » seront également touchés par une demande insuffisante. Cela nous incite à considérer l’impact de l’IA sur l’emploi d’un point de vue économique systémique plus large. (Source: Reddit r/artificial)

Point de vue : Les LLM exploitent les biais cognitifs humains en simulant l’intelligence: Pedro Domingos estime que les grands modèles de langage (LLM) excellent à générer du texte qui semble intelligent, ce qui exploite la faiblesse cognitive de certaines personnes à distinguer la véritable intelligence du « baratin » (BS). (Source: pmddomingos)