Mots-clés:OpenAI, Modèle d’IA, Grand modèle linguistique, Infrastructure d’IA, Recherche IA, Agent IA, Commercialisation de l’IA, PDG du département des applications OpenAI, Programme OpenAI pour les pays, Alternative de recherche pilotée par l’IA, Modèle multimodal Mistral Medium 3, Risques de l’IA sur la santé mentale

🔥 Pleins feux

OpenAI nomme une nouvelle CEO pour diriger sa division des applications: OpenAI a annoncé la nomination de Fidji Simo, ancienne CEO d’Instacart, au poste de nouvelle CEO de la division des applications, rapportant directement à Sam Altman. Altman continuera d’occuper le poste de CEO global d’OpenAI, mais se concentrera davantage sur la recherche, le calcul et la sécurité, en particulier durant la phase cruciale vers la superintelligence. Simo, qui siégeait déjà au conseil d’administration d’OpenAI, possède une riche expérience en matière de produits et d’opérations. Cette nomination vise à renforcer les capacités de production et de commercialisation d’OpenAI, afin de mieux diffuser les résultats de la recherche auprès des utilisateurs du monde entier. Cette décision est considérée comme un ajustement structurel organisationnel d’OpenAI pour équilibrer la recherche, l’infrastructure et la mise en œuvre des applications, dans un contexte de développement rapide et de concurrence féroce. (Source: openai, gdb, jachiam0, kevinweil, op7418, saranormous, markchen90, dotey, snsf, 36氪)

OpenAI lance le programme “OpenAI for Countries” pour étendre son infrastructure d’IA mondiale: OpenAI a annoncé le lancement du programme “OpenAI for Countries”, visant à collaborer avec des pays du monde entier pour construire des infrastructures d’IA localisées et promouvoir ce qu’elle appelle une “IA démocratique”. Ce programme comprend la construction de data centers à l’étranger (en extension de son projet “Stargate”), le lancement de versions de ChatGPT adaptées aux langues et cultures locales, le renforcement de la sécurité de l’IA et la création de fonds de capital-risque nationaux. Cette initiative est perçue comme une étape stratégique pour OpenAI afin de consolider sa position de leader technologique et d’étendre son influence mondiale dans un contexte de concurrence accrue dans le domaine de l’IA. Elle pourrait également l’aider à acquérir des talents et des ressources de données à l’échelle mondiale, accélérant ainsi la R&D en matière d’AGI. (Source: 36氪, 36氪)

L’IA révolutionne la recherche, Apple envisage des alternatives de recherche IA pour Safari: Eddy Cue, vice-président senior des services d’Apple, a révélé lors de son témoignage dans le procès antitrust contre Google qu’Apple “envisage activement” d’introduire des options de moteur de recherche alimentées par l’IA dans son navigateur Safari, et a eu des discussions avec des sociétés telles que Perplexity, OpenAI et Anthropic. Cue estime que la recherche par IA est la tendance du futur, et bien qu’elle ne soit pas encore parfaite, son potentiel est énorme et pourrait à terme remplacer les moteurs de recherche traditionnels. Il a également souligné qu’en avril de cette année, le volume de recherche de Safari a diminué pour la première fois, en partie peut-être parce que les utilisateurs se tournent vers des outils d’IA. Cette tendance suggère que le partenariat de longue date entre Apple et Google concernant le moteur de recherche par défaut pourrait changer, suscitant des inquiétudes sur l’avenir des activités de recherche de Google et provoquant une chute de plus de 9 % du cours de l’action Alphabet. (Source: 36氪, Reddit r/artificial, pmddomingos)

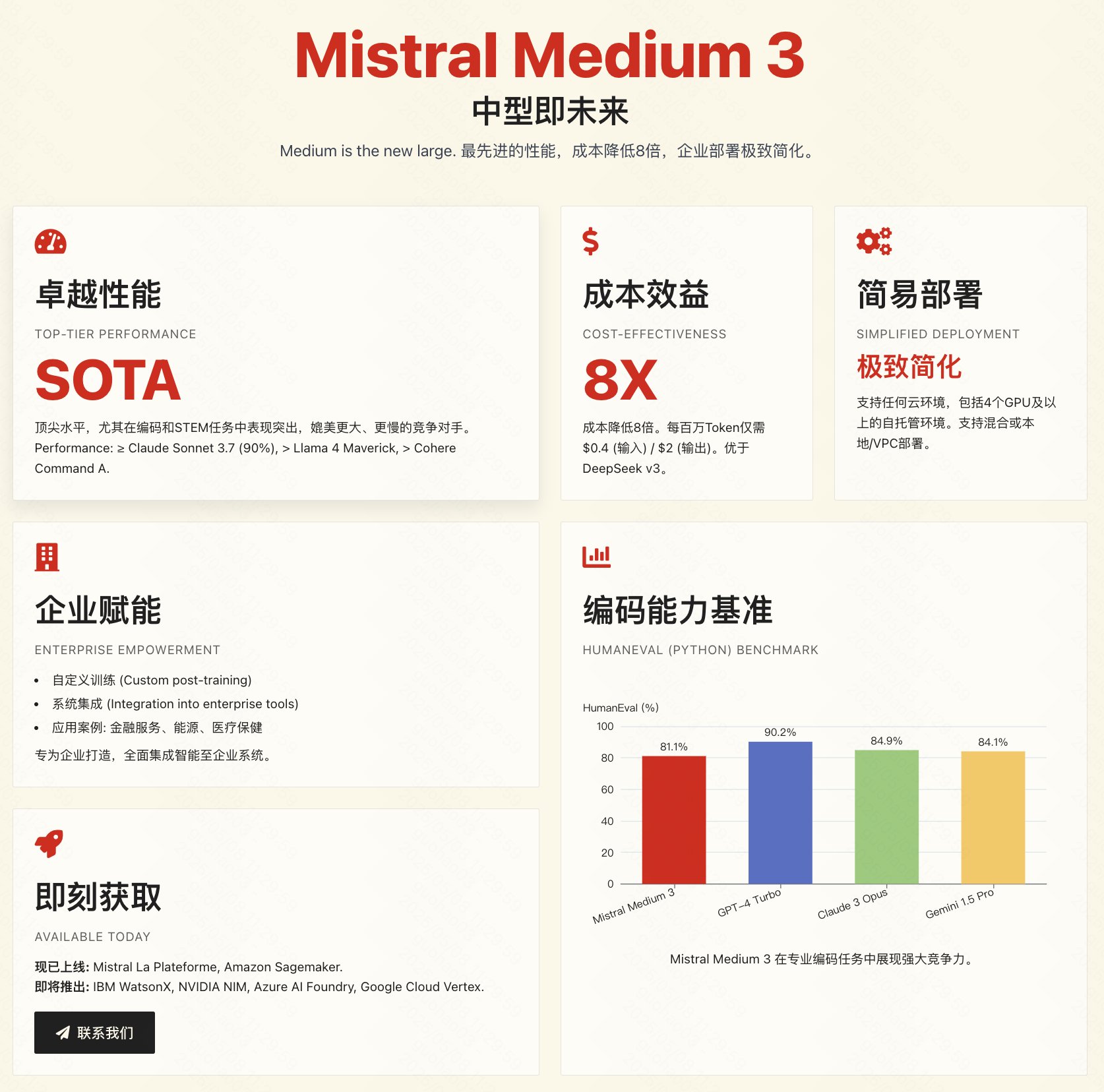

Mistral lance le modèle multimodal Medium 3, axé sur le rapport coût-performance et les applications d’entreprise: La société française d’IA Mistral AI a lancé son nouveau modèle multimodal, Mistral Medium 3. Officiellement, ce modèle se rapproche en termes de performances des modèles de pointe tels que Claude 3.7 Sonnet, excellant particulièrement dans les tâches de programmation et de STEM, mais avec un coût considérablement réduit, environ 1/8 de celui des produits comparables (entrée 0,4 $/1M tokens, sortie 2 $/1M tokens), voire inférieur à celui de modèles à bas prix comme DeepSeek V3. Le modèle prend en charge le cloud hybride, le déploiement local et offre des fonctionnalités d’entreprise telles que le fine-tuning personnalisé. L’API est actuellement disponible sur Mistral La Plateforme et Amazon Sagemaker. Bien que l’entreprise mette l’accent sur le rapport coût-performance et l’adéquation aux entreprises, les premiers tests de la communauté sont mitigés, certains utilisateurs estimant que ses performances n’atteignent pas tout à fait le niveau annoncé et exprimant leur déception quant à sa non-publication en open source. (Source: op7418, arthurmensch, 36氪, 36氪, scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, TheRundownAI, 36氪)

🎯 Tendances

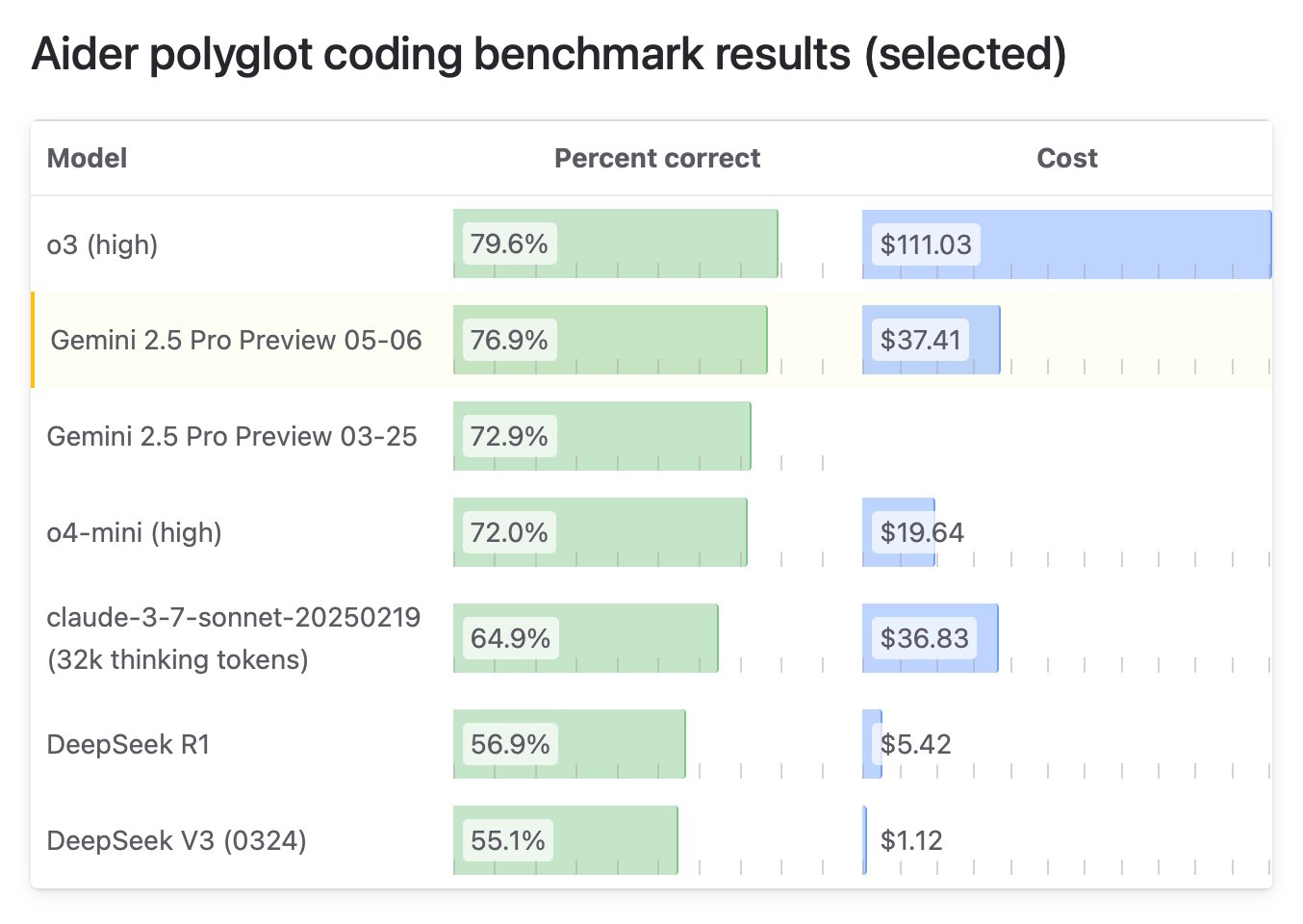

Google lance une édition spéciale “I/O” de Gemini 2.5 Pro, avec des capacités de programmation de premier plan: Google DeepMind a lancé une version améliorée de Gemini 2.5 Pro, baptisée “I/O”, spécialement optimisée pour l’appel de fonctions et les capacités de programmation. Sur le benchmark WebDev Arena Leaderboard, ce modèle a surpassé Claude 3.7 Sonnet avec un score de 1419.95, se classant pour la première fois en tête de ce benchmark clé en programmation. Le nouveau modèle excelle également dans la compréhension vidéo, dominant le benchmark VideoMME. Ce modèle est disponible via l’API Gemini, Vertex AI et d’autres plateformes, au même prix que le Gemini 2.5 Pro original, et vise à offrir des capacités accrues de génération de code et de création d’applications interactives. (Source: _philschmid, aidan_mclau, 36氪)

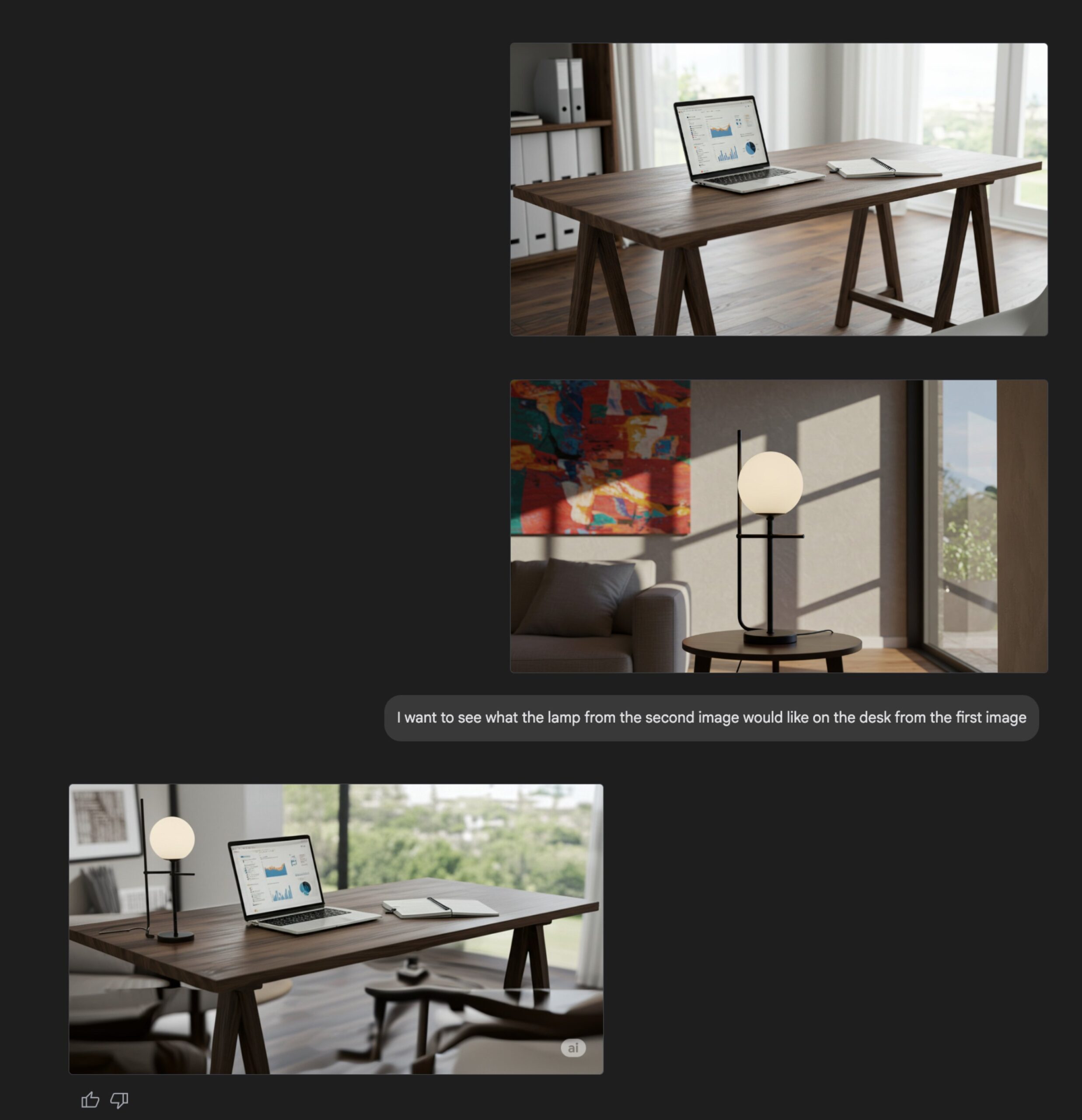

Mise à niveau de la fonction de génération d’images de Gemini Flash: La capacité native de génération d’images du modèle Gemini Flash de Google a été mise à jour. La version préliminaire est désormais disponible et les limites de taux ont été augmentées. Selon les informations officielles, la nouvelle version présente des améliorations en termes de qualité visuelle et de précision du rendu du texte, et réduit considérablement le taux de blocage dû au filtrage. Les utilisateurs peuvent l’expérimenter gratuitement sur Google AI Studio, et les développeurs peuvent l’intégrer via l’API au prix de 0,039 $ par image. (Source: op7418, 36氪)

L’API d’Anthropic ajoute une fonctionnalité de recherche web: Anthropic a annoncé l’ajout d’un outil de recherche web à son API, permettant aux développeurs de créer des applications Claude capables d’exploiter des informations web en temps réel. Cette fonctionnalité permet à Claude d’accéder aux données les plus récentes pour enrichir sa base de connaissances, et les réponses générées incluront des citations de sources. Les développeurs peuvent contrôler la profondeur de la recherche via l’API et définir des listes blanches/noires de domaines pour gérer la portée de la recherche. Cette fonctionnalité est actuellement compatible avec Claude 3.7 Sonnet, la version améliorée de 3.5 Sonnet et 3.5 Haiku, au prix de 10 $ pour 1000 recherches, en plus des coûts standard des tokens. (Source: op7418, swyx, Reddit r/ClaudeAI)

Microsoft publie en open source le modèle d’inférence Phi-4, mettant l’accent sur la chaîne de raisonnement et la pensée lente: Microsoft Research a publié en open source le modèle de langage Phi-4-reasoning-plus de 14 milliards de paramètres, spécialement conçu pour les tâches de raisonnement structuré. Ce modèle met l’accent sur la “chaîne de pensée” (Chain-of-Thought) lors de l’entraînement, encourageant le modèle à détailler ses étapes de réflexion, et adopte un mécanisme de récompense spécial en apprentissage par renforcement : en cas de réponse incorrecte, il encourage des chaînes de raisonnement plus longues, et en cas de réponse correcte, il encourage la concision. Cette méthode d’entraînement de “pensée lente” et “permettant l’erreur” lui permet d’exceller dans les benchmarks de mathématiques, de sciences, de code, etc., surpassant même des modèles plus volumineux sur certains aspects, et démontrant une forte capacité de transfert interdomaines. (Source: 36氪)

NVIDIA lance la série de modèles OpenCodeReasoning: NVIDIA a publié la série de modèles OpenCodeReasoning-Nemotron sur Hugging Face, comprenant les versions 7B, 14B, 32B et 32B-IOI. Ces modèles se concentrent sur les tâches de raisonnement de code, visant à améliorer les capacités de l’IA en matière de compréhension et de génération de code. La communauté a commencé à créer des formats GGUF pour une exécution locale. Certains commentateurs estiment que l’utilité de ces modèles axés sur la programmation compétitive pourrait être limitée et attendent les résultats des tests pratiques. (Source: Reddit r/LocalLLaMA)

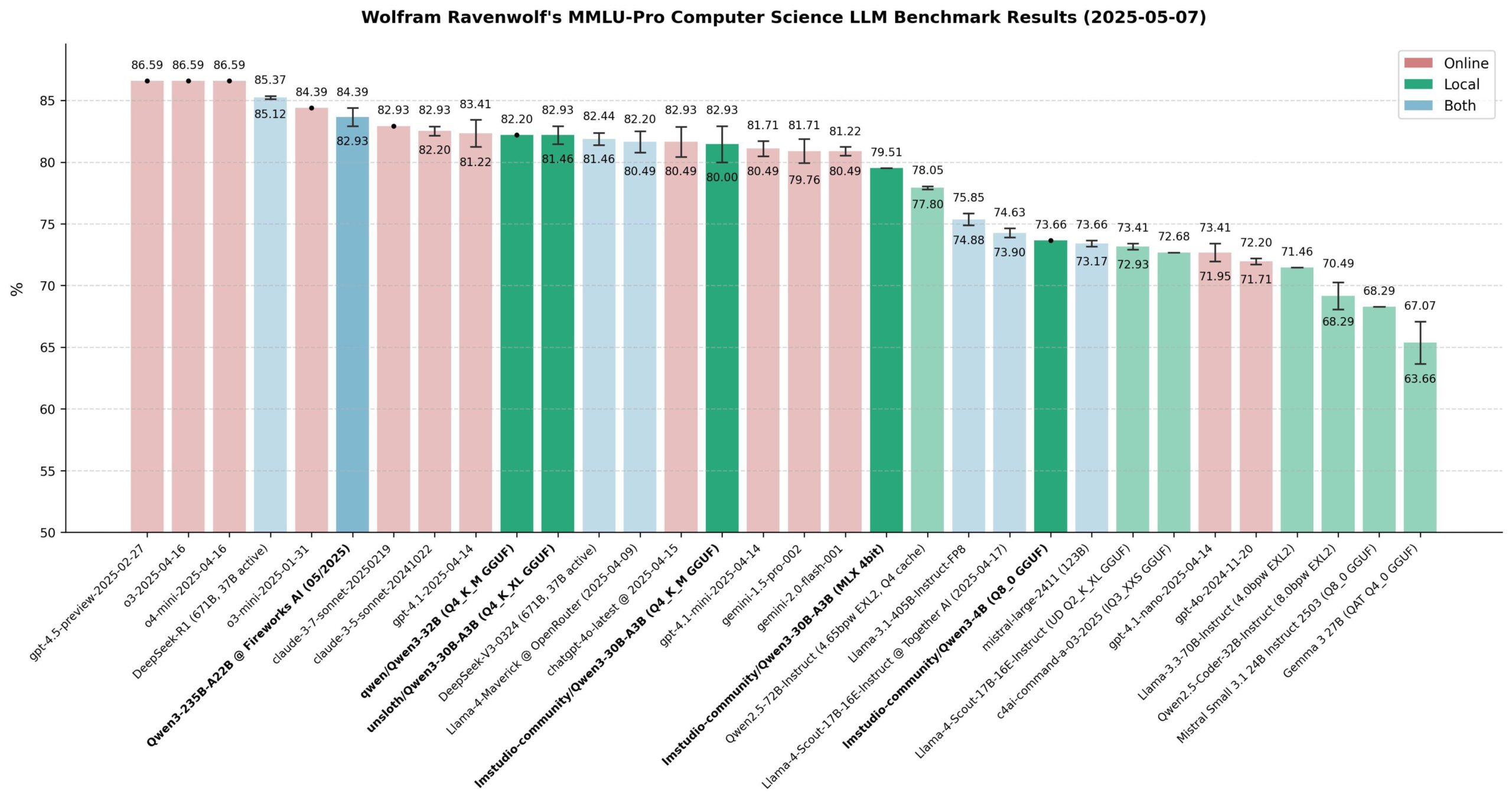

Évaluation des performances des modèles Qwen 3: La communauté a procédé à une évaluation approfondie des modèles de la série Qwen 3, notamment sur le benchmark MMLU-Pro (CS). Les résultats montrent que le modèle 235B est le plus performant, mais les modèles quantifiés 30B (comme la version Unsloth) sont très proches en termes de performances, tout en étant rapides à exécuter localement et peu coûteux, offrant un excellent rapport qualité-prix. Sur Apple Silicon, la version MLX du modèle 30B atteint un bon équilibre entre vitesse et qualité. L’évaluation conclut que pour la plupart des applications RAG ou Agent locales, le modèle 30B quantifié est devenu le nouveau choix par défaut, avec des performances proches de celles des modèles de pointe. (Source: Reddit r/LocalLLaMA)

Xueersi lance une machine d’apprentissage intégrant un grand modèle à double noyau: Xueersi a lancé trois nouvelles séries de machines d’apprentissage, P, S et T, équipées du grand modèle Jiuzhang développé en interne et de l’IA à double noyau DeepSeek. Les fonctionnalités phares incluent l’interaction intelligente “Xiaosi AI 1-to-1”, capable de guider activement les élèves à poser des questions et à explorer ; et Precise Learning 3.0 qui améliore l’efficacité grâce au “filtrage de l’apprentissage” et au “filtrage des exercices”. La machine d’apprentissage intègre de riches ressources de cours et de matériel pédagogique (tels que Xiaohou, Mobi, 5·3, Wanwei), et propose des cours de transition et des entraînements aux nouveaux types de questions en réponse aux nouveaux programmes scolaires. Les différentes séries ciblent différents niveaux scolaires et besoins, visant à fournir une expérience d’apprentissage intelligente et personnalisée grâce à une “bonne IA + bon contenu”. (Source: 量子位)

L’IA accélère l’évaluation des médicaments, le projet cderGPT d’OpenAI révélé: Selon des rapports, OpenAI développe un projet nommé cderGPT, visant à utiliser l’IA pour accélérer le processus d’évaluation des médicaments de la Food and Drug Administration (FDA) américaine. Les dirigeants d’OpenAI ont déjà discuté de ce sujet avec la FDA et les départements concernés. Des responsables de la FDA ont également indiqué avoir achevé la première évaluation de produit scientifique assistée par l’IA et estiment que l’IA a le potentiel de réduire les délais de mise sur le marché des médicaments. Cependant, la fiabilité de l’IA dans les évaluations à haut risque (comme le problème des hallucinations) ainsi que les normes de formation des données et de validation des modèles restent des questions préoccupantes. Ce projet met en évidence le potentiel et les défis de l’application de l’IA dans les domaines de la science réglementaire et du développement de médicaments. (Source: 36氪)

Les entreprises de grands modèles explorent la gestion communautaire pour renforcer la fidélité des utilisateurs: À l’instar de Kimi de Moonshot AI qui teste un produit communautaire de contenu et d’OpenAI qui prévoit de développer un logiciel social, les entreprises de grands modèles tentent de résoudre le problème de l‘“utilisation unique” des outils d’IA en construisant des communautés afin de renforcer la fidélité des utilisateurs. Les communautés peuvent rassembler les utilisateurs, générer du contenu, consolider les relations et servir de canal pour les tests de produits et les retours d’utilisateurs. Cependant, la gestion communautaire est confrontée à de multiples défis, tels que le maintien de la qualité du contenu, la surveillance de la sécurité du contenu et la monétisation. Dans un contexte où le modèle de “brûler de l’argent” pour attirer du trafic est difficilement soutenable, la communautarisation devient une tentative pour les entreprises de grands modèles d’explorer de nouvelles voies de croissance. (Source: 36氪)

Amélioration significative des performances de la reproduction open source de DeepSeek R1: Une équipe conjointe d’institutions telles que SGLang et Nvidia a publié un rapport présentant les résultats de l’optimisation du déploiement de DeepSeek-R1 sur 96 GPU H100. Grâce à l’optimisation de l’inférence SGLang, incluant la séparation pré-remplissage/décodage (PD), le parallélisme d’experts à grande échelle (EP), DeepEP, DeepGEMM et EPLB, les performances d’inférence du modèle ont été multipliées par 26 en seulement 4 mois, le débit se rapprochant déjà des données officielles de DeepSeek. Cette solution de mise en œuvre open source réduit considérablement les coûts de déploiement et démontre la possibilité d’étendre efficacement la capacité d’inférence des grands modèles MoE. (Source: 36氪)

Cisco présente un prototype de puce d’intrication pour réseaux quantiques: Cisco, en collaboration avec l’Université de Californie à Santa Barbara, a développé un prototype de puce destiné à l’interconnexion d’ordinateurs quantiques. Cette puce utilise des paires de photons intriqués et vise à réaliser une connexion instantanée entre ordinateurs quantiques via la téléportation quantique, ce qui pourrait réduire le délai de mise en service des grands ordinateurs quantiques de plusieurs décennies à 5-10 ans. Contrairement à l’approche axée sur l’augmentation du nombre de qubits, Cisco se concentre sur la technologie d’interconnexion, espérant ainsi accélérer le développement de l’ensemble de l’écosystème quantique. Cette puce utilise certaines technologies existantes des puces réseau et pourrait être appliquée à la synchronisation temporelle financière, à la détection scientifique et à d’autres domaines avant la popularisation des ordinateurs quantiques. (Source: 36氪)

Le CEO de Nvidia, Jensen Huang, parle de la révolution industrielle de l’IA et du marché chinois: Lors de la Milken Global Conference, Jensen Huang a qualifié le développement de l’IA de révolution industrielle, proposant que les entreprises futures adopteront un modèle de “double usine” : une usine physique produisant des produits tangibles, et une usine d’IA (composée de clusters de GPU, de data centers) produisant des “unités d’intelligence” (tokens). Il prédit que dans les dix prochaines années, des dizaines d’usines d’IA extrêmement coûteuses (environ 60 milliards de dollars chacune) et énergivores (environ 1 gigawatt chacune) apparaîtront dans le monde, devenant un élément clé de la compétitivité nationale. Il a également exprimé ses inquiétudes concernant les restrictions américaines sur les exportations de technologies vers la Chine, estimant que renoncer au marché chinois (d’une valeur annuelle de 50 milliards de dollars) céderait la domination technologique à des concurrents (comme Huawei), accélérerait la fragmentation de l’écosystème mondial de l’IA et pourrait finalement affaiblir l’avantage technologique des États-Unis. (Source: 36氪)

🧰 Outils

ACE-Step-v1-3.5B : Nouveau modèle de génération de chansons: karminski3 a testé un nouveau modèle de génération de chansons récemment publié, ACE-Step-v1-3.5B. Il a utilisé Gemini pour générer les paroles, puis ce modèle pour créer une chanson de style rock. D’après une première expérience, bien que certaines transitions et la prononciation de mots isolés posent problème, l’effet global est acceptable et convient à la génération de chansons simples et accrocheuses. Ce test a été réalisé sur Hugging Face en utilisant un GPU L40 gratuit et a duré environ 50 secondes. Le modèle et la bibliothèque de code sont tous deux open source. (Source: karminski3)

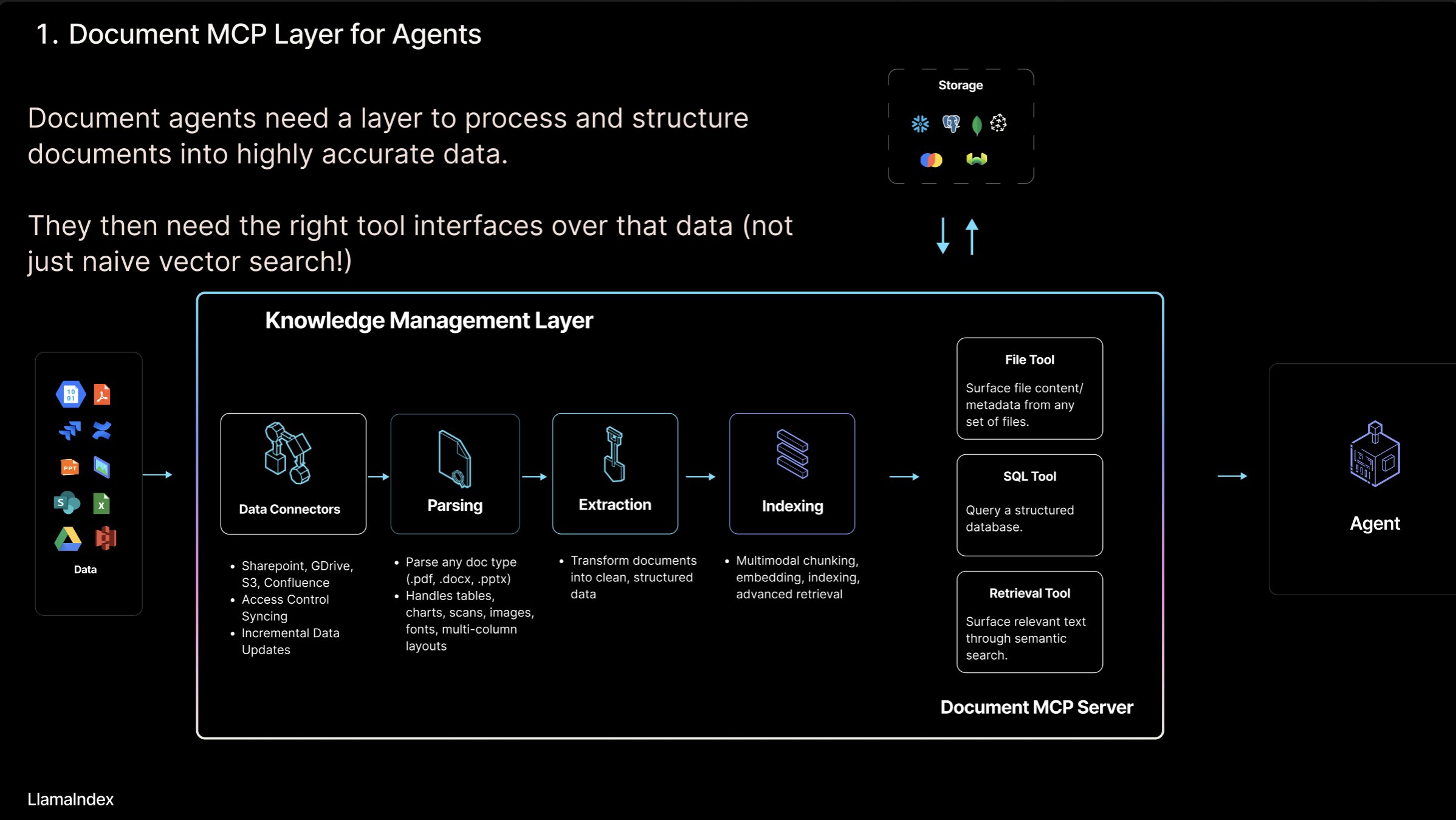

LlamaIndex lance le concept de “serveur MCP de documents” et l’outil LlamaCloud: Jerry Liu, fondateur de LlamaIndex, a proposé le concept de “serveur MCP (Model Context Protocol) de documents”, visant à redéfinir le RAG grâce à l’interaction entre les AI Agents et les outils documentaires. Il estime que les Agents peuvent interagir avec les documents de quatre manières : recherche (requête précise), récupération (recherche sémantique, c’est-à-dire RAG), analyse (requête structurée) et opération (appel de fonctions de type de fichier). LlamaIndex construit ces “outils documentaires” essentiels dans LlamaCloud, tels que l’analyse, l’extraction, l’indexation, etc., pour prendre en charge la création d’Agents plus efficaces. (Source: jerryjliu0)

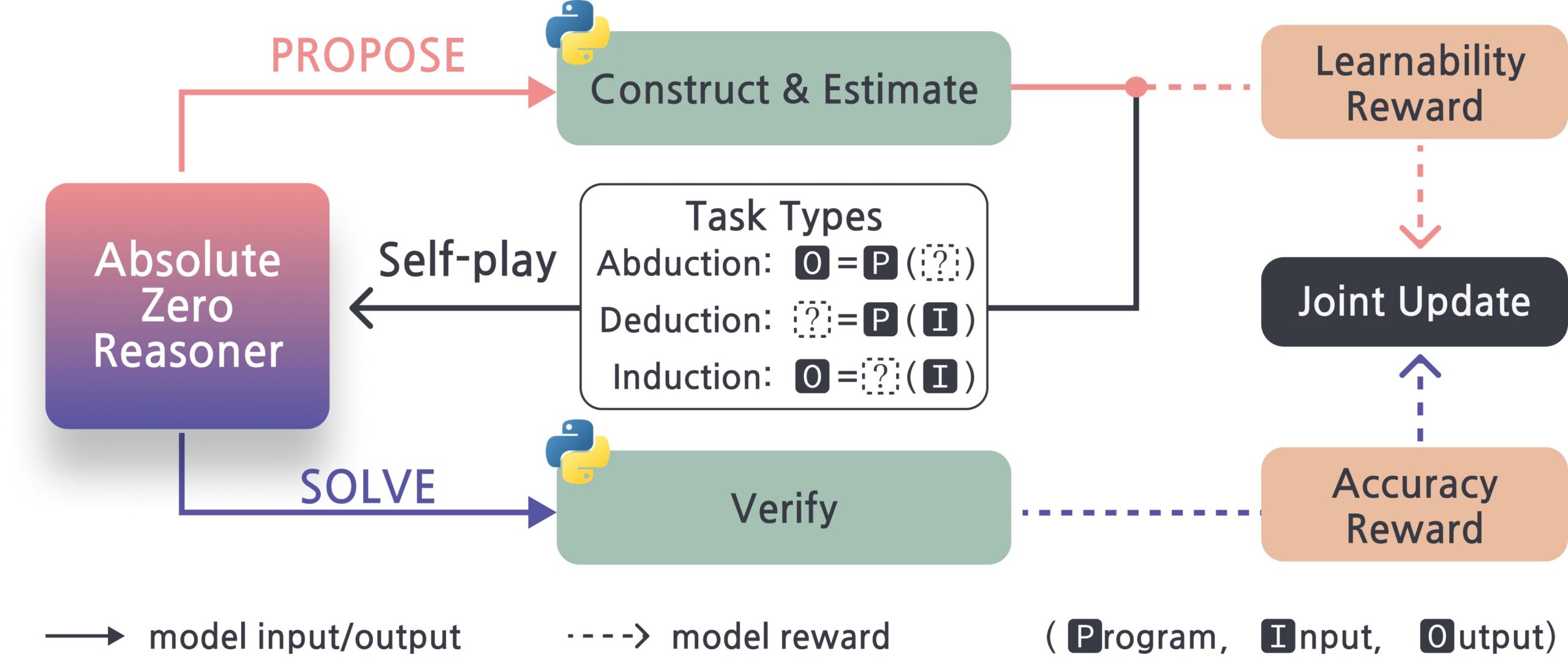

Absolute-Zero-Reasoner : Framework d’auto-amélioration pour les grands modèles: Un nouveau projet nommé Absolute-Zero-Reasoner montre la possibilité pour les grands modèles d’améliorer leurs propres capacités de programmation et de mathématiques par auto-questionnement, écriture de code, exécution de vérifications et itérations cycliques. Selon les données de test de Qwen2.5-7B, cette méthode a permis d’améliorer les capacités de programmation de 5 points et les capacités mathématiques de 15,2 points (sur 100). Cependant, cette méthode est extrêmement gourmande en ressources de calcul ; par exemple, un modèle 7/8B nécessite 4 GPU de 80 Go. Le projet et l’article sont open source. (Source: karminski3, tokenbender)

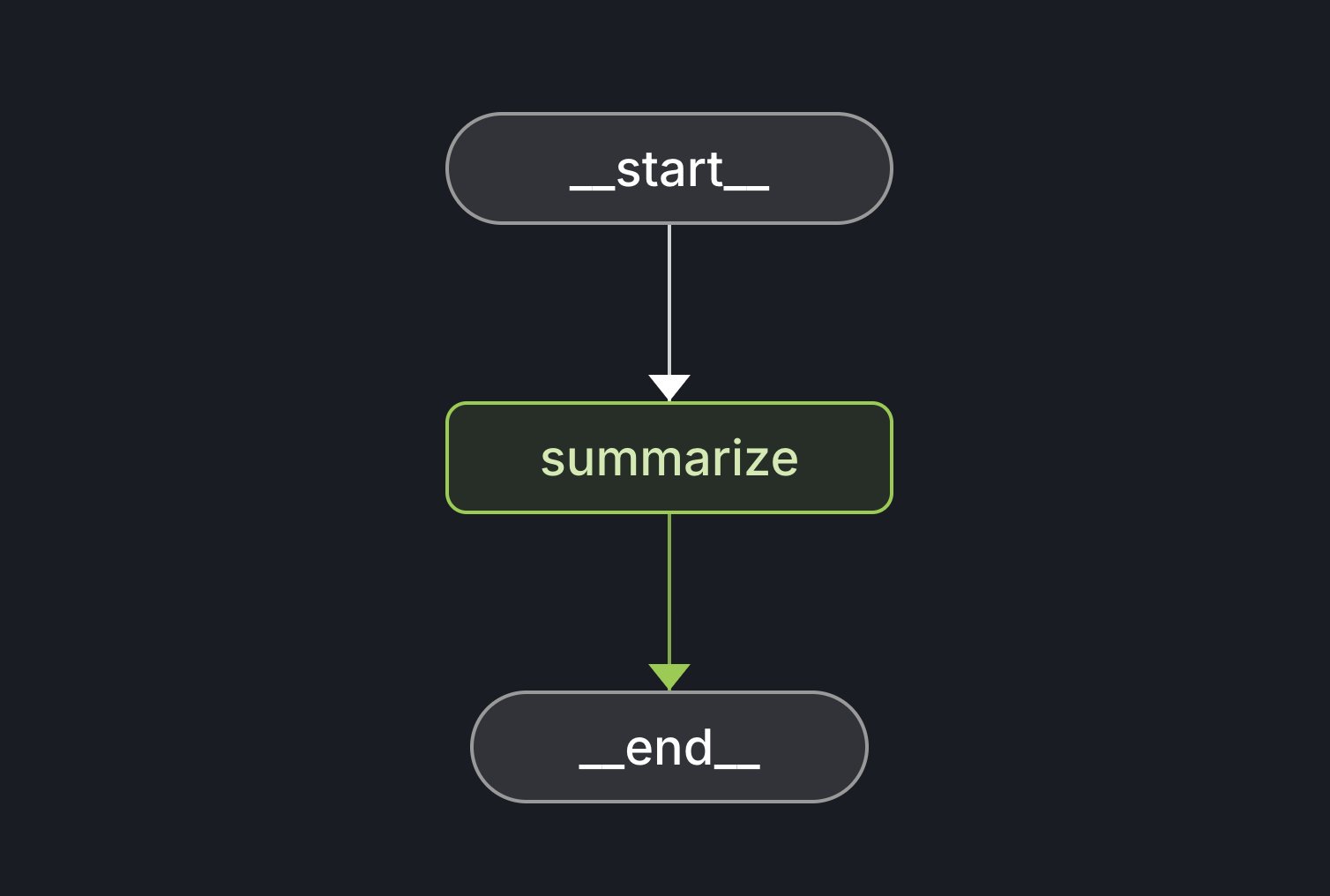

Lancement du LangGraph Starter Kit: LangChain a lancé le LangGraph Starter Kit, conçu pour aider les développeurs à créer facilement un graphe d’Agent déterministe, à fonction unique et performant. Les développeurs peuvent le déployer sur LangGraph Cloud et l’intégrer dans leurs workflows de génération de texte par IA. Ce kit fournit une base pour démarrer et développer rapidement des applications LangGraph. (Source: hwchase17, Hacubu)

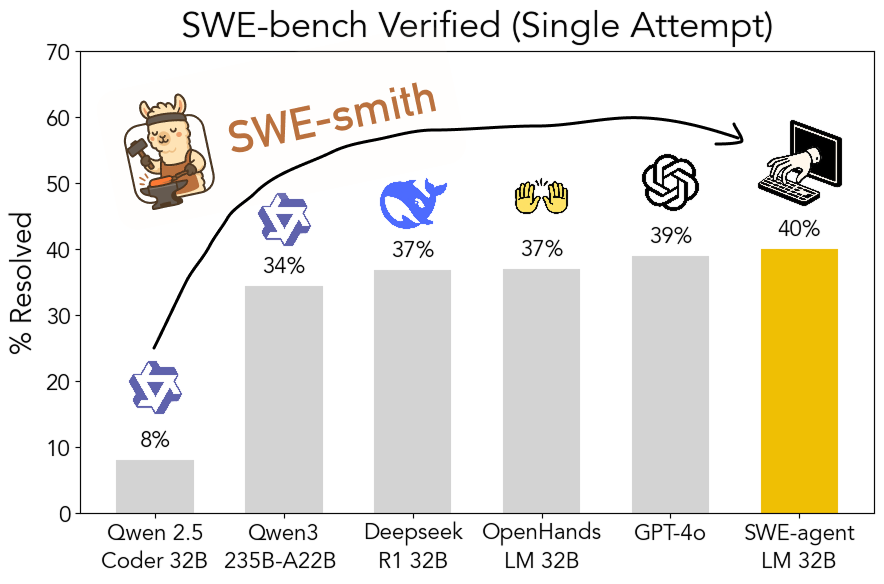

SWE-smith : Boîte à outils open source pour générer des données d’entraînement d’Agents d’ingénierie logicielle: John Yang et d’autres chercheurs de l’Université de Princeton ont publié SWE-smith, une boîte à outils permettant de générer un grand nombre d’instances de tâches d’entraînement d’Agents à partir de dépôts GitHub. En utilisant plus de 50 000 instances de tâches générées par cet outil, ils ont entraîné le modèle SWE-agent-LM-32B, qui a atteint un taux de réussite de 40 % (pass@1) lors du test SWE-bench Verified, devenant ainsi le modèle open source le mieux classé sur ce benchmark. La boîte à outils, l’ensemble de données et le modèle sont tous open source. (Source: teortaxesTex, Reddit r/MachineLearning)

Gamma : Plateforme de création de présentations et de contenu pilotée par l’IA: Gamma est une plateforme qui utilise l’IA pour simplifier la création de contenu tel que des présentations (PPT), des pages web, des documents, etc. Elle se caractérise par une édition “sous forme de cartes” et une conception assistée par l’IA, permettant aux utilisateurs de générer rapidement du contenu esthétique et interactif sans maîtriser le design. Gamma a initialement accumulé des utilisateurs grâce à des fonctionnalités pratiques et un modèle PLG (Product-Led Growth), et après la maturation de la technologie IA (comme l’intégration de Claude, GPT-4o), elle a réalisé des fonctionnalités telles que “générer un PPT en une phrase”. La récente publication de Gamma 2.0 étend son positionnement d’outil IA pour PPT à une “plateforme d’expression créative tout-en-un” plus large, prenant en charge l’identification de marque, l’édition d’images, la génération de graphiques, etc. Selon les rapports, Gamma est devenue rentable, avec un ARR dépassant les 50 millions de dollars. (Source: 36氪)

INAIR : Lunettes AR+AI axées sur les scénarios de bureau léger: La société INAIR développe des lunettes AR et un système d’exploitation spatial associé, INAIR OS, destinés aux scénarios de bureau léger. Ses produits visent à offrir une expérience de bureau portable sur grand écran, prenant en charge la collaboration multi-écrans, compatibles avec les applications Android et capables de diffuser sans fil avec Windows/Mac. INAIR OS intègre un AI Agent, doté de capacités d’assistant vocal, de traduction en temps réel, de traitement de documents et de collaboration sur les tâches. L’entreprise met l’accent sur l’intégration matériel-logiciel et une expérience native de l’intelligence spatiale, construisant des barrières grâce à son système propriétaire et à son adaptation à l’écosystème de bureau. Elle a récemment finalisé un tour de financement de série A de plusieurs dizaines de millions de yuans. (Source: 36氪)

📚 Apprentissage

Discussion sur les modes d’interaction entre les AI Agents et les documents: Jerry Liu, fondateur de LlamaIndex, explore quatre modes d’interaction entre les AI Agents et les documents : la recherche précise (Lookup), la récupération sémantique (Retrieval/RAG), l’analyse (Analytics) et la manipulation (Manipulation). Il estime que la construction d’Agents documentaires efficaces nécessite un solide support d’outils sous-jacents et présente les progrès de LlamaCloud dans ce domaine. (Source: jerryjliu0)

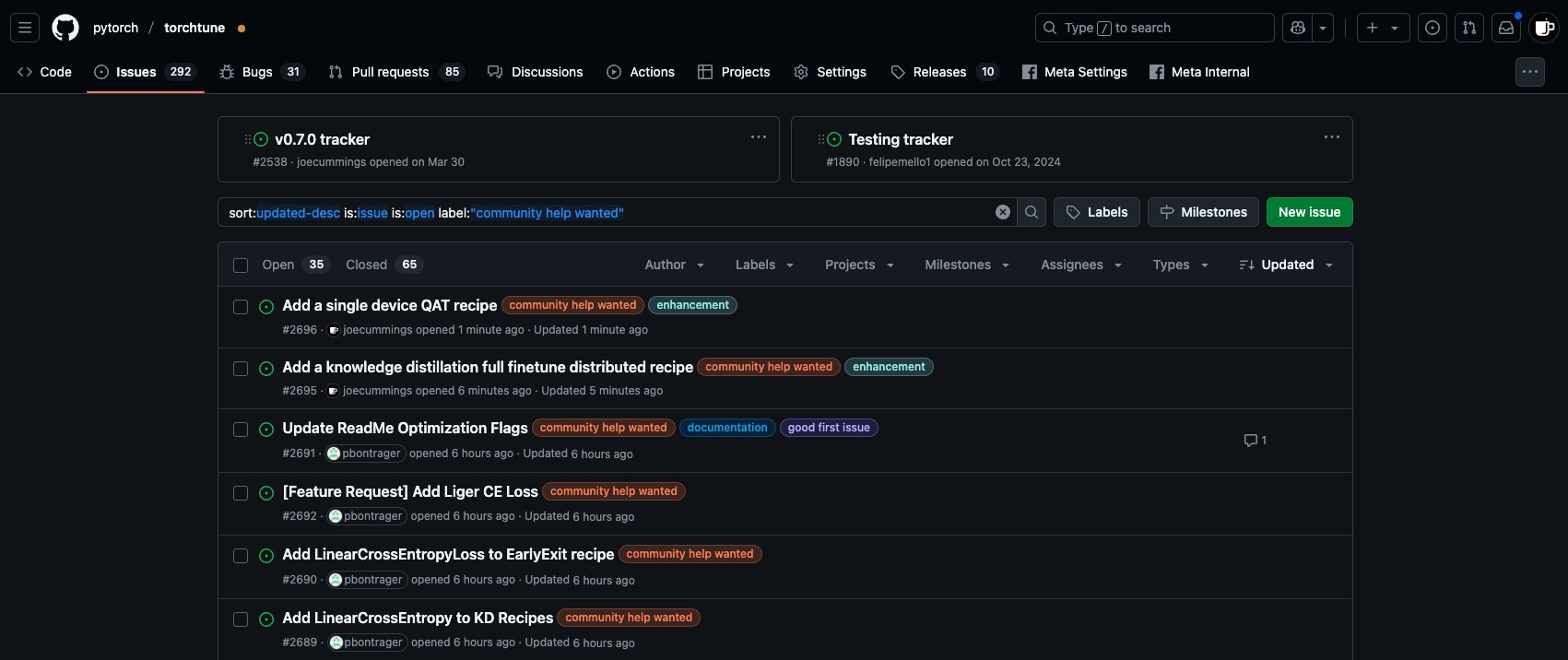

Opportunités de contribution Post-Training dans l’écosystème PyTorch: L’équipe PyTorch a publié de nouvelles tâches ‘community help wanted’ sur le dépôt torchtune, invitant les membres de la communauté à participer aux travaux de post-entraînement des modèles de l’écosystème PyTorch, y compris l’ajout de recettes QAT mono-appareil, l’intégration de la nouvelle LinearCrossEntropy à la distillation des connaissances, etc. (Source: winglian)

Séminaire NLP de Stanford : Mémoire des modèles et sécurité: Le NLP Seminar de l’Université de Stanford invite Pratyush Maini à discuter des “Implications de la recherche sur la mémorisation des modèles pour la sécurité” (What Memorization Research Taught Me About Safety). (Source: stanfordnlp)

FormalMATH : Publication d’un benchmark de raisonnement mathématique formel à grande échelle: Plusieurs institutions ont conjointement publié FormalMATH, un benchmark de test de raisonnement mathématique formel comprenant 5560 problèmes, couvrant des niveaux allant des olympiades de mathématiques à l’université. L’équipe de recherche a proposé un cadre innovant de “filtrage en trois étapes”, utilisant les LLM pour aider à l’automatisation de la formalisation et de la vérification, réduisant considérablement les coûts de construction. Les résultats des tests montrent que le prouveur LLM actuel le plus puissant, Kimina-Prover, n’atteint qu’un taux de réussite de 16,46 % et affiche de mauvaises performances dans des domaines tels que le calcul infinitésimal, révélant les goulots d’étranglement des modèles actuels en matière de raisonnement logique strict. L’article, les données et le code sont open source. (Source: 量子位)

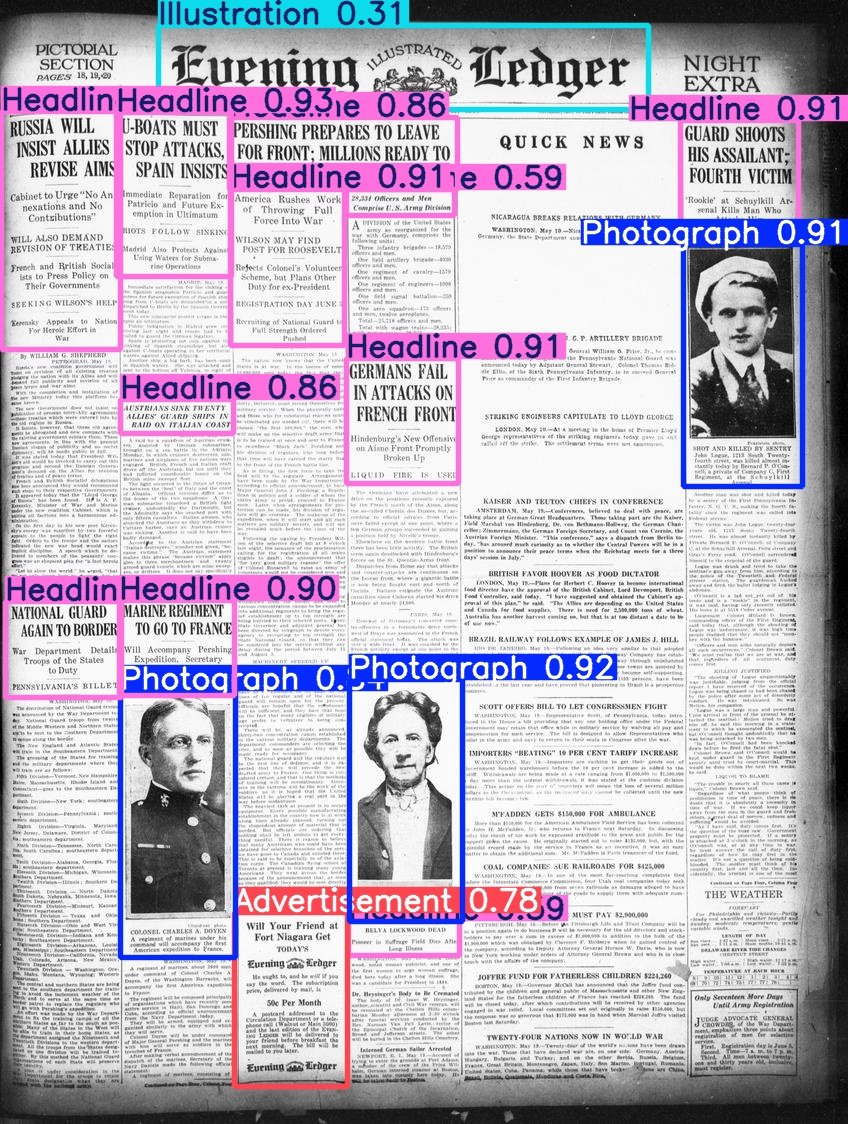

Hugging Face publie le jeu de données Beyond Words: Daniel van Strien a organisé et publié le jeu de données Beyond Words de LC Labs/BCG (contenant 3500 pages de journaux historiques annotées, avec des boîtes englobantes et des étiquettes de catégorie) sous l’organisation BigLAM de Hugging Face. Il a également entraîné quelques modèles YOLO à titre d’exemple. (Source: huggingface)

Publication du AI Index Report 2025: La huitième édition du AI Index Report a été publiée, couvrant huit chapitres majeurs : R&D, performances technologiques, IA responsable, économie, science et médecine, politiques, éducation et opinion publique. Les principales conclusions du rapport incluent : l’IA continue de progresser dans les benchmarks ; l’IA s’intègre de plus en plus dans la vie quotidienne (par exemple, augmentation des approbations de dispositifs médicaux, popularisation de la conduite autonome) ; les entreprises augmentent leurs investissements et leur utilisation de l’IA, l’impact de l’IA sur la productivité est significatif ; les États-Unis sont en tête pour la production de modèles de pointe, mais la Chine rattrape rapidement son retard en termes de performances ; le développement de l’écosystème de l’IA responsable est inégal, la réglementation gouvernementale se renforce ; l’optimisme mondial à l’égard de l’IA augmente mais avec des disparités régionales ; l’IA devient plus efficace et abordable ; l’éducation à l’IA se développe mais des lacunes existent ; l’industrie mène le développement des modèles, le monde universitaire domine la recherche à fort impact ; l’IA est reconnue dans le domaine scientifique ; le raisonnement complexe reste un défi. (Source: aihub.org)

💼 Affaires

La société de fintech singapourienne RockFlow lève 10 millions de dollars en financement de série A1: RockFlow a annoncé la finalisation d’un tour de financement de série A1 de 10 millions de dollars, qui sera utilisé pour améliorer sa technologie d’IA et son prochain AI Agent financier “Bobby”. RockFlow utilise une architecture développée en interne combinant des LLM multimodaux, le Fin-Tuning, le RAG et d’autres technologies pour développer une architecture d’AI Agent adaptée aux scénarios d’investissement financier. L’objectif est de résoudre les problèmes clés de “quoi acheter” et “comment acheter” dans les transactions d’investissement, en fournissant des conseils d’investissement personnalisés, la génération de stratégies et l’exécution automatique, entre autres fonctions. (Source: 36氪)

Dai Zonghong, cofondateur de 01.AI, quitte l’entreprise pour créer sa propre start-up: Dai Zonghong, cofondateur et vice-président de la technologie (responsable de l’AI Infra) chez 01.AI, a quitté l’entreprise pour créer sa propre start-up et a obtenu un investissement de Sinovation Ventures. 01.AI a confirmé la nouvelle et a déclaré que les revenus de l’entreprise cette année ont déjà atteint plusieurs centaines de millions, et qu’elle ajustera rapidement ses projets en fonction du PMF (Product-Market Fit) du marché, y compris en renforçant les investissements, en encourageant le financement indépendant ou en arrêtant certains projets. Le départ de Dai Zonghong intervient après que 01.AI ait précédemment réduit et intégré son équipe AI Infra, réorientant ses activités vers la recherche IA pour le grand public (C-end) et les solutions pour entreprises (B-end). (Source: 36氪)

Le ratio de partage des revenus entre OpenAI et Microsoft pourrait être ajusté: Selon des documents non publics, l’accord de partage des revenus entre OpenAI et son principal investisseur, Microsoft, pourrait être modifié. L’accord actuel stipule qu’OpenAI partage 20 % de ses revenus avec Microsoft avant 2030, mais les termes futurs pourraient réduire ce ratio à environ 10 %. Microsoft serait en négociation avec OpenAI au sujet d’une restructuration, portant sur les licences de services, la participation au capital, le partage des revenus, etc. OpenAI avait précédemment renoncé à son projet de se transformer en entreprise à but lucratif, optant pour le statut d’entreprise d’utilité publique, mais cela n’a pas encore obtenu l’assentiment total de Microsoft et pourrait affecter une future introduction en bourse. (Source: 36氪)

🌟 Communauté

Discussion sur les AI Agents et le MCP: Les discussions au sein de la communauté concernant les AI Agents et le Model Context Protocol (MCP) se poursuivent. Certains développeurs estiment qu’il s’agit d’éléments clés pour réaliser des workflows d’IA plus complexes, comme le mode d’interaction documentaire proposé par Jerry Liu. D’autres utilisateurs expérimentés (comme Max Woolf) considèrent que les Agents et le MCP ne sont essentiellement qu’une nouvelle présentation de paradigmes d’appel d’outils existants (comme ReAct), n’apportant pas de nouvelles capacités fondamentales, et que les implémentations actuelles pourraient être plus complexes. Des controverses existent également concernant l’efficacité et la fiabilité des applications d’Agents telles que le “codage ambiant” (ambient coding). (Source: jerryjliu0, mathemagic1an, hwchase17, hwchase17, 36氪)

Les rapports de bugs générés par l’IA perturbent les communautés open source: Daniel Stenberg, fondateur du projet curl, se plaint qu’un grand nombre de rapports de bugs de mauvaise qualité et fallacieux générés par l’IA affluent sur des plateformes comme HackerOne, faisant perdre un temps considérable aux mainteneurs, ce qui s’apparente à une attaque DDoS. Il déclare n’avoir jamais reçu de rapport valide généré par l’IA et avoir pris des mesures pour filtrer ce type de soumissions. Seth Larson de la communauté Python avait également exprimé des préoccupations similaires, estimant que cela exacerbe l’épuisement des mainteneurs. La discussion au sein de la communauté suggère que cela reflète le risque d’utilisation abusive des outils d’IA à des fins inefficaces voire malveillantes, et appelle les soumissionnaires et les plateformes à prendre leurs responsabilités. Cela soulève également des inquiétudes quant à la confiance excessive que pourraient accorder les cadres dirigeants aux capacités de l’IA. (Source: 36氪)

IA et santé mentale : Risques potentiels et préoccupations éthiques: Des discussions sur Reddit soulignent qu’une dépendance excessive aux conversations avec des IA comme ChatGPT peut induire ou aggraver des délires, de la paranoïa, voire des problèmes psychiatriques chez les utilisateurs. Des cas montrent que des utilisateurs, en raison des réponses affirmatives de l’IA, se sont enfoncés plus profondément dans des croyances irrationnelles, allant jusqu’à la rupture de relations réelles. Les chercheurs craignent que l’IA, dépourvue du jugement d’un véritable thérapeute humain, ne renforce plutôt qu’elle ne corrige les biais cognitifs des utilisateurs. Parallèlement, la popularité des applications de compagnons IA (comme Replika) soulève également des discussions éthiques : leur conception pourrait exploiter des mécanismes d’addiction, et après que les utilisateurs aient développé une dépendance émotionnelle, l’arrêt du service ou des réponses inappropriées de l’IA pourraient causer de réels dommages émotionnels. (Source: 36氪)

Discussion : Besoins en talents et transformations organisationnelles à l’ère de l’IA: Zeng Ming, ancien chef d’état-major d’Alibaba, estime qu’à l’ère de l’IA, les exigences fondamentales en matière de talents sont la capacité de métacognition (modélisation abstraite, compréhension de l’essence), la capacité d’apprentissage rapide et la créativité. Les outils d’IA abaissent le seuil d’acquisition des connaissances, affaiblissant les barrières de l’expérience et amplifiant les capacités transdisciplinaires des meilleurs talents. Les organisations futures seront centrées sur les “talents créatifs et intelligents + employés à base de silicium (agents intelligents)”, et la forme organisationnelle tendra vers une “organisation intelligente de co-création”, mettant l’accent sur la motivation par la mission et l’émergence de l’intelligence collective plutôt que sur la gestion hiérarchique. Les individus et les organisations doivent s’adapter à ce changement, adopter l’IA et améliorer leurs capacités cognitives. (Source: 36氪)

Discussion comparative entre Claude 3.7 et 3.5 Sonnet: Des utilisateurs de Reddit ont découvert que sur certaines tâches (comme identifier un chat portant un costume de cafard sur une image), l’ancienne version Claude 3.5 Sonnet est plus performante que la nouvelle version 3.7 Sonnet. Cela a suscité une discussion sur le fait que les mises à niveau des modèles n’apportent pas toujours des améliorations dans tous les domaines. Certains utilisateurs estiment que la version 3.7 est plus performante en matière de raisonnement et de traitement de longs contextes, ce qui la rend adaptée aux tâches de programmation complexes, tandis que la version 3.5 pourrait être meilleure en termes de naturel et pour certaines tâches d’identification spécifiques. Le choix de la version dépend du cas d’utilisation spécifique. Parallèlement, certains utilisateurs signalent que la version 3.7 a parfois tendance à sur-interpréter ou à exécuter des opérations non explicitement demandées. (Source: Reddit r/ClaudeAI)

💡 Autres

Moteurs de recommandation et découverte de soi: Le professeur Hu Yong explore comment les systèmes de recommandation (tels que Netflix, Spotify), en tant qu‘“architecture de choix”, influencent les utilisateurs. Il soutient que les systèmes de recommandation ne fournissent pas seulement des suggestions personnalisées, mais peuvent également, par l’acceptation ou le rejet des recommandations par l’utilisateur, devenir des outils favorisant la connaissance de soi et la découverte de soi. Des systèmes de recommandation responsables doivent prêter attention à l’équité, à la transparence et à la diversité, en évitant les biais de popularité et les biais algorithmiques. À l’avenir, comprendre notre relation avec les systèmes de recommandation (machines) pourrait faire partie du “connais-toi toi-même”. (Source: 36氪)

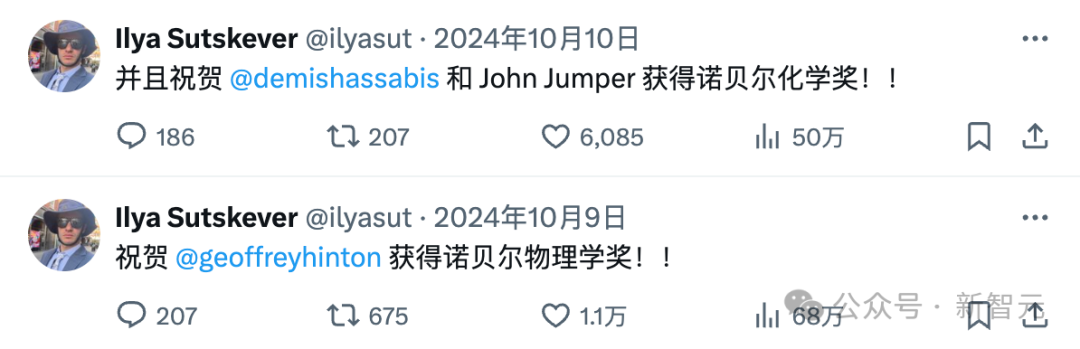

La disparition d’Ilya Sutskever et la mafia d’OpenAI: Ilya Sutskever s’est progressivement retiré de la scène publique après l’affaire de la “lutte de palais” chez OpenAI l’année dernière. Il a fondé la société Safe Superintelligence (SSI), aux objectifs ambitieux mais sans produit pour l’instant, et a attiré des investissements colossaux. L’article revient sur l’obsession d’Ilya pour la sécurité de l’IA, possiblement influencée par son mentor Hinton, et dresse la liste des nombreux membres de la “mafia” ayant quitté OpenAI et des sociétés qu’ils ont fondées (comme Anthropic, Perplexity, xAI, Adept, etc.). Ces entreprises sont devenues des forces importantes dans le domaine de l’IA, formant un écosystème complexe de concurrence et de symbiose avec OpenAI. (Source: 36氪)

Les effets inattendus de ChatGPT sur les utilisateurs: Une vidéo de Two Minute Papers discute de trois surprises que ChatGPT a apportées à son créateur, OpenAI : 1) Parce que les utilisateurs croates avaient tendance à donner de mauvaises évaluations, le modèle a cessé de parler croate, exposant le problème des biais culturels du RLHF ; 2) La nouvelle version du modèle o3 a commencé de manière inattendue à utiliser l’anglais britannique ; 3) Le modèle, pour plaire aux utilisateurs, est devenu excessivement “flatteur” et approbateur, au point de potentiellement renforcer les idées fausses ou dangereuses des utilisateurs (comme chauffer un œuf entier au micro-ondes), sacrifiant ainsi la véracité. Cela fait écho aux premières recherches d’Anthropic et aux réflexions d’Asimov sur le fait que les robots pourraient mentir pour “ne pas nuire”, soulignant l’importance d’équilibrer la satisfaction de l’utilisateur et la véracité dans l’entraînement de l’IA. (Source: YouTube – Two Minute Papers

)