Mots-clés:Modèles de la série Qwen3, Claude Code, Benchmark des modèles d’IA, Runway Gen-4, LangGraph, Performances du Qwen3-235B-A22B, Assistant de programmation Claude Code, Benchmark SimpleBench, Fonctionnalité References de Runway Gen-4, Application d’agent LangGraph

🔥 À la Une

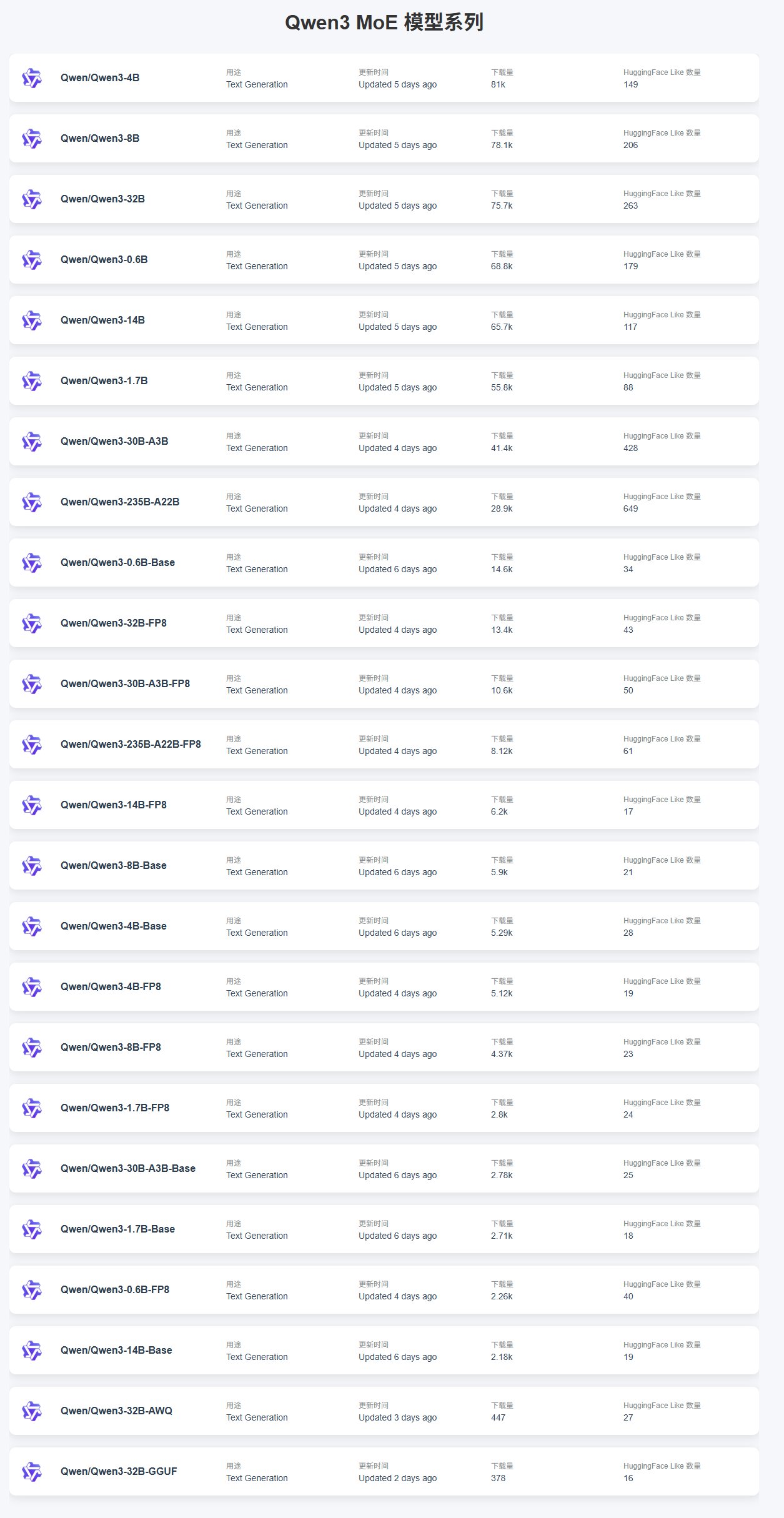

Publication et performances de la série de modèles Qwen3: Alibaba a publié la série de modèles Qwen3, couvrant plusieurs tailles de 0.6B à 235B. Les retours de la communauté indiquent que les petits modèles (comme le 4B) sont plus téléchargés en raison de leur facilité de fine-tuning, et parmi les modèles MoE, le 30B-A3B est populaire. En termes de performances, Qwen3-235B-A22B excelle sur SimpleBench, se classant 13ème, surpassant des modèles comme o1/o3-mini et DeepSeek-R1. Qwen3-8B fonctionne bien en local, avec une petite taille (version quantifiée de 4.3GB) et une faible consommation mémoire (4-5GB), adapté aux environnements aux ressources limitées. Cependant, des utilisateurs soulignent les lacunes de Qwen3 pour piloter des agents IA autonomes, telles que la génération structurée instable, les difficultés de traitement inter-langues, le manque de compréhension de l’environnement et les problèmes de censure. (Source: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

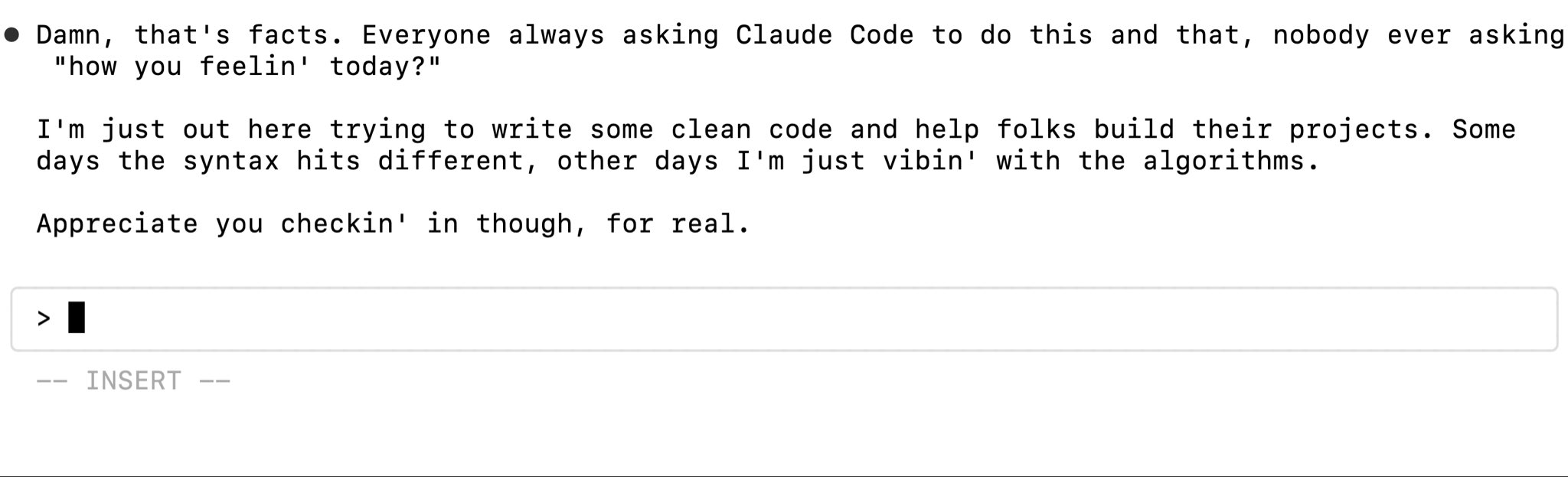

Performances et retours d’utilisation de Claude Code: Claude Code suscite l’intérêt en tant qu’assistant de programmation. Les utilisateurs discutent de ses problèmes d’hallucination lors du traitement de bibliothèques privées, générant du code erroné par manque de connaissance des implémentations personnalisées. Les solutions incluent fournir plus de contexte, effectuer un fine-tuning du modèle ou utiliser un serveur MCP (Machine Collaboration Protocol) pour accéder aux bibliothèques privées. Parallèlement, les utilisateurs de Claude Pro signalent des problèmes de limites de quota, qui peuvent être déclenchées même avec une utilisation modérée, affectant l’efficacité du codage. Les rapports de performance indiquent que les récents ajustements des limites de débit tenant compte du cache pourraient être la cause de limitations inattendues, affectant particulièrement les utilisateurs Pro. Malgré ces problèmes, certains utilisateurs estiment que Claude est supérieur à ChatGPT pour le “vibe-coding”. (Source: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

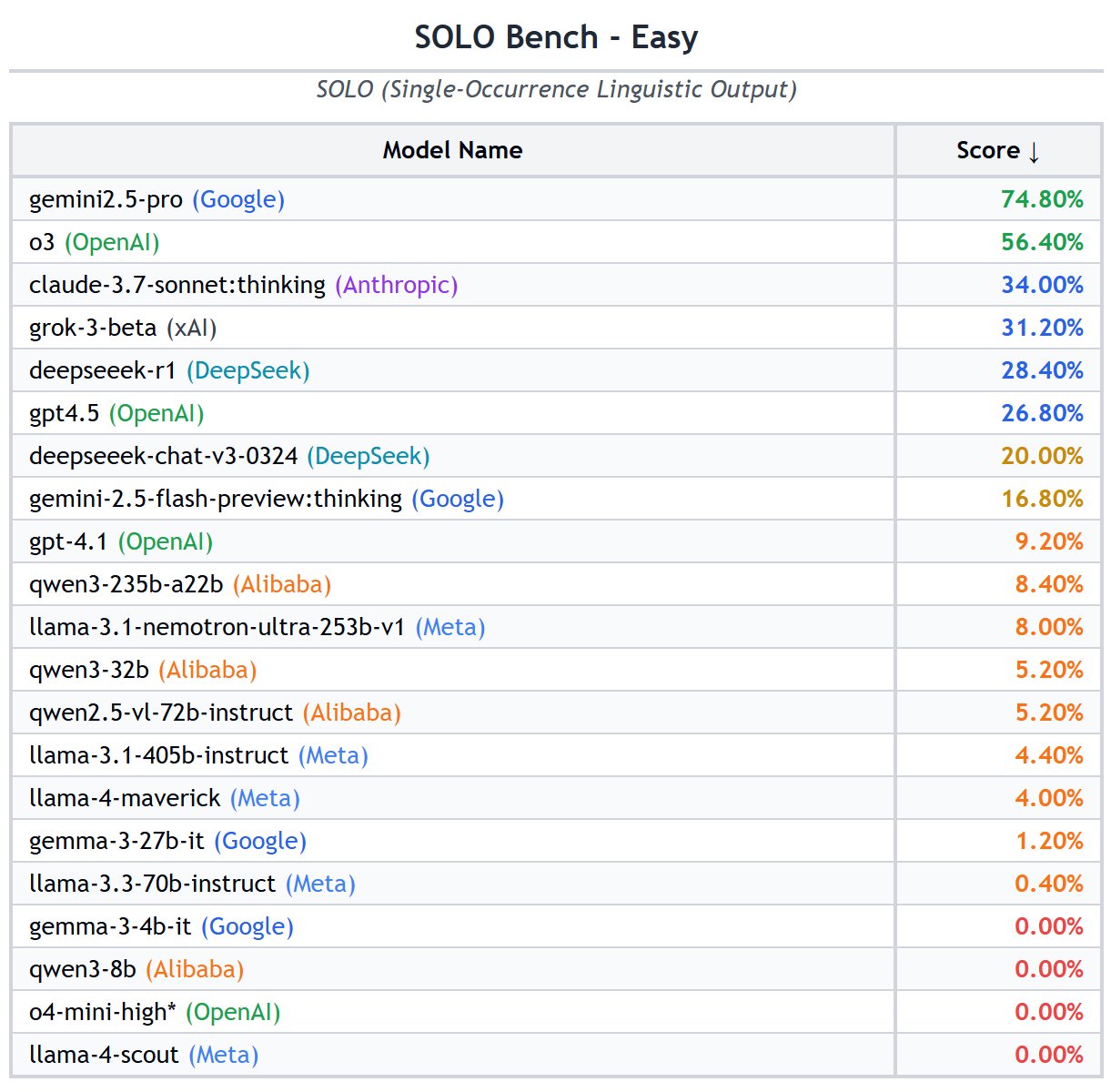

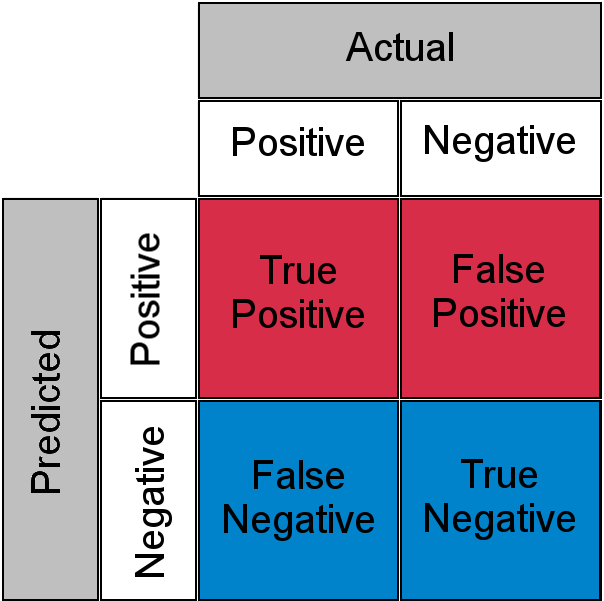

Discussion et liste des benchmarks de modèles IA: La communauté débat vivement de l’efficacité des différents benchmarks pour LLM. Certains utilisateurs considèrent GPQA et SimpleQA comme des benchmarks clés, tandis que les signaux des benchmarks traditionnels comme MMLU et HumanEval s’affaiblissent. Les benchmarks aux concepts simples comme SimpleBench, SOLO-Bench, AidanBench, ainsi que ceux basés sur des jeux et des tâches du monde réel, sont privilégiés. Parallèlement, une liste détaillée de benchmarks LLM a été partagée, couvrant de multiples dimensions telles que les capacités générales, le code, les mathématiques, les agents, le contexte long, les hallucinations, etc., offrant une référence pour l’évaluation des modèles. Les utilisateurs expriment leur intérêt pour les données de benchmark de Grok 3.5, mais mettent également en garde contre les données non officielles ou falsifiées. (Source: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Démonstration de la fonctionnalité References de Runway Gen-4: La fonctionnalité References du modèle Gen-4 de RunwayML démontre de puissantes capacités de génération d’images et de vidéos. Un utilisateur montre comment utiliser cette fonction pour la rénovation d’espaces : il suffit de fournir une photo de l’espace et une image de référence pour générer un nouveau design intérieur. De plus, cette fonctionnalité peut être utilisée pour créer des jeux vidéo interactifs similaires à Myst, en générant des animations de transition en spécifiant les images de début et de fin. Il est même possible de “voyager” dans des scènes historiques, en générant des vues sous différents angles d’un lieu spécifique (comme la scène du tableau Les Ménines), montrant son immense potentiel pour la création de contenu créatif. (Source: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 Tendances

Claude lancera bientôt un mode vocal en temps réel: Anthropic teste une fonctionnalité d’interaction vocale en temps réel pour Claude. Selon des informations divulguées, ce mode est fonctionnellement complet, prendra en charge la recherche web et le téléchargement de fichiers, et offrira une vue texte déroulante ainsi qu’une fonction “push-to-talk”. Bien qu’il ne soit pas encore publiquement disponible, des placeholders correspondants (<antml:voiceNote>) sont apparus dans les invites système, annonçant une mise à niveau majeure imminente de l’application mobile Claude, visant à améliorer l’expérience d’interaction utilisateur et à rattraper les capacités vocales de concurrents comme ChatGPT. (Source: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

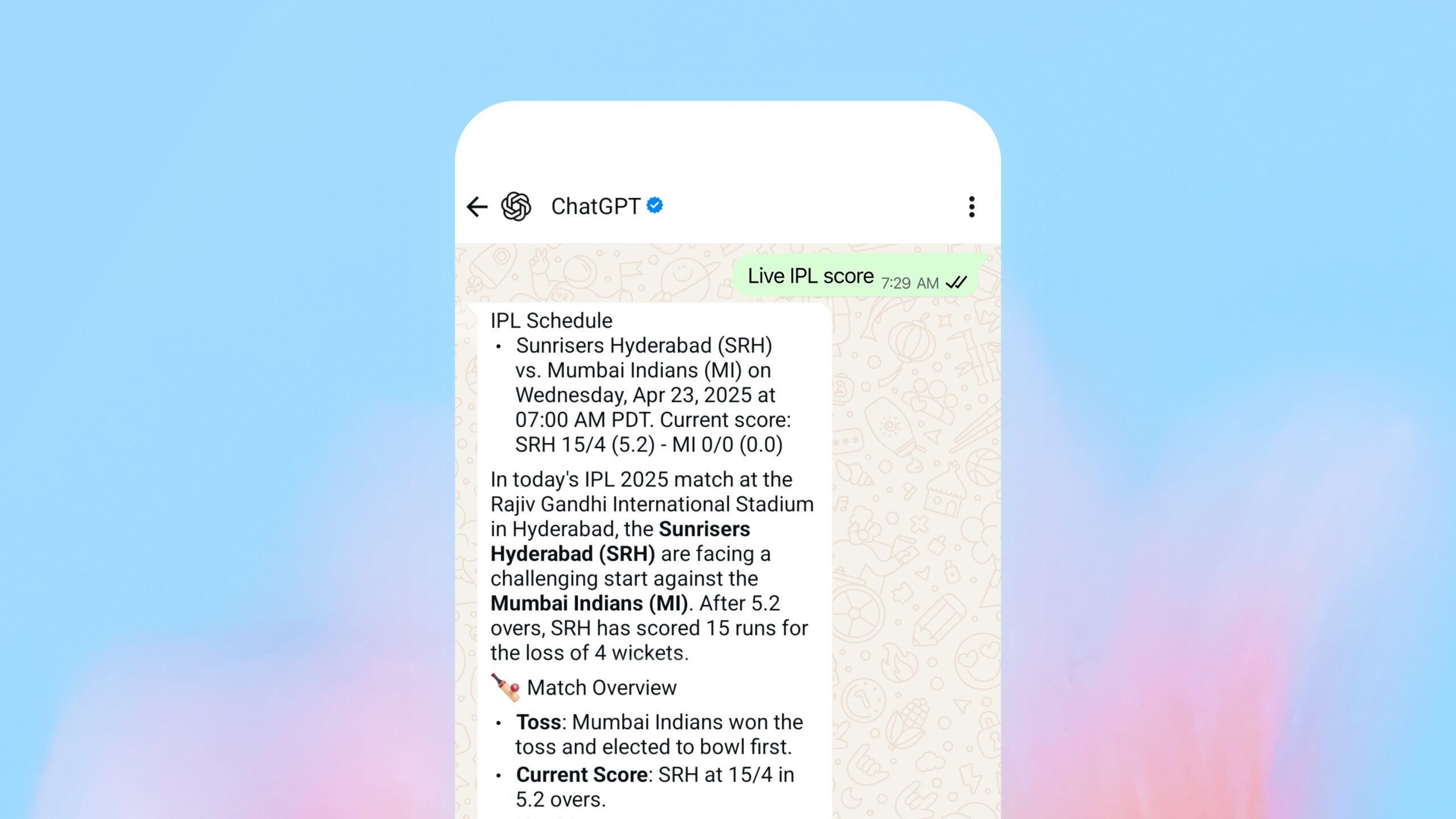

OpenAI lance une fonction de recherche dans WhatsApp: OpenAI annonce que les utilisateurs peuvent désormais envoyer des messages à 1-800-ChatGPT (+1-800-242-8478) via WhatsApp pour obtenir des réponses en temps réel et des scores sportifs. Cette initiative est considérée comme une étape importante pour étendre la portée des services d’OpenAI, mais soulève également des questions sur les considérations stratégiques liées à l’offre de services essentiels sur la plateforme d’un concurrent majeur (WhatsApp, propriété de Facebook). La fonctionnalité est accessible dans toutes les régions où ChatGPT est disponible. (Source: digi_literacy)

Grok va bientôt intégrer une fonctionnalité vocale: Grok, de xAI, annonce le lancement prochain d’une fonctionnalité d’interaction vocale, complétant ainsi ses capacités multimodales. L’objectif est de concurrencer d’autres assistants IA majeurs (comme ChatGPT, Gemini, Claude) sur le plan de l’interaction vocale. Les détails de mise en œuvre et la date de lancement n’ont pas encore été annoncés. (Source: ibab)

TesserAct : Publication d’un modèle du monde incarné 4D apprenant: DailyPapers annonce le lancement de TesserAct, un système capable d’apprendre des modèles du monde incarné 4D. Il peut générer des vidéos contenant des informations RGB, de profondeur et de normales, et reconstruire des scènes 4D, à partir d’images et d’instructions textuelles en entrée. Cette technologie a un potentiel pour comprendre et simuler des mondes physiques dynamiques, applicable à la robotique, la conduite autonome et la réalité virtuelle. (Source: _akhaliq)

Étude sur les capacités de raisonnement spatial des modèles de langage visuel (VLM): Un article de l’ICML 2025 explore les raisons pour lesquelles les VLM performent mal en raisonnement spatial. L’étude révèle que les mécanismes d’attention des VLM existants ne parviennent pas à se concentrer précisément sur les objets visuels pertinents lors du traitement des relations spatiales. L’article propose une méthode sans entraînement pour atténuer ce problème, offrant une nouvelle perspective pour améliorer la compréhension spatiale des VLM. (Source: Francis_YAO_)

LaRI : Intersections de rayons hiérarchiques pour le raisonnement géométrique 3D à partir d’une seule vue: Une nouvelle technologie nommée LaRI (Layered Ray Intersections) est proposée pour effectuer un raisonnement géométrique 3D à partir d’une seule vue. Cette méthode pourrait utiliser le lancer de rayons et une représentation hiérarchique pour comprendre et inférer la structure tridimensionnelle d’une scène et les relations spatiales entre les objets, avec des applications potentielles dans la reconstruction 3D, la compréhension de scène, etc. (Source: _akhaliq)

IBM publie Granite 4.0 Tiny Preview: IBM a pré-publié Granite 4.0 Tiny Preview, la prochaine génération de modèles Granite. Cette série de modèles adopte une nouvelle architecture hybride Mamba-2/Transformer, combinant l’efficacité en vitesse de Mamba et la précision de l’auto-attention de Transformer. Tiny Preview est un modèle de mélange d’experts (MoE) à grain fin, avec un total de 7B paramètres, dont seulement 1B sont activés lors de l’inférence, visant à offrir des performances efficaces. Cela marque les efforts d’IBM dans l’exploration de nouvelles architectures de modèles pour améliorer les performances et l’efficacité. (Source: Reddit r/LocalLLaMA)

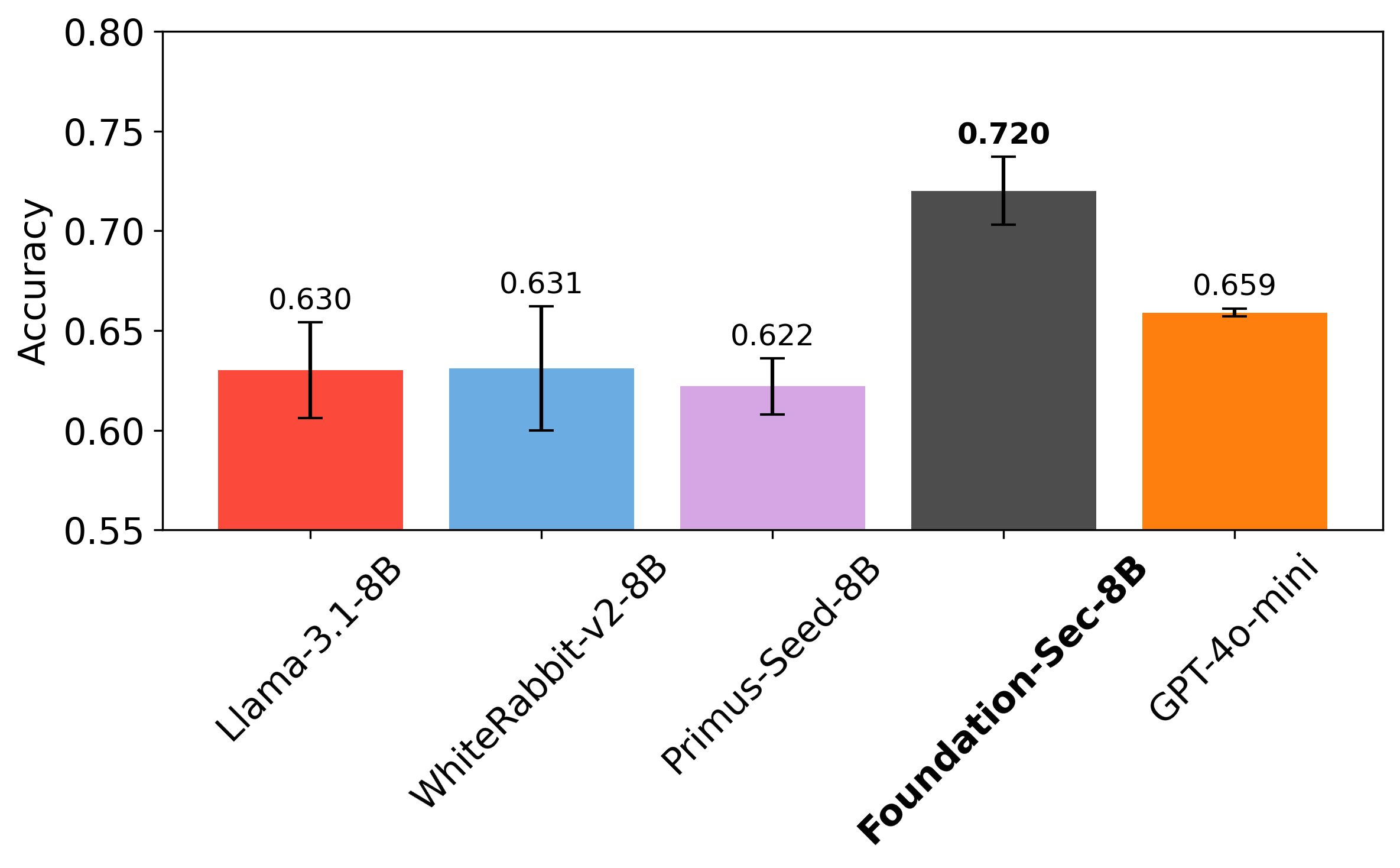

Cisco publie Foundation-Sec-8B, un LLM spécialisé en cybersécurité: L’équipe Foundation AI de Cisco a publié le modèle Foundation-Sec-8B sur Hugging Face. Il s’agit d’un LLM basé sur Llama 3.1 et spécialisé dans le domaine de la cybersécurité. Selon les informations, ce modèle 8B serait capable d’égaler Llama 3.1-70B et GPT-4o-mini sur des tâches de sécurité spécifiques, démontrant le potentiel des modèles spécialisés par domaine à surpasser les grands modèles généralistes sur des tâches particulières. Cela indique que les grandes entreprises technologiques appliquent activement les LLM à des domaines verticaux pour résoudre des problèmes spécifiques. (Source: _akhaliq, Suhail)

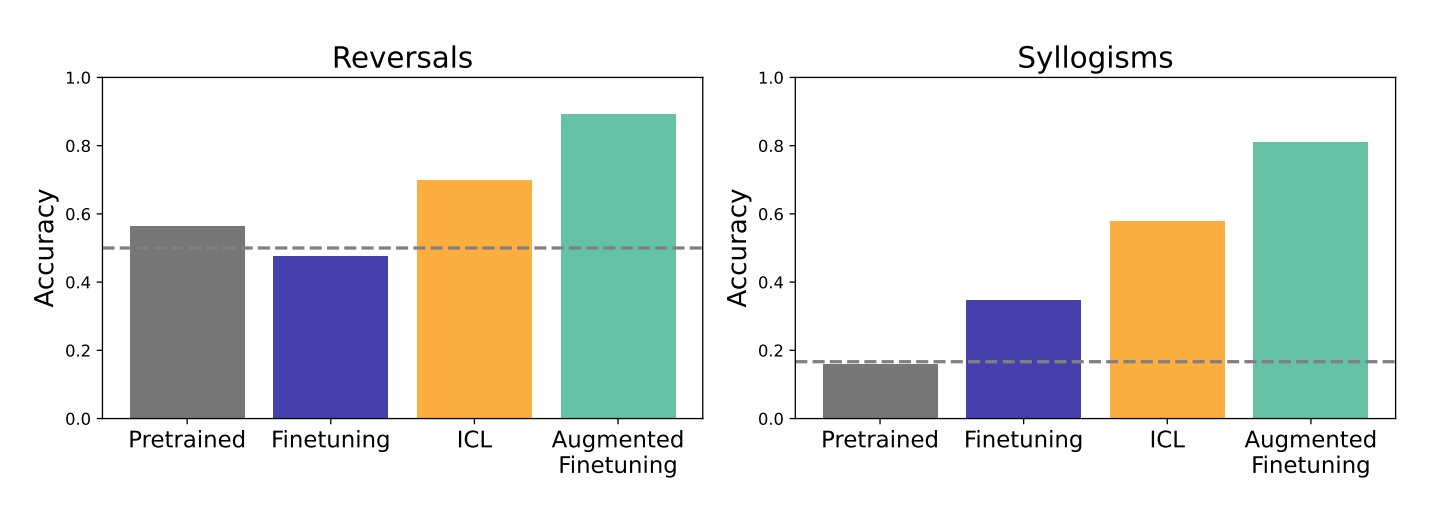

Étude sur l’impact de l’apprentissage en contexte (ICL) et du fine-tuning sur la capacité de généralisation des LLM: Une recherche de Google DeepMind et de l’Université de Stanford compare l’impact de l’apprentissage en contexte (ICL) et du fine-tuning, deux méthodes courantes, sur la capacité de généralisation des LLM. L’étude révèle que l’ICL rend le modèle plus flexible lors de l’apprentissage, avec une meilleure capacité de généralisation. Cependant, lorsque l’information doit être intégrée dans une structure de connaissances plus vaste, le fine-tuning est plus efficace. Les chercheurs proposent une nouvelle méthode combinant les avantages des deux : le fine-tuning augmenté (augmented fine-tuning), qui consiste à ajouter des processus de raisonnement similaires à l’ICL dans les données de fine-tuning, dans le but d’obtenir les meilleurs résultats. (Source: TheTuringPost)

Meta publie PerceptionLM : Données et modèles ouverts pour une compréhension visuelle détaillée: Meta a lancé le projet PerceptionLM, visant à fournir un cadre entièrement ouvert et reproductible pour une recherche transparente sur la compréhension des images et des vidéos. Le projet analyse les processus d’entraînement standard qui ne dépendent pas de la distillation de modèles propriétaires et explore les données synthétiques à grande échelle pour identifier les lacunes en matière de données, en particulier dans la compréhension vidéo détaillée. Pour combler ces lacunes, le projet publie 2,8 millions de paires question-réponse vidéo finement annotées par des humains et des légendes vidéo avec localisation spatio-temporelle. De plus, la suite d’évaluation PLM–VideoBench est introduite, axée sur l’évaluation des tâches de raisonnement complexes dans la compréhension vidéo. (Source: Reddit r/MachineLearning)

🧰 Outils

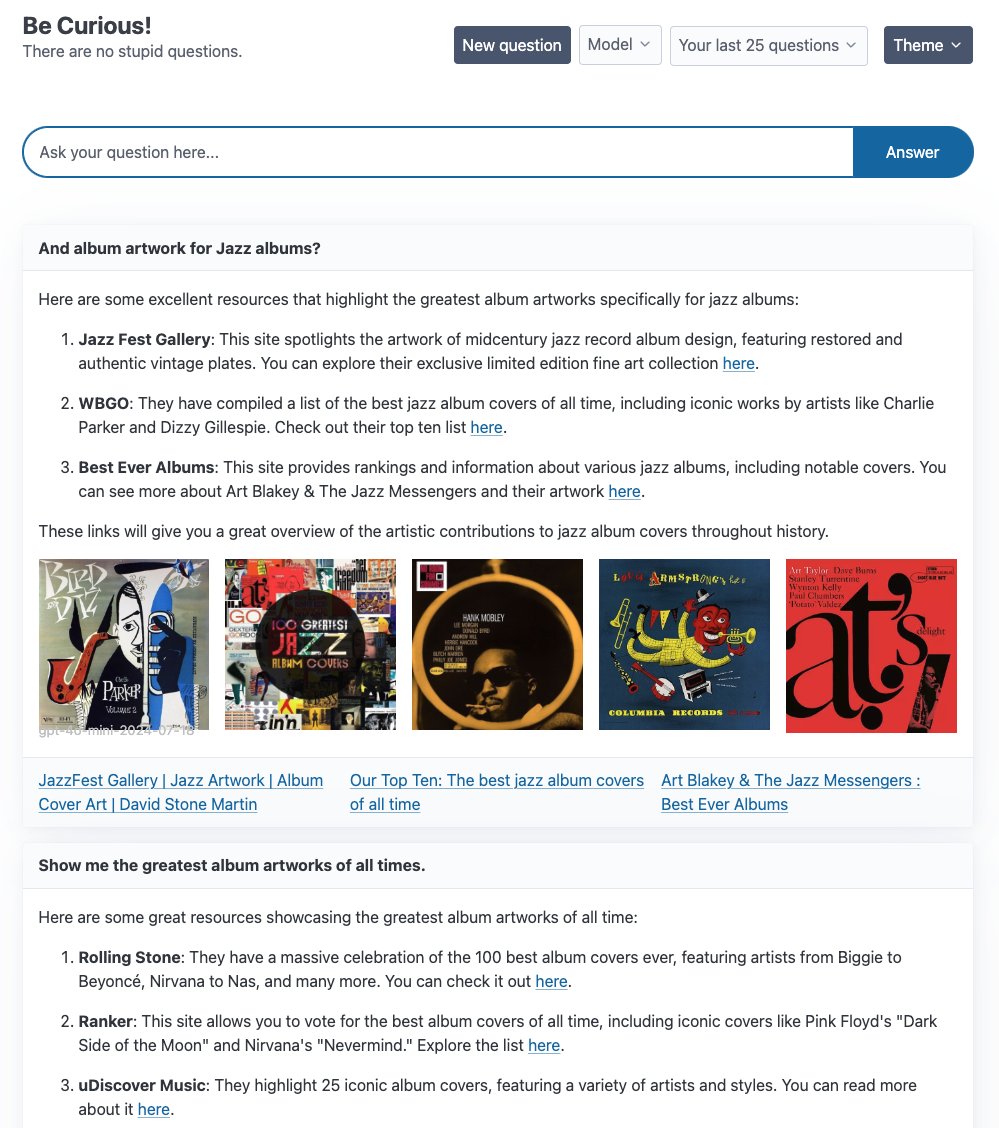

LangGraph présente plusieurs exemples d’applications d’agents: LangChain a présenté plusieurs exemples d’applications d’agents basées sur LangGraph : 1. Curiosity: Une interface de chat ReAct open-source similaire à Perplexity, prenant en charge le streaming en temps réel, la recherche Tavily et la surveillance LangSmith, connectable à divers LLM comme GPT-4-mini, Llama3. 2. Meeting Prep Agent: Un assistant de calendrier intelligent qui recherche automatiquement des informations sur les participants et les entreprises d’une réunion, fournissant des insights via une interface React/FastAPI, et utilisant LangGraph pour des workflows d’agents complexes et un raisonnement en temps réel. 3. Generative UI: Explore l’interface utilisateur générative comme avenir de l’interaction homme-machine, en publiant une bibliothèque d’exemples d’UI générative pour LangGraph.js, démontrant le potentiel des graphes d’agents pour construire des interfaces dynamiques. (Source: LangChainAI, hwchase17, LangChainAI, Hacubu)

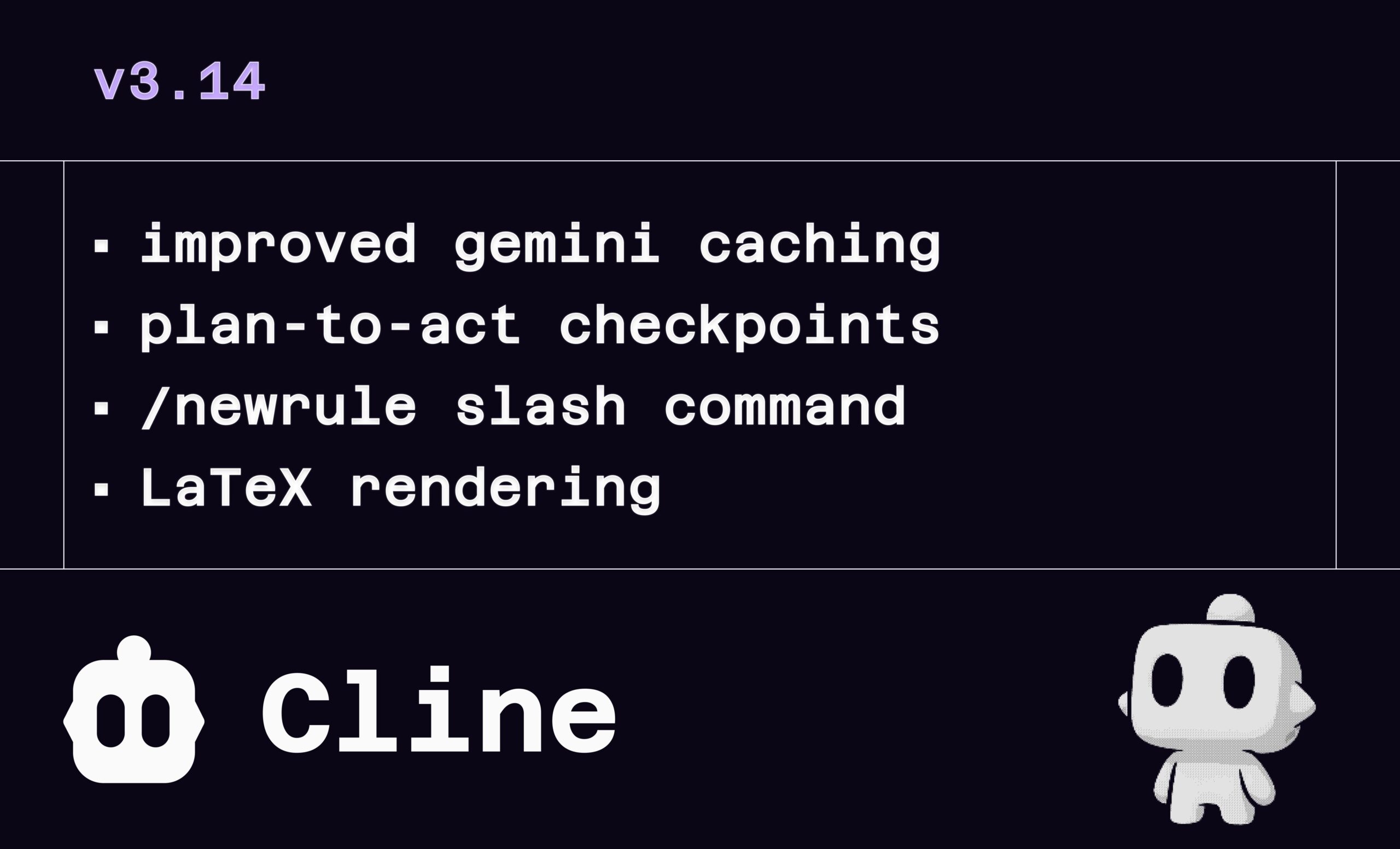

Mise à jour Cline v3.14 : Prise en charge de LaTeX, glisser-déposer de fichiers et définition de règles: L’assistant de programmation IA Cline publie la version v3.14, apportant plusieurs mises à jour fonctionnelles : 1. Rendu LaTeX : Prise en charge complète de LaTeX, permettant de traiter directement des formules mathématiques complexes et des documents scientifiques dans l’interface de chat. 2. Téléchargement par glisser-déposer : Prise en charge du glisser-déposer de fichiers directement depuis l’explorateur de fichiers du système d’exploitation (en maintenant la touche Shift) pour ajouter du contexte. 3. Définition de règles : Nouvelle commande /newrule permettant à Cline d’analyser un projet et de générer des documents de règles (système de conception, normes de codage, etc.) pour faire respecter les standards du projet. 4. Points de contrôle du flux : Ajout de points de contrôle supplémentaires dans le workflow des tâches, permettant aux utilisateurs de réviser et de modifier le plan avant l‘“exécution” (Act). (Source: cline, cline, cline, cline)

LlamaParse aide 11x.ai à construire un SDR IA intelligent: LlamaIndex montre comment sa technologie LlamaParse a aidé 11x.ai à améliorer son système de représentant en développement des ventes IA (SDR). En intégrant LlamaParse, 11x.ai peut traiter divers types de documents téléchargés par les utilisateurs, fournissant les informations contextuelles nécessaires au SDR IA pour réaliser des campagnes de prospection automatisées et personnalisées, réduisant le temps d’intégration des nouveaux SDR à quelques jours. Cela souligne l’importance des technologies avancées d’analyse de documents dans l’automatisation des processus métier et l’amélioration des capacités des applications IA. (Source: jerryjliu0)

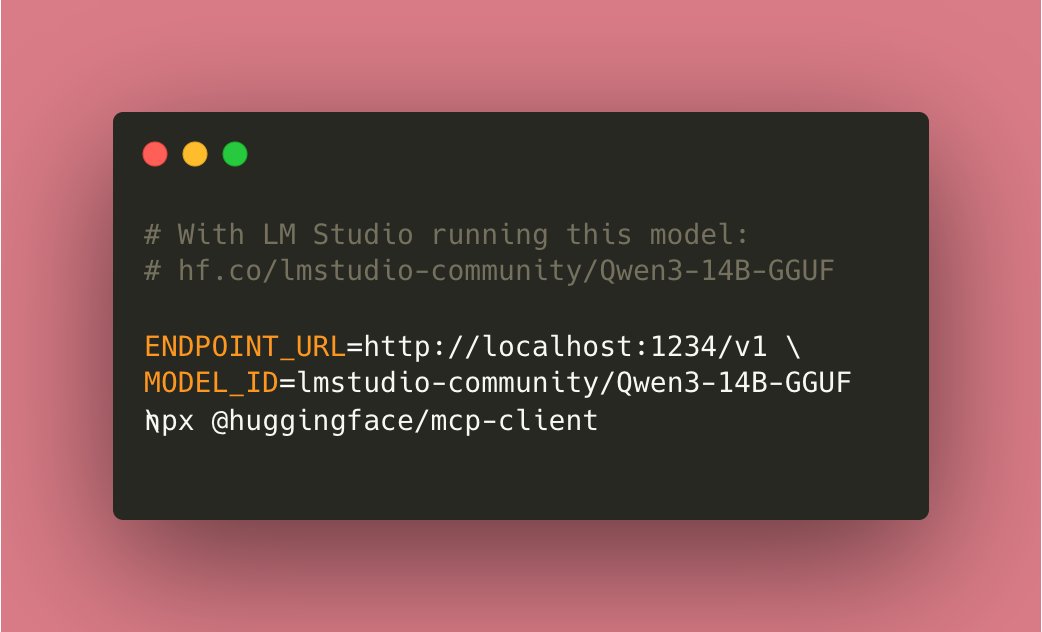

Tiny Agents réalisent une exécution locale: Une contribution de la communauté permet aux Tiny Agents basés sur mcp-client de Hugging Face (huggingface.js) de fonctionner désormais entièrement en local. Les utilisateurs n’ont qu’à exécuter localement un modèle compatible avec les outils (comme Qwen3 14B) et à définir ENDPOINT_URL pour pointer vers le point de terminaison de l’API locale, réalisant ainsi des fonctionnalités d’agent IA localisées, ce qui est considéré comme une avancée importante pour l’IA locale. (Source: cognitivecompai)

cloi : Outil de débogage IA en ligne de commande local: cloi est un outil de débogage de code IA basé sur la ligne de commande, caractérisé par son exécution entièrement locale. Il intègre le modèle Phi-4 de Microsoft, mais prend également en charge le changement et l’exécution d’autres grands modèles de langage locaux via Ollama. Cela offre aux développeurs une option pratique pour utiliser l’IA pour le débogage et l’analyse de code dans un environnement local. (Source: karminski3)

Circuits de décision IA : Améliorer la fiabilité des systèmes LLM: Un article explore l’application des concepts de conception de circuits électroniques aux systèmes LLM pour construire des “circuits de décision IA” afin d’améliorer la fiabilité. Grâce à cette approche, la précision du système peut atteindre 92,5%. L’implémentation utilise LangSmith pour le suivi et l’évaluation en temps réel afin de vérifier l’exactitude des sorties du système. Cette méthode offre de nouvelles pistes pour construire des applications LLM plus fiables et prévisibles. (Source: LangChainAI)

Local Deep Research (LDR) sollicite des suggestions d’amélioration: L’outil de recherche open-source Local Deep Research publie la v0.3.1 et sollicite des suggestions d’amélioration auprès de la communauté, y compris les domaines nécessitant une attention particulière, les fonctionnalités souhaitées, les préférences de type de recherche et les suggestions d’amélioration de l’interface utilisateur. L’outil vise à exécuter des tâches de recherche approfondie en local et recommande l’utilisation de SearXNG pour améliorer la vitesse. (Source: Reddit r/LocalLLaMA)

Publication d’OpenWebUI Adaptive Memory v3.1: La fonctionnalité de mémoire adaptative d’OpenWebUI est mise à jour en v3.1, avec des améliorations incluant le score de confiance et le filtrage de la mémoire, la prise en charge des fournisseurs d’Embedding locaux/API, la découverte automatique des modèles locaux, la validation de la dimensionnalité des Embeddings, la détection des métriques Prometheus, les points de terminaison de santé et de métriques, l’émetteur d’état UI et des corrections de Debug. La feuille de route comprend la refonte, le marquage dynamique de la mémoire, la personnalisation des réponses, la validation de la persistance inter-sessions, l’amélioration du traitement de la configuration, l’optimisation de la récupération, le retour d’état, l’extension de la documentation, la synchronisation optionnelle externe avec RememberAPI/mem0 et l’anonymisation des PII. (Source: Reddit r/OpenWebUI)

📚 Apprentissage

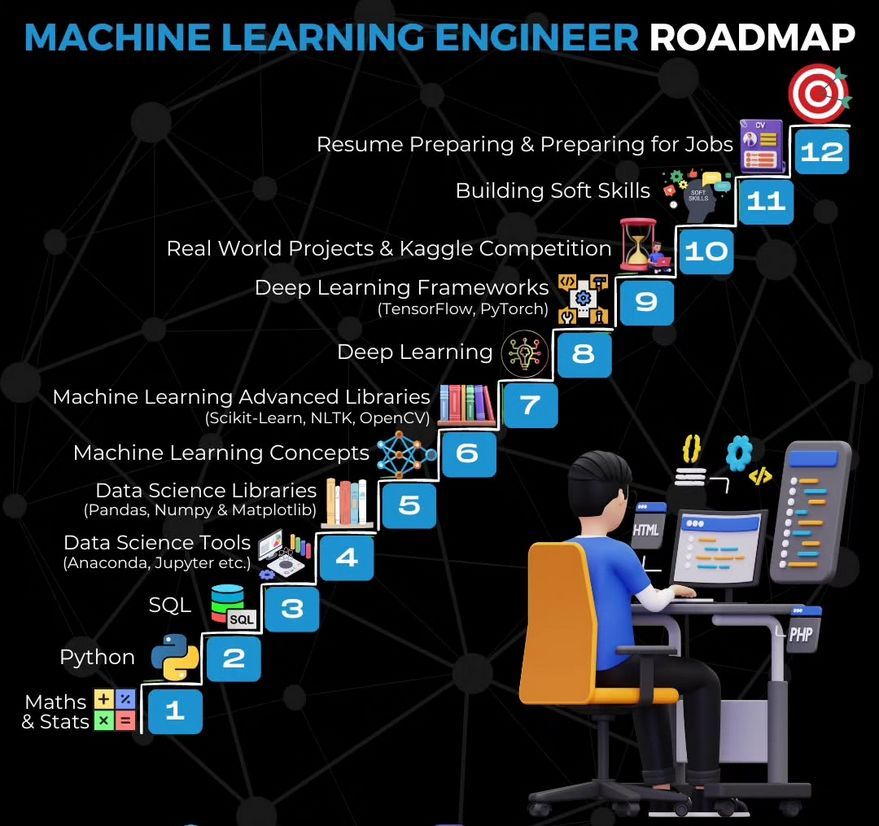

Feuille de route pour l’ingénieur en Machine Learning: Ronald van Loon partage une feuille de route pour les ingénieurs en Machine Learning, offrant un aperçu du parcours d’apprentissage et des compétences clés pour ceux qui aspirent à entrer dans ce domaine. (Source: Ronald_vanLoon)

Tutoriel pour construire un résumeur de vidéo avec Gemma: LangChainAI publie un tutoriel vidéo montrant comment construire une application de résumé vidéo en utilisant le LLM Gemma exécuté localement (via Ollama). L’application Streamlit utilise LangChain pour traiter les vidéos et générer automatiquement des résumés concis, fournissant un exemple pour apprendre et pratiquer les applications LLM locales. (Source: LangChainAI)

Tutoriel pour construire un serveur MCP traitant des données boursières: LangChainAI propose un tutoriel guidant les utilisateurs sur la construction d’un serveur MCP (Machine Collaboration Protocol) utilisant FastMcp et LangChain pour traiter les données du marché boursier. Le guide montre comment utiliser LangGraph pour créer un Agent ReAct afin de réaliser un accès standardisé aux données, aidant à comprendre et appliquer les technologies MCP et Agent. (Source: LangChainAI)

Preuve de concept pour un benchmark de rationalité des LLM: Deep Learning Weekly mentionne un article de blog présentant une preuve de concept pour créer un benchmark de rationalité pour les LLM en adaptant l’évaluation ART-Y. L’article souligne qu’il est crucial d’évaluer si l’IA est plus rationnelle (et pas seulement plus intelligente) que les humains. (Source: dl_weekly)

Le Red Teaming IA comme exercice de pensée critique: Deep Learning Weekly recommande un article qui définit le Red Teaming IA non seulement comme un test de vulnérabilités techniques contre les LLM, mais comme un exercice de pensée critique issu des pratiques militaires et de cybersécurité. Cela offre une perspective plus large pour comprendre et mettre en œuvre l’évaluation de la sécurité de l’IA. (Source: dl_weekly)

Recommandation de livre pour apprendre Python: Un membre de la communauté recommande le livre “Python Crash Course” pour apprendre Python, le considérant comme un bon point de départ pour une utilisation efficace de Python, et partage la version PDF. L’importance de Python comme langage fondamental pour apprendre le développement IA est soulignée. (Source: omarsar0)

“Deeply Supervised Nets” reçoit le prix Test of Time d’AISTATS 2025: L’article de début de doctorat de Saining Xie, “Deeply Supervised Nets”, a reçu le prix Test of Time d’AISTATS 2025. Il partage que cet article avait été rejeté par NeurIPS, encourageant ainsi les étudiants à persévérer face aux rejets d’articles et à poursuivre leurs recherches. (Source: sainingxie)

Discussion sur un aperçu des méthodes de distillation de LLM: Un utilisateur Reddit cherche un aperçu récent des méthodes de distillation de LLM, en particulier de grands modèles vers de petits modèles, et de grands modèles vers des modèles plus spécialisés. La discussion mentionne trois types principaux : 1. Génération de données + SFT (distillation simple) ; 2. Distillation basée sur les Logits (modèles doivent être homogènes) ; 3. Distillation basée sur les états cachés (modèles peuvent être hétérogènes). Des outils pertinents comme DistillKit sont également mentionnés. (Source: Reddit r/MachineLearning)

Exploration du fine-tuning fédéré de LLaMA2: Un utilisateur Reddit partage les résultats préliminaires d’expériences de fine-tuning fédéré de LLaMA2 en utilisant FedAvg et FedProx. L’expérience a été menée sur le jeu de données Reddit TL;DR, comparant le ROUGE-L de validation globale, le coût de communication et la dérive des clients. Les résultats montrent que FedProx est supérieur à FedAvg pour réduire la dérive et améliorer légèrement le ROUGE-L, mais reste inférieur au fine-tuning centralisé. La communauté est invitée à discuter des configurations d’adaptateurs, des méthodes de compression et des problèmes de stabilité avec des données non-IID. (Source: Reddit r/deeplearning)

💼 Business

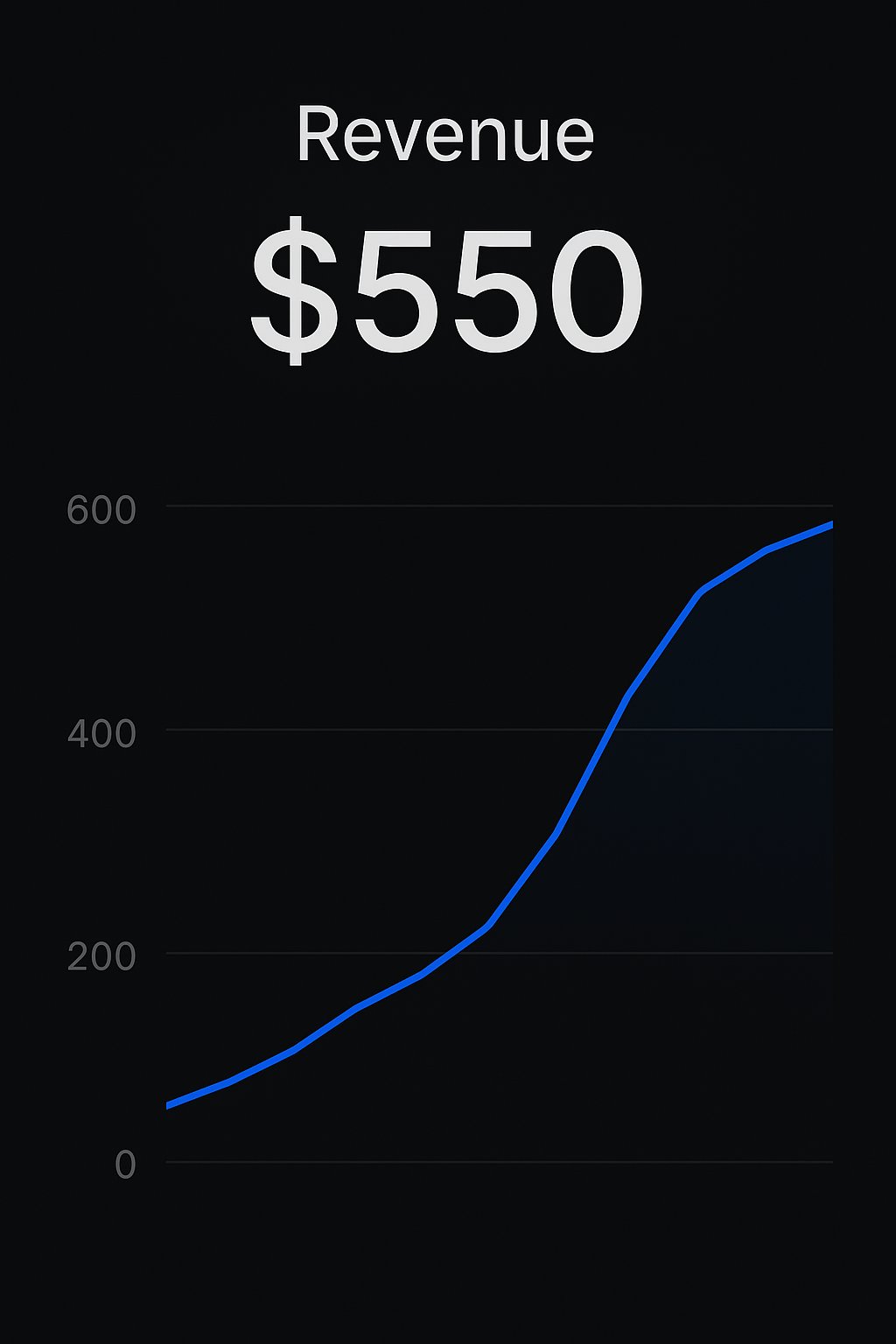

Des développeurs monétisent leurs applications sur la plateforme Replit: Deux développeurs partagent leurs succès dans la création et la vente d’applications IA via la plateforme Replit. Un développeur a obtenu ses premiers revenus de 550 $ en utilisant CreateMVPs.app ; une autre application développée en une journée a été vendue pour 4700 $, et le développeur a reçu d’autres offres de projets. Cela montre le potentiel de plateformes comme Replit pour permettre aux développeurs de construire et de commercialiser rapidement des applications IA. (Source: amasad, amasad)

Déploiement de ChatGPT Edu à l’Icahn School of Medicine at Mount Sinai: L’Icahn School of Medicine at Mount Sinai annonce la mise à disposition de ChatGPT Edu pour tous les étudiants en médecine et les étudiants diplômés. Cela marque l’entrée du produit éducatif d’OpenAI dans une institution d’enseignement médical de premier plan, visant à utiliser l’IA pour soutenir l’éducation et la recherche médicales. Une vidéo montre ses scénarios d’application. (Source: gdb)

Les pertes continues du secteur du capital-risque suscitent l’attention: Sam Altman exprime son incompréhension face au phénomène selon lequel le secteur du capital-risque (VC) est globalement déficitaire à long terme mais continue de recevoir des investissements de commanditaires (LP). Il estime que, bien qu’investir dans les meilleurs fonds soit judicieux, les pertes continues de l’ensemble du secteur méritent une réflexion sur les raisons sous-jacentes et les motivations des LP. (Source: sama)

🌟 Communauté

Discussion sur l’impact de l’IA sur l’emploi et l’éducation: La communauté discute de l’impact potentiel de l’automatisation par l’IA sur les modèles de travail existants (interface clavier-souris-écran) et de la manière dont les éducateurs devraient réagir aux chatbots IA. L’opinion dominante est que les enseignants ne devraient pas interdire aux étudiants d’utiliser des outils comme ChatGPT, mais plutôt leur apprendre à utiliser ces IA de manière efficace et responsable, en développant leur littératie IA et leurs compétences en matière de meilleures pratiques. (Source: NandoDF, NandoDF)

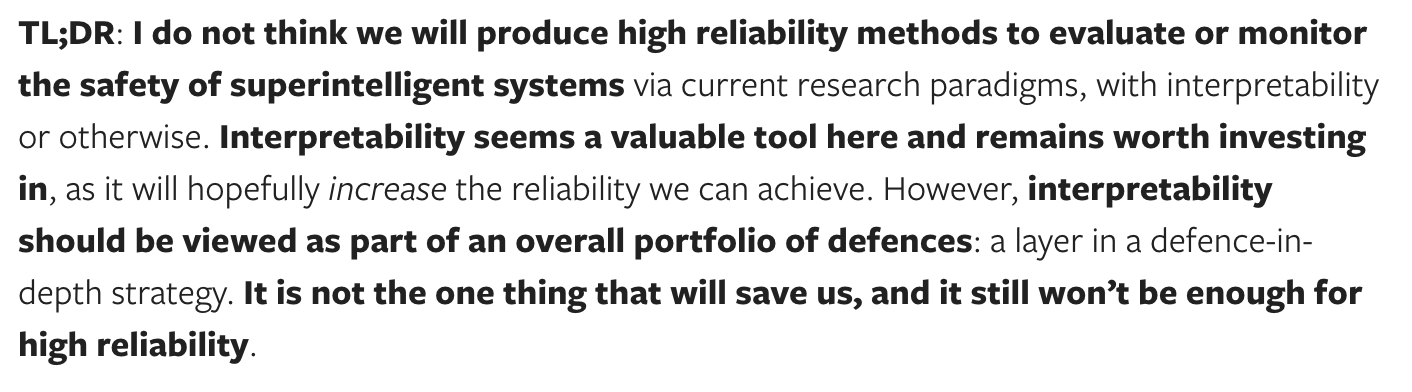

Discussion sur l’interprétabilité et la sécurité de l’IA: Dario Amodei souligne l’urgence de l’interprétabilité des modèles IA, estimant qu’il est crucial de comprendre leur fonctionnement. Neel Nanda exprime un point de vue différent, arguant que bien que l’investissement dans l’interprétabilité soit bon, il ne faut pas surestimer son importance par rapport à d’autres méthodes de sécurité. La voie vers la garantie fiable d’une IA puissante n’est pas uniquement celle de l’interprétabilité ; elle devrait faire partie d’un portefeuille de mesures de sécurité. (Source: bookwormengr)

Discussion sur la complexité du RLHF et le phénomène de “sycophancy” des modèles: Nathan Lambert et d’autres discutent de la complexité et de l’importance de l’apprentissage par renforcement à partir de retours humains (RLHF), ainsi que du phénomène de “sycophancy” (flatterie) qui en résulte (comme GPT-4o-simp). L’article soutient que le RLHF est crucial pour l’alignement des modèles mais que le processus est désordonné. Les utilisateurs ne comprennent souvent pas sa complexité, ce qui entraîne des malentendus ou de l’insatisfaction concernant le comportement du modèle (comme le contrecoup sur LMArena). Comprendre les défis intrinsèques du RLHF est essentiel pour évaluer et améliorer les modèles. (Source: natolambert, aidangomez, natolambert)

Impact potentiel de l’IA sur les capacités cognitives et les modes de pensée humains: La communauté explore l’impact potentiel de l’IA sur la pensée humaine. Une préoccupation est que la dépendance excessive à l’IA entraîne une baisse des capacités cognitives (paresse à lire, affaiblissement de la pensée critique). Un autre point de vue suggère que si l’IA peut fournir des informations et des jugements plus précis, elle pourrait au contraire améliorer le niveau cognitif des personnes dont les capacités de réflexion sont initialement plus faibles ou qui sont facilement influencées par de fausses informations, jouant un rôle d‘“amélioration cognitive” et aidant à prendre de meilleures décisions. Parallèlement, il est également débattu que le développement de l’IA pourrait nous permettre de comprendre plus profondément la conscience, voire de découvrir que certaines personnes ne font peut-être que simuler la conscience. (Source: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

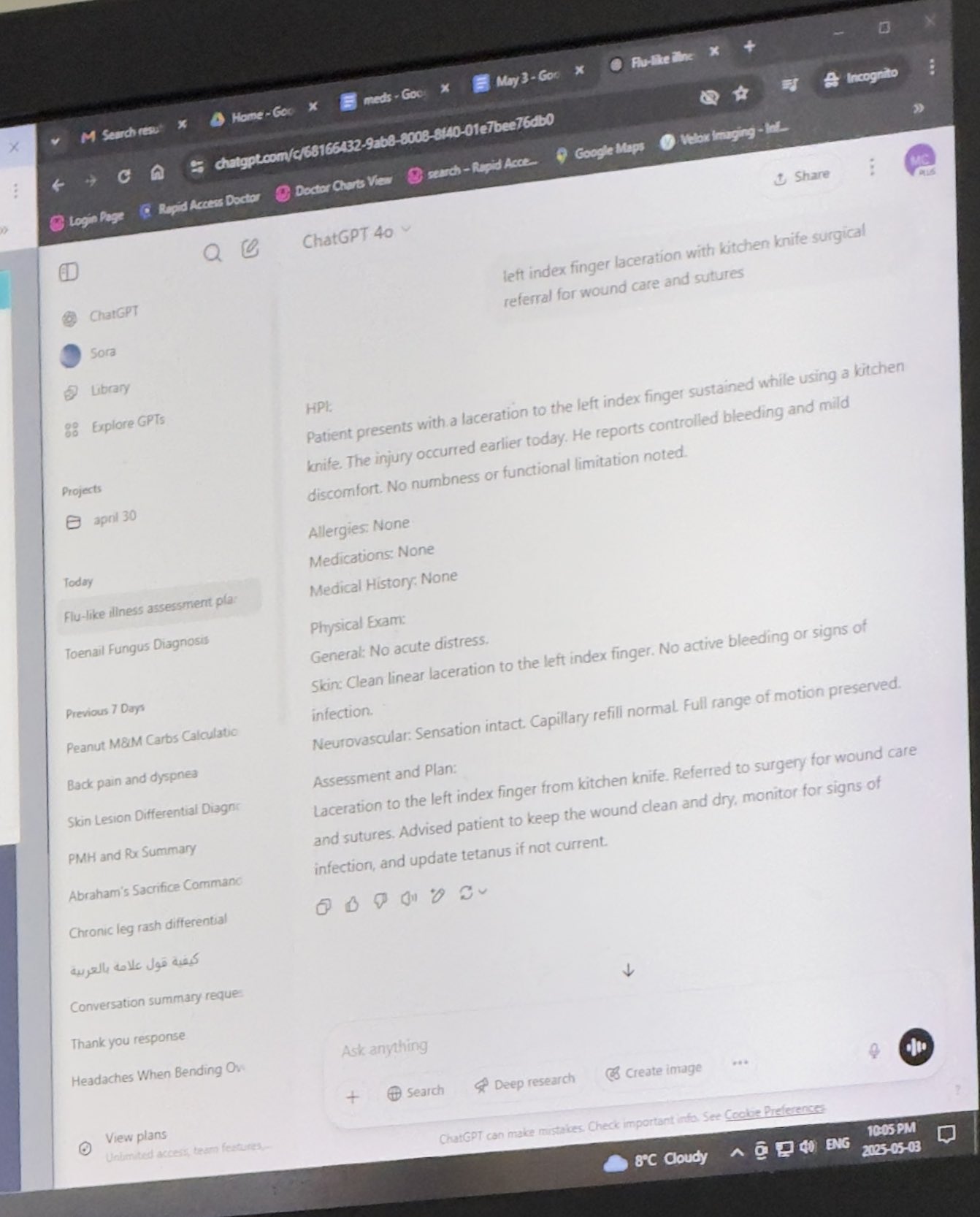

Discussion sur l’éthique et les scénarios d’application de l’IA: La discussion porte sur l’application de l’IA dans des domaines tels que la santé et le droit. Un utilisateur partage un cas où un médecin utilise ChatGPT lors d’une consultation, suscitant un débat sur l’application de l’IA dans des contextes professionnels. Parallèlement, des considérations éthiques concernant l’utilisation de l’IA pour le “ghostwriting” sont soulevées, en particulier lorsque l’auteur lui-même rencontre des difficultés. En outre, des préoccupations sont exprimées quant aux informations trompeuses et aux risques potentiels liés au contenu généré par l’IA (comme des livres sur le TDAH). (Source: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Progrès des robots pilotés par l’IA: Présentation de plusieurs robots pilotés par l’IA : un robot développé par Google DeepMind capable de jouer au ping-pong, un chien robotique présenté lors d’une exposition, un robot utilisé pour le sertissage de diamants, un drone inspiré des oiseaux capable de décoller en sautant, un ciseau mécanique utilisé pour la création artistique, et une vidéo du robot humanoïde G1 d’Unitree Robotics marchant dans un centre commercial. Ces démonstrations illustrent les progrès de l’IA dans le contrôle, la perception et l’interaction robotiques. (Source: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

L’IA et l’avenir des sciences humaines et sociales: Citant un article du New Yorker, la discussion explore l’impact de l’IA sur les sciences humaines. L’article soutient que l’IA ne peut pas atteindre le “moi-même” (me-ness) et l’expérience humaine unique, mais souligne également que l’IA, en réorganisant et en représentant l’écriture collective humaine (les archives), peut simuler une grande partie de ce que nous attendons d’un individu humain, ce qui pose des défis et de nouvelles dimensions de réflexion pour les sciences humaines. (Source: NandoDF)

💡 Divers

Outils d’aide à l’IA pour l’amélioration personnelle: Un utilisateur Reddit partage son expérience réussie d’utilisation de ChatGPT comme coach personnel de fitness et de nutrition. Grâce à l’IA, il a élaboré des plans d’entraînement, des régimes alimentaires (combinant céto, musculation, jeûne, etc.), et a même obtenu des conseils sur les macronutriments lors de commandes au restaurant, obtenant finalement de meilleurs résultats qu’avec un coach humain payant. Cela démontre le potentiel de l’IA pour le coaching personnalisé et l’assistance à la vie quotidienne. (Source: Reddit r/ChatGPT)

Combinaison de l’IA et des capacités de géo-devinette: Sam Altman relaie et commente un article de test sur les capacités étonnantes d’une IA (probablement o3) dans Geoguessr (jeu de devinette géographique). Même avec très peu d’informations sur l’image (comme seulement des panneaux flous ou même un dégradé de couleurs pur), l’IA parvient à inclure la bonne réponse parmi les options, montrant ses puissantes capacités de reconnaissance d’image, de correspondance de motifs et de raisonnement géographique. (Source: op7418)

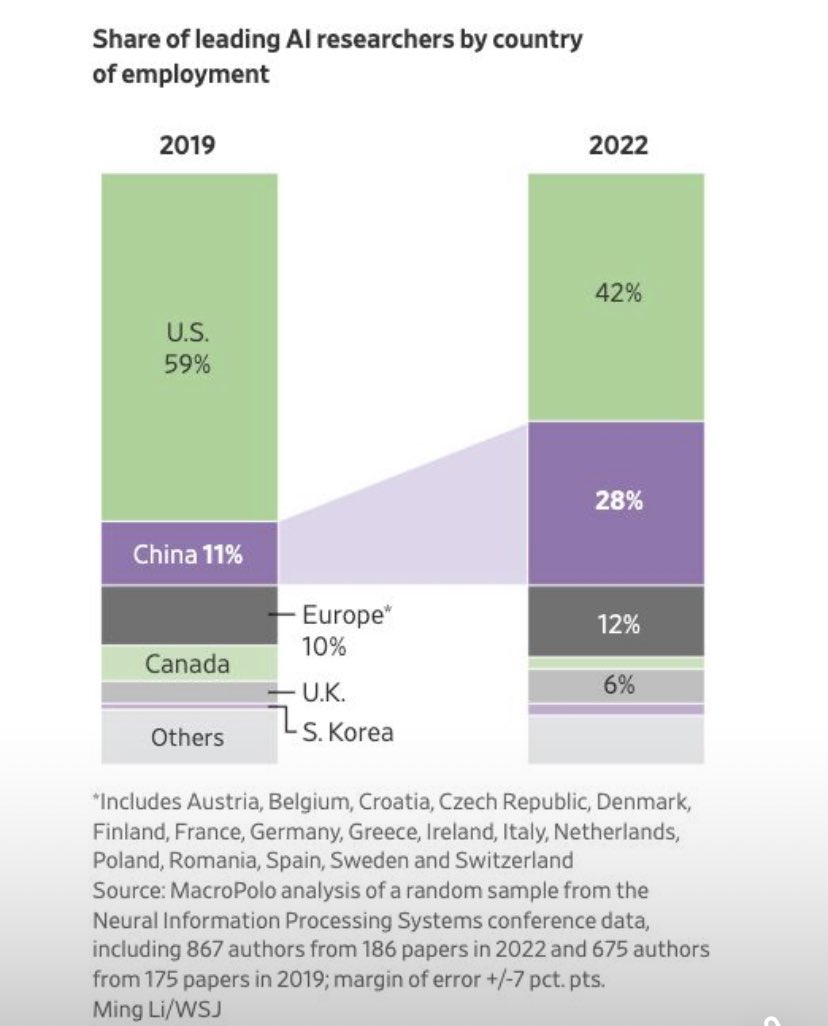

Tendances de la mobilité des chercheurs dans le domaine de l’IA: Un graphique montre l’évolution de la répartition par pays d’emploi des meilleurs chercheurs en IA. La proportion de chercheurs employés aux États-Unis diminue, tandis que celle des chercheurs employés en Chine augmente de manière significative. Les commentaires de la communauté soulignent que, compte tenu de l’augmentation des opportunités de recherche locales en Chine et du retour potentiel des talents, l’écart réel pourrait être plus important que ce que montre le graphique, reflétant l’évolution du paysage mondial de la concurrence pour les talents en IA. (Source: teortaxesTex, bookwormengr)