Mots-clés:Gemini 2.5 Pro, Modèle d’IA, Robot humanoïde, Éthique de l’IA, Entrepreneuriat en IA, Contenu généré par IA, Créativité assistée par IA, Gemini 2.5 Pro complète Pokémon : Bleu, Recherche web mondiale Anthropic Claude, Biais de routage du modèle Qwen3 MoE, Fonctionnalité Runway Gen-4 References, Application de l’IA dans le soutien en santé mentale

🔥 À la une

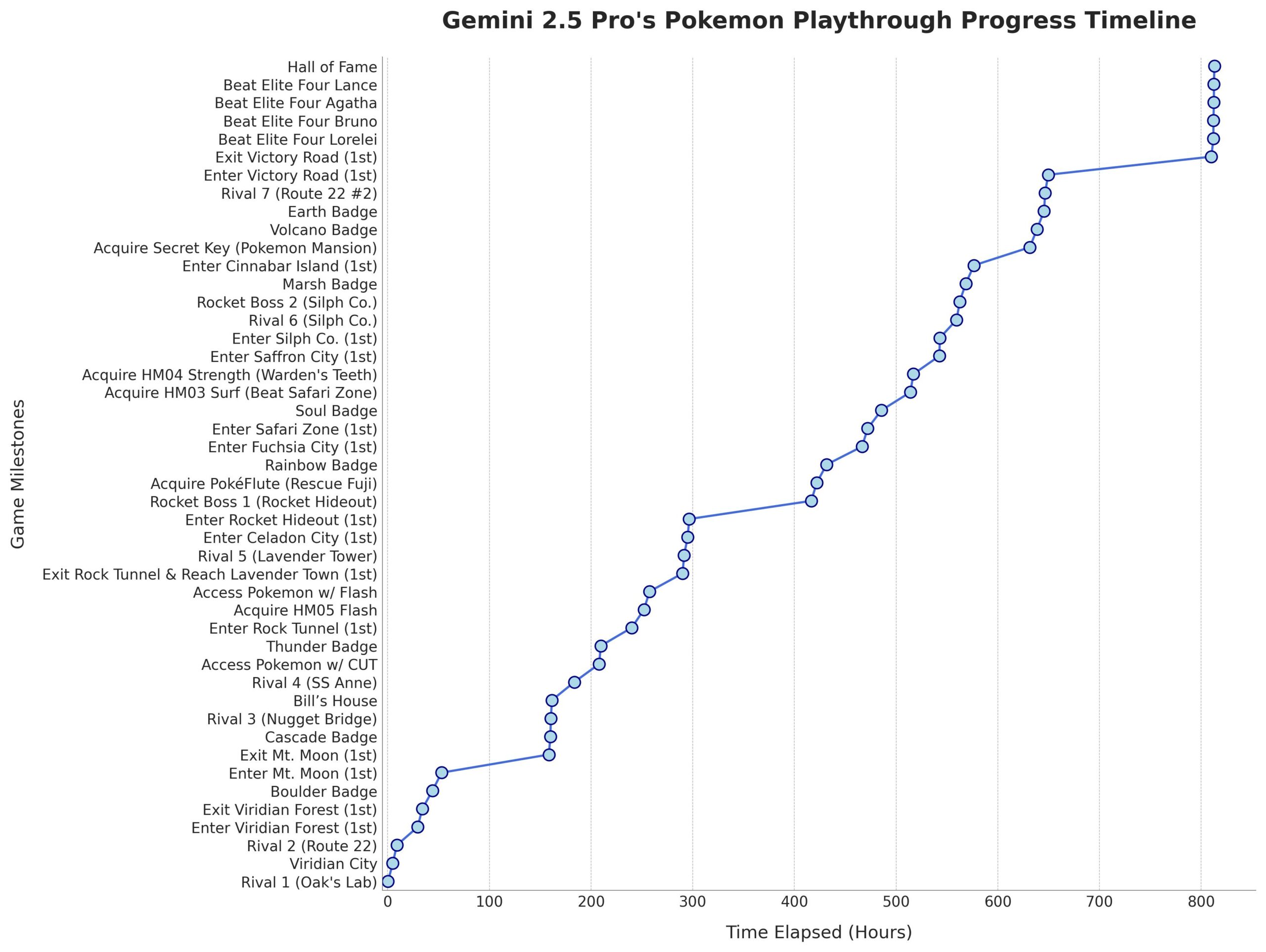

Gemini 2.5 Pro réussit à terminer Pokémon : Bleu : Le modèle d’IA Gemini 2.5 Pro de Google a terminé avec succès le jeu classique Pokémon : Bleu, incluant la collecte des 8 badges et la victoire contre le Conseil des 4 de la Ligue Pokémon. Cet exploit a été réalisé et diffusé en direct par le streamer @TheCodeOfJoel, et a été félicité par le PDG de Google, Sundar Pichai, et le PDG de DeepMind, Demis Hassabis. Cela démontre les progrès significatifs de l’IA actuelle dans la planification de tâches complexes, l’élaboration de stratégies à long terme et l’interaction avec des environnements simulés, dépassant les performances précédentes de l’IA dans ce jeu et marquant une nouvelle étape dans les capacités des agents IA. (Source: Google, jam3scampbell, teortaxesTex, YiTayML, demishassabis, _philschmid, Teknium1, tokenbender)

Apple collabore avec Anthropic pour développer la plateforme de codage IA “Vibe Coding” : Selon Bloomberg, Apple collabore avec la startup d’IA Anthropic pour développer conjointement une nouvelle plateforme de codage basée sur l’IA appelée “Vibe Coding”. La plateforme est actuellement testée en interne auprès des employés d’Apple et pourrait être ouverte aux développeurs tiers à l’avenir. Cela marque une nouvelle exploration d’Apple dans le domaine des outils d’assistance à la programmation par IA, visant à utiliser l’IA pour améliorer l’efficacité et l’expérience de développement, potentiellement en complément ou en intégration avec ses propres projets comme Swift Assist. (Source: op7418)

Progrès et discussions sur la robotique pilotée par l’IA : Les robots humanoïdes et l’intelligence incarnée ont récemment suscité une large attention. La société Figure a présenté son nouveau siège social high-tech, couvrant des laboratoires de batteries, d’actionneurs et d’IA, annonçant ses ambitions dans le domaine de la robotique. Disney a également présenté sa technologie de robots personnages humanoïdes. Cependant, lors du marathon de robots humanoïdes de Pékin, certains robots (y compris des Unitree G1 modifiés par des clients) ont montré de mauvaises performances, avec des chutes, une faible autonomie et des problèmes d’équilibre, suscitant des discussions sur les capacités réelles actuelles des robots humanoïdes et soulignant les progrès considérables encore nécessaires en matière de “cervelet” (contrôle moteur) et de “cerveau” (prise de décision intelligente). (Source: adcock_brett, Ronald_vanLoon, 人形机器人,最重要的还是“脑子”)

Intensification des discussions sur l’éthique de l’IA et son impact social : Les discussions sur l’impact social et les questions éthiques de l’IA se multiplient sur les réseaux sociaux et dans le domaine de la recherche. Par exemple, le projet de loi californien SB-1047 sur l’IA suscite la controverse, et des documentaires connexes explorent la nécessité et les défis de la réglementation. La conférence NAACL 2025 a organisé un tutoriel sur “l’intelligence sociale à l’ère des LLM”, explorant les défis à long terme et émergents de l’interaction de l’IA avec les humains et la société. Parallèlement, les utilisateurs expriment des inquiétudes quant à la qualité du contenu généré par l’IA (“slop”), estimant qu’une meilleure conception et un meilleur contrôle des modèles sont nécessaires. Ces discussions reflètent les préoccupations croissantes de la société concernant les questions éthiques, réglementaires et d’adaptabilité sociale posées par le développement rapide de la technologie de l’IA. (Source: teortaxesTex, gneubig, stanfordnlp, jam3scampbell, willdepue, wordgrammer)

🎯 Tendances

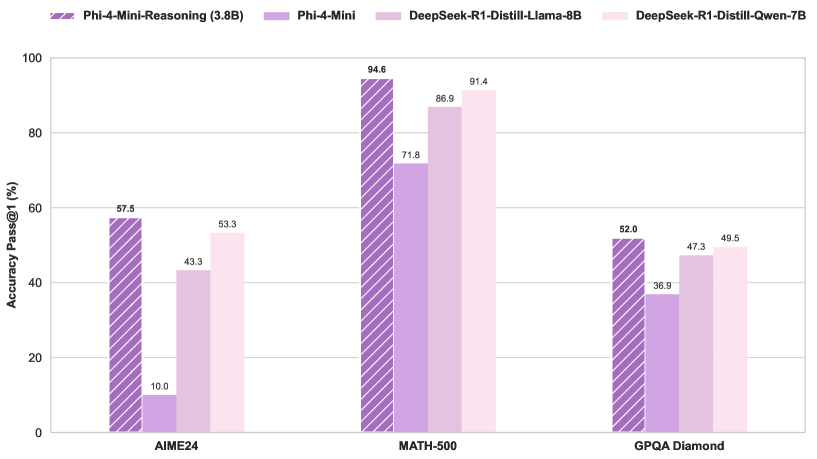

Microsoft publie le modèle Phi-4-Mini-Reasoning : Microsoft a publié le modèle Phi-4-Mini-Reasoning sur Hugging Face. Ce modèle vise à améliorer les capacités de raisonnement mathématique des petits modèles de langage, favorisant ainsi le développement de modèles plus petits et plus efficaces. (Source: _akhaliq)

Le modèle Claude d’Anthropic prend en charge la recherche Web mondiale : Anthropic a annoncé que son modèle d’IA Claude offre désormais une fonctionnalité de recherche Web mondiale à tous les utilisateurs payants. Pour les tâches simples, Claude effectuera une recherche rapide ; pour les questions complexes, il explorera plusieurs sources d’information, y compris Google Workspace, améliorant ainsi les capacités d’acquisition et de traitement d’informations en temps réel du modèle. (Source: Teknium1, Reddit r/ClaudeAI)

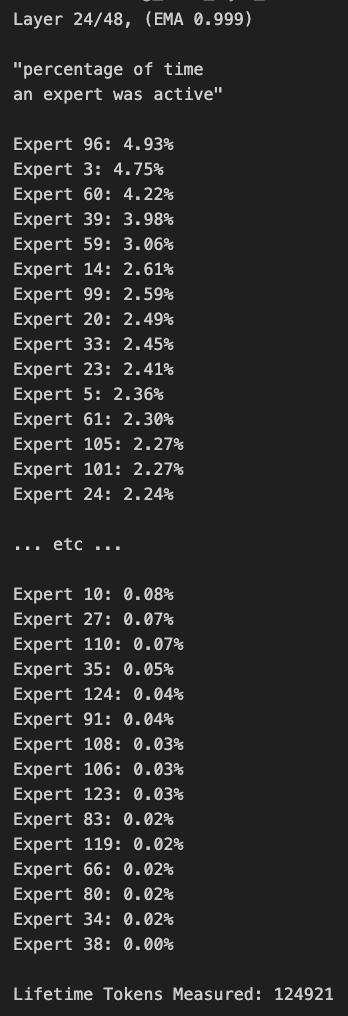

Le routage du modèle Qwen3 MoE présente des biais et peut être élagué : L’utilisateur kalomaze a analysé et découvert que la distribution du routage du modèle Qwen3 MoE (Mixture of Experts) présente des biais significatifs, même le modèle 30B MoE montre un potentiel d’élagage (pruning). Cela signifie que certains experts pourraient ne pas être pleinement utilisés, et l’élagage de ces experts pourrait réduire la taille du modèle et les besoins en calcul sans affecter significativement les performances. Kalomaze a publié une version élaguée du modèle 30B à 16B basée sur cette découverte et prévoit de publier une version élaguée du 235B à 150B. (Source: andersonbcdefg, Reddit r/LocalLLaMA)

DeepSeek Prover V2 se distingue parmi les assistants mathématiques open source : DeepSeek Prover V2 est considéré comme le modèle d’assistance mathématique open source le plus performant actuellement. Bien que ses performances soient encore inférieures à celles des modèles fermés ou plus puissants comme Gemini 2.5 Pro, o4 mini high, o3, Claude 3.7 et Grok 3, il excelle dans le raisonnement structuré. Les utilisateurs estiment qu’il doit encore être amélioré pour les sessions de “brainstorming” nécessitant une pensée créative. (Source: cognitivecompai)

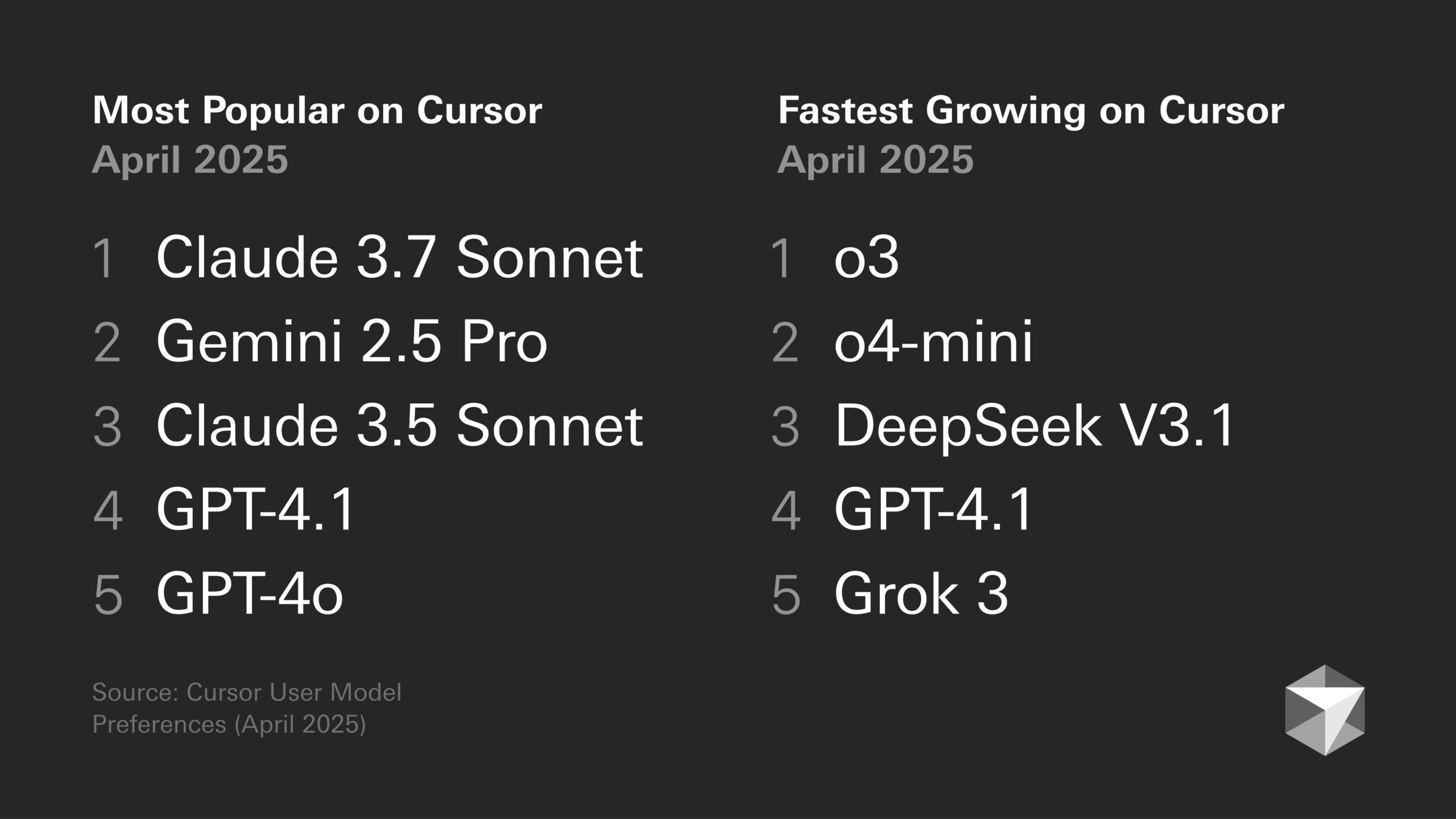

Discussion sur les préférences de modèles : tendances des développeurs et caractéristiques spécifiques des modèles : Les discussions sur les avantages et les inconvénients des différents grands modèles de langage se poursuivent dans la communauté des développeurs. Par exemple, Sentdex estime que la combinaison de Codex et o3 dans Cursor est plus performante que Claude 3.7. VictorTaelin indique que bien que Sonnet 3.7 ne soit pas parfait (ajoutant parfois du contenu non demandé, intelligence en deçà des attentes), il fournit en pratique des résultats plus stables et fiables que GPT-4o (sujet aux erreurs), o3/Gemini (mauvais formatage et réécriture du code), R1 (légèrement dépassé) et Grok 3 (le deuxième meilleur, mais légèrement inférieur en pratique). Cela reflète l’adéquation variable des différents modèles pour des tâches et des flux de travail spécifiques. (Source: Sentdex, VictorTaelin, paul_cal)

Discussion sur la tendance des performances des LLM : croissance exponentielle ou rendements décroissants ? : Les utilisateurs de Reddit débattent pour savoir si les LLM connaissent toujours une amélioration exponentielle. Certains pensent que, malgré des progrès rapides au début, l’amélioration des performances des LLM tend maintenant vers des rendements décroissants, où obtenir des performances supplémentaires devient de plus en plus difficile et coûteux, à l’instar du développement de la technologie de conduite autonome. D’autres utilisateurs réfutent cet argument, soulignant le bond énorme de GPT-3 à Gemini 2.5 Pro comme preuve que les progrès restent significatifs et qu’il est trop tôt pour parler de plateau. La discussion reflète des attentes différentes quant à la vitesse future du développement de l’IA. (Source: Reddit r/ArtificialInteligence)

Les puces IA deviennent la clé du développement des robots humanoïdes : L’industrie considère que le cœur des robots humanoïdes réside dans leur “cerveau”, c’est-à-dire les puces haute performance. L’article souligne que les robots humanoïdes actuels présentent encore des lacunes en matière de contrôle moteur (“cervelet”) et de prise de décision intelligente (“cerveau”), et que les performances des puces déterminent directement le degré d’intelligence du robot. Les GPU de Nvidia, les processeurs Intel, ainsi que les puces chinoises Huashan A2000 et Wudang C1236 de Black Sesame Technologies, fournissent aux robots des capacités de perception, de raisonnement et de contrôle accrues, et sont essentielles pour faire passer les robots humanoïdes du stade de gadget à celui d’application pratique. (Source: 人形机器人,最重要的还是“脑子”)

Éthique de l’IA et anthropomorphisme : pourquoi disons-nous “merci” à l’IA ? : La discussion souligne que, bien que l’IA n’ait pas d’émotions, les utilisateurs ont tendance à utiliser un langage poli (comme “merci”, “s’il vous plaît”) avec elle. Cela découle de l’instinct d’anthropomorphisation humain et de la “perception de présence sociale”. Des études montrent que des interactions polies peuvent amener l’IA à générer des réponses plus conformes aux attentes et plus humaines. Cependant, cela comporte également des risques, tels que l’apprentissage et l’amplification par l’IA des biais humains, ou son orientation malveillante pour produire du contenu inapproprié. La politesse envers l’IA reflète la psychologie complexe et l’adaptation sociale des humains lors de l’interaction avec des machines de plus en plus intelligentes. (Source: 你对 AI 说的每一句「谢谢」,都在烧钱)

🧰 Outils

Fonctionnalité Runway Gen-4 References : La fonctionnalité Gen-4 References lancée par RunwayML permet aux utilisateurs d’intégrer leurs propres images ou des images de référence dans des vidéos ou des images générées par IA (comme des mèmes). Les retours des utilisateurs indiquent que la fonctionnalité est très efficace, capable de gérer plusieurs personnages cohérents apparaissant dans la même image générée, simplifiant le processus d’intégration de personnes ou de styles spécifiques dans les créations IA. (Source: c_valenzuelab)

Krea AI lance des modèles de génération d’images : Krea AI ajoute une nouvelle fonctionnalité qui transforme les prompts courants de génération d’images de GPT-4o en modèles. Les utilisateurs n’ont qu’à télécharger leur propre image et choisir un modèle pour générer une image dans le style correspondant, sans avoir à saisir manuellement des prompts complexes, simplifiant ainsi le processus de génération d’images. (Source: op7418)

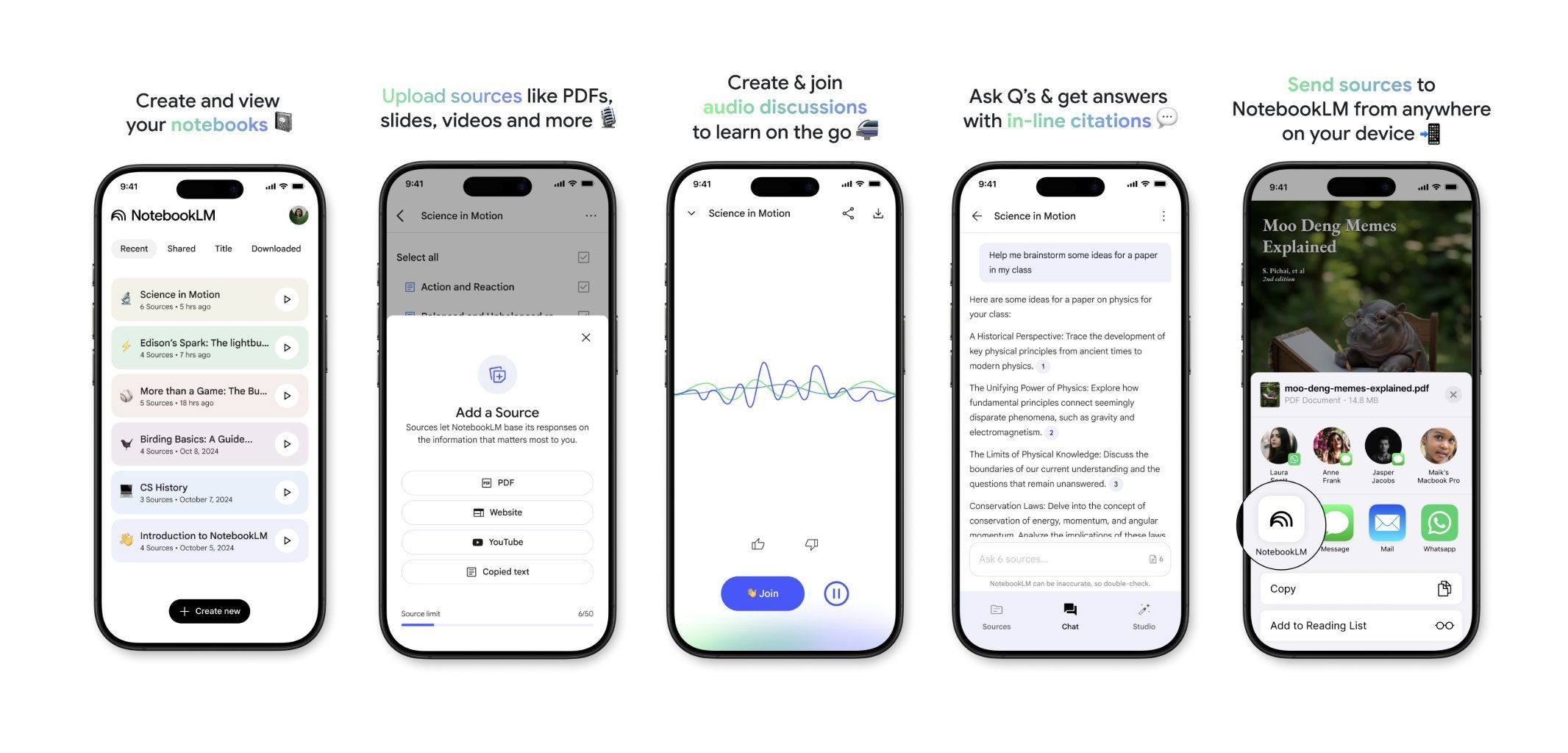

NotebookLM lancera bientôt une application mobile : NotebookLM de Google (anciennement Project Tailwind) s’apprête à lancer une application mobile. Les utilisateurs pourront rapidement transférer des articles et du contenu vus sur leur téléphone vers NotebookLM pour traitement et intégration. Une liste d’attente pour l’application est déjà ouverte, visant à offrir une expérience plus pratique de gestion de l’information mobile et d’apprentissage assisté par IA. (Source: op7418)

Runway pour la décoration d’intérieur : Un utilisateur montre un exemple d’utilisation de Runway AI pour la décoration d’intérieur. En fournissant une image d’un espace et une image de référence représentant un style/une ambiance, Runway peut générer des rendus de décoration d’intérieur fusionnant les caractéristiques des deux, démontrant le potentiel de l’IA dans le domaine de la conception créative. (Source: c_valenzuelab)

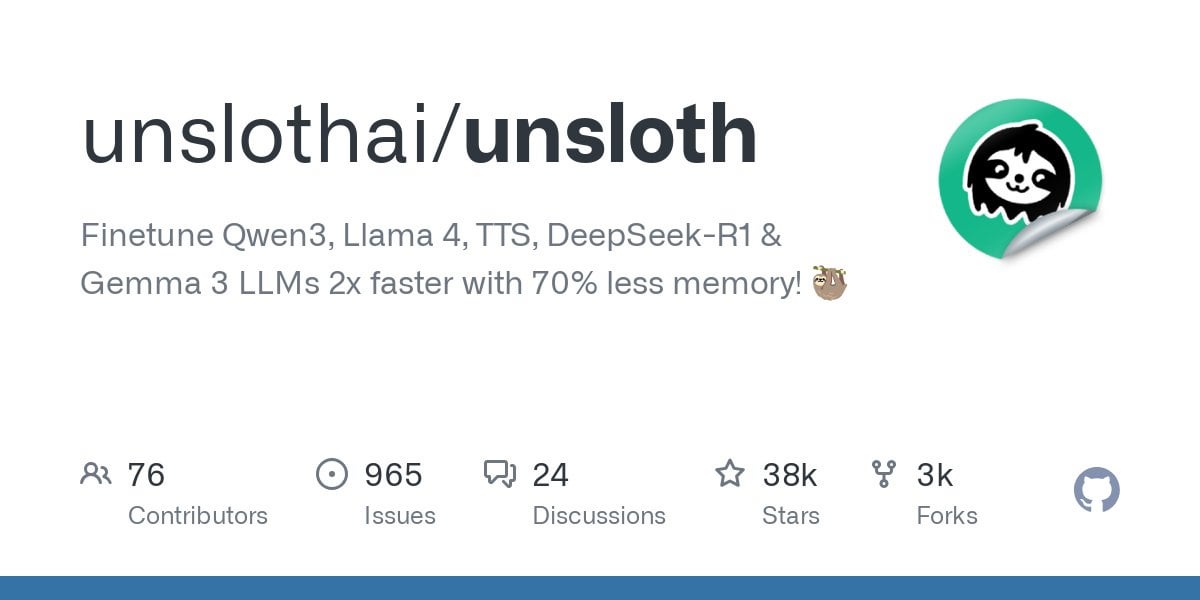

Unsloth prend en charge le fine-tuning des modèles Qwen3 : Unsloth annonce la prise en charge du fine-tuning des modèles de la série Qwen3, avec une vitesse multipliée par 2 et une utilisation de la VRAM réduite de 70%. Les utilisateurs peuvent effectuer un fine-tuning avec une longueur de contexte 8 fois supérieure à celle de Flash Attention 2 sur un GPU de 24 Go de VRAM. Un notebook Colab est fourni pour fine-tuner gratuitement le modèle Qwen3 14B, et diverses versions quantifiées, y compris GGUF, ont été mises en ligne. Cela abaisse le seuil matériel pour le fine-tuning de modèles avancés. (Source: Reddit r/LocalLLaMA)

Fonctionnalité Claude AI Styles : Un utilisateur partage son expérience d’utilisation de la fonctionnalité Styles de Claude AI pour améliorer la collaboration avec l’IA. En créant un style nommé “Iterative Engineering”, définissant des étapes de discussion, planification, modifications par petites étapes, test, itération, refactoring à la demande, il est possible de guider Claude vers un codage plus méthodique et incrémental, évitant la réécriture excessive du code et améliorant l’utilité de l’IA en tant que partenaire de programmation. (Source: Reddit r/ClaudeAI)

Deepwiki fournit la source des blocs de code : L’utilisateur cto_junior mentionne un avantage de Deepwiki : il affiche le bloc de code source à côté de chaque réponse, et pas seulement des liens annexes. Cette pratique augmente la crédibilité de l’information, ce qui est particulièrement utile pour les ingénieurs en développement logiciel (SDEs) sceptiques vis-à-vis des outils IA. (Source: cto_junior)

📚 Apprentissage

NousResearch publie une mise à jour du framework Atropos RL : Le framework d’environnement d’apprentissage par renforcement (RL) Atropos de NousResearch a été mis à jour. La nouvelle fonctionnalité permet aux utilisateurs de tester rapidement et facilement le rollout d’environnements RL, sans nécessiter d’entraînement ou de moteur d’inférence. Par défaut, il utilise l’API OpenAI, mais peut être configuré pour d’autres fournisseurs d’API (ou des points de terminaison locaux VLLM/SGLang). Une fois le test terminé, un rapport web contenant les completions et leurs scores est généré, et la journalisation wandb est prise en charge, facilitant le débogage et l’évaluation des environnements RL. (Source: Teknium1)

Publication du jeu de données de référence RAG personnalisé EnronQA : Des chercheurs ont publié le jeu de données EnronQA, visant à promouvoir la recherche sur la génération augmentée par récupération personnalisée (Personalized RAG) sur des documents privés. Ce jeu de données contient 103 638 e-mails et 528 304 paires question-réponse de haute qualité pour 150 utilisateurs, fournissant une ressource pour évaluer et développer des systèmes RAG capables de comprendre et d’utiliser des informations spécifiques à l’utilisateur. (Source: lateinteraction)

Publication de GTE-ModernColBERT (PyLate) : LightOnAI a publié GTE-ModernColBERT (PyLate), un retriever MaxSim de 128 dimensions, basé sur gte-modernbert-base et fine-tuné sur ms-marco-en-bge-gemma. Il prend en charge nativement la bibliothèque PyLate pour le re-ranking et l’indexation HNSW. Il obtient d’excellentes performances sur le benchmark NanoBEIR et dépasse ColBERT-small sur le score moyen BEIR, offrant une nouvelle option efficace pour la récupération de texte. (Source: lateinteraction)

SOLO Bench – Nouveau benchmark pour LLM : L’utilisateur jd_3d a développé et publié SOLO Bench, une nouvelle méthode de benchmark pour LLM. Ce test demande au LLM de générer un texte contenant un nombre spécifique de phrases (par exemple 250 ou 500), chaque phrase devant contenir un et un seul mot d’une liste prédéfinie (contenant des noms, verbes, adjectifs, etc.), et chaque mot ne pouvant être utilisé qu’une seule fois. L’évaluation est effectuée par un script basé sur des règles, visant à tester la capacité du LLM à suivre les instructions, à satisfaire les contraintes et à générer de longs textes. Les premiers résultats montrent que ce benchmark permet de différencier efficacement les performances des différents modèles. (Source: Reddit r/LocalLLaMA)

Manipulation de l’espace latent par réflexion récursive stratégique : Un utilisateur propose une méthode pour créer des hiérarchies de raisonnement imbriquées dans l’espace latent d’un LLM via une “réflexion récursive stratégique” (Strategic recursive reflection, RR). En incitant le modèle à réfléchir aux interactions précédentes à des moments clés, des boucles métacognitives sont générées, construisant des “mini-espaces latents”. Chaque prompt est considéré comme une contrainte guidant le chemin du modèle dans l’espace latent, le rendant plus autoréférentiel et capable d’abstraction. Ceci est considéré comme simulant le processus humain d’approfondissement de la pensée par la réflexion sur les pensées, visant à explorer des concepts plus profonds. (Source: Reddit r/ArtificialInteligence)

💼 Affaires

Google paie Samsung pour préinstaller Gemini AI : Suite à sa condamnation l’année dernière pour violation des lois antitrust concernant l’accord sur le moteur de recherche par défaut, il a été révélé que Google verse mensuellement des “sommes considérables” et une part des revenus à Samsung pour préinstaller Gemini AI sur les appareils Samsung, et pourrait exiger des partenaires qu’ils préinstallent obligatoirement Gemini. Cela explique pourquoi la série Samsung Galaxy S25 intègre profondément Gemini, allant jusqu’à le définir comme assistant IA par défaut. Cette démarche reflète la stratégie de Google visant à s’emparer rapidement de l’entrée de l’IA mobile, compte tenu de l’insuffisance de ses propres canaux matériels, mais pourrait également raviver les préoccupations antitrust. (Source: 三星手机预装Gemini AI,也是谷歌花钱买的)

Les startups IA confrontées à des défis : Une discussion sur Reddit souligne que de nombreuses startups IA pourraient manquer de “moat” (avantage concurrentiel durable), car les capacités des modèles convergent et la fidélité des utilisateurs est faible. Les grandes entreprises technologiques (Google, Microsoft, Apple) bénéficient de l’avantage de leur écosystème (préinstallation, intégration) pour atteindre plus facilement les utilisateurs. Même si le modèle d’une startup est légèrement meilleur, les utilisateurs pourraient préférer utiliser l’IA par défaut ou intégrée qui est “suffisamment bonne”. Cela soulève des inquiétudes quant à la viabilité à long terme des startups IA et aux perspectives d’investissement en capital-risque. (Source: Reddit r/ArtificialInteligence)

Résumé des financements et actualités commerciales de l’IA cette semaine (2 mai 2025) : Le PDG de Microsoft révèle que l’IA a écrit des “parties importantes” du code de l’entreprise ; le directeur financier de Microsoft avertit que les services IA pourraient être interrompus en raison d’une demande excessive ; Google commence à diffuser des publicités dans les chatbots IA tiers ; Meta lance une application IA indépendante ; Cast AI lève 108 M$, Astronomer lève 93 M$, Edgerunner AI lève 12 M$ ; une étude accuse LM Arena de manipulation de benchmarks ; Nvidia conteste le soutien d’Anthropic aux contrôles d’exportation de puces. (Source: Reddit r/artificial)

🌟 Communauté

Discussion sur la qualité et le coût du contenu généré par l’IA : La communauté exprime des inquiétudes quant à la qualité inégale du contenu généré par l’IA (appelé “slop”). L’utilisateur wordgrammer souligne que de nombreuses vidéos IA générées sont de mauvaise qualité et que le coût réel (en tenant compte du filtrage et des nouvelles tentatives) est bien supérieur au prix affiché. Cela suscite des discussions sur la conception des modèles (comme jam3scampbell citant Steve Jobs) et l’utilisation efficace des outils IA, soulignant la nécessité d’un contrôle plus fin et de normes de qualité de génération plus élevées. (Source: wordgrammer, jam3scampbell, willdepue)

Discussions sur les performances de l’IA dans des tâches spécifiques : Les membres de la communauté discutent des performances et des limites de l’IA dans différentes tâches. Par exemple, DeepSeek R1 est considéré comme pouvant représenter un pic du battage médiatique autour des LLM ; bien qu’il y ait des progrès dans des domaines comme les mathématiques formelles et la médecine, cela n’a pas encore attiré l’attention du grand public. DeepSeek Prover V2 est performant en mathématiques mais est jugé manquant de créativité. L’utilisateur vikhyatk remet en question la pertinence de l’optimisation excessive des modèles pour performer sur des benchmarks spécifiques comme l’AIME (American Invitational Mathematics Examination), arguant que le grand public ne se soucie pas des capacités mathématiques. Ces discussions reflètent une réflexion sur les limites des capacités de l’IA et leur valeur applicative réelle. (Source: wordgrammer, cognitivecompai, vikhyatk)

Créativité et design assistés par IA : La communauté présente diverses manières d’utiliser les outils IA pour la conception créative. Des utilisateurs utilisent la fonction Gen-4 References de Runway pour s’intégrer dans des mèmes ; utilisent Runway pour générer des concepts de décoration d’intérieur ; utilisent GPT-4o et des modèles de prompts pour créer des images avec des styles spécifiques (comme un tigre de Chine méridionale en origami, des repose-poignets en silicone en forme d’animaux, l’intégration du sens des mots dans la conception des lettres). Ces exemples montrent le potentiel de l’IA dans la créativité visuelle et le design personnalisé. (Source: c_valenzuelab, c_valenzuelab, dotey, dotey, dotey)

Questionnement sur la capacité de l’IA à imiter le style d’écriture : L’utilisateur nrehiew_ estime que l’instruction donnée à un LLM de “continuer à écrire sur mon ton et mon style” pourrait ne pas avoir d’effet réel, car la plupart des gens surestiment l’unicité de leur propre style d’écriture. Cela soulève une discussion sur la capacité des LLM à comprendre et à reproduire des nuances subtiles de style d’écriture, ainsi que sur la perception biaisée des utilisateurs quant à cette capacité. (Source: nrehiew_)

L’IA pour le soutien émotionnel suscite empathie et discussion : Des utilisateurs de Reddit partagent leurs expériences de soutien émotionnel, voire d’aide en situation de crise, obtenues en dialoguant avec des IA comme ChatGPT. Beaucoup déclarent que, dans des moments de solitude, de besoin de parler ou face à des difficultés psychologiques, l’IA offre un interlocuteur sans jugement, patient et toujours disponible, parfois même ressenti comme plus efficace qu’une conversation avec un humain. Cela suscite une discussion sur le rôle de l’IA dans le soutien à la santé mentale, tout en soulignant qu’elle ne peut remplacer l’aide humaine professionnelle et qu’il faut être vigilant quant aux biais ou aux informations trompeuses qu’elle pourrait véhiculer. (Source: Reddit r/ChatGPT, Reddit r/ClaudeAI)

Divergences d’opinions sur l’art généré par IA : Les utilisateurs discutent de l’impact potentiel de l’art généré par IA sur la perception des artistes humains et de leurs œuvres. Certains se plaignent que des œuvres de haute qualité sont désormais souvent attribuées à tort à l’IA, ignorant le talent et les efforts du créateur. Ce phénomène commence même à déformer la perception des gens, les incitant à rechercher des “erreurs humaines” dans les œuvres pour confirmer qu’elles ne sont pas créées par l’IA. La discussion aborde également la question de savoir si un filigrane devrait être obligatoire pour le contenu généré par IA. (Source: Reddit r/ArtificialInteligence)

💡 Autres

La consommation de ressources par l’IA attire l’attention : La discussion souligne l’énorme consommation de ressources derrière le développement de l’IA. L’entraînement et l’exécution de grands modèles d’IA nécessitent d’importantes quantités d’électricité et d’eau, les centres de données devenant de nouvelles installations à forte consommation d’énergie. Chaque interaction d’un utilisateur avec une IA, y compris un simple “merci”, consomme de l’énergie de manière cumulative. Cela suscite des préoccupations quant au développement durable de l’IA et à l’attention portée aux solutions énergétiques (comme la fusion nucléaire). (Source: 你对 AI 说的每一句「谢谢」,都在烧钱)

Distance entre l’IA et la conscience : Des utilisateurs de Reddit discutent pour savoir si l’IA actuelle possède une conscience de soi. L’opinion générale est que l’IA actuelle (comme les LLM) est essentiellement un système complexe de reconnaissance de formes basé sur la prédiction probabiliste de mots, dépourvu de véritable compréhension et de conscience de soi, et qu’elle est encore très loin de posséder cette capacité. Cependant, certains commentaires soulignent que la conscience humaine elle-même n’est pas entièrement comprise, que la comparaison peut être erronée, et que les capacités surhumaines de l’IA dans des tâches spécifiques ne doivent pas être ignorées. (Source: Reddit r/ArtificialInteligence)

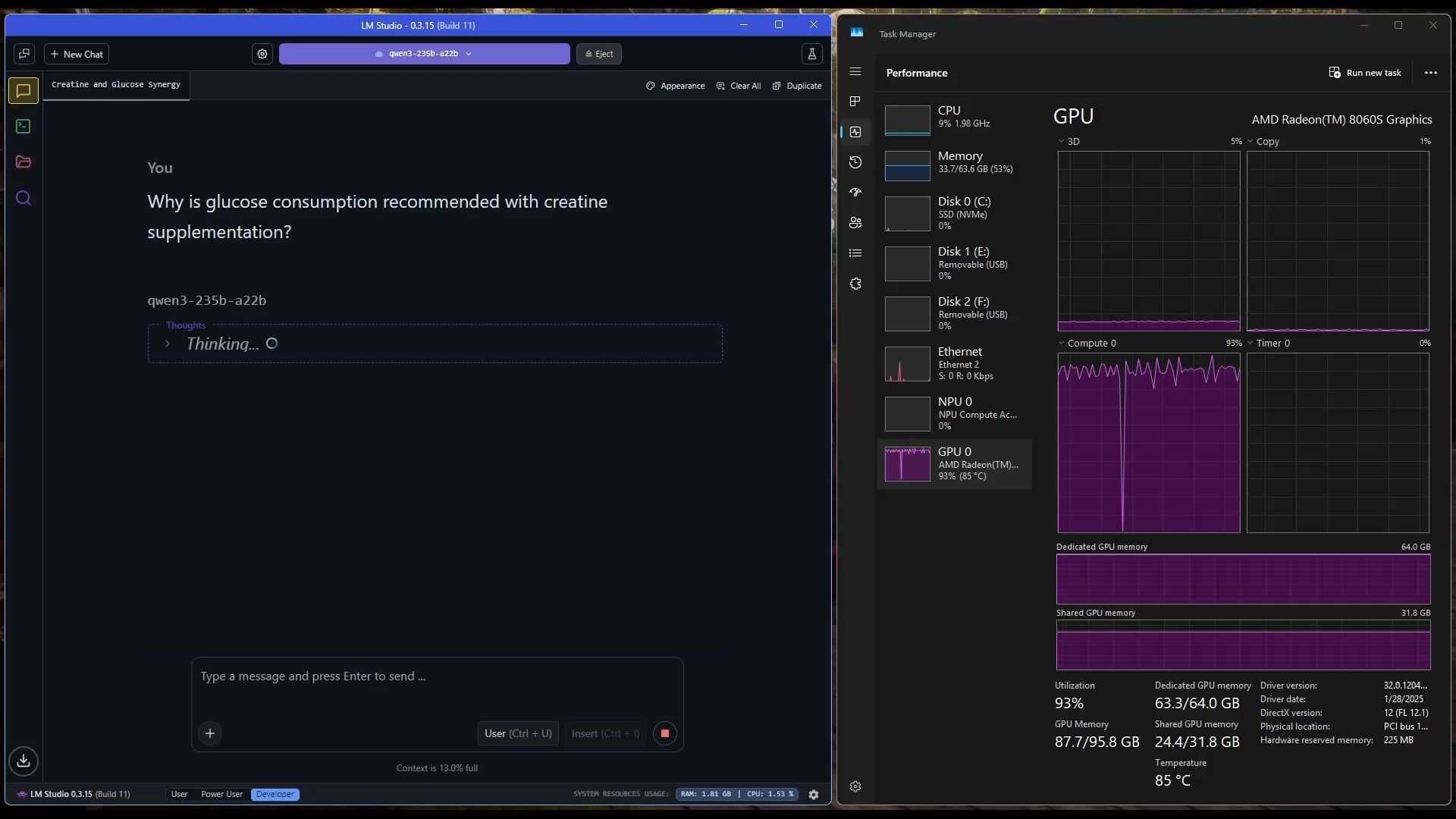

Une tablette Windows exécute un grand modèle MoE : Un utilisateur montre un exemple d’exécution du modèle Qwen3 235B-A22B MoE (avec quantification Q2_K_XL) sur une tablette Windows équipée d’un AMD Ryzen AI Max 395+ et de 128 Go de RAM, en utilisant uniquement l’iGPU (Radeon 8060S, avec 87,7 Go des 95,8 Go alloués comme VRAM), atteignant une vitesse d’environ 11,1 t/s. Cela démontre la possibilité d’exécuter des modèles de très grande taille sur des appareils portables, bien que la bande passante mémoire reste un goulot d’étranglement. (Source: Reddit r/LocalLLaMA)