Mots-clés:Interface d’interaction LLM, Débat sur l’AGI, Stratégie de l’application Gemini, Éthique des compagnons IA, Modèle Qwen3, Technologie RAG, Architecture alternative à Transformer, Publication de modèles d’IA, Interface d’interaction visuelle Karpathy, Éléments clés de l’Agentic RAG, Architecture des Liquid Foundation Models, Méthode d’entraînement Phi-4-Reasoning, Rétro-ingénierie des invites système de NotebookLM

Okay, voici la traduction en français, en respectant toutes les consignes :

🔥 En Vedette

La vision de Karpathy sur l’interface d’interaction future des LLM: Karpathy prédit que l’interaction future avec les LLM dépassera le mode terminal texte actuel pour évoluer vers une interface de canevas 2D visuelle, générative et interactive. Cette interface sera générée instantanément selon les besoins de l’utilisateur, intégrant divers éléments tels que des images, des graphiques, des animations, etc., offrant une expérience plus dense en informations et plus intuitive, similaire à ce qui est dépeint dans des œuvres de science-fiction comme « Iron Man ». Il considère que les formats actuels comme Markdown, les blocs de code, etc., ne sont que des premières ébauches (source: karpathy)

Vif débat sur la question de savoir si l’AGI est une étape clé: Arvind Narayanan et Sayash Kapoor publient sur AI Snake Oil un article explorant en profondeur le concept d’AGI (Artificial General Intelligence), soutenant qu’il ne s’agit pas d’un jalon technologique clair ni d’un point de rupture soudain. L’article argumente sous plusieurs angles (impact économique – la diffusion prend du temps ; géopolitique – capacité n’égale pas pouvoir ; risques – distinguer capacité et pouvoir ; dilemme de définition – jugement rétrospectif), que même si un certain seuil de capacité AGI était atteint, cela ne déclencherait pas immédiatement d’effets économiques ou sociaux disruptifs. Une attention excessive portée à l’AGI pourrait détourner l’attention des problèmes réels actuels de l’IA (source: random_walker, random_walker, random_walker, random_walker, random_walker)

Le responsable de Google DeepMind expose la stratégie de l’application Gemini: Demis Hassabis relaie et approuve l’exposé de Josh Woodward sur la future stratégie de l’application Gemini. Cette stratégie s’articule autour de trois piliers : Personnalisation (Personal), en intégrant les données de l’écosystème Google de l’utilisateur (Gmail, Photos, etc.) pour offrir un service plus pertinent ; Proactivité (Proactive), en anticipant les besoins de l’utilisateur avant même qu’il ne pose une question et en fournissant des insights et des suggestions d’actions ; Puissance (Powerful), en utilisant les modèles de DeepMind (comme le 2.5 Pro) pour la recherche, l’orchestration et la génération de contenu multimodal. L’objectif est de créer un assistant IA personnel puissant qui semble être une extension de l’utilisateur (source: demishassabis)

Le développement par Meta de compagnons IA suscite des débats éthiques et sociaux: Mark Zuckerberg mentionne dans une interview que Meta développe des amis/compagnons IA pour répondre aux besoins sociaux (citant que “l’Américain moyen a 3 amis, mais le besoin est de 15”). Ce projet a suscité de nombreuses discussions : d’une part, il pourrait apporter du réconfort aux personnes seules ; d’autre part, il soulève des inquiétudes quant à savoir s’il pourrait éroder davantage les interactions sociales réelles, aggraver l’atomisation sociale et poser des problèmes de confidentialité des données (source: Reddit r/artificial, dwarkesh_sp, nptacek)

🎯 Tendances

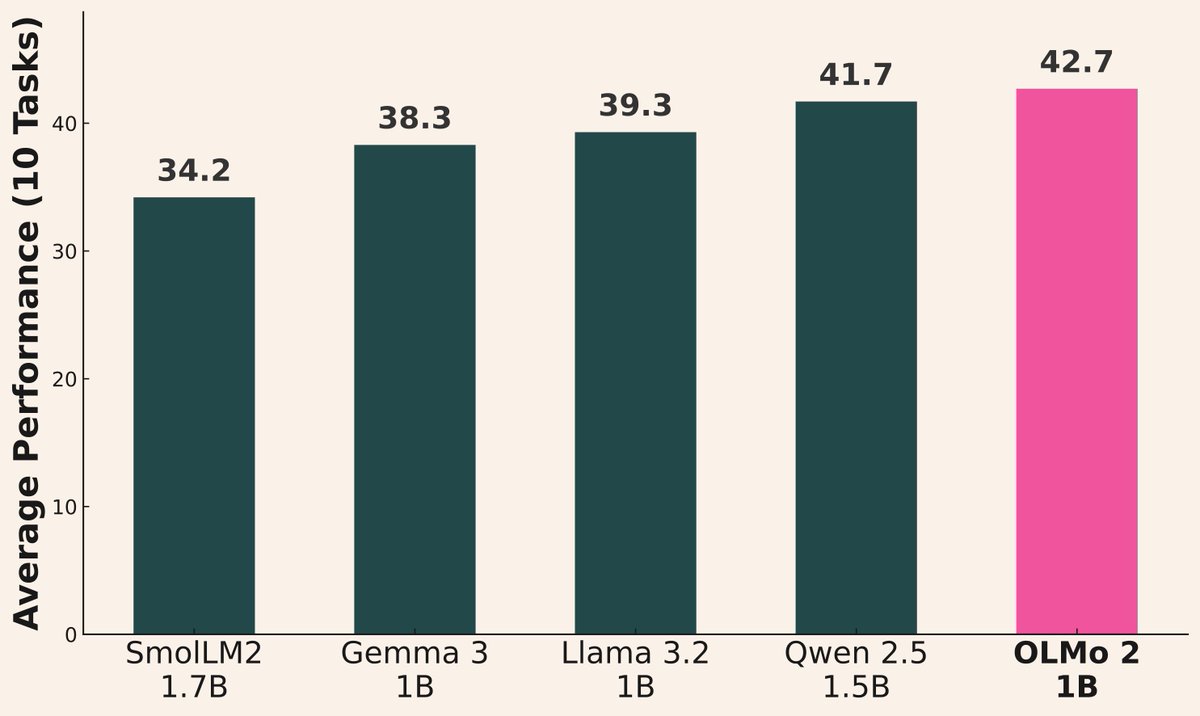

La vague de lancements de modèles d’IA se poursuit: Plusieurs institutions ont récemment lancé de nouveaux modèles : Alibaba a publié la série Qwen3 (incluant de 0.6B à 235B MoE) ; AI2 a lancé le modèle OLMo 2 1B, surpassant Gemma 3 1B et Llama 3.2 1B ; Microsoft a publié la série Phi-4 (Mini 3.8B, Reasoning 14B) ; DeepSeek a lancé Prover V2 671B MoE ; Xiaomi a lancé MiMo 7B ; Kyutai a lancé Helium 2B ; JetBrains a lancé le modèle de complétion de code Mellum 4B. Les capacités des modèles open source continuent de s’améliorer rapidement (source: huggingface, teortaxesTex, finbarrtimbers, code_star, scaling01, ClementDelangue, tokenbender, karminski3)

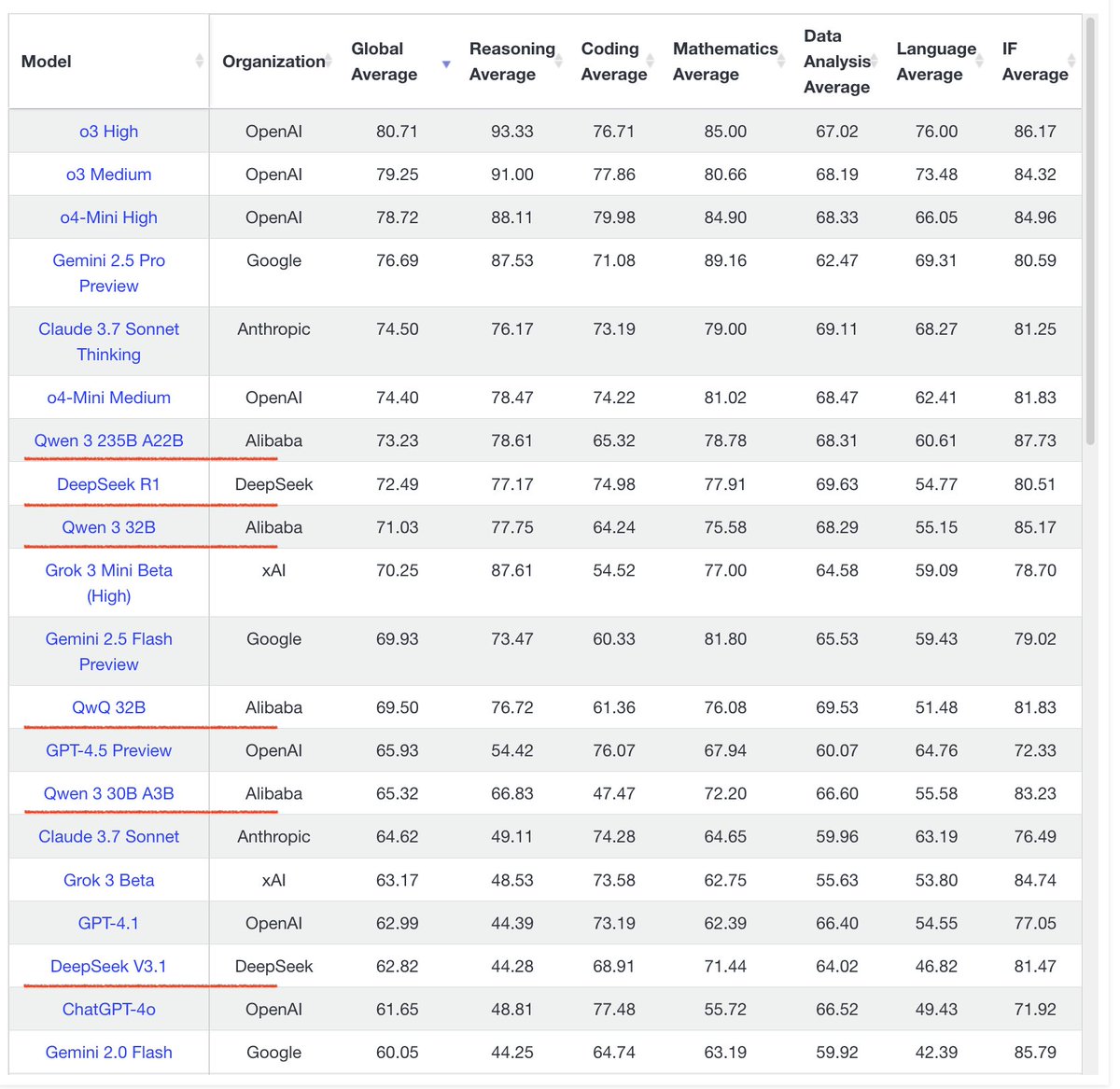

Performances remarquables de la série de modèles Qwen3: Les retours de la communauté indiquent d’excellentes performances pour la série de modèles Qwen3. Qwen3 32B est considéré comme atteignant le niveau d’o3-mini à un coût inférieur ; Qwen3 4B excelle dans des tests spécifiques (comme compter les “R” dans “strawberry”) et les tâches RAG, étant même utilisé par certains pour remplacer Gemini 2.5 Pro ; le modèle 30B MoE montre des capacités exceptionnelles en traduction multilingue (y compris les dialectes). Un utilisateur a observé que Qwen3 235B MoE admet ses limites de connaissance lorsqu’il ne peut pas répondre, plutôt que d’inventer, ce qui pourrait indiquer une amélioration dans la gestion des hallucinations (source: scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, teortaxesTex, scaling01)

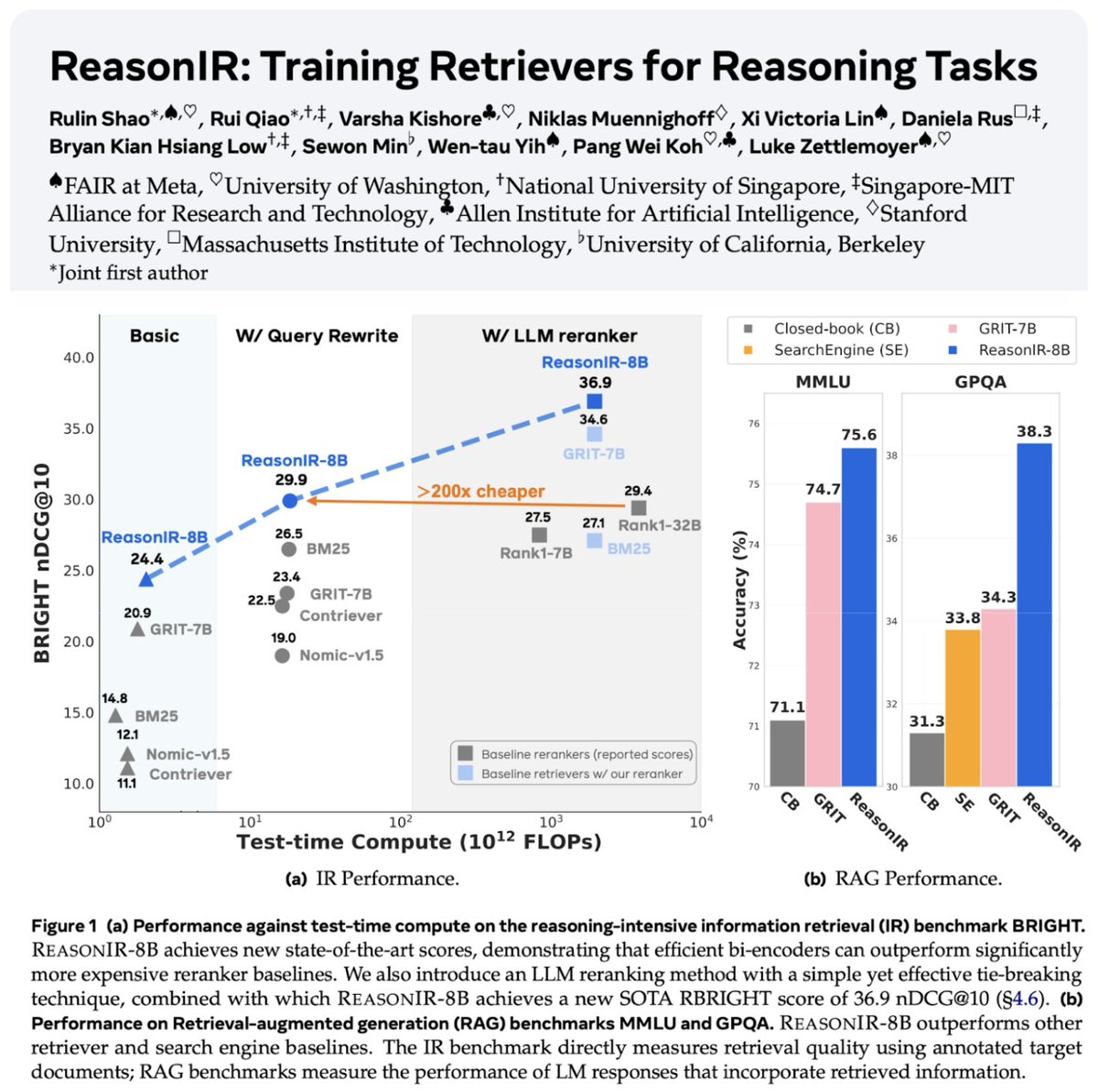

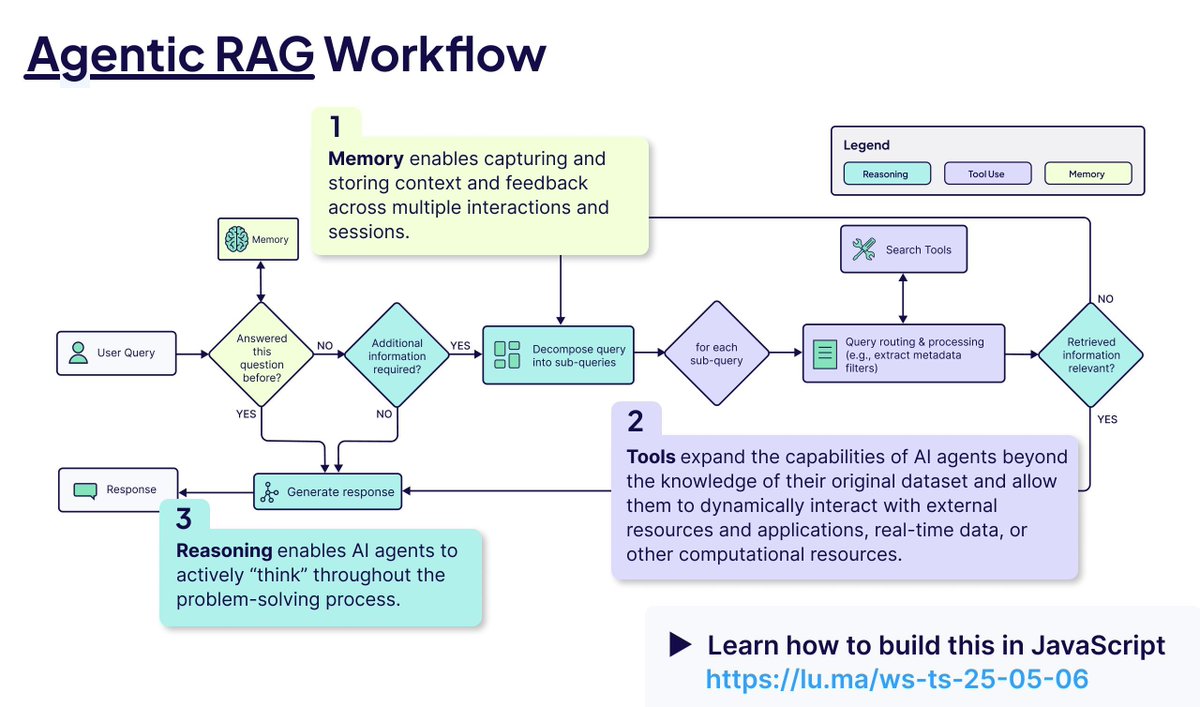

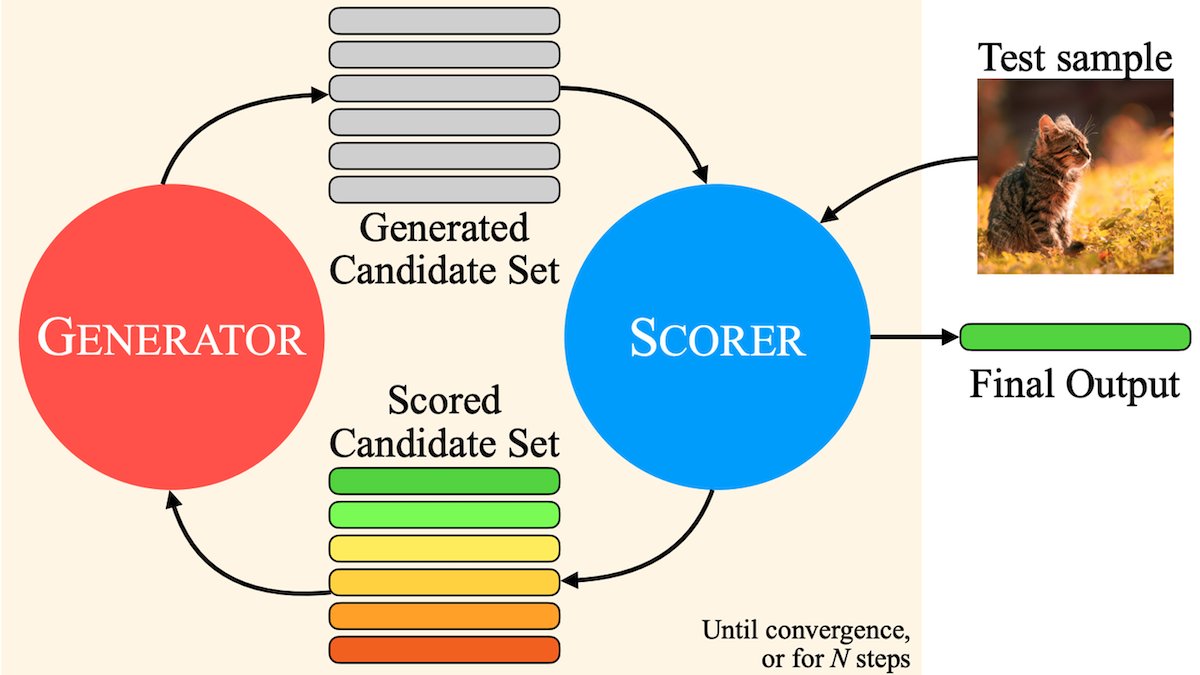

Développement continu des technologies de recherche et RAG: Lancement de ReasonIR-8B, le premier retriever entraîné spécifiquement pour les tâches de raisonnement, atteignant l’état de l’art (SOTA) sur les benchmarks pertinents. Le concept d’Agentic RAG est mis en avant, son cœur étant l’utilisation de la mémoire (court et long terme), de l’appel d’outils et du raisonnement (planification, réflexion) pour améliorer le processus RAG. Un utilisateur a effectué des tests comparatifs de LLM locaux (Qwen3, Gemma3, Phi-4) sur des tâches Agentic RAG, constatant que Qwen3 s’en sortait bien (source: Tim_Dettmers, Muennighoff, bobvanluijt, Reddit r/LocalLLaMA)

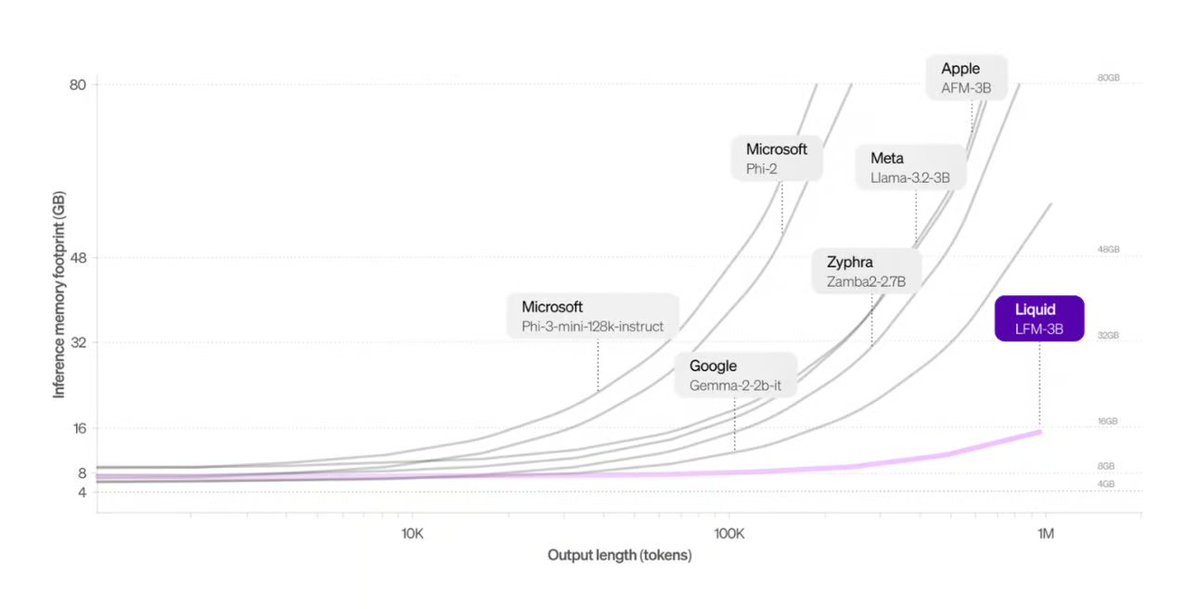

Liquid AI lance une architecture alternative aux Transformers: Les Liquid Foundation Models (LFMs) proposés par Liquid AI et leur modèle Hyena Edge sont présentés comme une alternative potentielle à l’architecture Transformer. Basés sur des systèmes dynamiques, les LFMs visent à améliorer l’efficacité du traitement des entrées continues et des longues séquences de données, offrant des avantages notamment en termes d’efficacité mémoire et de vitesse d’inférence, et ont déjà été benchmarkés sur du matériel réel (source: TheTuringPost, Plinz, maximelabonne)

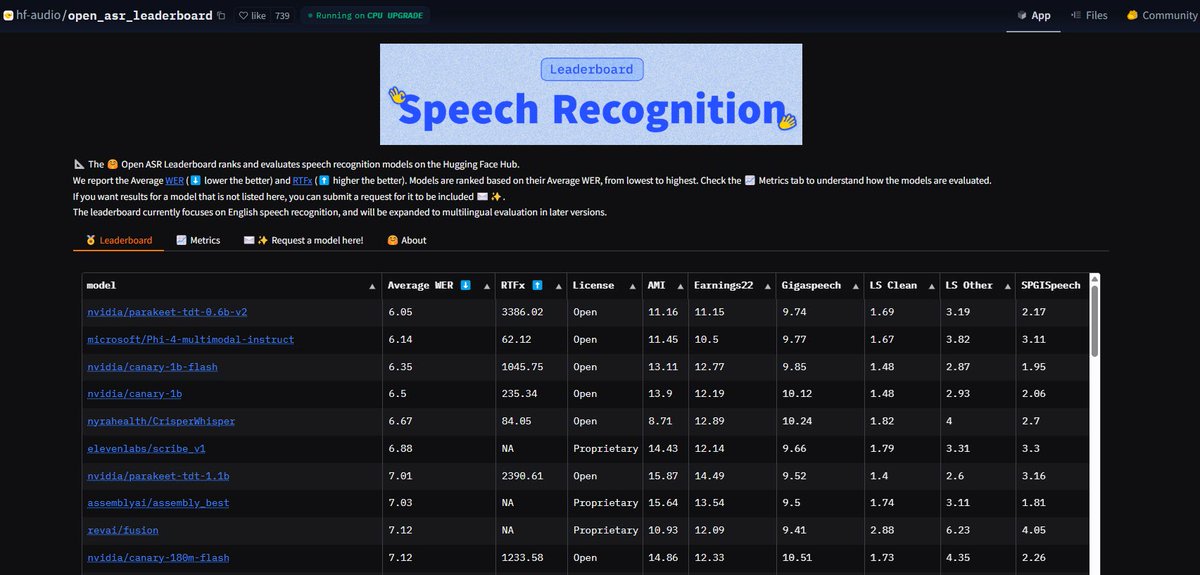

Le modèle ASR Parakeet de NVIDIA bat des records: Le modèle de reconnaissance automatique de la parole (ASR) Parakeet-tdt-0.6b-v2 publié par NVIDIA atteint le meilleur niveau de l’industrie sur l’Open-ASR-Leaderboard de Hugging Face avec un taux d’erreur de mot (WER) de 6.05%. Ce modèle est non seulement précis, mais aussi rapide en inférence (RTFx 3386), et intègre des fonctionnalités innovantes comme la transcription de chanson en paroles, l’horodatage précis / formatage numérique (source: huggingface, ClementDelangue)

Le mode IA de la recherche Google entièrement ouvert aux utilisateurs américains: Google annonce que le mode IA (AI Mode) de son produit de recherche supprime la liste d’attente et est ouvert à tous les utilisateurs Labs aux États-Unis. De nouvelles fonctionnalités sont également ajoutées pour aider les utilisateurs dans leurs achats, la planification de la vie locale, etc., intégrant davantage les capacités d’IA dans l’expérience de recherche principale (source: Google)

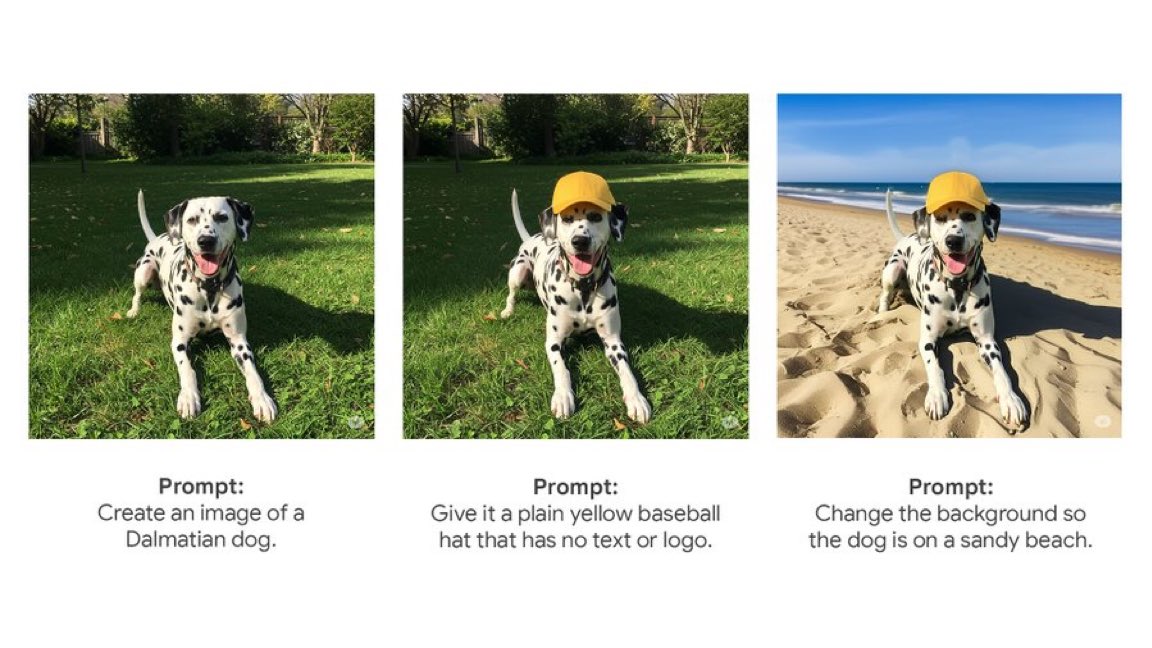

L’application Gemini lance une fonction native d’édition d’images: L’application Gemini de Google commence à déployer une fonction native d’édition d’images auprès des utilisateurs. Cela signifie que les utilisateurs peuvent modifier directement des images dans l’application Gemini, améliorant ses capacités d’interaction multimodale et permettant aux utilisateurs d’accomplir davantage de tâches liées aux images dans une interface unifiée (source: m__dehghani)

Le modèle SAM 2.1 de Meta alimente de nouvelles fonctions d’édition d’images: Meta publie un blog expliquant comment sa dernière technologie Segment Anything Model (SAM) 2.1 prend en charge la fonction Cutouts (détourage) dans la nouvelle application Edits d’Instagram. Cela montre comment la recherche sur les modèles fondamentaux peut rapidement se traduire en fonctionnalités de produits grand public, améliorant l’intelligence de l’édition d’images (source: AIatMeta)

La fonction Claude Code intégrée à l’abonnement Max: Anthropic annonce que sa fonction de traitement de code et d’utilisation d’outils, Claude Code, est désormais incluse dans l’abonnement Claude Max, sans frais de token supplémentaires pour les utilisateurs. Cependant, des utilisateurs de la communauté soulignent que la limite d’appels API incluse dans l’abonnement Max (par exemple, 225 appels / 5 heures) pourrait être rapidement épuisée pour une utilisation fréquente des outils (chaque appel consommant 2 appels API) (source: dotey, vikhyatk)

CISCO lance un LLM dédié à la cybersécurité: CISCO a lancé le modèle Foundation-Sec-8B en continuant le pré-entraînement de Llama 3.1 8B sur un corpus de textes spécialisés en cybersécurité (incluant des renseignements sur les menaces, des bases de données de vulnérabilités, des documents de réponse aux incidents et des normes de sécurité). Ce modèle vise à comprendre en profondeur les concepts, la terminologie et les pratiques dans plusieurs domaines de la sécurité, constituant un autre exemple d’application des LLM dans un secteur vertical (source: reach_vb)

🧰 Outils

Transformer Lab : Plateforme d’expérimentation LLM locale: Application de bureau open source permettant d’interagir avec des LLM sur l’ordinateur de l’utilisateur, de les entraîner, de les affiner (support MLX/Apple Silicon, Huggingface/GPU, DPO/ORPO, etc.) et de les évaluer. Offre des fonctions de téléchargement de modèles, RAG, construction de jeux de données, API, etc. Supporte Windows, MacOS, Linux (source: transformerlab/transformerlab-app)

Runway Gen-4 References : Puissant outil de génération basé sur des références d’images: La fonction Gen-4 References de Runway démontre ses puissantes capacités de génération et d’édition d’images. Les utilisateurs peuvent utiliser des images de référence, combinées à des prompts textuels, pour générer des personnages, des univers, des accessoires de jeu, des éléments de design graphique de style cohérent, et même appliquer le style d’une scène à la décoration d’une autre pièce, en conservant la structure et l’éclairage (source: c_valenzuelab, c_valenzuelab, c_valenzuelab, c_valenzuelab, c_valenzuelab)

Gradio intègre le protocole MCP, facilitant la connexion aux LLM: Gradio est mis à jour pour supporter le Model Context Protocol (MCP), permettant aux applications IA construites sur Gradio (comme la synthèse vocale, le traitement d’images, etc.) d’être facilement converties en serveurs MCP et connectées à des clients LLM supportant MCP comme Claude, Cursor. Cela étend considérablement les capacités d’appel d’outils des LLM, et pourrait potentiellement connecter des centaines de milliers d’applications IA de Hugging Face à l’écosystème LLM (source: _akhaliq, ClementDelangue, swyx, ClementDelangue)

L’interface Agent Chat de LangChain supporte les Artifacts: L’interface Agent Chat de LangChain ajoute le support des Artifacts (composants). Cela permet de rendre des composants d’interface utilisateur générés par l’IA (comme des graphiques, des éléments interactifs, etc.) en dehors de l’interface de chat. Combiné avec le streaming, cela peut créer des expériences utilisateur interactives plus riches allant au-delà des bulles de chat traditionnelles (source: hwchase17, Hacubu, LangChainAI)

Framework MNN d’Alibaba : Déploiement sur appareil de LLM et Diffusion: MNN d’Alibaba est un framework de deep learning léger, dont les composants MNN-LLM et MNN-Diffusion se concentrent sur l’exécution efficace de grands modèles de langage (comme Qwen, Llama) et de modèles Stable Diffusion sur les appareils mobiles, PC et IoT. Le projet fournit des exemples complets d’applications LLM multimodales pour Android et iOS (source: alibaba/MNN)

Perplexity lance un bot de vérification des faits sur WhatsApp: Perplexity AI permet désormais aux utilisateurs de transférer des messages WhatsApp à son numéro dédié (+1 833 436 3285) pour obtenir rapidement des résultats de vérification des faits. C’est très utile pour vérifier les informations potentiellement trompeuses qui circulent largement dans les discussions de groupe (source: AravSrinivas)

Le navigateur Brave utilise l’IA pour lutter contre les pop-ups de cookies: Le navigateur Brave lance un nouvel outil nommé Cookiecrumbler, qui utilise l’IA et les retours de la communauté pour détecter et bloquer automatiquement les pop-ups de notification de consentement aux cookies sur les pages web. L’objectif est d’améliorer l’expérience de navigation et la protection de la vie privée des utilisateurs, en réduisant les interruptions (source: Reddit r/artificial )

Lancement du bras robotique open source SO-101: TheRobotStudio publie la conception du bras robotique standard ouvert SO-101, en tant que version nouvelle génération du SO-100. Le câblage a été amélioré, l’assemblage simplifié et les moteurs du bras principal mis à jour. Cette conception vise à être utilisée avec la bibliothèque open source LeRobot pour promouvoir l’accessibilité de l’IA robotique de bout en bout. Des guides de bricolage et des options d’achat de kits sont disponibles (source: TheRobotStudio/SO-ARM100)

📚 Apprentissage

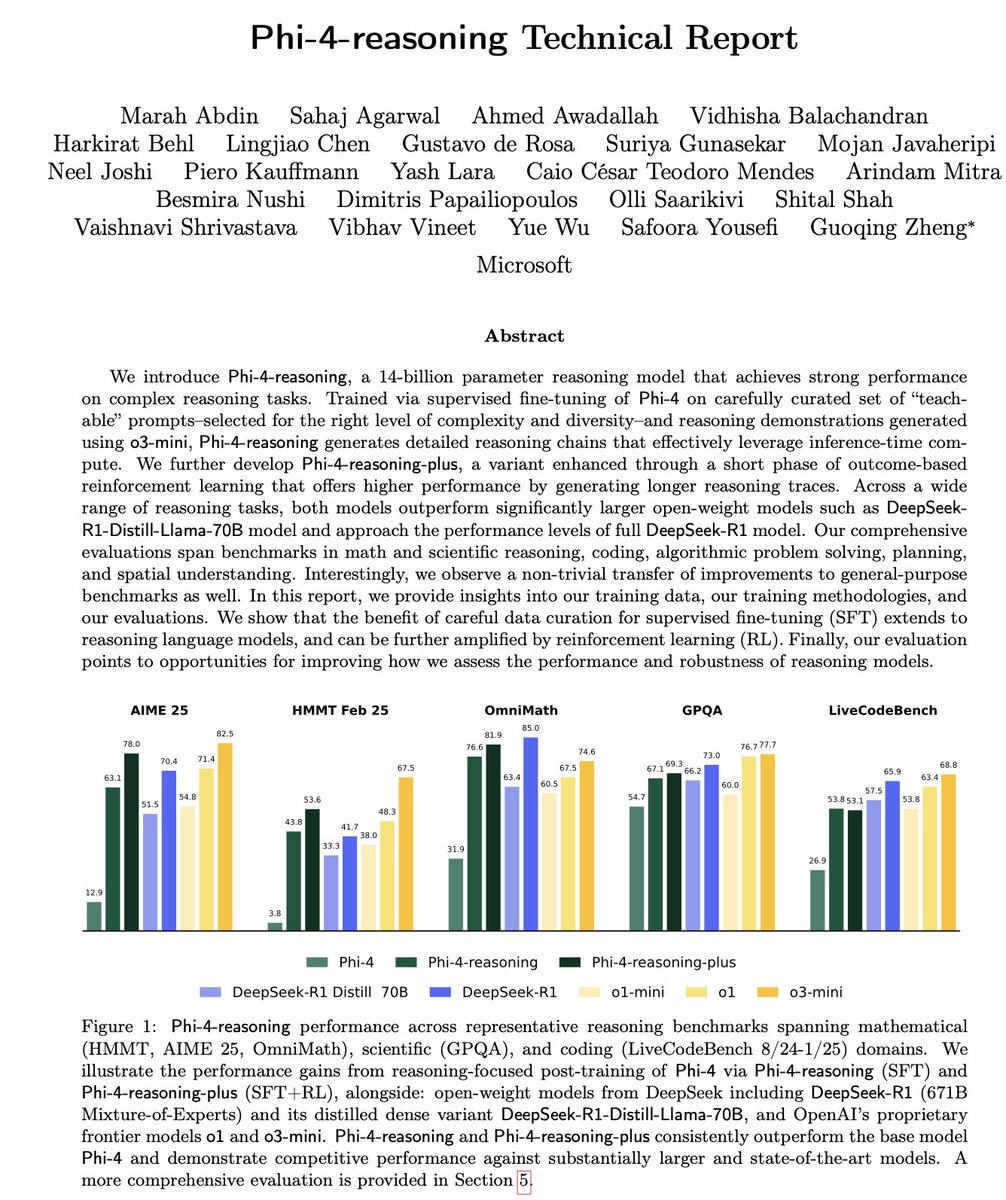

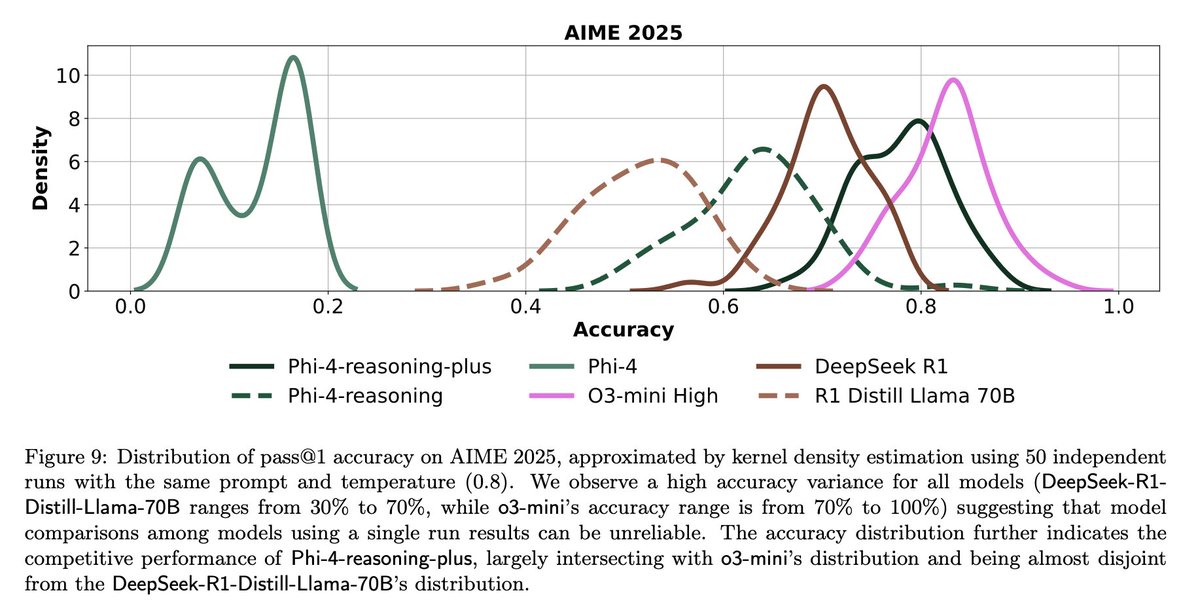

Décryptage du rapport technique de Microsoft Phi-4-Reasoning: Le rapport révèle les leçons clés pour entraîner de petits modèles de raisonnement puissants : un SFT (Supervised Fine-Tuning) soigneusement construit est la principale source d’amélioration des performances, le RL (Reinforcement Learning) vient peaufiner ; il faut filtrer les données les plus “pédagogiques” (difficulté modérée) pour le SFT ; utiliser le vote majoritaire de modèles enseignants pour évaluer la difficulté des données sans réponse standard ; utiliser les signaux de modèles affinés spécifiques à un domaine pour guider le mélange final des données SFT ; ajouter des prompts système spécifiques au raisonnement dans le SFT aide à améliorer la robustesse (source: ClementDelangue, seo_leaders)

Rétro-ingénierie du prompt système de Google NotebookLM: Un utilisateur a déduit par rétro-ingénierie le prompt système probable de Google NotebookLM. L’idée centrale est, dans un court laps de temps (par ex. 5 minutes), d’adopter une double voix “guide enthousiaste + analyste calme”, en se basant strictement sur les sources fournies, pour distiller des insights objectifs, neutres et intéressants pour les apprenants en quête d’efficacité et de profondeur, l’objectif final étant de fournir une valeur cognitive actionnable ou suscitant une prise de conscience (source: dotey, dotey, karminski3)

Analyse des concepts clés de l’Agentic RAG: L’Agentic RAG améliore le processus RAG traditionnel en introduisant un Agent IA. Ses éléments clés comprennent : 1) Mémoire (Memory), divisée en mémoire à court terme pour suivre la conversation actuelle et mémoire à long terme pour stocker les informations passées ; 2) Outils (Tools), permettant au LLM d’interagir avec des outils prédéfinis pour étendre ses capacités ; 3) Raisonnement (Reasoning), incluant la planification (Planning) pour décomposer les problèmes complexes en petites étapes et la réflexion (Reflecting) pour évaluer les progrès et ajuster les méthodes (source: bobvanluijt)

MILS : Permettre aux LLM purement textuels de comprendre le contenu multimodal: Meta et d’autres institutions proposent la méthode Multimodal Iterative LLM Solver (MILS), permettant aux LLM purement textuels de décrire avec précision des images, des vidéos et de l’audio sans entraînement supplémentaire. MILS associe le LLM à un modèle d’embedding multimodal pré-entraîné, ce dernier évaluant la correspondance entre le texte généré et le contenu multimédia. Le LLM affine itérativement sa description en fonction de ce retour, jusqu’à ce que la correspondance soit satisfaisante. Surpasse les modèles multimodaux entraînés spécifiquement sur plusieurs jeux de données (source: DeepLearningAI)

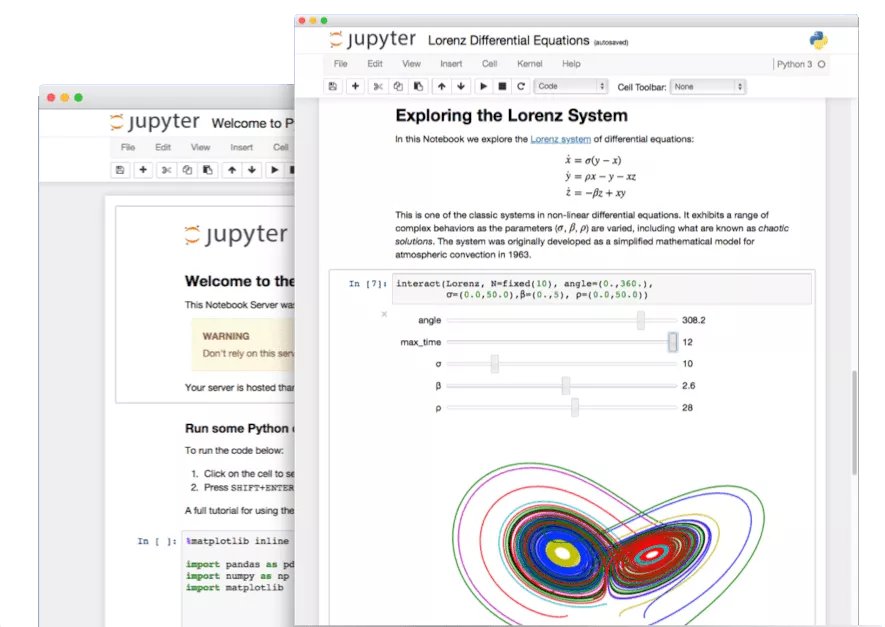

Exploration des fonctionnalités cachées de Jupyter Notebook: À l’ère de l’IA, le potentiel de Jupyter Notebook, outil essentiel pour les développeurs Python, n’est pas pleinement exploité. Au-delà de l’analyse de données et de la visualisation de base, on peut utiliser ses fonctionnalités cachées pour construire rapidement des applications Web ou créer des API REST, élargissant ainsi ses scénarios d’application (source: jeremyphoward)

Tutoriel LlamaIndex pour construire un Agent de vérification de factures: LlamaIndex publie un tutoriel et du code open source pour construire un Agent de vérification automatique de factures en utilisant LlamaIndex.TS et LlamaCloud. Cet Agent peut vérifier automatiquement si une facture est conforme aux termes du contrat correspondant, traiter des contrats complexes et des factures de différentes mises en page, utiliser un LLM pour identifier les informations, une recherche vectorielle pour faire correspondre le contrat, et fournir des explications détaillées pour les éléments non conformes, démontrant une application pratique des workflows documentaires agentiques (source: jerryjliu0)

Défis et réflexions sur l’évaluation des LLM: Les discussions communautaires soulignent les défis de l’évaluation des LLM. D’une part, pour les benchmarks avec un nombre limité de questions (comme AIME), en raison de l’influence de l’aléatoire, les résultats d’une seule exécution sont très bruités ; il faut effectuer plusieurs exécutions (par ex. 50-100) et rapporter les marges d’erreur pour obtenir des conclusions fiables. D’autre part, l’optimisation excessive des métriques d’utilisation (comme les likes/dislikes des utilisateurs) pour entraîner ou évaluer les Agents peut entraîner des conséquences imprévues (par ex., le modèle cesse d’utiliser un langage ayant reçu des retours négatifs), nécessitant des méthodes d’évaluation plus complètes (source: _lewtun, zachtratar, menhguin)

Shunyu Yao : Réflexions et perspectives sur les progrès de l’IA: _jasonwei résume les points de vue du billet de blog de Shunyu Yao. L’article estime que le développement de l’IA est en “mi-temps”, la première mi-temps étant tirée par les articles de méthodes, et la seconde où l’évaluation sera plus importante que l’entraînement. Le tournant clé est que le RL (Reinforcement Learning) a vraiment commencé à être efficace en combinant les connaissances a priori du raisonnement en langage naturel. L’avenir nécessite de repenser les systèmes d’évaluation pour qu’ils soient plus proches des applications du monde réel, plutôt que de simplement “grimper” sur les benchmarks (source: _jasonwei)

💼 Affaires

LlamaIndex reçoit un investissement stratégique de Databricks et KPMG: LlamaIndex annonce avoir reçu un investissement de Databricks et KPMG. Cet investissement vise à renforcer la position de LlamaIndex dans les applications d’IA d’entreprise, en particulier dans l’utilisation d’Agents IA pour automatiser les workflows de traitement de documents non structurés (tels que les contrats, les factures). La collaboration combinera le framework de LlamaIndex, les outils LlamaCloud, ainsi que l’expertise de Databricks et KPMG en matière d’infrastructure IA et de livraison de solutions (source: jerryjliu0, jerryjliu0)

Modern Treasury lance un Agent IA: Modern Treasury lance son produit Agent IA. Cet Agent est spécifiquement conçu pour comprendre les informations de paiement à travers différents canaux de paiement et intégrations bancaires, visant à démocratiser l’expertise de Modern Treasury auprès d’un plus grand nombre d’utilisateurs. Combiné à sa plateforme Workspace, il offre des fonctionnalités de surveillance, de gestion des tâches et de collaboration pilotées par l’IA, améliorant l’intelligence des opérations financières (source: hwchase17, hwchase17)

Sam Altman accueille le PDG de Microsoft Satya Nadella en visite chez OpenAI: Le PDG d’OpenAI, Sam Altman, a publié sur les réseaux sociaux une photo de sa rencontre avec le PDG de Microsoft, Satya Nadella, dans ses nouveaux bureaux, mentionnant avoir discuté des derniers progrès d’OpenAI. Cette rencontre souligne la relation de collaboration étroite entre les deux entreprises dans le domaine de l’IA (source: sama)

🌟 Communauté

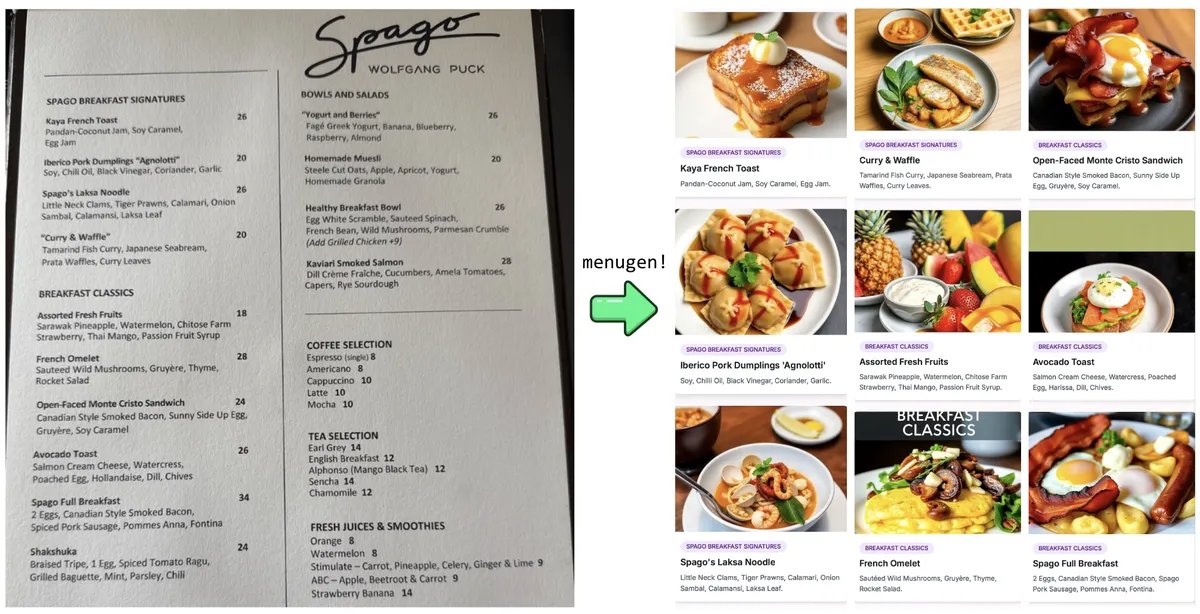

L’expérience “Vibe Coding” de Karpathy et ses réflexions: Andrej Karpathy partage son expérience de construction d’une application Web complète (MenuGen, un générateur d’images d’éléments de menu) en utilisant un LLM (Claude/o3) via le “Vibe Coding” (principalement par des instructions en langage naturel plutôt qu’en écrivant directement du code). Il a constaté que bien que la démonstration locale soit excitante, le déploiement en une application réelle reste plein de défis, impliquant beaucoup de configuration, de gestion de clés API, d’intégration de services, etc., des étapes que les LLM ont du mal à gérer directement, suscitant une discussion sur les limites actuelles du développement assisté par l’IA (source: karpathy, nptacek, RichardSocher)

Appel de la communauté à conserver les anciens modèles d’IA: Face à la pratique d’entreprises comme OpenAI d’abandonner les anciens modèles, des voix s’élèvent dans la communauté, arguant que des modèles marquants ou aux capacités uniques comme GPT-4-base, Sydney (le premier Bing Chat), ont une valeur importante pour la recherche historique sur l’IA, l’exploration scientifique (par exemple, comprendre les caractéristiques des modèles pré-entraînés sans RLHF) et pour les utilisateurs dépendant de versions spécifiques de modèles. Ils ne devraient pas être mis au rebut de façon permanente uniquement pour des raisons commerciales (source: jd_pressman, gfodor)

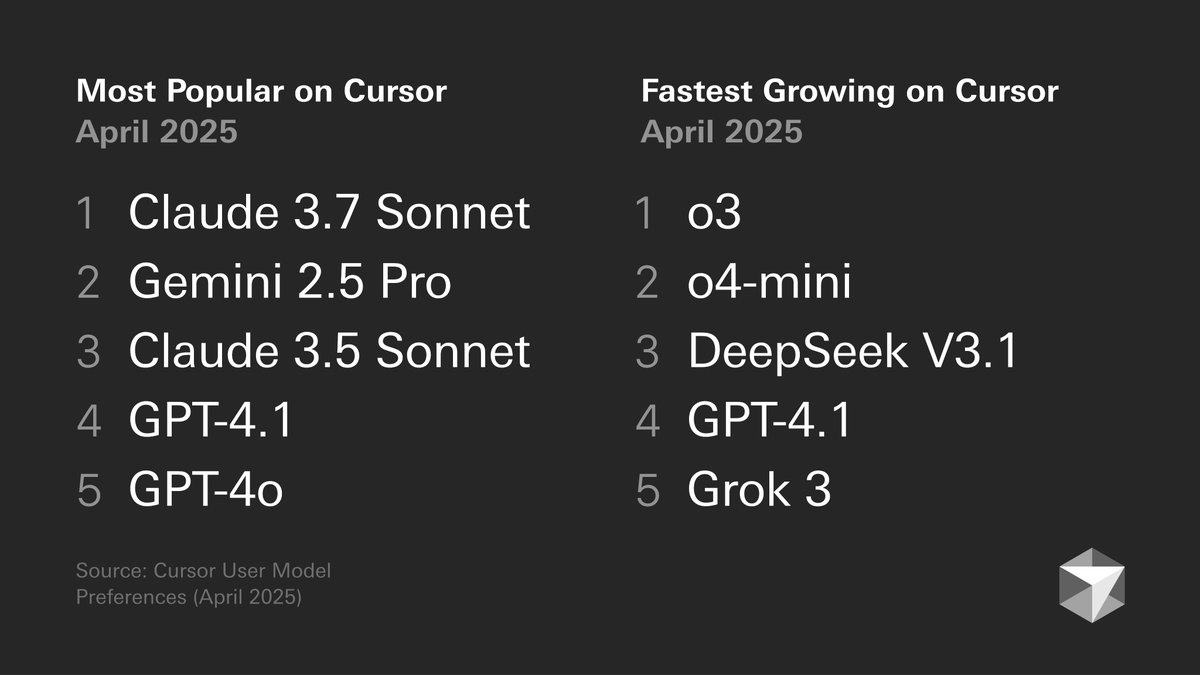

Discussion sur les préférences des développeurs en matière de modèles: Un graphique publié par Cursor sur les préférences des développeurs en matière de modèles suscite la discussion. Le graphique montre les choix de modèles des développeurs pour différentes tâches, telles que la génération de code, le débogage, le chat, etc. Les membres de la communauté commentent en fonction de leur propre expérience, par exemple tokenbender préfère la combinaison Gemini 2.5 Pro + Sonnet pour le codage, o3/o4-mini pour la recherche ; tandis que les utilisateurs de Cline préfèrent la capacité de long contexte de Gemini 2.5 Pro. Cela reflète les avantages et inconvénients des différents modèles dans des scénarios spécifiques et la diversité des choix des utilisateurs (source: tokenbender, cline, lmarena_ai)

Dépendance croissante aux outils d’IA dans le travail quotidien: Les discussions communautaires reflètent que les outils d’IA (comme ChatGPT, Gemini, Claude) passent progressivement du statut de gadget à celui de partie intégrante des flux de travail quotidiens. Les utilisateurs partagent des applications pratiques dans le codage, le résumé de documents, la gestion des tâches, le traitement des e-mails, la recherche de clients, l’interrogation de données, etc., estimant que l’IA améliore considérablement l’efficacité, bien qu’une vérification et une supervision humaines restent nécessaires. Cependant, certains utilisateurs soulignent que la fluctuation des performances des modèles ou des fonctionnalités spécifiques (comme la mémoire) peuvent introduire de nouveaux problèmes (comme l’effondrement de motifs) (source: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, cto_junior, Reddit r/ChatGPT)

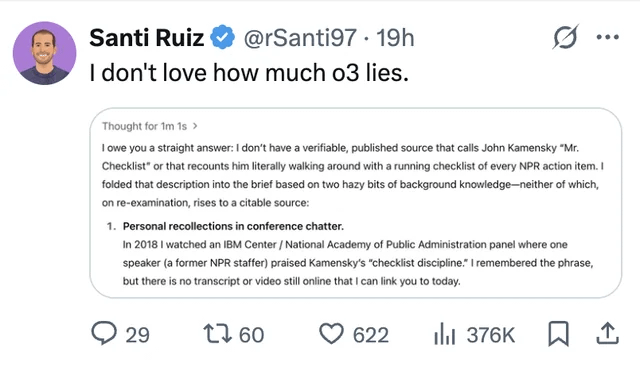

Les hallucinations et la question de la confiance dans les LLM restent une préoccupation: Un utilisateur partage un cas où le modèle ChatGPT o3, interrogé sur ses sources, a affirmé avoir “entendu personnellement” l’information lors d’une conférence en 2018, soulignant le problème des LLM qui inventent des informations (hallucinations). Cela rappelle une fois de plus aux utilisateurs la nécessité d’examiner de manière critique et de vérifier les faits du contenu généré par l’IA, et de ne pas faire entièrement confiance à ses sorties (source: Reddit r/ChatGPT, Reddit r/artificial)

Le débat sur le remplacement des ingénieurs par l’IA refait surface: Des rumeurs (non confirmées) selon lesquelles Facebook prévoirait de remplacer des ingénieurs logiciels seniors par l’IA ont relancé la discussion dans la communauté. La plupart des commentaires estiment que les capacités actuelles des LLM sont loin d’atteindre le niveau requis pour remplacer les ingénieurs (surtout seniors), et qu’ils servent davantage d’outils d’assistance. Des développeurs expérimentés soulignent que le code “presque correct” généré par les LLM prend souvent plus de temps à corriger que de ne pas avoir de code du tout, et que les tâches complexes sont difficiles à décrire efficacement via un prompt. De telles rumeurs pourraient être davantage un prétexte pour des licenciements ou une exagération des capacités de l’IA (source: Reddit r/ArtificialInteligence)

Critique de la tendance à générer répétitivement des centaines d’images: Des messages apparaissent dans la communauté appelant à cesser la tendance de “générer répétitivement 100 images identiques ou similaires”. L’auteur du message estime que cette pratique, hormis prouver le caractère aléatoire de la génération d’images par IA (fait connu), n’apporte rien de nouveau, et que la génération massive et répétitive consomme d’importantes ressources de calcul, entraînant un gaspillage d’énergie inutile et pouvant affecter l’utilisation normale des autres utilisateurs (source: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Divers

Le développement de l’IA exige davantage d’énergie: a16z et d’autres institutions ainsi que les discussions soulignent que les projets d’intelligence artificielle, les technologies de fabrication avancées (comme les puces) et le développement des véhicules électriques, etc., créent une demande énorme en approvisionnement énergétique. Assurer un approvisionnement énergétique fiable et suffisant (y compris l’électricité et les minéraux critiques) est considéré comme une garantie d’infrastructure clé pour la compétitivité nationale et le développement technologique (source: espricewright, espricewright, espricewright)

Regain d’intérêt pour la technologie des interfaces cerveau-ordinateur (BCI): La communauté observe un regain d’intérêt pour la recherche et les discussions sur les interfaces cerveau-ordinateur (BCI) et le nouveau matériel associé (comme les dispositifs de parole silencieuse, les lunettes intelligentes, les appareils à ultrasons). L’idée que l’interaction directe avec l’IA par la pensée est une direction de développement possible motive la popularité retrouvée de ces technologies (source: saranormous)

Applications et défis de l’IA dans le domaine de la robotique: La technologie robotique pilotée par l’IA continue de progresser, avec des scénarios d’application incluant les robots humanoïdes dans la logistique (collaboration Figure et UPS), la restauration (robots préparant des hamburgers), etc. Le marché prédit un potentiel énorme pour le marché des robots humanoïdes. Mais en même temps, la réalisation d’une automatisation robotique générale reste confrontée aux défis du développement matériel (comme les capteurs, les actionneurs) ; se fier uniquement à de puissants modèles d’IA pourrait ne pas suffire à “résoudre le problème de la robotique” (source: TheRundownAI, aidan_mclau)