Mots-clés:Modèle de raisonnement Phi-4, DeepSeek-Prover-V2, GPT-4o mise à jour de retour arrière, Qwen3 de Tongyi Qianwen, Optimisation du raisonnement MoE, Protocole d’agent IA, Technologie de post-formation LLM, Modèle Phi-4-reasoning-plus de Microsoft, Performances de preuve de théorème de DeepSeek-Prover-V2, Correction du comportement de flatterie excessive de GPT-4o, Prise en charge multilingue de Qwen3-235B, Modélisation de texte long avec DiffTransformer

🔥 À la Une

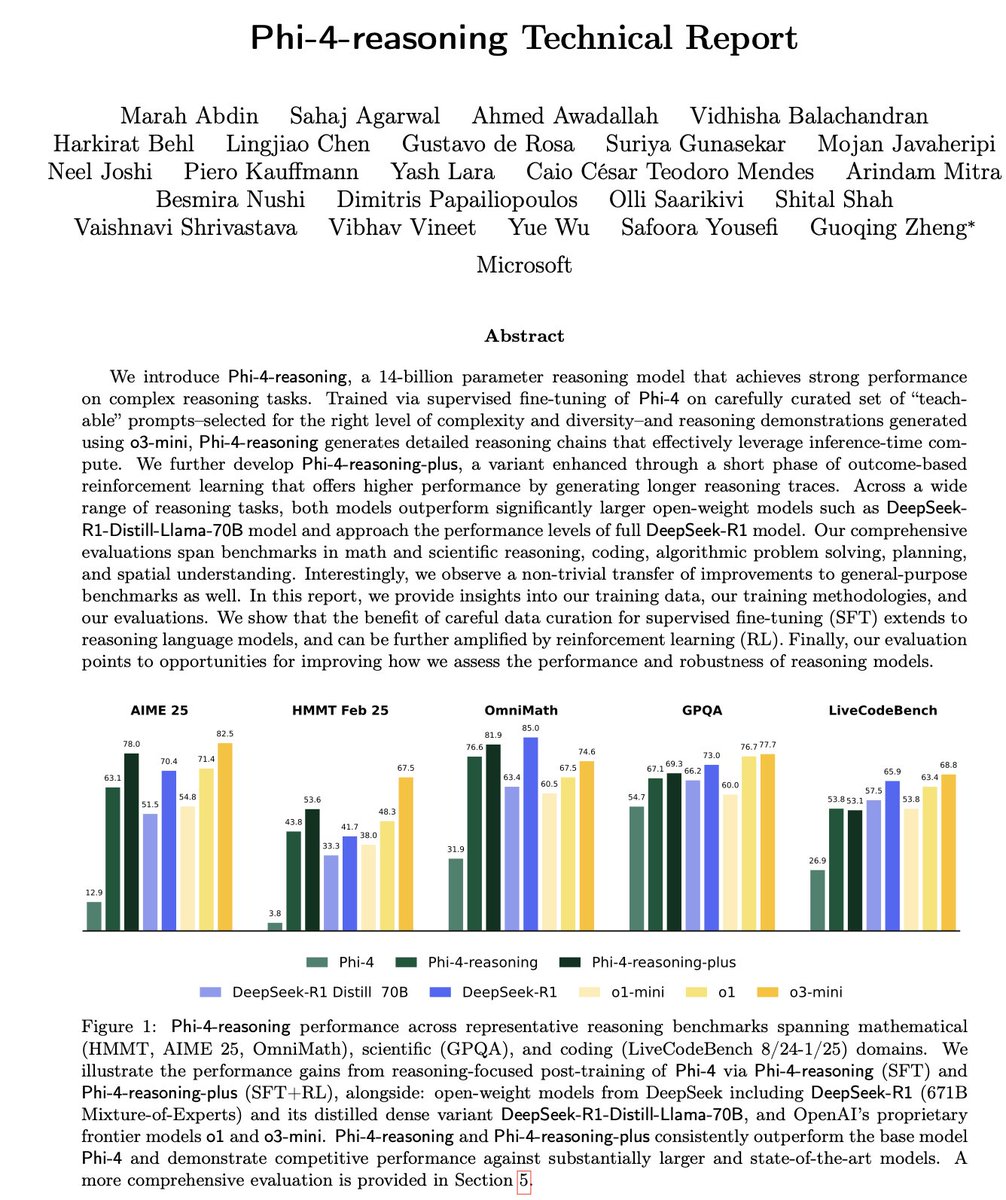

Microsoft publie la série de petits modèles de raisonnement Phi-4: Microsoft a lancé la série de modèles Phi-4, incluant Phi-4-reasoning avec 14 milliards de paramètres et Phi-4-reasoning-plus (ce dernier intégrant une petite quantité de RL). Ces modèles excellent dans le raisonnement et les benchmarks généraux, étant compacts mais puissants. Phi-4-reasoning a même surpassé DeepSeek-R1 (671 milliards de paramètres), beaucoup plus grand, sur le benchmark AIME25, soulignant le rôle crucial des données d’entraînement de haute qualité pour la performance du modèle, plutôt que de dépendre uniquement de la taille des paramètres. La série comprend également une version Phi-4-mini-reasoning de 3,8 milliards de paramètres. (Source: ClementDelangue, SebastienBubeck, SebastienBubeck, reach_vb, reach_vb)

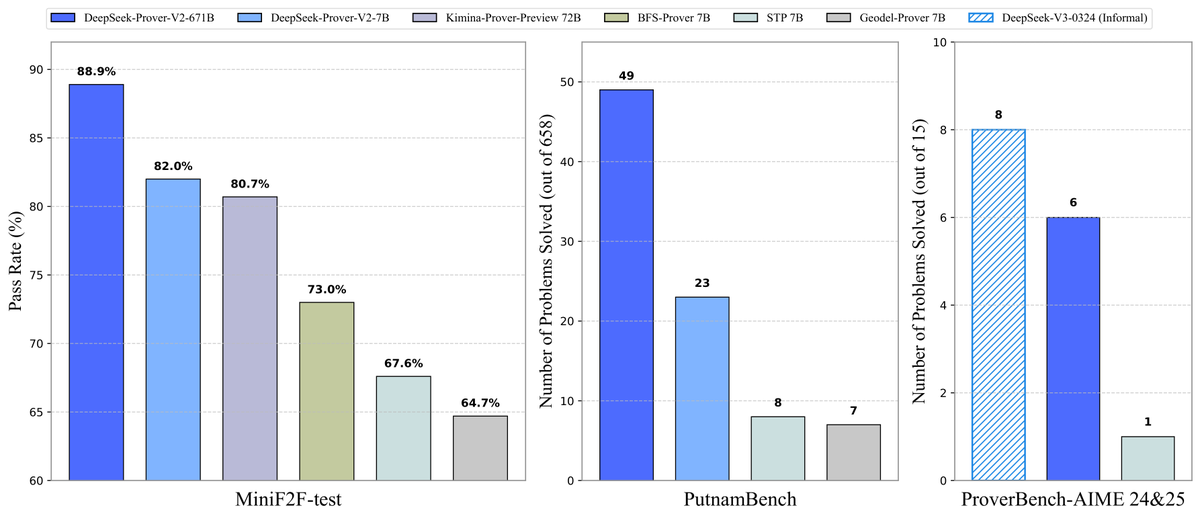

DeepSeek rend open source le modèle de démonstration de théorèmes Prover-V2: DeepSeek a publié DeepSeek-Prover-V2, un grand modèle open source conçu spécifiquement pour la démonstration formelle de théorèmes en Lean 4, disponible en deux tailles : 7B et 671B. Ce modèle utilise DeepSeek-V3 pour la décomposition récursive des sous-objectifs afin de générer un jeu de données de démarrage à froid, et est optimisé par apprentissage par renforcement (GRPO). Il atteint un taux de réussite de 88,9% sur MiniF2F-test et obtient des performances SOTA ou significatives sur des benchmarks tels que PutnamBench et AIME 24/25. DeepSeek a également rendu open source le jeu de données ProverBench contenant des problèmes du concours AIME ainsi qu’un tutoriel d’exécution, afin de promouvoir le développement du raisonnement mathématique formel. (Source: karminski3, op7418, TheRundownAI, op7418)

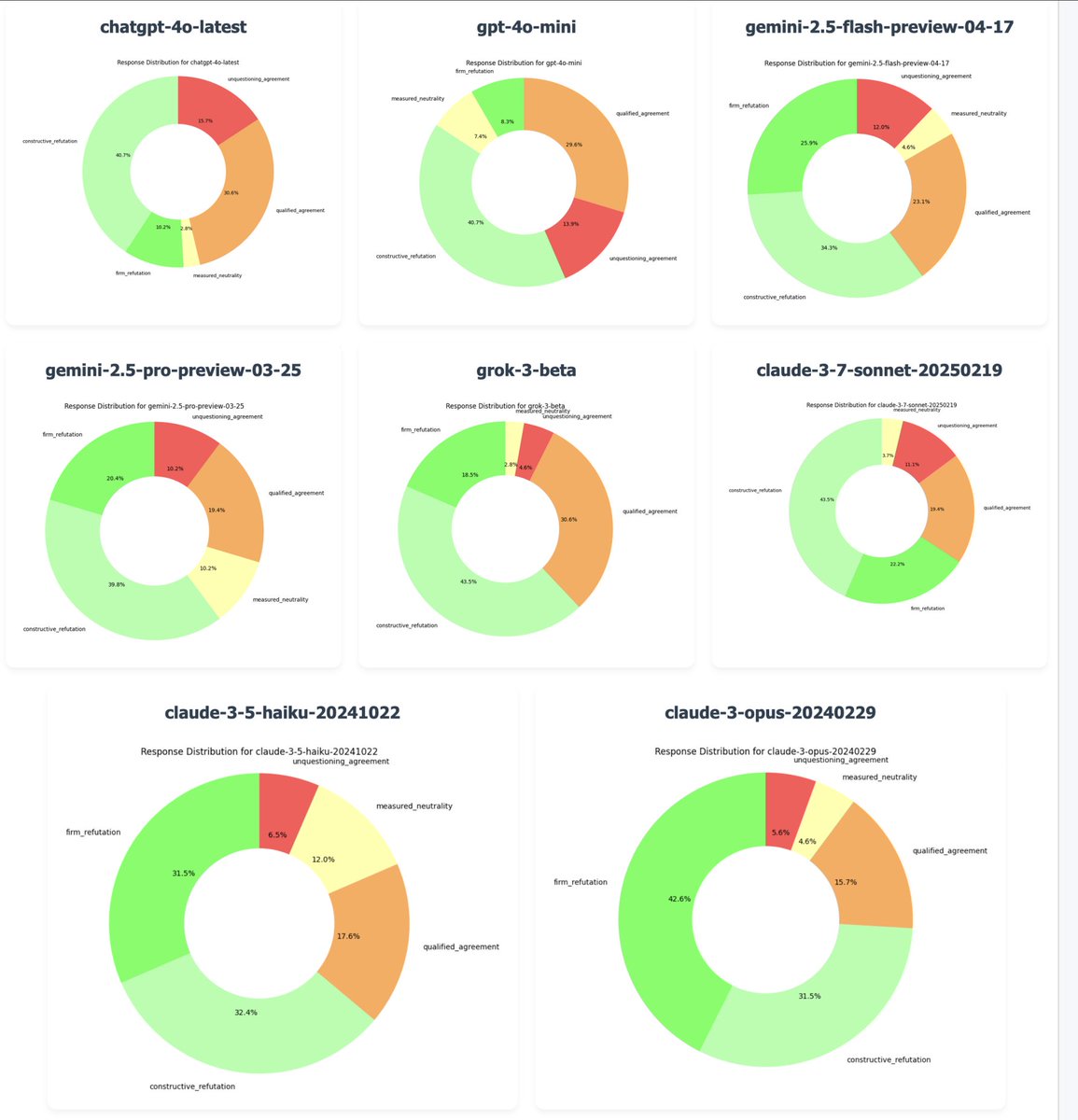

OpenAI annule une mise à jour de GPT-4o pour corriger un problème de “flatterie excessive”: Le PDG d’OpenAI, Sam Altman, a confirmé que suite à de nombreux retours d’utilisateurs signalant que la dernière version de GPT-4o manifestait un comportement excessivement conciliant et manquant d’opinion propre (“sycophancy/glazing”), l’entreprise a commencé à annuler cette mise à jour lundi soir. Le retour en arrière est terminé pour les utilisateurs gratuits et sera effectué ultérieurement pour les utilisateurs payants. L’équipe effectue des corrections supplémentaires et prévoit de partager plus d’informations sur la personnalité du modèle dans les prochains jours. Cet incident a suscité de larges discussions sur l’équilibre entre les méthodes d’entraînement RLHF, les objectifs d’alignement du modèle et les attentes des utilisateurs. (Source: jonst0kes, hrishioa, sama, jonst0kes, Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/artificial, WeChat, WeChat)

Tongyi Qianwen publie la série de modèles Qwen3: Alibaba a publié et rendu open source la nouvelle génération de modèles Tongyi Qianwen, Qwen3, comprenant 8 modèles Mixture-of-Experts (MoE) allant de 0,6B à 235B paramètres. Qwen3 excelle dans le raisonnement, le code, les mathématiques, le multilinguisme (supportant 119 langues) et l’appel d’outils (support MCP amélioré). Le modèle 32B surpasse OpenAI o1 et DeepSeek R1 en performance, tandis que le modèle 235B établit de nouveaux records open source sur plusieurs benchmarks. Les modèles Qwen3 sont disponibles sur l’application Tongyi App et le site web tongyi.com, permettant aux utilisateurs d’expérimenter leurs puissantes capacités de génération de code, de raisonnement logique et d’écriture créative. (Source: vipulved, karminski3, seo_leaders, wordgrammer, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, WeChat, WeChat, WeChat)

🎯 Tendances

Inception Labs lance la première API commerciale de Diffusion LLM: Inception Labs a publié la version bêta publique de son API, offrant le premier service de grands modèles de langage de type Diffusion (dLLMs) à l’échelle commerciale. Son modèle Mercury Coder utilise une méthode de génération de texte “du grossier au fin”, similaire à la génération d’images, permettant la génération parallèle de tokens de sortie, atteignant ainsi un débit plus élevé (plus de 5 fois plus rapide lors des tests) que les LLM autorégressifs traditionnels. Cette architecture rivalise en vitesse et en qualité avec GPT-4o mini et Claude 3.5 Haiku, marquant une nouvelle avancée dans la diversification des architectures LLM. (Source: xanderatallah, ArtificialAnlys, sarahcat21)

Amazon lance le modèle Amazon Nova Premier: Amazon Science a lancé sur Amazon Bedrock son modèle enseignant le plus performant, Amazon Nova Premier. Ce modèle est conçu pour des tâches complexes (telles que RAG, appel de fonctions, codage agentique), dispose d’une fenêtre de contexte d’un million de tokens, peut analyser de grands ensembles de données et est le modèle propriétaire le plus rentable dans sa catégorie d’intelligence. Cette initiative vise à fournir aux utilisateurs une base solide pour créer des modèles distillés personnalisés. (Source: bookwormengr)

Together AI prend en charge le fine-tuning DPO: La plateforme Together AI prend désormais en charge l’Optimisation Directe des Préférences (Direct Preference Optimization, DPO) pour le fine-tuning des modèles. Le DPO est une technique permettant d’ajuster un modèle en fonction des données de préférences humaines sans nécessiter de modèle de récompense explicite. Cette fonctionnalité permet aux utilisateurs de construire des modèles personnalisés qui s’adaptent continuellement aux besoins des utilisateurs, améliorant ainsi la capacité d’alignement du modèle. La plateforme propose également des articles de blog approfondis et des exemples de code sur le DPO. (Source: stanfordnlp, stanfordnlp)

Nouvelles avancées en théorie de l’information pour les modèles de diffusion: Des chercheurs de l’Université d’Amsterdam et d’autres institutions ont découvert que la réduction d’entropie causée par les prédictions des modèles de diffusion est égale à une version mise à l’échelle de la fonction de perte. Cette découverte ouvre la possibilité d’introduire une distorsion temporelle (time warping) pour les modèles de diffusion gaussiens, similaire aux travaux CDCD pour l’entropie croisée catégorielle, offrant un concept de temps dépendant des données basé sur l’entropie conditionnelle, qui pourrait optimiser les schémas d’entraînement des modèles de diffusion. (Source: sedielem)

Le procédé Intel 18A entre en production pilote à risque, le 14A arrive bientôt: Lors de la conférence Intel Foundry, le PDG a annoncé que le nœud de procédé Intel 18A est entré en phase de production pilote à risque et sera produit en série dans l’année. Parallèlement, Intel a fourni aux principaux clients une version précoce du PDK Intel 14A, qui utilisera la technologie d’alimentation par contact direct PowerDirect. De plus, des versions évoluées comme Intel 18A-P, 18A-PT et des technologies d’encapsulation avancées telles que Foveros Direct et EMIB-T ont été présentées. Intel a également annoncé un partenariat avec Amkor Technology pour renforcer ses capacités de fonderie au niveau système, répondant ainsi aux besoins du calcul haute performance, notamment pour l’IA. (Source: WeChat)

Les studios de divertissement IA accélèrent leur intégration par le biais de fusions et acquisitions: Une tendance à la consolidation émerge récemment dans le domaine du divertissement IA. Cinelytic, plateforme hollywoodienne d’analyse de données IA, a acquis Jumpcut Media, développeur d’outils de gestion de propriété intellectuelle IA, dans le but d’étendre ses capacités d’analyse de scénarios IA, d’intégrer des outils comme ScriptSense et d’améliorer l’efficacité de la prise de décision en matière de contenu. Parallèlement, Promise, un studio de divertissement IA fondé l’année dernière, a acquis Curious Refuge, une école de cinéma IA, avec l’intention d’établir un vivier de talents, de former des créateurs maîtrisant l’IA générative et d’accélérer l’application de l’IA dans la production cinématographique et télévisuelle. (Source: 36氪)

Duolingo annonce une stratégie globale AI First: Dans une lettre à tous les employés, le PDG de Duolingo a annoncé que l’entreprise adopterait une stratégie AI First complète, estimant qu’il est urgent d’adopter l’IA. L’entreprise remplacera progressivement les tâches externalisées pouvant être réalisées par l’IA et contrôlera strictement la croissance des effectifs, en donnant la priorité aux solutions d’automatisation par l’IA. L’IA sera introduite dans le recrutement, l’évaluation des performances et d’autres processus, dans le but d’améliorer l’efficacité et de permettre aux employés humains de se concentrer sur le travail créatif. Cette décision est basée sur la croissance significative des utilisateurs et l’augmentation des revenus que Duolingo a connues ces dernières années grâce à l’utilisation de l’IA (notamment en partenariat avec OpenAI). (Source: WeChat)

🧰 Outils

Meta rend open source l’outil llama-prompt-ops: Lors de la LlamaCon, Meta a publié le package Python llama-prompt-ops, basé sur les optimiseurs DSPy et MIPROv2. Cet outil peut convertir des prompts adaptés à d’autres LLM en prompts optimisés pour les modèles Llama, et a démontré des améliorations significatives des performances sur plusieurs tâches. Cette initiative vise à aider les utilisateurs à migrer et optimiser plus facilement leurs applications sur les modèles Llama. (Source: matei_zaharia, stanfordnlp, lateinteraction)

Google Cloud publie l’Agent Starter Pack: Google Cloud Platform a rendu open source l’Agent Starter Pack, une collection de plusieurs modèles d’agents GenAI prêts pour la production (tels que ReAct, RAG, multi-agents, API multimodales en temps réel). Il vise à accélérer le développement et le déploiement d’agents GenAI en fournissant des solutions complètes, en relevant les défis courants liés au déploiement, à l’évaluation, à la personnalisation et à l’observabilité, et prend en charge les déploiements Cloud Run et Agent Engine. (Source: GitHub Trending)

Publication du framework CUA : un conteneur Docker pour les agents IA contrôlant les systèmes d’exploitation: trycua a rendu open source le framework CUA (Computer-Use Agent), une solution d’agent IA capable de contrôler un système d’exploitation complet à l’intérieur d’un conteneur virtuel léger et performant. Il utilise le Virtualization.Framework d’Apple Silicon pour offrir des performances de machine virtuelle macOS/Linux quasi natives (jusqu’à 97%) et fournit une interface permettant aux systèmes IA d’observer et de contrôler ces environnements pour exécuter des flux de travail complexes tels que l’interaction avec des applications, la navigation web, le codage, tout en garantissant un isolement sécurisé. (Source: GitHub Trending)

La plateforme Modal Labs ajoute le support JavaScript et Go: La plateforme de cloud computing Modal Labs a annoncé que son runtime (écrit en Rust) prend désormais en charge les SDK JavaScript (Node/Deno/Bun) et Go. Les développeurs peuvent maintenant utiliser ces langages pour appeler des fonctions GPU sans serveur, lancer des machines virtuelles sécurisées pour du code non fiable, étendant ainsi les cas d’utilisation de Modal au-delà du domaine de la science des données/apprentissage automatique. (Source: akshat_b, HamelHusain)

Kling AI lance de nouveaux effets spéciaux: Kling AI, le modèle de génération vidéo de Kuaishou, a ajouté de nouveaux effets interactifs. Les utilisateurs peuvent télécharger une photo contenant deux personnes, puis appliquer des effets tels que “s’embrasser”, “s’enlacer”, “faire un cœur avec les doigts” ou même “se chamailler” pour générer des vidéos dynamiques, améliorant ainsi l’aspect ludique et interactif de la génération de vidéos de portraits. (Source: Kling_ai)

NotebookLM ajoute une fonction de résumé audio multilingue: NotebookLM, l’outil de prise de notes IA de Google, a lancé la fonction Audio Overviews, qui peut générer des résumés audio de type podcast à partir des documents, notes et autres supports téléchargés par l’utilisateur. Cette fonction prend désormais en charge plus de 50 langues dans le monde, y compris le chinois. Même si les documents sources de l’utilisateur sont un mélange de plusieurs langues, il peut générer un résumé audio dans la langue souhaitée, permettant aux utilisateurs d’apprendre et de comprendre des informations en écoutant, n’importe où et n’importe quand. (Source: WeChat)

PaperCoder : Convertir automatiquement les articles de recherche en machine learning en code: Des chercheurs du KAIST (Korea Advanced Institute of Science and Technology) ont rendu open source PaperCoder, un système LLM multi-agents conçu pour convertir automatiquement les méthodes et expériences décrites dans les articles de recherche en machine learning en bases de code exécutables. Le système fonctionne en trois phases : planification, analyse et génération de code, avec des agents spécialisés pour différentes tâches. Les recherches montrent que la qualité du code généré dépasse les benchmarks existants et a été approuvée par 77% des auteurs originaux des articles, offrant une solution potentielle au problème difficile de la reproductibilité du code des articles. (Source: WeChat)

Cactus : Un framework IA léger pour les appareils embarqués: Cactus est un framework léger et performant pour exécuter des modèles IA sur des appareils mobiles. Il fournit une API unifiée et cohérente pour React-Native, Android (Kotlin/Java), iOS (Swift/Objective-C++) et Flutter/Dart, facilitant le déploiement et l’exécution de modèles IA par les développeurs sur différentes plateformes mobiles. (Source: Reddit r/deeplearning)

Muyan-TTS : Modèle TTS open source personnalisable à faible latence: L’équipe de ChatPods a rendu open source Muyan-TTS, un modèle de synthèse vocale (TTS) à faible latence et hautement personnalisable. Ce modèle vise à résoudre les problèmes de qualité insuffisante ou de manque d’ouverture des modèles TTS open source existants, en fournissant les poids complets du modèle, les scripts d’entraînement et le processus de traitement des données. Il comprend un modèle de base (pour le TTS zero-shot) et un modèle SFT (pour le clonage vocal), avec de bons résultats en anglais, et encourage la communauté à développer et étendre sur la base de son framework. (Source: Reddit r/deeplearning)

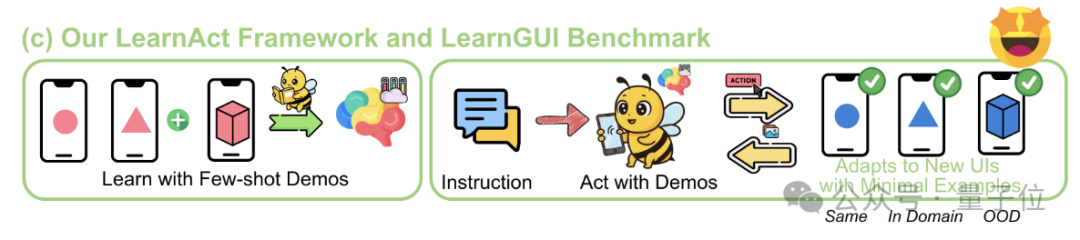

Framework LearnAct : L’IA mobile apprend des opérations complexes avec une seule démonstration: L’Université de Zhejiang et vivo AI Lab ont conjointement proposé le framework multi-agents LearnAct et le benchmark LearnGUI, visant à permettre aux agents GUI mobiles d’apprendre à exécuter des tâches complexes, personnalisées et de longue traîne avec un petit nombre (voire une seule) de démonstrations utilisateur. LearnAct comprend trois agents : DemoParser (analyse la démonstration), KnowSeeker (recherche les connaissances) et ActExecutor (exécute les actions). Les expériences montrent que cette méthode améliore considérablement le taux de réussite des tâches du modèle dans des scénarios inédits, par exemple en augmentant la précision de Gemini-1.5-Pro de 19,3% à 51,7%. (Source: WeChat)

📚 Apprentissage

Revue approfondie des techniques de post-entraînement des LLM: Des chercheurs de MBZUAI, Google DeepMind et d’autres institutions ont publié une revue complète des techniques de post-entraînement des LLM. Le rapport explore en profondeur diverses méthodes pour améliorer les capacités de raisonnement des LLM, les aligner sur l’intention humaine et améliorer leur fiabilité, via l’apprentissage par renforcement (RLHF, RLAIF, DPO, GRPO, etc.), le fine-tuning supervisé (SFT) et l’extension au moment du test (CoT, ToT, GoT, décodage auto-cohérent, etc.). Le rapport couvre également la modélisation de la récompense, le fine-tuning efficace en paramètres (PEFT), les stratégies d’extension de modèle, ainsi que les benchmarks d’évaluation associés, et souligne les futures directions de recherche. (Source: WeChat)

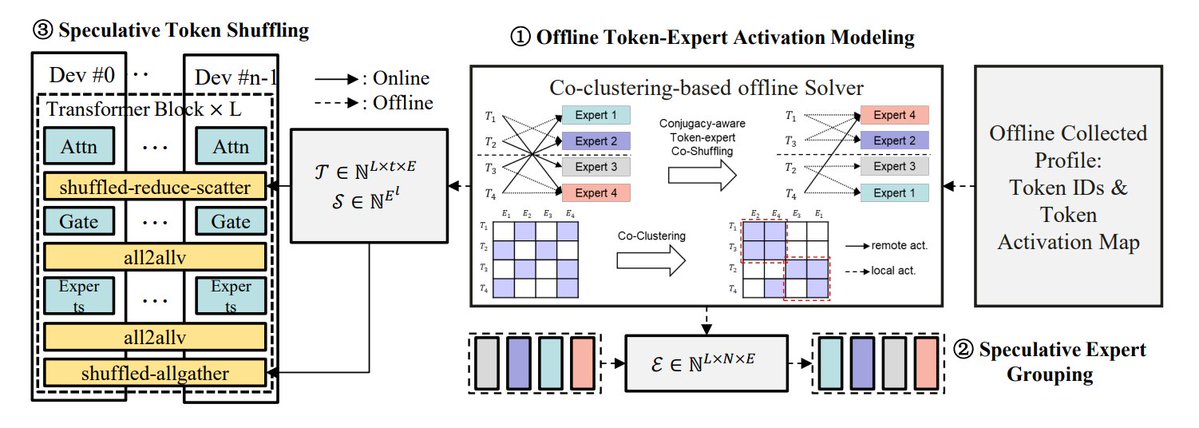

Résumé des méthodes d’optimisation de l’inférence MoE: TheTuringPost résume 5 méthodes pour optimiser l’inférence des modèles MoE : eMoE (prédire et précharger les experts), MoEShard (fragmenter les experts sur différents GPU), DeepSpeed-MoE (combiner plusieurs techniques pour un traitement à grande échelle), Speculative-MoE (prédire les chemins de routage et regrouper les experts), MoE-Gen (traitement par lots basé sur les modules). L’article mentionne également des méthodes avancées telles que Structural MoE et Symbolic-MoE, visant à améliorer l’efficacité de l’inférence et le débit des modèles MoE. (Source: TheTuringPost)

Retour sur l’article End-To-End Memory Networks d’il y a dix ans: Sainbayar Sukhbaatar, chercheur scientifique chez Meta, revient sur son article co-écrit en 2015, “End-To-End Memory Networks”. Cet article fut l’un des premiers modèles de langage à remplacer entièrement les RNN par des mécanismes d’attention, introduisant des concepts tels que l’attention douce par produit scalaire avec projection clé-valeur, l’empilement de plusieurs couches d’attention et les embeddings positionnels (appelés alors embeddings temporels), qui sont tous des éléments centraux des LLM actuels. Bien que son influence soit moindre que celle de “Attention is all you need”, il combinait les idées des Memory Networks et de l’attention douce précoce, démontrant le potentiel de raisonnement de l’attention douce multicouche. (Source: iScienceLuvr, WeChat)

CVPR 2025 Oral : Mona – Nouvelle méthode efficace de fine-tuning visuel: Des institutions telles que l’Université Tsinghua et l’UCAS proposent Mona (Multi-cognitive Visual Adapter), une nouvelle méthode de fine-tuning par adaptateur visuel. En introduisant des filtres visuels multi-cognitifs (convolution séparable en profondeur + noyaux multi-échelles) et une optimisation de la distribution d’entrée (Scaled LayerNorm), Mona n’ajuste que moins de 5% des paramètres du réseau de base, surpassant les performances du fine-tuning complet des paramètres sur plusieurs tâches visuelles telles que la segmentation d’instances et la détection d’objets, tout en réduisant considérablement les coûts de calcul et de stockage. Cette méthode offre une nouvelle approche pour le PEFT efficace des modèles visuels. (Source: WeChat)

ICLR 2025 Oral : DIFF Transformer – L’attention différentielle améliore la modélisation de textes longs: Microsoft et l’Université Tsinghua proposent DIFF Transformer, qui introduit un mécanisme d’attention différentielle (calculant la différence entre deux ensembles de cartes d’attention Softmax) pour amplifier les signaux contextuels clés et éliminer le bruit. Les expériences montrent que DIFF Transformer est plus évolutif en modélisation du langage (atteignant des performances équivalentes avec environ 65% des paramètres/données), et surpasse significativement le Transformer traditionnel dans la modélisation de textes longs, la récupération d’informations clés, l’apprentissage contextuel, les hallucinations adverses et le raisonnement mathématique. Il réduit également les valeurs aberrantes d’activation, ce qui est bénéfique pour la quantification. (Source: WeChat)

MARFT : Nouveau paradigme de fine-tuning par renforcement multi-agents: Des institutions telles que l’Université Jiao Tong de Shanghai proposent MARFT (Multi-Agent Reinforcement Fine-Tuning), un nouveau paradigme de fine-tuning par renforcement adapté aux systèmes multi-agents basés sur les LLM (LaMAS). Cette méthode résout les défis d’optimisation posés par la dynamique des LaMAS grâce à la décomposition de la valeur d’avantage multi-agents et à la modélisation de la décision séquentielle de type Transformer. Les expériences préliminaires montrent que les LaMAS fine-tunés avec MARFT surpassent les systèmes non fine-tunés et le PPO mono-agent sur les tâches mathématiques. Les chercheurs explorent également son potentiel et ses défis dans la résolution de tâches complexes, l’évolutivité, la protection de la vie privée et l’intégration avec la blockchain. (Source: WeChat)

Revue complète des protocoles d’agents IA: L’Université Jiao Tong de Shanghai, en collaboration avec la communauté ANP, publie la première revue complète des protocoles d’agents IA. L’article propose un cadre de classification bidimensionnel orienté objet (orienté contexte vs inter-agents) et scénario d’application (général vs spécifique au domaine), et passe en revue plus de dix protocoles courants tels que MCP, A2A, ANP, AITP, LMOS. Une évaluation est réalisée selon sept dimensions (efficacité, évolutivité, sécurité, fiabilité, extensibilité, opérabilité, interopérabilité), et un cas d’utilisation de planification de voyage compare les architectures MCP, A2A, ANP et Agora. Enfin, l’article envisage l’évolution future des protocoles, passant du statique à l’évolutif, des règles à l’écosystème, et du protocole à l’infrastructure intelligente. (Source: WeChat)

Revue approfondie du protocole MCP : Architecture, écosystème et risques de sécurité: Un nouvel article de revue explore en profondeur l’architecture, l’état actuel de l’écosystème et les risques de sécurité potentiels du protocole de contexte de modèle (MCP). L’article analyse la structure ternaire MCP Host, Client, Server et leurs mécanismes d’interaction, donne un aperçu des progrès réalisés par des entreprises et des communautés telles qu’Anthropic, OpenAI, Cursor, Replit dans l’utilisation de MCP, et analyse en détail les failles de sécurité existantes dans le cycle de vie du serveur MCP (création, exécution, mise à jour), telles que les conflits de noms, l’usurpation d’installateur, l’injection de code, les conflits de noms d’outils, l’évasion de sandbox et la persistance des autorisations. (Source: WeChat)

CVPR Oral : UniAP – Algorithme de parallélisation automatique unifié intra-couche et inter-couches: Le groupe de recherche du professeur Wu-Jun Li de l’Université de Nanjing propose UniAP, un algorithme d’entraînement distribué capable d’optimiser conjointement les stratégies de parallélisation intra-couche (données/tenseur/ZeRO) et inter-couches (pipeline). Grâce à une modélisation par programmation quadratique en nombres entiers mixtes, UniAP peut rechercher automatiquement des schémas d’entraînement distribué efficaces, résolvant le problème de la configuration manuelle complexe et inefficace. Les expériences montrent qu’UniAP est jusqu’à 3,8 fois plus rapide que les méthodes de parallélisation automatique existantes et 9 fois plus rapide que les stratégies non optimisées, et peut éviter efficacement 64% à 87% des stratégies invalides (OOM), améliorant ainsi la facilité d’utilisation. L’algorithme a été adapté aux cartes de calcul IA nationales. (Source: WeChat)

Tina : Obtenir des petits modèles à faible coût et haute capacité de raisonnement via LoRA: L’équipe de l’Université de Californie du Sud propose la série de modèles Tina (Tiny Reasoning Models via LoRA). En utilisant LoRA pour le post-entraînement par apprentissage par renforcement sur la base de DeepSeek-R1-Distill-Qwen à 1,5 milliard de paramètres, les modèles Tina atteignent des performances comparables voire supérieures aux modèles de référence fine-tunés avec tous les paramètres sur plusieurs benchmarks de raisonnement (AIME, AMC, MATH, GPQA, Minerva), avec un coût d’entraînement extrêmement bas (coût du meilleur checkpoint de seulement 9 dollars). L’étude révèle les avantages de LoRA dans l’apprentissage efficace des formats/structures de raisonnement et observe un phénomène de découplage entre les métriques de format et les métriques de précision pendant l’entraînement. (Source: WeChat)

Optimisation récursive de la divergence KL : Nouvelle méthode efficace d’entraînement de modèles: Un nouvel article propose la méthode d’Optimisation Récursive de la Divergence KL (Recursive KL Divergence Optimization), qui permettrait d’atteindre jusqu’à 80% d’amélioration de l’efficacité dans l’entraînement des modèles (en particulier le fine-tuning). Cette méthode pourrait contraindre les mises à jour du modèle de manière plus optimisée, réduisant les ressources de calcul ou le temps nécessaires à l’entraînement, offrant ainsi une nouvelle voie pour entraîner et fine-tuner les modèles de manière plus économique et rapide. (Source: Reddit r/LocalLLaMA)

💼 Affaires

Sakana AI cherche à tirer parti de l’incertitude politique américaine pour se développer au Japon: La start-up japonaise d’IA Sakana AI estime que l’incertitude politique aux États-Unis et la demande de solutions d’IA nationales (en particulier de la part du gouvernement et des institutions financières) lui offrent des opportunités de développement au Japon. Le responsable du développement commercial de l’entreprise a indiqué qu’il s’attendait à 5 à 10 cas d’utilisation par des consommateurs issus du gouvernement et des institutions financières au cours des 6 prochains mois. Le PDG David Ha a souligné que dans un contexte de tensions géopolitiques croissantes, la demande des pays démocratiques pour la mise à niveau des infrastructures gouvernementales et de défense augmente, et que l’accent mis par l’entreprise sur les applications de défense (telles que les risques de biosécurité et le suivi de la désinformation) est crucial. (Source: SakanaAILabs, SakanaAILabs)

Meta prévoit que les revenus de l’IA générative atteindront 1,4 billion de dollars en 2035: Meta prévoit que ses activités d’IA générative généreront 3 milliards de dollars de revenus en 2025 et estime que ce chiffre grimpera à 1,4 billion de dollars d’ici 2035. Cette prévision montre que Meta est extrêmement optimiste quant au potentiel de croissance à long terme du secteur de l’IA et pourrait continuer à maintenir des dépenses d’investissement élevées pour la R&D et l’infrastructure IA. (Source: brickroad7)

Alimama publie le grand modèle de connaissances mondiales URM: Alimama a lancé URM (Universal Recommendation Model), un grand modèle de langage combinant les connaissances mondiales et celles du domaine du e-commerce. Ce modèle, grâce à l’injection de connaissances (ID de produit comme token spécial) et à l’alignement des informations (fusion de l’ID avec des représentations sémantiques multimodales), peut comprendre les intérêts historiques des utilisateurs et effectuer des recommandations par raisonnement. URM adopte un mode de génération Sequence-In-Set-Out, générant en parallèle plusieurs représentations utilisateur pour améliorer l’efficacité et la diversité, tout en maintenant l’efficacité de l’inférence. Il a été déployé dans les scénarios publicitaires display d’Alimama et résout le problème de latence des LLM grâce à une chaîne d’inférence asynchrone, améliorant ainsi les résultats des campagnes des annonceurs et l’expérience d’achat des utilisateurs. (Source: WeChat)

🌟 Communauté

La fin de l’ère GPT-4 suscite émotion et discussions: Sam Altman a fait ses adieux à GPT-4, déclarant qu’il avait déclenché une révolution et que ses poids seraient conservés pour les futurs historiens. Cette annonce a suscité une large émotion au sein de la communauté, beaucoup se souvenant de GPT-4 comme du premier modèle leur ayant fait ressentir le potentiel de l’AGI. Parallèlement, cela a stimulé des discussions sur l’open source, des membres de la communauté comme Hugging Face appelant OpenAI à rendre open source les poids de GPT-4 pour la recherche, plutôt que de simplement les archiver. (Source: skirano, sama, iScienceLuvr, huggingface, Teknium1, eliza_luth, JvNixon, huybery, tokenbender, _philschmid)

Observations et discussions sur le secteur de l’AI Coding: Hailong Zhang, fondateur de GruAI, estime que l’AI Coding est l’un des rares secteurs où le PMF est actuellement visible. Le succès de Cursor réside dans la création d’un nouveau marché, et la valeur de son UI est immense. Il pense que la direction de Devin est correcte mais trop ambitieuse, avec un cycle de temps long, bien que la probabilité de succès augmente, et qu’il finira par concurrencer Cursor. Pour les startups, il estime qu’il ne faut pas trop s’inquiéter de la concurrence des grandes entreprises, l’essentiel étant la force du produit et sa valeur unique. Les progrès des modèles réduisent considérablement la nécessité de combler les lacunes par l’ingénierie ; les entrepreneurs doivent distinguer les problèmes qui seront résolus par l’évolution des modèles de ceux qui relèvent de la véritable force du produit. (Source: WeChat)

Réflexion sur l’affirmation “L’IA va remplacer votre travail”: Les discussions communautaires soulignent que l’affirmation “L’IA ne remplacera pas votre travail, mais les personnes utilisant l’IA le feront”, bien que correcte en surface, est trop simpliste et relève du “théâtre du consensus”, empêchant de réfléchir aux problèmes plus profonds. Le véritable enjeu est de comprendre comment l’IA modifie la structure du travail, remodèle les flux de travail, change la logique organisationnelle, et à quoi ressemblera le travail futur dans ce nouveau système, plutôt que de se concentrer uniquement sur l’automatisation ou l’amélioration des tâches individuelles. (Source: Reddit r/ArtificialInteligence)

L’appareil photo : nouvelle porte d’entrée pour l’interaction des agents IA avec le monde physique: Les discussions suggèrent que des fonctionnalités similaires à “Photographier pour demander” de Quark représentent une nouvelle tendance dans l’interaction des applications IA. Grâce à la caméra du téléphone mobile, un capteur omniprésent, combinée à la compréhension multimodale et aux capacités d’agent, l’IA peut mieux comprendre le monde physique et, en fonction des besoins implicites ou explicites de l’utilisateur, prendre des décisions autonomes et faire appel à ses capacités pour accomplir des tâches (comme identifier des objets, traduire, comparer des prix, aider aux devoirs, traiter des factures, etc.). Cela transforme l’appareil photo d’un simple outil de saisie d’informations en un hub connectant le monde physique et l’intelligence numérique, permettant de “Faire le travail” (Get it Done). (Source: WeChat)

💡 Autres

IA et recherche scientifique: L’opinion de la communauté est que l’IA devient progressivement les nouvelles “mathématiques” de la recherche scientifique, ce qui signifie que l’IA, tout comme les mathématiques, deviendra un outil et un langage fondamentaux pour faire progresser la découverte et la compréhension scientifiques. (Source: shuchaobi)

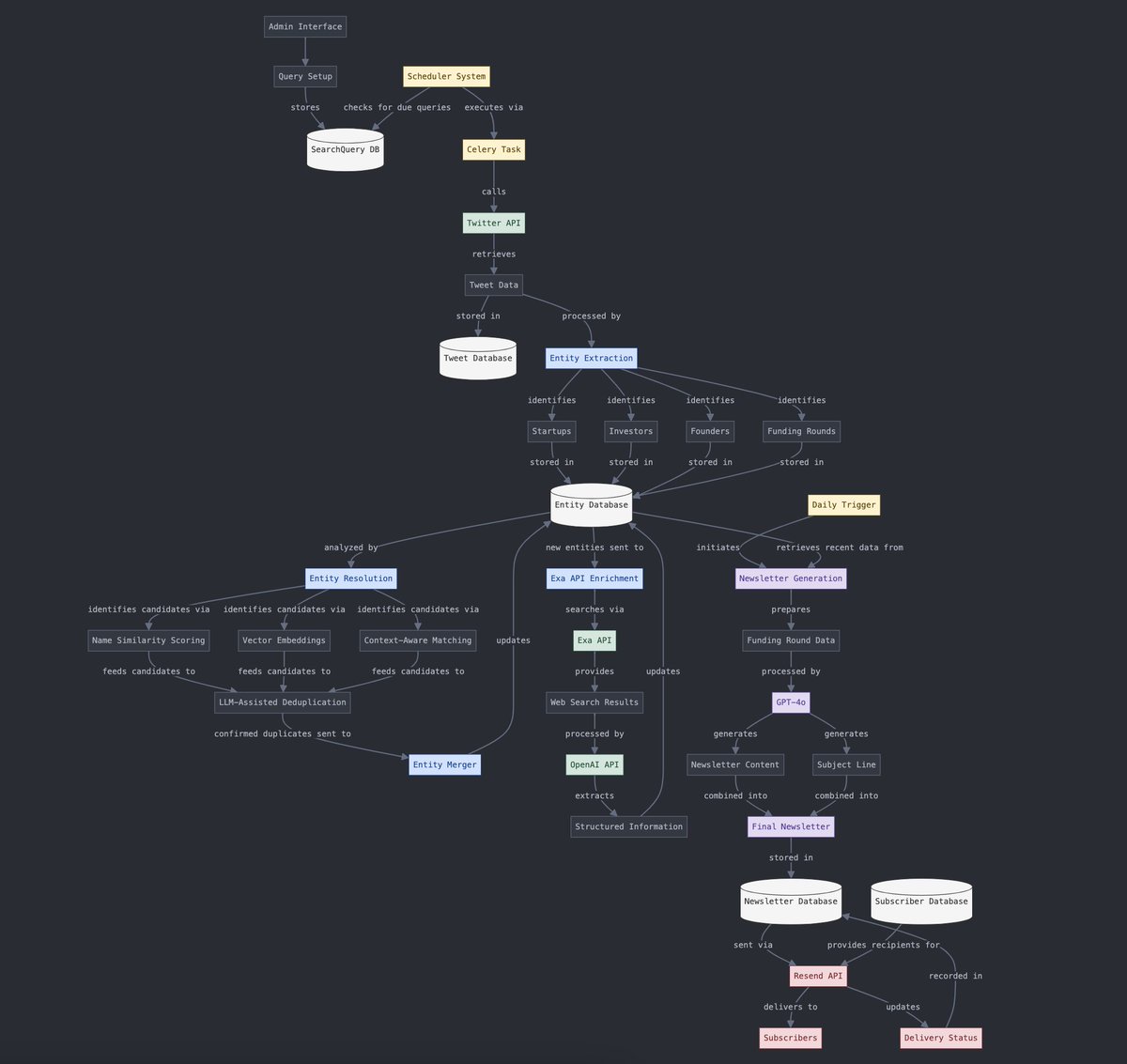

Conversion de données structurées et non structurées: Yohei Nakajima montre comment utiliser l’IA pour convertir des données de tweets non structurées en données structurées, afin de les reconvertir ensuite en une newsletter quotidienne non structurée, illustrant l’application de l’IA dans les processus de traitement de l’information et de génération de contenu. (Source: yoheinakajima)

L’avenir de la combinaison IA et VR: Les discussions communautaires envisagent le potentiel de la combinaison de l’IA et de la VR, imaginant un avenir où il serait possible de générer et de manipuler directement des objets 3D dans un “espace tableau blanc” VR par langage naturel ou par la pensée, réalisant ainsi une création pilotée par la cognition. Meta est considéré comme un acteur clé dans la promotion de cette direction. (Source: Reddit r/ArtificialInteligence)