Mots-clés:AI, OpenAI, o3/o4-mini modèle, Gemini 2.5 Pro, outil de programmation AI, technologie AI multimodale, agent intelligent AI

🔥 Pleins feux sur

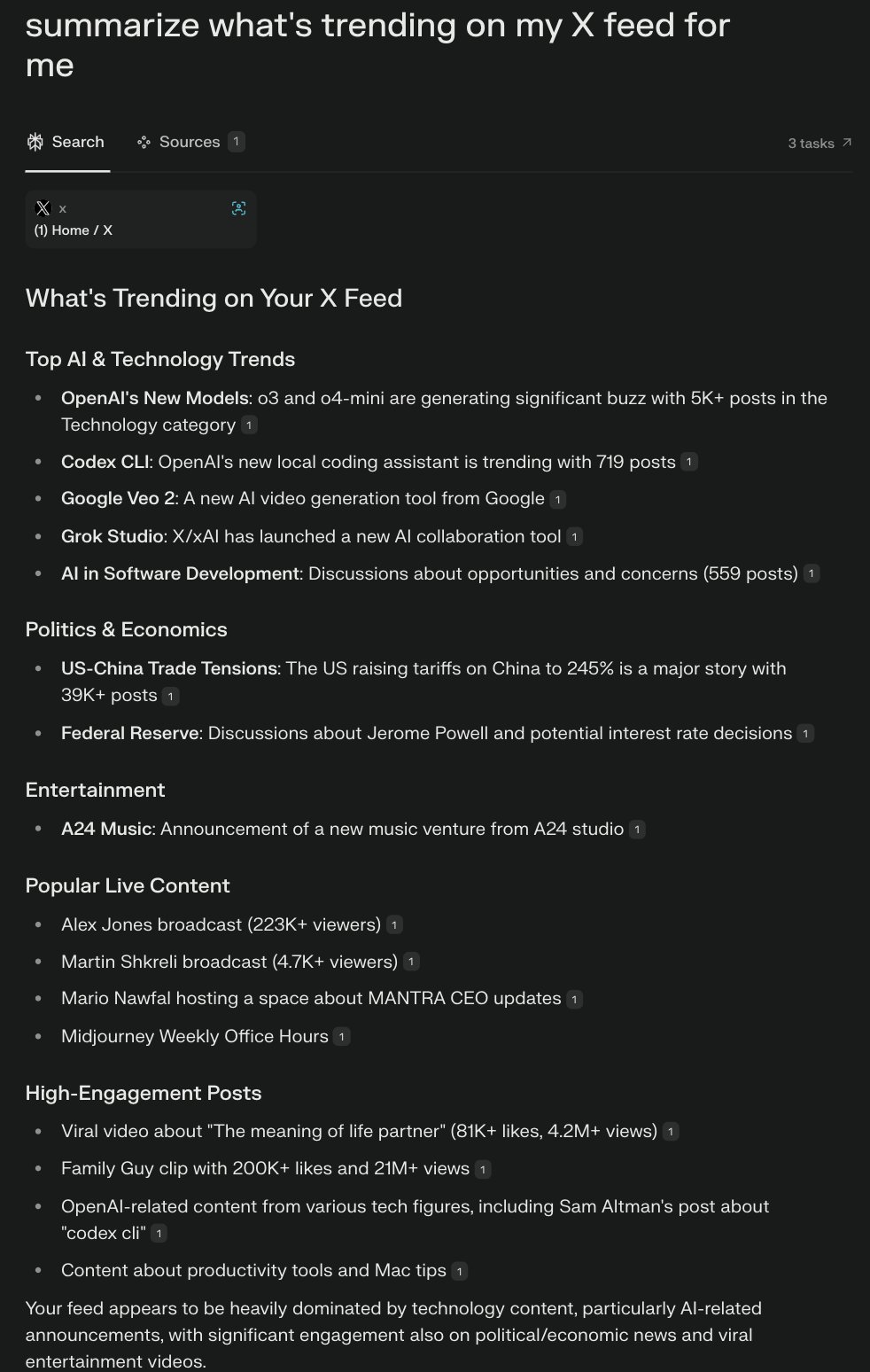

OpenAI annonce de manière fracassante o3 et o4-mini, inaugurant une nouvelle ère de “réflexion à partir d’images”: OpenAI a officiellement lancé son dernier modèle phare de “raisonnement” o3 et sa version allégée o4‑mini. Ces deux modèles réalisent pour la première fois la “réflexion à partir d’images”, capables d’intégrer et de traiter des images (par exemple, zoomer, pivoter) au sein de la chaîne de raisonnement, en les combinant avec du texte pour l’analyse. Ils peuvent également, pour la première fois, combiner de manière autonome tous les outils au sein de ChatGPT (recherche web, exécution de code Python, analyse de fichiers, génération d’images) pour résoudre des problèmes complexes. o3 établit de nouveaux SOTA (State-Of-The-Art) dans plusieurs benchmarks tels que Codeforces, SWE-bench, MMMU, excellant particulièrement dans le raisonnement visuel et les tâches multi-étapes, avec un taux d’erreurs graves réduit de 20% par rapport à o1. o4-mini, quant à lui, surpasse o3-mini en mathématiques, programmation et tâches visuelles, avec une latence et un coût inférieurs. Parallèlement, OpenAI a rendu open source l’agent IA de programmation léger pour terminal Codex CLI et a lancé un programme de financement d’un million de dollars. Les nouveaux modèles sont désormais disponibles pour les utilisateurs de ChatGPT Plus/Pro/Team ainsi que pour les développeurs API, marquant une avancée de l’IA vers des capacités multimodales et d’agent plus poussées. (Source: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表, openai, sama, karminski3, karminski3, sama, gdb, karminski3, sama, dotey, openai, karminski3, op7418, gdb,

)

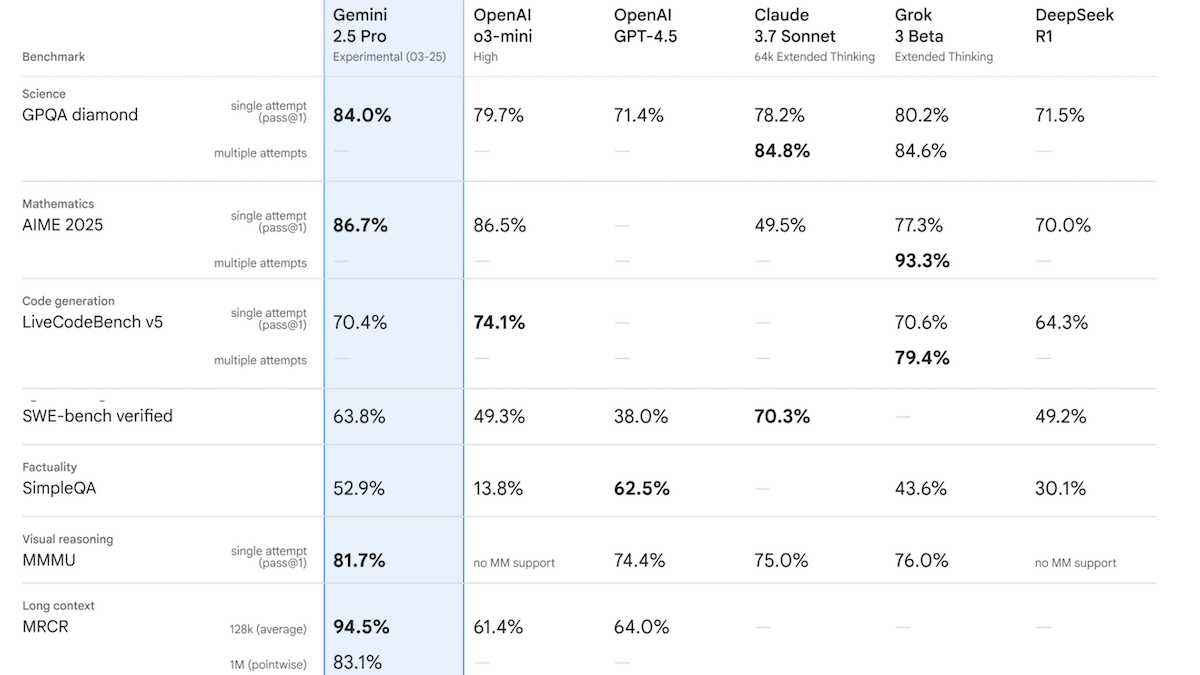

Google lance Gemini 2.5 Pro Experimental, qui atteint le sommet du classement Chatbot Arena en termes de performances: Google a présenté le premier modèle de sa famille Gemini 2.5, Gemini 2.5 Pro Experimental, et a annoncé une version à faible latence, Gemini 2.5 Flash. Ce modèle prend en charge les entrées texte, audio, image et vidéo (jusqu’à 1 million de tokens, avec un objectif futur de 2 millions), et les sorties texte (jusqu’à 65 000 tokens). Sa caractéristique notable est sa puissante capacité de raisonnement, réalisée en générant des tokens de raisonnement cachés (chaîne de pensée) avant la réponse. Sur Chatbot Arena, Gemini 2.5 Pro Experimental, avec un score Elo de 1437, dépasse GPT-4o et Grok 3 Preview, se classant en première position. Dans 12 benchmarks, il surpasse les modèles de pointe, y compris o3-mini, GPT-4.5 et Claude 3.7 Sonnet, dans 7 d’entre eux. Cela indique que les modèles d’IA, en particulier les modèles de raisonnement, continuent de progresser rapidement. Google prévoit que tous ses futurs nouveaux modèles seront dotés de capacités de raisonnement. (Source: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

🎯 Tendances

OpenAI lance la série de modèles GPT-4.1, axée sur la réduction des coûts et l’amélioration de l’efficacité: OpenAI a introduit la série GPT-4.1, comprenant GPT-4.1, GPT-4.1 Mini et GPT-4.1 Nano. Les caractéristiques principales sont la réduction des coûts et l’augmentation de la vitesse. GPT-4.1 Mini surpasse GPT-4o dans plusieurs benchmarks, avec une latence considérablement réduite et un coût diminué de 83%. GPT-4.1 Nano est le premier modèle ultra-compact, supportant un contexte de 1 million de tokens, adapté aux tâches à faible latence. Les trois modèles portent la fenêtre de contexte de 128K à 1 million de tokens. Côté prix, GPT-4.1 coûte 2$/8$ par million de tokens en entrée/sortie, soit 26% moins cher que GPT-4o ; Nano coûte 0.1$/0.4$. Cette initiative est perçue comme une réponse à la guerre des prix menée par des concurrents tels que DeepSeek. Parallèlement, le projet coûteux GPT-4.5 a été suspendu. (Source: 压力给到梁文锋,

)

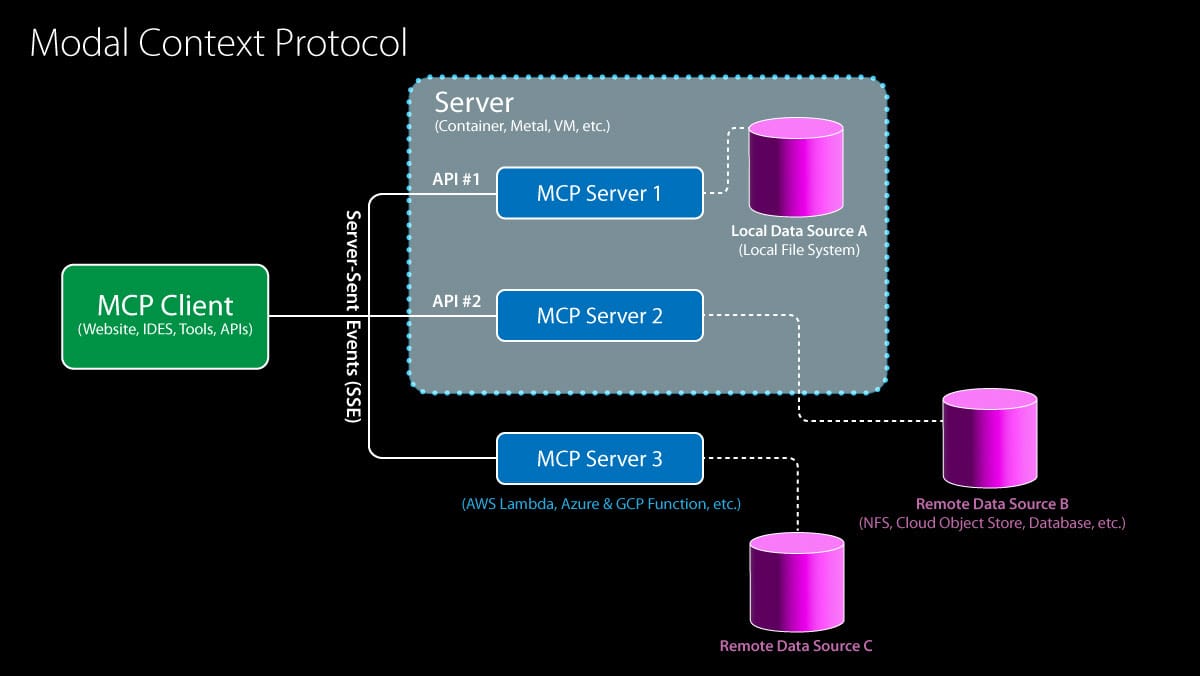

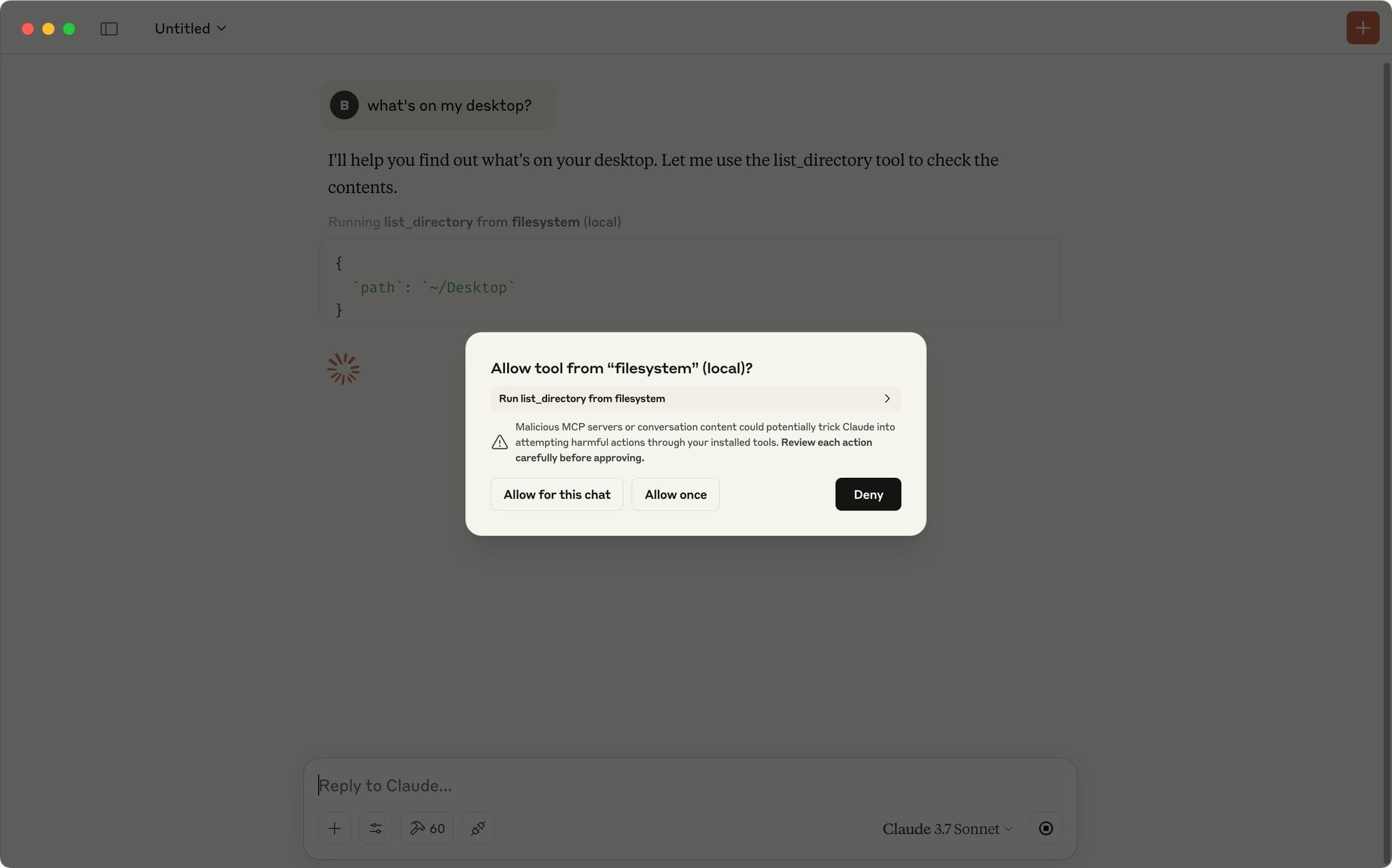

Le Model Context Protocol (MCP) reçoit le soutien d’OpenAI, accélérant l’intégration de l’écosystème: OpenAI a annoncé la prise en charge du Model Context Protocol (MCP) dans son Agents SDK, son application de bureau ChatGPT et son API Responses. Le MCP, initié par Anthropic à la fin de l’année dernière, vise à fournir un standard ouvert pour connecter les modèles d’IA aux outils et sources de données. Grâce au MCP, les modèles peuvent accéder à un écosystème croissant de ressources, comprenant plus de 6000 serveurs et connecteurs développés par la communauté (comme la recherche web, les opérations sur le système de fichiers). Auparavant, Microsoft avait intégré le MCP dans CoPilot Studio, Cloudflare supportait le déploiement de serveurs MCP distants, et l’éditeur de code Cursor le prenait également en charge. L’adhésion d’OpenAI va considérablement promouvoir le MCP comme standard de facto pour la construction d’applications d’agents IA, simplifiant l’intégration par les développeurs de divers outils et sources de données tiers. (Source: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

ByteDance lance Kling 2.0, améliorant les effets de génération vidéo: Kling 2.0 est le dernier modèle de génération vidéo lancé par ByteDance. Selon les retours des utilisateurs et les démonstrations, Kling 2.0 excelle dans la génération de scènes vidéo fluides et réalistes, montrant une amélioration par rapport aux versions précédentes et aux concurrents comme Sora, notamment dans la conversion image-vidéo. Les utilisateurs peuvent d’abord utiliser des outils comme ChatGPT pour générer des images avec une bonne fidélité textuelle, puis utiliser Kling 2.0 pour les transformer en vidéos dynamiques. Cela indique que la technologie de génération vidéo continue de progresser en termes de cohérence de scène et de réalisme. (Source:

)

Google lance DolphinGemma pour explorer le mystère de la communication des dauphins: Google AI a lancé le projet DolphinGemma, visant à utiliser la technologie IA pour décoder les méthodes de communication des dauphins. Le projet a accumulé un vaste jeu de données de sons de dauphins et a entraîné un modèle de 400 millions de paramètres (pouvant fonctionner sur un téléphone Pixel 9) pour analyser ces sons, à la recherche de motifs et de règles pouvant indiquer un langage. La recherche en est actuellement à un stade exploratoire, et il n’est pas encore certain que les dauphins possèdent un langage complexe similaire à celui des humains, mais des types de sons liés à des comportements spécifiques (comme la dénomination, les combats, la parade nuptiale) ont été identifiés. L’objectif final est de comprendre la structure et la signification potentielle des sons des dauphins, et d’essayer d’établir une communication bidirectionnelle simple avec eux en générant des sons spécifiques. (Source:

)

IBM lance la série de modèles Granite 3.3, incluant la reconnaissance vocale: IBM a introduit la série de modèles Granite 3.3, qui comprend un modèle de reconnaissance vocale de 8 milliards de paramètres (Granite Speech 3.3). Ce modèle adopte une approche en deux étapes, visant à traiter la parole sans dégrader les capacités fondamentales du LLM. La nouvelle famille de modèles vise à fournir des capacités de raisonnement plus affinées et des performances RAG (génération augmentée par récupération) améliorées, et prend en charge le fine-tuning LoRA. Ces modèles peuvent être intégrés dans des assistants IA dans divers domaines. (Source: Reddit r/LocalLLaMA)

L’IA révolutionne les prévisions météorologiques, améliorant considérablement l’efficacité: L’intelligence artificielle transforme discrètement le domaine des prévisions météorologiques. Les tâches de prévision qui nécessitaient traditionnellement d’énormes équipes d’experts et des supercalculateurs peuvent désormais être réalisées sur un ordinateur portable grâce aux modèles d’IA. L’IA est capable de traiter et d’analyser des quantités massives de données météorologiques, d’identifier des motifs complexes, générant ainsi des prévisions plus rapides et potentiellement plus précises. Cela marque une application importante de l’IA dans le calcul scientifique et la prévision, promettant d’améliorer la rapidité et la couverture des prévisions. (Source: Reddit r/ArtificialInteligence)

L’application Google Gemini ajoute le support LaTeX: L’application Google Gemini a été mise à jour pour inclure le support de LaTeX. Les utilisateurs peuvent désormais utiliser la syntaxe LaTeX dans l’application Gemini pour afficher des formules mathématiques, des symboles scientifiques, etc. Cette mise à jour couvre les modèles Gemini 2.0 Flash et 2.5 Pro, améliorant l’utilité de Gemini dans les scénarios de communication académique et technique. (Source: JeffDean)

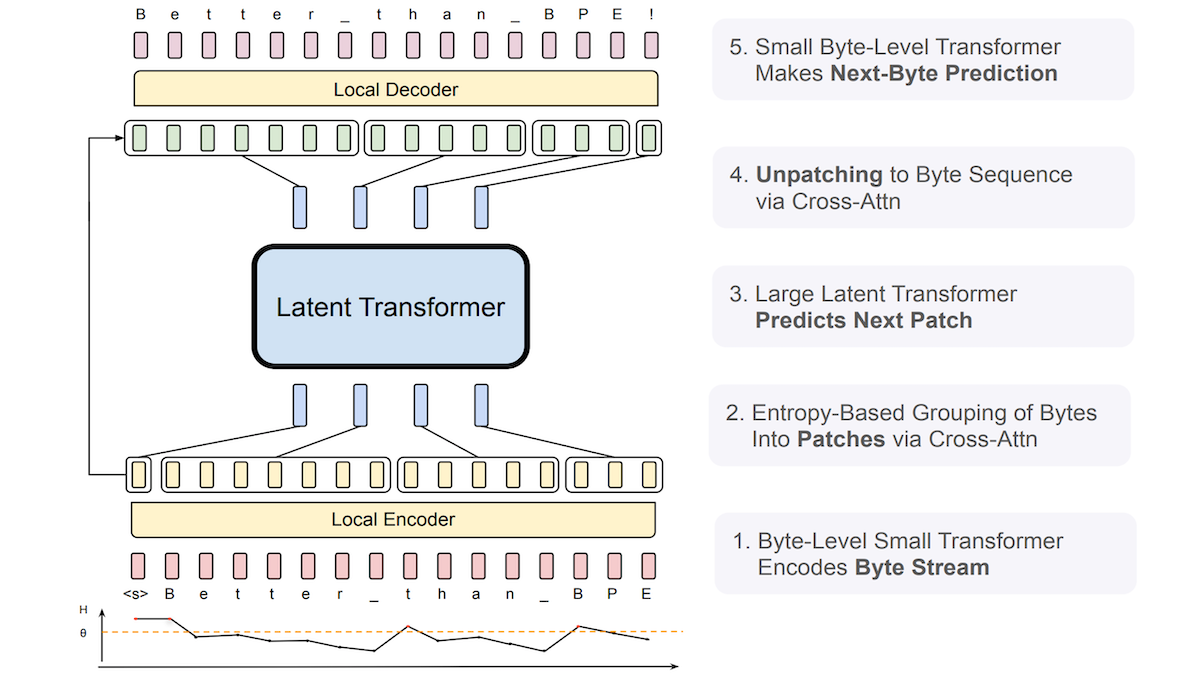

Meta propose le Byte Latent Transformer (BLT) pour améliorer la robustesse des LLM aux entrées bruitées: Des chercheurs de Meta et d’autres institutions ont introduit le Byte Latent Transformer (BLT), conçu pour remplacer les tokenizers traditionnels. Le BLT traite directement les séquences d’octets (caractères), en utilisant un petit Transformer au niveau de l’octet pour prédire la probabilité de l’octet suivant et en utilisant l’entropie pour regrouper dynamiquement les octets : faible entropie (haute prévisibilité) les ajoute au groupe actuel, haute entropie (faible prévisibilité) commence un nouveau groupe. Le système comprend un encodeur, un Transformer latent et un décodeur, totalisant 8 milliards de paramètres. Les expériences montrent que le BLT est légèrement supérieur à Llama 3 de taille équivalente sur les benchmarks de langage général et de codage, et démontre une robustesse significativement plus forte aux entrées bruitées telles que les fautes d’orthographe et les langues rares, car il comprend mieux les similitudes au niveau des caractères. (Source: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

Une nouvelle étude explore l’extension au moment du test de la collaboration multi-agents pour le raisonnement: Un article intitulé “Two Heads are Better Than One: Test-time Scaling of Multi-agent Collaborative Reasoning” a été soumis à arXiv. Cette recherche se concentre sur la manière d’améliorer les performances dans les tâches de raisonnement complexes en faisant collaborer plusieurs agents IA au moment du test (inférence), explorant une voie d’extension des capacités du modèle sans augmenter les coûts d’entraînement. (Source: Reddit r/MachineLearning)

La gouvernance des agents IA devient un nouveau point focal: Avec l’amélioration des capacités des agents IA (Agentic AI), leur gouvernance efficace devient un enjeu majeur. Cela implique d’assurer que le comportement des agents est conforme aux attentes, sûr et contrôlable, et respecte les normes éthiques. Il est nécessaire d’établir des cadres, des normes et des mécanismes de régulation appropriés pour gérer ces “esprits synthétiques” capables d’agir et de décider de manière autonome. (Source: Ronald_vanLoon)

L’IA génère des images de haute qualité plus rapidement que les méthodes SOTA actuelles: Des chercheurs du MIT ont développé un nouvel outil d’intelligence artificielle capable de surpasser les méthodes de pointe actuelles (SOTA) en matière de génération d’images de haute qualité, et ce, plus rapidement. Cela indique que dans le domaine de la génération d’images, l’efficacité et la qualité continuent de faire des percées. (Source: Ronald_vanLoon)

xAI introduit une fonctionnalité de type Canvas pour Grok AI: xAI a ajouté une fonctionnalité similaire à ChatGPT Canvas à son chatbot Grok AI. Les fonctionnalités de type Canvas offrent généralement une interface de canevas infini, permettant aux utilisateurs d’organiser et d’interagir avec les informations de manière plus libre et visuelle, en combinant texte, code, images, etc. Cette initiative permet à Grok de rattraper ChatGPT en termes d’expérience utilisateur interactive, et cette fonctionnalité est proposée gratuitement. (Source: Reddit r/ArtificialInteligence)

🧰 Outils

Anx Reader : Lecteur d’e-books multiplateforme intégrant plusieurs moteurs IA: Anx Reader est un lecteur d’e-books prenant en charge divers formats tels que EPUB, MOBI, AZW3, FB2, TXT, utilisable sur iOS/macOS/Windows/Android. Sa particularité réside dans l’intégration de multiples capacités IA (OpenAI, Claude, Gemini, DeepSeek, etc.), utilisables pour le résumé de contenu, la pose de questions, l’obtention rapide d’informations, etc. L’application prend en charge la synchronisation de la progression de lecture, des fichiers de livres et des notes via WebDAV, offre des styles de lecture hautement personnalisables (interligne, police, palette de couleurs, etc.), et inclut des fonctions TTS (Text-To-Speech), de traduction, de recherche, d’enregistrement d’idées, etc. Elle vise à offrir une expérience de lecture intelligente, concentrée et personnalisée. (Source: Anxcye/anx-reader – GitHub Trending (all/daily))

OpenAI rend open source Codex CLI : un agent IA de programmation léger fonctionnant localement: Parallèlement au lancement d’o3/o4-mini, OpenAI a rendu open source Codex CLI, un agent IA de programmation exécutable dans le terminal. Il permet aux développeurs, via des instructions en langage naturel, de faire exécuter directement des tâches de codage par l’IA sur leur ordinateur local, comme écrire du code, installer des dépendances, configurer l’environnement, corriger des bugs, etc. Codex CLI vise à exploiter pleinement les puissantes capacités de raisonnement des modèles comme o3/o4-mini, et peut combiner des entrées multimodales (comme des captures d’écran) avec un accès au code local. Cet outil a pour but de simplifier le processus de développement, en étant particulièrement convivial pour les débutants. OpenAI a également lancé un programme de subventions d’un million de dollars pour soutenir les projets basés sur cet outil. (Source: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表, sama, karminski3, dotey, sama, dotey)

Les modèles Cohere arrivent sur Hugging Face Hub, offrant des services d’inférence: Cohere a annoncé que ses modèles sont devenus le premier fournisseur d’inférence tiers pris en charge sur Hugging Face Hub. Les utilisateurs peuvent désormais accéder directement aux modèles open source de Cohere (comme la série Aya) et aux modèles d’entreprise (comme la série Command) sur le Hub, et effectuer des inférences rapides. Ces modèles sont particulièrement doués pour l’utilisation d’outils et les capacités multilingues, et offrent une interface compatible avec OpenAI, facilitant l’intégration et la construction d’applications par les développeurs. (Source: huggingface, huggingface, huggingface)

LocalAI v2.28.0 publié, lancement de la plateforme d’agents IA locaux LocalAGI: LocalAI, serveur permettant d’exécuter des LLM localement et fournissant une API compatible OpenAI, est mis à jour en v2.28.0. Parallèlement, la toute nouvelle plateforme LocalAGI est lancée. LocalAGI est une plateforme d’orchestration d’agents IA auto-hébergée avec une interface WebUI, permettant aux utilisateurs de construire des workflows d’agents IA complexes et multi-étapes (similaires à AutoGPT). L’élément clé est que ces agents peuvent être pilotés par des LLM locaux fournis via LocalAI ou d’autres API compatibles (comme llama-cpp-python). Associé à la banque de mémoire locale LocalRecall, les utilisateurs peuvent exécuter des agents IA autonomes dans un environnement entièrement localisé pour effectuer des tâches de recherche, de codage, de traitement de contenu, etc. (Source: Reddit r/LocalLLaMA)

Le framework Droidrun open source : contrôler un téléphone Android avec l’IA: Droidrun est un framework permettant aux utilisateurs de contrôler un téléphone Android pour exécuter des tâches via l’IA (comme les grands modèles de langage), désormais open source sur GitHub. Les utilisateurs peuvent donner des instructions en langage naturel pour que l’IA effectue des opérations sur le téléphone, comme ouvrir des applications, cliquer sur des boutons, saisir du texte, etc. Cela nécessite l’installation de l’outil ADB (Android Debug Bridge). Ce framework montre de nouvelles possibilités pour l’IA dans l’automatisation et l’interaction avec les appareils mobiles. (Source: karminski3)

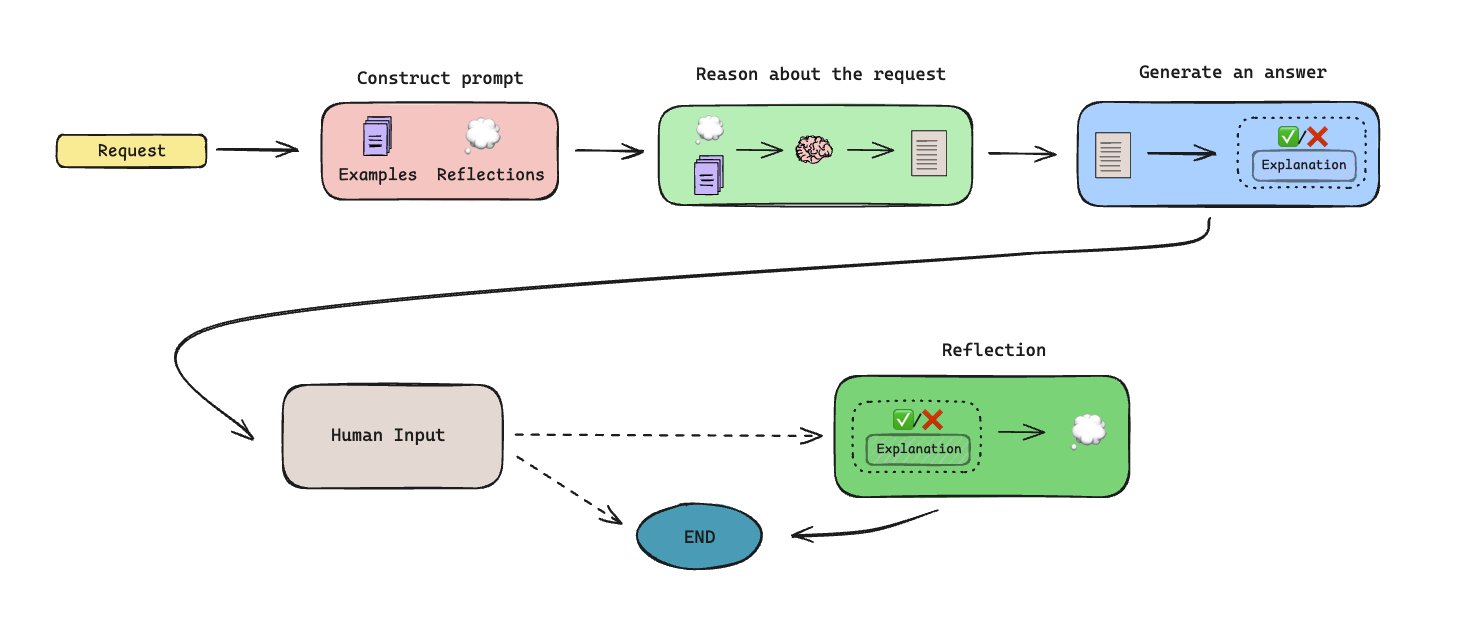

Lancement de LLManager : workflow d’approbation automatisé basé sur la mémoire: LLManager est un workflow open source construit avec LangGraph, conçu pour automatiser les tâches d’approbation à l’aide d’agents IA dotés de mémoire. Le système est capable de générer de la mémoire grâce à la collaboration homme-machine (human-in-the-loop), apprenant et améliorant ainsi les décisions d’approbation au fil du temps. L’architecture est conçue pour traiter les processus d’approbation répétitifs, augmentant l’efficacité. (Source: LangChainAI)

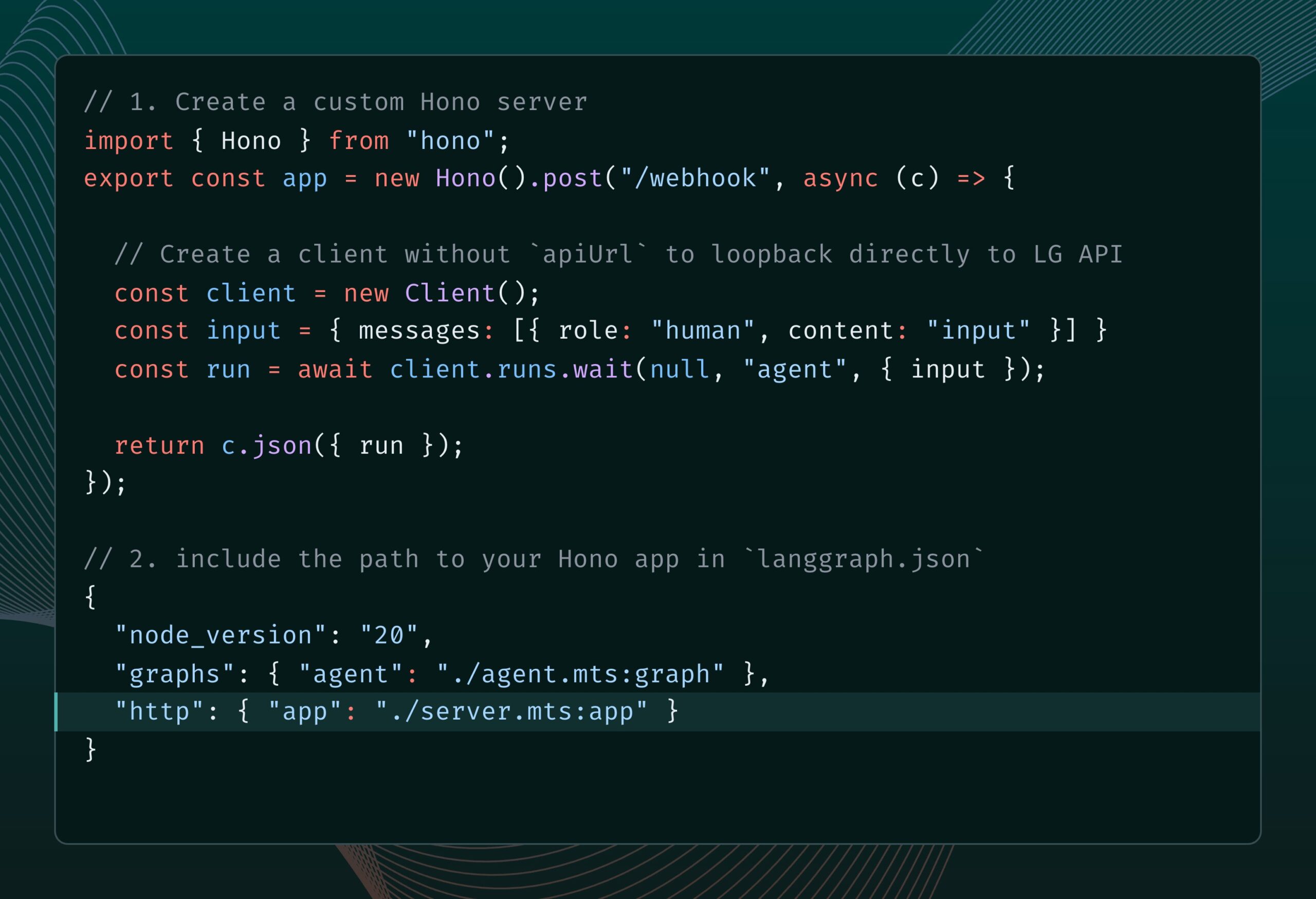

LangGraph.js intègre Hono, supportant les routes HTTP personnalisées et les middlewares: LangGraph.js (la version JS de la bibliothèque LangChain pour construire des applications multi-agents avec état) peut désormais être intégré avec Hono (un framework web léger). Cela permet aux développeurs d’ajouter des routes HTTP personnalisées et des middlewares à leurs applications LangGraph.js, permettant ainsi de construire des services backend plus complexes, comme le traitement de webhooks, la création d’applications API complètes, etc., élargissant les scénarios d’application de LangGraph.js. (Source: LangChainAI)

Le robot humanoïde open source Reachy 2 mis en vente: Clem Delangue, co-fondateur de Hugging Face, a annoncé que le premier robot humanoïde open source auquel son équipe a participé, Reachy 2, est mis en vente cette semaine. Le robot est vendu 70 000 $, destiné au marché de la recherche et de l’éducation, et est déjà utilisé à l’Université Cornell, à l’Université Carnegie Mellon et dans les principaux laboratoires d’IA. Il présente une forme humanoïde, une base mobile omnidirectionnelle, de nombreux capteurs (caméras, microphones, LiDAR, etc.), est basé sur ROS 2 et LeRobotHF, supporte un SDK Python, et sa conception modulaire permet la personnalisation. (Source: huggingface)

Perplexity lance le navigateur Comet, explorant une expérience de navigation native IA: Arav Srinivas, PDG de Perplexity, développe un navigateur nommé Comet et sollicite des idées sur la croissance du produit et ses fonctionnalités. Comet vise à incarner un “système d’exploitation agentique” (agentic OS), contrôlant les applications web et les données via le navigateur, utilisant l’IA pour répondre aux questions et exécuter des tâches. L’idée est que, puisque la plupart des applications sont sur le Web, une IA contrôlant le navigateur peut contrôler la majeure partie de la vie numérique. Le projet met l’accent sur le fait de commencer petit, en évitant de trop promettre des capacités universelles. (Source: AravSrinivas, AravSrinivas, AravSrinivas, AravSrinivas, AravSrinivas)

L’application Claude prend en charge un script d’approbation automatique des requêtes MCP: Un utilisateur de la communauté a partagé un script JavaScript à exécuter dans la console des outils de développement de l’application Claude, qui peut approuver automatiquement les requêtes MCP (Model Context Protocol) provenant d’une liste prédéfinie d’outils de confiance. Pour les utilisateurs qui utilisent fréquemment des outils locaux ou distants spécifiques, cela peut éviter de cliquer manuellement sur “Autoriser” à chaque fois, améliorant l’efficacité du workflow. Cependant, les utilisateurs doivent être conscients des risques de sécurité et n’activer cela que pour les outils en lesquels ils ont entièrement confiance. (Source: Reddit r/ClaudeAI)

Recommandations de serveurs MCP indispensables pour l’automatisation du codage et des workflows: Un utilisateur de la communauté a partagé une série de serveurs MCP (Model Context Protocol) recommandés, qui peuvent être intégrés avec des modèles IA supportant MCP (comme Claude) ou des frameworks d’agents pour améliorer l’efficacité du codage et les capacités d’automatisation. La liste recommandée comprend : Sequential Thinking MCP pour la pensée structurée, Puppeteer MCP pour l’interaction web, Memory Bank MCP pour la gestion des connaissances de projet, Playwright MCP pour les tests multi-navigateurs, GitHub MCP pour les opérations GitHub, Knowledge Graph Memory MCP pour la mémoire persistante, DuckDuckGo MCP pour la recherche sans clé API, et MCP Compass pour découvrir d’autres outils MCP. (Source: Reddit r/ClaudeAI)

📚 Apprentissage

Dépôt GitHub : Guide complet des techniques RAG avancées: Le dépôt GitHub RAG_Techniques créé par Nir Diamant offre la collection la plus complète à ce jour de tutoriels sur les techniques avancées de génération augmentée par récupération (RAG). Ce dépôt vise à améliorer la précision, l’efficacité et la richesse contextuelle des systèmes RAG, couvrant tout, depuis l’implémentation de base (LangChain/LlamaIndex), l’optimisation du découpage de texte (taille fixe, découpage propositionnel, découpage sémantique), l’amélioration des requêtes (transformation, HyDE, HyPE), l’enrichissement contextuel (en-têtes de bloc, extraction de segments pertinents, extension de fenêtre, amélioration de document), jusqu’à la récupération avancée (fusion, réordonnancement, filtrage multi-facettes, indexation hiérarchique, intégration, multimodalité), les techniques itératives (boucles de rétroaction, adaptatif, récupération itérative), l’évaluation (DeepEval, GroUSE), l’explicabilité, ainsi que les architectures avancées (Graph RAG, RAPTOR, Self-RAG, CRAG), etc., soit plus de 30 techniques, avec des implémentations en Jupyter Notebook ou script Python. Ce projet est piloté par la communauté et encourage les contributions. (Source: NirDiamant/RAG_Techniques – GitHub Trending (all/daily))

DeepLearning.AI lance un nouveau cours : Construire des agents IA pour navigateur: Andrew Ng a annoncé un nouveau cours de courte durée “Building AI Browser Agents” en partenariat avec AGI Inc. Le cours, enseigné par les co-fondateurs d’AGI Inc., Div Garg et Naman Garg, vise à enseigner comment construire des agents IA capables d’interagir avec des sites web et d’exécuter des tâches (comme extraire des informations, remplir des formulaires, cliquer, passer des commandes). Le contenu du cours comprend le fonctionnement des Web Agents, leur architecture, leurs limites, les stratégies de décision, la construction pratique d’un Web Agent pour extraire les cours de DeepLearning.AI et structurer la sortie, la construction d’un agent autonome pour accomplir plusieurs tâches (trouver et résumer des pages web, remplir des formulaires, s’abonner), l’exploration du framework AgentQ (combinant la recherche arborescente Monte-Carlo MCTS et l’optimisation directe des préférences DPO pour l’auto-correction), l’approfondissement des principes MCTS, ainsi qu’une discussion sur l’état actuel et l’avenir des agents IA. (Source: AndrewYNg)

Hugging Face met à jour sa documentation sur la quantification, offrant un guide conceptuel et des benchmarks de sélection: Hugging Face a considérablement mis à jour sa documentation concernant la quantification des modèles. La nouvelle documentation vise à aider les utilisateurs à mieux comprendre les concepts de quantification et à choisir la technologie appropriée en fonction de leurs besoins. Les mises à jour incluent : une explication des bases de la quantification (comme les schémas, int4, FP8), un nouveau guide de sélection (aidant à choisir entre des technologies comme bnb, AWQ, GPTQ, HQQ en fonction des besoins et du matériel), ainsi que des données de benchmark comparant la précision et les performances des méthodes de quantification populaires pour les modèles Llama 3.1 8B et 70B. Cela fournit une référence précieuse aux développeurs souhaitant compresser leurs modèles et améliorer l’efficacité de l’inférence. (Source: huggingface)

Nouvelle méthode MODE : une alternative légère et interprétable au RAG: Rahul Anand, chercheur indépendant, propose une nouvelle méthode appelée MODE (Mixture of Document Experts) comme alternative légère au processus RAG traditionnel. MODE ne repose pas sur des bases de données vectorielles ni sur des réordonnanceurs, mais extrait les informations en clusterisant les documents et en utilisant une récupération basée sur les centroïdes. Cette méthode serait efficace et hautement interprétable, particulièrement adaptée aux jeux de données de petite et moyenne taille. L’auteur cherche l’approbation d’arXiv (domaine cs.AI) pour publier l’article. (Source: Reddit r/MachineLearning)

Dépôt GitHub Beyond-NanoGPT : Ressource avancée pour passer de débutant LLM à chercheur IA: Tanishq Kumar a rendu open source un dépôt GitHub nommé beyond-nanoGPT. Ce projet vise à aider les apprenants ayant déjà maîtrisé les bases des LLM au niveau de nanoGPT à comprendre et implémenter des idées complexes proches de la pointe de la recherche en deep learning. Le dépôt contient des milliers de lignes de code PyTorch commenté, implémentant à partir de zéro diverses avancées de la recherche ML moderne, y compris le décodage spéculatif, les Transformers visuels/de diffusion, l’attention linéaire/sparse, etc. L’objectif du projet est d’aider davantage de personnes à faire la transition vers le domaine de la recherche en IA. (Source: Reddit r/MachineLearning)

Tutoriel : Entraîner un chatbot basé sur un dépôt GitHub en utilisant AI Scraper et LLM: Un article publié sur le blog Stackademic explique comment utiliser AI Scraper (outil de web scraping) et un grand modèle de langage (LLM) pour entraîner un chatbot capable de répondre à des questions sur un dépôt GitHub spécifique. Cette méthode implique généralement de scraper le code, la documentation (comme le README), les Issues, etc., du dépôt, de les traiter dans un format compréhensible par le LLM, puis d’utiliser RAG (génération augmentée par récupération) ou le fine-tuning pour permettre au chatbot de répondre aux questions en se basant sur ces informations. (Source: Reddit r/ArtificialInteligence)

Interprétation d’article : Utiliser la propagation de pertinence couche par couche (LRP) pour l’IA explicable (XAI) sur données tabulaires: Un article de blog explore comment utiliser la technique de propagation de pertinence couche par couche (Layer-Wise Relevance Propagation, LRP) pour expliquer le processus de décision des modèles de deep learning lors du traitement de données tabulaires. LRP est une méthode d’attribution visant à décomposer la prédiction de sortie du modèle sur les caractéristiques d’entrée, révélant ainsi quelles caractéristiques contribuent le plus à la décision finale. Son application aux données tabulaires aide à comprendre le comportement du modèle, améliorant la transparence et la fiabilité. (Source: Reddit r/deeplearning)

💼 Affaires

Zhipu AI entame la préparation de son introduction en bourse, visant une finalisation d’ici la fin de l’année: La société chinoise d’IA Zhipu AI a officiellement entamé la phase de préparation pour son introduction en bourse (“listing guidance”), avec CICC comme banque conseil. Selon le rapport de dépôt, Zhipu AI prévoit de finaliser la préparation à l’IPO entre août et octobre 2025. Le PDG de l’entreprise, Zhang Peng, avait précédemment déclaré que la route vers l’AGI était longue et que les fonds levés n’étaient que des “frais de voyage”, nécessitant davantage de capitaux à l’avenir. Cette IPO est considérée comme une étape clé pour obtenir “plus de frais de voyage”. Zhipu AI est un acteur majeur dans le domaine des grands modèles en Chine, et son processus d’IPO est très attendu. (Source: 压力给到梁文锋)

La startup Gumloop, composée de 2 personnes, lève plus de 100 millions de yuans grâce à l’IA: La plateforme no-code Gumloop, avec seulement ses deux fondateurs comme employés officiels, a récemment finalisé un tour de financement de série A de 17 millions de dollars (environ 124 millions de RMB). L’entreprise a débuté en fournissant une interface utilisateur simple pour Auto-GPT, puis s’est développée en une plateforme de construction de workflows IA pour les non-techniciens, AgentHub, capable d’intégrer des outils comme GitHub, Gmail, etc., pour automatiser le traitement de documents, le web scraping, le SEO, le CRM, le marketing par e-mail, etc. Gumloop utilise elle-même massivement des agents IA pour gérer ses activités. L’objectif des fondateurs est de construire une entreprise valorisée à 1 milliard de dollars avec une équipe de moins de 10 personnes. Cela reflète la possibilité pour de petites équipes à l’ère de l’IA d’atteindre une haute efficacité et une grande valeur en utilisant des outils IA, ainsi que l’opportunité entrepreneuriale de résoudre le problème du “dernier kilomètre” de l’application de l’IA. (Source: 把AI当成“牛马”,2人创业团队,拿下了超1亿元融资)

Rumeur : OpenAI envisagerait d’acquérir la société d’outils de programmation IA Windsurf (anciennement Codeium) pour 3 milliards de dollars: Selon des sources de Bloomberg, OpenAI serait en pourparlers pour acquérir la société d’outils de programmation assistée par IA Windsurf (anciennement Codeium) pour environ 3 milliards de dollars. Si la transaction se concrétise, ce serait la plus grande acquisition de l’histoire d’OpenAI, visant à renforcer sa compétitivité sur le marché des assistants de programmation IA, en concurrence directe avec Anthropic, GitHub Copilot, Anysphere (Cursor), etc. Windsurf, fondée en 2021, était précédemment valorisée à 1,25 milliard de dollars et avait déjà levé plus de 200 millions de dollars de financement. Cette rumeur d’acquisition laisse également présager une possible consolidation accrue dans le domaine des outils de programmation IA. (Source: dotey)

La société Safe Superintelligence d’Ilya Sutskever serait valorisée à 32 milliards de dollars: Selon TechCrunch, Safe Superintelligence (SSI), la nouvelle société fondée par le co-fondateur d’OpenAI Ilya Sutskever, a atteint une valorisation de 32 milliards de dollars lors d’un récent tour de financement. La société aurait obtenu 2 milliards de dollars d’investissement. L’objectif de SSI est de construire une superintelligence de manière sûre. Sa valorisation élevée reflète les fortes attentes du marché envers les talents de pointe en IA et la vision de l’AGI, bien que la société n’ait encore lancé aucun produit. (Source:

)

La guerre commerciale sino-américaine pourrait affecter le développement de l’IA, l’approvisionnement en puces étant au centre des préoccupations: Une analyse suggère que la guerre commerciale des États-Unis contre la Chine, en particulier les restrictions à l’exportation de puces IA haut de gamme (comme les séries H100/B200 de NVIDIA), ainsi que les potentielles contre-mesures chinoises limitant l’exportation de terres rares, constituent un défi pour le développement mondial de l’IA. Le rapport souligne que les entreprises d’IA (comme OpenAI) ressentent déjà les limites de l’approvisionnement insuffisant en GPU. Parallèlement, la Chine progresse dans la fabrication de puces (comme les avancées technologiques 3nm, 1nm) et pourrait produire des puces IA de haute qualité dans les années à venir. L’article soutient que les restrictions commerciales actuelles pourraient ralentir le développement de l’IA aux États-Unis, voire permettre à la Chine de les dépasser dans ce domaine, appelant à promouvoir le développement de l’IA par le libre-échange. (Source: Reddit r/ArtificialInteligence)

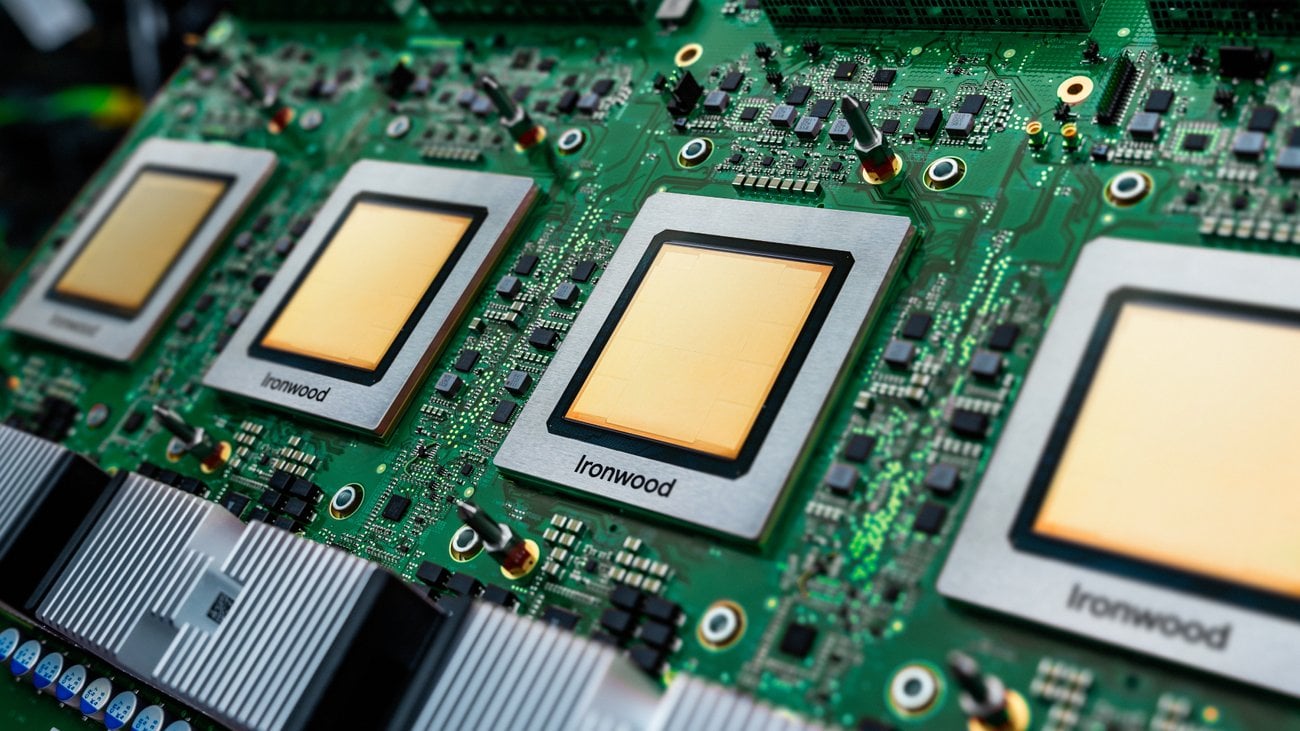

Discussion sur l’application pratique des TPU en environnement de production: Google a récemment lancé une nouvelle génération de TPU (Tensor Processing Units) optimisés pour l’inférence. Cependant, une discussion communautaire souligne que, bien que les TPU existent depuis des années et que Google offre un généreux programme de ressources pour les chercheurs (TRC), leur application dans les environnements de production industriels semble moins répandue que celle des GPU NVIDIA. Les raisons pourraient inclure la complexité de la configuration, des avantages de performance peu évidents, des fonctionnalités insuffisantes de la plateforme GCP (comme les IP fixes, les outils d’observabilité), la difficulté de débogage (XLA) et les préoccupations liées au verrouillage fournisseur dues à la location exclusive via GCP. La discussion appelle les utilisateurs ayant une expérience de production réelle à partager leur utilisation et les défis liés aux TPU. (Source: Reddit r/MachineLearning)

L’IA crée un fossé de confiance dans le secteur de l’assurance: Un rapport de recherche de Swiss Re souligne que l’application de l’IA générative dans le secteur de l’assurance est confrontée à des défis de confiance. Bien que le potentiel de l’IA soit énorme, des préoccupations existent concernant la confidentialité des données, la cybersécurité et la transparence des décisions, ce qui peut entraîner un fossé de confiance entre les compagnies d’assurance et les clients. Le rapport explore comment exploiter les avantages de l’IA tout en abordant les risques et les questions éthiques associés, afin de construire et de maintenir la confiance des utilisateurs. (Source: Ronald_vanLoon)

🌟 Communauté

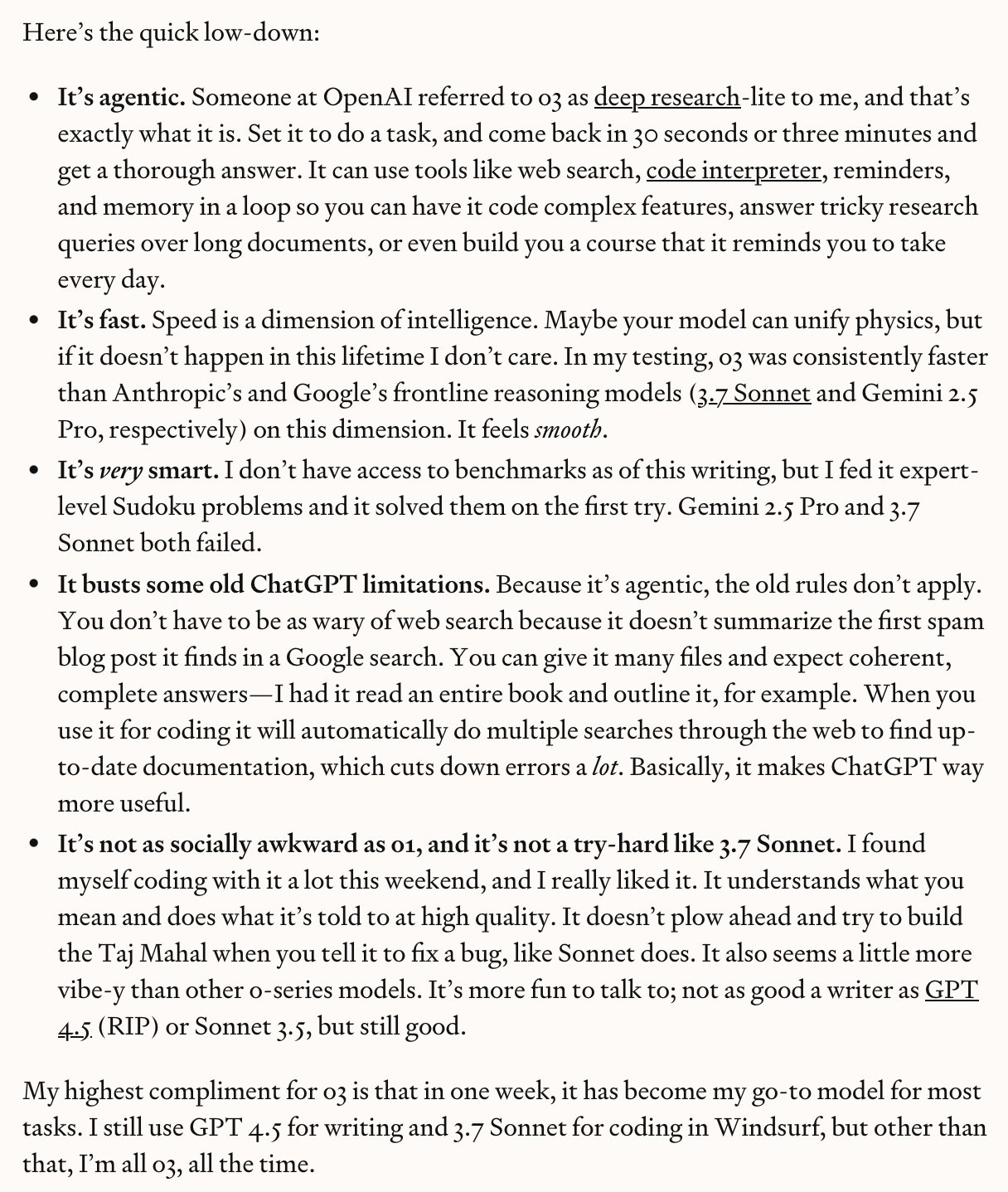

OpenAI o3/o4-mini suscitent un vif débat, entre capacités réelles et battage médiatique: Le lancement d’o3 et o4-mini par OpenAI a suscité de vives réactions dans la communauté. Les premiers testeurs (comme Dan Shipper) louent leur vitesse, leur intelligence et leurs capacités d’agent, les considérant déjà comme leurs modèles de prédilection, capables de réussir des benchmarks de code, de personnaliser des cours, de reconnaître des images floues, d’analyser des écrits, etc. Sam Altman a relayé ces propos en soulignant leur niveau “proche ou atteignant le génie”. Cependant, d’autres commentaires (comme la vidéo d’AI Explained) notent que, malgré la puissance des modèles, les affirmations telles que “AGI” ou “sans hallucination” relèvent d’un battage médiatique excessif. Les modèles commettent encore des erreurs de bon sens et de raisonnement physique, et leur rapport qualité-prix pourrait être inférieur à celui de Gemini 2.5 Pro. La communauté reconnaît globalement leurs progrès, notamment en matière de codage et d’utilisation d’outils, mais reste prudente quant à leurs capacités réelles et leurs limites. (Source:

,

, sama, sama, karminski3, gdb, natolambert)

Débat communautaire : L’IA dépend-elle principalement des progrès de la puissance de calcul pour atteindre l’AGI ?: Des utilisateurs de Reddit ont lancé une discussion pour savoir si la réalisation de l’AGI (Intelligence Artificielle Générale) se résume principalement à l’augmentation de la puissance de calcul brute. Certains pensent que même avec les limitations actuelles des LLM, une augmentation d’un ordre de grandeur de la puissance de calcul pourrait apporter une utilité proche de l’AGI, même s’il ne s’agit pas d’une “vraie” AGI. La question clé est de savoir si le problème de l’AGI est intrinsèquement “traitable” (tractable) ; si oui, la force brute computationnelle pourrait suffire. D’autres commentaires réfutent cet argument, estimant que la seule puissance de calcul ne peut surmonter les limitations fondamentales des LLM et que l’AGI nécessite davantage de ruptures de paradigme. (Source: Reddit r/ArtificialInteligence)

Débat communautaire : Quels secteurs seront les premiers à être bouleversés par l’IA ?: Des utilisateurs de Reddit ont lancé une discussion pour spéculer sur les secteurs qui seront les premiers à “s’effondrer” sous l’impact de l’IA. Les secteurs cités incluent : la traduction/rédaction, le support client, l’enseignement des langues, la gestion de portefeuille, l’illustration/photographie commerciale. Les commentaires ont ajouté les transports, le design (interface, marque, logo), les relations publiques/marketing/gestion des médias sociaux, l’enseignement (en particulier le tutorat privé), les blogs/podcasts (changement dans la création de contenu), l’organisation d’événements, etc. Certains commentaires soulignent cependant que tous les domaines ne disparaîtront pas complètement, par exemple la traduction hautement spécialisée ou l’illustration nécessitant une créativité humaine fondamentale conserveront leur place. (Source: Reddit r/ArtificialInteligence)

Expérience utilisateur : Le débogage de code généré par IA est un défi: Un développeur a partagé son expérience de débogage de code généré par un LLM (migration de SAS vers SQL/Python). Bien que le code IA semblait “correct”, il était en réalité truffé d’erreurs : appels à des fonctions non définies, confusion entre des logiques de code similaires mais différentes, omission de SQL mal formaté mais correct, remplacement arbitraire de valeurs clés, et résultats incohérents lors d’exécutions multiples. La conclusion finale est que le code était totalement inutilisable et nécessitait une réécriture complète, la réparation étant plus risquée que la réécriture. Cela met en évidence les limites actuelles des capacités de génération de code par l’IA et souligne la nécessité d’un examen et d’une validation humains. (Source: Reddit r/ArtificialInteligence)

IA et relations de travail : Comment les syndicats devraient-ils réagir ?: Une discussion souligne qu’avec l’augmentation des capacités d’automatisation de l’IA dans divers secteurs, les syndicats doivent réagir plus activement à son impact potentiel sur les travailleurs. L’article cite des grèves et des manifestations passées liées à l’IA, comme des écoles suggérant de remplacer les assistants diplômés en grève par l’IA, l’utilisation de l’IA pour surveiller les manifestations étudiantes, les préoccupations concernant l’automatisation des services de santé mentale, et la possibilité de grèves d’enseignants en raison de l’application de l’IA dans les écoles. L’opinion exprimée est que les travailleurs (et leurs organisations représentatives) ne devraient pas attendre, mais élaborer activement des stratégies pour faire face aux changements induits par l’IA. (Source: Reddit r/artificial)

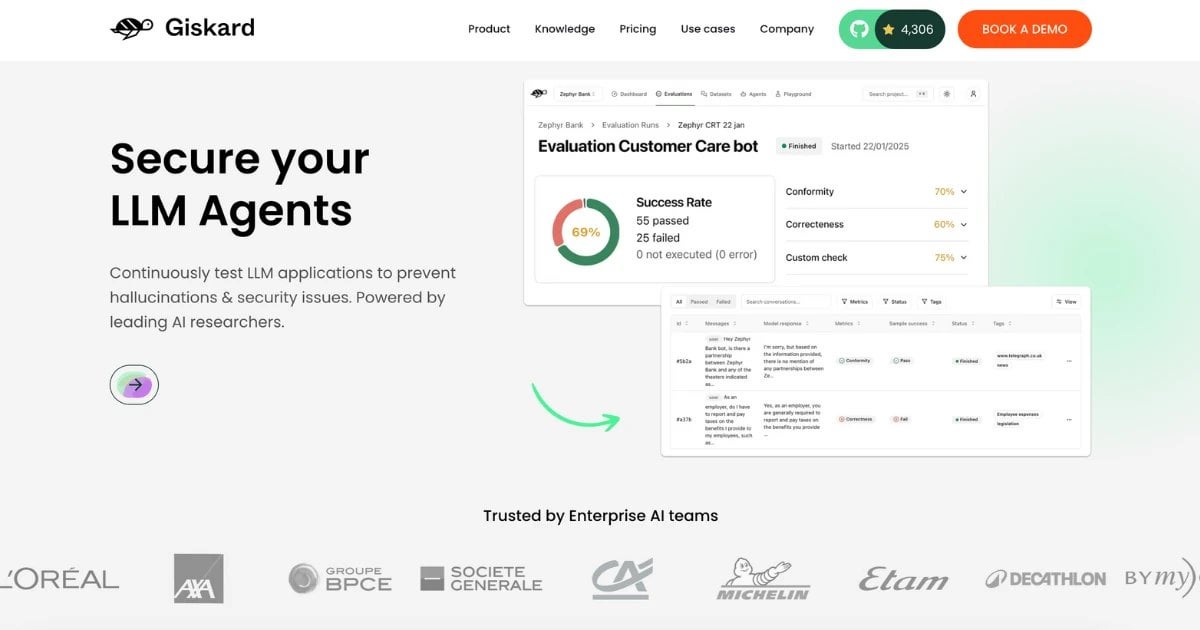

Publication du jeu de données RealHarm : Collecte de cas réels d’échec d’agents IA: L’équipe Giskard a publié le jeu de données RealHarm, qui recense des cas réels et publiquement rapportés où des agents IA (en particulier ceux basés sur des LLM) ont posé problème dans des applications pratiques. En analysant ces cas, l’équipe a constaté que l’atteinte à la réputation est le préjudice organisationnel le plus courant, que la désinformation et les hallucinations sont les types de risques les plus fréquents, et que les garde-fous existants n’ont pas réussi à prévenir efficacement de nombreux incidents. Ce jeu de données vise à aider les chercheurs et les développeurs à mieux comprendre et prévenir les risques de l’IA dans le monde réel. (Source: Reddit r/LocalLLaMA)

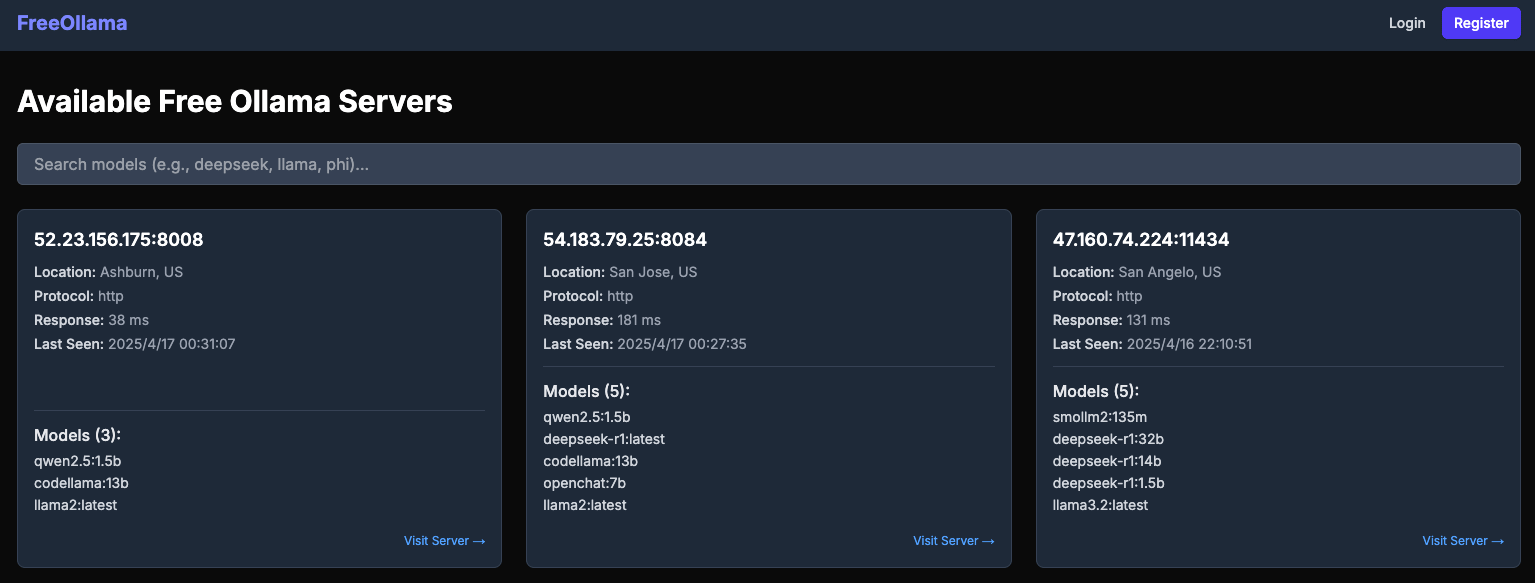

Un rapport révèle les risques de sécurité des serveurs Ollama publics: Le site web freeollama.com met en évidence un grand nombre d’instances de serveurs Ollama exposées sur l’Internet public. Cela indique que de nombreux utilisateurs, lors du déploiement de services LLM locaux, n’ont pas correctement configuré les mesures de sécurité (comme définir l’adresse d’écoute sur 0.0.0.0 sans ajouter d’authentification), exposant leurs modèles et potentiellement leurs données à des accès et utilisations non autorisés. Il est rappelé aux utilisateurs de prêter une attention particulière à la configuration de la sécurité réseau lors du déploiement de services IA locaux. (Source: Reddit r/LocalLLaMA)

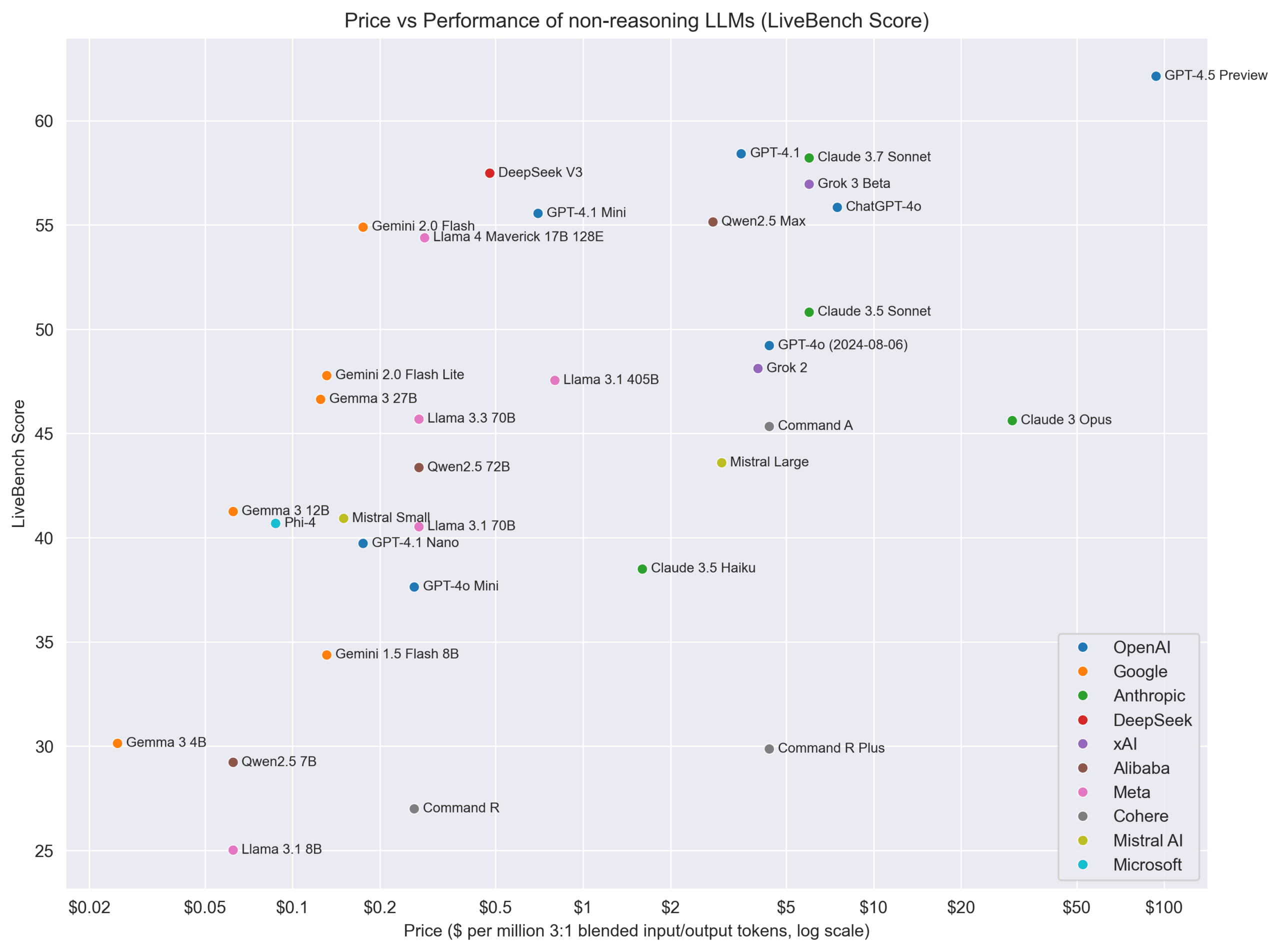

Point de vue : Il ne faut pas diviser strictement les modèles en “raisonnement” et “non-raisonnement”: Le chercheur en IA Nathan Lambert suggère qu’il ne faut pas classer strictement les modèles en catégories “raisonnement” et “non-raisonnement”, mais plutôt évaluer tous les modèles dans tous les domaines. Les “modèles de raisonnement” obtiennent généralement de bons résultats également sur les benchmarks de non-raisonnement, alors que l’inverse n’est pas vrai. Cela suggère que les modèles dotés de capacités de raisonnement pourraient être plus généraux. Parallèlement, il souligne la nécessité de meilleurs modèles de tarification pour refléter les différentes capacités et coûts. (Source: natolambert)

Demis Hassabis, co-fondateur de DeepMind, figure au TIME100 et souligne la coopération en matière de sécurité de l’IA: Demis Hassabis, PDG de Google DeepMind, a été inclus dans la liste des 100 personnes les plus influentes de 2025 du magazine Time. Dans une interview, il a souligné son espoir que les pays et entreprises concurrents puissent mettre de côté leurs différends et coopérer sur la sécurité de l’IA, car assurer que l’IA évolue positivement est dans l’intérêt de tous. (Source: demishassabis)

Cadre dirigeant de Google DeepMind : L’apprentissage par renforcement doit dépasser la connaissance humaine: David Silver, vice-président de l’apprentissage par renforcement chez Google DeepMind, estime que la recherche en IA doit aller au-delà des connaissances humaines connues, vers des systèmes capables d’auto-apprentissage et même de découvrir de nouvelles connaissances scientifiques. Cela souligne le potentiel de l’apprentissage par renforcement pour stimuler l’exploration et la découverte autonomes par l’IA. (Source: GoogleDeepMind)

Point de vue : Le goulot d’étranglement du développement de l’IA est passé de la puissance de calcul aux données et à l’évaluation: En analysant les progrès de modèles comme Kling 2.0, GPT-4.1, o3, l’animateur de la chaîne AI Explained cite des cadres d’OpenAI indiquant que les facteurs limitants actuels du développement de l’IA sont passés davantage de la puissance de calcul aux données, en particulier les données de haute qualité spécifiques à un domaine et les méthodes d’évaluation efficaces (Evals). L’amélioration des performances des modèles dépend de plus en plus de la découverte de meilleures données et de meilleures façons de mesurer les progrès. (Source:

)

Graphique comparatif prix/performance des modèles sans raisonnement: La communauté Reddit a partagé un graphique comparant le prix (probablement le coût de l’API) de différents LLM sans capacité de raisonnement explicite avec leur score de performance sur LiveBench (une plateforme de benchmark en temps réel). Le graphique montre de manière intuitive le rapport qualité-prix de divers modèles sur ce benchmark spécifique, indiquant par exemple que la série Gemma/Gemini se distingue par son rapport qualité-prix. (Source: Reddit r/LocalLLaMA)

💡 Autres

Nouvelle avancée en interface cerveau-machine : convertir directement les ondes cérébrales en parole: Une nouvelle recherche présente un implant d’interface cerveau-machine (BCI) capable de décoder en temps réel les ondes cérébrales d’une personne paralysée et de les synthétiser en parole naturelle. Cette technologie offre de nouvelles possibilités de communication aux personnes ayant perdu la capacité de parler suite à des lésions nerveuses ou des maladies, représentant une percée majeure à l’intersection de l’IA, des technologies d’assistance et des neurosciences. (Source: Ronald_vanLoon, Ronald_vanLoon)

L’exploration du jeu vidéo IA par le fondateur de Mihoyo, Cai Haoyu: Anuttacon, la société d’IA fondée par l’ancien PDG de Mihoyo, Cai Haoyu, a publié une bande-annonce et une démo jouable de son jeu expérimental IA “Whispers From The Star”. Le jeu est centré sur des dialogues en temps réel pilotés par l’IA, où les joueurs interagissent avec le personnage IA Stella par texte, voix ou vidéo pour guider sa survie. Le jeu utilise des technologies IA multimodales ; les émotions, réactions et actions de Stella sont générées en temps réel par l’IA, avec des expressions faciales et des mouvements naturels. Cela reflète l’exploration par Cai Haoyu de la manière dont l’AIGC peut transformer le développement de jeux, mais fait face à des défis de maturité technologique, de modèle économique et d’acceptation par les joueurs. L’article compare également les différentes stratégies d’application de l’IA dans les jeux par de grands acteurs comme Tencent et NetEase. (Source: 原神之后,蔡浩宇的 AIGC 游戏野望)

Unitree met à niveau son robot industriel à roues B2-W: Unitree Robotics a présenté les capacités améliorées de son robot industriel à roues B2-W. Bien que les détails spécifiques de la mise à niveau n’aient pas été précisés, ces types de robots intègrent généralement la technologie IA pour la navigation, l’évitement d’obstacles, l’exécution de tâches, etc. Cette mise à niveau pourrait impliquer une autonomie accrue, une capacité de charge supérieure ou des applications spécifiques à des scénarios industriels. (Source: Ronald_vanLoon)

Les robots apprennent les compétences humaines: Circuit Robotics montre comment les robots peuvent apprendre des compétences humaines. Cela implique généralement des méthodes d’IA telles que l’apprentissage par imitation et l’apprentissage par renforcement, permettant aux robots de maîtriser des tâches opérationnelles complexes en observant des démonstrations ou par essais et erreurs, ce qui constitue une direction de recherche importante combinant robotique et IA. (Source: Ronald_vanLoon)

Les robots d’achat deviennent une réalité: Une vidéo ou une information partagée par Fabrizio Bustamante indique que l’utilisation de robots pour faire les courses devient une réalité. Cela pourrait faire référence à des robots de tri automatisés dans les entrepôts, ou à des robots de livraison ou d’assistance en magasin destinés aux consommateurs, qui nécessitent généralement l’IA pour la planification d’itinéraires, la reconnaissance d’objets et l’interaction homme-machine. (Source: Ronald_vanLoon)

Application de l’IA et de la robotique dans l’agriculture: JC Niyomugabo discute de l’application de l’IA et de la robotique dans l’agriculture (AgriTech). Cela inclut l’utilisation de l’IA pour la surveillance des cultures, le diagnostic des maladies et des ravageurs, la prise de décision pour l’irrigation et la fertilisation de précision, ainsi que l’utilisation de robots pour le semis, le désherbage, la récolte automatisés, etc. L’objectif est d’améliorer l’efficacité, le rendement et la durabilité de l’agriculture. (Source: Ronald_vanLoon)

Des nano-robots porteurs d‘“armes cachées” peuvent tuer les cellules cancéreuses: Une recherche partagée par Khulood Almani montre qu’un type de nano-robot équipé d‘“armes cachées” (mécanisme spécifique non détaillé) est capable de cibler et de tuer les cellules cancéreuses. Les mécanismes de navigation et de ciblage des nano-robots impliquent souvent des algorithmes d’IA pour identifier les cibles et exécuter des tâches dans des environnements biologiques complexes, ce qui représente une application de pointe dans le domaine de la santé. (Source: Ronald_vanLoon)

Développement de la main bionique COVVI: La main bionique développée par la société COVVI vise à fournir aux personnes amputées une prothèse plus flexible et fonctionnelle. Ces mains bioniques avancées intègrent généralement des capteurs et des algorithmes d’IA pour interpréter les signaux musculaires de l’utilisateur (comme les signaux électromyographiques EMG) ou les signaux nerveux, permettant un contrôle par la pensée plus naturel et des manipulations fines. (Source: Ronald_vanLoon)

Un robot humanoïde chinois effectue des tâches de contrôle qualité: WevolverApp rapporte que des robots humanoïdes en Chine sont désormais utilisés pour effectuer des tâches de contrôle qualité. Cela nécessite que le robot possède des capacités avancées de reconnaissance visuelle (potentiellement pilotées par l’IA), des capacités de manipulation précises et une certaine capacité de décision pour juger si un produit est conforme, illustrant une application des robots humanoïdes dans l’automatisation industrielle. (Source: Ronald_vanLoon)

Première chirurgie humaine au monde réalisée par un robot dentiste: Gigadgets rapporte la première chirurgie humaine au monde entièrement réalisée par un robot dentiste. Bien que les détails ne soient pas clairs, cela signifie généralement qu’un système robotique, assisté par l’IA, a effectué la planification, le positionnement et l’opération chirurgicale, visant à améliorer la précision et la cohérence chirurgicales. Il s’agit d’une étape importante dans la combinaison de la robotique médicale et de l’IA. (Source: Ronald_vanLoon)

L’IA moteur du progrès numérique, construction de nations intelligentes: Un article de Ronald van Loon en collaboration avec Huawei explore comment les technologies numériques telles que l’IA, l’Internet des Objets (IoT), la connectivité et l’analyse de données peuvent stimuler le progrès national et construire des nations plus intelligentes. Il souligne le rôle de l’IA dans l’optimisation des services publics, la gestion des infrastructures, le développement économique, etc. (Source: Ronald_vanLoon)

Le robot Velox capable de se déplacer sur terre et sur l’eau: Le robot Velox partagé par Pascal Bornet est un robot amphibie capable de se déplacer aussi bien dans l’eau que sur terre. Cette polyvalence pourrait le rendre adapté à des scénarios complexes tels que la recherche et le sauvetage, la surveillance environnementale, et sa capacité de navigation autonome et d’adaptation à différents environnements pourrait être pilotée par l’IA. (Source: Ronald_vanLoon)